May

8

Fluctuaciones de vacío, D-Branas, Dimensiones extra: ¿Será nuestro..

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (10)

Comments (10)

Fluctuaciones del vacío no pueden ser frenadas eliminando su energía

¡Las fluctuaciones de vacío! que, al igual que las ondas “reales” de energía positiva, están sujetas a las leyes de la dualidad onda/partícula; es decir, tienen tanto aspectos de onda como aspectos de partícula. Las ondas fluctúan de forma aleatoria e impredecible, con energía positiva momentáneamente aquí, energía negativa momentáneamente allí, y energía cero en promedio. El aspecto de partícula está incorporado en el concepto de partículas virtuales, es decir, partículas que pueden nacer en pares (dos partículas a un tiempo), viviendo momentáneamente de la energía fluctuacional tomada prestada de regiones “vecinas del espacio”, y que luego se aniquilan y desaparecen, devolviendo la energía a esas regiones vecinas. Si hablamos de fluctuaciones electromagnéticas del vacío las partículas virtuales son fotones virtuales; en el caso de fluctuaciones de la Gravedad en el vacío, son gravitones virtuales.

Claro que, en realidad, sabemos poco de esas “regiones vecinas” de las que tales fluctuaciones toman la energía pero, insistimos en querer verlas para saber y no dejamos de preguntarnos… ¿Qué es lo que hay allí? ¿Estaba en esa región la tan buscada partícula de Higgs? En realidad sabemos que las fluctuaciones de vacío son, para las ondas electromagnéticas y gravitatorias, lo que “los movimientos de degeneración claustrofóbicos” son para los electrones que, al ser fermiones están supeditados al Principio de exclusión de Pauli (como demuestra su comportamiento en el fenómeno de creación de las estrellas enanas blancas).

Si confinamos un electrón a una pequeña región del espacio, entonces, por mucho que un trate de frenarlo y detenerlo, el electrón está obligado por las leyes de la mecánica cuántica a continuar moviéndose aleatoriamente, de forma impredecible. Este movimiento de degeneración claustrofóbico que produce la presión mediante la que una estrella enana blanca se mantiene contra su propia compresión gravitatoria o, en el mismo caso, la degeneración de los neutrones, mantiene estable a la estrella de neutrones que, obligada por la fuerza que se genera de la degeneración de los neutrones, es posible frenar la enorme fuerza de gravedad que está comprimiendo a la estrella.

De la misma forma, si tratamos de eliminar todas las oscilaciones electromagnéticas o gravitatorias de alguna región del espacio, nunca tendremos éxito. Las leyes de la mecánica cuántica insisten en que siempre quedarán algunas oscilaciones aleatorias impredecibles, es decir, algunas ondas electromagnéticas y gravitatorias aleatorias e impredecibles. Estas fluctuaciones del vacío no pueden ser frenadas eliminando su energía (aunque algunos estiman que, en promedio, no contienen energía en absoluto).

Ver ambos lados del nivel de Fermi es importante porque, cuando convertimos un material en superconductor, es una energía que rodea al vacío. Con una perfecta simétrica (espaciados por igual encima y por debajo del nivel de Fermi) es una fuerte indicación de que los electrones están vinculados hacia arriba. El vacío superconductor existe en y por debajo de la temperatura de transición, siempre y cuando un material actúe como un superconductor.

Claro que, como antes decía, aún nadie ha podido medir de ninguna manera la cantidad real de energía que se escapa de ese supuesto “vacío”, como tampoco se ha medido la cantidad de fuerza gravitatoria que puede salir de ese mismo espacio “vacío”. Si la energía es masa y si la masa produce gravedad, entonces ¿Qué es lo que hay en ese mal llamado “espacio vacío”?

No puedo contestar de momento esa pregunta, sin embargo, parece que no sería un disparate pensar en la existencia allí, de alguna clase de materia que, desde luego, al igual que la bariónica que sí podemos ve, genera energía y ondas gravitacionales que, de alguna manera que aún se nos oculta, escapa a nuestra vista y solo podemos constatar sus efectos al medir las velocidades a que se alejan las galaxias unas de otras: velocidad de expansión del Universo que no se corresponde en absoluto, con la masa y la energía que podemos ver. ¿Tendrá algo que ver la energía de vacío con todo eso?

Cuando lleguemos a saber lo que realmente es la energía de vacío, podremos utilizarla en nuestro beneficio y, provocar la aprtura de agujeros de gusano para viajar a las estrellas, a otras galaxias, o, incluso, ¿a otros universos? Algunas veces no podemos dejar sorprendernos al leer cosas como:

“Así, como entramos en una nueva era para comprender el tiempo, también hemos entrado a una nueva era de comprender el espacio. Se ha descubierto que lo que llamamos espacio vacío, el vacío, en realidad está repleto de inmensa energía potencial. La conclusión ordinaria de considerar el espacio como la nada, el lugar donde se sitúa la materia, evidentemente se ha convertido en nuestro espacio. Pero el vacío tiene más energía que la materia que está en ese vacío y de hecho, la materia y el vacío son una misma cosa, hay una continuidad. Se ha descubierto que hay más energía en un centímetro cúbico de vacío que en todo el Universo manifiesto.”

Lo cierto es que estamos en un momento crucial de la Física, las matemáticas y la cosmología, y debemos, para poder continuar avanzando, tomar conceptos nuevos que, a partir de los que ahora manejamos, nos permitan traspasar los muros que nos están cerrando el paso para llegar a las supercuerdas, a la posible “materia oscura” o a una “teoría cuántica de la gravedad” que, también está implícita en la teoría M.

Con la incertidumbre de no saber lo que nos podamos encontrar en ese sendero desconocido, estamos obligados a emprender el camino, la aventura merecerá la pena si, al final, encontramos lo que andamos buscando. ¿Que sería de nuestro mundo si, aquellos viajeros aventureros del pasado nunca hubieran osado cruzar los océanos, los desiertos y montañas y las grandes llanuras?

Estamos anclados, necesitamos nuevas y audaces ideas que puedan romper las cadenas “virtuales” que atan nuestras mentes a ideas del pasado que, como la relatividad y la mecánica cuántica llevan cien años predominando sobre la física. ¿No es tiempo ya de andar otros caminos que nos lleven más lejos, que nos enseñen otros horizontes? Sí, creo que hablar de la Teoría del todo, las cuerdas vibrantes, universos paralelos… podría ser un comienzo.

En su momento, esas ideas eran perfectas y cumplieron su misión (y siguen cumpliendo). Sin embargo, ahora no nos dejan continuar y debemos preparar nuestras mentes para evolucionar hacia nuevos conceptos y ahondar en aquellos que, aún estando ahí presentes, no somos capaces de utilizar, como por ejemplo, el Hiperespacio de tan enorme importancia en el futuro de la Humanidad. ¿Será cuándo sepamos “ver” dimensiones más altas que todo nos resultará mucho más sencillo y encontraremos las respuestas a los problemas que hoy, no sabemos resolver?

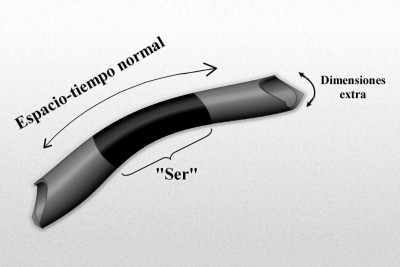

El gráfico representa un modelo de manguera de un espacio-tiempo de dimensiones más altas de tipo Kaluza-Klein, donde la longitud, o mejor, la dimensión a lo largo de la longitud de la manguera representa el 4-espacio-tiempo normal, y la dimensión alrededor de la manguera representa la dimensión extra “pequeñas” (quizá escala de Planck). Imaginemos un “ser” que habite en este mundo, que rebasa estas dimensiones extra “pequeñas”, y por ello no es realmente consciente de ellas.

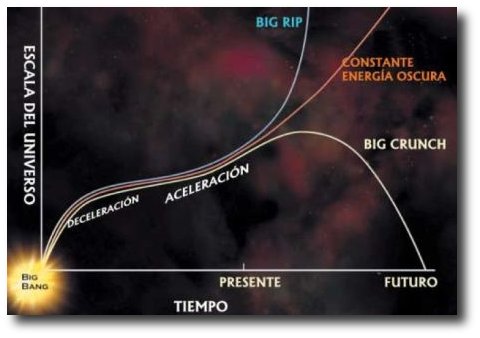

Es posible que, de la misma manera, también nosotros estémos imposibilitados para ver esas dimensiones extra que, sin embargo, nos permita ver más allá de las matemáticas topológicas, más allá de las fluctuaciones de vacío, más allá de los quarks, más allá de las singularidades y… ¿Por qué no decirlo? ¡Más allá de nuestro propio Universo! No podemos olvidarnos de que dentro de varios eones, nuestro Universo podría morir. Estamos obligados a buscar la manera (si existe), de escapar de ese destino fatal.

Si el final del universo es convertirse en una singularidad, entonces, de ella, nacerá otro universo y todo comenzará de nuevo. Estaríamos entonces en un Universo cíclico como pensaban algunos de los pueblos de la Antigüedad-

Si el Universo, finalmente, se convierte en una singularidad que es una región donde (según las leyes de la relatividad general) la curvatura del espacio-tiempo se hace infinitamente grande, y el espacio-tiempo deja de existir, toda vez que, la singularidad es también una región de gravedad de marea infinita, es decir, una región donde la gravedad ejerce un tirón infinito sobre todos los objetos a lo largo de algunas direcciones y una compresión infinita a lo largo de otras.

Después de crear un horizonte de agujero negro a su alrededor, dicen las ecuaciones que describen este fenómeno, la materia toda que compone nuestro Universo, continuará implosionando, inexorablemente, hasta alcanzar densidad infinita y volumen cero, creándose así la singularidad que estará fundida con el espacio-tiempo.

Si eso ocurre (cosa poco probable), seguramente, de esa “nada” que se ha formado, más pronto o más tarde surgirá, mediante una enorme explosión, un nuevo Universo que, no sabemos si será igual, con las mismas fuerzas y las mismas leyes que el que ahora tenemos. Por otra parte, en el mismo inmenso tiempo, el Universo en lugar de contraerse sobre sí mismo, al no contener la materia suficiente, se expandirá para siempre y, llegará a la muerte térmica del cero absoluto (-273 ºC) Así que, si todo esto resulta ser así ¿No sería una irresponsabilidad, el no hacer nada? ¡Claro que sí!

Tenemos que continuar, cada uno en la medida de sus posibilidades, procurando avanzar hacía un futuro de profundos conocimientos que nos permitan, algún día lejano escapar de ese escenario de destrucción. Precisamente por eso, se buscan nuevas teorías y se piensa en otros universos y, nos hacemos preguntas sobre branas y dimensiones extra.

Sí, siempre estamos tratando de llegar a sitios… ¿Imposibles?, o, simplemente se trata de que nuestra intuición “sabe” que están ahí y trata de alcanzarlo

¿Qué son las D-Branas? ¿Por qué las requiere la teoría de cuerdas? La respuesta básica a la segunda pregunta es que dan sentido a las cuerdas abiertas que intervienen en la teoría tipo I: cada uno de los dos extremos de una cuerda abierta debe residir en una D-brana.

La mayoría de las versiones de la teoría de cuerdas implican dos tipos de cuerda: cuerdas abiertas con puntos finales desligados y cuerdas cerradas que forman lazos cerrados. Explorando las consecuencias de la acción Nambu-Goto, queda claro que la energía puede fluir a lo largo de una cuerda, deslizándose hasta el punto final y desapareciendo. Esto plantea un problema: la conservación de la energía establece que la energía no debe desaparecer del sistema. Por lo tanto, una teoría consistente de cuerdas debe incluir lugares en los cuales la energía pueda fluir cuando deja una cuerda; estos objetos se llaman D-branas. Cualquier versión de la teoría de cuerdas que permite cuerdas abiertas debe incorporar necesariamente D-branas, y todas las cuerdas abiertas debe tener sus puntos finales unidos a estas branas. Para un teórico de cuerdas, las D-branas son objetos físicos tan “reales” como las cuerdas y no sólo entes matemáticos que reflejan un valor.

Se espera que todas las partículas elementales sean estados vibratorios de las cuerdas cuánticas, y es natural preguntarse si las D-branas están hechas de alguna modo con las cuerdas mismas. En un sentido, esto resulta ser verdad: entre el espectro de las partículas que las vibraciones de la cuerda permiten, encontramos un tipo conocido como taquión, que tiene algunas propiedades raras, como masa imaginaria. Las D-branas se pueden imaginar como colecciones grandes de taquiones coherentes, de un modo parecido a los fotones de un rayo láser.

¿Tendrá el Universo más dimensiones de las que podemos ver?

Esto tiene implicaciones en la cosmología, porque la teoría de cuerdas implica que el universo tienen más dimensiones que lo esperado (26 para las teorías de cuerdas bosónicas y 10 para las teorías de supercuerdas) tenemos que encontrar una razón por la cual las dimensiones adicionales no son evidentes. Una posibilidad sería que el universo visible es una D-brana muy grande que se extiende sobre tres dimensiones espaciales. Los objetos materiales, conformados de cuerdas abiertas, están ligados a la D-brana, y no pueden moverse “transversalmente” para explorar el universo fuera de la brana. Este panorama se llama una Cosmología de branas. La fuerza de la Gravedad no se debe a las cuerdas abiertas; los gravitones que llevan las fuerzas gravitacionales son estados vibratorios de cuerdas cerradas. Ya que las cuerdas cerradas no tienen porque estar unidas a D-branas, los efectos gravitacionales podrían depender de las dimensiones adicionales perpendiculares a la brana.

Los dos extremos de la cuerda abierta residen en un subespacio (q+l)- dimensional de género tiempo llamado una D-brana, o D-q-brana que es una entidad esencialmente clásica (aunque posee propiedades de súpersimetría=, que representa una solución de la teoría de la supergravedad 11 dimensional.

Las teorías de dimensiones extra permiten transitar por otros caminos que, el mundo tetradimensional prohibe

En respuesta a la primera pregunta, una D-Brana es una estructura de genero tiempo, como más arriba indico, 1+q dimensiones espaciotemporales. (Invocando una de las dualidades de la teoría M, alternativamente podemos considerar una D-Grana como una solución de las ecuaciones de alguna otra versión de la teoría M de cuerdas.)

Las D-branas aparecen en muchas discusiones modernas relacionadas con las cuerdas (por ejemplo, en la entropía de los agujeros negros). Suelen tratarse como si fueran objetos clásicos que yacen dentro del espaciotiempo completo 1+9 (° 1+10) dimensiones. La “D” viene de “Dirichlet”, por analogía con el tipo de problema de valor de frontera conocido como un problema de Dirichlet, en el que hay una frontera de género tiempo sobre la que se especifican datos (según Meter G. Lejeune Dirichlet, un eminente matemático francés que vivió entre 1805 y 1859.)

Con la introducción de tales “D-branas” varios teóricos han expresado una “filosofía de cuerdas” que parece representar un profundo cambio respecto a lo anterior. En efecto, se afirma con cierta frecuencia que podríamos “vivir en” esta o esa D-brana, lo que significa que nuestro espaciotiempo percibido podría yacer realmente dentro de una D-brana, de modo que la razón de que no se perciban ciertas “dimensiones extra” se explicaría por el hecho de que “nuestra” D-brana no se extiende a esas dimensiones extra.

La última posibilidad sería la postura más económica, por supuesto, de modo que “nuestra” D-brana (una D-3 brana) sería de 1+3 dimensiones. Esto no elimina los grados de libertad en las dimensiones extra, pero los reduce drásticamente. ¿Por qué es así? Nuestra perspectiva ahora es que somos “conscientes” de los grados de libertad que están implicados en el interior profundo del espacio de mayores dimensiones entre los D-branas, y es en esto donde se está dejando sentir la excesiva libertad funcional.

Solo vamos a ser conscientes de dimensiones extra allí donde inciden directamente sobre las D-brana en la que “vivimos”. Más que una imagen de tipo “espacio cociente” que evoca la analogía de Kaluza-Kleinoriginal:

Pero ¿Cuántas dimensiones existen en realidad?

Así, nuestro espaciotiempo observado aparece ahora como un subespacio 4-dimensional del espacio real de dimensiones más altas. Con algo de imaginación, lo podemos visualizar en nuestra mente. ¿Cuánta libertad funcional esperamos ahora? La situación es ahora algo parecida a la imagen geométrica que hemos adoptado en el gráfico para obtener una perspectiva más convencional con respecto a la “supergeometría”.

Puesto que ahora estamos interesados solo en el comportamiento en la D-brana (que suponemos que es geométricamente una (1+3)-superficie ordinaria), podemos imaginar que nuestra libertad funcional se ha convertido en una aceptable αMα3, aunque para un M bastante grande. Sin embargo, incluso esto supone que la restricción de la dinámica en el 10-espacio (u 11-espacio) completo nos proporciona ecuaciones dinámicas dentro de “nuestra” D-brana 4-dimensional que son del tipo convencional, de modo que bastará los datos iniciales en una 3-superficie para determinar el comportamiento en todo el 4-espacio. Esto es difícilmente probable, en general, de modo que aún cabe esperar un excesivo αMα3.

¡El problema no ha desaparecido todavía! y, seguiremos investigando al mismo tiempo que nuestra imaginación, teoriza y conjetura… ¡De tantas maneras! que, será casi imposible que no demos, algún día, con la verdad que el Universo esconde.

emilio silvera

May

7

¿Somos materia evolucionada hasta el nivel de la consciencia?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y... ¿nosotros? ~

Clasificado en El Universo y... ¿nosotros? ~

Comments (6)

Comments (6)

Una Galaxia es simplemente una pequeña del Universo, nuestro planeta es, una mínima fracción infinitesimal de esa Galaxia, y, nosotros mismos, podríamos ser comparados (en relación a la inmensidad del cosmos) con una colonia de bacterias pensantes e inteligentes. Sin embargo, toda forma parte de lo mismo y, aunque pueda dar la sensación engañosa de una cierta autonomía, en realidad todo está interconectado y el funcionamiento de una cosa incide directamente en las otras. ¡Ah! Nada es pequeño ni grande, las dimensiones son relativas y dependen del contexto en el que las podamos medir.

Sí, en nuestro universo si algo cambia, muchas otras cosas serán distintas

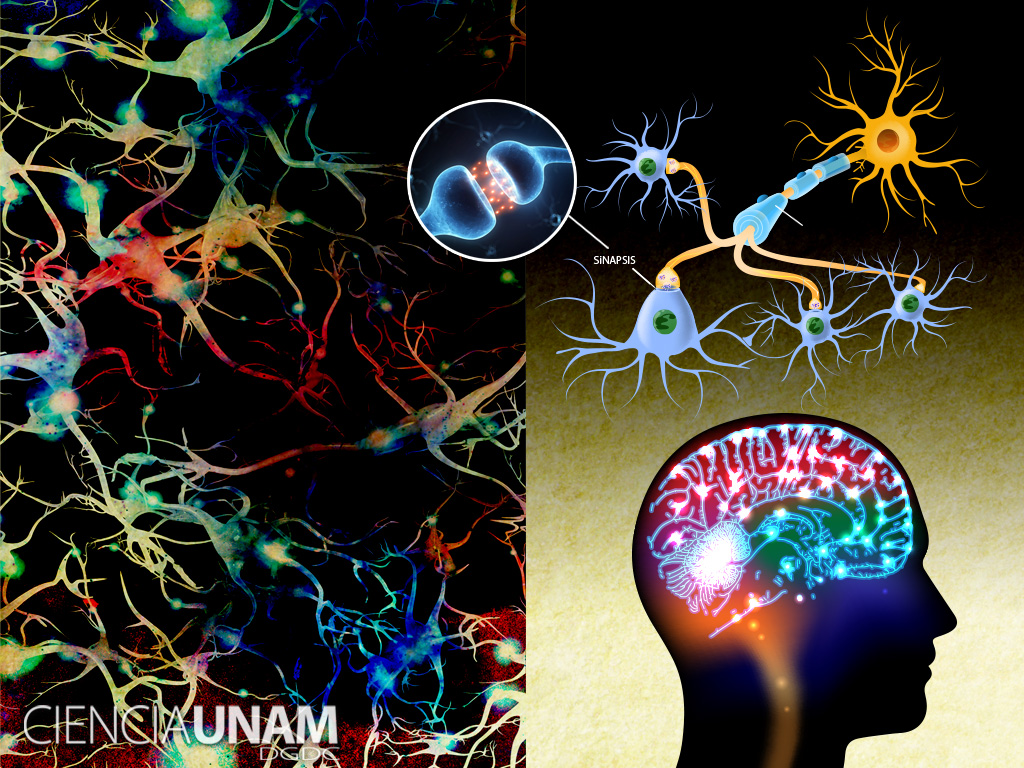

Pocas dudas pueden caber a estas alturas del hecho de que poder estar hablando de estas cuestiones, es un milagro en sí mismo. Después de millones y millones de años de evolución, se formaron las conciencias primarias que surgieron en los animales con ciertas estructuras cerebrales de alta complejidad que, podían ser capaces de construir una escena mental, con capacidad semántica o simbólica muy limitada y careciendo de un verdadero lenguaje.

La conciencia de orden superior (que floreció en los humanos y presupone la coexistencia de una conciencia primaria) viene acompañada de un sentido de la propia identidad y de la capacidad explícita de construir en los estados de vigilia escenas pasadas y futuras. mínimo, requiere una capacidad semántica y, en su forma más desarrollada, una capacidad lingüística.

Los procesos neuronales que subyacen en nuestro cerebro son en realidad desconocidos y, aunque son muchos los estudios y experimentos que se están realizando, su complejidad es tal que, de , los avances son muy limitados. Estamos tratando de conocer la máquina más compleja y perfecta que existe en el Universo.

Si eso es así, resultará que después de todo, no somos tan insignificantes como en un principio podría parecer, y solo se trata de tiempo. En su momento y evolucionadas, nuestras mentes tendrán un nivel de conciencia que estará más allá de las percepciones físicas tan limitadas. Para entonces, sí estaremos totalmente integrados y formando parte, como un todo, del Universo que presentimos.

El carácter especial de la conciencia me hace adoptar una posición que me lleva a decidir que no es un objeto, sino un proceso y que, este punto de vista, puede considerarse un ente digno del estudio científico perfectamente legítimo.

La conciencia plantea un problema especial que no se encuentra en otros de la ciencia. En la Física y en la Química se suele explicar unas entidades determinadas en función de otras entidades y leyes. Podemos describir el agua con el lenguaje ordinario, pero podemos igualmente describir el agua, al menos en principio, en términos de átomos y de leyes de la mecánica cuántica. Lo que hacemos es conectar dos niveles de descripción de la misma entidad externa (uno común y otro científico de extraordinario poder explicativo y predictivo. Ambos niveles de descripción) el agua líquida, o una disposición particular de átomos que se comportan de acuerdo con las leyes de la mecánica cuántica (se refiere a una entidad que está fuera de nosotros y que supuestamente existe independientemente de la existencia de un observador consciente.)

En el caso de la conciencia, sin embargo, nos encontramos con una asimetría. Lo que intentamos no es simplemente comprender de qué manera se puede explicar las conductas o las operaciones cognitivas de otro ser humano en términos del funcionamiento de su cerebro, por difícil que esto parezca. No queremos simplemente conectar una descripción de algo externo a nosotros con una descripción científica más sofisticada. Lo que realmente queremos es conectar una descripción de algo externo a nosotros (el cerebro), con algo de nuestro interior: una experiencia, nuestra propia experiencia individual, que nos acontece en tanto que observadores conscientes. Intentamos meternos en el interior o, en la atinada ocurrencia del filósofo Tomas Negel, saber qué se siente al ser un murciélago. Ya sabemos qué se siente al ser nosotros mismos, qué significa ser nosotros mismos, pero queremos explicar por qué somos conscientes, saber qué es ese “algo” que nos hace ser como somos, explicar, en fin, cómo se generan las cualidades subjetivas experienciales. En suma, deseamos explicar ese “Pienso, luego existo” que Descartes postuló como evidencia primera e indiscutible sobre la cual edificar toda la filosofía.

Ninguna descripción, por prolija que sea, logrará nunca explicar cabalmente la experiencia subjetiva. Muchos filósofos han utilizado el ejemplo del color para explicar este punto. Ninguna explicación científica de los mecanismos neuronales de la discriminación del color, aunque sea enteramente satisfactorio, bastaría para comprender cómo se siente el proceso de percepción de un color. Ninguna descripción, ninguna teoría, científica o de otro , bastará nunca para que una persona daltónica consiga experimentar un color.

En un experimento mental filosófico, Mary, una neurocientífica del futuro daltónica, lo sabe todo acerca del sistema visual y el cerebro, y en particular, la fisiología de la discriminación del color. Sin embargo, cuando por fin logra recuperar la visión del color, todo aquel conocimiento se revela totalmente insuficiente comparado con la auténtica experiencia del color, comparado con la sensación de percibir el color. John Locke vio claramente problema hace mucho tiempo.

Pensemos por un momento que tenemos un amigo ciego al que contamos lo que estamos viendo un día soleado del mes de abril: El cielo despejado, limpio y celeste, el Sol allí arriba esplendoroso y cegador que nos envía su luz y su calor, los árboles y los arbustos llenos de flores de mil colores que son asediados por las abejas, el aroma y el rumor del río, cuyas aguas cantarinas no cesan de correr transparentes, los pajarillos de distintos plumajes que lanzan alegres trinos en sus por el ramaje que se mece movido por una brisa suave, todo esto lo contamos a nuestro amigo ciego que, si de pronto pudiera ver, comprobaría que la experiencia directa de sus sentidos ante tales maravillas, nada tiene que ver con la pobreza de aquello que le contamos, por muy hermosas palabras que para hacer la descripción empleáramos.

La mente humana es tan compleja que, no todos ante la misma cosa, vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugiere. De diez personas solo coinciden tres, los otro siete divergen en la apreciación de lo que el dibujo o la figura les sugiere.

Claro que, no siempre podemos elegir. Lo del libre albedrío es muy limitado

Esto nos viene a demostrar la individualidad de pensamiento, el libre albedrío para decidir. Sin embargo, la misma prueba, realizada en grupos de conocimientos científicos similares y específicos: Físicos, matemáticos, químicos, etc., hace que el de coincidencias sea más elevada, más personas ven la misma respuesta al problema planteado. Esto nos sugiere que, la mente está en un estado virgen que cuenta con todos los elementos necesarios para dar respuestas pero que necesita experiencias y aprendizaje para desarrollarse.

¿Debemos concluir entonces que una explicación científica satisfactoria de la conciencia queda siempre fuera de nuestro alcance?

¿O es de alguna manera posible, romper esa barrera, tanto teórica como experimental, para resolver las paradojas de la conciencia?

La respuesta a estas y otras preguntas, en mi opinión, radica en reconocer nuestras limitaciones actuales en campo del conocimiento complejo de la mente, y, como en la Física cuántica, existe un principio de incertidumbre que, al menos de momento (y creo que en muchos cientos de años), nos impide saberlo todo sobre los mecanismos de la conciencia y, aunque podremos ir contestando a preguntas parciales, alcanzar la plenitud del conocimiento total de la mente no será nada sencillo, entre otras razones está el serio inconveniente que suponemos nosotros mismos, ya que, con nuestro que podemos, en cualquier momento, provocar la propia destrucción.

Una cosa si está clara: ninguna explicación científica de la mente podrá nunca sustituir al fenómeno real de lo que la propia mente pueda sentir. ¿Cómo se podría comparar la descripción de un gran amor con sentirlo, vivirlo física y sensorialmente hablando?

Hay cosas que no pueden ser sustituidas, por mucho que los analistas y especialistas de publicidad y marketing se empeñen, lo auténtico siempre será único. Si acaso, el que más se aproximar, a esa verdad, es el poeta.

emilio silvera

May

7

Decir Universo… ¡Son tantas cosas!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Curiosidades ~

Clasificado en Curiosidades ~

Comments (2)

Comments (2)

En el vacío, la existencia del cuanto de acción, h, que está íntimamente unida a la propia naturaleza de la energía de las fluctuaciones cuánticas obliga a que su estructura sea discontinua, escalonada, fractal (prefractal), lejos de la continuidad clásica, por ello la geometría fractal puede enseñarnos algo que antes no podíamos ver. Pero las fluctuaciones cuánticas de energía del vacío no son simples variaciones sobre un fondo absoluto y estático. Las fluctuaciones determinan la propia geometría del espacio, por lo que analizando su estructura podremos averiguar algo más sobre la referencia espaciotemporal que determinan. La forma en que se puede proceder a analizarlas es idéntica a como se determina la dimensión fractal de una costa o cualquier figura fractal sencilla. La pauta que nos guia, en nuestro caso, es la variación de la energía virtual de las fluctuaciones con la distancia.

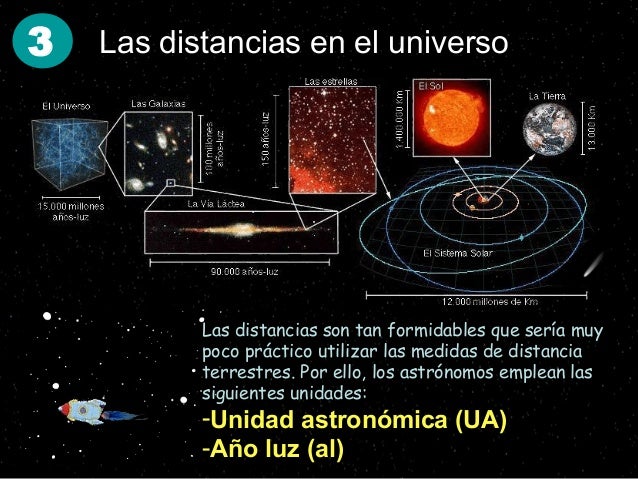

Desde distancias astronómicas hasta la Longitud de Planck la energía asociada está siempre en proporción inversa a dicha distancia: si para una distancia D se le asocia una energía E, para una distancia 2D se le asocia una energía E/2.A pesar de lo intrincadas e irregulares que son las fluctuaciones cuánticas su dependencia con el inverso de la distancia permite al vacío cuántico que se nos presente de forma, prácticamente, similar al vacío clásico a pesar de las tremendas energías a las que se encuentra asociado. En este efecto tuvo mucho que ver la particular geometría que adoptó nuestro Universo : 3 dimensiones espaciales ordinarias, una temporal y 6 compactadas (como supone la teoría de cuerdas). Esta geometría y la propia naturaleza del cuanto de acción, h, están íntimamente ligadas. Con otra geometría diferente las reglas de la mecánica cuántica en nuestro universo serían completamente diferentes.

La estabilidad del espacio-tiempo, de la materia y de la energía tal como los conocemos sería imposible y, a la postre, tampoco sería posible la belleza que esta estabilidad posibilita así como la propia inteligencia y armonía que, en cierta forma, subyace en todo el Universo.

Se supone que la “materia oscura” está por ahí, aunque no la podamos ver

Así que, entre el espacio que podemos ver, ese vacío que sabemos que está ahí y no podemos más más que algunas consecuencias de su existencia, lo que llamamos “materia oscura” que es la mayor concentración de “ese algo” que existe, y, que, bien podrían ser las semillas a partir de las cuales surge la materia normal o luminosa una vez que, con el tiempo y a partir de esa “semilla” se transforma en materia “normal”, Bariónica y, ahora sí, sujeta al electromagnetismo…Todo eso, amigos, no podría incidir de alguna manera en esa Entropía destructora que, sin que lo sepamos está siendo combatida por todos esos parámetros que ignoramos…a ciencia cierta.

Una ley científica es un fenómeno universal observado experimentalmente y que puede verificarse mediante el método científico. Algunas de leyes establecidas mediante el método científico que confirman la creación son:

Leyes de la Termodinámica y otras que hemos podido descubrir pero… esa sería otra historia.

Laboratorio estelar, la cuna de los mundos.

Cuando me sumerjo en los misterios y maravillas que encierra el universo, no puedo dejar de sorprenderme por sus complejas y bellas formaciones, la inmensidad, la diversidad, las fuerzas que están presentes, los objetos que lo pueblan, y, esa presencia invisible que permea todo el espacio y que se ha dado en denominar océano y campos de Higgs, allí donde reside esa clase de energía exótica, ese nuevo éter que, en definitiva hace que el Universo funcione tal como lo podemos ver. Existen muchos parámetros del Cosmos que aún no podemos comprender y que, de momento, sólo sabemos presentir, es como si pudiéramos ver la sombra de algo que no sabemos lo que es.

Todo el Universo conocido nos ofrece una ingente cantidad de objetos que se nos presentan en formas de estrellas y planetas, extensas nebulosas formadas por explosiones de supernovas y que dan lugar al nacimiento de nuevas estrellas, un sin fin de galaxias de múltiples formas y colores, extraños cuerpos que giran a velocidades inusitadas y que alumbran el espacio como si de un faro se tratara, y, hasta objetos de enormes masas y densidades infinitas que no dejan escapar ni la luz que es atrapada por su fuerza de gravedad.

Ya nos gustaría saber qué es, todo lo que observamos en nuestro Universo

Sin embargo, todo eso, sin importar las figuras que puedan haber adoptado, está formado por minúsculos e infinitesimales objetos que llamamos quarks y leptones, partículas elementales que se unen para formar toda esa materia que podemos ver y que llamamos Bariónica pudiendo ser detectada porque emite radiación. Al contrario ocurre con esa otra supuesta materia que llamamos oscura y que, al parecer, impregna todo el universo conocido, ni emite radiación ni sabemos a ciencia cierta de qué podrá estar formada, y, al mismo tiempo, existe también una especie de energía presente también en todas partes de la que tampoco podemos explicar mucho.

Con esta imagen nos preguntas qué es la energía oscura

Pensemos por ejemplo que un átomo tiene aproximadamente 10-8 centímetros de diámetros. En los sólidos y líquidos ordinarios los átomos están muy juntos, casi en contacto mutuo. La densidad de los sólidos y líquidos ordinarios depende por tanto del tamaño exacto de los átomos, del grado de empaquetamiento y del peso de los distintos átomos.

Isaac Asimov en uno de sus libros nos explicó que, los sólidos ordinarios, el menos denso es el hidrógeno solidificado, con una densidad de 0’076 gramos por cm3. El más denso es un metal raro, el osmio, con una densidad de 22’48 gramos/cm3. Si los átomos fuesen bolas macizas e incompresibles, el osmio sería el material más denso posible, y un centímetro cúbico de materia jamás podría pesar ni un kilogramo, y mucho menos toneladas.

Ese puntito blanco del centro de la Nebulosa planetaria, es mucho más denso que el osmio, es una enana blanca, y, sin embargo, no es lo más denso que en el Universo podemos encontrar. Cualquier estrella de neutrones es mucho más densa y, no hablemos de los agujeros negros, de su singularidad.

Pero los átomos no son macizos. El físico neozelandés experimentador por excelencia, Ernest Ruthertord, demostró en 1909 que los átomos eran en su mayor parte espacio vacío. La corteza exterior de los átomos contiene sólo electrones ligerísimos, mientras que el 99’9% de la masa del átomo está concentrada en una estructura diminuta situada en el centro: el núcleo atómico.

El núcleo atómico tiene un diámetro de unos 10-15 cm (aproximadamente 1/100.000 del propio átomo). Si los átomos de una esfera de materia se pudieran estrujar hasta el punto de desplazar todos los electrones y dejar a los núcleos atómicos en contacto mutuo, el diámetro de la esfera disminuiría hasta un nivel de 1/100.000 de su tamaño original. De manera análoga, si se pudiera comprimir la Tierra hasta dejarla reducida a un balón de núcleos atómicos, toda su materia quedaría reducida a una esfera de unos 130 metros de diámetro. En esas mismas condiciones, el Sol mediría 13’7 km de diámetro en lugar de los 1.392.530 km que realmente mide. Y si pudiéramos convertir toda la materia conocida del universo en núcleos atómicos en contacto, obtendríamos una esfera de sólo algunos cientos de miles de km de diámetro, que cabría cómodamente dentro del cinturón de asteroides del Sistema Solar.

El calor y la presión que reinan en el centro de las estrellas rompen la estructura atómica y permiten que los núcleos atómicos empiecen a empaquetarse unos junto a otros. Las densidades en el centro del Sol son mucho más altas que la del osmio, pero como los núcleos atómicos se mueven de un lado a otros sin impedimento alguno, el material sigue siendo un gas. Hay estrellas que se componen casi por entero de tales átomos destrozados. La compañera de la estrella Sirio es una “enana blanca” no mayor que el planeta Urano, y sin embargo tiene una masa parecida a la del Sol.

Los núcleos atómicos se componen de protones y neutrones. Ya hemos dicho antes que todos los protones tienen carga eléctrica positiva y se repelen entre sí, de modo que en un lugar dado no se pueden reunir más de un centenar de ellos. Los neutrones, por el contrario, no tienen carga eléctrica y en condiciones adecuadas pueden estar juntos y empaquetados un enorme número de ellos para formar una “estrella de neutrones”. Los púlsares, según se cree, son estrellas de neutrones en rápida rotación.

Estas estrellas se forman cuando las estrellas de 2 – 3 masas solares, agotado el combustible nuclear, no pueden continuar fusionando el hidrógeno en helio, el helio en oxígeno, el oxigeno en carbono, etc, y explotan en supernovas. Las capas exteriores se volatilizan y son expulsados al espacio; el resto de la estrella (su mayor parte), al quedar a merced de la fuerza gravitatoria, es literalmente aplastada bajo su propio peso hasta tal punto que los electrones se funden con los protones y se forman neutrones que se comprimen de manera increíble hasta que se degeneran y emiten una fuerza que contrarresta la gravedad, quedándose estabilizada como estrella de neutrones.

El Gran Telescopio Canarias (GTC), instalado en el Observatorio del Roque de los Muchachos (La Palma), ha obtenido imágenes de una profundidad “sin precedentes” de una estrella de neutrones del tipo magnetar, de las que se conocen seis. Si el Sol se convirtiera en una estrella de neutrones, toda su masa quedaría concentrada en una pelota cuyo diámetro sería de 1/100.000 del actual, y su volumen (1/100.000)3, o lo que es lo mismo 1/1.000.000.000.000.000 (una milmillonésima) del actual. Su densidad sería, por tanto, 1.000.000.000.000.000 (mil billones) de veces superior a la que tiene ahora.

La densidad global del Sol hoy día es de 1’4 gramos/cm3. Una estrella de neutrones a partir del Sol tendría una densidad que se reflejaría mediante 1.400.000.000.000.000 gramos por cm3. Es decir, un centímetro cúbico de una estrella de neutrones puede llegar a pesar 1.400.000.000 (mil cuatrocientos millones de toneladas). ¡Qué barbaridad!

Objetos como estos pueblan el universo, e incluso más sorprendentes todavía, como es el caso de los agujeros negros explicado en páginas anteriores de este mismo trabajo. Cuando hablamos de las cosas del universo estamos hablando de cosas muy grandes. Cualquiera se podría preguntar, por ejemplo: ¿hasta cuándo podrá mantener el Sol la vida en la Tierra? Está claro que podrá hacerlo mientras radie energía y nos envie luz y calor que la haga posible tal como la conocemos.

Como ya explicamos antes, la radiación del Sol proviene de la fusión del hidrógeno en helio. Para producir la radiación vertida por el sol se necesita una cantidad ingente de fusión: cada segundo tienen que fusionarse 654.600.000 toneladas de hidrógeno en 650.000.000 toneladas de helio (las 4.600.000 toneladas restantes se convierten en energía de radiación y las pierde el Sol para siempre. La ínfima porción de esta energía que incide sobre la Tierra basta para mantener toda la vida en nuestro planeta).

Los rayos del Sol que envían al planeta Tierra su luz y su calor, también forma parte del Universo, al mismo tiempo que hace posible la vida en un planeta maravilloso que es el habitat de millones de especies, unas más inteligentes que otras en relación al roll que, a cada una, le tocó desempañar.

Nadie diría que con este consumo tan alto de hidrógeno por segundo, el Sol pudiera durar mucho tiempo, pero es que ese cálculo no tiene en cuenta el enorme tamaño del Sol. Su masa totaliza 2.200.000.000.000.000. 000.000.000.000 (más de dos mil cuatrillones) de toneladas. Un 53% de esta masa es hidrógeno, lo cual significa que el Sol contiene en la actualidad una cantidad de 1.166.000.000.000.000.000.0000.0000.000 toneladas.

Para completar datos diré que el resto de la masa del Sol es casi todo helio. Menos del 0’1 por 100 de su masa está constituido por átomos más complicados que el helio. El helio es más compacto que el hidrógeno. En condiciones idénticas, un número dado de átomos de helio tiene una masa cuatro veces mayor el mismo número de átomos de hidrógeno. O dicho de otra manera: una masa dada de helio ocupa menos espacio que la misma masa de hidrógeno. En función del volumen – el espacio ocupado –, el Sol es hidrógeno en un 80 por ciento.

Si suponemos que el Sol fue en origen todo hidrógeno, que siempre ha convertido hidrógeno en helio al ritmo dicho de 4.654.600 toneladas por segundo y que lo seguirá haciendo hasta el final, se calcula que ha estado radiando desde hace unos 4.000 millones de años y que seguirá haciéndolo durante otros cinco mil millones de años más. Pero las cosas no son tan simples. El Sol es una estrella de segunda generación, constituida a partir de gas y polvo cósmico desperdigado por estrellas que se habían quemado y explotado miles de millones de años atrás. Así pues, la materia prima del Sol contenía ya mucho helio desde el principio, lo que nos lleva a pensar que el final puede estar algo más cercano.

Por otra parte, el Sol no continuará radiando exactamente al mismo ritmo que ahora. El hidrógeno y el helio no están perfectamente entremezclados. El helio está concentrado en el núcleo central y la reacción de fusión se produce en la superficie del núcleo. Cuando el Sol se convierta en gigante roja… Nosotros tendremos que haber podido buscar la manera de salir de la Tierra para unicarnos en otros mundos, dado que, dicha fase del Sol, no permitirá la vida en nuestro planeta.

Los planetas interiores serán engullidos por nuestro Sol y, la Tierra, quedará calcinada, sus océanos se evaporarán y toda la vida, desaparecerá

Las estrellas, como todo en nuestro universo, tienen un principio y un final. La que en la imagen de arriba podemos contemplar, ha llegado al final de su ciclo, y, agotado su combustible nuclear, quedará a merced de la fuerza de la Gravedad que la convertirá en un objeto distinto del que fue durante su larga vida. Dependiendo de su masa, las estrellas se convierten en enanas blancas -el caso del Sol-, estrella de neutrones o Agujeros negros.

Espero que al lector de este trabajo (obtenido principalmente de uno original de Asimov), encargado por la Asociación Cultural “Amigos de la Física 137, e/hc”, les esté entreteniendo y sobre todo interesando los temas que aquí hemos tratado, siempre con las miras puestas en difundir el conocimiento científico de temas de la naturaleza como la astronomía y la física. Tratamos de elegir temas de interés y aquellos que han llamado la atención del público en general, explicándolos y respondiendo a preguntas cuyas respuestas seguramente querrían conocer.

La atracción gravitatoria de la Luna sobre la Tierra hace subir el nivel de los océanos a ambos lados de nuestro planeta y crea así dos abultamientos. A medida que la Tierra gira de oeste a este, estos dos bultos –de los cuales uno mira hacia la Luna y el otro en dirección contraria– se desplazan de este a oeste alrededor de la Tierra. Al efectuar este desplazamiento, los dos bultos rozan contra el fondo de los mares poco profundos, como el de Bering o el de Irlanda. Tal rozamiento convierte energía de rotación en calor, y este consumo de la energía de rotación terrestre hace que el movimiento de rotación de la Tierra alrededor de su eje vaya disminuyendo poco a poco. Las mareas actúan como freno sobre la rotación de la Tierra, y como consecuencia de ello, los días terrestres se van alargando un segundo cada mil años.

Pero no es sólo el agua del océano lo que sube de nivel en respuesta a la gravedad lunar. La corteza sólida de la Tierra también acusa el efecto, aunque en medida menos notable. El resultado son dos pequeños abultamientos rocosos que van girando alrededor de la Tierra, el uno mirando hacia la Luna y el otro en la cara opuesta de nuestro planeta. Durante ese desplazamiento, el rozamiento de una capa rocosa contra otra va minando también la energía de rotación terrestre. (Los bultos, claro está, no se mueven físicamente alrededor del planeta, sino que a medida que el planeta gira, remiten en un lugar y se forman en otro, según qué porciones de la superficie pasen por debajo de la Luna y sean atraídas por su fuerza de gravedad).

La Luna no tiene mares ni mareas en el sentido corriente. Sin embargo, la corteza sólida de la luna acusa la fuerte atracción gravitacional de la Tierra, y no hay que olvidar que ésta es 80 veces más grande que la Luna. El abultamiento provocado en la superficie lunar es mucho mayor que el de la superficie terrestre. Por tanto, si la Luna rotase en un periodo de 24 horas, estaría sometida a un rozamiento muchísimo mayor que la Tierra. Además, como nuestro satélite tiene una masa mucho menor que la Tierra, su energía total de rotación sería, ya de entrada, para periodos de rotación iguales, mucho menor.

Así pues, la Luna, con una reserva inicial de energía muy pequeña, socavada rápidamente por los grandes bultos provocados por la Tierra, tuvo que sufrir una disminución relativamente rápida de su periodo de rotación. Hace seguramente muchos millones de años debió de decelerarse hasta el punto de que el día lunar se igualó con el mes lunar. De ahí en adelante, la Luna siempre mostraría la misma cara hacia el planeta Tierra.

Esto, a su vez, congela los abultamientos en un aposición fija. Unos de ellos miran hacia la Tierra desde el centro mismo de la cara lunar que nosotros vemos, mientras que el otro está apuntando en dirección contraria desde el centro mismo de la cara lunar que no podemos ver. Puesto que las dos caras no cambian de posición a medida que la Luna gira alrededor de la Tierra, los bultos no experimentan ningún nuevo cambio ni tampoco se produce rozamiento alguno que altere el periodo de rotación del satélite. La luna continuará mostrándonos la misma cara indefinidamente; lo cual, como veis, no es ninguna coincidencia, sino la consecuencia inevitable de la gravitación y del rozamiento.

Durante unos ochenta años, por ejemplo, se pensó que Mercurio (el planeta más cercano al Sol y el más afectado por la fuerza gravitatoria solar) ofrecía siempre la misma cara al Sol, por el mismo motivo que la Luna ofrece siempre la misma cara a la Tierra. Pero se ha comprobado que, en el caso de este planeta, los efectos del rozamiento producen un periodo estable de rotación de 58 días, que es justamente dos tercios de los 88 días que constituyen el período de revolución de Mercurio alrededor del Sol.

Hay tantas cosas que aprender que el corto tiempo que se nos permite estar aquí es totalmente insuficiente para conocer todo lo que nos gustaría. ¿Hay algo más penoso que la ignorancia? Continuemos pues aprendiendo cosas nuevas.

En alguna ocasión dejé una reseña de lo que se entiende por entropía y así sabemos que la energía sólo puede ser convertida en trabajo cuando dentro del sistema concreto que se esté utilizando, la concentración de energía no es uniforme. La energía tiende entonces a fluir desde el punto de mayor concentración al de menor concentración, hasta establecer la uniformadad. La obtención de trabajo a partir de energía consiste precisamente en aprovechar este flujo.

El agua de un río está más alta y tiene más energía gravitatoria en el manantial del que mana en lo alto de la montaña y menos energía en el llano en la desembocadura, donde fluye suave y tranquila. Por eso fluye el agua río abajo hasta el mar (si no fuese por la lluvia, todas las aguas continentales fluirían montaña abajo hasta el mar y el nivel del océano subiría ligeramente. La energía gravitatoria total permanecería igual, pero estaría distribuida con mayor uniformidad).

Una rueda hidráulica gira gracias al agua que corre ladera abajo: ese agua puede realizar un trabajo. El agua sobre una superficie horizontal no puede realizar trabajo, aunque esté sobre una meseta muy alta y posea una energía gravitatoria excepcional. El factor crucial es la diferencia en la concentración de energía y el flujo hacia la uniformidad.

Esta imagen que lleva el nombre de “Noche cristalina” fue tomada en abril de 2008 en la mina de Río Tinto, en (Huelva) España. Foto: J. Henry Fair/Cortesía: Galería Gerald Peters

Y lo mismo reza para cualquier clase de energía. En las máquinas de vapor hay un depósito de calor que convierte el agua en vapor, y otro depósito frío que vuelve a condensar el vapor en agua. El factor decisivo es esta diferencia de temperatura. Trabajando a un mismo y único nivel de temperatura no se puede extraer ningún trabajo, por muy alta que sea aquella.

El término “entropía” lo introdujo el físico alemán Rudolf J. E. Clausius en 1.849 para representar el grado de uniformidad con que está distribuida la energía, sea de la clase que sea. Cuanto más uniforme, mayor la entropía. Cuando la energía está distribuida de manera perfectamente uniforme, la entropía es máxima para el sistema en cuestión. El Tiempo, podríamos decir que es el portador de una compañera que, como él mismo, es inexorable. La entropía lo cambia todo y, en un Sistema cerrado (pongamos el Universo), la entropía siempre crece mientras que la energía es cada vez menor. Todo se deteriora con el paso del tiempo.

Marzo de 2009, Carolina del Sur, Estados Unidos. Lo que vemos son los desechos de cenizas de carbón en una planta generadora de electricidad. Foto: J. Henry Fair/Cortesía: Galería Gerald Peters. De la misma manera, en el Universo, se producen transiciones de fase que desembocan en el deterioro de los objetos que lo pueblan. Nunca será lo mismo una estrella de 1ª generación que una de 3ª y, el material del que están compuestas las últimas serán más complejos y cada vez, tendrán menor posibilidad de convertirse en Nebulosas que sean capaces de crear nuevas estrellas.

Clausius observó que cualquier diferencia de energía dentro de un sistema tiende siempre a igualarse por sí sola. Si colocamos un objeto caliente junto a otro frío, el calor fluye de manera que se transmite del caliente al frío hasta que se igualan las temperaturas de ambos cuerpos. Si tenemos dos depósitos de agua comunicados entre sí y el nivel de uno de ellos es más alto que el otro, la atracción gravitatoria hará que el primero baje y el segundo suba, hasta que ambos niveles se igualen y la energía gravitatoria quede distribuida uniformemente.

Considerado como Sistema Cerrado, la Entropía no deja de aumentar en nuestro Universo a medida que el Tiempo transcurre

Clausius afirmó, por tanto, que en la naturaleza era regla general que las diferencias en las concentraciones de energía tendían a igualarse. O dicho de otra manera: que la entropía aumenta con el tiempo. El estudio del flujo de energía desde puntos de alta concentración a otros de baja concentración se llevó a cabo de modo especialmente complejo en relación con la energía térmica. Por eso, el estudio del flujo de energía y de los intercambios de energía y trabajo recibió el nombre de “termodinámica”, que en griego significa “movimiento de calor”.

Con anterioridad se había llegado ya a la conclusión de que la energía no podía ser destruida ni creada. Esta regla es tan fundamental que se la denomina “primer principio de la termodinámica”. Sin embargo, cuando la entropía ataca, la energía puede quedar congelada e inservisble. La idea sugerida por Clausius de que la entropía aumenta con el tiempo es una regla general no menos básica, y que denomina “segundo principio de la termodinámica.”

Según este segundo principio, la entropía aumenta constantemente, lo cual significa que las diferencias en la concentración de energía también van despareciendo. Cuando todas las diferencias en la concentración de energía se han igualado por completo, no se puede extraer más trabajo, ni pueden producirse cambios.

¿Está degradándose el universo?

Bueno, todos sabemos que el Universo evoluciona y, como todo, con el paso del tiempo cambia. Lo que hoy es, mañana no será. Existe una pequeña ecuación: S = k log W que, aunque pequeña y sencilla, es la mayor aportación de Boltzmann y una de las ecuaciones más importantes de la Física. El significado de las tres letras que aparecen (aparte la notación para el logaritmo es el siguiente: S es la entropía de un Sistema; W el número de microestados posibles de sus partículas elementales y k una constante de proporcionalidad que hoy día recibe el nombre de constante de Boltzmann y cuyo valor es k = 1,3805 x 10-23 J(K (si el logaritmo se toma en base natural). En esta breve ecuación se encierra la conexión entre el micromundo y el macromundo, y por ella se reconoce a Boltzmann como el padre de la rama de la Física comocida como Mecánica Estadistica (en el siguiente trabajo se habla de ésta maravillosa fórmula).

Pero esa, es otra historia.

Sin ambargo, nunca debemos olvidar que el Universo es inmenso, en realidad, “infinito” para nosotros que no podemos recorrrer sus distancias en las que, bellas formaciones, como la que arriba podemos contemplar, sólo pueden ser captadas por ingenios modernos y sofisticados telescopio que atrapan la luz que viaja desde miles de millones de kilómetros de distancia para poder así mostrarnos, objetos de una belleza que ningún pintor podría reproducir por su dinámica constante ni tampoco, nuestra imaginación podría mentalizar por el desconocimiento que tenemos de que maravillas así pudieran existir en un vasto Universo que, en gran parte, es aún un gran desconocido.

emilio silvera

Fuente: Parte del texto está sacado de 100 preguntas ciencia de Isaac Asimov

May

6

La NASA lanza su sonda ‘InSight’

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (1)

Comments (1)

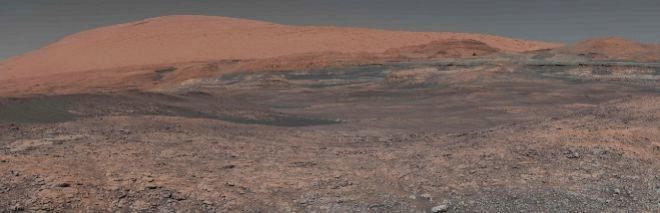

Para tomar el pulso a Marte

ESPACIO

Estudiará por primera vez su actividad sísmica

- TERESA GUERRERO | AGENCIAS

- Madrid

La NASA acaba de lanzar este sábado su nueva misión robótica a Marte, la primera que tomará el pulso al planeta rojo estudiando su actividad sísmica. La sonda InSight ha despegado desde la base aérea de Vandenberg, en California, a bordo de un cohete Atlas V. Se trata del primer lanzamiento de una misión interplanetaria desde la costa Oeste de EEUU, pues hasta ahora todos se habían hecho desde Cabo Cañaveral, en Florida.

Como estaba previsto, el lanzamiento ha tenido lugar puntualmente a las 13.05 del sábado, hora peninsular española. Pocas horas después del despegue, Tom Hoffman, uno de los responsables de InSight en el Jet Propulsion Laboratory (JPL) de la NASA, aseguró que los datos recibidos apuntaban a que “la sonda se encuentra en buen estado de salud”.

La nave, cuya misión durará casi dos años y que recorrerá desde hoy los 485 millones de kilómetros que separan la Tierra y Marte, está financiada y coordinada en su mayor parte por EEUU (813 millones de dólares), pero también han participado diferentes países europeos: especialmente Alemania y Francia (entre los dos, 180 millones de dólares) y también otros como España.

Tras una travesía de casi siete meses, InSight (de Interior Exploration using Seismic Investigations, Geodesy and Heat Transport) llegará a Marte el 26 de noviembre. La nave iba a comenzar su misión en 2016, pero los problemas técnicos con uno de los instrumentos obligaron a aplazarla dos años.

Su trabajo consistirá en estudiar las capas internas del planeta rojo para intentar esclarecer cómo han evolucionado los mundos del Sistema Solar. “No sólo debería decirnos por qué Marte se formó de la manera en que lo hizo, sino también cómo los planetas en general llegaron a tener su forma actual”, ha declarado en un comunicado Bruce Banerdt, investigador principal de la misión en el Jet Propulsion Laboratory (JPL) de la NASA.

Hasta ahora, las misiones a Marte han capturado imágenes de la superficie, estudiado rocas, excavado en la tierra y buscado pistas sobre el agua que alguna vez fluyó en Marte, pero nunca se ha indagado en su interior.

‘Martemotos’

Entre los instrumentos que la sonda lleva a bordo destaca el sismómetro que permitirá analizar los martemotos que tienen lugar bajo la superficie marciana. La nave cuenta también con un componente desarrollado en España por el Centro de Astrobiología (CAB-CSIC/INTA) que permitirá monitorizar la temperatura y la velocidad del viento.

“Tras el aterrizaje del 26 de noviembre, el vehículo tomará imágenes de la superficie que ayudarán al equipo a elegir el lugar en el que se colocará el sismómetro (SEIS) y la sonda que penetrará el suelo marciano (HP3)”, detalla Fernando Abilleira, uno de los responsables del diseño de la misión en el JPL de la NASA. Según explica el ingeniero español, “la fase de despliegue de los instrumentos puede llevar alrededor de dos meses. En cuanto se desplieguen, comenzaremos a recoger datos científicos”.

“El 99,9% de este planeta nunca se ha observado antes. Vamos a ir a estudiarlo con nuestro sismómetro y nuestra sonda de flujo de calor por primera vez”, señaló a los periodistas Bruce Banerdt, principal investigador de InSight, en un encuentro con los medios previo al lanzamiento.

Según compara la NASA, esta misión permitirá medir las constantes vitales de Marte: su pulso (a través de la sismología), su temperatura (estudiando el flujo calor que emana de su interior) y sus reflejos (a través de la radiociencia). “Será el primer chequeo completo desde que el planeta se formó hace 4.500 millones de años”.

Para el director de ciencias planetarias de la NASA, Jim Green, esta misión planetaria “fantástica” ayudará a la humanidad a comprender la composición de la corteza, el manto y el núcleo de Marte y dará una idea de cómo se originó el Sistema Solar.

InSight también ha lanzado por primera vez dos microsatélites (cubesat) interplanetarios, de unos 13 kilogramos cada uno, denominados MarCO: “Se separarán del cohete después de que lo haga InSight y volarán en su propia trayectoria interplanetaria. Su objetivo será mandar datos telemétricos de la sonda durante la entrada, el descenso y el aterrizaje en Marte”, explica Abilleira.

May

6

¿Qué pasaría si la Tierra girara al revés?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Cambios inesperados ~

Clasificado en Cambios inesperados ~

Comments (0)

Comments (0)

La Tierra gira sobre su eje en la misma dirección desde hace miles de millones de años – Fotolia

El mundo sería muy diferente: los desiertos se desplazarían de lugar y cambiarían las corrientes oceánicas

Todos recordamos aquella escena en la que Supermán consiguió la reversión de la rotación de la Tierra

Desde hace miles de millones de años, la Tierra gira sobre su eje en la misma dirección: de oeste a este, al contrario de las agujas del reloj si se tiene en cuenta el polo norte como punto de vista. Esto es común a todos los planetas de nuestro Sistema Solar, con la excepción de Venus y Urano. A una velocidad de 1.670 kilómetros por hora, en nuestro mundo una rotación completa dura casi 24 horas. Este fenómeno tiene distintas consecuencias, como el efecto Coriolis, que es el responsable, por ejemplo, del sentido en el que giran los anticiclones en cada hemisferio. Pero, ¿qué ocurriría si al mundo le diera por dar frenazo y marcha atrás y esa dirección se invirtiera?

Un equipo de investigadores de la Universidad de Reading en Reino Unido y el Instituto Max Planck de Meteorología en Alemania, entre otros, ha presentado en la asamblea general de la Unión Europea de Geociencias, que se ha celebrado recientemente en Austria, una simulación que muestra las consecuencias globales a nivel climático. Y resulta que el mundo sería muy diferente al que hoy conocemos.

Para empezar, uno de los mayores cambios es que el ancho cinturón desértico que se extiende desde África Occidental hasta Oriente Medio sería reemplazado por un vergel, un paisaje verde de clima húmedo y templado. Al mismo tiempo, las dunas cubrirían América del Norte y del Sur, hasta el punto de que el sur de Brasil y Argentina se convertirían en los mayores desiertos sobre la Tierra. El sur de EE.UU. sufriría un brutal cambio climático desde la humedad a una aridez absoluta. Mientras, en Europa occidental, nos quedaríamos congelados durante los gélidos inviernos.

Además, según los investigadores, las cianobacterias, un grupo de bacterias que producen oxígeno a través de la fotosíntesis, aparecerían donde nunca antes lo habían hecho. Dominarían el norte del Océano Índico. Y la Circulación Atlántica Meridional de Retorno (AMOC), una importante corriente oceánica reguladora del clima en el Atlántico, se esfumaría para resurgir de nuevo en el Océano Pacífico norte.

Un planeta más verde

Estas condiciones climáticas completamente nuevas en todo el mundo surgirían durante miles de años. Curiosamente, los investigadores descubrieron que una Tierra que gira hacia atrás tiene sus ventajas. En general, sería más verde. La cobertura mundial del desierto se reduciría a la nada desdeñable cifra de 11 millones de kilómetros cuadrados (de 42 millones a unos 31 millones de kilómetros cuadrados). Las praderas aparecerían en más de la mitad de las antiguas áreas desérticas, y las plantas leñosas brotarían para cubrir la otra mitad. La vegetación de este mundo «marcha atrás» almacenaría más carbono que nuestra Tierra actual. Como punto negativo, los desiertos surgirían donde nunca lo han hecho: norte de China, sureste de EE.UU., sur de Brasil y Argentina.

Además de los tirones gravitatorios del Sol y la Luna, existe un abanico de factores que también pueden influir en la velocidad de la rotación, tanto incrementándola como ralentizándola. Por ejemplo, el aumento del nivel del mar provocado por el deshielo de glaciares o la atmósfera. Además, hay investigadores que creen que la presencia de vida tiene la capacidad de influir en la velocidad de rotación de un planeta a base de liberar gases como el oxígeno. Pero, ¿hay algo que pueda provocar que gire al revés? El impacto brutal de un gigantesco asteroide. Pero seguro que no vivimos para contarlo.

Totales: 85.809.717

Totales: 85.809.717 Conectados: 41

Conectados: 41