May

17

¿La Física? Mucho más de lo que nos pueda parecer

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Para ser llamado científico, un método de investigación debe basarse en lo empírico y en la medición, sujeto a los principios específicos de las pruebas y el razonamiento, hay que demostrar con certeza la teoría.

Empecé a estudiar física hace ahora unos 50 años. Y poco a poco he ido viendo que una parte de la física iba dejando de ser ciencia, olvidando el método de Galileo, y avanzando hacia un sistema dogmático, místico e iniciático. Recordemos que el método dogmático es aquel en el cual se exige aceptar una afirmación que no esta apoyada en ningún hecho comprobable: La afirmación de que las tablas de la ley las había entregado una deidad, por ejemplo. Hoy es imposible, en el campo de la física, no aceptar la afirmación incomprobable, de que el mundo empezó en un Big-Bang, con una cierta energía que no se sabe que era, y moviéndose de una forma que exige un razonamiento circular que pasa de energía a frecuencias de algo que se desconoce, a energías de caracter desconocido a frecuencias de ….., y así indefinidamente.

¿Qué produjo el Big Bang? ¿Qué había antes allí?

Pero como con las tablas de la ley, nadie puede subir a la montaña a verificar las afirmaciones expresadas, que sin embargo hay que creer bajo pena de excomunión. Nadie puede volar en el tiempo hacia atrás hasta hace unos miles de millones de años, para verificar la hipótesis.

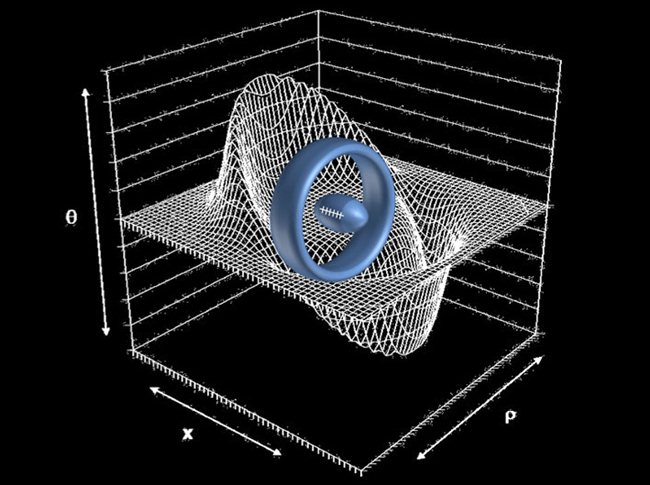

El sistema avanza hacia el misticismo: ¿Que otra cosa es la idea de las supercuerdas, una idea que para Steven Weinberg, padre de la Gran Unificacion, era ilusionante, pero se ha revelado incapaz de tener algo que ver con la realidad? O la SUSY, la supersimetría que postula que, por ejemplo, los electrones, con spin fraccionario, tengan simétricos con spin entero, selectrones que nadie ha medido ni de lejos.

Y se está convirtiendo en iniciático. Para ”descubrir” el Higgs, el CERN cerró las puertas y aisló a sus dos equipos durante años, en un sistema indigno de la idea de la ciencia, que había sido pública y abierta para todos hasta ese momento. El CERN ha publicado los resultados de sus dos equipos pero, o estoy muy equivocado, no ha distribuido los datos originales, las fotografías de las trazas de los productos de desintegració. (Si, dos veces, pues si hay Higgs, ¿a qué tanto misterio?

Sólo vemos los productos de los productos de la desaparición de la partícula buscada. En las sociedades místicas, tras un periodo de iniciación para los elegidos, las verdades se revelaban siempre en ceremonias secretas bajo la terrible promesa de no revelar los ritos nunca fuera de la institución.

Otro de los padres de la Gran Unificación, el físico Abdus Salam, daba como razón poderosa para la búsqueda de la misma su fé en un único dios. Según él, la naturaleza debería tener una única fuerza, correspondiente a esa única deidad.

El padre de la mecánica cuántica, Niels Bohr, apremiado por Einstein, entre otros, llegó a decir que de esa forma de analizar el mundo atómico y sub-atómico, de esa mecánica cuántica había que tomar las reglas de cálculo, pero que había que renunciar a entender lo que pasaba en él. Esto dicho por un supuesto científico que había renunciado a entender la naturaleza, pero que controló, hasta su muerte, la concesión de los premios Nobel de física.

Es tremendamente importante considerar esto que he escrito aquí, en todos los caminos de la ciencia. Hoy la presión es publicar, aunque lo que se publique sea mera copia no entendida de otros trabajos publicados anterior o simultáneamente. Esos trabajos se acumulan en las revistas científicas, de donde no salen a las empresas ni hacia la técnica. Los resultados de un enorme tanto por ciento de la investigación no son aprovechados por aquellos que la han financiado, que dejan que esos resultados caigan en el olvido.

Mientras que miles de científicos trabajan de manera seria e incansable sobre asuntos y proyectos reales que, en su momento, darán una respuesta y en sus trabajos de laboratorio, sus resultados se aprovechan para la sociedad, otros cientos de miles de ellos, destinan inmensas cantidades de dinero y esfuerzo que se desperdician en desarrollos místicos sin utilidad alguna. Antes de acometer un proyecto habría que ver las posibilidades reales de los mismos.

Claro que, pensándolo bien, tampoco Colón sabía hacia donde iba cuando emprendió su viaje.

Edward Witten revisita la teoría de supercuerdas perturbativa en Strings 2012.

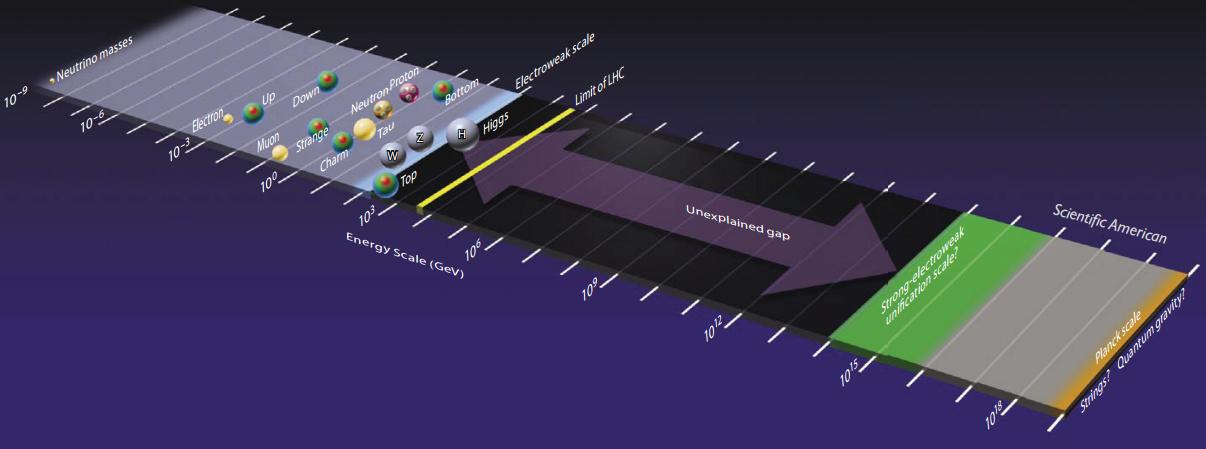

“Me gusta esta figura porque muestra muy claramente lo que conocemos en física de partículas, lo que esperamos explorar en las próximas décadas, y lo que creemos conocer, aunque nunca llegaremos a explorar de forma directa. La partícula con más masa conocida tiene menos de 200 GeV y todavía se sigue explorando entre 10 a 200 GeV en busca de nuevas partículas. Basta recordar que se acaba de descubrir una partícula con 125 GeV de masa, el bosón de Higgs, y que muchos físicos creen que la partícula responsable de la materia oscura tiene una masa en este rango. El LHC y sus sucesores en las próximas décadas explorarán las energías entre 100 y 5000 GeV (difícilmente podrán llegar más lejos). Sin embargo, hay un desierto hasta energías de 10 000 000 000 GeV (la escala de Planck) que no hemos explorado, que no podremos explorar en el siglo XXI y del que no conocemos absolutamente nada,”

“Bernard Bigot, director general de ITER, el reactor de fusión experimental que se está construyendo en Cadarache, Francia, ha anunciado que la primera inyección de plasma (que marca el final de su construcción) se retrasará hasta 2025. Recuerda que el proyecto se inició en 2006 y se planificó la primera inyección de plasma para 2016, pero en 2010 se retrasó hasta 2019.”

A veces, queremos imitar la Naturaleza sin llegar a ser conscientes de que, nunca la podremos igualar. ¿Qué materiales aquí en la Tierra podrían soportar temperaturas de millones de grados sin deteriorarse).”

Aún hay ciencia. Pero hay disciplinas que se están, tristemente, alejando de ella aunque se consideran públicamente, y así lo afirman, como los que marcan el camino del futuro de la misma. Terminarán olvidadas, como ha ocurrido con toda la mística iniciática. Pero de momento aún nos dicen, como los sufíes, que son los únicos que están cerca de la verdad.

La Ciencia es una cosa de la que todos sabemos como anda sus caminos y cuando se puede considerar digna de su nombre, otra cosa muy distinta será el especular y aventurar “teorías” que no llegan a ninguna parte, toda vez que tienen la imposibilidad de ser demostradas y, eso, amigos míos, es como hablar de la existencia de Dios.

May

17

Noticias del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

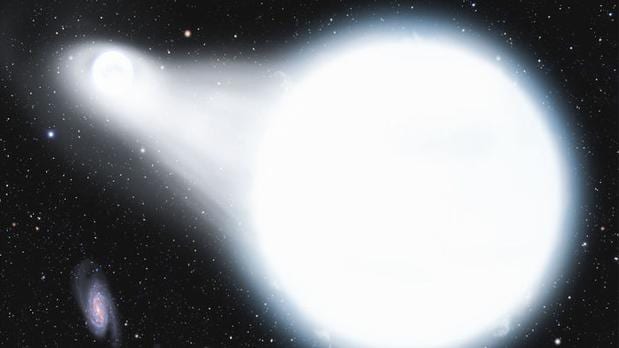

Representación de una enana blanca rápida disparada en una explosión de supernova – DAVID A. AGUILAR/CFA

Descubren varios invasores llegados de otra galaxia

Los últimos datos proporcionados por el gigantesco catálogo estelar de Gaia han permitido identificar estrellas procedentes de la Gran Nube de Magallanes y otras que viajan a velocidades de hasta 2.400 kilómetros por segundo

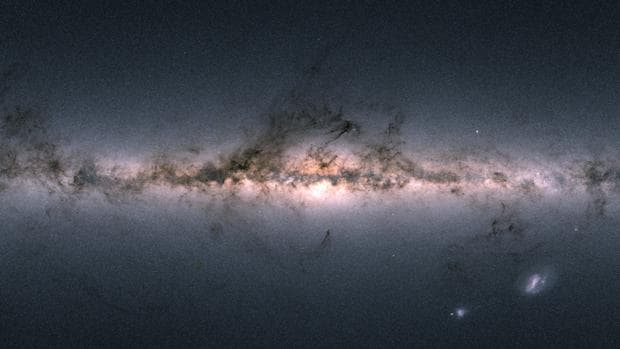

El pasado 25 de abril la Agencia Espacial Europea (ESA) publicó el descomunal catálogo de estrellas de la Vía Láctea cosechado por la misión Gaia. Este catálogo, elaborado después de 22 meses de observación, recoge con gran precisión la posición de 1.700 millones de estrellas, la trayectoria de más de 1.300 millones y muchos datos sobre colores y brillos, lo que habla sobre su naturaleza.

La Vía Láctea, vista por Gaia – ESA

También asteroides

Otra de las misiones de Gaia es la de observar objetos en el interior de nuestro Sistema Solar. Por eso, entre los datos recién liberados también figuran las posiciones de más de 14.000 asteroides conocidos, lo que permitirá determinar con toda precisión sus órbitas y su potencial grado de peligrosidad para la Tierra.

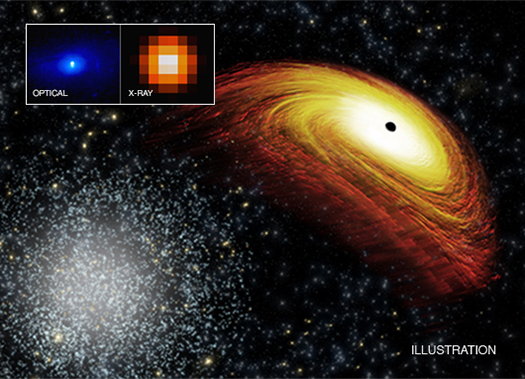

En el Universo lejano, Gaia ha logrado también identificar las posiciones de cerca de medio millón de cuásares, galaxias extremadamente brillantes y activas, alimentadas por los agujeros negros supermasivos que residen en sus núcleos.

La utilidad de esta masiva cantidad de información es que permite acercarse con una «lupa» a la Vía Láctea para mirar cómo se mueven las estrellas, por qué lo hacen o cómo ha evolucionado todo el vecindario galáctico. De hecho, apenas un par de semanas después de la publicación de este catálogo, decenas de científicos se han apresurado a observar estrellas especialmente interesantes. Tal como ha informado Sciencemag.org, gracias a ello los astrónomos están publicando varios artículos sobre estrellas ultra-rápidas catapultadas en explosiones de supernovas e incluso sobre algunas invasoras procedentes de fuera de la Vía Láctea.

Invasoras y estrellas catapultadas

El equipo del astrónomo Tommaso Marchetti, de la Universidad de Leiden (Holanda) ha estudiado 28 estrellas rápidas, que, según ha concluido, fueron expulsadas del agujero negro del centro de la Vía Láctea a velocidades de cerca de 1.000 kilómetros por segundo. Aparte de estas, hay dos que son estrellas «invasoras» situadas en las afueras de nuestra galaxia y que proceden de la Gran Nube de Magallanes, una pequeña galaxia vecina.

El astrónomo Denis Erkal, de la Universidad de Surrey (Reino Unido) publicó un artículo en ArXiv el 26 de abril en el que hablaba de HVS3, una estrella descubierta en 2005 cerca de la Gran Nube de Magallanes, en el halo de la Vía Láctea (una vasta región donde hay estrellas dispersas, fuera del plano galáctico). Según los datos de Gaia, esta estrella viene tan rápido de la galaxia vecina que podría ser que hubiera sido expulsada de un agujero negro central no detectado hasta ahora.

Esto es bastante importante, porque si los astrónomos consideran que las grandes galaxias tienen grandes agujeros negros en su centro, no está claro si todas las pequeñas también los tienen.

Aparte de todo esto, el pasado 30 de abril el equipo de Ken Shen, astrofísico de la Universidad de California en Berkeley (EE.UU.) anunció el descubrimiento de tres estrellas enanas blancas que surcan el espacio a increíbles velocidades de miles de kilómetros por segundo, y que parecen provenir, según sostienen, de explosiones de supernovas. Una de ellas viaja a una velocidad de 2.400 kilómetros por segundo (8.640.000 kilómetros por hora), lo que le convierte en una de las estrellas más rápidas de la Vía Láctea.

¿Cómo es posible que viaje tan rápido? El origen está, según sugiere Shen, en supernovas de tipo Ia. Estas ocurren cuando se produce una explosión termonuclear en una estrella enana blanca que le ha robado el gas a otra estrella compañera. Shen propone que esta compañera puede ser otra enana blanca y que, cuando este estallido ocurre, una de ellas sale disparada al espacio a velocidades que no se pueden ni imaginar.

Los investigadores han rebobinado el tiempo unos 100.000 años para observar la trayectoria de esas tres estrellas rápidas. Una de ellas les ha llevado hasta los restos de una supernova, ocurrida tiempo atrás.

«Es un resultado genial», ha dicho en Sciencemag.org Kris Stanek, astrofísica de la Universidad del Estado de Ohio en Columbus (EE.UU.). Según esta, la enana blanca «es probablemente parte de una explosión de supernova».

May

16

¡Entrañable relación!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Mi hija María ~

Clasificado en Mi hija María ~

Comments (3)

Comments (3)

Hace algún tiempo, recibí un correo de mi hija María Padagoga musical, Clavecinista y Pianista) que, no siendo nada privado, os lo quiero dejar ver para que podáis comprender de primera mano, nuestra relación y las informaciones que intercambiamos. Por mi parte, le doy la tabarra con la Física y la Astronomía que ella, también comprende muy bien.

Leonardo Berstein & The New York Philharmonic

“Tú que alguna vez has mencionado el contrapunto incluso en tus libros y tu blog, y que luego al escuchar Bach hay cosas que no llegas a comprender y que reconoces que te son aburridas… He encontrado un video de un programa antiguo, en el que Leonard Bernstein (mi director de orquesta favorito en el mundo junto con Sergiu Celibidache), habla de Bach y explica en qué consiste su obra. Lo hace de una forma tan magistral y tan entendible por todos, incluso hasta para el menos versado en la materia, que confieso que me emocioné y no pude sino verlo hasta el final con las lagrimillas a punto de salir!

May

16

Rumores del saber del mundo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del Saber ~

Clasificado en Rumores del Saber ~

Comments (1)

Comments (1)

En la serie rumores del saber del mundo que hemos ido dejando aquí, de manera esporádica, algunos retazos de ese saber que por el mundo, a lo largo y a lo ancho del discurrir del tiempo, han dejado los pueblos y civilizaciones que nos precedieron. Ellos sentaron las bases de lo que hoy somos. Hemos hablado aquí de los sumerios, egipcios, hindúes, chinos y de otras civilizaciones también misteriosas. Hemos dedicado algún tiempo al surgir de la escritura y de los números, sin dejar de lado a los grandes filósofos naturales que estudiaban la Naturaleza para tratar de desvelar sus secretos.

Tiempos de Oráculos y Deidades

Sin embargo, en Alejandría, las matemáticas o, al menos, los números tuvieron otro aspecto muy importante, y también muy diferente. Se trata de los denominados “misterios órficos” y su énfasis místico.

Según Marsilio Ficino, autor del siglo XV d.C., hay seis grandes teólogos de la antigüedad que forman una linea sucesoria. Zoroastro fue “el principal referente de los Magos”; el segundo era Hermes Trismegisto, el líder de los sacerdotes egipcios; Orfeo fue el sucesor de Trismegisto y a él le siguió Aglaofemo, que fue el encargado de iniciar a Pitágoras en los secretos, quien a su vez los confió a Platón. En Alejandría, Platón fue instruido por Clemente y Filón, para crear lo que se conocería como neoplatonismo.

Tres ideas conforman los cimientos de los misterios órficos. Una es el poder místico de los números. La existencia de los números, su cualidad abstracta y su comportamiento, tan vinculado como el del Universo, ejercieron una permanente fascinación sobre los antiguos, que veían en ellos la explicación de lo que percibían como armonía celestial.

“El número once y su par, 11:11, engloban un código sincromístico, relacionado para muchas personas con la comunicación de una inteligencia cósmica que busca abrir un portal en la conciencia y en la genética humana. Aparte de ésto, esta cifra tiene una resonancia y una simbología profunda que hace reparar en este código, más allá de cultos y creencias, como un atisbo de la naturaleza matemática que subyace, como código de programación, el mundo en el que vivimos.“

La naturaleza abstracta de los números contribuyó a reforzar la idea de un “Alma” abstracta, en la que estaba implícita la idea (trascendental en este contexto) de la salvación: la creencia de que habrá un futuro estado de éxtasis, al que es posible llegar a través de la trasmigración o reencarnación.

Por último, estaba el principio de emanación, esto es, que existe un bien eterno, una unidad o “mónada”, de la que brotaba toda la creación. Como el número, esta era considerada una entidad básicamente abstracta. El alma ocupada una posición intermedia entre la mónada y el mundo material, entre la mente, abstracta en su totalidad, y los sentidos.

Según los órficos, la mónada enviaba (“emanaba”) proyecciones de sí misma al mundo material y la tarea del alma era aprender usando los sentidos. De esta forma, a través de sucesivas reencarnaciones, el alma evolucionaba hasta el punto en el que ya no eran necesarias más reencarnaciones y se alcanzaba el momento de profunda iluminación que daba lugar a una forma conocida como gnosis, allí la mente esta fundida con lo que percibe. Es posible reconocer que esta idea, original de Zoroastro, subyace en muchas de las regiones principales del mundo, con distintas variantes o matices que, en esencia, viene a ser los mismos.

Pitágoras, en particular, creía que el estudio de los números y la armonía conducían a la gnosis. Para los pitagóricos, el número uno no era un número en realidad, sino la “esencia” del número, de la cual surge todo el sistema numérico. Su división en dos creaba un triángulo, una trinidad, la forma armónica más básica, idea de la que encontramos ecos en santísimas religiones.

Platón, en su versión más mítica, estaba convencido de que existía un “alma mundial”, también fundada en la armonía y el número, y de la cual brotaba toda la creación. Pero añadió un importante refinamiento al considerar que la dialéctica, el examen crítico de las opiniones era el método para acceder a la gnosis.

La tradición sostiene que el cristianismo llegó a Alejandría a mediados del siglo I d.C., cuando Marcos el evangelista llegó a la ciudad para predicar la nueva religión.

Las similitudes espirituales entre el platonismo y el cristianismo fueron advertidas de forma muy clara por Clemente de Alejandría (150-215 d.C.), pero fue Filón el indio quien primero desarrolló esta nueva fusión. En Alejandría habían existido escuelas pitagóricas y platónicas desde hacía un largo tiempo, y los judíos cultos conocían los paralelos entre las ideas judías y las tradiciones Geténicas, hasta el punto de que para muchos de ellos el orfismo no era otra cosa que “una emanación de la Torá de la que no había quedado constancia”.

Filón era el típico alejandrino que “nunca confiaba en el sentido literal de las cosas y siempre estaba a la búsqueda de interpretaciones músticas y alegóricas”. Pensaba que podía “conectar” con Dios a través de ideas divinas, que las ideas eran “los pensamientos de Dios” porque ponían orden a la “materia informe”. Al igual que Platón, tenía una noción dualista de la Humanidad:

También se ha dicho que la música es el refugio de las almas puras, pues en ella encuentran aliento las palabras de amor y cobijo los suspiros profundos.

“De las almas puras que habitan el espacio etéreo, aquellas más cercanas a la tierra resultan atraídas por los seres sensibles y descienden a sus cuerpos”.

Las Almas son el lado divino del hombre.

Es interesante reparar los hechos pasados y la evolución del pensamiento humano que, en distintos lugares del mundo y bajo distintas formas, todos iban en realidad a desembocar en el mismo mar del pensamiento.

La naturaleza humana y el orden universal, el primero unido a un alto concepto cuasi divino, el Alma, el segundo regido por la energía cósmica de las fuerzas naturales creadoras de la materia y, todo esto, desarrollado de una u otra manera por los grandes pensadores de todos los tiempos que hicieron posible la evolución del saber para tomar posesión de profundos conocimiento que, en un futuro, nos podrán permitir alcanzar metas, que aún hoy, serían negadas por muchos.

No deberíamos perder de vista la Historia de la Humanidad

Para mí, el mirar los hechos pasados y estudiar los logros alcanzados en todos los campos del saber, es una auténtica aventura que profundiza y lleva al conocimiento del ser humano que, según la historia, es capaz de lo mejor y de lo pero, sin embargo, nadie podrá negarle grandeza ni imaginación.

Los pensadores del Renacimiento creían que todo el Universo era un modelo de la idea divina y que el hombre era “un creador que venía después del creador divino”. Esta concepción era el concepto de belleza, una forma de armonía que reflejaba las intenciones de la divinidad.

Lo que era placentero para los ojos, el oído y la mente era bueno, moralmente valioso en sí mismo. Más aún: revelaba parte del plan divino para la Humanidad, pues evidenciaba la relación de las partes con el todo.

Este ideal renacentista de belleza respaldaba la noción de que esta tenía dos funciones, noción aplicable a todas las disciplinas. En un nivel, la arquitectura, las artes visuales, la música y los aspectos formales de las artes literarias y dramáticas informaban a la mente; en segundo nivel, la complacían mediante el decoro, el estilo y la simetría. De esta forma se estableció una asociación entre belleza e ilustración. También esto era lo que entonces significaba la sabiduría.

Algunos quisieron abarcarlo todo

El fin perseguido era el deseo de universalidad personal, la consecución de conocimientos universales, la conjunción de disciplinas diferentes como ramas del todo, del saber profundo que abarcaba desde el núcleo las distintas esferas del conocimiento universales, la conjunción de disciplinas diferentes como ramas del todo, del saber profundo que abarcaba desde el núcleo las distintas esferas del conocimiento como partes de ese todo.

El reconocimiento de la belleza se funda en los dones divinos del intelecto humano. Durante el Renacimiento se escribieron unos cuarenta y tres tratados sobre la belleza. La idea de hombre universal es una idea común a casi todos ellos.

Ahora, aunque de diferente manera y con medios muy alejados de los que podían utilizar los antiguos, los estudiosos de hoy persiguen la misma cosa, es decir una Teoría del Todo que unifique el saber “del mundo” y que éste sea explicado por una sola ecuación mágica.

emilio silvera

Fuente: Ideas de Peter Watson

May

16

Distancias inalcanables de forma física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Divagando ~

Clasificado en Divagando ~

Comments (0)

Comments (0)

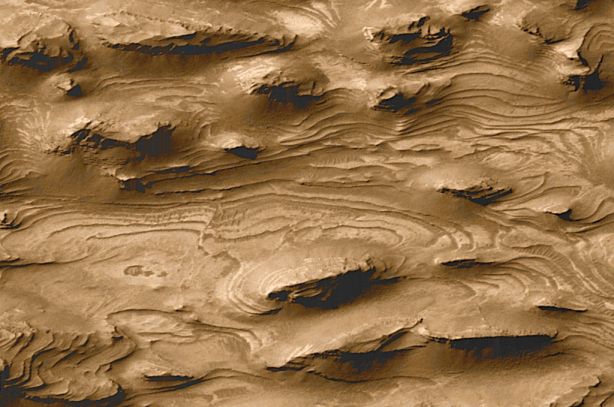

En el espacio exterior, el Cosmos, lo que conocemos por universo, las distancias son tan enormes que se tienen que medir con unidades espaciales como el año luz (distancia que recorre la luz en un año a razón de 299.792.458 metros por segundo). Otra unidad ya mayor es el pársec (pc), unidad básica de distancia estelar correspondiente a una paralaje trigonométrica de un segundo de arco (1”). En otras palabras, es la distancia a la que una Unidad Astronómica (UA = 150.000.000 Km) subtiende un ángulo de un segundo de arco. Un pársec es igual a 3’2616 años luz, o 206.265 Unidades Astronómicas, o 30’857×1012 Km. Para las distancias a escalas galácticas o intergalácticas se emplea una unidad de medida superior al pársec, el kilopársec (Kpc) y el megapársec (Mpc).

Para tener una idea aproximada de estas distancias, pongamos el ejemplo de nuestra galaxia hermana, Andrómeda, situada (según el cuadro anterior a 725 kilopársec de nosotros) en el Grupo local a 2’3 millones de años luz de la Vía Láctea.

¿Nos mareamos un poco?

| 1 segundo luz | 299.792’458 Km |

| 1 minuto luz | 18.000.000 Km |

| 1 hora luz | 1.080.000.000 Km |

| 1 día luz. | 25.920.000.000 Km |

| 1 año luz | 9.460.800.000.000 Km |

| 2’3 millones de años luz | 21.759.840.000.000.000.000 Km |

¡Una barbaridad!

Andrómeda, la hermana mayor de la Vía Láctea, situada a 2,3 años-luz de nosotros, viaja en nuestra dirección a una buena velocidad. Sin embargo, se calcula que nos no llegará hasta nosotros hasta dentro de unos pocos miles de millones de años, antes de que el Sol esté agotando su combustible nuclear de fusión para convertirse en una Nebulosa planetaria con una enana blanca en su centro.

Ahí tenemos la imposibilidad física de viajar a otros mundos, y no digamos a otras galaxias. Las velocidades que pueden alcanzar en la actualidad nuestros ingenios espaciales no llegan ni a 50.000 Km/h. ¿Cuánto tardarían en recorrer los 21.759.840.000.000.000.000 Km que nos separa de Andrómeda?

Incluso el desplazarnos hasta la estrella más cercana, Alfa Centauri, resulta una tarea impensable si tenemos en cuenta que la distancia que nos separa es de 4’3 años luz, y un año luz = 9.460.800.000.000 Km.

Muchos son los que han querido imaginar como viajar más rápido que la Luz… ¡Sin superar su velocidad! Todos sabemos, como nos enseñó la Relatividad Especial de Einstein que, la luz, nos marca el límite de la velocidad que se puede alcanzar en el Espacio. Nada podrá nunca viajar más rápido que la luz en el vacío, es decir, más ráipido que 299.792.458 metros cada segundo. Y, se idean otras formas para poder burlar ese límite y llegar antes que la luz a un determinado lugar. Hasta que no se busque la manera de esquivar la barrera de la velocidad de la luz, los viajes a otros mundos están algo complicados para nosotros.

La única ventaja a nuestro favor: ¡EL TIEMPO! Tenemos mucho, mucho tiempo por delante para conseguir descifrar los secretos del hiperespacio que nos mostrará otros caminos para desplazarnos por las estrella que, en definitiva, será el destino de la humanidad.

Nuestro Sol, antes de que pasen 4.000 millones de años, comenzará una transición de fase que, de estrella en la secuencia principal de HP, pasará a su fase terminal convirtiéndose en una Gigante roja que, eyectará sus capas exteriores al espacio interestelar formando una Nebulosa planetaria y, la estrella, exenta de la energía de fusión, quedará a merced de la fuerza de Gravedad que la comprimirá hasta límites de una densidad que sólo podrá ser frenada por la degeneración de los electrones. En ese punto, volverá el equilibrio entre dos fuerzas y el proceso se parará dejando una enana blanca con un radio parecido al de la Tierra y una densidad de 109 Kg m3.

Antes de que todo eso llegue, tenemos que tener en cuenta que habrá que salvar otro gran escollo que se nos viene encima (nunca mejor dicho), ya que, la Galaxia Andrómeda viene hacia La Vía Láctea a razón de 1.000.000 de Km/h y, aproximadamente en unos 3.000 millones de años la tendremos, irremediablemente, colisionando con nuestra Galaxia, con lo cual, las fuerzas de marea que esas enormes masas puden producir, son de impensable magnitud y, el desenlace tardará varios millones de años en finalizar hasta que de las dos grandes Galaxias del Grupo Local, sólo quede una enorme galaxia elíptica y, en el proceso, habrán nacido un sin fin de nuevas estrellas, otras habrán sido despladas de su regiones y lanzadas a distancias enormes, algunas habrán podido colisionar y, en definitiva, lo que allí pueda ocurrir en el futuro lejano, es de incalculable trascendencia para la Humanidad (si aún sigue aquí para ese tiempo).

Sí, existen muchos lugares a los que, cuando llegue el momento podremos viajar. Sin embargo, necesitamos muchos más conocimientos de los que actualmente tenemos para poder realizar esos viajes “imposibles” en las actuales circunstancias. Estamos comenzando, ahora, a poder realizar los primeros intentos de salir al Espacio, y, para cuando realmente podamos efectuar viajes espaciales, habrán pasado muchos, muchos, muchísimos años. No quiero mencionar, lo que podríamos tardar en dominar viajes hiperespaciales a velocidades uperlumínicas. Claro que, la imaginación humana es… ¡”infinita”!

Si esto es así (que lo es), tenemos una buena excusa para pensar en posibles modos de escapar hacia otros mundos lejanos en los que poder asentar a la Humanidad lejos de esos acontecimientos de magnitud (para nosotros) infinita y contra los que nada podremos hacer, excepto, si podemos y buscamos el medio… huir a otros lugares más seguros.

Si, las distancias que nos separan de esos otros mundos parece una barrera difícil de franquear, y, sin embargo, tengo una gran esperanza puesta en que, la Humanidad, la inteligencia de los seres que la compone, y, sobre todo su imaginación, con el tiempo por delante tendrá la oportunidad de buscar esas difíciles soluciones que posibiliten nuestro traslado a las estrellas lejanas.

Para lograr eso, con nuestras limitaciones actuales, no tenemos más remedio que valernos de sondas robotizadas y, en el futuro, serán perfectos robots humanoides que, no tendrán ninguna de nuestras barreras para deambular por el cielo y visitar esas regiones lejanas en las que, posiblemente, se encuentren los planetas idóneos para habitats de seres como nosotros.

Esas son, en realidad, las miras que están puestas en todas esas misiones enviadas a las lunas y planetas cercanos para estudiar su entorno, la atmósfera, la superficie y las radiaciones. Se trata de ir conociendo el entorno y, con los adelantos tecnológicos que ahora mismo tenemos, se hace lo que se va pudiendo y, cada día, se avanza un paso más a la búsqueda de esas soluciones que, ese día muy lejano aún, llegará la debacle a la Tierra y, para entonces, no podremos continuar aquí. La única solución: Escapar a otros mundos.

emilio silvera

Totales: 74.215.021

Totales: 74.215.021 Conectados: 41

Conectados: 41