Ago

29

¡La Luna! Esa compañera inseparable

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (0)

Comments (0)

La Luna es nuestra compañera en el espacio, Viaja junto a nosotros alrededor del Sol y es el más próximo de todos los cuerpos astronómicos naturales. No es de extrañar que tendamos de manera instintiva a concederle importancia y a considerarla como algo nuestro. Desde tiempos inmomoriales, nuestros ancestros, le concedieron a la Luna unos poderes mágicos sobre cosechas, embarazos…y otras cuestiones como las mareas entre ellas.

Hsi y Ho, dos astrólogos de la antigua China, no tuvieron tanta suerte como Einstein (gracias a un eclipse de Sol, pudo ver confirmada su teoría de la relatividad General). Su ignorancia les costó la vida a ambos por no predecir el eclipse total de Sol que se produjo en el año 2137 a. C., lo que causó las iras del emperador Tshung-Kong, que ordenó ejecutarlos.

Está claro que la Luna, ese plateado espejo que refleja nuestro mundo por las noches, le ha brindado a la ciencia la oportunidad de descifrar numerosos enigmas cada vez que oculta al Sol durante un eclipse. Si se analiza en detalle la historia podría comprobarse que la Luna se ha convertido en una maravillosa herramienta para los Astrónomos, que han sacado tanto partido científico de ella como belleza han podido percibir sus afortunados observadores.

¿Quién no ha representado alguna vez esta bonita escena? Con un testigo tan especial, el momento se hace sublime. Siempre hemos tenido símbolos de la Naturaleza que nos han acompañado en nuestras diferentes actividades. Como por ejemplo, la estrella Polar para los antiguos marinos.

La Luna es el astro más observado. En la antigüedad y hasta mediados del siglo XX, los principales astrónomos y los principales Observatorios centraron en ella una gran parte de sus observaciones e investigaciones de primera línea. Bien es cierto que, al ser tan conocida, salvo algunos proyectos específicos, en la actualidad ha quedado un poco relegada y, la verdad es, que aún le quedan cosas por decir.

Hace más de 40 años que el mundo, asombrado, contempló esta imagen

Allá por al año 1969, el hombre puso sus pies sobre la superficie lunar y pareció culminar una etapa de las exploraciones y, así, practicamente todo el mundo (pasados aquellos primeros momentos de excitación colectiva) empezó a olvidarse de ella. ¿Alguien podría pensar que quedara algo por descubrir en ese polvoriento satélite de apariencia inerte?

La respuesta llegó en 1996 gracias a la sonda Clementine de la NASA, cuyas fotografías dieron un inusitado vuelco a nuestra concepción lunar. La nave aportó pruebas de que en el cráter Aitkin, que se halla en el polo sur de la Luna, existe hielo. Esto es, que en el lugar más árido que se conoce del Sistema Solar hay agua. Aquello lo cambió todo y comenzaron a salir carpetas archivadas y llenas de polvo para retomar algunos proyectos olvidados.

Es verdaderamente sorprendente que, en la Luna, pueda haber agua. Tal hallazgo supone una buena baza para los futuros proyectos de la Base Lunar. No es despreciable la idea de poder en la Luna un Gran Complejo Espacial, con Base de lanzamientos de Naves hacia otros mundos con el enorme ahorro en el coste que eso supondría, o, Laboratorios que podrían investigar en el vacío del espacio, o, Telescopios libres de contaminación que, al igual que el Hubble pudiera llegar a todos los rincones del Universo pero, con menor mantenimiento y, el que necesitara sería más cómodo y menos costoso.

Hace unos días se publicó el hallazgo del agua en la Luna

Entre los muchos enigmas que aún rodean a nuestra compañera Luna. De hecho, la Astronomía tiene pendiente allí otro de sus grandes enigmas, como es la naturaleza de los fenómenos transitorios lunares, que se denominan habitualmente con la abreviatura TLP, correspondiente a la desripción inglesatransient lunar phenomenon. Consite en repentinos cambios de brillo en la superficie o en llamaradas, y se cree que están causados fundamentalmente por erupciones internas que se producen de forma esporádica, en especial en algunos cráteres. No todos están de acuerdo con este dictamen pero, la verdad es que se han producido suficientes testimonios de TPL como para dudar de ello, y, aunque exista la Incertidumbre de la verdadera causa…Ahí están.

Luces misteriosas aparecen en algunos cráteres de la Luna de manera inexplicable y, han sido observados con cierta frecuencia pero nunca se ha podido dar una explicación científica a los mismos. Lo cierto es que, en la Luna como en otros cuerpos celestes que nos circundan, se producen extrañas transiciones que nos son desconocidas y de cuyos orígenes quisiéramos saber.

En el verano de 1178, varios monjes observaron desde la Catedral de Canterbury un espectáculo increíble: La Luna, que estaba en fase creciente, comenzó a arder en su borde, que escupió varias llamaradas y chispar enormes. Con toda probabilidad vieron las nubes igneas de polvo y roca desprendidas por el impacto de un gigantesco meteorito en la cara oculta, desde la que asomó el resplandor producido por la colisión.

Se ha sugerido que el impacto de 1178 formó el cráter Giordano Bruno, pero de lo que no cabe duda es de que la aparentemente mortecina quietud lunar se rompe de forma ocasional por suscesos como éste. Y, aunque el caso más famoso se ha centrado en aquellos monjes de la Catedral de Canterbury, la verdad es que, también encontramos entre los testigos a famosos astrónomos como el mismísimo Herschel, descubridor de Urano, que en 1783 creyó ver un repentino destello rojizo en el hemisferio no iluminado de la Luna. Los resplandores rojizos constituyen el aspecto más llamativo de la mayoría de las observaciones de este tipo de fenómenos.

Los sentidos nos pueden confundir pero, ¡cuándo el río suena!

Muchos son los que se han recogido sobre este tipo de fenómenos en la Luna, y, su diversidad y abundancia, nos lleva a pensar que, fenómenos hay, lo que hace falta es que despejémos las incognitas y podamos dar con los diversos orígenes de los mismos. El fogonazo del Cráter Alphonsus observado por Kozyrev en 1958 es uno de esos extraños fenómenos.

El artífice del espectáculo de las Leónidas es el cometa Temple- Tuttle, descubierto en 1865. La corriente de corpúsculos que este objeto celeste va dejando en el espacio al describir su órbita es atravesada todos los años por la Tierra en torno al 16-17 de noviembre, pero cada treinta y tres años el cometa se adentra en la partem interior del Sistema Solar y alcanza su perihelio, lo que da lugar a extraordinarias tormentas de “estrellas fugaces”, como las que se observaron en 1966 y 1999.

Merced a los escasos 384 000 Kilómetros de distancia que separan la Tierra de la Luna, puede considerarse que ambas viajan juntas por el espacio y, por tanto, atraviesan al mismo tiempo las corrientes meteóricas que dejan el Tempel-Tuttle y otros cometas. Era evidente que el mes de noviembre de 1999 se presentaba como una magnifica ocasión para analizar la incidencia de las Leónidas en la Luna, de esta forma, se han conseguido detectar, por primera vez los destellos luminosos causados por los impactos y fragmentos del Cometa sobre la superficie lunar. El Estudio fue realizado por: El Instituto de Astrofísica de Andalucía (IAA), Instituto de Astrofísica de Canarias (IAC) y el Centro Hispano-Alemán de Calar Alto (Almería), en colaboración con la Universidad de Monterrey (México).

Muchos son los instrumentos con los que podemos contar para realizar toda clase de observaciones del cielo profundo, y, la Luna, al estar más cerca y casi a nuestro lado (384 000 Km de distancia en el espacio…es bien poca cosa), nos abre la posibilidad de conocerla mejor.

El papel desempeñado por las colisiones meteóricas en la evolución de la Tierra y la Luna no ha dejado de sorprender a los científicos desde hace tres décadas, pero la teória más fascinante es la que ha obtenido una mayoritaria aceptación relativamente reciente tras décadas de discusión: El origen de la Luna es la consecuencia de una de las mayores catátrofes cósmicas ocurridas en el Sistema Solar, al chocar contra la Tierra un planetoide de varios miles de kilómetros de diámetro. Esa colisión, se cree que se produjo hace unos 4.500 millones de años, poco después de la formación de nuestro planeta, y el planetoide intruso, mezclado con la enorme masa de materiales que arranco del manto terrestre a causa del impacto, acabó transformándose en la Luna con el paso del Tiempo. La coincidencia de la composición lunar con los materiales pesentes en las capas exteriores de la Tierra concuerda con esa teoría, que es la mejor asentada en la actualidad acerca del nacimiento de la Luna.

Con certeza no podemos saber si en realidad ocurrió así. Sin embargo, es lo cierto que de haber sucedido de esa manera, aquél drámatico Caos en la joven Tierra, nos proporcionó una bonita compañera de viaje que nos acompañó y fue testigo callado de todas esas Civilizaciones perdidas de la Antigüedad.

Es bien conocida la interacción gravitatoria que la Luna intercambia con la Tierra y los fenómenos mareales que esa fuerza produce, y, de la misma manera, se cree que otros fenómenos también son producto de la proximidad del satélite de la Tierra que, los Humanos, desde tiempo inmemoriales, ha utilizado para muchas de sus de su actividades de todo tipo, atribuyéndo a sus rayos de plata unos poderes que no siempre serían beneficiosos.

Escapar del planeta Tierra, es difícil, costoso y peligroso. Sin embargo, de la Luna sería barato y fácil

El diámetro de la Luna es de 3 476 Km y su masa de 7,348 x 1022 Kg, su volumen es un 0,12% del de la Tierra, y, su velocidad de escape es de 0,02 Km/s, mientras que conseguir que una nave escape de la fuerza de Gravedad terrestre, nos hace tener que vencerla mediante una velocidad de 11 Km/s, con lo cual, las ventajas de una Base lunar serían enormes.

Mucho más podríamos estar hablando sobre la Luna y sus enigmas. Muchos de los datos que aquí han sido reseñados se tomaron del libro de Vicente Aupi: Los Enigmas del Cosmos. Otros, han sido rescatados de la Biblioteca, sección del espacio, y, algunos…de mi archivo mental.

Un saludo amigos.

emilio silvera

Ago

29

Partículas, antipartículas, fuerzas…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

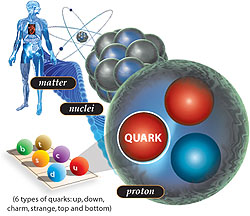

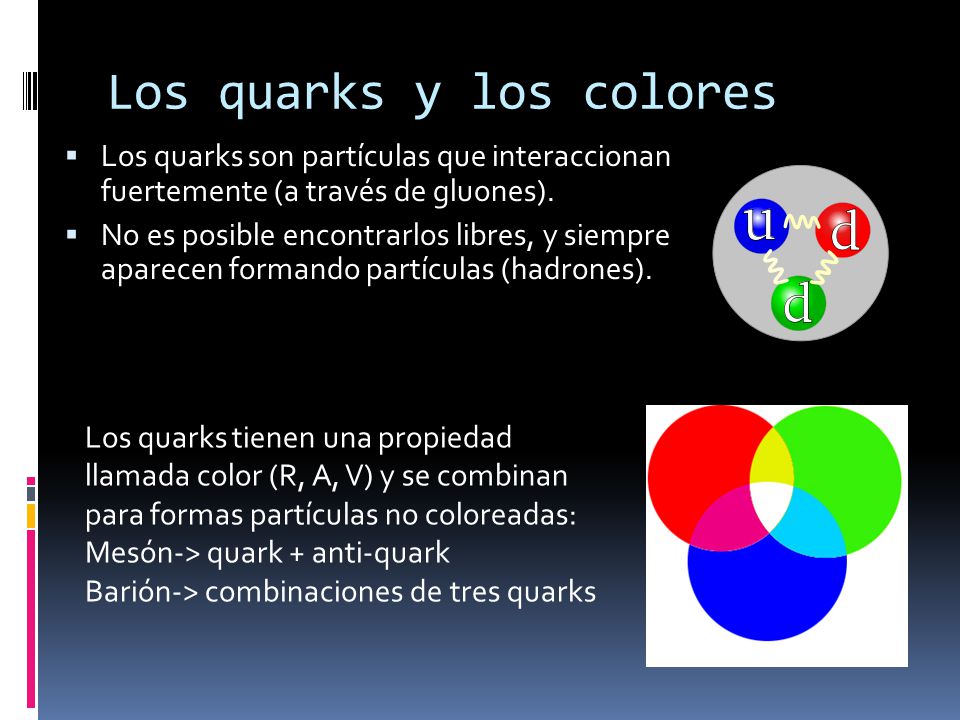

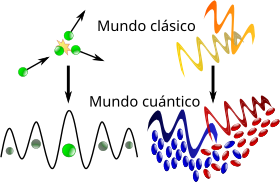

Bajo la “definición basada en quarks y leptones”, las partículas elementales y compuestas formadas de quarks (en púrpura) y leptones (en verde) serían la “materia”; mientras los bosones “izquierda” (en rojo) no serían materia. Sin embargo, la energía de interacción inherente a partículas compuestas (por ejemplo, gluones, que implica a los neutrones y los protones) contribuye a la masa de la materia ordinaria.

Esquema de una aniquilación electrón-positrón.

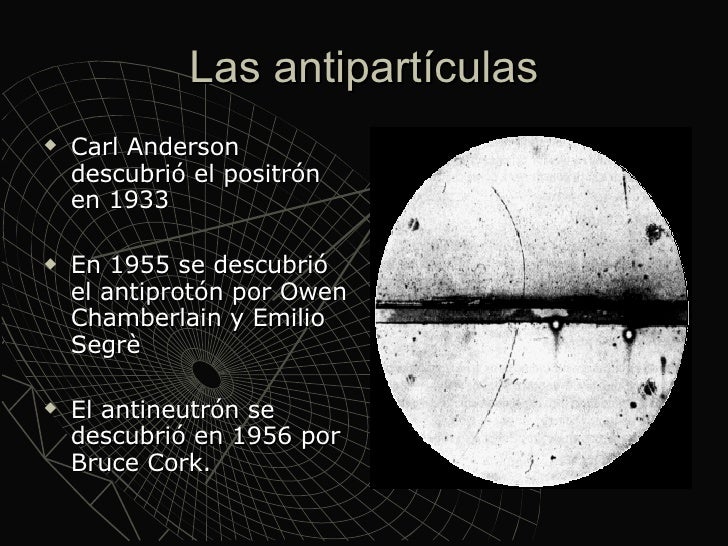

Ya hemos descrito en trabajos anteriores las dos familias de partículas elementales: Quarks y Leptones. Pero hasta ahí, no se limita la sociedad del “universo” infinitesimal. Existen además las antifamilias. A quarks y electrones se asocian, por ejemplo, antiquarks y antielectrones. A cada partícula, una antipartícula.

Uno de los primeros éxitos de la teoría relativista del campo cuántico fue la predicción de las antipartículas: nuevos cuantos que eran la imagen especular de las partículas ordinarias. Las antipartículas tienen la misma masa y el mismo spin que sus compañeras las partículas ordinarias, pero cargas inversas. La antipartícula del electrón es el positrón, y tiene, por tanto, carga eléctrica opuesta a la del electrón. Si electrones y positrones se colocan juntos, se aniquilan, liberando la energía inmensa de su masa según la equivalencia masa-energía einsteniana.

¿Cómo predijeron los físicos la existencia de antipartículas? Bueno, por la «interpretación estadística» implicaba que la intensidad de un campo determinaba la probabilidad de hallar sus partículas correspondientes. Así pues, podemos imaginar un campo en un punto del espacio describiendo la creación o aniquilación de sus partículas cuánticas con una probabilidad concreta. Si esta descripción matemática de la creación y aniquilación de partículas cuánticas se inserta en el marco de la teoría relativista del campo cuántico, no podemos contar con la posibilidad de crear una partícula cuántica sin tener también la de crear un nuevo género de partícula: su antipartícula. La existencia de antimateria es imprescindible para una descripción matemáticamente coherente del proceso de creación y aniquilación según la teoría de la relatividad y la teoría cuántica.

La misteriosa sustancia conocida como “materia oscura” puede ser en realidad una ilusión, creada por la interacción gravitacional entre partículas de corta vida de materia y antimateria. Un mar hirviente de partículas en el espacio puede crear la gravedad repulsiva.

Puede ser posible que las cargas gravitacionales en el vacío cuántico podrían proporcionar una alternativa a la “materia oscura”. La idea se basa en la hipótesis de que las partículas y antipartículas tienen cargas gravitacionales de signo opuesto. Como consecuencia, los pares de partícula-antipartícula virtuales en el vacío cuántico y sus dipolos de forma gravitacional (una carga gravitacional positivos y negativos) pueden interactuar con la materia bariónica para producir fenómenos que se suele atribuir a la materia oscura. Fue el físico del CERN, Dragan Slavkov Hajdukovic, quien propuso la idea, y demostró matemáticamente que estos dipolos gravitacionales podrían explicar las curvas de rotación de las galaxias observadas sin la materia oscura en su estudio inicial. Sin embargo, señaló que quedaba mucho por hacer.

Pero sigamos con la cuántica…

El pionero en comprender que era necesario que existiesen antipartículas fue el físico teórico Paul Dirac, que hizo varías aportaciones importantes a la nueva teoría cuántica. Fue él quien formuló la ecuación relativista que lleva hoy su nombre, y a la que obedece el campo electrónico; constituye un descubrimiento comparable al de las ecuaciones del campo electromagnético de Maxwell. Cuando resolvió su ecuación, Dirac se encontró con que además de describir el electrón tenía soluciones adicionales que describían otra partícula con una carga eléctrica opuesta a la del electrón. ¿Qué significaría aquello? En la época en que Dirac hizo esta observación, no se conocían más partículas con esta propiedad que el protón. Dirac, que no deseaba que las partículas conocidas proliferasen, decidió que las soluciones adicionales de su ecuación describían el protón.

Pero, tras un análisis más meticuloso, se hizo evidente que las partículas que describían las soluciones adicionales tenían que tener exactamente la misma masa que el electrón. Quedaba así descartado el protón, cuya masa es por lo menos, 1.800 veces mayor que la del electrón. Por tanto, las soluciones adicionales tenían que corresponder a una partícula completamente nueva de la misma masa que el electrón, pero de carga opuesta: ¡El antielectrón! Esto quedó confirmado a nivel experimental en 1932 cuando Carl Anderson, físico del Instituto de Tecnología de Calífornia, detectó realmente el antielectrón, que hoy se llama positrón.

Antes de empezar, debemos recordar que el Premio Nobel de Física de 1936 se repartió a partes iguales entre Victor Franz Hess y Carl David Anderson. Merece la pena leer la Nobel Lecture de Carl D. Anderson, “The production and properties of positrons,” December 12, 1936, quien nos explica que en esta imagen un “electrón” de 63 MeV atraviesa un placa de plomo de 6 mm y emerge con una energía de 23 MeV, pero lo hace con la curvatura “equivocada” como si fuera una partícula de carga positiva, como si fuera un protón pero con la masa de un electrón. La Nobel Lecture muestra muchas otras fotografías de positrones y electrones. Anderson afirma: “The present electron theory of Dirac provides a means of describing many of the phenomena governing the production and annihilation of positrons.”

Por otro lado, el Premio Nobel de Física de 1933 se repartió a partes iguales entre Erwin Schrödinger y Paul Adrien Maurice Dirac. También vale la pena leer la Nobel Lecture de Paul A. M. Dirac, “Theory of electrons and positrons,” December 12, 1933, aunque no cuente la historia de su descubrimiento, afirma que su ecuación predice el “antielectrón” de soslayo: ”There is one other feature of these equations which I should now like to discuss, a feature which led to the prediction of the positron.” (fuente: Francis (th)E mule Science’s News).

La aparición de las antipartículas cambió definitivamente el modo de pensar de los físicos respecto a la materia. Hasta entonces, se consideraba la materia permanente e inmutable. Podían alterarse las moléculas, podían desintegrarse los átomos en procesos radiactivos, pero los cuántos fundamentales se consideraban invariables. Sin embargo, tras el descubrimiento de la antimateria realizado por Paul Dirac hubo que abandonar tal criterio. Heisenberg lo expresaba así:

“Creo que el hecho de que Dirac haya descubierto partículas y antipartículas, ha cambiado toda nuestra visión de la física atómica… creo que, hasta entonces, todos los físicos habían concebido las partículas elementales siguiendo los criterios de la filosofía de Demócrito, es decir, considerando esas partículas elementales como unidades inalterables que se hallan en la naturaleza como algo dado y son siempre lo mismo, jamás cambian, jamás pueden transmutarse en otra cosa. No son sistemas dinámicos, simplemente existen en sí mismas. Tras el descubrimiento de Dirac, todo parecía distinto, porque uno podía preguntar: ¿por qué un protón no podría ser a veces un protón más un par electrón-positrón, etc.?… En consecuencia, el problema de la división de la materia había adquirido una dimensión distinta.”

Dado que la antimateria tiene la misma masa que la materia, es decir son de la misma magnitud y signo (la definición de masa es positiva siempre), el efecto gravitacional de la antimateria no debe ser distinto de la materia, es decir, siempre sera un efecto atractivo. Pero, ¿acaso no importa la equivalencia establecida de antipartícula viajando al futuro = partícula viajando al pasado?

Existe un “universo” que se nos escapa de la comprensión

La respuesta es sí. Dicha equivalencia proviene de algo llamado simetría CPT (Charge-Parity-Time), y nos dice que la equivalencia entre las partículas y antipartículas no solo corresponde a realizar una transformación sobre la carga, sino también sobre la paridad y el tiempo. La carga no afecta la gravedad, pero la paridad y el tiempo si la afectan. En otras palabras, al modificarse el tiempo (poner el tiempo al reves) y el espacio (la paridad es “girar” el espacio), estamos alterando el espacio-tiempo, y como la teoría general de la relatividad lo afirma, es la geometría de este el que determina la gravedad.

El carácter mutable de la materia se convirtió en piedra angular de la nueva física de partículas. El hecho de que partículas y antipartículas puedan crearse juntas a partir del vacío si se aporta energía suficiente, no sólo es importante para entender cómo se crean las partículas en aceleradores de alta energía, sino también para entender los procesos cuánticos que se produjeron en el Big Bang.

Como ya lo hemos expresado, el conocimiento que se obtuvo sobre la existencia de antifamilias de partículas o familias de antipartículas es una consecuencia de la aplicación de la teoría relativista del campo cuántico, para cada partícula existe una partícula que tiene la misma masa pero cuya carga eléctrica (y otras llamadas cargas internas) son de signo opuesto. Estas son las antipartículas. Así, al conocido electrón, con carga negativa, le corresponde un «electrón positivo» como antipartícula, llamado positrón, descubierto en 1932. El antiprotón, descubierto en 1956, tiene la misma masa que el protón, pero carga eléctrica negativa de igual valor. El fotón, que no tiene masa ni carga eléctrica, puede ser considerada su propia antipartícula.

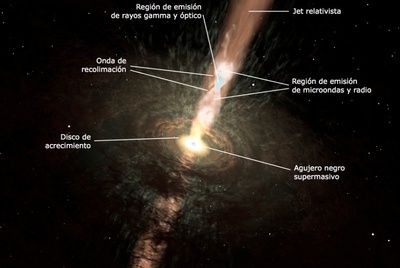

Un agujero negro es un objeto que tiene tres propiedades: masa, espin y carga eléctrica. La forma del material en un agujero negro no se conoce, en parte porque está oculta para el universo externo, y en parte porque, en teoría, el material continuaría colapsando hasta tener radio cero, punto conocido como Singularidad, de densidad infinita.

Un agujero negro tiene tres propiedades: masa, espín y carga eléctrica. La forma del material de un agujero negro no se conoce, en parte porque está oculta para el universo externo, y en parte porque, en teoría, el material continuaría colapsando hasta tener radio cero, punto conocido como singularidad, de densidad infinita.

La luz (fotones), no son una onda distinta que un electrón o protón, etc.

1°- “No se dispersan”, no son más pequeñas, como las ondas del agua (olitas) cuando tiramos una piedrita, a medida que se alejan de su centro; sino que en el caso de la luz son menos partículas, pero son siempre el mismo tipo de onda (determinada frecuencia), igual tamaño.

2°- Las ondas con más energía son más grandes, los fotones al igual que las partículas son más pequeñas, contra toda lógica (contracción de Lorentz).

3°- No necesitan de un medio material para desplazarse. Viajan en el vacío. El medio que usan para viajar, es el mismísimo espacio.

4°- Su cualidad de onda no es diferente de las partículas. Lo podemos ver en la creación de pares y la cualidad de onda de las partículas, etc. En ningún momento la partícula, es una cosa compacta (ni una pelotita), siempre es una onda, que no se expande. En la comparación con la ola, sería como un “montón” o un “pozo” de agua, con una dirección, lo que conocemos como ecuación de Schrödinger. En ningún momento la partícula, es una pelotita; la ola sobre el agua, no es un cuerpo que se mueve sobre el agua, no es un montón de agua que viene (aunque parece), sino una deformación del agua. Así la partícula, no es un montón de algo, sino una deformación del espacio.

La curvatura está relacionadas con la probabilidad de presencia, no es una bolita que está en uno de esos puntos, sino que es una onda en esa posición. El fotón es una onda que no necesita de un medio material para propagarse, se propaga por el espacio vacío. Así como una onda de sonido es una contracción-expansión del medio en que se propaga, el fotón es una contracción-expansión del espacio (del mismísimo espacio), razón por la cual entendemos que el espacio se curva, se contrae y expande. La rigidez del medio, da la velocidad de la deformación (velocidad de la onda), en el caso de la rigidez del espacio da una velocidad “c”.Esta onda por causa de la contracción del tiempo (velocidad “c”), no se expande, sino que se mantiene como en su origen (para el observador ), como si fuese una “burbuja”, expandida o contraída, en cada parte, positiva-negativa

Cada partícula está caracterizada por un cierto número de parámetros que tienen valores bien definidos: su masa, carga eléctrica, spin o rotación interna y otros números, conocidos como cuánticos. Estos parámetros son tales que, en una reacción, su suma se mantiene y sirve para predecir el resultado. Se dice que hay conservación de los números cuánticos de las partículas. Así, son importantes el número bariónico, los diversos números leptónicos y ciertos números definidos para los quarks, como la extrañeza, color, etc. Estos últimos y sus antipartículas tienen cargas eléctricas (± 1/3 o ± 2/3) y números bariónicos (±1/3) fraccionarios. No todos los números asociados a cada partícula han sido medidos con suficiente precisión y no todas las partículas han sido detectadas en forma aislada, por lo menos de su ligamento, como el caso de los quarks y de los gluones.

Los gluones son una especie de «partículas mensajeras» que mantienen unidos a los quarks. Su nombre proviene del término inglés “glue”, que significa pegamento, en español quizás podría ser gomón. Ahora, en cuanto a los quarks, ya hicimos referencia de ellos anteriormente. Pero recordemos aquí, que fueron descubiertos en 1964 por Murray Gell-Mann, como los componentes más reducidos de la materia. Hasta entonces se pensaba que los átomos consistían simplemente en electrones rodeando un núcleo formado por protones y electrones.

En estado natural, quarks y gluones no tienen libertad. Pero si se eleva la temperatura a niveles 100.000 veces superiores, como se ha hecho en aceleradores de partículas, a la del centro del Sol, se produce el fenómeno del desconfinamiento y por un brevísimo tiempo quedan libres. En ese preciso momento aparece lo que se suele llamar plasma, «una sopa de quarks y gluones» que equivale al estado en que se podría haber encontrado la naturaleza apenas una milésima de segundo luego del Big Bang.

Recientemente se ha descubierto un nuevo estado de la materia, esta vez a niveles muy altos de energía, que los científicos han denominado Plasma Gluón-Quark. La transición ocurre a temperaturas alrededor de cien mil millones de grados y consiste en que se rompen las fuertes ligaduras que mantienen unidos los quarks dentro de los núcleos atómicos. Los protones y neutrones están formados, cada uno, por 3 quarks que se mantienen unidos gracias a los gluones (El gluón es la partícula portadora de interacción nuclear fuerte, fuerza que mantiene unida los núcleos atómicos). A temperaturas superiores se vence la fuerza nuclear fuerte y los protones y neutrones se dividen, formando esta sopa denominada plasma Gluón-Quark.

Pero por ahora aquí, nos vamos a quedar con los quarks al natural. Normalmente, los quarks no se encuentra en un estado separados, sino que en grupos de dos o tres. Asimismo, la duración de las vidas medias de las partículas, antes de decaer en otras, es muy variable (ver tablas).

Por otra parte, las partículas presentan una o más de las siguientes interacciones o fuerzas fundamentales entre ellas. Por un lado se tiene la gravitación y el electromagnetismo, conocidas de la vida cotidiana. Hay otras dos fuerzas, menos familiares, que son de tipo nuclear y se conocen como interacciones fuertes y débiles.

La gravitación afecta a todas las partículas, es una interacción universal. Todo cuerpo que tiene masa o energía está sometido a esta fuerza. Aunque es la más débil de las interacciones, como las masas son siempre positivas y su alcance es infinito, su efecto es acumulativo. Por ello, la gravitación es la fuerza más importante en cosmología.

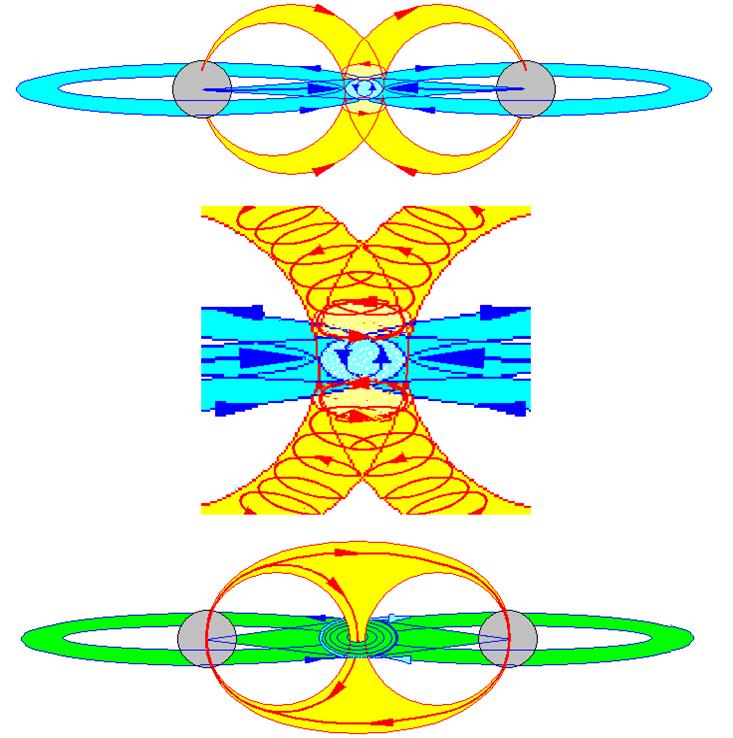

Los campos magnéticos están presentes por todo el Universo

La fuerza electromagnética se manifiesta entre partículas con cargas eléctricas. A diferencia de las demás, puede ser de atracción (entre cargas de signos opuestos) o de repulsión (cargas iguales). Esta fuerza es responsable de la cohesión del átomo y las moléculas. Mantiene los objetos cotidianos como entidades con forma propia. Un vaso, una piedra, un auto, el cuerpo humano. Es mucho más fuerte que la gravitación y aunque es de alcance infinito, las cargas de distinto signo se compensan y sus efectos no operan a grandes distancias. Dependiendo de las circunstancias en que actúen, estas interacciones pueden manifestarse como fuerzas eléctricas o magnéticas solamente, o como una mezcla de ambos tipos.

La Fuerza Nuclear Débil: otra fuerza nuclear, considerada mucho más débil que la Fuerza Nuclear Fuerte. El fenómeno de decaimiento aleatorio de la población de las partículas subatómicas (la radioactividad) era difícil de explicar hasta que el concepto de esta fuerza nuclear adicional fue introducido.

La interacción nuclear débil es causa de la radioactividad natural y la desintegración del neutrón. Tiene un rol capital en las reacciones de fusión del hidrógeno y otros elementos en el centro de las estrellas y del Sol. La intensidad es débil comparada con las fuerzas eléctricas y las interacciones fuertes. Su alcance es muy pequeño, sólo del orden de 10-15 cm.

La interacción fuerte es responsable de la cohesión de los núcleos atómicos. Tiene la intensidad más elevada de todas ellas, pero es también de corto alcance: del orden de 10-13 cm. Es posible caracterizar las intensidades de las interacciones por un número de acoplamiento a, sin dimensión, lo que permite compararlas directamente:

Fuerte as = 15

Electromagnéticas a = 7,3 x 10-3

Débil aw 3,1 x 10-12

Gravitacional aG = 5,9 x 10-39

Por otro lado, la mecánica cuántica considera que la interacción de dos partículas se realiza por el intercambio de otras llamadas «virtuales». Tienen ese nombre porque no son observables: existen por un tiempo brevísimo, tanto más corto cuanto mayor sea su masa, siempre que no se viole el principio de incertidumbre de Heisenberg de la teoría cuántica (que en este contexto dice que el producto de la incertidumbre de la energía por el tiempo de vida debe ser igual o mayor que una constante muy pequeña). Desaparecen antes de que haya tiempo para que su interacción con otras partículas delate su existencia.

El fotón virtual común se desplaza hacia la partícula menos energética.

Dos partículas interactúan al emitir una de ellas una partícula virtual que es absorbida por la otra. Su emisión y absorción cambia el estado de movimiento de las originales: están en interacción. Mientras menos masa tiene la partícula virtual, más lejos llega, mayor es el rango de la interacción. El alcance de la interacción es inversamente proporcional a la masa de la partícula portadora o intermedia. Por ejemplo, la partícula portadora de la fuerza electromagnética es el fotón, de masa nula y, por lo tanto, alcance infinito. La interacción gravitacional también tiene alcance infinito y debe corresponder a una partícula de masa nula: se le denomina gravitón. Naturalmente tiene que ser neutro. (Aún no ha sido vistos ni en pelea de perros).

Como ya hicimos mención de ello, a las fuerzas nucleares se les asocian también partículas portadoras. Para la interacción débil estas partículas se llaman bosones intermedios, expresados como W+, W- y Zº (neutro). El W- es antipartícula del W+. Los W tienen masas elevadas comparadas con las otras partículas elementales. Lo de bosones les viene porque tienen spin entero, como el fotón y el gravitón, que también los son, pero que tienen masas nulas. Las fuerzas fuertes son mediadas por unas partículas conocidas como gluones, de los cuales habría ocho. Sin embargo, ellos no tienen masa, pero tienen algunas de las propiedades de los quarks, que les permiten interactuar entre ellos mismos. Hasta ahora no se han observado gluones propiamente tal, ya que lo que mencionamos en párrafos anteriores corresponde a un estado de la materia a la que llamamos plasma. Claro está, que es posible que un tiempo más se puedan detectar gluones libres cuando se logre aumentar, aún más, la temperatura, como está previsto hacerlo en el acelerador bautizado como “Relativistic Heavy Ion Collider”, empotrado en Estados Unidos de Norteamérica.

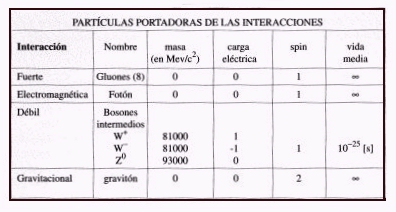

TABLA DE LAS PRINCIPALES PROPIEDADES DE LAS PARTÍCULAS PORTADORAS DE LAS INTERACCIONES FUNDAMENTALES

Una partícula y su antipartícula no pueden coexistir si están suficientemente cerca como para interactuar. Si ello ocurre, ellas se destruyen mutuamente: hay aniquilación de las partículas. El resultado es radiación electromagnética de alta energía, formada por fotones gamma. Así, si un electrón está cercano a un positrón se aniquilan en rayos gamma. Igual con un par protón-antiprotón muy próximos.

La reacción inversa también se presenta. Se llama «materialización o creación de partículas» de un par partícula-antipartícula a partir de fotones, pero se requieren condiciones físicas rigurosas. Es necesario que se creen pares partícula-antipartícula y que los fotones tengan una energía mayor que las masas en reposo de la partículas creadas. Por esta razón, se requieren fotones de muy alta energía, de acuerdo a la relación de Einstein E=mc2 . Para dar nacimiento a electrones/positrones es necesario un campo de radiación de temperaturas mayores a 7×109 °K. Para hacer lo mismo con pares protón/antiprotón es necesario que ellas sean superiores a 2×1012 °K. Temperaturas de este tipo se producen en los primeros instantes del universo.

Se detectan grandes emisiones de rayos gamma en explosiones supernovas y otros objetos energéticos

Los rayos gamma están presentes en explosiones de supernovas, colisión de estrellas de neutrones… Todos los sucesos de altas energías los hace presente para que nuestros ingenios los detecten y podamos conocer lo que la materia esconde en lo más profundo de sus “entrañas”. Aún no hemos podido conocer en profundidad la materia ni sabemos, tampoco, lo que realmente es la luz.

emilio silvera

Ago

28

¡La perfección! ¿No serán simples rumores?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Belleza sí ~

Clasificado en Belleza sí ~

Comments (5)

Comments (5)

Si sabemos verla, la Belleza está por todas partes

Espíritu de belleza, que has consagrado

Con tus propios matices todo aquello sobre lo que brillas

Del pensamiento o la forma Humanos, ¿adonde has ido?

¿Por qué has desaparecido y abandonado nuestra existencia,

Este oscuro Valle de lágrimas, vacío y desolado

El Universo está construido según un plan

cuya profunda simetría está presente de algún

modo en la estructura interna de nuestro intelecto.

El primero pretende ser un himno a la Belleza intelectual de Shelley y, en el segundo Paul Valery, nos transmite la idea de que, la belleza, forma parte de nuestro intelecto humano que, no simplemente valora lo material sino que, de alguna manera, deja un lugar para la excelencia del mundo.

El Joven Henry Poincaré

Algunas veces, los físicos teóricos, como los artistias (uno se siente tentado a decir: como otros artistas) se seguían en su trabajo por preocupaciones estéticas tanto como racionales. “Para hacer ciencia, es necesario algo más que la pura lógica”, escribió Poincaré, quien identificaba este elemeto adicional como la intuición, que supone “el sentido de la belleza matemática”. Heisenberg hablaba de “la simplicidad y belleza” de los esquemas matemáticos que la Naturaleza nos presenta.

Usted también debe hacer sentido esto -le dijo a Einstein, la casi temible simplicidad e integridad de la relación que la Naturaleza repentinamente extiende ante nosotros”. Paul Dirac, el físico teórico ingles y enorme matemático, cuya descripción relativista del electrón está a la altura de las obras maestras de Einstein y Bohr, llegó hasta sostemer que “más importante que nuestras ecuaciones se ajusten a los experimentos es que sean bellas”.

La estética es, evidentemente, subjetiva, y la afirmación de que los físicos buscan la belleza en sus teorías tiene sentido sólo si podemos definir la Belleza. Afortunadamente, esto se puede hacer, en cierta medida, pues la estética científica está iluminada por ese sol central de la simetría.

La simetría es un concepto venerable y en modo alguno inescrutable, que tiene muchas implicaciones en la ciencia y el arte, mucho después de que el físico chino – norteamericano Chen Ning Yang ganase el Premio Nobel por su trabajo en el desarrollo de una teoría de campos basada en la simetría, aún afirmaba que “no comprendo todavía todo el alcance del concepto de simetría”.

Debajo de las manifestaciones visibles y audibles de simetría hay profundas invariancias matemáticas. Los esquemas espirales que se encuentran en el interior del nautilus, en la superficie de los girasoles, por ejemplo, pueden ser presentados por aproximación mediante la serie de Fibonacci, una operación aritmética en la que cada miembro es igual a la suma de los dos precedentes (, 1, 2, 3, 5, 8, 13, 21, 34, …). La razón creada dividiendo cada número de la serie por el número que le sigue se aproxima al valor 0,618.

No es casual que esta sea la fórmula de la “sección aurea”, una proporción geométrica que aparece en el Partenón, La Mona Lisa y El nacimiento de Venus de Boticelli, y es la base de la octava que se emplea en la músuca occidental desde el tiempo de Bach. Toda la fecunda diversidad de esta simetría particular, expresada en infinidad de modos, desde conchas marinas y las piñas hasta el Clave buien temperado, deriva, por lo tanto, de una sola unvariancia, la de la serie de Fibonacci. La comprensión de que una sola simetria abstracta podría tener tantas frustíferas y diversas manifestaciones deleitó a los sabios del Renacimiento, quines la citaban como prueba de la eficacia de las matemáticas y de la sutileza de los designios de la Naturaleza sabia. Desde entonces, otras muchas simetías abstractas han sido identificadas en la naturaleza -algunas intactas y otras , “rotas” o estropeadas-, y sus efectos parecen incluso extenderse hasta los cimientos mismos de la materia y la energía.

El Partenón de Atenas. La Grecia clásica , fuente de simetría y canon. presente en todas las imágenes de arriba

La palbra simetría en griego, significa “la misma medida” (sun significa “juntos”, como en sinfonía, una unión de sonidos, metrón, “medición”); así, su etimología nos informa que la simetría para los griegos también significa la “debida proporción” , lo que sugiere que la repetición involucrada debe ser armoniosa y placentera; esto indica que una relación simétrica debe ser juzgada por un criterio estético superior. Pero en la ciencia del siglo XX se puso de relieve el primer aspecto de la vieja definición: se dice que hay simetría cuando una cantidad medible permanece invariante (lo que significa que no cambia) bajo una transformación (que significa una alteración).

Nosotros, casi todos, hemos conocido la simetría en sus manifestaciones geométricas, o, en el Arte. Cuando decimos, por ejemplo, que una esfera tiene una simetrtía de rotación, lo que tratamos de indicar es que poseer unas características -en este caso, su perfil circular- que permanece invariante en las transformaciones producidas al hacerla rotar. Puede hacerso rotar la esfera en cualquier eje y cualquier grado sin que cambie su perfil, lo cual hace que sea más simétirca, por ejemplo, que un cilibro, que tiene una simetría similarsólo cuando rota alrededor de su eje largo; si rota alrededor de su eje corto, el cilindro se reduce a un círculo.

Las simetrías son comunes en las esculturas, empezamdo por el desnudo humano, que es (de modo aproximado) bilateralmente simétrico cuando se le contempla de frente o de atrás, y en arquitectura como en los planos de suelo en forma de cruz de las catefrales medievales, y aparecen en todas partes desde el tejido hasta el baile de figuras.

Hay muchas simetrías en la música de Bach, en un pasaje de la Tocata y Fuga en Mi menor (mo he podido encontrar la partitura) traslada arrina y abajo del pentagrama pequeños trios de notas como tiendas de campaña. Excepto con la ocasional diferencia de alguna que otra nota, la construcción tiene una simetría de traslación. Si quitamos un trío cualquiera y lo pusiéramos sobre otro, encajaría perfectamente.

Nos encontramos simetrías en el Universo, en el mundo que habitamos, también en nosotros y, nuestras Mentes, no son una excepción y en ellas subyace una simetría más profunda que trasciende a lo material.

De todas las maneras, es preciso que no perdamos de vista que, la Belleza, como otras muchas cuestiones, está sometida a la relatividad, no todos podemos ver la misma cosa y valorarla de la misma manera. Una imagen nos puede resultar a unos de una belleza extrema, y, a otros, les podría parecer un extraño objeto sin sentido. ?Por qué será eso? Creo que, precisamente es así debido a la diversidad que está presente en nuestras Mentes, y, también, a las circunstancias en las que esté inmerso el observador.

emilio silvera

Ago

26

El Universo y… ¿Nosotros?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo y la Mente ~

Clasificado en El Universo y la Mente ~

Comments (0)

Comments (0)

Heber Doust Curtis

June 27, 1872. Muskegon, Michigan

Heber Doust Curtis fue un astrónomo estadounidense, conocido por defender en el conocido “Gran Debate”, la hipótesis de que las conocidas como nebulosas espirales eran galaxias fuera de la Vía Láctea frente a las idea contraria defendida por Harlow Shapley. La situación era con confusa que, en abril de 1920, Shapley y Herbert Curtis, uno de los principales proponentes de la hipótesis del universo-isla, mantuvieron un debate en el Instituto Smithsoniano, sobre la cuestión de la estructura del universo. Financiado por la National Academy od Sciencie.

Como podréis comprender, por aquellas fechas no existían los grandes telescopios que hoy nos traen ante nuestros ojos las imágenes de los cúmulos de galaxias situados a muchos años-luz del Sistema Solar. Así que, en aquellos tiempos el Debate entre Herbert Curtis y Shapley, fue el no va más y, todavía, es considerado por los Astrónomos como el equivalente a los famosos debates Huxley-Wilberforce sobre la validez de la evolución.

Shapley presentó sus pruebas del tamaño de la Vía Láctea y Curtis argumentó a favor de la existencia de otras galaxias, como la nuestra. Nadie “ganó” el debate, en primer lugar porque los dos hombres dicutían diferentres temas. Cada uno era correcto en su propio dominio. La Vía Láctrea es realmente muy grande, como aducía Shapley, pero las distancias a las otras galaxias son aún mayores.

La Nebulosa Cabeza de Caballo en Orión

La Naturaleza de las Nebulosas fue finalmente averiguada en 1923 cuando el Astrónomo Edwin Hubble se convirtió en una de los primeros científicos que pudo utilizar el nuevo telescopio de 100 pulgadas del Monte Wilson, cerca de los Ángeles. Con este instrumento Hubble era capaz de aislar estrellas individuales, incluidas en las Cefeidas variables, en las galaxias cercanas. Utilizando la correlación entre pulsación y brillo desarrollado por Leavitt, Hubble demostró que las distancias a las nebulosas espirales debían medirse en millones de años-luz, distancias mucho mayores que las asignadas por Shapley al tamaño de la Galaxia.

Una vez más el universo se expandía al aumentar nuestra capacidad para ver en él. No sólo había otros universos islas, sino que estaban mucho más lejos de lo que nadie había podido imaginar nunca. Las Nebulosas espirales eran en realidad sistemas de estrellas como el nuestro, situados a enormes distancias de nosotros. Otras Nebulosas -las que tienen relativamente pocas estrellas y mucho material diseminado-, son nubes de gas en nuestra propia Galaxia. Para señalar la diferencia entre las dos necesitábamos un telescopio capaz de determinar que un conjunto de nebulosas estaba más distante que el otro. Una vez que se hizo esto, el problema quedó resuelto.

Las galaxias no están distribuidas por el espacio de manera aleatoria o azarosa, sino que tienden a reunirse en estructuras llamadas cúmulos que a su vez están agrupados en supercúmulos que llegan a tener miles o cientos de miles de galaxias. Claro que Hubbkle no podía saber eso y en aquellos tiempos, poder explicar la desiguadad en la distribución de las galaxias constituía uno de los mayores problemas. Incluso algunos, dicen que es el mayor problema de la Cosmología moderna.

Claro que, por importante que pudiera ser el descubrimiento o demostración de Hubble de la existencia de otras galaxias, todavía fue mucho más asombroso que hizo como parte del mismo estudio. Observando las galaxias más cercanas, Hubble podía ver que se alejaban de él, y que cuanto más lejos estaba la galaxia, más rápidamente se movía. Este descubrimiento era tan desconcertante -tan cuajado de implicaciones para la cosmología moderna- que era necesario considerar la base del razonamiento sobre el que hizo Hubble sus afirmaciones.

Del Efecto Doppler todos hemos oido hablar y sabemos que, si un coche se nos acerca percibimos las ondas sonaras muy juntas, más fuertes y, cuando pasa de largo y se aleja, las ondas también se alejan y nos suenan más suaves. Esto explica (de manera muy sencilla el efecto Doppler, y también explica como descubrió Hubble la expansión del universo. Lo que sucede con el sonido también sucede con cualquier tipo de onda, desde las olas del océano hasta la luz. En el caso de la Luz, el apretarse de las ondas cuando un objeto se acerca se percibe un desplazamiento hacia el Azul en el color del objeto; al separarse las ondas cuando un objeto se aleja se descubre como un desplazamiento hacia el rojo.

Lo que en realidad hizo Hubble fue comparar la luz emitida por átomos de elementos conocidos en las galaxias cercanas con la luz de los mismos átomos emitidas en laboratorios terrestres y descubrió que la luz de las galaxias distantes se desplazaba hasta el extremo rojo del espectro, de lo que concluyó que las galaxias se estaban alejando de la Tierra. Al estudiar lo lejos que estaban las galaxias apareció otro modelo, Hubble vio que los datos marcaban una tendencia: cuanto más lejos estaban las galaxias, más elevado era el desplazamiento al rojo.

El descubrimiento de Hubble tiene que ser atribuido en parte, a la buena técnica experimental y en parte a una premonición inspirada en lo que surgiría cuando se pudieran hacer mejores mediciones con aparatos más modernos y tecnologías más avanzadas. Así, especulando, fuimos mejorando los telescopios en las distintas partes del Mundo hasta que llegó el Hubble, el Telescopio Espacial al que se le pudo el nombre de aquel gran Astrónomo.

No sería justo cerrar esta pequeña reseña sin mencionar… ¡Lo que sigue!

“¿Por qué nace la gente? ¿Por qué muere ¿Y por qué pasa tanto tiempo intermedio llevando relojes digitales?Doug Adams en La guía Hitchhiker para la galaxia.

Ago

26

Recordar es viajar en el Tiempo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Rumores del saber del mundo ~

Clasificado en Rumores del saber del mundo ~

Comments (16)

Comments (16)

A finales del siglo XIX, poca gente sabía con exactitud a qué se dedicaban los “físicos”. El término mismo era relativamente nuevo. En Cambridge, la física se enseñaba como parte del grado de matemáticas.

En este sistema no había espacio para la investigación: se consideraba que la física era una rama de las matemáticas y lo que se le enseñaba a los estudiantes era como resolver problemas.

En la década de 1.870, la competencia económica que mantenían Alemania, Francia, Estados Unidos, y Gran Bretaña se intensificó. Las Universidades se ampliaron y se construyó un Laboratorio de física experimental en Berlín.

Cambridge sufrió una reorganización. William Cavendish, el séptimo duque de Devonshire, un terrateniente y un industrial, cuyo antepasado Henry Cavendish había sido una temprana autoridad en teoría de la gravitación, accedió a financiar un Laboratorio si la Universidad prometía fundar una cátedra de física experimental. Cuando el laboratorio abrió, el duque recibió una carta en la que se le informaba (en un elegante latín) que el Laboratorio llevaría su nombre.

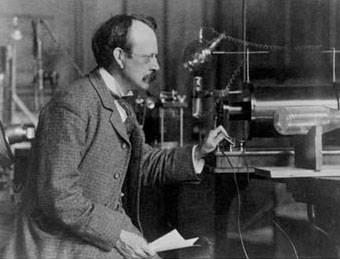

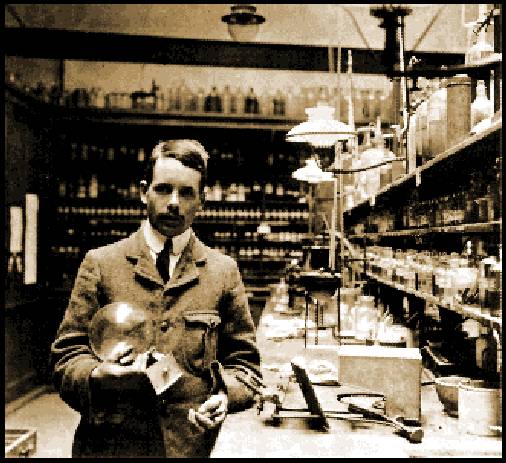

Primer profesor J. J. Thomson como director del laboratorio

Tras intentar conseguir sin éxito atraer primero a William Thomson, más tarde a lord Kelvin (quien entre otras cosas, concibió la idea del cero absoluto y contribuyó a la segunda ley de la termodinámica) y después a Hermann von Helmohltz, de Alemania (entre cuyas decenas de ideas y descubrimientos destaca una noción pionera del cuanto), finalmente se ofreció la dirección del centro a James Clerk Maxwell, un escocés graduado en Cambridge. Este fue un hecho fortuito, pero Maxwell terminaría convirtiéndose en lo que por lo general se considera el físico más destacado entre Newton y Einstein. Su principal aportación fue, por encima de todo, las ecuaciones matemáticas que permiten entender perfectamente la electricidad y el magnetismo. Estas explicaban la naturaleza de la luz, pero también condujeron al físico alemán Heinrich Hertz a identificar en 1.887, en Karlsruhe, las ondas electromagnéticas que hoy conocemos como ondas de radio.

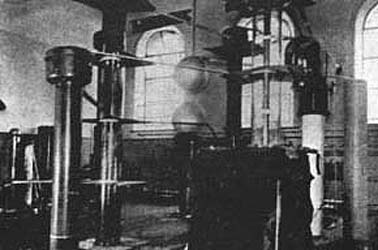

En el Laboratorio Cavendish de la Universidad de Cambridge, Cockcroft y Walton construyeron este acelerador de 500 kilovolts en 1932. Si lo comparamos con el LHC del CERN nos podemos dar cuenta de cómo la Ciencia ha ido avanzando en relativamente tan poco tiempo y, desde entonces hemos alcanzado un nivel que nos permite trabajar con 14 TeV, una energía de todo punto imposible e impensable en aquellos primeros tiempos.

Maxwell también creó un programa de investigación en Cavendish con el propósito de idear un estándar preciso de medición eléctrica, en particular la unidad de resistencia eléctrica, el ohmio. Esta era una cuestión de importancia internacional debido a la enorme expansión que había experimentado la telegrafía en la década de 1.850 y 1.860, y la iniciativa de Maxwell no solo puso a Gran Bretaña a la vanguardia de este campo, sino que también consolidó la reputación del Laboratorio Cavendish como un centro en el que se trataban problemas prácticos y se ideaban nuevos instrumentos.

Tubo de vacío usado por JJ Thomson en uno de los experimentos realizados para descubrir el electrón. Expuesto en el museo del laboratorio Cavendish. A este hecho es posible atribuir parte del crucial papel que el laboratorio iba a desempeñar en la edad dorada de la Física, entre 1.897 y 1.933. Los científicos de Cavendish, se decía, tenían “sus cerebros en la punta de los dedos.”

Maxwell murió en 1.879 y le sucedió lord Rayleigh, quien continuó su labor, pero se retiró después de cinco años y, de manera inesperada, la dirección pasó a un joven de veintiocho años, Joseph John Thomson, que a pesar de su juventud ya se había labrado una reputación en Cambridge como un estupendo físico-matemático. Conocido universalmente como J.J., puede decirse que Thomson fue quien dio comienzo a la segunda revolución científica que creó el mundo que conocemos.

Ernest Rutherford

Se dedicó al estudio de las partículas radioactivas y logró clasificarlas en alfaa (α), beta (β) y gamma (γ). Halló que la radiactividad iba acompañada por una desintegración de los elementos, lo que le valió ganar el Premio Nobel de Química de 1908. Se le debe un modelo atómico con el que probó la existencia de núcleol en los átomos, en el que se reúne toda la carga positiva y casi toda la masa del átomo. Consiguió la primera transmutación artificial con la colaboración de su discípulo Frederick Soddy.

Henry Cavendish en su Laboratorio

La primera revolución científica comenzó con los descubrimientos de Copérnico, divulgados en 1.543, y los de Isaac Newton en 1.687 con su Gravedad y su obra de incomparable valor Principia Matemática, a todo esto siguió los nuevos hallazgos en la Física, la biología y la psicología.

Pero fue la Física la que abrió el camino. Disciplina en permanente cambio, debido principalmente a la forma de entender el átomo (esa sustancia elemental, invisible, indivisible que Demócrito expuso en la Grecia antigua).

John Dalton

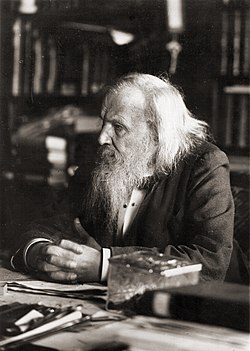

En estos primeras décadas del siglo XIX, químicos como John Dalton se habían visto forzados a aceptar la teoría de los átomos como las unidades mínimas de los elementos, con miras a explicar lo que ocurría en las reacciones químicas (por ejemplo, el hecho de que dos líquidos incoloros produjeran, al mezclarse, un precipitado blanco). De forma similar, fueron estas propiedades químicas y el hecho de que variaran de forma sistemática, combinada con sus pesos atómicos, lo que sugirió al ruso Dimitri Mendeleyev la organización de la Tabla Periódica de los elementos, que concibió jugando, con “paciencia química”, con sesenta y tres cartas en su finca de Tver, a unos trescientos kilómetros de Moscú.

Pero además, la Tabla Periódica, a la que se ha llamado “el alfabeto del Universo” (el lenguaje del Universo), insinuaba que existían todavía elementos por descubrir.

Dimitri Mendeléiev en 1897

La tabla de Mendeleyev encajaba a la perfección con los hallazgos de la Física de partículas, con lo que vinculaba física y química de forma racional: era el primer paso hacia la unificación de las ciencias que caracterizaría el siglo XX.

En Cavendish, en 1.873, Maxwell refinaría la idea de átomo al introducir la idea de campo electromagnético (idea que tomó prestada de Faraday), y sostuvo que éste campo “impregnaba el vacío” y la energía eléctrica y magnética se propagaba a través de él a la velocidad de la luz. Sin embargo, Maxwell aún pensaba en el átomo como algo sólido y duro y que, básicamente, obedecían a las leyes de la mecánica.

El problema estaba en el hecho de que, los átomos, si existían, eran demasiado pequeños para ser observados con la tecnología entonces disponible.

Esa situación empezaría a cambiar con Max Planck, el físico alemán que, como parte de su investigación de doctorado, había estudiado los conductores de calor y la segunda ley termodinámica, establecida originalmente por Rudolf Clausius, un físico alemán nacido en Polonia, aunque lord Kelvin también había hecho algún aporte.

El joven Max Planck

Clausius había presentado su ley por primera vez en 1.850, y esta estipulaba algo que cualquiera podía observar, a saber, que cuando se realiza un trabajo la energía se disipaba convertida en calor y que ese calor no puede reorganizarse en una forma útil. Esta idea, que por lo demás parecería una anotación de sentido común, tenía consecuencias importantísimas.

Dado que el calor (energía) no podía recuperarse, reorganizarse y reutilizarse, el Universo estaba dirigiéndose gradualmente hacia un desorden completo:

cántaro roto…

Una casa que se desmorona nunca se reconstruye así misma, una botella rota nunca se recompone por decisión propia. La palabra que Clausius empleó para designar este fenómeno o desorden irreversible y creciente fue “entropía”: su conclusión era que, llegado el momento, el Universo moriría.

En su doctorado, Planck advirtió la relevancia de esta idea. La segunda ley de la termodinámica evidenciaba que el tiempo era en verdad una parte fundamental del Universo, de la física. Sea lo que sea, el tiempo es un componente básico del mundo que nos rodea y se relaciona con la materia de formas que todavía no entendemos.

La noción de tiempo implica que el Universo solo funciona en un sentido, hacia delante, nunca se está quieto ni funciona hacia atrás, la entropía lo impide, su discurrir no tiene marcha atrás. ¿No será nuestro discurrir lo que siempre marcha hacia delante, y, lo que tenemos por tiempo se limita a estar ahí?

En el Laboratorio Cavendish, me viene a la memoria que fue allí, donde Thomson, en 1.897, realizó el descubrimiento que vino a coronar anteriores ideas y trabajos de Benjanmin Franklin, Euge Goldstein, Wilhelm Röntgen, Henri Becquerel y otros. El descubrimiento del electrón convirtió a la física moderna en una de las aventuras intelectuales más fascinantes e importantes del mundo contemporáneo.

Thomson descubrió el electrón.

Los “corpúsculos”, como Thomson denominó inicialmente a estas partículas, hoy conocidas como electrones, condujo de forma directa al trascendental avance realizado una década después por Ernest Rutherford, quien concibió el átomo como una especie de “sistema solar” en miniatura, con los electronesdiminutos orbitando alrededor de un núcleo masivo como hacen los planetas alrededor del Sol. Rutherford demostró experimentalmente lo que Einstein había descubierto en su cabeza y revelado en su famosa ecuación, E = mc2 (1905), esto es que la materia y la energía eran esencialmente lo mismo.

Todo aquello fue un gran paso en la búsqueda del conocimiento de la materia. El genio, la intuición y la experimentación han sido esenciales en la lucha del ser humano con los secretos, bien guardados, de la N

emilio silvera

Totales: 74.883.790

Totales: 74.883.790 Conectados: 52

Conectados: 52

los

los