Jun

5

Distancias inalcanzables de forma física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo dinámico ~

Clasificado en El Universo dinámico ~

Comments (0)

Comments (0)

En el espacio exterior, el cosmos, lo que conocemos por universo, las distancias son tan enormes que se tienen que medir con unidades espaciales como el año luz (distancia que recorre la luz en un año a razón de 299.792.458 metros por segundo). Otra unidad ya mayor es el pársec (pc), unidad básica de distancia estelar correspondiente a una paralaje trigonométrica de un segundo de arco (1”). En otras palabras, es la distancia a la que una Unidad Astronómica (UA = 150.000.000 Km) subtiende un ángulo de un segundo de arco. Un pársec es igual a 3’2616 años luz, o 206.265 Unidades Astronómicas, o 30’857×1012 Km. Para las distancias a escalas galácticas o intergalácticas se emplea una unidad de medida superior al pársec, el kilopársec (Kpc) y el megapársec (Mpc).

Para tener una idea aproximada de estas distancias, pongamos el ejemplo de nuestra galaxia hermana, Andrómeda, situada (según el cuadro anterior a 725 kilopársec de nosotros) en el Grupo local a 2’3 millones de años luz de la Vía Láctea.

¿Nos mareamos un poco?

| 1 segundo luz | 299.792’458 Km |

| 1 minuto luz | 18.000.000 Km |

| 1 hora luz | 1.080.000.000 Km |

| 1 día luz. | 25.920.000.000 Km |

| 1 año luz | 9.460.800.000.000 Km |

| 2’3 millones de años luz | 21.759.840.000.000.000.000 Km |

¡Una barbaridad!

Andrómeda, la hermana mayor de la Vía Láctea, situada a 2,3 años-luz de nosotros, viaja en nuestra dirección a una buena velocidad. Sin embargo, se calcula que nos no llegará hasta nosotros hasta dentro de unos pocos miles de millones de años, casí cuando el Sol esté agotándo su combustible nuclear de fusión para convertirse en una Nebulosa planetaria con una enana blanca en su centro.

Ahí tenemos la imposibilidad física de viajar a otros mundos, y no digamos a otras galaxias. Las velocidades que pueden alcanzar en la actualidad nuestros ingenios espaciales no llegan ni a 50.000 Km/h. ¿Cuánto tardarían en recorrer los 21.759.840.000.000.000.000 Km que nos separa de Andrómeda?

Incluso el desplazarnos hasta la estrella más cercana, Alfa Centauri, resulta una tarea impensable si tenemos en cuenta que la distancia que nos separa es de 4’3 años luz, y un año luz = 9.460.800.000.000 Km.

Muchos son los que han querido imaginar como viajr más rápido que la Luz… ¡Sin superar su velocidad! Todos sabemos, como nos enseñó la Relatividad Especial de Einstein que, la luz, nos marca el límite de la velocidad que se puede alcanzar en el Espacio. Nada podrá nunca viajar más rápido que la luz en el vacío, es decir, más ráipdo que 299.792.458 metros cada segundo. Y, se idean otras formas para poder burlar ese límite y llegar antes que la luz a un determinado lugar. Hasta que no se busque la manera de esquivar la barrera de la velocidad de la luz, los viajes a otros mundos están algo complicados para nosotros.

La única ventaja a nuestro favor: ¡EL TIEMPO! Tenemos mucho, mucho tiempo por delante para conseguir descifrar los secretos del hiperespacio que nos mostrará otros caminos para desplazarnos por las estrella que, en definitiva, será el destino de la humanidad.

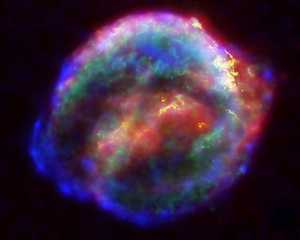

Nuestro Sol, antes de que pasen 4.000 millones de años, comenzará una transición de fase que, de estrella en la secuencia principal de HP, pasará a su fase terminal convirtiéndose en una Gigante roja que, eyectará sus capas exteriores al espacio interestelar formando una Nebulosa planetaria y, la estrella, exenta de la energía de fusión, quedará a merced de la fuerza de Gravedad que la comprimirá hasta límites de una densidad que sólo podrá ser frenada por la degeneración de los electrones. En ese punto, volverá el equilibrio entre dos fuerzas y el proceso se parará dejando una enana blanca con un radio parecido al de la Tierra y una densidad de 109 Kg m3.

El encuentro será digno de contemplar

Antes de que todo eso llegue, tenemos que tener en cuenta que habrá que salvar otro gran escollo que se nos viene encima (nunca mejor dicho), ya que, la Galaxia Andrómeda viene hacia La Vía Láctea a razón de 1.000.000 de Km/h y, aproximadamente en unos 3.000 millones de años la tendremos, irremediablemente, colisionando con nuestra Galaxia, con lo cual, las fuerzas de marea que esas enormes masas puden producir, son de impensable magnitud y, el desenlace tardará varios millones de años en finalizar hasta que de las dos grandes Galaxias del Grupo Local, sólo quede una enorme galaxia elíptica y, en el proceso, habrán nacido un sin fin de nuevas estrellas, otras habrán sido despladas de su regiones y lanzadas a distancias enormes, algunas habrán podido colisionar y, en definitiva, lo que allí pueda ocurrir en el futuro lejano, es de incalculable trascendencia para la Humanidad (si aún sigue aquí para ese tiempo).

Sí, existen muchos lugares a los que, cuando llegue el momento podremos viajar. Sin embargo, necesitamos muchos más conocimientos de los que actualmente tenemos para poder realizar esos viajes “imposibles” en las actuales circunstancias. Estamos comenzando, ahora, a poder realizar los primeros intentos de salir al Espacio, y, para cuando realmente podamos efectuar viajes espaciales, habrán pasado muchos, muchos, muchísimos años. No quiero mencionar, lo que podríamos tardar en dominar viajes hiperespaciales a velocidades superlumínicas. Claro que, la imaginación humana es… ¡”infinita”!

Si esto es así (que lo es), tenemos una buena excusa para pensar en posibles modos de escapar hacia otros mundos lejanos en los que poder asentar a la Humanidad lejos de esos acontecimientos de magnitud (para nosotros) infinita y contra los que nada podremos hacer, excepto, si podemos y buscamos el medio… huir a otros lugares más seguros.

Si, las distancias que nos separan de esos otros mundos parece una barrera difícil de franquear, y, sin embargo, tengo una gran esperanza puesta en que, la Humanidad, la inteligencia de los seres que la compone, y, sobre todo su imaginación, con el tiempo por delante tendrá la oportunidad de buscar esas difíciles soluciones que posibiliten nuestro traslado a las estrellas lejanas.

Para lograr eso, con nuestras limitaciones actuales, no tenemos más remedio que valernos de sondas robotizadas y, en el futuro, serán perfectos robots humanoides que, no tendrán ninguna de nuestras barreras para deambular por el cielo y visitar esas regiones lejanas en las que, posiblemente, se encuentren los planetas idóneos para habitats de seres como nosotros.

Esas son, en realidad, las miras que están puestas en todas esas misiones enviadas a las lunas y planetas cercanos para estudiar su entorno, la atmósfera, la superficie y las radiaciones. Se trata de ir conociendo el entorno y, con los adelantos tecnológicos que ahora mismo tenemos, se hace lo que se va pudiendo y, cada día, se avanza un paso más a la búsqueda de esas soluciones que, ese día muy lejano aún, llegará la debacle a la Tierra y, para entonces, no podremos continuar aquí. La única solución: Escapar a otros mundos.

emilio silvera

Jun

5

Más lejos, más profundo, más simple

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Las teorías de Newton sobre el movimiento y la gravedad, con sus trescientos años de edad siguen proporcionando reglas que son maravillosamente precisas para entender y predecir la forma en que se mueven las cosas a velocidades mucho menores que la de la luz cuando la gravedad es muy débil. En los quince primeros años del siglo XX, Einstein dio con una teoría más profunda que podía tratar con el movimiento rápido y la gravedad intensa cuando la teoría de Newton fallaba. Pero, y esto es crucial, la teoría más ampliam y más profunda de Einstein se convierte en la de Newton cuando los movimientos son lentos y la Gravedad es débil.

Teoría cuántica, o, ¿universos paralelos?

Pasó lo mismo con las teorías cuánticas revolucionarias que se descubrieron en el primer cuarto del siglo XX cuando todos los físicos siguieron el rastro dejado por la semilla dejada por Planck a la que llamó “cuanto” y se simbolizó con la letra h. Aquella nueva teoría ofrecía una descripción más completa que la de Newton del funcionamiento del mundo cuando sondeamos el dominio de lo muy pequeño. Sus predicciones sobre el micromundo no-newtoniano son tremendamente precisas.

Pero una vez más, cuando trabajan con objetos grandes se hacen cada vez más parecidas a la descripción newtoniana. Así es como el núcleo de verdad dentro de una teoría pasada puede permanecer como una parte restrictiva de una teoría nueva y mejor. No parece que vaya a haber más revoluciones cintíficas (que las habrá).

Si consideramos nuestro “almacén” de teorías, podemos ver las interrelaciones entre las viejas y las nuevas. Consioderemos nuestro caso, en el que la mecánica cuántica se convierte en la mecánica newroniana cuando h se aproxima a cero. Este límite corresponde a una situación en la que los aspectos ondulatorios cuánticos de las partículas se hacen despreciables. Por esto podemos confiar plenamente en que la tricentenaria teoría de Newton del movimiento y de la gravedad se enseñaran y se urtilizaran dentro de mil años con la misma eficacia que lo hacemos hoy. Cualquiera que resulte ser la Teoría de Todo final, tendrá una forma restrictiva que describa el movimiento a velocidades mucho menores que la de la luz y, entonces, ahí estará Newton y, de la misma manera, cuando esos movimientos sean cercanos a c, Einstein también se hará presernte. Es decir, en la futura teoría subyacen las ideas de Newton y de Einstein como cimientis de esa nueva teoría que vendrá.

Fotografía del Congreso en el Hotel Metropole. Sentados, de izquierda a derecha: W. Nernst, M. Brillouin, E. Solvay (mecenas), H. Lorentz, E. Warburg, J. Perrin, W. Wien, M. Curie y H. Poincaré. De pie, de izquierda a derecha: R. Goldschmidt, M. Planck, H. Rubens,A. Sommerfeld, F. Lindemann (secretario), M. de Broglie (secretario), M. Knudsen, F. Hasenöhrl, G. Hostelet, E. Herzen, J.H. Jeans, E. Rutherford, H. Kamerlingh Onnes, A. Einstein y P. Langevin. En esta situación llegó el histórico Congreso Solvay.

Se cuenta que en un descanso del aquel famoso Congreso Solvay, Einstein y Henri Poincaré se encontraron un momento sólos y, se entabló entre ellos, la conversación siguiente:

-Einstein: Sabe usted, Henri, en un tiempo estudié matemáticas, pero lo dejé por la Física.

-Poincaré: Oh, ¿de verdad Albert? ¿Y por qué?

-Einstein: Porque aunque podía distinguir los enunciados verdaderos de los falsos, no podía distinguir que hechos eran importantes.

.Poincaré: Eso es muy interesante, Albert, Porque originalmente yo estudié Física, pero la dejé por las matemáticas.

.Einstein: ¿De verdad? ¿Por qué?

.Poncaré: Porque no podía distinguir cuáles de los hechos importantes eran verdaderos.

Podeis sacar una conclusión.

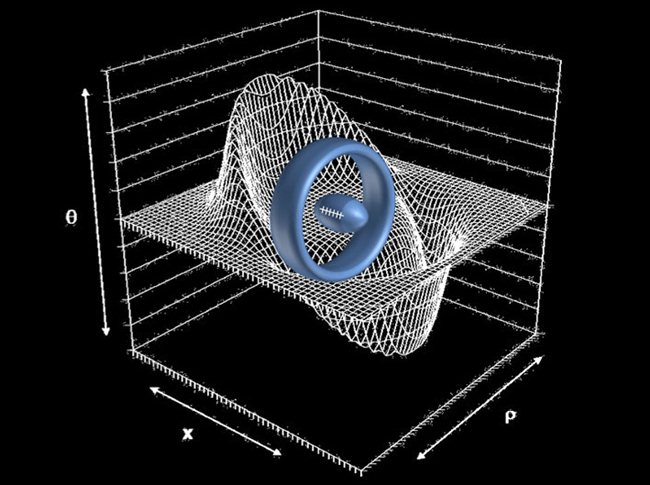

Donde esté presente la materia…, lo estará la Gravedad

Aquí la gravedad está presente y es la responsable de mantener unidos todos los objetos que en la imagen podemos contemplar, sus masas titan las unas de las otras y todo se mantiene unido. La fuerza de la gravedad tiene su mayor potencia, próximo al elemento que la origina, ya sea un átomo o un planeta, pero sus lineas de fuerza, aunque van disminuyendo con la distancia son infinitas, que no por débiles se deben despreciar. Lo que ocurre en el universo es que cualquier fuerza de gravedad mas fuerte, aparentemente anula las fuerzas débiles pero si el universo estuviera vacío de materia y de energía, dos átomos en ambos extremos del universo terminarían por atraerse. La fuerza de gravedad de un elemento viene determinado por el conjunto de átomos que lo forman comportándose como un solo elemento.

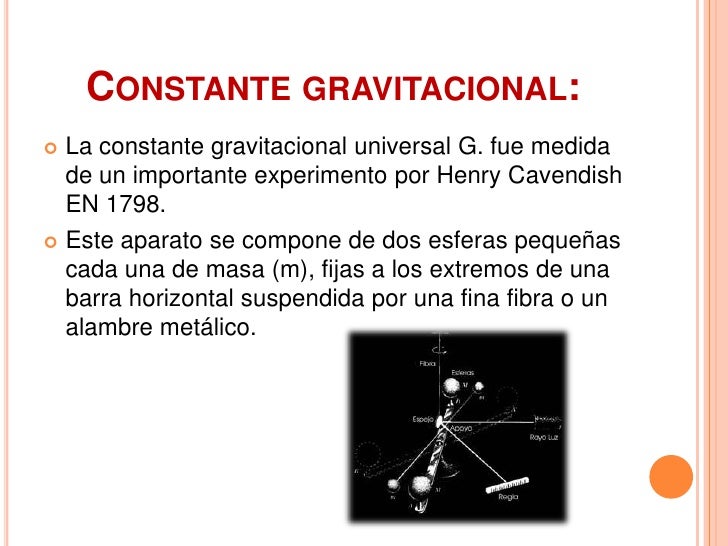

La principal sospechosa de variaciones minúsculas ha sido siempre la constante Gravitatoria, G. La Gravedad es con mucho la fuerza la fuerza más débil de la Naturaleza y la menos estrechamente sondeada por el experimento. Si se buscan los valores conocidos de las constantes principales en la contraportada de un libro de texto de Física podemos descubrir que G aparece especificada con muchas menos cifras decimales que c, h, o e. Aunque G a soportado asaltos a su constancia durante mucho tiempo, los ataques más rcientes han sido lanzados sobre α (alfa), la constante de estructura fina de la que hablamos ayer. está ahora de mucha actualidad debido a unos experimentos que se han hecho observando y midiendo la luz de unos quásares lejanos. Y, como ayer os decía, la constante de estructura fina liga la velocidad de la luz, la constante de Planck y la carga del electrón. Y, todo ello hace que, si varía en una pequerña proporción, el Universo cambiaría.

¿Quién será el que resuelve este misterio?

emilio silvera

Jun

5

¡La `Primera luz del Universo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Luz esconde muchos secretos ~

Clasificado en La Luz esconde muchos secretos ~

Comments (0)

Comments (0)

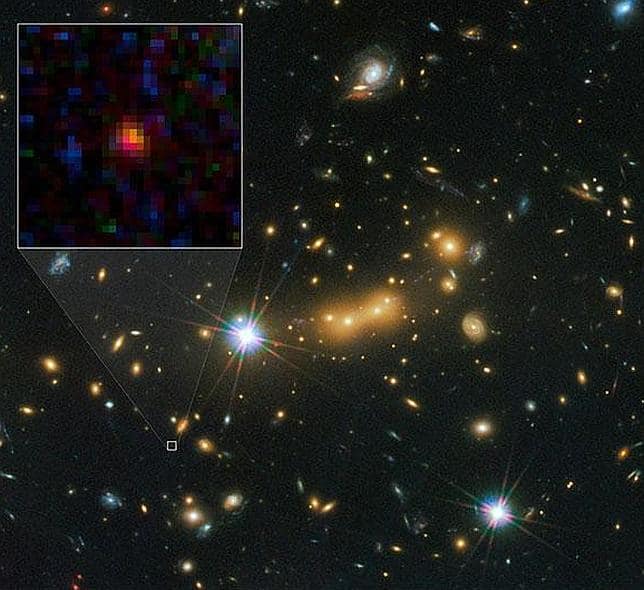

Estamos más cerca de entender como se “encendió” la primera luz del UNiverso

La galaxia más lejana en el tiempo y en el espacio ha dado nuevas pistas para entender cómo el Cosmos dejó de ser un lugar oscuro y se volvió transparente, permitiendo que luego se iluminaran las primeras estrellas y galaxias

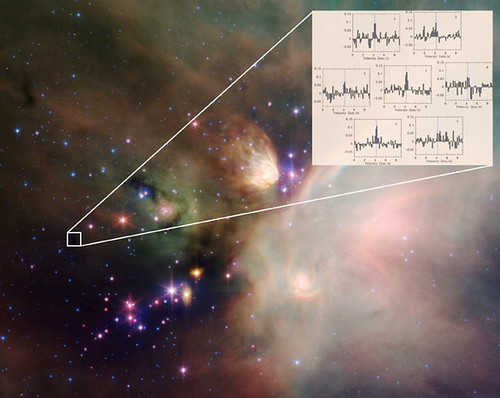

El telescopio ALMA ha detectado oxígeno ionizado en una galaxia muy joven situada a 13.100 millones de años luz. Este hallazgo ayudará a entender cómo se formaron las primeras galaxias y estrellas – NAOJ

En el año 2012 el telescopio Subaru, del Observatorio Nacional de Japón (NAOJ) y situado en Hawaii, logró ver algo a la mayor distancia hasta la fecha. Gracias a sus espejos de 8,2 metros de diámetro, logró captar una galaxia, llamada SXDF-NB1006-2, cuya principal peculiaridad es estar situada a una distancia de 13.100 millones de años luz. Aparte del récord, esta lejana galaxia se convirtió en una ventana al Universo más remoto en el tiempo: aquel que existió hace 13.100 millones de años, y «solo» 700 millones de años después del Big Bang.

En un primer momento se encontraron trazas de hidrógeno, el material básico con el que se construyeron las primeras galaxias. Pero los investigadores quisieron también saber si había algo más. Gracias al potente telescopio ALMA, situado en Chile, los científicos encontraron evidencias de la presencia de oxígeno, un elemento que nunca se había descubierto tan lejos y que podría servir para explicar un fenómeno conocido como «reionización cósmica». El hallazgo ha sido publicado este jueves en Science.

«Ver elementos pesados en el Universo temprano es esencial para saber cómo se formaron estrellas en ese periodo», ha dicho Akio Inoute, investigador en la Universidad Osaka Sangyo, Japón, y principal autor del estudio. Y no solo eso: «Estudiar elementos pesados nos da también una pista para entender cómo se formaron las galaxias y qué causó la reionización cósmica», ha añadido.

¿En qué consiste ese fenómeno? Hoy en día el Universo es rico en una gran variedad de elementos y está repleto de estrellas y galaxias. Pero no siempre fue así. Cientos de millones de años después del Big Bang, el Universo era un lugar muy oscuro en el que no había estrellas ni galaxias. Fue la «reionización cósmica» la que lo cambió todo.

El fin de la «Edad oscura»

Se liberaron las fotones y se hizo la luz. El Universo dejó de ser opaco

Antes de eso, el Universo estaba sumido en un periodo conocido como «Edad oscura». Por entonces, centenares de millones de años después del Big Bang, la materia estaba más apelmazada y caliente que hoy en día, y estaba compuesta por protones, neutrones y electrones. Con el tiempo esta «sopa» se fue enfriando, de modo que los protones y los neutrones comenzaron a combinarse para generar hidrógeno y helio ionizados, los elementos más básicos y sencillos de toda la tabla periódica. A medida que estos elementos fueron atrayendo los electrones, el espacio dejó de ser opaco para la luz y se volvió transparente. Y así, ¡se hizo la luz!

Poco después del Big Bang, el universo se volvió completamente oscuro. El intenso y seminal evento que creó el cosmos produjo tanto gas caliente y espeso que la luz quedó completamente atrapada.

La explicación. Mucho más tarde, tal vez hasta mil millones de años después del Big Bang, el universo se expandió, se volvió más transparente y finalmente se llenó de galaxias, planetas, estrellas y otros objetos que emiten luz visible.

Todo esta etapa de la «reionización cósmica» es el periodo más antiguo en la vida del Universo al que se puede acceder a través de telescopios, puesto que antes de eso no había luz (al menos si las teorías no se equivocan). Por suerte, muchos científicos consideran que es posible ver cosas aún más antiguas recurriendo a las ondas gravitacionales.

Sea como sea, parece que fue cientos de millones de años después de esta reionización cósmica, cuando las condiciones permitieron que se formaran las primeras fuentes de luz: las estrellas, unas inmensas centrales nucleares capaces de fundir hidrógeno y helio y producir átomos más pesados. La «Edad oscura» del Universo tocaba a su fin.

A pesar de la importancia de este fenómeno, que cambió por completo la naturaleza del Universo, lo cierto es que no se sabe mucho acerca de cómo o por qué ocurrió. Por fortuna, el telescopio ALMA permitió obtener algunas pistas.

El pasado más remoto al alcance

Todo comenzó en junio de 2015, cuando se logró detectar la luz procedente del oxígeno ionizado en SXDF-NB1006-2. Con este vistazo a un momento antiquísimo del Universo, los investigadores se llevaron varias sorpresas. «Algo extraño podría estar ocurriendo en esa galaxia», dijo Inoue.

¿Cuál es el motivo de su sorpresa? Básicamente, haber encontrado una cantidad total de elementos pesados de solo el 10 por ciento de la que hay en el Universo actual, y, además, una cantidad muy pequeña de polvo interestelar. Por último, tampoco se encontraron lecturas de carbono, un elemento que es clave para justificar la posibilidad de que una estrella pueda estar implicada en la «reionización cósmica».

Estrellas contra la oscuridad

Que no haya carbono ni polvo indica que las estrellas gigantes que hay en la región, una docena de veces más pesadas que el sol y que producen una intensa luz ultravioleta, podrían haber sido capaces de tener un papel protagonista en la reionización. El motivo es que tanto el polvo como el carbono pueden frenar la luz. Por eso, tanto estas estrellas como esta galaxia podrían ser los protagonistas típicos de una historia que fue la que permitió que el Universo fuera dejando atrás la «Edad oscura».

«Este es el primer paso para entender qué tipo de objetos causaron el fenómeno de la”reionización cósmica”», ha explicado Yoichi Tamura, investigador de la Universidad de Tokio. «Nuestras próximas observaciones con ALMA ya han comenzado. Si conseguimos observaciones de mayor resolución podremos ver la distribución y el movimiento del oxígeno en la galaxia y conseguir información crucial para entender sus propiedades».

Explorar ese rincón tan lejano del Universo no ha sido sencillo: no ha bastado con apuntar el telescopio en la dirección correcta; ha hecho falta hacer complejas simulaciones de ordenador para tratar de predecir el brillo de esas regiones tan remotas en el tiempo y en el espacio.

En este caso, cuanto más lejos se mira más atrás en el tiempo se llega. Aparte de satisfacer la gran curiosidad de entender cómo se formó y cómo se originó el Universo, gracias a trabajos como este también se puede entender cómo se formó la materia, y qué secretos esconde aún en su interior.

Reportaje de Prensa

Jun

4

¿La Naturaleza! ¡Es la misma en todas partes!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Naturaleza ¡Es sabia! ~

Clasificado en La Naturaleza ¡Es sabia! ~

Comments (1)

Comments (1)

La Música que incide en nosotros

¿Estamos ahora en condiciones de comprender por qué, si existieran animales en otros planetas capaces de moverse a través de sus mares, de su atmósfera o de sus tierras, sería muy probable que, también ellos, tengan simetría bilateral? En otro planeta, igual que en la Tierra, atuarían los mismos factores que darían lugar a la mencionada simetría. La Gravedad produciría diferencias esenciales entre arriba y abajo, y la locomoción originaría marcadas diferencias entre frente y dorso. La ausencia de asimetrías fundamentales en el entorno permitiría que la simetría izquierda derecha de los cuerpos permaneciera inalterada.

No pocas veces contemplamos escenas que son dignas del mayor asombro

¿Podemos ir más allá? ¿Podemos esperar semejanzas más concretas entre la vida extraterrestre y la vida tal como la conocemos? Creo que sí, que de la misma manera que existen planetas como la Tierra que tendrán paisajes parecidos a los que podemos contemplar en nuestro mundo, de igual forma, dichos planetas podrán albergar formas de vida que, habiendo surgido en condiciones similares a las nuestras de Gravedad, Magnetismo, Radiación… Habrán seguido el mismo camino que tomamos nosotros y los otros seres que en la fauna terrestre nos acompañan.

¡Sorprendente Naturaleza!

En los extraños mares de otros planetas, sin tener en cuenta la composición química, es difícil imaginar que la evolución de lugar a una forma más sencilla de locomoción que la que se produce ondulando colas y aletas. Que la propia evolución encontraría este tipo de propulsión viene avalado por el hecho de que, incluso en la Tierra, esta evolución se ha produción de manera totalmente espontánea e independiente. Los peces desarrollaron la propulsión cola-aleta; después, ellos mismos evolucionaron hasta convertirse en tipos anfibios que se arrastraban por tierra firme hasta llegar a ser reptiles.

Ornitorrinco: ¿Mamífero, Ave o Reptil? Lo cierto es que, sin movernos de aquí, podemos ver los mismos extraños animales que nos podríamos encontrar en cualquier lugar situado en lejanos sistemas planetarios alumbrados por otras estrellas distintas a nuestro Sol. Allí como aquí en la Tierra, las mismas leyes, las mismas fuerzas, los mismos principios y los mismos ritmos que el Universo impone por el inmenso Cosmos, estarían presentes.

Algunos reptiles fueron evolucionando y dieron lugar a a los mamíferos. Pero cuando algunos de estos últimos regresaron al mar (los que luego han sido ballenas y focas, por ejemplo), sus piernas volvieron a evolucionar hacia las formas de las aletas destinadas a la propulsión por el medio acuático y a la navegación.

De la misma manera, cuesta imaginarse una forma más sencilla de volar por el aire que no sea utilizando las alas. De nuevo, también en la Tierra ha habido una evolución independiente y paralela de las alas. Los reptiles las desarrollaron a causa de la evolución, y llegaron a volar.

Los Pterodáctilos desaparecieron hace unos 100 millones de años

No todas las especies son conocidas por nosotros

Lo mismo hicieron los insectos que los podemos encontrar conformados en las figuras más asombrosas y con estremedidas y ojos que nublan la imaginación, la Naturaleza los ha dotado para que se defiendan en el medio en el que se mueven y les otorgó los atributos necesarios para ello.. Algunos mamíferos, como la ardilla voladora, desarrollaron alas para planear. El murciélago, otro mamífero, desarrolló unas alas excelentes. Algunas especies de peces, que saltan por encima del agua para evitar ser capturadas, se han provisto de alas de planeo.

¡La Naturaleza! ¿Qué no será posible para ella?

En tierra firme, ¿existe algún modelo más sencillo por el cual un animal puede desplazarce que no sea mediante apendices articulados? Las patas de un perro, desde el punto de vista mecánico, no se diferencian demasiado de las de una mosca, pese a haber sufrido evoluciones completamente independientes una de otra. Evidentemente, la rueda es también, una máquina muy sencilla, útil para desplazarce por tierra, pero hay buenas razones técnicas que dificultan su evolución.

Recuerdo haber visto con los chicos cuando eran pequeños, aquella película en la que L. Frank Baum, en Ozma de Oz, inventó una raza de hombres, llamada “los rodadores” , con cuatro piernas como un perro pero que, cada una de ellas terminaba con una ruedecilla que les hacía correr velozmente para causar el pánico en la pequeña protagonista de la fantástica historia. Y, de la misma manera, si nos paramos a observar la Naturaleza y las criaturas que en ella han llegado a sugir, el asombro de tan fantástico logro, nos llega a dejar sin habla.

Pese a que ningún animal utiliza ruedas para autopropulsarse a través del suelo o del aire, sí existen bacterias que se mueven por los líquidos haciendo rodar sus flagelos a modo de propulsores.

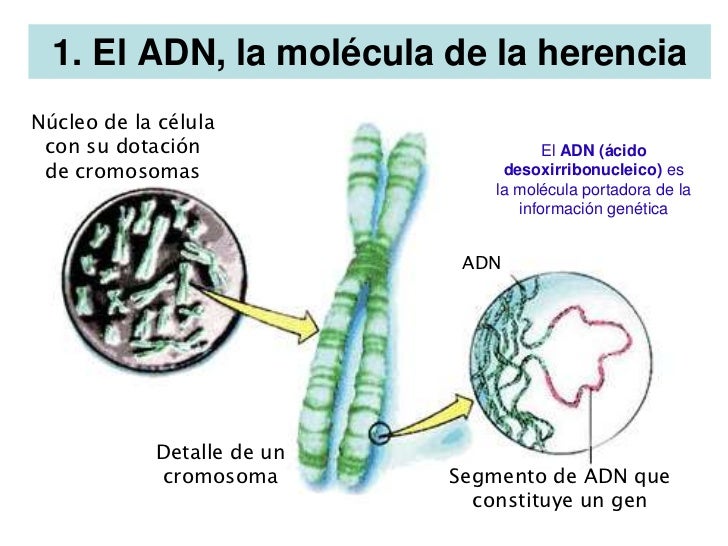

Existen mecanismos de rotación en el interior de las células para esparcir filamentos retorcidos de ADN. Algunos aniumales unicelulares se desplazan a través del agua haciendo que ruede todo su cuerpo. Si estudiamos el mundo microscópico de esos infinitesimales seres, nos quedaríamos maravillados de la inmensa diversidad de mecanismos que utilizan para poder realizar sus actividades cotidianas.

Órganos sensoriales como los ojos y nariz también deben ser como son si la vida evoluciona hacia algún tipo de actividad inteligente avanzada. Las ondas electromagnéticas son ideales para dar al cerebro un cuidadoso “mapa” del mundo exterior. Las ondas de presión, transmitidas por moléculas, proporcionan pistas adicionales de gran valor sobre el entorno, y son captadas por los oídos. Las moléculas emanadas por una sustancia se detectan por la nariz.

Por ahí fuera, cualquier cosa que podamos imaginar… ¡Podría ser posible!

No es imposible que puedan existan culturas avanzadas extraterrestres inteligentes en las que el olfato y el gusto no sean solamente los sentidos dominantes, sino que también sean los que proporcionan los principales medios de comunicación entre individuos. Hasta hace muy pocos años, los biólogos no han descubierto que, en especies animales terrestres, se transmite una gran cantidad de información mediante una transferencia directa de sustancias que ahora se denominan feromonas.

Las formas de vida que existen aquí en la Tierra no son todas conocidas por nosotros y especies que están ocultas a nuestro conocimiento deambulan por el planeta tan ricamente. De la misma manera, en cualquiera de los mundos que son en el Universo, habrá miles de millones de criaturas que, como las de la Tierra, estarán habitando ecosistemas diversos en las mismas condiciones que aquí lo hacen las especies vecinas conocidas o no por nosotros. Un mensaje sí está claro: Todas las criaturas que existen en la Tierra están basadas en el Carbono.

Puesto que tanto la luz como el sonido y las moléculas existen efectivamente en otros planetas, parece que la evolución debería crear también sentidos que explotaran éstos fenómenos como excelente medio de control de las circunstancias de la vida. Aquí en la Tierra, por ejemplo, el ojo no ha tenido menos de tres desarrollos independientes entre sí: Los ojos de los vertebrados, los ojos de los Insectos y los de las diversas clases de moluscos.

¡La Naturaleza! Esa maravilla que, a pesar de la diversidad, hace a todos los seres vivos de la misma cosa: Quarks y Leptones. En este caso, en el planeta Tierra que es lo que conocemos, están basados en el Carbono, el elemento más idóneo para que sean posibles esas combinaciones increíbles.

El pulpo, por ejemplo, tiene un ojo particularmente bueno (de hecho, en algunos aspectos es mejor que el nuestro); posse párpados, córnea, iris, pupila, retina igual que el ojo humano, ¡aunque ha evolucionado de forma completamente independiente del ojo de los vertebrados! Es difícil encontrar un ejemplo más sorprendente de cómo la evolución, actuando según dos líneas de desarrollo desconectadas, puede llegar a crear dos instrumentos nada sencillos que, en esencia, poseen la misma función e idéntica estructura.

Los ojos, igual que otros órganos sensoriales, tienen buenas razones para constituir un tipo de cara habitual. En primer lugar, constituye una gran ventaja que ojos, nariz y oídos estén situados cerca de la boca, pués así son de utilidad para buscar alimentos. Asimismo, resulta ventajoso que estén colocados en las proximidades del cerebro: la sensibilidad está allí, y debe reaccionar para conseguir alimentos, eludir peligros y atisbar el mundo que nos rodea transmitiendo, por medio de los sentidos al cerebro, lo que pasa a nuestro alrededor.

El propio cerebro, al evaluar e interpretar los impulsos sensoriales, lo hace mediante redes eléctricas: una especie de microcomputador de inmensa complejidad. Los filamentos nerviosos que conducen los impulsos eléctricos pueden ser esenciales para el cerebro de los seres vivos avanzados (de ello hemos hablado aquí con frecuencia).

Si la vida en otros planetas llega a alcanzar el nivel de inteligencia de nuestra especie en la Tierra, parece probable que tendría al menos, algunos rasgos humanoides. La ubicación de los dedos en los extremos de los brazos reporta, evidentemente, indudables ventajas. De la misma manera y para su seguridad, el valioso cerewbro debe estar fuertemente encastado y, además, tan alejado del suelo como sea posible, su seguridad es esencial.

Imaginar podemos todo lo que a nuestras mentes pueda acudir, incluso seres con ojos en las puntas de los dedos pero, la Naturaleza es racional, no pocas veces decimos que es sabia y, si pensamos en todo lo que antes hemos leído y visto, no tenemos más remedio que aceptarlo: ¡La Naturaleza es realmente Sabia! y, lo mismo que aquí en la Tierra, habrá sabido crear criaturas en esos mundos lejanos en los que, la diversidad, será tan abundante como lo es en nuestro propio planeta y, lo mismo que en él, en esos otros mundos estará presente la evolución y la adaptación al medio que, en definitiva, son las reglas que rigen cuando la vida está presente.

emilio silvera

Jun

4

El placer de Descubrir: Aventurarse por nuevos caminos.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

La molécula de agua es polar en virtud principalmente de su geometría angular.

Aunque parezca extraño, todos los seres vivos de la Tierra, estamos hechos de la misma cosa y basados en el mismo elemento. De alguna manera, estamos emparentado con todos los seres vivos. Nosotros tuvimos la suerte de poder generar pensamientos. Tenemos que pensar que las moléculas de la vida, están presentes en cualquier Nebulosa del Espacio Interestelar.

¡Ah! ¿Pero sabemos?

Los organismos vivos somos sistemas extremadamente complejos, formados por un elevado número de elementos interrelacionados que deben mantener sus características a lo largo del tiempo, de una generación a otra. Esto supone que debe existir algún mecanismo para que cada elemento de los organismos se elabore de acuerdo a un “plan”, a un modelo de organización establecido, y que ese modelo pueda ser transmitido de una célula a sus descendientes. Esta necesidad de los seres vivos nos acerca a la noción de información genética.

El Universo, la Ciencia…Nosotros.

![[stephan_quinteto_2009_hubble.jpg]](http://3.bp.blogspot.com/_xBXZbW6ivIs/SqpvjP3SBJI/AAAAAAAAEqc/fh3ULAFurbs/s1600/stephan_quinteto_2009_hubble.jpg)

¿Cuantas veces habremos comentado aquí los efectos gravitatorios de las grandes masas del Universo?

“Quien ha visto las cosas presentes ha visto todo, todo lo ocurrido desde la eternidad y todo lo que ocurrirá en el tiempo sin fin; pues todas las cosas son de la misma clase y la misma ”.

Marco Aurelio

Claro que él, quería significar que todo, desde el comienzo del mundo, ha sido igual, sigue unos patrones que se repiten una y otra vez a lo largo del transcurso de los tiempos: el día y la noche, las estaciones, el frío y el calor, el río muerto por la sequía o aquel que, cantarino y rumoroso ve correr sus aguas cristalinas hasta que desembocan en el océano. La Bondad y la maldad… Y, también, el Hombre y la Mujer. Así ha sido desde que podemos recordar y, así continuará siendo.

Para fugarnos de la tierra

un libro es el mejor bajel;

y se viaja mejor en el poema

que en más brioso corcel.

Whitman

“Todo presente de una sustancia simple es naturalmente una consecuencia de su estado anterior, de modo que su presente está cargado de su futuro.”

Leibniz

Niels Bohr, citando a Gohete preguntaba: ¿Cuál es el camino? No hay ningún camino. Está claro el mensaje que tal pregunta y tal respuesta nos quiere hacer llegar, el camino, tendremos que hacerlo nosotros mediante la exploración hacia el futuro en el que está lo que deseamos encontrar. Hay que explorar y arriesgarse para tenemos que ir más allá de las regiones habituales y conocidas que nos tienen estancados siempre en el mismo lugar. ¡Arrisguémosno!

Homero nos contó como Ulises de Ítaca se arriesgó a oír el canto de las sirenas amarrado al palo de la vela mayor de su embarcación. Él no que´ria ser atraído por aquellas fuerzas malignas pero quería sentir los efectos de aquella llamada en lugar seguro. Eso nos lleva a pensar que hay un mensaje en el pasaje de Homero: Arriesgarse… ¡Sí! Pero con las precauciones necesarias. Así que, cuidado con los Robots, con los experimentos científicos de todo tipo, y, sobre todo, no debemos creer que lo sabemos todo. Tenemos que ser conscientes de que, el peligro nos acecha por todas partes.

Pero, no cabe duda alguna de que, el acto de exploración modifica la perspectiva del explorador; Ulises, Marco Polo y Colón habían cambiado cuando volvieron a sus lugares de partida . Lo mismo ha sucedido en la investigación científica de los extremos en las escalas, desde la grandiosa extensión del espacio cosmológico hasta el mundo minúsculo y enloquecido de las partículas subatómicas.

La galaxia conocida por el nombre de Bella Durmiente

Una bella galaxia espiral de cien mil años-luz de diámetro que podemos comparar con…¡Un átomo! El tema de las medidas es relativo y todo se supedita a su ámbito natural, cada cosa tiene la medida que requiere su funciòn en el Universo, desde un átomo hasta una galaxia.

En ambos “universos” existe una descomunal diferencia en los extremos de las escalas. Sin embargo, la inmensa galaxia de arriba no sería posible sin la existencia de infinitesimal átomo de abajo. ¡Todo lo grande está hecho de cosas pequeñas!

Así que, cuando hacemos esos viajes, irremediablemente nos cambian, y, desde luego, desafían muchas de las concepciones científicas y filosóficas que, hasta ese momento, más valorábamos. Algunas tienen que ser desechadas, como el bagaje que se deja atrás en una larga travesía por el desierto. Otras tienen que ser modificadas y reconstruidas hasta quedar casi irreconocibles, ya que, lo que hemos podido ver en esos viajes, lo que hemos descubierto, nos han cambiado por completo el concepto y la perspectiva que del mundo teníamos, conocemos y sabemos.

La exploración del ámbito de las galaxias extendió el alcance de la visión humana en un factor de 1026veces mayor que la escala humana, y produjo la revolución que identificamos con la relatividad, la cual reveló que la concepción newtoniana del mundo sólo era un parroquianismo en un universo más vasto donde el espacio es curvo y el tiempo se hace flexible.

La exploración del dominio subatómico nos llevó lejos en el ámbito de lo muy pequeño, a 10-15 de la escala humana, y también significó una revolución. fue la Física cuántica que, transformó todo lo que abordó.

La teoría cuántica nació en 1900, Max Planck comprendió que sólo podía explicar lo que llamaba la curva del cuerpo negro -el espectro de energía que genera un objeto de radiación perfecta- si abandonaba el supuesto clásico de que la emisión de energía es continua, y lo reemplazó por la hipótesis sin precedentes de que la energía se emite en unidades discretas. Planck llamó cuantos a estas unidades.

1) Figura animada que representa un rayo de luz incidiendo sobre un cuerpo negro hasta su total absorción. 2) En la gráfica se representa la intensidad de la radiación emitida por el cuerpo negro en función de la longitud de onda a diferentes temperaturas. El máximo de la curva aumenta al ir hacia menores longitudes de onda (Ley de Wien). Se compara con el modelo clásico de Rayleigh-Jeans a altas temperaturas (5000 K) comprobándose la llamada catástrofe del ultravioleta

La constante de Planck es una constante física que desempeña un papel central en la teoría de la mecánica cuántica y recibe su nombre de su descubridor, Max Plancc, uno de los padres de dicha teoría. Denotada como  , es la constante que frecuentemente se define como el cuanto elemental de acción.Planck la denominaría precisamente «cuanto de acción»

, es la constante que frecuentemente se define como el cuanto elemental de acción.Planck la denominaría precisamente «cuanto de acción»

Fue inicialmente propuesta como la constante de proporcionalidad entre la energía  de un fotón y la frecuencia

de un fotón y la frecuencia  de su onda electromagnética asociada. Esta relación entre la energía y la frecuencia se denomina «relación de Planck»:

de su onda electromagnética asociada. Esta relación entre la energía y la frecuencia se denomina «relación de Planck»:

La constante de proporcionalidad h es conocida como la constante de Planck. La relación cuantificada de la naturaleza de la luz desempeña un papel importante mediante la comprensión de fenómenos tales como el efecto fotoeléctrico, y la ley de Planck de la radiación del cuerpo negro. Véase también el postulado de Planck.mmg.

La luz puede ser caracterizada usando varias magnitudes espectrales, como la frecuencia ν, la longitud de onda λ, el número de onda, y sus equivalentes angulares (frecuencia angular ω, longitud de onda angular y número de onda angular k). Estas cantidades están relacionadas de la siguiente manera:

por lo que la relación de Planck puede tomar el siguiente estándar de forma:

así como la siguiente forma angular:

El estándar de las formas hacen uso de la constante de Planck h. Las formas angulares hacen uso de la reducción de Planck, la constante ħ = h2π. Aquí c es la velocidad de la luz.

Esto es una consecuencia directa de la relación de Planck–Einstein.

Planck definió a “sus” cuantos en términos del “cuanto de acción”, simbolizado por la letra h que ahora, se ha convertido en el símbolo de una constante, la constante de Planck, h. Planck no era ningún revolucionario – a la edad de cuarenta y dos años era un viejo, juzgado por patrones de la ciencia matemática y, además, un pilar de la elevada cultura alemana del siglo XIX-, pero se percató fácilmente de que el principio cuántico echaría abajo buena de la física clásica a la que había dedicado la mayor parte de su carrera. “Cuanto mayores sean las dificultades -escribió-…tanto más importante será finalmente para la ampliación y profundización de nuestros conocimientos en la física.”

Sus palabras fueron proféticas: cambiando y desarrollándose constantemente, modificando su coloración de manera tan impredecible como una reflexión en una burbuja de , la física cuántica pronto se expandió practicamente a todo el ámbito de la física, y el cuanto de acción de Planck, h llegó a ser considerado una constante de la Naturaleza tan fundamental como la velocidad de la luz, c, de Einstein.

Dos buenos amigos, dos genios. Ellos veían lo que otros no podían y, sin embargo, sus dos teorías no han podido compatibilizarse hasta el momento. La Gravedad y la cuántica siguen caminos separados e incompatibles. Precisamente por eso, la Gravedad no quiere estar en el Modelo Estándar.

Max Planck es uno de los científicos a los que más veces se le han reconocido sus méritos y, su , está por todas partes: La Constante de Planc, las Unidades de Planck, El cuanto de Planck, la Radiación de Planck, El Teimpo de Planck, la masa de Planck, la Energía de Plancik, la Longitud de Planck… ¡Todo merecido!

Confinados en nuestro pequeño mundo, una mota de polvo en la inmensidad de una Galaxia grandiosa que, a su vez, forma parte de un universo “infinito”, hemos podido darnos traza para poder saber, a pesar de las enormes distancias, sobre lo que existe en regiones remotas del Universo. Un Universo formado por Supercúmulos de galaxias que formadas en grupos conforman la materia visible, y, dentro de cada una de esas galaxias, como si de universos se tratara, se reproducen todos los objetos y fenómenos que en el Universo son.

The Scale of the Universe 2 – HTwins.net

Sigamos con la escala del Universo conocido y hagamos un pequeño esquema que lo refleje: El Universo Observable, la mayor escala que abarca más de 100 mil trillones de kilómetros (según nos cuenta Timothy Ferris:

Radio en metros Objetos característicos

1026 Universo observable

1024 Supercúmulos de Galaxias

1023 Cúmulos de Galaxias

1022 Grupo de Galaxias (por ejemplo el Grupo Local)

1021 Galaxia La Vía Láctea

Nube Molecular gigante muy masiva, de gas y polvo compuesta fundamentalmente de moléculas con diámetro típico de 100 a.l. Tienen masa de diez millones de masas solares (moléculas de Hidrógeno (H2) el 73% en masa), átomos de Helio (He, 25%), partículas de polvo (1%), Hidrógeno atómico neutro (H I, del 1%) y, un rico coctel de moléculas interestelares. En nuestra galaxia existen al menos unas 3000 Nubes Moleculares Gigantes, estando las más masivas situadas cerca de la radiofuente Sagitario B en el centro Galáctico.

1018 Nebulosas Gigantes, Nubes Moleculares

1012 Sistema Solar

1011 Atmósfera externa de las Gigantes rojas

Aunque a una Unidad Astronómica de distancia (150 millones de Kilómetros de la Tierra), el Sol caliente el planeta y nos da la vida

109 El Sol

108 Planetas Gigantes Júpiter

107 Estrellas enanas, planetas similares a la Tierra

105 Asteroides, núcleos de cometas

104 Estrellas de Neutrones

Los seres humanos son parte del Universo que queremos descubrir.

1 Seres Humanos

10-2 Molécula de ADN (eje largo)

10-5 Células vivas

Células vivas

10-9 Molécula de ADN (eje corto)

10-10 Átomos

10-14 Núcleos de átomos pesados

10-15 Protones y Neutrones

10-35 Longitud de Planck: cuanto de espacio; radio de partículas sin dimensiones = la cuerda.

Es la escala de longitud a la que la descripción clásica de la Gravedad cesa de ser válida y debe ser tenida en la mecánica cuántica. Está dada por la ecuación de arriba, donde G es la constante gravitacional, ħ es la constante de Planck racionalizada y c es la velocidad de la luz. El valor de la longitud de Planck es del orden de 10-35 m (veinte órdenes de magnitud menor que el tamaño del protón 10-15 m).

Me llama la atención y me fascina la indeterminación que está inmersa en el mundo cuántico. La indeterminación cuántica no depende del aparato experimental empleado investigar el mundo subatómico. Se trata, en la medida de nuestro conocimiento, de una limitación absoluta, que los más destacados sabios de una civilización extraterrestre avanzada compartirían con los más humildes físicos de la Tierra.

Por muy avanzados que pudieran estar, ellos también estarían supeditados al Principio de Incertidumbre o Indeterminación cuántica, y, como nosotros, cuando trataran de encontrar (sea cual fuese las matemáticas o sistemas que emplearan para hallarlo) el resultado de la constante de estructura fina, la respuesta sería la misma: 137, puro y adimensional.

Todo esto nos ha llevado a la más firme convicción definir la visión del mundo de la física que nos revelaba que no sólo la materia y la energía sino que también el conocimiento están cuantizados. Cuando un fotón choca con un átomo, haciendo saltar un electrón a una órbita más elevada, el electrón se mueve de la órbita inferior a la superior instantáneamente, sin tener que atravesar el espacio intermedio. Los mismos radios orbitales están cuantizados, y el electrón simplemente deja de existir en un punto para aparecer simultáneamente en otro. Este es el famoso “salto cuántico” que tanto desconcierta, y no es un mero problema filosófico, es una realidad que, de , no hemos llegado a comprender.

No, esto no es un salto cuántico. Simplemente le tocó la Lotería

Pero, ¿quién sabe? Quizás un día lejano aún en el tiempo, cuando descubramos el secreto que salto cuántico nos esconde, poderemos aprovechar la misma técnica que emplea la Naturaleza con los electrones hacer posible que se transporten de un lugar a otro sin tener que recorrer las distancias que separan ambos destinos.

Estaría bien poder trasladarse las estrellas por ese medio

Bueno, pongamos los pies en el suelo, volvamos a la realidad. La revolución cuántica ha sido penosa, pero podemos agradecerle que, nos haya librado de muchas ilusiones que afectaban a la visión clásica del mundo. Una de ellas era que el hombre es un ser aparte, separado de la naturaleza a la que en realidad, no es que esté supeditado, sino que es, ella. ¡Somos Naturaleza!

Está claro, como nos decía Immanuel Kant que:

“La infinitud de la creación es suficientemente grande como para que un mundo, o una Vía Láctea de mundos, parezca, en comparación con ella, lo que una flor o un insecto en comparación con la Tierra.”

Algún día podríamos desaparecer en una especie de plasma como ese de la imagen y salir al “otro lado” que bien (¡Por qué no) podría ser otra galaxias lejana. Creo que la imaginación se nos ha dado para algo y, si todo lo que podemos imaginar se realizar, la conclusión lógica es que sólo necesitamos ¡Tiempo!

Sí, amigos míos, la Naturaleza vive en constante movimiento, y, nosotros, que formamos parte de ella…También vivimos en una constante evolución física y del conocimiento. Tenemos que llegar a conocerla.

Existen muchos mundos con dos soles, ¿cómo será vivir en uno de ellos?

En tiempos y lugares totalmente inciertos,

Los átomos dejaron su camino celeste,

Y mediante abrazos fortuítos,

Engendraron todo lo que existe.

Maxwell

Doy las gracias a Timothy Ferris de cuyo libro, La Aventura del Universo, he podido obtener bellos pasajes que aquí, quedan incluídos.

emilio silvera

Totales: 75.628.540

Totales: 75.628.540 Conectados: 63

Conectados: 63