Jul

21

Mutaciones con el transcurrir del tiempo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Misterios del Universo ~

Clasificado en Misterios del Universo ~

Comments (1)

Comments (1)

La transferencia de genes entre especies creó el mundo moderno

Patrones de formaciones de cianobacterias y travertino, en una zona del Parque de Yellowstone, (EE UU). Peter Unger Getty Images / Lonely Planet Images

Así como los historiadores piensan que conocer los siglos pasados es esencial para entender el presente, asimismo creen los evolucionistas que conocer la historia de la Tierra es la clave para comprender los procesos que nos han creado. Los biólogos saben que todos venimos de microbios humildes como las bacterias y las arqueas; y que, hacia la mitad de la historia del planeta, bacterias y arqueas se asociaron para crear la célula de la que estamos hechos por entero, la célula eucariota, el origen de la modernidad biológica. Los geólogos, entretanto, están intentando averiguar por qué. La gran pregunta.

Para los geólogos, el acontecimiento más importante de la historia de la Tierra es la “revolución del oxígeno” (great oxidation event), que transformó el planeta hacia la mitad de su historia (hace unos 2.300 millones de años). Este incremento del oxígeno atmosférico alcanzó unas cifras muy modestas (solo una pequeña fracción de los niveles actuales, que son del 21% de la atmósfera), pero dejó una huella profunda en el planeta, cuyas evidencias geológicas son aplastantes en los estratos de todo el mundo. ¿De dónde salió ese oxígeno?

Hay un acuerdo general en que ese oxígeno es producto de las cianobacterias, o bacterias fotosintéticas. Pero el nuevo estudio revela que no es así

Hay un acuerdo general en que ese oxígeno es producto de las cianobacterias, o bacterias fotosintéticas. La fotosíntesis es la energía fotovoltaica de la biología, el proceso que genera energía útil para la célula a partir de la luz solar. La luz se utiliza para romper el agua (H2O), y la célula utiliza el hidrógeno (H) para generar energía y libera el oxígeno (O) a la atmósfera. A las cianobacterias se las supone muy antiguas –tal vez entre las más antiguas de la Tierra— y algunos científicos piensan que su actividad lenta y tenaz acabó generando la revolución del oxígeno.

Un nuevo trabajo del geólogo Woodward Fisher y sus colegas del CalTech (Instituto Tecnológico de California en Pasadena) y la Universidad de Queensland, Australia, revela que no es así: las cianobacterias, o sus precursores, carecían por completo de la compleja habilidad de la fotosíntesis durante la primera mitad de la historia de la Tierra. Solo la adquirieron muy tarde, ya casi en tiempos de la revolución del oxígeno, y solo la adquirieron comprando los genes de otros microbios (técnicamente, transferencia genética horizontal, o HGT en sus siglas inglesas).

La constitución celular, tal como conocemos, no siempre se da en todas las masas vivientes, sino que a veces se encuentran organismos constituidos por una masa plasmática con varios núcleos sumergidos en ella, no apreciándose límites celulares: esto constituye un plasmodio. Una masa celular con varios núcleos.

Fisher y sus colegas, que presentan su investigación en Science, están asombrados por la cercanía de esas dos fechas: la del origen relativamente tardío y rápido de las cianobacterias fotosintéticas, y la del “gran evento de oxidación”, o revolución del oxígeno que cambió el mundo. Muestran que la explicación más parsimoniosa de esa coincidencia es que la revolución del oxígeno se deba a la evolución de las bacterias fotosintéticas. Una causa biológica para un fenómeno geológico. Más aún: para el ‘gran’ fenómeno geológico de la historia del planeta.

Desde Darwin, los biólogos se suelen sentir más cómodos con los fenómenos lentos y graduales que con las (relativas) brusquedades que revela a menudo el registro geológico. El evolucionismo clásico se basa en la pequeña acumulación de variaciones mínimas, cada una con una pequeña ventaja en el entorno del momento, hasta consolidar un sistema complejo prodigioso como el ojo del águila, el cerebro humano o la fotosíntesis. Pero también hay otros mecanismos evolutivos más rápidos, y la transferencia de genes entre unas especies de bacterias y otras es el mejor demostrado de ellos.

Las cianobacterias carecían por completo de la compleja habilidad de la fotosíntesis durante la primera mitad de la historia de la Tierra. Y solo la adquirieron ‘comprando los genes’ de otros microbios

Sin embargo, que el origen de la revolución del oxígeno sea un suceso relativamente rápido de transferencia genética, o compra de genes por las cianobacterias, plantea una nueva cuestión clave: ¿quién se los vendió? ¿Qué otro microorganismo tuvo la gentileza de donar sus genes fotosintéticos al precursor de las cianobacterias y cambiar así el mundo?

“Esa es una gran pregunta”, responde en un correo electrónico el jefe de la investigación, Woodward Fisher, “pero no tiene respuesta por el momento; es bien notable que ahora podamos afirmar con certeza que aquel suceso de transferencia de genes fue importante [para la revolución del oxígeno], pero el taxón de bacterias que donó los genes fotosintéticos no está claro todavía”.

“Es tentador”, prosigue el científico del CalTech, “pensar que alguno de los otros filos [grandes grupos bacterianos] capaces de un tipo de fotosíntesis que no produce oxígeno [fotosíntesis anoxigénica], y hay seis para elegir, donaron los genes, y luego las cianobacterias receptoras embellecieron ese metabolismo al añadirle la habilidad de romper el agua y producir oxígeno; pero si miras en detalle las relaciones evolutivas entre esos grupos, no obtienes una historia clara de la evolución de la fotosíntesis”.

La investigación muestra más bien que la fotosíntesis es lo que los evolucionistas llaman un “carácter derivado”, una propiedad que no es ancestral en las cianobacterias, y que por tanto no parece que puedan haber ido perfeccionando gradualmente con el paso del tiempo, sino una que han adquirido tarde y de forma secundaria. Y eso en los seis grandes grupos bacterianos que muestran algún tipo de fotosíntesis, aunque no produzca oxígeno. Todos ellos parecen haber comprado sus genes fotovoltaicos. ¿Quién se los vendió?

A pesar del mito persistente, el oxígeno no es una precondición de la vida. La vida prosperó durante la primera mitad de su historia en la completa ausencia de oxígeno. Los culpables de que haya oxígeno en nuestro planeta son seres vivos

“Puede que descubramos más grupos de microbios fotosintéticos”, responde Fisher, “y los enfoques metagenómicos [como sacar un cubo de agua del mar y secuenciar el ADN de todo lo que haya allí] dejan claro que solo hemos empezado a arañar la superficie de la diversidad microbiana; pero igual de posible es que el grupo de microbios que donó los genes fotosintéticos se extinguiera hace mucho”. Un triste final para el hacedor de nuestro mundo, ¿no es cierto?

Pese a lo fragoroso de su nombre, la gran revolución del oxígeno no alcanzó unos valores ni parecidos a los actuales (21% de la atmósfera). Eso solo ocurrió hace unos 600 millones de años, en los prolegómenos de la explosión cámbrica, el corto periodo de innovación evolutiva que nos vio nacer a todos los animales.

A pesar del mito persistente, el oxígeno no es una precondición de la vida. La vida prosperó durante la primera mitad de su historia en la completa ausencia de ese gas. Los culpables de que haya oxígeno en nuestro planeta son seres vivos. Y tal vez estén ya extintos.

Jul

21

Hoy un sueño ¿Realidad mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Llegará un día en el que, podremos entrar en un inmenso espacio, una enorme habitación, en la que, previa elección de la programación adecuada, todo se transformará en un “mundo ficticio”, un holograma que, lo mismo podrá ser una playa luminosa con arena dorada por el Sol que, una Selva tropical o un desierto, dependiendo de los gustos del usuario.

Si repasamos la historia de la ciencia, seguramente encontraremos muchos motivos para el optimismo. Witten (el Físico de la Teoría M), está convencido de que la ciencia será algún día capaz de sondear hasta las energías de Planck. Como ya he referido en otras ocasiones, él dijo:

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles. En el siglo XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible. Si usted hubiera dicho a un físico del siglo XIX que hacia el siglo XX sería capaz de calcularlo, le habría parecido un cuento de hadas… La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante 25 años.”

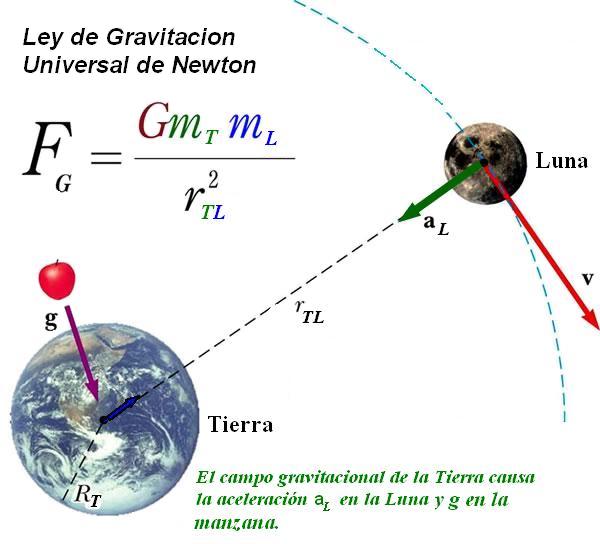

En su opinión, las buenas ideas siempre se verifican. Los ejemplos son innumerables: la gravedad de Newton, el campo eléctrico de Faraday y el electromagnetismo de Maxwell, la teoría de la relatividad de Einstein en sus dos versiones y su demostración del efecto fotoeléctrico, la teoría del electrón de Paul Dirac, el principio de incertidumbre de Heisenberg, la función de ondas de Schrödinger, y tantos otros. Algunos de los físicos teóricos más famosos, sin embargo, protestaban de tanto empeño en la experimentación. El astrónomo arthur Eddington se cuestionaba incluso si los científicos no estaban forzando las cosas cuando insistían en que todo debería ser verificado. ¡Cómo cambia todo con el Tiempo! Hasta la manera de pensar.

Sin embargo, muchos son los ejemplos de un ingenio superior que nos llevaron a desvelar secretos de la Naturaleza que estaban profundamente escondidos, y, el trabajo de Dirac en relación al electrón, es una buena muestra de ese ingenio humano que, de vez en cuando vemos florecer.

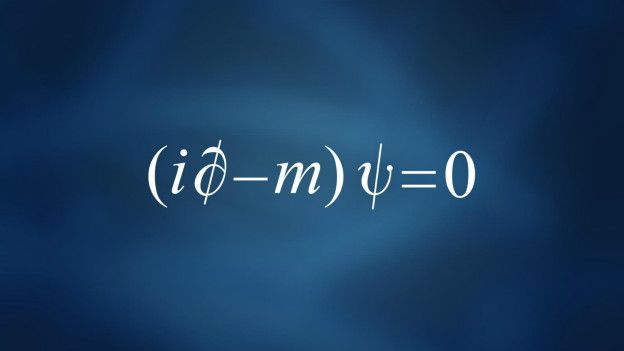

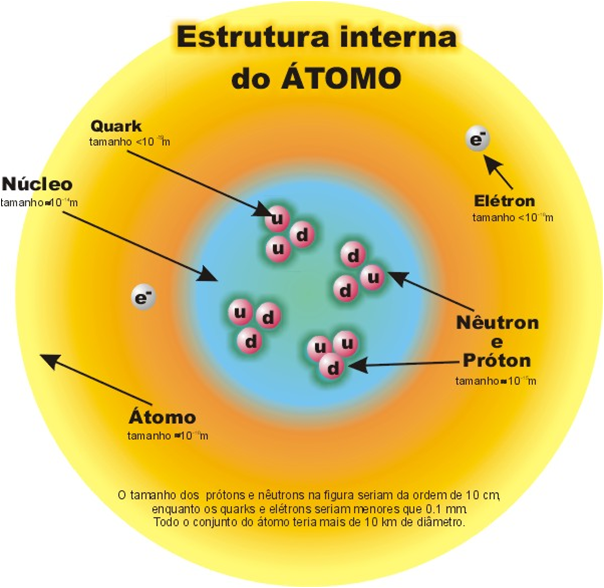

Ya que la ecuación de Dirac fue originalmente formulada para describir el electrón, las referencias se harán respecto a “electrones”, aunque actualmente la ecuación se aplica a otros tipos de partículas elementales de espín ½, como los quarks. Una ecuación modificada de Dirac puede emplearse para describir de forma aproximada los protones y los neutrones, formados ambos por partículas más pequeñas llamadas quarks (por este hecho, a protones y neutrones no se les da la consideración de partículas elementales).

La ecuación de Dirac presenta la siguiente forma:

Ésa es la ecuación de Dirac. Gracias a esto, se describe el fenómeno de entrelazamiento cuántico, que en la práctica dice que: ‘Si dos sistemas interactúan uno con el otro durante un cierto período de tiempo y luego se separan, lo podemos describir como dos sistemas separados, pero de alguna manera sutil están convertidos en un solo sistema. Uno de ellos sigue influyendo en el otro, a pesar de kilómetros de distancia o años luz’. Esto es el entrelazamiento cuántico o conexión cuántica. Dos partículas que, en algún momento estuvieron unidas, siguen estando de algún modo relacionadas. No importa la distancia entre ambas, aunque se hallen en extremos opuestos del universo. La conexión entre ellas es instantánea.

La llamada ecuación de Dirac es la versión relativista de la ecuación de ondas de la mecánica cuántica y fue formulada por Paul Dirac en 1928. Da una descripción de las partículas elementales de espín ½, como el electrón, y es completamente consistente con los principios de la mecánica cuántica y de la teoría de la relatividad especial. Además de dar cuenta del espín, la ecuación predice la existencia de antimateria.

El premio Nobel Paul dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años, «Es sólo el optimista el que consigue algo en este mundo».“

Yo, como todos ustedes, un hombre normal y corriente de la calle, escucho a unos y a otros, después pienso en lo que dicen y en los argumentos y motivaciones que les han llevado a sus respectivos convencimientos, y finalmente, también decido según mis propios criterios mi opinión, que no obligatoriamente coincidirá con alguna de esas opiniones, y que en algún caso, hasta me permito emitirla.

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? Nadie las llama y, sin embargo, allí aparecen para decirnos que, la Teoría de cuerdas es un buen camino a seguir, ya que, si en ella subyacen las ecuaciones de Einstein de la relatividad General… ¡No debe ser por casualidad!

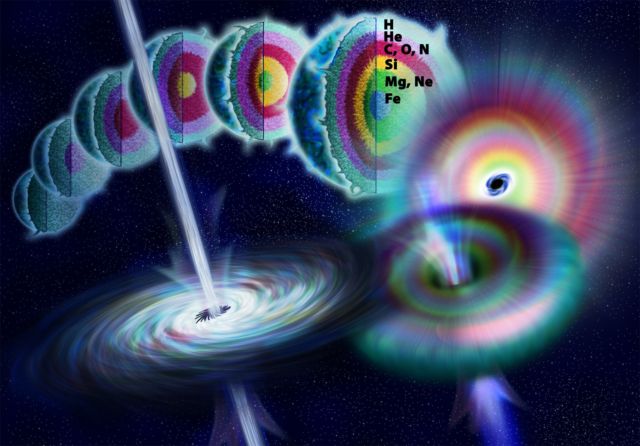

Suponiendo que algún físico brillante nos resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro universo, con un poco de suerte, podría ocurrir en este mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas es naturalmente una teoría de la creación.

Las primeras observaciones realizadas por Planck | ESA y Axel Mellinger.

Fuimos capaces de predecir que el Big Bang produjo un “eco” cósmico reverberando en el universo y que podría ser mesurable por los instrumentos adecuados. De hecho, Arno Penzias y Robert Wilson de los Bell Telephone Laboratories ganaron el premio Nobel en 1.978 por detectar este eco del Big Bang, una radiación de microondas que impregna el universo conocido. El que el eco del Big Bang debería estar circulando por el universo miles de millones de años después del suceso fue predicho por primera vez por George Gamow y sus discípulos Ralpher y Robert Herman, pero nadie les tomó en serio. La propia idea de medir el eco de la creación parecía extravagante cuando la propusieron por primera vez poco después de la segunda guerra mundial. Su lógica, sin embargo, era aplastante.

La estufa básica es la resistencia por hilo enrollado Nicrom. Ésta se llega a poner al rojo vivo, por lo que emite también algo de calor por radiación.

Cualquier objeto, cuando se calienta, emite radiación de forma gradual. Ésta es la razón de que el hierro se ponga al rojo vivo cuando se calienta en un horno, y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

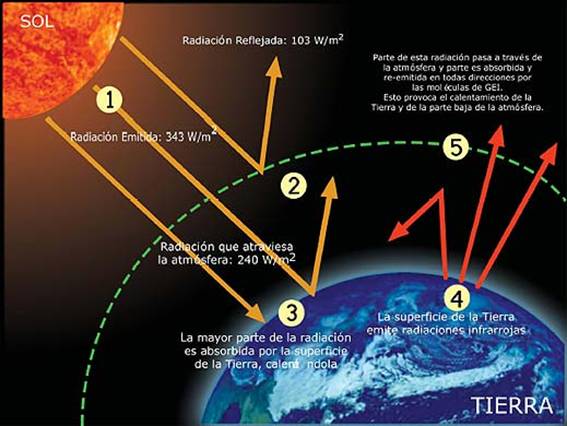

Esta radiación, cómo no, ha sido aprovechada por los ejércitos, que mediante visores nocturnos pueden operar en la oscuridad. De noche, los objetos relativamente calientes, tales como soldados enemigos o los carros de combate, pueden estar ocultos en la oscuridad, pero continúan emitiendo radiación de cuerpo negro invisible en forma de radiación infrarroja, que puede ser captada por gafas especiales de infrarrojo. Ésta es también la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura.

Análogamente, la radiación de cuerpo negro produce el efecto invernadero. Al igual que el vidrio, los altos niveles de dióxido de carbono en la atmósfera, causados por la combustión sin control de combustibles fósiles, pueden atrapar la radiación de cuerpo negro infrarroja en la Tierra, y de este modo calentar gradualmente el planeta.

Gamow razonó que el Big Bang era inicialmente muy caliente, y que por lo tanto sería un cuerpo negro ideal emisor de radiación. Aunque la tecnología de los años cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

Ya la lista de ingenios es larga. Todos quieren medir la radiación del fondo de microondas generadas por el Big Bang. Incluso hemos preparado telescopios especiales para que nos puedan captar las ondas gravitatorias surgidas en aquellos primeros momento de la inflación.

La lógica que había detrás de su razonamiento era la siguiente: alrededor de 300.000 años después del Big Bang, el universo se enfrió hasta el punto en el que los átomos pudieron empezar a componerse; los electrones pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento, el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

Pasados 300.000 años, la radiación no era tan potente; se había enfriado y por lo tanto la luz podía atravesar grades distancias sin ser dispersada. En otras palabras, el universo se hizo repentinamente negro y transparente.

Terminaré esta parte comentando que un auténtico cuerpo negro es un concepto imaginario; un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

Hablar, sin más especificaciones, de radiación, es estar refiriéndonos a una energía que viaja en forma de ondas electromagnéticas o fotones por el universo. También nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

La radiación actínida es la electromagnética que es capaz de iniciar una reacción química. El término es usado especialmente para la radiación ultravioleta y también para denotar radiación que podría afectar a las emulsiones fotográficas.

La radiación gamma es un tipo de radiación electromagnética producida generalmente por elementos radioactivos o procesos subatómicos como la aniquilación de un par positrón-electrón. Este tipo de radiación de tal magnitud también es producida en fenómenos astrofísicos de gran violencia.

Debido a las altas energías que poseen, los rayos gamma constituyen un tipo de radiación ionizante capaz de penetrar en la materia más profundamente que la radiación alfa o beta. Dada su alta energía pueden causar grave daño al núcleo de las células, por lo que son usados para esterilizar equipos médicos y alimentos.

La Radiación expone un amplio abanico dependiendo de la fuente: blanda, radiación cósmica, radiación de calor, radiación de fondo, de fondo de microondas, radiación dura, electromagnética, radiación gamma, infrarroja, ionizante, monocromática, policromática, de sincrotrón, ultravioleta, de la teoría cuántica, de radiactividad… y, como se puede ver, la radiación en sus diversas formas es un universo en sí misma.

Siempre me llamó la atención y se ganó mi admiración el físico alemán Max Planck (1.858 – 1.947), responsable entre otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

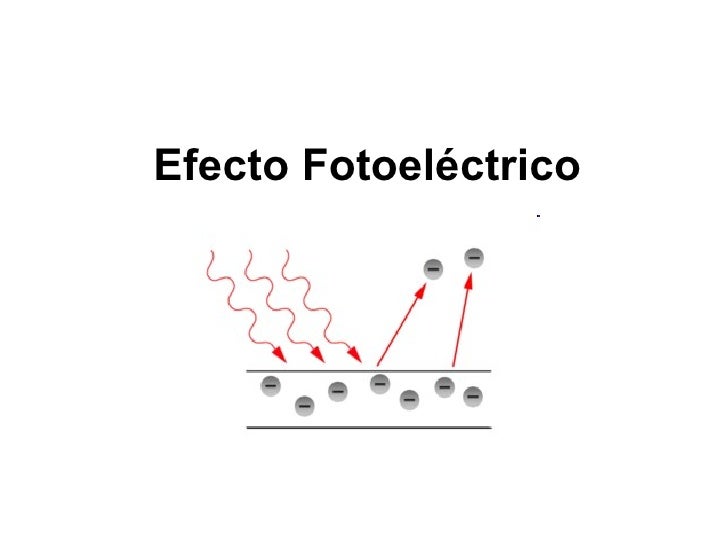

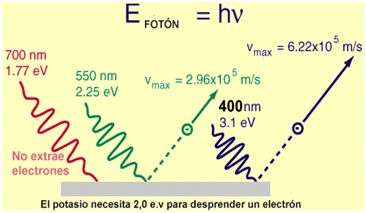

Einstein se inspiró en este trabajo para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre: Em = hf – Φ.

Cada metal requiere, para que se produzca la extracción, una radiación con una frecuencia mínima (no). Cualquier otra radiación de menor frecuencia, no será capaz de arrancar electrones. Por debajo de la frecuencia mínima la intensidad de corriente -”i” (amperios)- será cero. No hay efecto fotoeléctrico.

Planck publicó en 1.900 un artículo sobre la radiación de cuerpo negro que sentó las bases para la teoría de la mecánica cuántica que más tarde desarrollaron otros, como el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

1. vale 10-35 metros. Esta escala de longitud (veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m) es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

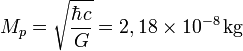

2. . Es la masa de una partícula cuya longitud de onda Compton es igual a la longitud de Planck. En la ecuación, ħ es la constante de Planck racionalizada, c es la velocidad de la luz y G es la constante gravitacional. Así, Se denomina masa de Planck a la cantidad de masa (21,7644 microgramos) que, incluida en una esfera cuyo radio fuera igual a la longitud de Planck, generaría una densidad del orden de 1093 g/cm³. Según la física actual, esta habría sido la densidad del Universo cuando tenía unos  segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planc se denota:

segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planc se denota:

El valor de la masa de Planck  se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

“Aunque todas estas descripciones reflejan más una abundante imaginación que un hecho existencial apoyado teóricamente con alguna hipótesis que pueda ser comprobada en el laboratorio sobre hechos que están más allá de poder ser medidos jamás en algún laboratorio construído por humanos. La única forma de confrontar la factibilidad o la posibilidad del modelo de la espuma cuántica nos lleva necesariamente a confrontar la carencia de un modelo que logre unificar exitosamente al macrocosmos con el microcosmos, a la Relatividad General con la Mecánica Cuántica, la Gravedad Cuántica. Si la energía y la materia (o mejor dicho la masa-energía) están discretizadas, se supone que también deben de estarlo el espacio y el tiempo (o mejor dicho, el espacio-tiempo), y la “partícula fundamental” del espacio-tiempo debe de serlo el gravitón, aunque de momento todo esto son especulaciones que seguirán siéndolo mientras no tengamos a la mano algo que pueda confirmar la existencia de tan exótica partícula, quizá la más exótica de cuantas hayan sido concebidas por la imaginación del hombre.”

La descripción de una partícula elemental de esta masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 103 GeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas. Únicamente en un laboratorio aparecieron partículas que tenían energías del orden de la masa de Planck: en el universo primitivo, de acuerdo con la teoría del Big Bang, motivo éste por el que es necesaria una teoría cuántica de la gravedad para estudiar aquellas condiciones. Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

Uno de los mayores misterios que hemos podido comprender es la complejidad que está presente en el núcleo de los átomos, las cosas que allí pasan y los objetos que actúan dentro del núcleo… Son asombrosos!

Siempre, desde que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos. Muchos han sido los velos que hemos podido descorrer para que, la luz cegadora del saber pudiera entrar en nuestras mentes para hacerlas comprender cómo actuaba la Naturaleza en ciertas ocasiones y el por qué de tales comportamientos, y, sin embargo, a pesar del largo camino recorrido, es mucho más el que nos queda por andar.

emilio silvera

Jul

21

¿En qué nos convertiremos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Futuro incierto ~

Clasificado en El Futuro incierto ~

Comments (0)

Comments (0)

-

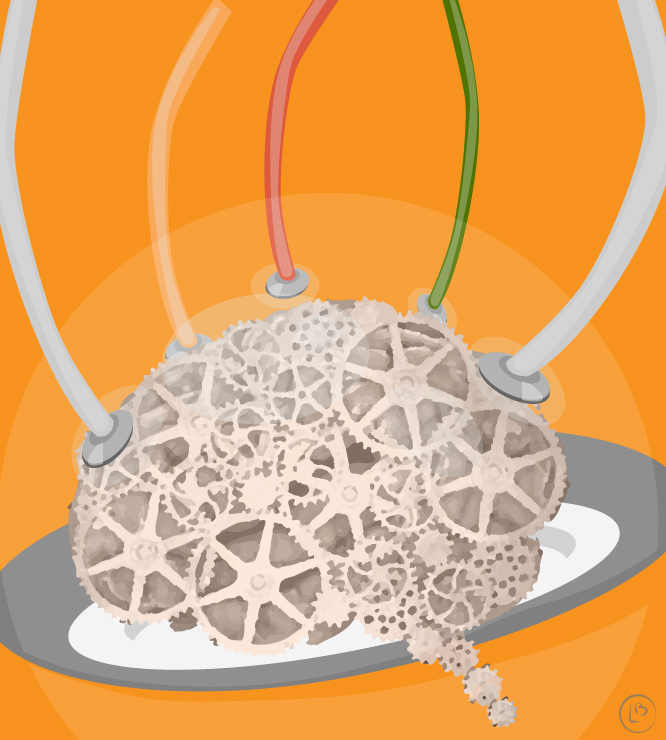

1. Cerebro · En los años 60 del siglo XX, el fisiólogo José Rodríguez Delgado inventó el “stimoceiver”o estimulador transdermal, un dispositivo implantado en el cerebro para transmitir impulsos eléctricos que modificaban comportamientos básicos como la agresión o sensaciones de placer.· En 2013 la FDA aprobaba un dispositivo de respuesta cerebral para el tratamiento de la epilepsia que venía siendo desarrollado por los médicos de la USC desde 2006.

· Neil Harbisson (Londres, 1984) es la primera persona en el mundo reconocida como cíborg por un gobierno y la primera persona con una antena implantada en la cabeza que le permite escuchar los colores y percibir infrarrojos, ultravioletas, recibir imágenes, vídeos, música o llamadas telefónicas directamente a su cabeza desde aparatos externos como móviles o satélites.

· En 2010, se logró devolver la vista a tres pacientes ciegos con un microchipimplantado en la retina sin una cámara externa. Creado por el profesor Eberhart Zrennera y Retina Implant AG.

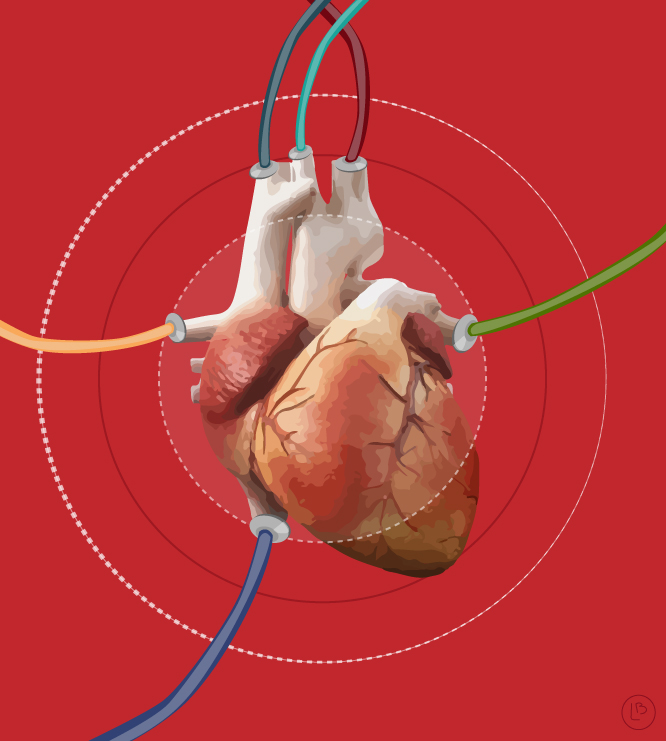

4. Corazón · La primera implantación clínica de un marcapasos interno en un humano fue hecha por el cirujano Åke Senning en 1958 en el Instituto Karolinska en Solna, Suecia, usando un marcapasos diseñado por Rune Elmqvist. El dispositivo falló tres horas después. Un segundo dispositivo fue implantado y duró dos días. El primer paciente en el mundo con marcapasos interno, Arne Larsson, recibió 26 marcapasos diferentes a lo largo de su vida. Murió en 2001 a la edad de 86 años.

5. Brazos y manos · En el año 1510-1590 el cirujano francés Ambroise Paré desarrolló el primer brazo artificial móvil llamado Le Petit Lorraine. Los dedos podían abrirse o cerrarse.

· La startup sueca Epicenter ofrece a sus empleados, opcionalmente, la implantación de estos chips, para abrir puertas, usar impresoras o comprar productos con un simple movimiento de mano.

Mediante piel tomada de su brazo y unos tubos implantados, su pene biónico de 20 cm puede conseguir una erección instantánea a través de un botón localizado en sus testículos para ‘encenderlo’ y otro para ‘apagarlo’.

http://www.alpoma.net/

http://eyeborgproject.tv/

http://www.investigacionyciencia.es/

http://www.elfinanciero.com.mx/

http://www.fpa.es/

http://www.excelsior.com.mx/

http://www.chrisdancy.com/

http://www.monografias.com/

http://www.latam.discovery.com/

http://stm.sciencemag.org/

https://es.wikipedia.org/

Ilustraciones: Olivia López Bueno

Totales: 75.604.255

Totales: 75.604.255 Conectados: 1

Conectados: 1