Sep

20

La energía de nuestro organismo: ¡Las mitocondrias!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Eva mitocondrial ~

Clasificado en Eva mitocondrial ~

Comments (0)

Comments (0)

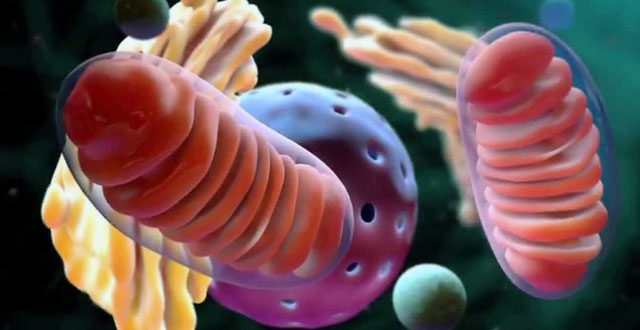

Nuestros cuerpos contienen aproximadamente diez mil billones de unos bichitos llamados mitocondrias, que invadieron a los antepasados de nuestras células hace alrededor de mil millones de años. Las mitocondrias están acostumbradas a vivir dentro de nosotros, y nosotros nos hemos acostumbrado de tal manera a tenerlas por todas partes, que ahora no podemos vivir separados. Ellas forman parte de nosotros y nosotros formamos parte de ellas.

Producen casi toda nuestra energía y nosotros nos encargamos de alimentarlas y cobijarlas. Nuestras mitocondrias tienen todavía su propia ADN, heredado sólo de nuestras madres, por lo que este ADN podría proceder de una única mujer que estaría en el origen de los seres humanos actuales: una Eva mitocondrial.

Una de las complejidades de la vida humana es que las mitocondrias estaban en simbiosis con la mujer que la transmitió a sus hijos, el varón no lo hace

Pero estos huéspedes celulares que parecen vivir pacíficamente en simbiosis con el resto de las células, puede ser también ser un enemigo que mata silenciosamente desde dentro. Siempre que una célula muere, hay una serie de pistas que conducen a las mitocondrias y que muestran como están implicadas en enfermedades devastadoras e incapacidades físicas o mentales, así como en el propio proceso de envejecimiento. El invitado indispensable se convierte en asesino en serie de proporciones monstruosas.

La diferencia entre una célula del hígado normal y otra cancerosa es demostrada aquí claramente por la localización de las mitocondrias (coloración roja) . La célula sana a la izquierda, demuestra muy pocas mitocondrias cerca de la pared de externa de la célula. Como puede ver, se mantienen densamente arracimadas (agrupadas) alrededor del núcleo de la célula (representado aquí como el agujero central negro). En la célula del cancerosa a la derecha, las mitocondrias se disgregan a través de la célula, no se arraciman. Observe el color rojo apagado de las mitocondrias disfuncionales. Fotografía obtenida con la tecnología Sandia’s biocavity laser

Casi todas las células de nuestro cuerpo contienen mitocondrias –alrededor de mil cada célula-. El “mitocondrión” es una bestia incansable que no cesa de adoptar formas distintas. Si se captara su aspecto en una única foto instantánea poco favorecedora, se vería algo parecido a un gusano, pero un gusano que se retuerce, se divide en dos y se fusiona con otros gusanos. Así pues, en ocasiones podemos captar un mitocondrión que parece un zepelín, y otras veces algo parecido a un animal con múltiples cabezas o colas, o bien podríamos ver una red de tubos y láminas que se entrecruzan. El mitocondrión es un monstruo antiguo y maternal – un dragón con un apetito monstruoso, que se come a su vez todo lo que nosotros hemos comido y lo respira a continuación en forma de fuego.

Las mitocondrias consumen prácticamente todo el alimento y el oxígeno que se introduce en el cuerpo, y producen la mayor parte del calor que éste genera. Sin embargo, este monstruo es diminuto –su tamaño es de una micra, es decir, una milésima de milímetro: mil millones de mitocondrias cabrían en el interior de un grano de arena.

Las mitocondrias tienen su propio ADN y su propia identidad, pero esto no significa ningún litigio entre ellas y nosotros. En parte somos mitocondrias; ellas constituyen aproximadamente un décimo del volumen de todas nuestras células juntas, una décima parte de cada uno de nosotros.

Dado que son prácticamente la única parte de la célula que tiene color, las mitocondrias constituyen el color de nuestras células y nuestros tejidos. Si no fuera por la melanina de nuestra piel, la mioglobina de nuestros músculos y la hemoglobina de nuestra sangre, seríamos del color de las mitocondrias, es decir, de un rojo amarronado. Además, si esto fuera así, cambiaríamos de color cuando hiciéramos ejercicio o corriéramos hasta perder el aliento, de tal forma que podría decir si alguien está usando mucha o poca energía…

Las mitocondrias son las centrales eléctricas de nuestras células y producen casi toda nuestra energía. No obstante, son unas centrales eléctricas con bastantes fugas de energía, lo cual tiene unas consecuencias terribles.

Guy Brown

“Llegué a creer (dice Guy Brown, autor de todas estas ideas e investigaciones) que los productos del diseño biológico (evolutivo) –la vida y todas sus manifestaciones- eran mucho más eficientes y eficaces que algunos productos de la creatividad humana, tales como las máquinas y la cultura. Nos han enseñado que mil millones de años de evolución han perfeccionado el diseño de la célula hasta tal punto que ningún diseñador humano podría mejorarlo, ningún avaro podría economizar más en el uso de energía, ningún técnico de gestión podría mejorar la adjudicación de recursos, ningún ingeniero podría lograr que hubiera menos fallos en el funcionamiento. Está ampliamente difundida la creencia de que la cultura humana no debería interferir con la naturaleza, porque la naturaleza está mejor diseñada que la cultura, y esta creencia causa el temor de que los científicos se entrometan en la naturaleza, como sucede en la medicina, la ingeniería genética, la clonación o los pesticidas.”

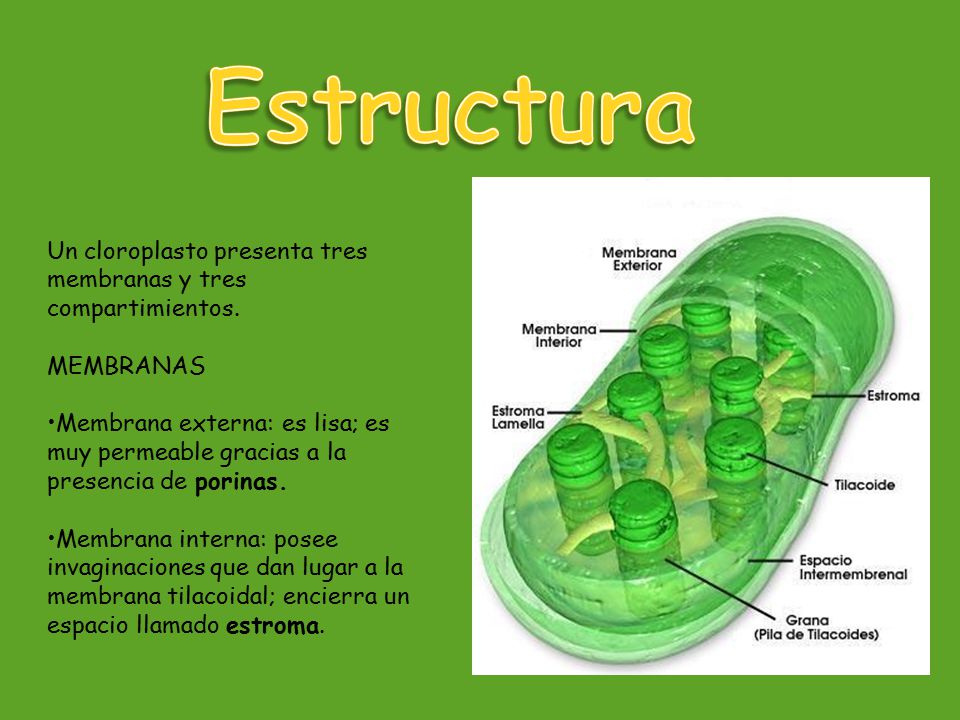

Los cloroplastos son orgánulos aún mayores y se encuentran en las células de plantas y algas, pero no en las de animales y hongos. Su estructura es aún más compleja que la mitocondrial: además de las dos membranas de la envoltura, tienen numerosos sacos internos formados por membrana que encierran el pigmento verde llamado clorofila. Desde el punto de vista de la vida terrestre, los cloroplastos desempeñan una función aún más esencial que la de las mitocondrias: en ellos ocurre la fotosíntesis; esta función consiste en utilizar la energía de la luz solar para activar la síntesis de moléculas de carbono pequeñas y ricas en energía, y va acompañado de liberación de oxígeno. Los cloroplastos producen tanto las moléculas nutritivas como el oxígeno que utilizan las mitocondrias.

Sean cuales sean los méritos de esas creencias, lo cierto es que, nuestras células ciertamente no son tan eficientes como creíamos que eran. Un ejemplo sería lo que parece un defecto espectacular en el diseño de nuestras mitocondrias: tienen fugas. La electricidad de electrones se escapan de las mitocondrias para producir radicales libres no tóxicos, y la electricidad de protones se escapan produciendo calor: no se trata de fugas pequeñas o insignificantes, sino que son grandes y constituyen una amenaza para la vida.

Lo que no podemos poner en duda es, el hecho cierto de que, nuestro complejo organismo está inmerso en una variedad y en una diversidad rica en parámetros que deben cumplir unos cometidos predeterminados que llevan a un todo simétrico de engranaje perfecto y, cuando algo falla en él, el sistema se reciente y el funcionamiento decae.

La célula se define como la unidad mínima de un organismo capaz de actuar de manera autónoma. Todos los organismos vivos están formados por células, y en general se acepta que ningún organismo es un ser vivo si no consta al menos de una célula. Algunos organismos microscópicos, como bacterias y protozoos, son células únicas, mientras que los animales y plantas están formados por muchos millones de células organizadas en tejidos y órganos. Aunque los virus y los extractos acelulares realizan muchas de las funciones propias de la célula viva, carecen de vida independiente, capacidad de crecimiento y reproducción propios de las células y, por tanto, no se consideran seres vivos.

La biología estudia las células en función de su constitución molecular y la forma en que cooperan entre sí para constituir organismos muy complejos, como el ser humano. Para poder comprender cómo funciona el cuerpo humano sano, cómo se desarrolla y envejece y qué falla en caso de enfermedad, es imprescindible conocer las células que lo constituyen.

Entre las células procarióticas y eucarióticas hay diferencias fundamentales en cuanto a tamaño y organización interna. Las procarióticas, que comprenden bacterias y cianobacterias (antes llamadas algas verdeazuladas), son células pequeñas, entre 1 y 5 µm de diámetro, y de estructura sencilla; el material genético (ADN) está concentrado en una región, pero no hay ninguna membrana que separe esta región del resto de la célula. Las células eucarióticas, que forman todos los demás organismos vivos, incluidos protozoos, plantas, hongos y animales, son mucho mayores (entre 10 y 50 µm de longitud) y tienen el material genético envuelto por una membrana que forma un órgano esférico conspicuo llamado núcleo. De hecho, el término eucariótico deriva del griego núcleo verdadero, mientras que procariótico significa antes del núcleo.

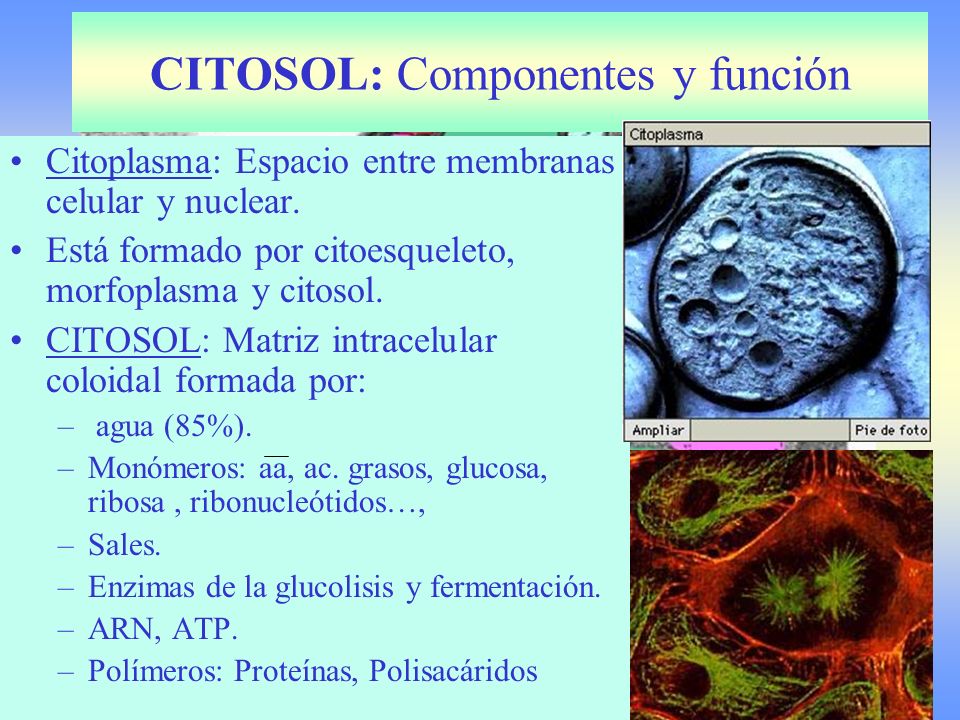

Citoplasma y citosol

El citoplasma comprende todo el volumen de la célula, salvo el núcleo. Engloba numerosas estructuras especializadas y orgánulos, como se describirá más adelante. La solución acuosa concentrada en la que están suspendidos los orgánulos se llama citosol. Es un gel de base acuosa que contiene gran cantidad de moléculas grandes y pequeñas, y en la mayor parte de las células es, con diferencia, el compartimiento más voluminoso (en las bacterias es el único compartimiento intracelular). En el citosol se producen muchas de las funciones más importantes de mantenimiento celular, como las primeras etapas de descomposición de moléculas nutritivas y la síntesis de muchas de las grandes moléculas que constituyen la célula. Aunque muchas moléculas del citosol se encuentran en estado de solución verdadera y se desplazan con rapidez de un lugar a otro por difusión libre, otras están ordenadas de forma rigurosa.

El citoplasma de las células eucariotas se encuentra atravesado por un conjunto de tubos, vesículas y cisternas, que presentan la estructura básica de la membrana citoplásmica. Entre esos elementos existen frecuentemente intercomunicaciones, y adoptan la forma de una especie de red, entre cuyas mayas se encuentra el citoplasma. Este sistema membranoso es llamado en la actualidad sistema vacuolar citoplásmico, integrándose en él la membrana nuclear, el retículo endoplásmico y el complejo de Golgi. Estas estructuras ordenadas confieren al citosol una organización interna que actúa como marco para la fabricación y descomposición de grandes moléculas y canaliza muchas de las reacciones químicas celulares a lo largo de vías restringidas.

Es tan amplio el tema que estamos tratando que, de un tema me paso a otro y, podemos perder la visión de lo que queríamos expresar, así que finalizaré con las mitocondrias y su función principal.

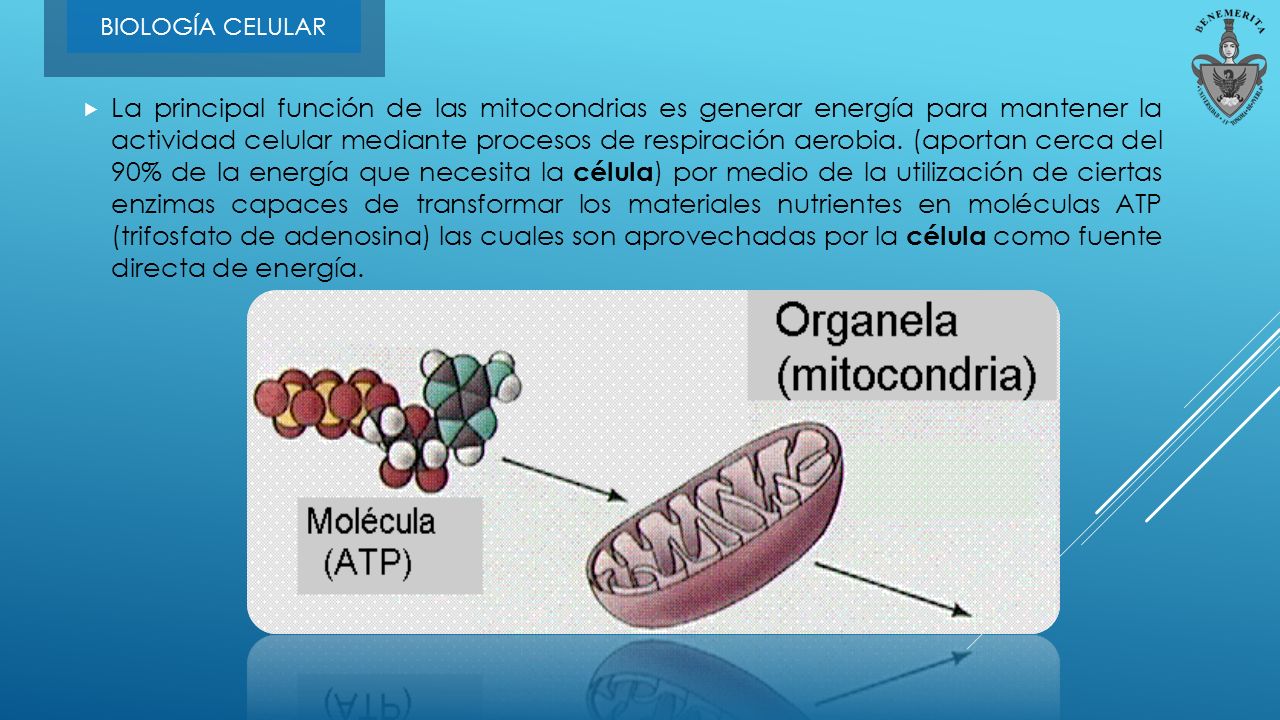

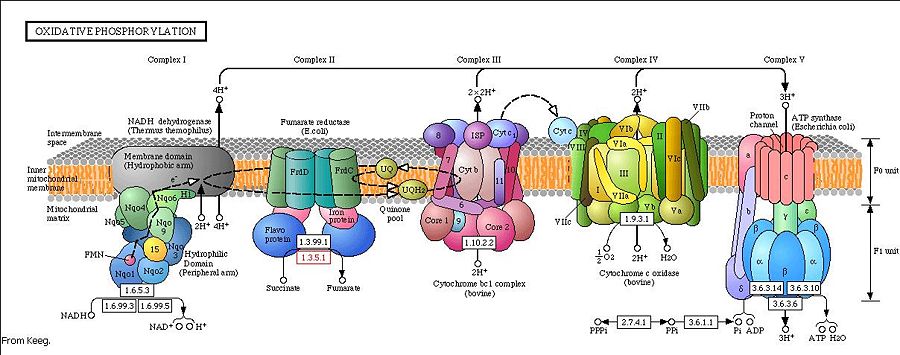

La principal función de las mitocondrias es generar energía para mantener la actividad celular mediante procesos de respiración aerobia. Los nutrientes se escinden en el citoplasma celular para formar ácido pirúvico que penetra en la mitocondria. En una serie de reacciones, parte de las cuales siguen el llamado ciclo de Krebs o del ácido cítrico, el ácido pirúvico reacciona con agua para producir dióxido de carbono y diez átomos de hidrógeno. Estos átomos de hidrógeno se transportan hasta las crestas de la membrana interior a lo largo de una cadena de moléculas especiales llamadas coenzimas. Una vez allí, las coenzimas donan los hidrógenos a una serie de proteínas enlazadas a la membrana que forman lo que se llama una cadena de transporte de electrones.

La cadena de transporte de electrones separa los electrones y los protones de cada uno de los diez átomos de hidrógeno. Los diez electrones se envían a lo largo de la cadena y acaban por combinarse con oxígeno y los protones para formar agua.

La energía se libera a medida que los electrones pasan desde las coenzimas a los átomos de oxígeno y se almacena en compuestos de la cadena de transporte de electrones. A medida que éstos pasan de uno a otro, los componentes de la cadena bombean aleatoriamente protones desde la matriz hacia el espacio comprendido entre las membranas interna y externa. Los protones sólo pueden volver a la matriz por una vía compleja de proteínas integradas en la membrana interior. Este complejo de proteínas de membrana permite a los protones volver a la matriz sólo si se añade un grupo fosfato al compuesto difosfato de adenosina (ADP) para formar ATP en un proceso llamado fosforilación.

El ATP se libera en el citoplasma de la célula, que lo utiliza prácticamente en todas las reacciones que necesitan energía. Se convierte en ADP, que la célula devuelve a la mitocondria para volver a fosforilarlo.

¡Mitocondrias! Parte de nuestro sistema interno. Sin ellas, no podríamos vivir y, hace ya mucho tiempo que, humanos y mitocondrias hicieron un contrato para formar, esa simbiosis que nos une desde tiempos ancestrales.

Recopila y resume: emilio silvera

Fuente: Agradecer a Guy Brown sus conocimientos

Sep

19

Un viaje hacia atrás en el tiempo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Recordando el pasado ~

Clasificado en Recordando el pasado ~

Comments (1)

Comments (1)

A finales del siglo XIX, poca gente sabía con exactitud a qué se dedicaban los “físicos”. El término mismo era relativamente nuevo. En Cambridge, la física se enseñaba como parte del grado de matemáticas.

En este sistema no había espacio para la investigación: se consideraba que la física era una rama de las matemáticas y lo que se le enseñaba a los estudiantes era como resolver problemas.

En la década de 1.870, la competencia económica que mantenían Alemania, Francia, Estados Unidos, y Gran Bretaña se intensificó. Las Universidades se ampliaron y se construyó un Laboratorio de física experimental en Berlín.

Cambridge sufrió una reorganización. William Cavendish, el séptimo duque de Devonshire, un terrateniente y un industrial, cuyo antepasado Henry Cavendish había sido una temprana autoridad en teoría de la gravitación, accedió a financiar un Laboratorio si la Universidad prometía fundar una cátedra de física experimental. Cuando el laboratorio abrió, el duque recibió una carta en la que se le informaba (en un elegante latín) que el Laboratorio llevaría su nombre.

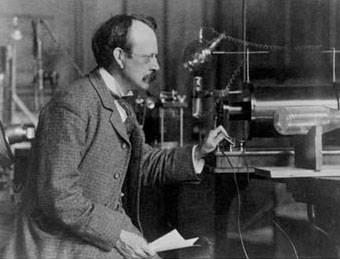

Primer profesor J. J. Thomson como director del laboratorio

Tras intentar conseguir sin éxito atraer primero a William Thomson, más tarde a lord Kelvin (quien entre otras cosas, concibió la idea del cero absoluto y contribuyó a la segunda ley de la termodinámica) y después a Hermann von Helmohltz, de Alemania (entre cuyas decenas de ideas y descubrimientos destaca una noción pionera del cuanto), finalmente se ofreció la dirección del centro a James Clerk Maxwell, un escocés graduado en Cambridge. Este fue un hecho fortuito, pero Maxwell terminaría convirtiéndose en lo que por lo general se considera el físico más destacado entre Newton y Einstein. Su principal aportación fue, por encima de todo, las ecuaciones matemáticas que permiten entender perfectamente la electricidad y el magnetismo. Estas explicaban la naturaleza de la luz, pero también condujeron al físico alemán Heinrich Hertz a identificar en 1.887, en Karlsruhe, las ondas electromagnéticas que hoy conocemos como ondas de radio.

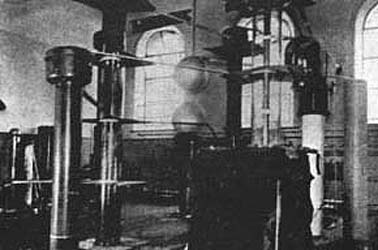

En el Laboratorio Cavendish de la Universidad de Cambridge, Cockcroft y Walton construyeron este acelerador de 500 kilovolts en 1932. Si lo comparamos con el LHC del CERN nos podemos dar cuenta de cómo la Ciencia ha ido avanzando en relativamente tan poco tiempo y, desde entonces hemos alcanzado un nivel que nos permite trabajar con 14 TeV, una energía de todo punto imposible e impensable en aquellos primeros tiempos.

Maxwell también creó un programa de investigación en Cavendish con el propósito de idear un estándar preciso de medición eléctrica, en particular la unidad de resistencia eléctrica, el ohmio. Esta era una cuestión de importancia internacional debido a la enorme expansión que había experimentado la telegrafía en la década de 1.850 y 1.860, y la iniciativa de Maxwell no solo puso a Gran Bretaña a la vanguardia de este campo, sino que también consolidó la reputación del Laboratorio Cavendish como un centro en el que se trataban problemas prácticos y se ideaban nuevos instrumentos.

Tubo de vacío usado por JJ Thomson en uno de los experimentos realizados para descubrir el electrón. Expuesto en el museo del laboratorio Cavendish. A este hecho es posible atribuir parte del crucial papel que el laboratorio iba a desempeñar en la edad dorada de la Física, entre 1.897 y 1.933. Los científicos de Cavendish, se decía, tenían “sus cerebros en la punta de los dedos.”

Maxwell murió en 1.879 y le sucedió lord Rayleigh, quien continuó su labor, pero se retiró después de cinco años y, de manera inesperada, la dirección pasó a un joven de veintiocho años, Joseph John Thomson, que a pesar de su juventud ya se había labrado una reputación en Cambridge como un estupendo físico-matemático. Conocido universalmente como J.J., puede decirse que Thomson fue quien dio comienzo a la segunda revolución científica que creó el mundo que conocemos.

Ernest Rutherford

Se dedicó al estudio de las partículas radioactivas y logró clasificarlas en alfaa (α), beta (β) y gamma (γ). Halló que la radiactividad iba acompañada por una desintegración de los elementos, lo que le valió ganar el Premio Nobel de Química de 1908. Se le debe un modelo atómico con el que probó la existencia de núcleol en los átomos, en el que se reúne toda la carga positiva y casi toda la masa del átomo. Consiguió la primera transmutación artificial con la colaboración de su discípulo Frederick Soddy.

Henry Cavendish en su Laboratorio

La primera revolución científica comenzó con los descubrimientos de Copérnico, divulgados en 1.543, y los de Isaac Newton en 1.687 con su Gravedad y su obra de incomparable valor Principia Matemática, a todo esto siguió los nuevos hallazgos en la Física, la biología y la psicología.

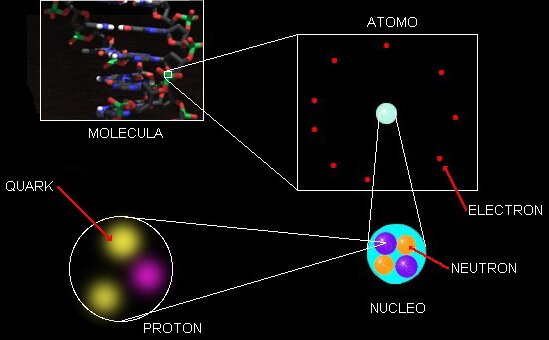

Pero fue la Física la que abrió el camino. Disciplina en permanente cambio, debido principalmente a la forma de entender el átomo (esa sustancia elemental, invisible, indivisible que Demócrito expuso en la Grecia antigua).

John Dalton

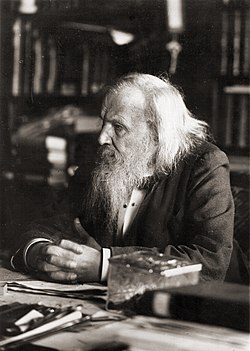

En estos primeras décadas del siglo XIX, químicos como John Dalton se habían visto forzados a aceptar la teoría de los átomos como las unidades mínimas de los elementos, con miras a explicar lo que ocurría en las reacciones químicas (por ejemplo, el hecho de que dos líquidos incoloros produjeran, al mezclarse, un precipitado blanco). De forma similar, fueron estas propiedades químicas y el hecho de que variaran de forma sistemática, combinada con sus pesos atómicos, lo que sugirió al ruso Dimitri Mendeleyev la organización de la Tabla Periódica de los elementos, que concibió jugando, con “paciencia química”, con sesenta y tres cartas en su finca de Tver, a unos trescientos kilómetros de Moscú.

Pero además, la Tabla Periódica, a la que se ha llamado “el alfabeto del Universo” (el lenguaje del Universo), insinuaba que existían todavía elementos por descubrir.

Dimitri Mendeléiev en 1897

La tabla de Mendeleyev encajaba a la perfección con los hallazgos de la Física de partículas, con lo que vinculaba física y química de forma racional: era el primer paso hacia la unificación de las ciencias que caracterizaría el siglo XX.

En Cavendish, en 1.873, Maxwell refinaría la idea de átomo al introducir la idea de campo electromagnético (idea que tomó prestada de Faraday), y sostuvo que éste campo “impregnaba el vacío” y la energía eléctrica y magnética se propagaba a través de él a la velocidad de la luz. Sin embargo, Maxwell aún pensaba en el átomo como algo sólido y duro y que, básicamente, obedecían a las leyes de la mecánica.

El problema estaba en el hecho de que, los átomos, si existían, eran demasiado pequeños para ser observados con la tecnología entonces disponible.

Esa situación empezaría a cambiar con Max Planck, el físico alemán que, como parte de su investigación de doctorado, había estudiado los conductores de calor y la segunda ley termodinámica, establecida originalmente por Rudolf Clausius, un físico alemán nacido en Polonia, aunque lord Kelvin también había hecho algún aporte.

El joven Max Planck

Clausius había presentado su ley por primera vez en 1.850, y esta estipulaba algo que cualquiera podía observar, a saber, que cuando se realiza un trabajo la energía se disipaba convertida en calor y que ese calor no puede reorganizarse en una forma útil. Esta idea, que por lo demás parecería una anotación de sentido común, tenía consecuencias importantísimas.

Dado que el calor (energía) no podía recuperarse, reorganizarse y reutilizarse, el Universo estaba dirigiéndose gradualmente hacia un desorden completo:

cántaro roto…

Una casa que se desmorona nunca se reconstruye así misma, una botella rota nunca se recompone por decisión propia. La palabra que Clausius empleó para designar este fenómeno o desorden irreversible y creciente fue “entropía”: su conclusión era que, llegado el momento, el Universo moriría.

En su doctorado, Planck advirtió la relevancia de esta idea. La segunda ley de la termodinámica evidenciaba que el tiempo era en verdad una parte fundamental del Universo, de la física. Sea lo que sea, el tiempo es un componente básico del mundo que nos rodea y se relaciona con la materia de formas que todavía no entendemos.

La noción de tiempo implica que el Universo solo funciona en un sentido, hacia delante, nunca se está quieto ni funciona hacia atrás, la entropía lo impide, su discurrir no tiene marcha atrás. ¿No será nuestro discurrir lo que siempre marcha hacia delante, y, lo que tenemos por tiempo se limita a estar ahí?

En el Laboratorio Cavendish, me viene a la memoria que fue allí, donde Thomson, en 1.897, realizó el descubrimiento que vino a coronar anteriores ideas y trabajos de Benjamín Franklin, Euge Goldstein, Wilhelm Röntgen, Henri Becquerel y otros. El descubrimiento del electrón convirtió a la física moderna en una de las aventuras intelectuales más fascinantes e importantes del mundo contemporáneo.

Thomson descubrió el electrón.

Los “corpúsculos”, como Thomson denominó inicialmente a estas partículas, hoy conocidas como electrones, condujo de forma directa al trascendental avance realizado una década después por Ernest Rutherford, quien concibió el átomo como una especie de “sistema solar” en miniatura, con los electrones diminutos orbitando alrededor de un núcleo masivo como hacen los planetas alrededor del Sol. Rutherford demostró experimentalmente lo que Einstein había descubierto en su cabeza y revelado en su famosa ecuación, E = mc2 (1905), esto es que la materia y la energía eran esencialmente lo mismo.

Todo aquello fue un gran paso en la búsqueda del conocimiento de la materia. El genio, la intuición y la experimentación han sido esenciales en la lucha del ser humano con los secretos, bien guardados, de la N

No podemos olvidar que, si aquel pasado no tendríamos este Presente.

emilio silvera

Sep

19

De lo pequeño a lo grande y, conocer la Naturaleza…¡No será...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

“Una formulación muy hermosa que, creo, procede de América es la siguiente: alguien que ha golpeado a otro afirma que sólo ha movido sus puños libremente; el juez, sin embargo, replica: «La libertad de movimiento de tus puños está limitada por la nariz de tu vecino».

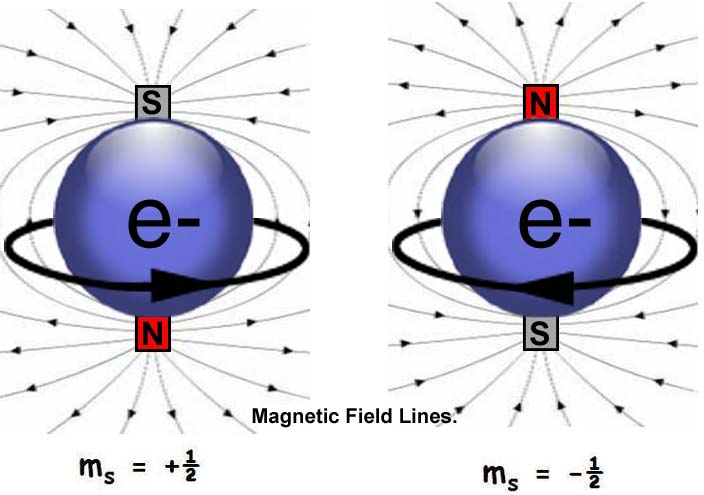

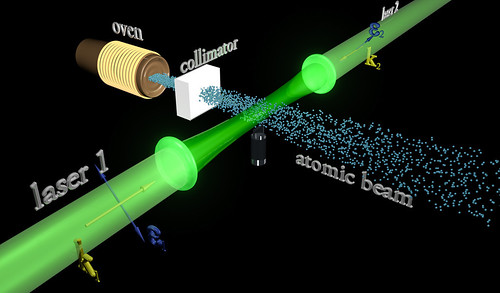

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7º K) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Una de las maravillas del Universo ¿Qué está pasando en el diminuto núcleo del átomo?

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosonesidénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

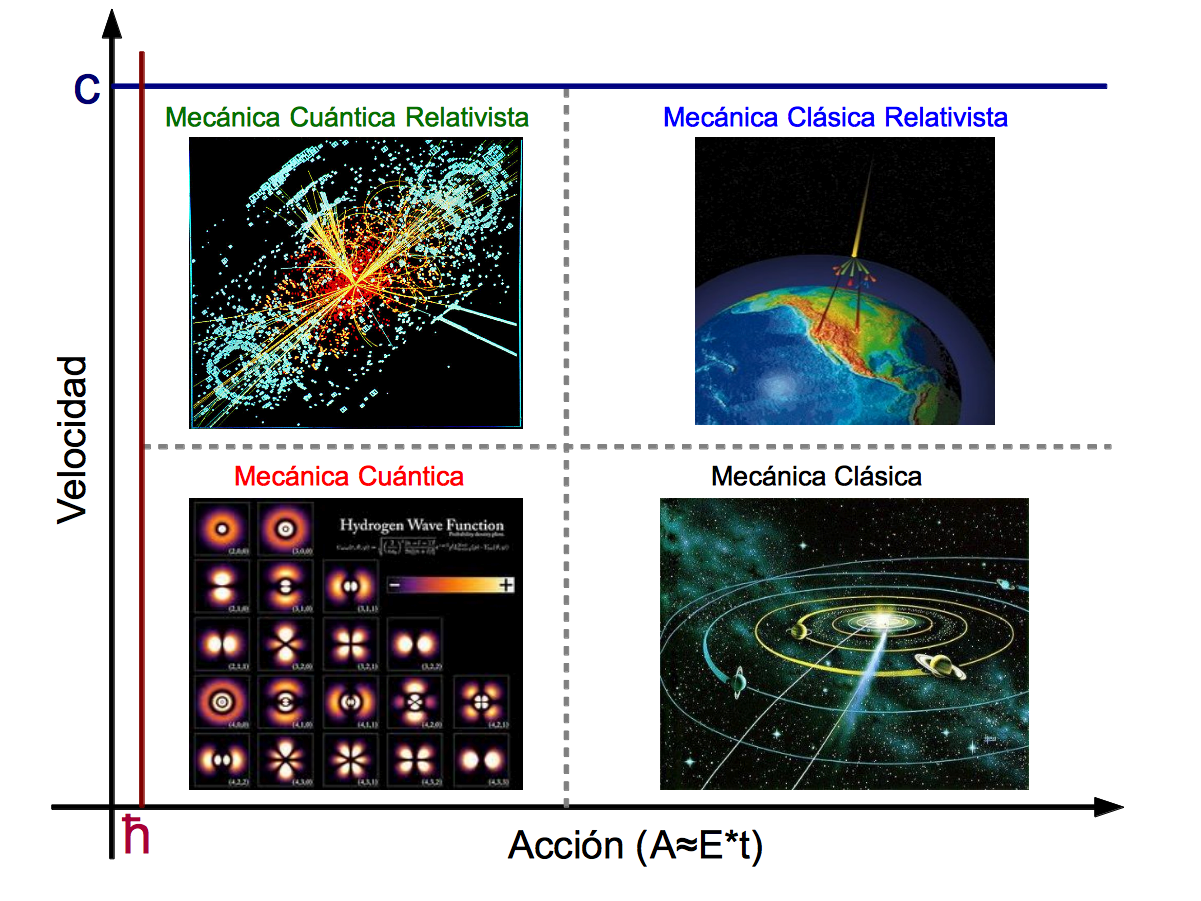

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Resulta fácil comprender cómo un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965

¿Qué es el anti-neutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos. Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un anti-deuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros anti-núcleos más complicados aún si se abordara el problema con más interés.

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

…, ¿Hay masas de antimateria en el Universo? ¿Galaxias de antimateria?

Bueno, sabemos que no son las galaxias las que se alejan, sino que es el espacio el que se expande. Lo que no sabemos es encontrar antimateria en el espacio interestelar y, si la hay y está presente… ¡Aún no la hemos podido localizar! Algunos dicen que hay galaxias de antimateria y, yo digo que tengo un pariente en la galaxia Astrinia del cúmulo Ultramón a diez mil millones de años-luz de nuestra región.

No parece que dichas observaciones, al menos hasta el , hayan sido un éxito.

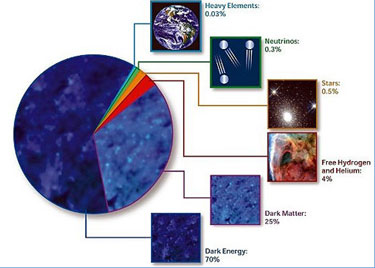

Según estimaciones recientes, resumidas en gráfico de la NASA, alrededor del 70% del contenido energético del Universo consiste en energía oscura, cuya presencia se infiere en su efecto sobre la expansión del Universo pero sobre cuya naturaleza última no se sabe casi nada.

¿Es posible que el Universo este formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? dado que la materia y la antimateria son equivalentes en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaria la otra, y el Universo debería estar compuesta de iguales cantidades de la una y de la otra.

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los causares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros como el único mecanismo conocido para producir la energía requerida.

Estábamos hablando de mecánica cuántica y me pasé, sin que me diera , al ámbirto de la antimateria y el espacio del macro universo de las galaxias. Sin embargo, y aunque parezcan temas dispares, lo cierto es que, a medida que profundizamos en estas cuestiones, todas nos llevan, de una u otra manera, a relacionar el “mundo de lo muy pequeño” con el “mundo” de lo muy grande que, al fín y al cabo, está hecho de lo que existe en el primero, es decir, partículas infinitesimales de materia y… ¡de antimateria! para que todo quede compensado.

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micromundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros.

La fuerza nuclear fuerte es la más potente del Universo

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son. En realidad, es la propia Naturaleza la que marca esos límites que Stoney-Planck, supieron plasmar en ecuaciones que los marcan.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 de centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Siempre hemos tratado de buscar información del Universo para saber de nuestro entorno, de nuestro Sistema solar, de nuestra Galaxias, de las galaxias lejanas, y, de las mismas estrellas que alumbran los mundos y permite la vida con su luz y su calor. Hemos llegado a saber que somos “polvo de estrellas”, que los materiales que nos conforman están “fabricados” en sus “hornos nucleares”, la fusión crea elementos que, más tarde, forman parte de los mundos y de los seres vivos.

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s(suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La información se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos.

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

(Longitud de Planck que al cuadrado sería de 10-66 cm2)

Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Stoney Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros estudios nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

|

α = 2πe2 / hc ≈ 1/137 |

|

αG = (Gmp2)2 / hc ≈ 10-38 |

Si varÍan algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

El número puro adimensional

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina”

Lederman

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Todo eso está relacionado: leyes fundamentales, constantes, materia y espacio tiempo… ¡nosotros! Es posible (digo posible), que finalmente no seámos ni tanto ni tan poco como a veces creemos. Dejémos en un término medio nuestra valía en el contexto del Universo, aunque, poder crear ideas y pensamientos… ¡No es cosa baladí!

emilio silvera

Sep

19

¡La Ciencia! A merced de Gobiernos de cortas miras

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticia comentada ~

Clasificado en Noticia comentada ~

Comments (0)

Comments (0)

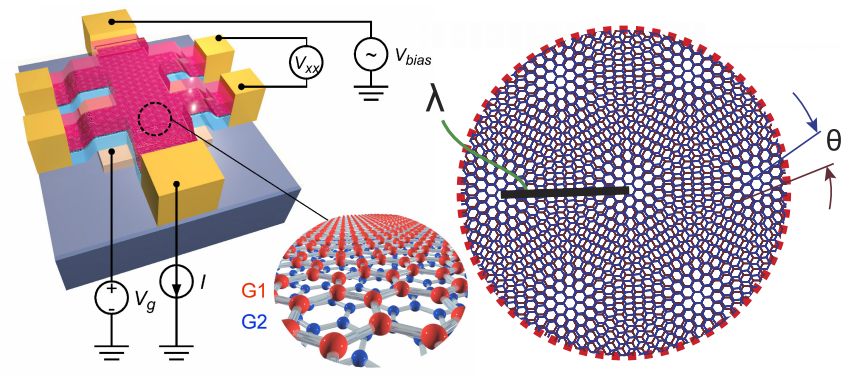

El físico Pablo Jarillo. Fundación BBVA

El físico valenciano “fichado” por Obama y el MIT: “En España m,e decían: “Echa el freno” Investigación Física de materiales

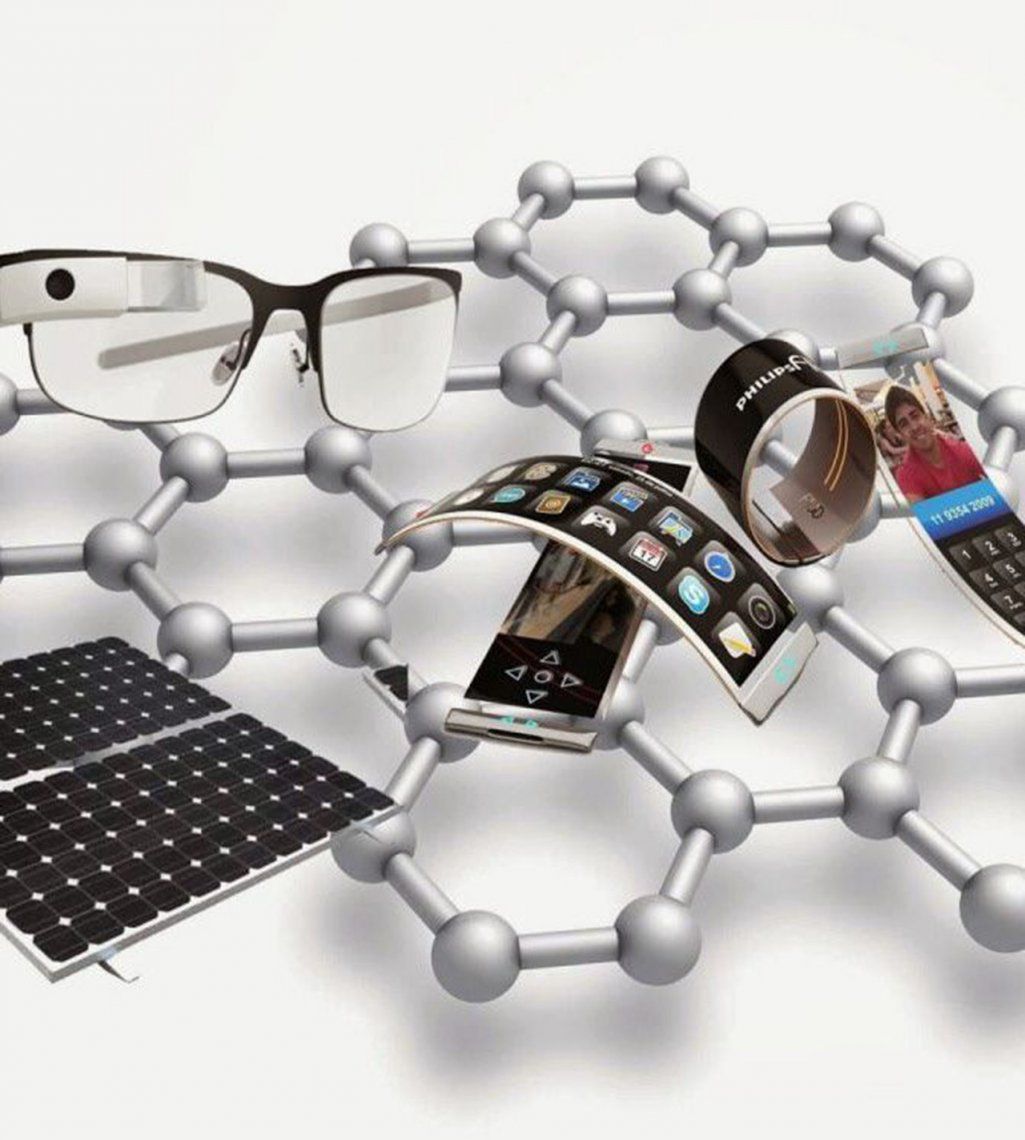

La investigación de Pablo Jarillo-Herrero sobre el grafeno fue premiada por la Casa Blanca y condujo a un hallazgo revolucionario el año pasado.

Noticias relacionadas

El grafeno entró en la vida de Pablo Jarillo-Herrero (Valencia, 1976) en 2005, recién doctorado en Física por la Universidad Tecnológica de Delft (Holanda). “Me pareció un material tan bonito que lo tuve que investigar”, explica este licenciado en Ciencias Físicas por la Universidad de Valencia.

Flash-forward a 2012, cuando su investigación le hace merecedor del galardón más prestigioso que concede el gobierno estadounidense para jóvenes investigadores, el Presidential Early Career Award for Scientists and Engineers. Jarillo recibe un millón de dólares como financiación y estrecha en persona la mano a Barack Obama en la Casa Blanca.

Un pequeño salto adelante más en esta vertiginosa carrera: es 2018 y Jarillo, al frente de su equipo del Instituto Tecnológico de Massachusets (MIT), revoluciona el ya de por sí pródigo campo del grafeno: han descubierto que, superponiendo dos láminas de este material y girándolas en lo que coloquialmente llaman el ‘angulo mágico’, adquiere una nueva y codiciada capacidad: la superconductividad.

Los materiales superconductores permiten transmitir electricidad sin pérdidas, como sufren incluso los conductores comunes más eficaces como el cobre. Una red eléctrica que usase la energía al 100% abre la puerta a un mundo más eficiente, pero hay un problema: solo funciona hoy en día solo a temperaturas de frío extremo, muy por debajo del cero.

El reto de una superconductividad a altas temperaturas, o a temperatura ambiente, ha centrado la XXVI edición de la Escuela de Verano ‘Nicolás Cabrera’ organizada por la Fundación BBVA y en la que Jarillo participa como ponente.

Teniendo en cuenta lo reciente que es el campo del grafeno y lo joven que es usted, cabe pensar que tienen, mano a mano, décadas de descubrimiento por delante.

Sí, yo creo que sí [ríe]. El descubrimiento de la superconductividad del grafeno ha generado un nuevo campo y mucho entusiasmo, no solo en mi grupo sino en laboratorios de todo el mundo. Yo creo que sí, que va a dar para décadas de investigación. Es bastante complejo, no creo que lo entendamos demasiado pronto [ríe].

El reto que se aborda ahora es el de la superconductividad a temperatura ambiente.

Claro, la superconductividad que hemos descubierto es a baja temperatura. Para temperatura ambiente ya existe un material, pero lo hace bajo condiciones extremas de presión. No tiene ninguna posibilidad de aplicación, por lo que se buscan materiales que sean superconductores y se pueda hacer algo con ellos.

Porque, retrotrayéndonos a la historia del grafeno, todo comienza con el estudio del grafito, el mismo de la mina de un lápiz.

Exacto. En el año 2004, dos científicos rusos que trabajaban entre Holanda e Inglaterra descubrieron que, si tienes grafito, puedes aislar una sola capa. Eso es el grafeno. Y tiene unas propiedades electrónicas muy inusuales. A partir de ahí muchísima gente se puso a investigarlo. Se habían descubierto muchas características peculiares, únicas y extraordinarias, pero no un comportamiento emblemático de los materiales como es la superconductividad. El descubrimiento que nosotros hicimos el año pasado es que si tú pones dos capas una encima de la otra y la rotas un pequeño ángulo, solo un grado, resulta que puede superconducir. Fue una sorpresa total.

A esta técnica le ha puesto un nombre fantástico: twistrónica.

[Ríe] Efectivamente, twistronics, de twist, rotar… como hacer un Twist.

Y esto da prueba de las propiedades increíbles del grafeno: se estira, se dobla, se modifica…

En la historia de la ciencia de materiales, nunca antes se había podido “girar” un ángulo entre dos estructuras bidimensionales cristalinas. Un material tridimensional crece con la estructura en función de su naturaleza. Y un semiconductor, como el transistor de un teléfono móvil, está hecho de arseniuro de galio, y solo puede crecer por la superposición de capas alineadas. Pero al descubrir los materiales bidimensionales, podemos poner dos láminas e inclinarlas en el ángulo que queramos. Y entonces puede adquirir propiedades que no tenía originalmente. El grafeno no era superconductor y ahora superconduce, y no solo eso: yo puedo aplicarle un voltaje para convertirlo en aislante, en un metal, hacer mogollón de cosas.

¿El ‘ángulo mágico’ se puede usar como interruptor entre distintas funciones del grafeno?

Sí. Desde el punto de vista ingenieril, lo que hemos hecho es un trasistor-superconductor: una cosa que la puedes poner en estado superconductor o en estado aislante, eléctricamente, como un switch. El ‘ángulo mágico’ ha sido lo primero que ha conseguido hacer algo así, y por eso hay tanta gente entusiasmada.

Porque las expectativas sobre el grafeno van desde su uso en la ropa a chips para la computación cuántica…

Yo creo que ahí se han creado expectativas poco realistas. Sobre todo de cuándo va a ocurrir, si es que ocurre alguna vez. Me puedo imaginar lo de incorporar electrónica flexible a los tejidos gracias a los materiales bidimensionales. Pero el grafeno no va a reemplazar al silicio en nuestros ordenadores, porque es muy bueno en lo que hace y hay una gran inversión e inercia detrás. Lo que si podría permitir es tener aplicaciones que no tenemos ahora.

¿Por eso no le gusta llamar al grafeno ‘el material de Dios’, por no crear expectativas desbordantes?

Bueno, es simplemente porque eso no tiene ningún significado. Es añadir un calificativo que no aporta ninguna información.

¿Y cómo lo llamaría usted?

Es un material extraordinario. ¿Puedes decir que es el más fino del mundo? Sí. Nada puede ser más fino que el espesor de un átomo. ¿Es el más fuerte? También. Y el que mejor conduce la electricidad. Hay muchos calificativos. Algunos lo llaman “material superlativo”, que tampoco te dice mucho: significa que, en muchos campos, es “lo más”. Un “supermaterial”, vaya, eso dice un poco más [ríe].

El físico valenciano Pablo Jarillo. Fundación BBVA

El químico Omar Yaghi, premiado en una edición anterior, lamentaba que la ciencia básica estuviera “bajo ataque”: se penaliza la investigación que no tiene resultados inmediatamente aplicables

Estoy totalmente de acuerdo. Si uno piensa en los orígenes de las mayores revoluciones tecnológicas -la electricidad, la máquina de vapor, el láser-, encontramos físicos, químicos o biólogos que estudiaban por pura curiosidad científica. En muchos casos, las aplicaciones prácticas no llegaron hasta décadas o siglos después. Por poner un ejemplo: los satélites de GPS funcionan con relojes atómicos que se inventaron para investigar propiedades de mecánica cuántica totalmente básicas. Nadie imaginaba que un día permitirían localizar la posición como se puede hacer ahora. La precisión en centímetros se basa en algunos conceptos de la Teoría de la Relatividad General de Einstein, que nadie pensó en su día que serviría para nada.

/s3.amazonaws.com/arc-wordpress-client-uploads/infobae-wp/wp-content/uploads/2018/09/20173758/mit-supply-chain-management-00_0.jpg)

El MIT capta a los jóvenes talentos

¿En una preocupación también presente en el MIT?

Si uno pone mucha presión en resultados a muy corto plazo, obtiene resultados muy incrementales. Mejoras de tecnología que ya tienes. Avanzas de manera lineal, si es que avanzas. Y es más de lo mismo. Es muy importante que la sociedad sea capaz de tener paciencia. Invertir en conocimiento puro genera a largo plazo mucho más crecimiento. En el MIT lo tienen claro. Pero se nutren sobre todo de fondos federales de investigación. Y el Gobierno de EEUU, como todos los del mundo, presiona por esa inmediatez. La inversión en ciencia básica está decreciendo.

¿Qué percepción hay sobre España, ahora que la ciencia vuelve a tener su Ministerio con un ingeniero e investigador -antes que astronauta- al frente?

Pedro Duque lleva relativamente poco como para ver un cambio significativo. A mi me parece muy normal que la ciencia tenga un Ministerio en sí. España tenía un gran atraso derivado de la dictadura que tuvimos durante 40 años. Volver a subirse al tren costó mucho, y no se han hecho las inversiones que cabría esperar. En algunos sectores hay grupos muy competitivos, pero de media, no estamos al nivel de otros países europeos, de EEUU, Japón o China. Creo que en este país hay menos tradición científica entre la clase gobernante, no entienden el beneficio a largo plazo.

Los presidentes de EEUU se implican personalmente en grandes proyectos científicos: Kennedy y la llegada del hombre a la Luna, Clinton y el genoma humano, Obama y el mapa del cerebro…

Durante la II Guerra Mundial, EEUU juntó un gran equipo de físicos, matemáticos y químicos de prestigio para desarrollar la bomba atómica. Y el poder político se dio cuenta de las ventajas, en este caso militares y con consecuencias lamentables. Pero desde entonces, durante décadas y hasta hace poco, se ha confiado en los científicos y han llegado logros mejores para la Humanidad. El presidente tiene por tradición un comité de asesores científicos y un asesor presidencial de muy alta categoría. Obama se reunía con él cada semana. Tenía al otro lado del teléfono a los expertos que necesitase para tomar decisiones informadas. Es una pena que no exista en España.

Quizás esa tradición en EEUU se traduce en mejores condiciones para su personal investigador.

Pero no solo eso. En EEUU se apuesta mucho por la gente joven, más que en Europa. A mi me dieron un montón de dinero y me dijeron: “Pensamos que tienes buenas ideas, haz lo que te parezca”. Yo creo que hay que apostar por los jóvenes, en general son más innovadores.

¿Se puede hablar de meritocracia? ¿Es más difícil acceder a la universidad pero los excelentes obtienen mayores oportunidades?

¿Más difícil cómo? ¿Económicamente? Sí y no. Cuando solicitas la admisión en el MIT, nadie te pregunta si puedes pagar. Si te admiten, te preguntan: “¿Tienes dinero?” Y si dices que no, no pasa nada: estudias gratis. Si lo tienes, pagas. No pasa en todas partes, solo en los centros que pueden permitírselo, pero yo tengo muchos estudiantes en el MIT que no están pagando ni un dólar. El aspecto de la meritocracia es el que más me gusta. A la gente que tiene ganas y trabaja duro se le intenta dar todas las posibilidades. Nadie te pone techos. En España, lo normal es decirte: “Para el carro, echa el freno”. Cuando estaba en la carrera, comiendo con un profesor, le pregunté por qué no iba a EEUU con los mejores en su campo: “¡Uy¡”, me dijo, “tienes una idea un poco distorsionada. Tú, con llegar aquí, date con un canto en los dientes”.

Sep

18

Las estrellas y la Vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

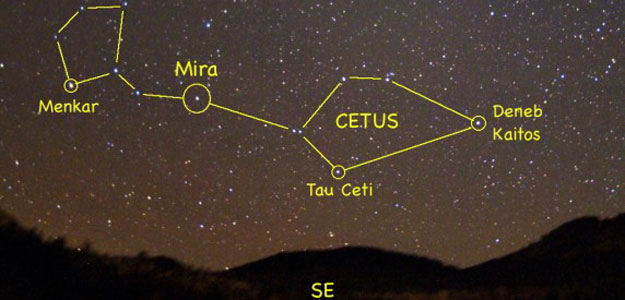

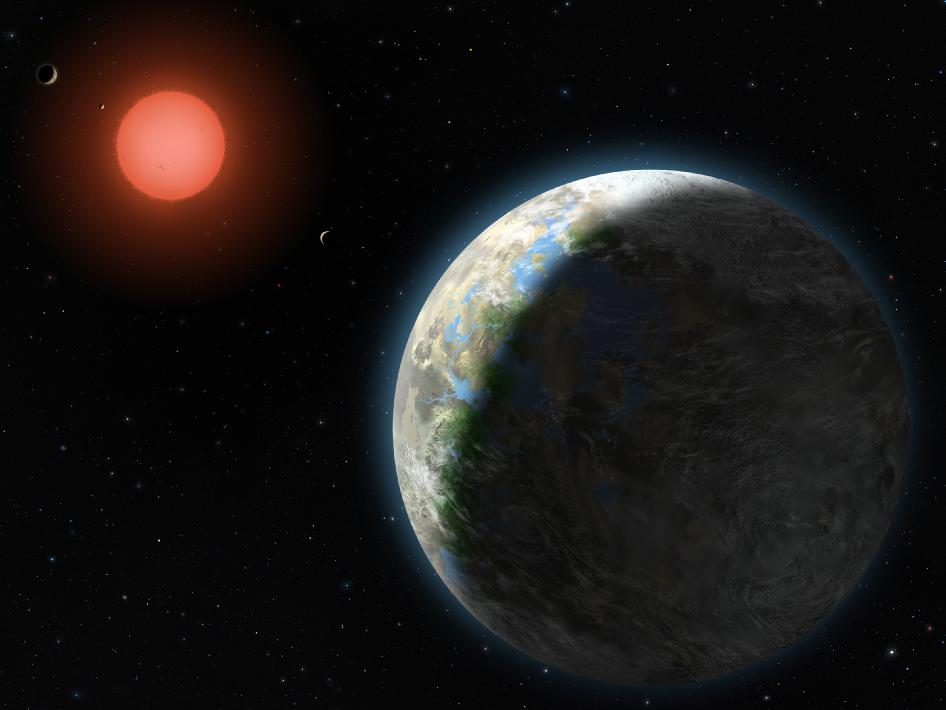

Hay una veintena de estrellas que se encuentran dentro de un radio de acción marcado por los doce años-luz de distancia al Sol. ¿Cuál de ella se nos presenta como la más probable para que, algunos de sus planetas pudieran albergar alguna clase de vida, incluso Vida Inteligente? La estrella más cercana a nosotros es Alfa Centauri que, en realidad es un sistema estelar situado a unos 4.37 años-luz de nosotros (unos 42 billones de kilómetros). En realidad, se trata de un sistema de tres estrellas.

Alfa Centauri contiene al menos un planeta del tamaño terrestre con algo más de la masa de la Tierra que está orbitando a Alfa Centauri B. Sin embargo, su cercanía a la estrella, unos 6 millones de kilómetros lo hace tener una temperatura de más de 1.ooo ºC lo que parece ser muy caliente para albergar alguna clase de vida.

Alfa Centauri, seguramente por su cercanía a nosotros, ha ejercido siempre una sugestiva atracción para nosotros cuando miramos el cielo nocturno. Resulta ser, en su conjunto, la tercera estrella más brillante de todas, y junto con Hadar (Beta Centauri), las dos en la imagen de arriba, es una muy importante y útil referencia para la localización de la Cruz del Sur. Además, y como se trata de una estrella triple, Alpha Centauri A, la componente principal, se constituye en una buena candidata para la búsqueda de planetas del mismo tipo que la Tierra.

Las tres estrellas se formaron a partir de la misma nebulosa de materia interestelar. El trio de estrellas se van orbitando las unas a las otras a un ritmo como de vals, unidas por los lazos invisibles de la fuerza gravitatoria que generan y con la que se influyen mutuamente. Lo cierto es que las estrellas triples gozan de pocas probabilidades para albergar la vida, porque no pueden mantener a sus planetas en una órbita estable y segura, la inestabilidad que producen las tres estrellas en esos posibles planetas, parece que sería insoportable para formas de vida inteligente. Claro que, las distancias a las que se encuentran unas estrellas de otras es grande y… ¿quién sabe? Nunca podemos afirmar nada sin haberlo confirmado.

La siguiente estrella más allá de Alfa Centauri es la estrella de Barnard, situada a 6 años-luz aproximadamente de nuestro Sol, o, lo que es lo mismo, a unos sesenta mil billones de kilómetros de distancia. Esta estrella parece contar con una familia de planetas. Sin embargo, es una estrella muy vieja, casi tanto como el propio universo, y, por tanto, es deficitaria en la mayoría de los elementos químicos esenciales para la vida. Es poco prometedora para buscar vida en sus alrededores.

Las 10 estrellas más cercanas al Sol se encuentran en un rango de distancia entre los 4 y 10 años luz. Para tener una idea, la Vía Láctea mide unos 100.000 años luz, lo cual convierte a estas estrellas en verdaderas vecinas:

En un radio de 12,5 años-luz

- Alfa Centauri (que, en realidad, es un sistema de tres estrellas): a 4,2 años luz.

- Estrella de Barnard: a 5,9 años luz.

- Wolf 359: a 7,7 años luz.

- Lalande 21185: a 8,2 años luz

- Sirio (un sistema binario de estrellas): a 8,6 años luz

- Luyten 726-8 (otro sistema binario): a 8,7 años luz.

- Ross 154: a 9,7 años luz

- Ross 248: a 10,3 años luz

- Epsilon Eridani: a 10,5 años luz.

- Lacaille 9352: a 10,7 años luz

Una supertierra orbita a la estrella de Barnard

Más allá de Barnard existe un cierto numero de estrellas, todas ellas poco prometedoras para la existencia de vida y de inteligencia porque, o son demasiado pequeñas y frías para emitir la clase de luz que la vida tal como la conocemos requiere, o demasiado jóvenes como para que haya aparecido la vida inteligente en los planetas que las circundan. No encontraremos otra estrella que pueda albergar la vida y seres inteligentes hasta que no viajemos a una distancia próxima a los once años-luz del Sol.

Épsilon Eridani está situada a unos 10,5 años-luz del Sol, es una de las estrellas más cercanas al Sistema Solar y la tercera más próxima visible a simple vista. Está en la secuencia principal, de tipo espectral K2, muy parecida a nuestro Sol y con una masa algo menor que éste, de unas 0,83 masas solares. Es joven, sólo tiene unos 600 millones de años de edad mientras que el Sol tiene 4.600 millones de años.

Épsilon emite menos luz visible y luz ultravioleta que nuestra estrella, pero probablemente sea suficiente para permitir allí el comienzo de la vida que, si tenemos en cuenta el corto tiempo que ha pasado, no llegaría a poder ser inteligente. Claro que, los cálculos realizados sobre la vida de las entrellas en general y sobre esta en particular… ¡No son fiables! Y, siendo así (que los), tampoco podemos estar seguro de lo que en sus alrededores pueda estar presente. Se le descubrió un planeta orbitando a su alrededor, Épsilon Eridani b, que se descubrió en el año 2000. La masa del planeta está en 1,2 ± 0,33 de la de Júpiter y está a una distancia de 3,3 Unidades Astronómicas. Se cree que existen algunos planetas de reciente formación que orbitan esta estrella.

El sol (izquierda) es de mayor tamaño y algo más caliente que Tau Ceti (derecha).

Más allá de Épsilon Eridani hay nueve estrellas que se encuentran todavía dentro de un margen de distancia del Sol que no sobrepasan los 12 años-luz. Sin embargo, todas ellas, menos una, son demasiado jóvenes, demasiado viejas, demasiado pequeñas o demasiado grandes para poder albergar la vida y la inteligencia. La excepción se llama Tau Ceti.

Tau Ceti está situada exactamente a doce años-luz de nosotros y satisface todas las exigencias básicas para que en ella (en algún planeta de su entorno) haya podido evolucionar la vida inteligente: Se trata de una estrella solitaria como el Sol -al contrario que Alfa Centauri- no tendría dificultad alguna en conservar sus planetas que no serían distorsionados por la gravedad generada por estrellas cercanas. La edad de Tau Ceti es la misma que la de nuestro Sol y también tiene su mismo tamaño y existen señales de que posee una buena familia de planetas. No parece descabellado pensar que, de entre todas las estrellas próximas a nosotros, sea Tau Ceti la única con alguna probabilidad de albergar la vida inteligente.

La noticia que publicaron los medios decía: ¡Descubren un nuevo planeta extrasolar que se encuentra en una zona habitable! El planeta orbita en torno a la estrella Tau Ceti, a doce años luz del Sol. Hay cinco cuerpos cuya masa oscila entre dos y seis veces la de la Tierra.

¿Quién sabe lo que en algunos de esos planetas que orbitan la estrella Tau Ceti pudiera estar pasando? Y, desde luego, dadas las características de su sistema planetario y la cercanía que parece existir entre alguno de los mundos allí presentes, si algún ser vivo inteligente pudiera contemplar el paisaje al amanecer, no sería extraño que pudiera ser testigo de una escena como la que arriba contemplamos. ¿Es tan bello el Universo! Cualquier escena que podamos imaginar en nuestras mentes… ¡Ahí estará! en alguna parte.

Es cierto que la vida, podría estar cerca de nosotros y que, por una u otra circunstancia que no conocemos, aún no hayamos podido dar con ella. Sin embargo, lo cierto es que podría estar mucho más cerca de lo que podemos pensar y, desde luego, es evidente que el Sol y su familia de planetas y pequeños mundos (que llamamos lunas), son también lugares a tener en cuenta para encontrarla aunque, posiblemente, no sea inteligente.

La distancia nos hace ver un conjunto de estrellas casi juntas, cuando en realidad, están separadas por miles de millones de kilómetros las unas de las otras.

Con certeza, ni sabemos cuentos cientos de miles de millones de estrellas puede haber en nuestra propia Galaxia, la Vía Láctea. Sabemos más o menos la proporción de estrellas que pueden albergar sistemas planetarios y, sólo en nuestro entorno galáctico podrían ser cuarenta mil millones de estrellas las que pudieran estar habilitadas para poder albergar la vida en sus planetas.

Estas cifras asombrosas nos llevan a plantear muchas preguntas, tales como: ¿Estarán todas esas estrellas prometedoras dando luz y calor a planetas que tengan presente formas de vida, unas inteligentes y otras no? ¿O sólo lo están algunas? ¿O ninguna a excepción del Sol y su familia. Algunos astrónomos dicen que la ciencia ya conoce la respuesta a esas preguntas. Razonan que la Tierra es una clase de planeta ordinario, que contiene materiales también ordinarios que pueden encontrarse por todas las regiones del Universo, ya que, la formación de estrellas y planetas siempre tienen su origen en los mismos materiales y los mismos mecanismos y, en todas las regiones del Universo, por muy alejadas que estén, actúan las mismas fuerzas, las mismas constantes, los mismos ritmos y las mismas energías.+

Gliese 581 ¿Otra promesa vida?

Planetas como la Tierra y muy parecidos los hay en nuestra propia Galaxia a miles de millones y, si la vida hizo su aparición en esta paradisíaca variedad de planeta, estos astrónomos se preguntan, ¿por qué no habría pasado lo mismo en otros planetas similares al nuestro? ¿Tiene acaso nuestro planeta algo especial para que sólo en él esté presente la vida? La Naturaleza, amigos míos, no hace esa clase de elecciones y su discurrir está regido por leyes inamovibles que, en cualquier circunstancia y lugar, siempre emplea los caminos más “simples” y lógicos para que las cosas resulten como nosotros las podemos contemplar a nuestro alrededor. Y, siendo así (que lo es), nada aconseja a nuestro sentido común creer que estamos sólos en tan vasto Universo.

El célebre astrónomo, con una sonrisa oía la pregunta del joven periodista:

– ¿Verdad señor que sería un milagro encontrar vida en otros planetas?

– El milagro joven, ¡sería que no la encontráramos!

emilio silvera

Totales: 75.628.529

Totales: 75.628.529 Conectados: 63

Conectados: 63