Sep

18

¿De dónde venimos? ¿Hacia dónde vamos? ¿Quiénes somos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo cambiante ~

Clasificado en El Universo cambiante ~

Comments (0)

Comments (0)

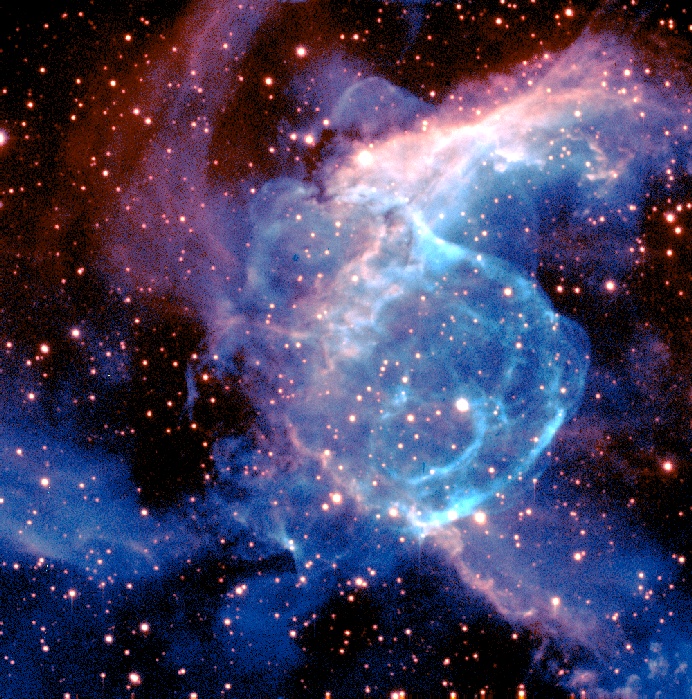

Miramos la Naturaleza y su asombrosa belleza, y, no siempre podemos explicar lo que vemos. Miramos el Universo y sus maravillas y sólo podemos asombrarnos. Nos pasamos todo el tiempo haciendo preguntas que, la mayoría de las veces nadie sabe contestar. Aprendemos a base de equivocarnos una y otra vez y, la observación y el estudio, la teoría y las matemáticas nos han llevado a discernir en qué lugar estamos pero… ¿No habremos tomado el camino hacia ninguna parte?

“¿Dónde estaríamos nosotros cuando se conformaron los cimientos de la Tierra?”

El titulo de ésta pagína es la pregunta que se hicieron los filósofos desde tiempos inmemoriales, y, en relación a las preguntas que se plantean, con los conocimientos que actualmente tenemos podríamos exponer diverdsas respuestas que serían el resultado de las distintas perspectivas que, cada una de ellas, pueden mostrarnos. Lo cierto es que, a ciencia cierta, nadie sabría contestar y todas esas posibles respuestas serían aproximaciones más o menos acertadas a los problemas planteados.

Muchas cosas han pasado desde que se formó la Tierra hasta llegar a nuestros días

“Nosotros, los humanos, llegamos muchísimo más tarde, cuando los materiales que formaron la Tierra estaban más fríos y se formaron los océanos, cuando había ya una atmósfera y, lo cierto es que, los materiales que hicieron posible nuestra presencia aquí, estaban en aquella nebulosa que se esparcía en el esapcio interestelar que hoy ocupa nuestro Sistema solar, una supernova hace ahora miles de millones de años, fue el pistoletazo de salida. Después, el Tiempo, aliado con la materia y la fuerza de gravedad, hicieron posible que surgiera el Sol y, a su alrededor, los planetas y lunas de nuestro entorno, y, con la ayuda de lo que hemos llamado evolución y los ingredientes precisos de atmósfera, agua, radioactividad y otros parámetros necesarios, surgío aquella primera célula replicante que lo comenzó todo, es decir, la aventura de la Vida.”

Una Tierra ígnea, incandescente, sin vida

Todas estas explicaciones, son muy pobres para describir los acontecimientos que aquí tuvieron lugar antes de que nosotros hiciéramos acto de presencia como seres humanos verdaderos. Ya me gustaría saber para poder contestar a todas las preguntas que me plantean.

La especulación sobre el origen del Universo es una vieja y destacada actividad humana. Vieja por el simple hecho de que la especie humana, no tiene ningún certificado de nacimiento y, tal desconocimiento de sus orígenes, les hace ser curiosos, deseosos de saber el por qué están aquí y pudo suceder su venida. Estamos obligados a investigar nuestros orígenes nosotros sólos, sin la ayuda de nadie, es el caso que, ningún ser inteligente nos puede contar lo que pasó y, siendo así, nos vemos abocados a tener que hurgar en el pasado y valernos de mil ingeniosos sistemas para tratar de saber. Así que, si investigamos sobre el mundo del que formamos parte, esas pesquisas terminarán por decirnos más, sobre nosotros mismos que sobre el universo que pretendemos describir. En realidad, todos esos pensamientos, que no pocas veces mezclan lo imaginario con la realidad, todo eso, en cierta medida, son proyecciones psicológicas, esquemas proyectados por nuestras mentes sobre el cielo, como sombras danzantes de un fuego fatuo que no siempre nos transmite algún mensaje.

Aquellos mitos de la creación pre-científicos dependían en su supervivencia menos de su acuerdo con los datos de la observación (de los que, de todos modos había pocos) que del grado en que eran satisfactorios, o tranquilizantes o poeticamente atractivos. Aficionados a ellos puesto que eran nuestros, esos cuentos poníann de relieve lo que más importaba a las sociedades que los conservaban. Los sumerios vivían en una confluencia de ríos, y, concebían la creación como una lucha en el barro entre dos dioses. Los mayas, obsesionados por los juegos de balón, conjeturaban que su creador se transformaba en balón cada vez que planeta Venus desaparecía detrás del Sol. El pescador tahitiano, hablaba de un dios pescador que arrastro sus islas desde el fondo del océano. Los espadachines japoneses formaron sus islas de gotas de sangre que caían de una espada cósmica. Para los griegos amantes de la lógica, la creación fue obra de los elementos: Para Tales de Mileto, el universo originalmente fue Agua; para Anaxímenes, fue Aire; para Heráclito, Fuego…Todos los pueblos tenían su propia génesis… Y, ¿cuál será la nuestra?

En Cosmología, las condiciones “iniciales” raramente son absolutamente iniciales, pues nadie sabe como calcular el estado de la materia y el espacio-tiempo antes del Tiempo de Planck, que culminó alrededor de 10-43 de segundo después del comienzo del tiempo. ¿Qué pasó en ese brevísimo intervalo de tiempo? Nadie lo sabe. Pero, a pesar de ello, nosotros pretendemos saber cómo comenzamos nuestra andadura en este mundo que, en realidad, comenzó en otro lugar muy lejano y muy caliente.

Es verdaderamente encomiable la pertinaz insistencia del ser humano por saber, y, en el ámbito de la Astronomía, desde los más remotos “tiempos” que podamos recordar o de los que tenemos alguna razón, nuestra especie ha estado interesada en saber, el origen de los objetos celestes, los mecanismos que rigen sus movimientos y las fuerzas que están presentes.

Nuestros ancestros miraban asombrados la salida y puesta del Sol

Claro que, nosotros, los Humanos, llevamos aquí el tiempo de un parpadeo del ojo si lo comparamos con el Tiempo del Universo. Sin embargo, nos hemos valido de todos los medios posibles para llegar al entendimiento de las cosas, incluso sabemos del pasado a través del descubrimiento de la vida media de los elementos y mediante algo que denominamos datación, como la del Carbono 14, podemos saber de la edad de muchos objetos que, de otra manera, sería imposible averiguar. La vida de los elementos es muy útil y, al mismo tiempo, nos habla de que todo en el Universo tiene un Tiempo Marcado. Por ejemplo, la vida media del Uranio 238 sabemos que es de 4.000 millones de años, y, la del Rubidio tiene la matusalénica vida media de 47.000 millones de años, varias veces la edad que tiene el Universo.

Hablaremos ahora del Big Bang (lo único que tenemos para agarrarnos a lo que “parece que fue”), esa teoría aceptada por todos y que trata de explicar cómo se formó nuestro universo y comenzó su evolución hasta llegar a ser como ahora lo podemos observar. De acuerdo a esta teoría, el universo se originó a partir de un estado inicial de alta temperatura y densidad, y entonces ha estado siempre expandiéndose. La teoría de la relatividad general predice la existencia de una singularidad en el comienzo, la temperatura y la densidad eran infinitas.

La mayoría de los cosmólogos interpretan singularidad una indicación de que la realtividad general de Einstein deja de ser válida en el universo muy primitivo (no existía materia), y el comienzo mismo debe ser estudiado utilizando una teoría de cosmología cuántica.

El Tiempo de Planck es una unidad de tiempo considerada como el intervalo temporal más pequeño que ser medido. Se denota mediante el símbolo tP. En cosmología, el Tiempo de Planck representa el instante de tiempo más antiguo en el que las leyes de la física pueden ser utilizadas para estudiar la Naturaleza y evolución del Universo. Se determina como combinación de otras constantes físicas en la siguiente:

5.39124(27) × 10−43 segundos

5.39124(27) × 10−43 segundos

Esta que es una de las célebres unidades de Planck, está formada por una combinación de la constante de estructura fina racionalizada ( , la constante gravitacional (G), y la velocidad de la luz elevada a la quinta potencia.

, la constante gravitacional (G), y la velocidad de la luz elevada a la quinta potencia.

La Era de planck: Es la era que comenzó cuando el efecto gravitacional de la materia empezó a dominar sobre el efecto de presión de radiación. Aunque la radiación es no masiva, tiene un efecto gravitacional que aumenta con la intensidad de la radiación. Es más, a altas energías, la propia materia se comporta como la radiación electromagnética, ya que se mueve a velocidades próximas a la de la luz. En las etapas muy antíguas del universo, el ritmo de expansión se encontraba dominado por el efecto gravitacional de la presión de radiación, pero a medida que el universo se enfrió, efecto se hizo menos importante que el efecto gravitacional de la materia. Se piensa que la materia se volvió predominante a una temperatura de unos 104 K, aproximadamente 30.000 años a partir del Big Bang. Este hecho marcó el comienzo de la era de la materia.

La materia salió de ese clima de enormes temperaturas inimaginables y, durante varias etapas o eras (de la radiación, de la materia, hadrónica y bariónica… llegamos al momento presente habiendo descubierto muchos de los secretos que el Universo guardaba celosamente para que nosotros, los pudiéramos desvelar.

Era de la radiación

Periodo 10-43 s (la era de Planck) y 300.000 después del Big Bang… Durante periodo, la expansión del universo estaba dominada por los efectos de la radiación o de las partículas rápidas (a altas energías todas las partículas se comportan como la radiación). De hecho, la era leptónica y la era hadrónica son ambas subdivisiones de la era de radiación. La era de radiación fue seguida por la era de la materia que antes se reseña, durante la cual los partículas lentas dominaron la expansión del universo.

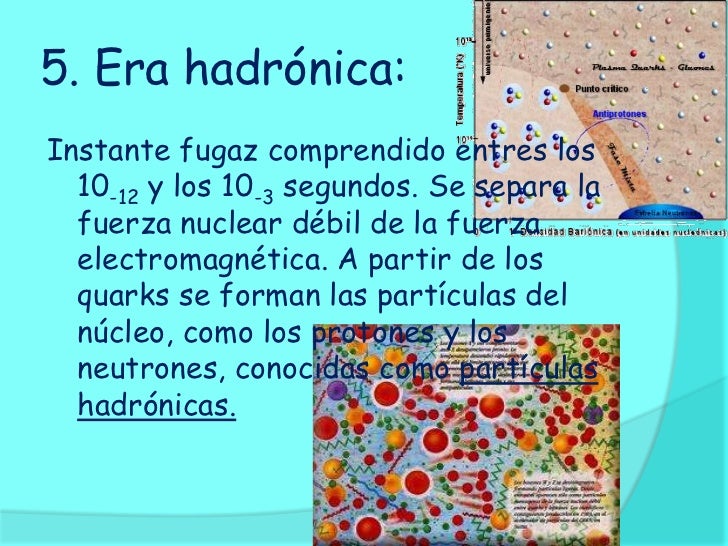

Era hadrónica

Corto periodo de tiempo entre 10-6 s y 10-5 s después del Big Bang en el que se formaron las partículas atómicas pesadas, protones, neutrones, piones, kaones entre otras. del comienzo de la era hadrónica, los quarks se comportaban como partículas libres. El proceso por el que se formaron los quarks se denomina transición de fase quark-hadrón. Al final de la era hadrónica, todas las demás especies hadrónicas habían decaído o se habían desintegrado, dejando sólo protones o neutrones. Inmediatamente después de esto el universo entró en la era leptónica.

Era Leptónica

Intervalo que comenzó 10-5 s después del Big Bang, en el que diversos tipos de leptones eran la principal contribución a la densidad del universo. Se crearon pares de leptones y antileptones en gran en el universo primitivo, pero a medida que el universo se enfrió, la mayor parte de las especies leptónicas fueron aniquiladas. La era leptónica se entremezcla con la hadrónica y ambas, como ya dije antes, son subdivisiones de la era de la radiación. El final de la era leptónica se considera normalmente que ocurrió cuando se aniquilaron la mayor parte de los pares electrón-positrón, a una temperatura de 5×109 K, más o un segundo después del Big Bang. Después, los leptones se unieron a los hadrónes formar átomos.

El universo es el conjunto de todo lo que existe, incluyendo ( he dicho) el espacio, el tiempo y la materia. El estudio del universo se conoce como cosmología. Los cosmólogos distinguen al Universo con “U” mayúscula, significando el cosmos y su contenido, y el universo con “u” minúscula, que es normalmente un modelo matemático deducido de alguna teoría física como por ejemplo, el universo de Friedmann o el universo de Einstein-de Sitter. El universo real está constituido en su mayoría de espacios que aparentemente están vacíos, existiendo materia concentrada en galaxias formadas por estrellas, planetas, gases y otros objetos cosmológicos.

En 1932 Einstein y de Sitter propusieron que la constante cosmológica debe tomar valor cero, y construyeron un modelo cosmológico homogéneo e isótropo que representa el caso intermedio los modelos abierto y cerrado de Friedmann. Einstein y de Sitter supusieron que la curvatura espacial del Universo no es ni positiva ni negativa, sino nula.

La geometría espacial de modelo es por lo tanto la geometría plana de Euclides; sin embargo el espacio-tiempo en su conjunto no es plano: hay curvatura en la dirección temporal. El tiempo comienza también en una Gran Explosión y las galaxias se alejan continuamente entre sí, sin embargo la velocidad de recesión (constante de Hubble) disminuye asintóticamente a cero a medida que el tiempo avanza.

“El Universo de Einstein-de Sitter es un caso particularmente sencillo de un universo de materia fría no relativista donde la tendencia a la expansión y la atracción gravitatoria están en un punto crítico, de tal manera que la energía total es cero. Aunque actualmente este modelo está prácticamente descartado por las observaciones, su manipulación matemática es de tal simplicidad que nos sirve como ejercicio de gran utilidad para entender cómo se relacionan los distintos parámetros en cosmología.”

Debido a que la geometría del espacio y las propiedades de la evolución del Universo están unívocamente definidas en el modelo de Einstein-de Sitter, mucha gente lo considera el modelo más apropiado describir el Universo real.

Durante los últimos años de la década de los 70 surgió un firme soporte teórico para ideas a partir de los estudios en física de partículas. Además, las observaciones experimentales sobre la densidad media del Universo apoyan esta concepción, aunque las evidencias aún no son concluyentes.

Todo esto está muy bien pero… ¿De donde venimos? ¿Hacia donde vamos? ¿Quiénes somos?

¡Si supiera contestar esas preguntas!

emilio silvera

Sep

17

¿Cuanta materia hay en nuestro Universo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

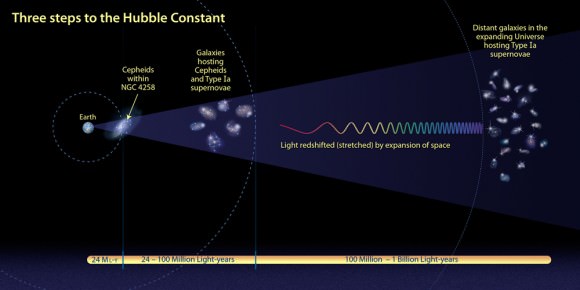

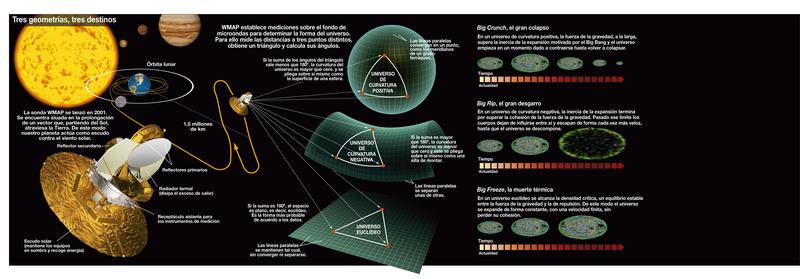

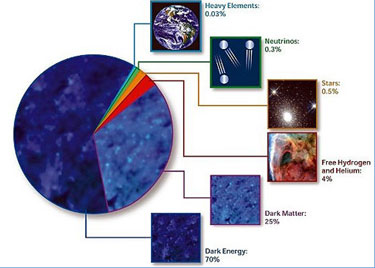

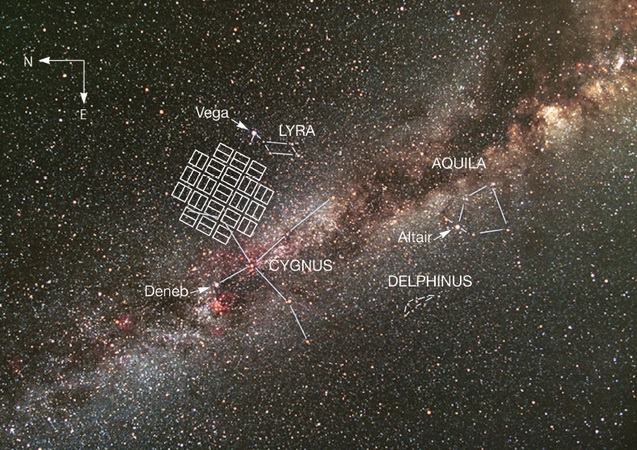

La constante de Hubble en función de la Densidad Crítica

La cantidad total de Materia del Universo se da generalmente en términos de una cantidad llamada Densidad Crítica, denotada por Omega (Ω). Esta es la densidad de la materia que se necesita para producir un universo plano. Si la Densidad efectivamente observada es menor o mayor que ese parámetro, en el primer caso el Universo es abierto, en el segundo es cerrado. La Densidad Crítica no es muy grande; corresponde aproximadamente a un protón por metro cúbico de espacio. Puede que no parezca mucho, dado el número inmenso de átomos en un metro cúbico de lodo, pero no debemos olvidar que existe una gran cantidad de espacio “vacío” entre las galaxias.

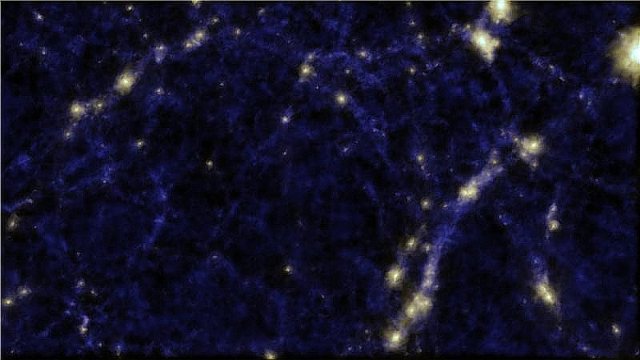

Un equipo de científicos explican que el Universo está lleno de grandes cúmulos de galaxias que parecen estar formando una intrincada red de clústeres y nodos conectados. A menudo se llama a esta estructura la ‘red cósmica’, con intersecciones de galaxias a las que rodean vastos espacios vacíos, regiones en las que no se ha encontrado nada.

Sin embargo, este nuevo estudio aporta nuevos datos de estos espacios. El investigador principal, Mehmet Alpaslan, ha explicado que estos vacíos cósmicos pueden contener una o dos galaxias, a diferencia de los cientos que se encuentran en los grandes cúmulos. Del mismo modo, descubrieron que el pequeño número de galaxias encontradas dentro de estos huecos parecen estar distribuidas en una nueva forma nunca antes vista.

Cuando contemplamos imágenes como la de arriba, nos resulta engañoso y no imaginamos las inmensas distancias que las separan. Las galaxias están muy retiradas las unas de las otras. Andrómeda y la Vía Láctea están a 2,3 años-luz perteneciendo al mismo Grupo Local.

Algunos números que definen nuestro Universo:

- El de fotones por protón

- La razón densidades de Materia Oscura y Luminosa.

- La Anisotropía de la Expansión.

- La falta de homogeneidad del Universo.

- La Constante Cosmológica.

- La desviación de la expansión respecto al valor crítico.

- Fluctuaciones de vacío y sus consecuencias.

- ¿Otras Dimensiones?

En las últimas medidas realizadas, la Densidad crítica que es la densidad necesaria para que la curvatura del universo sea cero, ha dado el resultado siguiente: r0 = 3H02/8pG = 1.879 h2 10-29 g/cm3, que corresponde a una densidad tan baja la de la masa de 2 a 3 átomos de hidrógeno por metro cúbico (siempre, por supuesto obviando la incertidumbre en la constante de Hubble).

Estimar la cantidad de materia luminosa del universo es una cosa muy fácil de hacer. Sabemos el brillo que tiene una estrella media, así que podemos hacer una estimación de las estrellas de una galaxia distante. Podemos contar entonces el número de galaxias en un volumen dado de espacio y sumar las masas que encontramos. Dividiendo la masa por el volumen del espacio obtenemos la densidad media de materia en ese volumen. Cuando llevamos a cabo esta operación, obtenemos que la densidad de la materia luminosa es aproximadamente entre el uno o dos % menor de la densidad crítica; es decir, menos de lo que se necesita para cerrar el universo.

Se ha tratado de medir la Densidad Crítica del Universo para poder saber en qué clase de universo estamos y, parece que es plano, la DC calculada resulta ser cerca de la ideal para que el universo sea plano y, si es así, nunca se producirá un Big Crunch, la expansión nos llevaría hacia una muerte térmica que se produciría al llegar al cero absoluto, es decir, -273 ºC. Los Cosmólogos llaman Omega a la cantidad de materia del universo y según la que realmente tenga podría ser un universo plano, abierto o cerrado.

Por otro lado, está lo bastante cerca del valor crítico para hacer una pausa. Después de todo, esta fracción podría haber sido en principio de una billonésima o trillonésima, y también podría haber sucedido que fuese un millón de veces la materia necesaria para el cierre. ¿Por qué, entre todas las masas que podría tener el universo, la masa de materia luminosa medida está cerca del valor crítico? Es decir, del valor ideal para que estemos en un Universo plano.

Claro que el hecho de que la materia luminosa medida esté tan cercana al valor crítico, simplemente podría deberse a un accidente cósmico; las cosas sencillamente “resultan” de ese modo. Me costaría mucho aceptar una explicación y supongo que a otros también. Es tentador decir que el Universo tiene en realidad la masa crítica, pero que de algún modo no conseguimos verla toda.

Tratamos de estudiar por todos los medios a nuestro alcance, qué nasa tiene el Universo para saber si estamos en un universo plano, abierto o cerrado y conocer, en función de ello, el final que tendrá.

Como resultado de esta suposición, los astrónomos comenzaron a hablar de la “masa perdida” con lo que aludían a la materia que habría llenado la diferencia entre las densidades observadas y la crítica. Tales teorías de “masa perdida”, “invisible” o, finalmente “oscura”, nunca me ha gustado, toda vez que, hablamos y hablamos de ella, damos por supuesta su existencia sin haberla visto ni saber, exactamente qué es, y, en ese plano, parece como si la Ciencia se pasara al ámbito religioso, la fe de creer en lo que no podemos ver ni tocar y, la Ciencia, amigos míos, es otra cosa.

Los cosmólogos suponen que los cúmulos de galaxias están impregnados de “materia oscura”, esa especie de sustancia cósmica que se busca sin éxito, ya que, no hemos sido capaces hasta el momento de inventar ingenios que la puedan detectar al carecer (según se cree) del efecto de radiación que tiene la materia bariónica formada por protones y neutrones, es decir, por Quarks y Leptones. También los del LHC han tratado de buscar esas partículas supersimétricas que, según algunas teorías, forman la hipotética “materia oscura”, y, el resultado, ha sido nulo.

Tendremos que imaginar satélites y sondas que, de alguna manera, puedan detectar grandes halos galácticos que encierren la tan buscada “materia oscura” y que, al parecer, hace que nuestro Universo sea como lo conocemos y, es la responsable del ritmo al que se alejan las galaxias, es decir, la expansión del Universo. (Yo no descartaría el hecho de que, el ritmo de alejamiento de las galaxias se debe a que están siendo atraídas por la fuerza de Gravedad que genera un universo vecino).

Algunos postulan que la Vía Láctea está rodeada por un halo esférico de materia oscura (halo de materia oscura) que se muestran en azul en esta imagen artística.

Esos halos, tendrían muchas veces las masas que podemos ver en la Materia luminosa de las estrellas, planetas, galaxias y nosotros mismos. La teoría de la “materia oscura” y su presencia en cúmulos y supercúmulos ha sido “descubierta” (o inventada para tapar nuestra ignorancia) en época relativamente cercana para que prevalezca entre los astrónomos la unanimidad respecto a su contribución a la masa total del universo. El debate continúa, está muy vivo y, es el tema tan candente e importante que, durará bastante tiempo mientras algún equipo de observadores no pueda, de una vez por todas, demostrar que, la “materia oscura” existe, que nos digan donde está, y, de qué está conformada y como actúa. Claro que, cuando se haga la suma de materia luminosa y oscura, la densidad de la masa total del universo no será todavía mayor del 30% del valor crítico. A todo esto, ocurren sucesos que no podemos explicar y, nos preguntamos si en ellos, está implicada la “Materia oscura”, o, por el contrario, está tirando de nuestro Universo, otros universos vecinos.

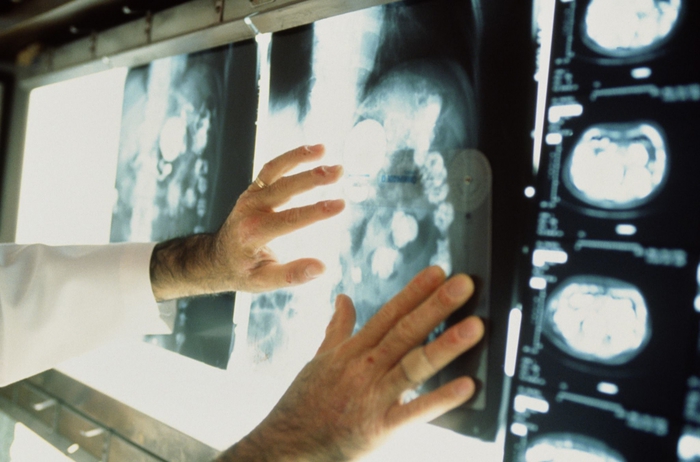

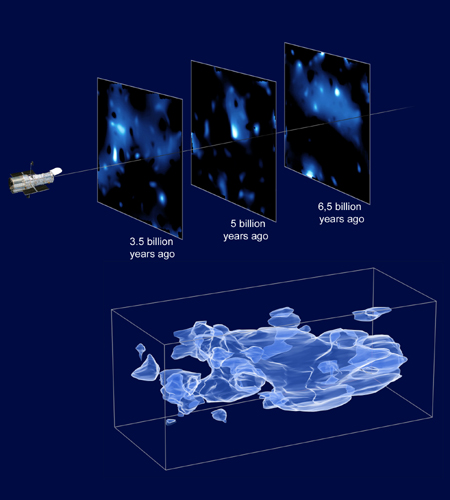

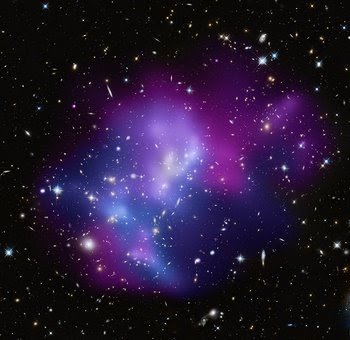

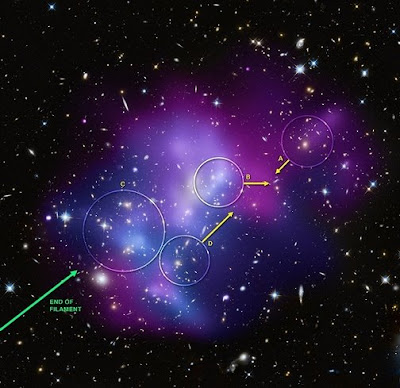

Inusual colisión de enanas blancas y también, se ha podido detectar la más abarrotada colisión de cúmulos galácticos que han sido identificados al combinar información de tres diferentes telescopios. El resultado brinda a los científicos una posibilidad de aprender lo que ocurre con algunos de los más grandes objetos en el universo que chocan en una batalla campal cósmica de inusitada fuerza y descomunal emisión de energía.

Usando del Observatorio de rayos-X Chandra, el Telescopio Espacial Hubble y el Observatorio Keck de Hawai, los astrónomos fueron capaces de determinar la geometría tridimensional y el movimiento en el sistema MACSJ0717.5+3745 localizado a 5.4 mil millones de luz de la Tierra. Los investigadores encontraron que cuatro distintos cúmulos de galaxias están envueltos en una triple fusión, la primera vez que un fenómeno así es documentado.

La composición de imagen (arriba) muestra el cúmulo de galaxias masivo MACSJ0717.5+3745. El color del gas caliente está codificado con colores mostrar su temperatura. El gas más frío es mostrado como un púrpura rojizo, el gas más caliente en azul y las temperaturas intermedias en púrpura. Las repetidas colisiones en el cúmulo son causadas por una corriente de galaxias, polvo y “materia oscura” -conocida filamento- de 13 millones de años luz.

Se han obtenido Imágenes (MACSJ0717) que muestran cómo cúmulos galácticos gigantes interactúan con su entorno en escalas de millones de años luz. Es un sistema hermoso para estudiar cómo los cúmulos crecen mientras el material cae en ellos a lo largo de filamentos. Simulaciones por ordenador muestran que los cúmulos de galaxias más masivos deben crecer en regiones donde filamentos de gran escala de gas intergaláctico, galaxias, y materia desconocida intersectan, pero…

¿Cuál debe ser la Masa del Universo?

Puede ser que algún día sepamos de manera exacta cuál es la masa del Universo y, si realmente, hay M.O.

Claro que la idea de masa perdida se introdujo porque la densidad observada de la materia del universo está cerca del valor crítico. Sin embargo, hasta comienzos de los ochenta, no se tuvo una razón teórica firme para suponer que el universo tenía efectivamente la masa crítica. En 1981, Alan Guth, publicó la primera versión de una teoría que entonces se ha conocido como “universo inflacionista”. Desde entonces, la teoría ha sufrido numerosas modificaciones técnicas, pero los puntos centrales no han cambiado.

Nuestra conversación de hoy, diremos que el aspecto principal del universo inflacionista es que estableció por primera vez una fuerte presunción de que la masa del universo tenía realmente el valor crítico. Esta predicción viene de las teorías que describen la congelación de la fuerza fuerte en el segundo 10-35 del Big Bang. los otros muchos procesos en marcha en ese tiempo estaba una rápida expansión del universo, un proceso que vino a ser conocido como inflación. Es la presencia de la inflación la que nos lleva a la predicción de que el universo tiene que ser plano.

Abell 370 La lente gravitacional distorsiona la Imagen y nos enseña, a la derecha, algo que nos parece una inmensa cuerda cósmica , ¿que podrá ser en realidad? la materia a lo largo y ancho del universo se reparte de manera que, se ve concentrada en cúmulos de galaxias y supercúmulos que son las estructuras más grandes conocidas y, dentro de ellas, están todos los demás objetos que existen. Claro que, deajndo a un lado esas fluctuaciones de vacío y, la posible materia desconocida.

El proceso mediante el cual la fuerza fuerte se congela es un ejemplo de un cambio de fase, similar en muchos aspectos a la congelación del agua. el agua se convierte en hielo, se expande; una botella de leche explotará si la dejamos en el exterior en una noche de invierno de gélido frío. No debería ser demasiado sorprendente que el universo se expanda del mismo modo al cambiar de fase.

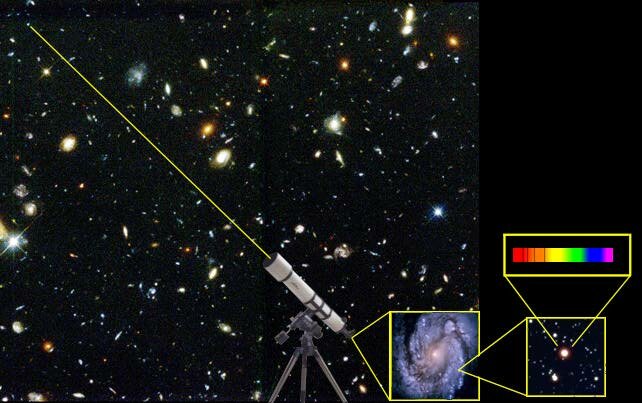

La distancia a una galaxia lejana se determina estudiando la luz proveniente de estrellas de tipo Cefeidas Variables. El espectro de la luz estelar revela la velocidad a la que se mueve la galaxia (Efecto Doppler) y la cantidad de expansión que ha sufrido el universo que la luz salió de su fuente.

Lo que es sorprendente es la enorme amplitud de la expansión. El tamaño del Universo aumentó en un factor no menor de 1050. Este es tan inmenso que virtualmente no tiene significado para la mayoría de la gente, incluido yo mismo que, no pocas veces me cuesta asimilar esas distancias inconmensurables del Cosmos. Dicho de otra manera, pongamos, por ejemplo, que la altura de los lectores aumentara en un factor tan grande como ese, se extenderían de un extremo al otro del Universo y, seguramente, faltaría sitio. Incluso un sólo protón de un sólo átomo de su cuerpo, si sus dimensiones aumentaran en 1050, sería mayor que el mismo universo. En 10-35 segundos, el universo pasó de algo con un radio de curvatura mucho menor que la partícula elemental más pequeña a algo como el tamaño de una naranja grande. No es extraño que el inflación esté ligado a este proceso.

Comparación entre un modelo de expansión desacelerada (arriba) y uno en expansión acelerada (abajo). La esfera de referencia es proporcional al factor de escala. El universo observable aumenta proporcionalmente al tiempo. En un universo acelerado el universo observable aumenta más rápidamente que el factor de escala con lo que cada vez podemos ver mayor del universo. En cambio, en un universo en expansión acelerada (abajo), la escala aumenta de manera exponencial mientras el universo observable aumenta de la misma manera que en el caso anterior. La cantidad de objetos que podemos ver disminuye con el tiempo y el observador termina por quedar aislado del resto del universo.

Cuando ( mucho tiempo ya) leí por primera vez acerca del universo inflacionario, experimenté dificultades para poder asimilar el índice de inflación. ¿No violaría un crecimiento tan rápido las reglas impuestas por la relatividad de Einstien que marcaban el límite de la velocidad en el de la luz en el vacío? Si un cuerpo material viajó de un extremo de una naranja a otro en 10-35 segundos, su velocidad excedió a la de la luz en una fracción considerable.

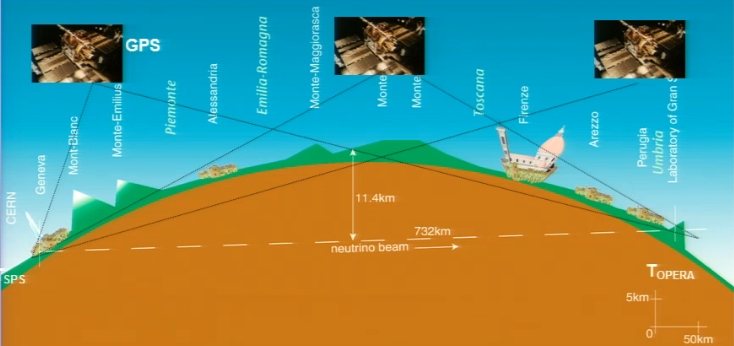

Claro que, con esto pasa como pasó con estos “veloces” neutrinos que, algunos decían haber comprobado que corrían más rápidos que la luz, y, sin embargo, todo fue un error de cálculo en el que no se tuvieron en algunos parámetros presentes en las mediciones y los aparatos que hacían las mismas.

Masa de Pan o el globo que se infla y las galaxias allí pintadas se separan a medida que el globo se hace más grande. En realidad, no serían las galaxias las que se mueven y expanden sino el mismo globo, o, explicado de otra manera:

Aquí, podría pasar algo parecido y, la respuesta la podemos encontrar en aquella analogía con la masa de pan. Durante el período de inflación es el espacio mismo -la masa de pan- lo que está expandiéndose. Ningún cuerpo material (acordaos que en aquella masa estaban incrustadas las uvas que hacían de galaxias y, a medida que la masa se inflaba, las uvas -galaxias- se alejaban las unas de las otras pero, en realidad, ninguna de estas uvas se mueven, es la masa lo que lo hace.

El Universo se expande

Las reglas contra los viajes a mayor velocidad que la de la luz sólo se aplican al movimiento del espacio. Así no hay contradicción, aunque a primera vista pueda parecer que sí. Las consecuencias del período de rápida expansión se pueden describir mejor con referencia a la visión einsteniana de la gravitación. de que el universo tuviera 10-35 segundos de edad, es de suponer que había algún tipo de distribución de la materia. A cauda de esa materia, el espacio-tiempo tendrá alguna forma característica. Supongamos que la superficie estaba arrugada antes de que se produjera la inflación. Y, de esa manera, cuando comenzó a estirarse, poco a poco, tomó la forma que podemos detectar de “casi” plana conforme a la materia que contiene.

En todo esto, hay un enigma que persiste, nadie sabe contestar cómo, a pesar de la expansión de Hubble, se pudieron formar las galaxias. La pregunta sería: ¿Qué clase de materia estaba allí presente, para evitar que la materia bariónica no se expandiera sin rumbo fijo por todo el universo y, se quedara el tiempo suficiente para formar las galaxias? Todo ello, a pesar de la inflación de la que hablamos y que habría impedido su formación. Así que, algo tenía que existir allí que generaba la gravedad necesaria para retener la materia bariónica hasta que ésta, pudo formar estrellas y galaxias.

No me extrañaría que, eso que llaman “materia oscura”, pudiera ser como la primera fase de la materia “normal” que, estando en esa primera fase, no emite radiaciones ni se deja ver y, sin embargo, sí que genera la fuerza de Gravedad para que nuestro Universo, sea tal como lo podemos observar.

En imágenes como estas , los “expertos” nos dicen cosas como:

“La materia oscura en la imagen de varias longitudes de onda de arriba se muestra en un falso color azul, y nos enseña detalles de como el cúmulo distorsiona la luz emitida por galaxias más distantes. En de gas muy caliente, la materia normal en falso color rojo, son fruto de los rayos-X detectados por el Observatorio de Rayois X Chandra que orbita alrededor de la Tierra.”

Algunas galaxias individuales dominadas por materia normal aparecen en colores amarillentos o blanquecinos. La sabiduría convencional sostiene que la materia oscura y la materia normal son atraídas lo mismo gravitacionalmente, con lo que deberían distribuirse homogéneamente en Abell 520. Si se inspecciona la imagen superior, sin embargo, se ve un sorprendente vacío de concentración de galaxias visibles a lo largo de la materia oscura. Una respuesta hipotética es que la discrepancia causada por las grandes galaxias experimentan algún efecto de “tirachinas” gravitacional.

Una hipótesis más arriesgada sostiene que la materia oscura está chocándo consigo misma de alguna forma no gravitacional que nunca se había visto antes..? (esto está sacado de Observatorio y, en el texto que se ha podido traducir podemos ver que, los astrónomos autores de dichas observaciones, tienen, al menos, unas grandes lagunas en sus explicaciones y, tratándo de taparlas hacen aseveraciones que nada tienen que ver con la realidad).

emilio silvera

Sep

17

El año en que solo progresó el conocimiento

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencias de la Tierra ~

Clasificado en Ciencias de la Tierra ~

Comments (0)

Comments (0)

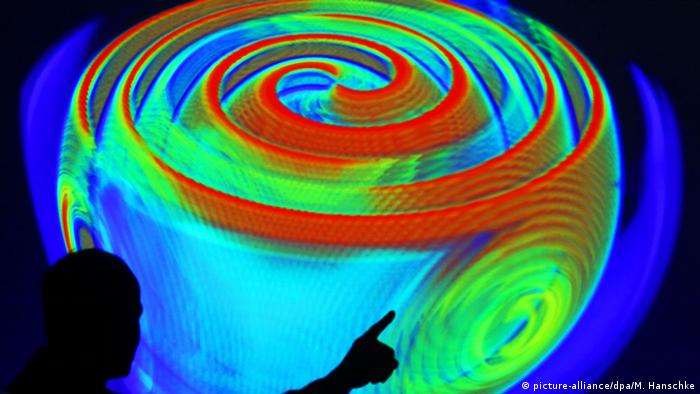

Las Ondas Gravitacionales detectadas y los grandes avances en medicina y tecnología cambiaran el mundo

En mitad de la mediocridad política y la inquietud social, 2016 produjo grandes avances en la física, la biología y la inteligencia artificial

Sí, este ha sido el año aciago del Brexit y Donald Trump, el año en que Europa ha consolidado su desprestigio y la población siria ha sido masacrada por su propio Gobierno con la ayuda de otros, en que la xenofobia, el nacionalismo y la miopía se han impuesto sobre la razón práctica, en que el autoritarismo se ha extendido por Hungría y Polonia como una plaga medieval, el año en que el paro y la pobreza se han instalado entre nosotros con la espontaneidad de una catástrofe natural. Y en que las únicas buenas noticias han provenido de la ciencia. En mitad del caos y la desesperanza, el conocimiento ha progresado con más firmeza que nunca. Aferrémonos a eso como a una ascua ardiendo.

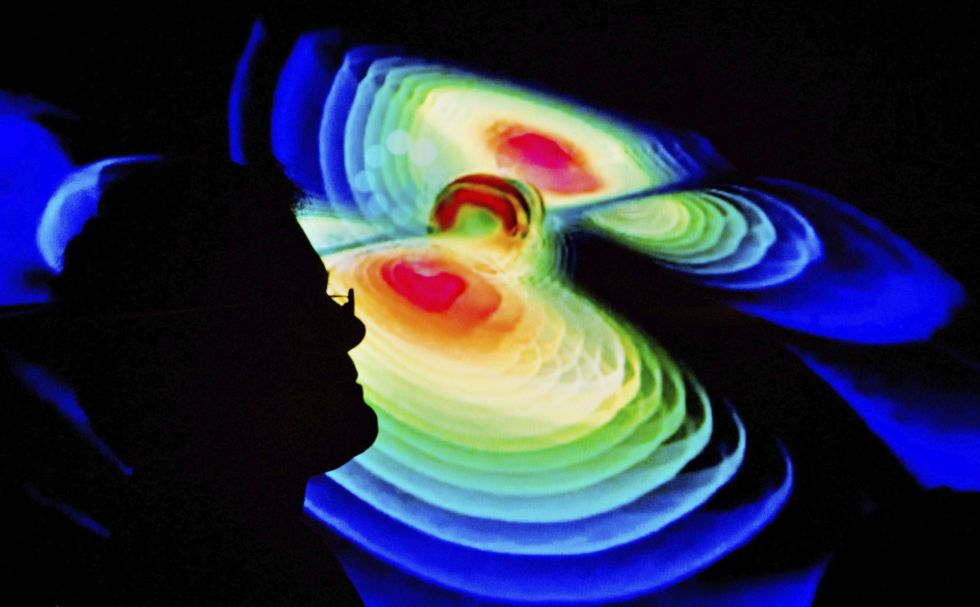

Llevamos décadas oyendo que, si el XX fue el siglo de la física, el XXI lo sería de la biología. Pero lo cierto es que la física goza en nuestros días de mejor salud que nunca. El mayor descubrimiento de 2016, según un consenso difícil de cuestionar, ha sido el de las ondas gravitatorias, una predicción de la relatividad general de Einstein que el propio Einstein consideró imposible de confirmar.

Ha hecho falta un siglo, la colisión de dos agujeros negros gigantescos y un sistema de detección (el LIGO) que se cuenta entre las obras más brillantes y refinadas del intelecto humano, pero el fenómeno se ha confirmado por encima de toda duda razonable. La gravedad no es una fuerza instantánea, como pensó Newton, sino que se propaga en forma de ondulaciones del espacio-tiempo que viajan a la velocidad de la luz, como predijo Einstein. Es un paso de gigante en el conocimiento que, como es habitual, abrirá un nuevo continente de exploración y progreso.

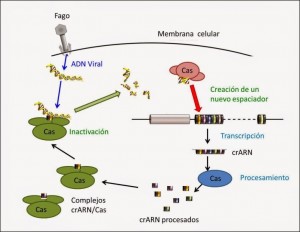

Proceso por el que el sistema CRISPR/Cas9 inactiva virus e integra parte de sus secuencias en el genoma de la bacteria.

Pero también es cierto que la biología está en un momento espléndido, y sobre todo en dos campos que prometen aplicaciones clínicas a medio plazo: la edición genómica y la reprogramación de células. En el primer caso, la estrella se llama CRISPR, y consiste en un sistema tan simple, eficaz y versátil que ha puesto la modificación del genoma humano (y de cualquier otro) al alcance de cualquier laboratorio de genética del planeta; su primera aplicación, sometida ya a una investigación muy activa, será sin duda la corrección de las mutaciones que causan las enfermedades raras: una forma por fin eficaz de terapia génica. En segundo lugar, la reprogramación de células –retrasar el reloj de una vulgar célula de la piel para convertirla en una célula madre— está logrando progresos espectaculares en la reparación de lesiones y el retraso del envejecimiento.

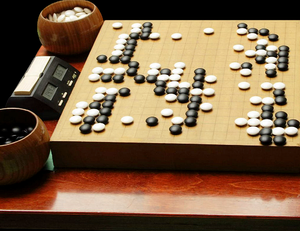

Sí, el Ordenador vence al campeón

Pero este año no se puede hablar solo de física y biología, porque la inteligencia artificial ha irrumpido con poderío en la actualidad científica y tecnológica. Drones, robots y automóviles, por no hablar de teléfonos, relojes y casi cualquier otra cosa, exhiben ya notables habilidades cognitivas: hacen cosas que serían consideradas inteligentes si las hubiera hecho un humano (así definió la inteligencia artificial uno de sus creadores, el gran Marvin Minsky, que murió en enero de este año). Y los ordenadores se han hecho en 2016 con el título mundial de Go, una proeza mucho más espectacular que aquella de ganar a Kaspárov al ajedrez. Las discusiones filosóficas sobre la inteligencia de las máquinas parecen haberse enranciado de forma definitiva.

El conocimiento ha seguido progresando entre la mediocridad política y el malestar social. Naturalmente, esto no tiene por qué seguir siendo así. Ya el Brexit puede constituir un lastre notable para la ciencia británica, y los planes xenófobos de Trump pueden convertirse en un escollo formidable para la norteamericana, pues buena parte de los grandes científicos de ese país son inmigrantes. Pero, de momento, 2016 ha ido bien para la ciencia. Es un consuelo.

Sep

16

Diversidad de estrellas, Diversidad de Mundos…¿Diversidad de vida?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Diversidad ~

Clasificado en Diversidad ~

Comments (1)

Comments (1)

De la misma forma que ocurre con las estrellas de las que existen una gran variedad, en colores -según los elementos de los que cada una esté conformada, dimensiones, masa, y otros parámetros que las definen, con los mundos ocurre otro tanto. No solo existen mundos rocosos y gaseosos (clasificación que sería una simplicidad), sino que, dependiendo de una serie de requisitos y circunstancias, los mundos pueden ser de muchas y diversas maneras y materiales.

¿Cómo se viviría en un mundo así? ¿Como sentiríamos la Gravedad de ese enorme planeta vecino tan cercano? Existen mundos en el espacio exterior que están alumbrados por estrellas enanas rojas cercanas a ellos, otros, se ven alumbrados por una luz intensamente roja proveniente de una estrella de carbono, también los hay que están a merced de estrellas múltiples, es decir, sistemas de tres o más estrellas ligadas por su atracción gravitacional múltiple (se estima que alrededor de un tercio de todas las binarias conocidas son realmente triples). También ha surgido mundos dependientes de una estrella peculiar, una estrella que se saber que es variable. ¿Cómo sentarían esos cambios o variaciones a sus posibles habitantes? Esposible que, sean estrellas en transición que no permiten la aparición de la vida en sus planetas hasta que no queda estabilizada.

Se han detectado planetas que orbitan alrededor de una estrella magnética, es decir, una estrella con un campo magnético descomunal (como se ha revelado el desdoblamiento Zeeman de las líneas de su espectro). Son conocidas por el término de estrella AM Herculis, una clase de variable cataclísmica entre las que pueden encontrarse algunas enanas blancas con campos magnéticos extremadamente intensos (del orden de 100 tesla). No parece que ningún planeta que la orbite a una distancia prudencial, pueda albergar la vida bajo esas extremas condiciones. ¿Cómo es posible explicar la enorme potencia de los campos magnéticos de las así llamadas ‘estrellas magnéticas’?

Mediante el uso de simulaciones numéricas en tres dimensiones han hallado las configuraciones de campo magnético que subyacen en los potentes campos magnéticos que se observan en las superficies de las llamadas estrellas magnéticas tipo A y las enanas blancas magnéticas. (Nature, 14/Oct/2004).

El campo magnético de este tipo de estrellas es continuo y estático, en contraste con el campo del Sol y de otras estrellas similares a éste, que son más débiles y consisten de pequeñas regiones, y cambian de modo continuo. Imaginar mundos habitables orbitando este tipo de estrellas es complicado.

Ilustración de estrella magnética

Como decimos, son muchos y variados los mundos que por ahí fuera se pueden encontrar. Es de lo más común encontrar estrellas a las que orbitan mundos de variado pelaje. Cuando se forma una estrella con una descomunal masa de gas y polvo interestelar que se junta por obligada por la fuerza de la Gravedad y se contrae más más sobre sí misma, hasta que el calor en el centro es tan descomunal que se produce la fusión nuclear y la estrella nueva nace a la vida, todo ese enorme conglomerado de material gira y incandescente mientras continúa aumentando su densidad, y, mientras tanto va girando y, algunos trozos de esa masa exterior que aún no llega a ser plasma, debido a la fuerza del giro se ve desprendida de la nueva estrella y, según sea el trozo despedido, se aleja más o menos hasta quedar retenido por la fuerza de gravedad que la estrella genera. Los trozos comienzan a enfriarse mientras giran y se forman nuevos planetas que, dependiendo de la distancia al nuevo sol y de sus masas, se configurarán de una u otra forma (planetas rocosos y gaseosos).

El descubrimiento de nuevos planetas no cesa y, a medida que mejoran los aparatos que los detectan, se acorta el tiempo que nos queda para poder localizar otros mundos que, como la Tierra, sean idóneos para albergar alguna clase de vida.

Como podeis ver en las imágenes de arriba y abajo, el Universo está plagado de Mundos. Si como antes decía, es común que las estrellas estén acompañadas por planetas, si pensamos que sólo en nuestra Galaxia, la Vía Láctea existen más de cien mil millones de estrellas, ¿cuántos planetas no tendremos en nuestra propia casa? Y, si pensamos en el Universo entero, la cifra podría ser descomunalmente grande, y, si eso es así (que lo es), ¿Cuántos planetas habitados podrían existir?.

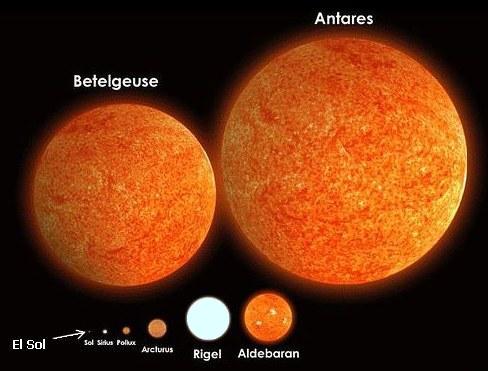

¿Alguna vez he pensado cómo sería vivir en un planeta cuya estrella fuese como Antares?, una supergigante 10 000 veces más luminosa que el Sol y cuyo diámetro sería de unos 700 millones de kilómetros, su densidad de unas 20 masas solares y la remperatura superficial de unos 4 ooo K. Está claro que habría que tener en cuenta muchas cuestiones para que, la vida en ese hipotético planeta pudiera ser posible, al menos como la conocemos aquí. La luminosidad incidiría en la clase de visión que los posibles habitantes pudieran tener, y, por otra parte, al ser la temperatura en la superficie de la estrella más baja que la de nuestro Sol, ¿a qué distancia debería estar situado el planeta para que los rayos del sol calentaran a sus habitantes y plantas?, y, no olvidemos los efectos de la Gravedad de tan enorme sol que, para hacerla soportable para esos imaginarios habitantes, tendría que estar situado lejos, mientras que la baja temperatura aconseja que el planeta esté cercano a la estrella. Estas contradicciones, posiblemente, impediaría la vida tan como la conocemos y, de haberla, sería otra clase de vida distinta a la nuestra.

En verdad, el problema de la vida en un planeta no es cosa fácil. ¡Son tantos los requisitos exigidos! Y, así y todo, si pudiéramos desplazarnos por lejanas rutas estelares, lo que podríamos contemplar superaría en mucho a todo lo que podamos imaginar. Ya sabéis, no pocas veces la realidad supera a la imaginación. Mundos de ensueño, criaturas imposibles, ¡cuántas maravillas! alberga nuestro Universo. Con razón se define como todo lo que existe: Espacio -Tiempo- Materia…Y, desde hace algún tiempo…Mentes pensantes que lo observan todo.

Que no estamos solos en el Universo no es novedad para muchos, cuando todos creemos que la Tierra puede no ser el único planeta con vida siempre solemos pensar en la vida extraterrestre, dando asi vida a una infinidad de hipótesis e historias acerca de cómo sería ésta. Lo cierto es que varios astrofísicos han anunciado la posibilidad de que existan varios planetas similares a la Tierra.

Inmensos y bellos planetas dobles, mundos gemelos que alumbrados por una estrella Gigante inusual de tipo espectral G, K o M y que presenta Litio en su espectro. Las reacciones nucleares en el núcleo de la estrella produce Berilio, que es transportado por convección hacia las capas superiores, donde captura un electrón para convertirse en Litio. Es una estrella T Tauri, muy joven y todavía recien salida de su cascarón, ya que, el Litio es probable que se hallara en el gas del cual se formó la estrella y será pronto destruido cuando la estrella alcance la secuencia principal. Esos mundos gemelos, mientras tanto, también siguen evolucionando y, pasados algunos miles de millones de años, es posible (sólo posible) que, algunos signos de vida puedan aparecer en su océanos.

Las estrellas pueden ser clasificadas de muchas maneras.

El estudio fotográfico de los espectros estelares lo inició en 1885 el astrónomo Edward Pickering en el observatorio del Harvard College y lo concluyó su colega Annie J. Cannon. Esta investigación condujo al descubrimiento de que los espectros de las estrella están dispuestos en una secuencia continua según la intensidad de ciertas líneas de absorción. Las observaciones proporcionan datos de las edades de las diferentes estrellas y de sus grados de desarrollo.

Clase A: Comprende las llamadas estrellas de hidrógeno con espectros dominados por las líneas de absorción del hidrógeno. Una estrella típica de este grupo …

Las diversas etapas en la secuencia de los espectros, designadas con las letras O, B, A, F, G, K y M, permiten una clasificación completa de todos los tipos de estrellas. Los subíndices del 0 al 9 se utilizan para indicar las sucesiones en el modelo dentro de cada clase.

Clase O: Líneas del helio, el oxígeno y el nitrógeno, además de las del hidrógeno. Comprende estrellas muy calientes, e incluye tanto las que muestran espectros de línea brillante del hidrógeno y el helio como las que muestran líneas oscuras de los mismos elementos.

Las estrellas de Wolf-Rayet o estrellas Wolf-Rayet (abreviadas frecuentemente como WR) son estrellas masivas (con más de 20-30 masas solares), calientes y evolucionadas que sufren grandes pérdidas de masa debido a intensos vientos estelares.

Este tipo de estrellas tiene temperaturas superficiales de entre de 25.000 – 50.000 K (en algunos casos incluso más), elevadas luminosidades, y son muy azules, con su pico de emisión situado en el ultravioleta. La superficie estelar también presenta líneas de emisión anchas de Carbono, Nitrógeno y Oxígeno. Tienen un color Blanco-Verdoso.

Clase B: Líneas del helio alcanzan la máxima intensidad en la subdivisión B2 y palidecen progresivamente en subdivisiones más altas. La intensidad de las líneas del hidrógeno aumenta de forma constante en todas las subdivisiones. Este grupo está representado por la estrella Epsilon Orionis.

Alnilam (Epsilon Orionis

Clase A: Comprende las llamadas estrellas de hidrógeno con espectros dominados por las líneas de absorción del hidrógeno. Una estrella típica de este grupo es Sirio, la más brillante de todo el cielo nocturno vista desde la Tierra. Su color es blanco, y, es muy conocida desde la antigüedad; por ejemplo, en el antiguo egipto, la salida helíaca de Sirio marcaba la época de las inundaciones del Nilo, y ha estado presente en civilizaciones tan dispares como la griega y la polinesia.

Sirio arriba

Clase F: En este grupo destacan las llamadas líneas H y K del calcio y las líneas características del hidrógeno. Una estrella notable en esta categoría es Delta Aquilae.

Clase G: Comprende estrellas con fuertes líneas H y K del calcio y líneas del hidrógeno menos fuertes. También están presentes los espectros de muchos metales, en especial el del hierro. El Sol pertenece a este grupo y por ello a las estrellas G se les denomina “estrellas de tipo solar”.

Clase K: Estrellas que tienen fuertes líneas del calcio y otras que indican la presencia de otros metales. Este grupo está tipificado por Arturo, una estrella anaranjada-amarillenta de enormes proporciones que comparada con nuestro Sol, la hace imponente y a éste minúsculo.

Clase M; Espectros dominados por bandas que indican la presencia de óxidos metálicos, sobre todo las del óxido de titanio. El final violeta del espectro es menos intenso que el de las estrellas K. La estrella Betelgeuse es típica de este grupo.

Hemos dado un repaso a los mundos que son y los que podrían ser. Las estrellas son tan importantes para los mundos que, dependiendo de sus configuraciones: brillo, masa, densidad, y, muchos otros parámetros que las definen, podrán tener planetas en los que puedan florecer o no la vida. Y, aunque hemos encontrado una larga lista de nuevos planetas extrasolares, debemos comprender que las dificultades para encontrar “Tierras” son muchas, toda vez que nuestro planeta es pequeño y si otros similares que puedan exitir están a una distancia similar (1 UA) a la nuestra, con las distancias que se trabajan (decenas, cientos o miles de años-luz), el mismo brillo de la estrella los oculta. Para hacernos una idea veamos la imagen de los planetas del Sistema Solar a escala.

Planetas del Sistema Solar a escala y ordenados con respecto a su distancia con el Sol. Los planetas son: 1: Mercurio, 2: Venus, 3: Tierra, 4: Marte, 5: Júpiter, 6: Saturno, 7: Urano, 8: Neptuno.Viendo ésta imágen, podemos caer en la cuenta del por qué, la mayoría de los planetas extrasolares descubiertos hasta el momento son del tipo jupiteriano. “Las Tierras” resultan extremadamente “pequeñas” para poder localizarlas con facilidad con la actual tecnología.

En nuestro planeta, al igual que en el Espacio las estrellas, la diversidad está presente en las múltiples formas de vida que lo pueblan.

emilio silvera

Sep

16

¿Será único nuestro Universo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Otros mundos ~

Clasificado en Otros mundos ~

Comments (0)

Comments (0)

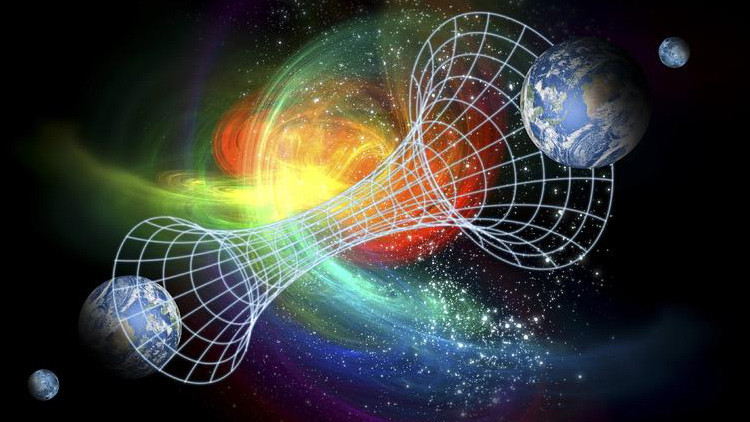

Como nunca nadie pudo estar en otro Universo, tenemos que imaginarlos y basados en la realidad del nuestro, realizamos conjeturas y comparaciones con otros que podrìán ser. ¿Quién puede asegurar que nuestro Universo es único? Realmente nadie puede afirmar tal cosa e incluso, estando limitados a un mundo de cuatro dimenciones espacio-temporales, no contamos con las físicas necesarias para poder captar (si es que lo hay), ese otro universo paralelo o simbiótico que presentimos junto al nuestro y que sospechamos que está situado en ese “vacío” que no hemos llegado a comprender. Sin embargo, podríamos conjeturar que, ambos universos, se necesitan mutuamente, el uno sin el otro no podría existir y, de esa manera, estaríamos en un universo dual dentro de la paradoja de no poder conocernos mutuamente, al menos de momento, al carecer de los conocimientos necesarios para ello.

Es curioso como un equipo de astrónomos y cosmólogos estudiantes de la expansión del Universo y tratando de buscar la verdadera causa de dicho comportamiento (las galaxias se alejan las unas de las otras sin una razón aparente, toda vez que, la cantidad de materia bariónica percibida, no sería suficiente para arrastrarlas de esa manera), de manera denodada y pertinaz buscan el por qué se expande el universo de esa manera que no pueden explicar y, en dicha tarea, dicen haber percibido, más allá del supuesto “borde de nuestro Universo” la presencia de algo grande.

Lo único que se me ocurre pensar es en la presencia de otro universo que tira del nuestro por la fuerza de gravedad que genera y, al final del camino, como ocurre con las galaxias, terminarán fusionándose los dos universos. Es simplemente lo que ocurre con las galaxias pero, a escala mayor.

Imagináis la grandiosidad que está presente en una sola Galaxia como la nuestra. Así el poeta, hablando consigo mismo exclamó:

¡Oh mundo de mundos!

¡Oh vida de vidas!

¿Cuál es tu centro?

¿Dónde estamos nosotros?

¿Habrá más de lo que vemos?

¿Debemos prestar atención a las voces que oímos en nuestras mentes?

El Universo (al menos el nuestro), nos ofrece algo más, mucho más que grandes espacios vacíos, oscuros y fríos. En él podemos ver muchos lugares luminosos llenos de estrellas, de mundos y… muy probablemente de vida. Sin embargo, tenemos la sospecha de que, aparte del nuestro, otros universos podrían rondar por ahí y conformar un todo de múltiples Universos de caracteristicas diversas y no en todos, sería posible la de estrellas y como consecuencia la Vida.

En nuestras ánsias de querer saber sobre “esa verdad” que incansables perseguimos, hemos realizados innumerables excursiones por todos los senderos conocidos y otros nuevos que hemos dejado abiertos intentanto llegar a entender y explicar si, las fuerzas fundamentales de la Naturaleza y, las Constantes Universales pudieran estar presentes, en otros Universos de la misma manera que en el nuestro. La conclusión ha sido que no. Otros Universos (si existen) podrían ser iguales al nuestro y también, muy diferentes y todo dependería de su momento inicial que es el que determina la de Universo quen será cualquier universo que pudiera llegar a existir.

No es fácil imaginar cómo serían esos otros universos y como llegar

Hemos visto como los cosmólogos contemplan activamente la naturaleza de “otros mundos” en los que las constantes harían la vida imposible. Esto nos plantea la cuestión más profunda de si estos otros mundos “existen” en algún sentido y, si es así, qué los hace diferentes del mundo que vemos nosotros. También ofrece una alternatica al vijeo argumento de que el aparente buen ajuste del mundo para que posea todas aquellas propiedades requeridas para la vida es de alguna forma de un diseño especial. Pues si existen todas las alternativas posibles, debemos encontrarnos necesariamente habitando en una de las que permiten que exista la vida. Y podríamos ir aún más lejos y aventurar la conjetura de que podríamos esperar encontrarnos en el tipo más probable de Universo que sustenta la vida.

“Si pudiéramos saber que nuestro propio Universo era sólo uno entre un número indefinido de ellos, con propiedades cambiantes, quizá podríamos invocar una solución análoga al principio de la selección natural; que sólo en ciertos universos, entre los que se incluye el nuestro, se dan las condiciones apropiadas para el surgir de la vida, y a menos que se satisfaga esta condición en otros universos no podría existir observadores para advertir tal hecho.”

¡No saben lo que se pierden! ¡Pobres universos!

Una de las dificultades de concebir siquiera semejantes multiversos de todos los universos posibles es que hay muchas cosas que podrían ser diferentes. De nuestro estudio de las matemáticas sabemos que existen lógicas diferentes a la que utilizamos en la práctica, en la que los enunciados son o verdaderos o falsos. Análogamente, hay diferentes estructuras matemáticas; diferentes leyes de la Naturaleza posible ; diferentes valores para las constantes de la Naturaleza; diferentes números de dimensiones de espacio y de tiempo; diferentes de partida para el Universo; y diferentes resultados aleatorios para secuencias complejas de sucesos. Frente a ello, la colección de todos los mundos posibles tendría que incluir, como mínimo, todas las permutaciones y combinaciones posibles de estas diferentes cosas. Obtener una comprensión de todo este maremagnum sería pedirnos demasiado (al menos por el momento).

Y, si existen otros Universos… ¿Cómo ir hasta ellos?

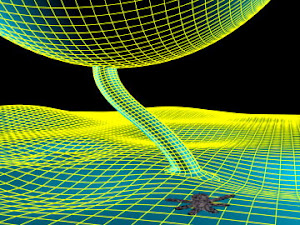

Claro que, concebir Universos además del nuestro… se nos hace muy cuesta arriba. Nuestras mentes son tridimensionales y, hemos al añadido de esa cuarta dimensión temporal que nos trajo la relatividad especial pero, cuando tratamos de ir más allá, no asimilamos bien y la visión de ese “mundo” de dimensiones extra, no caben en nuestra cabeza. Sin embargo, los números sí lo permiten y pueden configurar mundos de 10, 11 y hasta 26 dimensiones y, en ese mundo teórico-matemático, sí pueden convivir todas las fuerzas de nuestro Universo y allí podemos respuestas que, en nuestro Universo cotidiano cuatridimensional, no podemos hallar.

Lo cierto es que, ya hemos visto lo que puede suceder si se realizaran algunos de esos otros mundos posibles, mundos con más dimensiones u otros valores de las constantes cruciales. Sin embargo, no sabemos si estos diferentes mundos son realmente posibles. Está muy bien contemplar cambios en las constantes de la Naturaleza y las cantidades que definen la forma y el tamaño del Universo. Pero ¿hay realmente universos alternativos permitidos o son tan posibles como los círculos cuadrados? Podría ser que la “Teoría de Todo” sea muy restrictiva cuando se trate de dar permiso de planificación para otros universos.

Por imaginar que no quede. Nuestras mentes construyen escenarios que…

El hecho de que podamos concebir muchos universos alternativos, definidos por otros valores de las constantes de la Naturaleza, quizá sea simplemente un reflejo de nuestra ignorancia acerca de “la prisión” en la que está confinada la consistencia lógica que exige una Teoría de Todo. Cuando se trata de contemplar otros universos tenemos dos formas de abordar el problema. Existe la aproximación conservadora que produce mundos alternativos haciendo pequeños cambios en las propiedades de nuestro mundo; pequeños cambios en los valores de algunas de las constantes de la Naturaleza, propiedades ligeramente diferentes del Universo astronómico, quizá, pero no cambios en las propias leyes de la Naturaleza. Normalmente estos muestran que si “los pequeños cambios” son demasiado grandes hay consecuencias adversas para la existencia de la vida tal como la conocemos. Nuestro tipo de vida puede seguir existiendo si hubiera un cambio de una parte en cien mil millones en el valor de la constante de estructura fina, pensamos nosotros, pero no si hubiera un cambio de una parte entre diez.

Saber lo que nos podemos encontrar en otros mundos…..

¿Quién sabe? Con unas constantes diferentes podríamos tener cualquier clase de Universo incluso ¿Alguno en la sombra? Claro que grandes cambios pueden alterar otras cosas como las leyes, la lógica matemática subyacente o el de dimensiones del espacio tiempo. Tiene que concebir tipos de “vida” que ni podemos imaginar, serían completamente nuevos y que podrían existir en ambientes tan diferentes al nuestro que, incluso, teniéndolos a nuestro lado, no lo podríamos ver y, claro, al llegar a este punto nos suscita tener que hacer un examen más detallado de qué entendemos por vida, dado que esa vida de ese otro universo, sería tan vida como la del nuestro.

Ante todas estas ideas… al contemplar escenas de nuestro mundo como la que arriba contemplamos, no puedo dejar de imaginar lo que pensarían seres de otros mundos que nos pudieran estar contemplando. Fabricamos “colmenas” que nos sirven de habitad y que están adecuadas a las de nuestro mundo. En otros mundos mucho mayores, de tener presente la vida, dada su enorme gravedad, ésta tendría que ser pequeña ¿De insectos quizá?

No sería nada visitar otro Universo en cuyos mundos sólo vivieran insectos de dos metros, o, aquellos otros que, poblados de sofisticados robots tuvieran una Sociedad constituida sobre una continuada replicación y su único objetico sería el de poblar mundos y más mundos en los que, como sería lógico pensar, no cabrían otros seres que, como nosotros, venimos de un origen natural que serían, seguramente los seres primigenios del planeta que construyeron a los que hoy dominan esos mundos.

Haber podido conquistar algunos conocimientos que nos hablan de la inmensidad del Universo, de la diversidad de infinitas estrellas y de la multiplicidad de mundos que existen en las galaxias que pueblan el Cosmos, no podemos dejar de imaginar los mundos que, con propiedades diferentes a las de la Tierra, puedan albergar a criaturas que, unas veces habrán alcanzado la consciencia y otras no. Cuando podamos alcanzar la tecnología necesaria para visitar otros mundos que orbitan a estrellas similares y diferentes al Sol, entonces, y sólo entonces, podremos comprender que la vida en el Universo es de muchas maneras y que no estamos solos en tan vasto espacio.

Negarlo no lo podemos negar y, hasta es muy probable que sí puedan existir esos otros Universos. Sin embargo, yo me quedo con el nuestro que, poco a poco, se va dejando descorrer el velo que esconde sus secretos y estamos llegando a un nivel aceptable de comprensión de lo que su Naturaleza pudiera ser. Ningún Universo como el nuestro para vivir y tratar de llevar a cabo nuestros proyectos de futuro. Y, si finalmente nos vemos abocados a tener que “mudarnos” a uno de esos otros Universos, lo esencial será comprobar antes que, las son exactas o muy parecidas a las del nuestro,

Este escenario evolutivo de nuestro Universo tiene la característica clave de que las físicas en el pasado no eran las mismas que las actuales o las futuras. Hubo épocas en que la vida no podía existir porque había demasiado calor para los átomos; hubo épocas previas a las estrellas y habrá un tiempo en el que todas las estrellas hayan muerto. En este escenario hay un intervalo preferido de la historia cósmica durante el que es más probable que los observadores evolucionen por primera vez y hagan sus observaciones del Universo y, si hemos hecho nuestra tarea, también sabremos de esos otros universos que nos pudieran acoger en ese momento final del nuestro.

¡Es todo tan complicado! ¡Sabemos tan poco!

¿Estaría programada la presencia de los seres vivos inteligentes en el Universo?

Por fuerza la cosmología conduce a cuestiones fronterizas entre ciencia experimental, filosofía y religión. No es solo el caso de los sabios antiguos. También los físicos de hoy se plantean preguntas de esa clase, sobre todo a propósito del llamado “principio antrópico”. A partir de los conocimientos actuales, este principio señala que las leyes y magnitudes físicas fundamentales parecen cuidadosamente afinadas para que la formación y el desarrollo del universo pudieran dar lugar a la vida en la Tierra y en otros planetas idóneos para acogerla.

El “Principio Copernicano”, invocado frecuentemente en la Cosmología moderna, insiste en la homogeneidad del Universo, negando cualquier primacía de posición o propiedades asociadas con la existencia humana. En cualquier parte del Universo podrán estar presentes los seres vivos.

El “Principio Copernicano” como habréis deducido ya, toma su nombre de la propuesta de Copérnico (ya anteriormente formulada por Aristarco) de desplazar a la Tierra de la posición central ocupada en el sistema de Tolomeo, aunque tal centralidad se debiese a la falta de paralaje estelar y no a una sobrevaloración de nuestra existencia en el planeta.

El paso siguiente lo dio Shapley hace un siglo, al mostrar que tampoco el Sol ocupa el centro de la Via Láctea. Finalmente, el Universo “finito pero ilimitado” de Einstein niega la posibilidad de encontrar un centro en su volumen tridimensional, y afirma la equivalencia de posición de todos los puntos del espacio. No tiene sentido preguntar dónde estamos en el continuo expandirse de un Universo que contiene probablemente más de 100.000 millones de galaxias, y que vuelve a la insignificancia aun la majestuosa estructura de la Vía Láctea, nuestra ciudad cósmica.

Sin embargo, a partir de la década de los años 30, se da una reacción interesante, que afirma, cada vez con argumentos más fuertes y detallados, que el Hombre está en un tiempo y un lugar atípicos y privilegiados en muchos respectos, que obligan a preguntarnos si nuestra existencia está ligada en un modo especial a características muy poco comunes en el Universo. Esta pregunta adquiere un significado especial al considerar las consecuencias previsibles (según las leyes físicas) de cualquier alteración en las condiciones iniciales del Universo. Con un eco de las palabras de Einstein: ¿tuvo Dios alguna alternativa al crear?. No solamente debemos dar razón de que el Universo exista, sino de que exista de tal manera y con tales propiedades que la vida inteligente puede desarrollarse en él. Tal es la razón de que se formule el Principio Antrópico, en que el Hombre (entendido en el sentido filosófico de “animal racional”, independientemente de su hábitat y su morfología corporal) aparece como condición determinante de que el Universo sea como es.

No hemos logrado ese contacto pero…llegará

Las primeras sugerencias de una conexión entre vida inteligente y las propiedades del Universo en su momento actual aparecen en las relaciones adimensionales hechas notar por Eddington: la razón de intensidad entre fuerza electromagnética y fuerza gravitatoria entre dos electrones, entre la edad del Universo y el tiempo en que la luz cruza el diámetro clásico de un electrón, entre el radio del Universo observable y el tamaño de una partícula subatómica, nos da cifras del orden de 10 elevado a la potencia 40. El número de partículas nucleares en todo el cosmos se estima como el cuadrado de ese mismo número. ¿Son éstas coincidencias pueriles o esconden un significado profundo?. La hipótesis de los grandes números sugiere que el Hombre solamente puede existir en un lugar y momento determinado, cuando tales coincidencias se dan, aunque nadie hasta el momento ha podido dar una explicación de estas relaciones.

Arthur Eddintong

Una versión más especulativa, el principio antrópico fuerte, asegura que las leyes de la física deben tener propiedades que permitan evolucionar la vida. La implicación de que el universo fue de alguna manera diseñado para hacer posible de la vida humana hace que el principio antrópico fuerte sea muy controvertido, ya que nos quiere adentrar en dominios divinos que, en realidad, es un ámbito incompatible con la certeza comprobada de los hechos a que se atiene la ciencia, que recorre senderos muy alejados de los que están presentes en la fe.

Si la carga del electrón, la masa del protón o la velocidad de la luz, variaran tan sólo una diezmilésima parte… ¡La vida tal como la conocemos no existiría! Es decir, estamos ante el problema del ajuste fino que significa que las las constantes fundamentales de un modelo físico para el universo deben ser ajustados de forma precisa para permitir la existencia de vida. Sobre estas constantes fundamentales no hay nada en la teoría que nos indique que deban tomar esos valores que toman. Podemos fijarlas de acuerdo con las observaciones, pero esto supone fijarlas de entre un rango de valores colosal. Esto da la impresión de cierta arbitrariedad y sugiere que el universo podría ser una realización improbable entre tal rango de valores. He ahí el problema.

El principio antrópico nos invita al juego mental de probar a “cambiar” las constantes de la naturaleza y entrar en el juego virtual de ¿qué hubiera pasado si…? Ya hemos hablado aquí muchas otras veces de lo que pasaría si el valor de las constantes fueran diferentes.

¿Viviríamos en un mundo de revés?

Especulamos con lo que podría haber sucedido si algunos sucesos no hubieran ocurrido de tal o cual manera para ocurrir de esta otra. ¿Qué hubiera pasado en el planeta Tierra si no aconteciera en el pasado la caída del meteorito que acabó con los dinosaurios? ¿Habríamos podido estar aquí hoy nosotros? ¿Fue ese cataclismo una bendición para nosotros y nos quitó de encima a unos terribles rivales?

Fantasean con lo que pudo ser…. Es un ejercicio bastante habitual; sólo tenemos que cambiar la realidad de la historia o de los sucesos verdaderos para pretender fabricar un presente distinto. Cambiar el futuro puede resultar más fácil, nadie lo conoce y no pueden rebatirlo con certeza. ¿Quién sabe lo que pasará mañana?

¿Serán ellos y no nosotros los que dominen el futuro?

Siempre estamos imaginando el futuro que vendrá. Los hombres tratan de diseñarlo pero, finalmente, será el Universo el que tome la última palabra de lo que deba ser. Por mucho que nosotros nos empeñemos, las estructuras del Universo nunca podrán ser cinceladas por nuestras manos ni por nuestros ingenios, sólo las inmensas fuerzas de la Naturaleza puede transformar las estrellas, las galaxias o los mundos…lo demás, por muy bello que pudiera ser, siempre será lo artificial.

Lo que ocurra en la naturaleza del universo está en el destino de la propia naturaleza del cosmos, de las leyes que la rigen y de las fuerzas que gobiernan su mecanismo sometido a principios y energías que, en la mayoría de los casos se pueden escapar a nuestro actual conocimiento.

Lo que le pueda ocurrir a nuestra civilización, además de estar supeditada al destino de nuestro planeta y de nuestro Sol, incluso de nuestro Sistema Solar y de la Galaxia, de alguna manera, también está en manos de los propios individuos que forman esta civilización y que, con sensibilidades distintas y muchas veces dispares, hace impredecibles los acontecimientos que puedan provocar individuos que participan con el poder individual de libre albedrío. Fijaos hoy mismo lo que puede dar de sí esa insensata polémica (que dura ya milenios) entre los palestinos y los israelitas.

Siempre hemos sabido especular con lo que pudo ser o con lo que podrá ser si… Lo que en la mayoría de las veces, es el signo de cómo queremos ocultar nuestra ignorancia. Bien es cierto que sabemos muchas cosas pero, también es cierto que son más numerosas las que no sabemos.

Cuando el Sol agote todo su combustible nuclear, estará acercándose el final de la Tierra como planeta que albergó la vida. Los cambios serán irreversibles, los océanos se evaporarán y sus aguas hirvientes comenzarán a llenar la atmósfera de gases. La Gigante roja engullirá a los planetas Mercurio, Venus y probablemente se quedará muy cerca de la Tierra calcinada y sin vida.

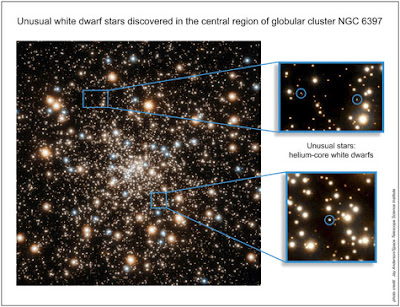

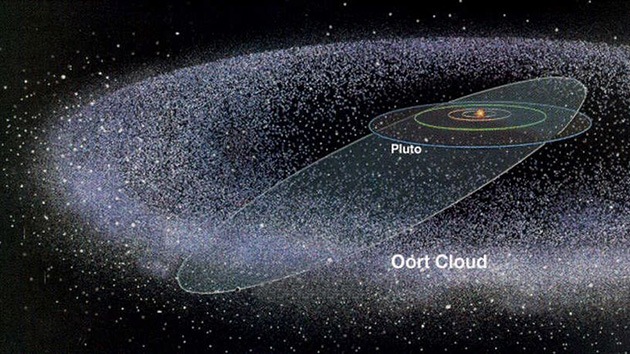

Sabiendo que el destino irremediable de nuestro mundo, el planeta Tierra, es de ser calcinado por una estrella gigante roja en la que se convertirá el Sol cuando agote la fusión de su combustible de hidrógeno, helio, carbono, etc, para que sus capas exteriores de materia exploten y salgan disparadas al espacio exterior, mientras que, el resto de su masa se contraerá hacia su núcleo bajo su propio peso, a merced de la gravedad, convirtiéndose en una estrella enana blanca de enorme densidad y de reducido diámetro. Sabiendo eso, el hombre está poniendo los medios para que, antes de que llegue ese momento (dentro de algunos miles de millones de años), poder escapar y dar el salto hacia otros mundos lejanos que, como la Tierra ahora, reúna las condiciones físicas y químicas, la atmósfera y la temperatura adecuadas para acogernos.

En el inmenso Universo, eso es lo que podría quedar de nuestro Sol, una insignificante Nebulosa Planetaria y, la consecuencia de tal transición de fase será, una Tierra sin vida y un Sistema solar de objetos muertos.

Pero el problema no es tan fácil y se extiende a la totalidad del universo que, aunque mucho más tarde, también está abocado a la muerte térmica, el frío absoluto si se expande para siempre como un universo abierto y eterno, o el más horroroso de los infiernos, si estamos en un universo cerrado y finito en el que, un día, la fuerza de gravedad, detendrá la expansión de las galaxias que comenzarán a moverse de nuevo en sentido contrario, acercándose las unas a las otras de manera tal que el universo comenzará, con el paso del tiempo, a calentarse, hasta que finalmente, se junte toda la materia-energía del universo en una enorme bola de fuego de millones de grados de temperatura, el Big Crunch. Eso daría lugar a otro Big Bang, a otro universo. Sin embargo, según los datos de que se dispone hoy, no parece que el Big Crunch pueda suceder.

Un universo replegándose sobre sí mismo…no parece probable

El irreversible final está entre los dos modelos que, de todas las formas que lo miremos, es negativo para la Humanidad (si es que para entonces aún existe). En tal situación, algunos ya piensan en la manera de escapar a tan terrible futuro. Claro que, ahora no podemos saber si finalmente, nuestro Universo se fundirá con otro como consecuencia de la expansión (el otro también se expande hacia nosotros) y, como se fusionan las galaxias, también deben hacerlo los universos. Si eso es así (que no se sabe), quizá todo diera lugar a un nuevo “amanecer” para la Humanidad.

Stephen Hawking ha llegado a la conclusión de que estamos inmersos en un multiuniverso, esto es, que existen infinidad de universos conectados los unos a los otros. Unos tienen constantes de la naturaleza que permiten vida igual o parecida a la nuestra, otros posibilitan formas de vida muy distintas y otros muchos no permiten ninguna clase de vida.

Este sistema de inflación autorreproductora nos viene a decir que cuando el universo se expande (se infla) a su vez, esa burbuja crea otras burbujas que se inflan y a su vez continúan creando otras nuevas más allá de nuestro horizonte visible. Cada burbuja será un nuevo universo, o mini-universo en los que reinarán escenarios diferentes o diferentes constantes y fuerzas.

¿Quién puede saber de lo que seremos capaces mañana?

El posible escenario futuro ha sido explorado y el resultado hallado es que, podrían exisitr otros universos en cada uno de esos universos, puede haber muchas cosas diferentes; pueden terminar con diferentes números de dimensiones espaciales o diferentes constantes y fuerzas de la naturaleza, pudiendo unos albergar la vida y otros no. ¡Qué locura!

El reto que queda para los cosmólogos es calcular las probabilidades de que emerjan diferenta universos a partir de esta complejidad inflacionaria ¿Son comunes o raros los universos como el nuestro? Existen, como para todos los problemas planteados, diversas conjeturas y consideraciones que influyen en la interpretación de cualquier teoría cosmológica futura cuántico-relativista. Hasta que no seamos capaces de exponer una teoría que incluya la relatividad general de Einstein (la gravedad-cosmos) y la mecánica cuántica de Planck (el cuanto-átomo), no será posible contestar a ciertas preguntas.

La teoría de cuerdas tiene un gancho tremendo. Te transporta a un mundo de 11 dimensiones, universos paralelos, y partículas formadas por cuerdecitas casi invisibles vibrando a diferentes frecuencias. Además, te dice que no se trata de analogías sino de la estructura más profunda de la realidad, y que ésta podría ser la teoria final que unificara por fin a toda la física. ¿No estaremos hablando de Filosofía?

Todas las soluciones que buscamos parecen estar situadas en teorías más avanzadas que, al parecer, sólo son posibles en dimensiones superiores, como es el caso de la teoría de supercuerdas situada en 10, 11 ó 26 dimensiones. Allí, si son compatibles la relatividad y la mecánica cuántica, hay espacio más que suficiente para dar cabida a las partículas elementales, las fuerzas gauge de Yang-Mill, el electromagnetismo de Maxwell y, en definitiva, al espacio-tiempo y la materia, la descripción verdadera del universo y de las fuerzas que en él actúan.

Científicamente, la teoría del hiperespacio lleva los nombres de Teoría de Kaluza-Klein y supergravedad. Pero en su formulación más avanzada se denomina Teoría de Supercuerdas, una teoría que desarrolla su potencial en nueve dimensiones espaciales y una de tiempo: diez dimensiones. Así pues, trabajando en dimensiones más altas, esta teoría del hiperespacio puede ser la culminación que conoce dos milenios de investigación científica: la unificación de todas las fuerzas físicas conocidas. Como el Santo Grial de la Física, la “teoría de todo” que esquivó a Einstein que la buscó los últimos 30 años de su vida (sin tener las herramientas matemáticas necesarias para ello).

Es cierto, los mejores siempre han buscado el Santo Grial de la Física. Una Teoría que lo pueda explicar todo, la más completa que, mediante una sencilla ecuación, responda a los misterios del Universo. Claro que tal hazaña, no depende siquiera de la inteligencia del explorador que la busca, es más bien un problema de que las herramientas necesarias (matemáticas) para hallarla, aún no han sido inventadas.

Durante el último medio siglo, los científicos se han sentido intrigados por la aparente diferencia entre las fuerzas básicas que mantienen unido al cosmos: la Gravedad, el electromagnetismo y las fuerzas nucleares fuerte y débil. Los intentos por parte de las mejores mentes del siglo XX para proporcionar una imagen unificadora de todas las fuerzas conocidas han fracasado. Sin embargo, la teoría del hiperespacio permite la posibilidad de explicar todas las fuerzas de la naturaleza y también la aparentemente aleatoria colección de partículas subatómicas, de una forma verdaderamente elegante. En esta teoría del hiperespacio, la “materia” puede verse también como las vibraciones que rizan el tejido del espacio y del tiempo. De ello se sigue la fascinante posibilidad de que todo lo que vemos a nuestro alrededor, desde los árboles y las montañas a las propias estrellas, no son sino vibraciones del hiperespacio.

Queremos llegar a manejar los mundos, las galaxias, el universo…

Antes mencionábamos los universos burbujas nacidos de la inflación y, normalmente, el contacto entre estos universos burbujas es imposible, pero analizando las ecuaciones de Einstein, los cosmólogos han demostrado que podría existir una madeja de agujeros de gusano, o tubos, que conectan estos universos paralelos.

Aunque muchas consecuencias de esta discusión son puramente teóricas, el viaje en el hiperespacio puede proporcionar eventualmente la aplicación más práctica de todas: salvar la vida inteligente, incluso a nosotros mismos, de la muerte de este universo cuando al final llegue el frío o el calor.

Esta nueva teoría de supercuerdas tan prometedora del hiperespacio es un cuerpo bien definido de ecuaciones matemáticas. Podemos calcular la energía exacta necesaria para doblar el espacio y el tiempo o para cerrar agujeros de gusano que unan partes distantes de nuestro universo. Por desgracia, los resultados son desalentadores. La energía requerida excede con mucho cualquier cosa que pueda existir en nuestro planeta. De hecho, la energía es mil billones de veces mayor que la energía de nuestros mayores colisionadores de átomos. Debemos esperar siglos, o quizás milenios, hasta que nuestra civilización desarrolle la capacidad técnica de manipular el espacio-tiempo utilizando la energía infinita que podría proporcionar un agujero negro para de esta forma poder dominar el hiperespacio que, al parecer, es la única posibilidad que tendremos para escapar del lejano fin que se avecina. ¿Que aún tardará mucho? Sí, pero el tiempo es inexorable, la debacle del frío o del fuego llegaría.

¿Doblar el Hiperespacio…? ¡Encontrar la manera de burlar la velocidad de la luz!

No existen dudas al respecto, la tarea es descomunal, imposible para nuestra civilización de hoy, ¿pero y la de mañana?, ¿no habrá vencido todas las barreras? Creo que el hombre es capaz de plasmar en hechos ciertos todos sus pensamientos e ideas, sólo necesita tiempo:

¡El Tiempo! ¿Tendremos mucho por delante? ¿Sabremos aprovecharlo?

emilio silvera

Totales: 75.611.357

Totales: 75.611.357 Conectados: 30

Conectados: 30