Nov

3

La frontera K-T. Hablemos de eso.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (0)

Comments (0)

Situación de los continentes a finales del Cretácico. El cráter de Chicxulub está señalado en el centro de la imagen. Los fantásticos dinosaurios que, si no tuviéramos la evidencia fósil

La teoría más extendida de todas las que intentan explicar la extinción del 65% de las especies que habitaban la Tierra hace 65 millones de años, se refiere al impacto de un gran meteorito en Chicxulub que formó un cráter de 180 kilómetros de diámetro. La prueba esgrimida como definitiva fue el hallazgo de esférulas derivadas del impacto inmediatamente debajo del límite estratigráfico entre el Cretácico y el Terciario, junto con la detección de una anomalía de iridio coincidente con la extinción masiva de foraminíferos marinos, y el descubrimiento y datación del propio cráter de Chicxulub.

Pero para entender de qué hablamos señalemos cuestiones sencillas que todos entendemos como, por ejemplo, la muerte de los dinosaurios que se extinguieron (según todos los indicios) hace ahora 65 millones de años, como parte de una extinción masiva de la vida en la Tierra, algo tan claramente reflejado en el registro fósil que se utiliza para marcar el final de un período de tiempo geológico, el cretáceo, y el comienzo de otro, el terciario.

La huella dejada por aquel acontecimiento en el todo el mundo, no deja lugar a dudas para los geólogos. La señal, les habla del pasado

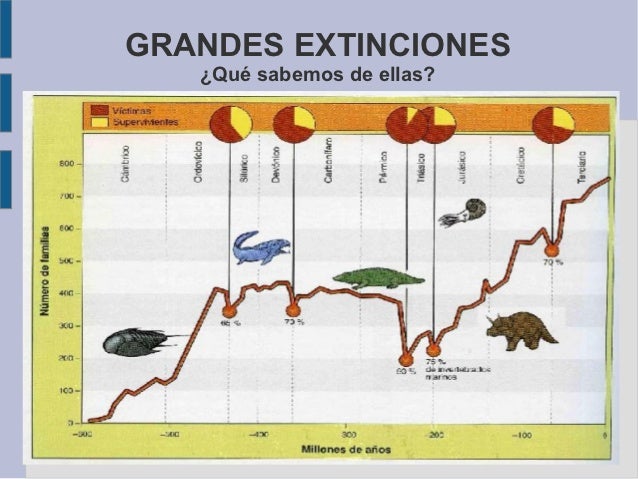

Puesto que la “C” ya se ha utilizado como inicial en un contexto similar en relación con el período Cámbrico, este marcador se suele denominar Frontera K-T, con una “K” de Kreide, que es el nombre del Cretáceo en alemán. No fueron sólos los dinosaurios los que resultaron afectados (aunque por sus características son los que siempre aparecen con mayor protagonismo en el suceso). Alrededor del 70 por ciento de todas las especies que vivían en la Tierra a finales del Cretáceo habían desaparecido al principio del Terciario, lo cual nos indica que se trató realmente de una “extinción en masa” y explica por qué los geólogos y los paleontólogos utilizan la frontera K – T como un marcador importante en el registro fósil.

Dadas las dificultades que plantean unas pruebas de tiempos tan remotos, y la lentitud con la que se acumulan los estratos geológicos, todo lo que podemos decir sobre la velocidad a la que se priodujo aquella extinción es que sucedió en menos de unas pocas decenas de miles de años o en unos cien mil años; sin embargo, esto se considera un cambio brusco en relación con la escala de tiempo utilizada en geología.

La hipótesis propone que un asteroide de 15 kilómetros de diámetro impactó en algún lugar de la Tierra (después se identificó con un cráter en las inmediaciones de la península del Yucatán, el llamado cráter de Chicxulub), levantando millones de toneladas de corteza continental volatilizada a la atmósfera. Posteriormente, tras unas prospecciones petrolíferas se encontró la posible huella del evento buscado, como se puede observar en la siguiente imagen:

El impacto que creó un cráter de 180 kilómetros de diámetro ocasionó que millones de toneladas de plataforma continental fueran volatilizadas y enviadas a decenas de kilómetros de altura ocasionando una nube de polvo muy densa que persistió durante años llevando al mundo a un enfriamiento global siendo aquel el mayor invierno nuclear que ha visto la Tierra, que sepamos.

Las preguntas obvias que todo esto plantearon las mismas que surgen tras un gran terremoto: ¿por qué sucedió? ¿podría suceder de nuevo? y, en ese caso, ¿cuándo? En el caso del suceso K – T, tenemos un candidato muy cualificado para que fuera el desencadenante que hizo que aquella extinción se produjera hacer 65 millones de años, en vez de suceder por ejemplo, hace 60 o 55 millones de años. Los restos de ese enorme cráter de arriba que data justo de entonces ha sido descubierto bajo lo que actualmente es la península de Yucatán, en México, y por todo el mundo se ha encontrado estratos de hace 65 millones de años que contienen restos de Iridio, un metal abundante en el centro de la Tierra pero, muy escaso en la superficie, del que sabemos que es un componente de los meteoritos de cierto tipo.

Si alguno de estos cayera sobre la Tierra, la Historia se podría repetir y, en algún caso, ni sería seguro que algo vivo pudiera seguir existiendo con la caída de un enorme “monstruo” pétreo venido del espacio interestelar a velocidades alucinantes que no podríamos frenar ni destruir. La Tierra, a pesar de su mucha y avanzada tecnología, no está preparada para solucionar estos problemas.

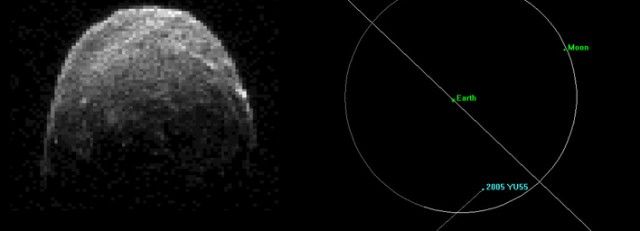

Se llama 2005 YU55 y no es la primera vez que tenemos noticias de él. Este asteroide de 400 metros de diámetro (el tamaño de un portaaviones) calificado en su día como potencialmente peligroso para la Tierra, se acercó el pasado 8 de noviembre a 324.600 kilómetros de nuestro planeta, una distancia inferior a la que está la Luna. En términos astronómicos, significa una arriesgada caricia en la cara. Observatorios de todo el mundo no perdieron detalle de la visita. En concreto, científicos de la NASA siguieron la trayectoria de la roca espacial desde radiotelescopios de Goldstone, California, y Arecibo, en Puerto Rico. Ante la sensación que causó la cercanía del cometa Elenin, la agencia espacial ha querido adelantarse a los más aprensivos: “el asteroide no ejercerá ninguna influencia sobre las placas tectónicas o la gravedad de la Tierra. No se notará efecto alguno.”

La trayectoria del 2005 YU55, descubierto en 2005 por astrónomos de la Universidad de Arizona, es bien conocida. En su punto máximo de aproximación llegará a 324.600 kilómetros de la Tierra (0,85 de la distancia a la Luna). Aunque 2005 YU55 visita regularmente la vecindad de la Tierra, Venus y Marte, debido a su trayectoria, el encuentro de 2011 fue el más cercano que esta roca espacial ha realizado durante los últimos 200 años. ¿Quién nos garantiza que la próxima vez será el viaje tan pacífico? Cualquier suceso podría variar su trayectoria con resultados funestos para nosotros.

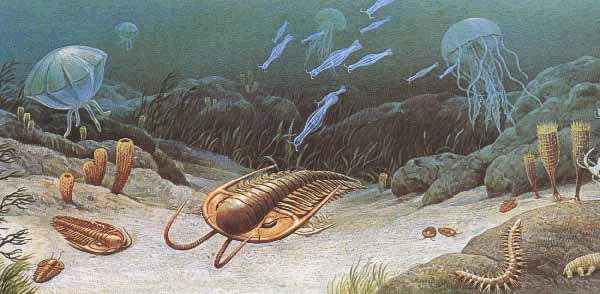

Hace 444 millones de años, en la transición entre los períodos Ordovícico y Silúrico, ocurrieron dos extinciones masivas llamadas extinciones masivas del Ordovícico-Silúrico. Su causa probable fue el período glaciar. El primer evento ocurrió cuando los hábitats marinos cambiaron drásticamente al descender el nivel del mar. El segundo ocurrió entre quinientos mil y un millón de años más tarde, al crecer el nivel del mar rápidamente.

Como decíamos antes, hace 65 millones de años en la extinción masiva del Cretácico-Terciario, desaparecieron cerca del 50% de todas las especies, incluyendo los dinosaurios.

Durante el cretácico tardío, el nivel del mar subió en todo el mundo, inundando casi un tercio de la superficie terrestre actual.

Hace 444 millones de años, en la transición entre los períodos Ordovícico y Silúrico, ocurrieron dos extinciones masivas llamadas extinciones masivas del Ordovícico-Silúrico. Su causa probable fue el período glaciar. El primer evento ocurrió cuando los hábitats marinos cambiaron drásticamente al descender el nivel del mar. El segundo ocurrió entre quinientos mil y un millón de años más tarde, al crecer el nivel del mar rápidamente.

Como decíamos antes, hace 65 millones de años en la extinción masiva del Cretácico-Terciario, desaparecieron cerca del 50% de todas las especies, incluyendo los dinosaurios.

Durante el cretácico tardío, el nivel del mar subió en todo el mundo, inundando casi un tercio de la superficie terrestre actual.

Así, el calor del sol pudo distribuirse más hacia el norte gracias a las corrientes marinas, dando lugar a un clima global cálido y suave, con polos sin casquete de hielo y una temperatura en las aguas del Ártico de 14° C o más.

En un clima así, los reptiles de sangre fría podían proliferar incluso en latitudes boreales, mientras que los fósiles de helechos y cicas encontrados en rocas del cretácico a latitudes árticas son similares a las plantas de hoy en los bosques húmedos subtropicales.

Nov

3

Hay que ir más allá del Modelo Estándar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Modelo Estánfar ~

Clasificado en El Modelo Estánfar ~

Comments (4)

Comments (4)

Gordon Kane (en 2003), un físico teórico de la Universidad de Michigan, decía: “… el Modelo Estándar es, en la historia, la más sofisticada teoría matemática sobre la naturaleza. A pesar de la palabra “modelo” en su nombre, el Modelo Estándar es una teoría comprensiva que identifica las partículas básicas y especifica cómo interactúan. Todo lo que pasa en nuestro mundo (excepto los efectos de la gravedad) es resultado de las partículas del Modelo Estándar interactuando de acuerdo con sus reglas y ecuaciones”.

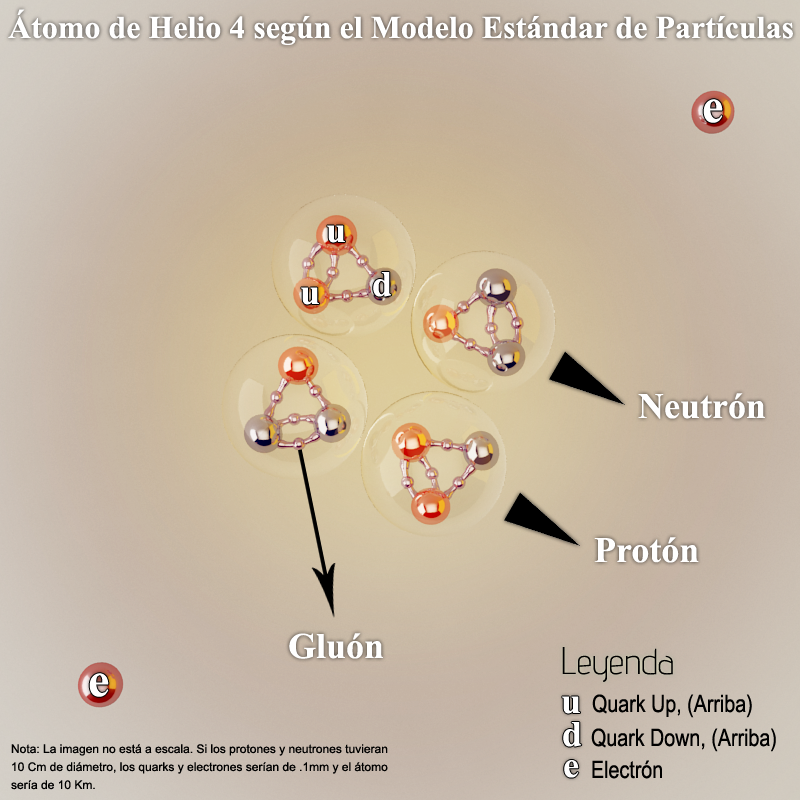

De acuerdo con el Modelo Estándar, leptones y quarks son partículas verdaderamente elementales, en el sentido de que no poseen estructura interna. Las partículas que tienen estructura interna se llaman hadrones; están constituidas por quarks: bariones cuando están formadas por tres quarks o tres antiquarks, o mesones cuando están constituidas por un quark y un antiquark.

Nuevos datos del experimento BaBar, una colaboración internacional que tiene su sede en California, Estados Unidos, fueron analizados recientemente y los resultados obtenidos parecen indicar que existen posibles fallos en el Modelo Estándar de la Física de Partículas, teoría que hasta el momento es la que explica mejor cómo funciona el universo a escalas subatómicas.

Claro que, ya estamos acostumbrados a que el imparable avance del conocimiento de la física, a medida que se van descubriendo nuevas tecnologías, también nos posibilite para poder avanzar más y más profundamente en los modelos y teorías que manejamos y, lo que podemos ir viendo en los nuevos descubrimientos nos ayudan a mejorar los modelos y teorías actuales para ir adaptando la física a la realidad que la Naturaleza nos muestra.

Sin embargo, y a pesar de ello, lo cierto es que, el llamado Modelo Estándar (en lineas generales) nos ha servido bien como una teoría coherente y de extraordinario éxito en relación a las interacciones que operan en el Universo. De hecho, el Modelo Estándar incorpora las teorías relativistas y cuánticas de interacciones fuertes, electromagnéticas y débiles (dejando fuera la Gravedad) que ha superado todas las pruebas con la evidencia experimental, desde las energías más pequeñas hasta los millones de millones de electrón-voltios que se han alcanzado en los Laboratorios del Fermilab en Illinois; desde la precisión de las medidas de masas de estados ligados o de momentos magnéticos, a baja energía, hasta las fabulosas del acelerador LEP en el CERN y ahora del LHC los dos en Ginebra.

Un átomo de Helio 4 según el modelo estándar, se muestra de color rojo las interacciones electromagnéticas y de color naranja las Fuertes. Entrar en este “universo” de lo muy pequeño resulta verdaderamente fascinante. Ahí podemos ver cosas que, en la vida cotidiana están ausentes y, nos puede parecer habernos transportado a otro mundo donde las cosas funcionan de otra manera.

Según el Modelo Estándar, la gran cantidad de partículas elementales hasta hoy detectadas, cerca de 300, en aceleradores/colisionadores de partículas o en rayos cósmicos, puede ser agrupada en leptones, quarks y hadrones o en leptones y hadrones, ya que los quarks son constituyentes de los hadrones o, también, en leptones, bariones y mesones, pues los hadrones pueden ser divididos en bariones y mesones.

Las interacciones fundamentales tienen lugar como si las partículas que interactúan “intercambiasen” otras partículas entre sí. Esas partículas mediadoras serían los fotones en la interacción electromagnética, los gluones en la interacción fuerte, las partículas W y Z en la interacción débil y los gravitones (aún no detectados) en la interacción gravitacional. Es decir, partículas eléctricamente cargadas interactuarían intercambiando fotones, partículas con carga color interactuarían intercambiando gluones, partículas con carga débil intercambiarían partículas W y Z, mientras que partículas con masa intercambiarían gravitones.

Los Gluoners mantienen unidos a los Quarks que forman los nucleones

Las partículas mediadoras pueden no tener masa, pero tienen energía, o sea, son pulsos de energía. Por eso, se llaman virtuales. De los cuatro tipos de partículas mediadoras, las del tipo W y Z tienen masa, pero es común que todas sean llamadas partículas virtuales.

Entonces, se podría decir que las partículas de materia o partículas reales (leptones, quarks y hadrones) interactúan intercambiando partículas virtuales (fotones, gluones, W y Z, y gravitones). Aquí hay que tener en cuenta que las partículas de materia pueden tener más de una carga, de modo que experimentarían varias interacciones y fuerzas, pero el ámbito de la interacción puede variar mucho, de tal manera que en un determinado dominio una cierta interacción puede ser irrelevante. La fuerza gravitacional, por ejemplo, puede ser despreciada en el dominio subatómico. Es decir, aunque existan cuatro interacciones fundamentales, cuatro cargas y cuatro fuerzas, eso no quiere decir que todas las partículas tengan las cuatro cargas y experimenten las cuatro interacciones. a Gravedad en este ámbito, es tan pequeña que, pasa desapercibida para nuestros actuales instrumentos.

¿Por qué hay algo en vez de nada? ¿Por qué hay tantas partículas elementales diferentes? Los señores que arriba vemos a los tres físicos que fueron premiados con el Nobel de Física por sus ideas teóricas que suministraron una comprensión más profunda de lo que sucede en el interior de los bloques más pequeños que forman la materia.

La naturaleza de las leyes de simetría se encuentran en el corazón de este asunto. O más bien, la ruptura de las simetrías, tanto las que parecen haber existido en nuestro universo desde el principio como aquellas que han perdido su simetría original en alguna parte del camino.

De hecho, todos somos hijos de la simetría rota. Ello debió ocurrir inmediatamente después del Big Bang, hace unos 14.000 millones de años cuando fueron creadas la materia y la antimateria. El contacto de materia y antimateria es fatal para ambas, se aniquilan mutuamente y se transforman en radiación. Es evidente que la materia, al final, ganó la partida a la antimateria, de otra manera nosotros no estaríamos aquí. Pero estamos, y una pequeña desviación de la simetría perfecta parece que ha sido suficiente –un exceso de una partícula de materia por cada diez mil millones de partículas de antimateria fueron suficientes para hacer que nuestro mundo exista-. Este exceso de la materia fue la semilla de nuestro universo, lleno de galaxias, estrellas y planetas y, eventualmente, de vida. Pero lo que hay detrás de esta violación de la simetría en el cosmos es aún un gran misterio y un activo campo de investigación.

La teoría de las partículas elementales considera tres formas básicas de simetría: simetría especular, simetría de carga y simetría temporal (en el lenguaje de la física la simetría especular es denominada P, de paridad; la simetría de carga, C y la simetría temporal,T).

En la simetría especular todos los sucesos ocurren exactamente igual si son observados directamente o reflejados en un espejo. Ello implica que no existe ninguna diferencia entre izquierda y derecha y nadie sería capaz de distinguir su propio mundo de otro reflejado en un espejo. La simetría de carga predice que las partículas cargadas se comportarán exactamente igual que sus antipartículas, las cuales tiene exactamente las mismas propiedades pero carga opuesta. Y de acuerdo con la simetría temporal, las cosas sucederían exactamente igual con independencia de que el tiempo transcurra hacia delante o hacia atrás.

Cotidianidad o simetría temporal

El Modelo Estándar es una síntesis de todas las ideas que la física de partículas ha generado durante más de un siglo. Se asienta sobre la base teórica de los principios de simetría de la física cuántica y la teoría de la relatividad y ha resistido a innumerables pruebas. No obstante, varias crisis se sucedieron poniendo en peligro el bien construido edificio del modelo. Estas crisis tuvieron lugar porque los físicos asumían que las leyes de la simetría eran aplicables al micromundo de las partículas elementales. Pero esto no era totalmente cierto.

La primera sorpresa surgió en 1956 cuando dos físicos teóricos chino-americanos, Tsung Dao Lee y Chen Ning Yang (galardonados con el Premio Nobel al año siguiente, en 1967) comprobaron que la simetría especular (simetría P) era violada por la fuerza débil.

Una nueva violación de las leyes de la simetría tenía lugar en la desintegración de una extraña partícula llamada kaón (Premio Nobel concedido a James Cronin y Val Fitch en 1980). Una pequeña fracción de los kaones no seguían las leyes de la simetría especular y de carga; se rompía la simetría CP y se desafiaba la estructura misma de la teoría.

Como ya se ha explicado el Modelo Estándar comprende todas las partículas elementales conocidas y tres de las cuatro fuerzas fundamentales. Pero, ¿por qué son estas fuerzas tan diferentes?. ¿Y por qué las partículas tienen masas tan diferentes?. La más pesada, el quark top, es más de tres mil cien veces más pesado que el electrón. ¿Por qué tienen todas masa? La fuerza débil destaca en este aspecto una vez más: sus portadores, las partículas Z y W son muy pesadas, mientras que el fotón, que transmite la fuerza electromagnética, carece de masa.

La mayoría de los físicos piensa que el llamado mecanismo de Higgs es el responsable de que la simetría original entre fuerzas fuera destruido dando a las partículas sus masas en las primeras etapas del universo.

El camino hacia ese descubrimiento fue trazado por Yoichiro Nambu quien, en 1960, fue el primero en introducir la violación espontánea de la simetría en la física de partículas. Es por este descubrimiento por el que se le concede el Premio Nobel de Física.

Tenemos algunos ejemplos banales de violación espontánea de la simetría en la vida diaria. Un lápiz en equilibrio sobre su punta lleva una existencia totalmente simétrica en la cual todas las direcciones son equivalentes. Pero esta simetría se pierde cuando cae -ahora sólo una dirección cuenta-. Por otro lado su condición es ahora más estable, el lápiz no puede volver a caer, ha llegado a su nivel más bajo de energía.

El vacío tiene el nivel de energía más bajo posible en el cosmos. En efecto, un vacío en física es precisamente un estado con la menor energía posible. Sin embargo, no está totalmente vacío. Desde la llegada de la física cuántica, el vacío está lleno de una burbujeante sopa de partículas que aparecen e inmediatamente desaparecen en invisibles y ubicuos campos cuánticos. Estamos rodeados por campos cuánticos que se extienden por el espacio; las cuatro fuerzas fundamentales de la naturaleza también son descritas como campos. Uno de ellos, el gravitacional, es conocido por todos nosotros. Es el que nos mantiene pegados a la tierra y determina la dirección arriba-abajo.

Nambu indicó que las propiedades del vacío son de gran interés para el estudio de la rotura espontánea de la simetría. Un vacío, que es el estado más bajo de energía, no se corresponde con el estado de mayor simetría. Tan pronto como el lápiz se cae, la simetría del campo cuántico queda rota y sólo una de las muchas direcciones posibles es elegida. En las últimas décadas los métodos de Nambu para tratar la violación de la simetría espontánea en el Modelo Estándar han sido refinados y son frecuentemente usados hoy para calcular los efectos de la fuerza fuerte.

Hablar de todo esto nos lleva hacia caminos amplios y de un largo recorrido.

¡Pero faltan los campos! Los cuatro campos. Sabemos que un cuerpo con masa crea alrededor de sí un campo gravitacional, un campo de fuerza que ejerce una fuerza sobre otro cuerpo masivo y viceversa. Análogamente, un cuerpo cargado eléctricamente, crea un campo electromagnético (si está en reposo, se percibe sólo su componente eléctrico, si está en movimiento se manifiesta también el componente magnético) y ejerce una fuerza electromagnética sobre otro cuerpo electrizado y viceversa.

De la misma manera, está el campo de la fuerza fuerte y el campo de la fuerza débil. O sea, hay cuatro campos fundamentales: el electromagnético, el fuerte, el débil y el gravitacional. Las partículas mediadoras son los quantos de los campos correspondientes: los fotones son los quantos del campo electromagnético, los gluones son los quantos del campo fuerte, las partículas W y Z del campo débil y los gravitones serían los quantos del campo gravitatorio.

En otras palabras, los cuatro campos fundamentales son el campo de fotones (electromagnético), el de gluones (fuerte), el de partículas W y Z (débil) y el de gravitones (gravitacional). El problema en esa bella simetría de cuatro cargas, cuatro interacciones, cuatro fuerzas, cuatro tipos de partículas mediadoras y cuatro campos es que aún no fue detectado ningún gravitón y la gravedad, en sí, no encaja bien en esa teoría llamada Modelo Estándar y, por eso precisamente, se dice que es incompleto y que necesitamosm una teoría cuántica de la Gravedad. En ese aspecto, yo, no las tengo todas conmigo, dado que la fuerza de Gravedad parece una teoría aparte y no quiere mezclarse con las otras. Sin embargo, dicen los de la teoría de cuerdas que allí, sí encajan las cuatro fuerzas.

Mucho, muchísimo nos queda por explicar en relación al Modelo estándar y a todo lo que en él está unido. Sin embargo, en física se avanza poco a poco, vamos conociendo cositas que unidas a otras cositas finalmente forman un todo en el que podemos contemplar una perspectiva más amplia y general y, a veces, hasta puede llegar a enseñarnos la belleza que encierram esos cuadros que pinta la Naturaleza y que nosotros, osados, tratamos de descubrir.

emilio silvera

Nov

2

Nanofotónica: luz + nanopartículas = Futuro tecnológico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (0)

Comments (0)

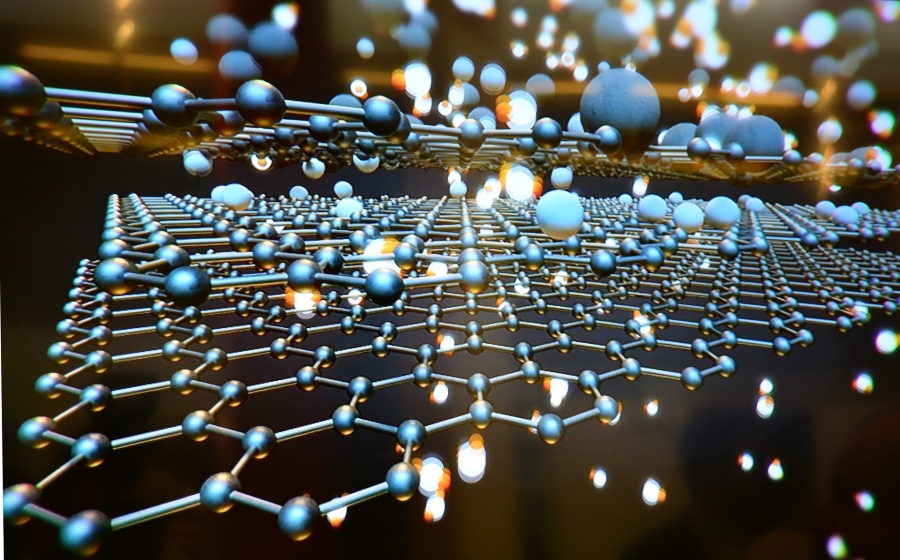

Han pasado ya cincuenta años que Richard Feynman dictara su famosa charla: There is plenty of room at the bottom: An invitation to enter a new field of physics (Hay suficiente espacio en el fondo: Una invitación a entrar en un campo en la Física). En ella estableció que las leyes de la Física no impiden manipular las cosas átomo a átomo; –es algo que se no se ha hecho debido a que somos demasiado grandes hacerlo-.

Desde entonces se ha buscando la manera de poder diseñar los materiales átomo a átomo. De hecho, los materiales nanoestructurados ya han sido utilizados en aplicaciones prácticas, siendo importantes en nuestra vida diaria. El color rojo de los vitrales en las catedrales góticas de Europa se obtenía utilizando nanopartículas de oro; la película fotográfica utiliza nanopartículas de plata; los bloqueadores solares utilizan nanopartículas de dióxido de titanio y de zinc como parte activa. El primer caso es una aplicación del efecto nano del oro y es quizás la primera aplicación de la nanotecnología. Quizás el mayor desarrollo de las nanoestructuras se dio con el descubrimiento de la microscopia de fuerza atómica ya que con esta se podía manipular a los átomos o partículas muy pequeñas. Hoy día, la investigación en el campo de los materiales nanoestructurados se ha multiplicado y sus aplicaciones abarcan todas las disciplinas convirtiendo a la nanotecnología en un campo interdisciplinario. Muchos países han implementado programas especiales para la investigación en este campo invirtiendo grandes cantidades de dinero. La apuesta puede ser de alto riesgo, pero el premio promete ser enorme.

Richard Feynman

Hoy día se estima el mercado de la nanotecnología en cientos de miles de millones de dólares. Nuestro país también ha apoyado la iniciativa aunque en menor proporción. De hecho la nanotecnología no es una prioridad dentro de nuestro sistema de investigación, no hay programas especiales de apoyo económico en este tópico y se compite por igual con todas las áreas. Con pocos recursos económicos se poca infraestructura y en general grupos pequeños lo que dificulta la capacidad para competir. Aún con estas limitaciones, se han obtenido excelentes resultados y hay grupos en nuestro país que cuentan con reconocimiento internacional.

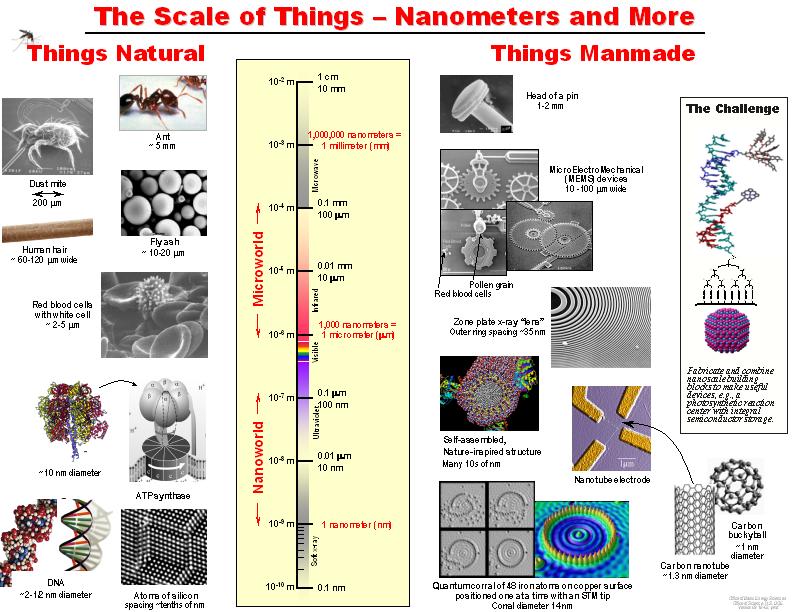

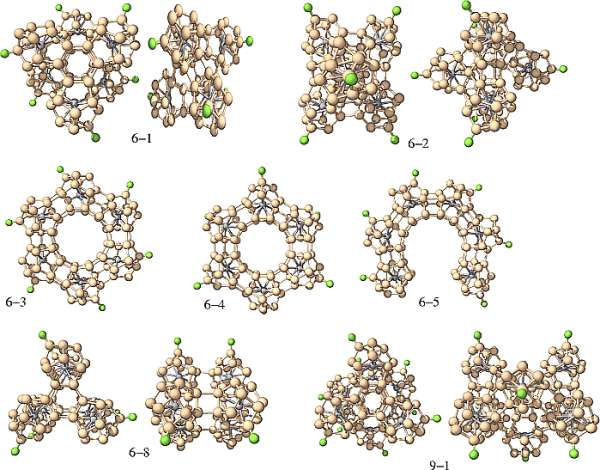

Materiales nanoestructurados y nanotecnología

Los materiales nanoestructurados (NEMs, por siglas en inglés) han despertado rápidamente un gran interés debido a la diversidad de sus aplicaciones. De acuerdo a la definición más aceptada, los materiales nanoestructurados son aquellos en los que por lo una de sus dimensiones se encuentra en el rango de 1-100 nm. Es decir, los NEMs son tres órdenes de magnitud más pequeños que los MEMS (sistemas microelectromecánicos, por sus siglas en inglés), e incluyen nanopartículas, nanocristales, nanoalambres, nanobarras, nanotubos, nanofibras, nanoespumas, etc. Los NEMs pueden ser semiconductores, dieléctricos, metales, orgánicos, inorgánicos, aleaciones, biomateriales, biomoléculas, oligómeros, polímeros, etc.

Nos sorprendería saber en qué lugares están presentes los cristales fotónicos con las nuevas técnicas alcanzadas en la nanotecnología

Aunque existen sistemas nanoestructurados de dimensiones mayores son los cristales fotónicos. En el rango de nanómetros, los materiales presentan propiedades ópticas, eléctricas, magnéticas y mecánicas únicas y totalmente diferentes de los materiales en el rango de los micrómetros o milímetros llamados materiales en bulto.

tener una idea de que tan pequeño es un nanómetro podemos mencionar que un milímetro tiene un millón de nanómetros; el diámetro del cabello humano mide 10,000 y 50,000 nanómetros; los glóbulos rojos y blancos miden 2 y 5 nanómetros mientras que el ADN mide 2.5 nanómetros.

Los superátomos de silicio pueden formar, por ejemplo, nanotubos. Además, se les agregar un metal de transición con el objetivo de cambiar sus propiedades eléctricas, lo que se denomina dopaje. el superátomo es de anión ( carga eléctrica negativa, le sobran electrones), “se le dopa con un metal alcalino, el potasio”, que tiene un electrón en su nivel energético más externo. Del mismo modo, cuando son cationes (con carga negativa, al perder electrones) se les dopa con un metal halógeno, que necesita un electrón más completar su último nivel energético.

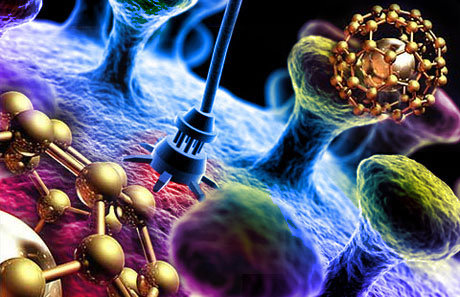

Las propiedades de los NEMs son dominadas por los efectos de superficie mientras que las de los materiales en bulto son debidas a un efecto de volumen. La tecnología su producción y uso se ha convirtiendo en una industria muy poderosa: la nanotecnología. La nanotecnología es la ciencia e ingeniería de producir materiales o estructuras funcionales de cuantos nanómetros. Es la tecnología del futuro con la cual se desarrollarán los nuevos materiales y dispositivos. Las aplicaciones son sorprendentes así como variadas, por ejemplo, la industria optoelectrónica y fotónica, biomedicina, sensores, celdas solares y de combustible, catálisis, memorias ópticas, procesadores de computadoras, fotodetectores, herramientas de corte, industria aeronáutica, moduladores e interruptores, cosméticos, etc. Aunque todas las aplicaciones son de gran interés, sin duda alguna las aplicaciones en sistemas biológicos son las más sobresalientes. Especialmente las aplicaciones de las propiedades ópticas de los sistemas nanoestructurados.

La Tecnología fundamental del siglo XXI: Nano Tecnología

Uno de sus apartados es la Nanofotónica

Esas nuevas formas, la nanotecnología, entrará en el “universo” de la mecánica cuántica, en el mundo infinitesimal, y, se lograrán cosas que , serían impensables. Posiblemente, la primera visita que hagamos a un mundo habitado por otros seres, estará tripulada por seres nanotecnológicos que, al igual que la misma nave, tengan medidas tan pequeñas que serán imposibles de observar y, sin embargo, estarán dotadas de adelantos tales que, podrán medir, evaluar, estudiar, captar imágenes, enviar por medios desconocidos, y, en fin, serán las avanzadillas de lo que irá después, la visita de humanos a otros mundos.

La nanofotónica es la fusión de la nanotecnología y la fotónica. Es un campo multidisciplinario que estudia las propiedades ópticas de los sistemas nanoestructurados y la interacción luz-materia a nivel nanoscópico. Ya mencionamos que las propiedades ópticas de las nanopartículas son dominadas por los efectos de superficie. Así, controlando el tamaño de las nanopartículas o nanoestructuras podemos controlar o amplificar ciertas propiedades de los sistemas bajo estudio. En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas.

La Nanotecnología marcará nuestro futuro. De ella partirán las nuevas ideas e instrumentos, los nuevos modos de construir lo que queda por venir, nuevas maneras de sondear el espacio “infinito”, de curar enfermedades, de sustituir órganos vitales, de construir robots.

Curiosamente, existe una creencia bastante arraigada en amplios sectores de la comunidad científica de que la fotónica (conjunto de tecnologías relacionadas con la luz) es un campo que cae fuera del universo de la nanotecnología. La creencia se apoya en el clásico criterio de Rayleigh de que la resolución espacial de un sistema óptico está limitada por la longitud de onda de la luz (≈ 500 nm), y por ello es próxima al micrómetro, muy lejos de los requisitos de la nanotecnología.

Yo, por mi , estimo que división es sin duda errónea, y hoy en día la fotónica está íntimamente implicada con la nanotecnología, e incluso se hablar propiamente de nanofotónica, de igual manera que se hablar de nanoelectrónica o de nanomagnetismo.

Sepamos conectar de manera conveniente todas las disciplinas del sabe Humano… ¡Las cosas cambiaran!

Decía que: “En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas”. una de ellas produce fenómenos de especial interés interactúan con una señal óptica, pudiendo así ser aplicadas en diferentes campos. Un campo de especial interés es la biología.

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bio-nanofotónica. Especialmente trata sobre el estudio de sistemas nanoestructurados en aplicaciones biomédicas. Diferentes nanopartículas han sido propuestas ser utilizadas en la detección de bajas concentraciones de diferentes elementos como células cancerígenas, virus, ADN, ARN, proteínas, etc. También han sido utilizadas para la entrega de medicamentos en dirigida y controlada así como para la destrucción de tumores cancerígenos. En la última década, los avances han sido sorprendentes pero aún hay mucho por . En el CIO, durante los últimos 6 años hemos trabajando en la síntesis de nanopartículas y estudiado sus propiedades ópticas a fin de poder ser utilizadas en distintas aplicaciones.

Las propiedades luminiscentes de nuestras nanopartículas son muy interesantes y prometen grandes oportunidades de aplicación en diferentes áreas.

Nanopartículas semiconductoras o puntos cuánticos. Grafeno luminiscente

Los nanocristales semiconductores llamados puntos cuánticos son nanoestructuras a base de materiales semiconductores inorgánicos y representan el grupo donde el efecto del tamaño es más evidente. El tamaño nano da lugar a lo que se conoce confinamiento cuántico, que no es más que la localización de los electrones en un espacio definido, es poner un electrón en una caja. Mientras que tamaños mayores los electrones están no localizados. El confinamiento produce un ensanchamiento de la banda de energía prohibida del semiconductor así la aparición de sub-bandas discretas en la banda de valencia y de conducción. Las dimensiones típicas oscilan uno y diez nanómetros.

Con frecuencia se les describe átomos artificiales debido a que los electrones están dimensionalmente confinados como en un átomo y sólo se tiene niveles de energía discretos. las nanoestructuras más estudiadas se encuentran las de CdSe/ZnS, CdSe/CdS, InP/ZnSe, CdTe/CdSe, entre otras. El resultado más vistoso de estas nanoestructuras es la capacidad poder sintonizar la longitud de onda o color de la emisión.

Así, con un solo material y variando el tamaño de la nanopartícula es posible obtener múltiples colores o longitudes de onda de la señal emitida. Las aplicaciones son impresionantes y apuntan en todas las direcciones. Por ejemplo, podrían ser utilizados como colorantes inorgánicos sin problemas de degradación a diferencia de los colorantes orgánicos. También podrían ser utilizados en el diseño de los nuevos amplificadores ópticos de amplio ancho de banda tan importantes en los sistemas de comunicación óptica; en caso nanopartícula con un diámetro determinado funcionaría como un amplificador, así el ancho de banda se determina con la selección adecuada de los diámetros de las partículas. O bien la producción de fuentes de luz blanca mediante excitación con un LED u OLED o por electroluminiscencia.

Quizás una de las aplicaciones que mayor atención ha recibido es en su uso como etiquetas fluorescentes con emisión en la región visible del espectro, la detección de una gran variedad de compuestos entre ellas células cancerigenas. Las técnicas actuales no detectan bajas concentraciones de células cancerigenas o compuestos de interés, por lo que la técnica de detección de fluorescencia de nanopartículas es una gran promesa para la detección temprana de este mal, para así incrementar el éxito en el tratamiento. Dado el tamaño tan pequeño de los puntos cuánticos actualmente se intenta desarrollar nanoestructuras más complejas formadas por puntos cuánticos o nanocristales acomplejados con diferentes componentes que desempeñan distintas funciones, detección, entrega de medicamento dirigido, efecto de la terapia, etc. Es decir, se busca una nanoestructura inteligente con múltiples funciones. El problema que presentan los puntos cuánticos es que son poco estables ya que tienden a aglomerarse, además de que se excitan con una fuente de luz UV donde la mayoría de los compuestos que se pueden encontrar en interior del cuerpo humano emiten luz lo que significa pérdida de contraste en la imagen de la célula deseada.

Nanopartículas dieléctricas o nanocristales

Los nanocristales dieléctricos son óxidos que presentan una banda de energía prohibida muy ancha y consecuencia requieren altas energías de bombeo o luz en el UV obtener emisión que en general es débil, aunque se combina con adecuados y diversos componentes son excelentes emisores de luz debido a su eficiencia y alta estabilidad. Son excelentes matrices soportar iones de tierras raras que son muy buenos emisores de luz. En caso no se observan efectos de confinamiento debido a que los electrones se encuentran localizados en orbitales atómicos del ion activo. Sin embargo, la dinámica de los iones emisores de luz se ve afectada por la interacción a nivel nanoscópico lo que producir una mejora en la eficiencia de emisión.

los nanocristales mas estudiados se encuentran algunos silicatos Y2SiO5, la combinación nY2O3 + mAl2O3 que comprende puramente el óxido de itria, puramente el óxido de aluminio, se combinan con n=3 y m=5 da lugar a la estructura cristalina mas utilizada en óptica producir láseres conocida como YAG, o YAP la combinación n=m=1 que corresponde a uno de los cristales mas sensibles a la radiación ionizante y que es utilizado la detección de rayos X o rayos gama. El óxido de titanio (TiO2) y el óxido de zinc (ZnO) que se utilizan en los bloqueadores solares además de ser excelentes para los procesos de fotocatálisis, útiles en la reducción de contaminantes, para celdas solares y como bactericida.

Recientemente, hemos demostrado que el óxido de zirconio (ZrO2) combinado con otros elementos bloquea el rango completo de la luz ultravioleta, especialmente aquella región que produce el . mismo nanocristal presenta excelente respuesta en la detección de radiación ionizante, UV, rayos X, gama, beta y alfa, tanto en tiempo real como en acumulada lo que sugiere buenas oportunidades para su uso en el diseño de dosímetros para la cuantificación de dosis recibidas.

Además, es excelente soporte para iones de tierras raras, con las cuales hemos obtenido luz visible (azul, verde y rojo) excitando con una fuente en el cercano infrarrojo. Ya que con fuente se excitan los nanocristales no hay emisión de fondo lo que mejora el contraste de las imágenes obtenidas. Estas características convierten a estos nanocristales en excelentes candidatos en aplicaciones biomédicas para la detección de diversos elementos a concentraciones bajas. La fabricación de estos nanocristales implica un tratamiento térmico para el proceso de oxidación lo que induce un tamaño de partícula grande. Se han reportado tamaños de partícula 10 a 90 nm.

Lo curioso es que en todo, siempre está la Luz presente

Muchas veces se obtienen cristales muy pequeños con poca eficiencia de emisión, el reto es obtener mayor eficiencia de emisión sin incrementar demasiado el diámetro de las nanopartículas. Tamaños promedios con los que se han obtenido excelente eficiencia de emisión son 40 y 60 nm.

Nano partículas metálicas, plasmones.

Las nanopartículas metálicas tienen la habilidad de esparcir y absorber la luz incidente. En caso, los efectos en las propiedades ópticas respecto a su contraparte en bulto se derivan de los efectos electrodinámicos y de la modificación del ambiente dieléctrico. A escala nanométrica la frontera metaldieléctrico produce cambios considerables en las propiedades ópticas.

resultado de la interacción la nanopartícula metálica y la señal óptica se obtiene la oscilación colectiva de electrones de superficie lo que genera bandas de resonancia conocidas plasmones localizados o plasmones de superficie localizados. La longitud de onda o color a la que se obtiene dicha resonancia se le conoce como banda de absorción del plasmón que depende tanto del tamaño como de la de la nanopartícula y es lo que da lugar a la diferente coloración observada. Las nanoestructuras metálicas más conocidas son partículas esféricas, barras y películas con núcleo dieléctrico. Aunque más recientemente se han reportado otras estructuras como cubos, triángulos, estrellas y ovoides. En todos los casos, la banda de resonancia se recorre hacia el cercano infrarrojo en comparación con las nanopartículas esféricas cuya banda centrada en la región verde del espectro.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta el monitoreo óptico y la formación de imágenes ópticas

localizadas. Una de las aplicaciones establecidas es de superficie mejorada (SERS por sus siglas en inglés). En caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo 11 000 veces más las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

Células modificadas por la nanofotónica

Quizás un proyecto más ambicioso es el de poder detectar células cancerígenas a temprana edad de lo cual ya se han reportado importantes avances. En el CIO trabajamos con nanopartículas de oro y plata a fin de desarrollar sensores ópticos la detección de diferentes compuestos a nivel de trazas y estamos aplicado exitosamente nanopartículas de oro en la detección de células cancerígenas.

En resumen, las nanoestructuras presentan propiedades ópticas únicas que no presentan su contraparte en bulto o de escala mayor. Éstas están siendo utilizadas el desarrollo de la nueva generación de dispositivos optoelectrónicos y/o fotónicos. Las aplicaciones son muy variadas y abarcan muchos campos haciendo de la nanociencia y nanotecnología una área

multidisciplinaria. Especial atención recibe el uso de dichas propiedades en aplicaciones biomédicas para la detección a nivel de trazas de diversos agentes patógenos. El estudio de las propiedades ópticas de las nanoestructuras ha definido una nueva área conocida como nanofotónica.

¡Eso que llamamos futuro… ya está aquí!

emilio silvera

Nov

1

¡Nuestro cerebro! Un gran misterio

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El cerebro ~

Clasificado en El cerebro ~

Comments (11)

Comments (11)

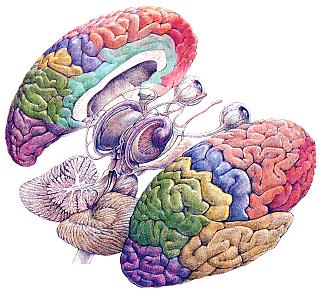

Aunque es mucho lo que hemos conseguido conocer de nuestro cerebro y su funcionamiento, mucho más es lo que nos queda por conocer. Ahí, en todo ese conglomerado de complejas estructuras que juntas, forman un todo, es de donde surge la Conciencia y, para poder entender como ocurre tal maravilla, debemos antes y es preciso que entendamos primero como funciona el cerebro: su arquitectura, su desarrollo y sus funciones dinámicas, su organización anatómica y la increíble dinámica que llega a generar. Todo ella nos llevará a tener una idea del por qué , a partir de está increíble “maquina de la naturaleza” surgir la conciencia.

Lo hemos comentado aquí en muchas ocasiones. El cerebro se entre los objetos más complicados del Universo y es, sin duda, una de las estructuras más notables que haya podido producir la evoluciòn y, si pensamos que toda esa inmensa complejidad ha tenido su origen en los materiales creados en las estrellas, no tendremos otra opción que la del asombro. ¿A partir de la materia “inerte” llegaron los pensamientos?

Antes incluso del advenimiento de la moderna neurociencia, se sabía ya que el cerebro era necesario la percepción, los sentimientos y los pensamientos. Lo que no está tan claro es por qué la conciencia se encuentra causalmente asociada a ciertos procesos cerebrales pero no a otros.

La “máquina” más compleja del Universo, creadora de pensamientos y.. sentimientos

En tanto que objeto y sistema, el cerebro humano es especial: su conectividad, su dinámica, su de funcionamiento, su relación con el cuerpo al que ordena qué funciones debe desarrollar en cada momento dependiendo de tal o cual situación dada y también su relación con el mundo exterior a él que, por medio de los sentidos, le hace llegar información de todo lo que ocurre para que pueda ado0ptar en cada momento, las medidas más adecuadas. Su carácter único hace que ofrecer una imagen fidedigna del cerebro, que pueda expresar todo lo que es, se convierta en un reto extraordinario que, en este momento, la ciencia no puede cumplir. Sin embargo, sí que puede, al menos, dar alguna que otra pista de lo que el cerebro y la conciencia puedan llegar a ser y aunque, aún lejos de una imagen completa, sí se puede dar una imagen parcial que siempre será mejor que nada, especialmente si nos da la suficiente información como para tener, una idea aproximada, de lo que el cerebro y la conciencia que surge de él, pueden llegar a ser.

Universo y Red neuronal ¿dónde está lña diferencia? en ninguna parte, ya que, a menor escala, nosotros también somos universo.

Es como una inmensa galaxia en sí mismo, el cerebro humano es una obra notable de la Naturaleza y se calcula que en su interior, cien mil millones de neuronas hacen posible una maravilla que aún, la Ciencia no llegado a comprender. El diez por ciento de esas neuronas son células piramidales que generan una red muy compleja (intercambio e interacciones ellas, lo que se conoce como diálogo neuronales) y llegan a construir mil millones de millones de de conexiones sinápticas que logran que nosotros, los poseedores de tal maravilla, estemos logrando comprender, a medida que esa “máquina” evoluciona, lo que el Universo es.

Si nos paramos a pensar en el hecho cierto de que, el cerebro humano adulto, con poco más de un kilo de peso, contiene unos cien mil millones de células nerviosas o neuronas, La capa ondulada más exterior o corteza cerebral, que es la del cerebro de evolución más reciente, contiene alrededor de 30 mil millones de neuronas y más de un billón de conexiones o sinapsis. Si contáramos una Sinapsis cada segundo, tardaríamos 32 millones de años en completar el recuento. Si consideramos el posible de circuitos neuronales, nos encontramos con cifras hiper-astronómicas: 10 seguido de un millón de ceros. No existe en el Universo ninguna otra cosa de la que pueda resultar una cantidad igual. Incluso el número de partículas del universo conocido es de 10 seguido de tan sólo 79 ceros. En comparación con el número de circuitos neuronales…¡No es nada!

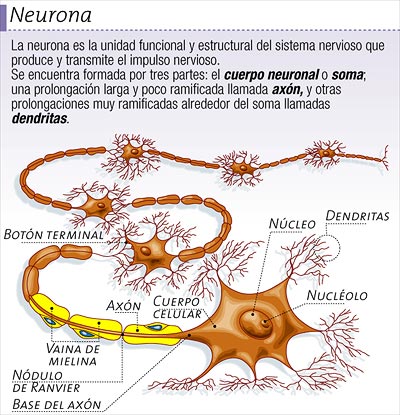

Las neuronas de las que existen una gran variedad de formas, poseen unas proyecciones arborescentes llamadas dendritas mediante las cuales realizan las conexiones sinápticas. posee así mismo una proyección única más larga, el axón, que establece conexiones sinápticas con las dendritas o directamente con el cuerpo celular de otras neuronas. Nadie ha contado con precisión los diferentes tipos de neuronas del cerebro, una estima groso modo de unos cincuenta tipos seguramente no sería excesiva. La longitud y patrones de ramificación de las dendritas y el axón de un tipo determinado de neurona caen dentro de un rango de variación determinado, pero incluso dentro de un mismo tipo, no existen dos células iguales.

Cada una de las neuronas tiene un cuerpo celular. Del cuerpo de la célula se proyectan unas largas fibras en de raíz. Como hemos dicho, hay dos tipos de fibra: axones y dendritas. Cada neurona tiene un axón largo que envía impulsos eléctricos a otras neuronas. Cada neurona tiene un variable de dendritas las cuales tienen muchas ramas. El axón de una neurona se conecta a las dendritas de otras neuronas. El punto en el que conectan se llama sinapsis (vamos a explorarla más adelante). Las dendritas recogen la información la célula y los axones envían la información a otras células.

Todo entramado tiene mucho que ver con los pensamientos. Aquí se fraguan los procesos del pensamiento. Al aprender, tener una idea, recordar algo, sentirse activado sexualmente, comunicar, etc. las neuronas están recibiendo y transmitiendo información a través del cerebro. Las células del cerebro se comunican sí a través de un proceso electroquímico. Cada vez que pensamos, aprendemos y nos comunicamos, una neurona envía un impulso nervioso por su axón. El axón de una célula cerebral hace varios miles de conexiones con muchos miles de otras células cerebrales. El punto donde una neurona se conecta a otra se llama sinapsis. Cuando un impulso nervioso (mensaje bioquímico electro-magnético) surge por el axón, es disparado a través del espacio sináptico a través de un mensajero químico, llamado neurotransmisor, hacia la dendrita de la neurona receptora.

El impulso nervioso viaja a lo largo del axón de la célula del cerebro, a través del espacio sináptico a otra célula del cerebro y así sucesivamente. Cuando una neurona se activa a otra de manera, es como si un interruptor se encendiera. Las neuronas se encienden, como una línea de fichas de dominó cayendo. Esta actividad es el proceso que crea el camino del pensamiento complejo, llamado también trazas de la memoria o caminos neuronales.

En una inmensa nebulosa en la que se encienden aquí y allí el resplandor de las estrellas

Una característica clave de los patrones neuronales que se puede observar al es su densidad y extensión y se vislumbran los puntos luminosos donde fotones energéticos sirven de con electrones transmitir los impulsos eléctricos necesarios que transportan la información. El cuerpo de una neurona mide cincuenta micrones (milésimas de milímetro) de diámetro, si bien la longitud del axón puede variar entre unos micrones y más de un metro, En un tejido como la corteza cerebral, las neuronas se encuentran en paquetadas con una enorme densidad; si todas se tiñeran con la plata utilizada en la llamada tinción de Golgi, que se utiliza para verlas al microscopio, la sección microscópica teñida sería completamente negra.

Otra de las características primordiales es el extraordinario aporte sanguíneo que sustenta a esta jungla. A través de grandes arterias que alimentan una extensa red de capilares, el cerebro recibe una gran cantidad de oxígeno y la glucosa que precisa para ser el órgano metabólicamente más activo del cuerpo. La regulación del flujo sanguíneo es de una exquisita perfección incluso hasta el nivel de las neuronas individuales, dado que la actividad sináptica depende fuertemente del aporte sanguíneo y de la oxigenación.

Entrando de lleno en toda complejidad que aún, no hemos podido llegar a desvelar en toda su inmensidad y sólo conocemos pequeñas parcelas de su estructura y funcionamiento, podemos tener una idea (más o menos) acertada de lo mucho que nos queda por aprender de nosotros mismos, de nuestro cerebro y de nuestro centro neurálgico dónde se fabrican los pensamientos, surgen los sentimientos, se delata el dolor y la tristeza y, en fín, podríamos decir sin el menor temor a equivocarnos que, aquí, en este complejo entramado que llamamos cerebro, en el que reside la conciencia y de donde surge la mente, está todo lo importante que nos hace diferentes a otros seres que, con nosotros comparten el mismo planeta. Gracias a ésta compleja “maquina” creada por la Naturaleza, podemos ser conscientes y “saber” del mundo, de nosotros, del universo en toda su magnitud y esplendor.

No pocas veces hemos podido oir: “El cerebro es como una gran computadora”. Lo cierto es que, no es verdad, nuestro cerebro, nuestra mente, es mucho más que ese algo artificial creado por el hombre y que, simplemente, trata de “imitar” de manera grosera, lo que el cerebro es. ¿Cómo una máquina generar sentimientos? Y, ¿Cómo puede pensar? Bueno, la inteligencia del ser humano (precisamente basada en este maravilloso cerebro del que hablamos), podrá crear sistemas que imiten y pretendan recrear lo que es un cerebro pero, al final del camino, será otra cosa muy diferente. No digo si mejor o peor, pero distinta.

Hemos examinado la escasa bibliografía fisiológica existente que no es mucha más que la que había en la època de William James, por ejemplo, y hay que concluir diciendo que no existen pruebas suficientes para poder limitar los correlatos neuronales de la conciencia al menos del cerebro completo. Eso sí, se ha podido descubrir que sólo una porción determinada de la actividad neuronal del cerebro, contribuye de directa a la conciencia -asó se ha podido determinar de complejos y profundos experimentos con estimulación y lesiones -o está relacionada de forma directa con aspectos de la experiencia consciente- como indican los estudios de registros de actividad neuronal. ¿Quiere esto decir que, en realidad, todavía sólo utilizamos una mínima parte del cerebro? No lo sabemos con certeza.

Decir, a ciencia cierta, como surgen los pensamientos…¡No podemos! muchas son las hipótesis y teorías que al respecto circulan y que están directamente vinculadas a la experiencia, al mundo que nos rodea yb a la informaciòn que el cerebro recibe de sus ayudantes, los sentidos. Todo lo que el cerebro, de una u otra manera recibe, es debidamente archivado en su compartimento especial y, ahí se queda para cuando, habiendo surgido una situación que lo requiera, sacarlo a la superficie en forma de pensamiento actuante que, nos sirve para dar solución a estae o aquel problema que se nos pueda plantear. El cerebro, escoge en fracciones de segundo, una de las miles de posibles soluciones que se puedan aplicar a un específico problema, y, siempre, elige (como lo hace la naturaleza) el que mejor pueda dar cumplida del problema.

Los procesos que realiza nuestro cerebro, son infinitamente superiores a los que realiza una computadora. Aunque, al igual que ésta, nuestro cerebro requiere de “programas”, sin los cuales sería imposible generar respuestas exitosas, ante los sucesos a los que estamos expuestos día.

Tenemos un programa para cada una de las cosas que hacemos a diario, que nos levantamos por la mañana hasta que nos acostamos por la noche. Incluso más allá de estas cosas que hacemos de manera parcialmente consciente, tenemos un programa para cada una de las actividades que nuestro cuerpo ejecuta de manera totalmente inconsciente. Entre estas, se encuentra la respiración, el latir del corazón, la circulación de la sangre, la división celular, la digestión, nuestra respuesta ante el peligro y el combate de los agentes infecciosos, por mencionar algunas; todas ellas, bajo el control de estructuras profundas de nuestro cerebro.

Requerimos programas para todo, incluso para cosas aparentemente tan sencillas como atarnos el cordón de los zapatos, la cual sin embargo, para alguien no familiarizado con esto, como un niño pequeño, resultaría una tarea casi imposible. En actividades más complejas, como fabricar un teléfono celular, conducir un auto o pilotear un avión, es muy evidente que se requiere contar con el programa adecuado, para el éxito en dichas actividades.

Claro que, nuestro cerebro es capaz de muchas más cosas que nunca podrá llevar a cabo ninguna computadora que, al fin y al cabo, siempre hará aquello lo que la tengamos programada. Nunca una computadora (al menos eso creo en mi ignorancia), podrá de manera individual e independiente, generar ideas nuevas y originales que vayan encaminadas a desvelar como funciona este o aquel misterio de la naturaleza como, por ejemplo, hacen a diario los físicos del mundo.

Por extrañas razones y aunque es evidente que nuestro cerebro es mucho más importante que una computadora, cuando de asegurar su correcto funcionamiento se trata, seguimos muy pocas o ninguna recomendación para su cuidado. En principio, recibimos información o “programas” de todo a través de familiares, amigos, maestros, estudios, experiencias, observación del mundo que nos rodea, medios de comunicación o cualquier persona con la que interaccionamos.Y, de esa manera, evolucionamos y seguimos nuestro camino hacia un destino que no conocemos.

A veces nos podemos preguntar qué hacemos nosotros ante tanta inmensidad, qué significado tiene nuestra presencia en un Universo inmenso que tratamos de comprender.

Las ideas nacen como estrellas en una inmensa nebulosa

A todo esto, tenemos que convenir en un hecho cierto: ¡La energía del Universo está en nosotros! Se nos da un tiempo (si no surgen problemas) que podamos desplegar la parte alicuota de intelecto que nos tocó en “suerte”, por “azar”, “genética” o vaya usted a saber el motivo de que, algunos tengan dotes superiores a las que otros tenemos y puedan “ver” con más facilidad la naturaleza de la Naturaleza. Creo que, todos los misterios del Universo, residen en nuestras mentes en las que, se encuentran todas las respuestas que podremos encontrar con el Tiempo. Precisamente por eso, se nos ha otorgado el don de poder luchar contra la entropía y, junto con las galaxias espirales, podemos generar entropía negativa que impide el deterioro ininterrumpido del “mundo”. ¿Estaremos llamados a más grandes proyectos?

emilio silvera

Totales: 75.611.509

Totales: 75.611.509 Conectados: 3

Conectados: 3

![inteligencia-artificial[1] cerebro y computadora](http://poderpersonalmexico.com/blog/wp-content/uploads/2011/12/inteligencia-artificial1.jpg)