Feb

25

La Física de Partículas al Servicio de la Salud

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Las nuevas tecnologías ~

Clasificado en Las nuevas tecnologías ~

Comments (0)

Comments (0)

En realidad, en el CERN, se trabaja en algo más que en las partículas subatómicas y se buscan nuevas respuestas y remedios para paliar el dolor en el mundo. También, se ha contribuido de manera notable a las comunicaciones y, el mundo es tal como lo conocemos hoy gracias a Ingenios como el LHC que, por desconocimiento de muchos, en su mpomento, fue tan denostado.

Transferencias tecnológicas del CERN a la Biomedicina.

Partículas y mucho más

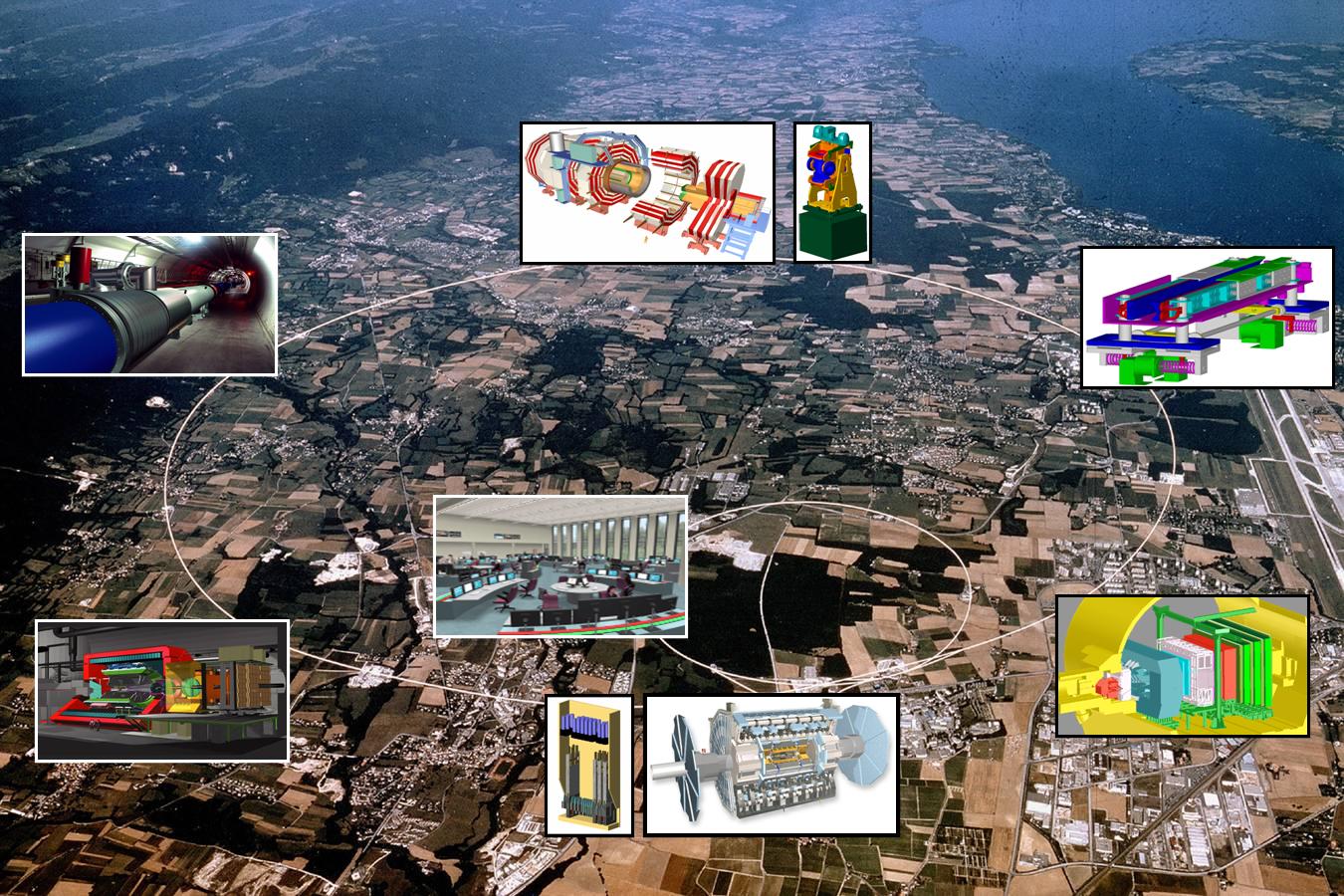

Seguramente la mayoría de los lectores de la Revista Española de Física han oído más de una vez hablar del CERN. Fundado en 1954, constituye el mayor laboratorio de física de partículas del mundo, con veinte países miembros y un personal de unas 3.000 personas entre físicos, ingenieros y personal técnico y administrativo de todo tipo. Seguramente están también al tanto de los grandes experimentos que se están preparando en este centro como el Large Hadron Collider (LHC), situado en un túnel circular de 27 km de longitud, destinado a elucidar el origen de la llamada ruptura de la simetría electrodébil y en última instancia el origen de las masas de las partículas elementales (no de la masa del protón o del neutrón como erróneamente se dice a veces en los medios de comunicación), o del proyecto CERN Neutrino Gran Sasso (CNGS), que consiste en enviar un haz de neutrinos de alta energía desde el CERN al laboratorio subterráneo italiano del Gran Sasso que se encuentra a 730 km, para estudiar las oscilaciones de estas huidizas partículas.

También es muy probable que muchos lectores asocien de manera natural la palabra acelerador de partículas a los instrumentos que utilizan los físicos modernos para estudiar y comprender mejor la estructura y el comportamiento de la materia a pequeñas escalas. Sin embargo, de los 17.000 aceleradores de partículas que se estima existen en la actualidad en todo el mundo, aproximadamente la mitad de ellos se usan en medicina y sólo una parte muy pequeña se usan para investigación fundamental. Por este y otros motivos que se discutirán más adelante, en este número especial de la Revista Española de Física dedicado a la física y las ciencias de la vida, ha parecido conveniente incluir un artículo en el que, al menos brevemente, se describieran algunas de las transferencias tecnológicas (spinoffs) importantes que la actividad del CERN aporta a dichas ciencias.

Mucho de lo que aquí se descubre, se aplica a nuestra Salud

Es bastante razonable que, como ocurre con las ciencias del espacio, mucha gente se pregunte cuál es la utilidad social de la física de partículas más allá de la adquisición de conocimientos fundamentales de la naturaleza. Sin embargo, es preciso señalar que los aceleradores y detectores de partículas del CERN y otros laboratorios similares requieren el uso, y muchas veces el desarrollo, de tecnologías de punta que obligan a una estrecha colaboración con la industria que redunda en beneficio de ambas partes. Las transferencias tecnológicas que se producen en este proceso se incorporan inmediatamente a nuestra vida diaria en áreas tales como la electrónica, procesamiento industrial y médico de imágenes, manejo y usos de la radiación , metrología, nuevos materiales, tecnologías de la computación y la información, tratamiento del cáncer, etc. En este artículo se pondrá el énfasis en aquellas actividades del CERN que han redundado de una forma más clara en beneficio de las ciencias biomédicas.

PET/TC o más allá de los rayos X

En el ámbito de la medicina los aceleradores de partículas se utilizan con dos finalidades; una para la formación de imágenes con propósitos diagnósticos y otra, para terapia, principalmente oncológica. Desde el descubrimiento de los rayos X por Röntgen en 1895, este tipo de radiación electromagnética ha proporcionado una información de valor incalculable y aún sigue proporcionándola. Sin embargo, mucho más recientemente, se han desarrollado otras técnicas complementarias de diagnóstico basadas en los llamados radiofármacos. Estas sustancias radiactivas presentan idealmente la propiedad de poder ser inyectadas en el organismo humano de forma segura y de fijarse exclusivamente a determinados tejidos. Posteriormente, a medida que van desintegrándose, emiten ciertas partículas que pueden ser detectadas y analizadas produciendo de esta forma imágenes estáticas o incluso dinámicas de los órganos en los que se depositaron los radiofármacos y, en definitiva, proporcionando información no solamente sobre la morfología de aquellos, sino también, en muchos casos, sobre su función y metabolismo.Los radiofármacos se producen utilizando haces de protones de alta intensidad y, como tienen una vida media muy baja, deben utilizarse cerca de donde se han creado. Se calcula que unos 20 millones de personas son diagnosticadas cada año mediante el uso de este tipo de sustancias.

Son técnicas no invasivas que dejan al descubierto lo que interesa ver y eliminar.

Una de las técnicas de este tipo más utilizada en la actualidad es la Positron Emission Tomography (PET). En su aplicación se utiliza normalmente un ciclotrón para irradiar alguna sustancia que se convierte en radiactiva por desintegración beta positiva (emisora de positrones). Esta sustancia se une por ejemplo a la glucosa y se inyecta al paciente. Los positrones producidos se aniquilan con los electrones circundantes dando lugar a dos fotones de energía muy bien definida, emitidos en direcciones opuestas. Estos fotones interaccionan con un material escintilador dando lugar a la emisión de otros fotones que pueden ser detectados por fotomultiplicadores o fotodiodos para formar la imagen de los tejidos que se pretenden estudiar en función de la distribución de la glucosa radiactiva. Por ejemplo, en el caso del diagnóstico del cáncer las células cancerosas suelen consumir más glucosa que las células sanas debido a su mayor vascularización y a su mayor actividad metabólica y reproductiva, produciendo por tanto una mayor emisión de fotones. Por el contrario, las zonas donde el tejido presente mayor número de células muertas brillarán menos debido a la menor concentración de glucosa radioactiva, lo cual puede ser muy útil para el diagnóstico de infartos y otras lesiones.

Tecnológias que llegan más allá

De acuerdo con David Townsend, uno de los pioneros en el desarrollo de la tecnología PET, aunque ésta no fue inventada en el CERN, una cantidad esencial e inicial de trabajo desarrollado en el CERN a partir de 1977 contribuyó de forma significativa al desarrollo del PET 3D. La tecnología PET alcanza su grado más alto de utilidad diagnóstica cuando se combina con la Computed Tomography (CT). La CT es un método de formación de imágenes tridimensionales a partir del procesamiento digital de un gran número de imágenes bidimensionales de rayos X. Inicialmente, las diferentes imágenes se obtenían alrededor de un solo eje de rotación y de ahí su nombre original de Computed Axial Tomography (CAT).

La técnica combinada PET/CT es uno de los desarrollos más excitantes de la medicina nuclear y la radiología modernas. Las reconstrucciones de imágenes CT permiten el diagnóstico precoz de tumores basándose en sus características morfológicas, mientras que la tecnología PET es capaz de diferenciar con grane eficiencia los tejidos malignos de los benignos. La fusión PET/CT permite ahora integrar las imágenes morfológica y fisiológica en una única imagen. El prototipo del scanner ART, el Partial Ring Tomograph (PRT), fue desarrollado en el CERN en 1980 y 1990 por David Townsend, Martín Wensveen y Henri Tochon-Danguy, y evaluado clínicamente en el departamento de medicina nuclear del Hospital Cantonal de Ginebra. ART puede considerarse como el precursor de la parte PET del moderno scanner PET/CT, que ha producido un impacto extraordinario en la tecnología de imágenes con fines médicos. Además, el CERN continua hoy en día contribuyendo a este campo fundamental de la medicina moderna mediante proyectos como Clear PET, Clear PEM, HPD PET etc.

Sin embargo, la importancia del CERN en el desarrollo de las tecnologías PET o CT, y en general de todo tipo de scanner, va mucho más allá. En efecto, todo este tipo de dispositivos se basa, de una forma u otra, en los detectores desarrollados a finales de los sesenta en el CERN por George Charpak. Su trabajo fue reconocido en 1992 con la concesión del Premio Nobel de Física por su invención y desarrollo de detectores de partículas, en particular de la cámara proporcional multihilos, que produjo una revolución en la técnica de exploración de las partes más íntimas de la materia. Los detectores desarrollados por Charpak se usan aún para todo tipo de investigaciones médicas y biológicas y podrían eventualmente sustituir completamente a las placas fotográficas en la radio-biología aplicada. La velocidad creciente con la que permiten registrar las imágenes en radio medicina conducen a una menor tiempo de exposición y a menores dosis de radiación indeseada recibida por los pacientes.

Hadronterapia, o las partículas contra el cáncer

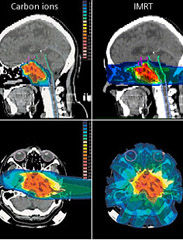

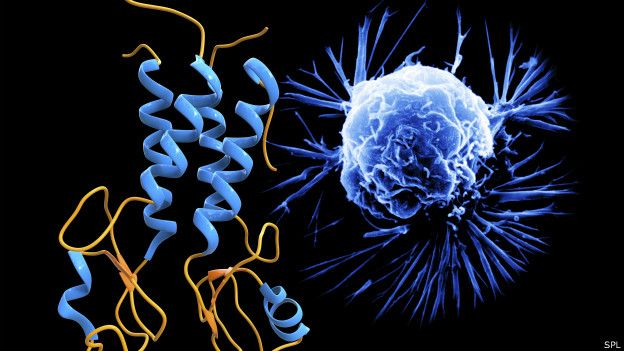

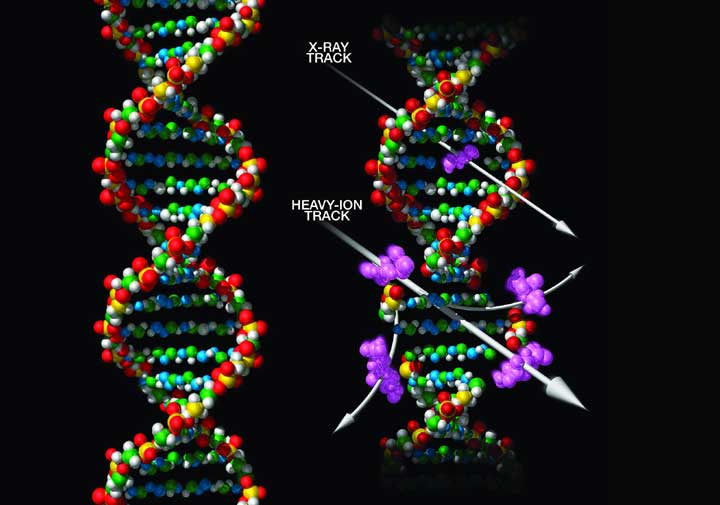

Como es bien sabido, una de las herramientas terapéuticas esenciales en el campo de la oncología es la radioterapia. Dicho tratamiento se aplica hoy en día aproximadamente a la mitad de los pacientes de cáncer. En cierto modo se puede considerar como una forma sutil de cirugía donde el bisturí es reemplazado por un haz colimado de partículas capaz de esterilizar las células malignas mediante la inactivación de su ADN, impidiendo así su reproducción. Tradicionalmente, la radioterapia se ha basado en el uso de rayos X (fotones), electrones y, más recientemente, hadrones, es decir, partículas capaces de interaccionar fuerte o nuclearmente, si bien no es ésta la propiedad más interesante de estas partículas para las aplicaciones radioterapeúticas. Los haces de rayos X y los electrones se obtienen normalmente a partir de aceleradores lineales como los del CERN, aunque mucho más pequeños, y se apuntan hacia los tumores con la energía, dirección y colimación apropiadas para optimizar su efecto destructivo sobre los mismos. Por su parte, los neutrones pierden energía en el interior del organismo de una forma diferente, lo cual les hace más indicados para el tratamiento de ciertos tipos especiales de tumores. Se obtienen a partir de las colisiones de protones, previamente acelerados en un ciclotrón, con núcleos de berilio. Este hecho hace que esta terapia sea bastante más cara que las anteriores, pero a cambio el ciclotrón puede ser usado también para la producción de radiofármacos.

Cintíficos del CERN aplivcan antimateria contra el Cáncer

El estudio de las posibilidades de utilización de haces de hadrones en la terapia del cáncer tuvo su origen en el trabajo seminal de R.R Wilson titulado Radiological Use of Fast Protons (Radiology 47, 1946). En dicho artículo se ponía de manifiesto que los protones, así como otras partículas cargadas pesadas, presentan la propiedad única de que al penetrar en el cuerpo humano depositan la mayor parte de su energía a una preofundidad que depende de su energía inicial. Este hecho permite seleccionar cuidadosamente el área que se quiere irradiar, preservando de dicha radiación al tejido sano que pudiera encontrarse a menor profundidad. Además, como las partículas se detienen a una distancia de la superficie bien definida por la energía del haz, tampoco resultarían dañadas las células situadas detrás del blanco seleccionado.

En contraste, la energía depositada por los rayos X alcanza su máximo cerca de la superficie de entrada y decae exponencialmente hasta que abandona el cuerpo humano en el lado opuesto, haciendo por tanto muy difícil seleccionar la zona que quiere irradiarse sin dañar otras áreas de células sanas. El trabajo de Wilson de 1946 condujo a toda una nueva línea de investigación experimental, principalmente en el Lawrence Berkeley Laboratory, que ha dado lugar al desarrollo de una nueva clase de terapias antitumorales basadas en la irradiación con protones y más recientemente con iones de carbono. Estas técnicas han sido aplicadas en más de 40 centros de todo el mundo, y de ellas se han beneficiado hasta la fecha más de 50.000 pacientes. No obstante, continúan investigándose nuevas formas de intentar mejorar el ratio entre la energía depositada en las células tumorales y en el tejido sano.

En la actualidad, el CERN se encuentra involucrado en diversos proyectos relacionados con la hadronterapia. Por ejemplo, en el diseño de un acelerador de protones e iones de carbono dedicado exclusivamente a usos médicos conocido como Proton Ion Medical Machine Study (PIMMS). Otro proyecto interesante es la realización de las pruebas del Linear Booster ( LIBO), capaz de acelerar una haz de protones hasta 200 Mev (los hospitales habiualmente utilizan energías en torno a los 65 MeV) y que estaría especializado en el tartamiento de tumores profundos.

Finalmente, y situándonos en un plano de investigación a un nivel más básico, es interesante señalar que en octubre de 2006 se presentaron los primeros resultados de un experimento llevado a cabo en el CERN con potencial para futuras aplicaciones en la terapia del cáncer. Se trataba del Antiproton Cell Experiment (ACE), que constituye la primera investigación realizada hasta la fecha sobre efectos biológicos de los antiprotones. Los antiprotones se comportan como los protones cuando entran en el organismo, pero generan mucha más energía en el blanco seleccionado debido a du aniquilación con los protones existentes en los núcleos de los átomos de las células, y además depositan esta energía de una forma biológicamente más efectiva.

Se busca antimateria contra el Cáncer. Los resultados muestran que los antiprotones son cuatro veces más efectivos que los protones para destruir células vivas. (Foto: Especial CERN )

Evaluando la fracción de células supervivientes después de la irradiación con el haz de antiprotones, el experimento ACE ha encontrado que a eficiencia de éstos es unas cuatro veces mayor que la de los protones, mientras que el daño producido a las células situadas antes del blanco era básicamente el mismo. De acuerdo con Michael Holzscheiter, portavoz del experimento ACE, este hecho podría ser extremadamente importante para el tratamiento de casos de cáncer recurrente, donde este tipo de propiedad es vital. La tecnología desarrollada previamente en el CERN para la obtención de haces de antiprotones de buena calidad a la energía apropiada es esencial para este prometedor experimento, que difícilmente podría haberse realizado en ningún otro laboratorio. Éste es por tanto un magnífico ejemplo de cómo la investigación en física de partículas desarrollada en el CERN puede generar soluciones innovadores con excelentes beneficios médicos potenciales.

Los investigadores de ACE, en colaboración con otras instituciones de todo el mundo, están realizando en la actualidad nuevos tests para comprobar la eficacia de este método en el caso de tumores situados a mayor profundidad, y comparando sus resultados con los de otros métodos más convencionales como la irradiación mediante iones de carbono. Si todo sale como se espera, los beneficios clínicos de esta nueva técnica podrían empezar a producirse dentro de la próxima década.

Otro ejemplo importante de tecnología creada en el CERN con aplicaciones a la terapia del cáncer es el Neutron Driven Element Trasmuter. Se trata de un sistema de producción de radioisótopos específicos específicos a partir de un acelerador de protones cuyo desarrollo fue liderado por Carlo Rubbia, Premio Nobel de Física en 1984 por el descubrimiento de los bosones W y Z y ex director general del CERN. La idea es utilizar el haz de protones para producir neutrones los cuales provocan reacciones en un ambiente apropiado donde ciertos elementos son convertidos en los isótopos deseados.

La diferencia principal entre este método, seguro y barato, y el método más tradicional de utilizar los neutrones provenientes de un reactor nuclear, es que no requiere el uso de material fisionable ni funciona críticamente, es decir las reacciones se detienen en el momento en el que el acelerador es apagado. Más aún, el método tiene la ventaja de que sólo se producen los isótopos requeridos, lo que redunda en una importante reducción de impacto ambiental. Normalmente, el blanco utilizado es plomo, elemento idóneo por presentar el menor ritmo de captura de neutrones. Los neutrones se producen por espalación a partir del haz de protones y permanecen en el interior del blanco de plomo, que está rodeado de un deflector de grafito, hasta que su espectro se suaviza suficientemente para cubrir un gran rango de energías que permiten su utilización para la transmutación de los elementos necesarios para la obtención de los isótopos deseados.

El Neutron Driven Element Trasmuter ha permitido, entre otras cosas, la producción de radioisótopos beta emisores como el 166Ho, 186 Re o el 188Re que son de gran importancia en braquiterapia. Dicha técnica, muy utilizada en el tratamiento de cánceres ginecológicos y en el de cáncer de próstata, es un tipo de radioterapia de proximidad donde la fuente radiactiva se sitúa dentro o muy cerca de los tejidos que requieren irradiación. Típicamente, la fuente radiactiva, de alta actividad y corta vida media, se encapsula en una semilla, filamento o tubo y se implanta en quirófano en la zona deseada. Las diferentes dosis requeridas en cada caso hacen que sea fundamental disponer del mayor muestrario posible de radioisótopos con la actividad y vida media apropiadas, lo cual convierte al Neutron Driven Element Trasmuter en una herramienta valiosísima para el futuro de este tipo de técnica terapéutica.

Información y computación sin fronteras

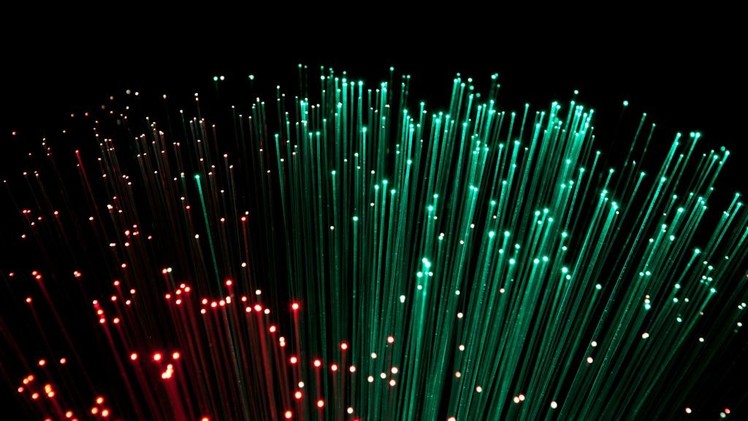

CERN, … where the web was born; éste es uno de los reclamos publicitarios que suelen utilizarse para hacer ver al público la importancia de los retornos tecnológicos que en este laboratorio tienen lugar. Y en efecto, fue a finales de los ochenta cuando Tim Berners-Lee desarrolló estándar de Hyper Text Transfer Protocol (HTTP) e implementó los primeros servidores web en el CERN. Su esfuerzo permitió la comunicación fácil y segura y el intercambio de todo tipo de información entre todos los ordenadores del mundo conectados a internet, dando lugar de esta forma a una de las revoluciones tecnológicas más importantes de las últimas décadas. Las repercusiones científicas, tecnológicas, culturales, comerciales y de ocio de la web son ya tan conocidas que apenas merecen comentario alguno.

El término Grid fue acuñado por Ian Foster and Carl Kesselman en su libro The Grid, Blueprint for new Computing Infraestructure (Morgan Kaufman, 1998), aunque las ideas básicas habían sido consideradas con anterioridad. No existe un acuerdo general sobre cual debería ser la definición precisa de las tecnologías Grid, pero hay un amplio concenso en que esta debería contener elementos tales como recursos compartidos, virtualización, abstracción del acceso a los recursos y estandarización. La filosofía Grid consistería, no sólo en compartir información entre diferentes usuarios, sino también recursos, como por ejemplo, procesadores, tiempo de CPU, unidades de almacenamiento, así como otros aparatos e instrumentos, de tal forma que eventualmente cada usuario tendría acceso virtual, por ejemplo, a la capacidad de cálculo de todos los demás usuarios de esa Grid. En los primeros tiempos de esta tecnología de la información se llegó a hablar de la Grid, refiriéndose a la posibilidad de existencia de una única World Wide Grid.

Todo surgió del CERN

Hasta el momento, sin embargo, este concepto no es una realidad y más bien lo que se encuentra es que diferentes grupos de proyectos crean su propia Grid usando sus propias implementaciones, estándares y protocolos y dando acceso restringido solamente a una cierta comunidad de usuarios autorizados. Así, aunque se siguen realizando importantes esfuerzos en cuanto a la estandarización de los protocolos, no está claro cual será el camino que este tipo de tecnología seguirá en el futuro en lo que se refiere a la futura existencia de un única Grid.

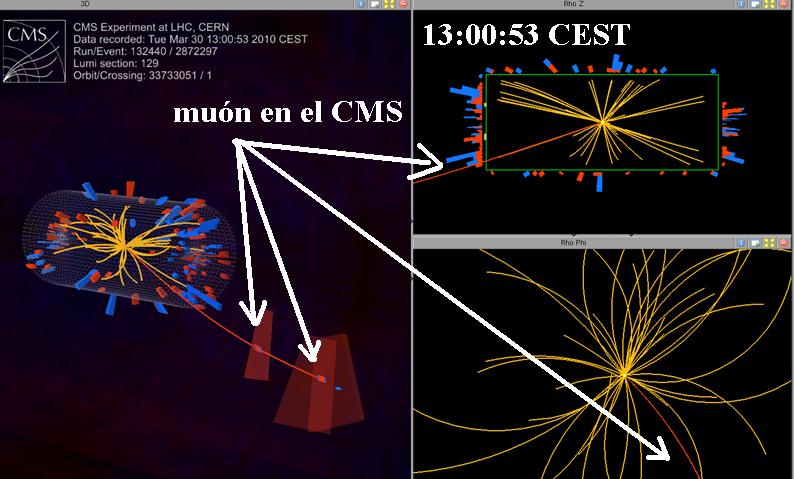

En cualquier caso es importante resaltar que una vez más el CERN ha sido pionero en este tipo de tecnología. Los detectores que se están instalando (a estas alturas, todos instalados y en marcha) en el LHC (ATLAS, CMS, ALICE, LHCb, SUSY, etc.), son tan complejos, que han requerido cada uno de ellos el concurso de muchas instituciones de todo el mundo para su construcción, y lo seguirán requiriendo para su mantenimiento cuando el acelerador empiece a funcionar (ya está en marcha), y, como no, para el análisis de los datos que se obtengan. Para hacerse una idea de la dimensión y complejidad de estos análisis baste mencionar que el compact Muon Selenoid (CMS), una vez pasado su primer filtro, deberá almacenar información sobre el resultado de las colisiones producidas en su interior a un ritmo del orden de 100 a 200 MB por segundo durante un tiempo esperado de unos cien días por año. Resulta obvio que sólo una tecnología tipo Grid puede afrontar con posibilidades de éxito un reto semejante y de hecho el CERN ha inspirado varios proyectos Grid multinacionales por este motivo. Posiblemente, el más grande de ellos hasta la fecha sea el EGEE (Enablinbg Grids for E-Science), que conecta más de 150 paises y ofrece 20 000 CPUs y más de 10 Petabytes de memoria.

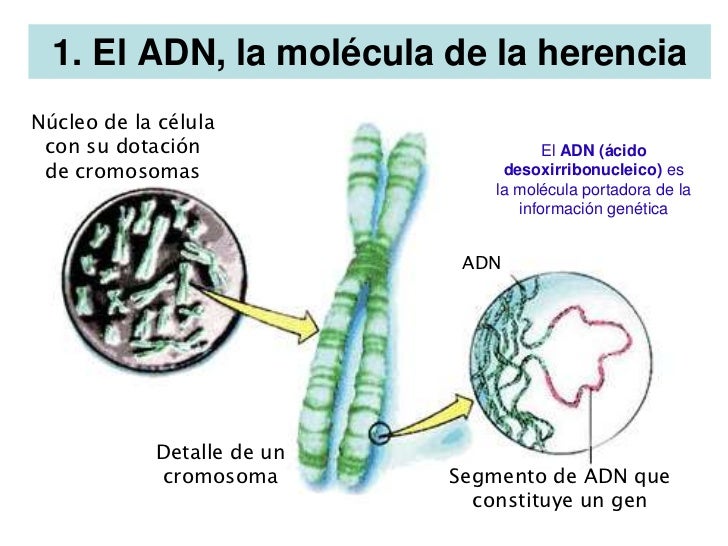

De manera análoga a como ocurrió con las tecnologías de la detección y aceleración, las tecnologías Grid tendrán, y de hecho ya empiezan a tener, un fuerte impacto en las ciencias de la vida y de la salud. En este sentido, uno de los campos obvios de aplicación es la bioinformática. Gracias a los espectaculares avances llevados a cabo en los últimos años en el campo de la biología molecular, se dispone hoy en día de cantidades crecientes de información genética de diferentes especies e individuos. Dicha información codificada en el ADN en forma de secuencia de tripletes o codones de ácidos nucleicos, que constituyen los genes que contienen la estructura primaria de las diferentes proteínas, ha sido y está siendo obtenida por centenares de grupos diferentes distribuidos por todo el mundo y debe almacenarse en gigantescas bases de datos de forma eficiente para su compartición, contrastación y análisis.

Ejemplos típicos serían la búsqueda de determinadas secuencias, comparaciones, búsqueda de determinadas mutaciones o alelos, etc. Resulta evidente que esta ingente labor puede verse enormemente beneficiada por el uso de tecnologías Grid. De hecho, la Bioinformática, y en particular sus aplicaciones biomédicas, han sido una parte importante del proyecto EGEE desde el comienzo del mismo.

Finalmente, y como última muestra de cómo puede revertir en la sociedad las tecnologías de la información y la computación provenientes de la física de partículas, es interesante mencionar el Proyecto Mammogrid y su continuación Mammogrid Plus. Liderado por el CERN, dicho proyecto de la UE utiliza la tecnología Grid para crear una base de datos de mamografías que pueda ser usada para investigar un gran conjunto de datos e imágenes que, aparte de otras aplicaciones sanitarias, sea útil para estudiar el potencial de esta tecnología para servir de soporte a la colaboración entre los profesionales de la salud de la UE.

Ciencia, Tecnología y Sociedad

A estas alturas debería haber quedado claro que los centros científicos de élite internacionales como el CERN, no sólo nos proporcionan un conocimiento más profundo de la naturaleza, sino que las tecnologías de punta que en ellos se desarrollan acaban permeando a la Sociedad y se incorporan a nuestras vidas cotidianas. El autor del artículo, Antonio Dobado, del Departamento de Física Teórica I de la Universidad Complutense de Madrid, ha pretendido ilustrar el hecho innegable de la conexión existente entre temas tan aparentemente dispares como el de la Física de Partículas y la Biomedicina, pero ejemplos semejantes podrían haberse encontrado en prácticamente cualquier área de la actividad humana.

La Sociedad no puede permanecer por más tiempo ajena a la Ciencia y a todo lo que trae consigo. Precisamente por eso la RSEF dedica un gran esfuerzo a la difícil tarea de convencer al público de la importancia de la Física como valor científico, cultural y social, como una forma rigurosa y profunda del acercamiento al conocimiento de la naturaleza, y a la vez como generadora de nuevas tecnologías. En este sentido, es una espléndida noticia la inminente creación de un nuevo Grupo especializado en el seno de la RSEF denominado Física Médica. Y, desde aquí, aprovechamos la oportunidad para darles la bienvenida y desearles el mayor éxito en sus futuras andaduras en la búsqueda de la verdad científica.

Fuente: Revista Española de FÍSICA.

Publicada por la RSEF con el Nº 3 Volumen 21 de 2007

La presente transcripción es de: Emilio Silvera

Miembro numerario de la RSEF y adscrito a los Grupos Especializados de Física Teórica y Astrofísica.

Feb

25

¿La Conciencia? ¡Qué complejidad!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en conciencia ~

Clasificado en conciencia ~

Comments (6)

Comments (6)

“Nada es tan difícil como evitar el autoengaño” Decía Ludwig Wittgestein

La conciencia emerge de procesos cerebrales

Nuestra estrategia para explicar la base neuronal de la conciencia consiste en centrarse en las propiedades más generales de la experiencia consciente, es decir, aquellas que todos los estados conscientes comparten. De estas propiedades, una de las más importantes es la integración o unidad. La integración se refiere a que el sujeto de la experiencia no puede en ningún momento dividir un estado consciente en una serie de componentes independientes. Esta propiedad está relacionada con nuestra incapacidad para hacer conscientemente dos cosas al mismo tiempo, como por ejemplo, estar ahora escribiendo este comentario para ustedes y al mismo tiempo mantener una conversación sobre el Universo con otros amigos.

Muchas y variadas son las opciones que tenempos a nuestro alcance. No pocas veces nos encontramos en una encrucijada entre la razón y el corazón y nos perdemos sin saber cuál es la decisión correcta. No siempre resulta fácil elegir el camino a seguir y… ¡Es tan importante acertar!

Otra propiedad clave de la experiencia consciente, y una que aparentemente contrasta con la anterior, es su extraordinaria diferenciación o informatividad: En cada momento podemos seleccionar uno entre miles de millones de estados conscientes posibles en apenas una fracción de segundo. Nos enfrentamos, pues, a la aparente paradoja de que la unidad encierra la complejidad: el cerebro tiene que afrontar la sobreabundancia sin perder la unidad o coherencia. La tarea de la ciencia consiste en mostrar de qué manera la consigue.

Los últimos pensamientos sobre la mente y la conciencia están centrados en el constructivismo y nos viene a decir que cada cual, se fabrica su propia realidad, y, al hilo de ese pensamiento se me vienen a la mente algunas lecciones de neuropsicología y lo que es la integración bajo tensión, me explico:

Algunas de las indicaciones más sobresalientes de la ineludible unidad de la experiencia consciente provienen del examen de ciertos fenómenos patológicos. Muchos trastornos neuropsicológicos demuestran que la conciencia puede doblarse o encogerse y, en ocasiones, incluso dividirse, pero que nunca tolera que se rompa la coherencia. Por ejemplo, aunque un derrame cerebral en el hemisferio derecho deja a muchas personas con ese lado del cuerpo paralizado y afectado por una pérdida sensorial completa, algunas personas niegan su parálisis, un fenómeno que se conoce como anosognosia.

Ella también pasó por la experiencia de un derrame cerebral

“Perdí bastante visión durante dos años, también la audición, no podía escribir, me costaba caminar, no podía hablar bien y perdí mucha memoria”. y

“me llevó mucho tiempo volver a funcionar, me costaba por el tema de la memoria, en el set, solo en los últimos dos años puedo decir que estoy recuperada totalmente”.

Sin embargo, algunos, cuando se le presentan pruebas de que su brazo y su pierna derecha no pueden moverse, llegan incluso a negar que se trate de sus extremidades y las tratan como si fuesen cuerpos extraños. Otras personas con daños bilaterales masivos en la región occipital no pueden ver nada y, sin embargo, no reconocen que estén ciegos (síndrome de Antón).

Todo está en nuestros cerebros

Las personas con cerebro dividido ofrecen una demostración más de que la conciencia siente horror por los vacíos o las discontinuidades. Las personas con hemi-inantención, un complejo síndrome neuropsicológico que se suele dar cuando se producen lesiones en el lóbulo parietal derecho, no son conscientes del lado izquierdo de las cosas, a veces incluso de toda la parte izquierda del mundo.

El cerebro izquierdo es objetiva y racional. Con la parte izquierda de nuestro cerebro, tratamos de ser objetivos y racionales. Podemos centrarnos en los detalles y hechos analíticos y tratamos de ser razonable y práctico. La parte izquierda del cerebro es responsable de procesar números y palabras, así que ahí es donde logramos por ejemplo la aritmética, ciencias e idiomas. Se podría decir que en esta parte del cerebro está la realidad de nuestro mundo consciente.

El cerebro derecho es subjetivo e intuitivo. La parte derecha de nuestro cerebro es más bien subjetiva. En lugar de tomar decisiones racionales y conscientes, esta parte se basa en la intuición. Nuestro pensamiento en el lado derecho es espontáneo e influido por las emociones, tales como nuestro estado de ánimo, o disparadores emocionales externos. Con esta parte del cerebro, usamos nuestra imaginación, la fantasía y las creencias personales para decidir por nosotros. Estamos dispuestos a asumir riesgos y centrarse en objetivos más que el proceso que se necesita para llegar allí. Apreciamos imágenes y elementos emocionales, en lugar de información objetiva.

Pongo estos ejemplos para que podamos ver la complejidad de lo que el cerebro encierra. No es fácil llegar a saber lo que ahí se cuece.

Asisto con otras muchas personas a un mismo lugar para escuchar y ser testigos de una conferencia de Física. Tal reunión dará lugar a una multitud de pensamientos, los suyos y los míos, algunos mutuamente coherentes, otros no. Son tan poco individuales y recíprocamente independientes como son un todo coherente al estar oyendo todos el mismo tema, sim embargo, casi nadie coincide al clasificar la manera de encajar lo que allí se expone, así que, no son ni lo uno ni lo otro: ninguno de ellos está separado, sino que cada uno pertenece al ámbito de los otros pero además al de ninguno. Mi pensamiento pertenece a la totalidad de mis otros pensamientos, y el de cada uno, a la totalidad de pensamientos de cada uno…los únicos estados de conciencia que de forma natural experimentamos se encuentran en las consciencias personales, en las mentes, en todos los yo y tu particulares y concretos…el hecho consciente universal no es “los sentimientos y los pensamientos existen”, sino “yo pienso” y “yo siento”. De ahí, sin lugar a ninguna duda surge, la idea de que cada cual, dentro de su mente, se inventa su realidad del mundo que le rodea.

Algunos se montan en barco y se ven cayendo por una catarata

Otros creen viajar hacia fantásticos mundos

Otros se limitan a disfrutar del paisaje y disfrutar de su tiempo libre

No todos, ante la misma situación, vemos lo mismo. Es un buen reflejo de la arrogancia humana el hecho de que se hayan erigido sistemas filosóficos enteros sobre la base de una fenomenología subjetiva: la experiencia consciente de un solo individuo con inclinaciones filosóficas. Tal como Descartes reconoció y estableció como punto de partida, esta arrogancia es justificada, por cuanto nuestra experiencia consciente es la única ontología sobre la cual tenemos evidencia directa. La inmensa riqueza del mundo fenoménico que experimentamos -la experiencia consciente como tal- parece depender de una nimiedad del menaje de ese mundo, un trozo de tejido gelatinoso del interior del cráneo.

Sí, estamos condicionados por el entorno, las experiencias, la información…¡Los sentidos!

Nuestro cerebro, un actor “secundario” y “fugaz” que casi ninguno llega a ver sobre el escenario de la conciencia, parece ser el guardián del teatro entero. Como a todos se nos hace dolorosamente obvio cuando nos vemos ante una escena de desgracia humana, en un ser querido cercano, supondrá una agresión al cerebro y puede modificar permanentemente todo nuestro mundo. De ahí, el hecho cierto, de que las sensaciones tales como los sentimientos o el dolor, inciden de manera directa, a través de los sentidos, en nuestra consciencia que, como decimos, siempre es particular e individualizada, nadie podrá nunca compartir su consciencia y, sin embargo ésta, estará también siempre, supeditada al mundo que la rodea y de la que recibe los mensajes que, aún siendo los mismos, cada cual nos interpretará a su manera muy particular y, al mismo tiempo, dentro de unos cánones pre-establecidos de una manera común de ver y entender el mundo al que pertenecemos.

Amigos, tenemos una jungla en la cabeza, y, su enmarañada ramificación es tan descomunalmente compleja que, de momento, lo único que podemos hacer es ir abriéndonos camino a machetazos de la ciencia que, sin duda alguna, finalmente nos permitirá deambular por esa intrincada selva que llamamos cerebro y que es la residencia de nuestras mentes ese lugar donde generan las ideas, los pendsamientos y los sentimientos.

En un trabajo anterior debajo de esta imagen decía:

“Los procesos científicos que comentamos en este lugar, los fenómenos del Universo que hemos debatido y, también, los misterios y secretos que el inmenso Cosmos nos oculta han contribuido, aunque inadvertidamente, a comprometer e involucrar a nuestra especie en la vastedad del universo. La astronomía ha venido a descorrer el velo, que supuestamente, aislaban la Tierra de los ámbitos etéreos que están situados mucho más allá de la Luna, todo eso, nos llevó lejos al auténtico Universo que ahora, sí -parece que- conocemos. La Física cuántica llegó para destruir esa barrera invisible que separaba lo grande de lo muy pequeño y que supuestamente, separaba al observador distante del mundo observado; descubrimos que estamos inevitablemente enredados en aquello que estudiamos.”

No siempre es conveniente un exceso de información

Como veréis, aquello que aquí decía, viene a corroborar que, nuestras mentes, están inmersas en el “mundo” que nos rodea, en el Universo que nos acoge y del que queremos saber a través de la información que nos transmiten los sentidos y, siendo consciente de la inmensa tarea que hemos echado sobre nuestras espaldas, también hemos llegado a saber que será “casi” imposible cumplirla. Sin embargo, esa otra parte del cerebro que intuye y siembra en nuestras mentes ilusiones, hace que no desfallezcamos, sino que, al contrario, cada día y con cada nuevo descubrimienro, nuestra fuerza crece y se ve revitalizada en esa ilusión de saber…¡cómo puede ser el mundo, la Naturaleza, el Universo!

¡Ah! Eso sí, algunos tienen una conciencia acomodaticia, ya que, en caso contrario, ¿cómo explicar sus comportamientos?

emilio silvera

Feb

22

El placer de Descubrir: Aventurarse por nuevos caminos.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (2)

Comments (2)

Es posible que lo que nosotros llamamos materia inerte, no lo sea tanto, y, puede que incluso tenga memoria que transmite por medios que no sabemos reconocer. Esta clase de materia, se alía con el tiempo y, en cada momento adopta una forma predeterminada y de esa manera sigue evolucionando hasta llegar a su máximo ciclo o nivel en el que, de “materia inerte” llega a la categoría de “materia viva”, y, por el camino, ocupará siempre el lugar que le corresponda. No olvidemos de aquel sabio que nos dijo: “todas las cosas son”. El hombre, con aquellas sencillas palabras, elevó a todas las cosas a la categoría de SER.

¡Ah! ¿Pero sabemos?

¿Qué nos separa de otras especies? ¿Somos acaso unos privilegiados? Lo cierto es que, al no entender a esos otros seres, no podemos opinar sobre los que ellos puedan ser en realidad, ni en qué mundo viven.

Neuronas sin fin (cien mil millones) que generan conexiones e impulsos eléctricos que, como vehículos lúmínicos transportan ideas y sentimientos

La vida, también ha ocupado una buena de nuestro tiempo en este lugar y hemos hablado de ella, de la que está presente en nuestro planeta y, de la posible “vida extraterrestre”, posibilidad enorme en este universo nuestro, y, con esas y otras cuestiones de interés, hemos hecho camino juntos, en armonía y siempre tratando de conseguir ese saber que es el sustento de nuestra enorme curiosidad. Claro que, la Física, esa disciplina que nos dice como funciona la Naturaleza, ocupó una gran parte del recorrido.

Hemos construido un Modelo del Universo que podría, o no, ser el real

Para s seguir avanzando es importante reconocer que, no sabemos tanto como creemos saber. Nuestras Teorías de hoy, serán mañana sustituidas por otras nuevas teorías que se implantarán en nuestras vidas cotidianas a medida que vayamos descubriendo cómo es la Naturaleza y desvelando sus secretos. Todavía, son muchas más las preguntas que las respuestas.

El ADN transporta la información que nos habla del pasado y del origen

Mediante el estudio y la observación se pudo comprobar que la cantidad de ADN era la misma para todas las células somáticas de los individuos de una determinada especie, mientras que los gametos sólo tenían la mitad. Así mismo, los estudios de Erwin Chargaff sobre las similitudes en las proporciones de bases nitrogenadas presentes en el ADN de los individuos de la misma especie parecían confirmar la relación existente entre esta molécula y la información genética.

La prueba definitiva fue obtenida en 1952 por Alfred Hershey y Martha Chase, quienes demostraron de forma concluyente que el ADN, y no una proteína, era el material genético del bacteriófago T2. Al año siguiente, James Watson y Francis Crick elaboraron su famoso modelo de doble hélice

El Universo, la Ciencia…Nosotros.

Científicos que estudian cómo podría ser la vida vegetal en un planeta similar a la Tierra con dos o tres ‘soles’ han encontrado que podría verse negra o gris, si el sistema está dominado por una enana roja.

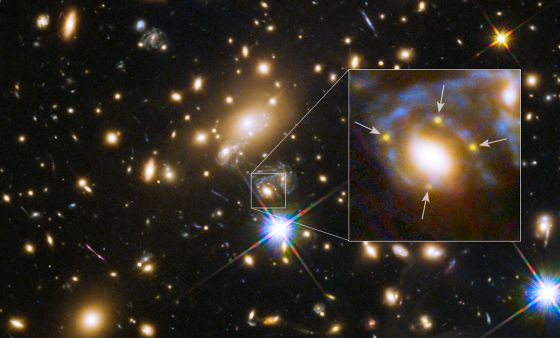

Las maravillas del universo son inagotables, y muy lentamente tenemos acceso a ellas. Hay lugares con tres soles de distintos colores: amarillo (como el nuestro), azul y verde, o blanco y rojo. Hay dos que casi se están tocando, sólo los separa una ligera y brillante materia cósmica que parece pura luz. Hay un mundo que tiene miles de lunas, y no muy lejos de él brilla un Sol que no es mayor que nuestro planeta Tierra. He podido ver un núcleo atómico de 3.000 m de diámetro que gira 160 veces por segundo. Hay soles que se desplazan por el universo a velocidades enormes y bacterias que escapan de las galaxias y vagan por el cosmos hasta encontrar un planeta donde instalarse. Las nubes de gas y polvo inundan los espacios entre las galaxias, y después de girar durante miles de millones de años, se juntan y forman nuevas galaxias de estrellas y planetas.

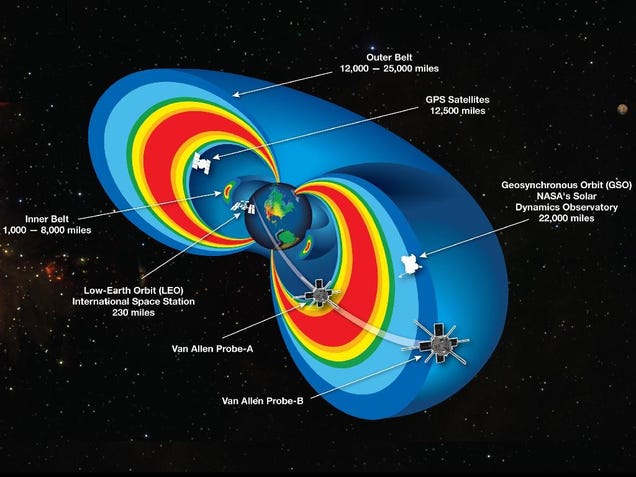

Es ampliamente sabido que el planeta Tierra actúa como un gran imán cuyas líneas de campo geomagnético surgen de un polo (el polo sur magnético) y convergen en el otro polo (polo norte magnético). El eje longitudinal de este imán tiene una desviación de aproximadamente 11^o con respecto al eje de rotación. Por ello, los polos del campo magnético generado no coinciden exactamente con los polos geográficos.

Este campo geomagnético es producido por la combinación de varios campos generados por diversas fuentes, pero en un 90% es generado por la parte exterior del núcleo de la Tierra (llamado Campo Principal o “Main Field”).

Por otra parte, la interacción de la ionosfera con el viento solar y las corrientes que fluyen por la corteza terrestre componen la mayor parte del 10% restante. Sin embargo, durante las tormentas solares (eventos de actividad solar exacerbada) pueden introducirse importantes variaciones en el campo magnético terrestre.

“Quien ha visto las cosas presentes ha visto todo, todo lo ocurrido desde la eternidad y todo lo que ocurrirá en el tiempo sin fin; pues todas las cosas son de la misma clase y la misma manera ”.

Marco Aurelio

Claro que él, quería significar que todo, desde el comienzo del mundo, ha sido igual, sigue unos patrones que se repiten una y otra vez a lo largo del transcurso de los tiempos: el día y la noche, las estaciones, el frío y el calor, el río muerto por la sequía o aquel que, cantarino y rumoroso ve correr sus aguas cristalinas hasta que desembocan en la Mar. La Bondad y la maldad… Y, también, el Hombre y la Mujer. Así ha sido desde que podemos recordar y, así continuará siendo.

Para fugarnos de la Tierra

un libro es el mejor bajel;

y se viaja mejor en el poema

que en más brioso corcel.

Whitman

“Todo presente de una sustancia simple es naturalmente una consecuencia de su estado anterior, de modo que su presente está cargado de su futuro.”

Leibniz

Niels Bohr, citando a Gohete preguntaba: ¿Cuál es el camino? No hay ningún camino. Está claro el mensaje que tal pregunta y tal respuesta nos quiere hacer llegar, el camino, tendremos que hacerlo nosotros mediante la exploración hacia el futuro en el que está lo que deseamos encontrar. Hay que explorar y arriesgarse para tenemos que ir más allá de las regiones habituales y conocidas que nos tienen estancados siempre en el mismo lugar. ¡Arrisguémosno!

Ulises de Ítaca se arriesgó a oír el canto de las sirenas amarrado al palo de la vela mayor de su embarcación.

Personajes mitológicos que se mezclaban con la realidad al contar las epopeyas

Pero, no cabe duda alguna de que, el acto de exploración modifica la perspectiva del explorador; Ulises, Marco Polo y Colón habían cambiado cuando volvieron a sus lugares de partida . Lo mismo ha sucedido en la investigación científica de los extremos en las escalas, desde la grandiosa extensión del espacio cosmológico hasta el mundo minúsculo y enloquecido de las partículas subatómicas.

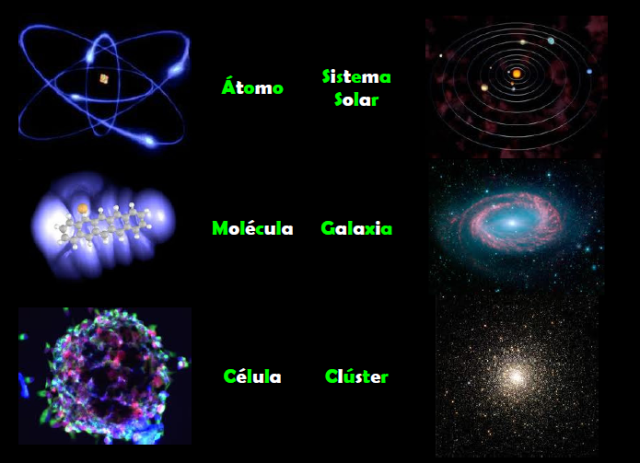

Una bella galaxia espiral de cien mil años-luz de diámetro que podemos comparar con…Un átomo.

En ambos “universos” existe una descomunal diferencia en los extremos de las escalas. Sin embargo, la inmensa galaxia de arriba no sería posible sin la existencia de infinitesimal átomo de abajo. ¡Todo lo grande está hecho de cosas pequeñas!

Así que, cuando hacemos esos viajes, irremediablemente nos cambian, y, desde luego, desafían muchas de las concepciones científicas y filosóficas que, hasta ese momento, más valorábamos. Algunas tienen que ser desechadas, como el bagaje que se deja atrás en una larga travesía por el desierto. Otras tienen que ser modificadas y reconstruidas hasta quedar casi irreconocibles, ya que, lo que hemos podido ver en esos viajes, lo que hemos descubierto, nos han cambiado por completo el concepto y la perspectiva que del mundo teníamos, conocemos y sabemos.

La exploración del ámbito de las galaxias extendió el alcance de la visión humana en un factor de 1026 veces mayor que la escala humana, y produjo la revolución que identificamos con la relatividad, la cual reveló que la concepción newtoniana del mundo sólo era un parroquianismo en un universo más vasto donde el espacio es curvo y el tiempo se hace flexible.

La exploración del dominio subatómico nos llevó lejos en el ámbito de lo muy pequeño, a 10-15 de la escala humana, y también significó una revolución. fue la Física cuántica que, transformó todo lo que abordó.

La teoría cuántica nació en 1900, Max Planck comprendió que sólo podía explicar lo que llamaba la curva del cuerpo negro -el espectro de energía que genera un objeto de radiación perfecta- si abandonaba el supuesto clásico de que la emisión de energía es continua, y lo reemplazó por la hipótesis sin precedentes de que la energía se emite en unidades discretas. Planck llamó cuantos a estas unidades.

1) Figura animada que representa un rayo de luz incidiendo sobre un cuerpo negro hasta su total absorción. 2) En la gráfica se representa la intensidad de la radiación emitida por el cuerpo negro en función de la longitud de onda a diferentes temperaturas. El máximo de la curva aumenta al ir hacia menores longitudes de onda (Ley de Wien). Se compara con el modelo clásico de Rayleigh-Jeans a altas temperaturas (5000 K) comprobándose la llamada catástrofe del ultravioleta

La constante de Planck es una constante física que desempeña un papel central en la teoría de la mecánica cuántica y recibe su nombre de su descubridor, Max Plancc, uno de los padres de dicha teoría. Denotada como  , es la constante que frecuentemente se define como el cuanto elemental de acción. Planck la denominaría precisamente «cuanto de acción»

, es la constante que frecuentemente se define como el cuanto elemental de acción. Planck la denominaría precisamente «cuanto de acción»

Fue inicialmente propuesta como la constante de proporcionalidad entre la energía  de un fotón y la frecuencia

de un fotón y la frecuencia  de su onda electromagnética asociada. Esta relación entre la energía y la frecuencia se denomina «relación de Planck»:

de su onda electromagnética asociada. Esta relación entre la energía y la frecuencia se denomina «relación de Planck»:

Dado que la frecuencia  , la longitud de onda

, la longitud de onda  y la velocidad de la luz

y la velocidad de la luz  cumplen

cumplen  lambda la relación de Planck se puede expresar como:

lambda la relación de Planck se puede expresar como:

lambda}.

lambda}.

Otra ecuación fundamental en la que interviene la constante de Planck es la que relaciona el momento lineal  de una partícula con la longitud de onda de De Broglie λ de la misma:

de una partícula con la longitud de onda de De Broglie λ de la misma:

En aplicaciones donde la frecuencia viene expresada en términos de radianes por segundo o frecuencia angular, es útil incluir el factor 1/2 dentro de la constante de Planck. La constante resultante, «constante de Planck reducida» o «constante de Dirac», se expresa como ħ (“h barra“):

De esta forma la energía de un fotón con frecuencia angular  omega” />, donde

omega” />, donde  omega = 2 \pi . f”

omega = 2 \pi . f”

Por otro lado, la constante de Planck reducida es el cuanto del momento angular en mecánica cuántica.

Planck definió a “sus”0 cuantos en términos del “cuanto de acción”, simbolizado por la letra h que ahora, se ha convertido en el símbolo de una constante, la constante de Planck, h. Planck no era ningún revolucionario – a la edad de cuarenta y dos años era un viejo, juzgado por patrones de la ciencia matemática y, además, un pilar de la elevada cultura alemana del siglo XIX-, pero se percató fácilmente de que el principio cuántico echaría abajo buena de la física clásica a la que había dedicado la mayor parte de su carrera. “Cuanto mayores sean las dificultades -escribió-…tanto más importante será finalmente para la ampliación y profundización de nuestros conocimientos en la física.”

Sus palabras fueron proféticas: cambiando y desarrollándose constantemente, modificando su coloración de manera tan impredecible como una reflexión en una burbuja de , la física cuántica pronto se expandió practicamente a todo el ámbito de la física, y el cuanto de acción de Planck, h llegó a ser considerado una constante de la Naturaleza tan fundamental como la velocidad de la luz, c, de Einstein.

Dos buenos amigos, dos genios

Max Planck es uno de los científicos a los que más veces se le han reconocido sus méritos y, su , está por todas partes: La Constante de Planc, las Unidades de Planck, El cuanto de Planck, la Radiación de Planck, El Teimpo de Planck, la masa de Planck, la Energía de Plancik, la Longitud de Planck… ¡Todo merecido!

Confinados en nuestro pequeño mundo, una mota de polvo en la inmensidad de una Galaxia grandiosa que, a su vez, forma parte de un universo “infinito”, hemos podido darnos traza para poder saber, a pesar de las enormes distancias, sobre lo que existe en regiones remotas del Universo. Un Universo formado por Supercúmulos de galaxias que formadas en grupos conforman la materia visible, y, dentro de cada una de esas galaxias, como si de universos se tratara, se reproducen todos los objetos y fenómenos que en el Universo son.

The Scale of the Universe 2 – HTwins.net

Sigamos con la escala del Universo conocido y hagamos un pequeño esquema que lo refleje: El Universo Observable, la mayor escala que abarca más de 100 mil trillones de kilómetros (según nos cuenta Timothy Ferris:

Radio en metros Objetos característicos

1026 Universo observable

1024 Supercúmulos de Galaxias

1023 Cúmulos de Galaxias

1022 Grupo de Galaxias (por ejemplo el Grupo Local)

1021 Galaxia La Vía Láctea

Nube Molecular gigante muy masiva, de gas y polvo compuesta fundamentalmente de moléculas con diámetro típico de 100 a.l. Tienen masa de diez millones de masas solares (moléculas de Hidrógeno (H2) el 73% en masa), átomos de Helio (He, 25%), partículas de polvo (1%), Hidrógeno atómico neutro (H I, del 1%) y, un rico coctel de moléculas interestelares. En nuestra galaxia existen al menos unas 3000 Nubes Moleculares Gigantes, estando las más masivas situadas cerca de la radiofuente Sagitario B en el centro Galáctico.

1018 Nebulosas Gigantes, Nubes Moleculares

1012 Sistema Solar

1011 Atmósfera externa de las Gigantes rojas

Aunque a una Unidad Astronómica de distancia (150 millones de Kilómetros de la Tierra), el Sol caliente el planeta y nos da la vida

109 El Sol

108 Planetas Gigantes Júpiter

107 Estrellas enanas, planetas similares a la Tierra

105 Asteroides, núcleos de cometas

104 Estrellas de Neutrones

Los seres humanos son parte del Universo que queremos descubrir.

1 Seres Humanos

10-2 Molécula de ADN (eje largo)

10-5 Células vivas

Células vivas

10-9 Molécula de ADN (eje corto)

10-10 Átomos

10-14 Núcleos de átomos pesados

10-15 Protones y Neutrones

10-35 Longitud de Planck: cuanto de espacio; radio de

partículas sin dimensiones = la cuerda.

Es la escala de longitud a la que la descripción clásica de la Gravedad cesa de ser válida y debe ser tenida en la mecánica cuántica. Está dada por la ecuación de arriba, donde G es la constante gravitacional, ħ es la constante de Planck racionalizada y c es la velocidad de la luz. El valor de la longitud de Planck es del orden de 10-35 m (veinte órdenes de magnitud menorque el tamaño del protón 10-15 m).

Me llama la atención y me fascina la indeterminación que está inmersa en el mundo cuántico. La indeterminación cuántica no depende del aparato experimental empleado investigar el mundo subatómico. Se trata, en la medida de nuestro conocimiento, de una limitación absoluta, que los más destacados sabios de una civilización extraterrestre avanzada compartirían con los más humildes físicos de la Tierra.

Por muy avanzados que pudieran estar, ellos también estarían supeditados al Principio de Incertidumbre o Indeterminación cuántica, y, como nosotros, cuando trataran de encontrar (sea cual fuese las matemáticas o sistemas que emplearan para hallarlo) el resultado de la constante de estructura fina, el resultado sería el mismo: 137, puro y adimensional.

Todo esto nos ha llevado a la más firme convicción definir la visión del mundo de la física que nos revelaba que no sólo la materia y la energía sino que también el conocimiento están cuantizados. Cuando un fotón choca con un átomo, haciendo saltar un electrón a una órbita más elevada, el electrón se mueve de la órbita inferior a la superior instantáneamente, sin tener que atravesar el espacio intermedio. Los mismos radios orbitales están cuantizados, y el electrón simplemente deja de existir en un punto para aparecer simultáneamente en otro. Este es el famoso “salto cuántico” que tanto desconcierta, y no es un mero problema filosófico, es una realidad que, de , no hemos llegado a comprender.

No, esto no es un salto cuántico. Simplemente le tocó la Lotería

Pero, ¿quién sabe? Quizás un día lejano aún en el tiempo, cuando descubramos el secreto que salto cuántico nos esconde, podremos aprovechar la misma técnica que emplea la Naturaleza con los electrones hacer posible que se transporten de un lugar a otro sin tener que recorrer las distancias que separan ambos destinos.

Estaría bien poder trasladarse las estrellas por ese medio

Bueno, pongamos los pies en el suelo, volvamos a la realidad. La revolución cuántica ha sido penosa, pero podemos agradecerle que, nos haya librado de muchas ilusiones que afectaban a la visión clásica del mundo. Una de ellas era que el hombre es un ser aparte, separado de la naturaleza a la que en realidad, no es que esté supeditado, sino que es, ella. ¡Somos Naturaleza!

Está claro, como nos decía Immanuel Kant que:

“La infinitud de la creación es suficientemente grande como para que un mundo, o una Vía Láctea de mundos, parezca, en comparación con ella, lo que una flor o un insecto en comparación con la Tierra.”

Algún día podríamos desaparecer en una especie de plasma como ese de la imagen y salir al “otro lado” que bien (¡Por qué no) podría ser otra galaxias lejana. Creo que la imaginación se nos ha dado para algo y, si todo lo que podemos imaginar se realizar, la conclusión lógica es que sólo necesitamos ¡Tiempo!

Sí, amigos míos, la Naturaleza vive en constante movimiento, y, nosotros, que formamos de ella…También.

En tiempos y lugares totalmente inciertos,

Los átomos dejaron su camino celeste,

Y mediante abrazos fortuítos,

Engendraron todo lo que existe.

Maxwell

Doy las gracias a Timothy Ferris de cuyo libro, la Aventura del Universo, he podido obtener bellos pasajes que aquí, quedan incluídos.

emilio silvera

Feb

22

¿Asombrarnos? ¡Tenemos tantos motivos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo misterioso ~

Clasificado en El Universo misterioso ~

Comments (0)

Comments (0)

La ciencia que estudia las leyes que determinan las estructura del Universo con referencia a la materia y la energía de la que está constituido. Se ocupa no de los cambios químicos que ocurren, sino de las fuerzas que existen entre los objetos y las interrelaciones entre la materia y la energía. Tradicionalmente, el estudio se dividía en campos separados: calor, luz, sonido, electricidad y magnetismo y mecánica (Física clásica).

Desde el siglo XX, sin embargo, la Mecánica cuántica y la Física relativista han sido cada vez más importantes; el desarrollo de la Física moderna ha estado acompañado del estudio de la Física atómica, Física nuclear y Física de partículas, molecular…

La Física de cuerpos astronómicos y sus interacciones recibe el nombre de Astrofísica, la Física de la Tierra, recibe la denominación de Geofísica, y el estudio de los aspectos Físicos de la Biología se denomina Biofísica. Tenemos que concluir que sin la Física, no sabríamos cómo es el universo que nos acoge y el por qué del comportamiento de la materia-energía que en él está presente.

Gracias a los aceleradores de partículas hemos podido llegar muy lejos hacia atrás en el tiempo para poder saber sobre cómo se pudo formar y, “suponer” cómo pudo surgir. Cuando llegamos a los 10-35 de segundo desde el comienzo del tiempo, entramos en un ámbito en el que las condiciones cósmicas son poco conocidas. Si las grandes teorías unificadas son correctas, se produjo una ruptura de la simetría por la que la fuerza electronuclear unificada se escindió en las fuerzas electrodébiles y las fuertes. Si es correcta la teoría de la supersimetría, la transición puede haberse producido antes, había involucrado a la gravitación.

Aún no había Carbono que se produciría mucho más tarde, en las estrellas, mediante el efecto triple alfa

En el universo temprano la primera materia (hidrógeno y Helio) era llevada por la fuerza de gravedad a conformarse en grandes conglomerados de gas y polvo que interaccionan, producían calor y formaron las primeras estrellas a los doscientos millones de años del comienzo del tiempo y, sus cúmulos y aglomerados se convirtieron en las primeras galaxias que, tampoco sabemos a ciencia cierta, que mecanismos pudieron seguir para formarse.

Elaborar una teoría totalmente unificada es tratar de comprender lo que ocurrió en ese tiempo remoto que, según los últimos estudios está situado entre 13.700 y 15.000 millones de años, cuando la perfecta simetría -que se pensaba, caracterizó el Universo-, se hizo añicos para dar lugar a las simetrías rotas que hallamos a nuestro alrededor y que nos trajo las fuerzas y constantes Universales que, paradójicamente, hicieron posible que unos diez mil millones de años más tarde, apareciera en escena la vida, y nuestra “aparición” para que ahora, sea posible que, alguien como yo esté contando lo que pasó.

Realmente, carecemos de una teoría que nos explique lo que pasó en aquellos primeros momentos y, hasta que no tengamos tal teoría no podemos esperar comprender lo que realmente ocurrió en ese Universo temprano. Los límites de nuestras conjeturas actuales cuando la edad del Universo sólo es de 10-43 de segundo, nos da la única respuesta de encontrarnos ante una puerta cerrada. Del otro lado de esa puerta está la época de Planck, un tiempo en que la atracción gravitatoria ejercida por cada partícula era comparable en intensidad a la fuerza nuclear fuerte.

Así que, llegados a este punto podemos decir que la clave teórica que podría abrir esa puerta sería una teoría unificada que incluyese la gravitación, es decir, una teoría cuántica-gravitatoria que uniese, de una vez por todas, a Planck y Einsteins que, aunque eran muy amigos, no parecen que sus teorías (la Mecánica Cuántica) y (la Relatividad General) se lleven de maravilla.

Y, a todo esto, tenemos que pensar en el hecho cierto de que átomos, moléculas y conexiones se pudieran estructurar en un conjunto complejo para poder formar pensamientos surgidos de algo nuevo que antes no estaba presente en el Universo: ¡La Vida! Que evolucionada pudo llegar, en algún caso, a generar no sólo pensamientos sino que también, llegaron los sentimientos y nos hizo adolescentes. Ahora, estamos a la espera de que llegue la mayoría de edad, ese tiempo en el que se deja de hacer chiquilladas y la seriedad predomina en los comportamientos que están aconsejados por la sabiduría de la experiencia. Pero para que eso le llegue a la Humanidad… ¡Falta mucho, mucho, muchísimo Tiempo!

¡El peligro nos acecha! Si no prestamos atención y nos dejamos llevar….

Hemos llegado a poder discernir la relación directa que vincula el tamaño, la energía de unión y la edad de las estructuras fundamentales de la Naturaleza. Una molécula es mayor y más fácil de desmembrar que un átomo; lo mismo podemos decir de un átomo respecto al núcleo atómico, y de un núcleo con respecto a los quarks que contiene.

La cosmología sugiere que esta relación resulta del curso de la historia cósmica, que los quarks se unieron primero, en la energía extrema del big bang original, y que a medida que el Universo se expandió, los protones y neutrones compuestos de quarks se unieron para formar núcleos de átomos, los cuales, cargados positivamente, atrajeron a los electrones cargados con electricidad negativa estableciéndose así como átomos completos, que al unirse formaron moléculas. Si es así, cuanto más íntimamente examinemos la Naturaleza, tanto más lejos hacia atrás vamos en el tiempo.

Todo lo grande está hecho de cosas pequeñas conformadas en la debida proporción para que existan mundos, estrellas, galaxias y seres vivos

Aquí, generalmente comentamos sobre la Física pura en sus dos versiones de la Relatividad y la Mecánica Cuántica que engloba ese universo particular de lo microscópico donde se mueven las partículas que conforma todo aquello que podemos observar en el Universo y que llamamos la Materia Bariónica, y, al mismo tiempo, nos ocupamos de la interrelación que entre los cuerpos físicos ocurren y las fuerzas que están presentes, así como, de las constantes universales que en nuestro universo, son las responsables de que todo funcione como lo hace.

Hablamos de física y no puedo dejar de pensar en cómo la mente humana, ha podido profundizar tanto en el conocimiento de la Naturaleza hasta llegar a números tan complejos como el de las constantes de la Naturaleza: la constante de Planck en sus dos versiones, h y ħ; la igualdad masa-energía de Einstein, la constante gravitacional de Newton, la constante de estructura fina (137) y el radio del electrón.

La velocidad de la luz en el vacío (c), es una constante física

En ciencias se entiende por constante física el valor de una magnitud física cuyo valor, fijado un sistema de unidades, permanece invariable en los procesos físicos a lo largo del tiempo. En contraste, una constante matemática, las constante de la Naturaleza representan un valor invariable que no está implicado directamente en ningún proceso físico. Algunas de ellas son:

- Constante de Planck: h = E/v

- Constante de Planck racionalizada: ℎ = h/2π

- Igualdad masa-energía: E = mc2

- Constante gravitacional: F = m1m2G/d2

- Constante de estructura fina: α = 2πe2/hc

- Radio del electrón: r0 = e2/mc2

¡Me encantan sus mensajes!

Es verdaderamente meritorio el enorme avance que en tan poco tiempo ha logrado la Humanidad en el campo de la física. En aproximadamente un siglo y medio, se ha pasado de la oscuridad a una claridad, no cegadora aún, pero sí aceptable. Son muchos los secretos de la naturaleza física que han sido desvelados, y el ritmo parece que se mantiene a una muy meritoria velocidad gracias a inmensas estructuras que, como el Acelerador de Hadrones (LHC), nos ha llevado hacia atrás en el Tiempo muy cerca del comienzo, después del Tiempo de Planck cuando la materia y la energía se distribuyeron para conformar el Universo que conocemos hoy. También los grandes telescopios nos enseñan como eran las estrellas y las galaxias de hace miles de millones de años.

¡El tiempo!, ése precioso bien está a nuestro favor. Sólo tenemos que ir pasando el testigo para alcanzar las metas propuestas. Pongamos nuestras esperanzas en que no seamos tan irresponsables como para estropearlo todo. ¿Nos haremos mayors alguna vez? Tenemos que pensar a lo grande, en el conjunto universal y dejarnos de parroquialismos locales, olvidarnos del Yo y pensar en el Nosotros.

Astronomía, gravedad o electromagnetismo; cuestiones sencillas de entender para los iniciados y, a veces, muy complejas para la gente corriente. Por tal motivo, si escribo sobre estos interesantes temas, mi primera preocupación es la de buscar la sencillez en lo que explico. No siempre lo consigo. Por ejemplo, expliquemos el magnetismo.

Magnetismo

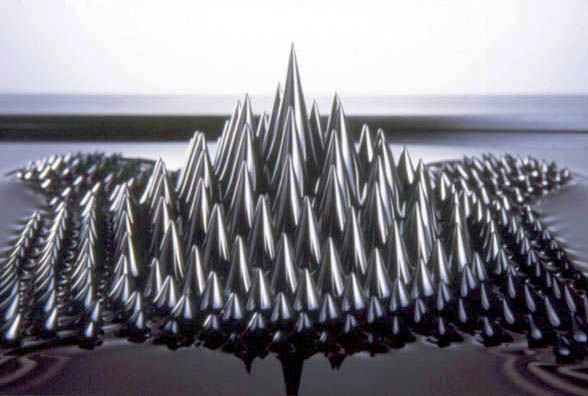

Grupo de fenómenos asociados a los campos magnéticos. Siempre que una corriente eléctrica fluye, se produce un campo magnético; como el movimiento orbital de un electrón y el espín de los electrones atómicos son equivalentes a pequeños circuitos de corriente, los átomos individuales crean campos magnéticos a su alrededor cuando los electrones orbitales tienen un momento magnético neto como resultado de su momento angular. El momento angular de un átomo es el vector suma de los momentos magnéticos de los movimientos orbitales y de los espines de todos los electrones en el átomo.

Las propiedades magnéticas macroscópicas de una sustancia tienen su origen en los momentos magnéticos de sus átomos o moléculas constituyentes. Diferentes materiales poseen distintas características en un campo magnético aplicado; hay cuatro tipos de comportamientos magnéticos.

a) En diamagnetismo, la magnetización está en la dirección opuesta a la del campo aplicado, es decir, la susceptibilidad es negativa. Aunque todas las sustancias son diamagnéticas, es una forma débil de magnetismo que puede ser enmascarada por otras formas más fuertes. Tiene su origen en los cambios introducidos por los campos aplicados en las órbitas de los electrones de una sustancia, siendo la dirección del cambio opuesta a la del flujo aplicado (de acuerdo con ley de Lenz).

Existe, por tanto, una débil susceptibilidad negativa (del orden de -10-8 m3 mol-1) y una permeabilidad relativa ligeramente menor que 1.

b) En paramagnetismo, los átomos o moléculas de la sustancia tienen momentos magnéticos orbitales o espín que son capaces de estar alineados en la dirección del campo aplicado. Éstos, por tanto, tienen una susceptibilidad positiva (aunque pequeña) y una permeabilidad relativa ligeramente mayor que 1.

El paramagnetismo aparece en todos los átomos y moléculas con electrones desapareados; es decir, átomos libres, radicales libres y compuestos de metales de transición que contienen iones con capas de electrones no llenas.

También ocurre en metales como resultado de momentos magnéticos asociados a los espines de los electrones de conducción.

c) En sustancias ferromagnéticas, dentro de un cierto rango de temperaturas, hay momentos magnéticos atómicos netos, que se alinean de forma que la magnetización persiste después de eliminar el campo aplicado.

Por debajo de una cierta temperatura llamada punto de Curie (o temperatura de Curie), un campo magnético en aumento aplicado a una sustancia ferromagnética causará una magnetización creciente hasta un valor máximo, llamado magnetización de saturación. Esto es debido a que una sustancia ferromagnética está constituida por pequeñas regiones magnetizadas (1 – 0’1 mm de ancho) llamadas dominios.

El momento magnético total de la muestra de sustancia es el vector suma de los momentos magnéticos de los dominios constituyentes. Dentro de cada dominio, los momentos magnéticos atómicos individuales se alinean espontáneamente por fuerzas de intercambio, que dependen de si los espines de los electrones atómicos son paralelos o antiparalelos.

Sin embargo, en un trozo no magnetizado de material ferromagnético, los momentos magnéticos de los dominios no están alineados; cuando un campo externo es aplicado, esos dominios que están alineados con el campo aumentan de tamaño a expensas de otros.

En un campo muy intenso, todos los dominios se alinean en la dirección del campo y producen la alta magnetización observada. El hierro, el níquel, el cobalto y sus aleaciones son ferromagnéticos. Por encima del punto de Curie, los materiales ferromagnéticos se vuelven paramagnéticos.

Densidad del flujo

Ordenamiento antiferromagnético

d) Algunos metales, aleaciones y sales elementales de transición, muestran otro tipo de magnetismo llamado antiferromagnetismo. Esto ocurre por debajo de cierta temperatura, llamada temperatura de Néel, a la cual se forma espontáneamente una red ordenada de momentos magnéticos atómicos en la que momentos alternos tienen direcciones opuestas. No hay, por tanto, momento magnético resultante en ausencia de un campo aplicado.

Manganeso Cloruro

En el fluoruro de manganeso, por ejemplo, esta disposición antiparalela ocurre por debajo de una temperatura de Néel de 72 K. Por debajo de esta temperatura, el ordenamiento espontáneo se opone a la tendencia normal de los momentos magnéticos de alinearse con el campo aplicado. Por encima de la temperatura de Néel, la sustancia es paramagnética.

Una forma especial de antiferromagnetismo es el ferrimagnetismo, un tipo de magnetismo mostrado por las ferritas. En estos materiales, o bien los momentos magnéticos de los iones adyacentes son antiparalelos y de intensidad desigual, o bien el número de momentos magnéticos en una dirección es mayor que el número de los que hay en la dirección opuesta.

Mediante una adecuada elección de los iones de tierras raras en las redes de ferrita es posible diseñar sustancias ferrimagnéticas con magnetizaciones específicas para su uso en componentes electrónicos.

Si nos queremos referir al geomagnetismo, estaremos hablando de la ciencia que estudia el campo magnético terrestre.

Si una barra de imán es suspendida en cualquier punto de la superficie terrestre, de forma que se pueda mover libremente en todos sus planos, el polo norte del imán apuntará en una dirección aproximadamente al norte. El ángulo (D) entre la dirección horizontal a la que apunta y el meridiano geográfico en ese punto se llama declinación magnética. Se toma positiva al este del norte geográfico y negativa al oeste. La aguja no estará horizontal salvo en el ecuador magnético. En todos los demás lugares formará un ángulo (/) con la horizontal, llamado inclinación magnética.

En todos los polos magnéticos / = 90º (+90º en el polo norte y -90º en el polo sur), y la aguja será vertical.

Las posiciones de los polos, que varían con el tiempo, eran en los años setenta aproximadamente 76, 1º N, 100º W (N) y 65, 8º S, 139º E (S). El vector intensidad (F) del campo geomagnético se determina por I, D y F, donde F es la intensidad magnética local del campo medida en gauss o teslas (1 gauss = 10-4 teslas). F, I y D, junto con las componentes verticales y horizontales de F y sus componentes norte y este, son llamados los elementos magnéticos.

Esta explicación del geomagnetismo podría ser más larga y completa, con muchos más datos técnicos y matemáticos, sin embargo, ¿a quién le gustaría? A eso me refería antes cuando decía “…mi primera preocupación es la de buscar la sencillez en lo que explico. No siempre lo consigo.“

Si el tema no interesa… cada cual irá a lo suyo

Si a continuación pongo un ejemplo práctico y explico el magnetismo de manera muy técnica y completa, que seguramente no sea del interés del lector de ciencia no iniciado. Éste no quiere estas complejidades que, por muy perfectas que puedan resultar técnicamente hablando, siempre les resultarán aburridas, tediosas, y lo que es peor, incomprensibles.

Los buenos escritores-divulgadores de la ciencia deben contar los fenómenos naturales revistiéndolos de un atractivo y misterioso toque mágico que se se muestre ante los ojos de la mente del lector y, produciéndoles asombro y sorpresa por tales maravillas queden embebidos en el relato y en las cosas maravillosas que allí se están tratando. Y, en Física, amigos míos, casi todo lo que te encuentras son maravillas de la Naturaleza que, cuando comienzas a comprender… ¡Es imposible dejar de mirar!

Si contamos la historia de una estrella, desde que nace a partir del gas y del polvo cósmico hasta que muere en una explosión de supernova para convertirse en otro objeto estelar diferente, al oyente le resultará atractivo o pesado, interesante o incomprensible, según quién y cómo lo cuente.

Me preocupa cuando escribo que lo que estoy contando pueda aburrir al posible lector.Siempre procuro ceñirme a la verdad científica y exponer los hechos con la veracidad requerida y, sin embargo, eso es totalmente posible aunque le podamos dar un pequeño toque de fantasía que lo hará más atractivo. Claro que, por mucho que queramos fantasear sabemos que en el mundo y en todo el Universo, las leyes que rigen son iguales para todo y para todos y lo que pasa aquí también pasará allí, aunque ese allí esté a miles de millones de años-luz de nosotros.

Aquí tenemos un ejemplo de lo que digo, la Naturaleza se repite

En los extraños mares de otros planetas, sin tener en cuenta la composición química, es difícil imaginar que la evolución de lugar a una forma más sencilla de locomoción que la que se produce ondulando colas y aletas. Que la propia evolución encontraría este tipo de propulsión viene avalado por el hecho de que, incluso en la Tierra, esta evolución se ha producción de manera totalmente espontánea e independiente. Los peces desarrollaron la propulsión cola-aleta; después, ellos mismos evolucionaron hasta convertirse en tipos anfibios que se arrastraban por tierra firme hasta llegar a ser reptiles. Lo cierto es que hemos llegado a saber que, de una u otra manera, ¡la vida se abre camino!

Por ejemplo, en nuestro planeta el ornitorrinco representa la primera rama de mamíferos a partir de un ancestro con características de ambos mamíferos y reptiles de hace 166 millones años. De alguna manera se mantiene una superposición de funciones, mientras que los mamíferos posteriores perdieron sus rasgos de reptil. Comparando el genoma del ornitorrinco con el ADN de otros mamíferos, incluidos los seres humanos que llegaron a lo largo del transcurso del tiempo, y los genomas de los pájaros, que bifurcan hace unos 315 millones años, ayuda a definir la evolución.

Algunos reptiles fueron evolucionando y dieron lugar a a los mamíferos. Pero cuando algunos de estos últimos regresaron al mar (los que luego han sido ballenas y focas, por ejemplo), sus piernas volvieron a evolucionar hacia las formas de las aleta destinadas a la propulsión por el medio acuático y a la navegación.

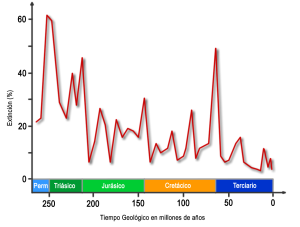

Aunque la vida tardó más de diez mil millones de años en hacer acto de presencia -al menos en la Tierra y, seguramente en otros planetas también- en sus formas más primitivas, supo adaptarse y evolucionar hasta llegar al momento presente en el que, sólo el uno por ciento de las especies que han existido en el planeta están vivas, el resto no pudo soportar los cambios y al no adaptarse, se extinguieron. Así seguirá siendo siempre: Adaptarse o morir.

Sí, es posible que hoy seamos nosotros la especie predominante en el planeta Tierra pero, no debemos olvidar que no siempre ha sido así. Antes ni estábamos aquí y, durante ciento ciencuenta millones de años reinaron en nuestro mundo aquellos terribles lagartos, los Dinosaurios que desaparecieron hace ahora sesenta y cinco millones de años para que nosotros, pudiéramos aparecer y evolucionar hasta conseguir hablar de mecánica cuántica y relatividad general pero… ¿Y mañana? ¿Seguiremos siendo la especie dominante?

Yo no estaría tan seguro de eso. El mañana es incierto

La Tierra con sus especies de vida seguirá su camino adelante, siempre hacia el futuro incierto y desconocido que dependerá de ¡tantas cosas! Y, mientras tanto, como hemos mantenido siempre, en otros mundos distintos al nuestro y repartidos por los confines de nuestra propia Galaxia y de muchas otras que albergan mundos ignotos, otras criaturas estarán elucubrando sobre las mismas cuestiones que nosotros lo hacemos para poder discernir sobre el saber del mundo, de la Naturaleza, del Universo.

¿Qué puede haber en Gliese 581 g? Hemos llegado a descubrir más de mil mundos extraterrestres que es como un grano de arena en la inmensa playa del Universo, y, cientos de miles de millones de mundos estan esparcidos por las galaxias que pueblan el Cosmos y, en muchos de ellos, extrañas y enigmáticas criaturas habrán podido desvelar secretos de la materia y de la luz, del átomo y de las estrellas y, también como nosotros estarán pensando en cómo poder llegar hacia esos otros mundos que albergan vida e inteligencia.

Quien sabe lo que, en otros mundos, nos podremos encontrar

Nosotros seguiremos avanzando aquí y “ellos” también lo harán “allí” donde quiera que ese “allí” pueda encontrarse que, será lejos, muy lejos. Tan lejos estamos de esos otros seres inteligentes que el hecho cierto de que no lo hayamos podido ver aún, nos habla de que, como nosotros, necesitan evolucionar mucho más para que, ese contacto se pueda producir.

Tampoco sería descabellado pensar que, la Naturaleza, tan sabia ella, tenga dispuesto que las especies estén cada una en su lugar, sin molestarse ni interferirse entre sí, que evolucionen en su propio entorno sin ingerencias que siempre vendrán a distorsionar lo que ya existe para cambiarlo en el mejor de los casos, o, aniquilarlo en el peor.

¿Quién sabe?

emilio silvera

Feb

21

¿Que pinta el Azar en todo esto?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (1)

Comments (1)

Todo lo que ocurre en la Naturaleza tiene una causa anterior, nada es fruto del Azar

Sí, la Naturaleza nos muestra constantemente su poder. Fenómenos que no podemos evitar y que nos hablan de unos mecanismos que no siempre comprendemos. Nuestro planeta por ejemplo, se comporta como si de un ser vivo se tratara, la llaman Gaia y realiza procesos de reciclaje y renovación por medio de terremotos y erupciones volcánicas, Tsunamis y tornados debastadores que cambian el paisaje y nosotros, lo único podemos hacer es acatar el destino que ignoramos de lo que está por venir.

El mundo nos parece un lugar complicado. Sin embargo, existen algunas verdades sencillas que nos parecen eternas, no varían con el paso del tiempo (los objetos caen hacia el suelo y no hacia el cielo, el Sol se levanta por el Este, nunca por el Oeste, nuestras vidas, a pesar de las modernas tecnologías, están todavía con demasiada frecuencia a merced de complicados procesos que producen cambios drásticos y repentinos. La predicción del tiempo atmosférico es más un arte que una ciencia, los terremotos y las erupciones volcánicas se producen de manera impredecible y aparentemente aleatoria, los cambios en las Sociedades fluctuan a merced de sucesos que sus componentes no pueden soportar y exigen el cambio.

La inmensa complejidad que está presente en el cerebro humano y de cómo se genera lo que llalamos “la mente”, a partir de una maraña de conexiones entre más de cien mil millones de neuronas, más que estrellas existen en nuestra Galaxia, la Vía Láctea. Es algo grande que, en realidad, no hemos alcanzado a comprender.

La mente humana es de tal complejidad que no hemos podido llegar a comprender su funcionamiento. ¿Por qué unas personas tienen una gran facilidad para tocar el piano, otros para comprender las matemáticas complejas y algunos para ver lo que nadie ha sido capaz de detectar en el ámbito de la Naturaleza, pongamos por ejemplo un paisaje, o, llegar a comprender fenómenos físicos que configuran el mundo, el Universo y la vida?