Jun

21

¿Habrá vida en otros mundos? ¡Qué pregunta! Sabemos que sí.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Vida en otros mundos ~

Clasificado en Vida en otros mundos ~

Comments (24)

Comments (24)

Bueno, sabemos que sí hay vida en otros mundos, al menos eso nos dice el sentido común al aplicar la lógica y la estadística. Nos queda confirmarlo, cosa que no será fácil debido a las enormes distancias con las que tenemos que bregar, y, mientras las tecnologías del futuro no estén disponibles, nos limitaremos a realizar conjeturas e hipótesis que, más o menos acertadas traten de acercarse a la realidad.

El primero que encontremos podría ser así

Sabemos que todas las Especies que viven en la Tierra están basadas en el Carbono. Si empleamos la lógica, y teniendo en cuenta que el Universo es igual en todas partes en relación a las fuerzas fundamentales y las constantes universales que lo rigen, salvo alguna excepción (que es posible), todos los mundos habitables seguirán el mismo camino evolutivo que la Toerra, y, salvo algunas peculuiaridades, sus habiotantes tendrían que ser parecidos a los que habitan la Tierra.

Jun

21

¡Las cosas del cerebro! Que siempre serán noticia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La realidad humana ¿es realidad? ~

Clasificado en La realidad humana ¿es realidad? ~

Comments (0)

Comments (0)

En una simulación neuronal sin precedentes, IBM ha logrado simular 500 mil millones de neuronas y 100 billones de sinapsis. Para ello ha utilizado Sequoia, el segundo superordenador más grande del mundo con millón y medio de núcleos. Esto es una proeza computacional, pero tiene poco que ver con la neurociencia. Veamos por qué.

El departamento de Cognitive Computing de IBM en Almaden dirigido por Dharmendra S. Modha lleva unos años realizando asombrosas simulaciones en el contexto del proyecto DARPA SyNAPSE. Como parte de este proyecto, anunció la simulación a la escala del córtex de un ratón, luego de una rata y más tarde de un gato.

El objetivo de este programa es crear un chip neurosináptico que supone una ruptura con la arquitectura tradicional de los ordenadores. Esta arquitectura es la llamada Von Neumann que usan la totalidad de los ordenadores en la actualidad, incluidos móviles y tarjetas. En la arquitectura Von Neumann la memoria está separada del procesador, el hardware del software y los programas están separados de los datos. Ha sido muy exitosa mientras se cumplía la miniaturización de componentes expresada en la ley de Moore: cada dos años se duplica el número de transistores en un espacio dado. El problema es que estamos llegando a los límites del átomo y que la ley dejará de cumplirse.

El chip neurosináptico es una ruptura total con la arquitectura Von Neumann. Se basa en el diseño de las neuronas en las que no hay distinción entre hw y sw, programas y datos, memoria y procesador. El chip consiste en una matriz de neuronas y entre sus cruces se realizan las sinapsis. De este modo, cada sinapsis del chip es hw y sw, proceso y memoria, programa y datos. Dado que todo está distribuido, no es necesaria un miniaturización tan extrema y sobre todo, un reloj tan rápido. Frente a los actuales gigahercios de frecuencia, las neuronas se disparan a un hercio, y en el caso del chip a 8 hercios. Además, los procesadores son clock driven, es decir, actúan bajo la batuta del reloj mientras que las neuronas son event driven, actúan solo si hay actividad que realizar.

Uno de los objetivos es reducir el consumo eléctrico. Un cerebro consume lo que una bombilla pequeña, 20 vatios. Un superordenador consume cientos de megavatios. El nuevo chip tiene un consumo muy reducido. Estos chips están construidos con tecnología de silicio clásica CMOS.

La arquitectura de muchos chips neurosinápticos unidos se ha llamado TrueNorth. Ya existe en desarrollo un chip de 256 neuronas, 1024 axones, y 256×1024 sinapsis.

El chip sin embargo no está en producción masiva. Para seguir trabajando en paralelo al desarrollo, se ha realizado la prueba actual. Para ello se ha usado un simulador llamado Compass. Compass traduce el comportamiento de un chip neurosináptico (no Von Neumann) a un ordenador clásico (Von Neumann). Usando Compass se ha simulado (pdf) el comportamiento de 2.000.000.000 chips. Esto supone 500 mil millones de neuronas y 100 billones de sinapsis, cifras por completo astronómicas. El resultado de la simulación se ha ejecutado 1.542 veces más lento que en tiempo real.

Para realizar la simulación se ha usado el segundo superordenador más grande del mundo, Sequoia un Blue Gene/Q de 96 armarios con 1 millón y medio de núcleos y 1,5 petabytes de memoria. Uno de los objetivos de la simulación es ver el escalado. Un problema habitual es que que cuando añadimos más cores, el sistema no funciona proporcionalmente más rápido. En el extremo, añadir más cores no aumenta el rendimiento: el sistema escala mal. Imagina un camarero atendiendo detrás de la barra. Si hay un segundo camarero, irán más rápido, pero no el doble. Si sigues añadiendo camareros, llegará un momento en que no aumente la eficiencia, incluso se verá reducida. El sistema escala mal. Pues bien, en la simulación realizada el escalado ha sido casi perfecto lo que es muy satisfactorio computacionalmente.

¿Qué tiene esto que ver con la neurociencia y el cerebro? Bien poco. La simulación no imita ningún comportamiento animal ni cognitivo ni humano. Para simular el comportamiento del cerebro, necesitamos saber cómo funciona y eso está lejos de lograrse. Para cuando llegue ese conocimiento debemos tener preparados ordenadores que sean capaces de simularlo y en este contexto se enmarca la presente investigación. Aunque no solo; la idea de diseñar estos nuevos chips es ponerlos en producción en aplicaciones comerciales tradicionales dando una gran potencia con un bajo consumo. La simulación del cerebro deberá esperar aún alguna década.

Fuente: Altioyo

Jun

21

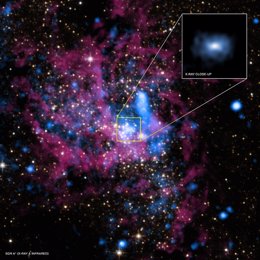

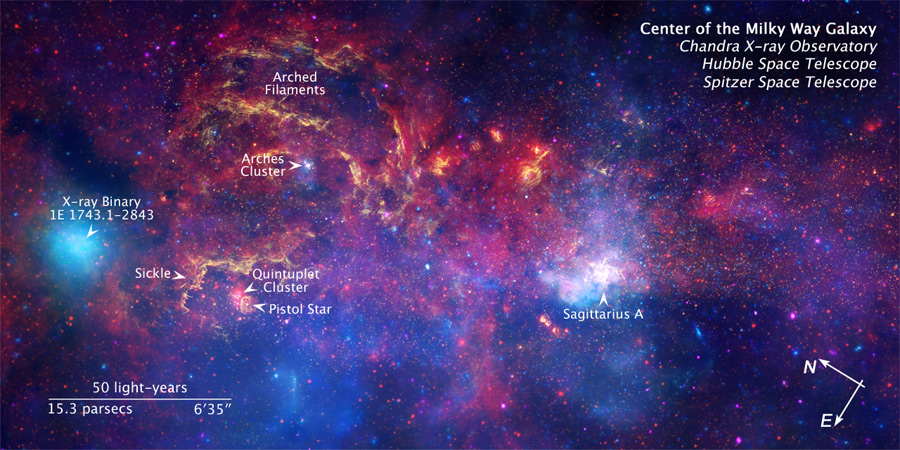

Sagitario A

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Agujeros negros ~

Clasificado en Agujeros negros ~

Comments (0)

Comments (0)

MADRID, (EUROPA PRESS)

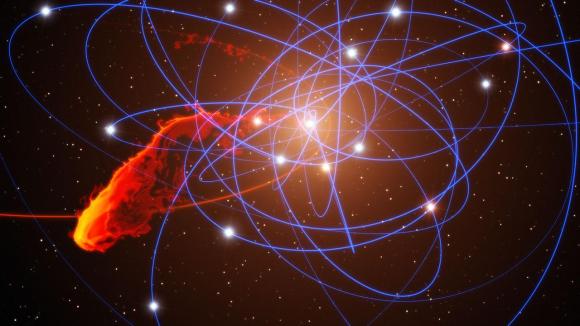

Los agujeros negros “no devoran todo lo que es lanzado hacia ellos”, según un estudio publicado en la revista ‘Science’ que se basa en la observación de Sagitario A, un agujero negro con 4 millones más de masa que el sol, situado a 26.000 años luz de la Tierra en la Vía Láctea.

“Contrariamente a lo que piensan algunas personas, los agujeros negros no devoran todo lo que es lanzado hacia ellos. Sagitario A* está aparentemente encontrando mucha comida difícil de engullir”, explica gráficamente Feng Yuan, investigador del Observatorio Astronómico de Shanghai y coautor del estudio.

Utilizando el teslescopio Chandra de rayos X de la NASA, los investigadores han descubierto que menos de un 1 por ciento del gas que rodea al agujero negro llega a alcanzar el punto de no retorno, también conocido como horizonte de sucesos, el lugar en el que es atrapada cualquier materia.

En lugar de eso, una gran cantidad de gases es expulsado antes de alcanzar el punto de no retorno. “La mayoría del gas debe ser lanzado fuera para que una pequeña parte pueda alcanzar el agujero negro”, explica Feng Yuan.

Este nuevo descubrimiento es el resultado de una ambiciosa campaña de observación con el teslescopio Chandra de rayos X que ha permitido a los investigadores recoger datos durante cinco semanas del agujero negro, el único descubierto hasta ahora los suficiente cerca de la Tierra como para poder observar en detalle lo que sucede a su alrededor.

Los investigadores captaron durante estas semanas imágenes de rayos X del gas supercaliente presente cerca del agujero negro. Según han podido observar los científicos, el agujero negro captura gas expulsado por estrellas cercanas y lo proyecta más allá de su punto de no retorno para que se enfríe y pueda ser absorbido.

El gas que tiene cerca Sagitario A* está muy caliente y difuso, por lo que es difícil para el agujero negro capturarlo y engullirlo, lo que convierte a este agujero negro de la Vía Láctea en “uno de los más fríos” vistos por el coautor del estudio Sera Markoff, de la Universidad de Amsterdam. Los agujeros negros capaces de activar cuásar y producir grandes cantidades de radiación tendrían a mano reservas de gases más fríos y densos que Sagitario A*, de acuerdo a la teoría de los investigadores.

La NASA ha señalado que el estudio tiene “importantes implicaciones en la comprensión de los agujeros negros”. Así por ejemplo, podría ayudar a enteder la sombra que se ve en el horizonte de sucesos que rodea a Sagitario A* y que contrasta con el brillo de la materia que envuelve al agujero negro.

Jun

21

¿En el Universo? ¡Cualquier cosa es posible!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Recreación artística del nudo cósmico en forma de oruga. | NASA

La última postal cósmica que acaba de enviar el telescopio espacial Hubble es una gran nube de polvo y gas interestelar con forma de oruga. Se trata del embrión de una futura estrella que aún se encuentra en proceso de formación, bombardeada por chorros de radiación ultravioleta proveniente de estrellas ultrabrillantes que esculpen la espectacular estructura de la ‘oruga’.

Según informa la NASA en un comunicado, estos astros, conocidos como como de ‘tipo O’, se encuentran entre las 65 estrellas más calientes y brillantes que se conocen, y se encuentran a 15 años luz de la nube de polvo y gas. Las estrellas ultrabrillantes, junto con otros 500 astros menos luminosos denominados de ‘tipo B’, componen la llamada asociación ‘Cygnus OB2’, un conjunto estelar que tiene una mása 30.000 veces mayor que nuestro sol.

Hay regiones en las que se pueden ver impresionantes fuegos “artificiales”

La impresionante ‘oruga cósmica’ es, por tanto, una estrella embrionaria en una etapa muy primitiva de su formación. Los astrónomos creen que las protoestrellas de esta región se convertirán en astros jóvenes, que tendrán aproximadamente una masa diez veces mayor que el Sol. Sin embargo, si la radiación de las estrellas vecinas erosiona su estructura antes de que terminen de formarse, su masa podría acabar siendo mucho más reducida.

Las observaciones captadas por el Hubble de la estrella embrionaria muestran que todavía está recogiendo gran cantidad de material. Sólo el tiempo dirá si el astro que surja finalmente de la ‘oruga’ será un “peso pesado” o “ligero” en lo que respecta a su masa.

ELMUNDO.es | Madrid

Totales: 74.930.962

Totales: 74.930.962 Conectados: 9

Conectados: 9