Oct

16

El año en que solo progresó el conocimiento

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticia comentada ~

Clasificado en Noticia comentada ~

Comments (0)

Comments (0)

Las Ondas Gravitacionales detectadas y los grandes avances en medicina y tecnología cambiaran el mundo

En mitad de la mediocridad política y la inquietud social, 2016 ha producido grandes avances en la física, la biología y la inteligencia artificial

Revisión del instrumental de LIGO. Caltech/MIT/LIGO Lab

Sí, este ha sido el año aciago del Brexit y Donald Trump, el año en que Europa ha consolidado su desprestigio y la población siria ha sido masacrada por su propio Gobierno con la ayuda de otros, en que la xenofobia, el nacionalismo y la miopía se han impuesto sobre la razón práctica, en que el autoritarismo se ha extendido por Hungría y Polonia como una plaga medieval, el año en que el paro y la pobreza se han instalado entre nosotros con la espontaneidad de una catástrofe natural. Y en que las únicas buenas noticias han provenido de la ciencia. En mitad del caos y la desesperanza, el conocimiento ha progresado con más firmeza que nunca. Aferrémonos a eso como a una ascua ardiendo.

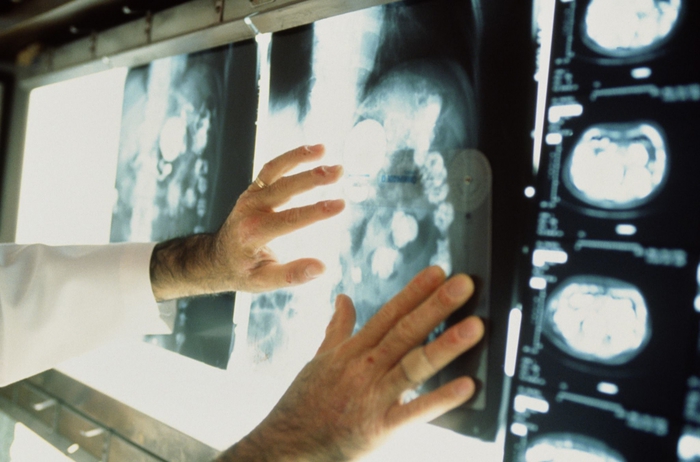

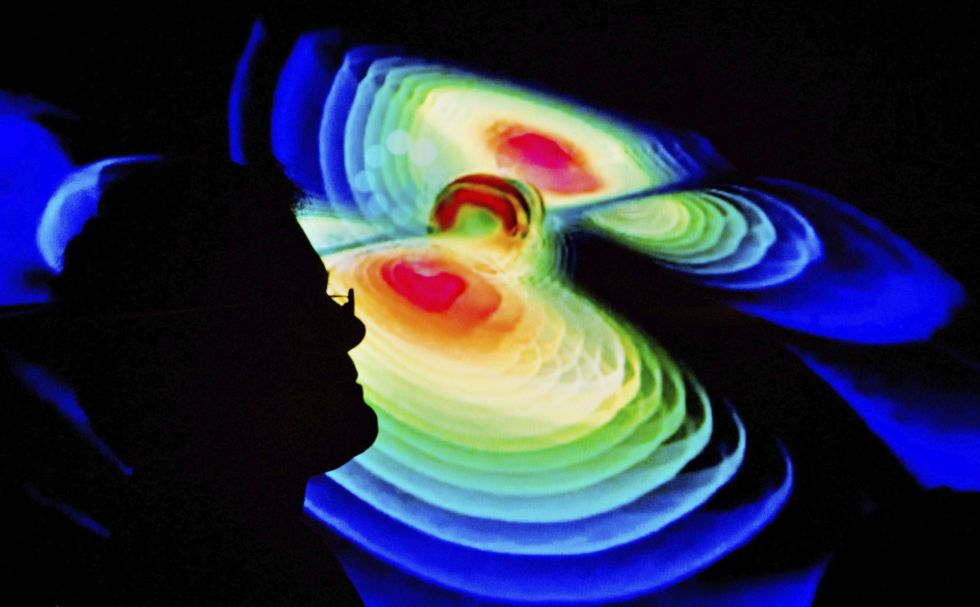

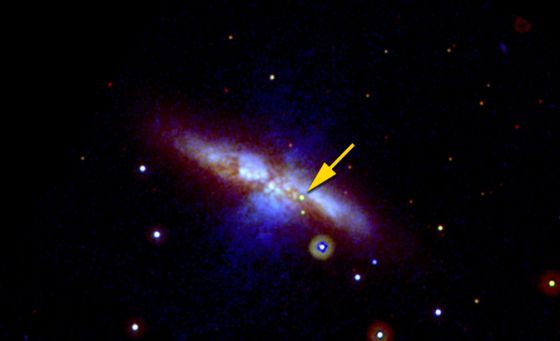

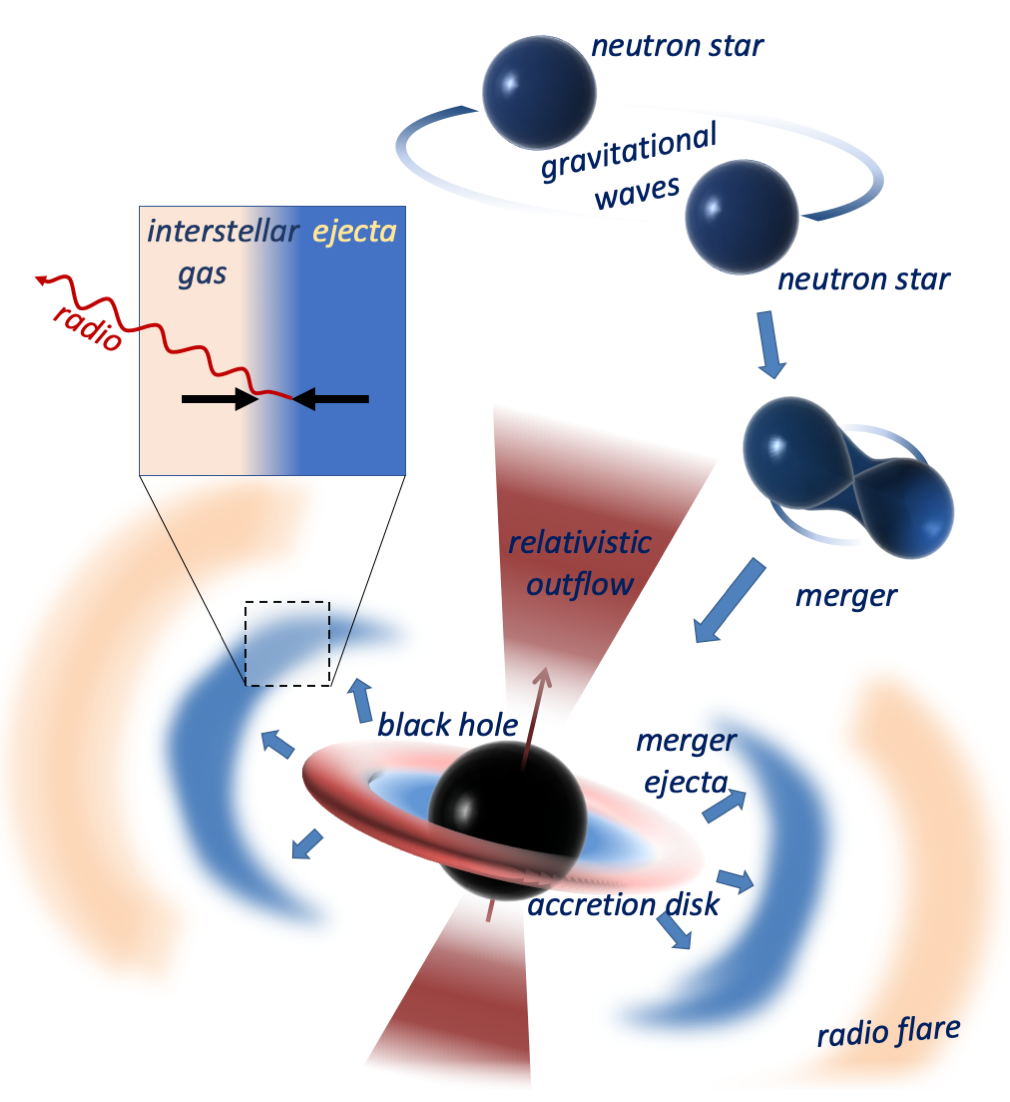

Llevamos décadas oyendo que, si el XX fue el siglo de la física, el XXI lo sería de la biología. Pero lo cierto es que la física goza en nuestros días de mejor salud que nunca. El mayor descubrimiento de 2016, según un consenso difícil de cuestionar, ha sido el de las ondas gravitatorias, una predicción de la relatividad general de Einstein que el propio Einstein consideró imposible de confirmar. Ha hecho falta un siglo, la colisión de dos agujeros negros gigantescos y un sistema de detección (el LIGO) que se cuenta entre las obras más brillantes y refinadas del intelecto humano, pero el fenómeno se ha confirmado por encima de toda duda razonable. La gravedad no es una fuerza instantánea, como pensó Newton, sino que se propaga en forma de ondulaciones del espacio-tiempo que viajan a la velocidad de la luz, como predijo Einstein. Es un paso de gigante en el conocimiento que, como es habitual, abrirá un nuevo continente de exploración y progreso.

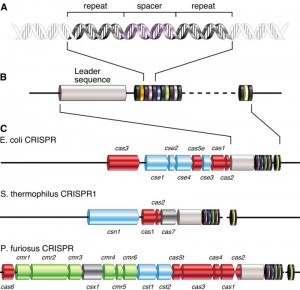

Las secuencias repetidas del CRISPR. Tomado de: Karginov FV y Hannon GJ. Mol Cell 2010

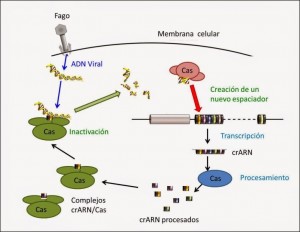

Cuando un virus entra dentro de la bacteria toma el control de la maquinaria celular y para ello interacciona con distintos componentes celulares. Pero las bacterias que tienen este sistema de defensa tienen un complejo formado por una proteína Cas unida al ARN producido a partir de las secuencias CRISPR. Entonces el material génico del virus puede interaccionar con este complejo. Si ocurre eso, el material genético viral es inactivado y posteriormente degradado. Pero el sistema va más allá. Las proteínas Cas son capaces de coger una pequeña parte del ADN viral, modificarlo e integrarlo dentro del conjunto de secuencias CRISPR. De esa forma, si esa bacteria (o su descendencia) se encuentra con ese mismo virus, ahora inactivará de forma mucho más eficiente al material genético viral. Es, por lo tanto, un verdadero sistema inmune de bacterias.

Proceso por el que el sistema CRISPR/Cas9 inactiva virus e integra parte de sus secuencias en el genoma de la bacteria.

Durante los años subsiguientes se continuó la investigación sobre este sistema, pero no fue hasta el año 2012 en el que se dio el paso clave para convertir este descubrimiento, esta observación biológica en una herramienta molecular útil en el laboratorio. En agosto de este año un equipo de investigadores dirigido por las doctoras Emmanuelle Charpentier en la Universidad de Umeå y Jennifer Doudna, en la Universidad de California en Berkeley, publicó un artículo en la revista Science el que se demostraba cómo convertir esa maquinaria natural en una herramienta de edición «programable», que servía para cortar cualquier cadena de ADN in vitro. Es decir, lograban programar el sistema para que se dirigiera a una posición específica de un ADN cualquiera (no solo vírico) y lo cortaran.

Jennifer Doudna y Emmanuelle Charpentier

La manera en que lo lograron es demasiado compleja para lo que pretende este blog. Baste simplemente decir que se utilizan unos ARNs que dirigen el sistema hacia el ADN que hay que cortar.

¿Cómo se edita el ADN con esta tecnología?

Todo comienza con el diseño de una molécula de ARN (CRISPR o ARN guía) que luego va a ser insertada en una célula. Una vez dentro reconoce el sitio exacto del genoma donde la enzima Cas9 deberá cortar.

El proceso de editar un genoma con CRISPR/Cas9 incluye dos etapas. En la primer atapa el ARN guía se asocia con la enzima Cas9. Este ARN guía es específico de una secuencia concreta del ADN, de tal manera que por las reglas de complementariedad de nucleótidos se hibridará en esa secuencia (la que nos interesa editar o corregir). Entonces actúa Cas9, que es una enzima endonucleasa (es decir, una proteína que es capaz de romper un enlace en la cadena de los ácidos nucléicos), cortando el ADN. Básicamente podemos decir que el ARN guía actúa de perro lazarillo llevando a Cas9, el ejecutor, al sitio donde ha de realizar su función.

Pero también es cierto que la biología está en un momento espléndido, y sobre todo en dos campos que prometen aplicaciones clínicas a medio plazo: la edición genómica y la reprogramación de células. En el primer caso, la estrella se llama CRISPR, y consiste en un sistema tan simple, eficaz y versátil que ha puesto la modificación del genoma humano (y de cualquier otro) al alcance de cualquier laboratorio de genética del planeta; su primera aplicación, sometida ya a una investigación muy activa, será sin duda la corrección de las mutaciones que causan las enfermedades raras: una forma por fin eficaz de terapia génica. En segundo lugar, la reprogramación de células –retrasar el reloj de una vulgar célula de la piel para convertirla en una célula madre— está logrando progresos espectaculares en la reparación de lesiones y el retraso del envejecimiento.

Sí, el Ordenador vence al campeón.

‘AlphaGo’ es el documental de Netflix que mejor explica lo que supuso la victoria de la IA de Google al campeón de Go

Pero este año no se puede hablar solo de física y biología, porque la inteligencia artificial ha irrumpido con poderío en la actualidad científica y tecnológica. Drones, robots y automóviles, por no hablar de teléfonos, relojes y casi cualquier otra cosa, exhiben ya notables habilidades cognitivas: hacen cosas que serían consideradas inteligentes si las hubiera hecho un humano (así definió la inteligencia artificial uno de sus creadores, el gran Marvin Minsky, que murió en enero de este año). Y los ordenadores se han hecho en 2016 con el título mundial de Go, una proeza mucho más espectacular que aquella de ganar a Kaspárov al ajedrez. Las discusiones filosóficas sobre la inteligencia de las máquinas parecen haberse enranciado de forma definitiva.

Inteligencia Artificial para solucionar problemas del cerebro, Ordenadores cuánticos… ¡U muchas cosas más! que, en unos pocos años (los que anden por aquí todavía) verán con asombro como cambia nuestro mundo y costumbres al pasar a otros niveles que ahora sin inimaginables para la gente corriente no versada en temas científicos.

El conocimiento ha seguido progresando entre la mediocridad política y el malestar social. Naturalmente, esto no tiene por qué seguir siendo así. Ya el Brexit puede constituir un lastre notable para la ciencia británica, y los planes xenófobos de Trump pueden convertirse en un escollo formidable para la norteamericana, pues buena parte de los grandes científicos de ese país son inmigrantes. Pero, de momento, 2016 ha ido bien para la ciencia. Es un consuelo.

Oct

16

Hay que recorrer un largo camino para saber

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo dinámico ~

Clasificado en El Universo dinámico ~

Comments (0)

Comments (0)

¡El futuro incierto!

El Futuro es el Tiempo por venir y nunca podremos saber cómo será o qué pasará en el “mañana” que está supeditado a parámetros aleatorios determinados por el Azar, lo imprevisto, lo que surge sin avisar. Y, teniendo en cuenta que un suceso “pequeño” en el inicio, puede ser un gran suceso a medida que el Tiempo transcurre, las incidencias finales pueden ser inimaginables.

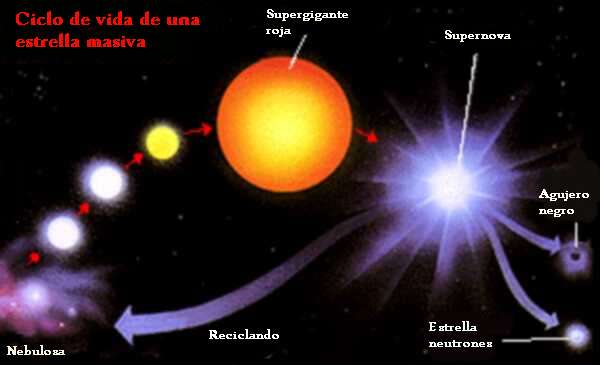

“La masa con la que nace una estrella determina su historia y, sobre todo, la duración de su vida. Llamamos estrellas masivas a todas aquellas estrellas aisladas que explotan como supernovas al final de su existencia debido al colapso gravitatorio. Para que exploten como supernovas deben tener un mínimo de alrededor de ocho masas solares. Estrellas con menos masa pueden explotar, pero no por sí mismas (deben darse otras condiciones). Y hay parámetros secundarios que pueden introducir cambios, pero la masa es determinante.”

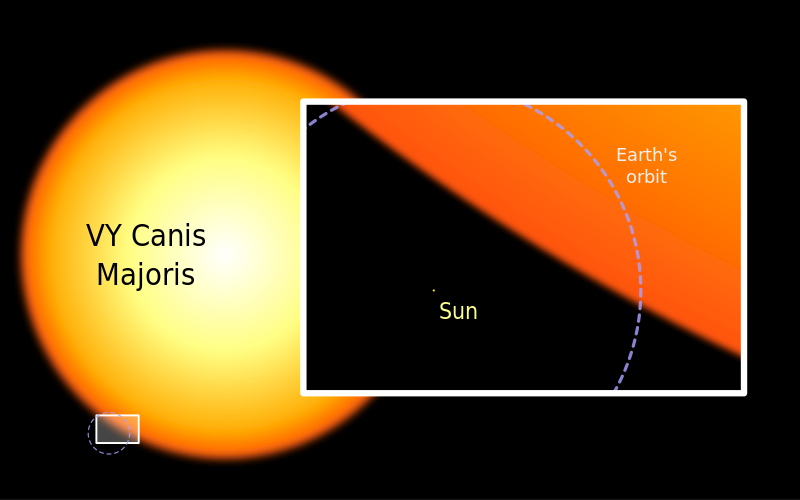

“En cuanto al máximo, el límite está en lo que la naturaleza sea capaz de producir. Hasta hace poco se creía que este límite estaba en torno a monstruos de 150 masas solares, aunque recientes trabajos lo elevan hasta 300. No obstante, no es un dato seguro ya que, cuanto más masiva es una estrella, menos vive, con lo cual estrellas más grandes serían difíciles de observar.”

Verdaderamente si pudiéramos contemplar de cerca, el comportamiento de una estrella cuando llega el final de su vida, veríamos como es, especialmente intrigante las transiciones de fase de una estrella en implosión observada desde un sistema de referencia externo estático, es decir, vista por observadores exteriores a la estrella que permanecen siempre en la misma circunferencia fija en lugar de moverse hacia adentro con la materia de la estrella en implosión.

La estrella, vista desde un sistema externo estático, empieza su implosión en la forma en que uno esperaría. Al igual que una pesada piedra arrojada desde las alturas, la superficie de la estrella cae hacia abajo (se contrae hacia adentro), lentamente al principio y luego cada vez más rápidamente. Si las leyes de gravedad de Newton hubieran sido correctas, esta aceleración de la implosión continuaría inexorablemente hasta que la estrella, libre de cualquier presión interna, fuera aplastada en un punto de alta velocidad. Pero no era así según las fórmulas relativistas que aplicaron Oppenheimer y Snyder.

En lugar de ello, a medida que la estrella se acerca a su circunferencia crítica su contracción se frena hasta hacerse a paso lento. Cuanto más pequeña se hace la estrella, más lentamente implosiona, hasta que se congela exactamente en la circunferencia crítica y, dependiendo de su masa, explosiona como supernova para formar una inmensa nebulosa o, se tranforma en nebulosa planetaria, más pequeña.

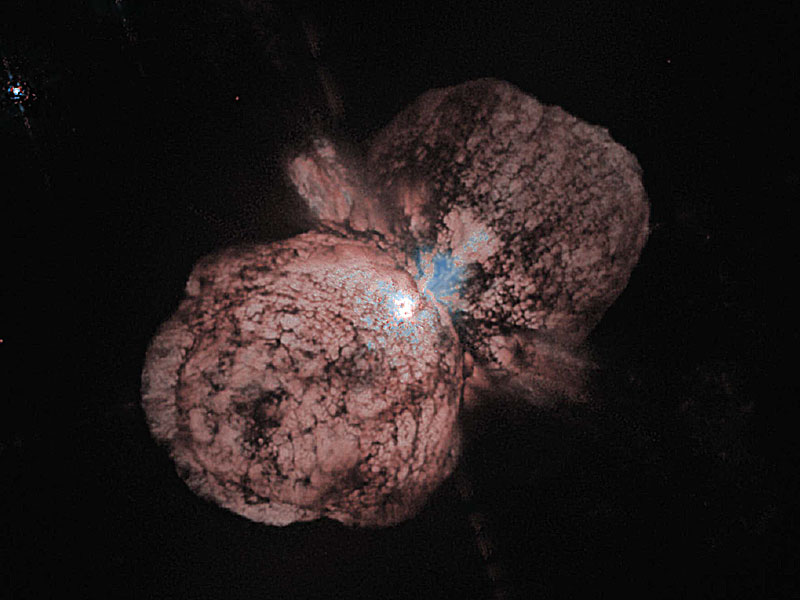

La gran erupción de Eta Carinae en la década de 1840 creó la nebulosa del Homúnculo, mostrada aquí en una imagen tomada por el Hubble. Con una longitud ahora de un año-luz, la nube en expansión contiene suficiente material para hacer por lo menos 10 copias de nuestro Sol. Los astrónomos aún no pueden explicar qué causó esta explosión. Crédito: NASA, ESA, y el Hubble SM4 ERO Team

Ahí podemos observar a una estrella muy joven, de dos o tres millones de años que, en un futuro lejano será una gran Supernova. Los procesos que podríamos observar al final de la vida de una estrella gigante… ¡Son fascinantes! Ese punto azulado que vemos envuelto en una masa de gas y polvo, no es otra cosa que la estrella Eta Carinae, una variable luminosa azul hipermasiva. Su masa puede osciular entre las 100 y 150 masas solares y, como el límite para la masa de una estrella está estipulado en 120 masas solares, ésta de arriba, para no ser destruida por su propia radiación y eyecta material al Espacio Interestelar para desahogo

En la escena que antes explicabámos, por mucho tiempo que nos quedemos esperando y comtemplando el suceso, si uno está en reposo fuera de la estrella (es decir, en reposo en el sistema de referencia externo estático), uno nunca podrá ver que la estrella implosiona a través de la circunferencia crítica. Ese fue el mensaje inequívoco que Oppenheimer y Snyder nos enviaron. Para poder ver eso, habría que estar dentro de la estrella, instalado en la materia que está sufriendo la contracción y, no sabemos porque eso es así.

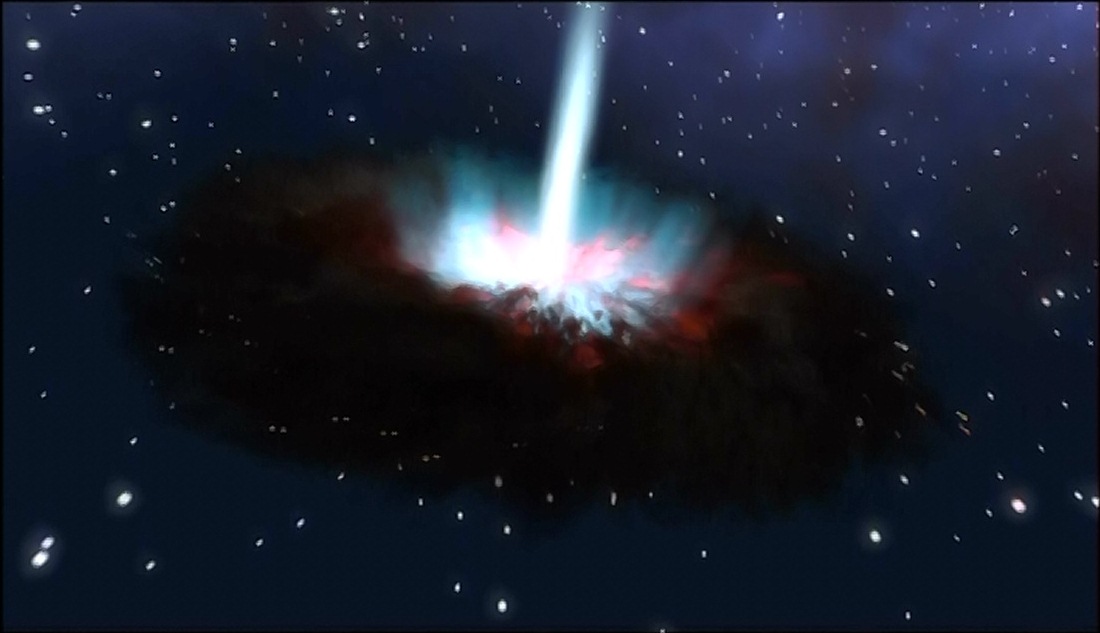

Cuando la estrella es muy masiva, su destino final es el de Agujero Negro

¿Se debe esta congelación de la implosión a alguna fuerza inesperada de la relatividad general en el interior de la estrella? No, en absoluto, advirtieron Oppenheimer y Snyder. Más bien se debe a la dilatación gravitatoria del tiempo (el frenado del flujo del tiempo) cerca de la circunferencia crítica. Tal como lo ven los observadores estáticos, el tiempo en la superficie de la estrella en implosión debe fluir cada vez más lentamente cuando la estrella se aproxima a la circunferencia crítica; y, consiguientemente, cualquier cosa que ocurre sobre o en el interior de la estrella, incluyendo su implosión, debe aparecer como si el movimiento se frenara poco a poco hasta congelarse.

Por extraño que esto pueda parecer, aún había otra predicción más extrañas de las fórmulas de Oppenheimer y Snyder: si bien es cierto que vista por observadores externos estáticos la implosión se congela en la circunferencia crítica, no se congela en absoluto vista por los observadores que se mueven hacia adentro con la superficie de la estrella. Si la estrella tiene una masa de algunas masas solares y empieza con un tamaño aproximado al del Sol, entonces vista desde su propia superficie implosiona hacia la circunferencia crítica en aproximadamente una hora, y luego sigue implosionando más allá de la criticalidad hacia circunferencias más pequeñas.

Allá por el año 1939, cuando Oppenheimer y Snyder descubrieron estas cosas, los físicos ya se habían acostumbrados al hecho de que el tiempo es relativo; el flujo del tiempo es diferente medido en diferentes sistemas de referencia que se mueven de diferentes formas a través del Universo. Claro que, nunca antes había encontrado nadie una diferencia tan extrema entre sistemas de referencia. Que la implosión se congele para siempre medida en el sistema externo estático, pero continúe avanzando rápidamente superando al punto de congelación medida en el sistema desde la superficie de la estrella era extraordinariamente difícil de comprender. Nadie que estudiara las matemáticas de Oppenheimer y Snyder se sentía cómodo con semejante distorsión extrema del tiempo. Pero ahí estaba, en sus fórmulas. Algunos podían agitar sus brazos con explicaciones heurísticas, pero ninguna explicación parecía muy satisfactoria. No sería completamente entendido hasta finales de los cincuenta.

En víspera del ataque a Pearl Harbour, John Wheeler trabajaba con su alumno Richard Feynman en lo que éste había bautizado como “suma de todas las historias”. En física cuántica, para calcular cómo algo que ocurre en A afecta a lo que está en B, tienes que sumar todas las alternativas físicamente posibles, aun las más peregrinas. Solo así hallas el resultado correcto. Es como si todas las historias posibles que van de A a B se produjeran al mismo tiempo. Y nos dice Wheeler que tan maravillado quedó con este resultado descubierto por Feynman, que de inmediato decidió acercarse a la casa de Einstein para contárselo. Después de pasar veinte minutos en su estudio dándole cuenta de este asombroso comportamiento de la realidad, Wheeler concluyó: “Profesor Einstein, viendo la mecánica cuántica desde esta nueva perspectiva, ¿no le parece completamente razonable aceptar la teoría?”

Enstein estuvo un rato digiriéndolo. “Todavía no puedo creerme que Dios juegue a los dados”, contestó. Y después de una pausa, añadió: “Creo que me he ganado el derecho de mantenerme en mis errores.” Einstein, como él mismo dijo en una ocasión, podía ser más terco que una mula. Así que, una vez más, no hubo manera de convencerlo de que, en su fundamento, la mecánica cuántica era correcta.

Fue Wheeler el que discrepó del trabajo de Oppenheimer y Snyder, alegando, con toda la razón que, cuando ellos habían realizado su trabajo, habría sido imposible calcular los detalles de la implosión con una presión realista (presión térmica, presión de degeneración y presión producida por la fuerza nuclear), y con reacciones nucleares, ondas de choque, calor, radiación y expulsión de masa. Sin embargo, los trabajos desde las armas nucleares de los veinte años posteriores proporcionaron justamente las herramientas necesarias.

Presión, reacciones nucleares, ondas de choque, calor radiación y expulsión de masa eran todas ellas características fundamentales de una bomba de hidrógeno; sin ellas, una bomba no explosionaría. A finales de los años cincuenta, Stirling Colgate quedó fascinado por el problema de la implosión estelar. Con el apoyo de Edward Teller, y en colaboración con Richard White y posteriormente Michael May, Colgate se propuso simular semejante implosión en un ordenador. Sin embargo, cometieron un error, mantuvieron algunas de las simplificaciones de Oppenheimer al insistir desde el principio en que la estrella fuera esférica y sin rotación, y, aunque tuvieron en cuenta todos los argumentos que preocupaban a Wheeler, aquello no quedó perfeccionado hasta después de varios años de esfuerzo y, a comienzo de los años sesenta ya estaban funcionando correctamente.

Un día a principio de los años sesenta, John Wheeler entró corriendo en la clase de relatividad de la Universidad de Princeton. Llegaba un poco tarde, pero sonreía con placer. Acababa de regresar de una visita a Livermore donde había visto los resultados de las simulaciones recientes de Colgate y su equipo. Con excitación en su voz dibujó en la pizarra un diagrama tras otro explicando lo que sus amigos de Livermore habían aprendido.

Cuando la estrella en implosión tenía una masa pequeña, desencadenaba una implosión de supernova y formaba una estrella de neutrones precisamente en la forma que Fritz Wicky había especulado treinta años antes. Sin embargo, si la estrella original era más masiva lo que allí se producía (aparte de la explosión supernova) era un agujero negro notablemente similar al altamente simplificado modelo que veinticinco años calcularon Oppenheimer y Snyder. Vista desde fuera, la implosión se frenaba y se quedaba congelada en la circunferencia crítica, pero vista por alguien en la superficie de la estrella, la implosión no se congelaba en absoluto. La superficie de la estrella se contraía a través de la circunferencia crítica y seguía hacia adentro sin vacilación.

Lo cierto fue que allí, por primera vez, se consiguió simular por ordenador la implosión que debía producir agujeros negros. Está claro que la historia de todo esto es mucho más larga y contiene muchos más detalles que me he saltado para no hacer largo el trabajo que, en realidad, sólo persigue explicar a ustedes de la manera más simple posible, el trabajo que cuesta obtener los conocimientos que no llegan (casi nunca) a través de ideas luminosas, sino que, son el resultado del trabajo de muchos.

Nebulosa planetaria y enana blanca, estrella de neutrones, hipotética estrella de Quarks, y, Agujero Negro

Hoy, sabemos mucho más de cómo finaliza sus días una estrella y, dependiendo de su masa, podemos decir de manera precisa que clase de Nebulosa formará, que clase de explosión (si la hay) se producirá, y, finalmente, si el resultado de todo ello será una estrella enana blanca que encuentra su estabilidad final por medio del Principio de exclusión de Pauli (en mecánica cuántica)que se aplica a los fermiones pero no a los Bosones (son fermiones los quarks, electrones, protones y neutrones), en virtud del cual dos partículas idénticas en un sistema, como los electrones en un átomo o quarks en un hadrón (protón o neutrón, por ejemplo), no pueden poseer un conjunto idéntico de números cuánticos.

La

estrella azul cerca del centro de esta imagen es Zeta Ophiuchi. Cuando se ve en luz visible aparece como una estrella roja relativamente débil rodeada de otras estrellas tenues y sin polvo. Sin embargo, en esta imagen infrarroja tomada con campo amplio por el Explorador Infrared Survey de la NASA, o WISE, un punto de vista completamente diferente emerge. Zeta Ophiuchi es en realidad una muy masiva y caliente estrella azul, brillante que traza su camino a través de una gran nube de polvo y gas interestelar.

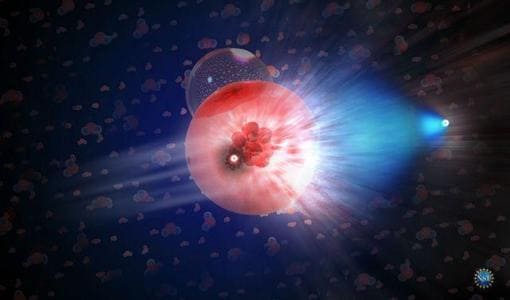

Una estrella masiva alejándose de su antiguo compañero se manifiesta haciendo un imponente surco a través de polvo espacial, como si se tratase de la proa de un barco. La estrella, llamada Zeta Ophiuchi, es enorme, con una masa de cerca de 20 veces la de nuestro Sol. En esta imagen, en los que se ha traducido la luz infrarroja a colores visibles que vemos con nuestros ojos, la estrella aparece como el punto azul en el interior del arco de choque. Zeta Ophiuchi orbitó una vez alrededor de una estrella aún más grande. Pero cuando la estrella explotó en una supernova, Zeta Ophiuchi se disparó como una bala. Viaja a la friolera velocidad de 24 kilómetros por segundo arrastrando con ella un conglomerado de polvo que distorsiona la región por la que pasa.

Mientras la estrella se mueve través del espacio, sus poderosos vientos empujan el gas y el polvo a lo largo de su camino en lo que se llama un arco de choque. El material en el arco de choque está tan comprimido que brilla con luz infrarroja que WISE puede captar. El efecto es similar a lo que ocurre cuando un barco cobra velocidad a través del agua, impulsando una ola delante de él. Esta onda de choque queda completamente oculta a la luz visible. Las imágenes infrarrojas como esta son importantes para arrojar nueva luz sobre lo que ocurre en situaciones similares.

Pero, siguiendo con el tema de las implosiones de las estrellas, ¿cuál es la razón por la que la materia no se colapsa, totalmente, sobre sí misma? El mismo principio que impide que las estrellas de neutrones y las estrellas enanas blancas implosionen totalmente y que, llegado un momento, en las primeras se degeneran los neutrones y en las segundas los electrones, y, de esa manera, se frena la compresión que producía la gravedad y quedan estabilizadas gracias a un principio natural que hace que la materia normal sea en su mayor parte espacio vacio también permite la existencia de los seres vivos. El nombre técnico es: El Principio de Exclusión de Pauli y dice que dos fermiones (un tipo de partículas fundamentales) idénticos y con la misma orientación no pueden ocupar simultáneamente el mismo lugar en el espacio. Por el contrario, los bosones (otro tipo de partículas, el fotón, por ejemplo) no se comportan así, tal y como se ha demostrado recientemente por medio de la creación en el laboratorio de los condensados de Bose-Einstein.

¿Cuál es la diferencia?

Los bosones son sociables; les gusta estar juntos. Como regla general, cualquier átomo con un número par de electrones+protones+neutrones es un bosón. Así, por ejemplo, los átomos del sodio ordinario son bosones, y pueden unirse para formar condensados Bose-Einstein.

Izquierda: Los bosones son sociables; los fermiones son antisociales.

Los fermiones, por otro lado, son antisociales. No pueden juntarse en el mismo estado cuántico (por el Principio de Exclusión de Pauli de la mecánica cuántica). Cualquier átomo con un número impar de electrones+protones+neutrones, como el potasio-40, es un fermión.

Pero, estábamos diciendo: “…no pueden poseer un conjunto idéntico de números cuánticos.” A partir de ese principio, sabemos que, cuando una estrella como nuestro Sol deja de fusionar Hidrógeno en Helio que hace que la estrella deje de expandirse y quede a merced de la Gravedad, ésta implosionará bajo el peso de su propia masa, es decir, se contraerá sobre sí misma por la fuerza gravitatoria pero, llegará un momento en el cual, los electrones, debido a ese principio de exclusión de Pauli que les impide estar juntos, se degeneran y se moverán de manera aleatoria con velocidades relativista hasta el punto de ser capaces de frenar la fuerza provocada por la gravedad, y, de esa manera, quedará estabilizada finalmente una estrella enana blanca.

Si hablamos de una estrella supermasiva, su produce la implosión arrojando las capas externas al espacio interestelar mientras que el grueso de la estrella se comprime más y más sin que nada la pueda frenar, aquí no sirve el Principipo de exclusión de Pauli para los fermiones y, es tal la fuerza gravitatoria que se desencadena como consecuencia de que la estrella supergigante no puede seguir fusionando y queda a merce4d de una sola fiuerza: La Gravedad, que ésta, la comprime hasta lo inimaginable para convertir toda aquella ingente masa en una singularidad, es decir, un punto de densidad y energía “infinitas” que ni la luz puede escapar de allí, y, el tiempo se ralentiza y el espacio se curva a su alrededor.

Si la estrella original es más masiva, la degeneración de los electrones no será suficiente para frenar la fuerza gravitatoria y, los electrones se fusionaran con los protones para convertirse en neutrones que, bajo el mismo principio de exclusión sufrirán la degeneración que frenará la fuerza de gravedad quedando entonces una estrella de neutrones. Por último, si la estrella es, aún más masiva, ni la degeneración de los neutrones será suficiente para frenar la inmensa fuerza gravitatoria generada por la masa de la estrella que, continuará la implosión contrayéndose cada vez más hasta desaparecer de nuestra vista convertida en un agujero negro.

¿Qué forma adoptará, qué transición de fase se produce en la materia dentro de una Singularidad?

¡Resulta todo tan complejo!

emilio silvera

Oct

15

Sabemos cómo evoluciona el Universo, observando las estrellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Evolución ~

Clasificado en Evolución ~

Comments (0)

Comments (0)

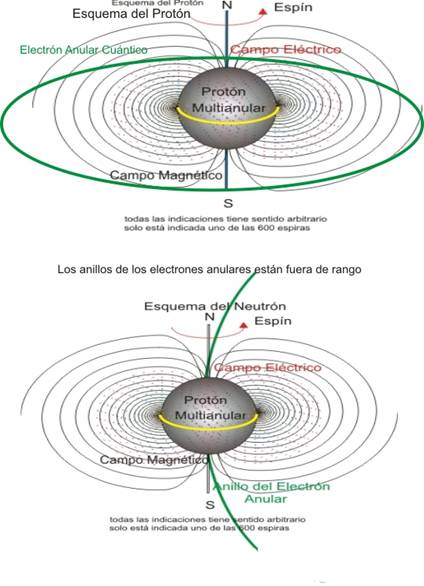

En física, el protón es una partícula subatómica con una carga eléctrica elemental positiva 1 (1,6 × 10-19 C), igual en valor absoluto y de signo contrario a la del electrón, y una masa 1836 veces superior a la de un electrón.

Se ve el protón como estable, con un límite inferior en su vida media de unos 1035 años, aunque algunas teorías predicen que el protón puede desintegrarse en otras partículas.2 Originalmente se pensó que el protón era una partícula elemental, pero desde la década de 1970 existe una evidencia sólida de que es una partícula compuesta. Para la cromodinámica cuántica el protón es una partícula formada por la unión estable de tres quarks.

El antiprotón es la antipartícula del protón. Se conoce también como protón negativo. Se diferencia del protón en que su carga es negativa y en que no forma parte de los núcleos atómicos. El antiprotón es estable en el vacío y no se desintegra espontáneamente. Sin embargo, cuando un antiprotón colisiona con un protón, ambas partículas se transforman en mesones, cuya vida media es extremadamente breve (véase Radiactividad). Si bien la existencia de esta partícula elemental se postuló por primera vez en la década de 1930, el antiprotón no se identificó hasta 1955, en el Laboratorio de Radiación de la Universidad de California, por Emilio Segre y Owen Chamberlain, razón por la cual se les concedió el Premio Nobel de Física en 1959.”

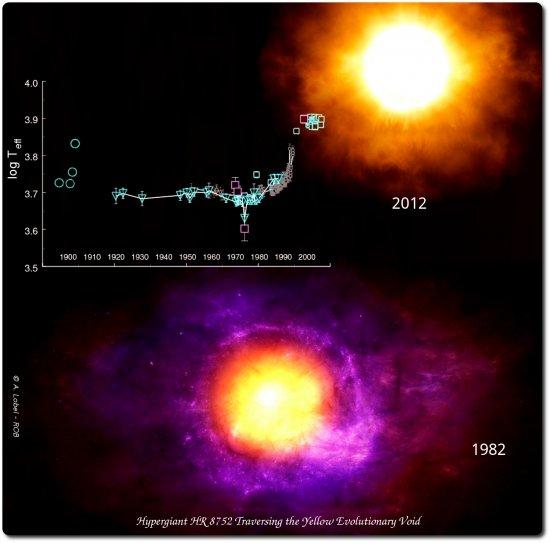

“La estrella hipergigante HR 8752 atravesando el Vacío Evolutivo Amarillo (YEV, por sus siglas en inglés) en una recreación artística. La gráfica muestra el aumento de temperatura que ha sufrido la superficie de la estrella en las últimas décadas.” /© A.Lob (1)

La estrella Hipergigante Amarila

“Es un tipo de estrella muy rara al hallarse en una fase muy temprana de su evolución, y existen dos tipos: las que están evolucionando de la secuencia principal a la fase de supergigante roja (como sucede con HD 33579 en la Gran Nube de Magallanes) y las que son consideradas como los núcleos de exestrellas supergigantes rojas, las cuales están evolucionando desde dicha fase a la de variable azul luminosa, o bien estrella Wolf-Rayet, o incluso presupernova (como sucede con Rho Cassiopeiae, IRC+10420, o HR 8752), en este caso sufriendo una gran pérdida de masa.”

“La mayor parte de los descubrimientos científicos son como fruta madura, caen, no se buscan… demasiado. El mérito está en encontrar el árbol adecuado al que arrimarse.”

Hace algún tiempo que salió la noticia en los medios: “Un equipo de científicos europeos, entre ellos investigadores del Instituto de Astrofísica de Canarias (IAC), ha hecho públicos los resultados de 30 años de investigación sobre la estrella hipergigante HR 8752, que han revelado el eslabón perdido en la evolución de este tipo de astros. Concretamente, han descubierto que, la región inestable conocida como Vacío Evolutivo Amarillo, puede cambiar profundamente la evolución de una estrella ya que, en estas tres décadas, HR 8752 ha aumentado de forma espectacular su temperatura superficial en 3.000 Kelvin (K) a su paso por esta región.” (1)

Los resultados obtenidos venían a desvelar algunos misterios que antes, no tenían explicación.

“Una hipergigante (hypergiant en inglés) es una estrella excepcionalmente grande y masiva, incluso mayor que una supergigante. Su masa puede ser de hasta 1000 veces la masa de nuestro Sol, próxima al límite máximo teórico, el cual establece que la cantidad de masa en una estrella no puede exceder las 120 M☉ (masas solares). Este límite en masa está asociado a la luminosidad de Eddington, por el que estrellas más masivas simplemente no pueden estar en equilibrio al vencer la presión de radiación interna a la fuerza gravitacional: producirían tanta energía que se desprenderían de la masa en exceso de las 120 M☉. Aun así, algunas hipergigantes aparentan tener más de 100 M☉ e, inclusive, haber tenido, inicialmente, entre 200 y 250 M☉, al contrario de lo que predicen las teorías actuales sobre la formación y evolución estelar.”

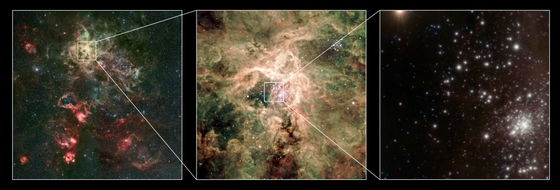

La nebulosa de la Quilla, también llamada nebulosa de Carina, nebulosa de Eta Carinae o NGC 3372

Aquí tenemos a R Leporis, una estrella de Carbono a la que se puso el nombre de la “Estrella Carmesí”, o, la “Gota de Sangre”.

R Leporis (R Lep / HD 31996 / HR 1607) es una estrella variable de la constelación de Lepus, cerca del límite con Eridanus. Visualmente es una estrella de un color rojo vívido, cuyo brillo varía entre magnitud aparente +5,5 y +11,7. Descubierta por John Russell Hind en 1845, es también conocida como Estrella carmesí de Hind.

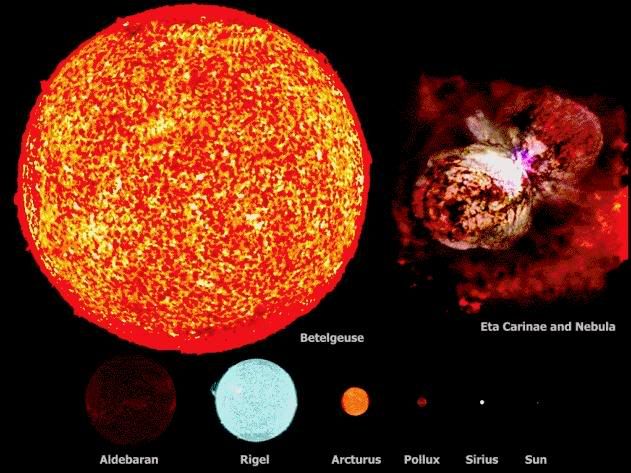

Del grupo destaca Antares, una supergigante M 1,5, 10 000 veces más luminosa que el Sol y con un diámetro que es probablemente más de 500 veces el del Sol. Nos contempla desde 520 a.l. de distancia y tiene una compañera enana. Su color es el rojo intenso.

Aldebaran, la estrella Alfa Tauri, es una Gigante K5. Aparentemente forma parte del grupo de estrella de las Hyades, aunque en realidad sólo está a 60 a.l., aprpoximadamente la mitad de la distancia del cúmulo.

Betelgeuse, la estrella Alfa Orionis, la décima más brillante del cielo, es una gigante tipo M2 que es una variable semirregular. Se dice que está a unos 400 a.l. de la Tierra y su luminosidad es 5000 veces superior a la del Sol pero, si se encuentra a la misma distancia de la Asociación de Orión (como algunos postulan), la luminosidad verdadera sería de 50 000 veces la del Sol. Su diámetro es cientos de veces el del Sol. Su brillo varía a medida que se expande y contrae en tamaño.

Arthurus es la estrella Alfa Boötis, magnitu -o,o4, la estrella más brillante al norte del ecuador celeste y la cuarta más brillante de todo el cielo. Es una gigante K 1 situada a 35 a.l.

Rigel, la estrella Beta Orionis de magnitud o,12 es una gigante B 8 situada a 1 400 a.l., su luminosidad es de unas 150 000 veces la del Sol, tiene una compañera de magnitud 6,8, que es a su vez una binaria espectroscópica.

Al lado de estas gigantes, el Sol y otras estrellas resultan minúsculos como podemos ver en la imagen y, sin embargo, ya sabemos todos la importancia que nuestro Sol tiene para hacer posible la vida en la Tierra.

¡No por pequeño se es insignificante! Ya sabéis: ¡Todo lo grande está hecho de cosas pequeñas!

El grupo de tres estrellas gigantes Pismis 24-1 (CSIC).

Mucho antes de que Russell descubriera la estrella carmesí y Johannes Hevelius quedara fascinado por Mira, la estrella maravillosa, los astrónomos árabes se fijaron en una estrella de la constelación de Perseo que cambiaba de brillo cada tres días, con una pauta muy regular y acentuada. Los árabes escribieron una de las escasas páginas destacadas de la astronomía medieval, paliando de alguna manera la importante decadencia que sufrió esta ciencia en ese período en Europa y el Mediterráneo en el periodo comprendido entre Ptolomeo y Copérnico, que duró un milenio y medio.

Bueno, hablar aquí de las estrellas que conocemos bien y de sus historias resulta entretenido y nos enseña un poco de la historia estelar en objetos individuales y determinados que, por una u otra razón tienen destacadas razones para que los astrónomos se fijaran en ellos. Por ejemplo, de Eta Carinae (antes mencionada y cuya imagen tenéis arriba), es una variable irregular hipergigante, que llegó a ser la segunda estrella más brillante del cielo. Es una variable azul luminosa con magnitud absoluta de -10, y es clasificada oficialmente como una estrella S Doradus. Se encuentra dentro de un cúmulo de estrellas masivas y una masa estimada en 100 masas solares, en tiempos se llegó a creer que era la estrella más masiva de la Galaxia. El único espectro visible es el de la Nebulosa del Homúnculo que la rodea. Eta Carinae es una intensa fuente infrarroja y su importante pérdida de masa (alrededor de 0,1 masas solares por año) tiene asociadas energías próximas a las de algunas supernovas y, teniéndola a unos 8000 años-luz, lo mejor será estar vigilante, ya que, aunque son distancias inmensas…Nunca se sabe lo que un monstruo de ese calibre nos podría enviar.

Estrellas masivas como Eta Carionae, Betegeuse, Arthurus, Antares y tantas otras que ahora sabemos que existen nos llevan a saber que, cuando mueren, se pueden convertir en otros objetos distintos como, por ejemplo:

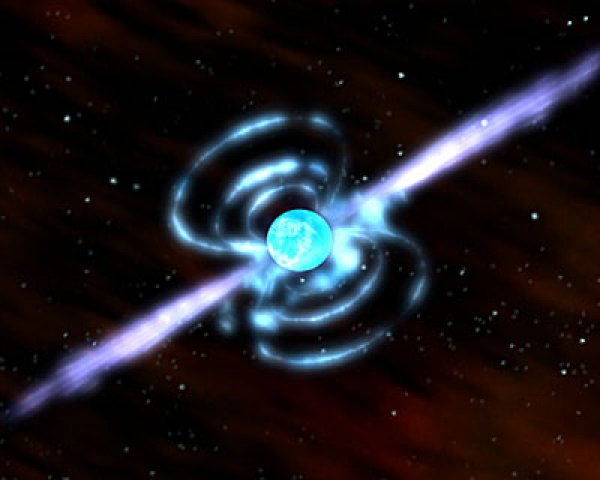

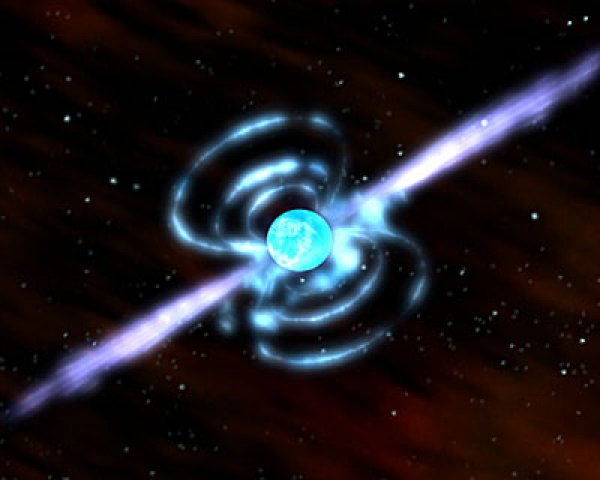

Estrellas de Neutrones

Estrellas que se forman a partir de estrellas masivas (2-3 masas solares) cuando al final de sus vidas, agotado el combustible nuclear de fusión, quedan a merced de la Gravedad que no se ve frenada por la fusión nuclear, y, en ese momento, la estrella comienza a contraerse bajo su propio peso, de forma tal que, los protones y electrones se funden y se convierten en neutrones que, al verse comprimidos tan violentamente, y, no pudiendo permitirlo por el principio de exclusión de Pauli, se degeneran y y hacen frente a la fuerza gravitatoria, consiguiendo así el equilibrio de lo que conocemos como estrella de nweutrones de intensom campo electromagnético y rápida rotación. Estos objetos, después de los Agujeros Negros, son los más densos que se conocen en el Universo, y, su masa podría pesar 1017 Kg/m3.

¿Estrella de Quarks?

Es hipotética, aún no se ha observado ninguna pero se cree que pueden estar por ahí, y, si es así, serían mucho más densas que las de neutrones, ya que, ni la degeneración de los neutrones podría parar la Fuerza de la Gravedad que sería frenada por los Quarks que también, son fermiones.

Si la estrella no es masiva, y tiene una masa como la del Sol, su final será la de convertirse en una ¡Estrella Enana Blanca!

Nebulosa planetaria y la enana blanca central

Nuestro Sol es de esta clase de estrellas y, tampoco su densidad se queda corta, ya que, alcanzan 5 x 108 Kg/m3. Aquí, cuando la estrella implosiona y comienza a comprimirse bajo su propio peso por la fuerza de Gravedad, como ocurrió con la estrella de Neutrones, aparece el Principio de Exclusión de Pauli, el cual postula que los fermiones (los electrones son fermiones) no pueden ocupar el mismo lugar estando en posesión del mismo número cuántico, y, siendo así, se degeneran y hace que, la compresión de la estrella por la Gravedad se frene y vuelve el equilibrio que la convierte en estrellas enana blanca.

El fenómeno de convertirse en enana blanca ocurre cuando la estrella original tiene una mása máxima posible de 1,44 masas solares, el límite de Shandrashekar, si fuera mayor se convertiría en estrella de neutrones. Y, siendo mayor la masa de 3-4 masas solares, su destino sería un agujero negro.

Las Nebulosas planetarias nos ofrecen una amplia gama de figuras con sus enanas blanca centrales

Nos despediremos con estas bellas imágenes de sendas Nebulosas Planetarias como, un día lejano aun en el futuro, nos mostrará nuestro Sol al llegar al término de su vida. Ese será su final: Una bonita Nebulosa Planetaria con una estrella enana blanca en en el centro.

Claro que, tampoco ese será el final para el Universo en el que, nuevas estrellas seguirán naciendo para hacer posible que, mundos como la Tierra puedan, con su luz y su calor, hacer surgir formas de vida que, como la nuestra, pueda alcanzar la consciencia de Ser y, a partir de ahí… comenzará otra nueva aventura que será digna de contar.

emilio silvera

Oct

13

El Universo siempre está presente

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo ~

Clasificado en El Universo ~

Comments (2)

Comments (2)

Hace mucho tiempo ya desde que mirábamos el cielo asombrados ante un eclipse de Sol. Cada civilización a lo largo de la Historia entendió el fenómeno natural de una manera distinta, según los conocimientos que poseían, 0, también, según interesaba a los mandatarios de turno.

Hechiceros y chamanes, religiosos y estudiosos más tardes eran los que determinaban el significado de todos los fenómenos que se podían contemplar, con miedo y con asombro al principio, y, sabiendo lo que se veía mucho después.

El primer eclipse solar de la década creó el “anillo de fuego” en la provincia de Jiangsu, China. Este evento es conocido como un eclipse anular, ya que el anillo brillante o anillo de luz del sol sigue siendo visible incluso cuando la Luna está directamente entre la Tierra y el sol. La órbita de la Luna no es un círculo perfecto, lo que significa la distancia exacta a la Tierra cambia. Durante un eclipse anular, la Luna está más lejos de la Tierra, por lo que su tamaño aparente es menor que el disco visible del sol.

Ahora, pasado el tiempo, nuestra innata curiosidad nos ha llevado a descubrir que vivimos en un planeta que pertenece a una estrella de una galaxia que forma parte de un grupo de treinta galaxias (el “Grupo Local”) y que a su vez, están inmersas en un Universo que cuenta con decenas de miles de millones de Galaxias como la nuestra.

Oct

12

¿La Mecánica Cuántica? ¡Una gran disciplina!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Universo, Ciencia, Consciencia…¡Futuro!

El Universo es todo lo que existe: Espacio-tiempo y materia “inerte” y “animada”, grandes objetos dinámicos como las estrellas y galaxias, también los mundos, y, en todo ese complejo escenarios de diferentes “cosas”, están las fuerzas fundamentales y las constantes universales que hacen que todo sea como lo podemos observar.

Si la masa del Protón, o, la carga del electrón, variaran aunque sólo fuera una diezmillonésima… ¡La Vida, tal como la conocemos no existiría.

La Ciencia nunca ha estado en posesión de la verdad absoluta, ha tenido que ir construyendo un espinoso y doloroso camino de pequeños descubrimientos mediante el experimento y la observación que nos ha situado en un nivel aceptable para poder dar el salto para poder desvelar los secretos de la Naturaleza que se nos resisten en todas las disciplinas del saber humano. Sabemos que las preguntas siguen siendo más abundantes que las respuestas.

De la Conciencia se ha escrito mucho y sabe muy poco. El funcionamiento de la Conciencia que lo escenificamos con el diablillo que nos habla a la oreja, nos aparece cuando no actuamos bien y nos queda esa amargura de la culpabilidad. También es la consciencia es saber de algo, ver de manera clara y precisa el significado de un todo complejo.

Parece que conciencia tenemos todos y, sin embargo, en unos se deja “ver” más que en otros que la tienen acomodaticia y apegada a sus propios intereses. Otros, no podemos soportar esas molestas voces en nuestro interior que recriminan un acto.

De la otra Consciencia, la que se refiere a la comprensión, es muy cara y no todos hemos podido desarrollar un intelecto que nos permite comprender algunas cuestiones complejas, y,. cuando eso pasa… divagamos y planteamos conjeturas de lo que podría ser.

¡El Futuro! Un Tiempo por venir, que no existe, y, cuando llega… ¡Se ha convertido en Presente! Ahora mismo, mientras escribo ésta línea de mis pensamientos, estoy en el Presente que, de inmediato… ¡Se ha ido al Pasado! Y, lo que escribiré en el Futuro sólo existe en mi imaginación que cuando sea plasmado en la superficie en blanco, será de nuevo Presente.

Estamos confinados en un Eterno Presente que recuerda el Pasado e imagina el Futuro incierto, ese tiempo que nunca podremos conocer, sólo imaginarlo podemos y, sin ninguna certeza de lo que pueda ser, ya que, las variantes son infinitas y, también el Azar, está ahí.

La fascinación que desde siempre ha producido el Tiempo en los grandes Pensadores ha sido grande, y, ninguno de ellos pudo reflejar (con acierto pleno) lo que el Tiempo es.

El “principio antrópico”

¿Estaría programada la presencia de los seres vivos inteligentes en el Universo?

Por fuerza la cosmología conduce a cuestiones fronterizas entre ciencia experimental, filosofía y religión. No es solo el caso de los sabios antiguos. También los físicos de hoy se plantean preguntas de esa clase, sobre todo a propósito del llamado “principio antrópico”. A partir de los conocimientos actuales, este principio señala que las leyes y magnitudes físicas fundamentales parecen cuidadosamente afinadas para que la formación y el desarrollo del universo pudieran dar lugar a la vida en la Tierra y en otros planetas idóneos para acogerla.

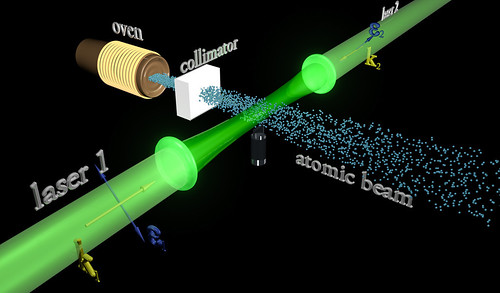

El universo de las partículas es fascinante. Cuando las partículas primarias chocan con átomos y moléculas en el aire, aplastan sus núcleos y producen toda clase de partículas secundarias. En esta radiación secundaria (aún muy energética) la que detectamos cerca de la Tierra, por los globos enviados a la atmósfera superior, han registrado la radiación primaria. Esa radiación, al chocar con los elementos que envuelven nuestro planeta y su atmósfera, en algunos lugares de la Tierra producen las fascinantes auroras boreales y australes.

Esta espectacular aurora boreal fue captada sobre la aldea de Ersfjordbotn cerca de Tromso, en el norte de Noruega, en el amanecer del 21 de febrero. Las auroras son causadas por la interacción entre las partículas energéticas cargadas del Sol y las moléculas de gas en la atmósfera superior de la Tierra, a unos 100 kilómetros de altura.El viento solar exhalado por el sol con especial volumen hace poco a una velocidad de aproximadamente 500 kilómetros por segundo colaboró en la espectacularidad en este caso.

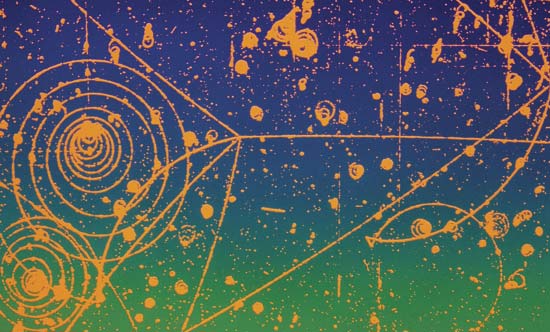

Trayectorias de las partículas cargadas en un campo magnético — Cuaderno de Cultura Científica

Al llegar a la Tierra, las partículas cargadas son atraídas por el campo magnético terrestre en los polos, donde chocan con las moléculas de gas en la atmósfera superior, haciendo que emitan luz.

El físico estadounidense Robert Andrews Millikan, que recogió una gran cantidad de información acerca de esta radiación (y que le dio el nombre de rayos cósmicos), decidió que debería haber una clase de radiación electromagnética. Su poder de penetración era tal que, parte del mismo, atravesaba muchos centímetros de plomo. Para Millikan, esto sugería que la radiación se parecía a la de los penetrantes rayos gamma, pero con una longitud de onda más corta.

Otros, sobre todo el físico norteamericano Holly Compton, no estaban de acuerdo en que los rayos cósmicos fuesen partículas. Había un medio para investigar este asunto; si se trataba de partículas cargadas, deberían ser rechazadas por el campo magnético de la Tierra al aproximarse a nuestro planeta desde el espacio exterior. Compton estudió las mediciones de la radiación cósmica en varias latitudes y descubrió que en realidad se curvaban con el campo magnético: era más débil cerca del ecuador magnético y más fuerte cerca de los polos, donde las líneas de fuerza magnética se hundían más en la Tierra.

Rayos cósmicos contra las células cuando se producen grandes erupciones solares

Las partículas cósmicas primarias, cuando entran en nuestra atmósfera, llevan consigo unas energías fantásticas, muy elevadas. En general, cuanto más pesado es el núcleo, más raro resulta entre las partículas cósmicas. Núcleos tan complejos como los que forman los átomos de hierro se detectaron con rapidez; en 1.968, otros núcleos como el del uranio. Los núcleos de uranio constituyen sólo una partícula entre 10 millones. También se incluirán aquí electrones de muy elevada energía.

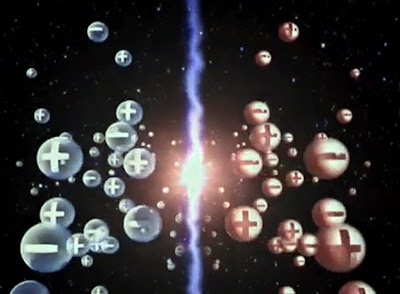

Ahora bien, la siguiente partícula inédita (después del neutrón) se descubrió en los rayos cósmicos. A decir verdad, cierto físico teórico había predicho ya este descubrimiento. Paul Adrien Dirac había aducido, fundándose en un análisis matemático de las propiedades inherentes a las partículas subatómicas, que cada partícula debería tener su antipartícula (los científicos desean no sólo que la naturaleza sea simple, sino también simétrica). Así pues, debería haber un antielectrón, salvo por su carga que sería positiva y no negativa, idéntico al electrón; y un antiprotón, con carga negativa en vez de positiva.

La ecuación de Dirac que predijo la existencia del Positrón

En 1.930, cuando Dirac expuso su teoría, no llamó demasiado la atención en el mundo de la ciencia. Pero, fiel a la cita, dos años después apareció el antielectrón. Por entonces, el físico americano Carl David Anderson trabajaba con Millikan en un intento por averiguar si los rayos cósmicos eran radiación electromagnética o partículas. Por aquellas fechas, casi todo el mundo estaba dispuesto a aceptar las pruebas presentadas por Compton, según las cuales, se trataría de partículas cargadas; pero Millikan no acababa de darse por satisfecho con tal solución.

Arriba una imagen que ilustra a la Heliosfera, la parte del espacio que está directamente afectada por el Sol a través del viento solar. Es la estructura magnética del viento solar quien hace de escudo contra las enérgicas partículas de los rayos cósmicos. Las variaciones en el viento solar (o en la actividad solar) cambia el flujo de los rayos cósmicos que llegan hasta la Tierra.

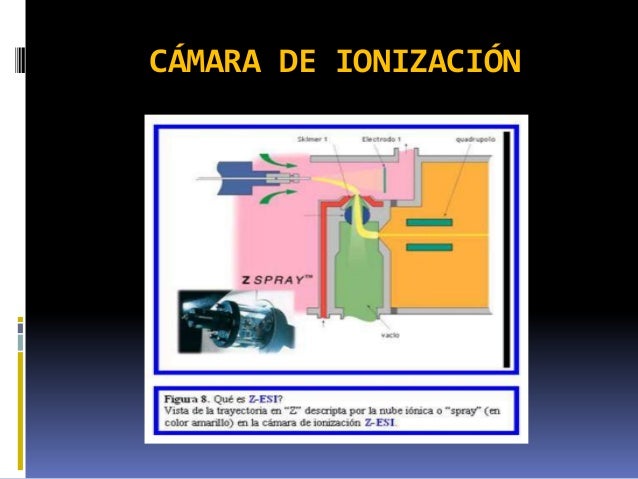

Anderson se propuso averiguar si los rayos cósmicos que penetraban en una cámara de ionización se curvaban bajo la acción de un potente campo magnético. Al objeto de frenar dichos rayos lo suficiente como para detectar la curvatura, si la había, puso en la cámara una barrera de plomo de 6’35 mm de espesor. Descubrió que, cuando cruzaba el plomo, la radiación cósmica trazaba una estela curva a través de la cámara; y descubrió algo más. A su paso por el plomo, los rayos cósmicos energéticos arrancaban partículas de los átomos de plomo. Una de esas partículas dejó una estela similar a la del electrón. ¡Allí estaba, pues, el antielectrón de Dirac! Anderson le dio el nombre de positrón. Tenemos aquí un ejemplo de radiación secundaria producida por rayos cósmicos. Pero aún había más, pues en 1.963 se descubrió que los positrones figuraban también entre las radiaciones primarias.

“Un positrón es una partícula de tipo elemental (ya que no existen evidencias de que esté compuesta por otras partículas más simples) cuya carga eléctrica resulta igual a la que posee el electrón, aunque positiva. Por esta característica, se dice que el positrón es la antipartícula de esta partícula subatómica.”

Abandonado a sus propios medios, el positrón es tan estable como el electrón (¿y por qué no habría de serlo si el idéntico al electrón, excepto en su carga eléctrica?). Además, su existencia puede ser indefinida. Ahora bien, en realidad no queda abandonado nunca a sus propios medios, ya que se mueve en un universo repleto de electrones. Apenas inicia su veloz carrera (cuya duración ronda la millonésima de segundo), se encuentra ya con uno.

“Primer Congreso Solvay (1911), financiado por el “rey de la sosa cáustica”, el belga Ernest Solvay y en el que tomaron parte todas las luminarias de la ciencia. Nernst, Poincaré, Langevin, Rutherford, Lorentz, Planck y Marie Curie están en primera fila de la fotografía y no es difícil reconocer a Einstein junto a ellos. Terminado el Congreso, Marie relató a Louis de Broglie los debates sobre el fotón y su naturaleza dual, de onda y partícula.

De Broglie, ante los resultados de Compton, se preguntaba en la tesis doctoral que presentó en 1924 si acaso la inversa del efecto Compton sería cierta: si las ondas son partículas ¿no serán ondas las partículas? Al recibir el premio Nobel en 1929, Louis de Broglie diría: “Para ambas, materia y radiación, la luz en especial, es necesario introducir los conceptos de partícula y de onda a la vez. En otras palabras, se tiene que suponer siempre la existencia de partículas acompañadas por ondas.”

Iguales con carga eléctrica diferentes

Así, durante un momento relampagueante quedaron asociados el electrón y el positrón; ambas partículas girarán en torno a un centro de fuerza común. En 1.945, el físico americano Arthur Edwed Ruark sugirió que se diera el nombre de positronio a este sistema de dos partículas, y en 1.951, el físico americano de origen austriaco Martin Deutsch consiguió detectarlo guiándose por los rayos gamma característicos del conjunto.

Pero no nos confundamos, aunque se forme un sistema positronio, su existencia durará, como máximo, una diezmillonésima de segundo. El encuentro del electrón-positrón provoca un aniquilamiento mutuo; sólo queda energía en forma de radiación gamma. Ocurre pues, tal como había sugerido Einstein: la materia puede convertirse en energía y viceversa. Por cierto, que Anderson consiguió detectar muy pronto el fenómeno inverso: desaparición súbita de rayos gamma para dar origen a una pareja electrón-positrón. Este fenómeno se llama producción en pareja. Anderson compartió con Hess el premio Nobel de Física de 1.936.

1936. Victor Franz Hess & Carl David Anderson

Poco después, los Joliot-Curie detectaron el positrón por otros medios, y al hacerlo así realizaron, de paso, un importante descubrimiento. Al bombardear los átomos de aluminio con partículas alfa, descubrieron que con tal sistema no sólo se obtenían protones, sino también positrones. Cuando suspendieron el bombardeo, el aluminio siguió emitiendo positrones, emisión que sólo con el tiempo se debilitó. Aparentemente habían creado, sin proponérselo, una nueva sustancia radiactiva. He aquí la interpretación de lo ocurrido según los Joliot-Curie: cuando un núcleo de aluminio absorbe una partícula alfa, la adición de los dos protones transforma el aluminio (número atómico 13) en fósforo (número atómico 15). Puesto que las partículas alfa contienen cuatro nucleones en total, el número masivo se eleva 4 unidades, es decir, del aluminio 27 al fósforo 31. Ahora bien, si al reaccionar se expulsa un protón de ese núcleo, la reducción en una unidad de sus números atómicos y masivos hará surgir otro elemento, o sea, el silicio 30.

Arriba teneis el proceso conocido como triple alfa: Una maravilla de la que se vale la Naturaleza para fabricar el Carbono en las estrellas.

Puesto que la partícula alfa es el núcleo del helio, y un protón es el núcleo del hidrógeno, podemos escribir la siguiente ecuación de esta reacción nuclear:

aluminio 27 + helio 4 = silicio 30 + hidrógeno 1

Nótese que los números másicos se equilibran:

27 + 4 = 30 + 1

Adentrarse en el universo de las partículas que componen los elementos de la tabla periódica, y en definitiva, la materia conocida, es verdaderamente fantástico.

Joliot – Curie

Tan pronto como los Joliot-Curie crearon el primer isótopo radiactivo artificial, los físicos se lanzaron en tropel a producir tribus enteras de ellas. En realidad, las variedades radiactivas de cada elemento en la tabla periódica son producto de laboratorio. En la moderna tabla periódica, cada elemento es una familia con miembros estables e inestables, algunos procedentes de la naturaleza, otros sólo del laboratorio. Por ejemplo, el hidrógeno presenta tres variedades: en primer lugar, el corriente, que tienen un solo protón. En 1.932, el químico Harold Urey logró aislar el segundo. Lo consiguió sometiendo a lenta evaporación una gran cantidad de agua, de acuerdo con la teoría de que los residuos representarían una concentración de la forma más pesada del hidrógeno que se conocía, y, en efecto, cuando se examinaron al espectroscopio las últimas gotas de agua no evaporadas, se descubrió en el espectro una leve línea cuya posición matemática revelaba la presencia de hidrógeno pesado.

núcleos de hidrógeno pesado.

El núcleo de hidrógeno pesado está constituido por un protón y un neutrón. Como tiene un número másico de 2, el isótopo es hidrógeno. Urey llamó a este átomo deuterio (de la voz griega deutoros, “segundo”), y el núcleo deuterón. Una molécula de agua que contenga deuterio se denomina agua pesada, que tiene puntos de ebullición y congelación superiores al agua ordinaria, ya que la masa del deuterio es dos veces mayor que la del hidrógeno corriente. Mientras que ésta hierve a 100º C y se congela a 0º C, el agua pesada hierve a 101’42º C y se congela a 3’79º C. El punto de ebullición del deuterio es de -23’7º K, frente a los 20’4º K del hidrógeno corriente. El deuterio se presenta en la naturaleza en la proporción de una parte por cada 6.000 partes de hidrógeno corriente. En 1.934 se otorgó a Urey el premio Nobel de Química por su descubrimiento del deuterio.

Reacciones de fusión nuclear

Reacciones de deuterio – tritio:

Esta es una de las dos reacciones de fusión nuclear más básicas que se conocen: en ella intervienen como reactivos un núcleo de deuterio (D) y uno de tritio (T). Si dichos reactivos se aproximan entre sí a velocidades adecuadas, se unen formando un núcleo compuesto (centro), que es inestable y se desintegra rápidamente produciendo un núcleo de helio (He) y un neutrón. El proceso de formación del núcleo compuesto se denomina fusión nuclear (de deuterio y tritio en el caso que estamos considerando). El tritio es radioactivo, el deuterio no. Esta es una de las dos reacciones de fusión nuclear más básicas que se conocen: en ella intervienen como reactivos un núcleo de deuterio.

El deuterio resultó ser una partícula muy valiosa para bombardear los núcleos. En 1934, el físico australiano Marcus Lawrence Edwin Oliphant y el austriaco P. Harteck atacaron el deuterio con deuterones y produjeron una tercera forma de hidrógeno, constituido por un protón y dos neutrones. La reacción se planteó así:

hidrógeno 2 + hidrógeno 2 = hidrógeno 3 + hidrógeno 1

Este nuevo hidrógeno superpesado se denominó tritio (del griego tritos, “tercero”); su ebullición a 25º K y su fusión a 20’5º K.

Reacciones de deuterio – deuterio:

En ella, dos núcleos de deuterio se fusionan formando un núcleo compuesto inestable (centro) que rápidamente decae siguiendo uno de dos posibles caminos: el ilustrado en la parte superior, que produce un núcleo de helio y un neutrón; y el indicado en la parte de abajo, donde se produce un núcleo de tritio y un protón. El camino que seguirá el núcleo compuesto para decaer, es impredecible con exactitud. Sólo puede afirmarse que el 50% de las veces, la naturaleza sigue el de arriba, y el 50% restante, el de abajo.

Reactor de fusión Tokamaka

Instalaciones donde se produce la fusión nuclear: Lograr fusión nuclear en la Tierra es complicado: se requieren reactores especiales.

Como es mi costumbre, me desvío del tema y sin poderlo evitar, mis ideas (que parecen tener vida propia), cogen los caminos más diversos. Basta con que se cruce en el camino del trabajo que realizo un fugaz recuerdo; lo sigo y me lleva a destinos distintos de los que me propuse al comenzar. Así, en este caso, me pasé a la química, que también me gusta mucho y está directamente relacionada con la física; de hecho son hermanas: la madre, las matemáticas, la única que finalmente lo podrá explicar todo.

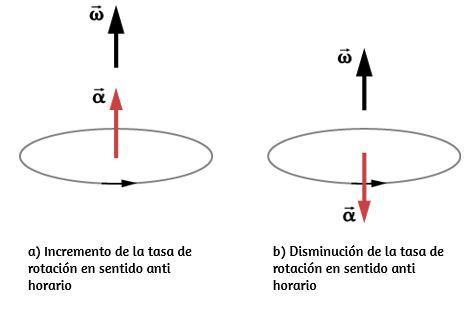

Estamos hablando de las partículas y no podemos dejar a un lado el tema del movimiento rotatorio de las mismas. Usualmente se ve cómo la partícula gira sobre su eje, a semejanza de un trompo, o como la Tierra o el Sol, o nuestra galaxia o, si se me permite decirlo, como el propio universo. En 1.925, los físicos holandeses George Eugene Uhlenbeck y Samuel Abraham Goudsmit aludieron por primera vez a esa rotación de las partículas. Éstas, al girar, generan un minúsculo campo electromagnético; tales campos han sido objeto de medidas y exploraciones, principalmente por parte del físico alemán Otto Stern y el físico norteamericano Isaac Rabi, quienes recibieron los premios Nobel de Física en 1.943 y 1.944 respectivamente, por sus trabajos sobre dicho fenómeno.

Esas partículas (al igual que el protón, el neutrón y el electrón), que poseen espines que pueden medirse en números mitad, se consideran según un sistema de reglas elaboradas independientemente, en 1.926, por Fermi y Dirac; por ello, se las llama y conoce como estadísticas Fermi-Dirac. Las partículas que obedecen a las mismas se denominan fermiones, por lo cual el protón, el electrón y el neutrón son todos fermiones.

Hay también partículas cuya rotación, al duplicarse, resulta igual a un número par. Para manipular sus energías hay otra serie de reglas, ideadas por Einstein y el físico indio S. N. Bose. Las partículas que se adaptan a la estadística Bose-Einstein son bosones, como por ejemplo la partícula alfa.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de esta teoría en vez de los de la mecánica clásica. En estadística cuántica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier número de partículas puede ocupar un estado cuántico dad. Dichas partículas (como dije antes) son bosones, que tienden a juntarse.

Los bosones tienen un momento angular nh/2π, donde n es 0 o un entero, y h es la constante de Planck. Para bosones idénticos, la función de ondas es siempre simétrica. Si sólo una partícula puede ocupar un estado cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n + ½)h / 2π y cualquier función de ondas de fermiones idénticos es siempre antisimétrica. La relación entre el espín y la estadística de las partículas está demostrada por el teorema espín-estadística.

El Spín

El Spín es una propieded intrínseca de las partículas elementales, es una propiedad física, esta propiedad fué introducidad por Ulembeck y Gouldsmith, descubrieron el spín del electrón, que hace referencia a sus propiedades de giro. Su valor está cuantizado, es decir solo puede tener como valor números enteros o semienteros. Para electrones, protones y neutrones este valor es de 1/2. Existen otros valores para otras partículas elementales, las matrices de Pauli nos dicen conceptos del spin del electrón.

En un espacio de dos dimensiones es posible que haya partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el nombre de aniones; para aniones idénticos, la función de ondas no es simétrica (un cambio de fase de +1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo estado cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental para explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7 K) se puede formar un condensado de Bose-Einstein, en el que varios miles de átomos dorman una única entidad (un superátomo). Este efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Si nos fijamos en todo lo que estamos hablando aquí, es fácil comprender cómo forma un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón tiene masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea como fuere, la rotación del neutrón nos da la respuesta a esas preguntas.

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos.

Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma forma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. Desde entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, para tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

emilio silvera

Totales: 75.611.696

Totales: 75.611.696 Conectados: 4

Conectados: 4