Nov

2

Desde el Pasado… Siempre hacia el Futuro

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Futuro ~

Clasificado en Futuro ~

Comments (0)

Comments (0)

Ahora todos hablamos del LHC. Sin embargo, la historia de los aceleradores no comenzó con éste moderno y complejo conglomerado de sofisticadas estructuras que hacen posible que visitemos lugares muy lejanos en el corazón de la materia. Tendríamos que recordar al acelerador lineal también llamado LINAC (linear accelerator) es un tipo de acelerador que le proporciona a la partícula subatómica cargada pequeños incrementos de energía cuando pasa a través de una secuencia de campos eléctricos alternos.

Mientras que el generador de Van de Graaff proporciona energía a la partícula en una sola etapa, el acelerador lineal y el ciclotrón proporcionan energía a la partícula en pequeñas cantidades que se van sumando. El acelerador lineal, fue propuesto en 1924 por el físico sueco Gustaf Ising. El ingeniero noruego Rolf Wideröe construyó la primera máquina de esta clase, que aceleraba iones de potasio hasta una energía de 50.000 eV.

De cómo llegamos hasta los Quarks

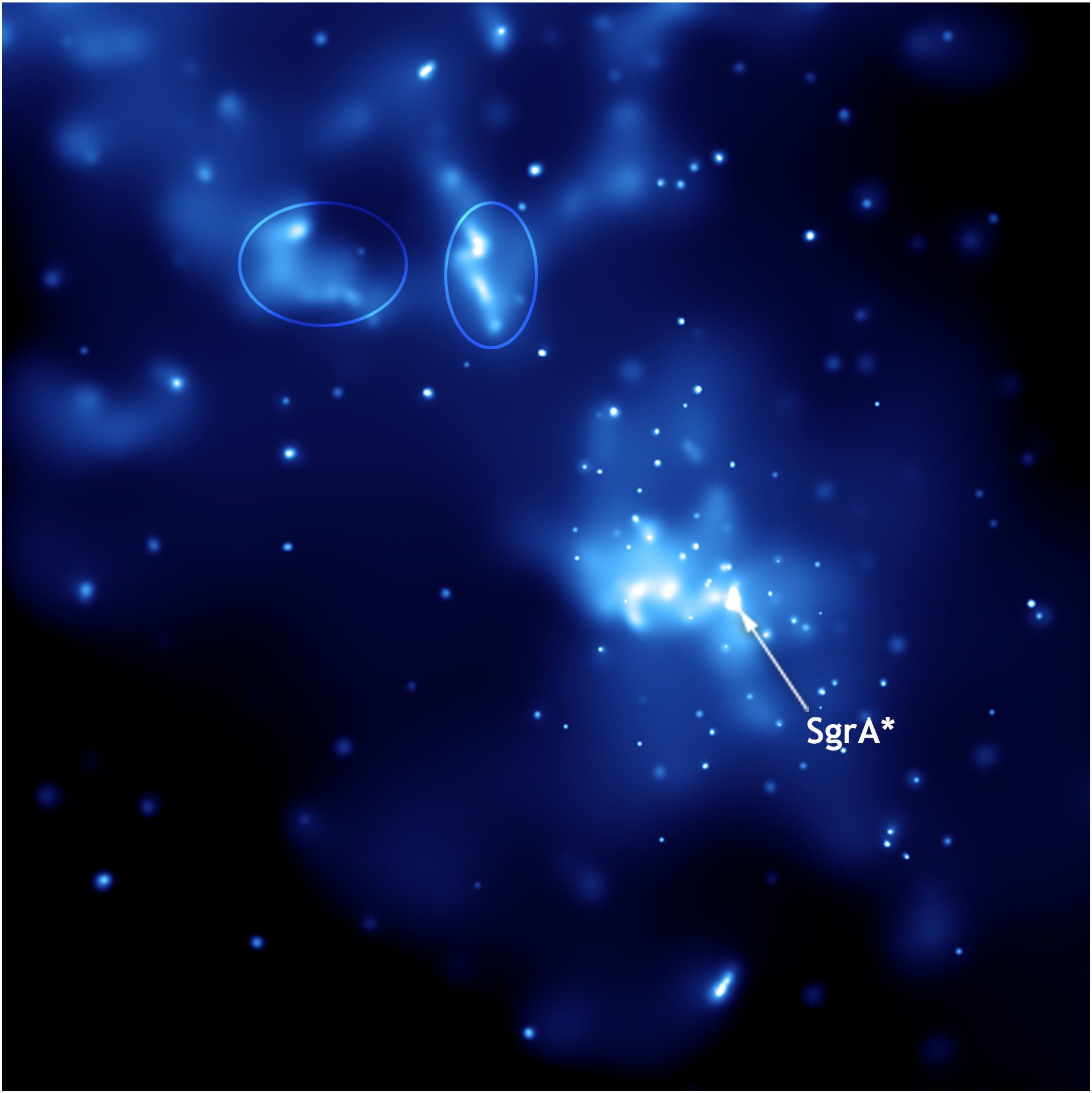

La técnica de la interferometría de muy larga base a longitudes de onda milimétricas (mm-VLBI) ha permitido obtener imágenes de los motores centrales de las galaxias activas con una resolución angular de decenas de microsegundos de arco. Para aquellos objetos más cercanos (M87, SgrA) se obtienen resoluciones lineales del orden de las decenas de Radios de Schwarzschild, lo que permite estudiar con detalle único la vecindad de los agujeros negros supermasivos.

Veamos que nos cuenta: “Desde el pasado pero…, ¡siempre hacia el futuro!”

Pueden leer documentos antiguos sin abrirlos

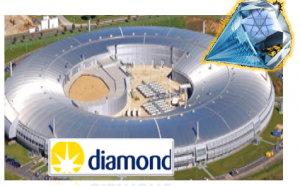

“La pregunta suena algo tonta ¿verdad?, pero no es nada imposible para la ciencia y la tecnología. La respuesta es SI, ¿cómo? A través de una fuente luminosa de diamantes.

Esta fuente luminosa de diamantes o “Diamond Light Source” es un acelerador de partículas que produce intensos rayos de luz. Es así que se inició este experimento en el año 2007 con el Diamond synchroton que puede generar una luz 100 mil millones de veces más brillantes que un rayo X estándar médico.

La utilidad de producir intensos rayos de luz, es para estudiar las propiedades de materiales microscópicos en varios campos como la estructura biológica , medicina, nano ciencia, química, entre otras, sin embargo a través de estos rayos podemos apreciar la lectura de libros sin necesidad de abrirlos. Pero, ¿Para qué serviría?, pues una de las utilidades es en la arqueología ya que es importante preservar los antiguos libros escritos y ante cualquier contacto se podrían desgastar y/o malograr.

El 13 de setiembre de 2007, científicos de la universidad de Cardiff , se descubrió esta funcionalidad del Diamond Synchroton para descubrir el contenido oculto de los documentos antiguos sin necesidad de abrirlos.”

Imagem cedida por Diamond Light Source

Acelerador de partículas construido en las instalaciones del Diamond Ligth Source en Oxfordshire (Inglaterra). Llamado la Fuente luminosa de diamante, el Diamond synchrotron comenzó a funcionar en enero de 2007. La luz que puede generar este artefacto es 100 mil millones de veces más brillante que un rayo X estándar médico.

Un acelerador de partículas (como todos sabemos) es, a grandes rasgos, una máquina que mediante campos electromagnéticos acelera partículas hasta que alcanzan velocidades inimaginables. Luego, por ejemplo, hacen chocar estas partículas y así se consigue saber de qué está formada la materia en sus partes más diminutas (mucho más diminutas que un átomo). Eso es lo que hace el LHC.

Sin embargo, en el caso de este acelerador, los científicos esperaban usar la luz del Diamond synchrotron para “leer” los textos antiguos que han sufrido el daño significativo. Porque los potentes rayos Xpermitirán hacerlo sin ni siquiera abrir el libro. El synchrotron emite un rayo X tan poderoso que, al incidir en una voluta, permite producir una imagen de 3-D del texto.

La técnica ya había sido aplicada satisfactoriamente en textos escritos con la tinta de hierro, que los escribanos comenzaron a usar en el siglo XII. Algunas de las tintas hechas con extractos vegetales y sales de hierro utilizadas en el Siglo XII deterioran el tipo de pergamino utilizado, imposibilitando la lectura de documentos valiosos. Simplemente he querido incluir esta introducción para que os hagais una idea de hasta donde puede llegar nuestro ingenio.

Nov

1

¿Qué nuevos caminos nos esperan?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Futuro incierto ~

Clasificado en El Futuro incierto ~

Comments (1)

Comments (1)

Aunque no pocas cosas en el Universo están escenificadas en ciclos que se repiten una y otra vez: Estrellas masivas que al final de sus vidas explotan como supernovas, dejan una enorme y bonita Nebulosa de la que vuelven a surgir nuevas estrellas y mundos y, la estrella se convierte en otra cosa distinta de lo que fue. Así ha venido pasando desde que que el Universo dinámico, con sus leyes y constantes, deja que las cosas transcurran tranquilas y siempre, con el “tiempo presente y vigilante” que, al no querer estar sólo, se acompaña del espacio y, también, de la Entropía.

“Quien ha visto las cosas presentes ha visto todo, todo lo ocurrido desde la eternidad y todo lo que ocurrirá en el tiempo sin fin; pues todas las cosas son de la misma clase y la misma forma”.

Marco Aurelio

Claro que él, quería significar que todo, desde el comienzo del mundo, ha sido igual, sigue unos patrones que se repiten una y otra vez a lo largo del transcurso de los tiempos: el día y la noche, el hombre y la mujer, el frío y el calor, el río muerto por la sequía o aquel que, discurre rumoroso y ve correr sus aguas cristalinas hasta que desembocan en el océano. La Bondad y la maldad…Así ha sido siempre y, así continuará siendo.

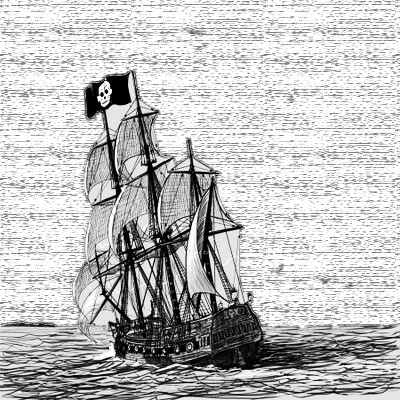

Bueno, este podría ser el bajel de la canción del Pirata de Espronceda

Para fugarnos de la tierra

un libro es el mejor bajel;

y se viaja mejor en el poema

que en más brioso corcel.

Whitman

Todo estado presente de una sustancia simple es naturalmente una consecuencia de su estado anterior, de modo que su presente está cargado de su futuro.

Leibniz

Niels Bohr citando a Goethe preguntaba: ¿Cuál es el camino? No hay ningún camino. Está claro el mensaje que tal pregunta y tal respuesta nos quiere hacer llegar, el camino, tendremos que hacerlo nosotros mediante la exploración hacia el futuro en el que está lo que deseamos encontrar. Hay que explorar y arriesgarse para descubrir tenemos que ir más allá de las regiones habituales y conocidas que nos tienen estancados siempre en el mismo lugar. ¡Arrisguemosnó!

Ulises de Ítaca se arriesgó a oír el canto de las sirenas amarrado al palo de la vela mayor de su embarcación.

Pero, no cabe duda alguna de que, el acto de exploración modifica la perspectiva del explorador; Ulises, Marco Polo y Colón habían cambiado cuando volvieron a su hogar. Lo mismo ha sucedido en la investigación científica de los extremos en las escalas, desde la grandiosa extensión del espacio cosmológico hasta el mundo minúsculo y enloquecido de las partículas subatómicas.

Una bella galaxia espiral de cien mil años-luz de diámetro que podemos comparar con…Un átomo.

Entre ambos “universos” existe una descomunal diferencia en los extremos de las escalas. Sin embargo, la inmensa galaxia de arriba no sería posible sin la existencia de infinitesimal átomo de abajo. Todo lo grande está hecho de cosas pequeñas.

Así que, cuando hacemos esos viajes, irremediablemente nos cambian, y, desde luego, desafían muchas de las concepciones científicas y filosóficas que, hasta ese momento, más valorábamos. Algunas tienen que ser desechadas, como el bagaje que se deja atrás en una larga travesía por el desierto. Otras tienen que ser modificadas y reconstruidas hasta quedar casi irreconocibles, ya que, lo que hemos podido ver en esos viajes, lo que hemos descubierto, nos han cambiado por completo el concepto y la perspectiva que del mundo teníamos, ahora conocemos y sabemos.

La exploración del ámbito de las galaxias extendió el alcance de la visión humana en un factor de 1026veces mayor que la escala humana, y produjo la revolución que identificamos con la relatividad, la cual reveló que la concepción newtoniana del mundo sólo era un localismo en un universo más vasto donde el espacio es curvo y el tiempo se hace flexible.

La exploración del dominio subatómico nos llevó lejos en el ámbito de lo muy pequeño, a unos 10-15 de la escala humana, y también significó una revolución. Esta fue la Física cuántica que, transformó todo lo que abordó.

La teoría cuántica nació en 1900, cuando Max Planck comprendió que sólo podía explicar lo que llamaba la curva del cuerpo negro -el espectro de energía que genera un objeto de radiación perfecta- si abandonaba el supuesto clásico de que la emisión de energía es continua, y lo reemplazó por la hipótesis sin precedentes de que la energía se emite en unidades discretas. Planck llamó cuantos a estas unidades.

Planck definió a “sus”0 cuantos en términos del “cuanto de acción”, simbolizado por la letra h que ahora, se ha convertido en el símbolo de una constante, la constante de Planck, h. Planck no era ningún revolucionario – a la edad de cuarenta y dos años era un viejo, juzgado por patrones de la ciencia matemática y, además, un pilar de la elevada cultura alemana del siglo XIX-, pero se percató fácilmente de que el principio cuántico echaría abajo buena parte de la física clásica a la que había dedicado la mayor parte de su carrera. “Cuanto mayores sean las dificultades -escribió-…tanto más importante será finalmente para la ampliación y profundización de nuestros conocimientos en la física.”

Sus palabras fueron prféticas: cambiando y desarrollándose constantemente, modificando su coloración de manera tan impredecible como una reflexión en una burbuja de jabón, la física cuántica pronto se expandió practicamente a todo el ámbito de la física, y el cuanto de acción de Planck, llegó a ser considerado una constante de la Naturaleza tan fundamental como la velocidad de la luz, c, de Einstein.

Max Planck es uno de los científicos a los que más veces se le han reconocido sus méritos y, su nombre, está por todas partes: La Constante de Planck, las Unidades de Planck, El cuanto de Planck, la Radiación de Planck, El Tiempo de Planck, la masa de Planck, la Energía de Planck, la Longitud de Planck…Todo bien merecido.

Pero sigamos con la escala del Universo conocido observable, la mayor escala que abarca más de 100 mil trillones de kilómetros y hagamos un pequeño esquema que lo refleje:

Radio en metros Objetos característicos

1026 Universo observable

1024 Supercúmulos de Galaxias

1023 Cúmulos de Galaxias

1022 Grupo de Galaxias (por ejemplo el Grupo Local)

1021 Galaxia La Vía Láctea

Nube Molecular gigante muy masiva, de gas y polvo compuesta fundamentalmente de moléculas con diámetro típico de 100 a.l. Tienen masa de hasta diez millones de masas solares (moléculas de Hidrógeno (H2) el 73% en masa), átomos de Helio (He, 25%), partículas de polvo (1%), Hidrógeno atómico neutro (H I, menos del 1%) y, un rico coctel de moléculas interestelares. En nuestra galaxia existen al menos unas 3000 Nubes Moleculares Gigantes, estando las más masivas situadas cerca de la radiofuente Sagitario B en el centro Galáctico.

1018 Nebulosas Gigantes, Nubes Moleculares

1012 Sistema Solar

1011 Atmósfera externa de las Gigantes rojas

Aunque a una Unidad Astronómica de distancia (150 millones de Kilómetros de la Tierra), el Sol caliente el planeta y nos da la vida

109 El Sol

108 Planetas Gigantes como Júpiter

107 Estrellas enanas, planetas similares a la Tierra

105 Asteroides, núcleos de cometas

104 Estrellas de Neutrones

Los seres humanos también son parte del Universo que queremos descubrir.

1 Seres Humanos

10-2 Molécula de ADN (eje largo)

10-5 Células vivas

Células vivas

10-9 Molécula de ADN (eje corto)

10-10 Átomos

10-14 Núcleos de átomos pesados

10-15 Protones y Neutrones

10-35 Quarks

Longitud de Planck: cuanto de espacio; radio de partículas sin dimensiones = la cuerda.

Es la escala de longitud a la que la descripción clásica de la Gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. Está dada por la ecuación de arriba, donde G es la constante gravitacional, ħ es la constante de Planck racionalizada y c es la velocidad de la luz. El valor de la longitud de Planck es del orden de 10-35 m (veinte órdenes de magnitud menor que el tamaño del protón10-15 m).

Me llama la atención y me fascina la indeterminación que esté inmersa en el mundo cuántico. La indeterminación cuántica no depende del aparato experimental empleado para investigar el mundo subatómico. Se trata, en la medida de nuestro conocimiento, de una limitación absoluta, que los más destacados sabios de una civilización extraterrestre avanzada compartirían con los más humildes físicos de la Tierra.

Por muy avanzados que pudieran estar, ellos también estarían supeditados al Principio de Incertidumbre o Indeterminación cuántica, y, como nosotros, cuando trataran de encontrar (sea cual fuese las matemáticas o sistemas que emplearan para hallarlo) el resultado de la constante de estructura fina, el resultado sería el mismo: 137, número puro y adimensional.

Todo esto nos ha llevado a la más firme convicción para definir la visión del mundo de la física que nos revelaba que no sólo la materia y la energía sino que también el conocimiento están cuantizados. Cuando un fotón choca con un átomo, haciendo saltar un electrón a una órbita más elevada, el electrón se mueve de la órbita inferior a la superior instantáneamente, sin tener que atravesar el espacio intermedio. Los mismos radios orbitales están cuantizados, y el electrón simplemente deja de existir en un punto para aparecer simultáneamente en otro. Este es el famoso “salto cuántico” que tanto desconcierta, y no es un mero problema filosófico, es una realidad que, de momento, no hemos llegado a comprender.

Por mucho que lo piense, no podrá aprovechar los mecanismos del Salto Cuántico para viajar a otras galaxias, de momento, que se sepa, sólo lo hacen electrones que reciben un fotón energético y desaparece de su orbital para aparecer, de manera inmediata, en otro más cercano al núcleo del átomo pero, sin tener que recorrer la distancia que separaba ambos puntos, el de partida y el de llegado. ¿Por dónde recorrió el camino? Nadie lo sabe.

Pero, ¿quién sabe? Quizás un día lejano aún en el tiempo, cuando descubramos el secreto que este salto cuántico nos esconde, podremos aprovechar la misma técnica que emplea la Naturaleza con los electrones para hacer posible que se transporten de un lugar a otro sin tener que recorrer las distancias que separan ambos destinos.

Pero la factibilidad de poder trasladarse de un punto a otro del Universo recurriendo a la ayuda de un agujero de gusano es tan sólo el principio de las … ¡elucubraciones mentales que, en el futuro, podrían ser una realidad! Estaría bien poder trasladarse entre las estrellas por ese medio

Bueno, pongamos los pies en el suelo, volvamos a la realidad. La revolución cuántica ha sido penosa, pero podemos agradecerle que, nos haya librado de muchas ilusiones que afectaban a la visión clásica del mundo. Una de ellas era que el hombre es un ser aparte, separado de la naturaleza a la que en realidad, no es que esté supeditado, sino que es, parte ella. ¡Somos Naturaleza!

Está claro, como nos decía Immanuel Kant que: “La infinitud de la creación es suficientemente grande como para hacer que un mundo, o una Vía Láctea de mundos, parezca, en comparación con ella, lo que una flor o un insecto en comparación con la Tierra.”

No creo que para 2.050 tengamos una puerta estelar

Algún día podríamos desaparecer en una especie anillo de plasma (¡Por qué no), abriendo una puerta estelar hacia otros mundos, otras estrellas. otras galaxias. Creo que la imaginación se nos ha dado para algo y, si todo lo que podemos imaginar… se puede hacer en realidad… la conclusión lógica es que sólo necesitamos ¡Tiempo!

Sí, amigos míos, la Naturaleza vive en constante movimiento y, nosotros, que formamos parte de ella…También.

En tiempos y lugares totalmente inciertos,

Los átomos dejaron su camino celeste,

Y mediante abrazos fortuitos,

Engendraron todo lo que existe.

Maxwell

emilio silvera

Doy las gracias a Timothy Ferris de cuyo libro, la Aventura del Universo, he podido obtener unos bellos pasajes que aquí, quedan incluidos.

emilio silvera

Nov

1

El hombre que quiso ser inmortal

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Imaginación ~

Clasificado en Imaginación ~

Comments (1)

Comments (1)

Él se sentía frustrado al darse cuenta de que el Tiempo transcurría, año tras año, y no conseguiría ver lo que en unos pocos siglos se avecinaba en los campos científicos de la Física y la Astronomía que juntos, desembocaban en la Astrofísica que tantos secretos tenía pendiente de desvelar del Universo inmenso. Y, de la misma manera, en Biología y otras disciplinas del saber científico. Buscó con ahínco la manera para frenar los efectos del paso del tiempo a través del estudio de los mecanismos moleculares del envejecimiento, rama en la que era un experto mundial, el reconocido Stanley Gilmante, poseedor de todos los premios.

La persecución de la Inmortalidad le llevó a probar (a escondida) todos los experimentos que podamos imaginar, y, algunos de ellos, no serían muy bien vistos por la comunidad científica. Sin embargo, no se paró en remilgos de ética y buscó la manera de no envejecer hasta que, un buen día, en su lugar de trabajo, le anunciaron la visita de un tal Señor Isat S.T., nombre que no le decía nada y, a punto estuvo, ocupado como estaba de no recibirlo.

Se gastaba su fortuna en obtener datos de leyendas antiguas y textos olvidados

Cuando lo tuvo ante él, le llamó poderosamente la atención su enorme figura. Era fuerte y tenía una altura de cerca de dos metros, su cabeza carecía de pelo y su cara era pétrea, parecía cincelada por un escultor. Los ojos eran grandes y de pupilas marrones, le miraban fijamente. Cuando le dio la mano, sintió la fuerte presión en la suya y oyó aquella voz poderosamente de extraña entonación pero melodiosa y cercana.

El profesor tenía la cara llena de una espuma que estaba probando para mantener la piel joven, y, no se dio cuenta de quitarse aquella especie de “mascara”. Sin embargo, el visitante no hizo el menor gesto de extrañeza.

– ¡Hola, profesor Stanley! Hace tiempo que le estamos observando y seguimos sus trabajos que, aunque precursores en este tiempo y de ideas nueva para la época, lo cierto es que son viejas y pasadas en mi mundo. Todas ellas quedan muy lejos de la realidad que trata de encontrar sobre el secreto de la vida eterna que, en realidad, reside en la genética.

Las palabras del extraño personaje le sonaron como si llegaran desde muy lejos y, a su mente acudió la imagen de una bella galaxia que, de inmediato desapareció. ¿Por qué aquella extraña visión? (Stanley no podía saber que le había sido transmitida por el extraño para enseñarle el lugar donde residía su especie).

Aquel personaje, sin dejarle reaccionar, continuó hablando: “Le diré que no soy de la Tierra y que en mi mundo, ya hemos encontrado lo que usted, con tanta pasión está buscando. Si quiere, le puedo dejar las fórmulas que le llevarán a ser inmortal pero, tengo una condición que ponerle. Sólo será aplicada a su persona y a nadie le dirá nada de este encuentro”.

Stanley, que había escuchado las palabras de aquel personaje en el mayor de los asombros, en un principio, no supo que decir, y, después de pasados unos pocos minutos con voz emocionada pudo articular unas palabras:

– “Le prometo señor que, si me entrega esas fórmulas, sólo en mí serán empleadas y, el mundo, nada sabrá de su existencia.”

El extraterrestre le entregó un sobre y sin decir palabra, dio media vuelta y antes de que pudiera reaccionar, había desaparecido de su vista.

Con mano temblorosa abrió el sobre y sacó de él las cuartillas en las que aparecían ecuaciones y esquemas con precisas explicaciones y gráficos, así como nítidas imágenes de moléculas y las distintas reacciones que se producían a medida que las fórmulas químicas eran aplicadas a un ser vivo.

Tras muchos días de estudio y una vez en posesión de todos aquellos datos que se aprendió de memoria, hizo una hoguera y quemó cualquier pruebas de su existencia. Seguidamente, cogió a su equipo y, de manera separada, puso a trabajar a los especialistas, de manera tal que, el uno no sabía lo que el otro estaba haciendo, dejándose él los trabajos más delicados y, de aquella manera, completó todas las fórmulas químicas que le posibilitaron la preparación de medicamentos y las operaciones secretas a las que fue sometido por colegas amigos en un quirófano secreto.

Metido en toda aquella vorágine, se pasó los días en el laboratorio, apenas comía y, hasta de la familia se olvidó. No atendía llamadas y su puerta estaba cerrada para todos. “Ya estoy acabando, dejadme y no molestar”. les decía.

Para no cansar al lector les diré que el buen Stanley consiguió lo que quería, y, con el paso de los años, todos envejecían y él seguía igual. Vio todos los adelantos de su tiempo pero también, vio morir a su mujer primero y a sus dos hijos después, se quedó solo en el mundo pero, eso sí, siguió siendo testigo de los adelantos que la ciencia realizaba en todos los campos del saber humano.

Fue testigo en directo del primer encuentro del hombre con un agujero negro (Pero echaba de menos a su familia).

Pudo contemplar la era de los Robots que protagonizaban las primeras y verdaderas excursiones Espaciales visitando otros mundos de los que nos enviaban imágenes a través de agujeros de gusano, un medio encontrado al fin para dejando de lado la velocidad de la luz, poder visitar otros mundos en un tiempo relativamente corto. Pero Stanley… ¡echaba de menos a su familia!

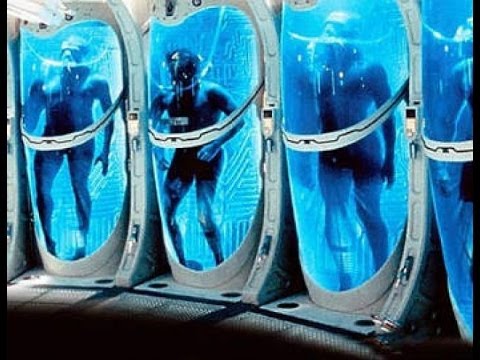

La criogenización Humana fue un un logro que fue alcanzado y, los pudientes, se metían en aquellos habitáculos para esperar el descubrimiento de la cura de sus enfermedades. Cuando se lograba la cura lo volvían a despertar y… ¡A vivir! (Recordaba con pena a su familia y una intensa nostalgia se apoderaba de él lentamente).

En el año 3.120 pudo realizar su sueño y fue parte de una excursión a Alpha Centauri pero… Notaba la falta de su familia. Ni el fascinante viaje logró borrar de su memoria la sonrisa de sus hijos y la bella cara de su esposa que le miraba amorosa.

Sí, es cierto que es bonito si pudiéramos estar presente en todas las maravillas que se avecinan y en los adelantos de la Ciencia que cambiará nuestro mundo de hoy pero, en cada momento, a los seres humanos, nos toca vivir el Tiempo que se nos ha dado, y, en ese Tiempo debemos desarrollar todas nuestras empresas y nuestros anhelos, vivir de la mejor manera posible “nuestro tiempo”, ya que, ambicionar otra cosa, no sería natural ni creo que nos hiciera más felices. Además, ¿Quién quiere sobrevivir a sus hijos?

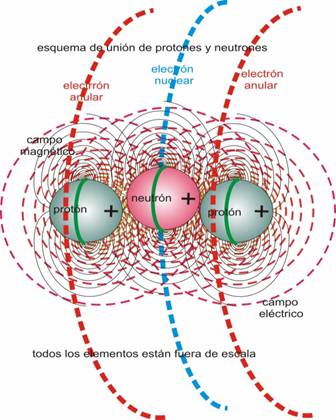

.png)

Pienso que estamos dotados de una inmensa imaginación de ilimitado horizonte, con ella, podemos ir a donde nos plazca e imaginar escenarios de increíble belleza en los que podemos estar de manera inmaterial, sin correr ningún peligro y, de esa manera, podemos trasladarnos al futuro que más nos guste o al que podamos pensar que será la realidad por venir dentro de 2.000 años. Otros, preferirán viajar al pasado, es cosa de gustos pero, todos,

Nunca ha sido bueno querer lo imposible, sentir de esa manera es estar abocado al sufrimiento y a la mayor de las frustraciones, ya que, desear lo que nunca tendremos… ¡No es muy racional!

emilio silvera

Nov

1

Imaginación sin límite pero… ¿Sabremos comprender?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Está claro que pensar siquiera en que en nuestro Universo, dependiendo de la región en la que nos encontremos, habrá distintas leyes físicas, sería pensar en un universo chapuza. Lo sensato es pensar y creer que en cualquier parte del universo rigen las mismas leyes físicas, hasta que no se encuentre pruebas reales a favor de lo contrario, los científicos suponen con prudencia que, sean cuales fueran las causas responsables de las pautas que llamamos “Leyes de la Naturaleza”, es mucho más inteligente adoptar la creencia de la igualdad física en cualquier parte del Cosmos por muy remota que se encuentre aquella región; los elementos primordiales que lo formaron fueron siempre los mismos y las fuerzas que intervinieron para formarlo también.

La materia y las fuerzas que conforman nuestro Universo

Las fuerzas fundamentales son

|

Tipo de Fuerza |

Alcance en m |

Fuerza relativa |

Función |

| Nuclear fuerte |

<3×10-15 |

1041 |

Une Protones y Neutrones en el núcleo atómico por medio de Gluones. |

| Nuclear débil |

< 10-15 |

1028 |

Es responsable de la energía radiactiva producida de manera natural. Portadoras W y Z– |

| Electromagnetismo |

Infinito |

1039 |

Une los átomos para formar moléculas; propaga la luz y las ondas de radio y otras formas de energías eléctricas y magnéticas por medio de los fotones. |

| Gravitación |

Infinito |

1 |

Mantiene unidos los planetas del Sistema Solar, las estrellas en las galaxias y, nuestros pies pegados a la superficie de la Tierra. La transporta el gravitón. |

Fue Einstein el que anunció lo que se llamó principio de covariancia: que las leyes de la naturaleza deberían expresarse en una forma que pareciera la misma para todos los observadores, independientemente de dónde estuvieran situados y de cómo se estuvieran moviendo. En caso contrario… ¿En qué clase de Universo estaríamos?

Lo cierto es que Einstein fue muy afortunado y pudo lanzar al mundo su teoría de la relatividad especial, gracias a muchos apoyos que encontró en Mach, en Lorentz, en Maxwell… En lo que se refiere a la relatividad general, estuvo dando vueltas y vueltas buscando la manera de expresar las ecuaciones de esa teoría pero, no daba con la manera de expresar sus pensamientos.

Sin embargo, fue un hombre con suerte, ya que, durante la última parte del siglo XIX en Alemania e Italia, matemáticos puros habían estado inmersos en el estudio profundo y detallado de todas las geometrías posibles sobre superficies curvas. Habían desarrollado un lenguaje matemático que automáticamente tenía la propiedad de que toda ecuación poseía una forma que se conservaba cuando las coordenadas que la describían se cambiaban de cualquier manera. Este lenguaje se denominaba cálculo tensorial. Tales cambios de coordenadas equivalen a preguntar qué tipo de ecuación vería alguien que se moviera de una manera diferente.

Einstein se quedó literalmente paralizado al leer la Conferencia de Riemann. Allí, delante de sus propios ojos tenía lo que Riemann denominaba Tensor métrico. Einstein se dio cuenta de que era exactamente lo que necesitaba para expresar de manera precisa y exacta sus ideas. Así llegó a ser posible la teoría de la relatividad general.

Gracias al Tensor de Rieman, Einstein pudo formular: ![]()

Recordando aquellos años de búsqueda e incertidumbre, Einstein escribió:

“Los años de búsqueda en la oscuridad de una verdad que uno siente pero no puede expresar el deseo intenso y la alternancia de confianza y desazón hasta que uno encuentra el camino a la claridad y comprensión sólo son familiares a aquél que los ha experimentado. “

Einstein, con esa aparentemente sencilla ecuación que arriba podemos ver, le dijo al mundo mucho más, de lo que él mismo, en un principio pensaba. En ese momento, se podría decir, sin temor a equivocarnos que comenzó la historia de la cosmología moderna. Comprendimos mejor el universo, supimos ver y comprender la implosión de las estrellas obligadas por la gravedad al salir de la secuencia principal, aprecieron los agujeros negros… y, en fin, pudimos acceder a “otro universo”.

Es curioso como la teoría de la relatividad general nos ha llevado a comprender mejor el Universo y, sobre todo, a esa fuerza solitaria, la Gravedad. Esa fuerza de la naturaleza que ahora está sola, no se puede juntar con las otras fuerzas que -como tantas veces hemos comentado aquí-, tienen sus dominios en la mecánica cuántica, mientras que la gravitación residen en la inmensidad del cosmos; las unas ejercen su dominio en los confines microscópicos del átomo, mientras que la otra sólo aparece de manera significativa en presencia de grandes masas galácticas, estrellas y sistemas planetarios y de objetos que, como los agujeros negros, emiten la fuerza curvando el espacio a su alrededor y distorsionando el tiempo si su densidad llega a ser extrema.

Cuando miramos al cielo nocturno -en la imagen de arriba lo hacemos desde Tenerife- y nos sentimos reducidos, empequeñecidos por la inmensidad de las luces celestes que puntúan en el cielo, estamos mirando realmente una minúscula porción de las estrellas localizadas en el brazo de Orión. El resto de los 200 mil millones de estrellas de la Vía Láctea están tan lejanas que apenas pueden ser vistas como una cinta lechosa que cruza el cielo nocturno.

Para cuando ese suceso pueda llegar aquí, nuestro Sol estará transformándose en una Gigante roja, antes de convertirse en una enana blanca. Así que, los acontecimientos futuros serían dignos de contemplar. Claro que, para entonces… ¿Quién andará por aquí?

Cuando recordamos que la galaxia Andrómeda se está acercando a la Vía Láctea a unos 300 km/s, y sabiendo lo que ahora sabemos, no podemos dejar de preguntarnos ¿Dónde estará la Humanidad dentro de miles de millones de años? Si tenemos la suerte de haber podido llegar tan lejos -que es dudoso-, seguramente, nuestra inmensa imaginación habrá desarrollado conocimientos y tecnologías suficientes para poder escapar de tan dramático suceso. Estaremos tan ricamente instalados en otras galaxias, en otros mundos. De alguna manera… ¿No es el Universo nuestra casa?

emilio silvera

Totales: 83.328.213

Totales: 83.328.213 Conectados: 17

Conectados: 17