Mar

30

La Física es la llave del futuro

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

El Premio Nóbel de Fisica 2008 se ha concedido a una aportación al conocimiento fundamental de la materia y de sus interacciones: La ruptura espontánea de la simetría y la violación de la simetría CP. Está dotado con diez millones de coronas suecas (un millón de euros) y, como el resto de galardones Nobel, se entrega el 10 de diciembre.

Lo han recibido el estadounidense Yoichiro Nambu por un lado, y los nipones Makoto Kobayashi y Toshihide Maskawa por su contribución al conocimiento de las partículas subatómicas.

A Nambu, nacido en 1921, y que forma parte del prestigioso Instituto Enrico Fermi de EEUU, se le reconoce “su descubrimiento del mecanismo de la ruptura espontánea de simetría, en la física subatómica”.

A Kobayashi -del Acelerador de Alta Energía de Tsukuba (Japón)- y Maskawa -del Instituto Yukawa de Física Teórica, de la Universidad de Kyoto-, se les alaba su papel en el descubrimiento del origen de las rupturas de simetría, “que predicen la existencia de al menos tres familias de quarks en la naturaleza”. Ya son parte del modelo estándar

En 1960, Yoichiro Nambu formuló su descripción matemática de la ruptura espontánea de simetría, como parte de la teoría de la física de partículas. Este mecanismo oculta la verdadera sencillez y el orden de la naturaleza bajo una superficie en apariencia compleja.

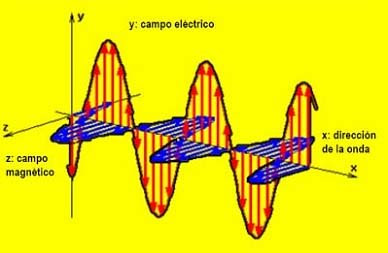

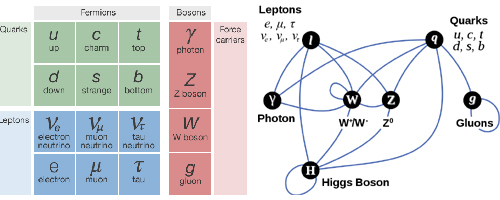

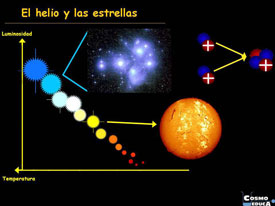

El modelo de Nambu ha resultado de tanta utilidad en las últimas décadas, que ya forma parte del modelo estándar de física de partículas, que permite unificar en una sola teoría lo que se conoce de las partículas subatómicas y de tres de las cuatro fuerzas de la naturaleza: la interacción nuclear fuerte (responsable de la unión del núcleo y de los quarks dentro de cada partícula), la débil (fuerza transmutadota de unas partículas en otras y responsable de cambiar el sabor de un quark en otro, así permite convertir un protón en un neutrón para conseguir Helio a partir de Hidrógeno, reacción básica que mantiene encendido al Sol y de ciertas desintegraciones radiactivas) y por último del electromagnetismo.

Respecto a Kobayashi y Maskawa (nacidos en 1944 y 1941, respectivamente), son los responsables de haber formulado en fecha tan temprana como 1971 la explicación a otro fenómeno de nombre similar, pero independiente, las rupturas de simetría, que parecen haber existido desde la creación del universo. Sus cálculos teóricos obligaron a ampliar el modelo estándar de física de partículas, hasta acoger tres familias de quarks, de cuyos miembros se ha ido obteniendo constancia durante los últimos tiempos.

¿Pero qué es la ruptura espontánea de la simetría?

Pese a que creemos firmemente que las fuerzas de la naturaleza parecen iguales desde cualquier dirección desde la que observemos, hay situaciones que parecen contradecirlo. Es un mecanismo muy frecuente incluso en nuestra vida cotidiana. Así el agua totalmente igual en cualquier dirección, cristaliza al congelarse y al formar una red parece primar unas direcciones con respecto a otras. Imaginemos que fuéramos un ser que vive dentro de un imán, Hay unas direcciones distintas a otras y parece que las leyes cambian según hacia donde miremos. Si calentáramos el imán hasta que perdiera sus propiedades veríamos que no es así.

Algo similar creemos que sucede en nuestro Universo: está tan frío que parece que no se cumple la simetría inherente a las fuerzas. Creemos que todas son manifestaciones de una única que operaba al principio.

Además de esta existe una ruptura de la simetría más profunda: responsable de que nuestro universo la materia y la antimateria no se aniquilaran totalmente al comienzo. Gracias a eso estamos aquí: en la poquita diferencia de materia que no se aniquiló.

Simetría C: Si cambiamos cada partícula por su antipartícula (sólo cambiamos el signo) las leyes no cambian. No es así.

Simetría P: También creemos que debería comportarse igual nuestro Universo que su imagen especular, pero tampoco es así. De ahí el tópico de que los electrones son todos zurdos.

Determinados procesos cumplen ambos: no varían si cambiamos a la vez Simetría CP. Cambiando carga y en una imagen especular los procesos son indistinguibles. La fuerza electromagnética y la interacción fuerte se comportan así(cumplen la simetría CP) pero no así la interacción débil.

(1944). Japón, que descubrió el origen de la ruptura de simetría que predice la existencia de, al menos tres familias de Quarks en la Naturaleza.

Toshihide Maskawa

Yoichiro Nambu, descubrió el mecanismo de ruptura espontánea de la simetría

¿Por qué hay algo en vez de nada? ¿Por qué hay tantas partículas elementales diferentes? Estos laureados con el Premio Nobel de Física de presentaron ideas teóricas que nos suministran una comprensión más profunda de lo que sucede en el interior de los bloques más pequeños que forman la materia.

La naturaleza de las leyes de simetría se encuentran en el corazón de este asunto. O más bien, la ruptura de las simetrías, tanto las que parecen haber existido en nuestro universo desde el principio como aquellas que han perdido su simetría original en alguna parte del camino. De hecho, todos somos hijos de la simetría rota. Ello debió ocurrir inmediatamente después del Big Bang, hace unos 14.000 millones de años cuando fueron creadas la materia y la antimateria. El contacto de materia y antimateria es fatal para ambas, se aniquilan mutuamente y se transforman en radiación. Es evidente que la materia, al final, ganó la partida a la antimateria, de otra manera nosotros no estaríamos aquí. Pero estamos, y una pequeña desviación de la simetría perfecta parece que ha sido suficiente –un exceso de una partícula de materia por cada diez mil millones de partículas de antimateria fueron suficientes para hacer que nuestro mundo exista-. Este exceso de la materia fue la semilla de nuestro universo, lleno de galaxias, estrellas y planetas y, eventualmente, de vida. Pero lo que hay detrás de esta violación de la simetría en el cosmos es aún un gran misterio y un activo para seguir buscando lo que no sabemos.

La mayoría de los físicos piensa que el llamado mecanismo de Higgs es el responsable de que la simetría original entre fuerzas fuera destruido dando a las partículas sus masas en las primeras etapas del universo. El camino hacia ese descubrimiento fue trazado por Yoichiro Nambu quien, en 1960, fue el primero en introducir la violación espontánea de la simetría en la física de partículas. Es por este descubrimiento por el que se le concede el Premio Nobel de Física.

Tenemos algunos ejemplos banales de violación espontánea de la simetría en la vida diaria. Un lápiz en equilibrio sobre su punta lleva una existencia totalmente simétrica en la cual todas las direcciones son equivalentes. Pero esta simetría se pierde cuando cae -ahora sólo una dirección cuenta-. Por otro lado su condición es ahora más estable, el lápiz no puede volver a caer, ha llegado a su nivel más bajo de energía.

El modelo que tenenos de la física de partículas se llama Modelo Estándard y, nos habla de las interacciones entre partículas y las fuerzas o interraciones que están presentes, las leyes que rigen el Universo físico y que, no hemos podido completar al no poder incluir una de las fuerzas: La Gravedad. Claro que, no es esa la única carencia del Modelo, tiene algunas más y, a estas alturas, se va necesitando un nuevo Modelo, más completo y audaz, que incluya a todas las fuerzas y que no tengá parámetros aleatorios allí donde nuestros conocimientos no llegan.

La fealdad del Modelo Estándar puede contrastarse con la simplicidad de las ecuaciones de Einstein, en las que todo se deducía de primeros principios. Para comprender el contraste estético entre el Modelo Estándar y la teoría de la relatividad general de Einstein debemos comprender que, cuando los físicos hablan de “belleza” en sus teorías, realmente quieren decir que estas “bellas” teorías deben poseer al menos dos características esenciales:

- Una simetría unificadora.

- La capacidad de explicar grandes cantidades de datos experimentales con las expresiones matemáticas más económicas.

E = mc2 . Esta es la mejor prueba de lo que decimos arriba.

El Modelo Estándar falla en ambos aspectos, mientras que la relatividad general los exhibe, ambos, de manera bien patente. Nunca una teoría dijo tanto con tan poco; su sencillez es asombrosa y su profundidad increíble.De hecho, desde que se publicó en 1.915, no ha dejado de dar frutos, y aún no se han obtenido de ella todos los mensajes que contiene.

El principio director del modelo estándar dicta que sus ecuaciones son simétricas. De igual modo que una esfera ofrece el mismo aspecto desde cualquier punto de vista, las ecuaciones del modelo estándar subsisten sin variación al cambiar la perspectiva desde la que son definidas. Las ecuaciones permanecen invariables, además, cuando esta perspectiva se desplaza en distinta magnitud a diferentes puntos del espacio y el tiempo.

Al contrario de la relatividad general, la simetría del Modelo Estándar, está realmente formada empalmando tres simetrías más pequeñas, una por cada una de las fuerzas; el modelo es espeso e incómodo en su forma. Ciertamente no es económica en modo alguno. Por ejemplo, las ecuaciones de Einstein, escritas en su totalidad, sólo ocupan unos centímetros y ni siquiera llenaría una línea de esta página. A partir de esta escasa línea de ecuaciones, podemos ir más allá de las leyes de Newton y derivar la distorsión del espacio, el Big Bang y otros fenómenos astronómicos importantes como los agujeros negros. Por el contrario, sólo escribir el Modelo Estándar en su totalidad requeriría, siendo escueto, un par de páginas y parecería un galimatías de símbolos complejos sólo entendibles por expertos.

Los científicos quieren creer que la naturaleza prefiere la economía en sus creaciones y que siempre parece evitar redundancias innecesarias al crear estructuras físicas, biológicas y químicas.

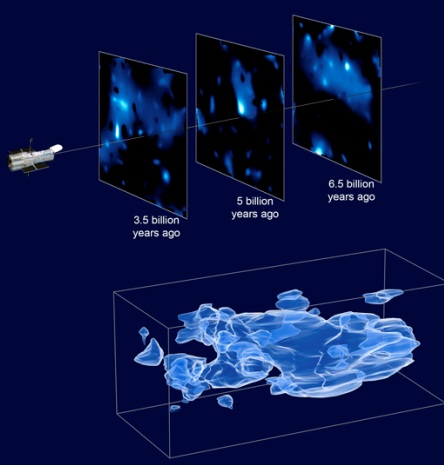

La luz antigua absorbida por átomos de hidrógeno neutro podría usarse para probar ciertas predicciones de la Teoría de Cuerdas, dicen los cosmólogos de la Universidad de Illinois. Realizar tales medidas, sin embargo, requeriría que se construyese un gigantesco conjunto de radio telescopios en la Tierra, el espacio, o la Luna.

El matemático francés Henri Poincaré lo expresó de forma aún más franca cuando escribió: “El científico no estudia la Naturaleza porque es útil; la estudia porque disfruta con ello, y disfruta con ello porque es bella”

E. Rutherford, quien descubrió el núcleo del átomo (entre otras muchas cosas), dijo una vez: “Toda ciencia es o física o coleccionar sello”.Se refería a la enorme importancia que tiene la física para la ciencia, aunque se le olvidó mencionar que la física está sostenida por las matemáticas que la explica.

Pero, a pesar de todos sus inconvenientes, el Modelo Estándar, desde su implantación, ha cosechado un éxito tras otro, con sus inconvenientes y sus diecinueve parámetros aleatorios, lo cierto es que es lo mejor que tenemos por el momento para explicar las familias de partículas que conforman la materia y cómo actúan las fuerzas de la naturaleza, todas las fuerzas menos la gravedad; esa nos la explica a la perfección y sin fisuras las ecuaciones de Einstein de la relatividad general.

Hace tiempo que los físicos tratan de mejorar el Modelo Estándar con otras teorías más avanzadas y modernas que puedan explicar la materia y el espacio-tiempo con mayor amplitud y, sobre todo, incluyendo la gravedad. Así que retomando la teoría de Kaluza de la quinta dimensión, se propuso la teoría de super.gravedad en 1.976 por los físicos Daniel Freedman, Sergio Ferrara y Peter van Nieuwenhuizen, de la Universidad del Estado de Nueva York en Stoney Brook que desarrollaron esta nueva teoría en un espacio de once dimensiones.

Para desarrollar la superteoría de Kaluza-Klein en once dimensiones, uno tiene que incrementar enormemente las componentes del interior del Tensor métrico de Riemann (que Einstein utilizó en cuatro dimensiones, tres de espacio y una de tiempo para su relatividad general y más tarde, Kaluza, añadiendo otra dimensión de espacio, la llevó hasta la quinta dimensión haciendo así posible unir la teoría de Einstein de la gravedad, con la teoría de Maxwell del electromagnetismo), que ahora se convierte en el supertensor métrico de Riemann.

Hasta hoy, no se ha logrado, ni mucho menos, inventar una teoría de campo consistente totalmente unificadora que incluya la gravedad. Se han dado grandes pasos, pero las brechas «científicounificantes» siguen siendo amplias. El punto de partida ha sido siempre la teoría de la relatividad general y conceptos con ella relacionados, por la excelencia que manifiesta esa teoría para explicar la física gravitatoria macro-cósmica. El problema que se presenta surge de la necesidad de modificar esta teoría sin perder por ello las predicciones ya probadas de la gravedad a gran escala y resolver al mismo tiempo los problemas de la gravedad cuántica en distancias cortas y de la unificación de la gravedad con las otras fuerzas de la naturaleza.

Su tensor métrico es un tensor de rango 2 que se utiliza para definir … Sin embargo, en otras teorías se ha elevado el rango y se pueden definir múltiples universos de dimensiones más altas.

El tensor métrico se podría adaptar a las necesidades de la búsqueda estableciendo la multiplicidad de dimensiones que la teoría exigía para su desarrollo.

Más allá de lo que nos permiten captar nuestros sentidos físicos, hay que tener nuestra mente abierta a la posibilidad de que puedan existir otras realidades diferentes a lo que nos dicta nuestra experiencia, realidades capaces de ser descubiertas por la fuerza del intelecto cuando nos atrevemos a cuestionar aquello que creíamos como absoluto.

Esta nueva teoría de supergravedad pretendía la unificación de todas las fuerzas conocidas con la materia, y, como en un rompecabezas, encajarlas en el Tensor de Riemann tan solo con elevar el número de dimensiones que exigía más componentes y nos daba el espacio necesario para poder ubicar en sus apartados correspondientes, todas las fuerzas fundamentales y también la materia, la que podía satisfacer, casi en su totalidad, el sueño de Einstein.

A partir de aquí, de estas ecuaciones, surgió todo. Este fue el puerto de donde salió el bajel de la teoría de Kaluza-Gleim, la super-gravedad y supersimetría, la cuerda heterótica y la Teoría de cuerdas, todo ello, rematado con la finalmente expuesta, teoría M. También, con el nacimiento de esta ecuación que es la imagen que mejor refleja hasta dónde puede3 llegar el intelecto humano, comenzó la verdadera cosmología.

La supergravedad casi consigue satisfacer el sueño de Einstein de dar una derivación puramente geométrica de todas las fuerzas y partículas del universo. Al añadir la supersimetría al Tensor métrico de Riemann, la métrica se duplica en tamaño, dándonos la supersimetría de Riemann. Las nuevas componentes del súper tensor de Riemann corresponden a quarks y leptones, casi todas las partículas y fuerzas fundamentales de la naturaleza: la teoría de la gravedad de Einstein, los campos de Yang-Mills y de Maxwell y los quarks y leptones. Pero el hecho de que ciertas partículas no estén en esta imagen nos obliga a buscar un formalismo más potente:

La materia con todas las fuerzas fundamentales de la naturaleza. Los bosones intermediarios o partículas portadoras de las fuerzas como el fotón para el electromagnetismo, los gluones para la fuerza nuclear fuerte, las partículas W y Z para la nuclear débil y, en la partícula portadora de la gravedad, el gravitón, ponemos el signo de interrogación, ya que se sabe que esta ahí en algún sitio pero hasta la fecha no ha sido detectado.

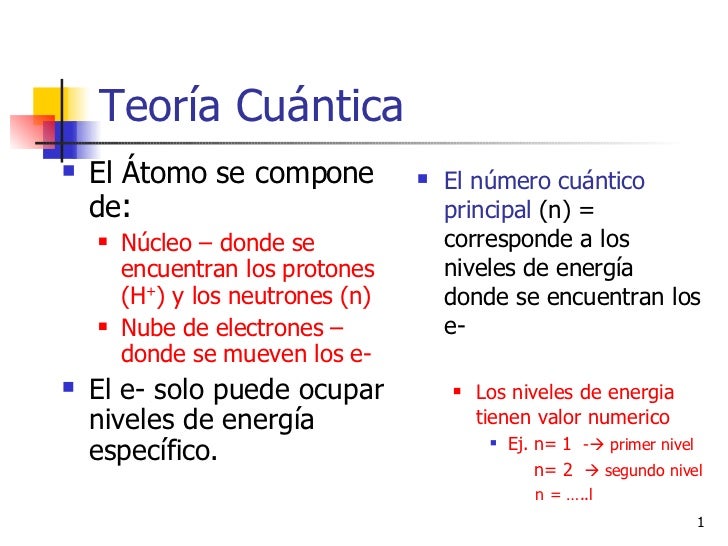

Antes de continuar con la teoría de súper cuerdas, o con su versión más avanzada la teoría M, parece conveniente recordar que hasta el momento los ladrillos del universo eran los quarks, las partículas más pequeñas detectadas en los aceleradores del CERN y FERMILAB. Pero ¿están hechos de cosas más pequeñas?, eso no lo sabemos. El Modelo Estándar, menos avanzado que las otras teorías, nos dice que los quarks son las partículas más pequeñas y forman protones y neutrones constituyendo la formación interna del átomo, el núcleo. En la actualidad, nuestros aceleradores de partículas no tienen capacidad para ahondar más allá de los quarks y averiguar si a su vez, éstos están formados por partículas aún más pequeñas.

No podemos saber (aún) que es lo que pueda haber (si es que lo hay) más allá de los Quarks, los constituyentes de la materia más pequeños conocidos hasta el momento actual. Sin embargo, no se descarta que puedan existir partículas más simples dentro de los Quarks que, al fin y al cabo, no serían tan elementales.

Por otro lado, los físicos están casi seguros de que los leptones no están compuestos de partículas más pequeñas. Sin embargo, esta sospecha no se tiene en el caso de los quarks; no se sabe qué puede haber detrás de ellos. Tan sólo se ha llegado a de-confinarlos junto con los gluones y por un breve periodo de tiempo de los protones y neutrones que los mantenían aprisionados, formando – en esos breves instantes – una materia plasmosa. No es raro oír dentro de la comunidad científica a los físicos teóricos hablando de pentaquarks.

Como antes hemos comentado de pasada, el Modelo Estándar agrupa las partículas en familias:

Claro, son muchos más. Además de los Bariones, también forman parte de la familia hadrónica los mesones y la lista de unos y otros es larga y cada individuo, como es natural, tiene sus propias características que lo hacen único.

| Hadrones: | Bariones: protón, neutrón , Lambda, omega, etc. |

| Mesones: pión, kaón, psí, etc. | |

| Quarks: | up, down, charmed, strange, top y botton |

| Leptones: | electrón, muón y tau (y sus neutrinos asociados), neutrino electrónico, muónico y tauónico |

Y describe las interacciones que estas partículas tienen con las cuatro fuerzas fundamentales de la naturaleza, sobre todo con las nucleares fuerte y débil y la electromagnética; la gravedad se queda aparte del Modelo Estándar, ya que su incidencia con las partículas elementales es inapreciable como consecuencia de las infinitesimales masas de éstas, y ya sabemos que la gravedad se deja sentir y se hace presente cuando aparecen las grandes masas como planetas, estrellas y galaxias.

Grandes estructuras que vienen a ser como pequeños ”universos islas” en los que podemos estudiar, a menos tamaño, todo lo que en el Gran Universo puede pasar. Partiendo de la base de que las leyes del universo son las mismas en todas partes, podemos tomar cualquier región del mismo y ver que, allí está ocurriendo lo mismo que aquí ocurre, es decir, están presentes las fuerzas fundamentales: nucleares débiles y fuertes, electromagnetismo y Gravedad y, todo, absolutamente todo, funciona al ritmo que dichas leyes nos marcan.

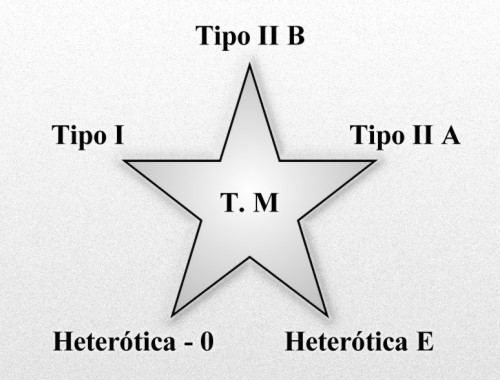

Como el Modelo Estándar es limitado, los físicos buscan desesperadamente nuevas teorías que puedan corregir y perfeccionar este modelo. Así aparecieron las teorías de súper simetría, súper gravedad, súper cuerdas, y ahora por último, la teoría M propuesta por Edward Witten en 1.995 y que nos quiere explicar, de manera más perfecta, el universo desde su origen, cómo y por qué está conformado ese universo, las fuerzas que lo rigen, las constantes de la naturaleza que establecen las reglas, y todo ello, a partir de pequeños objetos infinitesimales, las cuerdas, que sustituyen a las partículas del modelo estándar que creíamos elementales.

Esas partículas súper simétricas que pronostican algunas teorías, aún no han sido observadas y se espera que en el LHC puedan aparecer algunas que, desde luego, si así ocurre, sería un buen adelanto para conocer el mundo que nos acoge y la Naturaleza del Universo.

Esta nueva teoría, permite además, unificar o incluir la gravedad con las otras fuerzas, como teoría cuántica de la gravedad, todo ello mediante una teoría estructurada y fundamentada con originalidad y compactificación de las cuatro fuerzas de la naturaleza y dejando un gran espacio matemático para eliminar anomalías o perturbaciones, y se propugna con coherencia quela cuerda es el elemento más básico de la estructura de la materia; lo que estaría bajo los quarks serían unas diminutos círculos semejantes a una membrana vibrante circular y de diferentes conformaciones.

Universos Paralelos, Teorías de Cuerdas, Súper gravedad, La Teoría M, y ¿Los pensamientos de la Mente, podrán dar para tanto?

Una vez se escucha sobre los fundamentos de la teoría cuántica uno no puede mas que sobrecogerse, ampliar la mente y galopar entre las múltiples posibilidades acerca de lo real e imaginario que por momentos y depende que conceptos se entrelazan intercambiables. Lo que llama la atención es que por mucho que hayan sido los físicos cuánticos más prestigiosos entre la sociedad científica los que hayan puesto sobre la mesa conceptos cuanto menos rimbombantes e inverosímiles como las multi-dimensiones, los universos paralelos, los efectos túneles y demás, sean los propios miembros de la academia los que grandilocuentemente se ofenden cuando se hace alusión al paralelismo evidente del comportamiento y extensión de la energía en referencia al universo preconizado por los místicos de muchas culturas. No tenemos los conocimientos necesarios para poder decir que no a esto o aquello, cada cosa tiene su lugar y tendremos que analizarlas muy a fondo y adentrarnos en esos mundos de misterio para poder decidir lo que es y lo que no puede ser.

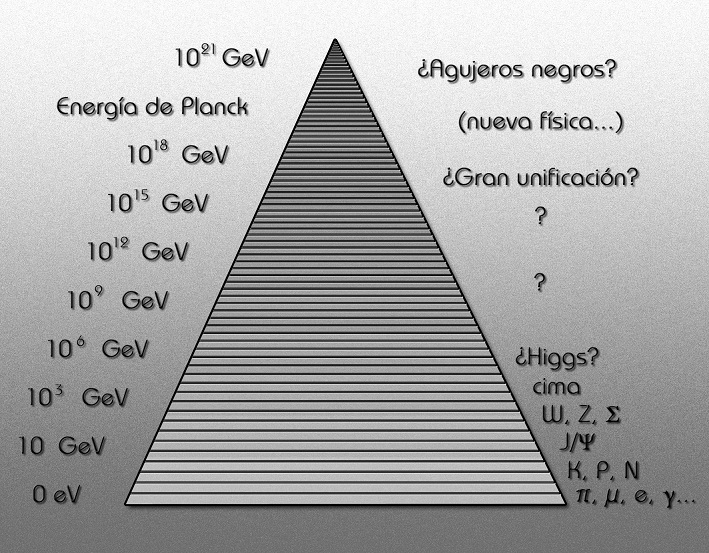

Aquí hemos llegado a una región de la Física de las partículas donde la energía (por partícula) es mucho mayor de la que actualmente podemos estudiar en nuestros laboratorios. Claro que especulamos, pero con los datos de los que disponemos, la realidad estará muy cerca de la expuesta en el gráfico, y, en él se señalan energía que no están a nuestro alcance para conseguir lo que se quiere saber.

Ed Witten, en su trabajo, presentó amplias evidencias matemáticas de que las cinco teorías obtenidas de la primera revolución, junto con la más reciente conocida como la súper gravedad (súper cuerda después), en 11 dimensiones, eran de hecho parte de una teoría inherentemente cuántica y no perturbativa conocida como teoría M. Las seis teorías están conectadas entre sí por una serie de simetrías de dualidad T, S, y U. Además, de la teoría propuesta por Witten se encuentran implícitas muchas evidencias de que la teoría M no es sólo la suma de las partes, sino que se vislumbra un alentador horizonte que podría concluir como la teoría definitiva tan largamente buscada.

Los resultados de la segunda revolución de las súper cuerdas han demostrado que las cinco teorías de cuerdas forman parte de un solo marco unificado, llamado Teoría M.

Las súper cuerdas, en realidad, sólo es otra manera utilizada por los científicos a la búsqueda de la verdad que la Humanidad necesita y reclama para continuar con su propia evolución que, sin esos conocimientos, quedaría estancada.

Como se puede ver, las partículas implicadas en el Modelo Estándar están en un mundo microscópico de 10-17cm que sí dominan nuestros aceleradores, mientras que la cuerda está en una distancia de 10-33 cm que les está prohibida, allí no podemos llegar, no disponemos de la energía suficiente para ello.

Igual que con la energía disponible por el momento, nos pasa con las distancias, que también nos tiene paralizados en nuestros deseos de visitar mundos lejanos, no podemos, al no disponer de los medios necesarios para poder soslayar las distancias de tantos años-luz como tendríamos que recorrer. ¿Habrá otro camino?

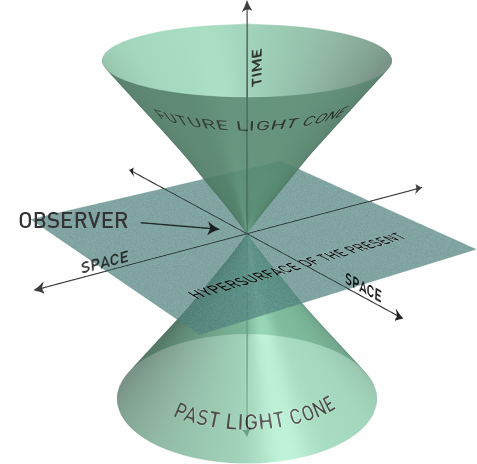

Está muy claro para los físicos que, aunque teóricamente, en la Teoría de Súper cuerdas se pueden unir todas las fuerzas, todavía tenemos que seguir sosteniendo que la gravedad resulta una fuerza solitaria para todos los efectos, ya que ha resistido todos los intentos para saber, con certeza, si finalmente se podrá unir a las otras fuerzas de la Naturaleza. La gravedad está descrita por la teoría de la relatividad general de Einstein y tiene una naturaleza esencialmente geométrica. Se entiende como la curvatura del espacio-tiempo alrededor de un objeto masivo. En los gráficos, generalmente, se representa como un objeto pesado sobre una superficie fina y tensa (una pelota o bola pesada de jugar a los bolos que dejamos encima de una sábana extendida tirando de las cuatro esquinas). El peso de la bola (materia) hundirá la sábana (espacio-tiempo) con mayor intensidad en la distancia más cercana a donde se encuentre masa.

El espacio tiempo se distorsiona allí donde residen objetos pesados como los planetas, las estrellas, galaxias y cualesquiera otros cuerpos masivos.

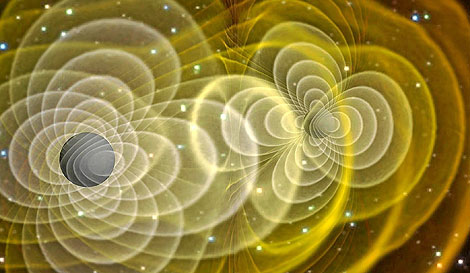

La teoría de Einstein goza de una amplia aceptación debido a los aciertos macroscópicos que han sido verificados de manera experimental. Los más recientes están referidos a los cambios de frecuencia de radiación en púlsares binarios debido a la emisión de ondas gravitacionales, que actualmente estudia Kip S. Thorne, en relación a los agujeros negros. Entre las predicciones que Einstein propugna en su teoría se encuentran, por ejemplo, la existencia de ondas gravitacionales, que el universo está en constante expansión y que, por lo tanto, tuvo un inicio: el Big Bang o los agujeros negros.

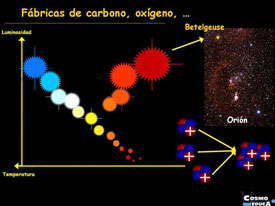

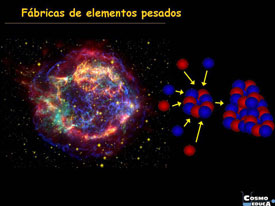

Se trata de regiones donde la gravedad es tan intensa que ni siquiera la luz puede escapar de su atracción. Estas regiones se forman por el colapso gravitatorio de estrellas masivas en la etapa final de su existencia como estrella, acabado el combustible nuclear y no pudiendo fusionar hidrógeno en helio, fusiona helio en carbono, después carbono en neón, más tarde neón en magnesio y así sucesivamente hasta llegar a elementos más complejos que no se fusionan, lo que produce la última resistencia de la estrella contra la fuerza de gravedad que trata de comprimirla, se degeneran los neutrones como último recurso hasta que, finalmente, la estrella explota en supernova lanzando al espacio las capaz exteriores de su material en un inmenso fogonazo de luz; el equilibrio queda roto, la fuerza de expansión que contrarrestaba a la fuerza de gravedad no existe, así que, sin nada que se oponga la enorme masa de la estrella supermasiva, se contrae bajo su propio peso, implosiona hacia el núcleo, se reduce más y más, su densidad aumenta hasta lo inimaginable, su fuerza gravitatoria crece y crece, hasta que se convierte en una singularidad, un lugar en el que dejan de existir el tiempo y el espacio.

Allí no queda nada, ha nacido un agujero negro y a su alrededor nace lo que se ha dado en llamar el Horizonte de Sucesos, que es una región del espacio, alrededor del agujero negro que una vez traspasada no se podrá regresar; cualquier objeto que pase esta línea mortal, será literalmente engullida por la singularidad del agujero negro. De hecho, el telescopio espacial Hubble, ha enviado imágenes captadas cerca de Sagitario X-1, en el centro de nuestra galaxia, donde reside un descomunal agujero negro que, en las fotos enviadas por el telescopio, aparece como atrapa la materia de una estrella cercana y se la engulle.

.Ondas gravitacionales que se forman a partir de los agujeros negros que, en su dinámica cotidiana y que, actualmente, estamos tratando de captar para saber de un njhuevo Universo que nos diría muchas cosas de las que ocurren a partir de fenómenos que sabemos existen pero, que hasta el momento no hemos podido “leer”.

Esta es la fuerza que se pretende unir a la Mecánica Cuántica en la teoría de supercuerdas, es decir, que Einstein con su relatividad general que nos describe el cosmos macroscópico, se pueda reunir con Max Planck y su cuanto infinitesimal del universo atómico, lo muy grande con lo muy pequeño.

La llamada gravedad cuántica trata de fundir en una sola las dos teorías físicas más soberbias con las que contamos, la relatividad general y la mecánica cuántica, que en el estado actual de nuestro conocimiento parecen incompatibles. Su estudio, ahora mismo, es en algunos aspectos análogo a la física de hace cien años, cuando se creía en los átomos, pero se ignaraban los detalles de su estructura.

Hasta el momento, Einstein se ha negado a esta reunión y parece que desea caminar solo. Las otras fuerzas están presentes en el Modelo Estándar, la gravedad no quiere estar en él, se resiste.

De hecho, cuando se ha tratadode unir la mecánica cuántica con la gravedad, aunque el planteamiento estaba muy bien formulado, el resultado siempre fue desalentador; las respuestas eran irreconocibles, sin sentido, como una explosión entre materia y antimateria, un desastre.

Sin embargo, es preciso destacar que las nuevas teorías de súper-simetría, súper-gravedad, súper-cuerdas o la versión mas avanzada de la teoría M de Ed Witten, tienen algo en común: todas parten de la idea expuesta en la teoría de Kaluza-Klein de la quinta dimensión que, en realidad, se limitaba a exponer la teoría de Einstein de la relatividad general añadiendo otra dimensión en la que se incluían las ecuaciones de Maxwell del electromagnetismo.

Hasta hoy no se ha logrado, ni mucho menos, inventar una teoría de campo que incluya la gravedad. Se han dado grandes pasos, pero la brecha “científicounificante” es aún muy grande. El punto de partida, la base, ha sido siempre la relatividad y conceptos en ella y con ella relacionados, por la excelencia que manifiesta esa teoría para explicar la física gravitatoria cósmica. El problema que se plantea surge de la necesidad de modificar esta teoría de Einstein sin perder por ello las predicciones ya probadas de la gravedad a gran escala y resolver al mismo tiempo el problema de la gravedad cuántica en distancias cortas y de la unificación de la gravedad con las otras fuerzas de la naturaleza. Desde la primera década del siglo XX se han realizado intentos que buscan la solución a este problema, y que han despertado gran interés.

Después de la explosión científica que supuso la teoría de la relatividad general de Einstein que asombró al mundo, surgieron a partir e inspiradas por ella, todas esas otras teorías que antes he mencionado desde la teoría Kaluza-Klein a la teoría M.

Esas complejas teorías cuánticas nos quieren acercar al misterio que encierra la materia: ¡El Espíritu de la Luz!

Es de enorme interés el postulado que dichas teorías expone. Es de una riqueza incalculable el grado de complejidad que se ha llegado a conseguir para desarrollar y formular matemáticamente estas nuevas teorías que, como la de Kaluza-Klein o la de supercuerdas (la una en cinco dimensiones y la otra en 10 ó 26 dimensiones) surgen de otra generalización de la relatividad general tetradimensional einsteniana que se plantea en cuatro dimensiones, tres espaciales y una temporal, y para formular las nuevas teorías se añaden más dimensiones de espacio que, aunque están enrolladas en una distancia de Planck, facilitan el espacio suficiente para incluir todas las fuerzas y todos los componentes de la materia, tratando de postularse como la Teoría de Todo.

Dimensiones enrolladas ¿En un espacio-tiempo fractal? La Naturaleza sabe de eso

La Gran Teoría Unificada que todo lo explique es un largo sueño acariciado y buscado por muchos. El mismo Einstein se pasó los últimos treinta años de su vida buscando el Santo Grial de la teoría del todo en la física, unificadora de las fuerzas y de la materia. Desgraciadamente, en aquellos tiempos no se conocían elementos y datos descubiertos más tarde y, en tales condiciones, sin las herramientas necesarias, Einstein no podría alcanzar su sueño tan largamente buscado. Si aún viviera entre nosotros, seguro que disfrutaría con la teoría de súper-cuerdas o la teoría M, al ver como de ellas, sin que nadie las llame, surgen, como por encanto, sus ecuaciones de campo de la relatividad general.

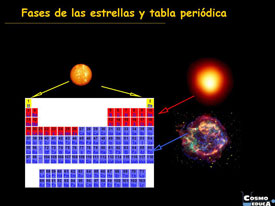

La fuerza de la Naturaleza, en el universo primitivo del Big Bang, era una sola fuerza y el estado de la materia es hoy conocido como “plasma”; las enormes temperaturas que regían no permitía la existencia de protones o neutrones, todo era como una sopa de quarks. El universo era opaco y estaba presente una simetría unificadora.

Más tarde, con la expansión, se produjo el enfriamiento gradual que finalmente produjo la rotura de la simetría reinante. Lo que era una sola fuerza se dividió en cuatro. El plasma, al perder la temperatura necesaria para conservar su estado, se trocó en quarks que formaron protones y neutrones que se unieron para formar núcleos. De la fuerza electromagnética, surgieron los electrones cargados negativamente y que, de inmediato, fueron atraídos por los protones de los núcleos, cargados positivamente; así surgieron los átomos que, a su vez, se juntaron para formar células y éstas para formar los elementos que hoy conocemos. Después se formaron las estrellas y las galaxias que sirvieron de fábrica para elementos más complejos surgidos de sus hornos nucleares hasta completar los 92 elementos naturales que conforma toda la materia conocida. Existen otros elementos que podríamos añadir a la Tabla, pero estos son artificiales como el pluton.

La materia ha evolucionado hasta límites increíbles: ¡la vida! y, aún no sabemos, lo que más allá pueda esperar.

¿Quizás hablar sin palabras, o, Incluso algo más?

Estos conocimientos y otros muchos que hoy posee la ciencia es el fruto de mucho trabajo, de la curiosidad innata al ser humano, del talento de algunos y del ingenio de unos pocos, todo ello después de años y años de evolución pasando los descubrimientos obtenidos de generación en generación.

¿Cómo habría podido Einstein formular su teoría de la relatividad general sin haber encontrado el Tensor métrico del matemático alemán Riemann?

¿Qué formulación del electromagnetismo habría podido hacer James C. Maxwell sin el conocimiento de los experimentos de Faraday?

La relatividad especial de Einstein, ¿habría sido posible sin Maxwell y Lorentz?

¿Qué unidades habría expuesto Planck sin los números de Stoney?

En realidad… ¿Cómo comenzaría todo? Mientras encontramos la respuesta, observamos como el Universo se expande y se vuelve viejo y fe0

Así podríamos continuar indefinidamente, partiendo incluso, del átomo de Demócrito, hace ahora más de dos milenios. Todos los descubrimientos e inventos científicos están apoyados por ideas que surgen desde conocimientos anteriores que son ampliados por nuevas y más modernas formulaciones.

Precisamente, eso es lo que está ocurriendo ahora con la teoría M de las supercuerdas de Witten. Él se inspira en teorías anteriores que, a su vez, se derivan de la original de A. Einstein que pudo surgir, como he comentado, gracias al conocimiento que en geometría aportó Riemann con su tensor métrico.

emilio silvera

Mar

29

La Naturaleza está en nuestras Mentes

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Naturaleza...El Universo ~

Clasificado en La Naturaleza...El Universo ~

Comments (0)

Comments (0)

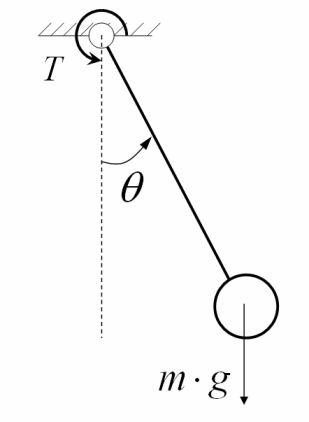

“La esfera, colgando de un largo cable fino al techo del

coro, oscilaba de un lado a otro con una majestad isócrona.

Yo sabía -pero cualquiera podía haberlo sentido en la

magia de ese sereno aliento- que el período estaba gobernado

por la raíz cuadrada de la longitud del cable y por π,

ese que, por irracional que sea para las mentes sublunares,

liga la circunferencia y el diámetro de todos los cículos posibles a

través de una racionalidad superior. El tiempo que necesitaba la

esfera oscilar de un extremo a otro estaba determinado por una

conspiración arcana la más intemporal de las medidas: la singularidad

del punto de suspensión, la dualidad de las dimensiones del plano, el

comienzo triádico de π, la secreta Naturaleza cuadrática de la raíz y la

innumerada perfección del propio círculo.”

Umberto Eco

Después de haber utilizado durante un tiempo las ecuaciones y fórmulas de la física matemática, uno se acostumbra a una peculiaridad de la Naturaleza. Es muy comprensiva con nuestra ignorancia de ciertos detalles. Las leyes de la Naturaleza tienen varios ingredientes: una máquina lógica predecir el futuro a partir del presente, constantes especiales de la Naturaleza y un conjunto de simples números. Estos simples números aparecen junto a las constantes de la Naturaleza en casi todas las fórmulas físicas.

Einstein los supo apreciar muy y así lo reflejaba en las cartas que le envió a su amiga Ilse Rosenthal Schneider y los llamaba “constantes básicas”. Son solamente números. Por ejemplo, el período (“tic”) de un reloj de péndulo estaba dado con gran precisión por una sencilla fórmula:

Período = 2π √(L/g)

Donde L es la longitud del péndulo y g es la aceleración de la gravedad en la superficie de la Tierra. Aquí podemos notar la aparición de la “constante básica” 2π = 6,28. En todas las fórmulas que utilizamos para describir algún aspecto del mundo físico, aparece un factor numérico de este . Lo más notable es que casi siempre tienen un valor próximo a uno y pueden despreciarse, o aproximarse por 1, si sólo se está interesado en obtener una estimación razonablemente buena del resultado.

Éste es un premio importante, porque en un problema como la determinación del período de un péndulo simple nos permite obtener la aproximada de la respuesta.. El período, que tiene dimensiones de tiempo, sólo puede depender de una manera de la longitud L y la aceleración g si la combinación resultante ha de ser un tiempo: esa combinación es la raíz cuadrada de L/g.

bonita característica del mundo físico, que parece estar bien descrito por leyes matemáticas en las que los factores puramente numéricos que aparecen no son muy diferentes de 1 en magnitud, es uno de los misterios casi desapercibidos de nuestro estudio del mundo físico. Einstein estaba muy impresionado por la ubicuidad de pequeños números adimensionales en las ecuaciones de la física y escribió sobre el misterio de que, aunque casi siempre parece ser así.

“…no podemos exigirlo rigurosamente, pues ¿por qué no debería aparecer un factor numérico (12π)3 en una deducción fisicomatemática? sin duda tales casos son rarezas.”

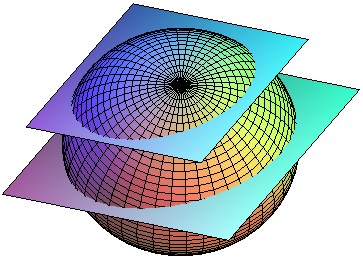

Es posible arrojar alguna luz sobre problema si reconocemos que casi todos los factores numéricos por los que Einstein estaba tan impresionado tienen un origen geométrico. Por ejemplo, el volumen de un cubo de arista R es R3, el volumen de una esfera de radio R es 4πR3/3. Los factores numéricos dan cuenta de la forma detallada las fuerzas de la Naturaleza están actuando. Puesto que las fuerzas fundamentales de la Naturaleza son simétricas y no tienen una preferencia por direcciones diferentes, hay una tendencia a la simetría esférica.

Nuestra Galaxia, el Sol y nuestro mundo y la Luna… ¡Todos tienden a ser esféricos!

Nos hemos podido dar de que a partir de todo lo que hemos podido aprender, hemos podido ver que las constantes de la Naturaleza tienen una influencia relativa mucho mayor cuando se trata de determinar los resultados de las leyes de la Naturaleza en tres dimensiones que la que tienen en universos con muchas más dimensiones espaciales.

Cuando consideramos mundos con dimensiones de espacio y tiempo distintas de 3 + 1 topamos con un problema sorprendente. Los mundos con más de una dimensión no permiten predecir el futuro a partir del presente. En este sentido son más bien como mundos sin dimensión temporal. Un sistema organizado complejo, como, por ejemplo, el necesario la vida, no podría utilizar la información recogida en su entorno para conformar su comportamiento futuro. Seguiría siendo simple: demasiado simple para almacenar información y evolucionar.

Si el de dimensiones de espacio y tiempo hubiera sido escogido aleatoriamente y todos los números fueran posibles, entonces esperaríamos que el número fuera muy grande. Es muy improbable escoger un número pequeño. Sin embargo, las ligaduras impuestas por la necesidad de tener “observadores” para hablar del problema significa que no todas las posibilidades están disponibles y que se nos impone un espacio tridimensional. Todas las alternativas estarían privadas de vida. Si científicos de otro universo conocieran nuestras leyes pero no el número de dimensiones en que vivimos, podrían deducir su número simplemente a partir del hecho de nuestra existencia.

Por muchas vueltas que le queramos dar, el Universo tiene tres dimensiones de Espacio y una de Tiempo

Así que, si queremos hacer una aproximación al problema de por qué el espacio tiene tres dimensiones, nos lleva a una estimación de gran alcance de cómo y por qué son peculiares los mundos tridimensionales con una única flecha del tiempo. Las alternativas son demasiado simples, demasiado inestables o demasiado impredecibles que observadores complejos evolucionen y perduren dentro de ellos. Como resultado, no debería sorprendernos encontrarnos viviendo en tres dimensiones espaciales sujetos a los caprichos de un único tiempo. No parece que existan alternativas.

Todo paisaje es cambiante y… ¡Las ideas también!

Y, a todo esto, ustedes se preguntarán: ¿Qué tiene que ver todo esto con el péndulo? Bueno, ya sabéis que todo evoluciona y, a medida que se va escribiendo parece que las ideas fluyen y también evolucionan en su transcurrir de manera tal que, de una cuestión se pasa a otra sin que lo podamos evitar.

Le doy aquí las gracias a John D. Barrow, que con sus ideas inspiró ésta página para que todos pudiéramos disfrutar al acercarnos al conocimiento de las cosas, del mundo, del universo y de su Naturaleza que continuamente nos enseña por qué camino debemos seguir avanzando.

emilio silvera

Mar

28

¡Qué bonito es saber!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El libre pensamiento ~

Clasificado en El libre pensamiento ~

Comments (3)

Comments (3)

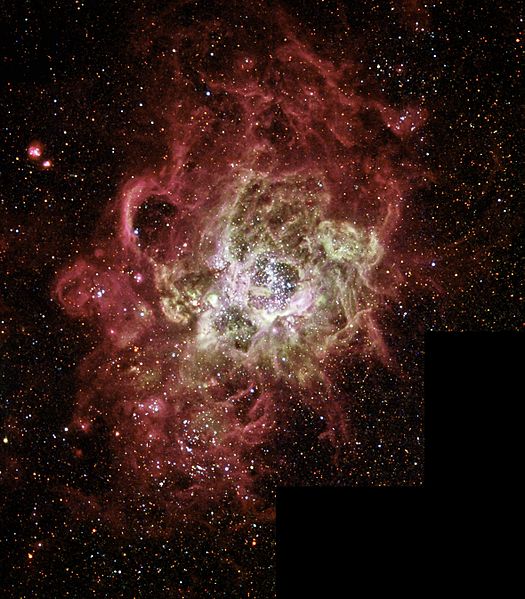

Nebulosa de Orión, M42 que está creando nuevos sistemas planetarios

“Al principio todo era opacidad, las estrellas no llegaron al universo hasta después de pasados 200 millones de años desde el Big Bang, y, hasta que no se liberaron los fotones, no se hizo la luz.”

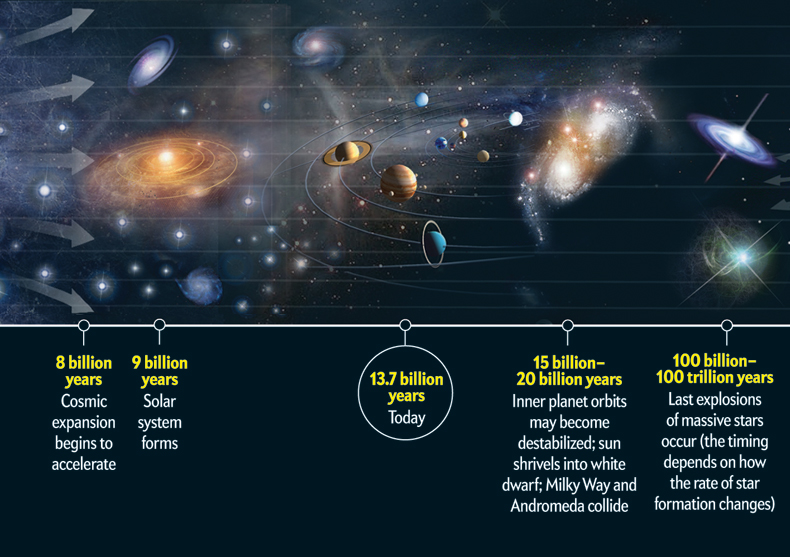

Al principio, cuando el universo era simétrico, sólo existía una sola fuerza que unificaba a todas las que ahora conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo. Más tarde, cuando el universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron los primeros quarks para unirse y formar protones y neutrones, los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos. Doscientos millones de años más tarde, se formaron las primeras estrellas y y las galaxias.

Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes de que se formase el Sol. Podemos decir, sin temor a equivocarnos, que una supernova anónima explotó hace miles de millones de años y sembró la nube de gas que dio lugar a nuestro sistema solar, poniendo allí los materiales complejos y necesarios para que algunos miles de millones de años más tarde, tras la evolución, apareciéramos nosotros.

Las estrellas evolucionan desde que en su núcleo se comienza a fusionar hidrógeno en helio, de los elementos más ligeros a los más pesados. Avanza creando en el horno termonuclear, cada vez, metales y elementos más pesados. Cuando llega al hierro y explosiona en la forma explosiva de una supernova. Luego, cuando este material estelar es otra vez recogido en una nueva estrella rica en hidrógeno, al ser de segunda generación (como nuestro Sol), comienza de nuevo el proceso de fusión llevando consigo materiales complejos de aquella supernova.

Una región H II es una nube de gas y plasma brillante que puede alcanzar un tamaño de varios cientos de años-luz y en la cual se forman estrellas masivas. Dichas estrellas emiten copiosas cantidades de ultravioleta extremo (con longitudes de onda inferiores a 912 Ångströms) que ionizan la nebulosa a su alrededor.

Puesto que el peso promedio de los protones en los productos de fisión, como el cesio y el kriptón, es menor que el peso promedio de los protones de uranio, el exceso de masa se ha transformado en energía mediante E = mc2. Esta es la fuente de energía que subyace en las explosiones atómica.

Así pues, la curva de energía de enlace no sólo explica el nacimiento y muerte de las estrellas y la creación de elementos complejos que también hicieron posible que nosotros estemos ahora aquí y, muy posiblemente, será también el factor determinante para que, lejos de aquí, en otros sistemas solares a muchos años luz de distancia, puedan florecer otras especies inteligentes que, al igual que la especie humana, se pregunten por su origen y estudien los fenómenos de las fuerzas fundamentales del universo, los componentes de la materia y, como nosotros, se interesen por el destino que nos espera en el futuro.

Cuando alguien oye por vez primera la historia de la vida de las estrellas, generalmente, no dice nada, pero su rostro refleja escepticismo. ¿Cómo puede vivir una estrella 10.000 millones de años? Después de todo, nadie ha vivido tanto tiempo como para ser testigo de su evolución.

Sin embargo, tenemos los medios técnicos y científicos para saber la edad que tiene, por ejemplo, el Sol.

Sí, hemos podido llegar a conocer lo que ocurre en el Sol, y sabemos de sus procesos y de qué está compuesto. También sabemos el motivo por el que no se deja contraer bajo el peso de la fuerza de Gravedad que genera su propio peso y en qué se convertirá cuando llegue el final de su vida.

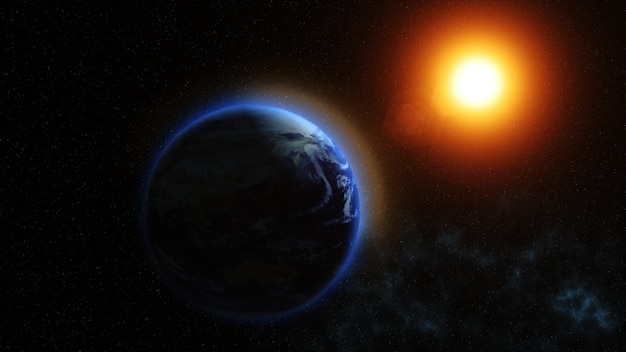

Nuestro Sol, la estrella alrededor de la que giran todos los planetas de nuestro Sistema Solar (hay que eliminar a Plutón de la lista, ya que en el último Congreso Internacional han decidido, después de más de 20 años, que no tiene categoría para ser un planeta), la estrella más cercana a la Tierra (150 millones de Km = UA), con un diámetro de 1.392.530 Km, tiene una edad de 4.500 millones de años.

Es tal su densidad, es tal su enormidad que, como se explicó en otro pasaje anterior de este mismo trabajo, cada segundo transforma por medio de fusión nuclear, 4.654.000 toneladas de hidrógeno en 4.650.000 toneladas de helio; las 4.000 toneladas restantes son lanzadas al espacio exterior en forma de luz y calor, de la que una parte nos llega a la Tierra y hace posible la vida. Se calcula que al Sol le queda material de fusión para otros 4.500 millones de años. Cuando transcurra dicho periodo de tiempo, se convertirá en una gigante roja, explotará como nova y se transformará finalmente en una estrella enana blanca. Para entonces, ya no podremos estar aquí.

Cuando mentalmente me sumerjo en las profundidades inmensas del universo que nos acoge, al ser consciente de su enormidad, veo con claridad meridiana lo insignificante que somos, en realidad, en relación al universo, Como una colonia de bacterias que habitan en una manzana, allí tienen su mundo, lo más importante para ellas, y no se paran a pensar que puede llegar un niño que, de un simple puntapié, las envíe al infierno.

Vista de la Tierra y el Sol. 160.000.000 de Km los separan

Igualmente, nosotros nos creemos importantes dentro de nuestro cerrado y limitado mundo en el que, de momento, estamos confinados. Podemos decir que hemos dado los primeros pasos para dar el salto hacia otros mundos, pero aún nos queda un largo recorrido por delante pero… ¡Todo se andará!

Tendremos que dominar la energía del Sol, ser capaces de fabricar naves espaciales que sean impenetrables a las partículas que a cientos de miles de trillones circulan por el espacio a la velocidad de la luz, poder inventar una manera de imitar la gravedad terrestre dentro de las naves para poder hacer la vida diaria y cotidiana sin estar flotando todo el tiempo y, desde luego, buscar un combustible que procure altas velocidades que, si no relativistas ni cercanas a c, si que hagan los viajes a los mundos cercanos de una duración aceptable y soportable a los viajeros, ya que, de otra manera, el traslado por la periferia de nuestro propio Sistema solar se haría interminable. Finalmente, y para escapar del sistema solar, habría que buscar la manera de burlar la barrera de la velocidad de la luz.

El Hiperespacio podría ser el camino para burlar la velocidad de la luz. Es decir, ya que el Universo, en su espacio tradicional, nos impide viajar más rápido que la luz, busquemos ese otro camino situado en dimensiones extra que, ¡sí lo permitiría! De manera tal que podríamos viajar a otras galaxias en tiempos soportables para nuestras efímeras vidas.

Hiperespacio. ¿La puerta a otras galaxias?

“Si pudiéramos encontrar el camino hacia dimensiones más altas… ¿Cuántas respuestas encontraríamos allí?”

emilio silvera

Mar

28

La Inmensidad del Universo y de las cosas que contiene

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¡Necesitamos saber! ~

Clasificado en ¡Necesitamos saber! ~

Comments (0)

Comments (0)

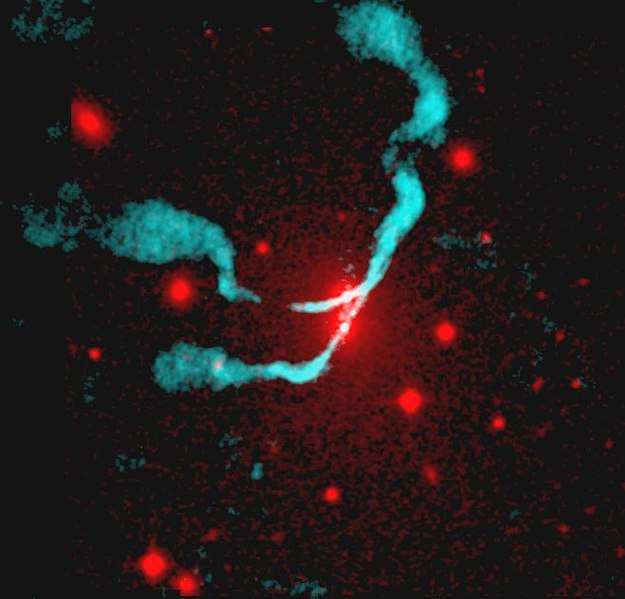

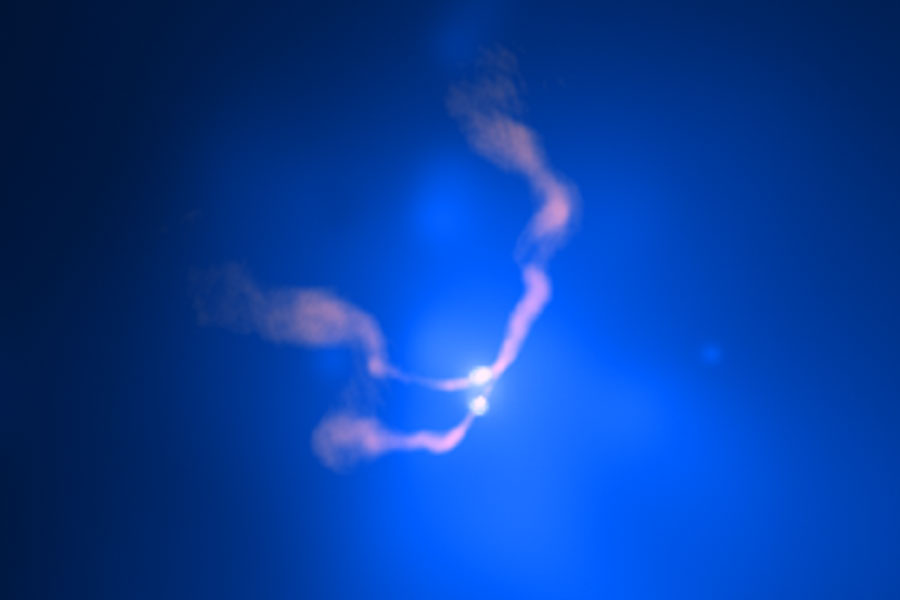

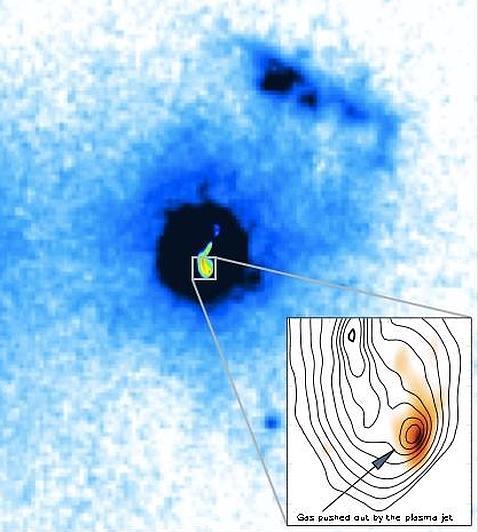

Radio-galaxia 3C 75 en longitud de onda visible y radiofrecuencia.

“Dos agujeros negros super-masivos en espiral hacia la fusión cerca del centro de NGC 1128, a unos 25,000 años luz de distancia. Crédito: rayos X (azul): NASA / CXC / D. Hudson, T. Reiprich et al. (AIfA); Radio (rosa): NRAO / VLA / NRL”.

“Grupo de Galaxias HCG 87 (Hickson Compact Group), vista desde el Observatorio Gemini en Cerro Pachón, Chile.”

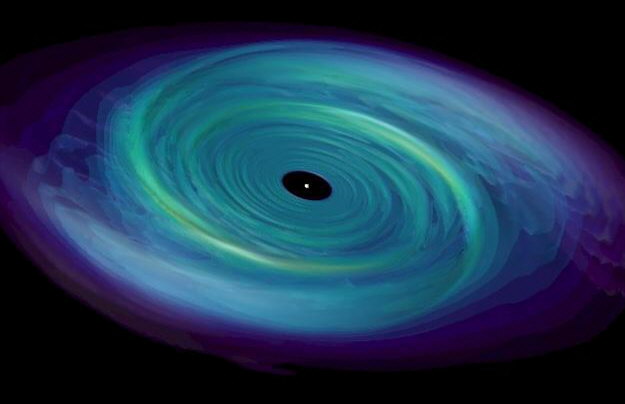

En el Universo existen objetos exóticos, de extraños comportamientos y que generan inmensas energías. Por ejemplo, una radio-galaxia es un emisor inusualmente intenso de ondas de radio. La emisión de una puede ser de hasta 1038 vatios, un millón de veces mayor que la de una galaxia normal como la nuestra.

3C 75 es un sistema binario de agujeros negros en el cúmulo de galaxias Abell 400. Tiene cuatro chorros de radio (dos de cada agujero negro en acreción). Se desplaza 1.200 Km por segundo a través del plasma del cúmulo, lo que hace que los chorros sean barridos hacia atrás.

La radio-galaxia tienen un núcleo de radio compacto coincidente con el núcleo de la galaxia visible, un par de chorros que emergen del núcleo en direcciones opuestas, u un par de lóbulos lejos de los confines visibles de la galaxia. La galaxia resulta ser casi siempre una gigante elíptica, que pudiera ser el resultado de la colisión o la fusión de dos o más galaxias más pequeñas. La fuente de la energía de la radio-galaxia se sospecha que es un agujero negro masivo situado en el núcleo galáctico desde donde emergen los chorros, enviando energía a los lóbulos. Algunas radio-galaxias notables son la que arriba podréis contemplar, 3C 75.

Ahí podéís contemplar la misma imagen pero más nítida de la potente fuente de radio 3C 75 en la que parece que dos agujeros negros gigantes están girando el uno alrededor del otro para potenciar la gigantesca fuente de radio. Rodeados por el gas que emite rayos X a varios millones de grados y expulsando chorros de partículas relativistas, esos agujeros negros super-masivos que parecen estar juntos, en realidad, están separados por 25.000 años-luz. La imagen captada por los ingenios de la NASA, está situada en el cúmulo de galaxias Abell 400, se encuentran a unos 300 millones de años-luz de distancia. Los astrónomos dicen que estos dos agujeros negros super-masivos están irremediablemente ligados por la gravedad y forman un sistema binario. Estas fusiones cósmicas espectaculares son objetos, según se cree, de intensas fuentes de ondas gravitacionales. El gas caliente sale disparado en chorros que corren a 1200 kilómetros por segundo.

¿Hasta que punto son comunes los agujeros negros gigantes? Los datos acumulados gradualmente y tomados cada vez con tecnologías más avanzadas u fiables, sugieren que tales agujeros habitan no sólo en los núcleos de la mayoría de los cuásares y radio-galaxias, sino también en los núcleos de la mayoría de las galaxias normales (no radio-galaxias) y galaxias grandes tales como la Vía Láctea y Andrómeda.

M110 fue descubierta en 1773 por Charles Messier, quien pensó que era parte de la nebulosa de Andrómeda y no la incluyó en su catálogo; no fue hasta 1966 en que el británico Kenneth Glyn Jones la incluyó en el catálogo Messier con el número 110, el último objeto de este catálogo.

M32, incluida en el catálogo NGC como NGC 221, es una galaxia elíptica enana y compacta de unos 8000 años luz de diámetro, que está a unos 110000 años luz de distancia de M31.

La imagen de la derecha, que es también un recorte de la anterior, es de M32.

También han sido detectados en los núcleos de algunas pequeñas galaxias tales como la compañera enana de Andrómeda, M32. En las galaxias normales como las nombradas, el agujero negro (en contra de lo que creen muchos) no está rodeado por ningún disco de acreción, o solamente lo está por un tenue disco que derrama sólo cantidades modestas de energía.

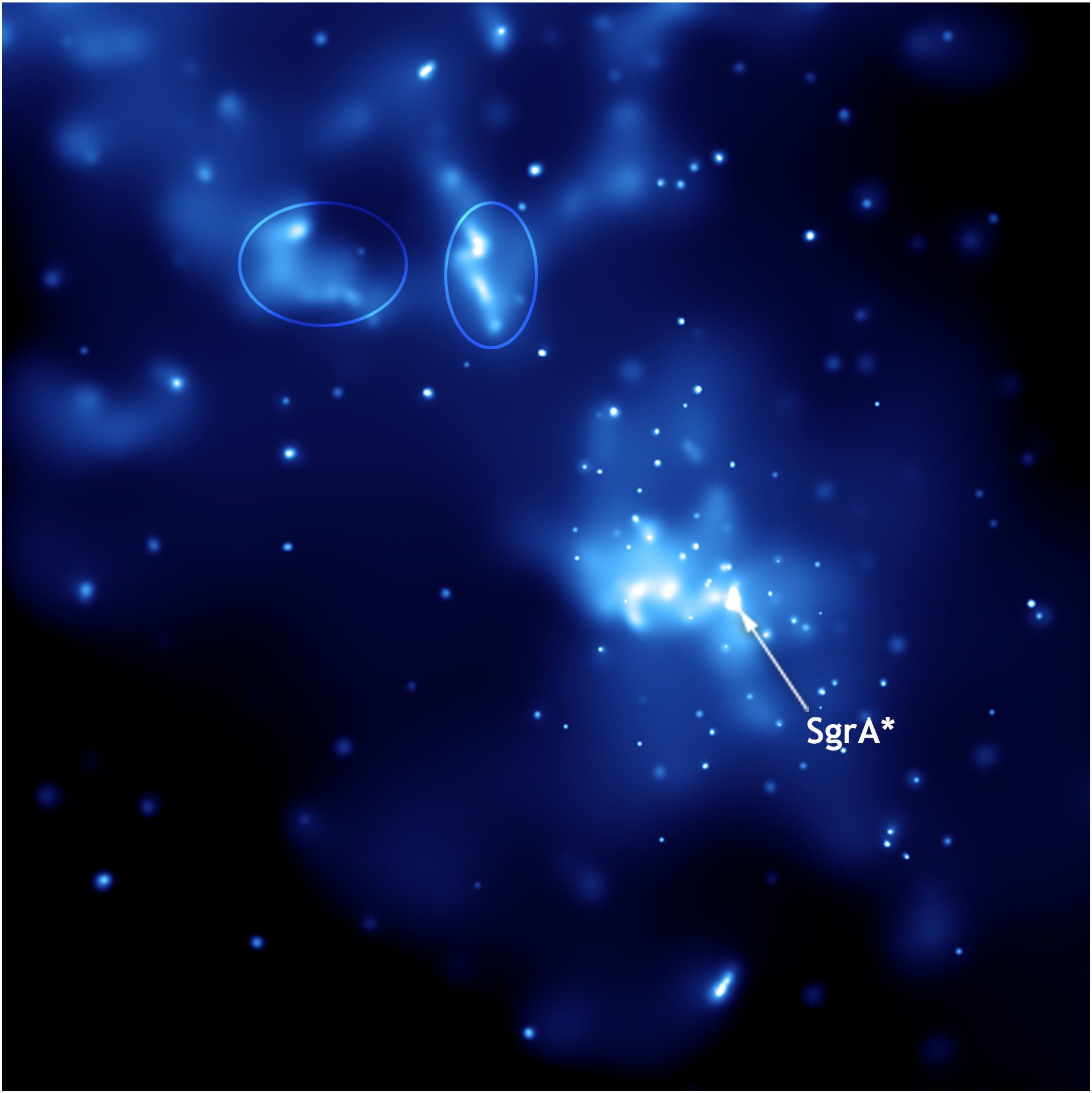

Nuestro Centro Galáctico es un lugar de mucha agitación y, en presencia de un agujero negro gigante, la seguridad está ausente. Mejor nos quedamos por aquí, en Orión, la Nebulosa más bonita de la Galaxia, aposentados en el Brazo del mismo nombre para situar nuestro hábitat en paz. Hay muchas evidencias de que, en el centro de nuestra Galaxia, procedentes de los movimientos orbitales de nubes de gas próximas al núcleo galáctico y las observaciones infrarrojas de de dichas nubes, realizadas por Charles Townes y su equipo en la Universidad de California en Berkeley, muestran sin lugar a ninguna duda que están orbitando en torno a un objeto con una masa alrededor de 3 millones de veces mayor que la del Sol, y las observaciones de radio revelan una fuente de radio muy peculiar en la posición de ese objeto central.

El centro de la Vía Láctea es una región turbulenta y dinámica, con cúmulos estelares brillantes, nubes de gas caliente y campos magnéticos monstruosos. Todos ellos parecen centrados en torno a un objeto pequeño y denso conocido como Sagitario A* (Sgr A*). Las observaciones de estrellas en órbita alrededor de ese punto sugieren que es un agujero negro super-masivo. Hay poco gas entrando en espiral en Sagitario A*, quizás porque las explosiones de estrellas han expulsado la mayor parte del gas y el polvo del núcleo de la Vía Láctea. Aunque Sgr A* es, con mucho, el agujero negro super-masivo más cercano, sigue siendo relativamente difícil de estudiar, porque se halla detrás de muchas nubes espesas de polvo interestelar, que absorben la luz visible. Los astrónomos utilizan los rayos-X, ondas de radio y otras longitudes de onda para estudiar el núcleo de la Vía Láctea.

Inmensos chorros de radiación Gamma han sido descubiertos recientemente provenientes del Centro galáctico, que, como decimos más arriba, es un lugar de enorme turbulencias. Y, si todo eso es así (que lo es), nos podríamos plantear algunas preguntas: ¿Qué futuro nos espera? ¿Debemos preocuparnos de que el Agujero Negro Gigante que habita en el Centro de nuestra Galaxia engulla algún día la Tierra?

“Arriba: representación artística de un agujero negro super-masivo absorbiendo materia de una estrella cercana. Abajo: imágenes de un supuesto agujero negro super-masivo devorando una estrella en la galaxia RXJ 1242-11. Izq.: en rayos x; Der.: en luz visible.”

Bueno, no es difícil realizar algunos cálculos para saberlo. El agujero negro central de nuestra Galaxia (si es que finalmente existe y las observaciones realizadas por los astrónomos expertos coinciden con sus estimaciones) tiene una masa de alrededor 3 millones de veces la masa del Sol, y por lo tanto tiene una circunferencia de alrededor de 50 millones de kilómetros, o 200 segundos-luz, aproximadamente una décima parte de la circunferencia de la órbita de la Tierra en torno al Sol. Esto es algo minúsculo comparado con el tamaño de la propia Galaxia.

“Primera imagen real de la historia de un agujero negro super-masivo ubicado en el centro de la galaxia M87 presentado el 10 de abril de 2019 por el consorcio internacional Telescopio del Horizonte de Sucesos.”“Un agujero negro super-masivo tiene algunas propiedades interesantes que lo diferencian de otros de menor masa:

- La densidad media de un agujero negro super-masivo puede ser muy baja; de hecho puede ser menor que la densidad del agua, si su masa es suficientemente grande. Esto ocurre porque el radio del agujero negro se incrementa linealmente con la masa, por lo que la densidad decae con el cuadrado de la masa, mientras que el volumen es proporcional al cubo del radio de Schwarzschild, de tal manera que la densidad satisface la siguiente proporcionalidad:

- Donde

es la masa del sol y

la masa del agujero negro super–masivo. La cantidad anterior es inferior a la densidad del agua cuando la masa supera ciento treinta y seis millones de veces la masa solar.”

Nuestra Tierra, junto con el Sol y el conjunto de los demás planetas del Sistema planetario en el que estamos ubicados, está orbitando en torno al Centro de la Galaxia en una órbita con una circunferencia de 200.000 años-luz, alrededor de 30.000 millones de veces mayor que la circunferencia del agujero. Si el agujero llegara a engullir finalmente la mayor parte de la masa de la Galaxia, su circunferencia se expandiría sólo en aproximadamente 1 año-luz, todavía 200.000 veces más pequeño que la circunferencia de nuestra órbita.

Nuestro Centro Galáctico, ese lugar misterioso.

Por supuesto, en los aproximadamente 10¹⁸ años (100 millones de veces la edad actual del Universo) que serían necesarios para que nuestro agujero negro central se tragase una gran fracción de la masa de nuestra Galaxia, la órbita de la Tierra y el Sol habría cambiado de forma substancial. No es posible predecir los detalles de dichos cambios, puesto que no conocemos suficientemente bien las posiciones y movimientos de todas las demás estrellas que pueden encontrar el Sol y la Tierra durante 10¹⁸ años.

Por lo tanto, no podemos predecir si la Tierra y el Sol se desviarían finalmente hacia el interior del Agujero Negro central de la Galaxia o si serán expulsados de la Galaxia. Sin embargo, podemos estar seguros de que, si la Tierra fuese finalmente engullida, su muerte está aproximadamente 10¹⁸ años en el futuro, tan lejanas que otras muchas catástrofes acabarán probablemente con la Tierra y la Humanidad mucho antes.

De todas las maneras existen algunos “sucesos” en relación a los agujeros negros que no están muy claros

Sí, uno de esos probables sucesos ha sido estudiado y un grupo de investigadores de la NASA acaba de calcular cómo se producirá exactamente la titánica colisión entre la Vía Láctea, nuestra galaxia, y su vecina más cercana, Andrómeda. El acontecimiento, que tendrá lugar dentro de 4.000 millones de años, cambiará para siempre el aspecto del cielo y, de paso, la historia de nuestro Sol y su sistema de planetas. Estas conclusiones se publicaron en tres estudios diferentes en Astrophysical Journal.

Otro acontecimiento que está situado también, antes en el calendario del futuro, es que, Cuando el Sol alcance el penúltimo momento de su vida, crecerá hasta la órbita actual de la Tierra. Incinerará Mercurio y Venus. La Tierra escapará a este infortunio porque, al haber expelido el Sol parte de su masa, su fuerza de gravedad se habrá debilitado y nuestro planeta se habrá trasladado a una nueva órbita, mayor que la actual. El Sol, de color ocre-rojizo, llenará el cielo del mediodía. Mientras uno de los bordes se pone por el oeste, el otro empezará a salir por el este. Aunque bastante más frío que hoy (unos 2000 kelvin frente a 5800 kelvin), el Sol cocerá la superficie del planeta. La Tierra será entonces testigo desde dentro de la formación de una nebulosa planetaria. El Sol expulsará sus capas más exteriores-una versión extrema del viento solar actual-.

Con el tiempo, la gigante roja irá perdiendo capas, hasta que no quede de ellas más que el núcleo: se habrá convertido en una enana blanca. Alumbrados por esa incandescente mota azul en el cielo, los objetos de la Tierra proyectarán sombras muy perfiladas, negras como el azabache; la salida y la puesta del Sol no llevarán más de un abrir y cerrar de ojos. La piedra expuesta a la iluminación se convertirá en un plasma porque la radiación ultravioleta de la enana blanca destrozará cualquier enlace molecular. La superficie se cubrirá con una niebla iridiscente que no dejará de ascender y arremolinarse. A medida que la enana vaya radiando su energía, se irá enfriando y debilitando hasta convertirse en ceniza fría y oscura. Nuestro mundo terminará primero como fuego y después como hielo. “

Si ésta fuera la Nebulosa planetaria formada por el Sol en su final, ese puntido blanco central es todo lo que quedaría de nuestro Sol, una enana blanca, rodeada del gas que forma la Nebulosa Planetaria que, con el paso de los años se irá diluyendo hasta desaparecer totalmente dejando desnudo y frío el cadáver estelar que un día fue nuestro luminoso Sol. Los colores de la Nebulosa son los elementos que han sido ionizados por la intensa radiación gamma de la joven enana blanca.

Cuando el Sol se convierta en Gigante roja… ¡La Tierra lo pasará mal!

Nuestro planeta, primero calcinado por el suceso, vería como los lagos, los ríos, los mares y océanos de la Tierra se evaporarían y la vida tal como la conocemos, desaparecía, Más tarde, llegaría la congelación y el frío que la falta del calor del Sol, produciría en el planeta Tierra. Y, nosotros, si para esos momentos futuros estamos aún aquí, ya habremos aprendido a conocer mejor la naturaleza y podemos haber encontrado la manera de escapar a tan terribles finales: Primero la colisión y fusión con Andrómeda y, por su fuera poco, el Sol se nos convierte en una Gigante Roja primero y en una enana blanca después.

Si queremos escapar de todos estos (y otros que vendrán y que ahora no conocemos) sucesos, como nos dejó dicho Hilbert, “¡Debemos saber, sabremos!”.

emilio silvera

Mar

27

¡La Filosofía! Ese tesoro del pensamiento Humano

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Filosofía ~

Clasificado en Filosofía ~

Comments (3)

Comments (3)

- Todo estudio científico se compone de fases de observación, procesamiento y conclusiones finales (o leyes generalistas). Una observación puntual puede arrojar resultados que no sean los esperados por lo que en muchos casos se hace uso de la probabilidad.

“El nacimiento y desarrollo de la ciencia experimental a partir del siglo XVII ha estado frecuentemente acompañado de polémicas filosóficas, y no pocas posturas filosóficas de la época moderna han representado, en parte, intentos diversos de solucionar esas polémicas”.

Resolver las diferentes polémicas filosóficas han hecho que en la época reciente se constituyese “la filosofía de la ciencia como disciplina autónoma, que ha dado lugar a la aparición de un nuevo tipo de dedicación profesional”.

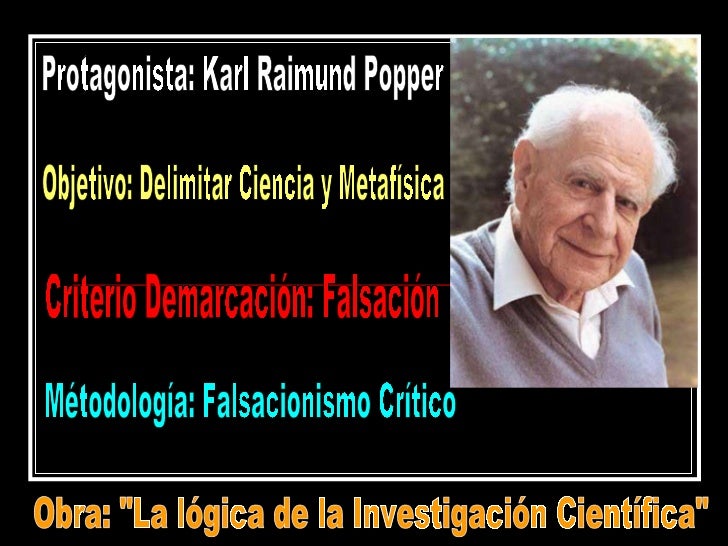

Karl Popper y el Circulo de Viena

La aparición de este nuevo tipo de filósofo suele estar ligada a las actividades del círculo de Viena “que contribuyeron decisivamente a la consolidación de la filosofía de la ciencia como disciplina autónoma”. Desde esas actividades surgieron nuevas figuras que, ancladas en las consideraciones iniciales de la filosofía neopositivista del Círculo intenta responder a la cuestión de qué es la actividad científica y cual es su racionalidad propia. Heredan de la visión positivista que la ciencia es el paradigma de la objetividad y de la racionalidad.

Junto a la postura neopositivista crecen las figuras de otros pensadores. Entre esos nuevos filósofos se encuentra Karl Popper, cuya filosofía es también un intento de explicar el método científico y la racionalidad propia de la ciencia. Se convierte, tras alguno de los miembros del Círculo, en uno de los principales artífices de la consolidación de esta disciplina. A su sombra crecieron los principales filósofos de la ciencia del siglo XX y sus ideas constituyen siempre un paradigma, ya sea para seguirlas, ya sea para criticarlas.

Aquí yace en Paz el cuerpo de Karl Popper, ya que sus pensamientos vagan por todo el Universo… ¡libres! Los logros filosóficos de Karl Popper le valieron numerosos reconocimientos, tales como ser nombrado caballero por la reina Isabel II del Reino Unido en 1969. Recibió la insignia de Compañero de Honor (Companion of Honour) en 1982, el premio Lippincott de la Asociación Norteamericana de Ciencias Políticas y el premio Sonning. Fue miembro de la Sociedad Mont Pelerin, una comunidad de estudios fundada por Hayek para promover una agenda política liberal, así como de la Royal Society de Londres, con el rango de miembro, y de la Academia Internacional de la Ciencia. Entre otras, cultivó la amistad del canciller alemán Helmut Schmidt. Algunos conocidos discípulos de Popper fueron Hans Albert, Imre Lakatos y Paul Feyerabend.

“Creo, sin embargo, que al menos existe un problema filosófico por el que se interesan todos los hombres que reflexionan: es el de la cosmología, el problema de entender el mundo… incluidos nosotros y nuestro conocimiento como parte de él. Creo que toda ciencia es cosmología, y, en mi caso, el único interés de la filosofía, no menos que el de la ciencia, reside en los aportes que ha hecho a aquella; en todo caso, tanto la filosofía como la ciencia perderían todo su atractivo para mí si abandonasen tal empresa.”

Karl Popper. La lógica de la investigación científica. México, Rei, 1991.

Popper expuso su visión sobre la filosofía de la ciencia en su obra, ahora clásica, La lógica de la investigación científica, cuya primera edición se publicó en alemán (Logik der Forschung) en 1934. En ella el filósofo austríaco aborda el problema de los límites entre la ciencia y la metafísica, y se propone la búsqueda de un llamado criterio de demarcación entre las mismas que permita, de forma tan objetiva como sea posible, distinguir las proposiciones científicas de aquellas que no lo son. Es importante señalar que el criterio de demarcaciçon no decide sobre la veracidad o falsedad de una afirmación, sino sólo sobre si tal afirmación ha de ser estudiada y discutida dentro de la ciencia o, por el contrario, se sitúa en el campo más especulativo de la metafísica. Para Popper una proposición es científica si puede ser refutable, es decir, susceptible de que en algún momento se puedan plantear ensayos o pruebas para refutarla independientemente de que salgan airosas o no de dichos ensayos.

Karl Popper en una caricatura de Tullio Pericoli

En este punto Popper discrepa intencionadamente del programa positivista, que establecía una distinción entre proposiciones contrastables (positivas), tales como Hoy llueve y aquellas que, según los positivistas, no son más que abusos del lenguaje y carecen de sentido, por ejemplo Dios existe. Para Popper, este último tipo de proposiciones sí tiene sentido y resulta legítimo discutir sobre ellas, pero han de ser distinguidas y separadas de la ciencia. Su criterio de demarcación le trajo sin querer un conflicto con Ludwing Wittgenstein, el cual también sostenía que era preciso distinguir entre proposiciones con sentido y las que no lo tienen. El criterio de distinción, para Wittgenstein, era el del “significado”: solamente las proposiciones científicas tenían significado, mientras que las que no lo tenían eran pura metafísica.

Era tarea de la filosofía desenmascarar los sinsentidos de muchas proposiciones autodenominadas científicas a través de la aclaración del significado de las proposiciones. A Popper se le encuadró en dicha escuela cuando formuló su idea de la demarcación, pero él mismo se encargó de aclarar que no estaba de acuerdo con dicho planteamiento, y que su tesis no era ningún criterio de significación (Popper siempre huyó de cualquier intento por aclarar significados antes de plantear teorías). Es más, Popper planteó que muchas proposiciones que para Wittgestein tenían significado no podían calificarse como ciencia como, por ejemplo, el psicoanálisis o el marxismo, ya que ante cualquier crítica se defendían con hipótesis ad hoc que impedían cualquier refutación.

- El problema principal: LOS LÍMITES Entre la ciencia y la metafísica Usando un criterio de ¿Cómo distinguir de los demarcación para que es ciencia de lo separar la ciencia de la que no lo es? especulación y la metafísica Para Popper una proposición es científica si puede ser refutable

- Popper planteó que muchas proposiciones que para los pensadores de su época tenían significado, no podían calificarse como ciencia como, por ejemplo, el psicoanálisis o el marxismo y, obviamente, la religión, ya que ante cualquier crítica se defendían con hipótesis ad hoc que impedían cualquier refutación.

- En el sistema de Popper se combina la racionalidad con la extrema importancia que la crítica tiene en el desarrollo de nuestro conocimiento. Por eso, tal sistema fue bautizado como racionalismo crítico. FALSABILIDAD O FALSACIÓN.

Popper estaba de acuerdo con Hume respecto de que justificar nuestro conocimiento en forma inductiva conduce al irracionalismo. Pero, negaba que los científicos normalmente utilicen inferencias inductivas. A su vez, estaba de acuerdo con Kant acerca de que la experiencia y la observación presuponen ideas a priori. Pero, negaba que esas ideas a priori sean necesariamente verdaderas. Finalmente, estaba de acuerdo con Wittgenstein y los positivistas en que no podemos recurrir a principios válidos a priori para justificar la ciencia empírica. Pero, consideraba que la metafísica no tenía porqué carecer de sentido y que la verificabilidad es incapaz de distinguir a la ciencia de la metafísica puesto que no puede dar cuentas de la cientificidad de las leyes científicas, las cuales no pueden ser verificadas a través de argumentos inductivos derivados de la experiencia.

Aquí, Popper cortó el nudo gordiano al sugerir que las teorías científicas, en última instancia, no pueden ser justificadas. También al afirmar que el conocimiento científico es racional, no porque lo hayamos justificado, sino porque podemos criticarlo.

Para Popper, cualquier intento por justificar nuestro conocimiento debe aceptar algún enunciado como verdadero sin justificación alguna, a fin de evitar el regreso infinito.

Wittgenstein y los positivistas habían apelado a la experiencia para justificar nuestro conocimiento. Al contrario, Popper afirmó que ‘el principal problema de la filosofía es el análisis crítico del recurso a la autoridad de la ‘experiencia’ –precisamente la ‘experiencia’ que todo partidario del positivismo ingenuamente da por sentada’.

Popper creía que los enunciados observacionales jamás pueden suponer la veracidad de una ley universal. Además, Popper afirmó que sólo basta un contra-ejemplo para mostrar que una ley universal es falsa. Así, concluyó que es la falsabilidad lo que distingue a la ciencia de la metafísica. También postuló que la asimetría lógica entre los enunciados universales y singulares –las teorías científicas pueden ser falsadas, mas no verificadas; los enunciados observacionales pueden ser verificados, aunque no falsados– significa que la distinción entre ciencias naturales y metafísica no puede coincidir con la distinción entre enunciados con sentido y carentes de él.

Nuestro filósofo también negó que las teorías científicas sean descubiertas a través de un proceso inductivo. Popper pensaba que los científicos no desarrollan sus teorías generalizando observaciones, sino que inventan dichas teorías a modo de soluciones hipotéticas para los problemas con los que se enfrentan; y que deben recurrir a la experiencia y a las observaciones –no para justificar– sino para testear sus hipótesis. Por tanto, el crecimiento de la ciencia es tanto empírico como racional. Es empírico porque podemos testear nuestras hipótesis frente a observaciones y a la experiencia. Es racional puesto que utilizamos las formas válidas de argumentos de la lógica deductiva para criticar las hipótesis que contradicen enunciados observacionales que pensamos son verdaderos, y porque nunca arribamos a la conclusión de haber demostrado que una teoría es verdadera cuando la misma ha sobrevivido a nuestros tests.

Lo cierto es que no podemos plasmar aquí, en un corto espacio y limitado tiempo, los pensamientos de toda una vida y, nos limitamos a tomar datos de aquí y de allá para dejar un bosquejo que nos hable de quién fue el personaje y sus pensamientos.

El No reía en los nacionalismos, decía que era como regresar a la Tribu.

¡Cuánta razón tenía!

El separatismo Catalán en España es una muestra

Por todo el mundo, en muchas de sus regiones, podemos ver los efectos negativos que dicho nacionalismo, por una u otra razón, la excusa no importa, los “inteligentes humanos” se matan. Y, de vez en cuando, sería bueno que algunos se pararan a pensar en los hechos y actuar después, emplear la lógica es bueno y debemos demostrar que somos seres raciponales. La Filosofía es un buen camino.

emilio silvera

Totales: 84.115.872

Totales: 84.115.872 Conectados: 44

Conectados: 44