Abr

24

¡La Luz! Esa maravilla

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Algunos filósofos de la antigua Grecia, entre ellos Empédocles (495-435 a.C., aprox.), consideraban a la luz como un fluido que emanaba de los ojos del observador, que actuaba al modo de unos tentáculos, asemejando el sentido de la vista al sentido del tacto.

Una metafísica de la luz. La consideración metafísica de la luz en la Edad Media es uno de esos temas a los que se le confiere un significado renovado respecto de la Antigüedad. Hay tres autores representativos del período que pueden ilustrar sobre el asunto: Pseudo-Dionisio Areopagita, Roberto Grosseteste y Tomás de Aquino.

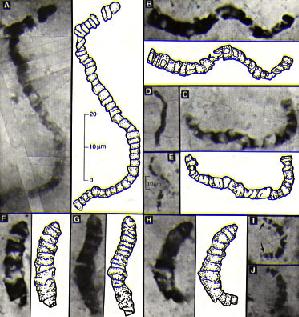

Los antiguos filósofos ya conocían algunos hechos sobre la propagación de la luz. Así se atribuye a Euclides el descubrimiento de las leyes de la reflexión de la luz (325 a. C.) Es a mediados del XVII cuando aparecen casi conjuntamente dos teorías acerca de la naturaleza de la luz. Teoría CORPUSCULAR (1666) y teoría ONDULATORIA (1678).

TEORIA CORPUSCULAR(NEWTON)

Supone que la luz está compuesta por una serie de corpúsculos o partículas emitidos por los manantiales luminosos, los cuales se propagan en línea recta y que pueden atravesar medios transparentes, y pueden ser reflejados por materias opacas. Esta teoría explica: La propagación rectilínea de la luz, la refracción y reflexión. Esta teoría no explica: Anillos de Newton (Irisaciones en las láminas delgadas de los vidrios) Este fenómeno lo explica la teoría ondulatoria y lo veremos más adelante. Tampoco explica los fenómenos de interferencia y difracción.

TEORIA ONDULATORIA (HUYGENS)

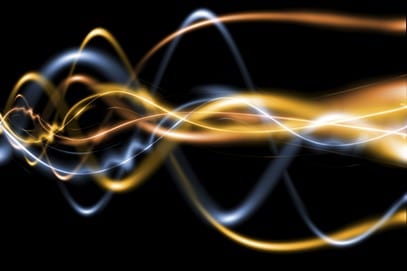

Esta teoría explica las leyes de la reflexión y la refracción , define la luz como un movimiento ondulatorio del mismo tipo que el sonido. Como las ondas se trasmiten en el vacío, supone que las ondas luminosas necesitan para propagarse un medio ideal, el ETER, presente tanto en el vacío como en los cuerpos materiales.

Esta teoría no fue aceptada debido al gran prestigio de Newton. Tuvo que pasar más de un siglo para que se tomara nuevamente en consideración la “Teoría Ondulatoria”. Los experimentos de Young (1801) sobre fenómenos de interferencias luminosas, y los de Fresnel sobre difracción fueron decisivos para que se tomaran en consideración los estudios de Huygens y para la explicación de la teoría ondulatoria.

TEORIA ELECTROMAGNETICA (MAXWELL 1865)

Descubre que la perturbación del campo electromagnético puede propagarse en el espacio a una velocidad que coincide con la de la luz en el vacío, equiparando por tanto las ondas electromagnéticas con las ondas luminosas.

Veinte años después Hertz comprueba que las ondas hertzianas de origen electromagnético tienen las mismas propiedades que las ondas luminosas, estableciendo definitivamente la identidad de ambos fenómenos.

Está claro que, los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1.637.

Siempre nos gustó hacer experimentos con la luz

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden.

Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro”, “fantasma”).

Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietudes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

En 1.678, el físico neerlandés Christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

Peor la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sombras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿Cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿cuál era esa mecánica ondulatoria?

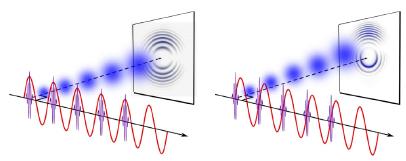

Interferencia: Sonido más sonido en algunos casos puede producir silencio. Esto sucede cuando dos ondas de sonido se superponen destructivamente, igual como se observa en las zonas nodales de una cuerda en vibración. ¿Será posible que en algún caso luz más luz produzca oscuridad? La respuesta es afirmativa. Quien lo demostrara en 1803, en un famoso experimento, fue Thomas Young (1773-1829). Éste consistió en hacer llegar un haz de luz simultáneamente a dos rendijas muy delgadas y muy cercanas, según se ilustra en el siguiente esquema.

Aproximadamente durante un siglo, contendieron entre sí estas teorías. La teoría corpuscular, de Newton, fue, con mucho, la más popular, en parte, porque la respaldó el famoso nombre de su autor. Pero hacia 1.801, un físico y médico ingles, de nombre Thomas Young, llevó a cabo un experimento que arrastró la opinión pública al campo opuesto. Proyectó un fino rayo luminoso sobre una pantalla, haciéndolo pasar antes por dos orificios casi juntos. Si la luz estuviera compuesta por partículas, cuando los dos rayos emergieran de ambos orificios, formarían presuntamente en la pantalla una región más luminosa donde se superpusieran, y regiones menos brillantes, donde no se diera tal superposición. Pero no fue esto lo que descubrió Young. La pantalla mostró una serie de bandas luminosas, separadas entre sí por bandas oscuras. Pareció incluso que, en esos intervalos de sombra, la luz de ambos rayos contribuía a intensificar la oscuridad.

Sería fácil explicarlo mediante la teoría ondulatoria. La banda luminosa representaba el refuerzo presado por las ondas de un rayo a las ondas del otro. Dicho de otra manera: Entraba “en fase” dos trenes de ondas, es decir, ambos nodos, al unirse, se fortalecían el uno al otro. Por otra parte, las bandas oscuras representaban puntos en que las ondas estaban “desfasadas” porque el vientre de una neutralizaba el nodo de la otra. En vez de aunar sus fuerzas, las ondas se interferían mutuamente, reduciendo la energía luminosa neta a las proximidades del punto cero.

Considerando la anchura de las bandas y la distancia entre los dos edificios por los que surgen ambos rayos, se pudo calcular la longitud de las ondas luminosas, por ejemplo, de la luz roja a la violeta o los colores intermedios. Las longitudes de onda resultaron ser muy pequeñas. Así, la de la luz roja era de unos 0’000075 cm. (Hoy se expresan las longitudes de las ondas luminosas mediante una unidad muy práctica ideada por Angströn. Esta unidad, denominada, en honor a su autor Ángstrom (Á), es la cienmillonésima parte de un centímetro. Así, pues, la longitud de onda de la luz roja equivale más o menos a 7.500 Á, y la de la luz violeta, a 3.900 Å, mientras que las de colores visibles en el espectro oscilan entre ambas cifras.)

La cortedad de estas ondas es muy importante. La razón de que las ondas luminosas se desplacen en línea recta y proyecten sombras recortadas se debe a que todas son incomparablemente más pequeñas que cualquier objeto; pueden contornear un obstáculo sólo si éste no es mucho mayor que la longitud de onda. Hasta las bacterias, por ejemplo, tienen un volumen muy superior de una onda luminosa y, por tanto, la luz puede definir claramente sus contornos bajo el microscopio. Sólo los objetos cuyas dimensiones se asemejan a la longitud de la onda luminosa (por ejemplo, los virus y otras partículas submicroscópicas) son lo suficientemente pequeños como para que puedan ser contorneados por las ondas luminosas.

Augustin Jean Fresnel (1788 – 1827)

Un físico francés, Augustin-Jean Fresnel, fue quien demostró por vez primera, en 1.818, que si un objeto es lo suficientemente pequeño, la onda luminosa lo contorneará sin dificultad. En tal caso, la luz determina el llamado fenómeno de “difracción”. Por ejemplo, las finísimas líneas paralelas de una “reja de difracción” actúan como una serie de minúsculos obstáculos, que se refuerzan entre si. Puesto que la magnitud de la difracción va asociada a la longitud de onda, se produce el espectro. A la inversa, se puede calcular la longitud de onda midiendo la difracción de cualquier color o porción del espectro, así como la separación de las marcas sobre el cristal.

Fraunhofer exploró dicha reja de difracción con objeto de averiguar sus finalidades prácticas, progreso que suele olvidarse, pues queda eclipsado por su descubrimiento más famoso: los rayos espectrales. El físico americano Henry Augustus Rowlane ideó la reja cóncava y desarrolló técnicas para regularlas de acuerdo con 20.000 líneas por pulgada. Ello hizo posible la sustitución del prisma por el espectroscopio.

Ante tales hallazgos experimentales, más el desarrollo metódico y matemático del movimiento ondulatorio, debido a Fresnel, pareció que la teoría ondulatoria de la luz había arraigado definitivamente, desplazando y relegando para siempre a la teoría corpuscular.

Jacques Babinet y el Observatorio de Paris

No sólo se aceptó las existencias de ondas luminosas, sino que también se midió su longitud con una precisión cada vez mayor. Hacia 1.827, el físico francés Jacques Babinet sugirió que se empleara la longitud de onda luminosa (una cantidad física inalterable) como unidad para medir tales longitudes, en vez de las muy diversas unidades ideadas y empleadas por el hombre. Sin embargo, tal sugerencia no se llevó a la práctica hasta 1.880 cuando el físico germano-americano Albert Abraham Michelson inventó un instrumento, denominado “interferómetro”, que podía medir las longitudes de ondas luminosas con una exactitud sin precedentes. En 1.893, Michelson midió la onda de la raya roja en el espectro del cadmio y determinó que su longitud era de 1/1.553.164 m.

Pero la incertidumbre reapareció al descubrirse que los elementos estaban compuestos por isótopos diferentes, cada uno de los cuáles aportaba una raya cuya longitud de onda difería ligeramente de las restantes. En la década de 1.930 se midieron las rayas del criptón 86. Como quiera que este isótopo fuera gaseoso, se podía abordar con bajas temperaturas, para frenar el movimiento atómico y reducir el consecutivo engrosamiento de la raya.

Tubo de descarga lleno de kriptón puro

En 1.960, el Comité Internacional de Pesos y Medidas adoptó la raya del criptón 86 como unidad fundamental de longitud. Entonces se restableció la longitud de metro como 1.650.763’73 veces la longitud de onda de dicha raya espectral. Ello aumento mil veces la precisión de las medidas de longitud. Hasta entonces se había medido el antiguo metro patrón con un margen de error equivalente a una millonésima, mientras que en lo sucesivo se pudo medir la longitud de onda con un margen de error equivalente a una milmillonésima.

Ahora, después de todo esto, sabemos algo más sobre la luz. Pero…, ¿Qué pasa con su velocidad?

¡Veámoslo!

La velocidad de la luz, desde hace mucho tiempo, fue un misterio que los estudiosos de la física de la Naturaleza querían desvelar

Está claro que, la luz se desplaza a enormes velocidades. Si pulsamos el interruptor de apagado de la lámpara de nuestro salón, todo queda a oscuras de manera instantánea y, de la misma manera e inmediata, todo se inunda de luz si con una potente linterna encendida, apuntamos hacia un rincón oscuro.

La velocidad del sonido es más lenta, por ejemplo, si vemos a un leñador que está cortando leña en un lugar alejado de nosotros, sólo oiremos los golpes momentos después de que caiga el hacha. Así, pues, el sonido tarda cierto tiempo en llegar a nuestros oídos. En realidad es fácil medir la velocidad de su desplazamiento: unos 1.206 km/h en el aire y a nivel del mar.

Sin materia no hay sonido. aquí se propaga el contacto del hacha contra el tronco

Galileo fue el primero en intentar medir la velocidad de la luz. Se colocó en lo alto de una colina, mientras que su ayudante, se situaba en otro lugar alto de la colina vecina; luego sacó una linterna encendida: tan pronto como su ayudante vió la luz, hizo una señal con otra linterna. Galileo repitió el experimento a distancias cada vez mayores, suponiendo que el tiempo requerido por su ayudante para responder mantendría una uniformidad constante, por lo cual, el intervalo entre la señal de su propia linterna y la de su ayudante representaría el tiempo empleado por la luz para recorrer cada distancia. Aunque la idea era lógica, la luz viajaba demasiado aprisa como para que Galileo pudiera percibir las sutiles diferencias con un método tan rudimentario.

Fue el primero en medir la velocidad de la luz allá por 1676. … Para la determinación de la velocidad de la luz, Ole Roemer obtuvo un valor de 214000 km/s, aceptable dada la poca precisión con la que se podía medir en aquella época la distancia de los planetas.

En 1.676, el astrónomo danés Olau Roemer logró cronometrar la velocidad de la luz a escala de distancias astronómicas. Estudiando los eclipses de Júpiter en sus cuatro grandes satélites, Roemer observó que el intervalo entre eclipses consecutivos era más largo cuando la Tierra se alejaba de Júpiter, y más corto cuado se movía en su órbita hacía dicho astro. Al parecer, la diferencia entre las duraciones del eclipse reflejaba la diferencia de distancias entre la Tierra y Júpiter. Y trataba, pues, de medir la distancia partiendo del tiempo empleado por la luz para trasladarse desde Júpiter hasta la Tierra. Calculando aproximadamente el tamaño de la órbita terrestre y observando la máxima discrepancia en las duraciones del eclipse que, según Roemer, representaba el tiempo que necesitaba la luz para atravesar el eje de al órbita terrestre, dicho astrónomo computó la velocidad de la luz. Su resultado, de 225.000 km/s., parece excelente si se considera que fue el primer intento, y resultó bastante asombroso como para provocar la incredulidad de sus coetáneos.

James Bradley

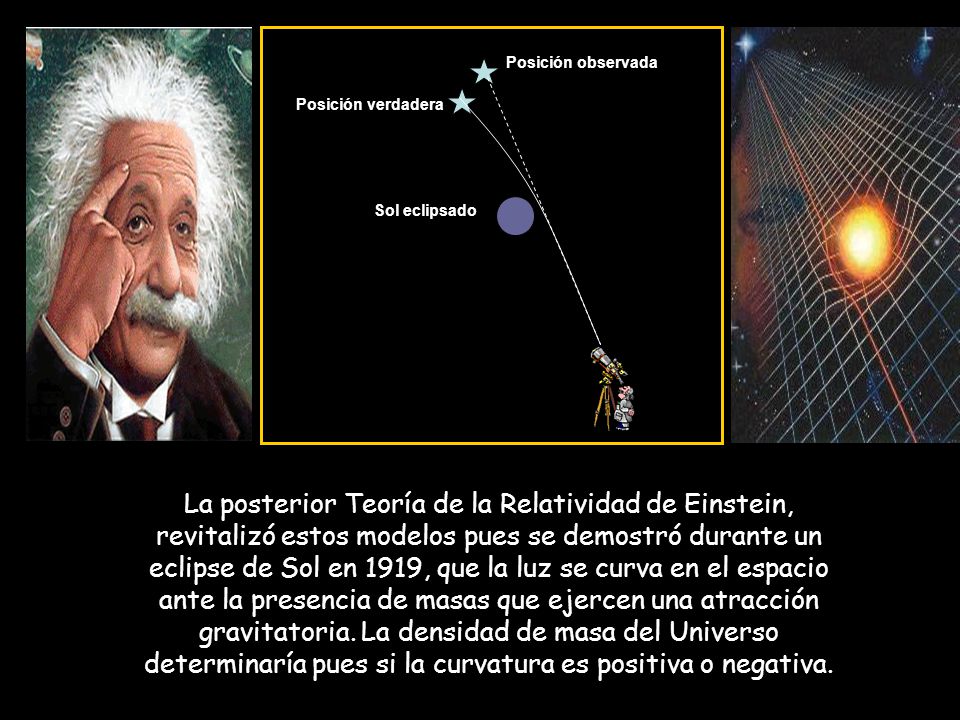

“A principios del XVIII todavía no se sabía a qué distancia se encontraban las estrellas, pero dado que se admitía que la Tierra orbitaba en torno al Sol, ya parecía posible medir el movimiento paraláctico de las mismas, lo que permitiría medir sus distancias. Tratando de medir ese movimiento, el astrónomo británico James Bradley descubrió el fenómeno de la aberración de la luz, con lo que confirmó inequívocamente el movimiento de traslación de la Tierra y estimó la velocidad de la luz. Bradley también descubrió y midió la nutación o cabeceo de los polos terrestres. Una vez identificados estos efectos, se estaba preparado para medir el pequeño movimiento paraláctico de las estrellas, un efecto menor que el de la aberración. Pero aún habría que esperar más de un siglo a que Friedrich Bessel (1784-1846) midiese -en 1838- la primera paralaje hacia la estrella 61 Cygni, lo que proporcionaría una primera idea de la inmensidad de la Galaxia.”

Sin embargo, medio siglo después se confirmaron los cálculos de Roemer en un campo totalmente distinto. Allá por 1.728, el astrónomo británico James Bradley descubrió que las estrellas parecían cambiar de posición con los movimientos terrestres; y no por el paralaje, sino porque la traslación terrestre alrededor del Sol era una fracción mensurable (aunque pequeña) de la velocidad de la luz. La analogía empleada usualmente es la de un hombre que camina con el paraguas abierto bajo un temporal. Aun cuando las gotas caigan verticalmente, el hombre debe inclinar hacia delante el paraguas, porque ha de abrirse paso entre las gotas.

James Bradley descubrió la aberración estelar

Cuanto más acelere su paso, tanto más deberá inclinar el paraguas. De manera semejante la Tierra avanza entre los ligeros rayos que caen desde las estrellas, y el astrónomo debe inclinar un poco su telescopio y hacerlo en varias direcciones, de acuerdo con los cambios de la trayectoria terrestre (no olvidemos que nuestro planeta Tierra, es como una enorme nave espacial que nos lleva en un viaje eterno, alrededor del Sol, a la velocidad de 30 km/s. + -) Mediante ese desvío aparente de los astros (“aberración de la luz”), Bradley pudo evaluar la velocidad de la luz y calcularla con gran precisión.

Sus cálculos fueron de 285.000 km/s, bastante más exacto que los de Roemer, pero aún un 5’5% más bajos. Poco a poco, con medios tecnológicos más sofisticados y más conocimientos matemáticos, los científicos fueron obteniendo medidas más exactas aún, conforme se fue perfeccionando la idea original de Galileo y sus sucesores.

En 1.849, el físico francés Armand-Hippolyte-Louis Fizeau ideó un artificio mediante el cual se proyectaba la luz sobre un espejo situado a 8 km de distancia, que devolvía el reflejo al observador. El tiempo empleado por la luz en su viaje de ida y vuelta no rebasó apenas la 1/20.000 de segundo, pero Fizeau logró medirlo colocando una rueda dentada giratoria en la trayectoria del rayo luminoso. Cuando dicha rueda giraba a cierta velocidad, regulada, la luz pasaba entre los dientes y se proyectaba contra el siguiente, al ser devuelta por el espejo; así, Fizeau, colocado tras la rueda, no pudo verla. Entonces se dio más velocidad a la rueda, y el reflejo pasó por la siguiente muesca entre los dientes, sin intercepción alguna. De esa forma, regulando y midiendo la velocidad de la rueda giratoria, Fizeau pudo calcular el tiempo transcurrido y, por consiguiente, la velocidad a que se movía el rayo de luz.

Un año más tarde, Jean Foucault (quien realizaría poco después su experimento con los péndulos) precisó más estas medidas empleando un espejo giratorio en ve de una rueda dentada. Entonces se midió el tiempo transcurrido desviando ligeramente el ángulo de reflexión mediante el veloz espejo giratorio. Foucault obtuvo un valor de la velocidad de la luz de 300.883 km/s. También, el físico francés utilizó su método para determinar la velocidad de la luz a través de varios líquidos. Averiguó que era notablemente inferior a la alcanzada en el aire. Esto concordaba también con la teoría ondulatoria de Huyghens.

Michelson fue más preciso aún en sus medidas. Este autor, durante cuarenta años largos, a partir de 1.879, fue aplicando el sistema Fizeau-Foucault cada vez con mayor refinamiento, para medir la velocidad de la luz. Cuando se creyó lo suficientemente informado, proyectó la luz a través de vacío, en vez de hacerlo a través del aire, pues este frena ligeramente su velocidad, y, empleó para ello tuberías de acero cuya longitud era superior a 1’5 km. Según sus medidas, la velocidad de la luz en el vacío era de 299.730 km(seg. (sólo un 0’006% más bajo). Demostraría también que todas las longitudes de ondas luminosas viajan a la misma velocidad en el vacío.

En 1.972, un equipo de investigadores bajo la dirección de Kenneth M. Eveson efectuó unas mediciones aún más exactas y vio que la velocidad de la luz era de 299.727’74 km/seg. Una vez se conoció la velocidad de la luz con semejante precisión, se hizo posible usar la luz, o por lo menos formas de ella, para medir distancias.

Aunque para algunos resulte alto tedioso el tema anterior, no he podido resistirme a la tentación de exponerlo, así podrá saber algo más sobre la luz y, habrán conocido a personajes que hicieron posible el que ahora nosotros, la conozcamos mejor.

Podría continuar, hasta el final de este trabajo, hablando de la luz y sus distintas formas o aplicaciones: ondas de luz a través del espacio, de cómo se transmite la luz en el “vacío”, nos llega a través del espacio desde Galaxias situadas a miles de millones de años luz; las líneas de fuerzas electromagnéticas de Faraday y Maxwell de campos eléctricos y magnéticos cambiantes (todo ello explicado en un simple conjunto de cuatro ecuaciones, que describían casi todos los fenómenos referentes a esta materia electromagnética), o de los enigmas aún por descubrir (aunque predichos).

Ahora, en Física, se dice que la luz es una forma de radiación electromagnética a la que el ojo humano es sensible y sobre la cual depende nuestra consciencia visual del universo y sus contenidos.

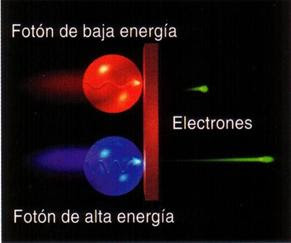

Aparte de todo lo que antes hemos explicado, no sería justo finalizar el trabajo sin exponer aquí que, en 1905, Albert Einstein, inspirado en el cuanto de Planck, realizó un importante avance en el conocimiento de lo que es la luz. Demostró que el Efecto fotoeléstrico sólo podía ser explicado con la hipótesis de que la luz consiste en un chorro de fotones de energía electromagnética discretos. Aquello le valió el Nobel de Física y… ¡Le hurtaron otros dos por las dos partes de su teoría de la relatividad! Una revolución que lo cambió todo y que nunca podremos pagarle.

El conflicto entre la teoría ondulatoria y corpuscular de la luz fue resuelto con la evolución de la teoría cuántica y la mecánica ondulatoria que ha dejado claro que, los electrones y las otras partículas elementales tienen propiedades duales de partículas y onda.

sería mucho más largo, pero creo que está bien con lo dicho.

emilio silvera

Abr

23

El Universo es dinámico y, ¡misterioso!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

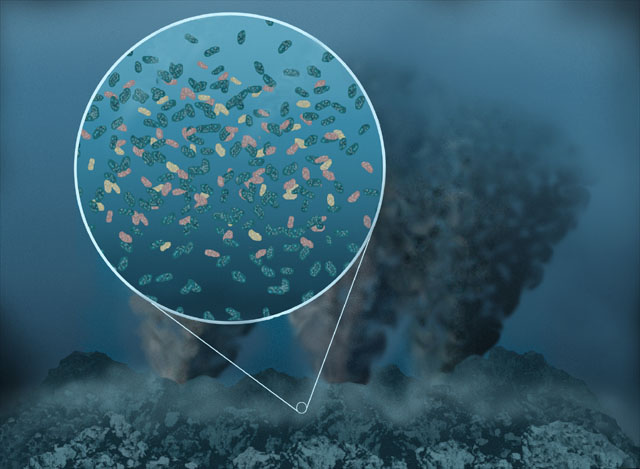

En no pocas ocasiones uno se ha parado a pensar en cómo pudo surgir el Universo a partir de la “nada”. Si surgió es porque había. Y, desde luego, todo está directamente relacionado con eso que se conoce por fluctuaciones, esas desviaciones aleatorias en el valor de las cosas sobre su valor medio. No hay que perder de vista los sistemas descritos por la mecánica cuántica, en ellos están bien definidas esas fluctuaciones que, en esa infinitesimal región se llaman “fluctuaciones cuánticas” y, tienen mucho que ver con el Principio de Incertidumbre de Heisenberg.

En Cualquier sistema por encima del cero absoluto se pueden presentar dichas fluctuaciones. Es necesario que tengamos en cuenta dichas fluctuaciones para poder obtener una teoría cuantitativa de de las “transiciones de fase” en tres dimensiones. Incluso se puede llegar a pensar que las “fluctuaciones cuánticas” pudieron ser las responsables de la formación de las estructuras en el universo primitivo que pudo surgir de una “Fluctuación del Vacío” que rasgando el espacio tiempo en otro lugar, produjo la opción de crear nuestro universo, o, incluso, múltiples universos conectados al principio y separados más tarde para hacerse unidades independientes de universos.

Lo que vemos arriba marcado dentro de un círculo es lo que se conoce como el Gran Vacío de Boötes, uno de los mayores “vacíos conocidos de nuestro Universo. El Tiene unos 250 millones de años luz de diámetro (casi el 0.27% del diámetro del universo visible), o unos 236,000 Mpc3 en el volumen. Se considera un super-vació y sólo tiene dentro de él a unas sesenta galaxias. Fue descubierto por Robert Kirshner (1981), como parte de un estudio de corrimientos al rojo galácticos. El centro del Vacío Boötes esta a aproximadamente 700 millones de años luz de la Tierra.

En astronomía, el vacío está referido a regiones del espacio con menor contenido de Galaxias que el promedio o ninguna galaxia. También le solemos llamar vacío cósmico. Han sido detectados vacíos con menos de una décima de la densidad promedio del Universo en escalas de hasta 200 millones de años-luz en exploraciones a gran escala.

El vacío, en el sentido de ausencia total de cualquier cosa, ya sea materia o energía, no existe. Incluso si en una región determinada de espacio consiguiéramos no toparnos con nada, ni siquiera con una única partícula solitaria que lo cruce, seguiría habiendo allí una serie de «fluctuaciones», diminutas ondas de naturaleza cuántica que, apareciendo y desapareciendo continuamente, harían que ese espacio burbujeara de energía.

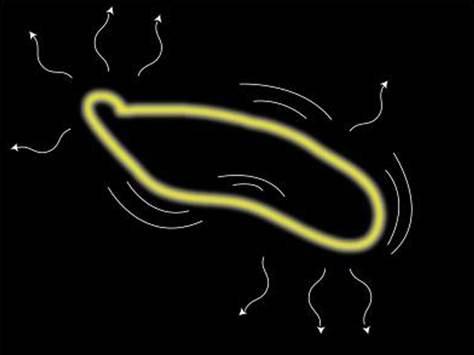

Sabemos que la “Nada” no existe y que, a partir de las “Fluctuaciones de vacío” nace la materia

El ojo humano es limitado, es mucho lo que está y no puede ver

¡Las fluctuaciones de vacío! que, al igual que las ondas “reales” de energía positiva, están sujetas a las leyes de la dualidad onda/partícula; es decir, tienen tanto aspectos de onda como aspectos de partícula. Las ondas fluctúan de forma aleatoria e impredecible, con energía positiva momentáneamente aquí, energía negativa momentáneamente allí, y energía cero en promedio. El aspecto de partícula está incorporado en el concepto de partículas virtuales, es decir, partículas que pueden nacer en pares (dos partículas a un tiempo), viviendo momentáneamente de la energía fluctuacional tomada prestada de regiones “vecinas del espacio”, y que luego se aniquilan y desaparecen, devolviendo la energía a esas regiones vecinas. Si hablamos de fluctuaciones electromagnéticas del vacío las partículas virtuales son fotones virtuales; en el caso de fluctuaciones de la Gravedad en el vacío, son gravitones virtuales.

Ni con los ojos abiertos como platos hemos podido “ver” lo que “hay” en esas “regiones vecinas” a nuestro mundo y que llamamos vacío en el que se producen fluctuaciones que hace surgir “cosas” que, de inmediato, desaparecen. Insistimos en querer verlas para saber y no dejamos de preguntarnos… ¿Qué es lo que hay allí? ¿Vivirá en esa región la tan buscada partícula de Higgs, la materia oscura o las cuerdas? ¿Qué es lo que allí puede haber? En realidad sabemos que las fluctuaciones de vacío son, para las ondas electromagnéticas y gravitatorias, lo que “los movimientos de degeneración claustrofóbicos” son para los electrones.

Si confinamos un electrón a una pequeña región del espacio, entonces, por mucho que un trate de frenarlo y detenerlo, el electrón está obligado por las leyes de la mecánica cuántica a continuar moviéndose aleatoriamente, de forma impredecible. Este movimiento de degeneración claustrofóbico que produce la presión mediante la que una estrella enana blanca se mantiene contra su propia compresión gravitatoria o, en el mismo caso, la degeneración de los neutrones, mantiene estable a la estrella de neutrones que, obligada por la fuerza que se genera de la degeneración de los neutrones, es posible frenar la enorme fuerza de gravedad que está comprimiendo a la estrella.

De la misma forma, si tratamos de eliminar todas las oscilaciones electromagnéticas o gravitatorias de alguna región del espacio, nunca tendremos éxito. Las leyes de la mecánica cuántica insisten en que siempre quedarán algunas oscilaciones aleatorias impredecibles, es decir, algunas ondas electromagnéticas y gravitatorias aleatorias e impredecibles. Estas fluctuaciones del vacío no pueden ser frenadas eliminando su energía (aunque algunos estiman que, en promedio, no contienen energía en absoluto).

Claro que, aún nadie ha podido medir de ninguna manera la cantidad real de energía que se escapa de ese supuesto “vacío”, como tampoco se ha medido la cantidad de fuerza gravitatoria que puede salir de ese mismo espacio “vacío”. Si la energía es masa y si la masa produce gravedad, entonces ¿Qué es lo que hay en ese mal llamado “espacio vacío”?

Podemos imaginar que el vacío es un depósito de energía: las partículas virtuales surgen del vacío, tomando prestada temporalmente parte de su energía. En física, lo normal es sorprenderse y leer cosas como esta:

“Así, como entramos en una nueva era para comprender el tiempo, también hemos entrado a una nueva era de comprender el espacio. Se ha descubierto que lo que llamamos espacio vacío, el vacío, en realidad está repleto de inmensa energía potencial. La conclusión ordinaria de considerar el espacio como la nada, el lugar donde se sitúa la materia, evidentemente se ha convertido en nuestro espacio. Pero el vacío tiene más energía que la materia que está en ese vacío y de hecho, la materia y el vacío son una misma cosa, hay una continuidad. Se ha descubierto que hay más energía en un centímetro cúbico de vacío que en todo el Universo manifiesto.”

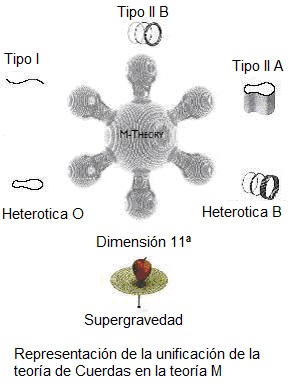

Lo cierto es que estamos en un momento crucial de la Física, las matemáticas y la cosmología, y debemos, para poder continuar avanzando, tomar conceptos nuevos que, a partir de los que ahora manejamos, nos permitan traspasar los muros que nos están cerrando el paso para llegar a las supercuerdas, a la posible “materia oscura” o a una “teoría cuántica de la gravedad” que, también está implícita en la teoría M.

Claro que esto estuvo bien pero… Habrá que buscar cosas nuevas que nos lleven más allá. Llevamos más de cien años utilizando las mismas herramientas (el cuanto de Planck y la relatividad de Einstein), sería la hora de que alguien iluminado tenga esa idea que nos haga dar ese gran paso hacia la física del futuro.

Las nuevas tecnologías cambiaran el futuro

Estamos anclados, necesitamos nuevas y audaces ideas que puedan romper las cadenas “virtuales” que atan nuestras mentes a ideas del pasado que, como la relatividad y la mecánica cuántica llevan cien años predominando sobre la física. ¿No es tiempo ya de andar otros caminos que nos lleven más lejos, que nos enseñen otros horizontes? ¿Dónde están las ideas? ¿Dónde nuestra imaginación?

Como nos dicen en este anuncio del Kybalión, nada es estático en el Universo y, todo está en continuo movimiento o vibración. Habréis oído hablar de la energía de punto cero que permanece en una sustancia en el cero absoluto (cero K). Está de acuerdo con la teoría cuántica, según la cual, una partícula oscilando con un movimiento armónico simple no tiene estado estacionario de energía cinética nula. Es más, el Principio de Incertidumbre no permite que esta partícula esté en reposo en el punto central exacto de sus oscilaciones. Del vacío surgen sin cesar partículas virtuales que desaparecen en fracciones de segundo, y, ya conocéis, por ejemplo, el Efecto Casimir en el que dos placas pueden producir energía negativa surgidas del vacío.

Efecto Casimir

Me llama poderosamente la atención lo que conocemos como las fluctuaciones de vacío; esas oscilaciones aleatorias, impredecibles e in-eliminables de un campo (electromagnético o gravitatorio), que son debidas a un tira y afloja en el que pequeñas regiones del espacio toman prestada momentáneamente energía de regiones adyacentes y luego la devuelven.

La bomba turbo, nos permite después del proceso de horneo llegar a régimen de ultra alto vacío (mejor que 1E-7 mbar.)

Ordinariamente, definimos el vacío como el espacio en el que hay una baja presión de un gas, es decir, relativamente pocos átomos o moléculas. En ese sentido, un vacío perfecto no contendría ningún átomo o molécula, pero no se puede obtener, ya que todos los materiales que rodean ese espacio tienen una presión de vapor infinita. En un bajo vacío, la presión se reduce hasta 10-2 pascales, mientras que un alto vacío tiene una presión de 10-2 – 10-7 pascales. Por debajo de 10-7 pascales se conoce como un vacío ultra-alto. Tenemos que llegar a la conclusión de que el “vacío” y la “nada” no existen realmente. ¡Siempre hay!

“La raíz etimológica de «nada»: res nata, es contradictoria del significado actual, pues significa cosa nacida. Quizás este -para muchos- insospechado y contundente hecho justifique las tal vez permanentes e irreconciliables concepciones antagónicas, y la reificación no incurra ya en falacia.

En contraste, en la filosofía griega la idea de la nada surgió con los problemas de la negación del ser, de la conservación del ser y de la imposibilidad de afirmar la nada. En particular, Parménides creyó que del «no ser» (la nada) no se puede hablar. Epicuro y Lucrecio aseveraron que la materia no se puede crear de la nada, ni destruir a nada”. Hasta los antiguos sospechaban esa verdad.

Fui a una charla de Álvaro Rújula del CERN y, entre otras cosas decía:

“Saquemos los muebles de la habitación, apaguemos las luces y vayámonos. Sellemos el recinto, enfriemos las paredes al cero absoluto y extraigamos hasta la última molécula de aire, de modo que dentro no quede nada. ¿Nada? No, estrictamente hablando lo que hemos preparado es un volumen lleno de vacío. Y digo lleno con propiedad. Quizás el segundo más sorprendente descubrimiento de la física es que el vacío, aparentemente, no es la nada, sino una substancia. Aunque no como las otras…”

Siempre hay

El hombre lleva toda la razón y es cierto que en física, la “nada” no existe y es simplemente una abstracción, un concepto, una manera de hablar para entendernos en ciertos aspectos de la conversación. Como antes he dicho por ahí arriba, existe ese algo que surge del “espacio vacío” y que conocemos como partículas virtuales, las que constantemente se crean y se destruyen y aunque no son observables de manera directa, los efectos que dichas partículas generan si que lo son. En ese sentido la física curiosamente se alinea con la etimología de la palabra nada. Todo esto, ese fenómeno que no hemos llegado a comprender nos lleva a sospechar que, ahí reside un a “identidad secreta” que nos pone delante de “la nada y el nacer”, es decir, nos pone delante del plano que nos dice que… !la nada puede ser el nacimiento! Lo que hace posible el propio proceso de nacer, o, dicho de otra manera, la “nada” podría ser la perenne potencia de ser.

Gráfico del Principio de Indeterminación de Heisenberg.

Así, podemos llegar a la conclusión de que debido a la extraña mecánica cuántica, “la nada” se puede transformar en “algo” de manera constante. El Principio de Incertidumbre de Heisenberg señala que un sistema nunca puede tener exactamente cero energía y como la energía es masa -la relatividad especial nos demostró que son dos caras de una misma moneda-, podríamos llegar a entender el por qué, pares de partículas se pueden formar espontáneamente siempre y cuando se aniquilen rápidamente para restablecer el equilibrio.

En mecánica cuántica, la Incertidumbre nos dice que hay una compensación entre energía y tiempo: Cuanta menor energía tiene un sistema, más tiempo podrá mantenerse. Lo mismo les pasa a las estrellas super-masivas que duran mucho menos que estrellas más pequeñas que consumen menos materia de fusión nuclear. Si pensamos en todo eso, incluso podríamos llegar a la conclusión final de que, el Universo, que tiene 13.700 millones de años, ha tenido el tiempo necesario para poder formar, a partir del “vacío cuántico” estrellas y galaxias llenas de mundos y de formas de vida complejas, gracias a que, su energía en conjunto, debe ser -teniendo en cuenta su extensión- demasiado baja, o, lo necesariamente baja para que eso sea posible.

Claro que, a pesar de todo lo que más arriba he dicho, debemos llegar a la conclusión de que “no sabemos”, y, el hecho cierto de que, hayamos sido capaces de desvelar “algunos” secretos de la Naturaleza, no debe ser suficiente para que se nos suban esos “pequeños” triunfos a la cabeza. Newton nos descubrió que la luz del Sol o luz blanca, era el producto de la mezcla de todos los componentes coloreados, hizo pasar un rayo de luz por un prisma y, la habitación donde hacía el experimento, sus paredes, se llenaron de luciérnagas luminosas de muchos colores, el arco iris estaba allí, del rojo al violeta, descompuestos en mariposas luminosas.

Planck nos habló del cuanto de energía, h. Einstein nos dijo que la energía y la masa eran la misma cosa y que la luz marcaba el límite al que podemos enviar la información en nuestro universo. Otros descubrieron de qué estaba formada la materia y cómo se transmitían las fuerzas fundamentales del nuestro Universo. Pudimos descubrir la existencia de unas constantes universales que hacían posible un Universo como el que nos acoge. Muchos otros secretos fueron desvelados y “arrancados” de la “gruta de los tesoros” que la Naturaleza esconde.

Todo eso es cierto, y, nuestro cerebro, una obra de la Naturaleza que lo hizo surgir a partir de la materia “inerte”, que ha podido evolucionar para desvelar todos esos secretos y, sin embargo, no debemos confundir -para nuestro propio bien-, que unos pocos conocimientos son los conocimientos. Como decía el sabio:

“cuanto más profundizo en el saber de las cosas, más consciente soy de lo poco que sé. Mis conocimientos son finitos pero, mi ignorancia, es infinita“.

“La ciencia no es otra cosa que la empresa de descubrir la unidad en la variedad desaforada de la naturaleza, o más exactamente, en la variedad de nuestra experiencia que está limitada por nuestra ignorancia.”

Yo creo que la Ciencia es un proceso de ir descubriendo a cada paso un orden nuevo que nos lleve a unir lo que parecía desunido. Todo en el Universo tiene una relación y, lo que pasa “aquí”, de alguna manera, influye en lo que pasará “allí”. Todo parece estar conectado por hilos invisibles de la Gravedad y el electromagnetismo que tienen alcance infinito y están presentes en todas partes, también en nosotros influyen esas y las otras fuerzas fundamentales del Universo para que seamos como somos y no de otra manera.

emilio silvera

Abr

23

¿Cómo poder ver la realidad… “del mundo” que nos rodea?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Si sabemos mirar la Naturaleza… Nos irá mucho mejor

No pocos se pasan la vida sin ver lo que existe a su alrededor, el trabajo, la familia, el coche nuevo, la hipoteca del chalet, alcanzar ese puesto más alto… Se pasan la vida en esa vorágine circunscrita a un pequeño “mundo” personal que le aleja de una realidad que es mucho más grande y, sin darse cuenta, se le pasa la vida sin haber podido ver todo lo que existe a su alrededor que, dejando a un lado las pequeñas cosas, también estaba a su alcance.

Es fácil caer en la tentación de mirarnos el ombligo y no hacerlo al entorno que nos rodea. Muchas más cosas habríamos evitado y habríamos descubierto si por una sola vez hubiésemos dejado el ego a un lado y, en lugar de estar pendientes de nosotros mismos, lo hubiéramos hecho con respecto a la Naturaleza que, en definitiva, es la que nos enseña el camino a seguir, nos elimina (de mil maneras diferentes) o permite que podamos seguir contemplando sus maravillas.

La edad actual del universo visible ≈ 1060 tiempos de Planck

Tamaño actual del Universo visible ≈ 1060 longitudes de Planck

La masa actual del Universo visible ≈ 1060 masas de Planck

Vemos así que la bajísima densidad de materia en el universo es un reflejo del hecho de que:

Densidad actual del universo visible ≈10-120 de la densidad de Planck

Y la temperatura del espacio, a 3 grados sobre el cero absoluto es, por tanto

Temperatura actual del Universo visible ≈ 10-30 de la T. de Planck

Mirando los escenarios que el Universo nos muestra, nos sentimos más humildes ante tanta grandeza

Estos números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el Universo está estructurado en una escala sobrehumana de proporciones asombrosas cuando la sopesamos en los balances de su propia construcción. Con respecto a sus propios patrones, el Universo es viejo. El tiempo de vida natural de un mundo gobernado por la gravedad, la relatividad y la mecánica cuántica es el fugaz breve tiempo de Planck. Parece que es mucho más viejo de lo que debería ser.

Pero, pese a la enorme edad del universo en “tics” del Tiempo de Planck, hemos aprendido que casi todo este tiempo es necesario para producir estrellas y los elementos químicos que traen la vida.

¿Por qué nuestro Universo no es mucho más viejo de lo que parece ser? Es fácil entender por qué el Universo no es mucho más joven. Las estrellas tardan mucho tiempo en formarse y producir elementos más pesados que son las que requiere la complejidad biológica. Pero los universos viejos también tienen sus problemas. Conforme para el Tiempo en el Universo el proceso de formación de estrellas se frena. Todo el gas y el polvo cósmico que constituyen las materias primas de las estrellas habrían sido procesados por las estrellas y lanzados al espacio intergaláctico donde no pueden enfriarse y fundirse en nuevas estrellas.

Pocas estrellas hacen que, a su vez, también sean pocos los sistemas planetarios. Los planetas que se forman son menos activos que los que se formaron antes, la entropía va debilitando la energía del sistema para realizar trabajo. La producción de elementos radiactivos en las estrellas disminuirá, y los que se formen tendrán semividas más largas. Los nuevos planetas serán menos activos geológicamente y carecerán de muchos de los movimientos internos que impulsan el vulcanismo, la deriva continental y la elevación de las montañas en el planeta. Si esto también hace menos probable la presencia de un campo magnético en un planeta, entonces será muy poco probable que la vida evolucione hasta formas complejas.

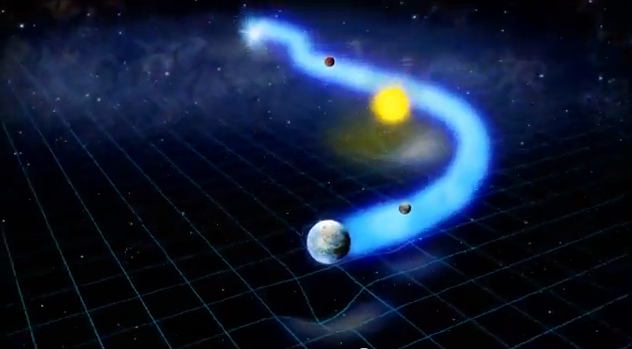

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre las atmósferas de los planetas en órbitas a su alrededor y, a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Las amenazas espaciales están siempre ahí. No pocas veces lo pudimos comprobar

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagar infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra, habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la Luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución que tantos miles de millones de años le costó al Universo para poder plasmarla en una realidad que llamamos vida. Cuando comento este tema no puedo evitar el recuerdo del meteorito caído en la Tierra que impactó en la península de Yucatán hace 65 millones de años, al final de la Era Mesozoica.

Cuando según todos los indicios, los dinosaurios se extinguieron. Sin embargo, aquel suceso catastrófico para los grandes lagartos, en realidad supuso que la Tierra fue rescatada de un callejón sin salida evolutivo. Parece que los dinosaurios evolucionaron por una vía que desarrollaba el tamaño físico antes que el tamaño cerebral.

La vida después de la desaparición de los dinosaurios

La desaparición de los dinosaurios junto con otras formas de vida sobre la Tierra en aquella época, hizo un hueco para la aparición de los mamíferos. Se desarrolló la diversidad una vez desaparecidos los grandes depredadores. Así que, al menos en este caso concreto, el impacto nos hizo un gran favor, ya que hizo posible que 65 millones de años más tarde pudiéramos llegar nosotros. Los dinosaurios dominaron el planeta durante 150 millones de años; nosotros en comparación, llevamos aquí tres días y, desde luego, ¡la que hemos formado!

Y no podemos tener la menor duda, mientras que estemos aquí, seguiremos pretendiendo y queriendo saber sobre los secretos de la Naturaleza que, al fin y al cabo, puede ser nuestra salvación. Ya saben ustedes: ¡Saber es poder! Y, en relación a la vida…

Hemos llegado a ser conscientes de que, el secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema solar habitado observado, ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales; el t(bio) – tiempo biológico para la aparición de la vida – algo más extenso.

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la fotodisociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

A muchos les cuesta trabajo admitir la presencia de vida en el universo como algo natural y corriente, ellos abogan por la inevitabilidad de un universo grande y frío en el que es difícil la aparición de la vida, y en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

¿Quién sabe lo que en otros mundos puede existir?

Los biólogos, sin embargo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de las estimaciones de la probabilidad de que haya inteligencias extraterrestres en el universo se centran en formas de vida similares a nosotros que habiten en planetas parecidos a la Tierra y que necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1.957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el universo.

¡Y pensar que nosotros, sólo somos una pequeña ramita del gran árbol!

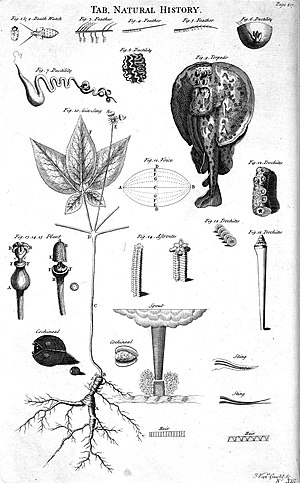

La luz del Sol es la responsable de que en la Tierra -y supongo que la de otras estrellas en otros muchos planetas del Universo- , se puedan formar complejas estructuras y germinar muchas otras que son imprescindibles para la existencia de los seres vivos. La utilización biológica de la luz se comprenderá más fácilmente si, consideramos primero, en que nosotros y todos los demás organismos heterótrofos -que viven en el aire-, es decir, animales, hongos y muchos protistas y bacterias, satisfacemos nuestras necesidades energéticas. La palabra clave es combustión; más técnicamente, oxidación, esto es, la producción de energía por la interacción de determinadas sustancias con el oxígeno. En este sentido, somos como cualquier máquina y, el combustible en nuestro caso, consiste en componentes del acervo metabólico, que a su vez deriva de los alimentos. Aquí, sin embargo, termina la analogía. Las combustiones vitales son frías; y las energías que liberan no se utiliza en forma de calor, un fenómeno que sería imposible en células vivas, en las que las diferencias de temperaturas son despreciables. Esta energía sirve en cambio, para hacer funcionar el generador químico central que, a su vez, proporciona energía a la mayoría de las formas de trabajo biológico.

En las combustiones celulares, al igual que en aquellas en las que estamos familiarizados, se utiliza el oxígeno para convertir el carbono de las sustancias orgánicas en dióxido de carbono (CO2) y su Hidrógeno en agua (H2O). En la fotosíntesis ocurre exactamente lo contrario. Lo que hacen las plantas verdes con ayuda de la energía luminosa es sencillamente invertir las oxidaciones. A partir de dióxido de carbono y agua, las plantas fabrican un azúcar de fórmula (CH2O)6, y emiten el Oxígeno sobrante (una molécula de O2 por cada molécula de CO2 utilizada) a la atmósfera.

En algún momento de las próximas décadas descubriremos el primer planeta albergando vida. Pero seguramente será “parecida” a la nuestra; basada en enlaces de C y agua como medio. Pero; ¿podría existir un tipo de vida completamente diferente? ¿la reconoceremos cuando la veamos? ¿podría evolucionar hasta desarrollar inteligencia?

Para poder saber sobre todo eso, para llegar a conocer los secretos de la Naturaleza, es preciso que sigamos observando atentamente para poder descubrir los secretos en los que están encerradas las respuestas a esas preguntas que nadie ha sabido contestar. Nosotros somo propensos a crearnos un entorno cercano y localista que, la mayoría de las veces, nos aparta de la realidad “del mundo” y de cómo son las cosas en el Universo del que formamos parte que, aunque sea muy pequeña, es la parte que piensa, la que imagina y tiene ideas de lo que todo esto podría ser.

“Existe un trabajo publicado hace tiempo que estima que los humanos no constituimos más del 0,01% de la biomasa terrestre. Sólo el 0,01%. Parece una cifra muy insignificante para el impacto que tenemos sobre el resto de los organismos vivos. A veces cuesta saber si estos datos pueden observarse desde una perspectiva positiva o una negativa.

Nuestra masa de 0,06 Gigatoneladas de Carbono (Gt C), que es apenas un 0,01% del total, resulta que es la causa de lo que los expertos denominan el Antropoceno, que no es más que el nombre con el que hace poco los geólogos decidieron bautizar esta nueva era geológica que empezó con el auge de la civilización de nuestra especie.”

Según Alex Richter-Boix al comentar el aludido trabajo.

De esa manera y a pesar de nuestra poca importancia en relación al todo, somos los responsables de la mayor incidencia observada en otros seres y sus ecosistemas. Siempre hemos pensado de manera algo egoísta en nosotros dejando de lado lo que eso podría repercutir en los demás.

emilio silvera

Abr

22

¡La Física! ¿Qué sería de nosotros sin ella?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Incluso las frecuencias de onda cerebrales están estrechamente relacionadas con la actividad fisiológica de nuestro organismo. Esto es algo indudable, puesto que todo lo que conocemos en el mundo físico está compuesto por átomos que vibran a determinadas frecuencias. En las últimas décadas, la física cuántica nos ha revelado información muy importante acerca de nuestra realidad. Fue Richard Feynman el que dijo en cierta ocasión que si tuviera que elegir en una frase el descubrimiento más importante de la Ciencia moderna, elegiría:

El mundo está hecho de átomos”

Átomos y moléculas que se constituyen en la materia que todo lo conforma… ¡También nosotros!

Muchas son las veces que aquí nos hemos referido a que, 500 años antes de Cristo, ya algunos hablaban de ese hecho cierto de que “el mundo estaba hecho de átomos”. Los filósofos de la Naturaleza (como los llamaban entonces), Leucipo de Mileto y su alumno, Demócrito de Abdera, fueron los encargados de divulgar ese increíble hecho que, según ellos decían: “Todas las cosas estaban hechas de unos objetos invisibles e indivisibles, la parte más pequeña de la materia que llamaban a-tomo o átomos. Aquella historia viene de mucho más lejos y, esos filósofos griegos tomaron prestadas las ideas de los pensadores hindúes que mucho antes que ellos hablaban de átomos y de vacío. Otro filósofo de la Naturaleza, Empédocles, nos decía:

Empedocles de Agrigento, filósofo presocrático de la antigua Grecia. Imagen procedente de Thomas Stanley (1655), The history of philosophy.

“Pues yo he sido a veces un muchacho y una chica,

Un matorral y un pájaro y un pez en las olas saladas.”

Esto nos decía Empédocles, el padre de aquellos primitivos elementos formados por Agua, tierra, aire y fuego que, mezclados en la debida proporción, formaban todas las cosas que podemos ver a nuestro alrededor. Claro que, él no podía llegar a imaginar hasta donde pudimos llegar después en la comprensión de la materia a partir del descubrimiento de las partículas “elementales” que formaban el átomo. Pero sí, con sus palabras, nos quería decir que, la materia, una veces está conformando mundos y, en otras, estrellas y galaxias.

Sí, hay cosas malas y buenas pero todas deben ser conocidas para poder, en el primer caso aprovecharlas, y en el segundo, prevenirlas.

Pero demos un salto en el tiempo y viajemos hasta los albores del siglo XX cuando se hacía cada vez más evidente que alguna clase de energía atómica era responsable de la potencia del Sol y del resto de las estrellas que más lejos, brillaban en la noche oscura. Ya en 1898, sólo dos años después del descubrimiento de la radiactividad por Becquerel, el geólogo americano Thomas Chrowder Chamberlin especulaba que los átomos eran “complejas organizaciones y centros de enormes energías”, y que “las extraordinarias condiciones que hay en el centro del Sol pueden…liberar una parte de su energía”. Claro que, por aquel entonces, nadie sabía cual era el mecanismo y cómo podía operar, hasta que no llegamos a saber mucho más sobre los átomos y las estrellas.

Conseguimos tener los átomos en nuestras manos y, aunque la imagen sea simbólica, nos muestra una realidad, toda vez que, en este mismo instante podemos construir “cosas” átomo a átomo. Hemos llegado a un nivel de manipulación de la materia que ni podíamos imaginar hasta hace tan sólo un siglo. Si aquellos Filósofos Naturales levantarán la cabeza…

El intento de lograr tal comprensión exigió una colaboración cada vez mayor entre los astrónomos y los físicos nucleares. Su trabajo llevaría, no sólo a resolver la cuestión de la energía estelar, sino también al descubrimiento de una trenza dorada en la que la evolución cósmica se entrelaza en la historia atómica y la estelar. En todos estos fenómenos y secretos que nos ocultan la Naturaleza, la Luz está presente y, en el futuro tendrá mucho que decirnos cuando de verdad, la podamos conocer.

¿Dónde estará el límite? Parece que no hay límites si el Tiempo es ilimitado

La Clave: Fue comprender la estructura del átomo. Que el átomo tenía una estructura interna podía inferirse de varias líneas de investigación, entre ellas, el estudio de la radio-ctividad: para que los átomos emitiesen partículas, como se había hallado que lo hacían en los laboratorios de Becquerel y los Curie, y para que esas emisiones los transformasen de unos elementos en otros, como habían demostrado Rutherford y el químico inglés Frederick Soddy, los átomos debían ser algo más que simples unidades indivisibles, como implicaba su nombre (de la voz griega que significa “imposible de cortar”).

El Premio Nobel de Física de 1903 fue compartido por Henri Becquerel, Pierre Curie y Marie Curie (Fuente). Pero no se quedó ahí. En 1911 ganó un segundo Premio Nobel, esta vez de Química y en solitario,

“En 1902, miembros de la Academia de Ciencias de Francia escribieron una carta a la Academia Sueca para presentar los descubrimientos en el campo de la radiactividad realizados por Marie y Pierre Curie, así como por Henri Becquerel, para el Premio Nobel de Física. Sin embargo, debido a las actitudes sexistas que prevalecían en la época, no se ofreció ningún tipo de reconocimiento a las contribuciones de Marie.”Como decimos más arriba, finalmente, la Academia Sueca reconoció, por dos veces, el mérito de MarieCurie.

La Clave: Fue comprender la estructura del átomo. Que el átomo tenía una estructura interna podía inferirse de varias líneas de investigación, entre ellas, el estudio de la radio-ctividad: para que los átomos emitiesen partículas, como se había hallado que lo hacían en los laboratorios de Becquerel y los Curie, y para que esas emisiones los transformasen de unos elementos en otros, como habían demostrado Rutherford y el químico inglés Frederick Soddy, los átomos debían ser algo más que simples unidades indivisibles, como implicaba su nombre (de la voz griega que significa “imposible de cortar”).

El átomo de Demócrito era mucho más de lo que él, en un principio intuyó que sería. Hoy sabemos que está conformado por diversas partículas de familias diferentes: unas son bariones que en el seno del átomo llamamos nucleones, otras son leptones que giran alrededor del núcleo para darle estabilidad de cargas, y, otras, de la familia de los Quarks, construyen los bariones del núcleo y, todo ello, está, además, vigilado por otras partículas llamadas bosones intermedios de la fuerza nuclear fuerte, los Gluones que, procuran mantener confinados a los Quarks.

Pero no corramos tanto, la física atómica aún debería recorrer un largo camino para llegar a comprender la estructura que acabamos de reseñar. De los trs principales componentes del átomo -el protón, el neutrón y el electrón-, sólo el electrón había sido identificado (por J.J. Thomson, en los últimos años del siglo XIX). Nadie hablaba de energía “nuclear” pues ni siquiera se había demostrado la existencia de un núcleo atómico, y mucho menos de sus partículas constituyentes, el protón y el neutrón, que serían identificados, respectivamente, por Thomson en 1913 y James Chawick en 1932.

Rutherford era uno de esos individuos poco corrientes que hizo su más importante contribución a la ciencia, él con su experimento al bombardear una plaxa de oro con partículas alfas, descubrió la existencia de un núcleo dentro del átomo y que era 1/100.000 veces menor que éste. Ganó el Nobel de Física por ello.

De importancia capital resultó conocer la existencia del núcleo y que éste, era 1/100.000 del total del átomo, es decir, casi todo el átomo estaba compuesto de espacios “vacíos” y, la materia así considerada, era una fracción infintesimal del total atómico.

Rutherford, Hans Geiger y Ernest Marsden se encontraban entre los “Estrabones y Tolomeos” de la cartografía atómica, en Manchester , de 1909 a 1911, sondearon el átomo lanzando corrientes de “partículas alfa” subatómicas -núcleos de helio- contra delgadas laminillas de oro, plata, estaño y otros metales. La mayoría de partículas Alfa se escapaban a través de las laminillas, pero, para sombro de los experimentadores, algunas rebotaban hacia atrás. Rutherford pensó durante largo tiempo e intensamente en este extraño resultado; era tan sorprendente, señalaba, como si una bala rebotase sobre un pañuelo de papel. Finalmente, en una cena en su casa en 1911, anunció a unos pocos amigos que había dado con una explicación: que la mayoría de la masa de un átomo reside en un diminuto núcleo masivo. Ruthertford pudo calcular la carga y el diámetro máximo del núcleo atómico. Así se supo que los elementos pesados eran más pesados que los elementos ligeros porque los núcleos de sus átomos tienen mayor masa.

Todos sabemos ahora, la función que desarrollan los electrones en el átomo. Pero el ámbito de los electrones para poder llegar a la comprensión completa, tuvo que ser explorado, entre otros, por el físico danés Niels Bohr, quien demostró que ocupaban órbitas, o capas, discretas que rodean al núcleo. (Durante un tiempo Bohr consideró el átomo como un diminuto sistema solar, pero ese análisis, pronto demostró ser inadecuado; el átomo no está rígido por la mecánica newtoniana sino por la mecánica cuántica.)

Entre sus muchos otros éxitos, el modelo de Bohr revelaba la base física de la espectroscopia. El número de electrones de un átomo está determinado por la carga eléctrica del núcleo, la que a su vez se debe al número de protones del núcleo, que es la clave de la identidad química del átomo. Cuando un electrón cae de una órbita externa a una órbita interior emite un fotón. La longitud de onda de este fotón está determinada por las órbitas particulares entre las que el electrón efectúa la transición.

Esta es la razón de que un espectro que registra las longitudes de onda de los fotones, revele los elementos químicos que forman las estrellas u otros objetos que sean estudiados por el espectroscopista. En palabras de Max Planck, el fundador de la física cuántica, el modelo de Bohr del átomo nos proporciona “la llave largamente buscada de la puerta de entrada al maravilloso mundo de la espectroscopia, que desde el descubrimiento del análisis espectral (por Fraunhoufer) había desafiado obstinadamente todos los intentos de conocerlo”.

Es curioso que, mirando en la oscura noche como brillan las estrellas del cielo, nos atrae su titilar engañoso (es la atmósfera terrestre la que hace que lo parezca) y su brillo, Sin embargo, pocos llegan a pensar en lo que verdaderamente está allí ocurriendo. Las transformaciones de fase por fusión no cesan. Esta transformación de materia en energía es consecuencia de la equivalencia materia-energía, enunciada por Albert Einstein en su famosa fórmula E=mc2; donde E es la energía resultante, m es la masa transformada en energía, y c es la velocidad de la luz (300 000 kilómetros por segundo). La cantidad de energía que se libera en los procesos de fusión termonuclear es fabulosa. Un gramo de materia transformado íntegramente en energía bastaría para satisfacer los requerimientos energéticos de una familia mediana durante miles de años.

Es un gran triunfo del ingenio humano el saber de qué, están “construidas” las estrellas, de qué materiales están hechas. Recuerdo aquí a aquel Presidente de la Real Society de Londres que, en una reunión multitudinaria, llegó a decir: “Una cosa está clara, nunca podremos saber de qué están hechas las estrellas”. El hombre se vistió de gloria con la desde entonces, famosa frase. Creo que nada, con tiempo por delante, será imposible para nosotros.

Pero, por maravilloso que nos pueda parecer el haber llegado a la comprensión de que los espectros revelan saltos y tumbos de los electrones en sus órbitas de Bohr, aún nadie podía hallar en los espectros de las estrellas las claves significativas sobre lo que las hace brillar. En ausencia de una teoría convincente, se abandonó este campo a los taxonomistas, a los que seguían obstinadamente registrando y catalogando espectros de estrellas, aunque no sabían hacia donde los conduciría esto.

No recibieron el reconocimiento del mérito que tenía su trabajo

En el Laboratorio de la Universidad de Harvard, uno de los principales centros de la monótona pero prometedora tarea de la taxonomía estelar, las placas fotográficas que mostraban los colores y espectros de decenas de miles de estrellas se apilaban delante de “calculadoras”, mujeres solteras en su mayoría y, de entre ellas, Henrietta Leavitt, la investigadora pionera de las estrellas variables Cefeidas que tan útiles serían a Shapley y Hubble.

Imagen de Sirio A, la estrella más brillante del cielo tomada por el Telescopio Hubble (Créd. NASA). Sirio es la quinta estrella más cercana y tiene una edad de 300, millones de años. Es una estrella blanca de la secuencia principal de tipo espectral A1V con temperatura superficial de 10 000 K y situada a 8,6 años luz de la Tierra. Es una estrella binaria y, de ella, podríamos contar muchas historias. La estrella fue importante en las vidas de Civilizaciones pasadas como, por ejemplo, la egipcia.

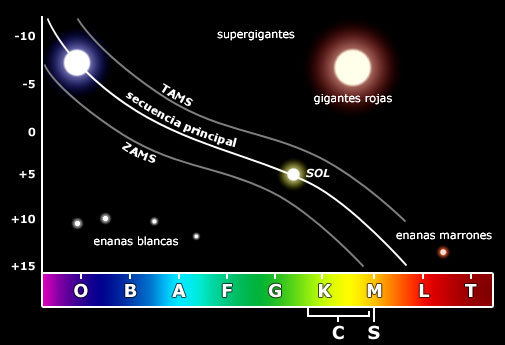

Fue Cannon quien, en 1915, empezó a discernir la forma en una totalidad de estrellas en las que estaba presente la diversidad, cuando descubrió que en una mayoría, las estrellas, pertenecían a una de media docena de clases espectrales distintas. Su sistema de clasificación, ahora generalizado en la astronomía estelar, ordena los espectros por el color, desde las estrellas O blanco-azuladas, pasando por las estrellas G amarillas como el Sol, hasta estrellas rojas M. Era un rasgo de simplicidad denajo de la asombrosa variedad de las estrellas.

Pronto se descubrió un orden más profundo, en 1911, cuando el ingeniero y astrónomo autodidacta danés Ejnar Hertzsprung analizó los datos de Cannon y Maury de las estrellas de dos cúmulos, las Híades y las Pléyades. Los cúmulos como estos son genuinos conjuntos de estrellas y no meras alineaciones al azar; hasta un observador inexperimentado salta entusiamado cuando recorre con el telecopio las Pléyades, con sus estrellas color azul verdoso enredadas en telarañas de polvo de diamante, o las Híades, cuyas estrellas varían en color desde el blanco mate hasta un amarillo apagado.

Las Híades

Hertzsprung utilizó los cúmulos como muestras de laboratorio con las que podía buscar una relación entre los colores y los brillos intrínsecos de las estrellas. Halló tal relación: la mayoría de las estrellas de ambos cúmulos caían en dos líneas suavemente curvadas. Esto, en forma de gráfico, fue el primer esbozo de un árbol de estrellas que desde entonces ha sido llamado diagrama Hertzsprung-Russell.

El progreso en física, mientras tanto, estaba bloqueado por una barrera aparentemente insuperable. Esto era literal: el agente responsable era conocido como barrera de Coulomb, y por un tiempo frustró los esfuerzos de las físicos teóricos para comprender como la fusión nuclear podía producir energía en las estrellas.

La línea de razonamiento que conducía a esa barrera era impecable. Las estrellas están formadas en su mayor parte por hidrógeno. (Esto se hace evidente en el estudio de sus espectros.) El núcleo del átomo de Hidrógeno consiste en un solo protón, y el protón contiene casi toda la masa del átomo. (Sabemos esto por los experimentos de Rutherford). Por tanto, el protón también debe contener casi toda la energía latente del átomo de hidrógeno. (Recordemos que la masa es igual a la energía: E = mc2.) En el calor de una estrella, los protones son esparcidos a altas velocidades -el calor intenso significa que las partículas involucradas se mueven a enormes velocidades- y, como hay muchos protones que se apiñan en el núcleo denso de una estrella, deben tener muchísimos choques. En resumen, la energía del Sol y las estrellas, puede suponerse razonablemente, implica las interacciones de los protones. Esta era la base de la conjetura de Eddintong de que la fuente de la energía estelar “difícilmente puede ser otra que la energía subatómica, la cual, como se sabe, existe en abundancia en toda materia”.

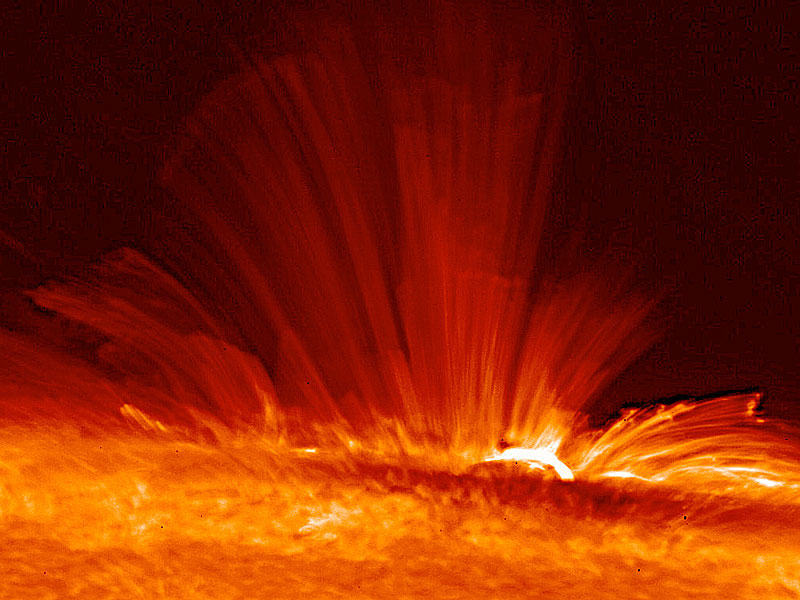

Plasma en ebullición en la superficie del Sol

Hasta el momento todo lo que hemos repasado está bien pero, ¿Que pasa con la Barrera de Coulomb? Los protones están cargados positivamente; las partículas de igual carga se repelen entre sí; y este obstáculo parecía demasiado grande para ser superado, aun a la elevada velocidad a la que los protones se agitaban en el intenso calor del interior de las estrellas. De acuerdo con la física clásica, muy raras veces podían dos protones de una estrella ir con la rapidez suficiente para romper las murallas de sus campos de fuerza electromagnéticos y fundirse en un solo núcleo. Los cálculos decían que la tasa de colisión de protones no podía bastar para mantener las reacciones de fusión. Sin embargo, allí estaba el Sol, con el rostro radiante, riéndose de las ecuaciones que afirmaban que no podía brillar.

Afortunadamente, en el ámbito nuclear, las reglas de la Naturaleza no se rigen por las de la mecánica de la física clásica, que tienen validez para grandes objetos, como guijarros y planetas, pero pierden esa validez en el reino de lo muy pequeño. En la escala nuclear, rigen las reglas de la indeterminación cuántica. La mecánica cuántica demuestra que el futuro del protón sólo puede predecirse en términos de probabilidades: la mayoría de las veces el protón rebotará en la Barrera de Coulomb, pero de cuando en cuando, la atravesará. Este es el “efecto túnel cuántico”; que permite brillar a las estrellas.

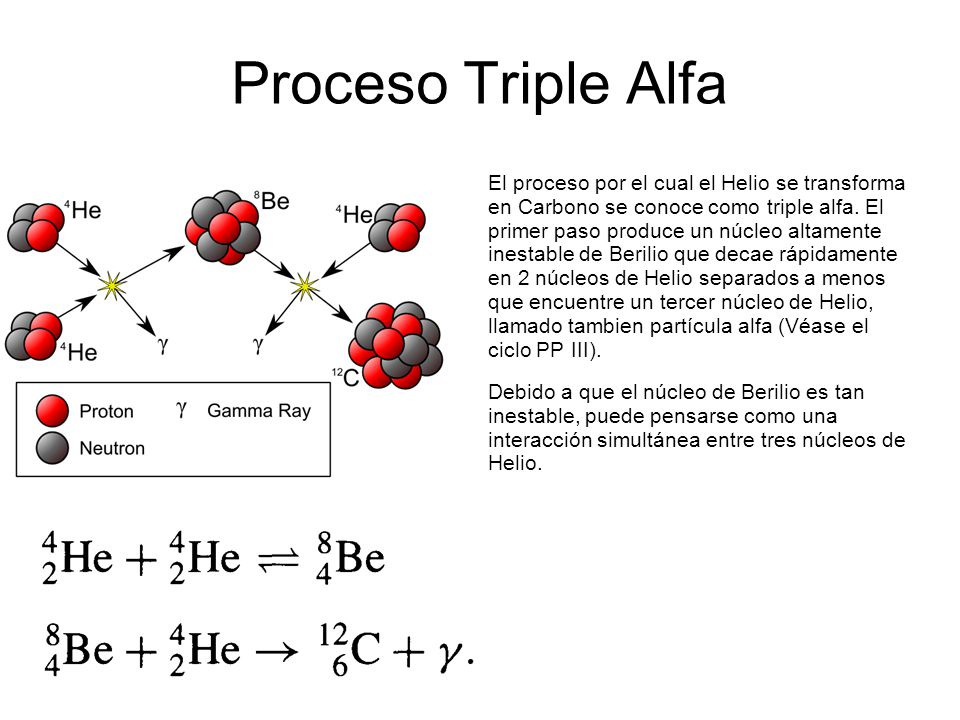

George Gamow, ansioso de explotar las conexiones entre la astronomía y la nueva física exótica a la que era adepto, aplicó las probabilidades cuánticas a la cuestión de la fusión nuclear en las estrellas y descubrió que los protones pueden superar la Barrera de Coulomb. Esta historia es mucho más extensa y nos llevaría hasta los trabajos de Hans Bethe, Edward Teller y otros, así como, al famoso Fred Hoyle y su efecto Triple Alfa y otras maravillas que, nos cuentan la historia que existe desde los átomos a las estrellas del cielo.

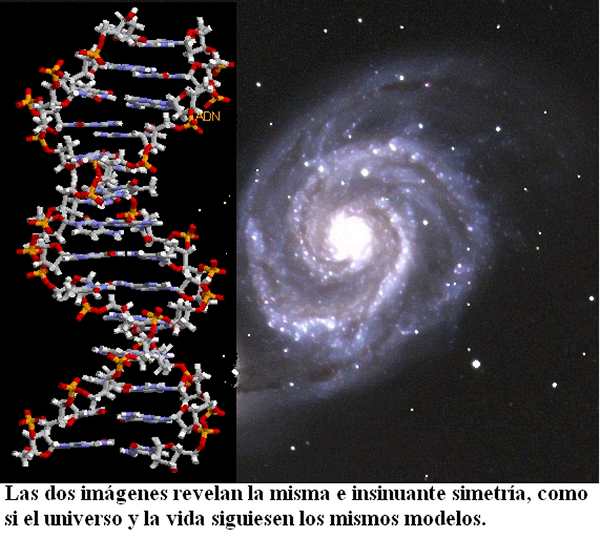

Una cuestión que no debemos olvidar nunca es que la simetría subyace en las leyes del Universo. Muchos han sido los cambios que en los últimos tiempos se han producido en la disciplina científica de la física y otras áreas del saber humano. Sin embargo, en todos ellos, en todos esos cambios ha estado siempre presente una característica esencia: La Simetría que es aquella propiedad que permanece invariable a pesar de los cambios. Los físicos fijándose en esa simetría han podido descubrir cuestiones importantes que permanecían profundamente escondidas en las entrañas de la Naturaleza.

Los que hemos trillado el camino de la Física y de la Astronomía, hemos podido llegar a comprender la importancia de la simetría en la comprensión del “mundo” (una manera en la que los victorianos expresaban su parecer sobre el universo). En todos los aspectos misteriosos y sutiles que encontramos en la naturaleza, la simetría nos arroja una luz sobre ellos que hace posible que lleguemos a comprender lo que antes no entendíamos. Muchos Físicos como Einstein, por ejemplo, con la Simetría en su cabeza llegó a comprender “su mundo” y se dio cuenta de qué cosas en el Universo no cambian a pesar de todo.

Índice de las eras del Universo

- 1El universo muy primigenio

- 2El universo primigenio

- 3Formación de estructuras

- 4Destino final del universo

- 4.1Muerte térmica, 1-100 billones de años

- 4.2El big crunch, 100 000 millones de años

- 4.3Big rip

- 4.4Metaestabilidad del vacío

El Universo no msiempre fue como en el Presente lo podemos observar, y pasó, por distintas eras

No hace mucho hemos hablado aquí de las eras por las que pasó el Universo primitivo hasta que, al enfriarse, se pudo estabilizar y hacerse mayor, es decir, el Universo que hoy conocemos y en los que están presentes una serie de simetrías o constantes que lo hacen reconocible para nosotros. Una de esas constantes, como tantas veces hemos podido referir aquí, es la de la Luz. El amigo Einstein supo “ver” que aquella simetría luminosa hecha de fotones, era invariable y, sin importar cual fuere la fuente ni a que velocidad pudiera moverse ésta o incluso estar parada, la luz, sin importarle nada de todo eso, seguía su camino a la misma velocidad siempre, es decir, a 299.972.458 metros por segundo cuando corría por el vacío interestelar, y, nada podría nunca sobrepasar de esa velocidad que era una constante de la Naturaleza.

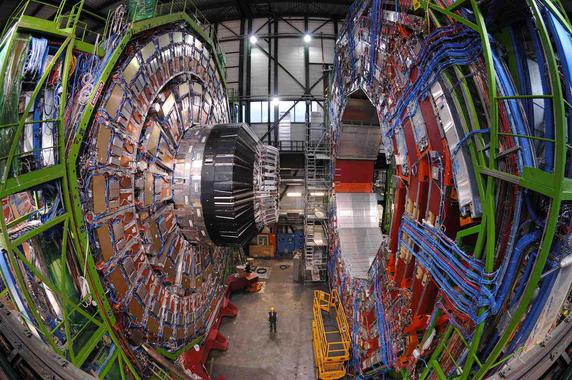

Hemos tenido que construir máquinas inmensas para poder comprobar los efectos que se producen en un cuerpo cuando éste quiere ir más rápido que la luz. Lo predijo la teoría de la relatividad especial de Einstein y se ha comprobado despuès en los aceleradores de partículas: Nada va más rápido que la luz en nuestro Universo.

Hemos tenido que construir máquinas inmensas para poder comprobar los efectos que se producen en un cuerpo cuando éste quiere ir más rápido que la luz. Lo predijo la teoría de la relatividad especial de Einstein y se ha comprobado despuès en los aceleradores de partículas: Nada va más rápido que la luz en nuestro Universo.

Es preciso ampliar un poco más las explicaciones anteriores que no dejan sentadas todas las cuestiones que el asunto plantea, y quedan algunas dudas que incitan a formular nuevas preguntas, como por ejemplo: ¿por qué se convierte la energía en masa y no en velocidad?, o ¿por qué se propaga la luz a 299.793 Km/s y no a otra velocidad?

La única respuesta que podemos dar hoy es que así es el universo que nos acoge y las leyes naturales que lo rigen, donde estamos sometidos a unas fuerzas y unas constantes universales de las que la velocidad de la luz en el vacío es una muestra.

Nada puede superar la velocidad de la luz en el vacío

Contracción de la longitud del objeto que viaja a velocidad relativista

Dilatación del Tiempo del que viaja a velocidad relativista

Haces de muones lanzados en el LHC a velocidades cercanas a c (la velocidad de la luz en el vacío), aumentaron diez veces sus masas. Al ser la velocidad de la Luz en el vacío un límite impuesto por el Universo, cuando el objeto se acerca a esa velocidad se va frenando y, la energía cinética se convierte en masa en virtud de E=mc2 .

A velocidades grandes cercanas a la de la luz (velocidades relativistas) no sólo aumenta la masa del objeto que viaja, sino que disminuye también su longitud en la misma dirección del movimiento (contracción de Lorentz) y en dicho objeto y sus ocupantes – si es una nave – se retrasa al paso del tiempo, o dicho de otra manera, el tiempo allí transcurre más despacio. A menudo se oye decir que las partículas no pueden moverse “más deprisa que la luz” y que la “velocidad de la luz” es el límite último de velocidad.

Pero decir esto es decir las cosas a medias, porque la luz viaja a velocidades diferentes dependiendo del medio en el que se mueve. Donde más deprisa se mueve la luz es en el vacío: allí lo hace a 299.792’458 Km/s. Este sí es el límite último de velocidades que podemos encontrar en nuestro universo.

En el futuro, grandes estaciones sumergidas en el océano y ciudades en otros mundos rodeadas de campos de fuerza que impedirán la radiación nociva mientras tanto se va consiguiendo terra-formar el planeta. La tecnología habrá avanzado tanto que nada de lo que hoy podamos imaginar estará fuera de nuestro alcance y, viajar a mundos situados a decenas de años-luz de la Tierra será para entonces, lo cotidiano

Eso es lo que imaginamos pero… ¿Qué maravillas tendremos dentro de 150 años? ¿Qué adelantos científicos se habrán alcanzado? ¿Qué planetas habremos colonizado? ¿Habrá sucedido ya ese primer contacto del que tanto hablamos? ¿Cuántas “Tierras” habrán sido encontradas? ¿Qué ordenadores utilizaremos? ¿Será un hecho cotidiano el viaje espacial tripulado? ¿Estaremos explotando las reservas energéticas de Titán? ¿Qué habrá pasado con la Teoría de Cuerdas? Y, ¿Habrán aparecido las dichosas teorías de la Gravedad – Cuántica, las Súper-Cuerdas, o, el enigma de la “materia oscura” Haciendo todas estas preguntas de lo que será o podrá ser, nos viene a la memoria todo lo que fue y que nos posibilita hacer estas preguntas.

Una cosa nos debe quedar bien clara, nada dentro de 250 años será lo mismo que ahora. Todo habrá cambiado en los distintos ámbitos de nuestras vidas y, a excepción del Amor y los sentimientos que sentiremos de la misma manera (creo), todo lo demás, habrá dado lugar a nuevas situaciones, nuevas formas de vida, nuevas sociedades, nuevas maneras y, podríamos decir que una Humanidad nueva, con otra visión y otras perspectivas.

Nuevas maneras de sondear la Naturaleza y desvelar los secretos

Pero echemos una mirada al pasado. Dejando a un lado a los primeros pensadores y filósofos, como Tales, Demócrito, Empédocles, Ptolomeo, Copérnico, Galileo, Kepler y otros muchos de tiempos pasados, tenemos que atender a lo siguiente: