May

30

¿Qué habrá más allá del Modelo Estándar de la Física de Partículas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

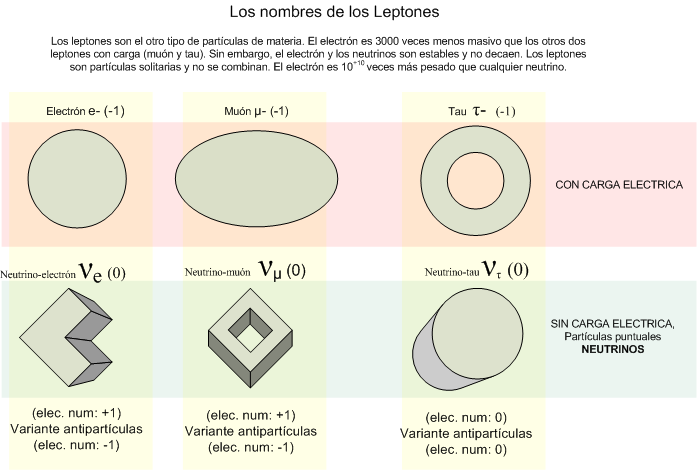

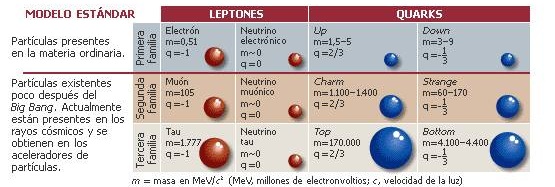

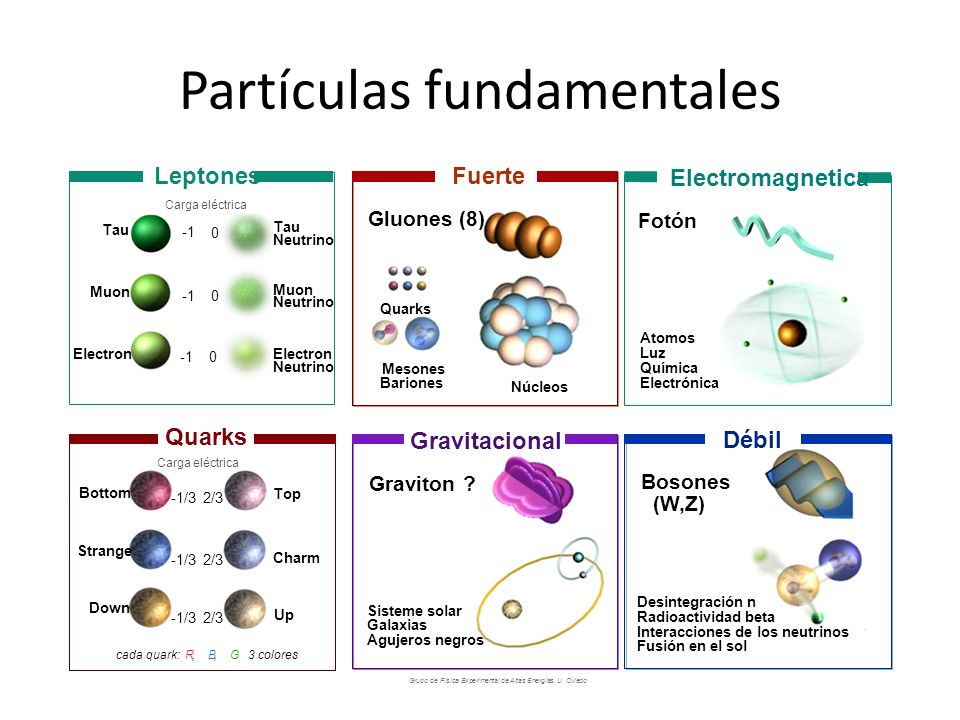

“Inicialmente, se presenta, de modo simplificado, el Modelo Estándar como una teoría sofisticada que identifica las partículas elementales y sus interacciones. Después, en el ámbito de esa teoría, se enfocan aspectos – el vacuo no es vacío; partículas desnudas y vestidas; materia oscura y viento oscuro; materia y antimateria; el campo y el bosón de Higgs; neutrinos oscilantes – que pueden ser motivadores desde el punto de vista de la enseñanza y del aprendizaje de la Física. Finalmente, se discute la probable superación de esa teoría por otra más completa.”

La Física actual busca una teoría más amplia que el modelo estándar . Una teoría que dé una descripción completa, unificada y consistente de la estructura fundamental del universo. ¿Será la compleja Teoría de cuerdas, que integra también la interacción gravitatoria?

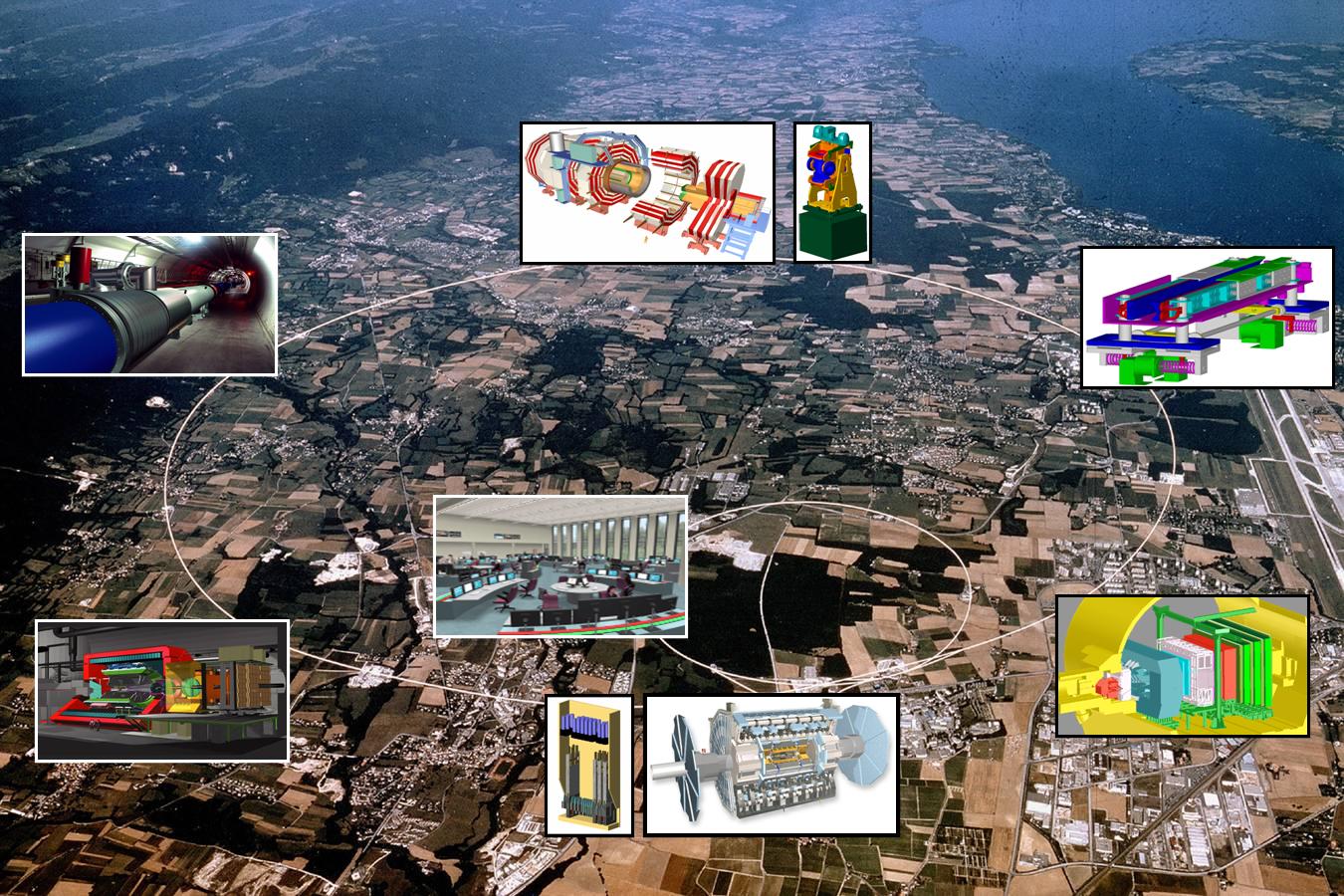

El modelo estándar es una poderosa herramienta pero no cumple todas las expectativas; no es un modelo perfecto. En primer lugar, podríamos empezar por criticar que el modelo tiene casi veinte constantes que no se pueden calcular. Desde luego, se han sugerido numerosas ideas para explicar el origen de todos estos parámetros o números inexplicables y sus valores, pero el problema de todas estas teorías es que los argumentos que dan nunca han sido enteramente convincentes. ¿Por qué se iba a preocupar la naturaleza de una fórmula mágica si en ausencia de tal fórmula no hubiera contradicciones? Lo que realmente necesitamos es algún principio fundamental nuevo, tal como el principio de la relatividad, pero no queremos abandonar todos los demás principios que ya conocemos. Ésos, después de todo, han sido enormemente útiles en el descubrimiento del modelo estándar. El mejor lugar para buscar un nuevo principio es precisamente donde se encuentran los puntos débiles de la presente teoría y, construímos máquinas como el LHC para que nos diga lo que no sabemos.

Una regla universal en la física de partículas es que para partículas con energías cada vez mayores, los efectos de las colisiones están determinados por estructuras cada vez más pequeñas en el espacio y en el tiempo. El modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero existen varias razones para sospechar que sus predicciones pueden, finalmente (cuando podamos emplear más energía en un nivel más alto), resultar equivocadas.

Vistas a través del microscopio, las constantes de la naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son. Hay algo muy erróneo aquí. Desde un punto de vista matemático no hay nada que objetar, pero la credibilidad del modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas, o lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas. ¿Y por qué debería ser el modelo válido hasta aquí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables. ¿Dónde está la partícula de Higgs? ¿Cómo se esconde de nosotros el gravitón?

Parece que el Modelo estándar no admite la cuarta fuerza y tendremos que buscar más profundamente, en otras teorías que nos hablen y describan además de las partículas conocidas de otras nuevas que están por nacer y que no excluya la Gravedad. Ese es el Modelo que necesitamos para conocer mejor la Naturaleza.

Claro que las cosas no son tan sencilla y si deseamos evitar la necesidad de un delicado ajuste de las constantes de la naturaleza, creamos un nuevo problema: ¿cómo podemos modificar el modelo estándar de tal manera que el ajuste fino no sea necesario? Está claro que las modificaciones son necesarias, lo que implica que muy probablemente haya un límite más allá del cual el modelo tal como está deja de ser válido. El modelo estándar no será nada más que una aproximación matemática que hemos sido capaces de crear, de forma que todos los fenómenos que hemos observado hasta el presente están reflejados en él, pero cada vez que se pone en marcha un aparato más poderoso, tenemos que estar dispuestos a admitir que puedan ser necesarias algunas modificaciones del modelo para incluir nuevos datos que antes ignorábamos.

Más allá del modelo estándar habrá otras respuestas que nos lleven a poder hacer otras preguntas que en este momento, no sabemos ni plantear por falta de conocimientos. Si no conociéramos que los protones están formados por Quarks, ¿Cómo nos podríamos preguntar si habrá algo más allá de los Quarks?

El gobierno de Estados Unidos, después de llevar gastados miles de millones de dólares, suspendió la construcción del super-colisionador superconductor de partículas asestando un duro golpe a la física de altas energías, y se esfumó la oportunidad para obtener nuevos datos de vital importancia para el avance de este modelo, que de momento es lo mejor que tenemos.

“Esta relación del modelo estándar se consigue con bosones de Higgs elementales en dobletes electrodébiles; está verificado experimentalmente a más del 1%. Aquí, g y g′ son acoplamientos gauge SU(2) y U(1) y tanθW = g′/g define el ángulo de mezcla débil.

La importante idea de una nueva interacción fuerte de gauge de fermiones sin masa en la escala electrodébil FEW que conducen a la ruptura espontánea de su simetría quiral, de la cual un sugrupo SU(2) ⊗ U(1) es de gauge débil, fue propuesta por primera vez en 1979 por S. Weinberg and L. Susskind. Este mecanismo “technicolor” es natural ya que no necesita ajuste fino de parámetros.”

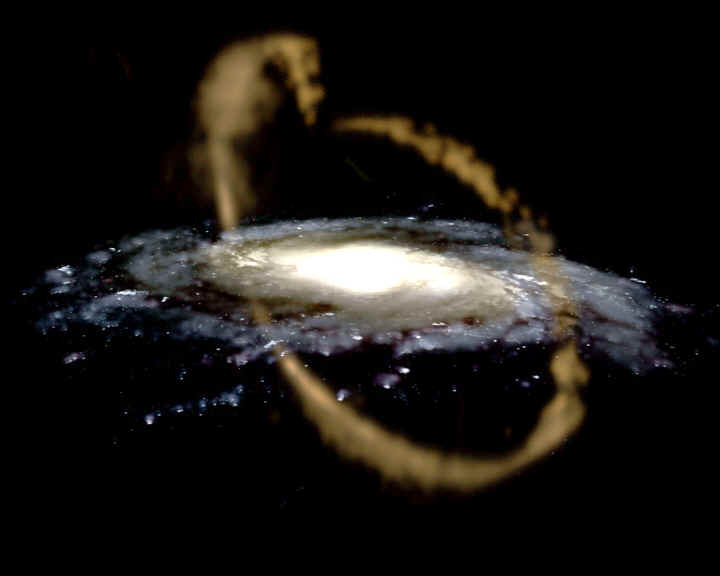

Se han estado inventando nuevas ideas, como la supersimetría y el technicolor. Los astrofísicos estarán interesados en tales ideas porque predicen una gran cantidad de nuevas partículas superpesadas, y también varios tipos de partículas que interaccionan ultra-débilmente, los technipiones. Éstas podrían ser las WIMP’s (Weakly Interacting Massive Particles, o Partículas Masivas Débilmente Interactivas) que pueblan los huecos entre las galaxias, y serían así las responsables de la masa perdida que los astrofísicos siguen buscando y llaman “materia oscura”.

Que aparezcan “cosas” nuevas y además, imaginarlas antes, no es fácil. Recordemos cómo Paul Dirac se sintió muy incómodo cuando en 1931 dedujo, a partir de su ecuación del electrón, que debería existir una partícula con carga eléctrica opuesta.

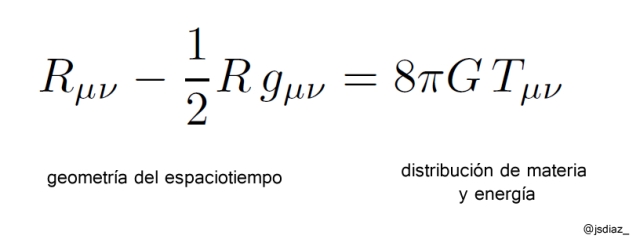

Esa partícula no había sido descubierta y le daba reparo perturbar la paz reinante en la comunidad científica con una idea tan revolucionaria, así que disfrazó un poco la noticia: “Quizá esta partícula cargada positivamente, tan extraña, sea simplemente el protón”, sugirió. Cuando poco después se identificó la auténtica antipartícula del electrón (el positrón) se sorprendió tanto que exclamó: “¡Mi ecuación es más inteligente que su inventor!”. Este último comentario es para poner un ejemplo de cómo los físicos trabajan y buscan caminos matemáticos mediante ecuaciones de las que, en cualquier momento (si están bien planteadas), surgen nuevas ideas y descubrimientos que ni se podían pensar. Así pasó también con las ecuaciones de Einstein de la relatividad general, donde Schwarzschild dedujo la existencia de los agujeros negros.

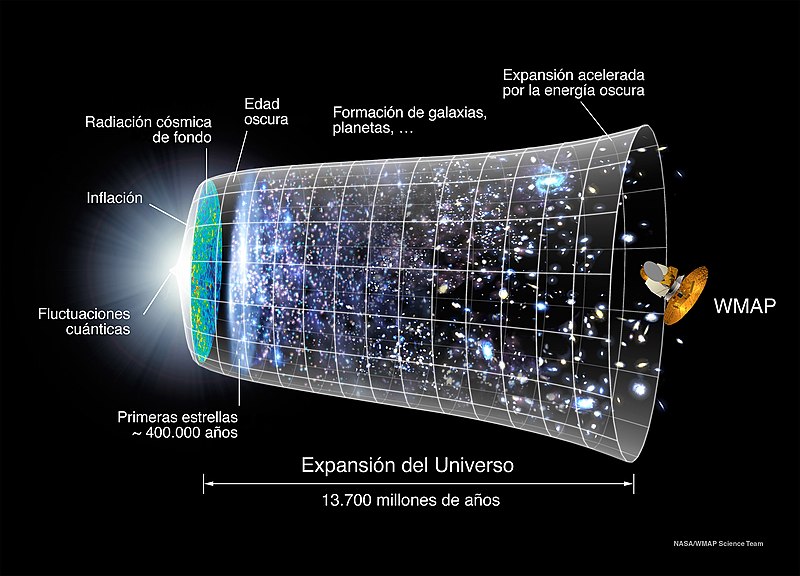

Se piensa que al principio del comienzo del tiempo, cuando surgió el Big Bang, las energías eran tan altas que allí reinaba la simetría total; sólo había una sola fuerza que todo lo englobaba. Más tarde, a medida que el universo se fue expandiendo y enfriando, surgieron las cuatro fuerzas que ahora conocemos y que todo lo rigen. Tenemos los medios, en los supercolisionadores de partículas, para viajar comenzando por 1.000 MeV, hasta finalizar en cerca de 1019 MeV, que corresponde a una escala de longitudes de aproximadamente 10–30 cm. Howard Georgi, Helen Quinn y Steven Weinberg descubrieron que ésta es la región donde las tres constantes de acoplamiento gauge se hacen iguales (U(1), SU(2) y SU(3)); resultan ser lo mismo. ¿Es una coincidencia que las tres se hagan iguales simultáneamente? ¿Es también una coincidencia que esto suceda precisamente en esa escala de longitud? Faltan sólo tres ceros más para alcanzar un punto de retorno. Howard Georgi y Sheldon Glashow descubrieron un modelo genuinamente unificado en el dominio de energías de 1019 MeV tal que, cuando se regresa de allí, espontáneamente surgen las tres fuerzas gauge tal como las conocemos. De hecho, ellos encontraron el modelo; la fórmula sería SU(5), que significa que el multiplote más pequeño debe tener cinco miembros.

Materia y Energía Oscura… Un Misterio…Sin resolver.

Y, a todo esto, ¿dónde está esa energía oculta? ¿Y donde la materia? Podemos suponer que la primera materia que se creo en el Universo fue la que llamamos (algún nom,bre había que ponerle) “Materia Oscura”, esa clase de Ilem o sustancia primera del Universo que mejor sería llamarla invisible, ya que, de no ser así, difícil sería explicar cómo se pudieron formar las primeras estrellas y galaxias de nuestro Universo, ¿dónde está el origen de la fuerza de Gravedad que lo hizo posible, sino en esa materia escondida?

¡Lo dicho! Necesitamos saber, y, deseo que de una vez por todas, se cumpla lo que dejó dicho Hilbert en su tumba de Gotinga (Alemania): “Tenemos que saber, ¡sabremos!. Pero…

¡Que sea pronto!

emilio silvera

May

30

La maravilla de… ¡los cuantos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (2)

Comments (2)

La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos. Planck escribió un artículo de ocho páginas y el resultado fue que cambió el mundo de la física y aquella páginas fueron la semilla de la futura ¡mecánica cuántica! que, algunos años más tardes, desarrollarían físicos como Einstein (Efecto fotoeléctrico), Heisenberg (Principio de Incertidumbre), Feynman, Bhor, Schrödinger, Dirac…

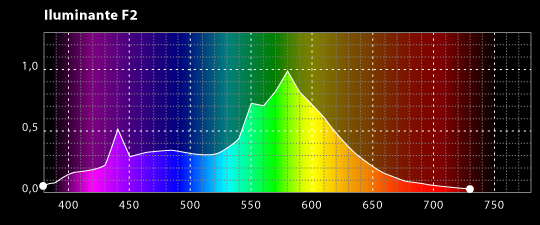

La expresión radiación se refiere a la emisión continua de energía de la superficie de todos los cuerpos. Los portadores de esta energía son las ondas electromagnéticas producidas por las vibraciones de las partículas cargadas que forman parte de los átomos y moléculas de la materia. La radiación electromagnética que se produce a causa del movimiento térmico de los átomos y moléculas de la sustancia se denomina radiación térmica o de temperatura.

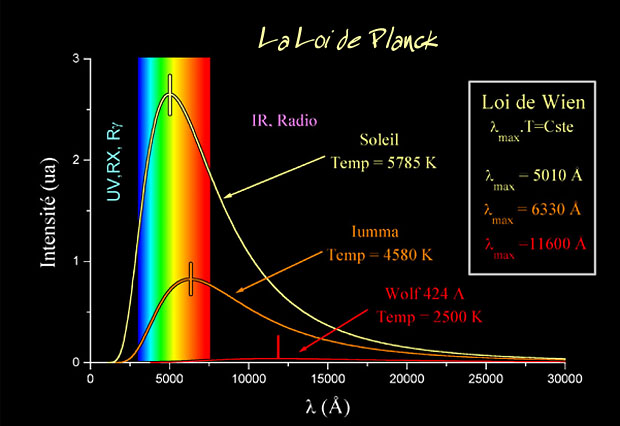

Ley de Planck para cuerpos a diferentes temperaturas.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía.

Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico o una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Acero al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = hv

Donde E es la energía del paquete, v es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck.

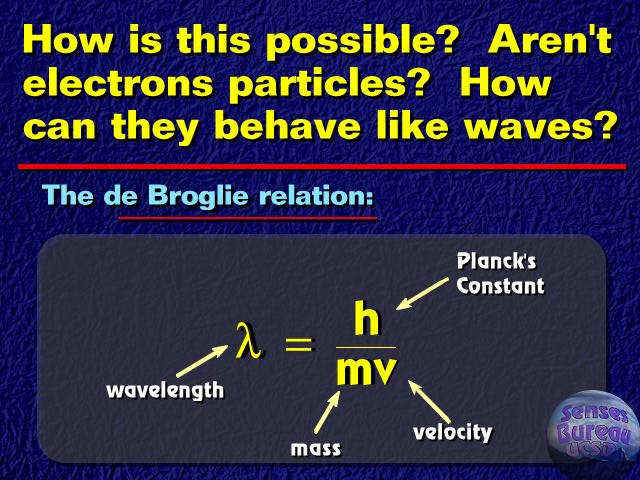

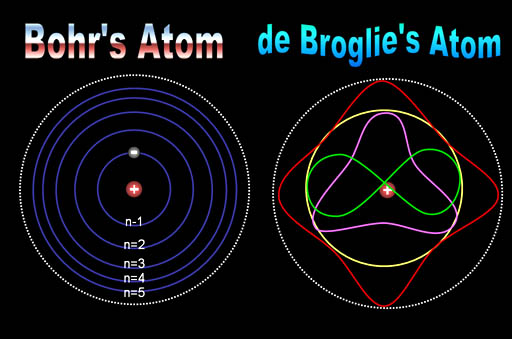

El príncipe francés Louis Victor de Broglie, dándole otra vuelta a la teoría, que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta dirección del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

Es curioso el comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Edwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar los cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de onda cuántica”.

No hay duda de que la Mecánica Cuántica funciona maravillosamente bien. Sin embargo, surge una pregunta muy formal: ¿qué significan realmente esas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá por el año 1687, formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo lo que significaban sus ecuaciones: que los planetas están siempre en una posición bien definida en el espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades con el tiempo.

Pero para los electrones todo esto es muy diferente. Su comportamiento parece estar envuelto en la bruma. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la “interpretación de Copenhague” de la Mecánica Cuántica. En vez de decir que el electrón se encuentra en el punto x o en el punto y, nosotros hablamos del estado del electrón. Ahora no tenemos el estado “x” o el estado “y”, sino estados “parcialmente x” o “parcialmente y. Un único electrón puede encontrarse, por lo tanto, en varios lugares simultáneamente. Precisamente lo que nos dice la Mecánica Cuántica es como cambia el estado del electrón según transcurre el tiempo.

Un “detector” es un aparato con el cual se puede determinar si una partícula está o no presente en algún lugar pero, si una partícula se encuentra con el detector su estado se verá perturbado, de manera que sólo podemos utilizarlo si no queremos estudiar la evolución posterior del estado de la partícula. Si conocemos cuál es el estado, podemos calcular la probabilidad de que el detector registre la partícula en el punto x.

Las leyes de la Mecánica Cuántica se han formulado con mucha precisión. Sabemos exactamente como calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas simultáneamente. Por ejemplo, podemos determinar la velocidad de una partícula con mucha exactitud, pero entonces no sabremos exactamente dónde se encuentra; o, a la inversa. Si una partícula tiene “espín” (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar con sencillez de dónde viene esta incertidumbre, pero hay ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar.

¿Onda o partícula? ¡Ambas a la vez! ¿Cómo es eso?

Para que las reglas de la Mecánica Cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuanto más grande y más pesado es un objeto más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica.

Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por “holismo”, y que se podría definir como “el todo es más que la suma de las partes”.

Bien, si la Física nos ha enseñado algo, es justamente lo contrario: un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (las partículas): basta que uno sepa sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que yo entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes.

Por ejemplo, la constante de Planck, h = 6,626075…x 10 exp. -34 julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

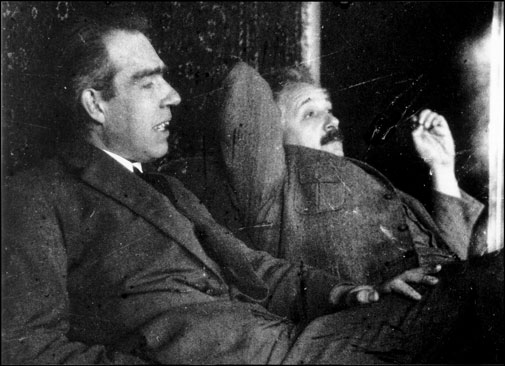

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros tales como Edwin Schrödinger, siempre presentaron serias objeciones a esta interpretación.

Quizá funcione bien, pero ¿dónde está exactamente el electrón, en el punto x o en el punto y? Em pocas palabras, ¿dónde está en realidad?, ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Hasta hoy, muchos investigadores coinciden con la actitud pragmática de Bohr. Los libros de historia dicen que Bohr demostró que Einstein estaba equivocado. Pero no son pocos, incluyéndome a mí, los que sospechamos que a largo plazo el punto de vista de Einstein volverá: que falta algo en la interpretación de Copenhague. Las objeciones originales de Einstein pueden superarse, pero aún surgen problemas cuando uno trata de formular la mecánica cuántica para todo el Universo (donde las medidas no se pueden repetir) y cuando se trata de reconciliar las leyes de la mecánica cuántica con las de la Gravitación… ¡Infinitos!

La mecánica cuántica y sus secretos han dado lugar a grandes controversias, y la cantidad de disparates que ha sugerido es tan grande que los físicos serios ni siquiera sabrían por donde empezar a refutarlos. Algunos dicen que “la vida sobre la Tierra comenzó con un salto cuántico”, que el “libre albedrío” y la “conciencia” se deben a la mecánica cuántica: incluso fenómenos paranormales han sido descritos como efectos mecano-cuánticos.

Yo sospecho que todo esto es un intento de atribuir fenómenos “ininteligibles” a causas también “ininteligibles” (como la mecánica cuántica) dónde el resultado de cualquier cálculo es siempre una probabilidad, nunca una certeza.

Claro que, ahí están esas teorías más avanzadas y modernas que vienen abriendo los nuevos caminos de la Física y que, a mi no me cabe la menor duda, más tarde o más temprano, podrá explicar con claridad esas zonas de oscuridad que ahora tienen algunas teorías y que Einstein señalaba con acierto.

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? ¿Por qué están ahí? ¿Quiere eso decir que la Teoría de Einstein y la Mecánica Cuántica podrán al fin unirse en pacifico matrimonio sin que aparezcan los dichosos infinitos?

Bueno, eso será el origen de otro comentario que también, cualquier día de estos, dejaré aquí para todos ustedes.

emilio silvera

Totales: 75.605.450

Totales: 75.605.450 Conectados: 15

Conectados: 15