Jun

10

Moléculas vivas sorprendentes

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

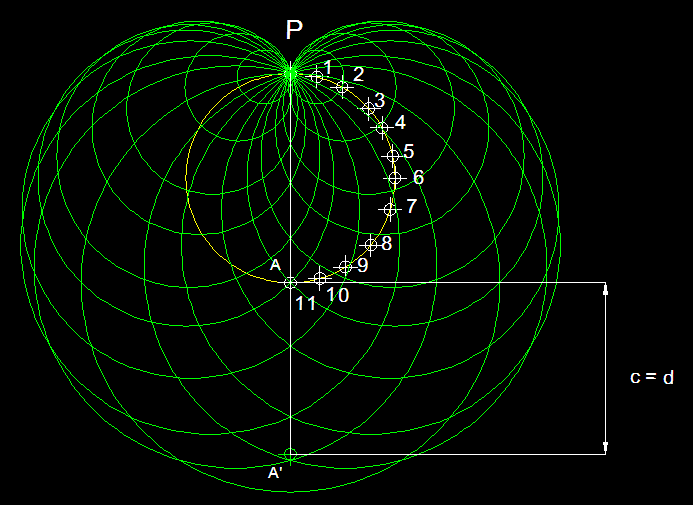

En matemáticas se pueden trazar líneas precisas y concretas que dividan en dos clases entes de naturaleza matemática. Una estructura geométrica se puede superponer o no a su imagen especular. Una estructura asimétrica puede tener una lateralidad a la derecha o bien a la izquierda.

Cualquier número entero positivo es par o impar, y no hay ninguno de tales números para el cual su situación a este respecto ofrezca la menor duda. Pero en el mundo, si exceptuamos el nivel subatómico de la teoría cuántica, las lineas divisortias son casi siempre difusas. El alquitrán, ¿es sólido o líquido?. Lo cierto es que, la mayoría de las propiedades físicas se “mueven” en un espectro continuo que hace que vayan cambiando de manera imperceptible de un extremo a otro del mismo.

El paso del tiempo convierte en líquido, gas o sólido algunos materiales y, a otros, los deforma hasta perder su estructura original para convertirlos en lo que antes no eran. Nada permanece, todo cambia. Sea cual fuere la línea de división, habrá algunos casos en los que no podamos definirla y, en otros, habrá objetos tan próximos a ella que el lenguaje ordinario no será lo suficientemente preciso como para poder afirmar a qué lado pertenece. Y, la propiedad de la vida, está, precisamente, en uno de esos continuos.

Para porbar esto basta que consideremos los virus: son las estructuras biológicas más pequeñas que se conocen con la propiedad de poder “comer” (absorber sustancias situadas en sus proximidades), crecer y fabricar copias exactas de sí mismas.

Son mucho más pequeños que una bacteria (en realidad, algunos virus infectan las bacterias) y pasan sin dificultad a través de un filtro de porcelana fina que, aunque a nosotros nos parezca que está completamente sellada y su superficie es totalmente hermética y lisa, para ellos, tan “infinitamente” pequeños, ofrece miles de huecos por los que poder colarse.

Nuevas grabaciones en vídeo de un virus que infecta a las células sugiere que los virus se expanden mucho más rápido de lo que pensábamos. El descubrimiento de este mecanismo permitirá crear nuevos fármacos para hacer frente a algunos virus. En la punta de un alfiler caben millones de ellos. De hecho, los virus tienen el tamaño de una décima de micrómetro (diezmillonésima parte del metro).

El mundo de lo muy pequeño es fascinante y, por ejemplo, si hablamos de átomos, se necesitarían aproximadamente una cantidad para nosotros inconmensurable de átomos (602.300.000.000.000.000.000.000) para lograr un solo gramo de materia. Fijáos que hablamos de lo pequeño que pueden llegar a ser los virus y, sin embargo, el Hidrógeno con un sólo protón es el átomo más ligero y su masa es 400.000 veces menor que la masa de un virus, como antes dije, el organismo vivo más pequelo que se conoce. El virus más diminuto conocido mide unos o,00000002 m; su tamaño es 2.000 veces mayor que el del átomo. Y, en la punta del algiler que antes mencionamos cabrían 60.000.000.000 (sesenta mil millones) de átomos.

… de onda correspondientes, desde el Everest hasta las moléculas de agua y el átomo de hidrógeno, pasando por ojos de aguja, glóbulos rojos, virus y ADN.

En realidad, los virus dominan la Tierra

Como los virus son menores que la longitud de onda de la luz, no pueden observarse con un microscopio luminoso ordinario, pero los bioquímicos disponen de métodos ingeniosos que les permiten deducir su estructura, ya que pueden verlos mediante bombardeos con rayos X u otras partículas elementales.

En realidad, se puede decir que un cristal “crece”, pero lo hace de un modo ciertamente trivial. Cuando se encuentra en una solución que contiene un compuesto semejante a él, dicho compuesto se irá depositando sobre su superficie; a medida que esto ocurre, el cristal se va haciendo mayor, pero el virus, igual que todos los seres vivos, crece de una manera más asombrosa: toma elementos de su entorno, los sintetiza en compuestos que no están presentes en el mismo y hace que se combinen unos con otros de tal manera que lleguen a dar una estructura compleja, réplica del propio virus.

Helicobacter Pylori, enemigo íntimo del sistema

Los virus sólo se multiplican en células vivientes. La célula huésped debe proporcionar la energía y la maquinaria de síntesis, también los precursores de bajo peso molecular para la síntesis de las proteínas virales y de los ácidos nucleicos. El ácido nucleico viral transporta la especificidad genética para cifrar todas las macromoléculas específicas virales en una forma altamente organizada.

El poder que tienen los virus de infectar, e incluso matar, un organismo, se debe precisamente a esto. Invade las células del organismo anfitrión, detiene su funcionamiento y lo sustituye, por decirlo de alguna manera, por otros nuevos. Ordena a la célula que deje de hacer lo que normalmente hace para que comience a fabricar las sustancias necesarias para crear copias de sí mismo, es decir, del virus invasor.

El primer virus que se descubrió, y uno de los más estudiados, es el virus sencillo que produce la “enfermedad del mosaico” en la planta del tabaco. Cristaliza en forma de barras finas que pueden observarse a través del microsopio electrónico. Recientemente se ha descubierto que cada barra es, en realidad, una estructura helicoidal orientada a la derecha, formada por unas 2.000 moléculas idénticas de proteína, cada una de las cuales contiene más de 150 subunidades de aminoácidos.

Jun

10

Nuestro lugar en el Universo…¿Cuál será?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

¿Quién nos observa? No podríamos negar que esté sucediendo

En esto de la vida en otros mundos, si nos ceñimos a las estadísticas, no podemos negar que estén ahí fuera, situados en mundos como el nuestro o parecidos, una ingente cantidad de criaturas de todo tipo y pelaje, unos con inteligencia y otros, como aquí en la Tierra, a medio camino entre la consciencia y ese limbo en el que no se tiene consciencia de Ser.

Antes en otra entrada que titulé “Observar la Naturaleza… da resultados”, comentaba sobre los grandes números de Dirac y lo que el personaje llamado Robert Henry Dicke pensaba de todo ello y, cómo dedujo que para que pudiera aparecer la biología de la vida en el Universo, había sido necesario que el tiempo de vida de las estrellas fuese el que hemos podido comprobar que es y que, el Universo, también tiene que tener, no ya las condiciones que posee, sino también, la edad que le hemos estimado.

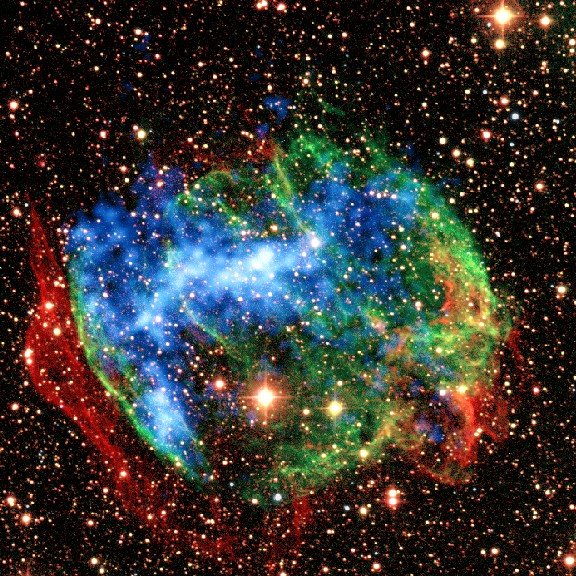

Los filamentos de un remanente de Supernova que, mirándolos y pensando de donde vienen… Te hacen recorrer unos caminos alucinantes que comenzaron con una inmensa aglomeración de gas y polvo que se constituyó en una estrella masiva que, después de vivir miles de millones de años, dejó, a su muerte, el rastro que arriba podemos contemplar.

Para terminar de repasar la forma de tratar las coincidencias de los Grandes Números por parte de Dicke, sería interesante ojear retrospectivamente un tipo de argumento muy similar propuesto por otro personaje, Alfred Wallace en 1903. Wallace era un gran científico que, como les ha pasado a muchos, hoy recibe menos reconocimiento del que se merece.

Jun

9

La Frontera KT – Hablemos de eso

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

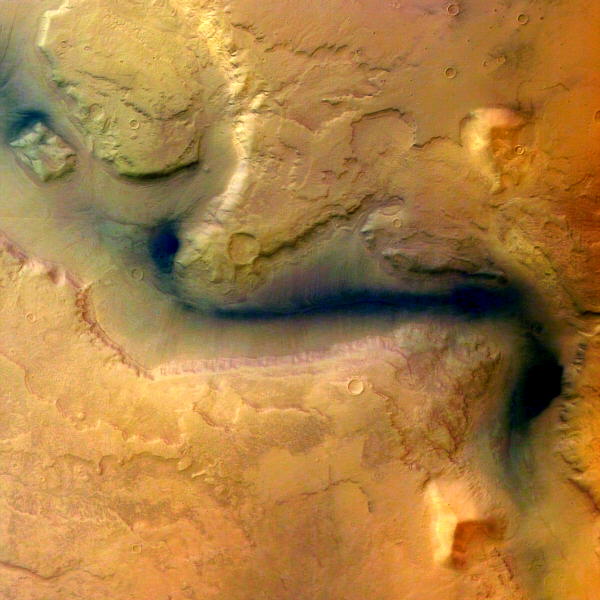

Situación de los continentes a finales del Cretácico. El cráter de Chicxulub está señalado en el centro de la imagen. Los fantásticos dinosaurios que, si no tuviéramos la evidencia fósil nunca hubiéramos creído su existencia

La teoría más extendida de todas las que intentan explicar la extinción del 65% de las especies que habitaban la Tierra hace 65 millones de años, se refiere al impacto de un gran meteorito en Chicxulub que formó un cráter de 180 kilómetros de diámetro. La prueba esgrimida como definitiva fue el hallazgo de esférulas derivadas del impacto inmediatamente debajo del límite estratigráfico entre el Cretácico y el Terciario, junto con la detección de una anomalía de iridio coincidente con la extinción masiva de foraminíferos marinos, y el descubrimiento y datación del propio cráter de Chicxulub.

Pero para entender de qué hablamos señalemos cuestiones sencillas que todos entendemos como, por ejemplo, la muerte de los dinosaurios que se extinguieron (según todos los indicios) hace ahora 65 millones de años, como parte de una extinción masiva de la vida en la Tierra, algo tan claramente reflejado en el registro fósil que se utiliza para marcar el final de un período de tiempo geológico, el cretáceo, y el comienzo de otro, el terciario.

La huella dejada por aquel acontecimiento en el todo el mundo, no deja lugar a dudas para los geólogos. La señal, les habla del pasado.

Puesto que la “C” ya se ha utilizado como inicial en un contexto similar en relación con el período Cámbrico, este marcador se suele denominar Frontera K-T, con una “K” de Kreide, que es el nombre del Cretáceo en alemán. No fueron solos los dinosaurios los que resultaron afectados (aunque por sus características son los que siempre aparecen con mayor protagonismo en el suceso). Alrededor del 70 por ciento de todas las especies que vivían en la Tierra a finales del Cretáceo habían desaparecido al principio del Terciario, lo cual nos indica que se trató realmente de una “extinción en masa” y explica por qué los geólogos y los paleontólogos utilizan la frontera K – T como un marcador importante en el registro fósil.

Dadas las dificultades que plantean unas pruebas de tiempos tan remotos, y la lentitud con la que se acumulan los estratos geológicos, todo lo que podemos decir sobre la velocidad a la que se produjo aquella extinción es que sucedió en menos de unas pocas decenas de miles de años o en unos cien mil años; sin embargo, esto se considera un cambio brusco en relación con la escala de tiempo utilizada en geología.

La hipótesis propone que un asteroide de 15 kilómetros de diámetro impactó en algún lugar de la Tierra (después se identificó con un cráter en las inmediaciones de la península del Yucatán, el llamado cráter de Chicxulub), levantando millones de toneladas de corteza continental volatilizada a la atmósfera. Posteriormente, tras unas prospecciones petrolíferas se encontró la posible huella del evento buscado, como se puede observar en la siguiente imagen:

El impacto que creó un cráter de 180 kilómetros de diámetro ocasionó que millones de toneladas de plataforma continental fueran volatilizadas y enviadas a decenas de kilómetros de altura ocasionando una nube de polvo muy densa que persistió durante años llevando al mundo a un enfriamiento global siendo aquel el mayor invierno nuclear que ha visto la Tierra, que sepamos.

Las preguntas obvias que todo esto planteason las mismas que surgen tras un gran terremoto: ¿por qué sucedió? ¿podría suceder de nuevo? y, en ese caso, ¿cuándo? En el caso del suceso K – T, tenemos un candidato muy cualificado para que fuera el desencadenante que hizo que aquella extinción se produjera hacer 65 millones de años, en vez de suceder por ejemplo, hace 60 o 55 millones de años. Los restos de ese enorme cráter de arriba que data justo de entonces ha sido descubierto bajo lo que actualmente es la península de Jucatán, en Mexico, y por todo el mundo se ha encontrado estratos de hace 65 millones de años que contienen restos de Iridio, un metal abundante en el centro de la Tierra pero, muy escaso en la superficie, del que sabemos que es un componente de los meteoritos de cierto tipo.

ESA – La cara oculta de Lutetia alberga un cráter oculto

Si alguno de estos cayera sobre la Tierra, la Historia se podría repetir y, en algún caso, ni sería seguro que algo vivo pudiera seguir existiendo con la caída de un enorme “monstruo” pétreo venido del espacio interestelar a velocidades alucinantes que no podríamos frenar ni destruir. La Tierra, a pesar de su mucha y avanzada tecnología, no está preparada para solucionar estos problemas.

Se llama 2005 YU55 y no es la primera vez que tenemos noticias de él. Este asteroide de 400 metros de diámetro (el tamaño de un portaaviones) calificado en su día como potencialmente peligroso para la Tierra, se acercó el pasado 8 de noviembre a 324.600 kilómetros de nuestro planeta, una distancia inferior a la que está la Luna. En términos astronómicos, significa una arriesgada caricia en la cara. Observatorios de todo el mundo no perdieron detalle de la visita. En concreto, científicos de la NASA siguieron la trayectoria de la roca espacial desde radiotelescopios de Goldstone, California, y Arecibo, en Puerto Rico. Ante la sensación que causó la cercanía del cometa Elenin, la agencia espacial ha querido adelantarse a los más aprensivos: “el asteroide no ejercerá ninguna influencia sobre las placas tectónicas o la gravedad de la Tierra. No se notará efecto alguno.”

La trayectoria del 2005 YU55, descubierto en 2005 por astrónomos de la Universidad de Arizona, es bien conocida. En su punto máximo de aproximación llegará a 324.600 kilómetros de la Tierra (0,85 de la distancia a la Luna). Aunque 2005 YU55 visita regularmente la vecindad de la Tierra, Venus y Marte, debido a su trayectoria, el encuentro de 2011 fue el más cercano que esta roca espacial ha realizado durante los últimos 200 años. ¿Quién nos garantiza que la próxima vez será el viaje tan pacífico? Cualquier suceso podría variar su trayectoria con resultados funestos para nosotros.

En un clima así, los reptiles de sangre fría podían proliferar incluso en latitudes boreales, mientras que los fósiles de helechos y cicas encontrados en rocas del cretácico a latitudes árticas son similares a las plantas de hoy en los bosques húmedos subtropicales.

A pesar de la benignidad de las condiciones ambientales a finales del periodo se produjeron varias extinciones en masa.

A pesar de la benignidad de las condiciones ambientales a finales del periodo se produjeron varias extinciones en masa.Jun

9

Los Misterios de la Tierra

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Encuentros espaciales

La más destructiva intensificación temporal de los normalmente suaves flujos de energía geotectónica –erupciones volcánicas o terremotos extraordinariamente potentes– o de energía atmosférica –vientos o lluvias anormalmente intensas–, parecen irrelevantes cuando se comparan con las (en el pasado) repetidas colisiones del planeta con cuerpos extraterrestres relativamente grandes. Que por ahora, nos están respetando y, además, tenemos el escudo de Júpiter que los atrae.

Apophis (conocido anteriormente por su designación provisional 2004 MN4) es un asteroide Atón, con una órbita próxima a la de la Tierra que, en un primer momento pareció que colisionaría con el planeta.Parece un tradición hacer grandes titulares cuando un nuevo asteroide se acerca a la Tierra. Las redes sociales se inflaman y todo el mundo se acuerda del asteroide que parece que terminó con los dinosaurios.

En el caso de Apophis, 99942 para sus íntimos, es cierto que se trata del objeto con más probabilidades de impacto, aunque sean muy lejanas. Además el nombre no ayuda. Apophis es el Dios del Caos o de las fuerzas del mal de los egipcios, lo cual sin duda es perfecto para hacer grandes titulares.

Tampoco ayuda su calificación astronómica: la NASA clasifica algunos objetos cercanos a la tierra (Near Earth Objects) como “potencialmente peligrosos”. El cóctel está servido para crear supuestos alarmantes.

Existen simulaciones de lo que puede ser el choque del meteorito en la Tierra y, desde luego, no quisiera estar aquí cuando suceda. La Tierra está siendo bombardeada continuamente por invisibles partículas microscópicas de polvo muy abundantes en todo el Sistema Solar, y cada treinta segundos se produce un choque con partículas de 1 mm de diámetro, que dejan un rastro luminoso al autodestruirse en la atmósfera. También son relativamente frecuentes los choques con meteoritos de 1 metro de diámetro, que se producen con una frecuencia de, al menos, uno al año.

Pero los impactos, incluso con meteoritos mayores, producen solamente efectos locales. Esto es debido a que los meteoritos que deambulan por la región de asteroides localizada entre Marte y Júpiter están girando alrededor del Sol en el mismo sentido que la Tierra, de manera que la velocidad de impacto es inferior a 15 Km/s.

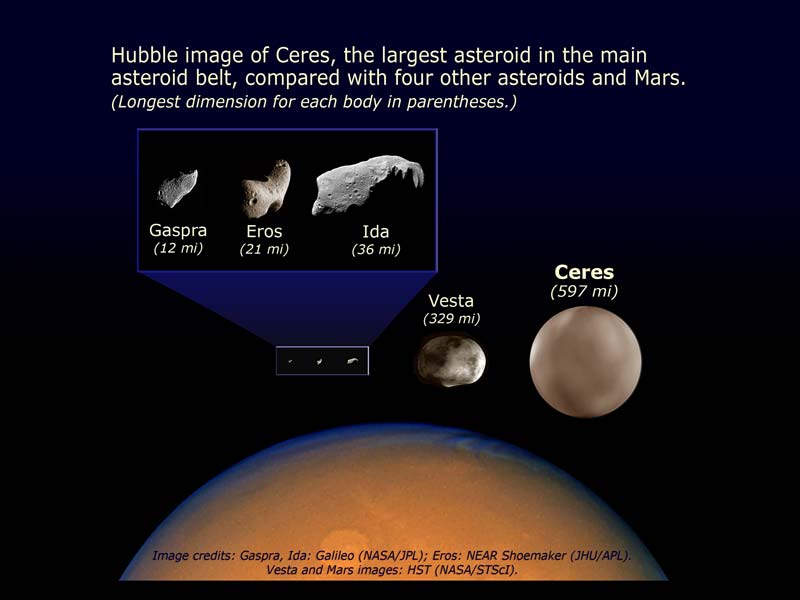

Entre Marte y Júpiter hay cientos de miles de cuerpos pequeños que orbitan alrededor del Sol llamados asteroides. También podemoas encontrarlos más allá de Plutón, llamado cinturón de Kuiper, y que en este caso reciben el nombre de objetos transneptunianos y que están hecho de hielo. Ceres es el asteroide más grande y tiene 913 km de diámetro.

El cráter de Arizona, casi perfectamente simétrico, se formó hace 25.000 años por el impacto de un meteorito que iba a una velocidad de 11 Km/s, lo que representa una potencia cercana a 700 PW. Estas gigantescas liberaciones de energías palidecen cuando se comparan con un choque frontal con un cometa típico. Su masa (al menos de 500 millones de toneladas) y su velocidad relativa (hasta 70 Km/s) elevan su energía cinética hasta 1022 J. Aunque se perdiera un diez por ciento de esta energía en la atmósfera, el impacto sería equivalente a una explosión de unas 2.500 bombas de hidrógeno de 100 megatones.

Está claro que un fenómeno de estas características produciría impresionantes alteraciones climatológicas. Sin embargo, no es seguro y sí discutible que un impacto parecido fuese la causa de la extinción masiva del cretácico, siendo lo más probable, si tenemos en cuenta el periodo relativamente largo en que se produjo, que se podría explicar por la intensa actividad volcánica de aquel tiempo.

La frecuencia de impactos sobre la Tierra disminuye exponencialmente con el tamaño del objeto. Muchas toneladas son las que recibimos cada año de pequeños fragmentos de todo tipo pero, cuando estos van aumentando de tamaño, los sucesos de espacian de manera sustancial

Aproximadamente, cada cincuenta o sesenta millones de años se produce una colisión con un cometa, lo que significaría que la biosfera, que ha evolucionado durante cuatro mil millones de años, ha debido superar unos cuarenta impactos de este tipo. Está claro que ha salido airosa de estas colisiones, ya que aunque haya sido modificada, no ha sido aniquilada.

Supernova 1994D (SN1994D) en la galaxia NGC 4526. La supernova es el punto brillante abajo a la izquierda. Pueden llegar a brillar más que toda la galaxia completa durante un breve período de tiempo. (Crédito: NASA). Ahí, en esa explosión sin igual, se gesta la “fabricación” de materiales muy complejos como el oro y el platino…entre otros.

Igualmente, la evolución de la biosfera ha sobrevivido a las explosiones altamente energéticas de las supernovas más “cercanas”. Dado que en nuestra galaxia se produce por término medio la explosión de una supernova cada 50 años, el Sistema Solar se encuentra a una distancia de 100 parsecs de la explosión cada dos millones de años y a una distancia menor de 10 parsecs cada dos mil millones de años. En este último caso, la parte alta de la atmósfera se vería inundada por un flujo de rayos X y UV de muy corta longitud de onda, diez mil veces mayor que el flujo habitual de radiación solar, lo que implica que la Tierra recibiría, en unas pocas horas, una dosis de radiación ionizante igual a la que recibe anualmente. Exposiciones de 500 roentgens son letales para la mayoría de los vertebrados y, sin embargo, los diez episodios de esta magnitud que se han podido producir en los últimos 500 millones de años no han dejado ninguna consecuencia observable en la evolución de la biosfera.

Si suponemos que una civilización avanzada podría preparar refugios para la población durante el año que transcurre ente la llegada de la luz y la llegada de la radiación cósmica, se encontraría con la inevitable dosis de 500 roentgens cada mil millones de años, tiempo suficiente para permitir el desarrollo de una sociedad cuyo conocimiento le sirviera para defenderse de un flujo tan extraordinario y de consecuencias letales.

La fotosíntesis

Todo el Oxígeno de la Atmósfera terrestre procede del oxígeno que desprenden los organismos autótrofos durante la fotosíntesis.

La fotosíntesis es el principal proceso bioquímico que consigue pasar materiales desde el biotopo hasta la biocenosis de un ecosistema. Una vez incorporados como parte de los organismos autótrofos, los heterótrofos (por ejemplo, los animales) solo tienen que aprovecharse de aquellos; con la existencia de pequeñas cantidades de agua, todo está preparado para que el ecosistema entero comience a funcionar. Además, siempre habrá animales depredadores, carnívoros, que seguirán aprovechando los materiales de otros.

La conocida ecuación básica que describe la reacción endotérmica por la cual se sintetiza una molécula de glucosa a partir de sus seis moléculas de CO2 y H2O, y 2’8 MJ de radiación solar, es una simplificadísima caja negra. Una caja negra más realista sería la siguiente:

106 CO2 + 90 H2O + 16 NO3 + PO4 + nutrientes minerales + 5’4 MJ de radiación = 3’258 g de protoplasma (106 C, 180 H, 46 O, 16 N, 1 P y 815 g de cenizas minerales) + 154 O2 + 5’35 MJ de calor disipado.

Sin macronutrientes ni micronutrientes no se puede producir fitomasa, que está compuesta por los nutrientes básicos necesarios para todos los seres heterótrofos: azúcares complejos, ácidos grasos y proteínas.

Para entender esta caja negra hay que comenzar por destacar la acción de unos pigmentos sensibles a la luz entre los cuales destacan las clorofilas. Éstas absorben la luz en dos bandas estrechas, una entre 420 y 450 nm, y la otra entre 630 y 690 nm. Así, la energía necesaria para la fotosíntesis sólo procede de la radiación azul y roja a la que corresponde menos de la mitad de la energía total de la insolación. Esta parte de la radiación fotosintéticamente activa (RFA) no se utiliza en reducir CO2, sino en la regeneración de compuestos consumidos durante la fijación del gas.

La síntesis de fitomasa en el ciclo reductor del fosfato pentosa (RPP) –un proceso con varios pasos de carboxilación por catálisis enzimática, reducción y regeneración– tiene que empezar con la formación de trifosfato de adenosina (ATP) y nicotinamida adenina dinucleótido fosfato (NADP), que son los dos compuestos que suministran energía a todas las reacciones biosintéticas. La síntesis de las tres moléculas de ATP y las dos de NADP que se necesitan para reducir cada molécula de CO2 requiere de diez cuantos de radiación solar con longitud de onda próxima al pico rojo de absorción de la clorofila (680 nm). El carbono procedente del CO2, combinado con el hidrógeno del agua y con los micronutrientes, dará lugar a nueva fitomasa que contiene 465 KJ/mol.

La cantidad de energía de un cuanto de luz roja es de 2’92×10-19 J (el producto de la constante de Planck, 6’62×10-34 por la frecuencia de la luz, que a su vez es el cociente entre la velocidad de la luz y la longitud de onda).

Un einstein (definido como un mol o número de Avogadro, 6’02×1023) de fotones rojos tiene una energía aproximadamente igual a 17 Kg. Suponiendo que la RFA es el 45% de la luz directa, la eficiencia global de la fotosíntesis es del 11%, que equivale a 456/(1.760/0’43). Esta eficiencia se reduce por lo menos en una décima parte más si tenemos en cuenta la reflexión de la luz en las hojas y la pérdida que supone atravesar la cubierta vegetal. Ninguna planta, sin embargo, se acerca siquiera a esta eficiencia teórica, porque parte de la luz absorbida por las clorofilas (generalmente, el 20 – 25 por ciento) vuelve a ser emitida en forma de calor, debido a que los pigmentos no pueden almacenar la luz y las reacciones enzimáticas no se producen con suficiente velocidad como para utilizar completamente el flujo de energía incidente. En la respiración se cede el carbono fijado en el metabolismo de la planta y en el mantenimiento de las estructuras que la soportan.

Mosaico de nuestro planeta Tierra que recibe una fracción de la energía solar

Para cada especie, la tasa con la que se pierde carbono está determinada principalmente por el tipo de fotosíntesis. Así, existen diferencias sustanciales entre las plantas C3 y C4. La respiración a escala de una comunidad o ecosistema depende del estado de crecimiento, y varía entre menos del 20 por ciento en plantas jóvenes en rápido crecimiento, hasta más del 90 por ciento en bosques maduros.

Con una pérdida del 25 por ciento para la reacción, y otro tanto para la respiración, la eficiencia fotosintética es ligeramente superior al 5 por ciento. En este punto, las estimaciones teóricas y los valores reales coinciden, ya que el valor medio de fotosíntesis neta en plantas muy productivas y en condiciones óptimas y durante cortos periodos de tiempo, oscila entre el 4 y el 5 por ciento. La mayoría de las plantas rinden en función de los nutrientes, especialmente nitrógeno y agua, o por las bajas temperaturas en las regiones de mayor altura y latitud. Los mejores rendimientos en sistemas naturales muy productivos, como los humedales y los cultivos, están entre el 2 y el 3 por ciento. En otros ecosistemas, como los pantanos tropicales templados y los bosques templados, el rendimiento de la transformación es del 1’5 por ciento, y en las praderas muy áridas sólo del 0’1 por ciento. Globalmente, la producción anual es, al menos, de 100.000 millones de toneladas de fitomasa, que se sintetizan con un rendimiento medio del 0’6 por ciento.

Mapa de clorofila en los océanos

La fotosíntesis en los océanos, muy afectada por la escasez de nutrientes, es incluso menos eficiente. La productividad medie es de poco más de 3 MJ/m2 y se realiza con un rendimiento fotosintético del 0’06 por ciento. La media ponderada total es 0’2 por ciento, es decir, que sólo uno de cada 500 cuantos de energía solar que llega a la superficie de la Tierra se transforma en energía de biomasa en forma de tejido vegetal.

La mayor parte de esta energía se almacena en forma de azúcares simples, que contienen más energía, y que sólo se encuentran en las semillas.

La mayor parte de la fitomasa está en los bosques. En los océanos, los principales productores son los organismos que componen el fitoplancton, que son muy pequeños y flotan libres. Su tamaño varía entre algo menos de 2 y 200 μm de diámetro y están formados por cantidades variables de bacterias y protoctistas eucarióticos. Las cianobacterias cocoides son tan abundantes en algunas aguas oligotrópicas que pueden ser las responsables de la mayor parte de la producción de fitoplancton.

Los protoctistas fotosintetizadores varían entre los más pequeños flagelados pigmentados (como las criptomonas y crisofitos), hasta las diatomeas y dinoflagelados, que son mayores (más de 10 mm) y generalmente dominantes. Las diatomeas están formadas por células sin flagelos, con paredes de silicio amorfo mezclados con otros compuestos orgánicos. Presentan una sorprendente y amplia variedad de diseño, desde las que tienen simetría central (las de forma radial son las dominantes en el océano), a las pennadas (simetría lateral), y otras forman largas cadenas.

La productividad de fitoplancton está controlada por la temperatura del agua y por la disponibilidad de radiación solar y nutrientes. La temperatura no es determinante, porque muchas especies son muy adaptables y consiguen una productividad similar en distintos ambientes. Aunque es frecuente la adaptación a diferentes condiciones lumínicas, tanto el volumen como en contenido en clorofila de las diatomeas aumenta con la intensidad de la luz. En el mar abierto, la mayor limitación es la cantidad de nutrientes disponibles.

Entre las carencias que más limitan la producción de fitoplancton está la de nitrógeno, el macro-nutriniente más importante, la de fósforo, y la de algunos otros micronutrientes clave como el hierro y el silicio.

Los medios menos productivos de la Tierra están en la capa superficial y la capa inmediatamente inferior de los océanos. En el mar abierto, las concentraciones más altas de nutrientes se encuentran entre los 500 y los 1.000 metros, a bastante más profundidad que la zona eufórica, capa en la que penetra la luz solar y que se extiende a unos 100 metros en las aguas transparentes.

El pequeñísimo tamaño de los productores dominantes es una adaptación eficaz a la escasez de nutrientes, ya que cuanto mayor sea el cociente entre la superficie y el volumen, y más lento el hundimiento de las células de fitoplancton en la capa eufórica, mayor es la tasa de absorción de nutrientes.

Cuando las corrientes elevan a la superficie las aguas frías y cargadas de nutrientes, la producción de fitoplancton aumenta sustancialmente. Las aguas costeras de Perú, California, noroeste y sudoeste de África, y de la India occidental son ejemplos destacados de ascensión costera de aguas frías. También se dan casos de ascensión mar adentro en la mitad del Pacífico, cerca del ecuador y en las aguas que rodean la Antártida. Otras zonas altamente productivas se encuentran en las aguas poco profundas cercanas a la costa que están enriquecidas por el aporte continental de nutrientes. Este enriquecimiento, con una proporción N/P muy descompensada, es especialmente elevados en los estuarios adonde van a parar grandes cantidades de aguas residuales y fertilizantes.

Las diferentes medidas de la productividad en las aguas oligotróficas de los mares subtropicales y de las aguas eutróficas con corrientes ascensionales, varían entre menos de 50 gC/m2 y 1 gC/m2, más de un orden de magnitud. Las estimaciones de la producción global de fitoplancton están comprendidas entre 80.000 y 100.000 millones de toneladas, que representan entre dos tercios y cuatro quintos de la fitomasa total terrestre. Contrasta con el resultado anterior el hecho de que, dado el corto periodo de vida del fitoplancton (1 – 5 días), la fitomasa marina represente sólo una pequeña fracción de todo el almacenamiento terrestre.

La distribución espacial del fitoplancton muestra zonas delimitadas que se extienden a escala local y global. La exploración desde los satélites es, con gran diferencia, la que permite detectar con mayor precisión las concentraciones de clorofila y la que ha posibilitado obtener las pautas de la distribución de fitoplancton. En las aguas que rodean la Antártida se observa claramente una distribución asimétrica en dos bandas casi concéntricas. La mejor distribución se explica por el hecho de que se deba a corrientes circumpolares y a la abundancia de ácido silicílico. Pero las zonas de mayor riqueza de fitoplancton se encuentran cerca de los continentes donde los ríos arrastran abundantes nutrientes disueltos.

La vida necesita un aporte continuo de energía que llega a la Tierra desde el Sol y pasa de unos organismos a otros a través de la cadena trófica.

El plancton es el conjunto de organismos, la mayoría microscópicos, que flotan en el agua del mar o en los ríos y lagos. Existen más de 1.000.000 de especies, entre pequeños animales, microalgas y bacterias que crecen y se distribuyen alrededor del globo para llevar a cabo importantes funciones en los ecosistemas.

El fitoplancton es la base energética de las intrincadas pirámides tróficas. Las cadenas alimenticias en el océano, generalmente, son redes complicadas. Una gran parte de la fito-masa disponible no la consumen directamente los herbívoros, sino que primero se almacena en depósitos de materia muerta que, transformada por bacterias, se convertirá en alimento para otros seres heterótrofos.

La gran producción de fitoplancton puede alimentar grandes cantidades de zoo-masa. El kril, pequeños crustáceos parecidos a las quisquillas que se alimentan de diatomeas, son los organismos más abundantes en la superficie del mar; sus densas acumulaciones pueden contener hasta mil millones de individuos y su producción anual de zoo-masa quizá llegue hasta los 1.300 millones de toneladas. Esta prodigiosa cantidad de zoomasa sirve de alimento a focas, calamares y peces, así como a los mayores carnívoros de la biosfera, las especies de ballenas con barbas que se alimentan filtrando el agua.

emilio silvera

Jun

8

Los grandes números distintivos del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

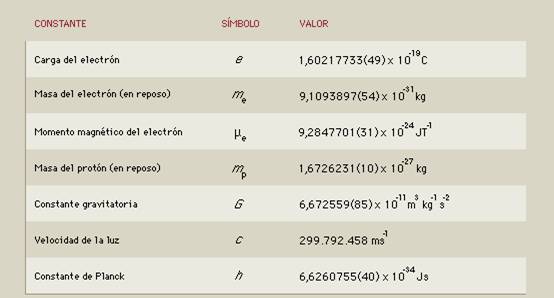

Si alguna de estas constantes de la Naturaleza, variaran tan sólo una millonésima, la vida no estaría presente

En la Física existen una serie de magnitudes que contienen información que es independiente del sistema de medida que elijamos, lo cual es muy valioso no sólo en los cálculos. Además, estos parámetros que fija la Naturaleza aparecen en las ecuaciones como parámetros que debemos ajustar lo más que podamos para que nuestras predicciones y nuestros modelos se ajusten a la realidad en la medida de lo posible.

Y aquí es donde viene el problema. Que son parámetros, es decir, su valor cuantitativo no es deducible de la teoría y por tanto hay que medirlo. Y esto añade la dificultad no sólo de idear un experimento, sino de hacerlo lo bastante preciso como para que el modelo sirva para algo.

El Modelo Estándar por ejemplo, que es el paradigma actual en el que se mueve la física de partículas y que recoge las interacciones fundamentales tiene unos 25 parámetros que se deben ajustar. Parámetros tales como la carga eléctrica, la masa, el espín, las constantes de acoplamiento de los campos, que miden la intensidad que éstos tienen, etcétera.

Ya no sólo se trata de averiguar el valor de cada una de ellas. Tampoco sabemos decir de antemano cuantas constantes fundamentales puede haber. Y es evidente que cuantas más constantes hay, más complicado se nos hace nuestro modelo.”

Si miramos hacia atrás en el Tiempo podemos contemplar los avances que la Humanidad logró en los últimos tiempos, caigo en la cuenta de que poco a poco hemos sido capaces de identificar una colección de números mágicos y misteriosos arraigados en la regularidad de la experiencia.

¡Las constantes de la naturaleza!

Dan al universo su carácter distintivo y lo hace singular, distinto a otros que podría nuestra imaginación inventar. Estos números misteriosos, a la vez que dejan al descubierto nuestros conocimientos, también dejan al desnudo nuestra enorme ignorancia sobre el universo que nos acoge. Las medimos con una precisión cada vez mayor y modelamos nuestros patrones fundamentales de masa y tiempo alrededor de su invarianza; no podemos explicar sus valores.

La Naturaleza nos manda mensajes que no siempre comprendemos

Nunca nadie ha explicado el valor numérico de ninguna de las constantes de la naturaleza. ¿Recordáis el 137? Ese número puro, adimensional, que guarda los secretos del electrón (e), de la luz (c) y del cuanto de acción (h). Hemos descubierto otros nuevos, hemos relacionado los viejos y hemos entendido su papel crucial para hacer que las cosas sean como son, pero la razón de sus valores sigue siendo un secreto profundamente escondido.

La Constante de la Estructura Fina, un número fundamental que afecta al color de la luz emitido por los átomos y todas las interacciones químicas, no ha cambiado en más de siete mil millones de años.

Esta constante ocupa un papel central en la física, apareciendo en casi todas las ecuaciones que involucran la electricidad y el magnetismo, incluso aquellas que describen la emisión de ondas electromagnéticas.

La constante, designada por la letra alfa del alfabeto griego en muchos textos, es una proporción de otras “constantes” de la naturaleza. Igual al cuadrado de la carga del electrón dividida por el producto de la velocidad de la luz multiplicada por la Constante de Planck, Alfa cambiaría, según una teoría reciente, sólo si la velocidad de la luz cambiase en el tiempo. Algunas teorías de energía oscura o de gran unificación, en particular aquellas que involucran muchas dimensiones extra más allá de las cuatro del espacio y tiempo con las que estamos familiarizados, predicen una evolución gradual de la constante de estructura fina.

Buscar esos secretos ocultos implica que necesitamos desentrañar la teoría más profunda de todas y la más fundamental de las leyes de la naturaleza: descubrir si las constantes de la naturaleza que las definen están determinadas y conformadas por alguna consistencia lógica superior o si, por el contrario, sigue existiendo un papel para el azar.

Si estudiamos atentamente las constantes de la naturaleza nos encontramos con una situación muy peculiar. Mientras parece que ciertas constantes estuvieran fijadas, otras tienen espacio para ser distintas de las que son, y algunas no parecen afectadas por ninguna otra cosa del - o en el – universo.

¿Llegaron estos valores al azar?

¿Podrían ser realmente distintos?

¿Cuán diferentes podrían ser para seguir albergando la existencia de seres vivos en el universo?

En 1.986, el libro The Anthropic Cosmological Principle exploraba las diez maneras conocidas en que la vida en el universo era sensible a los valores de las constantes universales. Universos con constantes ligeramente alteradas nacerían muertos, privados del potencial para desarrollar y sostener la complejidad que llamamos vida.

En la literatura científica puede encontrarse todo tipo de coincidencias numéricas que involucran a los valores de las constantes de la naturaleza. He aquí algunas de las fórmulas propuestas (ninguna tomada en serio) para la constante de estructura fina.

Valor experimental: 1/α = 137’035989561…

- Lewis y Adams: 1/α = 8π (8π5 / 15)1/3 = 137’384

- Eddington: 1/α = (162 – 16) / 2 + 16 – 1 = 137

- Wiler: 1/α = (8π4 / 9)(245! / π5)1/4 = 137’036082

- Aspden y Eagles: 1/α = 108π (8 / 1.843)1/6 = 137’035915

Por supuesto, si la teoría M da al fin con una determinación del valor de 1/α podría parecerse perfectamente a una de estas fórmulas especulativas. Sin embargo ofrecería un amplio y constante edificio teórico del que seguiría la predicción.

También tendría que haber, o mejor, que hacer, algunas predicciones de cosas que todavía no hemos medido; por ejemplo, las siguientes cifras decimales de 1/α, que los futuros experimentadores podrían buscar y comprobar con medios más adelantados que los que ahora tenemos, a todas luces insuficientes en tecnología y potencia.

Este letrero en el mejor sitio de todas las viviendas de los mejores físicos, para recordrales lo que no saben

Todos estos ejercicios de juegos mentales numéricos se acercan de manera impresionante al valor obtenido experimentalmente, pero el premio para el ingeniero persistente le corresponde a Gary Adamson, cuya muestra de 137-logía se mostraron en numerosas publicaciones.

Estos ejemplos tienen al menos la virtud de surgir de algún intento de formular una teoría de electromagnetismo y partículas. Pero hay también matemáticos “puros” que buscan cualquier combinación de potencias de números pequeños y constantes matemáticas importantes, como π, que se aproxime al requerido 137’035989561… He aquí algún ejemplo de este tipo.

- Robertson: 1/α = 2-19/4 310/3 517/4 π-2 = 137’03594

- Burger: 1/α = (1372 + π2)1/2 = 137’0360157

Unidades naturales que no inventó el hombre

Ni siquiera el gran físico teórico Werner Heisenberg pudo resistirse a la ironía o irónica sospecha de que…

“En cuanto al valor numérico, supongo que 1/α = 24 33 / π, pero por supuesto es una broma.”

Arthur Eddington, uno de los más grandes astrofísicos del siglo XX y una notable combinación de lo profundo y lo fantástico, más que cualquier figura moderna, fue el responsable impulsor de poner en marcha los inacabables intentos de explicar las constantes de la naturaleza mediante auténticas proezas de numerología pura. Él también advirtió un aspecto nuevo y especular de las constantes de la naturaleza.

“He tenido una visión muy extraña, he tenido un sueño; supera el ingenio del hombre decir qué sueño era. El hombre no es más que un asno cuando tiene que exponer este sueño. Se llamará el sueño del fondo, porque no tiene fondo.”

A. S. Eddington

“El conservadurismo recela del pensamiento, porque el pensamiento en general lleva a conclusiones erróneas, a menos que uno piense muy, muy intensamente.”

Roger Scruton

Todo lo que existe… ¡Tiene una explicación! No importa la extraño que pueda ser

Hay que prestar atención a las coincidencias. Uno de los aspectos más sorprendentes en el estudio del universo astronómico durante el siglo XX, ha sido el papel desempeñado por la coincidencia: que existiera, que fuera despreciada y que fuera recogida. Cuando los físicos empezaron a apreciar el papel de las constantes en el dominio cuántico y a explorar y explorar la nueva teoría de la gravedad de Einstein para describir el universo en conjunto, las circunstancias eran las adecuadas para que alguien tratara de unirlas.

Entró en escena Arthur Eddington; un extraordinario científico que había sido el primero en descubrir cómo se alimentaban las estrellas a partir de reacciones nucleares. También hizo importantes contribuciones a nuestra comprensión de la galaxia, escribió la primera exposición sistemática de la teoría de la relatividad general de Einstein y fue el responsable de verificar, en una prueba decisiva durante un eclipse de Sol, la veracidad de la teoría de Einstein en cuanto a que el campo gravitatorio del Sol debería desviar la luz estelar que venía hacia la Tierra en aproximadamente 1’75 segmentos de arco cuando pasaba cerca de la superficie solar, y así resultó.

Arthur Eddington creyó en las teorías de Einstein desde el principio, y fueron sus datos tomados durante el eclipse solar de 1919 los que dieron la prueba experimental de la teoría general de la relatividad. La amplia cobertura informativa de los resultados de Eddington llevó a la teoría de la relatividad, y al propio Einstein, a unos niveles de fama sin precedentes.

Arthur Eddington está considerado uno de los más importantes astrónomos ingleses del siglo XX. Se especializó en la interpretación de las observaciones de los movimientos de las estrellas en el Observatorio de Greenwich. En 1913, fue uno de los primeros científicos no alemanes en entrar en contacto con las primeras versiones de la teoría general de la relatividad, e inmediatamente se convirtió en un declarado partidario.

Albert Einstein y Arthur Stanley Eddington se conocieron y se hicieron amigos. Se conservan fotos de los dos juntos conversando sentados en un banco en el jardín de Eddington en el año 1.930, donde fueron fotografiados por la hermana del dueño de la casa.

Aunque Eddington era un hombre tímido con pocas dotes para hablar en público, sabía escribir de forma muy bella, y sus metáforas y analogías aún las utilizan los astrónomos que buscan explicaciones gráficas a ideas complicadas. Nunca se casó y vivió en el observatorio de Cambridge, donde su hermana cuidaba de él y de su anciana madre.

Eddington creía que a partir del pensamiento puro sería posible deducir leyes y constantes de la naturaleza y predecir la existencia en el universo de cosas como estrellas y galaxias. ¡Se está saliendo con la suya!

Entre los números de Eddington, uno lo consideró importante y lo denominó “número de Eddington”, que es igual al número de protones del universo visible. Eddington calculó (a mano) este número enorme y de enorme precisión en un crucero trasatlántico concluyendo con esta memorable afirmación.

“Creo que en el universo hay

15.747.724.136.275.002.577.605.653.961.181.555.468.044.717.914.527.116.709.366.231.425.076.185.631.031.296

protones y el mismo número de electrones.”

Este número enorme, normalmente escrito NEdd, es aproximadamente igual a 1080. Lo que atrajo la atención de Eddington hacia él era el hecho de que debe ser un número entero, y por eso en principio puede ser calculado exactamente.

Durante la década de 1.920, cuando Eddington empezó su búsqueda para explicar las constantes de la naturaleza, no se conocían bien las fuerzas débil y fuerte, y las únicas constantes dimensionales de la física que sí se conocían e interpretaban con confianza eran las que definían la gravedad y las fuerzas electromagnéticas.

No siempre sabemos valorar la grandeza a la que puede llegar la mente humana: … que puedan haber accedido a ese mundo mágico de la Naturaleza para saber ver primero y desentrañar después, esos números puros y adimensionales …”

Eddington las dispuso en tres grupos o tres puros números adimensionales. Utilizando los valores experimentales de la época, tomó la razón entre las masas del protón y del electrón:

mp / me ≈ 1.840

La inversa de la constante de estructura fina:

2πhc / e2 ≈ 137

Y la razón entre la fuerza gravitatoria y la fuerza electromagnética entre un electrón y un protón:

e2 / Gmpme ≈ 1040

A éstas unió o añadió su número cosmológico, NEdd ≈ 1080.

¿No cabría la posibilidad de que todos los grandes sucesos presentes correspondan a propiedades de este Gran Número [1040] y, generalizando aún más, que la historia entera del universo corresponda a propiedades de la serie entera de los números naturales…? Hay así una posibilidad de que el viejo sueño de los filósofos de conectar la naturaleza con las propiedades de los números enteros se realice algún día.

Eddington a estos cuatro números los llamó “las constantes últimas”, y la explicación de sus valores era el mayor desafío de la ciencia teórica.

“¿Son estas cuatro constantes irreducibles, o una unificación posterior de la física demostrará que alguna o todas ellas pueden ser prescindibles?

¿Podrían haber sido diferentes de los que realmente son?”

Lo cierto es que, si las constantes varían aunque sólo sea una diez millonésima parte… ¿Habría vida en la Tierra?

De momento, con certeza nadie ha podido contestar a estas dos preguntas que, como tantas otras, están a la espera de esa Gran Teoría Unificada del Todo, que por fin nos brinde las respuestas tan esperadas y buscadas por todos los grandes físicos del mundo. ¡Es todo tan complejo! ¿Acaso es sencillo y no sabemos verlo? Seguramente un poco de ambas cosas; no será tan complejo, pero nuestras mentes aún no están preparadas para ver su simple belleza. Una cosa es segura, la verdad está ahí, esperándonos.

Para poder ver con claridad no necesitamos gafas, sino evolución. Hace falta alguien que, como Einstein hace 100 años, venga con nuevas ideas y revolucione el mundo de la física que, a comienzos del siglo XXI, está necesitada de un nuevo y gran impulso. ¿Quién será el elegido? Por mi parte me da igual quién pueda ser, pero que venga pronto. Quiero ser testigo de los grandes acontecimientos que se avecinan, la teoría de supercuerdas y mucho más.

emilio silvera

Totales: 74.200.210

Totales: 74.200.210 Conectados: 54

Conectados: 54