Jun

8

¿Qué pasa con el Cambio Climático?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

“El riego del cambio climático para España es muy preocupante”ENTREVISTA EN “EL MUNDO”

Richard Alley, experto en cambio climático y Premio BBVA Fronteras del Conocimiento.

Richard Alley hace 20 años que no paga una plaza de aparcamiento. No se considera un activista ni un ejemplo de ciudadano que ha pasado a la acción, pero cada mañana acude a su puesto de catedrático de Geociencias de la Universidad de Pennsylvania en bicicleta. Alley ha pasado más de 30 años extrayendo testigos de hielo de Groenlandia o la Antártida y leyendo en ellos la historia del clima desde hace millones de años.

Cápsulas de Tiempo para estudiar el cambio del clima

Sus propias conclusiones le permiten hablar con la firmeza: «la huella dactilar del ser humano está en el cambio climático que estamos viviendo». Ha sido investigador principal de uno de los grupos del panel científico de Naciones Unidas para el Cambio Climático (IPCC, por sus siglas en inglés). Madrid para recoger el Premio Fundación BBVA Fronteras del Conocimientos en esa categoría.

Estuvo en Madrid para recoger el Premio Fundación BBVA Fronteras del Conocimientos en esa categoría.

- ¿Así que los testigos de hielo son el ADN de la Tierra?

- Sí, es fantástico. Es como leer su diario. Podemos volver atrás en el tiempo y leer lo que escribió nuestro tatarabuelo. En el día más cálido de mitad del verano en el centro de la Antártida hace -20ºC. Así que el hielo no se derrite, pero la nieve se acumula de manera diferente durante los veranos y los inviernos. Sólo con la nieve ya podemos contar los años. Pero además de nieve, también hay polvo y pequeños trozos de micrometeoritos y divertidos isótopos creados por los rayos cósmicos y hay burbujas de aire todo ello atrapado en la nieve año tras año. Así que podemos contar un relato maravilloso sobre el pasado del clima.

- ¿Hay diferencias entre el cambio climático actual y los que ha habido del pasado?

- Cuando miramos los testigos de hielo, vemos muchísimas cosas que afectan al clima. Está afectado por el Sol, por volcanes que bloquean la luz solar, por movimientos de placas geológicas que provocan cambios lentos en las corrientes marinas… Pero los cambios en la atmósfera parecen ser el factor más importante que controla el clima. Cuando la naturaleza aumenta el CO2 a través de las emisiones de los volcanes o de otros cambios, el clima se calienta. Pero también vemos que cuando el clima cambia, la vida cambia. Hay una línea y un montón de especies mueren en esa línea. Pero en el presente, hace cerca de 30 años que el Sol tiene una actividad baja, no hay volcanes que bloqueen el Sol y las órbitas del planeta no han cambiado demasiado. Hemos aumentado el CO2 y su efecto sobre el clima explica lo que ocurre. La naturaleza está cambiando y nuestra huella dactilar está en ello.

- P.- ¿Quiere decir que la vida que conocemos cambiará?

- Sí, con un muy alto grado de confianza, si cambiamos el clima, la vida también cambiará. Ya hemos visto como se están produciendo cambios en la época de floración de algunas plantas y que están ocurriendo algunas cosas raras. Pero el cambio climático que hemos causado hasta ahora está aún por debajo de 1ºC. Pero, si continuamos quemando fuentes fósiles, después de vendrán los 2ºC, y luego los 3ºC y luego los 4ºC… Podemos empezar a ver lugares que estarán más cálidos que cualquier lugar que conozcamos hoy en todo el planeta, y eso será muy duro.

- ¿Los dos grados centígrados son la última frontera o nos podemos permitir un aumento de 3ºC?

- Podemos realmente llegar a eso y mucho más si continuamos quemando fuentes fósiles. Y ésta es la media global, y debido a que la Tierra se calienta mucho más que en el océano, casi todos nosotros viviremos en condiciones más cálidas que esa cifra global. Pero podemos contener el calentamiento si realmente queremos hacerlo. Si somos serios en las negociaciones internacionales, podemos contener el aumento en dos grados. O, en caso contrario, nos podemos ir a tres, cuatro o más, sabiendo que cada uno de esos grados será más costoso y más peligroso que el anterior.

- ¿Confía en que en París se llegue a un acuerdo que logre controlar el aumento de temperatura en dos grados?

- No confío, ya veremos. Es posible. Estamos en un momento muy interesante, con la encíclica del Papa…

- ¿Son buenas señales?

- Sí, muy buenas. Es muy interesante el texto del Papa. La ciencia en la que se basa es muy sólida.

- ¿Qué quiere decir para España un aumento como el que estamos contemplando?

- Es muy preocupante. Acabamos de ver los efectos de las olas de calor en India y Paquistán. Las zonas secas alrededor de los trópicos se harán mayores y esto puede influir en España. Si continuamos por el mismo camino, en la mayoría de lugares de la Tierra el peor verano que se recuerda hoy en día estará por debajo de la media a finales de siglo.

- Abandonando los mensajes catastróficos, ¿Qué podemos hacer como ciudadanos?

- Tenemos una larguísima tradición de quemar cosas para conseguir energía mucho más rápido de lo que la naturaleza crea otras nuevas. Quemábamos la grasa de las ballenas para tener luz por las noches y casi nos quedamos sin ballenas. Y se ha recuperado la población porque encontramos otra cosa que quemar: combustibles fósiles. Tenemos que crear un sistema energético sostenible que podamos permitirnos y que podamos construir. Dentro de 30 años tendremos un sistema que podrá abastecernos a todos prácticamente para siempre. Podremos dejar de preocuparnos por lo que vendrá después. Podremos abastecer a nuestros nietos y a los nietos de nuestros nietos.

Jun

7

El fascinante “universo” cuántico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Las leyes que gobiernan el mundo físico tienen dos características importantes: muchas leyes de la naturaleza permanecen inalterables, no se alteran cuando cambia la escala, pero hay otros fenómenos, tales como una vela encendida o las gotas de agua, que no cambian del mismo modo. La implicación final es que el mundo de los objetos muy pequeños será completamente diferente del mundo ordinario.

Ahora tendríamos que hablar algo de la mecánica cuántica y, en ese ámbito, las reglas de la mecánica cuántica funcionan tan bien que resultaría realmente difícil refutarlas. Acordaos de los trucos ingeniosos descubiertos por Werner Hesinberg, Paul Dirac, o, Schrödinger que vinieron a mejorar y completar las reglas generales. Sin embargo, algunos de aquellos pioneros (Einstein y el mismo Schrödinger), sin embargo, presentaron serias objeciones a dicha interpretación de la naturaleza de lo muy pequeño.

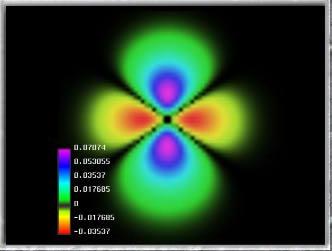

Esta cosita tan pequeñita, el electrón, es inversamente proporcional en importancia para que el mundo, la Naturaleza, y, nuestro Universo sea como es. Se ha conseguido la foto de un electrón. Poder filmar y fotografiar un electrón no es fácil por dos razones: primero, gira alrededor del núcleo atómico cada 0,000000000000000140 segundos , y, porque para fotografiar un electrón es necesario bombardearlo con partículas de luz (y cualquier que haya intentado sacarle una foto a un electrón sabe que hay que hacerlo sin flash). La imagen de la izquierda es el resultado.

El electrón fue descubierto en 1.897 por el físico británico Joseph John Thomson (1.856 – 1940). El problema de la estructura (si la hay) del electrón no está resuelto. Si el electrón se considera como una carga puntual, su auto-energía es infinita y surgen dificultades en la ecuación conocida como de Lorentz–Dirac.

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de solamente 1/1.836 de la del núcleo más ligero, el del hidrógeno que está formado por un solo protón. La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

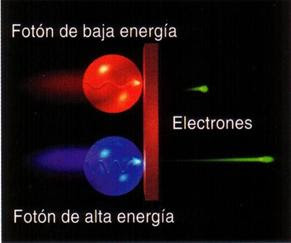

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, pero esto lo veremos más adelante.

Onda y partícula

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿Qué significan realmente estas ecuaciones?, ¿Qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero para los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

![]()

La notable capacidad de un electrón de existir en dos lugares al mismo tiempo ha sido controlada en el material electrónico más comun el – silicio – por primera vez, siendo este un gran avance para la electrónica moderna y tiene un potencial enorme para el futuro y para la creación de la computadora cuántica.

Imagen: El movimiento de los electrones en el silicio. El electrón gira alrededor de una átomo de fósforo embebido en la estructura cristalina del silicio, que se muestra en plata. La distribución de densidad electrónica no perturbado, a partir de la ecuaciones de la mecánica cuántica del movimiento se muestra en amarillo. Un pulso de láser de electrones puede modificar el estado de manera que tiene la distribución de la densidad se muestra en verde. Nuestro pulso láser en primer lugar, que llegan desde la izquierda, pone el electrón en una superposición de ambos estados, que podemos controlar con un segundo impulso, también desde la izquierda, para dar un pulso que se detecte que, saliendo a la derecha. Las características de este “eco” del pulso nos hablan de la superposición que hemos hecho.

Cuando podamos dominar el “universo” de lo muy pequeño… ¡Nuestro Universo será otro para nosotros!

Sus leyes son distintas a las del mundo cotidiano que conocemos y en el que vivimos

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Sí, la música influye en el cerebro

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Aunque la semilla la puso Planck en 1900, fue a partir de 1930 cuando la mecánica cuántica se aplicó con mucho éxito a problemas relacionados con núcleos atómicos, moléculas y materia en estado sólido. La mecánica cuántica hizo posible comprender un extenso conjunto de datos, de otra manera enigmáticos. Sus predicciones han sido de una exactitud notable. Ejemplo de ésto último es la increíble precisión de diecisiete cifras significativas del momento magnético del electrón calculadas por la EDC (Electrodinámica Cuántica) comparadas con el experimento.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

Jun

7

¡Nuestro “Sentido Común”! Que a veces nos engaña

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

No es solo que creyeran que la Tierra era el centro del Sistema solar, en la Edad Media creían que la Tierra era plana

¡Nuestros predecesores! Para ellos, era absolutamente evidente que la Tierra fuera estable y que estaba inmóvil. Éramos el centro del Universo. La ciencia occidental moderna parte de la negación de este axioma derivado del sentido común. Tal negación, origen y prototipo de las mayores paradojas de la ciencia, constituiría nuestra invitación a un mundo invisible e infinito. Llegó un día en que el hombre, se dio cuenta de la desnudez de sus sentidos. El Sentido común, pilar de la vida cotidiana, ya no servía para gobernar el mundo. En el momento en que el conocimiento “científico”, sofisticado, dio lugar a verdades incuestionables, las cosas dejaron de ser lo que parecían.

Las cosmologías antiguas utilizaban mitos pintorescos y convincentes para adornar los veredictos del sentido común y para describir los movimientos de los cuerpos celestes. En los muros de las tumbas de los faraones egipcios del valle de los Reyes encontramos vistosas representaciones del dios del aire sosteniendo la cúpula celeste por encima de la tierra.

Asimismo, observamos que el dios del sol, Ra, conduce su barca cada día por el cielo y que, cada noche, en otra barca que surca las aguas por debajo de la tierra, retorna al punto de partida de su viaje diurno, que vuelve a iniciar. Como hemos visto, esta visión mítica no impidió que los egipcios elaboraran el más preciso de los calendarios solares, que fue utilizado durante miles de años. Para los egipcios, tales mitos tenían sentido, no contradecían lo que veían cada día y cada noche con sus ojos.

Con el tiempo, todo aquello cambió, y, la mente humana evolucionó. ¿Por qué se tomó Nicolás Copérnico tantas molestias para desplazar un sistema que era sostenido con firmeza por la experiencia cotidiana, la tradición y la autoridad? Cuánto más nos familiarizamos con la era de Copérnico, vemos con mayor claridad que los que no se dejaban convencer por él simplemente demostraban sensatez. Las pruebas de que disponían no exigían una revisión del sistema. Habrían de pasar varias décadas para que los astrónomos y matemáticos reunieran datos nuevos y hallaran nuevos instrumentos, y al menos un siglo para que los legos se convencieran de lo que era contrario al sentido común. Lo cierto es que, pese a todas las modificaciones ideadas por astrónomos y filósofos, el esquema antiguo no incluía todos los datos conocidos. Pero tampoco lo hizo la simplificación de Copérnico.

Las constelaciones cuyos nombres antiguos han llegado hasta nuestros días

Parece que no era la fuerza de los hechos sino una preocupación estética y metafísica lo que empujaba a Copérnico. Se le ocurrió que un sistema diferente sería mucho más hermoso. Su mente inquieta y su atrevida imaginación hicieron el resto. Como astrónomo, Copérnico no era más que un aficionado. No se ganaba la vida con la Astronomía ni con ninguna aplicación de esta ciencia. Al menos desde el punto de vista actual, era extraordinariamente polifacético, lo que le sitúa en la línea central del alto Renacimiento. Nació cuando Leonardo da Vinci se encontraba en plena actividad y fue contemporáneo de Miguel Ángel.

Copérnico se daba cuenta de que su sistema parecía transgredir el sentido común. Por esa misma razón, sus amigos habían tenido que “instarlo e incluso apremiarlo hasta el fastidio” para que publicara la obra. “Insistían en que, si bien era posible que al principio mi teoría sobre el movimiento de la Tierra pareciera extraña, resultaría admirable y aceptable una vez que la publicación de mis comentarios aclaratorios disipara las brumas de la paradoja”.

Con todo esto, sólo quiero dejar una pequeña muestra de la dificultad con la que hemos ido avanzando en el camino de la Ciencia. No siempre ha sido un camino de rosas el poder enseñar al mundo la verdadera faz de la Naturaleza, todo vez que, el mundo, la que veía era otra muy distinta y, sus sentidos, se negaban a admitir que las cosas pudieran ser diferentes a como ellos la podían ver.

Galileo por Leoni Alguna de sus Obras

Galileo que era un científico de vocación, escribió un libro que se trataba de “Dos Ciencias Nuevas”, una que se ocupaba de la mecánica y otra de la resistencia de los materiales. Como era costumbre en la época, también ese libro fue escrito en italiano y adoptó la forma de diálogo sostenido entre los personajes Salvati, Sagredo y Simplicio. Dado que la Inquisición había prohibido todos sus libros, la obra hubo de ser sacada furtivamente del país para que la publicaran los Elzevir en Leyden. Este fue el último libro de Galileo y en él ponía los cimientos sobre los cuales Huygens y Newton construirían la ciencia de la dinámica y, finalmente, una teoría de la gravitación universal.

Leeuwenhoek, primer cazados de microbios

El microscopio y el telescopio fueron ambos productos de la misma era, pero mientras que Copérnico y Galileo se han convertido en héroes populares, en los profetas de la modernidad, Hooke y Leeuwenhoek, sus equivalentes en el mundo microscópico, han quedado relegados al panteón de las ciencias especializadas. Copérnico y Galileo desempeñaron importantes papeles en la tan conocida batalla entre “ciencia” y “religión”; no sucedió lo mismo con Hooke y Leeuwenhoek.

Los astrónomos de todo el planeta conmemoraron el cuarto centenario del reconocimiento oficial por parte de las autoridades de la República de Venecia del primer telescopio, un invento del científico italiano Galileo Galilei (1564-1642) que cambió para siempre el rumbo de la Astronomía.

“Zacharias Janssen, también conocido como Zacharias Jansen o Sacharias Jansen (1583-16381), fue un fabricante de lentes neerlandés. A veces también es considerado como el inventor del primer microscopio. Sin embargo, el origen del microscopio, al igual que el origen del telescopio, sigue siendo una cuestión controvertida.”

En realidad no se sabe quién inventó el microscopio. El principal candidato es Zacharias Jansen, humilde fabricante de anteojos de Middelburg. Si sabemos que el microscopio como las gafas y el telescopio, se usaban mucho antes de que se comprendieran los principios de la óptica, y probablemente su invención fue tan accidental como la del telescopio. No podía haber sido inventado por alguien que quisiera echar una mirada al mundo microscópico nunca imaginado hasta entonces.

Poco a poco se fueron mejorando hasta los que hoy captan galaxias situadas a miles de millones de años luz

Aunque actualmente se finaliza la construcción del último y más sofisticados, el Telescopio James West, lo cierto es que los muchos que actualmente están en uso han dado un rendimiento asombroso al mostrarnos un Universo desconocido que, sin ellos, nunca hubiera podido llegar a nosotros.

Poco después de que fueran fabricados los primeros telescopios, la gente los utilizaba para ver ampliados objetos cercanos. En 1614, Galileo le decía a un visitante: “Con este tubo he visto moscas que parecían tan grandes como corderos, y he comprobado que están cubiertas de pelo y tienen unas uñas muy afiladas mediante las cuales se sostienen y andan sobre el cristal, aunque estén patas arriba, insertando la punta de las uñas en los poros del cristal”.

El aparato llamó la atención del ejército para tener más localizado al enemigo lejano. Más tarde, a Galileo se le ocurrió apuntar su telescopio hacia el cielo, y, ya nunca lo apartó de él. Con aquel simple movimiento, él, cambiaría el mundo y, la Tierra, entró a formar parte de un Sistema mayor que ahora llamamos Universo.

Claro que, lo mismo que se descubrió el mundo de lo muy grande, y, paralelamente, también se descubriría el mundo de lo muy pequeño.

Al igual que el Telescopio había unido la Tierra y los cuerpos celestes más distantes en un solo esquema de pensamiento, las imágenes del microscopio revelaban un mundo minúsculo que se asemejaba de modo sorprendente al que se veía diariamente a gran escala.

En Historias Insectorum Generalis, Jan Swammerdam demostraba que los insectos, como los animales “superiores” poseían una intrincada anatomía y no se reproducían por generación espontánea. En el microscopio vio que los insectos se desarrollaban igual que el hombre, por epigénesis, o desarrollo gradual de un órgano después de otro. Con todo, sobrevivió la creencia en otras formas de generación espontánea, hasta que, en el siglo XIX, Luis Pasteur realizó sus brillantes experimentos.

Bacterias e insectos

El microscopio abrió las puertas de oscuros continentes en los que nunca se había entrada con anterioridad y que en muchos sentidos eran fáciles de explorar. Las grandes travesías marítimas habían exigido grandes inversiones, en genio organizador, capacidad de liderazgo y el de carisma de personajes como Colón, Magallanes o Vasco de Gama. La exploración astronómica exigía coordinación de las exploraciones realizadas en distintos lugares y con medios cada vez más costosos. Pero un hombre sólo, situado en cualquier parte con un microscopio, podía aventurarse por vez primera por vericuetos a los que no habían llegado los expertos navegantes o los valerosos pilotos.

Antoni van Leeuwenhoek fue con su microscopio el primer promotor de esta nueva ciencia de la exploración de otros mundos que resultaron estar en este. Sería bonito relatar aquí la historia del personaje pero, no tenemos el espacio necesario para ello.

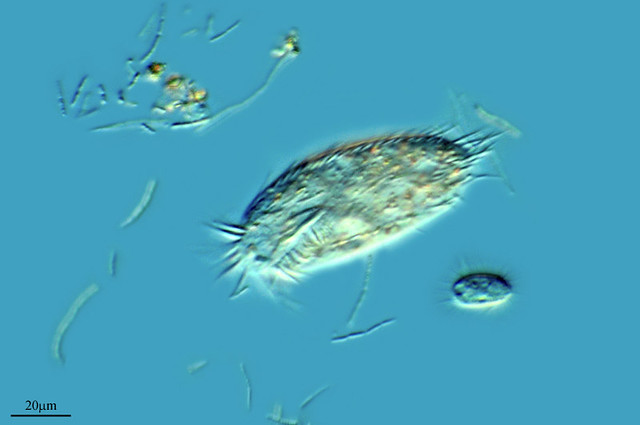

Os contaré que, en una ocasión, disponiendo de un microscópico, comenzó a buscar algo que hace con él. En septiembre de 1674, por pura curiosidad, llenó un frasco de cristal de un agua turbia y verdosa, que la gente de campo llamaba “rocío de miel”, procedente de un lago pantanoso situado a tres kilómetros de Delft, y bajo la mente de aumento descubrió “muchísimos animáculos diminutos”. A continuación dirigió su microscopio hacia una gota de agua de pimienta, infusión a base de pimienta negra utilizada en sus observaciones:

“Entonces vi con claridad que se trataba de pequeñas anguilas o lombrices apiñadas y culebreando, igual que si viera en un charco lleno de pequeñas anguilas y agua, todas retorciéndose por encima de otras, y parecía que toda el agua estaba vivía y llena de estos múltiples “seres”. Para mí, ésta fue, entre todas las maravillas que he descubierto en la naturaleza, la más maravillosa de todas; y he de decir, en lo que a mí concierne, que no se ha presentado ante mis ojos ninguna visión más agradable que esos miles de criaturas vivientes, todas vivas en un diminuta gota de agua, moviéndose unas junto a otras, y cada una de ellas con su propio movimiento…”

Escherichia coli vive en los intestinos de las personas y de los animales sanos. La mayoría de las variedades de Escherichia coli son inofensivas.

Borrelia burgdorferi

Borrelia burgdorferi una especie de bacteria de la clase Spirochaetes y del género Borrelia. Es el agente causante de la enfermedad de Lyme.

Cyanobacterium

“Las cianobacterias (Cyanobacteria, gr. κυανός kyanós, “azul”), es una división del dominio Bacteria que comprende las bacterias capaces de realizar fotosíntesis oxigénica. Son los únicos procariontes que llevan a cabo ese tipo de fotosíntesis, por ello también se les llama oxifotobacterias.”

Anabaena sp. (cyanobacterium) and Netrium and Zygnema sp. (green algae)

Una vida tan pequeña que ni la podemos ver. Zygnematales, también llamado Conjugales, es un orden de algas verdes, que comprende varios cientos de especies en géneros tales como los bien conocidos Zygnema y Spirogyra. … «Nuclear DNA content estimates in green algal lineages: chlorophyta and streptophyta»

Holospora undulata

The Holosporaceae are a family of bacteria. The member Holospora is an intracellular parasite found in the unicellular protozoa Paramecium.

Chromatium

“Chromatium es un género de bacterias Gram-negativas encontradas en agua. Metabólicamente se clasifica como bacteria púrpura del azufre (o roja) con capacidad para la fotosíntesis anoxigénica.”

Achromatium

“No se conoce bacteria más grande que ella y es gigante entre las minúsculas, Achromatium, literalmente “que no tiene color”, aunque no lo tenga, es la bacteria más grande de nuestro Planeta, tanto que con diez mil de mediano tamaño se podría rellenar el cuerpo de esta enorme desconocida, que aunque fue descubierta ya hace muchos años en un estanque de agua dulce en Alemania por Schewiakoff (1892) y aunque por sus características tan particulares ha sido objeto de numerosas investigaciones, en cada intento de averiguar algo sobre su vida, surgen nuevas cuestiones para indagar cada vez más interesantes.”

Tras descubrir el mundo de las bacterias, Leeuwenhoek prosiguió la tarea dignificando a estos individuos. Contradiciendo los dogmas aristotélicos relativos a los “animales inferiores”, declaró que cada uno de estos animáculos disponía de la dotación completa de órganos corporales necesarios para el tipo de vida que llevaba.

Con todo este pequeño recorrido, en el que he tomado algunos ejemplos al azar, sólo he querido significar que, la Ciencia, a lo largo de la historia de la Humanidad, ha ido tomando diversos caminos y, unas veces debido a mentes preclaras que tenían el don de “ver” lo que otros no podían, y, otras veces, por hechos del destino y la casualidad o el azar, el hombre, ha podido ir avanzando y conociendo el mundo en el que le ha tocado vivir y, al decir mundo, me refiero no sólo a la Tierra, sino que, me estoy refiriendo al Universo, tanto de lo grande como de lo pequeño. Ahora sabemos que, si nosotros estamos aquí, tal presencia es posible gracias a la existencia de esos minúsculos animáculos que descubriera Leeuwenhoek que, en sus diferentes dominios, hacen lo necesario para que nosotros podamos vivir en simbiosis con ellos y, además, son los verdaderos responsables del clima del planeta que nos permite llevar una vida tranquila gracias a la atmósfera que dichos bichitos fabrican para nosotros.

¡La Ciencia! Son tantas cosas.

emilio silvera

Jun

6

El Universo siempre sorprendente

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Noticias NASA

Imagen del cúmulo Westerlund 2, publicada con motivo del 25 aniversario del Hubble. Crédito: NASA, ESA, Hubble Heritage Team (STScI/AURA), A. Nota (ESA/STScI), y el Equipo Científico Westerlund 2.

NASA y ESA celebraron el aniversario número 25 del Telescopio Espacial Hubble presentando esta imagen de fuegos artificiales naturales; un cúmulo gigante de aproximadamente 3.000 estrellas llamado Westerlund 2. El cúmulo se encuentra dentro de un vibrante semillero estelar conocido como Gum 29, ubicado a 20.000 años-luz de distancia en la constelación de Carina (la quilla).

Westerlund 2 es difícil de observar debido a que está rodeado por polvo, pero los instrumentos del telescopio Hubble son capaces de ver a través de este velo de polvo en infrarrojo cercano, dando a los astrónomos una vista clara del cúmulo. La visión nítida de Hubble nos muestra la densa concentración de estrellas en el cúmulo central, que abarca unos 10 años-luz de diámetro.

Chorros supersónicos liberados por estrellas jóvenes. Estas son las imágenes del comportamiento dinámico de los chorros estelares, grandes flujos de gas y partículas arrojadas desde los polos de las estrellas recién nacidas.

Los inimitables fuegos “artificiales” que se producen en la Naturaleza

Este cúmulo estelar relativamente joven de 2 millones de años, contiene algunas de las estrellas más calientes, brillantes y masivas de nuestra galaxia. Las estrellas más grandes están liberando un torrente de luz ultravioleta y vientos huracanados que dan forma a la nube de hidrógeno gaseoso presente en la región. Esto crea un fantástico paisaje espacial de pilares, crestas y valles.

emilio silvera

Jun

5

Si el Sol desaparece… la Vida se iría con él

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

¿Y si el Sol desapareciera de repente?

Esta es la cascada de consecuencias para nuestro planeta y cómo se sucederían en el tiempo

Reportaje de prensa

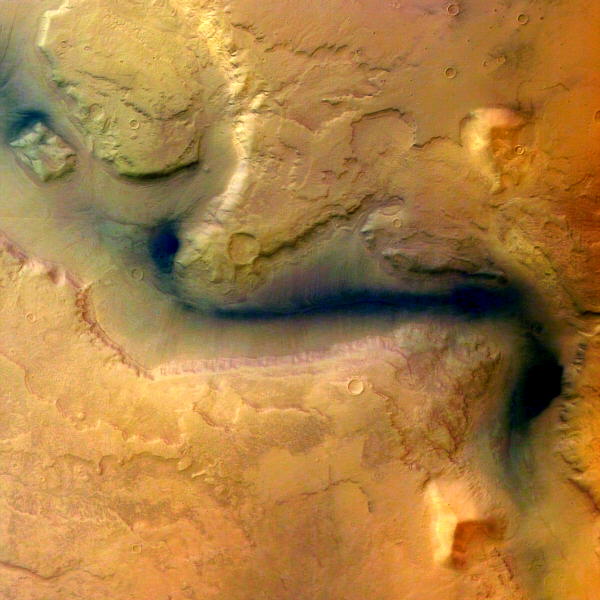

No hace falta ser un astrónomo experimentado para saber que dependemos completamente del Sol. Nuestra estrella particular, en efecto, ocupa el centro de nuestro sistema planetario, mantiene los mundos en su sitio e irradia la energía necesaria para que aquí, en la Tierra, sea posible la vida. Gracias al Sol tenemos luz, calor, atmósfera, fotosíntesis, océanos… Sabemos también, sin embargo, que nada, ni siquiera el Sol, dura eternamente. Durará mucho tiempo, sí, aunque no para siempre. ¿Pero qué sucedería si un buen día el Sol desapareciera de repente? ¿Cuáles serían las consecuencias para nosotros y cómo se sucederían en el tiempo?

Un gráfico recién publicado por la web Solar Centre ha recopilado mucha de la información disponible para resolver la cuestión. Y el panorama, como era de suponer, no resulta nada esperanzador…

Se acabó la gravedad

El mundo sería muy distinto si de pronto desapareciera la fuerza de Gravedad que genera el Sol

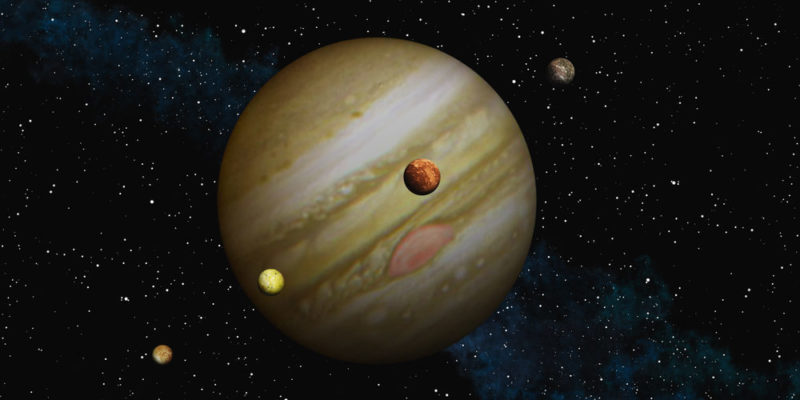

En una secuencia cronológica, lo primero que desaparecería con el Sol es su atracción gravitatoria. Todos los planetas están “ligados” gravitatoriamente al Sol, y su súbita desaparición los dejaría sin un centro alrededor del que orbitar. De modo que empezarían a viajar, más o menos, en línea recta, hasta que se toparan con otro cuerpo lo suficientemente grande como para atraerlos. La estrella más cercana, Alpha Centauri, está a 4,2 años luz de distancia, así que esta situación de “vagabundeo espacial”, suponiendo que algún mundo se dirigiera hacia allí, duraría muchos miles de años.

Por supuesto, al perder su orden establecido es muy probable que algunos planetas chocaran entre sí, o que muchas lunas acabaran precipitándose sobre los mundos a los que orbitan. Júpiter y Saturno, los dos gigantes del Sistema Solar, lograrían quizá atraer a algunos de los planetas que nos rodean, para devorarlos sin contemplaciones.

Oscuridad eterna si el Sol desapareciera

Bueno, no sólo oscuridad eterna…. ¡Sería mucho más!

Aquí, en la Tierra, tardaríamos 8 minutos en darnos cuenta de que el Sol ya no está en su sitio. Ese es, en efecto, el tiempo que un rayo de sol tarda en recorrer, a la velocidad de la luz, los 150 millones de km. que nos separan del astro rey. Pasado ese tiempo, nos veríamos sumidos de repente en una total oscuridad. Y sería para siempre. Ni siquiera seríamos capaces de volver a contemplar la Luna, ya que su brillo no es más que un reflejo de la luz que recibe del Sol. Sí que veríamos las estrellas, que disponen de sus propias fuentes de luz, pero nuestras vidas se convertirían en una larga e interminable noche. Sin luz, además, las plantas ya no podrían seguir haciendo la fotosíntesis, con lo que la aportación de oxígeno a la atmósfera se interrumpiría casi por completo. Las reservas planetarias del gas que nos permite respirar apenas si durarían un par de semanas.

Se acabó el calor

Pero la oscuridad no sería lo más grave. De hecho, la temperatura media de la Tierra, que actualmente es de 29,6 grados, descendería rápidamente hasta los -123 grados en apenas dos meses. Cuatro meses después de la desaparición del Sol, la temperatura media de nuestro planeta sería de -198 grados, casi doscientas veces más fría que el interior de una nevera doméstica. En estas condiciones, la inmensa mayoría de la vida desaparecería de nuestro mundo. Solo quedarían algunos micro-organsmos extremófilos que viven en medio de las rocas de la corteza terrestre, a varios km. de profundidad, y que no dependen de la luz solar. Los animales subterráneos y los carroñeros lograrían sobrevivir, quizá, durante un breve tiempo adicional, alimentándose de los cadáveres del resto. Pero terminarían desapareciendo en pocas semanas, junto a los demás. Sorprendentemente, los árboles más grandes lograrían, quizá, sobrevivir más tiempo, incluso durante algunas décadas, a pesar del frío y sin fotosíntesis.

No creo que la idea de los submarinos sea ningún remedio a la catástrofe

Para los humanos, la única opción sería embarcar en submarinos y sumergirse con ellos hasta lo más profundo de los océanos, para aprovechar el calor interno del planeta a medida que surge a través de las fuentes hidrotermales. Con los océanos congelados, ese sería, probablemente, uno de los últimos reductos para la vida terrestre. Otra solución temporal sería la de construir módulos habitables totalmente aislados de las condiciones externas, aunque habría muy poco tiempo para hacerlo (menos de un mes desde el “apagón”) y, de conseguirlo, solo se salvarían unos pocos y durante un tiempo limitado.

Al final, unos pocos cientos de años tras la desaparición del Sol, incluso las profundidades oceánicas se congelarían. La atmósfera se colapsará y la gélida superficie de lo que fue un mundo lleno de vida quedaría indefensa del bombardeo radiactivo de los rayos cósmicos.

Un panorama, pues totalmente desolador. Por fortuna, el Sol es una estrella de mediana edad, que lleva brillando unos 5.000 millones de años y todo parece indicar que lo seguirá haciendo durante otros 5.000 millones de años más. Aunque ningún ser humano llegará a verlo. Dentro de “solo” unos 1.000 millones de años, en efecto, el Sol se habrá vuelto tan caliente que hará hervir los océanos, que se evaporarán y harán de la Tierra un mundo inhabitable. Ojalá que para entonces ya estemos instalados en otros lugares, muy lejos de aquí…

Totales: 74.187.946

Totales: 74.187.946 Conectados: 47

Conectados: 47