Abr

2

La Física de Partículas al Servicio de la Salud

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (0)

Comments (0)

Transferencias tecnológicas del CERN a la Biomedicina

Partículas y mucho más

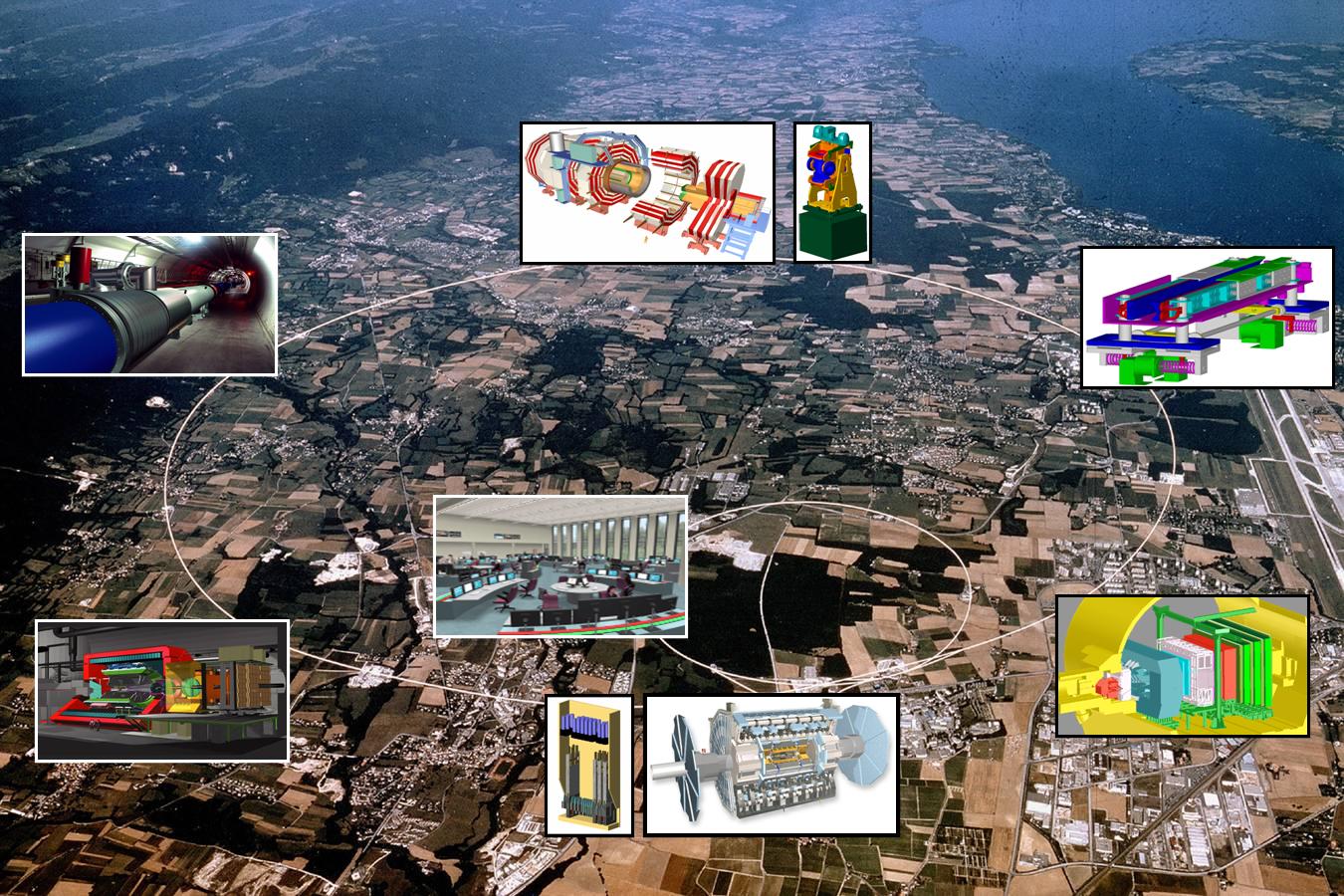

Seguramente la mayoría de los lectores de la Revista Española de Física han oído más de una vez hablar del CERN. Fundado en 1954, constituye el mayor laboratorio de física de partículas del mundo, con veinte países miembros y un personal de unas 3.000 personas entre físicos, ingenieros y personal técnico y administrativo de todo tipo.

“El concepto de ruptura espontánea de simetría es uno de los ingredientes fundamentales del SM electrodébil, dando lugar a excitaciones de Goldstone que pueden ser asociadas a los términos de masa de los bosones gauge.”

Seguramente están también al tanto de los grandes experimentos que se están preparando en este centro como el Large Hadron Collider (LHC), situado en un túnel circular de 27 km de longitud, destinado a elucidar el origen de la llamada ruptura de la simetría electro-débil y en última instancia el origen de las masas de las partículas elementales (no de la masa del protón o del neutrón como erróneamente se dice a veces en los medios de comunicación), o del proyecto CERN Neutrino Gran Sasso (CNGS), que consiste en enviar un haz de neutrinos de alta energía desde el CERN al laboratorio subterráneo italiano del Gran Sasso que se encuentra a 730 km, para estudiar las oscilaciones de estas huidizas partículas.

También es muy probable que muchos lectores asocien de manera natural la palabra acelerador de partículas a los instrumentos que utilizan los físicos modernos para estudiar y comprender mejor la estructura y el comportamiento de la materia a pequeñas escalas. Sin embargo, de los 17.000 aceleradores de partículas que se estima existen en la actualidad en todo el mundo, aproximadamente la mitad de ellos se usan en medicina y sólo una parte muy pequeña se usan para investigación fundamental. Por este y otros motivos que se discutirán más adelante, en este número especial de la Revista Española de Física dedicado a la física y las ciencias de la vida, ha parecido conveniente incluir un artículo en el que, al menos brevemente, se describieran algunas de las transferencias tecnológicas (spinoffs) importantes que la actividad del CERN aporta a dichas ciencias.

Mucho de lo que aquí se descubre, se aplica a nuestra Salud

Es bastante razonable que, como ocurre con las ciencias del espacio, mucha gente se pregunte cuál es la utilidad social de la física de partículas más allá de la adquisición de conocimientos fundamentales de la naturaleza. Sin embargo, es preciso señalar que los aceleradores y detectores de partículas del CERN y otros laboratorios similares requieren el uso, y muchas veces el desarrollo, de tecnologías de punta que obligan a una estrecha colaboración con la industria que redunda en beneficio de ambas partes. Las transferencias tecnológicas que se producen en este proceso se incorporan inmediatamente a nuestra vida diaria en áreas tales como la electrónica, procesamiento industrial y médico de imágenes, manejo y usos de la radiación , metrología, nuevos materiales, tecnologías de la computación y la información, tratamiento del cáncer, etc. En este artículo se pondrá el énfasis en aquellas actividades del CERN que han redundado de una forma más clara en beneficio de las ciencias biomédicas.

PET/TC o más allá de los rayos X

En el ámbito de la medicina los aceleradores de partículas se utilizan con dos finalidades; una para la formación de imágenes con propósitos diagnósticos y otra, para terapia, principalmente oncológica. Desde el descubrimiento de los rayos X por Röntgen en 1895, este tipo de radiación electromagnética ha proporcionado una información de valor incalculable y aún sigue proporcionándola. Sin embargo, mucho más recientemente, se han desarrollado otras técnicas complementarias de diagnóstico basadas en los llamados radiofármacos. Estas sustancias radiactivas presentan idealmente la propiedad de poder ser inyectadas en el organismo humano de forma segura y de fijarse exclusivamente a determinados tejidos.

Posteriormente, a medida que van desintegrándose, emiten ciertas partículas que pueden ser detectadas y analizadas produciendo de esta forma imágenes estáticas o incluso dinámicas de los órganos en los que se depositaron los radiofármacos y, en definitiva, proporcionando información no solamente sobre la morfología de aquellos, sino también, en muchos casos, sobre su función y metabolismo.Los radiofármacos se producen utilizando haces de protones de alta intensidad y, como tienen una vida media muy baja, deben utilizarse cerca de donde se han creado. Se calcula que unos 20 millones de personas son diagnosticadas cada año mediante el uso de este tipo de sustancias.

Son técnicas no invasivas que dejan al descubierto lo que interesa ver y eliminar.

Una de las técnicas de este tipo más utilizada en la actualidad es la Positron Emission Tomography (PET). En su aplicación se utiliza normalmente un ciclotrón para irradiar alguna sustancia que se convierte en radiactiva por desintegración beta positiva (emisora de positrones). Esta sustancia se une por ejemplo a la glucosa y se inyecta al paciente. Los positrones producidos se aniquilan con los electrones circundantes dando lugar a dos fotones de energía muy bien definida, emitidos en direcciones opuestas. Estos fotones interaccionan con un material escintilador dando lugar a la emisión de otros fotones que pueden ser detectados por fotomultiplicadores o fotodiodos para formar la imagen de los tejidos que se pretenden estudiar en función de la distribución de la glucosa radiactiva.

Por ejemplo, en el caso del diagnóstico del cáncer las células cancerosas suelen consumir más glucosa que las células sanas debido a su mayor vascularización y a su mayor actividad metabólica y reproductiva, produciendo por tanto una mayor emisión de fotones. Por el contrario, las zonas donde el tejido presente mayor número de células muertas brillarán menos debido a la menor concentración de glucosa radioactiva, lo cual puede ser muy útil para el diagnóstico de infartos y otras lesiones.

Tecnologías que llegan más allá

De acuerdo con David Townsend, uno de los pioneros en el desarrollo de la tecnología PET, aunque ésta no fue inventada en el CERN, una cantidad esencial e inicial de trabajo desarrollado en el CERN a partir de 1977 contribuyó de forma significativa al desarrollo del PET 3D. La tecnología PET alcanza su grado más alto de utilidad diagnóstica cuando se combina con la Computed Tomography (CT). La CT es un método de formación de imágenes tridimensionales a partir del procesamiento digital de un gran número de imágenes bidimensionales de rayos X. Inicialmente, las diferentes imágenes se obtenían alrededor de un solo eje de rotación y de ahí su nombre original de Computed Axial Tomography (CAT).

La técnica combinada PET/CT es uno de los desarrollos más excitantes de la medicina nuclear y la radiología modernas. Las reconstrucciones de imágenes CT permiten el diagnóstico precoz de tumores basándose en sus características morfológicas, mientras que la tecnología PET es capaz de diferenciar con grane eficiencia los tejidos malignos de los benignos. La fusión PET/CT permite ahora integrar las imágenes morfológica y fisiológica en una única imagen. El prototipo del scanner ART, el Partial Ring Tomograph (PRT), fue desarrollado en el CERN en 1980 y 1990 por David Townsend, Martín Wensveen y Henri Tochon-Danguy, y evaluado clínicamente en el departamento de medicina nuclear del Hospital Cantonal de Ginebra. ART puede considerarse como el precursor de la parte PET del moderno scanner PET/CT, que ha producido un impacto extraordinario en la tecnología de imágenes con fines médicos. Además, el CERN continua hoy en día contribuyendo a este campo fundamental de la medicina moderna mediante proyectos como Clear PET, Clear PEM, HPD PET etc.

Sin embargo, la importancia del CERN en el desarrollo de las tecnologías PET o CT, y en general de todo tipo de scanner, va mucho más allá. En efecto, todo este tipo de dispositivos se basa, de una forma u otra, en los detectores desarrollados a finales de los sesenta en el CERN por George Charpak. Su trabajo fue reconocido en 1992 con la concesión del Premio Nobel de Física por su invención y desarrollo de detectores de partículas, en particular de la cámara proporcional multihilos, que produjo una revolución en la técnica de exploración de las partes más íntimas de la materia. Los detectores desarrollados por Charpak se usan aún para todo tipo de investigaciones médicas y biológicas y podrían eventualmente sustituir completamente a las placas fotográficas en la radio-biología aplicada. La velocidad creciente con la que permiten registrar las imágenes en radio medicina conducen a una menor tiempo de exposición y a menores dosis de radiación indeseada recibida por los pacientes.

Hadron-terapia, o las partículas contra el cáncer

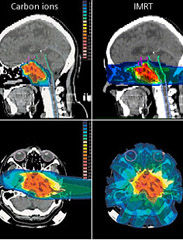

Como es bien sabido, una de las herramientas terapéuticas esenciales en el campo de la oncología es la radioterapia. Dicho tratamiento se aplica hoy en día aproximadamente a la mitad de los pacientes de cáncer. En cierto modo se puede considerar como una forma sutil de cirugía donde el bisturí es reemplazado por un haz colimado de partículas capaz de esterilizar las células malignas mediante la inactivación de su ADN, impidiendo así su reproducción. Tradicionalmente, la radioterapia se ha basado en el uso de rayos X (fotones), electrones y, más recientemente, hadrones, es decir, partículas capaces de interaccionar fuerte o nuclearmente, si bien no es ésta la propiedad más interesante de estas partículas para las aplicaciones radioterapeúticas. Los haces de rayos X y los electrones se obtienen normalmente a partir de aceleradores lineales como los del CERN, aunque mucho más pequeños, y se apuntan hacia los tumores con la energía, dirección y colimación apropiadas para optimizar su efecto destructivo sobre los mismos. Por su parte, los neutrones pierden energía en el interior del organismo de una forma diferente, lo cual les hace más indicados para el tratamiento de ciertos tipos especiales de tumores. Se obtienen a partir de las colisiones de protones, previamente acelerados en un ciclotrón, con núcleos de berilio. Este hecho hace que esta terapia sea bastante más cara que las anteriores, pero a cambio el ciclotrón puede ser usado también para la producción de radiofármacos.

Cintíficos del CERN aplican antimateria contra el Cáncer

El estudio de las posibilidades de utilización de haces de hadrones en la terapia del cáncer tuvo su origen en el trabajo seminal de R.R Wilson titulado Radiological Use of Fast Protons (Radiology 47, 1946). En dicho artículo se ponía de manifiesto que los protones, así como otras partículas cargadas pesadas, presentan la propiedad única de que al penetrar en el cuerpo humano depositan la mayor parte de su energía a una profundidad que depende de su energía inicial. Este hecho permite seleccionar cuidadosamente el área que se quiere irradiar, preservando de dicha radiación al tejido sano que pudiera encontrarse a menor profundidad. Además, como las partículas se detienen a una distancia de la superficie bien definida por la energía del haz, tampoco resultarían dañadas las células situadas detrás del blanco seleccionado.

En contraste, la energía depositada por los rayos X alcanza su máximo cerca de la superficie de entrada y decae exponencialmente hasta que abandona el cuerpo humano en el lado opuesto, haciendo por tanto muy difícil seleccionar la zona que quiere irradiarse sin dañar otras áreas de células sanas. El trabajo de Wilson de 1946 condujo a toda una nueva línea de investigación experimental, principalmente en el Lawrence Berkeley Laboratory, que ha dado lugar al desarrollo de una nueva clase de terapias antitumorales basadas en la irradiación con protones y más recientemente con iones de carbono. Estas técnicas han sido aplicadas en más de 40 centros de todo el mundo, y de ellas se han beneficiado hasta la fecha más de 50.000 pacientes. No obstante, continúan investigándose nuevas formas de intentar mejorar el ratio entre la energía depositada en las células tumorales y en el tejido sano.

Nuevas instalaciones que ayudan a la m3edicina

En la actualidad, el CERN se encuentra involucrado en diversos proyectos relacionados con la hadron-terapia. Por ejemplo, en el diseño de un acelerador de protones e iones de carbono dedicado exclusivamente a usos médicos conocido como Proton Ion Medical Machine Study (PIMMS). Otro proyecto interesante es la realización de las pruebas del Linear Booster ( LIBO), capaz de acelerar una haz de protones hasta 200 Mev (los hospitales habitualmente utilizan energías en torno a los 65 MeV) y que estaría especializado en el tratamiento de tumores profundos.

Finalmente, y situándonos en un plano de investigación a un nivel más básico, es interesante señalar que en octubre de 2006 se presentaron los primeros resultados de un experimento llevado a cabo en el CERN con potencial para futuras aplicaciones en la terapia del cáncer. Se trataba del Antiproton Cell Experiment (ACE), que constituye la primera investigación realizada hasta la fecha sobre efectos biológicos de los antiprotones. Los antiprotones se comportan como los protones cuando entran en el organismo, pero generan mucha más energía en el blanco seleccionado debido a du aniquilación con los protones existentes en los núcleos de los átomos de las células, y además depositan esta energía de una forma biológicamente más efectiva.

Se busca antimateria contra el Cáncer. Los resultados muestran que los antiprotones son cuatro veces más efectivos que los protones para destruir células vivas. (Foto: Especial CERN )

Evaluando la fracción de células supervivientes después de la irradiación con el haz de antiprotones, el experimento ACE ha encontrado que a eficiencia de éstos es unas cuatro veces mayor que la de los protones, mientras que el daño producido a las células situadas antes del blanco era básicamente el mismo. De acuerdo con Michael Holzscheiter, portavoz del experimento ACE, este hecho podría ser extremadamente importante para el tratamiento de casos de cáncer recurrente, donde este tipo de propiedad es vital. La tecnología desarrollada previamente en el CERN para la obtención de haces de antiprotones de buena calidad a la energía apropiada es esencial para este prometedor experimento, que difícilmente podría haberse realizado en ningún otro laboratorio. Éste es por tanto un magnífico ejemplo de cómo la investigación en física de partículas desarrollada en el CERN puede generar soluciones innovadores con excelentes beneficios médicos potenciales.

Los investigadores de ACE, en colaboración con otras instituciones de todo el mundo, están realizando en la actualidad nuevos tests para comprobar la eficacia de este método en el caso de tumores situados a mayor profundidad, y comparando sus resultados con los de otros métodos más convencionales como la irradiación mediante iones de carbono. Si todo sale como se espera, los beneficios clínicos de esta nueva técnica podrían empezar a producirse dentro de la próxima década.

Otro ejemplo importante de tecnología creada en el CERN con aplicaciones a la terapia del cáncer es el Neutron Driven Element Trasmuter. Se trata de un sistema de producción de radioisótopos específicos específicos a partir de un acelerador de protones cuyo desarrollo fue liderado por Carlo Rubbia, Premio Nobel de Física en 1984 por el descubrimiento de los bosones W y Z y ex director general del CERN. La idea es utilizar el haz de protones para producir neutrones los cuales provocan reacciones en un ambiente apropiado donde ciertos elementos son convertidos en los isótopos deseados.

Se utilizan neutrones e isótopos radiactivos

La diferencia principal entre este método, seguro y barato, y el método más tradicional de utilizar los neutrones provenientes de un reactor nuclear, es que no requiere el uso de material fisionable ni funciona críticamente, es decir las reacciones se detienen en el momento en el que el acelerador es apagado. Más aún, el método tiene la ventaja de que sólo se producen los isótopos requeridos, lo que redunda en una importante reducción de impacto ambiental. Normalmente, el blanco utilizado es plomo, elemento idóneo por presentar el menor ritmo de captura de neutrones. Los neutrones se producen por espalación a partir del haz de protones y permanecen en el interior del blanco de plomo, que está rodeado de un deflector de grafito, hasta que su espectro se suaviza suficientemente para cubrir un gran rango de energías que permiten su utilización para la transmutación de los elementos necesarios para la obtención de los isótopos deseados.

El Neutron Driven Element Trasmuter ha permitido, entre otras cosas, la producción de radioisótopos beta emisores como el 166Ho, 186 Re o el 188Re que son de gran importancia en braquiterapia. Dicha técnica, muy utilizada en el tratamiento de cánceres ginecológicos y en el de cáncer de próstata, es un tipo de radioterapia de proximidad donde la fuente radiactiva se sitúa dentro o muy cerca de los tejidos que requieren irradiación. Típicamente, la fuente radiactiva, de alta actividad y corta vida media, se encapsula en una semilla, filamento o tubo y se implanta en quirófano en la zona deseada. Las diferentes dosis requeridas en cada caso hacen que sea fundamental disponer del mayor muestrario posible de radioisótopos con la actividad y vida media apropiadas, lo cual convierte al Neutron Driven Element Trasmuter en una herramienta valiosísima para el futuro de este tipo de técnica terapéutica.

Información y computación sin fronteras

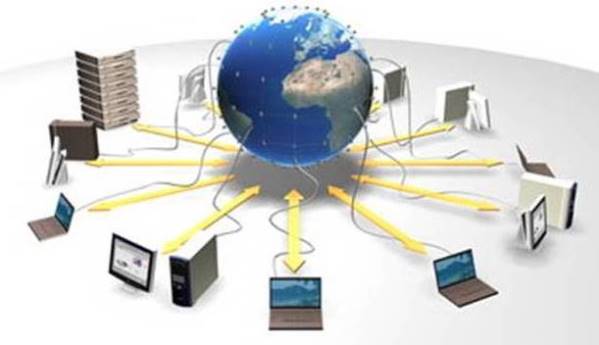

CERN, … where the web was born; éste es uno de los reclamos publicitarios que suelen utilizarse para hacer ver al público la importancia de los retornos tecnológicos que en este laboratorio tienen lugar. Y en efecto, fue a finales de los ochenta cuando Tim Berners-Lee desarrolló estándar de Hyper Text Transfer Protocol (HTTP) e implementó los primeros servidores web en el CERN. Su esfuerzo permitió la comunicación fácil y segura y el intercambio de todo tipo de información entre todos los ordenadores del mundo conectados a internet, dando lugar de esta forma a una de las revoluciones tecnológicas más importantes de las últimas décadas. Las repercusiones científicas, tecnológicas, culturales, comerciales y de ocio de la web son ya tan conocidas que apenas merecen comentario alguno.

El término Grid fue acuñado por Ian Foster and Carl Kesselman en su libro The Grid, Blueprint for new Computing Infraestructure (Morgan Kaufman, 1998), aunque las ideas básicas habían sido consideradas con anterioridad. No existe un acuerdo general sobre cual debería ser la definición precisa de las tecnologías Grid, pero hay un amplio concenso en que esta debería contener elementos tales como recursos compartidos, virtualización, abstracción del acceso a los recursos y estandarización. La filosofía Grid consistería, no sólo en compartir información entre diferentes usuarios, sino también recursos, como por ejemplo, procesadores, tiempo de CPU, unidades de almacenamiento, así como otros aparatos e instrumentos, de tal forma que eventualmente cada usuario tendría acceso virtual, por ejemplo, a la capacidad de cálculo de todos los demás usuarios de esa Grid. En los primeros tiempos de esta tecnología de la información se llegó a hablar de la Grid, refiriéndose a la posibilidad de existencia de una única World Wide Grid.

Todo surgió del CERN

Hasta el momento,, sin embargo, este concepto no es una realidad y más bien lo que se encuentra es que diferentes grupos de proyectos crean su propia Grid usando sus propias implementaciones, estándares y protocolos y dando acceso restringido solamente a una cierta comunidad de usuarios autorizados. Así, aunque se siguen realizando importantes esfuerzos en cuanto a la estandarización de los protocolos, no está claro cual será el camino que este tipo de tecnología seguirá en el futuro en lo que se refiere a la futura existencia de un única Grid.

En cualquier caso es importante resaltar que una vez más el CERN ha sido pionero en este tipo de tecnología. Los detectores que se están instalando (a estas alturas, todos instalados y en marcha) en el LHC (ATLAS, CMS, ALICE, LHCb, SUSY, etc.), son tan complejos, que han requerido cada uno de ellos el concurso de muchas instituciones de todo el mundo para su construcción, y lo seguirán requiriendo para su mantenimiento cuando el acelerador empiece a funcionar (ya está en marcha), y, como no, para el análisis de los datos que se obtengan. Para hacerse una idea de la dimensión y complejidad de estos análisis baste mencionar que el compact Muon Selenoid (CMS), una vez pasado su primer filtro, deberá almacenar información sobre el resultado de las colisiones producidas en su interior a un ritmo del orden de 100 a 200 MB por segundo durante un tiempo esperado de unos cien días por año. Resulta obvio que sólo una tecnología tipo Grid puede afrontar con posibilidades de éxito un reto semejante y de hecho el CERN ha inspirado varios proyectos Grid multinacionales por este motivo. Posiblemente, el más grande de ellos hasta la fecha sea el EGEE (Enablinbg Grids for E-Science), que conecta más de 150 paises y ofrece 20 000 CPUs y más de 10 Petabytes de memoria.

De manera análoga a como ocurrió con las tecnologías de la detección y aceleración, las tecnologías Grid tendrán, y de hecho ya empiezan a tener, un fuerte impacto en las ciencias de la vida y de la salud. En este sentido, uno de los campos obvios de aplicación es la bioinformática. Gracias a los espectaculares avances llevados a cabo en los últimos años en el campo de la biología molecular, se dispone hoy en día de cantidades crecientes de información genética de diferentes especies e individuos. Dicha información codificada en el ADN en forma de secuencia de tripletes o codones de ácidos nucleicos, que constituyen los genes que contienen la estructura primaria de las diferentes proteínas, ha sido y está siendo obtenida por centenares de grupos diferentes distribuidos por todo el mundo y debe almacenarse en gigantescas bases de datos de forma eficiente para su compartición, contrastación y análisis.

Ejemplos típicos serían la búsqueda de determinadas secuencias, comparaciones, búsqueda de determinadas mutaciones o alelos, etc. Resulta evidente que esta ingente labor puede verse enormemente beneficiada por el uso de tecnologías Grid. De hecho, la Bioinformática, y en particular sus aplicaciones biomédicas, han sido una parte importante del proyecto EGEE desde el comienzo del mismo.

Finalmente, y como última muestra de cómo puede revertir en la sociedad las tecnologías de la información y la computación provenientes de la física de partículas, es interesante mencionar el Proyecto Mammogrid y su continuación Mammogrid Plus. Liderado por el CERN, dicho proyecto de la UE utiliza la tecnología Grid para crear una base de datos de mamografías que pueda ser usada para investigar un gran conjunto de datos e imágenes que, aparte de otras aplicaciones sanitarias, sea útil para estudiar el potencial de esta tecnología para servir de soporte a la colaboración entre los profesionales de la salud de la UE.

Ciencia, Tecnología y Sociedad

A estas alturas debería haber quedado claro que los centros científicos de élite internacionales como el CERN, no sólo nos proporcionan un conocimiento más profundo de la naturaleza, sino que las tecnologías de punta que en ellos se desarrollan acaban permeando a la Sociedad y se incorporan a nuestras vidas cotidianas. El autor del artículo, Antonio Dobado, del Departamento de Física Teórica I de la Universidad Complutense de Madrid, ha pretendido ilustrar el hecho innegable de la conexión existente entre temas tan aparentemente dispares como el de la Física de Partículas y la Biomedicina, pero ejemplos semejantes podrían haberse encontrado en prácticamente cualquier área de la actividad humana.

La Sociedad no puede permanecer por más tiempo ajena a la Ciencia y a todo lo que trae consigo. Precisamente por eso la RSEF dedica un gran esfuerzo a la difícil tarea de convencer al público de la importancia de la Física como valor científico, cultural y social, como una forma rigurosa y profunda del acercamiento al conocimiento de la naturaleza, y a la vez como generadora de nuevas tecnologías. En este sentido, es una espléndida noticia la inminente creación de un nuevo Grupo especializado en el seno de la RSEF denominado Física Médica. Y, desde aquí, aprovechamos la oportunidad para darles la bienvenida y desearles el mayor éxito en sus futuras andaduras en la búsqueda de la verdad científica.

Fuente: Revista Española de FÍSICA.

Publicada por la RSEF con el Nº 3 Volumen 21 de 2007

La presente transcripción es de: Emilio Silvera

Miembro numerario de la RSEF y adscrito a los Grupos Especializados de Física Teórica y Astrofísica.

Abr

2

La maravilla de… ¡los cuantos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

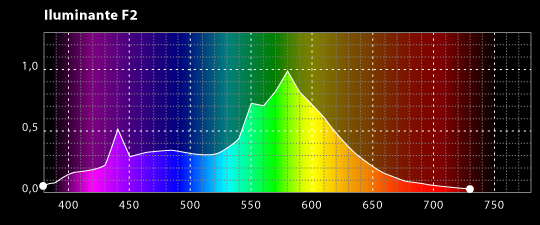

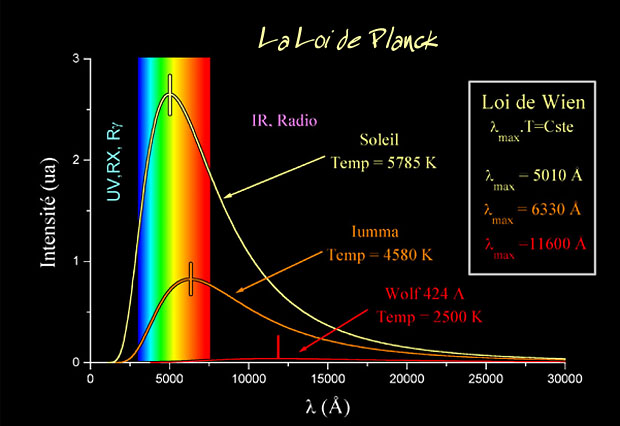

La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos. Planck escribió un artículo de ocho páginas y el resultado fue que cambió el mundo de la física y aquella páginas fueron la semilla de la futura ¡mecánica cuántica! que, algunos años más tardes, desarrollarían físicos como Einstein (Efecto fotoeléctrico), Heisenberg (Principio de Incertidumbre), Feynman, Bhor, Schrödinger, Dirac…

La expresión radiación se refiere a la emisión continua de energía de la superficie de todos los cuerpos. Los portadores de esta energía son las ondas electromagnéticas producidas por las vibraciones de las partículas cargadas que forman parte de los átomos y moléculas de la materia. La radiación electromagnética que se produce a causa del movimiento térmico de los átomos y moléculas de la sustancia se denomina radiación térmica o de temperatura.

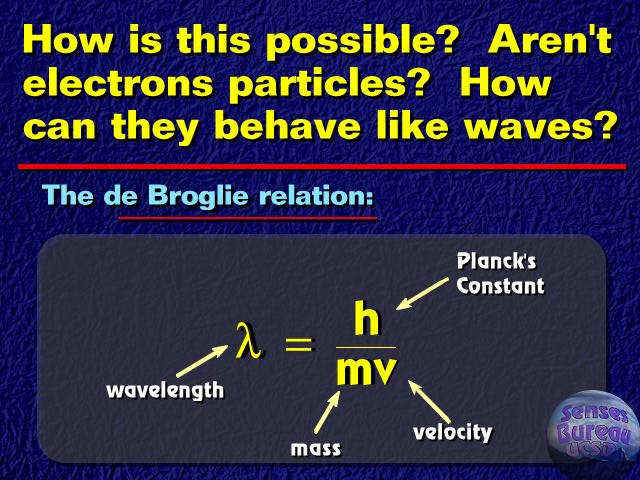

Ley de Planck para cuerpos a diferentes temperaturas.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía.

Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico o una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Acero al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = hv

Donde E es la energía del paquete, v es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck.

El príncipe francés Louis Victor de Broglie, dándole otra vuelta a la teoría, que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta dirección del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

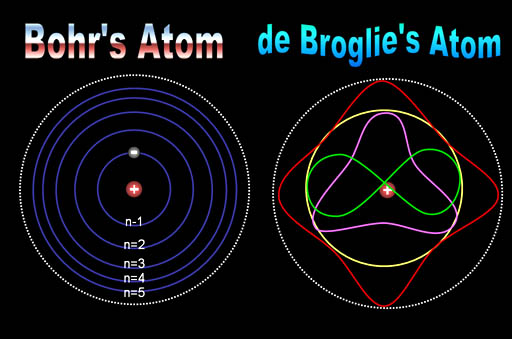

Es curioso el comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Edwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar los cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de onda cuántica”.

No hay duda de que la Mecánica Cuántica funciona maravillosamente bien. Sin embargo, surge una pregunta muy formal: ¿Qué significan realmente esas ecuaciones?, ¿Qué es lo que están describiendo? Cuando Isaac Newton, allá por el año 1687, formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo lo que significaban sus ecuaciones: que los planetas están siempre en una posición bien definida en el espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades con el tiempo.

Pero para los electrones todo esto es muy diferente. Su comportamiento parece estar envuelto en la bruma. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la “interpretación de Copenhague” de la Mecánica Cuántica. En vez de decir que el electrón se encuentra en el punto x o en el punto y, nosotros hablamos del estado del electrón. Ahora no tenemos el estado “x” o el estado “y”, sino estados “parcialmente x” o “parcialmente y. Un único electrón puede encontrarse, por lo tanto, en varios lugares simultáneamente. Precisamente lo que nos dice la Mecánica Cuántica es como cambia el estado del electrón según transcurre el tiempo.

Un “detector” es un aparato con el cual se puede determinar si una partícula está o no presente en algún lugar pero, si una partícula se encuentra con el detector su estado se verá perturbado, de manera que sólo podemos utilizarlo si no queremos estudiar la evolución posterior del estado de la partícula. Si conocemos cuál es el estado, podemos calcular la probabilidad de que el detector registre la partícula en el punto x.

Las leyes de la Mecánica Cuántica se han formulado con mucha precisión. Sabemos exactamente como calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas simultáneamente. Por ejemplo, podemos determinar la velocidad de una partícula con mucha exactitud, pero entonces no sabremos exactamente dónde se encuentra; o, a la inversa. Si una partícula tiene “espín” (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar con sencillez de dónde viene esta incertidumbre, pero hay ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar.

¿Onda o partícula? ¡Ambas a la vez! ¿Cómo es eso?

“La dualidad onda-corpúsculo, también llamada dualidad onda–partícula es un fenómeno cuántico, bien comprobado empíricamente, por el cual muchas partículas pueden exhibir comportamientos típicos de ondas en unos experimentos mientras aparecen como partículas compactas y localizadas en otros experimentos.”

Para que las reglas de la Mecánica Cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuanto más grande y más pesado es un objeto más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica.

Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por “holismo”, y que se podría definir como “el todo es más que la suma de las partes”.

Bien, si la Física nos ha enseñado algo, es justamente lo contrario: un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (las partículas): basta que uno sepa sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que yo entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes.

Por ejemplo, la constante de Planck, h = 6,626075…x 10 exp. -34 julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros tales como Edwin Schrödinger, siempre presentaron serias objeciones a esta interpretación.

Quizá funcione bien, pero ¿Dónde está exactamente el electrón, en el punto x o en el punto y? Em pocas palabras, ¿Dónde está en realidad?, ¿Cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Hasta hoy, muchos investigadores coinciden con la actitud pragmática de Bohr. Los libros de historia dicen que Bohr demostró que Einstein estaba equivocado. Pero no son pocos, incluyéndome a mí, los que sospechamos que a largo plazo el punto de vista de Einstein volverá: que falta algo en la interpretación de Copenhague. Las objeciones originales de Einstein pueden superarse, pero aún surgen problemas cuando uno trata de formular la mecánica cuántica para todo el Universo (donde las medidas no se pueden repetir) y cuando se trata de reconciliar las leyes de la mecánica cuántica con las de la Gravitación… ¡Infinitos!

La mecánica cuántica y sus secretos han dado lugar a grandes controversias, y la cantidad de disparates que ha sugerido es tan grande que los físicos serios ni siquiera sabrían por donde empezar a refutarlos. Algunos dicen que “la vida sobre la Tierra comenzó con un salto cuántico”, que el “libre albedrío” y la “conciencia” se deben a la mecánica cuántica: incluso fenómenos paranormales han sido descritos como efectos mecano-cuánticos.

Yo sospecho que todo esto es un intento de atribuir fenómenos “ininteligibles” a causas también “ininteligibles” (como la mecánica cuántica) dónde el resultado de cualquier cálculo es siempre una probabilidad, nunca una certeza.

Claro que, ahí están esas teorías más avanzadas y modernas que vienen abriendo los nuevos caminos de la Física y que, a mi no me cabe la menor duda, más tarde o más temprano, podrá explicar con claridad esas zonas de oscuridad que ahora tienen algunas teorías y que Einstein señalaba con acierto.

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? ¿Por qué están ahí? ¿Quiere eso decir que la Teoría de Einstein y la Mecánica Cuántica podrán al fin unirse en pacifico matrimonio sin que aparezcan los dichosos infinitos?

Bueno, eso será el origen de otro comentario que también, cualquier día de estos, dejaré aquí para todos ustedes.

emilio silvera

Abr

2

¡La Física! Siempre presente en nuestras vidas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

En 1.849, el físico francés Armand-Hippolyte-Louis Fizeau ideó un artificio mediante el cual se proyectaba la luz sobre un espejo situado a 8 km de distancia, que devolvía el reflejo al observador. El tiempo empleado por la luz en su viaje de ida y vuelta no rebasó apenas la 1/20.000 de segundo, pero Fizeau logró medirlo colocando una rueda dentada giratoria en la trayectoria del rayo luminoso. Cuando dicha rueda giraba a cierta velocidad, regulada, la luz pasaba entre los dientes y se proyectaba contra el siguiente, al ser devuelta por el espejo; así, Fizeau, colocado tras la rueda, no pudo verla. Entonces se dio más velocidad a la rueda, y el reflejo pasó por la siguiente muesca entre los dientes, sin intercepción alguna. De esa forma, regulando y midiendo la velocidad de la rueda giratoria, Fizeau pudo calcular el tiempo transcurrido y, por consiguiente, la velocidad a que se movía el rayo de luz.

Jean-Bernard-Léon Foucault suspendió una bola de 62 libras (unos 28 kilogramos) de hierro desde la cúpula del Panteón y lo puso en movimiento, balanceándolo. Para marcar su progreso el enganchó una aguja a la bola y colocó un anillo de tierra mojada en el suelo bajo él. La audiencia observó con pavor como el péndulo inexplicablemente parecía rotar, dejando un trazo ligeramente distinto en cada balanceo. En realidad era el suelo del Panteón el que estaba ligeramente en movimiento, y Foucault había demostrado, de una forma más convincente que nunca, que la tierra gira sobre su eje. En la latitud de París, el trazo del péndulo completaría una rotación completa en el sentido horario cada 30 horas; en el hemisferio sur rotaría en sentido antihorario, y en el ecuador no rotaría nada. En el Polo Sur, como han confirmado los científicos de la era moderna, el periodo de rotación es de 24 horas.

Un año más tarde, Jean Foucault (quien realizaría poco después su experimento -arriba- con los péndulos) precisó más estas medidas empleando un espejo giratorio en ve de una rueda dentada. Entonces se midió el tiempo transcurrido desviando ligeramente el ángulo de reflexión mediante el veloz espejo giratorio. Foucault obtuvo un valor de la velocidad de la luz de 300.883 km/s. También, el físico francés utilizó su método para determinar la velocidad de la luz a través de varios líquidos. Averiguó que era notablemente inferior a la alcanzada en el aire. Esto concordaba también con la teoría ondulatoria de Huyghens (abajo).

La naturaleza de la luz. Profesor escrupuloso, aunque poco entusiasta, Newton se dedicó a estudios de óptica que le llevaron, a través de una serie de experimentos, al famoso descubrimiento de la descomposición de la luz blanca, que fue explicada por él mediante una teoría corpuscular de la luz destinada a dar jaque a la teoría ondulatoria de C. Huygens y a dominar durante todo el siglo XVIII. Experimentos, descubrimientos e hipótesis sobre la luz fueron hechos públicos en una memoria a la Royal Society. Pero las tempestuosas disputas suscitadas por esta memoria le disgustaron hasta el punto de que se abstuvo de publicar sus Lecciones de óptica (desarrolladas en la cátedra lucasiana entre 1668 y 1671), las cuales sólo vieron la luz en 1729. No obstante, en 1675 presentó a la Royal Society una importante memoria, que constituirá después la base de su Óptica, en la que, partiendo de los experimentos sobre la coloración de laminillas metálicas, expone los principios de su teoría sobre la luz. En la imagen, El descubrimiento de la refracción de la luz de Newton (1827), óleo del pintor italiano Pelagio Palagi.

Michelson, Einstein y Millikan

Michelson fue más preciso aún en sus medidas. Este autor, durante cuarenta años largos, a partir de 1.879, fue aplicando el sistema Fizeau-Foucault cada vez con mayor refinamiento, para medir la velocidad de la luz. Cuando se creyó lo suficientemente informado, proyectó la luz a través de vacío, en vez de hacerlo a través del aire, pues este frena ligeramente su velocidad, y, empleó para ello tuberías de acero cuya longitud era superior a 1’5 km. Según sus medidas, la velocidad de la luz en el vacío era de 299.730 km/seg. (Sólo un 0’006% más bajo). Demostraría también que todas las longitudes de ondas luminosas viajan a la misma velocidad en el vacío.

En 1972, un equipo de investigadores bajo la dirección de Kenneth M. Eveson efectuó unas mediciones aún más exactas y vio que la velocidad de la luz era de 299.727’74 km/seg. Una vez se conoció la velocidad de la luz con semejante precisión, se hizo posible usar la luz, o por lo menos formas de ella, para medir distancias.

Desde Galileo con sus lámparas, cada vez se han utilizado aparatos más sofisticados para medir la velocidad de la luz, y, finalmente, se consiguió medirla de manera muy exacta en 299.792.458 metros por segundo que, es el límite que algo puede alcanzar corriendo por el espacio vacío y que sólo ha conseguido la luz.

Aunque para algunos resulte alto tedioso el tema anterior, no he podido resistirme a la tentación de exponerlo, así podrá saber algo más sobre la luz y, habrán conocido a personajes que hicieron posible el que ahora nosotros, la conozcamos mejor.

Podría continuar, hasta el final de este trabajo, hablando de la luz y sus distintas formas o aplicaciones: ondas de luz a través del espacio, de cómo se transmite la luz en el “vacío”, nos llega a través del espacio desde Galaxias situadas a miles de millones de años luz; las líneas de fuerzas electromagnéticas de Faraday y Maxwell de campos eléctricos y magnéticos cambiantes (todo ello explicado en un simple conjunto de cuatro ecuaciones, que describían casi todos los fenómenos referentes a esta materia electromagnética), o de los enigmas aún por descubrir (aunque predichos).

Muchos han ido a la caza de los monopolos magnéticos que, deben ser raros en el Universo, si finalmente existen. Parece que, algunos físicos han conseguido alguna cosa…no se bien qué sobre su existencia.

En 1.931, Dirac, acometiendo el asiento de una forma matemática, llegó a la conclusión de que sí los monopolos magnéticos existían, sería necesario que todas las cargas eléctricas fuesen múltiplos exactos de una carga más pequeña, como en efecto así es. Y dado que todas las cargas eléctricas son múltiplos exactos de alguna carga más pequeña, ¿no deberían en realidad existir los monopolos magnéticos?

En 1.974, un físico joven y prometedor (más tarde ganó el Nobel), Gerard’t Hooft, y un físico soviético, Alexander Poliakov, mostraron, independientemente, que podía razonarse, a partir de las grandes teorías unificadas, que los monopolos magnéticos debían así mismo existir, y que debían poseer una masa enorme. Aunque un monopolo magnético sería incluso más pequeño que un protón, debería tener una masa que sería de 10 trillones a 10 cuatrillones mayor que la del protón. Eso equivaldría a la masa de una bacteria comprimida en una diminuta partícula subatómica.

![[monopolos+m.gif]](http://4.bp.blogspot.com/_nbADpD65WD4/SqENDeBLtLI/AAAAAAAAJ0s/XB4iORp8-eQ/s1600/monopolos%2Bm.gif)

Sería la confirmación de una teoría de 1931. Si seres de otros mundos han podido verlos, habrían visto otro tipo de magnetismo los llamados “monopolos magnéticos”.

Semejantes partículas sólo podían haberse formado en el momento de la gran explosión (otra vez volvemos al origen). Desde entonces, no ha existido la suficientemente alta concentración de energía necesaria para formarla. Esas grandes partículas deberían avanzar a unos 225 km por seg., más o menos, y la combinación de una enorme masa y un pequeño tamaño le permitiría deslizarse a través de la materia sin dejar el menor rastro de presencia. Esta propiedad, de hecho, está relacionada directamente con el fracaso obtenido en su búsqueda.

Los físicos están tratando de idear un mecanismo capaz de poder detectar, con claridad, el paso de monopolos magnéticos.

Podríamos decir que, un monopolo magnético es una entidad magnética hipotética consistente en un polo Norte o Sur elemental aislado. Ha sido postulado como una fuente de campo magnético en analogía a la forma en que las partículas eléctricamente cargadas producen un campo eléctrico.

Se han diseñado numerosos experimentos ingeniosos para detectar monopolos, pero hasta ahora, ninguno ha producido un resultado definitivo. Los monopolos magnéticos son predichos en ciertas teorías gauge con bosones de Higgs. En particular, algunas teorías de gran unificación predicen monopolos muy pesados (con masas del orden de 1016 GeV). Se habló de su aparición en los primeros experimentos del LHC, algunos denunciaron eso junto con la aparición de agujeros negros microscópicos pero, de momento…nada

Los monopolos magnéticos también son predichos en las teorías de Kaluza-Klein (5 dimensiones) y en teoría de supercuerdas (10 y 26 dimensione). Es decir, que se predice pero no se puede verificar, y, siendo así, quedamos anclados en el campo de la teoría.

Recuerdo que estaba hablando de los distintos aspectos de la luz, lo que no recuerdo es como he llegado a éste berenjenal de los monopolos magnéticos. Me ocurre siempre, estoy tratando un tema y termino hablando (escribiendo) de otro. No parece más que, el bolígrafo, tenga vida propia. Sin embargo, lo que ocurre en verdad es que, todo es uno, compuesto de distintas partes. Siempre estamos hablando de lo mismo, solo cambian las partes que, en cada momento, estemos estudiando.

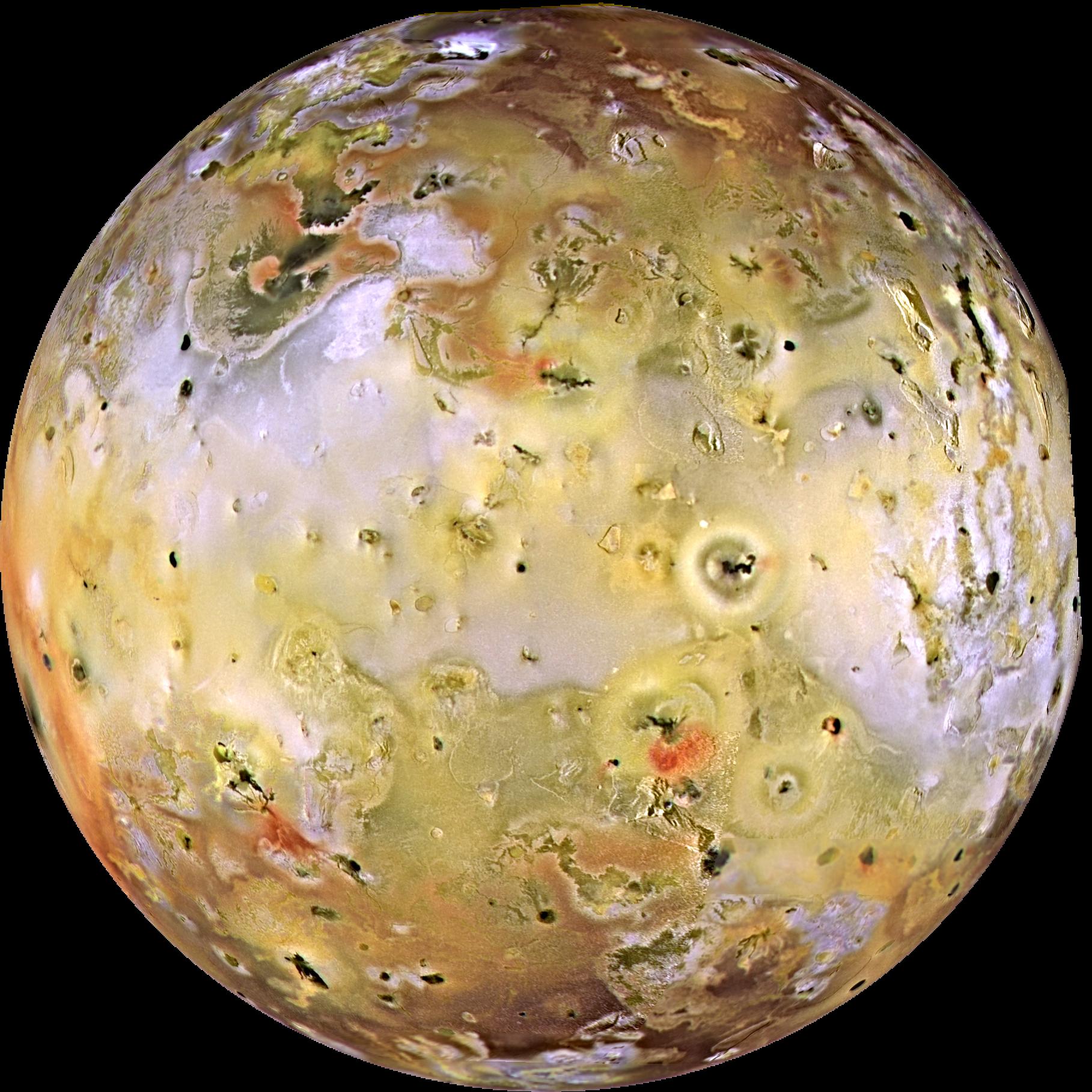

La misteriosa materia que compondría el 23 % (se especula) de toda la materia del universo es tan esquiva que jamás ha sido observada por nadie. Así que sólo podíamos sospechar que quizá existía. La materia oscura emite, absorbe e interactúa con radiación electromagnética de manera tan débil que no puede ser observada por medios técnicos ordinarios, no refleja la luz para ser observada.

Sin embargo, un equipo internacional de astrónomos de Japón, Gran Bretaña y Taiwan acaba de conseguir, por primera vez, imágenes que reflejan la distribución de materia oscura alrededor de 20 grandes cúmulos de galaxias. Los resultados se publicarán en la revista mensual de la Royal Astronomical Society. Las pruebas aún no son concluyentes, pero sí muy esperanzadoras.

Ni en el infrarrojo, ni en los rayos X ni en el ultravioleta la materia oscura había revelado aún su auténtica naturaleza. Pero utilizando lentes gravitacionales los científicos han sido capaces de mostrar las primeras imágenes en las que se “aprecia” la misteriosa materia oscura.

Masa-Materia-Luz: Todo la misma cosa ¡Energía! que es el motor que hace andar al ¡El Universo!

emilio silvera

Totales: 75.516.652

Totales: 75.516.652 Conectados: 64

Conectados: 64