Abr

15

El colapso del núcleo de las estrellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El vacío superconducto – La máquina de Higgs-Kibble

El vacío superconductor – La máquina de Higgs-Kibble II

Lo único que no resulta ser lo mismo cuando se mira a través a través del microscópico electrónico (o, en la jerca de la física teórica, cuando se realiza una transformación de escala) es la masa de la partícula. Esto se debe a que el alcance de la fuerza parece mayor a través del microscopio y, por lo tanto, la masa de la partícula parece ser menor. Nótese que esta situación es la opuesta a la que se presenta en vida corriente donde un grano de arena parece mayor -¿más pesado, por lo tanto?- cuando se observa con un microscopio.

Granos de arena vistos al microscópico electrónico

Una consecuencia de todo esto es que en una teoría de Yang-Mills el termino de masa parece desaparecer se realiza una transformación de escala, lo que implica que a través del microscopio se recupera la invariancia gauge. Esto es lo que causa la dificultad con la que se enfrentó Veltman. ¿Se observar directamente el potencial vector de Yang-Mills? Parece que puede observa4rse en el mundo de las cosas grandes, no en el mundo de lo pequeño. Esto es una contradicción y es una raz´`on por la que ese esquema nunca ha podido funcionar adecuadamente.

En el mundo cuántico se pueden contemplar cosas más extrañas

Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, = 1’62 × 10-33 cm, es la escala de longitud por debajo de la cual es espacio, tal tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler, o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que la longitud de Planck-Wheeler, es decir, 2’61 × 10-66 cm2) juega un papel clave en la entropía de un agujero negro.

Los electrones orbitan el núcleo atómico

Poco tiempo después resultó evidente que existían otras subpartículas en el interior del átomo. Cuando Becquerel descubrió la radiactividad, identificó como emanaciones constituidas por electrones algunas de las radiaciones emitidas por sustancias radiactivas. Pero también quedaron al descubierto otras emisiones. Los Curie en Francia y Ernest Rutherford en Inglaterra detectaron una emisión bastante menos penetrante que el flujo electrónico. Rutherford la llamó rayos alfa, y denominó rayos beta a la emisión de electrones.

Pero el trabajo de hoy se titula: El colapso del núcleo de las estrellas

En la imagen podemos contemplar lo que se clasifica NGC 3603, es un cúmulo abierto de estrellas en una vasta zona estelar, rodeada de una región H II (una enorme nube de gas y plasma en el que constantemente están naciendo estrellas), situado en el brazo espiral Carina de la Vía Láctea, a unos 20.000 años-luz de distancia en la constelación de Carina. Es uno de los jóvenes cúmulos de estrellas más luminosas e impresionante en la Vía Láctea, y la concentración más densa de estrellas muy masivas conocidas en la galaxia. Se estima que se ha formado hace alrededor de un millón de años. Las estrellas azules calientes en el núcleo son responsables de la fuerte radiación ultravioleta y los vientos estelares, tallando una gran cavidad en el gas.

NGC 3603 alberga miles de estrellas de todo tipo: la mayoría tienen masas similares o menores a la de nuestro Sol, pero las más espectaculares son algunas de las estrellas muy masivas que están cerca del final de sus vidas. Ahí están presentes algunas estrellas supergigantes que se agolpan en un volumen de menos de un año luz cúbico, se han localizado en la misma zona a tres llamadas Wolf-Rayet, estrellas muy brillantes y masivas que expulsan grandes cantidades de material antes de convertirse en supernovas.

Una de estas estrellas (NGC 3603-A1), una estrella doble azul que orbita alrededor de la otra una vez cada 3,77 días, es la estrella más masiva conocida hasta en la Vía Láctea. La más masiva de estas dos estrellas tiene una masa estimada de 116 masas solares, mientras que su compañera tiene una masa de 89 masas solares. Hay que decir que la máxima máxima de las estrellas está calculada en 120 masas solares, ya que, a partir de ahí, su propia radiación las destruiría.

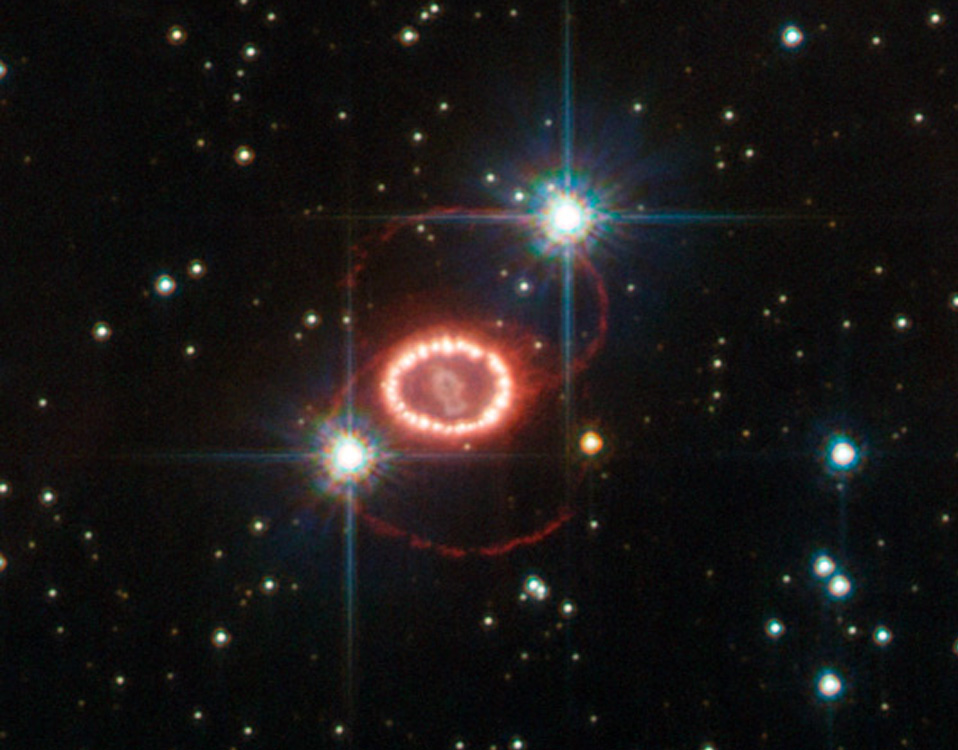

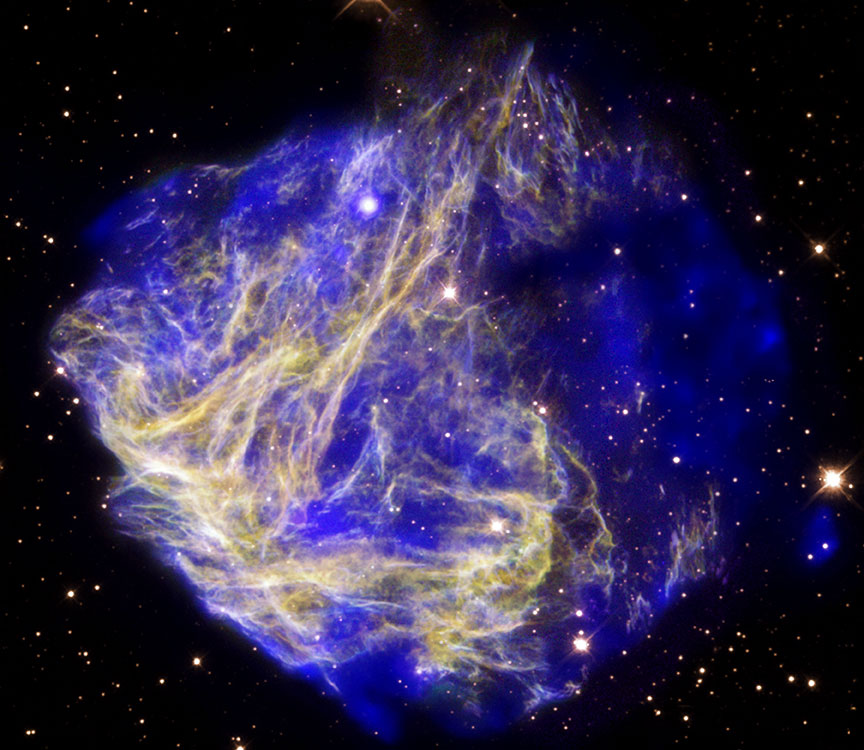

En el centro de la imagen podemos contemplar ese “collar de diamantes” que es el resultado evolucionado de aquella tremenda explosión estelar contemplada en 1987, cuando una estrella super-masiva, habiendo agotado todo su combustible nuclear de fusión, se contrae sobre sí misma al quedar sin defensa, en “manos” de la Gravedad que ya no se ve frenada por la inercia explosiva de la fusión que tendía a expandir la estrella.

Las capas exteriores son eyectadas al Espacio Interestelar con violencia para formar una nebulosa, mientras el grueso de la masa de la estrella se contrae más y más para formar una estrella de neutrones o un agujero negro dependiendo de su masa.

Las estrellas super-masivas cuando colapsan forman extrañas y, a veces, fantásticas imágenes que podemos captar por nuestros más sofisticados telescopios. Hace veinte años, los astrónomos fueron testigos de uno de los más brillantes explosiones estelares en más de 400 años. La supernova titánica, llamada SN 1987A, ardió con la fuerza de 100 millones de soles varios meses después de su descubrimiento el 23 de febrero de 1987.

Las observaciones de SN 1987A, hechas en los últimos 20 años por el Telescopio Espacial Hubble de NASA / ESA y muchos otros grandes telescopios terrestres y espaciales, han servido para cambiar la perspectiva que los astrónomos tenían de cómo las estrellas masivas terminan sus vidas. Estudiando estos sucesos sus comienzos se pueden ver los detalles más significativos del acontecimiento, cosa que, estuadinado los remanentes de supernovas muy antiguas no se podían ver.

Las estrellas super-masivas cuando colapsan forman extrañas y, a veces, fantásticas imágenes que podemos captar por nuestros más sofisticados telescopios. Arriba podemos contemplar observaciones realizadas en distintas fechas que nos muestran la evolución de los anillos de SN 1987 A. ¿Qué pudo causar los extraños anillos de esta Supernova. Hace 28 años se observó en la Gran Nube de Magallanes la supernova más brillante de la historia contemporánea.

El clúster abierto NGC 3603 contiene a Sher 25, una super gigante B1a que inevitablemente morirá en un masivo suceso supernova en los próximos 20,000 . ¡Esto emitirá una luz tan potente que competirá en el cielo con el planeta Venus! Un detalle muy emocionante es que Sher 25 presenta anillos similares a los que dejó la supernova SN 1987 A.

Cuando colapsa el núcleo de una estrella, ocurre en la formación de una estrella de neutrones, es preciso que la estrella esté evolucionada hasta el punto de que su núcleo esté compuesto completamente por hierro, que se niega a ser quemado en reacciones nucleares, no se puede producir la fusión y, por tanto, no produce la energía suficiente como soportar la inmensa fuerza de gravedad que propia masa de la estrella genera y que, solamente era frenada por la energía que produce la fusión nuclear que tiende a expandir la estrella, mientras que la gravedad tiende a contraerla.

El núcleo entonces se contrae, liberando energía potencial gravitatoria, se rompen los núcleos de los átomos de hierro en sus protones y sus neutrones constituyentes. A medida que aumenta la densidad, los protones se combinan con los electrones para formar neutrones. El colapso sólo se detiene (a veces) con la presión de degeneración del gas de neutrones (Principio de exclusión de Pauli) compensa el empuje hacia adentro de la Gravedad. El proceso completo hasta que todo ese ingente material se transmuta en la estrella de neutrones dura muy poco tiempo, es un proceso vertiginoso.

Otra perspectiva del remanente de la supernova por colapso de núcleo SN 1987A.

Han sido muy variados los grupos de astrónomos investigadores que han realizado observaciones durante largos períodos de tiempo llevar a cabo la no fácil tarea de comprender cómo se forman las estrellas de neutrones y púlsares cuando estrellas masivas llegan al final de sus vidas y finalizan el proceso de la fusión nuclear, momento en el que -como explicaba antes- la estrella se contrae, implosiona sobre sí misma, se produce la explosión supernova y queda el remanente formado por material más complejo en forma de gases que han sido expulsados por la estrella en este proceso final en el que, las capas exteriores de la estrella, forman una nebulosa y la estrella en sí misma, al contraerse y hacerse más densa, es decir de 1017 kg/m3.

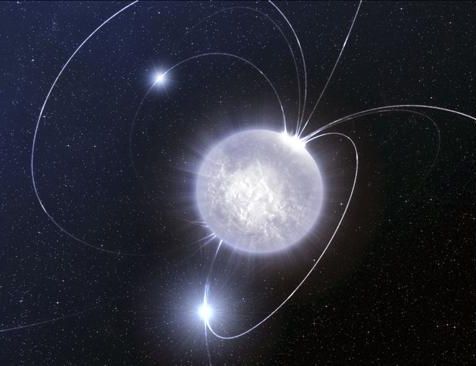

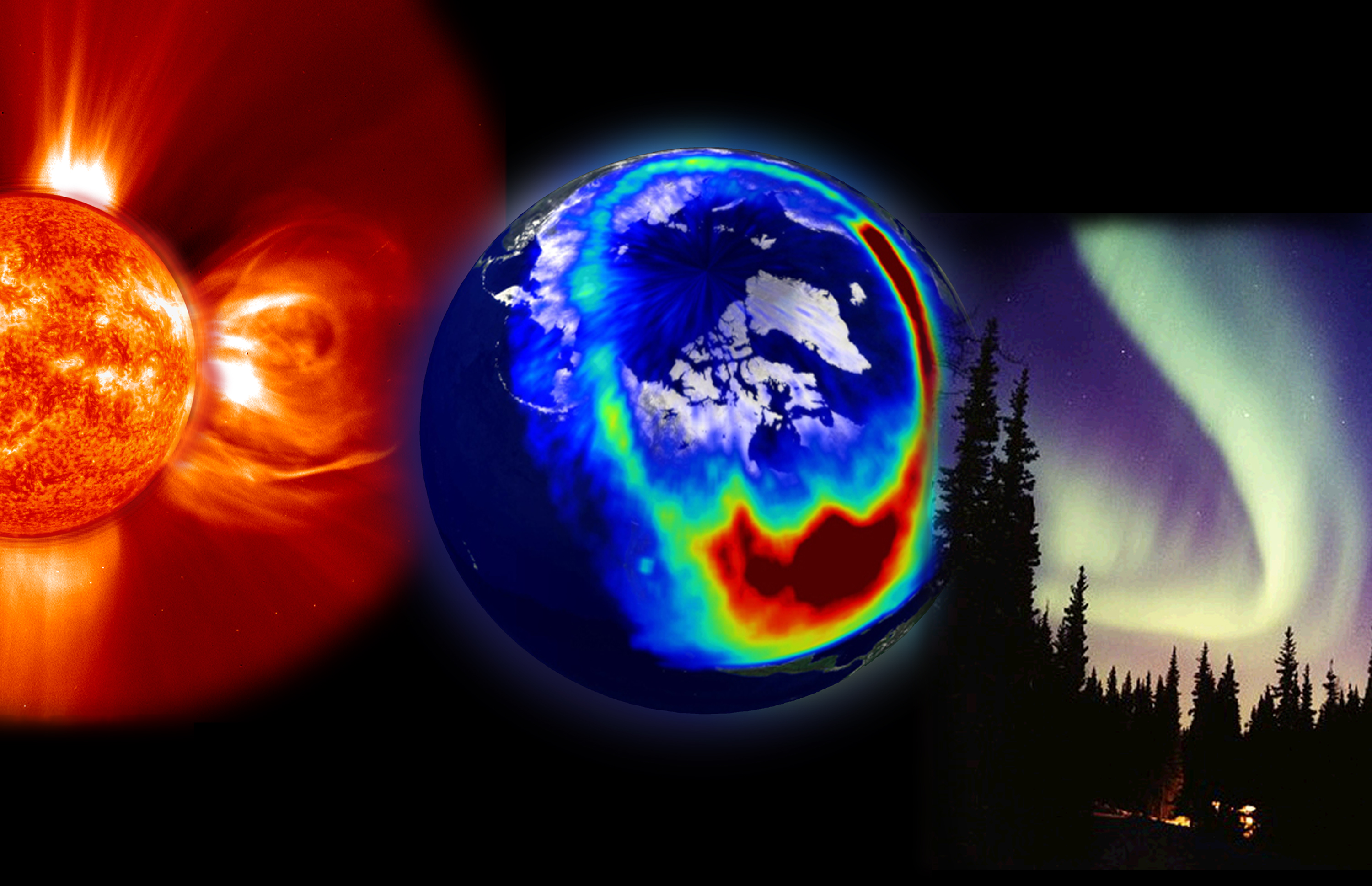

Actividad en el Sol

Se ha podido llegar a saber que las supernovas por colapso de núcleo suelen ocurrir en los brazos de galaxias espirales, así como también en las regiones HII, donde se concentran regiones de formación estelar. Una de las consecuencias de esto es que las estrellas, con masas a partir de 8 veces la masa del Sol, son las estrellas progenitoras de estos estos sucesos cósmicos. También es muy interesante y se está estudiando cómo se forman los inmensos campos magnéticos alrededor de estas estrellas de neutrones y púlsares que se conviertan en magnétares.

Cuando hace unos pocos años se descubrió la estrella de neutrones SGR0418, poco podían pensar los astrónomos que su funcionamiento alteraría todas las teorías existentes ahora acerca del funcionamiento de los magnétares. Sin embargo es así, ya que funciona como uno de éstos y no como sería propio de su condicción. Este hallazgo obliga a la ciencia a replantearse las teorías que se manejaban hasta ahora acerca del origen y evolución de los magnétares.

El “universo” de los procesos que siguen al colapso de los núcleos de las estrellas masivas es fascinante. Así, cuando se un púlsar que es una estrella de neutrones que gira sobre sí misma a una gran velocidad y tambien una fuente de ondas de radio que vibran con periodos regulares, este de estrellas tan extrañas son fruto -como antes decía- de una supernova o por consecuencias de la acreción de materia en estrellas enanas blancas en sistemas binarios. Una enana blanca que también es muy masiva, si tiene una estrella compañera cercana, genera mucha fuerza gravitatoria comienza a tirar del material de la estrella vecina y se lo queda hasta tal punto que, se transforma en una estrella de neutrones en una segunda etapa en la que se producen nuevos procesos de implosión.

“Las estrellas de neutrones tienen densidades totales de 3,7×1017 a 5,9×1017 kg/m³ (de 2,6×1014 a 4,1×1014 veces la densidad del Sol), comparable con la densidad aproximada de un núcleo atómico de 3×1017 kg/m³.”

La densidad de estas estrellas son increíblemente grande, tanto que un cubo de arena lleno del material de una estrella de neutrones tendría un peso parecido al de la montaña mas grande de la tierra, el monte . Los púlsares fueron descubiertos en 1970 y hasta solo se conoce unas 300 estrellas de este tipo. Sin embargo, se calcula que sólo en nuestra Galaxia podrían ser un millón. La rápida rotación de los pùlsares los mantiene fuertemente magnetizados y sus rotaciones vertiginosas generan y son inmensas fuentes de electricidad. Llegan a producir mil millones de millones de voltios. Cuando nuestros aparatos los observan y estudian detectan intensos haces de radiación en toda la gama del espectro (radio, luz, rayos X, Gamma).

Imagen de rayos-X en falso color de la región del cielo alrededor de SGR 1627-41 obtenida con XMM-Newton. La emisión indicada en rojo procede de los restos de una estrella masiva que estalló. Cubre una región más extendida de lo que se deducía anteriormente de las observaciones de radio, alrededor del SGR. Esto sugiere que la estrella que estalló fue el progenitor del magnetar. Crédito: ESA/XMM-Newton/EPIC (P. Esposito et al.)

Por ahora se conoce que de cada diez supernovas una se convierte en magnetar, si la supernova posee 6 y 12 masas solares, se convierte en una estrella de neutrones de no más de 10 a 20 km de diámetro. En el caso de las estrellas supermasivas de decenas de masas solares, el resultado es muy diferente y nos encontramos con los agujeros negros, esos monstruos del espacio devoradores de materia.

Cuando una estrella super-masiva muere, las consecuencias energéticas son inmensas. Ahí, en esa explosión se producen transiciones de fase que producen materiales pesados y complejos. En una supernova, en orden decreciente tenemos la secuencia de núcleos H, He, O, C, N, Fe, que coincide bastante bien con una ordenación en la tabla periódica de elementos.

Las estrellas mueren cuando dejan la secuencia principal, es decir, cuando no tienen material de fusión y quedan a merced de la fuerza de gravedad que hace comprimirse a la estrella más y más, en algunos casos, cuando son super-masivas, llegan a desaparecer de nuestra vista, y, su único destino es convertirse en temibles Agujeros Negros.

Colapso de la estrella super-masiva que finaliza con la creación del Agujero Negro

La explosión de una estrella gigante y super-masiva hace que brille más que la propia galaxia que la acoge y, en su ese tránsito de estrella a púlsar o agujero negro, se forman elementos que, el oro o el platino, se riegan por el espacio interestelar en las inmensas nebulosas de las que, más tarde, nacerán nuevas estrellas y nuevos mundos.

Pero está claro que todo el proceso estelar evolutivo inorgánico nos condujo el simple gas y polvo cósmico a la formación de estrellas y nebulosas solares hasta los planetas, la Tierra en particular, en cuyo medio ígneo describimos la formación de las estructuras de los silicatos, desplegándose con ello una enorme diversidad de composiciones, formas y colores, asistiéndose, por primera vez en la historia de la materia, a unas manifestaciones que contrastan con las que hemos mencionado en relación al proceso de las estrellas. Porque, en última instancia, debemos ser conscientes de un hecho cierto: En las estrellas se ¡ “fabrican los materiales que darán lugar al surgir de la vida”!.

El remanente estelar después de la explosión puede ser muy variado

Es posible que lo que nosotros llamamos materia inerte, no lo sea tanto, y, puede que incluso tenga memoria que transmite por medios que no sabemos reconocer. Esta clase de materia, se alía con el tiempo y, en momento adopta una forma predeterminada y de esa manera sigue evolucionando hasta llegar a su máximo ciclo o nivel en el que, de “materia inerte” llega a la categoría de “materia viva”, y, por el camino, ocupará siempre el lugar que le corresponda. No olvidemos de aquel sabio que nos dijo: “todas las cosas son”. El hombre, con aquellas sencillas palabras, elevó a todas las cosas a la categoría de ¡SER!

¿No os pensar que nosotros estemos hechos, precisamente, de lo que llamamos materia inerte?

Claro que, el mundo inorgánico es sólo una del inmenso mundo molecular. El resto lo constituye el mundo orgánico, que es el de las moléculas que contienen carbono y otros átomos y del que quedan excluidos, por convenio y características especiales, los carbonatos, bicarbonatos y carburos metálicos, los cuales se incluyen en el mundo inorgánico.

Según expliqué muchas veces, los quarks u y d se hallan en el seno de los nucleones (protones y neutrones) y, por tanto, en los núcleos atómicos. Hoy día, éstos se consideran una subclase de los hadrones. La composición de los núcleos (lo que en química se llama análisis cualitativo) es extraordinariamente sencilla, ya que como es sabido, constan de neutrones y protones que se pueden considerar como unidades que dentro del núcleo mantienen su identidad. Tal simplicidad cualitativa recuerda, por ejemplo, el caso de las series orgánicas, siendo la de los hidrocarburos saturados la más conocida. Recordad que su fórmula general es CnH2n+2, lo que significa que una molécula de hidrocarburo contiene n átomos de carbono (símbolo C) y (2n+2) átomos de hidrógeno (símbolo H).

Bueno, otra vez, como tantas veces me pasa, me desvío del camino que al principio del me propuse seguir y me pierdo en las elucubraciones que imaginan mis pensamientos. Mejor lo dejamos aquí.

emilio silvera

Abr

15

Rumores del pasado, el saber del mundo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

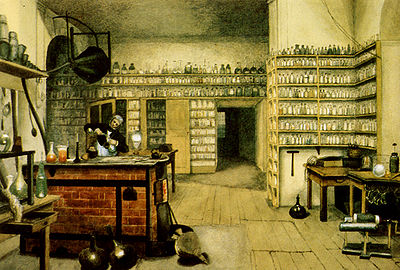

Faraday dando una charla sobre sus trabajos y explicando al público lo que era la luz y la electricidad

En su juventud, Michael Faraday tuvo unos humildes comienzos como repartidor de periódicos y aprendiz de encuadernador. Sin embargo, su afición al experimento y la investigación le llevó a descubrir algunos de los secretos más guardados de la Naturaleza. De hecho, el concepto de “Campo” que tanto hoy manejan los físicos, es debido a él. Gracias a sus trabajos y los resultados obtenidos en sus miles de experimentos, pudo Maxwell (un gran físico y matemático), crear su teoría de la luz y el electromagnetismo mediante sus famosas ecuaciones vectoriales.

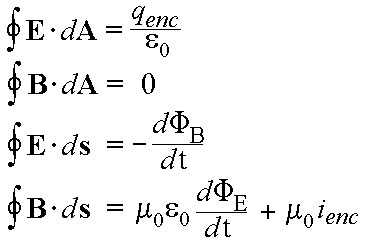

James Clark Maxwell

El trabajo más importante de Maxwell se efectuó entre 1864 y 1873, cuando dio forma matemática a las especulaciones de Faraday respecto a las líneas de fuerza magnéticas. Al hacerlo, Maxwell, pudo conseguir unas cuantas ecuaciones simples que expresaban todos los fenómenos variados de electricidad y magnetismo y las unió de un modo indisoluble. Su teoría demostraba que la electricidad y el magnetismo no podían existir aisladamente, donde esta una allí estaba el otro, por tanto, se hace referencia a su obra, generalmente, como la teoría del electromagnetismo.

La “profesionalización” e “institución” de la ciencia, entendiendo por tal que la práctica de la investigación científica se convirtiese en una profesión cada vez más abierta a personas sin medios económicos propios, que se ganaban la vida a través de la ciencia y que llegasen a atraer la atención de gobiernos e industrias, tuvo su explosión a lo largo de 1.800, y muy especialmente gracias al desarrollo de dos disciplinas, la química orgánica y el electromagnetismo. Estas disciplinas, junto a las matemáticas, la biología y las ciencias naturales (sin las cuales sería una necedad pretender que se entiende la naturaleza, pero con menos repercusiones socio-económicas), experimentaron un gran desarrollo entonces, tanto en nuevas ideas como en el número de científicos importantes: Faraday, Maxwell, Lyell, Darwin y Pasteur, son un ejemplo. Sin olvidar a otros como Mendel, Helmholtz, Koch, Virchow, Lister o Kelvin, o la matemática de Cauchy, de Gauss, Galois, Fourier, Lobachevski, Riemann, Klein, Cantor, Russell, Hilbert o Poincaré. Pero vamos a pararnos un momento en Faraday y Maxwell.

Las ecuaciones de Maxwell, por dar una simple explicación de lo que significan, hace posible que tengamos una información fidedigna de cómo se transmite la información para la televisión, Internet y la telefonía en general, cuánto tarda en llegarnos la luz de las estrellas, cuál es la base del funcionamiento de las neuronas o como funciona cualquier central de electricidad, aparte de otros miles de fenómenos que podemos estar experimentando en nuestras vidas cotidianas que están relacionados con la luz, la electricidad y el magnetismo. Y, todo ello, se explica con esas cuatro “sencillas ecuaciones”.

Para la electricidad, magnetismo y óptica, fenómenos conocidos desde la antigüedad, no hubo mejor época que el siglo XIX. El núcleo principal de los avances que se produjeron en esa rama de la física (de los que tanto se benefició la sociedad -comunicaciones telegráficas, iluminación, tranvías y metros, etc.-) se encuentra en que, frente a lo que se suponía con anterioridad, se descubrió que la electricidad y el magnetismo no eran fenómenos separados.

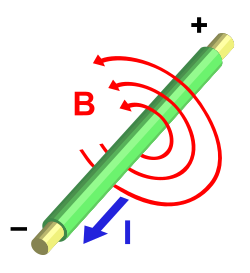

Estatua de Hans Christian Ørsted en Ørstedsparken, Copenhague, Dinamarca. Hans Christian Orsted físico y químico danés, que descubrió en 1819 que la aguja imantada de una brújula se desviaba cuando se encontraba próxima a un cable conductor por el cual fluía una corriente eléctrica. Esta desviación implica la existencia de un campo magnético en la región vecina al conductor. Asi se demostraba la existencia de un campo magnético en torno a todo conductor por el que fluye una corriente eléctrica, este descubrimiento fue crucial ya que puso en evidencia la relación existente entre la electricidad y el magnetismo.

Así que, el punto de partida para llegar a este resultado crucial fue el descubrimiento realizado en 1.820 por el danés Hans Christian Oersted (1777 – 1851) de que la electricidad produce efectos magnéticos: observó que una corriente eléctrica desvía una aguja imanada. La noticia del hallazgo del profesor danés se difundió rápidamente, y en París André-Marie Ampère (1775 – 1836) demostró experimentalmente que dos hilos paralelos por los que circulan corrientes eléctricas de igual sentido, se atraen, repeliéndose en el caso de que los sentidos sean opuestos.

La expresión diferencial

∇×H ≡ J (“Ley de Ampère“)

Conocida como “Ley de Ampère“, muestra la relación que existe entre el campo H y la fuente J cuando las corrientes y los campos no cambian el tiempo, pero falla cuando los fenómenos no son estacionarios. La contribución de Maxwell se resume en haber agregado a J, el sumando ∂D/∂t correspondiente a la corriente de desplazamiento en los fenómenos no estacionarios, algo que nadie había medido y que no resultaba intuitivo. La falta de ese término deja fuera los casos dinámicos, muchos casos tan importantes como por ejemplo las Ondas Electromagnéticas !

Con esta formulación, Ampère avanzaba la expresión matemática que representaba aquellas fuerzas. Su propósito era dar una teoría de la electricidad sin más que introducir esa fuerza (para él “a distancia”).

Pero el mundo de la electricidad y el magnetismo resultó ser demasiado complejo como para que se pudiera simplificar en un gráfico sencillo, como se encargó de demostrar uno de los grandes nombres de la historia de la ciencia: Michael Faraday (1791 – 1867), un aprendiz de encuadernador que ascendió de ayudante de Humphry Davy (1778 – 1829) en la Royal Intitution londinense.

En este humilde rinconcillo trabajaba Faraday

En 1.821, poco después de saber de los trabajos de Oersted, Faraday, que también dejó su impronta en la química, demostró que un hilo por el que pasaba una corriente eléctrica podía girar de manera continua alrededor de un imán, con lo que vio que era posible obtener efectos mecánicos (movimiento) de una corriente que interacciona con un imán. Sin pretenderlo, había sentado el principio del motor eléctrico, cuyo primer prototipo sería construido en 1.831 por el físico estadounidense Joseph Henry (1797 – 1878).

Lo que le interesaba a Faraday no eran necesariamente las aplicaciones prácticas, sino principalmente los principios que gobiernan el comportamiento de la naturaleza, y en particular las relaciones mutuas entre fuerzas, de entrada, diferentes. En este sentido, dio otro paso importante al descubrir, en 1.831, la inducción electromagnética, un fenómeno que liga en general los movimientos mecánicos y el magnetismo con la producción de corriente eléctrica.

Este fenómeno, que llevaría a la dinamo, representaba el efecto recíproco al descubierto por Oersted; ahora el magnetismo producía electricidad , lo que reforzó la idea de que un lugar de hablar de electricidad y magnetismo como entes separados, sería más preciso referirse al electromagnetismo.

La intuición natural y la habilidad experimental de Faraday hicieron avanzar enormemente el estudio de todos los fenómenos electromagnéticos. De él es, precisamente, el concepto de campo que tanto juego ha dado a la física.

Sin embargo, para desarrollar una teoría consistente del electromagnetismo se necesitaba un científico distinto: Faraday era hábil experimentador con enorme intuición, pero no sabía expresar matemáticamente lo que descubría, y se limitaba a contarlo. No hubo que esperar mucho, ni salir de Gran Bretaña para que un científico adecuado, un escocés de nombre James Clerk Maxwell (1831 – 1879), hiciera acto de presencia.

Las ecuaciones de Maxwell tienen más de 150 años. Publicado por Augusto en Divulgación, Historia de la Física. Las ecuaciones de Maxwell son un conjunto de cuatro ecuaciones (originalmente 20 ecuaciones) que describen por completo los fenómenos electromagnéticos. La gran contribución de James Clerk Maxwell fue reunir en estas ecuaciones largos años de resultados experimentales, debidos a Coulomb, Gauss, Ampere, Faraday y otros, introduciendo los conceptos de campo y corriente de desplazamiento, y unificando los campos eléctricos y magnéticos en un solo concepto: El Campo Electromagnético.

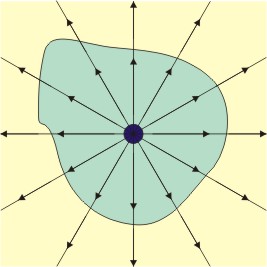

Las cuatro ecuaciones de Maxwell describen todos los fenómenos electromagnéticos, aquí se muestra la inducción magnética por medio de una corriente eléctrica en la figura situada en primer lugar. En la segunda se quiere escenificar el Flujo eléctrico de una carga puntual en una superficie cerrada. En la tercera imagen, quedan escenificadas las líneas de campo magnético que comienzan y terminan en el mismo lugar, por lo que no existe un monopolo magnético.

Maxwell desarrolló las matemáticas para expresar una teoría del magnetismo-electricidad (o al revés) que sentó las bases físicas de aquel fenómeno y contestaba a todas las preguntas de los dos aspectos de aquella misma cosa, el electromagnetismo. En sus ecuaciones vectoriales estaban todos los experimentos de Faraday, que le escribió una carta pidiéndole que le explicara, con palabras sencillas, aquellos números y letras que no podía entender.

Pero además, Maxwell también contribuyó a la física estadística y fue el primer director del Laboratorio Cavendish, unido de manera indisoluble a la física de los siglos XIX y XX (y también al de biología molecular) con sede en Cambridge.

Su conjunto de ecuaciones de, o en, derivadas parciales rigen el comportamiento de un medio (el campo electromagnético) que él supuso “transportaba” las fuerzas eléctricas y magnéticas; ecuaciones que hoy se denominan “de Maxwell”. Con su teoría de campo electromagnético, o electrodinámica, Maxwell logró, además, unir electricidad, magnetismo y óptica. Las dos primeras, como manifestaciones de un mismo substrato físico, electromagnético, que se comporta como una onda, y la luz, que es ella misma, una onda electromagnética, lo que, en su tiempo, resultó sorprendente.

Más de ciento treinta años después, todavía se podía o se puede apreciar la excitación que sintió Maxwell cuando escribió en el artículo Sobre las líneas físicas de la fuerza, 1861 – 62, en el que presentó esta idea: “Difícilmente podemos evitar la inferencia de que la luz consiste de ondulaciones transversales del mismo medio que es la causa de los fenómenos eléctricos y magnéticos.”

Todo aquello fue posible gracias a las bases sentadas por otros y a los trabajos de Faraday como experimentador infatigable, que publicaba sus resultados en artículos y los divulgaba en conferencias en la sede de la Royal Institution londinense. Todos estos artículos y conferencias fueron finalmente publicados en el libro que llamaron Philosophical transactions de la Royal Society, y Experimental researches in chemistry and physics (Richard Taylor y William Francis, Londres, 1859; dos grandes científicos unidos por la historia de la ciencia que nos abrieron puertas cerradas que nos dejaron entrar al futuro).

Magnetismo y electromagnetismo, ecuaciones

Claro que, si miramos hacia atrás en el tiempo, ¿Cuántas historias como ésta podemos encontrar? Para cualquiera de las cosas que ahora sabemos, casi siempre, ha sido necesario aunar los pensamientos dispersos de muchos que, aunados en un sólo y completo pensamiento, ha podido formar la teoría final que nos explicaron el funcionamiento de la Naturaleza. Así ha ocurrido siempre y seguirá pasando. Einstein se tuvo que vales de ideas dispersas de Mach, Maxwell, Riemann, Lorentz y algunos otros para poder formular su bella Teoría de la Relatividad.

Faraday fue el prototipo de experimentador de los fenómenos físicos

A finales del siglo XIX, poca gente sabía con exactitud a qué se dedicaban los “físicos”. El término mismo era relativamente nuevo. En Cambridge, la física se enseñaba como del grado de matemáticas. En este sistema no había espacio la investigación: se consideraba que la física era una rama de las matemáticas y lo que se le enseñaba a los estudiantes era como resolver problemas.

En la década de 1.870, la competencia económica que mantenían Alemania, Francia, Estados Unidos, y Gran Bretaña se intensificó. Las Universidades se ampliaron y se construyó un Laboratorio de física experimental en Berlín.

Cambridge sufrió una reorganización. William Cavendish, el séptimo duque de Devonshire, un terrateniente y un industrial, cuyo antepasado Henry Cavendish había sido una temprana autoridad en teoría de la gravitación, accedió a financiar un Laboratorio si la Universidad prometía fundar una cátedra de física experimental. Cuando el laboratorio abrió, el duque recibió una carta en la que se le informaba (en un elegante latín) que el Laboratorio llevaría su .

Primer profesor J. J. Thomson director del laboratorio

Tras intentar conseguir sin éxito atraer primero a William Thomson, más tarde a lord Kelvin (quien otras cosas, concibió la idea del cero absoluto y contribuyó a la segunda ley de la termodinámica) y después a Hermann von Helmohltz, de Alemania (entre cuyas decenas de ideas y descubrimientos destaca una noción pionera del cuanto), finalmente se ofreció la dirección del centro a James Clerk Maxwell, un escocés graduado en Cambridge. Este fue un hecho fortuito, pero Maxwell terminaría convirtiéndose en lo que por lo general se considera el físico más destacado entre Newton y Einstein. Su principal aportación fue, por encima de todo, las ecuaciones matemáticas que permiten entender perfectamente la electricidad y el magnetismo. Estas explicaban la naturaleza de la luz, pero también condujeron al físico alemán Heinrich Hertz a identificar en 1.887, en Karlsruhe, las ondas electromagnéticas que hoy conocemos ondas de radio.

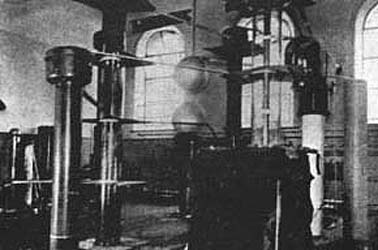

En el Laboratorio Cavendish de la Universidad de Cambridge, Cockcroft y Walton construyeron este acelerador de 500 kilovolts en 1932. Si lo comparamos con el LHC del CERN nos podemos dar de cómo la Ciencia ha ido avanzando en relativamente tan poco tiempo y, desde entonces hemos alcanzado un nivel que nos permite trabajar con 14 TeV, una energía de todo punto imposible e impensable en aquellos primeros tiempos.

Maxwell también creó un programa de investigación en Cavendish con el propósito de idear un estándar preciso de medición eléctrica, en particular la unidad de resistencia eléctrica, el ohmio. Esta era una cuestión de importancia internacional debido a la enorme expansión que había experimentado la telegrafía en la década de 1.850 y 1.860, y la iniciativa de Maxwell no solo puso a Gran Bretaña a la vanguardia de este campo, sino que también consolidó la reputación del Laboratorio Cavendish como un centro en el que se trataban problemas prácticos y se ideaban nuevos instrumentos.

Tubo de vacío usado por JJ Thomson en uno de los experimentos realizados para el electrón. Expuesto en el museo del laboratorio Cavendish. Aquellos físicos primeros que abrieron el camino a lo que más tarde sería la física moderna, tuvieron un gran mérito al poder avanzar hacia el conocimientos de las cosas, de la Naturaleza, con pocas herramientas y mucha imaginación.

A este hecho es posible atribuir del crucial papel que el laboratorio iba a desempeñar en la edad dorada de la Física, entre 1.897 y 1.933. Los científicos de Cavendish, se decía, tenían “sus cerebros en la punta de los dedos.”

Maxwell murió en 1.879 y le sucedió lord Rayleigh, quien continuó su labor, pero se retiró después de cinco años y, de manera inesperada, la dirección pasó a un joven de veintiocho años, Joseph John Thomson, que a pesar de su juventud ya se había labrado una reputación en Cambridge como un estupendo físico-matemático. Conocido universalmente como J.J., puede decirse que Thomson fue quien dio comienzo a la segunda revolución científica que creó el mundo que conocemos.

Ernest Rutherford otro experimentador

Se dedicó al estudio de las partículas radioactivas y logró clasificarlas en alfaa (α), beta (β) y gamma (γ). Halló que la radiactividad iba acompañada por una desintegración de los elementos, lo que le valió ganar el Premio Nobel de Química de 1908.

Se le debe un modelo atómico con el que probó la existencia de núcleo en los átomos, en el que se reúne toda la carga positiva y casi toda la masa del átomo. Consiguió la primera transmutación artificial con la colaboración de su discípulo Frederick Soddy.

La primera revolución científica comenzó con los descubrimientos de Copérnico, divulgados en 1.543, y los de Isaac Newton en 1.687 con su Gravedad y su obra de incomparable valor Principia Matemática, a todo esto siguió los nuevos hallazgos en la Física, la biología y la psicología.

Pero fue la Física la que abrió el camino. Disciplina en permanente cambio, debido principalmente a la de entender el átomo (esa sustancia elemental, invisible, indivisible que Demócrito expuso en la Grecia antigua).

John Dalton

En estos primeras décadas del siglo XIX, químicos como John Dalton se habían visto forzados a aceptar la teoría de los átomos como las unidades mínimas de los elementos, con miras a explicar lo que ocurría en las reacciones químicas (por ejemplo, el hecho de que dos líquidos incoloros produjeran, al mezclarse, un precipitado blanco). De similar, fueron estas propiedades químicas y el hecho de que variaran de forma sistemática, combinada con sus pesos atómicos, lo que sugirió al ruso Dimitri Mendeleyev la organización de la Tabla Periódica de los elementos, que concibió jugando, con “paciencia química”, con sesenta y tres cartas en su finca de Tver, a unos trescientos kilómetros de Moscú.

Pero además, la Tabla Periódica, a la que se ha llamado “el alfabeto del Universo” (el lenguaje del Universo), insinuaba que existían todavía elementos por .

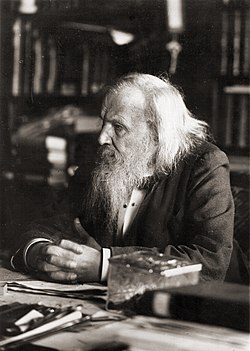

Dimitri Mendeléiev en 1897

La tabla de Mendeleyev encajaba a la perfección con los hallazgos de la Física de partículas, con lo que vinculaba física y química de racional: era el primer paso hacia la unificación de las ciencias que caracterizaría el siglo XX.

En Cavendish, en 1.873, Maxwell refinaría la idea de átomo al introducir la idea de campo electromagnético (idea que tomó prestada de Faraday), y sostuvo que éste campo “impregnaba el vacío” y la energía eléctrica y magnética se propagaba a través de él a la velocidad de la luz. Sin embargo, Maxwell aún pensaba en el átomo como algo sólido y duro y que, básicamente, obedecían a las leyes de la mecánica.

El problema estaba en el hecho de que, los átomos, si existían, eran demasiado pequeños ser observados con la tecnología entonces disponible.

Esa situación empezaría a cambiar con Max Planck, el físico alemán que, como de su investigación de doctorado, había estudiado los conductores de calor y la segunda ley termodinámica, establecida originalmente por Rudolf Clausius, un físico alemán nacido en Polonia, aunque lord Kelvin también había hecho algún aporte.

El joven Max Planck

Clausius había presentado su ley por primera vez en 1.850, y esta estipulaba algo que cualquiera podía observar, a saber, que cuando se realiza un la energía se disipaba convertida en calor y que ese calor no puede reorganizarse en una forma útil. Esta idea, que por lo demás parecería una anotación de sentido común, tenía consecuencias importantísimas.

Dado que el calor (energía) no podía recuperarse, reorganizarse y reutilizarse, el Universo estaba dirigiéndose gradualmente un desorden completo:

cántaro roto…

Una casa que se desmorona nunca se reconstruye así misma, una botella rota nunca se recompone por decisión propia. La palabra que Clausius empleó designar este fenómeno o desorden irreversible y creciente fue “entropía”: su conclusión era que, llegado el , el Universo moriría.

En su doctorado, Planck advirtió la relevancia de esta idea. La segunda ley de la termodinámica evidenciaba que el tiempo era en verdad una fundamental del Universo, de la física. Sea lo que sea, el tiempo es un componente básico del mundo que nos rodea y se relaciona con la materia de formas que todavía no entendemos.

La noción de tiempo implica que el Universo solo funciona en un sentido, hacia delante, nunca se está quieto ni funciona hacia atrás, la entropía lo impide, su discurrir no tiene marcha atrás. ¿No será nuestro discurrir lo que siempre marcha hacia delante, y, lo que tenemos por tiempo se limita a estar ahí?

En el Laboratorio Cavendish, me viene a la memoria que fue allí, donde Thomson, en 1.897, realizó el descubrimiento que vino a coronar anteriores ideas y trabajos de Benjamín Franklin, Eugen Goldstein, Wilhelm Röntgen, Henri Becquerel y otros. El descubrimiento del electrón convirtió a la física moderna en una de las aventuras intelectuales más fascinantes e importantes del mundo contemporáneo.

Joseph John Thomson

Los “corpúsculos”, como Thomson denominó inicialmente a estas partículas, hoy conocidas como electrones, condujo de directa al trascendental avance realizado una década después por Ernest Rutherford, quien concibió el átomo como una especie de “sistema solar” en miniatura, con los electrones diminutos orbitando alrededor de un núcleo masivo como hacen los planetas alrededor del Sol. Rutherford demostró experimentalmente lo que Einstein había descubierto en su cabeza y revelado en su famosa ecuación, E = mc2 (1905), esto es que la materia y la energía eran esencialmente lo mismo.

Todo aquello fue un gran paso en la búsqueda del conocimiento de la materia. El genio, la intuición y la experimentación han sido esenciales en la lucha del ser humano con los secretos, bien guardados, de la Naturaleza.

emilio silvera

Abr

14

Plasma, Nebulosas, Gases, elementos, moléculas.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El plasma es el estado de la materia observable que más abunda en el Universo (99%), ya sea por los grandes volúmenes del mismo o debido a las altas energías involucradas en los procesos astrofísicos.

El Plasma, ese otro estado de la Materia (el cuarto dicen) que, según sabemos, resulta ser el más abundante del Universo. Todos desde pequeños aprendimos aquellos tres estados de la materia que cantábamos en el patio del centro educativo durante el recreo, donde todos a una gritábamos como papagayos: “Sólido, líquido y gaseoso”. Nada nos decían del Plasma, ese estado que, en realidad, cubre el 99% del estado de la materia en nuestro Universo (bueno, hablamos de la materia conocida, esa que llamamos bariónica y está formada por átomos de Quarks y Leptones). Sospecho que hay otros estados de la materia que nos son desconocidos.

El plasma está en las estrellas, en remanentes de Supernovas y… ¡en tantos procesos astrofísicos!

Según la energía de sus partículas, los plasmas (como digo), constituyen el cuarto estado de agregación de la materia, tras los sólidos, líquidos y gases. Para cambiar de uno al otro, es necesario que se le aporte energía que aumente la temperatura. Si aumentamos de manera considerable la temperatura de un gas, sus átomos o moléculas adquieren energía suficiente para ionizarse al chocar entre sí. de modo que a ~ 20.000 K muchos gases presentan una ionización elevada. Sin embargo, átomos y moléculas pueden ionizarse también por impacto electrónico, absorción de plasma en las nebulosas donde están presentes elementos y moléculas ionizados y donde se producen reacciones químicas o nucleares y otros procesos.

Aquí podemos contemplar una enorme región ionizada en la Nebulosa del Pelícano. Estrellas nuevas emiten potente radiación ultravioleta que ataca el espesor de la Nebulosa molecular y hace que, el gas se ionice fuertemente creando una luminosidad que “viste” de azul claro todo el contorno que circunda el radio de acción de las estrellas.

Un plasma es un gas muy ionizado, con igual número de cargas negativas y positivas. Las cargas otorgan al Plasma un comportamiento colectivo, por las fuerzas de largo alcance existente entre ellas. En un gas, cada partícula, independientemente de las demás, sigue una trayectoria rectilínea, hasta chocar con otra o con las grandes paredes que la confinan. En un plasma, las cargas se desvían atraídas o repelidas por otras cargas o campos electromagnéticos externos, ejecutando trayectorias curvilíneas entre choque y choque. Los gases son buenos aislantes eléctricos, y los plasmas buenos conductores.

En la Tierra, los plasmas no suelen existir en la Naturaleza, salvo en los relámpagos, que son trayectorias estrechas a lo largo de las cuales las moléculas de aire están ionizadas aproximadamente en un 20%, y en algunas zonas de las llamas. Los plasmas de electrones libres de un metal también pueden ser considerados como un plasma. La mayor parte del Universo está formado por materia en estado plasmático (sólo tenemos que pensar en la cantidad de estrellas que existen en las galaxias, en los remanentes supernovas y otros fenómenos físicos que se producen en el Cosmos).

La ionización está causada por las elevadas temperaturas, como ocurre en el Sol y las demás estrellas, o por la radiación, como sucede en los gases interestelares o en las capas superiores de la atmósfera, donde se produce el fenómeno denominado aurora.

Así que, aunque escasos en la Tierra, el Plasma constituye la materia conocida más abundante del Universo, más del 99%. Abarcan desde altísimos valores de presión y temperatura, como en los núcleos estelares, hasta otros asombrosamente bajos en ciertas regiones del espacio. Uno de sus mayores atractivos es que emiten luz visible, con espectros bien definidos, particulares en cada especie. Algunos objetos radiantes, como un filamento incandescente, con espectro continuo similar al cuerpo negro, o ciertas reacciones químicas productoras de especies excitadas, no son plasmas, sin embargo, lo son la mayoría de los cuerpos luminosos.

Bombilla de incandescencia

Los Plasmas se clasifican según la energía media (o temperatura) de sus partículas pesadas (iones y especies neutras). Un primer tipo son los Plasmas calientes, prácticamente ionizados en su totalidad, y con sus electrones en equilibrio térmico con las partículas más pesadas. Su caso extremo son los Plasmas de Fusión, que alcanzan hasta 108 K, lo que permite a los núcleos chocar entre sí, superando las enormes fuerzas repulsivas inter-nucleares, y lograr su fusión. Puede producirse a presiones desde 1017 Pascales, como en los núcleos estelares, hasta un Pascal, como en los reactores experimentales de fusión.

Los reactores de fusión nuclear prácticos están ahora un poco más cerca de la realidad gracias a nuevos experimentos con el reactor experimental Alcator C-Mod del MIT. Este reactor es, de entre todos los de fusión nuclear ubicados en universidades, el de mayor rendimiento en el mundo.

Los nuevos experimentos han revelado un conjunto de parámetros de funcionamiento del reactor, lo que se denomina “modo” de operación, que podría proporcionar una solución a un viejo problema de funcionamiento: cómo mantener el calor firmemente confinado en el gas caliente cargado (llamado plasma) dentro del reactor, y a la vez permitir que las partículas contaminantes, las cuales pueden interferir en la reacción de fusión, escapen y puedan ser retiradas de la cámara.

Otros Plasmas son los llamados térmicos, con e ~electrones y especies pesadas en equilibrio, pero a menor temperatura ~ 103 – 104 K, y grados de ionización intermedios, son por ejemplo los rayos de las tormentas o las descargas en arcos usadas en iluminación o para soldadura, que ocurren entre 105 y ~ 102 Pa. Otro tipo de Plasma muy diferente es el de los Plasmas fríos, que suelen darse a bajas presiones ( < 102 Pa), y presentan grados de ionización mucho menores ~ 10-4 – 10-6. En ellos, los plasmas, nebulosas, gases, elementos, moléculas y electrones pueden alcanzar temperaturas ~ 105 K, mientras iones y neutros se hallan a temperatura ambiente. Algunos ejemplos son las lámparas de bajo consumo y los Plasmas generados en multitud de reactores industriales para producción de películas delgadas y tratamientos superficiales.

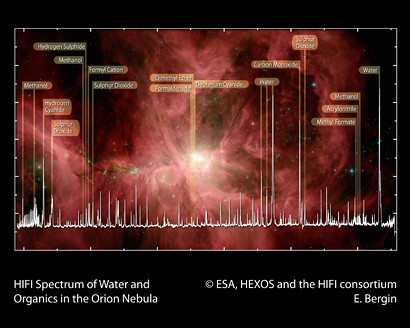

El Observatorio Espacial Herschel de la ESA ha puesto de manifiesto las moléculas orgánicas que son la llave para la vida en la Nebulosa de Orión, una de las regiones más espectaculares de formación estelar en nuestra Vía Láctea. Este detallado espectro, obtenido con el Instrumento Heterodino para el Infrarrojo Lejano (Heterodyne Instrument for the Far Infrared, HIFI) es una primera ilustración del enorme potencial de Herschel-HIFI para desvelar los mecanismos de formación de moléculas orgánicas en el espacio. Y, para que todo eso sea posible, los Plasmas tienen que andar muy cerca.

Precursores moleculares

En los Plasmas calientes de precursores moleculares, cuanto mayor es la ionización del gas, más elevado es el grado de disociación molecular, hasta poder constar solo de plasma de electrones y especies atómicas neutras o cargadas; en cambio, los Plasmas fríos procedentes de especies moleculares contienen gran proporción de moléculas y una pequeña parte de iones y radicales, que son justamente quienes proporcionan al Plasma su característica más importante: su altísima reactividad química, pese a la baja temperatura.

Herschel-HIFI desvela los precursores moleculares de la Vida en las Nebulosas

En la Naturaleza existen Plasmas fríos moleculares, por ejemplo, en ciertas regiones de las nubes interestelares y en las ionosfera de la Tierra y otros planetas o satélites. Pero también son producidos actualmente por el ser humano en gran variedad para investigación y multitud de aplicaciones.

En un número de la Revista Española de Física dedicado al vacío, el tema resulta muy apropiado pues no pudieron generarse Plasmas estables en descargas eléctricas hasta no disponer de la tecnología necesaria para mantener presiones suficientemente bajas; y en el Universo, aparecen Plasmas fríos hasta presiones de 10 ⁻ ¹⁰ Pascales, inalcanzable por el hombre.

Lo que ocurre en las Nubes moleculares es tan fantástico que, llegan a conseguir los elementos necesarios para la vida prebiótica que, más tarde situados en el planeta y ambiente adecuados, tras cumplirse las reglas y cubrir los parámetros adecuados, dan lugar al surgir de la vida.

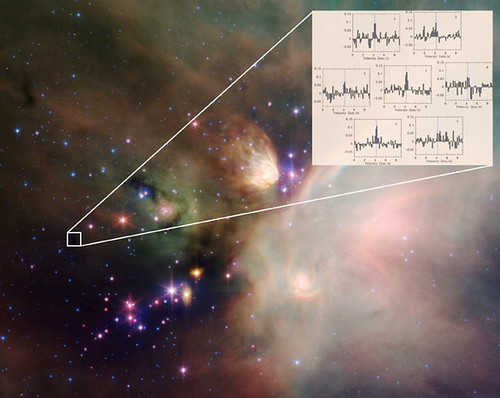

El papel de las moléculas en Astronomía se ha convertido en un área importante desde el descubrimiento de las primeras especies poliatómicas en el medio interestelar. Durante más de 30 años, han sido descubiertas más de 180 especies moleculares en el medio interestelar y gracias al análisis espectral de la radiación. Muchas resultan muy exóticas para estándares terrestres (iones, radicales) pero buena parte de estas pueden reproducirse en Plasma de Laboratorio. Aparte del interés intrínseco y riqueza de procesos químicos que implican, estas especies influyen en la aparición de nuevas estrellas por su capacidad de absorber y radiar la energía resultante del colapso gravitatorio, y de facilitar la neutralización global de cargas, mucho más eficientemente que los átomos.

Su formación en el espacio comienza con la eyección de materia al medio interestelar por estrellas en sus últimas fases de evolución y la transformación de éstas por radiación ultravioleta, rayos cósmicos y colisiones; acabando con su incorporación a nuevas estrellas y Sistemas planetarios, en un proceso cíclico de miles de millones de años.

En las explosiones supernovas se producen importantes transformaciones en la materia que, de simple se transforma en compleja y dan lugar a todas esas nuevas especies de moléculas que nutren los nuevos mundos en los que podemos encontrar elementos como el oro y el platino que han sido creados en sucesos de una magnitud aterradora donde las fuerzas desatadas del Universo han quedado sueltas para transformarlo todo.

El H₂ y otras moléculas diatómicas homo-nucleares carecen de espectro rotacional. Detectando las débiles emisiones cuadru-polares del H₂ en infrarrojo, se ha estimado una proporción de H₂ frente a H abrumadoramente alto ( ~ 104) en Nubes Interestelares con densidades típicas de ~ 104 partículas /cm3; pero dada la insuficiente asociación radiactiva del H para formar H2, ya mencionada, el H2 debe producirse en las superficies de granos de polvo interestelar de Carbono y Silicio, con diámetros ~ 1 nm — μm, relativamente abundantes en estas nubes.

Experimentos muy recientes de desorción programada sobre silicatos ultra-fríos, demuestran que tal recombinación ocurren realmente vía el mecanismo de Langmuir-Hinshelwood, si bien los modelos que expliquen las concentraciones de H2 aún deben ser mejorados.

Por otro lado, ciertas regiones de las nubes en etapas libres de condensación estelar presentan grados de ionización ~ 10-8 – 10-7 a temperaturas de ~ 10 K. La ionización inicial corresponde principalmente al H2 para formar H2 +, que reacciona eficientemente con H2, dando H3 + + H (k = 2• 10-9 cm3 • s-1.

El H3, de estructura triangular, no reacciona con H2 y resulta por ello muy “estable” y abundante en esas regiones de Nebulosas interestelares, donde ha sido detectado mediante sus absorciones infrarrojas caracterizadas por primera vez en 1980 en descargas de H2 en Laboratorio.

La constelación de Orión contiene mucho más de lo que se puede ver, ahí están presentes los elementos que como el H2 que venimos mencionando, tras procesos complejos y naturales llegan a conseguir otras formaciones y dan lugar a la parición de moléculas significativas como el H2O o HCN y una gran variedad de Hidrocarburos, que podrían contribuir a explicar en un futuro próximo, hasta el origen de la vida.

La detección por espectroscopia infrarroja de COH+ y N2H+, formados en reacciones con H3 + a partir de CO y N2, permite estimar la proporción de N2/CO existente en esas regiones, ya que el N2 no emite infrarrojos. Descargas de H2 a baja presión con trazas de las otras especies en Laboratorio conducen casi instantáneamente a la aparición de tales iones y moléculas, y su caracterización puede contribuir a la comprensión de este tipo de procesos.

Así amigos míos, hemos llegado a conocer (al menos en parte), algunos de los procesos asombrosos que se producen continuamente en el Espacio Interestelar, en esa Nebulosas que, captadas por el Hubble y otros telescopios, miramos asombrados maravillándonos de sus colores y fantásticas figuras arabescas que se forman por el choque del material allí existente con los vientos solares y la radiación de las estrellas radiantes nuevas que, en realidad, llevan mensajes que nos están diciendo el por qué se producen y que elementos son los causantes de que brillen deslumbrantes cuando la radiación estelar choca de lleno en esas nubes en la que nacen las estrellas y los nuevos mundos…y, si me apuráis un poco, también la vida.

emilio silvera

Abr

13

El fino equilibrio que permite la presencia de la Vida I

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Agujeros Negros Gigantes

La idea de que los agujeros negros gigantes podían activar los cuásares y las radio-galaxias…

Animación del péndulo de Foucault

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre los atmósferas de los planetas en órbitas a su alrededor y a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Hasta el momento sólo sabemos de la vida en la Tierra

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagan infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el Planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución.

Ellos vivieron tranquilos en la Tierra durante 150 millones de años, llegó el meteorito y acabó con ellos.

Gracias a este acontecimiento, nuestra especie pudo prosperar 65 millones de años más tarde.

Cuando comento éste tema no puedo evitar el recuerdo del meteorito caído en la Tierra que impactó en la península de Yucatán hace 65 millones de años, al final de la Era Mesozoica, cuando según todos los indicios, los dinosaurios se extinguieron. Sin embargo, a aquel suceso catastrófico para los grandes lagartos, en realidad supuso que la Tierra fue rescatada de un callejón sin salida evolutivo. Parece que los dinosaurios evolucionaron por una vía que desarrollaba el tamaño físico antes que el tamaño cerebral.

La desaparición de los dinosaurios junto con otras formas de vida sobre la Tierra en aquella época, hizo un hueco para la aparición de los mamíferos. Se desarrollo la diversidad una vez desaparecidos los grandes depredadores. Así que, al menos en este caso concreto, el impacto nos hizo un gran favor, ya que, hizo posible que 65 millones de años más tarde pudiéramos llegar nosotros. Los dinosaurios dominaron el planeta durante 150 millones de años; nosotros, en comparación, llevamos tres días y, desde luego, ¡la que hemos formado!

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema Solar habitado observado ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales el t(bio) –tiempo biológico para la aparición de la vida- algo más extenso.

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la foto-disociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

A muchos les cuesta trabajo admitir la presencia de vida en el Universo como algo natural y corriente, ellos abogan por la inevitabilidad de un Universo grande y frío en el que, es difícil la aparición de la vida, y, en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

Creo que la clave está en los compuestos del carbono, toda la vida terrestre actualmente conocida exige también el Agua como disolvente. Y como para el carbono, se supone a veces que el agua es el único producto químico conveniente para cumplir este papel. El amoníaco (el nitruro de hidrógeno) es la alternativa ciertamente al agua, la más generalmente posible propuesta como disolvente bioquímico. Numerosas reacciones químicas son posibles en disolución en el amoníaco, y el amoníaco líquido tiene algunas semejanzas químicas con el agua. El amoníaco puede disolver la mayoría de las moléculas orgánicas al menos así como el agua, y por otro lado es capaz de disolver muchos metales elementales. A partir de este conjunto de propiedades químicas, se teorizó que las formas de vida basada en el amoníaco podrían ser posibles. También se dijo del Silicio. Sin embargo, ninguno de esos elementos son tan propicios para la vida como el Carbono y tienen, como ya sabemos, parámetros negativos que no permiten la vida tal como la conocemos.

Hasta el momento, todas las formas de vida descubiertas en la Tierra, están basadas en el Carbono.

Los biólogos, sin embargo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de los estimaciones de la probabilidad de que haya inteligencias extraterrestres en el Universo se centran en formas de vida similares a nosotras que habiten en planetas parecidos a la Tierra y necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el Universo.

Hay una coincidencia o curiosidad adicional que existe entre el tiempo de evolución biológico y la astronomía. Puesto que no es sorprendente que las edades de las estrellas típicas sean similares a la edad actual del Universo, hay también una aparente coincidencia entre la edad del Universo y el tiempo que ha necesitado para desarrollar formas de vida como nosotros.

Si miramos retrospectivamente cuánto tiempo han estado en escena nuestros ancestros inteligentes (Homo sapiens) vemos que han sido sólo unos doscientos mil años, mucho menos que la edad del Universo, trece mil millones de años, o sea, menos de dos centésimos de la Historia del Universo. Pero si nuestros descendientes se prolongan en el futuro indefinidamente, la situación dará la vuelta y cuando se precise el tiempo que llevamos en el Universo, se hablará de miles de millones de años.

- C: Carbono

- H: Hidrógeno

- O: Oxígeno

- N: Nitrógeno

- P: Fósforo

- Fe: Hierro

- S: Azufre

- Ca: Calcio

- I: Yodo

- Na: Sodio

- K: Potasio

- Cl: Cloro

- Mg: Magnesio

- F: Flúor

- Cu: Cobre

- Zn: Zinc

- Glúcidos o Hidratos de Carbono

- Lípidos

- Proteínas

- Ácidos Nucleicos

El el gráfico de arriba están resumidas sus funciones.

A veces, nuestra imaginación dibuja mundos de ilusión y fantasía pero, en realidad… ¿serán sólo sueños?, o, por el contrario, pudieran estar en alguna parte del Universo todas esas cosas que imaginamos aquí y que pudieran estar presentes en otros mundos lejanos que, como el nuestro…posibilito la llegada de la vida.

Sí, imaginamos demasiado pero… ¿Qué hay más poderoso que la imaginación?

Brandon Carter y Richard Gott han argumentado que esto parece hacernos bastante especiales comparados con observadores en el futuro muy lejano.

¿Cuántos secretos están en esos números escondidos? La mecánica cuántica (h), la relatividad (c), el electromagnetismo (e–). Todo eso está ahí escondido. El número 137 es un número puro y adimensional, nos habla de la constante de estructura fina alfa (α), y, el día que sepamos desentrañar todos sus mensajes… ¡Ese día sabremos!

Extraños mundos que pudieran ser

Podríamos imaginar fácilmente números diferentes para las constantes de la Naturaleza de forma tal que los mundos también serían distintos al planeta Tierra y, la vida no sería posible en ellos. Aumentemos la constante de estructura fina más grande y no podrá haber átomos, hagamos la intensidad de la gravedad mayor y las estrellas agotarán su combustible muy rápidamente, reduzcamos la intensidad de las fuerzas nucleares y no podrá haber bioquímica, y así sucesivamente.

Hay cambios infinitesimales que seguramente podrían ser soportados sin notar cambios perceptibles, como por ejemplo en la vigésima cifra decimal de la constante de estructura fina. Si el cambio se produjera en la segunda cifra decimal, los cambios serían muy importantes. Las propiedades de los átomos se alteran y procesos complicados como el plegamiento de las proteínas o la replicación del ADN pueden verse afectados de manera adversa. Sin embargo, para la complejidad química pueden abrirse nuevas posibilidades. Es difícil evaluar las consecuencias de estos cambios, pero está claro que, si los cambios consiguen cierta importancia, los núcleos dejarían de existir, n se formarían células y la vida se ausentaría del planeta, siendo imposible alguna forma de vida.

“Es difícil formular cualquier teoría firme sobre las etapas primitivas del universo porque no sabemos si hc/e2 es constante o varía proporcionalmente a log(t). Si hc/e2fuera un entero tendría que ser una constante, pero los experimentadores dicen que no es un entero, de modo que bien podría estar variando. Si realmente varía, la química de las etapas primitivas sería completamente diferente, y la radiactividad también estaría afectada. Cuando empecé a trabajar sobre la gravedad esperaba encontrar alguna conexión ella y los neutrinos, pero esto ha fracasado.”

Las constantes de la naturaleza ¡son intocables! Si varía la carga del electrón o la masa del protón, aunque sólo sea una diezmillonésima parte… ¡La Vida no sería posible en nuestro mundo!

Ahora sabemos que el Universo tiene que tener miles de millones de años para que haya transcurrido el tiempo necesario par que los ladrillos de la vida sean fabricados en las estrellas y, la gravitación nos dice que la edad del Universo esta directamente ligada con otros propiedades como la densidad, temperatura, y el brillo del cielo.

Ahora, cuando miramos el Universo, comprendemos, en parte, lo que ahí está presente.

Puesto que el Universo debe expandirse durante miles de millones de años, debe llegar a tener una extensión visible de miles de millones de años luz. Puesto que su temperatura y densidad disminuyen a medida que se expande, necesariamente se hace frío y disperso. Como hemos visto, la densidad del Universo es hoy de poco más que 1 átomo por M3 de espacio. Traducida en una medida de las distancias medias entre estrellas o galaxias, esta densidad tan baja muestra por qué no es sorprendente que otros sistemas estelares estén tan alejados y sea difícil el contacto con extraterrestres. Si existe en el Universo otras formas de vía avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada.

La expansión del Universo es precisamente la que ha hecho posible que el alejamiento entre estrellas con sus enormes fuentes de radiación, no incidieran en las células orgánicas que más tarde evolucionarían hasta llegar a nosotras, diez mil millones de años de alejamiento continuado y el enfriamiento que acompaña a dicha expansión, permitieron que, con la temperatura ideal y una radiación baja los seres vivos continuaran su andadura en este planeta minúsculo, situado en la periferia de la galaxia que comparado al conjunto de esta, es solo una cuota de polvo donde unos insignificantes seres laboriosos, curiosos y osados, son conscientes de estar allí y están pretendiendo determinar las leyes, no ya de su mundo o de su galaxia, sino que su osadía ilimitada les lleva a pretender conocer el destino de todo el Universo.

Cuando a solas pienso en todo esto, la verdad es que no me siento nada insignificante y nada humilde ante la inmensidad de los cielos. Las estrellas pueden ser enormes y juntas, formar inmensas galaxias… pero no pueden pensar ni amar; no tienen curiosidad ni en ellas está el poder de ahondar en el porqué de las cosas, nosotros si podemos hacer todo eso y más.

La estructura de los átomos y las moléculas está controlada casi por completo por dos números: la razón entre las masas del electrón y el protón b, que es aproximadamente igual a 1/1.836, y la constante de estructura fina a, que es aproximadamente 1/137. Supongamos que permitimos que estas dos constantes cambien su valor de forma independiente y supongamos también (para hacerlo sencillo) que ninguna otra constante de la Naturaleza cambie. ¿Qué le sucede al mundo si las leyes de la naturaleza siguen siendo las mismas?

Si deducimos las consecuencias pronto encontramos que no hay muchos espacios para maniobrar. Incrementemos b demasiado y no puede haber estructuras moleculares ordenadas porque es el pequeño valor de Beta (aF) el que asegura que los electrones ocupen posiciones bien definidas alrededor de un núcleo atómico y las cargas negativas de los electrones igualan las cargas positivas de los protoneshaciendo estable el núcleo y el átomo.

Si en lugar de a versión b, jugamos a cambiar la intensidad de la fuerza nuclear fuerte aF, junto con la de a, entonces, a menos que aF > 0,3 a½, los elementos como el carbono no existirían.

No podrían existir químicos orgánicos, no podrían mantenerse unidos.Si aumentamos aF en solo un 4 por 100, aparece un desastre potencial porque ahora puede existir un nuevo núcleo de helio, el helio-2, hecho de 2 protones y ningún neutrón, que permite reacciones nucleares directas y más rápidas que de protón + protón → helio-2.

Las estrellas agotarían rápidamente su combustible y se hundirían en estados degenerados o en agujeros negros. Por el contrario, si aF decreciera en un 10 por 100, el núcleo de deuterio dejaría de estar ligado y se bloquearía el camino a los caminos astrofísicos nucleares hacia los elementos bioquímicos necesarios para la vida

Hasta donde sabemos, en nuestro Sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas que llegaran a poder cristalizar los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono… Si miramos por ahí, encontraremos múltiples noticias como estas:

Telescopio Spitzer de la NASA ha detectado los pilares de la vida en el universo distante, aunque en un entorno violento. Ha posado su poderoso ojo infrarrojo en un débil objeto situado a una distancia de 3.200 millones de años luz (recuadro), Spitzer ha observado la presencia de agua y moléculas orgánicas en la galaxia IRAS F00183-7111.

Sólo hemos visto las formas de vida presentes en la Tierra pero… Tiempo al Tiempo

Como podemos ver, amigos míos, la vida, como tantas veces vengo diciendo aquí, pulula por todo el Universo en la inmensa familia galáctica compuesta por más de ciento veinticinco mil millones y, de ese número descomunal, nos podríamos preguntar: ¿Cuántos mundos situados en las zonas habitables de sus estrellas habrá y, de entre todos esos innumerables mundos, cuántos albergaran la vida?

A muchos les cuesta trabajo admitir la presencia de vida en el universo como algo natural, ellos abogan por la inevitabilidad de un universo grande y frío en el que es difícil la aparición de la vida. Yo (como muchos otros), estoy convencido de que la vida es, de lo más natural en el universo y estará presente en miles de millones de planetas que, como la Tierra, tienen las condiciones para ello. Una cosa no se aparta de mi mente, muchas de esas formas de vida, serán como las nuestras aquí en la Tierra y estarán también, basadas en el Carbono. Sin embargo, no niego que puedan existir otras formas de vida diferentes a las terrestres.

emilio silvera

Abr

13

Contra esto no podemos luchar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El administrador jefe de la NASA, Charles Bolden, señaló en su comparecencia en la Comisión de Ciencias en el Congreso de Estados Unidos, que solo cabe rezar si un asteroide se dirigiera a Nueva York.

La realidad es que no tenemos medio de frenar la catástrofe

“Un asteroide de unos 17 metros de diámetro explotó el pasado 15 de febrero sobre Chelyabinsk, Rusia, generando ondas de choque que rompieron ventanas y dañaron edificios. Más de 1.500 personas resultaron heridas.”

Este nos pasó cerca entre la Tierra y la Luna

Más tarde, ese mismo día, un asteroide más grande descubierto el año pasado pasó a solo 27.681 kilómetros de la Tierra, más cerca que los satélites de telecomunicaciones que rodean el planeta. Para Bolden, estos eventos “sirven como prueba de que vivimos en un sistema solar activo, con objetos potencialmente peligrosos que pasan por nuestro vecindario con una frecuencia sorprendente”.

Tenemos suerte de que tengamos ahí el planeta Júpiter que atrae a la mayoría y nos sirve de escudo.

“Tuvimos la suerte de que los acontecimientos del mes pasado fueran simplemente una coincidencia interesante en lugar de una catástrofe”, dijo (en su momento) el presidente del Comité, Lamar Smith, republicano de Texas, quien convocó la audiencia para saber qué se está haciendo y cuánto dinero se necesita para proteger mejor el planeta.

Visita de Apophis, el Dios del Caos

La NASA ha encontrado y sigue de cerca un 95 por ciento de los objetos más grandes que vuelan cerca de la Tierra, los que tienen 1 kilómetro o más de diámetro. ”Un asteroide de ese tamaño, de un kilómetro o más grande, probablemente podría acabar con la civilización”, dijo John Holdren, asesor científico de la Casa Blanca, a los legisladores en la misma audiencia.

Potenciales asesinos de ciudades

Sin embargo, sólo se conoce aproximadamente el 10 por ciento de una estimación de 10.000 potenciales asteroides “asesinos de ciudades”, aquellos con un diámetro de 50 metros, añadió Holdren. En promedio, se estima que los objetos de ese tamaño llegan a la Tierra alrededor de una vez cada 1.000 años. ”A partir de la información que tenemos, no sabemos de ningún asteroide que amenace la población de los Estados Unidos”, dijo Bolden. “Pero si viene en tres semanas, recen”.

Además de la intensificación de sus esfuerzos de vigilancia y la creación de alianzas internacionales, la NASA está considerando el desarrollo de tecnologías para desviar un objeto que puede estar en un curso de colisión con la Tierra.

El asteroide que explotó sobre Rusia el mes pasado fue el objeto más grande que chocó con la atmósfera de la Tierra desde el evento de Tunguska en 1908, cuando un asteroide o un cometa explotó sobre Siberia, arrasando 80 millones de árboles en más de 2.150 kilómetros cuadrados como arriba podéis ver. La onda expansiva dio la vuelta al mundo y fue recogida por todos los sismógrafos.

Los dinosaurios reinaron en la Tierra 150 millones de años. Hace 65 millones que les cayó encima un pedrusco enorme, cayço en el Yucatán (México), y, según parece acabó con ellos. Aquel acontecimiento, aunque parezca negativo, posibilitó que hoy, estemos nosotros aquí.

Claro que, el suceso, podría caer en cualquier parte del mundo y, los americanos ¡tan suyos ellos! se empeñan en que todo pase en Nueva York… Aunque sea una catástrofe. Con tal de hacer una película son capaces de cualquier cosa.

¡Qué suerte hemos tenido hasta el momento presente!

emilio silvera

Totales: 75.624.527

Totales: 75.624.527 Conectados: 65

Conectados: 65