Jun

20

¿La Física? ¡La llave del Futuro!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Pensador y la Rosa

El poderoso hombre sabio, ordenó al empleado que, cada mañana, le pusiera una rosa fresca, recién cortada del rosal, en un vaso de agua en su mesa de escritorio. Después de un frugal desayuno, se sentaba delante de ella y, la contemplaba durante horas.

El viejo criado, extrañado de tal actitud e3e su jefe, que durante tanto tiempo contemplaba y disfrutaba del olor y el color de la bella flor, le preguntó:

¿Qué es lo que busca cada día en la rosa?

Levantando levemente su mirada, lo contempló un momento y contestó:

Amigo mío, trato de encontrar las respuestas de cómo la Naturaleza ha podido construir algo tan bello, sin ser tan grande como una galaxia es igual a ella, está hecha de sencillos átomos que se han puesto de acuerdo para conformar una estructura compleja que nos delita durante su efímera vida.

Alguna vez he leído alguna historia en las que había hadas en el frondoso jardín. Es cierto, no existen pruebas de que así pudiera ser. Sin embargo, tampoco las hay de que no las haya, y, el hecho cierto de que nosotros, los humanos, no la hayamos podido ver, no es prueba de su inexistencia. Hay que tener una imaginación abierta a todo y, de esa manera, evitamos sobresaltos y sorpresas inesperadas que, dicho sea de paso, pueden estar a cada paso que damos. El Universo es eso, un océano de maravillosas sorpresas que nos habla del comportamiento de las grandes energías y de la materia, unas veces disfrazada de estrella, otras de emisiones gamma y no en pocas ocasiones de agujeros negros y púlsares.

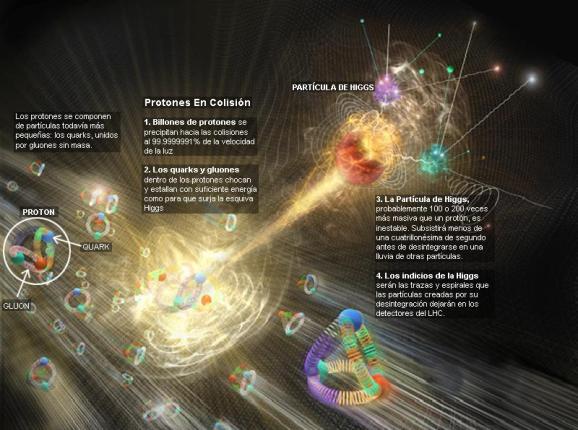

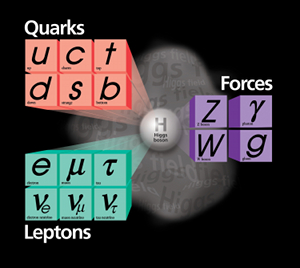

El modelo estándar de partículas fundamentales y sus interacciones

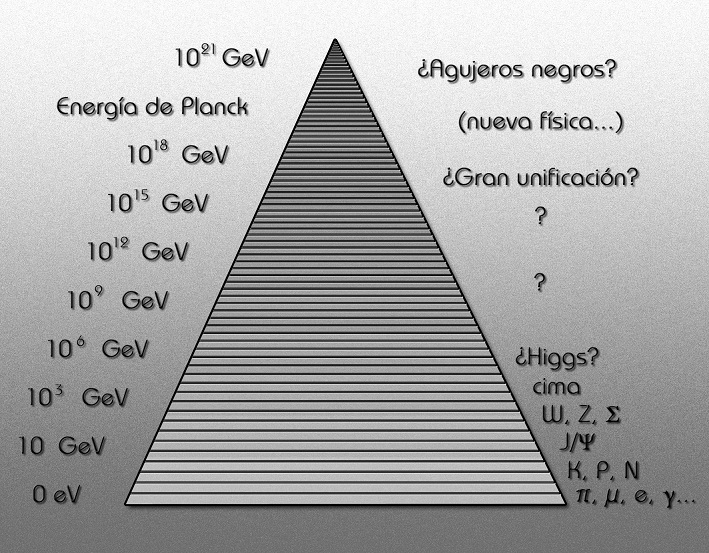

Esta imagen representa todo lo que conocemos, y que se ha podido verificar experimentalmente, sobre la estructura de la materia de la que estamos hechos nosotros y todo lo que hasta ahora hemos observado en el universo, con el nivel de precisión que podemos alcanzar utilizando los instrumentos que tenemos.

Equilibrio, estabilidad: el resultado de dos fuerzas contrapuestas que en el átomo están presentes

Por ahí deambula uno de mis trabajos sobre este mismo tema que titulé ¡La perfección imperfecta! En referencia al Modelo Estándar que no incorpora la Gravedad, y, se ha construido un edificio que nos habla de cómo funciona el universo y, sin embargo, le falta uno de sus pilares, precisamente, ese que nos dice como es su geometría espacial en presencia de grandes masas.

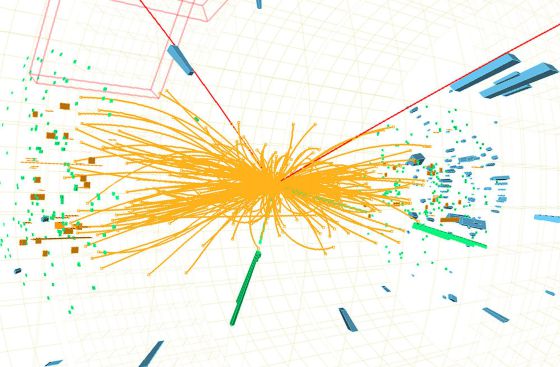

“Colisión del Bosón de Higgs desintegrándose en fermiones”. Primeras evidencias de un nuevo modo de desintegración del bosón de Higgs. Las primeras evidencias de la desintegración del recién descubierto bosón de Higgs en dos partículas denominadas tau, pertenecientes a la familia de partículas que compone la materia que vemos en el Universo. Hasta ahora los experimentos del LHC habían detectado la partícula de Higgs mediante su desintegración en otro tipo de partículas denominadas bosones, portadoras de las fuerzas que actúan en la Naturaleza, mientras las evidencias de desintegraciones en fermiones no eran concluyentes. Esta es la primera evidencia clara de este nuevo modo de desintegración del bosón de Higgs.”

La regla universal en la física de partículas es que cuando las partículas chocan con energías cada vez mayores, los efectos de las colisiones están determinados por estructuras cada vez menores, más pequeñas en el espacio y en el tiempo. Supongamos por un momento que tenemos a nuestra disposición un Acelerador de Partículas 10.000 veces más potente que el LHC, donde las partículas pueden adquirir esas tantas veces más energías de las alcanzadas actualmente. Las colisiones que tendrían lugar nos dirían algo acerca de los detalles estructurales de esas partículas que ahora no conocemos, que serían mucho más pequeñas que las que ahora podemos contemplar.

Ahora el LHC se prepara para nuevas aventuras y experimentos mayores, con mayores energías. ¿Podéis imaginar conseguir colisiones a 70.000 TeV? ¿Qué podríamos ver? Y, entonces, seguramente, podríamos oír en los medios la algarada de las protestas de algunos grupos: “Ese monstruo creado por el hombre puede abrir en el espacio tiempo agujeros de gusano que se tragará el mundo y nos llevará hacia otros universos”

Hoy el máximo de energía empleada ha sido de 14 TeV.

¿Justifica el querer detectar las partículas que conforman la “materia oscura”, o, verificar si al menos, podemos vislumbrar la sombra de las “cuerdas” vibrantes de esa Teoría del Todo, el que se gasten ingentes cantidades de dinero en esos artilugios descomunales? Bueno, a pesar de todos los pesares, la respuesta es que SÍ, el rendimiento y el beneficio que hemos podido recibir de los aceleradores de partículas, justifica de manera amplia todo el esfuerzo realizado, toda vez que, no solo nos ha llevado a conocer muchos secretos que la Naturaleza celosamente guardaba, sino que, de sus actividades hemos tenido beneficios muy directos en ámbitos como la medicina, las comunicaciones y otros que la gente corriente desconocen.

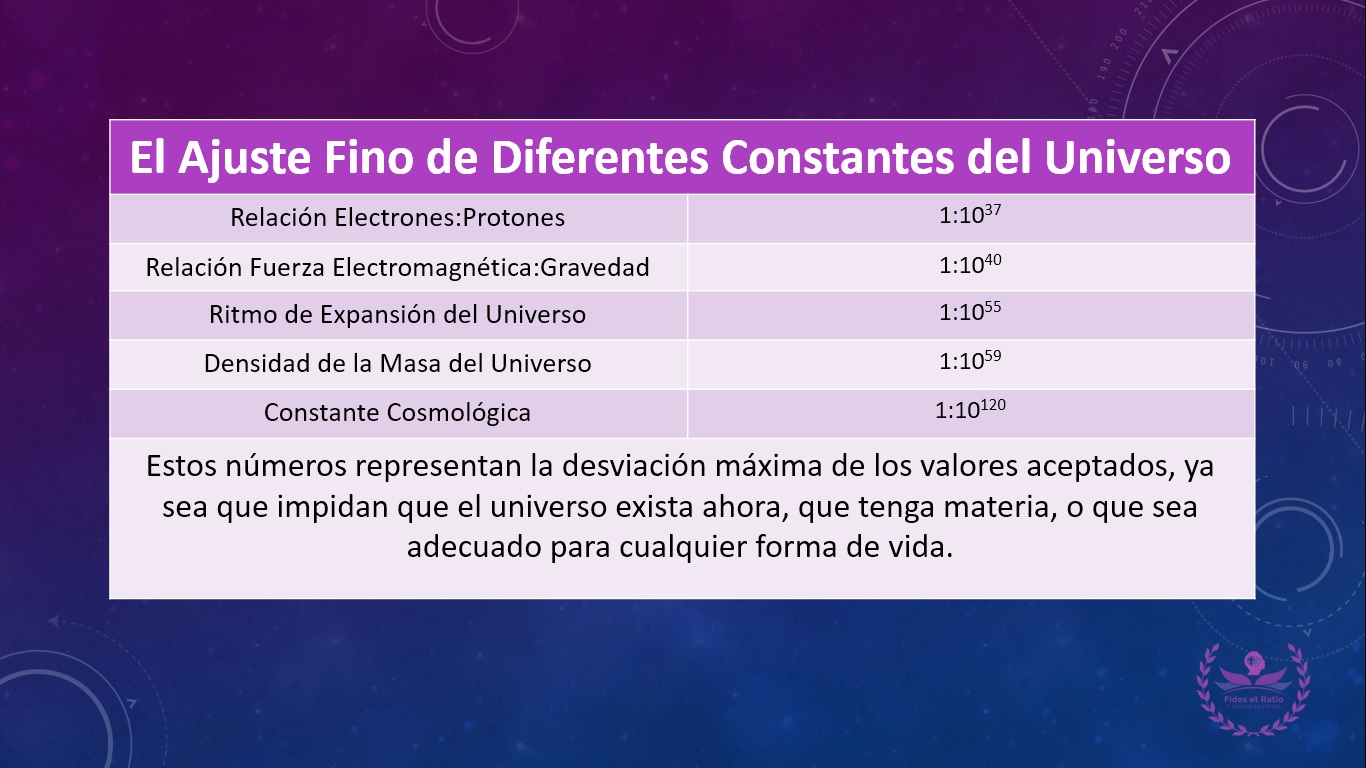

¿Implica el ajuste fino un diseño con propósito? ¿Hay tantos parámetros que deben tener un ajuste fino y el grado de ajuste fino es tan alto, que no parece posible ninguna otra conclusión?

Hoy, el Modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero tenemos algunas razones para sospechar que tales predicciones resultan estar muy alejadas de la realidad, o, incluso, ser completamente falsas. Cuando tenemos la posibilidad de llegar más lejos, con sorpresa podemos descubrir que aquello en lo que habíamos creído durante años, era totalmente diferente. El “mundo” cambia a medida que nos alejamos más y más de lo grande y nos sumergimos en ese otro “mundo” de lo muy pequeño, allí donde habitan los minúsculos objetos que conforman la materia desde los cimientos mismos de la creación.

Así el modelo que tenemos de la física de partículas se llama Modelo Estándar y, nos habla de las interacciones entre partículas y las fuerzas o interacciones que están presentes, las leyes que rigen el Universo físico y que, no hemos podido completar al no poder incluir una de las fuerzas: La Gravedad. Claro que, no es esa la única carencia del Modelo, tiene algunas más y, a estas alturas, se va necesitando un nuevo Modelo, más completo y audaz, que incluya a todas las fuerzas y que no tenga parámetros aleatorios allí donde nuestros conocimientos no llegan.

La fealdad del Modelo Estándar puede contrastarse con la simplicidad de las ecuaciones de Einstein, en las que todo se deducía de primeros principios. Para comprender el contraste estético entre el Modelo Estándar y la teoría de la relatividad general de Einstein debemos comprender que, cuando los físicos hablan de “belleza” en sus teorías, realmente quieren decir que estas “bellas” teorías deben poseer al menos dos características esenciales:

- Una simetría unificadora.

- La capacidad de explicar grandes cantidades de datos experimentales con las expresiones matemáticas más económicas.

E = mc2 . Esta es la mejor prueba de lo que decimos arriba.

El Modelo Estándar falla en ambos aspectos, mientras que la relatividad general los exhibe, ambos, de manera bien patente. Nunca una teoría dijo tanto con tan poco; su sencillez es asombrosa y su profundidad increíble.De hecho, desde que se publicó en 1.915, no ha dejado de dar frutas, y aún no se han obtenido de ella todos los mensajes que contiene.

El principio director del modelo estándar dicta que sus ecuaciones son simétricas. De igual modo que una esfera ofrece el mismo aspecto desde cualquier punto de vista, las ecuaciones del modelo estándar subsisten sin variación al cambiar la perspectiva desde la que son definidas. Las ecuaciones permanecen invariables, además, cuando esta perspectiva se desplaza en distinta magnitud a diferentes puntos del espacio y el tiempo.

Al contrario de la relatividad general, la simetría del Modelo Estándar, está realmente formada empalmando tres simetrías más pequeñas, una por cada una de las fuerzas; el modelo es espeso e incómodo en su forma. Ciertamente no es económica en modo alguno. Por ejemplo, las ecuaciones de Einstein, escritas en su totalidad, sólo ocupan unos centímetros y ni siquiera llenaría una línea de esta página. A partir de esta escasa línea de ecuaciones, podemos ir más allá de las leyes de Newton y derivar la distorsión del espacio, el Big Bang y otros fenómenos astronómicos importantes como los agujeros negros. Por el contrario, sólo escribir el Modelo Estándar en su totalidad requeriría, siendo escueto, un par de páginas y parecería un galimatías de símbolos complejos sólo entendibles por expertos.

Los científicos quieren creer que la naturaleza prefiere la economía en sus creaciones y que siempre parece evitar redundancias innecesarias al crear estructuras físicas, biológicas y químicas.

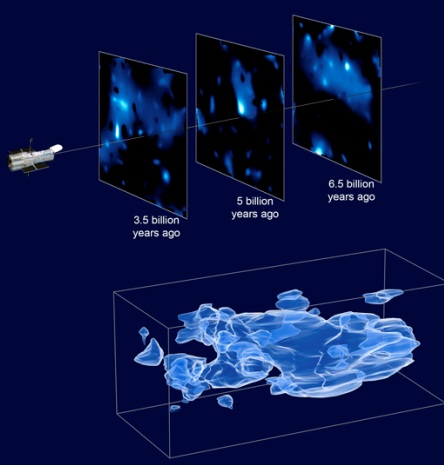

La primera luz del Universo

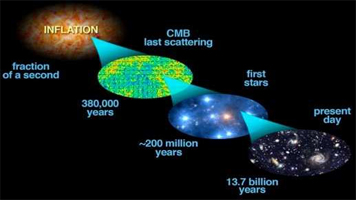

La luz antigua absorbida por átomos de hidrógeno neutro podría usarse para probar ciertas predicciones de la Teoría de Cuerdas, dicen los cosmólogos de la Universidad de Illinois. Realizar tales medidas, sin embargo, requeriría que se construyese un gigantesco conjunto de radio telescopios en la Tierra, el espacio, o la Luna.

El matemático francés Henri Poincaré lo expresó de forma aún más franca cuando escribió: “El científico no estudia la Naturaleza porque es útil; la estudia porque disfruta con ello, y disfruta con ello porque es bella”

E. Rutherford, quien descubrió el núcleo del átomo (entre otras muchas cosas), dijo una vez: “Toda ciencia es o física o coleccionar sello”.Se refería a la enorme importancia que tiene la física para la ciencia, aunque se le olvidó mencionar que la física está sostenida por las matemáticas que la explica.

Pero, a pesar de todos sus inconvenientes, el Modelo Estándar, desde su implantación, ha cosechado un éxito tras otro, con sus inconvenientes y sus diecinueve parámetros aleatorios, lo cierto es que es lo mejor que tenemos por el momento para explicar las familias de partículas que conforman la materia y cómo actúan las fuerzas de la naturaleza, todas las fuerzas menos la gravedad; esa nos la explica a la perfección y sin fisuras las ecuaciones de Einstein de la relatividad general.

Hace tiempo que los físicos tratan de mejorar el Modelo Estándar con otras teorías más avanzadas y modernas que puedan explicar la materia y el espacio-tiempo con mayor amplitud y, sobre todo, incluyendo la gravedad. Así que retomando la teoría de Kaluza de la quinta dimensión, se propuso la teoría de supergravedad en 1.976 por los físicos Daniel Freedman, Sergio Ferrara y Peter van Nieuwenhuizen, de la Universidad del Estado de Nueva York en Stoney Brook que desarrollaron esta nueva teoría en un espacio de once dimensiones.

Para desarrollar la super-teoría de Kaluza-Klein en once dimensiones, uno tiene que incrementar enormemente las componentes del interior del Tensor métrico de Riemann (que Einstein utilizó en cuatro dimensiones, tres de espacio y una de tiempo para su relatividad general y más tarde, Kaluza, añadiendo otra dimensión de espacio, la llevó hasta la quinta dimensión haciendo así posible unir la teoría de Einstein de la gravedad, con la teoría de Maxwell del electromagnetismo), que ahora se convierte en el supertensor métrico de Riemann.

Hasta hoy, no se ha logrado, ni mucho menos, inventar una teoría de campo consistente totalmente unificadora que incluya la gravedad. Se han dado grandes pasos, pero las brechas «científicounificantes» siguen siendo amplias. El punto de partida ha sido siempre la teoría de la relatividad general y conceptos con ella relacionados, por la excelencia que manifiesta esa teoría para explicar la física gravitatoria macrocósmica. El problema que se presenta surge de la necesidad de modificar esta teoría sin perder por ello las predicciones ya probadas de la gravedad a gran escala y resolver al mismo tiempo los problemas de la gravedad cuántica en distancias cortas y de la unificación de la gravedad con las otras fuerzas de la

naturaleza.

Su tensor métrico es un tensor de rango 2 que se utiliza para definir … Sin embargo, en otras teorías se ha elevado el rango y se pueden definir múltiples universos de dimensiones más altas.

Tensor métrico de Riemann

El tensor métrico se podría adaptar a las necesidades de la búsqueda estableciendo la multiplicidad de dimensiones que la teoría exigía para su desarrollo.

Más allá de lo que nos permiten captar nuestros sentidos físicos, hay que tener nuestra mente abierta a la posibilidad de que puedan existir otras realidades diferentes a lo que nos dicta nuestra experiencia, realidades capaces de ser descubiertas por la fuerza del intelecto cuando nos atrevemos a cuestionar aquello que creíamos como absoluto.

Esta nueva teoría de super-gravedad pretendía la unificación de todas las fuerzas conocidas con la materia, y, como en un rompecabezas, encajarlas en el Tensor de Riemann tan solo con elevar el número de dimensiones que exigía más componentes y nos daba el espacio necesario para poder ubicar en sus apartados correspondientes, todas las fuerzas fundamentales y también la materia, la que podía satisfacer, casi en su totalidad, el sueño de Einstein.

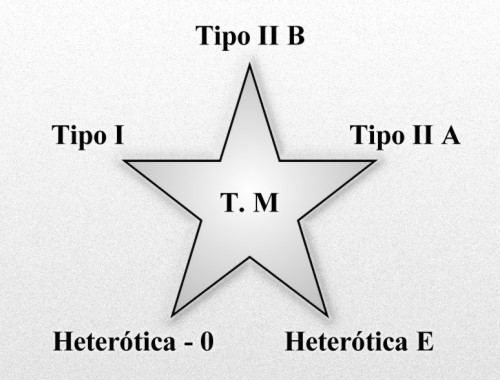

A partir de aquí, de estas ecuaciones, surgió todo. Este fue el puerto de donde salió el bajel de la de Kaluza-Gleim, la supergravedad y supersimetría, la cuerda heterótica y la Teoría de cuerdas, todo ello, rematado con la finalmente expuesta, teoría M.

La supergravedad casi consigue satisfacer el sueño de Einstein de dar una derivación puramente geométrica de todas las fuerzas y partículas del universo. Al añadir la supersimetría al Tensor métrico de Riemann, la métrica se duplica en tamaño, dándonos la supersimetría de Riemann. Las nuevas componentes del súper tensor de Riemann corresponden a quarks y leptones, casi todas las partículas y fuerzas fundamentales de la naturaleza: la teoría de la gravedad de Einstein, los campos de Yang-Mills y de Maxwell y los quarks y leptones. Pero el hecho de que ciertas partículas no estén en esta imagen nos obliga a buscar un formalismo más potente:

La materia con todas las fuerzas fundamentales de la naturaleza. Los bosones intermediarios o partículas portadoras de las fuerzas como el fotón para el electromagnetismo, los gluones para la fuerza nuclear fuerte, las partículas W y Z para la nuclear débil y, en la partícula portadora de la gravedad, el gravitón, ponemos el signo de interrogación, ya que se sabe que esta ahí en algún sitio pero hasta la fecha no ha sido detectado.

Fermilab

Antes de continuar con la teoría de súper cuerdas, o con su versión más avanzada la teoría M, parece conveniente recordar que hasta el momento los ladrillos del universo eran los quarks, las partículas más pequeñas detectadas en los aceleradores del CERN y FERMILAB. Pero ¿están hechos de cosas más pequeñas?, eso no lo sabemos. El Modelo Estándar, menos avanzado que las otras teorías, nos dice que los quarks son las partículas más pequeñas y forman protones y neutrones constituyendo la formación interna del átomo, el núcleo. En la actualidad, nuestros aceleradores de partículas no tienen capacidad para ahondar más allá de los quarks y averiguar si a su vez, éstos están formados por partículas aún más pequeñas.

No podemos saber (aún) que es lo que pueda haber (si es que lo hay) más allá de los Quarks, los constituyentes de la materia más pequeños conocidos hasta el momento actual. Sin embargo, no se descarta que puedan existir partículas más simples dentro de los Quarks que, al fin y al cabo, no serían tan elementales.

Por otro lado, los físicos están casi seguros de que los leptones no están compuestos de partículas más pequeñas. Sin embargo, esta sospecha no se tiene en el caso de los quarks; no se sabe qué puede haber detrás de ellos. Tan sólo se ha llegado a desconfinarlos junto con los gluones y por un breve periodo de tiempo de los protones y neutrones que los mantenían aprisionados, formando – en esos breves instantes – una materia plasmosa. No es raro oir dentro de la comunidad científica a los físicos teóricos hablando de prequarks.

Como antes hemos comentado de pasada, el Modelo Estándar agrupa las partículas en familias:

Fermiones y Bosones

Cada leptón grande, es decir, el electrón, el muón y el tau, tiene un primo pequeño. Así el electrón tiene un neutrino electrónico, el muón un neutrino muónico y el tau un neutrino tau. Como se puede ver en la tabla anterior la única diferencia entre el electrón, el muón y el tau es la masa, que va creciendo. Todos tienen carga eléctrica negativa. Los neutrinos en cambio no tienen carga y tienen una masa muy pequeña (pero tienen y es una de las razones por la que se dice que los neutrinos cambian de sabor, es decir cuando salen, por ejemplo, del sol salen en forma de neutrinos electrónicos pero cuando los detectamos en la tierra, vemos que llegan menos neutrinos electrónicos de los que deberían, porque durante el viaje han cambiado de sabor y se han convertido en neutrinos muónicos o tau).

Los bariones se componen de tres quarks o tres anti-quarks. En este último caso se denominan anti-bariones.

Los mesones se componen de dos quarks y obligatoriamente uno es un quark y el otro un anti-quark.

Claro, son muchos más. Además de los Bariones, también forman parte de la familia hadrónica los mesones y la lista de unos y otros es larga y cada individuo, como es natural, tiene sus propias características que lo hacen único.

Se llaman bosones porque, al contrario que los fermiones, éstos obedecen la estadística de Bose-Einstein que dice que pueden existir en el mismo estado cuántico muchas bosones al mismo tiempo (recordad que en el caso de los fermiones sólo podía haber dos en el mismo estado cuántico). Algunos bosones tienen la peculiaridad de que son los portadores de las fuerzas fundamentales de la naturaleza, es decir, cada vez que ocurre una interacción entre dos partículas, lo que realmente ocurre es que intercambian un bosón. Estas fuerzas son el electromagnetismo, la fuerza débil y la fuerza fuerte (vienen a continuación). Existe otro bosón, aunque sólo a nivel teórico, conocido como el gravitón que sería el responsable de la fuerza gravitatoria. La fuerza gravitatoria no está explicada por el modelo estándar y por lo tanto el gravitón, no forma parte del mismo.

La fuerza débil es la responsable de las desintegraciones radiactivas, es decir, que una partícula se convierta en otra a través de la emisión de una o más partículas adicionales. Esta interacción es mediada por los bosones W+, W- y Z0. Estos bosones tienen la particularidad de que tienen masa, al contrario que el resto de bosones.

La fuerza fuerte hace que los quarks que componen los núcleos atómicos se mantengan unidos y no se rompan espontáneamente. El bosón encargado de hacer esto es el gluón.

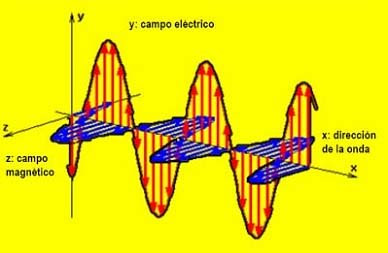

La fuerza electromagnética es la que más conocemos todos, ya que se compone de la fuerza eléctrica y la fuerza magnética (en realidad es una única fuerza que se manifiesta de dos maneras diferentes, de ahí que reciba el nombre de fuerza electromagnética). El bosón portador de esta fuerza es el fotón. Nuestra experiencia diaria se basa principalmente en sufrir los efectos de esta fuerza y cada vez que vemos la luz, sentimos calor, calentamos la comida en el microondas, etc., lo que estamos haciendo es interaccionar con fotones de diversas energías.

Interacciones entre partículas

En la imagen de la izquierda se representa como un neutrón se desintegra para dar un protón, un electrón y un antineutrino electrónico. Esta desintegración es conocida como desintegración beta.

En la imagen central se muestra la colisión entre un electrón y un positrón que da lugar a una desintegración de materia en energía pura, otra vez a través de la ecuación de Einstein E=mc2. La energía se convierte, por la misma ecuación, otra vez en otras partículas diferentes. En este caso se forma un mesón B0 y un anti-mesón B0.

Por último, en la imagen de la derecha aparece la colisión de dos protones (como los que ocurren en el LHC del CERN) para dar lugar a dos bosones Z0 y varios hadrones, es decir, varias partículas compuestas de diferentes quarks (mesones y bariones).

… Han dejado fuera del Modelo estándar a la Gravedad que se resiste a estar junto a las otras tres fuerzas. Así, continúan persiguiendo ese sueño llamado… ¡Teoría cuántica de la gravedad o Gravedad cuántica!

Y describe las interacciones que estas partículas tienen con las cuatro fuerzas fundamentales de la naturaleza, sobre todo con las nucleares fuerte y débil y la electromagnética; la gravedad se queda aparte del Modelo Estándar, ya que su incidencia con las partículas elementales es inapreciable como consecuencia de las infinitesimales masas de éstas, y ya sabemos que la gravedad se deja sentir y se hace presente cuando aparecen las grandes masas como planetas, estrellas y galaxias.

Grandes estructuras que vienen a ser como pequeños ”universos islas” en los que podemos estudiar, a menos tamaño, todo lo que en el Gran Universo puede pasar. Partiendo de la base de que las leyes del universo son las mismas en todas partes, podemos tomar cualquier región del mismo y ver que, allí está ocurriendo lo mismo que aquí ocurre, es decir, están presentes las fuerzas fundamentales: nucleares débiles y fuertes, electromagnetismo y Gravedad y, todo, absolutamente todo, funciona al ritmo que dichas leyes nos marcan.

Como el Modelo Estándar es limitado, los físicos buscan desesperadamente nuevas teorías que puedan corregir y perfeccionar este modelo. Así aparecieron las teorías de súper simetría, súper gravedad, súper cuerdas, y ahora por último, la teoría M propuesta por Edward Witten en 1.995 y que nos quiere explicar, de manera más perfecta, el universo desde su origen, cómo y por qué está conformado ese universo, las fuerzas que lo rigen, las constantes de la naturaleza que establecen las reglas, y todo ello, a partir de pequeños objetos infinitesimales, las cuerdas, que sustituyen a las partículas del modelo estándar que creíamos elementales.

Esas partículas súper simétricas que pronostican algunas teorías, aún no han sido observadas y se espera que en el LHC puedan aparecer algunas que, desde luego, si así ocurre, sería un buen adelanto para conocer el mundo que nos acoge y la Naturaleza del Universo.

Esta nueva teoría, permite además, unificar o incluir la gravedad con las otras fuerzas, como teoría cuántica de la gravedad, todo ello mediante una teoría estructurada y fundamentada con originalidad y compactificación de las cuatro fuerzas de la naturaleza y dejando un gran espacio matemático para eliminar anomalías o perturbaciones, y se propugna con coherencia quela cuerda es el elemento más básico de la estructura de la materia; lo que estaría bajo los quarks serían unas diminutos círculos semejantes a una membrana vibrante circular y de diferentes conformaciones.

Universos Paralelos, Teorías de Cuerdas, Súper gravedad, La Teoría M, y ¿Los pensamientos de la Mente, podrán dar para tanto?

Una vez se escucha sobre los fundamentos de la teoría cuántica uno no puede mas que sobrecogerse, ampliar la mente y galopar entre las múltiples posibilidades acerca de lo real e imaginario que por momentos y depende que conceptos se entrelazan intercambiables. Lo que llama la atención es que por mucho que hayan sido los físicos cuánticos más prestigiosos entre la sociedad científica los que hayan puesto sobre la mesa conceptos cuanto menos rimbombantes e inverosímiles como las multi-dimensiones, los universos paralelos, los efectos túneles y demás, sean los propios miembros de la academia los que grandilocuentemente se ofenden cuando se hace alusión al paralelismo evidente del comportamiento y extensión de la energía en referencia al universo preconizado por los místicos de muchas culturas. No tenemos los conocimientos necesarios para poder decir que no a esto o aquello, cada cosa tiene su lugar y tendremos que analizarlas muy a fondo y adentrarnos en esos mundos de misterio para poder decidir lo que es y lo que no puede ser.

Aquí hemos llegado a una región de la Física de las partículas donde la energía (por partícula) es mucho mayor de la que actualmente podemos estudiar en nuestros laboratorios. Claro que especulamos, pero con los datos de los que disponemos, la realidad estará muy cerca de la expuesta en el gráfico, y, en él se señalan energía que no están a nuestro alcance para conseguir lo que se quiere saber.

Ed Witten, en su trabajo, presentó amplias evidencias matemáticas de que las cinco teorías obtenidas de la primera revolución, junto con la más reciente conocida como la súper gravedad (súper cuerda después), en 11 dimensiones, eran de hecho parte de una teoría inherentemente cuántica y no perturbativa conocida como teoría M. Las seis teorías están conectadas entre sí por una serie de simetrías de dualidad T, S, y U. Además, de la teoría propuesta por Witten se encuentran implícitas muchas evidencias de que la teoría M no es sólo la suma de las partes, sino que se vislumbra un alentador horizonte que podría concluir como la teoría definitiva tan largamente buscada.

Los resultados de la segunda revolución de las súper cuerdas han demostrado que las cinco teorías de cuerdas forman parte de un solo marco unificado, llamado Teoría M.

Las súper cuerdas, en realidad, sólo es otra manera utilizada por los científicos a la búsqueda de la verdad que la Humanidad necesita y reclama para continuar con su propia evolución que, sin esos conocimientos, quedaría estancada.

Como se puede ver, las partículas implicadas en el Modelo Estándar están en un mundo microscópico de 10-17cm que sí dominan nuestros aceleradores, mientras que la cuerda está en una distancia de 10-33 cm que les está prohibida, allí no podemos llegar, no disponemos de la energía suficiente para ello.

Igual que con la energía disponible por el momento, nos pasa con las distancias, que también nos tiene paralizados en nuestros deseos de visitar mundos lejanos, no podemos, al no disponer de los medios necesarios para poder soslayar las distancias de tantos años-luz como tendríamos que recorrer. ¿Habrá otro camino?

Está muy claro para los físicos que, aunque teóricamente, en la Teoría de Súper cuerdas se pueden unir todas las fuerzas, todavía tenemos que seguir sosteniendo que la gravedad resulta una fuerza solitaria para todos los efectos, ya que ha resistido todos los intentos para saber, con certeza, si finalmente se podrá unir a las otras fuerzas de la Naturaleza. La gravedad está descrita por la teoría de la relatividad general de Einstein y tiene una naturaleza esencialmente geométrica. Se entiende como la curvatura del espacio-tiempo alrededor de un objeto masivo. En los gráficos, generalmente, se representa como un objeto pesado sobre una superficie fina y tensa (una pelota o bola pesada de jugar a los bolos que dejamos encima de una sábana extendida tirando de las cuatro esquinas). El peso de la bola (materia) hundirá la sábana (espacio-tiempo) con mayor intensidad en la distancia más cercana a donde se encuentre masa.

El espacio tiempo se distorsiona allí donde residen objetos pesados como los planetas, las estrellas, galaxias y cualesquiera otros cuerpos masivos.

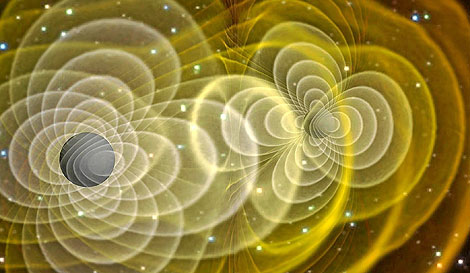

La teoría de Einstein goza de una amplia aceptación debido a los aciertos macroscópicos que han sido verificados de manera experimental. Los más recientes están referidos a los cambios de frecuencia de radiación en púlsares binarios debido a la emisión de ondas gravitacionales, que actualmente estudia Kip S. Thorne, en relación a los agujeros negros. Entre las predicciones que Einstein propugna en su teoría se encuentran, por ejemplo, la existencia de ondas gravitacionales, que el universo está en constante expansión y que, por lo tanto, tuvo un inicio: el Big Bang o los agujeros negros.

Se trata de regiones donde la gravedad es tan intensa que ni siquiera la luz puede escapar de su atracción. Estas regiones se forman por el colapso gravitatorio de estrellas masivas en la etapa final de su existencia como estrella, acabado el combustible nuclear y no pudiendo fusionar hidrógeno en helio, fusiona helio en carbono, después carbono en neón, más tarde neón en magnesio y así sucesivamente hasta llegar a elementos más complejos que no se fusionan, lo que produce la última resistencia de la estrella contra la fuerza de gravedad que trata de comprimirla, se degeneran los neutrones como último recurso hasta que, finalmente, la estrella explota en supernova lanzando al espacio las capaz exteriores de su material en un inmenso fogonazo de luz; el equilibrio queda roto, la fuerza de expansión que contrarrestaba a la fuerza de gravedad no existe, así que, sin nada que se oponga la enorme masa de la estrella supermasiva, se contrae bajo su propio peso, implosiona hacia el núcleo, se reduce más y más, su densidad aumenta hasta lo inimaginable, su fuerza gravitatoria crece y crece, hasta que se convierte en una singularidad, un lugar en el que dejan de existir el tiempo y el espacio.

Allí no queda nada, ha nacido un agujero negro y a su alrededor nace lo que se ha dado en llamar el Horizonte de Sucesos, que es una región del espacio, alrededor del agujero negro que una vez traspasada no se podrá regresar; cualquier objeto que pase esta línea mortal, será literalmente engullida por la singularidad del agujero negro. De hecho, el telescopio espacial Hubble, ha enviado imágenes captadas cerca de Sagitario X-1, en el centro de nuestra galaxia, donde reside un descomunal agujero negro que, en las fotos enviadas por el telescopio, aparece como atrapa la materia de una estrella cercana y se la engulle.

Ondas gravitacionales que se forman a partir de los agujeros negros que, en su dinámica cotidiana y que, actualmente, estamos tratando de captar para saber de un njhuevo Universo que nos diría muchas cosas de las que ocurren a partir de fenómenos que sabemos existen pero, que hasta el momento no hemos podido “leer”.

Esta es la fuerza que se pretende unir a la Mecánica Cuántica en la teoría de supercuerdas, es decir, que Einstein con su relatividad general que nos describe el cosmos macroscópico, se pueda reunir con Max Planck y su cuanto infinitesimal del universo atómico, lo muy grande con lo muy pequeño.

La llamada gravedad cuántica trata de fundir en una sola las dos teorías físicas más soberbias con las que contamos, la relatividad general y la mecánica cuántica, que en el estado actual de nuestro conocimiento parecen incompatibles. Su estudio, ahora mismo, es en algunos aspectos análogo a la física de hace cien años, cuando se creía en los átomos, pero se ignaraban los detalles de su estructura.

Hasta el momento, Einstein se ha negado a esta reunión y parece que desea caminar solo. Las otras fuerzas están presentes en el Modelo Estándar, la gravedad no quiere estar en él, se resiste.

De hecho, cuando se ha tratadode unir la mecánica cuántica con la gravedad, aunque el planteamiento estaba muy bien formulado, el resultado siempre fue desalentador; las respuestas eran irreconocibles, sin sentido, como una explosión entre materia y antimateria, un desastre.

Sin embargo, es preciso destacar que las nuevas teorías de súper-simetría, súper-gravedad, súper-cuerdas o la versión mas avanzada de la teoría M de Ed Witten, tienen algo en común: todas parten de la idea expuesta en la teoría de Kaluza-Klein de la quinta dimensión que, en realidad, se limitaba a exponer la teoría de Einstein de la relatividad general añadiendo otra dimensión en la que se incluían las ecuaciones de Maxwell del electromagnetismo.

Hasta hoy no se ha logrado, ni mucho menos, inventar una teoría de campo que incluya la gravedad. Se han dado grandes pasos, pero la brecha “científico-unificante” es aún muy grande. El punto de partida, la base, ha sido siempre la relatividad y conceptos en ella y con ella relacionados, por la excelencia que manifiesta esa teoría para explicar la física gravitatoria cósmica. El problema que se plantea surge de la necesidad de modificar esta teoría de Einstein sin perder por ello las predicciones ya probadas de la gravedad a gran escala y resolver al mismo tiempo el problema de la gravedad cuántica en distancias cortas y de la unificación de la gravedad con las otras fuerzas de la naturaleza. Desde la primera década del siglo XX se han realizado intentos que buscan la solución a este problema, y que han despertado gran interés.

Después de la explosión científica que supuso la teoría de la relatividad general de Einstein que asombró al mundo, surgieron a partir e inspiradas por ella, todas esas otras teorías que antes he mencionado desde la teoría Kaluza-Klein a la teoría M.

Esas complejas teorías cuánticas nos quieren acercar al misterio que encierra la materia: ¡el Espíritu de la Luz!

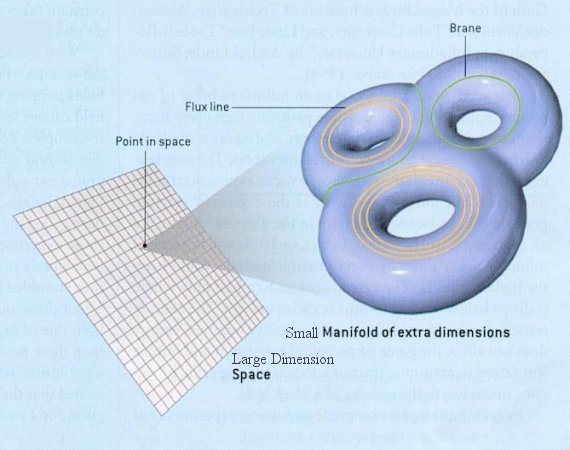

Es de enorme interés el postulado que dichas teorías expone. Es de una riqueza incalculable el grado de complejidad que se ha llegado a conseguir para desarrollar y formular matemáticamente estas nuevas teorías que, como la de Kaluza-Klein o la de supercuerdas (la una en cinco dimensiones y la otra en 10 ó 26 dimensiones) surgen de otra generalización de la relatividad general tetradimensional einsteniana que se plantea en cuatro dimensiones, tres espaciales y una temporal, y para formular las nuevas teorías se añaden más dimensiones de espacio que, aunque están enrolladas en una distancia de Planck, facilitan el espacio suficiente para incluir todas las fuerzas y todos los componentes de la materia, tratando de postularse como la Teoría de Todo.

Dimensiones enrolladas ¿En un espacio-tiempo fractal? La Naturaleza sabe de eso

La Gran Teoría Unificada que todo lo explique es un largo sueño acariciado y buscado por muchos. El mismo Einstein se pasó los últimos treinta años de su vida buscando el Santo Grial de la teoría del todo en la física, unificadora de las fuerzas y de la materia. Desgraciadamente, en aquellos tiempos no se conocían elementos y datos descubiertos más tarde y, en tales condiciones, sin las herramientas necesarias, Einstein no podría alcanzar su sueño tan largamente buscado. Si aún viviera entre nosotros, seguro que disfrutaría con la teoría de súper-cuerdas o la teoría M, al ver como de ellas, sin que nadie las llame, surgen, como por encanto, sus ecuaciones de campo de la relatividad general.

La fuerza de la Naturaleza, en el universo primitivo del Big Bang, era una sola fuerza y el estado de la materia es hoy conocido como “plasma”; las enormes temperaturas que regían no permitía la existencia de protones o neutrones, todo era como una sopa de quarks. El universo era opaco y estaba presente una simetría unificadora.

Más tarde, con la expansión, se produjo el enfriamiento gradual que finalmente produjo la rotura de la simetría reinante. Lo que era una sola fuerza se dividió en cuatro. El plasma, al perder la temperatura necesaria para conservar su estado, se trocó en quarks que formaron protones y neutrones que se unieron para formar núcleos. De la fuerza electromagnética, surgieron los electrones cargados negativamente y que, de inmediato, fueron atraídos por los protones de los núcleos, cargados positivamente; así surgieron los átomos que, a su vez, se juntaron para formar células y éstas para formar los elementos que hoy conocemos.

Después se formaron las estrellas y las galaxias que sirvieron de fábrica para elementos más complejos surgidos de sus hornos nucleares hasta completar los 92 elementos naturales que conforma toda la materia conocida. Existen otros elementos que podríamos añadir a la Tabla, pero estos son artificiales como el plutonio o el einstenio que llamamos transuranidos, es decir, más allá del uranio.

La materia ha evolucionado hasta límites increíbles: ¡la vida! y, aún no sabemos, lo que más allá pueda esperar.

¿Quizás hablar sin palabras, o, Incluso algo más

Estos conocimientos y otros muchos que hoy posee la ciencia es el fruto de mucho trabajo, de la curiosidad innata al ser humano, del talento de algunos y del ingenio de unos pocos, todo ello después de años y años de evolución pasando los descubrimientos obtenidos de generación en generación.

¿Cómo habría podido Einstein formular su teoría de la relatividad general sin haber encontrado el Tensor métrico del matemático alemán Riemann?

¿Qué formulación del electromagnetismo habría podido hacer James C. Maxwell sin el conocimiento de los experimentos de Faraday?

La relatividad especial de Einstein, ¿habría sido posible sin Maxwell y Lorentz?

¿Qué unidades habría expuesto Planck sin los números de Stoney?

Es cierto que nuestra imaginación es grande pero… No pocas veces ¡la realidad la supera!

emilio silvera

Jun

19

¿Por qué es difícil Viajar a Marte? I

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

¿Por qué es difícil ir a Marte?

Fotograma de la película ‘The martian’. AIDAN MONAGHAN

El estreno de la película ‘Marte’ (The Martian) ha despertado cierta curiosidad acerca de posibles futuros viajes humanos al planeta rojo. Después de haber ido a la Luna en varias ocasiones hace ya casi cinco décadas, y estando acostumbrados a ver astronautas viajar al espacio casi de forma rutinaria, es tentador pensar que enviar seres humanos a Marte pueda ser algo perfectamente plausible a día de hoy, o tal vez un tanto más complicado que lo hecho hasta ahora. Sin embargo, la realidad es que enviar seres humanos a Marte constituye un desafío de una dificultad y complejidad absolutamente descomunales que se aleja mucho de todo lo que se ha hecho hasta ahora en la historia de la exploración humana del espacio.

En esta y en la siguiente entrada hablaré de las razones por las que esta empresa constituye un desafío inmenso y sobre cómo se plantea en la actualidad una misión tripulada a Marte. Con objeto de ofrecer una perspectiva inicial para entender la dimensión del problema de una forma intuitiva, en esta entrada trataré de la razón principal que hace extremadamente difícil una misión a Marte, la razón de la que prácticamente se derivan casi todas las demás: la distancia.

Matt Damon in “The Martian.” Credit Aidan Monaghan/Twentieth Century Fox

Vemos astronautas viajar con frecuencia al espacio, a la Estación Espacial Internacional (ISS), antes a la estación Mir, a bordo de naves Soyuz, o antes a bordo del Transbordador Espacial, etc., y se suele tener la impresión de que el lugar al que se viaja en estas misiones es muy lejano; sin embargo, las altitudes típicas a las que estas estaciones y vehículos espaciales orbitan alrededor de la Tierra son de unos pocos cientos de kilómetros. La ISS, por ejemplo, orbita alrededor de la Tierra a una altitud que es equivalente a la distancia que hay en línea recta entre Madrid y Almería: unos 400 km. Esta región espacial a la que viajan los humanos de forma rutinaria está dentro de la conocida como ‘región de las órbitas bajas de la Tierra’, y técnicamente la llamamos LEO (del inglés Low Earth Orbit).

Comparativa entre orbitas bajas de la Tierra (arriba) y la distancia a escala entre la Tierra y la Luna (abajo).

Los viajes tripulados lunares implicaron viajar más allá de las órbitas LEO ya que la Luna orbita nuestro planeta a una distancia media de unos 380.000 km, lo que viene a ser unas 1.000 veces más lejos que las altitudes de estas órbitas bajas. Una tripulación y su nave se ponen en órbita alrededor de la Tierra poco después de su lanzamiento, mientras que la distancia a la Luna se cubría en las misiones Apolo en prácticamente 3 días.

En el caso de Marte la situación es muy diferente. Ir a Marte implica pasar de una misión geocéntrica a una centrada en el Sol, o heliocéntrica, lo que supone un salto enorme en las distancias involucradas. Aunque las distancias máxima y mínima entre la Tierra y Marte varían dentro de un cierto rango, la mínima distancia posible es de unos 55 millones de km y la máxima posible es de unos 400 millones de km.

Estas son distancias enormes en comparación a todo lo que se ha volado en misiones tripuladas al espacio hasta ahora. La distancia máxima a Marte viene a ser 1.000 veces mayor que la que hay entre la Tierra y la Luna, lo que viene a ser 1.000.000 de veces mayor que la distancia que separa la superficie terrestre de las órbitas LEO a las que se viaja normalmente.

Distancias aproximadas mínima y máxima posibles entre la Tierra y Marte. Como referencia, la distancia media de la Tierra a la Luna es de 380.000 km.

Sin necesidad de conocer nada más, los datos acerca de la distancia a Marte ya constituyen una buena pista para empezarnos a asomar a la magnitud del problema. Para apreciarlo mejor, y sin entrar en detalles relativos a métodos de propulsión o dinámica orbital, vamos a comparar en números redondos dos misiones tripuladas, una orbital alrededor de la Tierra para un solo tripulante y otra lunar de tres tripulantes, para hacernos una idea de la progresión en la masa necesaria de los cohetes involucrados para llevar a cabo estas misiones y entender el contexto de lo que supondrá una misión a Marte.

Empezamos con la primera misión orbital del Programa Mercury de principios de los ’60: la Mercury 6 de John Glenn. Aquí se precisó de un cohete Atlas de 120 toneladas y 29 metros de altura para poner en una órbita de 200 km de altitud media alrededor de la Tierra una masa útil de 1,2 toneladas formada por una cápsula Mercury con su único tripulante, el cual permaneció en el espacio 5 horas.

Veamos ahora lo que cambia la situación al tener a la Luna como destino unas 1.000 veces más lejos. En el caso del Apolo 17 -la última misión de exploración lunar-, su módulo de mando y servicio más su módulo lunar, sumando todo cerca de 50 toneladas, hubieron de ser lanzados a la Luna por el poderoso cohete Saturno V de unas 3.000 toneladas y de 110 metros de altura para una misión de una duración total de unos 12 días y medio en la que 2 de sus tripulantes permanecieron sobre la superficie lunar algo más de 3 días.

Cohete lunar Saturno V junto al cohete Atlas del Programa Mercury para un tripulante (Transbordador Espacial incluido como referencia). Fuente: http://historicspacecraft.com/.

Vemos así el salto cuantitativo necesario cuando queremos ir a otro mundo que está 1.000 veces más allá de las órbitas bajas de la Tierra tanto en la masa útil a lanzar (de 1,2 a 50 toneladas) como en el tamaño del cohete lanzador requerido (de 120 a 3.000 toneladas). Comparemos todo esto con una misión a Marte. Aquí la tripulación constará de 6 astronautas y su duración, tomando como ejemplo la oportunidad en 2037, sería de 174 días para la ida y 201 días para la vuelta, con una estancia de 539 días en Marte. Una estancia tan larga en Marte sería necesaria a la espera de que la posición relativa entre este planeta y la Tierra fuera óptima para el regreso con un mínimo gasto de combustible, lo que ahorra el envío de centenares de toneladas de combustible. Todo esto supone un total de 914 días, o 2 años y medio.

Como vemos, el salto entre la Luna y Marte es descomunal, ya que doblar la tripulación y extender la duración a cerca de 73 veces la de la misión lunar más larga, supone la necesidad de proveer y transportar cerca de 150 veces más suministros. Por otra parte, una mayor duración de viaje interplanetario supone la necesidad de proveer a la tripulación de mayor protección contra las radiaciones, lo que se consigue en parte añadiendo aún más masa, aunque este problema no está aún resuelto.

Otro problema de la larga duración es que las cosas se rompen a lo largo de tanto tiempo. O bien se tendrá que mejorar sustancialmente la durabilidad de los equipos o estos habrán de poder ser repuestos por recambios que también habrá que transportar, lo que implica una mayor masa. Las naves de carga que visitan la ISS pueden abastecerla de repuestos cuando algo se estropea a bordo pero esta opción no será posible en una misión a Marte.

Una vez dicho todo esto, al igual que cuesta más acelerar y frenar un camión que un turismo por tener el primero más masa, tengamos en cuenta que enviar más masa a Marte implica transportar también más combustible para acelerar toda esa carga hacia Marte, para frenarla a la llegada a ese planeta, y para volver a la Tierra desde allí; y pensemos que todo ese combustible (centenares de toneladas) también hay que lanzarlo al espacio inicialmente.

En total, para una misión a Marte se requerirá lanzar al espacio entre 850 y 1.250 toneladas. Esta es una cantidad enorme si tenemos en cuenta que la Ia ISS tiene una masa de unas 420 toneladas y que una nave con la que estamos familiarizados como el Transbordador Espacial solo podía enviar al espacio entre 15 y 25 toneladas aproximadamente, dependiendo de la altitud de la órbita final. El Ariane 5 es capaz de poner unas 20 toneladas en órbita baja alrededor de la Tierra, al igual que el cohete ruso Protón, por ejemplo.

Así pues, a partir de todo esto, y sin saber mucho más, ya podemos anticipar de forma intuitiva que no se podrá utilizar un único cohete para ir a Marte, sino que se precisarán varios lanzamientos de cohetes -tanto o más poderosos que el Saturno V de los años ’60- para ensamblar en el espacio distintos elementos de propulsión, módulos de combustible, hábitats y naves, que habrán de enviarse a Marte por separado y por anticipado, además de la nave con la tripulación, que sería enviada en último lugar. Entraremos en estos detalles en la siguiente entrada.

Aunque depende de diversos factores, se requerirán, de hecho, del orden de 10 lanzamientos de cohetes con la capacidad del Saturno V o similar; pero recordemos que el número total de cohetes Saturno V que se enviaron a la Luna en todo el Programa Apolo fue de 9. El Saturno V fue retirado de servicio después del Porgrama Apolo pero ostenta el récord, aún a día de hoy, como el cohete operativo más poderoso que haya habido nunca, capaz de poner algo más de 120 toneladas en órbita baja alrededor de la Tierra y de enviar 50 toneladas a la Luna. Tuvo que ser específicamente diseñado y construido en su día para poder alcanzar la Luna, y no existe un lanzador de tanta capacidad en la actualidad. El cohete que se encargaría de la mayor parte de los lanzamientos en una futura misión a Marte se está desarrollando en la actualidad y se llama SLS (Space Launch System), el cual tendrá prestaciones parecidas o acaso un tanto mayores que el Saturno V.

Por otra parte, un tiempo de 174 días de ida en condición de ingravidez afecta profundamente a la fisiología humana, algo especialmente preocupante al llegar a un planeta donde no hay nadie para asistirte. Las naves que se pueden ver en las películas (incluida la película ‘Marte’), con un amplio y confortable habitáculo en forma de donut girando para simular la aceleración de la gravedad, no son realistas en la actualidad.

Dos años y medio es un tiempo muy largo también por razones psicológicas. La Tierra será vista por la tripulación como un punto de luz semejante a una estrella durante la mayor parte del viaje y será apenas imperceptible en la noche marciana cuando fuera visible. La tripulación tendrá que convivir en una condición de confinamiento permanente en un espacio reducido en una situación de gran estrés, y con la imposibilidad de mantener conversaciones fluidas con los seres queridos en la Tierra debido al tiempo de viaje de la señal.

Después de todo esto, y aunque no se han mencionado todas las dificultades técnicas, tecnológicas y operativas, creo que ahora puede apreciarse un poco mejor a lo que nos enfrentamos en una misión a Marte. A partir de aquí, y una vez expuesta esta perspectiva para contextualizar el problema y entrar en materia, en la siguiente entrada explicaré cómo se plantea en la actualidad una misión humana a Marte y cómo se relaciona con lo que se ve en la película ‘Marte’ (The Martian).

sigue en la II parte

Fuente: NASA

Jun

19

¿Por qué es difícil viajar a Marte? II (Desde la NASA)

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (2)

Comments (2)

Fotograma de la película ‘Marte’ (‘The Martian’).

¿Por qué es difícil ir a Marte? (II)

En la pasada entrada contextualizamos el problema de una misión humana a Marte para apreciar la dimensión del desafío que supone. Como vimos, la principal razón que la hace difícil es la enorme distancia que nos separa de ese planeta, lo que implica que la misión tendría una duración total de aproximadamente 2 años y medio. En esta entrada vamos a concretar cómo se plantea hoy en día esta misión, tomando como ejemplo la oportunidad para el año 2037.

Según está propuesto en la actualidad, para completar una misión humana a Marte serán necesarias 3 naves: dos de carga y una para la tripulación. Una de las naves de carga transportará a Marte el hábitat que albergará a la tripulación durante su estancia de 539 días en la superficie marciana. Este hábitat se denomina SHAB (Surface Hábitat), y es ahí donde Mark Watney, el protagonista de ‘Marte’ The Martian, trata de sobrevivir en solitario.

La otra nave de carga es el denominado ‘vehículo de descenso y ascenso’, o DAV (Descent and Ascent Vehicle). El DAV es la nave a bordo de la que la tripulación, una vez acabada su estancia en Marte, abandonará este planeta, y es, por tanto, la nave que utiliza la tripulación al principio de la película para abortar su estancia en la superficie marciana en medio de una feroz tormenta de arena.

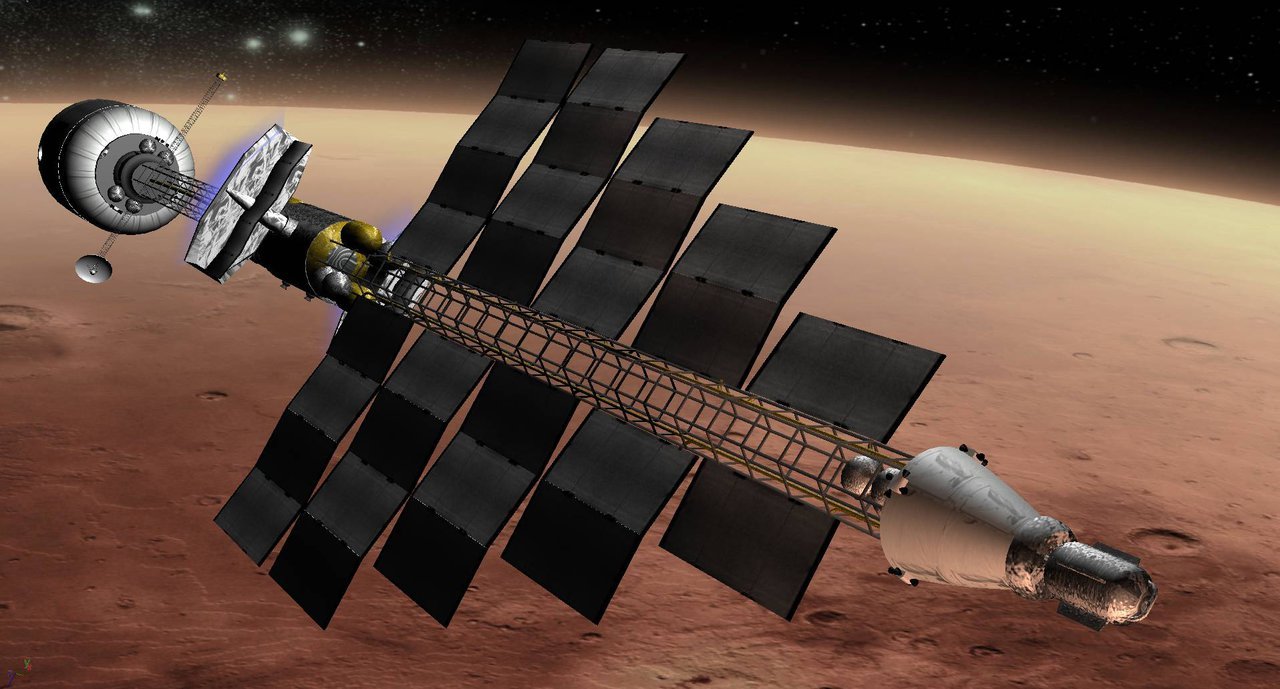

La nave con la tripulación es conocida como ‘vehículo de transferencia para Marte’, o MTV (Mars Transfer Vehicle), y es la que se encargará de transportar a la tripulación en sus dos trayectos interplanetarios: el de ida a Marte y el de regreso a la Tierra (las naves de carga solo tienen tiques de ida).

Concepto de vehículo de transferencia de tripulación para Marte. Fuente: NASA.

Estas tres naves habrán de ensamblarse en una órbita baja alrededor de la Tierra antes de ser enviadas por separado a Marte, pero estos ensamblajes y envíos se harán en tiempos distintos. Las naves de carga (SHAB y DAV) serán las primeras en ser ensambladas, y serán lanzadas al planeta rojo dos años antes que el MTV con la tripulación. ¿Por qué dos años? Porque es aproximadamente cada dos años que se da la posición relativa precisa entre Marte y la Tierra que permite que entre ambos planetas se pueda volar una trayectoria por la que se minimiza la cantidad de combustible a utilizar. Esto es de gran importancia porque son muchas las toneladas de combustible que se necesitan para hacer posible una misión así, como veremos luego.

Concepto de nave de carga para Marte. Fuente: NASA.

Una vez ensamblada cualquiera de estas tres naves en órbita alrededor de la Tierra, cada una de ellas es lanzada desde ahí hacia Marte a través del encendido de sus motores durante un corto espacio de tiempo. La nave es así acelerada hasta adquirir la velocidad necesaria para abandonar la influencia gravitatoria terrestre y dirigirse hacia Marte a lo largo de una trayectoria interplanetaria que es, en realidad, una órbita elíptica alrededor del Sol y cuyo punto más lejano intersectará con el paso de Marte por ese punto en el momento preciso. Cuando la velocidad deseada ha sido alcanzada, los motores se apagan y permanecen así durante toda la travesía (se encenderán en algún momento para hacer alguna corrección en la trayectoria). A pesar de encender los motores durante un corto espacio de tiempo, del orden de pocos minutos o decenas de minutos, la cantidad de combustible que se utiliza es enorme (decenas de toneladas).

Este lanzamiento hacia Marte desde una órbita baja alrededor de la Tierra se denomina ‘inyección trans-marciana’, y nos referimos a él como TMI (Trans-Mars Injection). Nótese que al regreso de la tripulación desde Marte, el mismo proceso ocurrirá desde allí en sentido inverso: desde una órbita alrededor de Marte, la nave encenderá sus motores por un corto espacio de tiempo en lo que se denomina ‘inyección transterrestre’, o TEI (Trans-Earth Injection).

Una vez llegada una nave a las proximidades de Marte, esta debe frenarse para quedar capturada en una órbita alrededor de ese planeta desde donde acometer las siguientes operaciones. Esta maniobra de frenado se denomina ‘inserción en órbita marciana’, o MOI (Mars Orbit Insertion).

El MOI puede hacerse de forma propulsada, encendiendo los motores otro corto espacio de tiempo, o de forma aero-asistida, utilizando la atmósfera marciana para frenar la nave en una maniobra llamada ‘aero-captura’. Esta última opción se ha propuesto solo para las naves de carga de forma que sería mucho el combustible que se ahorraría en la misión. El problema es que nunca se ha volado una aero-captura hasta la fecha, con lo que esta capacidad habría de ser demostrada antes. El SHAB (la nave portando el hábitat) permanecerá en órbita alrededor de Marte a la espera de la tripulación, pero el DAV (vehículo de descenso y ascenso) descenderá a la superficie marciana de forma autónoma.

El DAV será la nave de ascenso que utilizará la tripulación en su día para despegar de la superficie al acabar su estancia en el planeta rojo. Con objeto de ahorrar el combustible necesario para ese lanzamiento, se propone que el DAV no porte el combustible con él, sino que lo produzca en Marte, in situ. Y es que sería prohibitiva la masa de una nave que descendiera a la superficie de Marte con el combustible para el lanzamiento posterior de 6 personas al finalizar su estancia allí. De hecho, se propone que el DAV no solo produzca in situ el combustible, siendo el metano/oxígeno la opción preferida, sino que también produzca el oxígeno, nitrógeno y el agua necesarios para la tripulación. Esta es otra área que precisa investigación y desarrollo tecnológico.

Dos años después de haber enviado las dos naves de carga, y después de comprobar que los consumibles (combustible, aire, agua) hayan sido producidos en Marte y de que todo allí funcione correctamente, la tripulación será lanzada finalmente al planeta rojo desde la Tierra. Una vez en órbita alrededor de Marte, el MTV (la nave en la que viaja la tripulación) se encontrará con el SHAB, que lo espera en órbita alrededor de Marte. Los astronautas pasarán al SHAB y procederán a bordo de esta nave al descenso a la superficie, donde aterrizarán a una corta distancia del DAV.

El descenso a Marte de naves de tanta masa es a día de hoy un problema no resuelto. Hasta la fecha se han enviado a Marte vehículos exploradores y aterrizadores de muy poca masa. El principal problema reside en que la atmósfera marciana es muy tenue y no consigue frenar una nave de reentrada lo suficiente sin necesidad de emplear retropropulsión supersónica o enormes superficies de frenado si la nave es lo suficientemente masiva. La tecnología a día de hoy permite como máximo aterrizar en Marte masas de alrededor de una tonelada, un valor muy lejano de las naves de varias decenas de toneladas que habrá que poder aterrizar en una misión humana, por lo que nuevas técnicas y tecnologías deberán también ser desarrolladas para este propósito, un área de investigación en el que personalmente trabajo parcialmente en la actualidad.

Después de los 539 días de estancia en Marte, la tripulación será lanzada en la etapa de ascenso del DAV al encuentro del MTV, que habrá permanecido en órbita alrededor de Marte todo ese tiempo. Una estancia tan larga en Marte sería necesaria a la espera de que la posición relativa entre este planeta y la Tierra fuera óptima para el regreso con un mínimo gasto de combustible, lo que ahorra el envío de ingentes cantidades de combustible. Una vez transferidos al MTV, se procederá a la inyección transterrestre por la que los astronautas regresarán a casa unos 200 días después, para acabar haciendo una reentrada en la atmósfera de la Tierra a bordo de una cápsula Orion, la cual está siendo desarrollada en la actualidad.

Muchas personas me preguntan si sería posible reducir la estancia en Marte. Efectivamente, la estancia podría reducirse a tiempos de entre 30 y 90 días; pero, en ese caso, los tránsitos interplanetarios habrían de ser muy largos, de mas de 200 días de ida y de unos 400 días de vuelta; requiriendo, además, maniobras de asistencia gravitatoria en el camino; de otra manera, el coste sería prohibitivo. Se favorece la opción de viajes cortos y estancias largas para reducir la exposición de la tripulación a la radiación. Estando en Marte, el mismo planeta bloquea el 50% de la radiación a la que estarían expuestos los astronautas, ademas de que ciertas medidas de protección serian mas fáciles de implantar.

Como se ha dicho constantemente, las masas involucradas en una misión humana a Marte son enormes. Un elemento que contribuye significativamente a esto es el combustible, y es por esta razón que se ha propuesto la opción de utilizar propulsión nuclear-térmica en lugar de propulsión química, tal y como ha sido el caso en todas las misiones tripuladas hasta la fecha. Esta no es una decisión baladí ya que el ahorro en combustible entre una opción y otra es de unas 400 toneladas; esto es, aproximadamente la masa de una Estación Espacial Internacional (ISS). Para poner esto en perspectiva, apuntemos que se precisaron 10 años para ensamblar la ISS y algo más de una treintena de lanzamientos (aunque de menor capacidad que el Saturno V).

Según se estima en la actualidad, para llevar a cabo una única misión a Marte habrá que lanzar al espacio desde la Tierra un total de 850 toneladas en caso de que se utilice propulsión nuclear-térmica, o 1.250 toneladas en caso de utilizar propulsión química. Esto son 2 o 3 Estaciones Espaciales Internacionales. Asumiendo que un cohete lanzador de prestaciones similares al Saturno V de las misiones lunares puede emplazar 120 toneladas en una órbita baja alrededor de la Tierra, el número de lanzamientos requeridos en una sola misión humana a Marte sería aproximadamente de 7 u 11, dependiendo del tipo de combustible, y asumiendo que todos los elementos necesarios puedan ponerse en órbita con un lanzador así. El envió de la tripulación precisaría de un lanzamiento especifico a bordo de un cohete de menor capacidad, por ejemplo, y es posible que ciertas tareas de ensamblaje puedan requerir asistencia humana también.

Existen muchas variaciones en las arquitecturas propuestas para misiones tripuladas a Marte pero lo expuesto aquí refleja lo que viene a ser la arquitectura de referencia que se considera hoy en día. En cualquier caso, la envergadura de una misión humana a Marte es sobrecogedora. Espero que estas dos ultimas entradas hayan ayudado a entender un poco mejor la magnitud de una empresa tan ambiciosa y compleja. Las dificultades técnicas, operativas y tecnológicas que encierra no son para nada triviales, y resulta imposible siquiera mencionarlas todas en una entrada de un blog. Se requiere aún el desarrollo de tecnologías inexistentes en la actualidad para llevar a cabo una misión así, y muchas de las cuestiones planteadas no están aún resueltas. Aún estamos lejos de poder enviar seres humanos a Marte, pero también hace un siglo se estuvo muy lejos de alcanzar el espacio y la Luna. Estoy seguro de que el ser humano llegará a Marte algún día si así lo desea, pero creo, y esta es una opinión estrictamente personal, que ese día está más lejos de lo que muchos puedan pensar.

Fuente: NASA

Jun

18

Nuestra Imaginación es mucho más rápida que la luz

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

¿Cuántas veces habré “visitado” Marte con la Imaginación?

Pero bajemos hasta la realidad y pongamos los pies en el suelo, veamos que cosas pasan por aquí, en nuestro mundo real que, a veces, también resultan tan fantásticas como viajar a Marte con el pensamiento.

Satélite Gravity Probe B. Dedicado a medir la curvatura del campo gravitatorio terrestre debido a la teoría de la relatividad de Einstein. La gravedad ha sido medida y comprobada de muchas maneras pero… ¡Gravedad cuántica! ¿qué es eso? La imaginación anda más rápida que los conocimientos. Sin embargo, así hemos ido avanzando en el transcurrir del Tiempo. Hace algunos miles de años algunos imaginaron la existencia del átomo y de los elementos y, ya sabéis lo que de esas cuestiones sabemos hoy.

La llamada gravedad cuántica trata de fundir en una sola las dos teorías físicas más soberbias con las que contamos, la relatividad general y la mecánica cuántica, que en el estado actual de nuestro conocimiento parecen incompatibles. Su estudio, ahora mismo, es en algunos aspectos análogo a la física de hace cien años, cuando se creía en los átomos, pero se ignoraban los detalles de su estructura.

Desde aquel día en que Kaluza, le escribió a Einstein una carta con su teoría de las cinco dimensiones, en la que unía la Gravedad con el Electromagnetismo, la puerta de las dimensiones más altas quedó abierta y a los teóricos se les regaló una herramienta maravillosa: el hiperespacio; todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí sí es posible encontrar esa soñada teoría de la gravedad cuántica.

Así que las teorías se han embarcado a la búsqueda de un objeto audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos; una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

Algunas ecuaciones nos dicen hasta donde puede llegar la mente humana

Claro que saber, lo que el universo es, leyendo una ecuación, por muy ingeniosa que ésta sea y por mucho que la misma pueda abarcar… Parece poco probable. ¿Dónde radica el problema? El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC, la máquina más potente del mundo hasta el momento.

La verdad es que la teoría que ahora tenemos, el modelo estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. ¡Necesitamos algo más avanzado!

A pesar de su grandeza, se queda corto para que nos pueda decir, lo que necesitamos saber: Si nos habló del Bosón de Higgs, por el momento no está nada mal, y, ahora, en su nueva etapa, seguramente nos dará alguna sorpresa y nos puede desvelar algún que otro secreto de la materia, del universo que presentimos y no podemos ver.

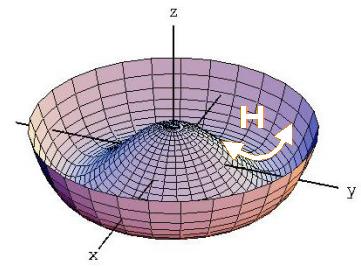

Se dijo que la función de la partícula de Higgs era la de dar masa a las partículas que carecen de ella, disfrazando así la verdadera simetría del mundo. Cuando su autor lanzó la idea a la comunidad científica, resultó además de nueva, muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resultó ser complejo, lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, y, el núcleo, una parte entre cien mil del total del átomo, resultó ser de una complejidad asombrosa.

Allí los nucleones (protones y neutrones) resultaron estar hechos por tripletes de Quarks que, confinados por la fuerza nuclear fuerte, eran retenidos por los Gluones, los Bosones transmisores de esa fuerza de la naturaleza. Así que un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo, cuando fue descubierto en todo su contenido, fue motivo de un gran asombro entre la comunidad científica. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún; los quarks que estaban instalados en nubes de otras partículas llamadas gluones, y ahora queremos continuar profundizando, sospechando que después de los quarks puede haber algo más.

Nos dicen que existen lugares que llaman los Océanos de Higgs, y, por ellos, circula libremente el dichoso Bosón que, también según nos dicen, proporciona la masa al resto de las partículas. Todo el Universo está permeado por esa especie de sustancia -como el viejo éter- que los griegos llamaban Ylem cósmico y que, a medida que el tiempo avanza, le vamos cambiando el nombre. Pues bien, ahí, en ese “océano” dicen que está el Bosón dador de masas que según parece, descubrieron hace un par de años.

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes, es decir, que si miramos a las estrellas en una noche clara, estamos mirando el campo de Higgs. Las partículas influidas por este campo toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado otras veces, tales como: del campo gravitatorio o del electromagnético.

Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquirirá energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra. Como E = mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein: la masa, m, tiene en realidad dos partes; una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) en los aceleradores, o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Pero la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan estas al campo de Higgs cuando interaccionan con él.

La influencia de Higgs en las masas de los quarks y de los leptones nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de qué reglas controlan los incrementos de masa generados por Higgs (de ahí la expectación creada -en su momento- por el nuevo acelerador de partículas LHC), pero el problema es irritante: ¿por qué sólo esas masas - las masas de los W+, W–, Z0, y el up, down, encanto, extraño, top y bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van desde la del electrón (0’0005 GeV) a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-Salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnética y débil. En la unidad hay cuatro partículas mensajeras sin masa – los W+, W–, Z0 y el fotón – que llevan la fuerza electrodébil. Además está el campo de Higgs, y rápidamente, los W y Z absorben la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos), y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen las teorías. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

“En la actualidad, prácticamente todos los fenómenos subatómicos conocidos son explicados mediante el modelo estándar, una teoría ampliamente aceptada sobre las partículas elementales y las fuerzas entre ellas. Sin embargo, en la década de 1960, cuando dicho modelo aún se estaba desarrollando, se observaba una contradicción aparente entre dos fenómenos. Por un lado, la fuerza nuclear débil entre partículas subatómicas podía explicarse mediante leyes similares a las del electromagnetismo (en su versión cuántica). Dichas leyes implican que las partículas que actúen como intermediarias de la interacción, como el fotón en el caso del electromagnetismo y las partículas W y Z en el caso de la fuerza débil, deben ser no masivas. Sin embargo, sobre la base de los datos experimentales, los bosones W y Z, que entonces sólo eran una hipótesis, debían ser masivos.

En 1964, tres grupos de físicos publicaron de manera independiente una solución a este problema, que reconciliaba dichas leyes con la presencia de la masa. Esta solución, denominada posteriormente mecanismo de Higgs, explica la masa como el resultado de la interacción de las partículas con un campo que permea el vacío, denominado campo de Higgs. El modelo estándar quedó finalmente constituido haciendo uso de este mecanismo.”

Tampoco el Higgs es una partícula especial porque sea una excitación del del campo de Higgs que nos permita explorar sus propiedades, porque en las teorías sin Higgs o con Higgs compuesto también hay excitaciones del vacío que nos permiten explorar el campo.” Eso nos dicen en el magnifico Blog de Francis (th)E mule Science’s News.

| Partícula | Símbolo | Masa (en GeV/c2) | Carga eléctrica | Espín | Interacción |

|---|---|---|---|---|---|

| Fotón |  |

0 | 0 | 1 | electromagnética |

| Bosón W | W± | 80,4 | ± 1 | 1 | débil |

| Bosón Z | Z0 | 91,187 | 0 | 1 | débil |

| Gluón | g | 0 | 0 | 1 | fuerte |

Las masas de los W y Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil, y las relajadas sonrisas de los físicos teóricos nos recuerdan que Hooft y Veltman dejaron sentado que la teoría entera está libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista de cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una voz potente y segura nos dice “¡Higgs!”. Durante más de sesenta años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo de Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmaniana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la materia?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente, y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen en entredicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “re-normalizándolo”, ese truco matemático que emplea cuando no saben hacerlo bien.

¿Sabremos alguna vez cómo adquieren masa las partículas?

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrínseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrínseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en la que los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

Una cosa más; hemos hablado de los bosones gauge y de su espín de una unidad. Hemos comentado también las partículas fermiónicas de la materia (espín de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espín cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs da masa a los objetos donde quiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” (sin dirección) por esa razón.

La interacción débil, recordaréis, fue inventada por E. Fermi para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar nuevas partículas que puedan despejar algunos interrogantes.

Recuerdo cuando andaban a la caza del Bosón de Higgs y decían “Pero todavía hay que responder montones de preguntas: ¿Cuáles son las propiedades de las partículas de Higgs? y, lo que es más importante, ¿Cuál es su masa? (Bueno, parece que, en el último experimento apareció se localizó un bosón con ~125 GeV que, según parece, podría ser el esquivo Higgs)¿Cómo reconoceremos una si nos la encontramos en una colisión del LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas o sólo las hace incrementarse? ¿Cómo podemos saber más al respecto? Cómo es su partícula, nos cabe esperar que la veremos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.”

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del universo, añadiendo pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Éstas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuado que las partículas y la cosmología pintan juntas de un universo primitivo puro y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10-5 grados Kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así, por ejemplo, antes del Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

No, esto no es el Higgs, es, simplemente, una burbuja multicolor

El universo se expande y se enfría, y entonces viene el Higgs (que “engorda” los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe. Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que les hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas formas, es tanta la ignorancia que tenemos sobre el origen de la masa que nos agarramos como a un clavo ardiendo, en este caso, a la partícula de Higgs, que algunos han llegado a llamar “la partícula divina”. Lo mismo nos pasa con la dichosa “materia oscura” para ocultar lo que no sabemos sobre la expansión del Universo.

¡Ya veremos en qué termina todo esto!

Arriba tenemos nada más y nada menos que: a John Mather, Carlo Rubbia, Martinus Veltman, Gerardus ‘t Hooft at the Lindau Nobel Meetings 2010. Si científicos como ellos no vienen a nuestro rescate, y nos sacan del atolladero en el que estamos inmerso y hasta el cuelo de ignorancia…¡Mal hirían las cosas!

Lo cierto es que (al menos de momento), la materia y energía oscura, las supercuerdas, sí son la alfombra que decía Veltman, aquel físico serio y Premio Nobel que, no confesaba con ciertas ruedas de molino. Él, quería hablar de cosas tangibles y, tampoco le gustaban las partículas virtuales.

Sobre estas ideas, Veltman, uno de los arquitectos de la Fñisica, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glashow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no tenemos la menor prueba experimental. Ahora, por fin, la tendremos con el LHC. El modelo estándar es lo bastante fuerte para decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” menor de 1 TeV, ¿por qué?; si tiene más de 1 TeV el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

emilio silvera

Jun

18

El secreto está en las estrellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El Tiempo es inexorable y su transcurrir va dejando atrás las cosas que del presente, van situándose en el pasado. Lejos queda ya aquellas efemérides y celebraciones del año 2009, cuando se conmemoró el Año Internacional de la Astronomía y me cupo el honor de (humildemente), colaborar con aquellas celebraciones.

Astrolabio de al-Sahli, del siglo XI (M.A.N., Madrid). El astrolabio es un antiguo instrumento que permite determinar la posición y altura de las estrellas sobre la bóveda celeste. El astrolabio era usado por los navegantes, astrónomos y científicos en general para localizar los astros y observar su movimiento, para determinar la hora a partir de la latitud o, viceversa, para averiguar la latitud conociendo la hora. También sirve para medir distancias por triangulación.

Con orgullo luzco en el ojal de mi chaqueta el astrolabio que nos dieron en Madrid, a todos los invitados, a la fiesta de inauguración en la que estaban presentes muchos astrónomos y astrofísicos del mundo entero.