Jul

28

El Universo, la Diversidad, la Belleza, la Vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

La galaxia anular de Hoag (A1515+2146) es un anillo de materia con estrellas jóvenes y azuladas que rodea a una galaxia esferoidal central sin traza de ninguna barra que conecte ambas, aunque como tienen el mismo corrimiento al rojo, deben estar a la misma distancia y deben estar relacionados entre sí. Las teorías actuales de formación galáctica permiten la formación de una galaxia anular siempre y cuando tenga una barra central. Se ha propuesto en el caso del objeto de Hoag que dicha barra se ha disuelto. Hay muchas galaxias anulares con anillos polares como NGC 6028 (que sí tiene una barra central) y UGC 6614 (ver más abajo, aunque no son imágenes tan detalladas como la del Telescopio Espacial Hubble).

Las azuladas estrellas orbítan alrededor del núcleo central de la Galaxia como si de un carrusel cósmico se tratara. En esa imagen que vemos las estrellas jóvenes emiten radiación ultravioleta que ioniza el material circundante de las nebulosas de las que surgieron, allá en la lejanía y ocultos por la inmensa infinitud de mundos y otros exóticos objetos que en la imagen captada por el Hubble no podemos ver.

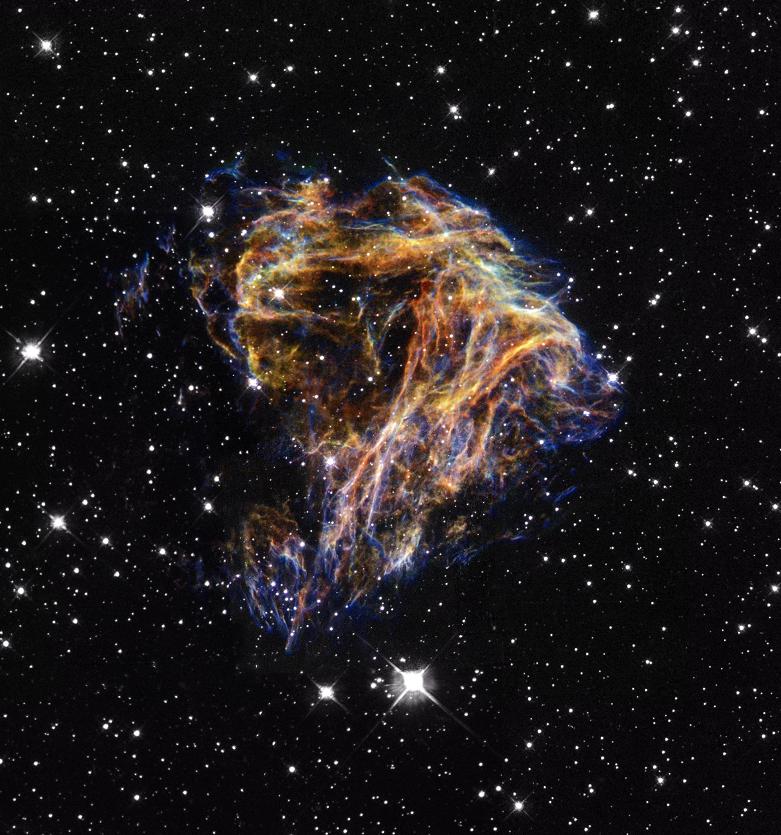

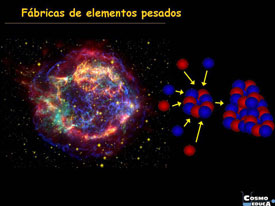

Remanente de Supernova

Imagen de la galaxia compacta azul con formación estelar IIZw71 y espectro de la región central con la identificación de las lineas de emisión de neón y argón.

Existen Galaxias con bajo brillo superficial (LSB): Tipo de galaxia cuya densidad de estrellas es tan baja que es difícil detectarla frente al fondo del cielo. Se desconoce la proporción de galaxias con bajo brillo superficial en relación a las galaxias normales, pudiendo representar una parte significativa del universo. Muchas de estas débiles galaxias son enanas, situadas particularmente en cúmulos de galaxias; algunas son tan masivas como las grandes espirales, por ejemplo, Malin-1.

Galaxia con envoltura: Galaxia espiral rodeada por débiles arcos o capas de estrellas, situados a ángulos rectos con respecto a su eje mayor. Pueden observarse entre una y veinte capas casi concéntricas, aunque incompletas. Se disponen de manera que capas sucesivas puedan aparecer normalmente en lados opuestos de la galaxia. Alrededor del 10% de las elípticas brillantes presentan envolturas, la mayoría de ellas en regiones de baja intensidad o densidad de galaxias. No se conoce ninguna espiral con una estructura de capas de ese tipo. Podrían ser el resultado de una elíptica gigante que se come una compañera.

Esta burbuja, fotografiada y examinada conjuntamente por la NASA y la ESA, entre 2006 y 2010, parece flotar sin actividad, pero lo cierto es que vivió un pasado convulso. Dicha envoltura gaseosa se formó después de una explosión estelar. Se conoce por el nombre de SNR B0509-67.5 y tiene un diámetro de 23 años luz (cuatro veces la distancia que nos separa de la estrella más cercana: Próxima Centaury).

Galaxia de anillo polar: Raro tipo de galaxia, casi siempre una galaxia lenticular, que tiene un anillo luminoso de estrellas, gas y polvo orbitando sobre los polos de su disco. Por tanto, los ejes de rotación del anillo y del disco forman casi un ángulo recto. Dicho sistema puede ser el resultado de una colisión, una captura de por maneras, o la unión de una galaxia rica en gas con la galaxia lenticular.

Hay un artículo muy interesante que propone analiza en detalle una galaxia con anillo polar y presenta una explicación bastante coherente y que a mí me parece bastante natural. Se trataría de galaxias tipo SBa(R) en la que los dos brazos espirales se han unido hasta confundirse en un anillo y el bulbo y la gran barra central han evolucionado hasta formar una galaxia de tipo S0 central. La explicación me gusta porque no alude a colisiones galácticas, para las que uno esperaría un resultado mucho menos simétrico, ni a dinámicas gravitatorias exóticas. Por supuesto, queda por clarificar por qué la conexión entre la barra central y el anillo se ha perdido.

Hay Galaxias de disco: Tipo de galaxia cuya estructura principal es un delgado disco de estrellas con órbitas aproximadamente circulares alrededor de su centro, y cuya emisión de luz típicamente disminuye exponencialmente con el radio. El término se aplica a todos los tipos de galaxias que no sean elípticas, esferoidales enanas o algunas galaxias peculiares. El disco de las galaxias lenticulares contiene muy poco material interestelar, mientras que los discos de las galaxias espirales e irregulares contienen cantidades considerables de gas y polvo además de estrellas.

La brillante galaxia NGC 3621

Galaxia de tipo tardío: Galaxia espiral o irregular. El nombre proviene de la posición convencional de estas galaxias en el diagrama diapasón de los tipos de galaxias. Por razones similares, una galaxia espiral Sc o Sd pueden ser denominadas espiral del tipo tardío, en contraposición a una espiral Sa o Sb de tipo temprano.

Galaxia de tipo temprano: Galaxia elíptica o lenticular: una sin brazos espirales. El hombre proviene de la posición de las galaxias en el diagrama diapasón de las formas de las galaxias. Por razones similares, una galaxia Sa podría ser referida como una espiral de tipo temprano, en contraposición a una espiral Sc o Sd de tipo tardío.

Se podría continuar explicando lo que es una galaxia elíptica, enana, compacta azul, esferoidal enana, espiral (como la Vía Láctea), espiral enésima, espiral barrada, interaccionante, irregular, lenticular, peculiar, starburst, primordiales… etc, sin embargo, creo que ya se ha dejado constancia aquí de los datos necesarios para el que lector tenga una idea de lo que es una galaxia. Así que decido finalizar el apartado de galaxias, reflejando un cuadro del Grupo Local de galaxias en el que está situada la nuestra.

En todas estas galaxias que arriba podemos contemplar, existen estrellas binarias de cuyo estudio obtenemos datos fascinantes y podemos llegar a conocer mejor la denámica del Universo. Ejemplo de una estrella binaria, donde dos cuerpos con masa similar orbitan alrededor de un centro de masa en órbitas elípticas.

Ejemplo de una estrella binaria, en donde dos cuerpos con una pequeña diferencia de masa orbitan alrededor de un centro de masa.

Binarias astrométricas: En este tipo de sistemas dobles sólo es visible un componente de la estrella. Se detectan que son binarias gracias al “tirón” gravitatorio ejercido por su compañera invisible. Esto produce un movimiento oscilatorio respecto al fondo de estrellas fijas que puede ser medido por técnicas de paralaje si está lo suficientemente cerca, ya que este tipo de cálculos se realiza en estrellas aproximadamente entre los 10 parsecs, a distancias menores el ángulo de paralaje no existe o es tan pequeño, que los cálculos no se pueden realizar. Como las binarias visuales, las astrométricas requieren prolongados períodos de observación.

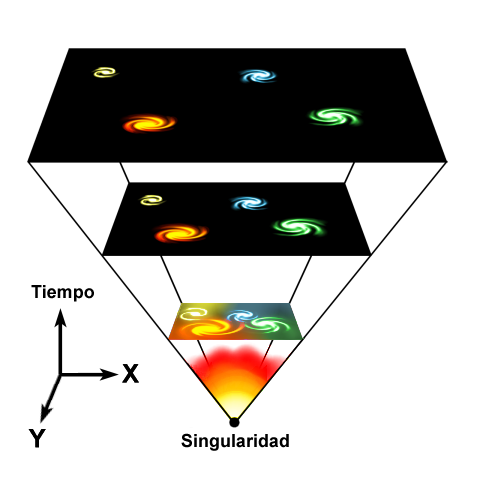

Hemos creado modelos del origen del Universo que están muy extendidos al coincidir sus predicciones con la observación. Así de momento hemos aceptado que en su inicio el Universo era algo extremadamente denso y de infinita energía que, al explosionar, se expandió y de la radiación intensa se paso la era de las partículas y más tarde, al enfriarse paulatinamente, a la de la materia para que comenzara, millones de años más tarde, a formarse las primeras estrellas. Se liberaron los fotones y el Universo se hizo transparente, es decri, se hizo la luz.

La Radiación del fondo de microondas ha venido a corrobarar tal teoría del Big Bang. la densidad y temperatura de la materia y la radiación en el Universo decrecieron continuamente a medida que el Universo se expandía. Esta expansión puede continuar para siempre o puede un día invertirse en un estado de contracción, volviendo a pasar por condiciones de densidad y temperaturas cada vez mayores hasta llegar al Big Crunch en un tiempo finito de nuestro futuro. Este escenario evolutivo tiene la característica clave de que las condiciones físicas en el pasado del Universo no eran las mismas que las actuales o las futuras. Hubo épocas en que la vida no podía existir porque había demasiado calor para los átomos; hubo épocas previas a las estrellas y habrá un tiempo en el que todas las estrellas hayan muerto. En este escenario hay un intervalo preferido de la historia cósmica durante el que es más probable que los observadores evolucionen por primera vez y hagan sus observaciones del Universo.

Todo eso, si es que realmente fue así, también implicaba que hubo un comienzo para Universo, un tiempo pasado antes del cuál éste (el propio tiempo) no existía, pero no decía nada al respecto de el por qué o al dónde de este comienzo. Todo quedaba oculto en el más profundo de los misterios y, nadie ha podido llegar a ese tiempo que marca la frontera que está situada en esa fracción de segundo, más allá del tiempo de Planck, en el cual los cosmólogos, para tapar su ignorancia, han puesto una singularidad lo mismo que ahora han colocado la materia oscura para explicar la expansión.

El Universo estacionario sostiene que el Universo nunca tuvo un origen, sino que siempre existió de la misma manera como lo conocemos hoy.

El escenario alternativo creado por Bondi, Gold y Hoyle estaba motivado en parte por un deseo de evitar la necesidad de un principio (o un posible final) del Universo. Su otro objetivo era crear un escenario cosmológico que pareciera de promedio siempre el mismo, de modo que no hubiera instantes privilegiados en la historia cósmica.

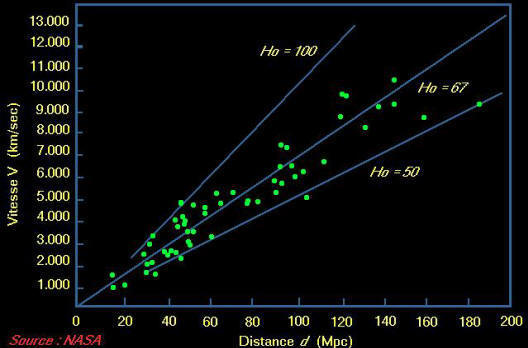

El gráfico de abajo indica la velocidad de alejamiento de las galaxias en función de sus distancias. La pendiente de la recta de “La constante de Hubble”

Horizontalmente: la medida de la distancia es proporcionada por la luminosidad de las galaxias más brillantes de diferentes grupos. Verticalmente: velocidades en Km. por segundo. Las diferentes curvas describen la relación velocidad distancia en función de la densidad supuesta del universo (en unidades de densidad crítica). Cuanto más denso es el universo, tanto más a la izquierda se sitúa la curva en el dibujo. La comparación con los puntos observados muestra que la densidad real es tres veces inferior a la densidad crítica. La curva más baja es la esperada en un universo estacionario.

Claro que dicho escenario, al principio parece imposible de conseguir. Después de todo, el Universo se está expandiendo. Está cambiando, de modo que, ¿Cómo puede hacerse invariable? La visión de Hoyle era la de un río que fluye constantemente, siempre en movimiento pero siempre igual. Para que el universo presente la misma densidad media de materia y el mismo ritmo de expansión, independientemente de cuándo sea observado, la densidad debería ser constante.

Él propuso que, en lugar de nacer en un instante pasado, la materia del universo se creaba continuamente a un ritmo que compensaba exactamente la tendencia a que la densidad sea diluida por la expansión. Este mecanismo de “creación continua” sólo tenía que ocurrir muy lentamente para conseguir una densidad constante; sólo se requería aproximadamente un átomo por metro cúbico cada diez mil millones de años y ningún experimento ni observación astronómica sería capaz de detectar un efecto tan pequeño.

Esta teoría del “estado estacionario” del Universo hacía predicciones muy precisas. El Universo parecía el mismo de promedio en todo momento. No había hitos especiales en la historia cósmica: Ningún “principio”, ningún “final”, ningún momento en que empezaran a formarse las estrellas o en el que la vida se hiciera posible por primera vez en el Universo. Claro que, finalmente, esta teoría quedó descartada por una serie de observaciones iniciadas a mediados de la década de 1950 que mostraba en primer lugar que la población de galaxias que eran emisores profusos de radioondas variaba significativamente a medida que el Universo envejecía.

La culminación de todo aquello llegó cuando en el año 1965 se descubrió la radiación térmica residual del comienzo caliente predicho por los modelos del Big Bang. Esta radiación de fondo de microondas no tenía lugar en el Universo en estado estacionario. Durante veinte años los astrónomos trataron de encontrar pruebas que dijeran si realmente el universo estaba realmente en el estado estacionario que propusieron Bondi, Gold y Hoyle.

Un sencillo argumento antrópico podría haber demostrado lo poco posible que sería ese estado de cosas. Si uno mide el ritmo de expansión del Universo, da un tiempo durante el que el Universo parece haber estado expandiéndose. En un Universo Big Bang éste es realmente el tiempo transcurrido desde que empezó la expansión: la edad del Universo. En la teoría del estado estacionario no hay principio y el ritmo de expansión es tan sólo el ritmo de expansión y nada más.

La simulación por ordenador pone ante nuestros ojos la formación de aquellas primeras estrellas que, no comenzaron a brillar en la secuencia principal hasta pasados 400 millones de años después del comienzo del Tiempo.

Las primeras estrellas se formaron millones de años después del (supuesto) big bang. Eran enormes, pesadas, y muy calientes. Brillaron con furia, vivieron rápido y murieron jóvenes. Fueron las responsables de la creación de los primeros agujeros negros en el Universo y también, de la creación de los primeros elementos pesados y más complejos que el hidrógeno y el Helio.

En una teoría del Big Bang, el hecho de que la edad de expansión sea sólo ligeramente mayor que la edad de las estrellas es una situación natural. Las estrellas se formaron en nuestro pasado y por ello deberíamos esperar encontrarnos en la escena cósmica una vez formadas, dado que, los elementos necesarios para la vida, se forjaron en los hornos nucleares de las estrellas calientes que fusionaron aquella primera materia más simple en otras más complejas.

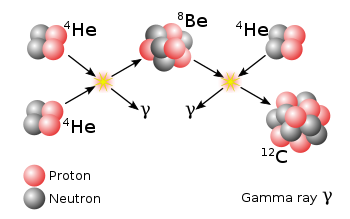

Se necesita mucho tiempo para que las estrellas fabriquen Carbono a partir de gases inertes como el Hidrógeno y el Helio. Pero no basta con el tiempo. La reacción nuclear específica que se necesita para hacer Carbono es una reacción bastante improbable. Requiere que se junten tres núcleos de Helio para fusionarse en un único núcleo de Carbono. Los núcleos de Helio se llaman partículas alfa, y esta reacción clave para formar Carbono ha sido bautizada como el proceso “triple alfa”.

Precisamente fue Fred Hoyle el que descubrió todo aquel complejo proceso de fabricación de Carbono en las estrellas. Él se unió a un grupo de investigadores que estaban trabajando sobre la cuestión de la relativa abundancia de elementos en las superficies de las estrellas. En conjunto, estructuraron un exhaustivo estudio de los elementos que se acumulan en los núcleos estelares. En un denso trabajo que publicaron en Octubre de 1957 en Review of Modem Physics, bajo el título de “Síntesis de los elementos de las estrellas”, lograron explicar la abundancia de prácticamente todos los isótopos de los elementos desde el Hidrógeno hasta el Uranio.

Descubrieron que las estrellas, en la medida que van gastando su combustible nuclear, transmutan el Hidrógeno en Helio; el Helio a Carbono y Oxígeno; y así sucesivamente, subiendo hasta llegar hasta los más pesados de la Tabla Periódica. En las explosiones de las supernovas se crean mucho de los elementos más pesados, incluidos el platino, el oro y el uranio. El trabajo que fue un inmenso logro científico, no sólo explicó la síntesis de todos los elementos más allá del Hidrógeno, sino que predijo su formación exactamente en las mismas proporciones que ocurrían en el Universo. Pero quedó por explicar la cuestión del Hidrógeno: Cómo se genera el combustible inicial de las estrellas.

Así, en las estrellas podemos encontrar muchas respuestas de cómo se forman los elementos que conocemos. Primero fue en el hipotético Big Bang donde se formaron los elementos más simples: El Hidrógeno (que nunca hemos podido llegar a saber cómo se formó), Helio y Litio. Pasados muchos millones de años se formaron las primeras estrellas y, en ellas, se formaron elementos más complejos como el Carbono, Nitrógeno y Oxígeno. Los elementos más pesados se tuvieron que formar en temperaturas mucho más altas, en presencia de energías inmensas como las explosiones de las estrellas moribundas que, a medida que se van acercando a su final forman materiales como: Sodio, Magnesio, Aluminio, Silicio, Azufre, Cloro, Argón, Potasio, Titanio, Hierro, Cobalto, Níquel, Cobre, Cinc, Plomo, Torio…Uranio. La evolución cósmica de los elementos supone la formación de núcleos simples ¿en el big bang? y la posterior fusión de estos núcleos ligeros para formar núcleos más pesados y complejos en el interior de las estrellas y en la transición de fase de las explosiones supernovas.

Abajo un gráfico de la Nucleo-síntesis estelar.

Estaba explicando el proceso triple alfa que es el proceso por el cual tres núcleos de helio (partículas alfa) se transforman en un núcleo de carbono. Esta reacción nuclear de fusión sólo ocurre a velocidades apreciables a temperaturas por encima de 100 000 000 kelvin y en núcleos estelares con una gran abundancia de helio. Por tanto, este proceso sólo es posible en las estrllas más viejas, donde el helio producido por las cadenas protón–protón y el ciclo CNO se ha acumulado en el núcleo. Cuando todo el hidrógeno presente se ha consumido, el núcleo se colapsa hasta que se alcanzan las temperaturas necesarias para iniciar la fusión de helio.

8Be + 4He ↔ 12C

Las estrellas que son unas ocho veces más masivas que el Sol representan sólo una fracción muy pequeña de las estrellas en una galaxia espiral típica. A pesar de su escasez, estas estrellas juegan un papel importante en la creación de átomos complejos y su dispersión en el espacio.

Elementos necesarios como carbono, oxígeno, nitrógeno, y otros útiles, como el hierro y el aluminio. Elementos como este último, que se cocinan en estas estrellas masivas en la profundidad de sus núcleos estelares, puede ser gradualmente dragado hasta la superficie estelar y hacia el exterior a través de los vientos estelares que soplan impulsando los fotones. O este material enriquecido puede ser tirado hacia afuera cuando la estrella agota su combustible termonuclear y explota. Este proceso de dispersión, vital para la existencia del Universo material y la vida misma, puede ser efectivamente estudiado mediante la medición de las peculiares emisiones radiactivas que produce este material. Las líneas de emisión de rayos gamma del aluminio, que son especialmente de larga duración, son particularmente apreciadas por los astrónomos como un indicador de todo este proceso. El gráfico anterior muestra el cambio predicho en la cantidad de un isótopo particular de aluminio, Al26, para una región de la Vía Láctea, que es particularmente rica en estrellas masivas. La franja amarilla es la abundancia de Al26 para esta región según lo determinado por el laboratorio de rayos gamma INTEGRAL. La coincidencia entre la abundancia observada y la predicha por el modelo re-asegura a los astrónomos de nuestra comprensión de los delicados lazos entre la evolución estelar y la evolución química galáctica.

Pero sigamos con la historia recorrida por Hoyle y sus amigos. Felizmente, la naturaleza proporcionó una piedra Rosetta con la cual Hoyle y sus colaboradores podían someter a prueba sus ideas, en la forma de curva cósmica de la abundancia. Ésta era un gráfico del peso de los diversos átomos -unas ciento veinte especies de núcleos, cuando se tomaban en cuanta los isótopos- en función de su abundancia relativa en el universo, establecido por el estudio de las rocas de la Tierra, meteoritos que han caído en la Tierra desde el espacio exterior y los espectros del Sol y las estrellas.

Hablar del Universo, algo tan grande que se escapa a nuestra comprensión, nos llevaría tanto tiempo que finalizar el trabajo sería casi imposible, así que, habiendo dado una sencilla vuelta por algunos de los sucesos y objetos que en él están presentes, aquí lo dejamos. Sin embargo, de todo estos sucesos se derivan objetos múltiples de diversidad muy rica que adorna y embellece todo el espacio interestelar con la inmensa cantidad de objetos que lo adornan a lo largo de millones y millones de año luz de espacio.

Un rico abanico de Nebulosas que se configuran en función de la masa inicial de la estrella que las formó al eyectar material al final de sus vidas. Estrellas masivas supergigantes que, comparadas con nuestro Sol son enermes objetos que lo contienen más de cien veces y consumen hidrógeno a velocidad de vértigo como si quisiera convertirse en agujero negro en el menor tiempo posible. Diversidad de mundos, explosiones supernovas, sistemas planetarios, cúmulos y siuper-cúmulos de galaxias…

Crédito NASA/ESA

que se fusionan por la fuerza de la gravedad que hace que se atraigan las unas hacia las otras como vemos en el conocido “aglomerado de galáxias Quinteto Stefan“, de cuya imagen podemos deducir de manera fácil las transiciones de fase que se producen en esta clase de fusiones de grandes galaxias, de donde surgen miles de millones de estrellas nuevas, se destruyen y nacen nuevos mundos y, finalmente, el complejo nuevo creado se convierte en una galaxia mayor, supergigante.

Explosiones de estrellas que finalizan sus vidas convirtiéndose en estrellas de neutrones o púlsares. Los Púlsares son fuentes de ondas de radio que vibran con periodos regulares. Se detectan mediante radiotelescopios. Los estudios indican que un púlsar es una estrella de neutrones pequeña que gira a gran velocidad. El más conocido está en la nebulosa de Cangrejo. Su densidad es tan grande que, en ellos, la materia de la medida de una bola de bolígrafo tiene una masa de cerca de 100.000 toneladas. Emiten una gran cantidad de energía. El campo magnético, muy intenso, se concentra en un espacio reducido. Esto lo acelera y lo hace emitir un haz de radiaciones que aquí recibimos como ondas de radio.

Las pulsares fueron descubiertas en 1967 por Anthony Hewish y Jocelyn Bell en el observatorio de radio astronomía en Cambridge. Se conocen más de 300, pero sólo dos, la Pulsar del Cangrejo, y la Pulsar de la Vela, emiten pulsos visibles detectables. Se sabe que estas dos también emiten pulsos de rayos gamma, y una, la del Cangrejo, también emite pulsos de rayos-X.

“

El 16 de marzo de 2013 se cumplió medio siglo del descubrimiento de que los cuásares eran objetos extragalácticos muy brillantes y a enormes distancias de nosotros. Este descubrimiento fue consecuencia del desarrollo pionero de la Radioastronomía y del estudio cuidadoso de los espectros ópticos de unas misteriosas “fuentes casi-estelares”. En la actualidad sabemos que el proceso que genera un cuásar es un agujero negro súper-masivo en el centro de una galaxia.”

La medida de sus desplazamientos al rojo espectroscópico, indicaban que estaban a grandes distancias de la Tierra. El primer cuásar estudiado, 3C 273 está a 1.500 millones de años luz de la Tierra y se han descubierto cuásares a 12.000 millones de años luz de la Tierra, es decir, cuásares que son casi tan viejos como el mismo universo.

Y, pasados los diez mil primeros millones de años, cuando las estrellas habían creado los materiales necesarios para que eso fuese posible, surgieron los primeros indicios de la presencia de vida en el Universo, Se asentaron en mundos como la Tierra y, en moléculas que se juntaron para formar células vivas surgidas de un protoplasma primordial… ¡Dio comienzo la aventura de la vida que, tantos secretos esconde y que tratamos de desvelar!

Muchas veces hemos oído hablar de la datación del Carbono y, el sistema de datación radiométrica más conocido es el proporcionado por el 14C, o Carbono 14, un isótopo raro de Carbono que se produce en natural por acción de los rayos cósmicos y antropo-génicamente por bombas nucleares. Se desintegra en Nitrogeno (14N) con una vida media de 5.730 años. Como el Carbono 14 es tan poco común (menos de uno de mil átomos de Carbono) y su vida media es tan corta, la datación con radio carbono queda limitada a los últimos cien mil años, aproximadamente.

Las trazas de vida primitiva han sido borradas por la geología, el fluir de las aguas, los UV y por la propia evolución de la vida, los cambios…del Oxígeno, de la atmósfera, etc.

En los materiales más antiguos simplemente no queda suficiente 14C que pueda medirse con precisión. Por consiguiente, el 14C proporciona una herramienta de datación valiosa para egiptólogos o para paleontólogos interesados en Mamuts lanudos, pero no sirve para desentrañar la historia profunda de la Tierra que sus secretos muy bien guardados en lo más profundo de los tiempos.

El grupo Warrawoona

En el Cinturón de Pilgangoora el Grupo Coonterunah de 3.517 millones de años y las granulitas de Carlindi (3.484-3.468 millones de años son la razón fundamental del Grupo Warrawoona bajo un desajuste de erosión, aportando así pruebas de la antigua corteza continental . La Cúpula del Polo Norte (NPD) se encuentra a 10 kilómetros del Grupo Warrawoona.

Son células que se agrupan en colonias formando rocas sedimentarias. Estas rocas se encuentran en mares cálidos y son el resultado de la unión de seres unicelulares, cianobacterias. Las rocas se forman muy lentamente, capa sobre capa y una capa se muere se deposita el carbonato de calcio de sus paredes sobre la capa anterior.

En el Grupo Warrawoona (3.400-3.500 millones de años) se encontraron estructuras sedimentarias que se identificaron como producidas por la actividad de organismos por William Schopf. Debido a identificación, se consideraron esos restos como la huella de vida más antigua de la que se tiene constancia. Son poco comunes (sólo se han encontrado, además de en Warrawoona, en el Supergrupo Pongola , de 2.700-2.500 millones de años, y en el Grupo de Bulawayan de Rhodesia, de 2.800 millones de años), por lo que no se puede estar seguro de que los organismos que los formaran fueran fotosintéticos y tampoco se pueden sacar conclusiones claras acerca de los ambientes en que se formaron. Ciertas bacterias no fotosintéticas forman estructuras similares a estromatolitos en fuentes termales de Yellowstone, por lo que existe la posibilidad de que bacterias similares formaran las estructuras estromolíticas arcaicas.

Estos restos de Warrawoona incluyen microfósiles filamentosos y cocoides muy parecidos a cianobacterias, lo que ha inducido a pensar en la existencia de organismos fotosintéticos aeróbicos.

Son muchas las teorías científicas que, a lo largo de la historia han tratado de explicar el origen de la vida en la Tierra. Ya Aristóteles (384 – 322 aC), en la antigua Grecia, propuso una hipótesis: que la vida surgió por generación espontánea. Esta idea sería rebatida por los experimentos científicos de Louis Pasteur (1822 – 1895). Ahora sabemos que de donde no hay nada puede surgir, sabemos que los elementos se crearon en las estrellas que, en explosiones supernovas son expandidos por todo el universo. Sabemos que esos elementos depositados en mundos bien situados en las zonas habitables de sus estrellas, pueden llegar a constituirse en estructuras complejas de las que pueden surgir, formas de vida poco evolucionadas que, con el tiempo, se transforman en complejas y, en algunos casos, en miles de millones de años de evolución, pasando por fases que las hace ser una vez una cosa y más tarde otra… ¡Pueden llegar hasta la consciencia de Ser!

Sí, muchas son las cosas que no sabemos

Son muchas las cosas que no sabemos y, palabras que empleamos de manera cotidiana de cosas que sabemos para que sirven, como por ejemplo la energía, no sabríamos explicar lo que es. Tampoco sabemos a ciencia cierta y en toda su extensión lo que la materia es, y, si nos referimos al Tiempo… ¿Qué es el Tiempo? ¿Existe en realidad o es una simple ilusión de la mente?

Mientras continuamos tratando se desvelar todos esos secretos, disfrutemos del El Universo, de su rica Diversidad, de la Belleza que nos ofrece por todas partes y, desde luego…, ¡de la Vida! Que no hemos llegado a comprender.

emilio silvera

Jul

28

¿Humano o Robot?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencia futura ~

Clasificado en Ciencia futura ~

Comments (1)

Comments (1)

Aquí dejo un resumen del pensamiento de Roger Penrose sobre este tema tan interesante que, nos regala en su LIbro Las Sombras de la Mente.

¿EL HOMBRE O EL ROBOT?

He dado muchas vueltas a la IA y a la consciencia de los seres vivos. Las conclusiones a las que he podido llegar son que el pensamiento consciente debe involucrar componentes que no pueden ser siquiera simulados adecuadamente por una mera computación; menos aún podría la computación por sí sola, provocar cualquier sentimiento o intención consciente. En consecuencia, la mente debe ser realmente algo que no puede describirse mediante ningún tipo de términos computacionales.

¿Cómo podrá imitar lo que hay en la segunda imagen a lo que vemos en la primera?

Bien es verdad que no tenemos una comprensión científica de la mente humana. Sin embargo, esto no quiere decir que el fenómeno de la consciencia deba permanecer fuera de la explicación científica. Ya se están buscando caminos científicos para dar esa explicación del misterio más profundo (seguramente) del Universo.

La comprensión es, después de todo, de lo que trata la ciencia; y la ciencia es mucho más que la mera computación mecánica.

¿Cuál es el campo de acción de la ciencia? ¿Son solamente los atributos materiales de nuestro Universo los que son abordables con sus métodos, mientras nuestra existencia mental debe quedar para siempre fuera de su alcance? ¿O podríamos llegar algún día a una comprensión científica adecuada del profundo misterio de la mente? ¿Es el fenómeno de la consciencia humana algo que está más allá del dominio de la investigación científica, o podrá la potencia del método científico resolver algún día el problema de la propia existencia de nuestro yo consciente?

Creo que se avecina un cambio importante, y, nuestros cerebros que forman parte del mundo material del Universo, tiene un ingrediente que aún no hemos llegado a comprender. Incluso con nuestra limitada comprensión actual de la naturaleza de este ingrediente ausente en nuestro saber, sí podemos empezar a señalar donde debe estar dejando su huella, y como debería estar aportando una contribución vital a lo que quiera que sea en que subyacen nuestros sentimientos y acciones conscientes.

Una visión científica del mundo que no trate de entender en profundidad el problema de la mente consciente no puede tener pretensiones serias de compleción. La consciencia es parte de nuestro Universo, de modo que cualquier teoría física que no le conceda un lugar apropiado se queda muy lejos de proporcionar una descripción auténtica del mundo.

Claro que, todo conocimiento científico es un arma de dos filos. Lo que realmente hacemos con nuestro conocimiento científico es otra cuestión. Tratemos de ver dónde pueden llevarnos nuestras visiones de la ciencia y la mente.

Pensemos que incluso en aquellos países afortunados donde hay una paz próspera y una libertad democrática, los recursos naturales y humanos son malgastados de formas aparentemente absurdas. ¿No es ésta una clara muestra de la estupidez general del hombre? Aunque creemos representar el pináculo de la inteligencia en el reino animal, esta inteligencia parece tristemente inadecuada para manejar muchos de los problemas a los que nuestra propia sociedad nos obliga a hacer frente.

El grupo de científicos de Cern han iniciado su primer intento de enviar un haz de protones por el Colisionador de Hadrones (LHC: Large Hadron Collider)

Pese a todo, no pueden negarse los logros positivos de nuestra inteligencia. Entre dichos logros se encuentran nuestras impresionantes ciencia y tecnología. En realidad, algunos de estos logros son alto cuestionables a largo (o corto) plazo, así lo atestiguan múltiples problemas medioambientales y un genuino temor a una catástrofe mundial inducida por las nuevas tecnologías traídas de la mano por nuestra moderna sociedad (aquí mismo, en éste foro, se ha expresado el temor sobre las consecuencias que traerá el LHC).

Pero, no podemos mirar para otro lado sin ver que, nuestras tecnologías no sólo nos proporciona una enorme expansión del dominio de nuestro yo físico sino que también amplia nuestras capacidades mentales mejorando en gran medida nuestras habilidades para realizar muchas tareas rutinarias. ¿Qué pasa con las tareas mentales que no son rutinarias, las tareas que requieren inteligencia genuina?

A veces me pregunto si podrían ser los Robots la respuesta. ¿No existe la posibilidad completamente diferente de una enorme expansión de una capacidad mental, a saber, esa inteligencia electrónica ajena que apenas está empezando a emerger de los extraordinarios avances en tecnología de ordenadores? De hecho, con frecuencia nos dirigimos ya a los ordenadores en busca de asistencia intelectual.

Hay muchas circunstancias en las que la inteligencia humana sin ayuda no resulta nada adecuada para prever las consecuencias probables de acciones alternativas. Tales consecuencias pueden quedar mucho más allá del alcance del poder computacional humano; así pues, cabe esperar que los ordenadores del futuro amplíen enormemente este papel, en donde la computación pura y dura proporcione una ayuda incalculable para la inteligencia humana.

Ordenador cuántico en proceso

Pero ¿no cabe la posibilidad de que los ordenadores lleguen finalmente a conseguir mucho más que todo esto? Muchos expertos afirman que los ordenadores nos ofrecen, al menos en principio, el potencial para una inteligencia artificial que al final superará a la nuestra. Una vez que los robots controlados por ordenador alcancen el nivel de “equivalencia humana”, entonces no pasará mucho tiempo, argumentan ellos, antes de que superen rápidamente nuestro propio y exiguo nivel. Sólo entonces, afirman estos expertos, tendremos una autoridad con inteligencia, sabiduría y entendimiento suficientes que sea capaz de resolver los problemas de este mundo que ha creado la humanidad.

A todo esto señalan el rapidísimo crecimiento exponencial de la potencia de los ordenadores y basan sus estimaciones en comparación entre la velocidad y precisión de los transistores, y la relativa lentitud y poca sólida acción de las neuronas. De hecho, los circuitos electrónicos son ya más de un millón de veces más rápido que el disparo de las neuronas en el cerebro (siendo la velocidad de aproximadamente 10 exp. 9 segundos para los transistores y de 10 exp. 3 segundos para las neuronas, y tienen una exactitud cronométrica y una precisión de acción que de ningún modo comparten las neuronas.

El Chip Intel Pentium tiene más de tres millones de de transistores en una “rodaja de silicio” del tamaño aproximado de una uña del pulgar, capaz cada uno de ellos de realizar 113 millones de instrucciones por segundo.

Se argumenta que el número total de neuronas de un cerebro humano (unos cientos de miles de millones) supera absolutamente al número de transistores de un ordenador. Además, existen muchas más conexiones, en promedio, entre neuronas diferentes que las que existen entre los transistores de un ordenador. En particular las células de Purkinje en el cerebelo pueden tener hasta ochenta mil terminaciones sinápticas (uniones entre neuronas), mientras que para un ordenador, el número correspondiente es de tres o cuatro a lo sumo. Además, la mayoría de los transistores de los ordenadores actuales están relacionados solamente con la memoria y no directamente con la acción computacional, mientras que tal acción computacional podría estar mucho más extendida en el caso del cerebro.

No necesitan comer, no les afecta la radiación del Espacio, no tienen que dormir, sus recambios están a mano y pueden alcanzar la inmortalidad, tienen una fuerza descomunal…

Si hiciéramos caso de las afirmaciones más extremas de los defensores más locuaces de la IA, y aceptáramos que los ordenadores y los robots guiados por ordenador superarán con el tiempo (quizá en muy poco tiempo) todas las capacidades humanas, entonces los ordenadores serían capaces de hacer muchísimo más que ayudar simplemente a nuestras inteligencias. Podríamos entonces dirigirnos a estas inteligencias superiores en busca de consejo y autoridad en todas las cuestiones de interés; ¡y finalmente podrían resolverse los problemas del mundo generados por la humanidad!

Pero parece haber otra consecuencia lógica de estos desarrollos potenciales que muy bien podría producirnos una alarma genuina. ¿No harían estos ordenadores a la largo superfluos a los propios humanos? Si los robots guiados por ordenador resultaran ser superiores a nosotros en todos los aspectos, entonces ¿no descubrirían que pueden dirigir el mundo sin ninguna necesidad de nosotros? La propia humanidad se habría quedado obsoleta. Quizá si tenemos suerte, ellos podrían conservarnos como animales de compañía.

Esperemos que la Mente Humana y los pensamientos originales prevalezcan sobre esa otra “especie” nueva que, a no tardar mucho tendremos conviviendo con nosotros… ¿No sabemos con qué resultado!

Yo, como he dejado claro otras veces. Soy partidario de pensar que, una cosa es la Inteligencia Artificial y otra muy distinta es el pensamiento consciente, muy superior a aquella que trabaja sólo con los datos suministrados previamente, sin poder de repentizar una solución que no esté en su programación. ¿Llegarán los robots algún día a pensar por sí mismos, como ahora lo hacemos nosotros?

La cuestión no es nada sencilla y plantea muchas variantes de entre las que, así, de momento, podríamos exponer aquí las siguientes:

- Todo pensamiento es computación; en particular, las sensaciones de conocimiento consciente son provocadas simplemente por la ejecución de computaciones apropiadas.

- El conocimiento es un aspecto de la acción física del cerebro; y si bien cualquier acción física puede ser simulada computacionalmente, la simulación computacional no puede por sí misma provocar conocimiento.

- La acción física apropiada del cerebro provoca conocimiento, pero esta acción física nunca puede ser simulada adecuadamente de forma computacional.

- El conocimiento no puede explicarse en términos físicos, computacionales o cualesquiera otros términos científicos.

Está claro que adentrarnos aquí a ciertas profundidades del pensamiento, no parece adecuado ni al momento ni al lugar, sin embargo, debemos pensar en que, la propia materia parece tener una existencia meramente transitoria puesto que puede transformarse de una forma en otra. Incluso la masa de un cuerpo material , que proporciona una medida física precisa de la cantidad de materia que contiene el cuerpo, puede transformarse en circunstancias apropiadas en pura energía (según E=mc2) de modo que incluso la sustancia material parece ser capaz de transformarse en algo con una actualidad meramente matemática y teórica.

De todas las maneras, por mi parte, me quedo con el punto tercero de los enumerados anteriormente, es un punto de vista más operacional que el anterior, puesto que afirma que existen manifestaciones externas conscientes (por ejemplo, cerebros) que difieren de las manifestaciones externas de un ordenador: los efectos externos de la consciencia no pueden ser correctamente simulados por un ordenador.

Trabajarán codo con codo con nosotros

¿Permite la Física actual la posibilidad de una acción que, en principio, sea imposible de simular en un ordenador? La respuesta no está completamente clara, sin embargo, según creo, es que tal acción no computacional tendría que encontrarse en un área de la física que está fuera de las leyes físicas actualmente conocidas.

Claro que, en este simple comentario, no queda claro quien será el vencedor final: Fisicalismo frente a Mentalismo. Seremos tan estúpidos como para poder crear máquinas que nos superen en inteligencia hasta el punto de que puedan dominarnos.

Ahí queda la pregunta flotando en el aire.

emilio silvera

Totales: 75.605.455

Totales: 75.605.455 Conectados: 18

Conectados: 18