Ago

16

Un comentario sobre el trabajo que sigue

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

|

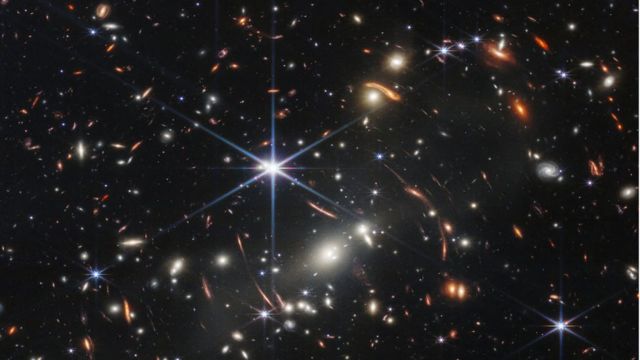

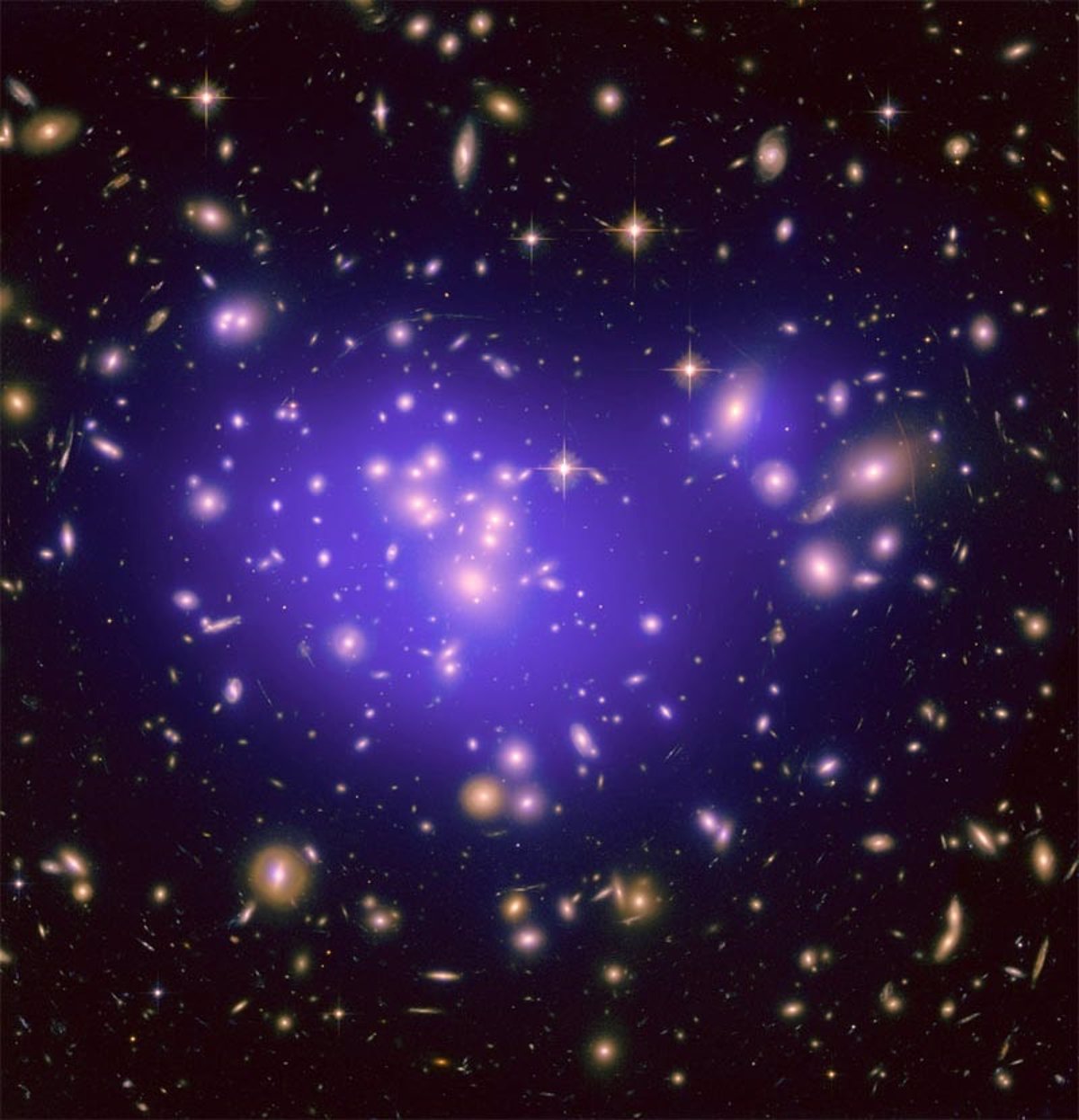

¡Las escalas del Universo no son Humanas! ¿Y, cómo podrían serlo? Hablamos de estrellas súper-gigantes que tienen millones de veces la masa de todo el sistema solar, de Nebulosas que abarcan extensiones de muchos años luz, de Agujeros negros gigantes en los que la fuerza de Gravedad que generan atraen a estrellas que viven en su vecindad, hablamos de súper-cúmulos de galaxias, de espacios vacíos inmensos o de extraños objetos que aún no hemos podido saber lo que son, y, hablando de grandeza, hablamos de un Universo que tiene un diámetro que, para nosotros, no es comprensible del todo. Y, si a todo esto añadimos la presencia de la Vida en ese inconmensurable “globo” que llamamos Universo, pues entonces, la complejidad se agranda hasta tal punto que para nosotros todo resulta tan incomprensible que lo único que podemos hacer es (con los pocos datos de que podamos disponer), especular y construir teorías de lo que podría ser. Hay que reconocer que tenemos la suerte de saber que pertenecemos a algo mucho mayor, que nosotros, en el contexto del Universo, somos tan poca cosa como para que, cuando nos vayamos de este mundo, ninguna estrella dejará de brillar, nuestra importancia sólo es familiar y localista, quitando a la familia y a los amigos y conocidos, ¿A quién les podemos importar? Nos damos mucha más importancia de la que tenemos, y, también, nos creemos que sanemos mucho más de lo que en realidad sabemos. ¡Las preguntas siguen siendo más, mucho más que las respuestas! Cada cosa tendrá su importancia pero, ¡todas son! Claro que, como decía el sabio: “Todas las cosas son” Y, con aquellas sencillas palabras elevó a todas las “cosas· a la categoría de Ser. Lo que no quiere decir que al estar ubicados ahí, podamos darnos más importancia de la que en realidad tenemos. |

Ago

16

Las escalas del Universo no son humanas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Es fácil caer en la tentación de mirarnos el ombligo y no hacerlo al entorno que nos rodea. Muchas más cosas habríamos evitado y habríamos descubierto si por una sola vez hubiésemos dejado el ego a un lado y, en lugar de estar pendientes de nosotros mismos, lo hubiéramos hecho con respecto a la Naturaleza que, en definitiva, es la que nos enseña el camino a seguir.

La edad actual del universo visible ≈ 1060 tiempos de Planck

Tamaño actual del Universo visible ≈ 1060 longitudes de Planck

La masa actual del Universo visible ≈ 1060 masas de Planck

Vemos así que la bajísima densidad de materia en el universo es un reflejo del hecho de que:

Densidad actual del universo visible ≈10-120 de la densidad de Planck

Y la temperatura del espacio, a 3 grados sobre el cero absoluto es, por tanto

Temperatura actual del Universo visible ≈ 10-30 de la Planck

Estos números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el universo está estructurado en una escala sobrehumana de proporciones asombrosas cuando la sopesamos en los balances de su propia construcción.

Con respecto a sus propios patrones, el universo es viejo. El tiempo de vida natural de un mundo gobernado por la gravedad, la relatividad y la mecánica cuántica es el fugaz breve tiempo de Planck. Parece que es mucho más viejo de lo que debería ser.

Pero, pese a la enorme edad del universo en “tics” de Tiempo de Planck, hemos aprendido que casi todo este tiempo es necesario para producir estrellas y los elementos químicos que traen la vida.

“En el final del universo uno tiene que utilizar mucho el tiempo pretérito… todo ha sido hecho, ¿sabes?”.

Douglas Adams

¿Por qué nuestro universo no es mucho más viejo de lo que parece ser? Es fácil entender por qué el universo no es mucho más joven. Las estrellas tardan mucho tiempo en formarse y producir elementos más pesados que son las que requiere la complejidad biológica. Pero los universos viejos también tienen sus problemas. Conforme pasa el tiempo en el universo el proceso de formación de estrellas se frena. Todo el gas y el polvo cósmico que constituyen las materias primas de las estrellas habrían sido procesados por las estrellas y lanzados al espacio intergaláctico donde no pueden enfriarse y fundirse en nuevas estrellas. Pocas estrellas hacen que, a su vez, también sean pocos los sistemas solares y los planetas. Los planetas que se forman son menos activos que los que se formaron antes, la entropía va debilitando la energía del sistema para realizar trabajo. La producción de elementos radiactivos en las estrellas disminuirá, y los que se formen tendrán semividas más largas. Los nuevos planetas serán menos activos geológicamente y carecerán de muchos de los movimientos internos que impulsan el vulcanismo, la deriva continental y la elevación de las montañas en el planeta. Si esto también hace menos probable la presencia de un campo magnético en un planeta, entonces será muy poco probable que la vida evolucione hasta formas complejas.

El Sol es una estrella pequeña amarilla de la clase G2V. En la Galaxia existen 30.000 Millones

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre las atmósferas de los planetas en órbitas a su alrededor y, a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagar infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra, habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la Luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución que tantos miles de millones de años le costó al Universo para poder plasmarla en una realidad que llamamos vida.

El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema solar habitado observado, ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales; el t(bio) – tiempo biológico para la aparición de la vida – algo más extenso.

El tiempo de las estrellas está directamente relacionado con la aparición de la vida en el planeta

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la foto-disociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

Así era la Tierra cuando surgió aquella primera célula replicante que dio comienzo a la fascinante historia de la Vida que en poco más de mil millones de años evolucionó y en otros tres mil llegó hasta nosotros.

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

A muchos les cuesta trabajo admitir la presencia de vida en el universo como algo natural y corriente, ellos abogan por la inevitabilidad de un universo grande y frío en el que es difícil la aparición de la vida, y en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

Algunas podrían estar bajo nuestras narices y no saber verlas al confundirlas con objetos inertes, No sabremos lo que encontraremos en otros mundos hasta que no podamos ir a ellos.

Los biólogos, sin embargo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de las estimaciones de la probabilidad de que haya inteligencias extraterrestres en el universo se centran en formas de vida similares a nosotros que habiten en planetas parecidos a la Tierra y que necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1.957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el universo.

emilio silvera

Ago

16

La Tecnología de Vacío en la simulación Espacial

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

De Jesús Manuel Sobrado y José Ángel Martín-Gago

Vivimos en una burbuja de vacío cósmico

La Tierra está rodeada, esencialmente, de vacío. Por tanto, una de las formas de profundizar en el conocimiento del espacio es mediante la utilización de equipos de vacío. No sólo se trata de comprender el funcionamiento de los cuerpos celestes o de los procesos que ocurren en el espacio sino también en la superficie de muchos de los planetas, incluyendo las capas altas de la atmósfera terrestre. Un sistema de vacío puede ser un entorno adecuado donde recrear diferentes ambientes espaciales controlando algunos de los parámetros físicos del sistema (como presión total, composición de los gases, radiación, temperatura…). La simulación espacial utilizando equipos de vacío es una poderosa herramienta para preparar misiones espaciales, interpretar datos de las mismas o simplemente para investigar cómo se comporta la materia en esas condiciones.

1. Introducción

Con el lanzamiento del primer satélite Sputnik [1] comienza una nueva era tecnológica que ha permitido a la humanidad explorar el universo físicamente [2]. Este año se ha cumplido el 40 aniversario de la llegada del hombre a la Luna. Del fruto de este empeño y de otros de la misma naturaleza, como fue el primer la puesta en marcha del proyecto internacional común para la construcción de la estación espacial internacional, la sociedad ha obtenido un elevado beneficio tecnológico.

Podemos afirmar que la frase pronunciada por Neil Armstrong cuando pisó Luna se ha hecho realidad: “Este es un pequeño paso para el hombre, pero un gran paso para la humanidad”.

La ventana abierta hacia el espacio nos acerca al conocimiento que tenemos sobre nosotros mismos. No olvidemos que formamos parte del sistema solar en el planeta Tierra y que estamos, por tanto, rodeados de vacío, en medio de fuerzas gravitatorias y electromagnéticas, que convierten nuestro planeta en una maravillosa perla azul en un vasto territorio negro. (En 1990, en la misión “Voyager”, Carl Sagan, insistió antes de que la sonda abandonase el sistema solar, que tomase fotografías de la tierra vista desde el exterior.

Las imágenes tardaban 5 horas y media en ser recibidas en la Tierra) [3]. Fruto de esta necesidad de conocimiento surge el planteamiento de buscar nuevas formas de conocer el espacio que nos rodea. El espacio está esencialmente vacío.

Parece por tanto evidente, que los avanzados sistemas de vacío actuales puedan ayudarnos a comprender mejor los procesos y mecanismos que ocurren fuera de la atmósfera terrestre.

No sólo en el espacio interestelar, sino también sobre la superficie de muchos de los planetas y objetos celestes en los que su presión atmosférica sea menor que la terrestre. Así, un sistema de vacío puede ser un entorno adecuado donde recrear diferentes ambientes espaciales, controlando algunos de los parámetros físicos del sistema para poder aprender sin necesidad de desplazarnos materialmente.

Las misiones espaciales presentan un número elevado de inconvenientes. Una de las principales críticas que han recibido siempre es su elevado coste. Por ejemplo, una misión “económica” a Marte, como pudo ser la Mars Express, tuvo un costo aproximado de unos 1000 millones de euros. Otro inconveniente es el largo tiempo necesario para realizarlas, ya que desde que una misión se concibe en los despachos hasta que se concluye pasa más de una década. Parece por tanto necesario asegurar todos los parámetros y, para ello, probar y calibrar lo mejor posible y en las mismas condiciones de operación, la instrumentación de la misión. Este es el marco en el que hay que entender la simulación en sistemas de vacío. Como una plataforma que nos permita reproducir condiciones planetarias e interestelares. Esta simulación tiene, por tanto, un doble objetivo. Por una parte preparar las misiones espaciales y, por otra, ayudar a entender los resultados obtenidos por las mismas.

La simulación de un problema complejo permite acotar y separar de forma controlada las variables relevantes de un sistema aislado. Es una manera de resolver pequeños problemas obteniendo valiosa información sobre el funcionamiento de sistemas en condiciones muy especificas. De este modo se van creando parámetros o esquemas de comportamiento que son fácilmente reproducibles, si se respetan todas las variables iníciales. Es importante conocer las limitaciones de la simulación. Al realizar la simulación en la Tierra, son dos normalmente los factores limitantes, las dimensiones de la cámara de vacío y la gravedad [4]. Este último es el menos relevante, ya que en la simulación de atmósferas o superficies planetarias, la gravedad es un factor existente que no determina las condiciones climatológicas de la atmósfera.

Simulaciones en la Cámara de Vacío

Sin embargo las dimensiones si son importantes, ya que limitan las diferentes gradientes de presión y temperatura, así como los niveles de radiación en función de la altura a la superficie. El volumen interno de una cámara así como la superficie interna limitan la transferencia de energía (calor), y por tanto la homogeneidad del sistema. En este trabajo vamos a describir como recrear distintos ambientes espaciales y planetarios mediante el uso de entornos de vacío. Daño del ADN por la radiación espacial, estabilidad de fases cristalinas de minerales en la superficie de Marte, comportamiento de sensores frente al polvo marciano o supervivencia de esporas en un viaje especial o superficie planetaria, son algunos ejemplos de una interminable lista de temas interdisciplinar que se pueden estudiar en equipos de simulación. Veremos cuáles son los parámetros importantes para reproducir una atmósfera planetaria en un laboratorio, o para poder estudiar los hielos que se forman en el medio interestelar denso. Estas ideas se han materializado en la creación de una serie de máquinas de vacío que describiremos y que están operativas dentro de la unidad de simulación de ambientes planetarios y microscopía del Centro de Astrobiología [5]. 2. La simulación espacial y de atmósferas planetarias Planetas con atmósferas singulares, residuos de explosión de estrellas, espacio profundo o la entrada de meteoritos en una atmósfera planetaria, son algunos de los objetos y procesos que ocurren en el espacio. Un entorno espacial se puede caracterizar en función de muchos parámetros, que cruzados dan como resultado la recreación de un sistema concreto. Las principales variables que definen un sistema de simulación en un entorno espacial son la presión total, la composición de gases, la temperatura local o en la superficie de objetos planetarios, la temperatura ambiental, y la radiación recibida.

Estas variables son muy generales. Para poder implementar una instrumentación adecuada que responda a un determinado problema, es necesario conocer su rango de variación [6]. A partir de este dato se desarrolla la tecnología necesaria para poder controlar y monitorizar estas variables en un entorno de vacío. Vamos a hacer un repaso de los rangos de cada una de ellas y del tipo de instrumentación que deberíamos utilizar en cada caso.

Planetas con atmósferas singulares, residuos de explosión de estrellas, espacio profundo o la entrada de meteoritos en una atmósfera planetaria, son algunos de los objetos y procesos que ocurren en el espacio. Un entorno espacial se puede caracterizar en función de muchos parámetros, que cruzados dan como resultado la recreación de un sistema concreto. Las principales variables que definen un sistema de simulación en un entorno espacial son la presión total, la composición de gases, la temperatura local o en la superficie de objetos planetarios, la temperatura ambiental, y la radiación recibida.

Estas variables son muy generales. Para poder implementar una instrumentación adecuada que responda a un determinado problema, es necesario conocer su rango de variación [6]. A partir de este dato se desarrolla la tecnología necesaria para poder controlar y monitorizar estas variables en un entorno de vacío. Vamos a hacer un repaso de los rangos de cada una de ellas y del tipo de instrumentación que deberíamos utilizar en cada caso.

Puesto que vamos a utilizar para la simulación sistemas de vacío, la presión total debe de ser menor que la presión atmosférica. Esta es la primera limitación, que excluye automáticamente el estudio de planetas como Venus, cuya presión en la superficie es unas 90 veces mayor que la de la Tierra [7]. Estos planetas, así como el interior de océanos y mares de hielo que puedan existir en objetos planetarios como Europa (luna de Júpiter), deben de estudiarse mediante cámaras de alta presión, que incorporan una tecnología completamente distinta.

Es muy difícil dar valores precisos para la presión total en diferentes entornos planetarios o interestelares, y de hecho se encuentra frecuentemente bibliografía contradictoria. No obstante intentaremos dar algunas estimaciones y sobre todo, los rangos aproximados de estos parámetros para algunos entornos espaciales.

En el espacio interplanetario, por ejemplo, la presión viene determinada por el viento solar y por moléculas provenientes de las atmósferas de los distintos cuerpos celestes que lo pueblan, como cometas, o planetas. En física del espacio se suele utilizar la presión dinámica, que se define como:

Esta fórmula, aplicada para el viento solar en las inmediaciones de la Tierra, que tiene un número de partículas aproximadode 4 por cm como del orden de vacío es el Pascal, 1 mbar se empleaba el Torr, como homenaje a Evangelista Torricelli. 1 mbar = 0,75 Torr [mm Hg]. Nosotros en este trabajo utilizaremos el mbar, que aunque no es la unidad en el sistema internacional, es la utilizada mayoritariamente por la comunidad científico-tecnológica en equipos de alto y ultra alto vacío).

El viento solar lo forman protones, partículas alfa, iones pesados y electrones, que fluyen desde la superficie del Sol con velocidades de hasta 800 Km/s. Como el viento solar es un plasma, este lleva consigo parte del campo magnético solar, por lo que las partículas de viento solar que son atrapadas en el campo magnético terrestre provocan entre otras cosas las auroras boreales y australes cuando chocan con la atmósfera terrestre cerca de los polos. Sabemos que el borde del sistema solar lo forma la burbuja del viento solar en el medio interestelar.

En el punto en el que el viento solar no ejerce presión para desplazar el medio interestelar, se considera que es el borde más exterior del sistema solar [8].

Si nos acercamos a algún cuerpo celeste, es la emisión de gases del mismo la que limita la presión total. Así, por ejemplo, cerca de la estación espacial internacional la presión viene determinada por los propios gases de la estación y otras partículas atrapadas por el campo gravitatorio de la misma, siendo esta del orden de Fuera del espacio interplanetario, en donde las temperaturas son muy bajas y la densidad molecular prácticamente inexistente, el concepto de presión deja de tener sentido. Sin embargo, encontramos zonas del espacio interestelar, las llamadas nubes de polvo, en las que se detecta acumulación de material.

Así, en el llamado medio interestelar difuso, (aquel cuya densidad es menor que el principal componente gaseoso es el hidrógeno atómico.

A causa de la gran cantidad de fotones y rayos cósmicos la temperatura típica del polvo en el medio interestelar difuso es de 100 K y sus principales componentes, según se deduce de las observaciones por absorción en el infrarrojo, son el hidrógeno, silicatos amorfos y carbono amorfo hidrogenado.

Su presión, puede ser estimada entonces como del orden de medio denso (nubes moleculares con densidades entre 103 – 106 partículas $ cm-3), cuyo principal componente gaseoso es el hidrógeno molecular. Aunque la densidad molecular en este caso es mucho mayor, la temperatura es muy baja en su interior, hasta unos 10 K, debido al apantallamiento de la radiación UV en las capas externas de la nube.

Las partículas de polvo, como las presentes en el medio difuso, se cubren de mantos de hielo con espesores del orden de 0.01 micras. Por tanto la presión total puede ser del orden de 10 -12 – 10 -18 mbar.

Se ha dicho en algunas ocasiones que las presiones del medio interestelar no son alcanzables en un laboratorio. Esto no es del todo cierto. En realidad no son medibles. En algunas líneas criogénicas de He líquido, se estima que la presión residual puede ser de 10-30 mbar, y es debida exclusivamente a la desorción por rayos cósmicos de los gases de las paredes del recipiente. El problema reside en que no existe actualmente tecnología para medir el vacío por debajo de 10-14 – 10-15 mbar. En el CERN, con manómetros modificados del tipo Bayard-Alpert se han podido medir presiones de hasta 2 $ 10-14 mbar [9].

En el caso de la mayor parte de los planetas la presión si es una magnitud alcanzable y con sentido físico. Así la presión media en la superficie de Marte es de unos 7 mbar, o en Tritón de 10-2 mbar. Las atmósferas planetarias de la mayoría de los cuerpos del sistema solar son conocidas por observaciones de IR. Sin embargo, no hay que olvidar que la presión total en un planeta depende de la altura. Por ejemplo, en la tierra a 86.000 m de altura la presión es de 10-2 mbar. (100.000 veces menor que la atmosférica). Por tanto debemos tener en cuenta esta dependencia cuando queramos simular la presión en la atmósfera marciana o la superficie marciana.

La figura 1 representa una gráfica en la que se resumen los distintos rangos del vacío junto con las bombas necesarias para alcanzarlos. En la figura vemos que las presiones interplanetarias y del medio interestelar son sólo reproducibles en sistemas trabajando en las llamadas de vacío extremo (XHV-del inglés, extreme high vacuum). Sin embargo, experimentos que se realicen en la estación espacial internacional, pueden simularse utilizando una bomba turbo molecular.

No sólo es necesario elegir el tipo de bombas adecuado para llegar a una u otra presión. También es necesario contar con distintos tipos de sensores, desde el Pirani y el piezoresistivo, para vacío bajo, capacitivo para vacíos medios y terminando en sensores tipo Penning o Bayard-Alpert para alto vacío y ultra alto vacío y vacío extremo.

La composición atmosférica

El siguiente parámetro relevante para controlar en una cámara de simulación es la composición de los gases de la atmósfera. De nuevo la primera división es entre composición de gases en medio interestelar denso y superficies planetarias. La principal fuente de información para la composición atmosférica son espectros de infrarrojo tomados por telescopios orbitales o por satélites. Por ejemplo en el caso de Marte la atmósfera es muy compleja. Se han detectado composiciones medias de 95% CO2, 2,7% N2, 1.6% Ar y 0.6% H2O.

En el caso de otros planetas como Europa, luna Galileana de Júpiter, la presión está formada en más de un 95% de O2 y en el caso del interior de una cámara de vacío a 10-11– mbar en el laboratorio, casi el 100% es hidrógeno.

La composición atmosférica según el medio interestelar denso es esencialmente hidrógeno tanto en forma molecular como gaseosa. En estos medios existen también una densidad no despreciable de otras moléculas, de composición orgánica y mineral, que se recombinan entre ellas dando lugar a lo que se conoce como Astroquímica. Por ejemplo, en el interior de la nube situada tras la nebulosa de Orión, el gas adquiere la densidad suficiente y la baja temperatura necesaria para que los átomos se enlacen y formen moléculas, en las que predomina el hidrógeno molecular y hay trazas de monóxido de carbono, cianógeno y amoniaco [10], entre otras moléculas.

El control de la composición de gases en el sistema de simulación se realiza mediante la inclusión de detectores de masa cuadrupolares. Estos detectores ionizan el gas separando cada molécula según su relación carga/masa. Sabiendo la masa molecular podemos, identificarla en muchos casos y cuantificar su número. Este instrumento, mediante bombeo diferencial, puede operarse desde presión atmosférica. Sin embargo, a presiones inferiores de 10-5 mbar puede utilizarse con mayor resolución.

Para estar seguros de la composición de la atmósfera es preciso primero hacer el mejor vacío posible, y luego introducir la composición de gases deseada. Es por tanto importante controlar la composición de la presión residual en el sistema de simulación. En un sistema de alto-vacío con cierres KF, y bombeado con una bomba turbo molecular la presión residual parcial de cada uno de los gases está determinada por la velocidad efectiva de bombeo de la bomba turbo molecular (es distinta para cada composición gaseosa), y por la tasa de fugas en cierres de juntas de vitón (KF y LF), situándose en 10-8 mbar. Por tanto, planetas como Europa no pueden simularse utilizando este tipo de cierres. En un sistema con cierres de UHV (ultra alto vacío), la presión mínima está determinada por la permeabilidad del hidrogeno en cámaras de vacío de acero inoxidable 316 L o aluminio, que está en el orden de 10-13– mbar.

Para introducir atmósferas complejas, como por ejemplo la de Marte, en el interior de las cámaras de vacío o sistema de simulación, se han desarrollado mezcladores (y evaporadores para el caso del agua) en los que se controla la presión parcial de cada uno de ellos mediante un espectrómetro de masas cuadrupolar antes de introducirlos en el sistema. Estos mezcladores pueden incorporar caudalímetros para experimentos en los que se requiera un control más preciso sobre alguno de los componentes atmosféricos. La mezcla de los gases en los sistemas de simulación se realiza mediante válvulas de fugas o sistemas de capilar controlados por válvulas de aguja. Las válvulas de fuga permiten una entrada de gas controlada hasta 2 $ 10-10 mbar litro/s, mediante el ajuste cónico de dos piezas metálicas una de cobre (metal blando) y la otra de acero (metal duro), de este modo la pieza de cobre se garantiza la estanqueidad ya que recupera su forma original después de cada cierre. En cuanto a los capilares permiten, o bien introducir o extraer gas desde el punto exacto donde comienza el capilar, esto permite además generar flujos en el interior de la cámara de simulación.

La temperatura

El concepto de temperatura es de difícil aplicación, ya que es un concepto termodinámico que se aplica a sistemas en equilibrio. En el espacio, el campo de temperaturas es quizá más amplio que el de las presiones. En planetas cercanos al Sol, puede superar varios cientos de grados y en los hielos de los cometas llega a pocos Kelvin.

La temperatura en la superficie de los objetos planetarios es fácilmente controlable con un criostato refrigerado con He líquido, en el que se pueden realizar ciclos de temperatura simulando por ejemplo, variaciones estacionales o diarias. Para ello, una vez enfriado el material que queremos estudiar en condiciones espaciales, un pequeño filamento nos permite aumentar la temperatura y ajustarla mediante un controlador PID a los valores deseados. Como ya hemos indicado, la temperatura en nubes densas de gas del medio interestelar viene determinada por la interacción de la materia con la radiación UV y rayos cósmicos. Esta temperatura es del orden de 10 K en el interior de la nube. Sin embargo en planetas con atmósfera muy ligera o prácticamente inexistente puede oscilar entre la noche y el día entre 400 K y 100 K,como puede ser el caso de la Luna, o entre 300 K y 135 K en los polos de Marte. La temperatura sobre un cristalito de hielo, por ejemplo de dióxido de carbono, que se pueda crear en el espacio interestelar, puede simularse depositando el gas sobre una ventana transparente de un criostato, que a través de un dedo frío, permite enfriar a 4 K.

Para las medidas de bajas temperaturas se emplean diodos de germanio y silicio, y para el resto de temperaturas hay un espectro amplísimo, que va desde distintos tipos de termopares, pasando por hilos de platino y acabando en Pirómetros ópticos.

Controlar la temperatura ambiental es un proceso más difícil de controlar de manera estable, aunque es relativamente sencillo monitorizarla. La temperatura como manifestación de la energía se transfiere mediante conducción, convección y radiación. En entornos interplanetarios como en ultra alto vacío y vacío extremo sólo se transfiere mediante radiación, y en atmósferas planetarias normalmente mediante convección y radiación. Solamente se le añade la conducción en la superficie de los planetas. En una cámara de simulación juega un papel muy importante las dimensiones, ya que estas condicionan el volumen interno y la superficie de radiación, con lo que se convierte en el factor determinante a la hora de poder cambiar la temperatura ambiental de la atmósfera en función de la temperatura del contenedor, en este caso las paredes de la cámara de vacío.

En los sistemas de simulación es realmente complejo establecer una temperatura homogénea para un volumen relativamente pequeño (50 l), como en una cámara destinada a la verificación de sensores, por lo que se suele emplear es un intercambiador de calor interno refrigerado por nitrógeno líquido, acompañando una resistencia externa que recubre todas la paredes de la cámara y utilizando un gas con una alta movilidad como es el helio. De este modo se consigue una cierta homogeneidad de la temperatura ambiental en detrimento de la composición gaseosa original de la atmósfera planetaria.

Los sistemas desarrollados para medir la temperatura ambiental están basados en conjuntos de sensores repartidos por todo el volumen de la cámara, y a la vez aislados térmicamente, para poder crear un mapa tridimensional de temperaturas en el interior de la cámara de vacío. Así, por ejemplo, la figura 2 representa una simulación mediante ordenador mostrando un diagrama de temperaturas de la cámara MARTE, cuando se resuelve la ecuación del calor en dos dimensiones mediante elementos finitos. Este estudio previo es necesario para poder entender cómo se comporta la temperatura ambiental antes de realizar una prueba experimental. En el caso de la figura 2 todas las

paredes externas así como los anillos interiores se encuentran a temperatura ambiental de 300 K, la parte inferior del porta muestras a 77 K (refrigerado por nitrógeno líquido), y la superior a 150 K (controlado térmicamente mediante un controlador PID, Proporcional Integral Diferencial), en un ambiente a 7 mbar en atmósfera de Marte. La figura 2 muestra el gradiente de temperatura ambiental en función de la distancia, en un plano medio de la cámara, que cuenta con simetría cilíndrica en el eje central vertical.

Así sería el interior de Marte

En el artículo original: Representación de la temperatura, en el interior de la cámara

MARTE, en el plano central de la misma. (La cámara MARTE presenta

simetría cilíndrica en el eje central vertical).

Las fuentes de irradiación

Para concluir esta revisión de parámetros relevantes para la simulación de entornos espaciales, nos falta añadir la radiación. En el sistema solar la mayor parte de la radiación recibida en la superficie de los planetas es UV (ultravioleta), que es generada en el laboratorio normalmente mediante una fuente de xenón. En el caso de vacío interplanetario, tenemos además electrones, iones y rayos X, que son generados en el laboratorio por fuentes de radiación específicas. Aunque las fuentes más comunes de electrones e iones tienen energías muy inferiores a las producidas por el viento solar pueden ayudar a hacerse una idea del tipo de alteraciones químicas que ocasionan.

Como hemos dicho cruzando todas estas variables generamos un entorno espacial. Entorno sobre el que podemos realizar multitud de estudios científicos y tecnológicos, apoyados en instrumentación específica como es el caso de interferómetros de Fourier en el infrarrojo FTIR y espectroscopia Raman, que nos permitan seguir en tiempo real los cambios químico-físicos que se producen.

La unidad de simulación de ambientes planetarios del CAB

Un ejemplo de aplicación de las ideas expuestas anteriormente lo podemos encontrar en la Unidad de Simulación de Ambientes Planetarios y Microscopia, del Centro de Astrobiología (centro mixto INTA-CSIC). El principal objetivo de la unidad es el de prestar apoyo técnico y tecnológico a los científicos usuarios del CAB y cualquier otro investigador interesado en la realización de experimentos

relacionados con el vacío y la simulación espacial.

Fig.3. Fotografía de la Unidad de Simulación de Ambientes Planetarios

y Microscopia en el centro de Astrobiología (INTA-CSIC).

La unidad cuenta actualmente con diversas máquinas de vacío dedicadas a la simulación de diferentes sistemas espaciales. Cada una de ellas está concebida para estudiar distintas facetas de diferentes entornos. En este sentido, las más importantes y representativas son: PASC (Planetary Atmospheres Simulation Chamber), ISAC (Interstellar Astrochemistry Chamber), MARTE (Mars Simulation Chamber) y TUNEL (Túnel de viento en vacío). Pasaremos a describir las más representativas tecnológicamente en la simulación de ambientes planetarios e interplanetarios [11].

ISAC (InterstellarAstrochemistry Chamber)

La primera aplicación de simulación espacial la encontramos en la simulación de ambientes interestelares y circun-estelares.

Uno de los objetivos científicos principales es el estudio de la naturaleza (las propiedades físico-químicas), el origen y la evolución de las partículas de polvo, de composición carbonácea/orgánica y/o mineral, en su periplo desde las atmósferas estelares, pasando por el medio interestelar hasta la nebulosa solar, para dar lugar a la formación de cometas, asteroides y planetas. Además se estudian las implicaciones astrobiológicas de dicha materia. Para tal fin es necesario entender la relación entre la materia observada en el espacio (radioastronomía y astronomía en el infrarrojo), la materia orgánica producida por procesos primarios (procesamiento fotónico e iónico de hielos) y simulacionesexperimentales del procesamiento de hielos (annealing térmico e irradiación). ISAC ha sido diseñada para tal efecto.

Describiremos la tecnología y las aplicaciones de ISAC [12], que cuenta con el diseño y la tecnología adecuados para trabajar en presiones por debajo de 10-10 mbar. Combinando bombas de absorción sin evaporación (NEG), y sublimadoras de Ti podemos alcanzar presiones de 2 $ 10-11 mbar. Esta máquina incorpora un criostato que permite bajar la temperatura hasta 7 K. A esta temperatura, una mezcla de gases que se introduce en el sistema, como los que se han detectado en las nubes de polvo interestelar, forman una capa de hielo en el criostato. El hielo de composición análoga a los mantos de hielo interestelares se puede irradiar con una fuente de ultravioleta de vacío y espectro parecido a la radiación presente en el medio difuso interestelar. Al mismo tiempo, tanto la composición química del hielo como su alteración debida a la irradiación pueden estudiarse in situ mediante espectroscopia infrarroja (FTIR) en transmisión y Raman. Las moléculas que desorben del hielo durante el calentamiento (desorción térmica) o la irradiación ultravioleta (foto-desorción) son detectadas por QMS. El avance en nuevas bombas de absorción no evaporables, bombas NEG (Non Evaporable Getter), combinado con una optimización del volumen y una correcta disposición de las bombas de vacío así como una desgasificación de la misma en un horno de vacío en el proceso de fabricación, hace posible pasar de UHV a XHV, permitiendo, alcanzarpresiones en torno a 10-11 mbar, en tan sólo 48 horas desde su puesta en marcha. Otro punto muy destacable y tecnológicamente viable pero complejo, es el de la preparación de mezclas de gases con una resolución en ppm (partes por millón), gracias al innovador diseño de una línea de gases que funciona con electroválvulas en condiciones de flujo laminar, mezcladores en vacío, monitorizados por un espectrómetro de masas o cuadrupolo en RF (radio frecuencia), que permiten una vez obtenida la composición deseada del gas, depositarlo por medio de una válvula de aguja en la cámara principal para formar el hielo de interés astrofísico. De este modo, es posible controlar el número de monocapas que se desea depositar. PASC (Planetary Atmosphere Simulation Chamber)

La máquina de simulación PASC, [13,14], es un entorno de simulación para las condiciones de objetos planetarios con atmósferas. La característica principal de esta máquina es la versatilidad, de manera que el investigador puede definir cada uno de los parámetros para simular el entorno que desee. Esta máquina reproduce la presión atmosférica, composición gaseosa, temperatura e irradiación de la mayor parte de los planetas sólidos del sistema solar o en un entorno ficticio. La presión puede regularse entre 5 y 5 $ 10-9 mbar y la temperatura desde 4 a 325 K. El porta muestras está concebido para permitir introducir diferentes tipos de muestras y de diferentes tamaños, que vayan desde regolitos marcianos o terrestres, esporas, hielos o materiales utilizados en aeronáutica. La irradiación (UV) se realiza mediante una lámpara de deuterio. Uno de los principales retos tecnológicos de este diseño es que permite el encendido de fuentes de irradiación de electrones e iones a presiones de 10-2 mbar. Para ello se ha diseñado una cámara interior en la que se realizan dos etapas de bombeo diferencial, como se indica en la figura 5. Así, se puede enviar electrones sobre la muestra en estudio, por ejemplo, mientras que en la presión total es 10-2 mbar. Las aplicaciones científicas de la misma tienen mucho que ver con el comportamiento de muestras de origen biológico y geológico, en condiciones similares a las de Marte, Triton o Europa, algunos ejemplos pueden ser el comportamiento de absorción y disorpción de CO2 en muestras minerales bajo ciclos de temperatura y radiación estacionales, disorpción de vapor de agua en jarositas, estabilidad de fases minerales en Marte, estudio de resistencia radiactiva UV de biosensores, son algunos de los proyectos de investigación recientes realizados en esta máquina.

4. MARTE

Veinte años ha tardado la NASA en volver a mostrar interés por Marte, este es el periodo de tiempo que hay entre las sondas Viking y el Mars Pathfinder (MPf). Durante este tiempo los científicos han estudiado las 57.000 imágenes de la Viking, que han permitido conocer la geología del planeta rojo con bastante exactitud. Sin lugar a dudas no hay planeta del sistema solar con mejores condiciones para albergar vida, extinta o actual, que Marte. Se parece a la Tierra en muchos aspectos; El proceso de su formación, la historia climática de sus primeros tiempos, sus reservas de agua y fenómenos geológicos como los volcanes [15,16]. Las misiones desde la MPf tienen un carácter de exploración física y ambiental del entorno, para lo cual la exploración no sólo se realiza con satélites y sondas como la Viking, sino también con rovers (pequeños vehículos todoterreno) que son capaces de recorrer la superficie marciana, cada vez con mayor autonomía. En las futuras misiones a Marte, no sólo por la NASA sino también por la ESA, se desea caracterizar la climatología, así como la búsqueda de vida primigenia, en la que mediante una tecnología basada en biosensores, se puedan analizar muestras in situ y de enviar los resultados a la Tierra en tiempo real.

La cámara de simulación de MARTE, está especialmente diseñada para estudiar condiciones marcianas e introducir muestras electrónicas reales. Para ello, se puede modificar la temperatura en el portamuestras en un rango entre 80 K y 450 K, y además es capaz de modificar la temperatura ambiental entre 200 K y 400 K y de generar “tormentas de polvo” en su interior. El principal objetivo de esta cámara es la de probar nuevos dispositivos electromecánicos “sensores”, por lo que su ámbito de aplicación se destina principalmente a la calibración de sensores e instrumentación ambiental que serán enviados al espacio en futuras misiones espaciales. El principal reto, está en poder combinar rangos de temperatura en el porta muestras distintos a los de la atmósfera, y cruzar esto con cambios bruscos de presión, mientras se mantiene la composición gaseosa de Marte. El porta muestras de MARTE, está diseñado para poder soportar dispositivos electromecánicos de grandes dimensiones usando la misma geometría de las mesas ópticas, y pudiendo ser enfriado y calentado desde el interior. En cuanto a la atmósfera el interior, de MARTE cuenta con unos anillos refrigeradores de nitrógeno líquido

que en función de la presión y la composición de la atmósfera permite enfriar la misma no sólo por radiación sino también por conducción y convección.

Además la cámara, está diseñada y construida para poder generar tormentas de polvo en su interior mediante un ingenioso sistema de deposición, que mediante la combinación de un tamiz vibratorio, la gravedad y la diferencia de presiones es capaz de producir una niebla de polvo de partículas de hierro,similar a las de Marte. Sobre todo este conjunto de posibilidades también hay unos pasamuros, en los que se pueden adaptar fuentes de luz halógenas y de xenón, siguiendo el esquema del movimiento del Sol en el hemisferio norte de Marte, de este modo simulamos la incidencia de la luz solar en función de la dependencia angular. Todo este complejo sistema se ha desarrollado para testear los sensores de la estación meteorológica REMS (Rover Environmental Monitoring Station), de la misión MSL (Mars Science Laboratory) de la NASA, así como otros proyectos para la ESA, como Exo-Mars. El proyecto REMS, lo compone una estación meteorológica formada por sensores de radiación ultravioleta, sensor de presión, sensor de temperatura del suelo, sensor de temperatura ambiental, y sensor de viento. En cuanto al vacío, la cámara MARTE puede trabajar en dinámico o en estático, en dinámico cuando las condiciones de temperatura tanto del porta muestras como del interior modifican las condiciones de presión, y en estático cuando lo que interesa es cambiar el volumen sin modificar las condiciones de temperatura, como ocurre cuando se desea verificar la resolución del sensor de presión (calibración y tiempo de respuesta) en incrementos de presión a partir de 0.05 mbar.

Conclusión

El avance en la tecnología del vacío, dado por la consecución de presiones cada vez menores, es debido no sólo a las mejoras de las bombas, sino también al avance en materiales contenedores de vacío, “cámaras”, con presiones de vapor y permeabilidades cada vez más bajas. Este desarrollo unido a sistemas de medida más precisos y fiables en rangos extremos, ha permitido que sea posible estudiar la

materia condicionada por fenómenos atmosféricos, que ocurren en objetos planetarios con un gran interés científico, y que están situados a cientos de miles de kilómetros de la Tierra, y de dar credibilidad a los resultados en los sistemas experimentales. La experiencia ha demostrado que la simulación no es sólo un recurso de innovación tecnológica, sino también una herramienta útil, que permite validar la responsabilidad de las misiones espaciales, que debido al alto coste de las mismas condicionan su propia viabilidad. Del fruto de la simulación de algo tan complejo y tan vasto como es un sistema climático, en el que una mínima variación de un parámetro condiciona el comportamiento global del sistema, estamos obteniendo un gran provecho tecnológico, que nos permitirá en un futuro cada vez más cercano verificar nuestros propios resultados, y realizarnos preguntas sobre fenómenos que ni siquiera podemos conocer.

6. Agradecimientos

Queremos agradecer a las empresas Tecnovac SL y Maques SL el gran esfuerzo técnico y tecnológico, así como su colaboración desinteresada, realizado durante la construcción de algunos de los sistemas de simulación que se describen en este artículo. También agradecemos a José Flores del ICMM-CSIC, por su tiempo, experiencia y dedicación en la construcción de cámaras y componentes de vacío, a Andrés Buendía de la UAM por sus consejos en criogenia y principalmente, a nuestros compañeros Eva Mateo Martí, Pablo Merino, Guillermo Muñóz Caro, Antonio Jimeneéz, Elena López, y Celia Rogero por su dedicación y responsabilidad en la explotación de las máquinas de la unidad de simulación de ambientes planetarios y microscopia de CAB.

Referencias bibliográficas

[1] Física y Sociedad. nº18, Especial sobre Astronáutica: 50 años

después del Sputnik

[2] GILES SPARROW. Astronáutica, La historia desde el Sputnik

al transbordador y más allá, Editorial Akal.

ISBN: 9788446029472.

[3] CARL SAGAN. Un punto azul pálido: Una visión del futuro

humano en el espacio. Editorial Planeta. 2006.

ISBN: 9788408059073.

[4] LORI C. WALTERS. To Create Space on Earth: The Space

Environment Simulation Laboratory and Project Apollo.

NASA/CR-2003-208933.

[5] http://www.cab.inta.es

[6] JOHN F. O´HANLON. A user´s guide to vacuum technology.

Editorial Wiley, Third Edition. ISBN: 9780471270522.

[7] ROMAN SMOLUCHOWSKI. El sistema solar. Biblioteca Scientifi c

American, ISBN: 9788475930138.

[8] La NASA dispone de datos sobre el viento solar en tiempo

real a través del satélite ACE, lanzado en 1997. La variación

del viento solar en tiempo real puede encontrarse en la página

web del satélite.

[9] KARL JOUSTEN. Pressure Measurement with ionization

Gauges. Physikalisch-Technische Bundesanstalt. Berlin.

[10] NICK SCOVILLE Y JUDITH S. YOUNG, Nubes moleculares,

formación de estrellas y estructura galáctica. La vida

de las estrellas, TEMAS 7 de Investigación y Ciencia.

ISBN: 9778411355668-0007.

[11] http://www.electronvoltio.com

[12] G.M. MUÑOZ-CARO, J.A. MARTÍN-GAGO, C. ROGERO,

J.M. SOBRADO, C. ATIENZA, S. PUERTAS. The Interstellar

Astrochemistry Chamber (ISAC). WSPC – September 9, 2008

[13] E. MATEO-MARTÍ, O. PRIETO-BALLESTEROS, J.M. SOBRADO,

J. GÓMEZ-ELVIRA AND J.A. MARTÍN-GAGO. A chamber for

studying planetary environments and its applications to

astrobiology. Meas. Sci. Technol. 17 (2006) 2274–2280.

[14] MARTIN REES. Universo, La guía visual defi nitiva. Editorial

Pearson de Alhambra. ISBN: 8420551414.

[15] PHILIP R. CHRISTENSEN, Estratigrafía y relieve de Marte.

Planetas. TEMAS 53 de, Investigación y Ciencia, Tercer

trimestre del 2008. ISBN: 9778411355668-00053

[16] TIM BEARDSLEY, Paseo Planetario, Marte. Sistemas Solares.

TEMAS 15 de Investigación y Ciencia, Primer trimestre de

1999. ISBN: 9778411355668-00015.

Jesús Manuel Sobrado

Centro de Astrobiología. CSIC-INTA

Unidad de Simulación de Ambientes Planetarios y Microscopía

(sobradovj@inta.es)

José Ángel Martín-Gago

Instituto de Ciencia de Materiales de Madrid. CSIC,

(gago@icmm.csic.es)

Nota: Si quieren leerel original y verlos gráficos, sólo tienen que poner en Google el Título de arriba y pulsar buscar. Enlace

Ago

15

El Universo y Nosotros, ¿sabremos algún día la verdadera relación?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Estudiamos y dejamos de intentar descubrir sus secretos

“La ciencia no puede resolver el misterio final de la Naturaleza. Y esto se debe a que, en el último análisis, nosotros somos parte del misterio que estamos tratando de resolver”.

Mac Planck

Y, desde luego, no parece que fuese muy desencaminado, nuestra complejidad es tan grande que, llegar a comprendernos, no será nada fácil.

Hace tiempo que nos interesamos por las especies de los seres vivos y tratamos de ordenarlos por sistemas compuestos por una jerarquía de taxones animados. Así, taxonomía biológica es una subdisciplina de la sistemática biológica, que estudia las relaciones de parentesco entre los organismos y su historia evolutiva. Hemos resuelto el árbol filogenético de los organismos estudiados, esto es, una vez que están resueltos los datos, o ramas evolutivas y las relaciones entre ellos, y, la conclusión final ha sido que, el Ser Humano, es el Ser vivo más complejo del Universo (claro que, solo de momento lo podemos afirmar, ya que, cabe la gran posibilidad de que puedan existir criaturas inteligentes en otros mundos).

A medida que revisamos la cadena de vida, de mineral a planta a animal a humano, encontramos seres cada vez más complejos; sin embargo, nada en la creación material es más complejo que un ser humano.

¿Quién no ha tenido alguna vez, la sensación de que sabe la respuesta ? ¿De que todo está ahí, en su mente, escondido y a punto de salir a la superficie? Esas sensaciones que parecen querer hablarnos, contarnos ese secreto tan largamente perseguido por muchos y no desvelado por ninguno. Sin embargo, ese momento es efímero y, lo mismo que llegó, se fue. La frustración que deja en nosotros esa sensación de tener ese algo a mano y de que se nos esfume y desaparezca sin más, es verdaderamente…dolorosa.

Bueno, a mí me pasa continuamente, siento que de un momento a otro, mi mente, me daría respuestas a preguntas que no han sido contestadas. El tiempo inexorable pasa y, las respuestas no llegan. ¡Qué impotencia! Nos queremos comer los puños, las respuestas se escurrió de entre los dedos y no la pudimos agarrar.

Imagino que, de vez en cuando, en algunas mentes, saltan esas respuestas y son ofrecidas al mundo para que puedan continuar avanzando (Newton, Planck, Einstein,,,)

Los aspectos inconscientes de la actividad mental, como las rutinas motoras y cognitivas, así como los recuerdos, intenciones y expectativas inconscientes, las preocupaciones y los estados de ánimos, desempeñan un papel fundamental a la hora de conformar y dirigir nuestras experiencias conscientes. Todo está siempre estrechamente relacionado, nada ocurre en nosotros que no esté unido a lo que pasa en nuestro entorno, somos una parte de un todo que se llama Universo, y, aún cuando somos autónomos en el pensamiento y en la manera de obrar, existen condicionantes exteriores que inciden, de una u otra manera en nosotros, en lo que somos.

¿Qué pasaría si la gravedad desapareciera? un físico y astronauta de la NASA, explica cómo la ausencia de la gravedad afecta al cuerpo humano. Se ha comprobado que los astronautas pierden masa ósea y fuerza muscular durante su estancia en el espacio, además de que su sentido del equilibrio se modifica.

Además, baja el nivel de glóbulos rojos, llegando a padecer anemia, las heridas tardan más en curarse, el sistema inmunológico pierde su fuerza y los ritmos del sueño se alteran. Una situación para el cuerpo y la mente que sería difícil de gestionar.

La gravedad, concretamente las ondas gravitacionales, está en la mente de muchas personas en este momento.

Sin la fuerza de Gravedad, nuestras mentes serían diferentes (o no serían), estamos estrechamente conectados a las fuerzas que rigen el Cosmos y, precisamente, somos como somos, porque las fuerzas fundamentales de la Naturaleza, son como son y hacen posible la vida y la existencia de seres pensantes y evolucionados que son capaces de tener conciencia de SER, de hacer preguntas tales como: ¿de donde venimos? ¿Hacia donde vamos?

La QUALIA

La forma en que sientes el impacto de los colores es un claro ejemplo de los qualia. Este término, desconocido para muchos, describe las experiencias particulares que sentimos al tomar contacto con cada cosa que nos rodea.

la discriminación, correlatos neuronales de la percepción del color, ¿un grupo neuronal, un quale?, los gualia y el núcleo dinámico, los qualia en el tiempo neuronal, el desarrollo de los qualia: referencia al propio yo, lo consciente y lo inconsciente, los puertos de entrada y de salida, los bucles largos y rutinas cognitivas, aprendizaje por el estudio y la experiencia, rupturas talamocorticales: posibilidades de núcleos escindidos, la observación, el lenguaje, el pensamiento, los mensajes exteriores, la unificación de datos y la selección lógica de respuestas, y, por fin: el significado último de las cosas (las preguntas de la filosofía), la metafísica.

Sí, por todas estas fases del estudio y del pensamiento he tenido que pasar para llegar a una simple conclusión:

No, no es el mensaje en la botella, el que no podemos comprender es ese otro que, venido del Espacio exterior no sabemos descifrar, y, sería tan importante saber quien lo manda y con qué intenciones

“No somos la imagen de nadie” y, simplemente, como seres que evolucionamos, sin que nos demos cuenta, mutamos y nos adaptamos al medio cambiante y, mientras eso ocurre, llegan mensajes que no comprendemos a la primera. No, no exagero, dentro de esa imagen de frágil físico y de escasa capacidad para poder dar respuesta a ciertas preguntas, en realidad, se esconden cualidades y potenciales que, no sabemos ni podemos medir. En realidad, somos una compleja estructura de pensamientos que puede llegar…muy lejos.

Dentro de nuestro ser están todas las respuestas y solo necesitamos tiempo para encontrarlas. Nuestra mente, es la energía del Universo, aún no sabemos utilizarla y pasaran, posiblemente, millones de años hasta que estemos preparados para saber lo que en realidad, es la conciencia.

Mientras eso llega, algunos curiosos como yo, con más voluntad que conocimientos, tratan de especular con ideas y conceptos que nos puedan dar alguna luz sobre tan complicado problema.

Un entramado complejo de sinapsis eléctricas entre neuronas. Ahí se guardan datos y se crean ideas

Nuestra mente es una maravilla de la Naturaleza, algo tan grande que, a pesar de los muchos avances y conocimientos alcanzados, no la podemos explicar… aún.

Está claro que, como me ha comentado un amigo, la materia tiene memoria y, es precisamente esa memoria, la que hace posible el avance de nuestros conocimientos a través de la mente que, sin duda, está directamente conectada con el resto del Universo y las fuerzas que lo gobiernan que son las que hacen posible su funcionamiento tal como acontece.

Pero nada es tan sencillo ni podemos hablar de lo sensorial sin tener en cuenta el plano más simple y cotidiano que está referido a la materia, a nuestro cuerpo, las sensaciones, las experiencias vividas, lo que aprendemos, el estudio y la profunda observación que nos lleva de la mano de la curiosidad hasta la fuente de la que mana el agua de la sabiduría.

Entender las claves que explican el devenir de la vida sobre este planeta, con la idea en el horizonte de aspiraciones intelectuales a que nos aboca la conciencia del SER, no resulta fácil, la complejidad de la empresa exige tener en cuenta múltiples factores que no siempre estamos preparados para comprender, y, sobre todo, debemos ser muy conscientes de que formamos parte de un Universo inmenso, y, estamos supeditamos a las fuerzas que lo rigen. Lo mejor para hacer nuestras vidas más fáciles, es tratar de comprender la Naturaleza de ese Universo nuestro.

¡La Vida! Siempre me llamó la atención y elevó el grado de curiosidad ese gran misterio que llamamos ¡vida!, y, cada vez que he tenido la oportunidad, no me he perdido el poder aprender alguna cosa sobre ella. Ya os he contado en otras ocasiones mi experiencia con la eminente y privilegiada mente de…

Lynn Margulis comenzó a explorar los caminos de la genética a partir de un libro escrito en el siglo XIX por Edmund B.Webs. En ese texto encontró reflexiones sobre la herencia citoplasmática y datos sobre las bacterias, entonces no muy consideradas en el estudio del origen de la vida.

La doctora Margulis (ya fallecida), fue profesora del Departamento de Geociencias de la Universidad de Massachusselts (Estados Unidos) relacionó el papel de las bacterias con la microbiología, una ciencia surgida de la medicina, de la salud pública y del procedimiento seguido para procesar los alimentos. De ahí saltó al estudio del tema que ocupa su curso magistral: Contribución de los microbios a la evolución.

Me puedo contar entre los privilegiados que pudimos asistir al curso. Tomé mis notas que ahora hace posible este comentario.

Ella centraba el curso en la enorme importancia que tenían los microbios para nosotros, no siempre bien valorados. Los microbios pueden ser definidos como organismos que no podemos ver a simple vista y, la cultura popular dice que tan sólo sirven de agentes para canalizar enfermedades, pero esa apreciación conlleva un error muy serio. Por ejemplo: el 10% del peso del cuerpo humano en seco está compuesto por microbios, sin los cuales no podemos vivir ni siquiera un día. Ellos asumen tareas tan importantes como la de generar el oxígeno del aire que precisamos para respirar. Además, tienen un papel fundamental en la evolución de la vida: todos los seres vivos considerados simples –animales, plantas, hongos, etc.- están hechos de microbios en combinación simbiótica con otros organismos. Se trata de una historia que se aleja en el pasado hasta 3.500 millones de años en el curso de la vida sobre la superficie de nuestro planeta: La Tierra.

Los conceptos que maneja y esgrime la doctora en genética, están encuadrados en una visión totalmente contradictoria con la religión y otros muchos conceptos culturales.

Pregunté a la doctora Margulis si la mala imagen de los microbios nacía de un estudio deficiente de la microbiología, o si simplemente surgía a partir de tópicos sin fundamentos. Su contestación fue:

“La asociación de esos pequeños organismos con aspectos negativos se explica por el origen de su estudio científico, que siempre estuvo relacionado con descubrimientos ligados a la investigación en torno a enfermedades. Junto a esta idea, lo cierto es que pensamos en formas ideales que corresponden al esquema platónico de hace casi 30 siglos, cuando en realidad no existen tales ideas sino organismos que interaccionan con el medio ambiente en el que se encuentran. Esta colaboración recibe el nombre de ecología. De hecho, el concepto de independencia no tiene sentido en este campo: al margen de los microbios moriríamos inmediatamente.”

Aquel día, como casi todos los días de mi vida, aprendí cosas nuevas y muy interesantes que me confirmaron que nuestras vidas, podrían ser cualquier cosa, menos simples. Es tal el nivel de complejidad implicado que, precisamente por eso, no somos capaces de explicarla al completo, solo vamos dominando parcelas limitadas que, algún día, al ser unidas, nos darán las respuesta.

En fin amigos, que como habréis podido deducir, aunque nuestras limitaciones nos impongan barreras, no debemos rendirnos ante ninguna de ellas y, si persistimos, finalmente encontraremos el camino de pasarlas para poder ir un poco más allá. Era Jhon Wheeler el que nos decía:

“Vivimos en una isla rodeada por un mar de ignorancia. Pero, cada nuevo conocimiento que adquirimos, hace la isla mayor, y, la ignorancia decrece en esa pequeña proporción”

Claro que, si los conocimientos que vamos adquiriendo son continuados…Finalmente, ¿podríamos secar ese mar?

emilio silvera

Ago

14

¿Por qué es así nuestro Universo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

La carga del electrón, la masa del protón, la velocidad de la luz en el vacío, la Gravead, la constante de estructura fina, la constante de Planck…

Está muy claro que, nuestro mundo es como es, debido a una serie de parámetros que, poco a poco, hemos ido identificando y hemos denominado Constantes de la Naturaleza. Esta colección de números misteriosos son los culpables, los responsables, de que nuestro universo sea tal como lo conocemos que, a pesar de la concatenación de movimientos caóticamente impredecibles de los átomos y las moléculas, nuestra experiencia es la de un mundo estable y que posee una profunda consistencia y continuidad.

Sí, nosotros también hemos llegado a saber que con el paso del tiempo, aumenta la entropía y las cosas cambian. Sin embargo, algunas cosas no cambian, continúan siempre igual, sin que nada les afecte. Esas, precisamente, son las constantes de la naturaleza que, desde mediados del siglo XIX, comenzó a llamar la atención de físicos como George Johnstone Stoney (1.826 – 1.911, Irlanda).

Parece, según todas las trazas, que el universo, nuestro universo, alberga la vida inteligente porque las constantes de la naturaleza son las que aquí están presentes, cualquier ligera variación en alguna de estas constantes habría impedido que surgiera la vida en el planeta que habitamos. El universo con las constantes ligeramente diferentes habría nacido muerto, no se hubieran formado las estrellas ni se habrían unido los quarks para construir nucleones (protones y neutrones) que formaran los núcleos que al ser rodeados por los electrones construyeron los átomos que se juntaron para formar las moléculas y células que unidas dieron lugar a la materia. Esos universos con las constantes de la naturaleza distintas a las nuestras, estarían privados del potencial y de los elementos necesarios para desarrollar y sostener el tipo de complejidad organizada que nosotros llamamos vida.

Ni la velocidad de la luz ni la gravitación universal han variado con el paso del tiempo

Nadie ha sabido responder a la pregunta de si las constantes de la naturaleza son realmente constantes o llegará un momento en que comience su transformación. Hay que tener en cuenta que para nosotros, la escala del tiempo que podríamos considerar muy grande, en la escala de tiempo del universo podría ser ínfima. El universo, por lo que sabemos, tiene 13.500 millones de años. Antes que nosotros, el reinado sobre el planeta correspondía a los dinosaurios, amos y señores durante 150 millones de años, hace ahora de ello 65 millones de años. Mucho después, hace apenas 2 millones de años, aparecieron nuestros antepasados directos que, después de una serie de cambios evolutivos desembocó en lo que somos hoy.

Todo ello pudo suceder como consecuencia de que, 200 millones de años después del Big Bang se formaron las primeras estrellas que, a su vez, dieron lugar a las primeras galaxias.

El material primario del universo fue el hidrógeno, el más sencillo y simple de los elementos que componen la tabla periódica. Hoy día, 13.500 millones de años después, continúa siendo el material más abundante del universo junto al helio.

Para hacer posible el resurgir de la vida, hacían falta materiales mucho más complejos que el hidrógeno; éste era demasiado simple y había que fabricar otros materiales que, como el carbono, el hidrógeno pesado, el nitrógeno, oxígeno, etc, hicieran posible las combinaciones necesarias de materiales diferentes y complejos que, al ser bombardeados por radiación ultravioleta y rayos gammas provenientes del espacio, diera lugar a la primera célula orgánica que sería la semilla de la vida.

¿Quién, entonces, fabricó esos materiales complejos si en el universo no había nadie?

Buena pregunta. Para contestar tengo que exponer aquí algunas características de lo que es una estrella, de cómo se puede formar, como puede ser, y cuál será su destino final. Veamos:

Lo que conocemos como estrella es una bola de gas luminosa que, durante una etapa de su vida, produce energía por la fusión nuclear del hidrógeno en helio. El término estrella, por tanto, no sólo incluye estrellas como el Sol, que están en la actualidad quemando hidrógeno, sino también protoestrellas, aún en formación y no lo suficientemente calientes como para que dicha combustión nuclear haya comenzado, y también varios tipos de objetos más evolucionados como estrellas gigantes y supergigantes, que están quemando otros combustibles nucleares, o las enanas blancas y las estrellas nucleares, que están formadas por combustible nuclear gastado.

Las estrellas se forman a partir de enormes nubes de gas y polvo que a veces tienen hasta años-luz de diámetro. Las moléculas de polvo, unidas a las de los gases, se rozan y se ionizan, se calientan y la nube comienza a girar lentamente. El enorme conglomerado, poco a poco se va juntando y la temperatura aumenta. Tal enormidad de materia crea una fuerza gravitatoria que hace contraerse la nube sobre sí misma; su diámetro y su temperatura en el núcleo es tal que se produce la fusión de los protones de hidrógeno que se transforman en un material más complejo, el helio, y ese es el momento en que nace la estrella que, a partir de ahí, puede estar miles de millones de años brillando y produciendo energía termonuclear.

La masa máxima de las estrellas puede rondar las 120 masas solares, es decir, ser 120 veces mayor que nuestro Sol, y por encima de este límite sería destruida por la enorme potencia de su propia radiación. La masa mínima para poder ser una estrella se fija en 0’08 masas solares; por debajo de ella, los objetos no serían lo suficientemente calientes en sus núcleos como para que comience la combustión del hidrógeno y se convertirían en enanas marrones. Las luminosidades de las estrellas varían desde alrededor de medio millón de veces la luminosidad del Sol para las más calientes hasta menos de la milésima de la del Sol para las enanas más débiles. Aunque las estrellas más prominentes visibles a simple vista son más luminosas que el Sol, la mayoría de las estrellas son en realidad más débiles que éste y, por tanto, imperceptibles a simple vista.

Como he dicho antes, el brillo de las estrellas (la luz y el calor) es el resultado de la conversión de masa en energía (E = mc2), por medio de reacciones nucleares, las enormes temperaturas de millones de grados de su núcleo, hace posible que los protones de los átomos del hidrógeno se fusionen y se conviertan en átomos de helio. Por cada kilogramo de hidrógeno quemado de esta manera, se convierten en energía aproximadamente siete gramos de masa. De acuerdo con la famosa ecuación de Einstein (arriba reseñada), los siete gramos equivalen a una energía de 6’3 × 1014 julios. Las reacciones nucleares no sólo aportan la luz y el calor de las estrellas, sino que también producen elementos pesados, más complejos que el hidrógeno y el helio que, posteriormente, son distribuidos por el universo, cuando al final de la estrella, esta explota en supernova, lanzando sus capas exteriores al espacio que de esta forma, deja “sembrado” de estos materiales el “vacío” estelar.

Las estrellas pueden clasificarse de muchas maneras. Una manera es mediante su etapa evolutiva: en pre-secuencia principal, secuencia principal*, gigante, supergigante, enana blanca, estrella de neutrones y agujeros negros. Estas últimas son la consecuencia del final de sus vidas como tales estrellas, convirtiéndose en objetos estelares de una u otra clase en función de sus masas originales. Estrellas como nuestro Sol, al agotar el combustible nuclear se transforman en gigantes rojas, explotan en novas y finalmente quedan como enanas blancas. Si la masa es mayor serán estrellas de neutrones, y si aún son mayores, su final está en agujeros negros.

Otra clasificación es a partir de sus espectros, que indican su temperatura superficial. Otra manera es en poblaciones I, II y III, que engloban estrellas con abundancias progresivamente menores de elementos pesados, indicando paulatinamente una mayor edad. También evolución estelar y magnitudes aparentes y absolutas y el tipo espectral con la distancia en a. L., es otra de las clasificaciones.

Después de estas clasificaciones genéricas tenemos otras mas particulares y definidas referidas a estrellas binarias, estrellas capullo, con baja velocidad, con envoltura, con exceso de ultravioleta, de alta velocidad, de baja luminosidad, de baja masa, de bario, de bariones, de campo, de carbono, de circonio, de estroncio, de helio, estrella de la población I extrema, de la población intermedia, de la rama gigante asintótica, estrella de litio, de manganeso, de manganeso-mercurio y, viceversa, estrella de metales pesados, de neutrones*, estrellas de quarks (hipotética con densidad intermedia entre la estrella de neutrones y el agujero negro), estrella de referencia, de silicio, de tecnecio, de tiempo intermedio, de tipo tardío, de tipo temprano, estrella del polo, estrella doble, estrella enana, estándar, evolucionada, etc.

La variedad de estrellas es grande y para los estudiosos fascinantes. Tal diversidad es debida a la evolución que desde su formación tiene cada tipo de estrella en función de su masa y de los gases y polvo cósmico que la forman y los que se crean en su núcleo (horno solar) a miles de millones de grados de temperatura capaces de transformar materiales simples como el hidrógeno hacia una gama más compleja y pesada que, finalmente, mediante la explosión de supernova (más temperatura), arroja al espacio materiales que, a su vez, forman nuevas estrellas de 2ª y 3ª generación con materiales complejos. La vida en nuestro planeta pudo surgir gracias a que en la Tierra había abundancia de estos materiales creados en las estrellas. Podemos decir, sin temor a equivocarnos que nosotros mismos estamos hechos del material creado en las estrellas lejanas que posiblemente, hace miles de millones de años explotó en supernova a millones de años luz de nuestro Sistema Solar.

Pero retomando el tema central de este capítulo, las constantes fundamentales de la naturaleza, tenemos que decir que, precisamente, estas constantes son las que tienen el mérito de que las estrellas brillen en las galaxias y de que nosotros estemos aquí para mirar a los cielos y contemplar su belleza.

Al principio mencioné a George J. Stoney, el físico irlandés y pensador excéntrico y original al que, en realidad, debemos la forma de deducir si otros planetas del sistema solar poseían o no una atmósfera gaseosa, como la Tierra, calculando si su gravedad superficial era suficientemente intensa para mantener esa atmósfera.

Pero su pasión real estaba reservada a su idea más preciada: el “electrón”. Stoney había deducido que debía existir un componente básico de carga eléctrica. Estudiando los experimentos de Michael Faraday sobre electrolisis, Stoney había predicho incluso cuál debía ser su valor, una predicción posteriormente confirmada por J. J. Thomson, descubridor del electrón en Cambridge en 1.897, dándole la razón a Stoney que finalmente, a esta unidad básica de la electricidad, le dio el nombre de electrón con el símbolo e en 1.891 (antes de su descubrimiento).

Stoney, primo lejano y más viejo del famoso matemático, científico de computación y criptógrafo Alan Turing, también era tío de George Fitzgerald, después famoso por proponer la “contracción Fitzgerald-Lorentz”, un fenómeno que fue entendido finalmente en el contexto de la teoría de la relatividad especial de Einstein.

Stoney, podemos decir con seguridad, fue el primero que señaló el camino para encontrar lo que más tarde conoceríamos como constantes fundamentales, esos parámetros de la física que son invariantes, aunque su entorno se transforme. Ellas, las constantes, continúan inalterables como sucede, por ejemplo, con la velocidad de la luz c, que sea medida en la manera que sea, esté en reposo o esté en movimiento quien la mide o la fuente de donde parte, su velocidad será siempre la misma, 299.792.458 m/s. Algo análogo ocurre con la gravedad, G, que en todas partes mide el mismo parámetro o valor: G = 6’67259 × 10-11 m3 s-2 Kg-1. Es la fuerza de atracción que actúa entre todos los cuerpos y cuya intensidad depende de la masa de los cuerpos y de la distancia entre ellos; la fuerza gravitacional disminuye con el cuadrado de la distancia de acuerdo a la ley de la inversa del cuadrado.

Profesor de filosofía natural (así llamaban antes a la Física) en el Queen’s College Galway en 1.860, tras su retiro se trasladó a Hornsey, al norte de Londres, y continuó publicando un flujo de artículos en la revista científica de la Royal Dublín Society, siendo difícil encontrar alguna cuestión sobre la que no haya un artículo firmado por él.

Stoney recibió el encargo de hacer una exposición científica del tema que él mismo eligiera para el programa de la reunión de Belfast de la Asociación Británica. Pensando en qué tema elegir, se dio cuenta de que existían medidas y patrones e incluso explicaciones diferentes para unidades que median cosas o distancias o algún fenómeno: se preguntaba la manera de cómo definirlos mejor y como interrelacionarlos. Vio una oportunidad para tratar de simplificar esta vasta confusión de patrones humanos de medida de una manera tal que diese más peso a su hipótesis del electrón.

emilio silvera

* Sol fusionando hidrógeno en helio.

* 1017 kg/m3. El material llega a estar tan junto que protones y electrones se funden y forman neutrones.

Totales: 75.608.744

Totales: 75.608.744 Conectados: 50

Conectados: 50