Ago

14

¿Por qué es así nuestro Universo? Parte II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Stoney recibió el encargo de hacer una exposición científica del tema que él mismo eligiera para el programa de la reunión de Belfast de la Asociación Británica. Pensando en qué tema elegir, se dio cuenta de que existían medidas y patrones e incluso explicaciones diferentes para unidades que median cosas o distancias o algún fenómeno: se preguntaba la manera de cómo definirlos mejor y como interrelacionarlos. Vio una oportunidad para tratar de simplificar esta vasta confusión de patrones humanos de medida de una manera tal que diese más peso a su hipótesis del electrón.

El 5 de julio de 1911, fallecía el físico anglo-irlandés George Johnstone Stoney (15 de febrero de 1826 – 5 de julio de 1911). En 1891 propuso el término electrón para describir la unidad fundamental de carga eléctrica.

Comienza II

En física, las unidades Stoney forman un sistema de unidades que lleva el nombre del físico irlandés George Johnstone Stoney , quien las propuso por primera vez en 1881. Son el primer ejemplo histórico de unidades naturales , es decir, unidades de medida diseñadas para que ciertas constantes físicas fundamentales sirvan como base . unidades _

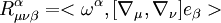

El conjunto de unidades base de Stoney es similar al utilizado en las unidades de Planck , propuestas independientemente por Planck treinta años después, pero Planck normalizó la constante de Planck en lugar de la carga elemental. [3] (En el uso moderno, se entiende que las unidades de Planck normalizan la constante de Planck reducida en lugar de la constante de Planck). En las unidades de Stoney, el valor numérico de la constante de Planck reducida es

donde α es la constante de estructura fina. Las unidades de Planck se usan más comúnmente que las unidades de Stoney en la física moderna, especialmente en la gravedad cuántica (incluida la teoría de cuerdas ). En raras ocasiones, las unidades de Planck se denominan unidades de Planck-Stoney.

En tal situación, Stoney centró su trabajo en unidades naturales que transcienden los patrones humanos, así que trabajó en la unidad de carga electrónica (según su concepto), inspirado en los trabajos de Faraday como hemos comentado antes. También, como unidades naturales escogió G y c que responde, como se ha explicado, a la gravedad universal y la velocidad de la luz en el vacío.

En su charla de la Reunión de Belfast, Stoney se refirió al electrón como el “electrino” y dio el primer cálculo de su valor esperado. Demostró que el trío mágico de G, c y e podía combinarse de una manera, y sólo de una, de modo que a partir de ellas se creaban una unidad de masa, una unidad de longitud y una unidad de tiempo. Para la velocidad de la luz utilizó un promedio de las medidas existentes, c = 3 × 108 metros por segundo; para la constante de gravitación de Newton utilizó el valor obtenido por John Herschel, G = 6’67259 × 10-11 m3 s-2 Kg-1, y para la unidad de carga del “electrino” utilizó e = 10-20 amperios. Estas fueron las inusuales nuevas unidades que él encontró, en términos de las constantes e, c y G, y en términos de gramo, metros y segundos:

Estas son cantidades extraordinarias. Aunque una masa de 10-7 gramos no es demasiado espectacular – es similar a la de una mota de polvo – las unidades de longitud y tiempo de Stoney eran muy diferentes de cualquiera que hubieran encontrado antes los científicos. Eran fantásticamente pequeñas, rozando lo inconcebible. No había (y sigue sin haber) ninguna posibilidad de medir directamente tales longitudes y tiempos. En cierto modo, esto es lo que se podría haber esperado.

Estas unidades no están construidas deliberadamente a partir de dimensiones humanas, por conveniencia humana o para utilidad humana. Están definidas por la propia fábrica de la realidad física que determina la naturaleza de la luz, la electricidad y la gravedad. No se preocupan de nosotros. Stoney triunfó de un modo brillante en su búsqueda de un sistema de unidades sobrehumanas.

“La ciencia no puede resolver el misterio final de la Naturaleza. Y esto se debe a que, en el último análisis, nosotros somos parte del misterio que estamos tratando de resolver”.

Max Planck

Las unidades naturales de Max Planck

La idea de Stoney fue descubierta en una forma diferente por el físico alemán Max Planck en 1.899, un año antes de que expusiera al mundo su teoría del “cuanto de acción” h.

Planck es uno de los físicos más importantes de todos los tiempos. Como antes he apuntado, descubrió la naturaleza cuántica de la energía que puso en marcha la revolución cuántica de nuestra comprensión del mundo, ofreció la primera descripción correcta de la radiación térmica (“espectro de Planck”) y una de las constantes fundamentales de la naturaleza lleva su nombre.

Ganador del premio Nobel de Física de 1.918, también fue, en el primer momento, el único que comprendió la importancia que, para la física y para el mundo, tendría el artículo del joven Einstein, en 1.905, sobre la teoría de la relatividad especial. Hombre tranquilo y modesto que fue profundamente admirado por sus contemporáneos más jóvenes, como el mismo Einstein y Bohr.

La concepción que tenía Planck de la naturaleza ponía mucho énfasis en su racionalidad intrínseca y en su independencia del pensamiento humano. Había que encontrar esas estructuras profundas que estaban lejos de las necesidades de la utilidad y conveniencia humanas pero que, en realidad, estaban ahí ocultas en lo más profundo de los secretos naturales y eran las responsables de que nuestro mundo, nuestro universo, fuese tal como lo conocemos.

En el último año de su vida un antiguo alumno le preguntó si creía que buscar la forma de unir todas las constantes de la naturaleza mediante alguna teoría más profunda era atractivo. Le contestó con el entusiasmo templado por el realismo y experiencia conociendo cuantas dificultades entrañaba tal empresa.

“Su pregunta sobre la posibilidad de unificar todas las constantes universales de la naturaleza, es sin duda una idea atractiva. Por mi parte, sin embargo, tengo dudas de que se logre con éxito. Pero puedo estar equivocado”

A diferencia de Einstein, Planck no creía que se pudiera alcanzar realmente una teoría globalizadora que explicara todas las constantes de la naturaleza.

Mientras que Stoney había visto en la elección de unidades prácticas una manera de cortar el nudo gordiano de la subjetividad, Planck utilizaba sus unidades especiales para sustentar una base no antropomórfica para la física y que, por consiguiente, podría describirse como “unidades naturales”.

De acuerdo con su perspectiva universal, en 1.899 Planck propuso que se construyeran unidades naturales de masa, longitud y tiempo a partir de las constantes más fundamentales de la naturaleza: la constante de gravitación G, la velocidad de la luz c y la constante de acción h, que ahora lleva el nombre de Planck. La constante de Planck determina la mínima unidad de cambio posible en que pueda alterarse la energía, y que llamó “cuanto”. Las unidades de Planck son las únicas combinaciones de dichas constantes que pueden formarse en dimensiones de masa, longitud, tiempo y temperatura. Sus valores no difieren mucho de los de Stoney:

| Mp = | (hc/G)½ = | 5’56 × 10-5 gramos |

| Lp = | (Gh/c3) ½ = | 4’13 × 10-33 centímetros |

| Tp = | (Gh/c5) ½ = | 1’38 × 10-43 segundos |

| Temp.p = | K-1 (hc5/G) ½ = | 3’5 × 1032 ºKelvin |

Estas formulaciones con la masa, la longitud, el tiempo y la temperatura de Planck incorporan la G (constante de gravitación), la h (la constante de Planck) y la c, la velocidad de la luz. La de la temperatura incorpora además, la K de los grados Kelvin.

La constante de Planck racionalizada (la más utilizada por los físicos), se representa por ћ que es igual a h/2π que vale del orden de 1’054589×10-34 Julios segundo.

En las unidades de Planck, una vez más, vemos un contraste entre la pequeña, pero no escandalosamente reducida unidad natural de la masa y las unidades naturales fantásticamente extremas del tiempo, longitud y temperatura. Estas cantidades tenían una significación sobrehumana para Planck. Entraban en La Base de la realidad física:

“Estas cantidades conservarán su significado natural mientras la Ley de Gravitación y la de Propagación de la luz en el vacío y los dos principios de la termodinámica sigan siendo válidos; por lo tanto, siempre deben encontrarse iguales cuando sean medidas por las inteligencias más diversas con los métodos más diversos.”

En sus palabras finales alude a la idea de observadores en otro lugar del universo que definen y entienden estas cantidades de la misma manera que nosotros.

De entrada había algo muy sorprendente en las unidades de Planck, como lo había también en las de Stoney. Entrelazaban la gravedad con las constantes que gobiernan la electricidad y el magnetismo.

“La creciente distancia entre la imagen del mundo físico y el mundo de los sentidos no significa otra cosa que una aproximación progresiva al mundo real.”

El joven Max Planck

Podemos ver que Max Planck apelaba a la existencia de constantes universales de la naturaleza como prueba de una realidad física al margen y completamente diferentes de las mentes humanas. Al respecto decía:

“Estos…números, las denominadas “constantes universales“ son en cierto sentido los ladrillos inmutables del edificio de la física teórica. Deberíamos preguntar:

¿Cuál es el significado real de estas constantes?”

Una de las paradojas de nuestro estudio del universo circundante es que a medida que las descripciones de su funcionamiento se hacen más precisas y acertadas, también se alejan cada vez más de toda la experiencia humana.

“Lo que realmente me interesa es si Dios podría haber hecho del mundo una cosa diferente; es decir, si la necesidad de simplicidad lógica deja la más mínima libertad.”

Albert Einstein

Einstein hizo más que cualquier otro científico por crear la imagen moderna de las leyes de la naturaleza. Desempeñó un papel principal en la creación de la perspectiva correcta sobre el carácter atómico y cuántico del mundo material a pequeña escala, demostró que la velocidad de la luz introducía una relatividad en la visión del espacio de cada observador, y encontró por sí solo la teoría de la gravedad que sustituyó la imagen clásica creada por Isaac Newton más de dos siglos antes que él. Su famosa fórmula de E = mc2 es una fórmula milagrosa, es lo que los físicos definen como la auténtica belleza. Decir mucho con pocos signos y, desde luego, nunca ningún físico dijo tanto con tan poco. En esa reducida expresión de E = mc2, está contenido uno de los mensajes de mayor calado del universo: masa y energía, son la misma cosa.

Einstein siempre estuvo fascinado por el hecho de que algunas cosas deben parecer siempre iguales, independientemente de cómo se mueva el que las ve, como la luz en el vacío, c.

Él nos dijo el límite con que podríamos recibir información en el universo, la velocidad de c.

Él reveló todo el alcance de lo que Stoney y Planck simplemente habían supuesto: que la velocidad de la luz era una constante sobrehumana fundamental de la naturaleza. También sabía el maestro que, en el proceso de nuevas teorías, la búsqueda de la teoría final que incluyera a otras fuerzas de la naturaleza distintas de la gravedad, daría lugar a teorías nuevas y cada vez mejores que irían sustituyendo a las antiguas teorías. De hecho, él mismo la buscó durante los 30 últimos años de su vida pero, desgraciadamente, sin éxito. Ahora se ha llegado a la teoría de supercuerdas que sólo funciona en 10 y 26 dimensiones y es la teoría más prometedora para ser la candidata a esa teoría final de la que hablan los físicos.

El físico espera que las constantes de la naturaleza respondan en términos de números puros que pueda ser calculado con tanta precisión como uno quiera. En ese sentido se lo expresó Einstein a su amiga Ilse Rosenthal-Schneider, interesada en la ciencia y muy amiga de Planck y Einstein en la juventud.

Lo que Einstein explicó a su amiga por cartas es que existen algunas constantes aparentes que son debidas a nuestro hábito de medir las cosas en unidades particulares. La constante de Boltzmann es de este tipo. Es sólo un factor de conversión entre unidades de energía y temperatura, parecido a los factores de conversión entre las escalas de temperatura Fahrenheit y centígrada. Las verdaderas constantes tienen que ser números puros y no cantidades con “dimensiones”, como una velocidad, una masa o una longitud. Las cantidades con dimensiones siempre cambian sus valores numéricos si cambiamos las unidades en las que se expresan.

La interpretación de las unidades naturales de Stoney y Planck no era en absoluto obvia para los físicos. Aparte de ocasionarles algunos quebraderos de cabeza al tener que pensar en tan reducidas unidades, y sólo a finales de la década de 1.960 el estudio renovado de la cosmología llevó a una plena comprensión de estos patrones extraños. Uno de los curiosos problemas de la Física es que tiene dos teorías hermosamente efectivas (la mecánica cuántica y la relatividad general) pero gobiernan diferentes dominios de la naturaleza.

La mecánica cuántica domina en el micro-mundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola delictiva o una ola de histeria: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros. Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son.

emilio silvera

Ago

14

¿Por qué es así nuestro Universo? III

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son.

Comienza III

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño.

La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 centímetros, más joven que el tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad.

Estas son todas las unidades de Planck: Con su Longitud, Temperatura y Límite

Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuitería de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos. Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

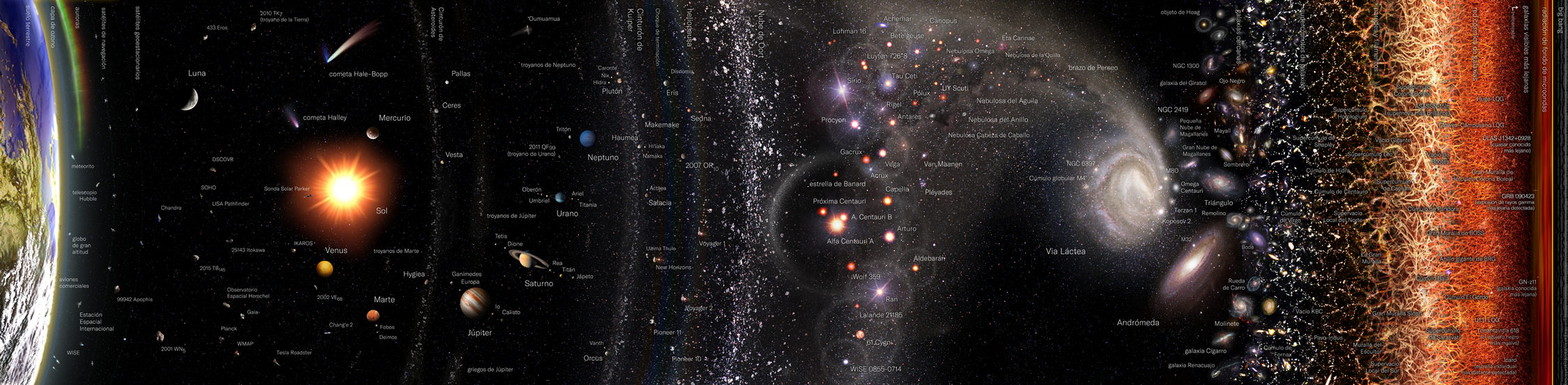

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias. Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón.

| α = 2πe2 / hc ≈ 1/137 |

| αG = (Gmp2)2 / hc ≈ 10-38 |

La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

Cuando surgen comentarios de números puros y adimensionales, de manera automática aparece en mi mente el número 137. Ese número encierra más de lo que estamos preparados para comprender; me hace pensar y mi imaginación se desboca en múltiples ideas y teorías. Einstein era un campeón en esta clase de ejercicios mentales que él llamaba “libre invención de la mente”. El gran físico creía que no podríamos llegar a las verdades de la naturaleza sólo por la observación y la experimentación. Necesitamos crear conceptos, teorías y postulados de nuestra propia imaginación que posteriormente deben ser explorados para averiguar si existe algo de verdad en ellos.

Para poner un ejemplo de nuestra ignorancia poco tendríamos que buscar, tenemos a mano miles de millones.

Me acuerdo de León Lederman (premio Nobel de Física) que decía:

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre de constante de estructura fina”.

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck*. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Lo más notable de este número es su dimensionalidad. La velocidad de la luz, c, es bien conocida y su valor es de 299.792.458 m/segundo; la constante de Planck racionalizada, ћ, es h/2π = 1’054589×10 julios segundo; la altura de mi hijo, el peso de mi amigo, etc, todo viene con sus dimensiones. Pero resulta que cuando uno combina las magnitudes que componen alfa ¡se borran todas las unidades! El 137 está solo: se escribe desnudo a donde va. Esto quiere decir que los científicos del undécimo planeta de una estrella lejana situada en un sistema solar de la galaxia Andrómeda, aunque utilicen Dios sabe qué unidades para la carga del electrón y la velocidad de la luz y qué versión utilicen para la constante de Planck, también les saldrá el 137. Es un número puro. No lo inventaron los hombres. Está en la naturaleza, es una de sus constantes naturales, sin dimensiones.

La física se ha devanado los sesos con el 137 durante décadas. Werner Heisember (el que nos regaló el Principio de Incertidumbre en la Mecánica Cuántica), proclamó una vez que todas las fuentes de perplejidad que existen en la mecánica cuántica se secarían si alguien explicara de una vez el 137.

¿Por qué alfa es igual a 1 partido por 137?

Esperemos que algún día aparezca alguien que, con la intuición, el talento y el ingenio de Galileo, Newton o Einstein, nos pueda por fin aclarar el misterioso número y las verdades que encierra. Menos perturbador sería que la relación de todos estos importantes conceptos (e–, h y c) hubieran resultado ser 1 ó 3 o un múltiplo de pi… pero ¿137?

Arnold Sommerfeld percibió que la velocidad de los electrones en el átomo de hidrógeno es una fracción considerable de la velocidad de la luz, así que había que tratarlos conforme a la teoría de la relatividad. Vio que donde la teoría de Bohr predecía una órbita, la nueva teoría predecía dos muy próximas.

Esto explica el desdoblamiento de las líneas. Al efectuar sus cálculos, Sommerfeld introdujo una “nueva abreviatura” de algunas constantes. Se trataba de 2πe2 / hc, que abrevió con la letra griega “α” (alfa). No prestéis atención a la ecuación. Lo interesante es esto: cuando se meten los números conocidos de la carga del electrón, e–, la constante de Planck, h, y la velocidad de la luz, c, sale α = 1/137. Otra vez 137 número puro.

Las constantes fundamentales (constantes universales) están referidas a los parámetros que no cambian a lo largo del universo. La carga de un electrón, la velocidad de la luz en el espacio vacío, la constante de Planck, la constante gravitacional, la constante eléctrica y magnética se piensa que son todos ejemplos de constantes fundamentales

Las constantes fundamentales (constantes universales) están referidas a los parámetros que no cambian a lo largo del universo. La carga de un electrón, la velocidad de la luz en el espacio vacío, la constante de Planck, la constante gravitacional, la constante eléctrica y magnética se piensa que son todos ejemplos de constantes fundamentales.

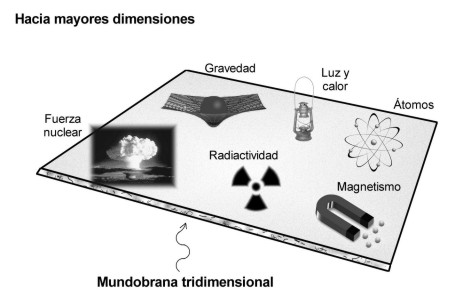

Las fuerzas de la naturaleza que gobiernan la electricidad, el magnetismo, la radiactividad y las reacciones nucleares están confinadas a un “mundo-brana” tridimensional, mientras que la gravedad actúa en todas las dimensiones y es consecuentemente más débil.

emilio silvera

Ago

13

Desde la materia “inerte” a los pensamientos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

« ¿Cerebro y Mente? ¿Inteligencia y Sabiduría?

La cosmología observacional se ocupa de las propiedades físicas del Universo, como su composición física referida a la química, la velocidad de expansión y su densidad, además de la distribución de Galaxias y cúmulos de galaxias. La cosmología física intenta comprender estas propiedades aplicando las leyes conocidas de la física y de la astrofísica. La cosmología teórica construye que dan una descripción matemática de las propiedades observadas del Universo basadas en esta comprensión física.

La cosmología también tiene aspectos filosóficos, o incluso teológicos, en el sentido de que trata de comprender por qué el Universo tiene las propiedades observadas. De hecho, después de unos miles de millones de años de evolución, el Universo se ha valido de las estrellas para elaborar los materiales que han posibilitado la aparición de la vida.

La cosmología teórica se basa en la teoría de la relatividad , la teoría de Einstein de la gravitación. De todas las fuerzas de la naturaleza, la gravedad es la que tiene efectos intensos a grandes escalas y domina el comportamiento del Universo en su conjunto. El espacio-tiempo, la materia contenida en el Universo con la fuerza gravitatoria que genera y, nuestras mentes que tienen conocimientos de que todo esto sucede.

Está con nosotros, es la parte más importante del Ser. Sin embargo, no nos paramos a pensar en que sea posible tal maravilla de la Naturaleza. Un pequeño reducto de un Ser vivo que genera ideas y pensamientos… ¡Y también sentimientos! Es la parte de nosotros que nos hace mejor cuando enlaza con la idea de la familia. También es la parte que, en algunos, hace posible que la especie avance con sus ideas nuevas y superiores.

De manera que, nuestro consciente (sentimos, pensamos, queremos obrar con conocimiento de lo que hacemos), es el elemento racional de nuestra personalidad humana que controla y reprime los impulsos del inconsciente, para desarrollar la capacidad de adaptación al mundo exterior. Al ser conscientes, entendemos y aplicamos nuestra razón natural para clasificar los conocimientos que adquirimos mediante la experiencia y el estudio que aplicamos a la realidad del mundo que nos rodea. Claro que, no todos podemos percibir la realidad de la misma manera, las posibilidades existentes de que el conocimiento de esa realidad responda exactamente a lo que ésta es en sí, no parece .

El ojo humano es el primer elemento del sistema sensorial: en este caso, la visión, para el sistema visual.

Descartes, Leibniz, Locke, Berkeley, Hume (que influyó decisivamente en Kant), entre otros, construyeron una base que tomó fuerza en Kant, para quien el conocimiento arranca o nace de nuestras experiencias sensoriales, es decir, de los que nos suministra nuestros cinco sentidos, pero no todo en él procede de esos datos. Hay en nosotros dos fuentes o potencias distintas que nos capacitan para conocer, y son la sensibilidad (los sentidos) y el entendimiento (inteligencia). Esta no puede elaborar ninguna idea sin los sentidos, pero éstos son inútiles sin el entendimiento.

A todo esto, para mí, el conocimiento está inducido por el . La falta y ausencia de interés aleja el conocimiento. El interés puede ser de distinta índole: científico, social, artístico, filosófico, etc. (La gama es tan amplia que existen conocimientos de todas las posibles vertientes o direcciones, hasta tal punto es así que, nunca nadie lo podrá saber todo sobre todo). Cada uno de nosotros puede elegir sobre los conocimientos que prefiere adquirir y la elección está adecuada a la conformación individual de la sensibilidad e inteligencia de cada cual. Allí, en alguna parte, está el germen del interés-curiosidad de cada cual.

También se da el caso de personas que prácticamente, por cuestiones genéticas o de otra índole, carecen de cualquier por el conocimiento del mundo que les rodea, sus atributos sensoriales y de inteligencia funcionan a tan bajo rendimiento que, sus comportamientos son cuasi-animales (en el sentido de la falta de racionalidad), son guiados por la costumbre y las necesidades primarias: comer, dormir…

El polo opuesto lo encontramos en múltiples ejemplos de la historia de la ciencia, donde personajes como Newton, Einstein, Riemann, Ramanujan y tantos otros (cada uno en su ámbito del conocimiento), dejaron la muestra al mundo de su genio .

Pero toda la realidad está encerrada en una enorme burbuja a la que llamamos Universo y que encierra todos los misterios y secretos que nosotros, seres racionales y conscientes, perseguimos. Todo el mundo sabe lo que es la conciencia; es lo que nos abandona cada noche cuando nos dormimos y reaparece a la siguiente cuando nos despertamos. Esta engañosa simplicidad me recuerda lo que William James escribió a finales del siglo XIX sobre la atención:

”Todo el mundo sabe lo que es la atención; es la toma de posesión por la mente, de una forma clara e intensa, de un hilo de pensamiento de entre varios simultáneamente posibles”.

Más de cien años más tarde somos muchos los que creemos que seguimos sin tener una comprensión de fondo ni de la atención, ni de la conciencia que, desde luego, no creo que se marche cuando dormimos, ella no nos deja nunca.

La falta de comprensión ciertamente no se debe a una falta de atención en los círculos filosóficos o científicos. Desde que René Descartes se ocupara del problema, pocos han los temas que hayan preocupado a los filósofos tan persistentemente como el enigma de la conciencia.

Para Descartes, como para James de dos siglos después, ser consciente era sinónimo de “pensar”: el hilo de pensamiento de James no era otra cosa que una corriente de pensamiento. El cogito ergo sum, “pienso, luego existo”, que formuló Descartes como fundamento de su filosofía en Meditaciones de prima philosophía, era un reconocimiento explícito del papel central que representaba la conciencia con respecto a la ontología (qué es) y la epistemología (qué conocemos y cómo le conocemos).

Claro que tomado a pie juntillas, “soy consciente, luego existo”, nos conduce a la creencia de que nada existe más allá o fuera de la propia conciencia y, por mi parte, no estoy de acuerdo. Existen muchísimas cosas y hechos que no están al alcance de mi conciencia. Unas veces por imposibilidad física y otras por imposibilidad intelectual, lo cierto es que son muchas las cuestiones y las cosas que están ahí y, sin embargo, se escapan a mi limitada conciencia.

Todo el entramado existente alrededor de la conciencia es de una complejidad enorme, de hecho, conocemos mejor el funcionamiento del Universo que el de nuestros propios cerebros, una máquina compleja que algunos dicen que hizo el Universo para poder observarse mismo.

Un día se despierta y nos acompaña para siempre

¿Cómo surge la conciencia como resultado de procesos neuronales particulares y de las interacciones entre el cerebro, el cuerpo y el mundo? ¿Cómo pueden explicar procesos neuronales las propiedades esenciales de la experiencia consciente?

Cada uno de los estados conscientes es unitario e indivisible, pero al mismo tiempo cada persona puede elegir entre un ingente de estados conscientes distintos.

Muchos han sido los que han querido explicar lo que es la conciencia. En 1.940, el gran neurofisiólogo charles Sherrington lo intento y puso un ejemplo de lo que él pensaba sobre el problema de la conciencia. Unos pocos años más tarde también lo intentaron otros y, antes, el mismo Bertrand Russell hizo lo propio, y, en todos los casos, con más o menos acierto, el resultado no fue satisfactorio, por una sencilla razón: nadie sabe a ciencia cierta lo que en verdad es la conciencia y cuales son sus verdaderos mecanismos; de hecho, Russell expresó su escepticismo sobre la capacidad de los filósofos para alcanzar una :

“Suponemos que un proceso físico da comienzo en un objeto visible, viaja hasta el ojo, donde se convierte en otro proceso físico en el nervio óptico y, finalmente, produce algún efecto en el cerebro al mismo tiempo que vemos el objeto donde se inició el proceso; pero este proceso de ver es algo “mental”, de naturaleza totalmente distinta a la de los procesos físicos que lo preceden y acompañan. Esta concepción es tan extraña que los metafísicos han inventado toda suerte de teorías con el fin de sustituirla con algo menos increíble”.

Está claro que en lo más profundo de ésta consciencia que no conocemos, se encuentran todas las respuestas planteadas o requeridas mediante preguntas que nadie ha contestado.

No creo que mirando en el fondo de la bolita encontremos las respuestas que todos buscamos. Más bien estarán dentro de nosotros mismos y, lo que tendremos que hacer es, comenzar la de nuestro propio yo. Lo cierto es que, no nos conocemos ni a nosotros mismos.

Al comienzo mencionaba el cosmos y la gravedad junto con la consciencia y, en realidad, con más o menos acierto, de lo que estaba tratando era de hacer ver que todo ello, es la misma cosa. Universo-Galaxia-Mente. Nada es independiente en un sentido global, sino que son de un todo y están estrechamente relacionados.

Una Galaxia es simplemente una parte pequeña del Universo, nuestro planeta es, una mínima fracción infinitesimal de esa Galaxia, y, nosotros mismos, podríamos ser comparados (en a la inmensidad del cosmos) con una colonia de bacterias pensantes e inteligentes. Sin embargo, todo forma parte de lo mismo y, aunque pueda dar la sensación engañosa de una cierta autonomía, en realidad todo está interconectado y el funcionamiento de una cosa incide directamente en las otras (efecto mariposa).

Pocas dudas pueden caber a estas alturas del hecho de que estar hablando de estas cuestiones, es un milagro en sí mismo.

Después de millones y millones de años de evolución, se formaron las conciencias primarias que surgieron en los animales con ciertas estructuras cerebrales de alta complejidad que, podían ser capaces de construir una escena mental, pero con capacidad semántica o simbólica muy limitada y careciendo de un verdadero lenguaje.

La conciencia de orden (que floreció en los humanos y presupone la coexistencia de una conciencia primaria) viene acompañada de un sentido de la propia identidad y de la capacidad explícita de construir en los estados de vigilia escenas pasadas y futuras. Como mínimo, requiere una capacidad semántica y, en su forma más desarrollada, una capacidad lingüística.

Los procesos neuronales que subyacen en nuestro cerebro son en realidad desconocidos y, aunque son muchos los y experimentos que se están realizando, su complejidad es tal que, de momento, los avances son muy limitados. Estamos tratando de conocer la “máquina” más compleja y perfecta que existe en el Universo.

Cien mil millones de neuronas, tantas como estrellas tiene nuestra Galaxia

Si eso es así, resultará que después de todo, no somos tan insignificantes como en un principio podría parecer, y solo se trata de tiempo. En su momento y evolucionadas, nuestras mentes tendrán un nivel de conciencia que estará más allá de las percepciones físicas tan limitadas. Para entonces, sí estaremos totalmente integrados y formando parte, como un todo, del Universo que presentimos.

El carácter de la conciencia me hace adoptar una posición que me lleva a decidir que no es un objeto, sino un proceso y que, desde este punto de , puede considerarse un ente digno del estudio científico perfectamente legítimo.

La conciencia plantea un problema especial que no se encuentra en otros dominios de la ciencia. En la Física y en la Química se suele explicar unas entidades determinadas en función de otras entidades y leyes. Podemos describir el agua con el lenguaje ordinario, pero podemos igualmente describir el agua, al menos en principio, en términos de átomos y de leyes de la mecánica cuántica. Lo que hacemos es conectar dos niveles de descripción de la misma entidad externa (uno común y otro científico de extraordinario poder explicativo y predictivo. Ambos niveles de descripción) el agua líquida, o una disposición particular de átomos que se comportan de acuerdo con las leyes de la mecánica cuántica (se refiere a una entidad que está fuera de nosotros y que supuestamente existe independientemente de la existencia de un observador consciente.)

Una maraña e conexiones sin fin

En el caso de la conciencia, sin embargo, nos encontramos con una simetría. Lo que intentamos no es simplemente comprender de qué manera se puede explicar las conductas o las operaciones cognitivas de otro ser humano en términos del funcionamiento de su cerebro, por difícil que esto parezca. No queremos simplemente conectar una descripción de algo externo a nosotros con una descripción científica más sofisticada. Lo que realmente queremos hacer es conectar una descripción de algo externo a nosotros (el cerebro), con algo de nuestro : una experiencia, nuestra propia experiencia individual, que nos acontece en tanto que observadores conscientes. Intentamos meternos en el interior o, en la atinada ocurrencia del filósofo Tomas Negel, saber qué se siente al ser un murciélago. Ya sabemos qué se siente al ser nosotros mismos, qué significa ser nosotros mismos, pero queremos explicar por qué somos conscientes, saber qué es ese “algo” que nos hace ser como somos, explicar, en fin, cómo se generan las cualidades subjetivas experienciales.

En suma, deseamos explicar ese “Pienso, luego existo” que Descartes postuló como evidencia primera e indiscutible sobre la cual edificar toda la filosofía. Y, todo esto, amigos míos, es posible gracias a que, en el Universo que nos acoge está presente la Física, la Química y la Biología que surgieron de la evolución de las estrellas y de la radiación cósmica para que , nosotros estemos aquí para comentar sobre un “todo” conformado por la materia y la mente.

emilio silvera

Ago

13

Fuerzas y Constantes…¡El Universo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Las fuerzas de la naturaleza que gobiernan la electricidad, el magnetismo, la radiactividad y las reacciones nucleares están confinadas a un “mundo-brana” tridimensional, mientras que la gravedad actúa en todas las dimensiones y es consecuentemente más débil. Seguramente ese será el motivo por el cual, encontrar al Bosón mediador de la fuerza, el Gravitón, resulta tan difícil.

Muchos han sido los intentos de localizar al gravitón, sin éxito alguno. ¿Será el de arriba? Seguramente no. Sin embargo, aunque no será fácil, debemos seguir la búsqueda del bosón que intermedia en la fuerza gravitacional.

Las fuerzas fundamentales

| Tipo de Fuerza | Alcance en m | Fuerza relativa | Función |

| Nuclear fuerte | <3×10-15 | 1041 | Une Protones y Neutrones en el núcleo atómico por medio de Gluones. |

| Nuclear débil | < 10-15 | 1028 | Es responsable de la energía radiactiva producida de manera natural. Portadoras W y Z– |

| Electromagnetismo | Infinito | 1039 | Une los átomos para formar moléculas; propaga la luz y las ondas de radio y otras formas de energías eléctricas y magnéticas por medio de los fotones. |

| Gravitación | Infinito | 1 | Mantiene unidos los planetas del Sistema Solar, las estrellas en las galaxias y, nuestros pies |

Fuerza Nuclear Fuerte

La Fuerza nuclear fuerte es la más potente de las cuatro fuerzas fundamentales. Los núcleos de los átomos están conformados por protones y neutrones que, a su vez están hechos de quarks. Los quarks están confinados dentro de los nucleones y sujetos por las partículas mediadoras de la fuerza, los Gluones que no permiten que los quarks se separen manteniendo así, el debido equilibrio.

Fuerza Nuclear Débil

“La fuerza nuclear débil es la responsable de la desintegración radiactiva de las partículas subatómicas y es la iniciadora del proceso conocido como fisión nuclear. La teoría de la interacción débil se conoce también como flavordinámica cuántica (QFD, de las siglas en inglés), aunque el término casi no se utiliza porque la fuerza nuclear débil se entiende mejor en términos de la teoría electrodébil (EWT). Es una fuerza de muy corto alcance, 10–17 m.

Desintegración Beta

Según el modelo estándar de física de partículas, la interacción débil es causada por la emisión o absorción de Bosones W y Z; por tanto, se considera una fuerza sin contacto, al igual que las otras tres fuerzas fundamentales. La interacción débil afecta a todos los fermiones conocidos, es decir, las partículas que tienen un espín (una propiedad de todas las partículas) semi-entero. El efecto más conocido de esta emisión es la desintegración Beta, que es una forma de radioactividad Los bosones W y Z son mucho más pesados que los protones o neutrones justamente eso explica el corto alcance de la interacción débil. De hecho, se denomina «débil» porque su intensidad de campo es varios órdenes de magnitud menor que la del electromagnetismo y la de la fuerza nuclear fuerte.”

Las constantes fundamentales

| Constante | Símbolo | Valor en unidades del SI |

| Aceleración en caída libre | g | 9,80665 m s-2 |

| Carga del electrón | e | 1,60217733(49) × 10-19 C |

| Constante de Avogadro | NA | 6,0221367 (36) × 1023 mol-1 |

| Constante de Boltzmann | K=R/NA | 1,380658 (12) × 10-23 J K-1 |

| Constante de Faraday | F | 9,6485309 (29) × 104 C mol-1 |

| Constante de los gases | R | 8,314510 (70) × J K-1 mol-1 |

| Constante de Loschmidt | NL | 2,686763 (23) × 1025 mol-3 |

| Constante de Planck | h | 6,6260755 (40) × 10-34 J s |

| Constante de Stefan-Boltzmann | σ | 5,67051 (19) × 10-8 Wm-2 K-4 |

| Constante eléctrica | ε0 | 8,854187817 × 10-12 F m-1 |

| Constante gravitacional | G | 6,67259 (85) × 10-11 m3 Kg-1 s-2 |

| Constante magnética | μ0 | 4π × 10-7 Hm-1 |

| Masa en reposo del electrón | me | 9,1093897 (54) × 10-31 Kg |

| Masa en reposo del neutrón | mn | 1,6749286 (10) × 10-27 Kg |

| Masa en reposo del protón | mp | 1,6726231 (10) × 10-27 Kg |

| Velocidad de la luz | c | 2,99792458× 108 m s-1 |

| Constante de estructura fina | α | 2 π e2/h c |

Desde el Big Bang, cuando aparecieron las fuerzas fundamentales, también lo hicieron las constantes universales que contribuyen a que, nuestro Universo sea tal como lo conocemos y posibilitan la presencia de vida aquí en la Tierra, y posiblemente, en otros muchos planetas.

Unas pueden ser más constantes naturales que otras, pero lo cierto es que, de momento, han servido como herramientas eficaces.

La velocidad de la luz (299.762.458 m/s) es el límite que impone el Universo para moverse

La última lección importante que aprendemos de la manera en que números puros como α (alfa) definen el mundo, es el verdadero significado de que los mundos sean diferentes.

La constante de estructura fina de Sommerfeld (símbolo α) es la constante física fundamental que caracteriza la fuerza de la interacción electromagnética. Es una cantidad sin dimensiones, por lo que su valor numérico es independiente del sistema de unidades usado

La expresión que la define y el valor recomendado por CODATA 2002 es:

137 EL NÚMERO PURO Y ADIMENSIONAL

El número puro que llamamos constante de estructura fina, e indicamos con α, es como decimos en el comentario siguiente, una combinación de e, c y h (el electrón, la velocidad de la luz y la constante de Planck). Inicialmente, podríamos estar tentados a pensar que un mundo en el que la velocidad de la luz fuera más lenta sería un mundo diferente. Pero sería un error. Si e, h y c cambian de modo que los valores que tienen en unidades métricas (o cualesquiera otras) fueran diferentes cuando las buscamos en nuestras tablas de constantes físicas, pero el valor de α permaneciera igual; este nuevo mundo sería observacionalmente indistinguible de nuestro mundo. Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la Naturaleza.

Fue Einstein el que anunció lo que se llamó principio de covariancia: que las leyes de la naturaleza deberían expresarse en una forma que pareciera la misma para todos los observadores, independientemente de dónde estuvieran situados y de cómo se estuvieran moviendo. Cuando trató de desarrollar este principio, Einstein tuvo dificultades; no encontraba la manera de expresarlo con la formulación matemática adecuada.

Pidió ayuda a su amigo Marcel Grossmann, matemático, quien sabiendo de las necesidades exactas de Einstein, le envió la copia de una conferencia que dio un tal Riemann, unos sesenta años antes.

Las matemáticas que ayudaron a Einstein para su teoría de los espacios curvos

Einstein fue muy afortunado, ya que durante la última parte del siglo XIX en Alemania e Italia, matemáticos puros habían estado inmersos en el estudio profundo y detallado de todas las geometrías posibles sobre superficies curvas. Habían desarrollado un lenguaje matemático que automáticamente tenía la propiedad de que toda ecuación poseía una forma que se conservaba cuando las coordenadas que la describían se cambiaban de cualquier manera. Este lenguaje se denominaba cálculo tensorial. Tales cambios de coordenadas equivalen a preguntar qué tipo de ecuación vería alguien que se moviera de una manera diferente.

Riemann , Georg Bernhard y la Teor´çia de la relatividad el tensor métrico

Einstein se quedó literalmente paralizado al leer la Conferencia de Riemann. Allí, delante de sus propios ojos tenía lo que Riemann denominaba Tensor métrico. Einstein se dio cuenta de que era exactamente lo que necesitaba para expresar de manera precisa y exacta sus ideas. Así llegó a ser posible la teoría de la relatividad general.

Einstein pudo expresar su principio de covariancia expresando sus leyes de la naturaleza como ecuaciones tensoriales, que poseían automáticamente la misma forma para todos los observadores.

Tensor métrico de Riemann:

La geometría de los espacios curvos de Riemann hizo posible la relatividad general de Einstein que se pasó siete años buscando la formulación adecuada a su ideas.

Este paso de Einstein completó un movimiento espectacular en la concepción física de la naturaleza que ha sido completado en el siglo XX. Está marcado por una evolución que se aleja continuamente de cualquier visión privilegiada del mundo, sea una visión humana, basada en la Tierra, o una visión basada en patrones humanos, la naturaleza tiene sus propios patrones (el 137 es un ejemplo de ello).

El Universo es igual en todas partes sin importar lo lejos que estén sus regiones

Está claro que pensar siquiera en que en nuestro universo, dependiendo de la región en la que nos encontremos, habrá distintos leyes físicas, sería pensar en un universo chapuza. Lo sensato es pensar como Einstein y creer que en cualquier parte del universo rigen las mismas leyes físicas, hasta que no se encuentre pruebas reales a favor de lo contrario, los científicos suponen con prudencia que, sea cual fueren las causas responsables de las pautas que llamamos “Leyes de la Naturaleza”, es mucho más inteligente adoptar la creencia de la igualdad física en cualquier parte de nuestro universo por muy remota que se encuentre; los elementos primordiales que lo formaron fueron siempre los mismos:

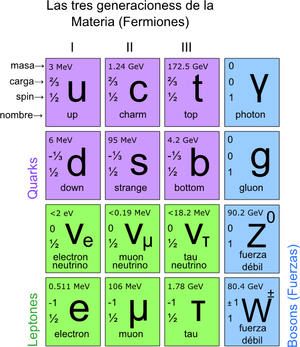

Quarks y Leptones que formaron los hadrones llamados bariones (como protones, neutrones y otros) para conformar la materia que vemos a nuestro alrededor, en los cielos y en el Universo profundo. Todo eso, grande o pequeño, está formado por la materia que está hecha de estos infinitesimales objetos ciudadanos del mundo cuántico y que se juntan por miles y cientos de miles de millones para dejarse ver en forma de mundos, de estrellas y galaxias y, ¿por qué no? también de seres vivientes racionales o no (aunque la definición de racionales no parece muy convincente).

emilio silvera

Ago

13

¿Que hay en el núcleo de un Púlsar? ¿Existen estrellas de...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

La pasta nuclear podría limitar el período de rotación de los Púlsares. Parece que con el nuevo descubrimiento se ha dado un paso más, hacia la comprensión de la materia y las formas que puede adoptar bajo ciertas circunstancias.

Jose A. Pons, profesor de la Universidad de Alicante

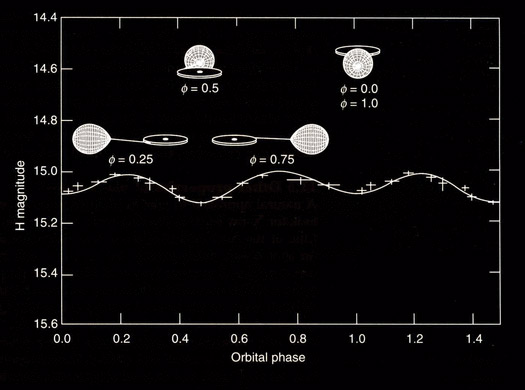

“Un púlsar de milisegundos ( MSP ) es un púlsar con un período de rotación inferior a unos 10 milisegundos . Se han detectado púlsares de milisegundos en partes de radio , rayos X y rayos gamma del espectro electromagnético . La teoría principal sobre el origen de los púlsares de milisegundos es que son estrellas de neutrones viejas que giran rápidamente y que se han hecho girar o “reciclado” a través de la acumulación de materia de una estrella compañera en un sistema binario cercano. Por esta razón, los púlsares de milisegundos a veces se denominan púlsares reciclados “

“Una estrella de neutrones es un tipo de remanente estelar resultante del colapso gravitacional de una estrella supergigante masiva después de agotar el combustible en su núcleo y explotar como una supernova tipo II, tipo Ib o tipo Ic.

Como su nombre indica, estas estrellas están compuestas principalmente de neutrones, más otro tipo de partículas tanto en su corteza sólida de hierro, como en su interior, que puede contener tanto protones y electrones, como piones y kaones.

Las estrellas de neutrones son muy calientes y se apoyan en contra de un mayor colapso mediante presión de degeneración cuántica, debido al fenómeno descrito por el principio de exclusión de Pauli. Este principio establece que dos neutrones (o cualquier otra partícula fermiónica) no pueden ocupar el mismo espacio y estado cuántico simultáneamente.”

“Una investigación en la que han participado científicos del Instituto de Ciencias del Espacio (ICE CSIC-IEEC) ha permitido observar por primera vez un púlsar (estrella de neutrones que emite radiaciones magnéticas) transitando entre dos de sus fases evolutivas.

Según ha informado el ICE, los científicos creen haber encontrado con esta observación “el eslabón perdido de los púlsares en los sistemas binarios”, con lo que confirmarían una teoría que se describe desde hace tres décadas.”

Un estudio liderado por el grupo de Astrofísica Relativista de la Universidad de Alicante ha detectado la que podría ser la primera evidencia observacional de la existencia de una nueva fase exótica de la materia en la corteza interna de las estrellas de neutrones (púlsares).

Los púlsares son estrellas de neutrones (estrellas ultra-compactas y fuertemente magnetizadas) en rotación, residuos de una explosión Supernova. Estas estrellas nacen rotando muy velozmente (hasta 100 veces por segundo), pero van perdiendo momento angular debido a la emisión de radiación electromagnética, de la misma forma que un gigantesco imán que gira perdería energía. Algunas de estas estrellas de neutrones emiten ondas de radio en la dirección de sus polos magnéticos que, cuando incidentalmente apuntan a la Tierra, pueden ser detectadas. El primer descubrimiento de estas señales muy periódicas se produjo en 1967 por Jocelyn Bell y Anthony Hewish, y significó que le concedieran el premio Nobel en 1974 a Anthony Hewish.

Con el paso de las décadas, y el nacimiento de la astronomía de rayos X, (o en general de altas energías) se empezaron a detectar púlsares no sólo en radio, sino también en rayos X o en rayos gamma. Una de las incógnitas en el campo de los púlsares de rayos X es la existencia de un límite superior de 12 segundos en los periodos de rotación. Históricamente, se conocía que los radio-púlsares (aquellos que detectamos en ondas de radio) tenían un límite superior observado a su periodo de rotación que se atribuía a un simple efecto observacional: los que giran más lentamente emiten ondas de radio con menor intensidad y más focalizadas, con lo que es más difícil observarlos. Sin embargo, las misiones espaciales de la última década han detectado un creciente número de púlsares aislados de rayos X, y hemos visto con sorpresa que tampoco ninguno de ellos presenta un periodo de rotación superior a 12 segundos, pero no existía ninguna explicación teórica para este fenómeno.

Dado que, para estrellas aisladas, el ritmo de perdida de energía de rotación depende del campo magnético de la estrella de neutrones, se esperaba que las estrellas de campo magnético alto se frenarán muy rápidamente, pudiendo alcanzar periodos de rotación de varias decenas o incluso centenares de segundos, mientras aún están suficientemente calientes para ser visibles en rayos X. Sin embargo, se vio con sorpresa que hay un acumulamiento de fuentes con periodos entre 10 y 12 segundos, pero sin que nunca se haya encontrado un pulsar de rayos X, que no forme parte de un sistema binario, con periodos de rotación superiores.

Otra variante de esta clase de residuos estelares son los magnetar. arriba señalan uno

“En un estudio reciente, publicado en el último número de Nature Physics, aparecen los resultados de la investigación, basada en simulaciones por ordenador de la evolución del campo magnético de los púlsares, que aborda este misterio. La idea fundamental es que el campo magnético no permanece constante, sino que se disipa muy rápidamente debido a la alta resistividad eléctrica de una capa de la corteza interna, donde las corrientes eléctricas que soportan el campo magnético ultra-intenso de las estrellas de neutrones tienden a a desplazarse. Lo localización de dicha capa resistiva coincide con las predicción de un nuevo estado de la materia nuclear, llamado “pasta nuclear”.

¿Lasaña o espagueti?

La pasta nuclear, llamada así por similitud con la pasta italiana, sucede cuando la combinación de la fuerza nuclear y electro-magnética, a densidades cercanas a la de los núcleos atómicos, favorece el ordenamiento de los nucleones (protones y neutrones) en formas geométricas no esféricas, como láminas o filamentos (lasaña o espagueti).

Esta puede ser la primera evidencia observacional de la existencia de la fase de “pasta nuclear” en el interior de estrellas de neutrones, lo cual puede permitir que futuras misiones de observatorios de rayos X puedan usarse para aclarar aspectos de cómo funciona la interacción nuclear que aún no están del todo claros. Es una oportunidad única, ya que probablemente no hay otro lugar en el Universo, aparte de las estrellas de neutrones, donde podamos encontrar las condiciones necesarias para que se forme la “pasta nuclear”.

Los púlsares nacen girando muy rápidamente, sin embargo sus intensos campos magnéticos los frenan a lo largo de su vida, con lo cual su periodo de rotación aumenta. Entre tanto, en la capa de “pasta” las corrientes se disipan y el campo magnético de la estrellas se vuelve débil, hasta que ya no es capaz de frenar significativamente la rotación de la estrella: el púlsar está “al dente”, con un periodo de alrededor de 10-12 segundos.

Referencia:

A highly resistive layer within the crust of X-ray pulsars limits their spin periods, J. A. Pons, D. Viganò, N. Rea, Nature (2013), doi:10.1038/nphys2640.

Después de leer el artículo del profesor Pons, se me ocurre que la materia, en realidad, es una gran desconocida y guarda secretos que debemos desvelar para poder obtener de ella todo lo que nos ofrece que es mucho y que no hemos sabido aprovechar por el momento en toda su extensión y sus muchas posibilidades que nos llevarán hacia otra forma de ver el universo.

En otra ocasión os hablé aquí de la posibilidad (nunca podemos negar nada que nuestra imaginación pueda idear), de que existieran estrellas hechas de materia extraña, es decir de una especie de pasta densa compuesta de Quarks-Gluones y que estaría en la escala intermedia entre las estrellas de neutrones y los agujeros negros.

La Hipótesis de estrella de Quarks (EQs) podrían responder a muchos interrogantes surgidos a partir de observaciones astrofísicas que no coinciden con los modelos canónicos teóricos de las Estrellas de Neutrones ( ENs ). Decimos que son hipotéticas porque se conjetura que estarían formadas por Materia Extraña ( ME ). La comunidad astrofísica espera evidencias observacionales que permitan diferenciarlas de las ENs, ya que podrían explicar un conjunto de observaciones astronómicas que aún resultan una incógnita. Es sabido que una EN es el remanente del colapso de una estrella masiva. El colapso de la estrella, la supernova, da lugar a un núcleo compacto hiperdenso de hierro y otros metales pesados que sigue comprimiéndose y calentándose. Su densidad continúa aumentando, dando lugar a una “neutronización“ (recombinación de electrones con protones que resultan en neutrones) y el gas degenerado de neutrones frena el colapso del remanente.

Se especula con la posibilidad de que existan estrellas de Quarks que estarían hechas de materia extraña de Quaks y Gluones.

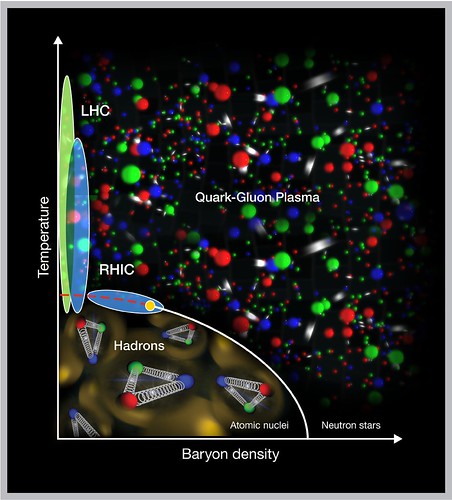

Una EQ, a diferencia de una EN, no se originaría necesariamente de una evolución estelar después del agotamiento del combustible nuclear de una estrella normal. Sería, probablemente, producto de la transición de fase hadrón-quark a altísima densidad. La Cromodinámica Cuántica (CDC), la Teoría de las Interacciones Fuertes que ocurren dentro de los nucleones (protones y neutrones), concibe teóricamente la idea de la transición de fase hadrón-quark a temperaturas y/ o densidades extremadamente altas con el consecuente desconfinamiento de quarks y gluones, que formarían una especie de “sopa “. Sin embargo, los quarks libres no se han encontrado aún, en uno u otro límite, en ningún experimento terrestre.

La “sopa“ que mencionamos antes, se conoce como Plasma Quark-Gluón ( PQG ). En el límite de altas temperaturas, el PQG está tratando de obtenerse en el laboratorio y existen fuertes indicios de que se logre con éxito experimentos de altas energías como el Colisionador Relativista de Iones Pesados (conocido por sus siglas en ingles como RHIC) de Brookhaven, New York.

Brookhaven (RHIC) de Nueva York

Por otro lado, se espera que a través de observaciones astronómicas se compruebe que la transición a altas densidades se hubiese producido en el interior de alguna EN. Esto se debe a que los valores de densidades estimados para que dicha transición tuviese lugar coinciden con densidades del orden de (3 exp. – 12) ρ0 (siendo ρ0 ̃ 0, 17 fmˉ ³ la densidad de equilibrio nuclear) que son típicas del interior de las ENs. Los cálculos basados en diferentes ecuaciones de estado de la materia nuclear muestran estos resultados, por lo que sería razonable que el núcleo de las ENs estuviese formado por materia de quarks.

Recientemente, la relación entre campo magnéticos y materia densa está atrayendo la atención de los astrofísicos, especialmente después de las observaciones de emisiones peculiares de pulsares anómalos de rayos X, que se interpretan como ENs en rotación, y de emisiones de radiación γ de baja energía de los llamados repetidores de rayos γ suaves ( SGRs – soƒt gamma-ray repeaters ). El motor central de esas radiaciones podría ser un campo magnético mayor que 4 x 10¹³ Gauss, que es el campo crítico previsto por la Electrodinámica Cuántica.

Muchas observaciones astronómicas indirectas sólo se explicarían a través de la existencia de campos magnéticos muy intensos en los núcleos de ENs en EQs, de manera que el papel que juega el campo magnético en la ME aún constituye un problema abierto y de sumo interés en la Astrofísica.

En particular, en un trabajo reciente, se ha analizado la ME considerando neutralidad de carga, equilibrio β y conservación del número bariónico. En dicho trabajo se obtuvo una cota superior para el valor del campo magnético que determina una transición de fase cuya explicación requiere ser estudiada en profundidad ya que sería independiente de la interacción fuerte entre los quarks. También se ha comprobado que la presencia de de campos magnéticos intensos favorece la estabilidad de la ME.

Por otro lado, estudios teóricos han demostrado que si la materia es suficientemente densa, la materia de quarks deconfinada podría estar en un estado superconductor de color. Este estado estaría formado por pares de quarks, análogos a los pares de Cooper (constituidos por electrones) existentes en los superconductores ordinarios.

Los quarks, a diferencia de los electrones, poseen grados de libertad asociados con el color, el sabor y el espín. Por este motivo, dependiendo del rango de densidades en el cual estamos trabajando, algunos patrones de apareamiento pueden verse favorecidos generando la aparición de distintas fases superconductoras de color. Según estudios teóricos, la fase superconductora más favorecida a densidades extremadamente altas sería la Color Flavor Locked (CFL), en la cual los quarks u, d y s poseen igual momento de Fermi, y en el apareamiento participan los tres colores y las dos proyecciones de espín de cada uno de ellos. Estudios recientes sobre la fase CFL han incluido los efectos de campos magnéticos intensos, obteniendo que bajo determinadas condiciones el gas superconductor, que corresponde a la separación entre bandas de energía en el espectro fermiónico, crece con la intensidad del campo. A esta fase se la llama Magnetic Color Flavor Locked (MCFL).

El púlsar del Cangrejo. La imagen combina información óptica del Hubble (en rojo) e imágenes de rayos X del Chandra (en azul). El púlsar está oculta en la Nebulosa del mismo nombre.

Son muchos los misterios que contiene el Universo y, nosotros, debemos recorrer los caminos que sean necesarios para desvelarlos. Cuando las cosas son conocidas, se evitan las sorpresas y, además, se les puede sacar más rendimiento, Así, si conocemos las posibilidades que nos ofrece la Naturaleza…

En la superconductividad electromagnética usual, un campo magnético suficientemente fuerte destruye el estado superconductor. Para la superconductividad de color no existe aún un consenso de cómo, la presencia del campo magnético, podría afectar al apareamiento entre los quarks.

En este trabajo describiremos brevemente la materia extraña, con el objetivo de explicar su formación en el interior de una EN y entender la composición y características de una EQ. Posteriormente, utilizaremos el modelo fenomenológico de bag del Massachussets Institute of Technology (MIT) para encontrar las ecuaciones de estado de la ME en condiciones determinadas, comprobando la estabilidad de la misma, frente a la materia de quarks ordinaria formada sólo por quarks u y d. Presentaremos, además, algunas candidatas posibles a EQs según observaciones astrofísicas. Por último, trataremos de entender la superconductividad de color y la influencia del campo magnético intenso en las fases superconductoras.

Materia de Quarks:

Ya se descubrió un nuevo tipo de materia dentro de las estrellas de neutrones

“En física de partículas, los cuarks o quarks son los fermiones elementales masivos que interactúan fuertemente formando la materia nuclear y ciertos tipos de partículas llamadas hadrones. Junto con los leptones, son los constituyentes fundamentales de la materia bariónica.”

Un gran logro de la Mente Humana

Uno de los mayores logros alcanzados por los físicos en el último siglo, fue la construcción del Modelo Estándar en la física de partículas elementales. Este modelo sostiene que la materia en el Universo está compuesta por fermiones, divididos en quarks y leptones, que interactúan a través de los llamados bosones de calibre: el fotón (interacción electromagnética), los bosones W± y Zº (interacción débil), y 8 tipos de gluones (interacción fuerte). Junto con los bosones de calibre, existen tres generaciones de fermiones: ( v e, e ), u, d ); ( vµ, µ ), ( c, s ) ; ( v….); y sus respectivas antipartículas. Cada “ sabor “ de los quarks, up ( u ), down ( d ), charme ( c ), strange ( s , top ( t ) y bottom ( b), tiene tres colores ( el color y el sabor son números cuánticos ). La partícula que aún no ha sido descubierta experimentalmente es el bosón de Higgs, que cabe suponer sería responsable del origen de la masa de las partículas.

Muchos son los científicos que buscan respuestas

Los quarks son los componentes fundamentales tanto de los hadrones fermiónicos (bariones formados por la combinación de tres quarks) como de los bosónicos (mesones formados por un quark y un antiquark). ES sabido que el núcleo de un átomo está compuesto por nucleones (protones y neutrones) que a su vez están compuestos por quarks (protón = udd). David Gross y Franks Wilczek y David Politzer, descubrieron teóricamente que en la CDC el acoplamiento efectivo entre los quarks disminuye a medida que la energía entre ellos aumenta (libertad asintótica). La elaboración de esta teoría permitió que recibieran el Premio Nobel de Física en el año 2004. En los años 60, la libertad asintótica fue comprobada experimentalmente en el acelerador lineal de Stanford ( SLAC ).

Sin embargo, la CDC no describe completamente el deconfinamiento en un régimen de alta densidad y baja temperatura, debido a su complejidad matemática y a su naturaleza no lineal para bajas energías. No obstante, es posible recurrir a una descripción fenomenológica para intentar entender la física de la formación de la materia de quarks en las ENs. La materia de quarks, es decir, el plasma de quarks deconfinados y gluones, es una consecuencia directa de la libertad asintótica cuando la densidad bariónica o la temperatura son suficientemente altas como para considerar que los quarks son partículas más fundamentales que los neutrones o protones. Esta materia, entonces, dependiendo de la temperatura y del potencial químico (µ) de los quarks, aparecería esencialmente en dos regímenes. Uno de ellos, el PQG, constituiría la fase “caliente” de la materia de quarks cuando T >> µ constituyendo la mencionada ME, que se formaría en el interior de las Ens. Esta transición de fase estaría ocurriendo en el Universo cada vez que una estrella masiva explotara en forma de supernova, con la consecuente aparición de una EN.

Las estrellas de Quarks, aunque de momento son una conjetura su existencia, hasta donde podemos saber, no sería nada extraña que, en cualquier momento, se pudieran descubrir algunas y, pasarían a engrosar la lista de los objetos más masivos del Universo. Ellas estarían entre las estrellas de Neutrones y los Agujeros Negros.

En 1971 A.R. Bodmer propuso que la ME es más estable que el Fe, que es el más estable de todos los núcleos ordinarios. Por lo tanto, según su hipótesis, la ME constituía el estado más fundamental de la materia. En la Naturaleza, la presencia de núcleos atómicos ordinarios. Por lo tanto, según su hipótesis, la ME constituía el estado más fundamental de la materia. En la Naturaleza, la presencia de núcleos atómicos ordinarios no se halla en contradicción con la mayor estabilidad que presenta la ME. Esto se debe a que la conversión de un núcleo atómico en ME, requiere que se transformen quarks u y d en quarks extraños s. La probabilidad de que esto ocurra involucra una transición débil que hace que los núcleos con peso atómico A ≥ 6 sean estables por más de 10 exp60. Años. De manera que si la hipótesis de la ME fuera correcta, estaríamos en presencia del estado más estable de la materia hadrónica y para su formación se necesitaría un ambiente rico en quarks s o la formación de un PQG, Como ya mencionamos, podríamos alcanzar dicho estado en las colisiones de iones pesados relativistas, segundos después del Big Bang en el Universo primordial y en el interior de las Ens.

A) Formación de Materia Extraña en una Estrella de Neutrones:

Inmediatamente después de la transición de fase hadrón-quark en el interior de la estrella, no existe una configuración de equilibrio químico entre los quarks. Esto puede entenderse de la siguiente forma: en el punto de transición, la materia bariónica predominante son los quarks u y d con una pequeña cantidad de electrones. Así, la densidad del quark d es aproximadamente dos veces la densidad del quark u, Nd ~ 2Nu, debido al hecho de que la materia en las estrellas compactas es eléctricamente neutra. Por el principio de exclusión de Pauli, sería energéticamente más favorable para los quarks d decaer en quarks s hasta restablecer el equilibrio entre sabores vía interacciones débiles. Dado que la densidad bariónica de la materia de quarks en el interior de la estrella sería ~ 5ρ0, los potenciales químicos de los quarks deberían ser grandes respecto de las masas. Esto implicaría que las densidades de los quarks fueran prácticamente iguales. De esta forma, la configuración más estable en el interior de la EN, sería un núcleo de ME con una densidad bariónica Nb = Ni ( i= u , d, s ). Si el interior de una EN estuviese compuesto por ME, cabe entonces preguntarnos: ¿podría transformarse una EN en una EQ?

B) EQs: Formación y características:

Para los astrónomos ha quedado bien establecido que el remanente estelar después de la explosión de una supernova podría resultar ser una Enana Blanca, una Estrella de neutrones o un Agujero Negro, dependiendo de la masa de la estrella de origen.

Observaciones astronómicas recientes sugieren un remanente aún más exótico: las EQs. La idea de la existencia de estas estrellas apareció en 1969, cinco años después de la predicción de Gell- Mann de la existencia de los quarks.

En el año 1984, Farhi y Jaffe, basándose en el modelo de bag del MIT, mostraron en sus cálculos que la energía por barión de la ME era menor que la del núcleo atómico más estable, el Fe. Esto daba mayor solidez a la hipótesis de Bodmer- Witten e inmediatamente se comenzaron a desarrollar modelos teóricos de Eqs. En el año 2002, el Observatorio de Rayos X Chandra, de la NASA, reportó el descubrimiento de dos estrellas candidatas a ser Eqs.

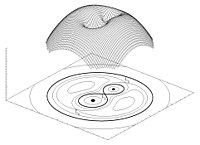

Para que una EN se transforme en una EQ pura, necesitamos algún mecanismo mediante el cual su densidad aumente cada vez más. Pensemos, por ejemplo, que la EN forma parte de un sistema binario. Para considerar que dos estrellas están en un sistema binario, debe analizarse su proximidad comparando el tamaño de las mismas con el radio del lóbulo de Roche, que es la región que define el campo de la acción gravitatoria de una estrella sobre otra.

Si el radio de cada estrella es menor que el lóbulo de Roche, las estrellas están desconectadas. Por el contrario, si una de ellas llena el lóbulo de Roche, el sistema es semi-conectado y la materia puede fluir a través del punto de Lagrange interno. El potencial gravitatorio de un sistema binario se consume la masa de la estrella compañera. Cuando la masa de la EN alcanza el valor de ~2 M (M corresponde a la masa solar), sufre un colapso gravitatorio, pudiéndose transformar en una EQ.

¿Podría el colapso de una supernova dar origen a la formación de una EQ? Esta pregunta nos conduce a otra hipótesis teórica acerca de la formación de la EN, hay conservación del momento angular. La proto-estrella de neutrones tiene una fracción pequeña de su radio original, que era el de la supernova, por lo que su momento de inercia se reduce bruscamente. Como resultado, la EN se forma con una altísima velocidad de rotación que disminuye gradualmente. Los períodos de rotación se hacen cada vez más largos debido a la pérdida de energía rotacional por la emisión de vientos de electrones y positrones y de la radiación bipolar electromagnética. Cuando la alta frecuencia de rotación o el campo electromagnético alcanzan un valor crítico, la EN se transforma en un pulsar que emite pulsos del orden de los milisegundos. Debido a la enorme fuerza centrífuga en estos objetos, la estructura interna se modifica, pudiendo alcanzar una densidad crítica por encima de la que corresponde a la transición de fase hadrón-quark. En estas condiciones, la fase de materia nuclear relativamente incomprensible se convertiría en la fase de ME, más comprensible, cuyo resultado final sería la aparición de una EQ.

La identificación de una EQ requiere señales observacionales consistentes. Con esto nos referimos a propiedades físicas de la estrella tales como su masa máxima, radio, período mínimo de rotación, enfriamiento por emisión de neutrinos. Todas estas propiedades dependen de una única ecuación de estado para la materia densa de quarks que aún no ha sido completamente establecida. Sin embargo, existe un rango de valores aceptados para las cantidades antes mencionadas, con base en datos observacionales recientes, que marcarían importantes diferencias entre las posibles Eqs y los demás objetos compactos.

Un rasgo característico de las Eqs es que la materia no se mantendría unida por la atracción gravitacional, como ocurre en las Ens, sino que sería consecuencia directa de la interacción fuerte entre los quarks. En este caso, la estrella se dice auto-ligada. Esto implica una diferencia sustancial entre las ecuaciones de estado para las dos clases de estrellas. Las correcciones perturbativas a la ecuación de estado de la materia de quarks y los efectos de superconductividad de color complican aun más este punto. Otra característica para poder diferenciar las Eqs de las Ens es la relación entre su masa M y el radio R. Mientras que para una EQ, M ~ R³. De acuerdo con esta relación, las Eqs tendrían radios más pequeños que los que usualmente se le atribuyen a las Ens. Además, las Eqs violarían el llamado límite de Eddington. Arthur Eddington (1882-1994) observó que las fuerzas debido a la radiación y a la gravitación de las estrellas normales dependían del inverso del cuadrado de la distancia. Supuso, entonces, que ambas fuerzas podían estar relacionadas de algún modo, compensándose para que la estrella fuera más estable. Para estrellas de altísima masa, la presión de radiación es la dominante frente a la gravitatoria. Sin embargo, debería existir una presión de radiación máxima para la cual la fuerza expansiva debido a la radiación se equilibrara con la gravedad local. Para una estrella normal, el límite de Eddington está dado por una ecuación que omito para no hacer más complejo el tema.

Para cualquier valor de radiación que supere este límite, no habrá equilibrio hidrostático, causando la pérdida de masa de la estrella normal. El mecanismo de emisión en una EQ produciría luminosidades por encima de dicho límite. Una posible explicación a este hecho sería que la EQ es auto-ligada y por lo tanto su superficie alcanzaría temperaturas altísimas con la consecuente emisión térmica.

Por otro lado, una alternativa para explicar algunas observaciones de destellos de rayos γ, sería suponer que las emisiones provienen de Eqs con radios R ~ 6 km, valores demasiados pequeños si pensáramos que los destellos provienen de ENs.

En esta sección, hemos presentado algunas características de las Eqs que las diferenciarían de las Ens. Futuras evidencias experimentales y observacionales nos permitirían saber si las Eqs realmente existen en la naturaleza.

C) Observaciones astrofísicas: posibles Eqs

El mes de febrero de 1987 fue la primera oportunidad de poner a prueba, a través de las observaciones directas, las teorías modernas sobra la formación de las supernovas. En el observatorio de Las Campanas, en Chile, fue observada la Supernova 1987A en la Gran Nube de Magallanes. Algunas características de la emisión de neutrinos de la SN 1987ª, podrían explicarse sin una hipotética fuente de energía subnuclear como la ME contribuyera a su explosión. El remanente estelar que ha quedado como consecuencia de la explosión de la Supernova 1987ª, podría ser una EQ, ya que el período de emisión de este pulsar es de P= 0.5 ms. Una EN canónica no podría tener una frecuencia de rotación tan alta.

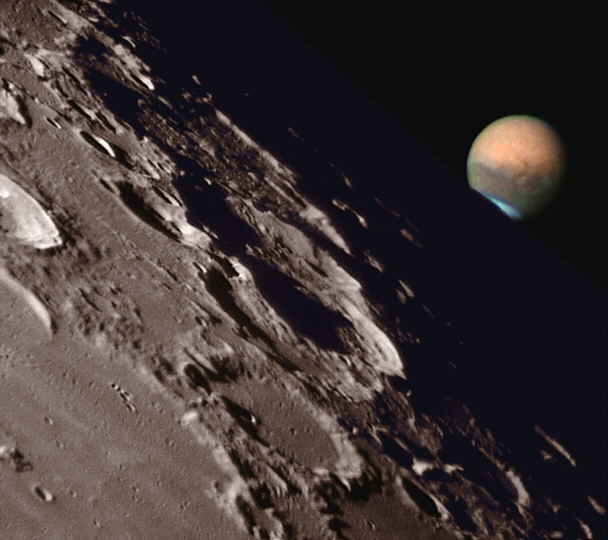

El observatorio Chandra de rayos X de la NASA también encontró dos estrellas inusuales: la fuente RX J1856.5-3754 con una temperatura de 105. K y la fuente 3C58 con un período de 65 ms. RX J1856.5-3754 es demasiado pequeña para ser una EN convencional y 3C58 parece haberse enfriado demasiado rápido en el tiempo de vida que se le estima.

Combinando los datos del Chandra y del telescopio espacial Hubble, los astrónomos determinaron que RX J1856. 5 – 3754 radia como si fuera un cuerpo sólido con una temperatura de unos 1x 10 exp5. ºC y que tiene un diámetro de alrededor de 11 km, que es un tamaño demasiado pequeño como para conciliarlo con los modelos conocidos de las Ens.