Dic

7

¡Qué barbaridad!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Dic

7

El LHC mucho más de lo que imaginamos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El público en general no sabe lo que hace realmente el LHC que, no sólo experimenta con las partículas y busca respuestas a los enigmas del Universo, sino que también, en muchas áreas de la Sociedad, como la medicina por ejemplo, ha contribuido de manera muy notable, al igual que lo hizo en lo referente a las comunicaciones.

En el Trabajo siguiente dejamos una muestra.

Dic

7

La Física de Partículas al Servicio de la Salud

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (1)

Comments (1)

En realidad, en el CERN, se trabaja en algo más que en las partículas subatómicas y se buscan nuevas respuestas y remedios para paliar el dolor en el mundo. También, se ha contribuido de manera notable a las comunicaciones y, el mundo es tal como lo conocemos hoy gracias a Ingenios como el LHC que, por desconocimiento de muchos, en su momento, fue tan denostado.

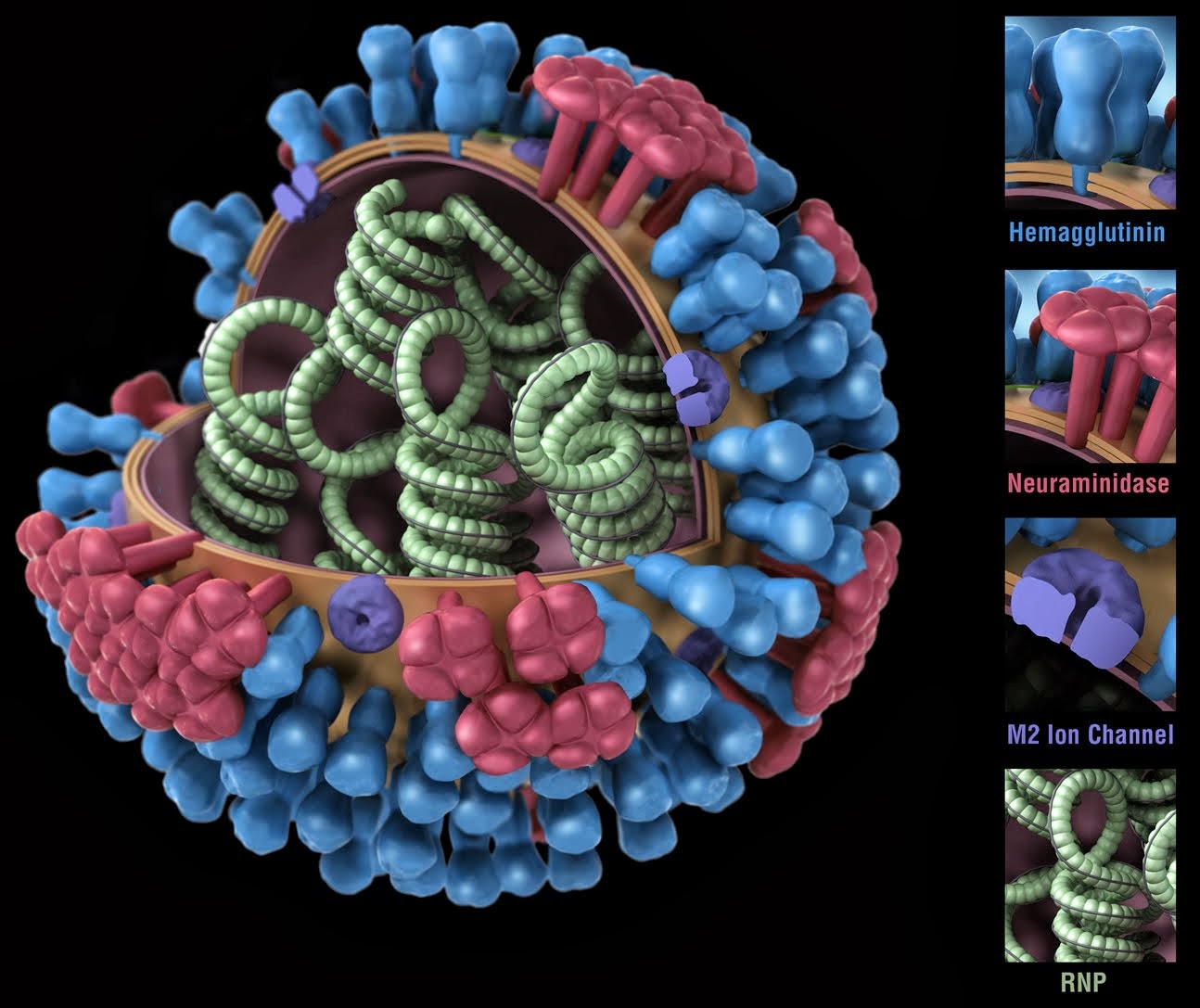

Transferencias tecnológicas del CERN a la Biomedicina.

Partículas y mucho más

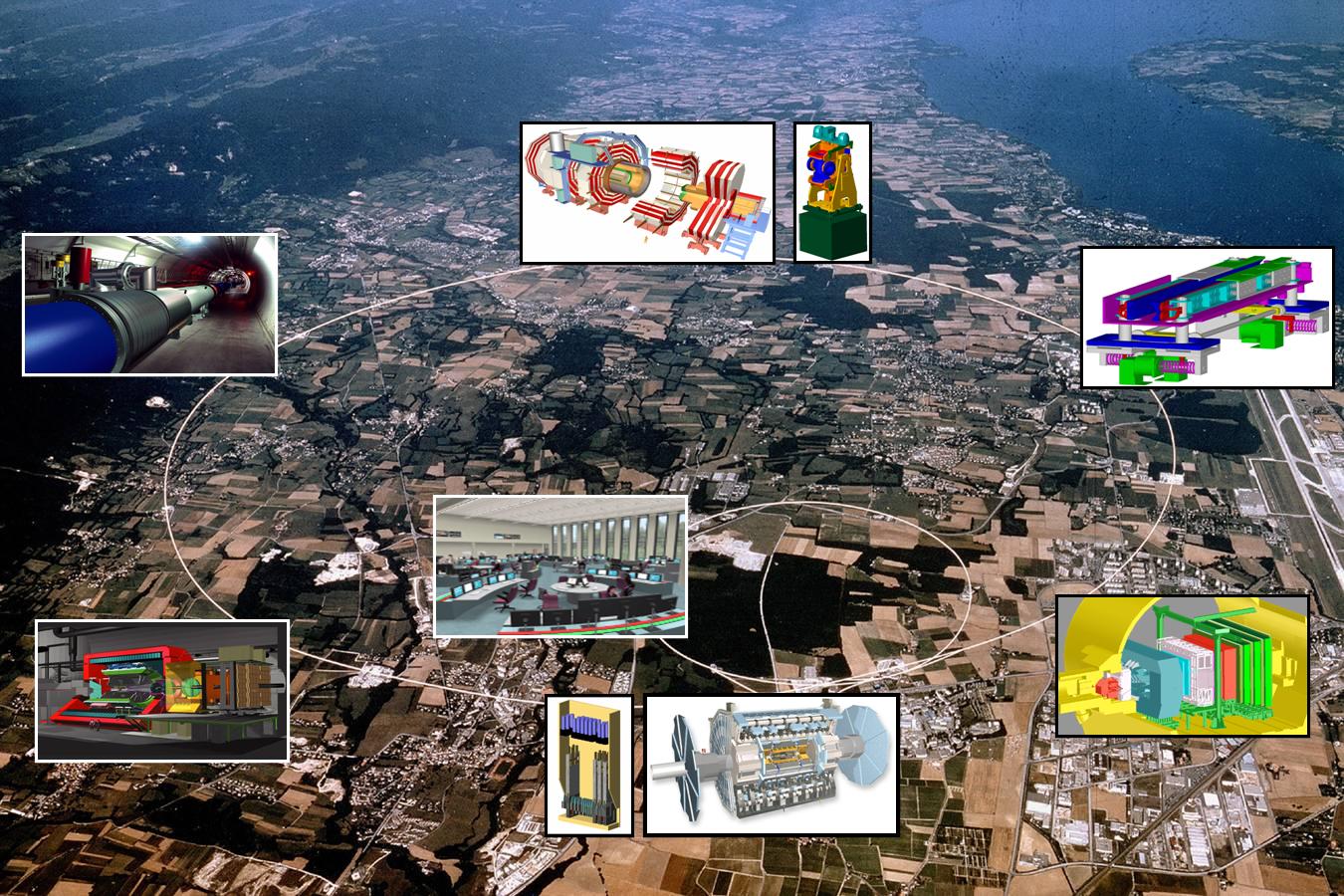

Seguramente la mayoría de los lectores de la Revista Española de Física han oído más de una vez hablar del CERN. Fundado en 1954, constituye el mayor laboratorio de física de partículas del mundo, con veinte países miembros y un personal de unas 3.000 personas entre físicos, ingenieros y personal técnico y administrativo de todo tipo. Seguramente están también al tanto de los grandes experimentos que se están preparando en este centro como el Large Hadron Collider (LHC), situado en un túnel circular de 27 km de longitud, destinado a elucidar el origen de la llamada ruptura de la simetría electrodébil y en última instancia el origen de las masas de las partículas elementales (no de la masa del protón o del neutrón como erróneamente se dice a veces en los medios de comunicación), o del proyecto CERN Neutrino Gran Sasso (CNGS), que consiste en enviar un haz de neutrinos de alta energía desde el CERN al laboratorio subterráneo italiano del Gran Sasso que se encuentra a 730 km, para estudiar las oscilaciones de estas huidizas partículas.

También es muy probable que muchos lectores asocien de manera natural la palabra acelerador de partículas a los instrumentos que utilizan los físicos modernos para estudiar y comprender mejor la estructura y el comportamiento de la materia a pequeñas escalas. Sin embargo, de los 17.000 aceleradores de partículas que se estima existen en la actualidad en todo el mundo, aproximadamente la mitad de ellos se usan en medicina y sólo una parte muy pequeña se usan para investigación fundamental. Por este y otros motivos que se discutirán más adelante, en este número especial de la Revista Española de Física dedicado a la física y las ciencias de la vida, ha parecido conveniente incluir un artículo en el que, al menos brevemente, se describieran algunas de las transferencias tecnológicas (spinoffs) importantes que la actividad del CERN aporta a dichas ciencias.

Mucho de lo que aquí se descubre, se aplica a nuestra Salud

Es bastante razonable que, como ocurre con las ciencias del espacio, mucha gente se pregunte cuál es la utilidad social de la física de partículas más allá de la adquisición de conocimientos fundamentales de la naturaleza. Sin embargo, es preciso señalar que los aceleradores y detectores de partículas del CERN y otros laboratorios similares requieren el uso, y muchas veces el desarrollo, de tecnologías de punta que obligan a una estrecha colaboración con la industria que redunda en beneficio de ambas partes. Las transferencias tecnológicas que se producen en este proceso se incorporan inmediatamente a nuestra vida diaria en áreas tales como la electrónica, procesamiento industrial y médico de imágenes, manejo y usos de la radiación , metrología, nuevos materiales, tecnologías de la computación y la información, tratamiento del cáncer, etc. En este artículo se pondrá el énfasis en aquellas actividades del CERN que han redundado de una forma más clara en beneficio de las ciencias biomédicas.

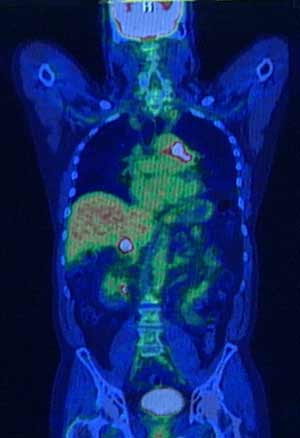

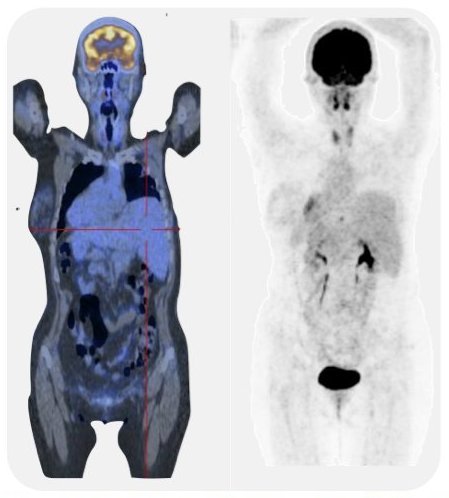

PET/TC o más allá de los rayos X

En el ámbito de la medicina los aceleradores de partículas se utilizan con dos finalidades; una para la formación de imágenes con propósitos diagnósticos y otra, para terapia, principalmente oncológica. Desde el descubrimiento de los rayos X por Röntgen en 1895, este tipo de radiación electromagnética ha proporcionado una información de valor incalculable y aún sigue proporcionándola. Sin embargo, mucho más recientemente, se han desarrollado otras técnicas complementarias de diagnóstico basadas en los llamados radiofármacos. Estas sustancias radiactivas presentan idealmente la propiedad de poder ser inyectadas en el organismo humano de forma segura y de fijarse exclusivamente a determinados tejidos. Posteriormente, a medida que van desintegrándose, emiten ciertas partículas que pueden ser detectadas y analizadas produciendo de esta forma imágenes estáticas o incluso dinámicas de los órganos en los que se depositaron los radiofármacos y, en definitiva, proporcionando información no solamente sobre la morfología de aquellos, sino también, en muchos casos, sobre su función y metabolismo. Los radiofármacos se producen utilizando haces de protones de alta intensidad y, como tienen una vida media muy baja, deben utilizarse cerca de donde se han creado. Se calcula que unos 20 millones de personas son diagnosticadas cada año mediante el uso de este tipo de sustancias.

Son técnicas no invasivas que dejan al descubierto lo que interesa ver y eliminar

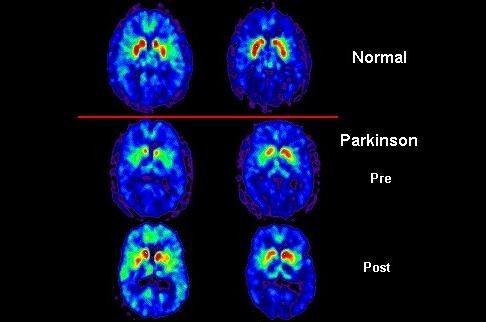

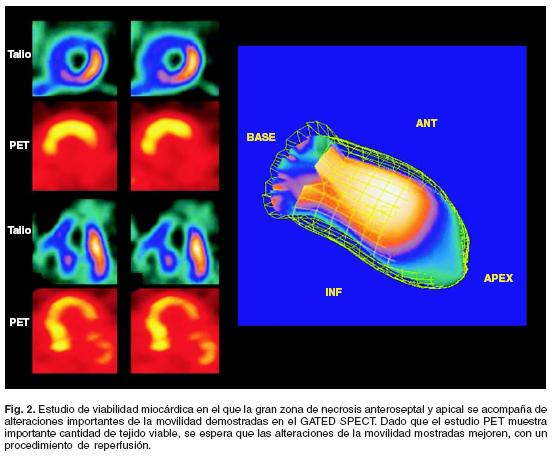

Una de las técnicas de este tipo más utilizada en la actualidad es la Positron Emission Tomography (PET). En su aplicación se utiliza normalmente un ciclotrón para irradiar alguna sustancia que se convierte en radiactiva por desintegración beta positiva (emisora de positrones). Esta sustancia se une por ejemplo a la glucosa y se inyecta al paciente. Los positrones producidos se aniquilan con los electrones circundantes dando lugar a dos fotones de energía muy bien definida, emitidos en direcciones opuestas. Estos fotones interaccionan con un material escintilador dando lugar a la emisión de otros fotones que pueden ser detectados por fotomultiplicadores o fotodiodos para formar la imagen de los tejidos que se pretenden estudiar en función de la distribución de la glucosa radiactiva. Por ejemplo, en el caso del diagnóstico del cáncer las células cancerosas suelen consumir más glucosa que las células sanas debido a su mayor vascularización y a su mayor actividad metabólica y reproductiva, produciendo por tanto una mayor emisión de fotones. Por el contrario, las zonas donde el tejido presente mayor número de células muertas brillarán menos debido a la menor concentración de glucosa radioactiva, lo cual puede ser muy útil para el diagnóstico de infartos y otras lesiones.

Tecnologías que llegan más allá

De acuerdo con David Townsend, uno de los pioneros en el desarrollo de la tecnología PET, aunque ésta no fue inventada en el CERN, una cantidad esencial e inicial de trabajo desarrollado en el CERN a partir de 1977 contribuyó de forma significativa al desarrollo del PET 3D. La tecnología PET alcanza su grado más alto de utilidad diagnóstica cuando se combina con la Computed Tomography (CT). La CT es un método de formación de imágenes tridimensionales a partir del procesamiento digital de un gran número de imágenes bidimensionales de rayos X. Inicialmente, las diferentes imágenes se obtenían alrededor de un solo eje de rotación y de ahí su nombre original de Computed Axial Tomography (CAT).

La técnica combinada PET/CT es uno de los desarrollos más excitantes de la medicina nuclear y la radiología modernas. Las reconstrucciones de imágenes CT permiten el diagnóstico precoz de tumores basándose en sus características morfológicas, mientras que la tecnología PET es capaz de diferenciar con grane eficiencia los tejidos malignos de los benignos. La fusión PET/CT permite ahora integrar las imágenes morfológica y fisiológica en una única imagen. El prototipo del scanner ART, el Partial Ring Tomograph (PRT), fue desarrollado en el CERN en 1980 y 1990 por David Townsend, Martín Wensveen y Henri Tochon-Danguy, y evaluado clínicamente en el departamento de medicina nuclear del Hospital Cantonal de Ginebra. ART puede considerarse como el precursor de la parte PET del moderno scanner PET/CT, que ha producido un impacto extraordinario en la tecnología de imágenes con fines médicos. Además, el CERN continua hoy en día contribuyendo a este campo fundamental de la medicina moderna mediante proyectos como Clear PET, Clear PEM, HPD PET etc.

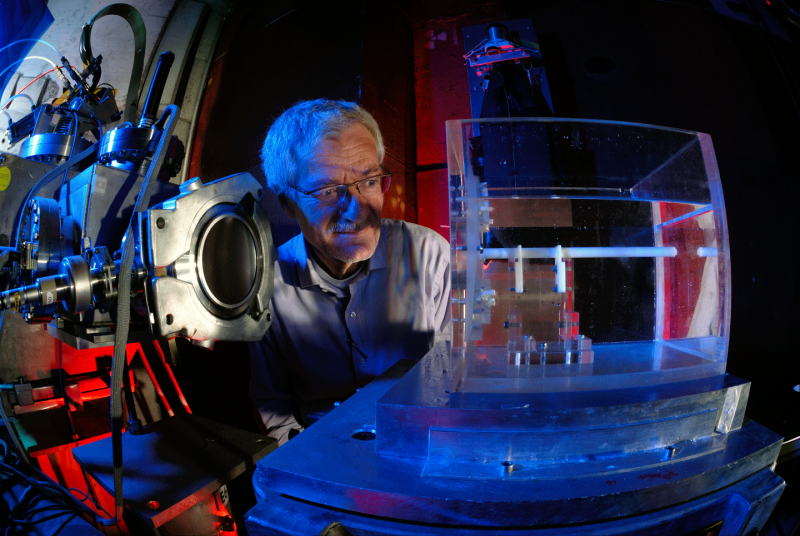

Sin embargo, la importancia del CERN en el desarrollo de las tecnologías PET o CT, y en general de todo tipo de scanner, va mucho más allá. En efecto, todo este tipo de dispositivos se basa, de una forma u otra, en los detectores desarrollados a finales de los sesenta en el CERN por George Charpak. Su trabajo fue reconocido en 1992 con la concesión del Premio Nobel de Física por su invención y desarrollo de detectores de partículas, en particular de la cámara proporcional multihilos, que produjo una revolución en la técnica de exploración de las partes más íntimas de la materia. Los detectores desarrollados por Charpak se usan aún para todo tipo de investigaciones médicas y biológicas y podrían eventualmente sustituir completamente a las placas fotográficas en la radio-biología aplicada. La velocidad creciente con la que permiten registrar las imágenes en radio medicina conducen a una menor tiempo de exposición y a menores dosis de radiación indeseada recibida por los pacientes.

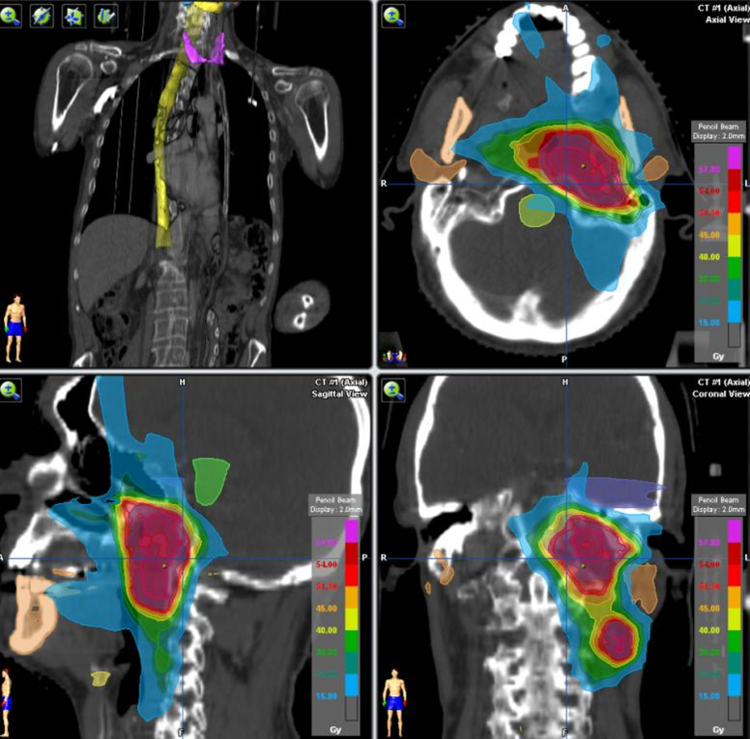

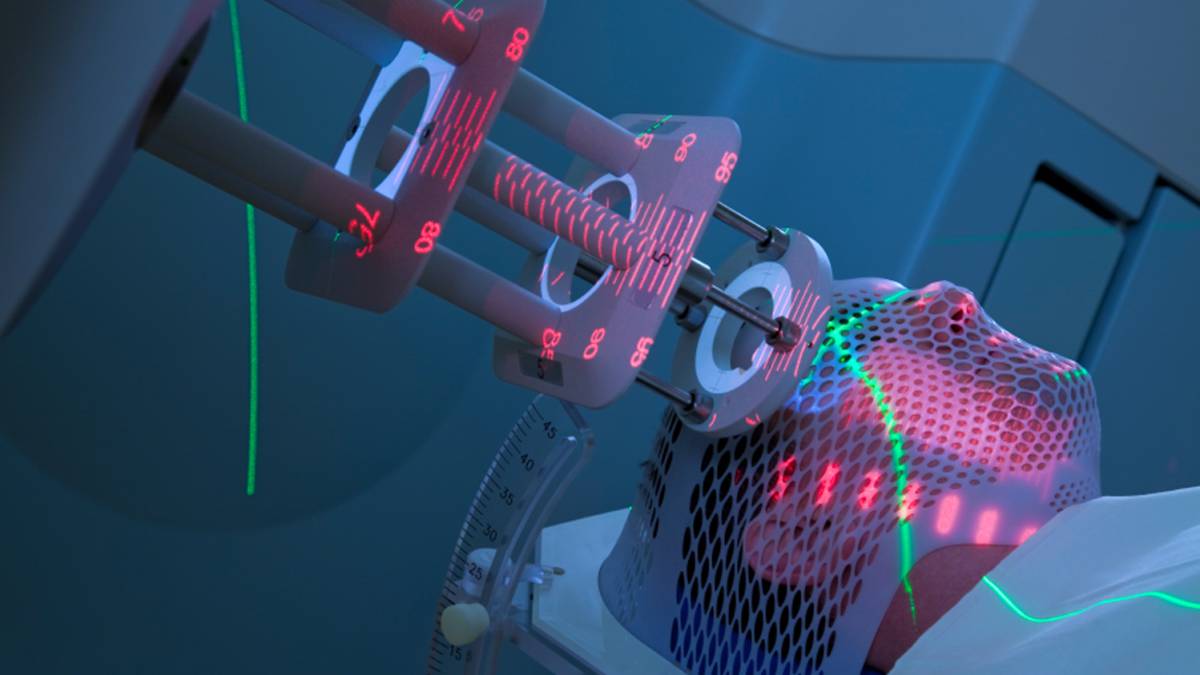

Hadrón-terapia, o las partículas contra el cáncer

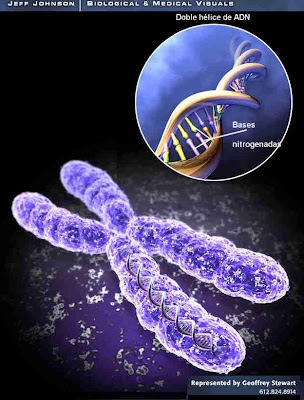

Como es bien sabido, una de las herramientas terapéuticas esenciales en el campo de la oncología es la radioterapia. Dicho tratamiento se aplica hoy en día aproximadamente a la mitad de los pacientes de cáncer. En cierto modo se puede considerar como una forma sutil de cirugía donde el bisturí es reemplazado por un haz colimado de partículas capaz de esterilizar las células malignas mediante la inactivación de su ADN, impidiendo así su reproducción. Tradicionalmente, la radioterapia se ha basado en el uso de rayos X (fotones), electrones y, más recientemente, hadrones, es decir, partículas capaces de interaccionar fuerte o nuclearmente, si bien no es ésta la propiedad más interesante de estas partículas para las aplicaciones radioterapeúticas. Los haces de rayos X y los electrones se obtienen normalmente a partir de aceleradores lineales como los del CERN, aunque mucho más pequeños, y se apuntan hacia los tumores con la energía, dirección y colimación apropiadas para optimizar su efecto destructivo sobre los mismos. Por su parte, los neutrones pierden energía en el interior del organismo de una forma diferente, lo cual les hace más indicados para el tratamiento de ciertos tipos especiales de tumores. Se obtienen a partir de las colisiones de protones, previamente acelerados en un ciclotrón, con núcleos de berilio. Este hecho hace que esta terapia sea bastante más cara que las anteriores, pero a cambio el ciclotrón puede ser usado también para la producción de radiofármacos.

Cintíficos del CERN aplican antimateria contra el Cáncer

El estudio de las posibilidades de utilización de haces de hadrones en la terapia del cáncer tuvo su origen en el trabajo seminal de R.R Wilson titulado Radiological Use of Fast Protons (Radiology 47, 1946). En dicho artículo se ponía de manifiesto que los protones, así como otras partículas cargadas pesadas, presentan la propiedad única de que al penetrar en el cuerpo humano depositan la mayor parte de su energía a una preofundidad que depende de su energía inicial. Este hecho permite seleccionar cuidadosamente el área que se quiere irradiar, preservando de dicha radiación al tejido sano que pudiera encontrarse a menor profundidad. Además, como las partículas se detienen a una distancia de la superficie bien definida por la energía del haz, tampoco resultarían dañadas las células situadas detrás del blanco seleccionado.

La técnica combinada PET/CT es uno de los desarrollos más excitantes de la medicina nuclear y la radiología modernas.

En contraste, la energía depositada por los rayos X alcanza su máximo cerca de la superficie de entrada y decae exponencialmente hasta que abandona el cuerpo humano en el lado opuesto, haciendo por tanto muy difícil seleccionar la zona que quiere irradiarse sin dañar otras áreas de células sanas. El trabajo de Wilson de 1946 condujo a toda una nueva línea de investigación experimental, principalmente en el Lawrence Berkeley Laboratory, que ha dado lugar al desarrollo de una nueva clase de terapias antitumorales basadas en la irradiación con protones y más recientemente con iones de carbono. Estas técnicas han sido aplicadas en más de 40 centros de todo el mundo, y de ellas se han beneficiado hasta la fecha más de 50.000 pacientes. No obstante, continúan investigándose nuevas formas de intentar mejorar el ratio entre la energía depositada en las células tumorales y en el tejido sano.

En la actualidad, el CERN se encuentra involucrado en diversos proyectos relacionados con la hadrón-terapia. Por ejemplo, en el diseño de un acelerador de protones e iones de carbono dedicado exclusivamente a usos médicos conocido como Protón Ion Medical Machine Study (PIMMS). Otro proyecto interesante es la realización de las pruebas del Linear Booster ( LIBO), capaz de acelerar una haz de protones hasta 200 Mev (los hospitales habitualmente utilizan energías en torno a los 65 MeV) y que estaría especializado en el tratamiento de tumores profundos.

Finalmente, y situándonos en un plano de investigación a un nivel más básico, es interesante señalar que en octubre de 2006 se presentaron los primeros resultados de un experimento llevado a cabo en el CERN con potencial para futuras aplicaciones en la terapia del cáncer. Se trataba del Antiproton Cell Experiment (ACE), que constituye la primera investigación realizada hasta la fecha sobre efectos biológicos de los antiprotones. Los antiprotones se comportan como los protones cuando entran en el organismo, pero generan mucha más energía en el blanco seleccionado debido a du aniquilación con los protones existentes en los núcleos de los átomos de las células, y además depositan esta energía de una forma biológicamente más efectiva.

Se busca antimateria contra el Cáncer. Los resultados muestran que los antiprotones son cuatro veces más efectivos que los protones para destruir células vivas. (Foto: Especial CERN )

Evaluando la fracción de células supervivientes después de la irradiación con el haz de antiprotones, el experimento ACE ha encontrado que a eficiencia de éstos es unas cuatro veces mayor que la de los protones, mientras que el daño producido a las células situadas antes del blanco era básicamente el mismo. De acuerdo con Michael Holzscheiter, portavoz del experimento ACE, este hecho podría ser extremadamente importante para el tratamiento de casos de cáncer recurrente, donde este tipo de propiedad es vital. La tecnología desarrollada previamente en el CERN para la obtención de haces de antiprotones de buena calidad a la energía apropiada es esencial para este prometedor experimento, que difícilmente podría haberse realizado en ningún otro laboratorio. Éste es por tanto un magnífico ejemplo de cómo la investigación en física de partículas desarrollada en el CERN puede generar soluciones innovadores con excelentes beneficios médicos potenciales.

Los investigadores de ACE, en colaboración con otras instituciones de todo el mundo, están realizando en la actualidad nuevos tests para comprobar la eficacia de este método en el caso de tumores situados a mayor profundidad, y comparando sus resultados con los de otros métodos más convencionales como la irradiación mediante iones de carbono. Si todo sale como se espera, los beneficios clínicos de esta nueva técnica podrían empezar a producirse dentro de la próxima década.

Otro ejemplo importante de tecnología creada en el CERN con aplicaciones a la terapia del cáncer es el Neutron Driven Element Trasmuter. Se trata de un sistema de producción de radioisótopos específicos específicos a partir de un acelerador de protones cuyo desarrollo fue liderado por Carlo Rubbia, Premio Nobel de Física en 1984 por el descubrimiento de los bosones W y Z y ex director general del CERN. La idea es utilizar el haz de protones para producir neutrones los cuales provocan reacciones en un ambiente apropiado donde ciertos elementos son convertidos en los isótopos deseados.

La diferencia principal entre este método, seguro y barato, y el método más tradicional de utilizar los neutrones provenientes de un reactor nuclear, es que no requiere el uso de material fisionable ni funciona críticamente, es decir las reacciones se detienen en el momento en el que el acelerador es apagado. Más aún, el método tiene la ventaja de que sólo se producen los isótopos requeridos, lo que redunda en una importante reducción de impacto ambiental. Normalmente, el blanco utilizado es plomo, elemento idóneo por presentar el menor ritmo de captura de neutrones. Los neutrones se producen por espalación a partir del haz de protones y permanecen en el interior del blanco de plomo, que está rodeado de un deflector de grafito, hasta que su espectro se suaviza suficientemente para cubrir un gran rango de energías que permiten su utilización para la transmutación de los elementos necesarios para la obtención de los isótopos deseados.

Estos aceleradores se suelen utilizar en la producción de isótopos para usos médicos, tratamientos especiales y funciones relacionadas con el campo de la Bioquímica. Incluso se utiliza en ocasiones en el campo de los alimentos.

El Neutron Driven Element Trasmuter ha permitido, entre otras cosas, la producción de radioisótopos beta emisores como el 166Ho, 186 Re o el 188Re que son de gran importancia en braquiterapia. Dicha técnica, muy utilizada en el tratamiento de cánceres ginecológicos y en el de cáncer de próstata, es un tipo de radioterapia de proximidad donde la fuente radiactiva se sitúa dentro o muy cerca de los tejidos que requieren irradiación. Típicamente, la fuente radiactiva, de alta actividad y corta vida media, se encapsula en una semilla, filamento o tubo y se implanta en quirófano en la zona deseada. Las diferentes dosis requeridas en cada caso hacen que sea fundamental disponer del mayor muestrario posible de radioisótopos con la actividad y vida media apropiadas, lo cual convierte al Neutron Driven Element Trasmuter en una herramienta valiosísima para el futuro de este tipo de técnica terapéutica.

Información y computación sin fronteras

CERN, … where the web was born; éste es uno de los reclamos publicitarios que suelen utilizarse para hacer ver al público la importancia de los retornos tecnológicos que en este laboratorio tienen lugar. Y en efecto, fue a finales de los ochenta cuando Tim Berners-Lee desarrolló estándar de Hyper Text Transfer Protocol (HTTP) e implementó los primeros servidores web en el CERN. Su esfuerzo permitió la comunicación fácil y segura y el intercambio de todo tipo de información entre todos los ordenadores del mundo conectados a internet, dando lugar de esta forma a una de las revoluciones tecnológicas más importantes de las últimas décadas. Las repercusiones científicas, tecnológicas, culturales, comerciales y de ocio de la web son ya tan conocidas que apenas merecen comentario alguno.

El término Grid fue acuñado por Ian Foster and Carl Kesselman en su libro The Grid, Blueprint for new Computing Infraestructure (Morgan Kaufman, 1998), aunque las ideas básicas habían sido consideradas con anterioridad. No existe un acuerdo general sobre cual debería ser la definición precisa de las tecnologías Grid, pero hay un amplio consenso en que esta debería contener elementos tales como recursos compartidos, virtualización, abstracción del acceso a los recursos y estandarización. La filosofía Grid consistiría, no sólo en compartir información entre diferentes usuarios, sino también recursos, como por ejemplo, procesadores, tiempo de CPU, unidades de almacenamiento, así como otros aparatos e instrumentos, de tal forma que eventualmente cada usuario tendría acceso virtual, por ejemplo, a la capacidad de cálculo de todos los demás usuarios de esa Grid. En los primeros tiempos de esta tecnología de la información se llegó a hablar de la Grid, refiriéndose a la posibilidad de existencia de una única World Wide Grid.

Todo surgió del CERN

Hasta el momento, sin embargo, este concepto no es una realidad y más bien lo que se encuentra es que diferentes grupos de proyectos crean su propia Grid usando sus propias implementaciones, estándares y protocolos y dando acceso restringido solamente a una cierta comunidad de usuarios autorizados. Así, aunque se siguen realizando importantes esfuerzos en cuanto a la estandarización de los protocolos, no está claro cual será el camino que este tipo de tecnología seguirá en el futuro en lo que se refiere a la futura existencia de un única Grid.

En cualquier caso es importante resaltar que una vez más el CERN ha sido pionero en este tipo de tecnología. Los detectores que se están instalando (a estas alturas, todos instalados y en marcha) en el LHC (ATLAS, CMS, ALICE, LHCb, SUSY, etc.), son tan complejos, que han requerido cada uno de ellos el concurso de muchas instituciones de todo el mundo para su construcción, y lo seguirán requiriendo para su mantenimiento cuando el acelerador empiece a funcionar (ya está en marcha), y, como no, para el análisis de los datos que se obtengan. Para hacerse una idea de la dimensión y complejidad de estos análisis baste mencionar que el compact Muon Selenoid (CMS), una vez pasado su primer filtro, deberá almacenar información sobre el resultado de las colisiones producidas en su interior a un ritmo del orden de 100 a 200 MB por segundo durante un tiempo esperado de unos cien días por año. Resulta obvio que sólo una tecnología tipo Grid puede afrontar con posibilidades de éxito un reto semejante y de hecho el CERN ha inspirado varios proyectos Grid multinacionales por este motivo. Posiblemente, el más grande de ellos hasta la fecha sea el EGEE (Enablinbg Grids for E-Science), que conecta más de 150 paises y ofrece 20 000 CPUs y más de 10 Petabytes de memoria.

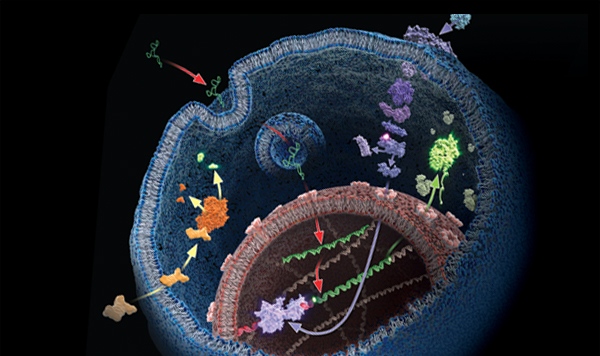

mucho es lo que hemos podido avanzar en el mundo de la biología molecular gracias a las nuevas técnicas

De manera análoga a como ocurrió con las tecnologías de la detección y aceleración, las tecnologías Grid tendrán, y de hecho ya empiezan a tener, un fuerte impacto en las ciencias de la vida y de la salud. En este sentido, uno de los campos obvios de aplicación es la bioinformática. Gracias a los espectaculares avances llevados a cabo en los últimos años en el campo de la biología molecular, se dispone hoy en día de cantidades crecientes de información genética de diferentes especies e individuos. Dicha información codificada en el ADN en forma de secuencia de tripletes o codones de ácidos nucleicos, que constituyen los genes que contienen la estructura primaria de las diferentes proteínas, ha sido y está siendo obtenida por centenares de grupos diferentes distribuidos por todo el mundo y debe almacenarse en gigantescas bases de datos de forma eficiente para su compartición, contrastación y análisis.

La biología celular se centra en la comprensión del funcionamiento de los sistemas celulares, de cómo estas células se regulan y la comprensión del funcionamiento de sus estructuras. Una disciplina afín es la biología molecular.

Ejemplos típicos serían la búsqueda de determinadas secuencias, comparaciones, búsqueda de determinadas mutaciones o alelos, etc. Resulta evidente que esta ingente labor puede verse enormemente beneficiada por el uso de tecnologías Grid. De hecho, la Bioinformática, y en particular sus aplicaciones biomédicas, han sido una parte importante del proyecto EGEE desde el comienzo del mismo.

Finalmente, y como última muestra de cómo puede revertir en la sociedad las tecnologías de la información y la computación provenientes de la física de partículas, es interesante mencionar el Proyecto Mammogrid y su continuación Mammogrid Plus. Liderado por el CERN, dicho proyecto de la UE utiliza la tecnología Grid para crear una base de datos de mamografías que pueda ser usada para investigar un gran conjunto de datos e imágenes que, aparte de otras aplicaciones sanitarias, sea útil para estudiar el potencial de esta tecnología para servir de soporte a la colaboración entre los profesionales de la salud de la UE.

Ciencia, y Tecnología al servicio de la salud

A estas alturas debería haber quedado claro que los centros científicos de élite internacionales como el CERN, no sólo nos proporcionan un conocimiento más profundo de la naturaleza, sino que las tecnologías de punta que en ellos se desarrollan acaban permeando a la Sociedad y se incorporan a nuestras vidas cotidianas. El autor del artículo, Antonio Dobado, del Departamento de Física Teórica I de la Universidad Complutense de Madrid, ha pretendido ilustrar el hecho innegable de la conexión existente entre temas tan aparentemente dispares como el de la Física de Partículas y la Biomedicina, pero ejemplos semejantes podrían haberse encontrado en prácticamente cualquier área de la actividad humana.

Gracias a la Física, la medicina ha dado un paso de gigante

La Sociedad no puede permanecer por más tiempo ajena a la Ciencia y a todo lo que trae consigo. Precisamente por eso la RSEF dedica un gran esfuerzo a la difícil tarea de convencer al público de la importancia de la Física como valor científico, cultural y social, como una forma rigurosa y profunda del acercamiento al conocimiento de la naturaleza, y a la vez como generadora de nuevas tecnologías. En este sentido, es una espléndida noticia la inminente creación de un nuevo Grupo especializado en el seno de la RSEF denominado Física Médica. Y, desde aquí, aprovechamos la oportunidad para darles la bienvenida y desearles el mayor éxito en sus futuras andaduras en la búsqueda de la verdad científica.

Fuente: Revista Española de FÍSICA.

Publicada por la RSEF con el Nº 3 Volumen 21 de 2007

La presente transcripción es de: Emilio Silvera

Miembro numerario de la RSEF y adscrito a los Grupos Especializados de Física Teórica y Astrofísica.

Dic

7

Nuevos mundos ¿Nuevas formas de Vida?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Una cosa está muy clara para mí. Sólo en nuestra Galaxia, la Vía Láctea, existen unos 30.000 millones de estrellas como nuestro Sol, es decir, de la clase G2V, medianas amarillas. La mayor parte tienen sus propios sistemas planetarios, y, es lógico pensar que en alguno de esos mundos se habrán dado las condiciones esenciales para el surgir de la Vida.

Si eso es así (que lo es)… ¿Cuántos mundos habitables no habrá en el Universo con cien mil millones de galaxias.

Está claro que la vida, será y tendrá las formas en función de las características de cada planeta (aquí mismo en nuestro mundo tenemos una buena muestra), las formas de vida serán según la Gravedad de aquel mundo y de otros parámetros diferentes a los de la Tierra.

Claro que, todo esto no implica que dichas formas de vida no estén, como aquí en la Tierra, basadas en el Carbono.

Dic

7

Caos y complejidad, normalidad y sencillez: Las partes de un todo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Todos hemos oído hablar, con más o menos frecuencia, de “Sistemas Complejos”, aquí mismo en estas páginas, la palabra sale a relucir con cierta frecuencia y, no me extraña que “la palabreja” cree una barrera, dado que, que para muchas personas, “complejo” significa “complicado” y suponen automáticamente que, si un sistema es complicado, será difícil de comprender. La naturaleza posee una fuerte tendencia a estructurarse en forma de entes discretos excitables que interactúan y que se organizan en niveles jerárquicos de creciente complejidad, por ello, los sistemas complejos no son de ninguna manera casos raros ni curiosidades sino que dominan la estructura y función del universo.

En el núcleo del átomo encontramos un ejemplo del sistema complej0: Los Nucleones (protones y neutrones), están formados por tripletes de Quarks confinados en las entrañas de estos dos hadrones de la rama bariónica, El núcleo es 1/100.000 del átomo, y, sin embargo, tiene el 99,9% de su masa. Dentro de ese pequeño núcleo está funcionando lo que conocemos como la Fuerza Nuclear Fuerte que mantiene confinados a los Quarks dentro de los nucleones, y, esa fuerza, está mediada por otras infinitesimales partículas de la rama de los Bosones que se llaman Gluones. La fuerza funciona al contrario de las otras tres fuerzas fundamentales, cuanto más lejos más fuertemente funciona.

El átomo considerado de manera conjunta es un sistema complejo. Sin embargo, si desmenuzamos todas sus partes y separamos todos los elementos que están presentes y actúan en el núcleo… ¡Se puede comprender mucho mejor!

La complejidad de un reactor nuclear se hace sencilla cuando lo estudiamos pieza a pieza

Claro que, no siempre ese temor a lo difícil y complicado, está justificado y, tal suposición no es, necesariamente correcta. En realidad, un sistema complejo es tan solo un sistema que está formado por varios componentes más sencillos que ejercen entre sí una interacción mutua que, naturalmente, tiene sus consecuencias. Si miramos la imagen de arriba, vemos una inmensa y hermosa Nebulosa que está formada por una serie de “cosas” sencillas como lo son el gas hidrógeno y el polvo interestelar entre otros y, en presencia de energías, la gravedad y otros parámetros, ahí ocurren cosas tales como, el nacimiento de estrellas y la aparición de mundos…entre otras.

Los grandes triunfos de la Ciencia se han logrado, en gran medida, descomponiendo los sistemas complejos en sus componentes simples, es decir, estudiar por partes lo que allí está presente (en caso necesario, como primera aproximación, dando el paso suplementario de pretender que todos los componentes son más sencillos de lo que son en realidad) para llegar a comprender el todo.

En el ejemplo clásico del éxito que ha logrado este planteamiento para conocer el mundo que nos rodea, buena parte de la química puede entenderse mediante un modelo en el que los componentes simples son átomos, y para eso importa poco de qué están formados los núcleos. Ascendiendo un nivel, las leyes que describen el comportamiento del dióxido de Carbono encerrado en una caja pueden entenderse pensando en unas moléculas más o menos esféricas que rebotan unas contra otras y contra las paredes de su contenedor, y poco importa que cada una de estas moléculas esté formada por un átomo de Carbono y dos de Oxígeno unidos entre sí. Ambos sistemas son complejos, en sentido científico, pero fáciles de entender

No siempre sabemos ver el mundo que nos rodea. El que miremos no significa que estemos viendo lo que realmente hay delante de nuestros ojos y, muchas veces, no son los ojos los únicos que pueden “ver” lo que hay más allá de lo que la vista puede alcanzar. Anoche, hasta una hora avanzada, estuve releyendo el Libro “Así de Simple” de John Gribbin, y, pareciéndome interesante os saqué un pequeño resumen del comienzo. Aquí os lo dejo.

El mundo que nos rodea parece ser un lugar complicado. Aunque hay algunas verdades sencillas que parecen eternas (las manzanas caen siempre hacia el suelo y no hacia el cielo; el Sol se levanta por el este, nunca por el oeste), nuestras vidas, a pesar de las modernas tecnologías, están todavía, con demasiada frecuencia, a merced de los complicados procesos que producen cambios drásticos y repentinos. La predicción del tiempo atmosférico tiene todavía más de arte adivinatorio que de ciencia; los terremotos y las erupciones volcánicas se producen de manera impredecible y aparentemente aleatorias; las fluctuaciones de la economía siguen ocasionando la bancarrota de muchos y la fortuna de unos pocos.

Sobre la posición de la salida del Sol

Desde la época de Galileo (más o menos, a comienzos del siglo XVII) la ciencia ha hecho progresos –enormes-, ignorando en gran medida estas complejidades y centrándose en cuestiones sencillas, intentando explicar por qué las manzanas caen al suelo y por qué el Sol se levanta por el Este. Los avances fueron de hecho tan espectaculares que hacia mediados del siglo XX ya se había dado respuesta a todas las cuestiones sencillas. Conceptos tales como la Teoría General de la Relatividad y la Mecánica Cuántica…

explicaron el funcionamiento global del Universo a escalas muy grandes y muy pequeñas respectivamente, mientras el descubrimiento de la estructura del ADN y el modo en que éste se copia de una generación a otra hizo que la propia vida, así como la evolución, parecieran sencillas a nivel molecular. Sin embargo, persistió la complejidad del mundo a nivel humano –al nivel de la vida-. La cuestión más interesante de todas, la que planteaba cómo la vida pudo haber surgido a partir de la materia inerte, siguió sin respuesta.

Un descubrimiento así no podía dejar al mundo indiferente. En unos años el mundo científico se puso al día y la revolución genética cambió los paradigmas establecidos. Mucha gente aún no está preparada para aceptar el comienzo de una era poderosa en la que el ser humano tiene un control de sí mismo mayor al habitual. Había nacido la Ingeniería genética.

No debe extrañarnos que sea precisamente a escala humana donde se den las características más complejas del universo. Las que se resisten más a rendirse ante los métodos tradicionales de la investigación científica. Realmente, es posible que seamos lo más complejo que existe en el universo. La razón es que, a escalas más reducidas, entidades tales como los átomos se comportan individualmente de un modo relativamente sencillo en sus interacciones mutuas, y que las cosas complicadas e interesantes surgen, cuando se unen muchos átomos de maneras complicadas e interesantes, para formar organismos tales como los seres humanos.

Pero este proceso no puede continuar indefinidamente, ya que, si se unen cada vez más átomos, su masa total aumenta hasta tal punto que la Gravedad aplasta toda la estructura importante y la aniquila. Un átomo, o incluso una molécula tan simple como la del agua, es algo más sencillo que un ser humano, porque tiene poca estructura interna; una estrella, o el interior de un planeta, es también algo más sencillo que un ser humano porque la gravedad aplasta cualquier estructura hasta aniquilarla. Esta es la razón por la cual la ciencia puede decirnos más sobre el comportamiento de los átomos y el funcionamiento interno de las estrellas o los planetas que sobre el modo en que las personas nos comportamos.

Sí, hemos podido llegar a conocer lo que ocurre en el Sol, y sabemos de sus procesos interiores y exteriores, de las ráfagas de partículas que en sus épocas activas, nos envía continuamente hacía la superficie del planeta y, que no sólo provoca esas bonitas Auroras, sino que, su intensa radiación y magnetismo incide en todos los artilugios que tenemos para leer los datos de… ¡tantas cosas!

Cuando los problemas sencillos se rindieron ante el empuje de la investigación, fue algo natural que los científicos abordaran rompecabezas más complicados que iban asociados con sistemas complejos, para que por fin fuera posible comenzar a comprender el funcionamiento del mundo a una escala más humana compleja y, para ello, hubo que esperar hasta la década de 1960, que fue cuando aparecieron los poderosos y rápidos (para lo que se estilaba en aquella época) ordenadores electrónicos. Estos nuevos inventos empezaron a ser conocidos por un público más amplio entre mediados y finales de la década de 1980, primero con la publicación del libro, ahora convertido en un clásico:

Order out of Chaos, de Ilya Prigogine e Isabelle Stergers, y luego, con Chaos, de James Gleick.

Las personas sencillas que, aunque tengan una educación aceptable, no están inmersas en el ámbito de la ciencia, cuando oyen hablar de Complejidad y Caos en esas áreas, sienten, de primeras, una especie de rechazo por aquello que (ellos creen) no van a comprender. Sin embargo, la cuestión no es tan difícil como a primera vista pudiera parecer, todo consiste en tener la posibilidad de que alguien, de manera “sencilla” (dentro de lo posible), nos explique las cosas dejando a un lado las matemáticas que, aunque describen de manera más amplia y pura aquellos conceptos que tratamos, también es verdad que, no siempre, están al alcance de todos. Un conocimiento básico de las cosas más complicadas, es posible. También la relatividad general y la mecánica cuántica, se consideraron, cuando eran nuevas, como unas ideas demasiado difíciles para que cualquiera las entendiera, salvo los expertos –pero ambas se basan en conceptos sencillos que son inteligibles para cualquier persona lega en la materia, siempre que esté dispuesta a aceptar su parte matemática con los ojos cerrados-. E la misma manera, el Caos y la Complejidad, también pueden ser entendidos y, si tenemos la suerte de tener un buen interlocutor que nos sepa explicar, aquellos conceptos básicos sobre los que se asientan tanto el Caos como la Complejidad, veremos maravillados como, de manera natural, la luz se hace en nosotros y podemos entender lo que antes nos parecía inalcanzable.

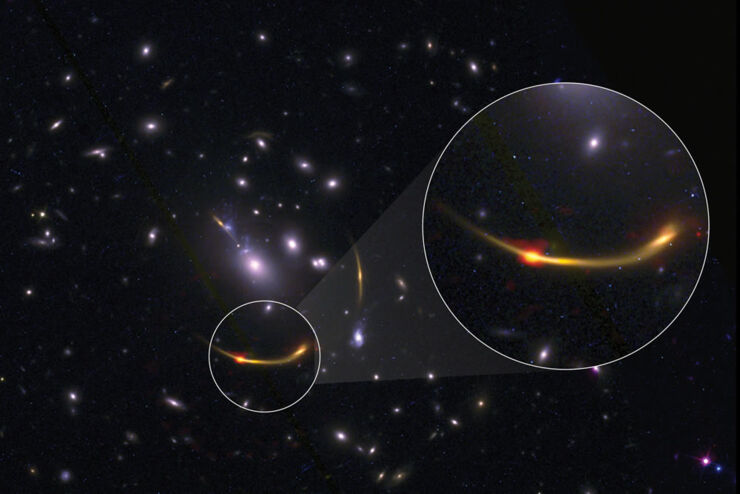

Imagen compuesta del cúmulo de galaxias MACSJ 0138 con datos del Atacama Large Millimeter/submillimeter Array (ALMA) y del telescopio espacial Hubble de la NASA. La sección ampliada muestra un punto rojo anaranjado brillante que representa el polvo frío observado en frecuencias de radio usando ALMA. El polvo frío ayuda a los científicos a calcular indirectamente la cantidad de gas de hidrógeno (necesario par la formación de estrellas) presente en las galaxias del cúmulo. Créditos: ALMA (ESO/NAOJ/NRAO)/S. Dagnello (NRAO),

STScI, K. Whitaker et al

El Universo es un “Ente Vivo” que maneja complejos sistemas para conformar maravillas

Se cree que las galaxias se han formado por la acumulación gravitacional de gas, algún tiempo después de la época de la recombinación. Las nubes de gas podrían haber comenzado a formar estrellas, quizás como resultado de las colisiones mutuas. El tipo de galaxia generado podría depender del ritmo al que el gas era transformado en estrellas, formándose las elípticas cuando el gas se convertía rápidamente en estrellas, y las espirales si la transformación de estrellas era lo suficientemente lenta como para permitir crecer de forma significativa un disco de gas.

Nubes moleculares en Orión que son los materiales primigenios para complejidades futuras

Las galaxias evolucionan al convertir progresivamente su gas remanente en estrellas, si bien no existe probablemente una evolución entre las diferentes tipos de la clasificación del conocido sistema de Hubble. No obstante, algunas galaxias elípticas pudieron haberse creado por la colisión y posterior fusión de dos galaxias espirales.

NGC 5426 y NGC 5427 son dos galaxias espirales de tamaños similares involucradas en una danza espectacular. No es seguro que esta interacción culmine en una colisión y a la larga en la fusión de las dos galaxias, aunque éstas ya han sido ya afectadas. Conocidas ambas con el nombre de Arp 271, su danza perdurará por decenas de millones de años, creando nuevas estrellas como resultado de la mutua atracción gravitacional entre las galaxias, un tirón observable en el borde de las estrellas que ya conectan a ambas. Ubicada a 90 millones de años-luz de distancia hacia la constelación de Virgo (la Virgen), el par Arp 271 tiene unos 130.000 años-luz de extensión. Fue descubierta originalmente en 1785 por William Herschel. Muy posiblemente nuestra Vía Láctea sufrirá una colisión similar en unos cinco mil millones de años más con la galaxia vecina Andrómeda, que ahora está ubicada a cerca de 2,6 millones de años-luz de la Vía Láctea.

Fantastic Colorful Galaxy wallpaper. high resolution

Sí, mirando la imagen nos da la sensación de que está por llegar cierto Caos y Complejidad a las regiones del Universo en la que se sitúan las grandes Nebulosas.

Tenemos que entender que, algunos sistemas (“sistema” no es más que una palabra de la jerga científica para asignar cualquier cosa, como un péndulo que oscila, o el sistema solar, o el agua que gotea de un grifo) son muy sensibles a sus condiciones de partida, de tal modo que una diferencia mínima en el “impulso” inicial que les damos ocasiona una gran diferencia en cómo van a acabar, y existe una retroalimentación, de manera que lo que un sistema hace afecta a su propio comportamiento. Así, a primera vista, parece que la guía es sencilla y, nos puede parecer mentira que así sea. Sin embargo, esa es la premisa que debemos tener en cuenta. Nos podríamos preguntar: ¿Es realmente verdad, que todo este asunto del Caos y de la Complejidad se basaba en dos ideas sencillas –la sensibilidad de un sistema a sus condiciones de partida, y la retroalimentación-¿ La respuesta es que sí.

La mayor parte de los objetos que pueden verse en el cielo nocturno son estrellas, unos pocos centenares son visibles a simple vista. Una estrella es una bola caliente principalmente compuesta por hidrógeno gaseoso. El Sol es un ejemplo de una estrella típica y común. La gravedad impide que el gas se evapore en el espacio y la presión, debida a la alta temperatura de la estrella, y la densidad impiden que la bola encoja. En el corazón de la estrella, la temperatura y la densidad son lo suficientemente altas para sustentar a las reacciones de fusión nuclear, y la energía, producida por estas reacciones, hace su camino a la superficie y la irradia al espacio en forma de calor y luz. Cuando se agota el combustible de las reacciones de fusión, la estructura de la estrella cambia. El proceso de producir elementos, cada vez más pesados, a partir de los más livianos y de ajustar la estructura interna para balancear gravedad y presión, es llamado evolución estelar.

La mayor parte de los objetos que pueden verse en el cielo nocturno son estrellas, unos pocos centenares son visibles a simple vista. Una estrella es una bola caliente principalmente compuesta por hidrógeno gaseoso. El Sol es un ejemplo de una estrella típica y común. La gravedad impide que el gas se evapore en el espacio y la presión, debida a la alta temperatura de la estrella, y la densidad impiden que la bola encoja. En el corazón de la estrella, la temperatura y la densidad son lo suficientemente altas para sustentar a las reacciones de fusión nuclear, y la energía, producida por estas reacciones, hace su camino a la superficie y la irradia al espacio en forma de calor y luz. Cuando se agota el combustible de las reacciones de fusión, la estructura de la estrella cambia. El proceso de producir elementos, cada vez más pesados, a partir de los más livianos y de ajustar la estructura interna para balancear gravedad y presión, es llamado evolución estelar.

Observar una estrella a través del telescopio permite conocer muchas de sus importantes propiedades. El color de una estrella es un indicador de su temperatura y ésta, a su vez, depende de una combinación entre la masa de la estrella y su fase evolutiva. Usualmente, las observaciones también permiten encontrar la luminosidad de la estrella o la tasa con la cual ella irradia energía, en forma de calor y luz.

Todas las estrellas visibles a simple vista forman parte de nuestra galaxia, la Vía Láctea. La Vía Láctea es un sistema compuesto por unos cien mil millones de estrellas, junto con una considerable cantidad de material interestelar. La galaxia tiene forma de un disco chato sumergido en un halo débil y esférico. La gravedad impide que las estrellas se escapen y, sus movimientos, hacen que el sistema no colapse. La Vía Láctea no posee un límite definido, la distribución de las estrellas decrece gradualmente con distancias crecientes del centro. El SDSS detecta estrellas más de un millón de veces más débiles que las que podemos ver a simple vista, lo suficientemente lejos para ver la estructura de la Vía Láctea.

De algún modo, esto es como decir que “todo lo que hay” sobre la teoría especial de la relatividad es que la velocidad de la luz es la misma para todos los observadores. Sin embargo, la complejidad de la estructura que se levanta sobre este hecho sencillo resulta asombrosa y requiere algunos conocimientos matemáticos para poder apreciarla plenamente. Claro que, eso no quita para que, un buen comunicador le pueda transmitir a otras personas mediante explicaciones sencillas lo esencial de la relatividad especial y general y también, sobre la esencia de la mecánica cuántica, y, de la misma manera, podríamos hablar del Caos y de la Complejidad. Debemos ser conscientes de que, el Caos, puede surgir a partir del Orden y que, la Complejidad, siempre llega a través de la sencillez de un comienzo. Podemos estar al borde del Caos y, de manera milagrosa ver que también a partir de él surge la normalidad y lo nuevo que no en pocas ocasiones pueden ser nuevas formas de vida. De la misma manera, las transformaciones de los elementos sencillos, bajo ciertas condiciones, llegan a adquirir una complejidad inusitada que, de alguna manera, es necesaria para que en este mundo que nos rodea, existan seres que como nosotros, sean el ejemplo más real y de más alto nivel que está presente en el Universo. Y, de la misma manera que nosotros estamos aquí, en un minúsculo sistema solar habitando un pequeño planeta que reúne todas las condiciones necesarias para la vida, de la misma forma digo, estarán poblados otros muchos planetas de otros muchos sistemas solares repartidos por nuestra Galaxia y por las otras que, a cientos de miles pululan por el Universo, y, todos esos seres “racionales”, se preguntaran las mismas cosas que nosotros y estarán interesados en descubrir los mismos misterios, los mismos secretos de la Naturaleza que, presintiendo que existen, tienen la intuición de que serán las respuestas esperadas para solucionar muchos de los problemas e inseguridades que ahora, en nuestro tiempo, nos aquejan.

Claro que, la mente nunca descansa. Acordaos de Aristarco de Samos que, en el siglo III a. C., ya anunció que la Tierra orbitaba alrededor del Sol y, Copérnico, que se llevó el premio, no lo dijo hasta el año 1543. Esto nos viene a demostrar que, a pesar de la complejidad del mundo, lo realmente complejo está en nosotros, en nuestras mentes que, presienten lo que pueda ser, intuyen el por qué de las cosas, fabrican pensamientos que, mucho más rápidos que la luz, llegan a las galaxias lejanas y, con los ojos de la mente pueden, atisbar aquellas cosas de las que, en silencio, ha oído hablar a su intuición dentro de su mente siempre atenta a todo aquello que puede ser una novedad, una explicación, un descubrimiento.

Vista de la Tierra y el Sol de la órbita (la imagen de la tierra tomada de http://visibleearth.nasa.gov)

Ahora estamos centrados en el futuro aquí en la Tierra pero, sin dejar de la mano ese futuro que nos espera en el espacio exterior. Es pronto aún para que el hombre vaya a las estrellas pero, algún día, ese será su destino y, desde ya, debe ir preparándose para esa aventura que sólo está a la espera de tener los medios tecnológicos necesarios para hacerla posible. Mientras tanto, jugamos con las sondas espaciales que enviamos a planetas vecinos para que, nos vayan informando de lo que están hechos aquellos mundos –grandes y pequeños- que, en relativamente poco tiempo, serán visitados por nuestra especie para preparar el salto mayor.

emilio silvera

Totales: 75.372.805

Totales: 75.372.805 Conectados: 38

Conectados: 38