Sep

18

La Imperfecta perfección

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

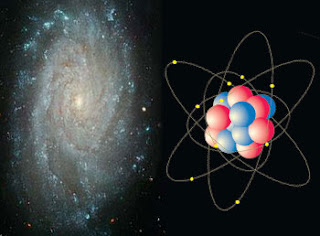

Todo lo que existe en nuestro Universo es el fruto de dos fuerzas antagónicas que se equilibran la una a la otra y produce la estabilidad que podemos observar en las galaxias y en las estrellas, en los átomos…

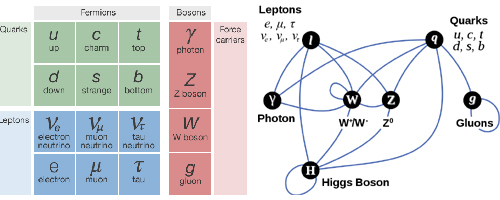

«A pesar de sus limitaciones, el modelo estándar es una herramienta básica para el avance de la física actual, como hace cien años lo fue el electromagnetismo. [Un] gran avance en nuestra comprensión del universo. Aunque no podamos hallar en él un candidato para la enigmática materia oscura, esta podrá ser identificada gracias a su interacción con detectores terrestres, y podrá ser interpretada gracias al modelo estándar».

Mario E. Gómez Santsamaría

Si consultamos nos dicen:

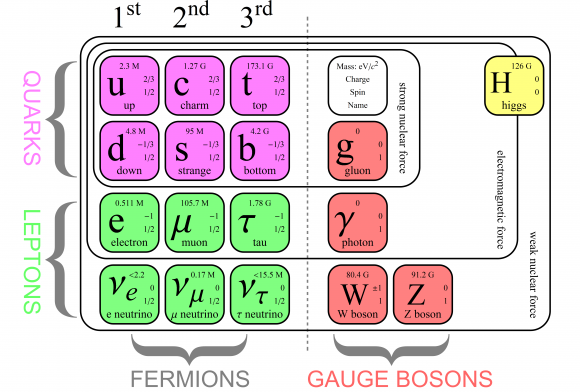

“El modelo estándar de la física de partículas es una teoría relativista de campos cuánticos desarrollada entre 1970 y 1973 [cita requerida] basada en las ideas de la unificación y simetrías1 que describe la estructura fundamental de la materia y el vacío considerando las partículas elementales como entes irreducibles cuya cinemática está regida por las cuatro interacciones fundamentales conocidas (exceptuando la gravedad, cuya principal teoría, la relatividad general, no encaja con los modelos matemáticos del mundo cuántico).”

Con el título que arriba podemos leer de “La perfección imperfecta”, me quiero referir al Modelo estándar de la física de partículas y de las interacciones fundamentales y, algunos, han llegado a creer que sólo faltan algunos detalles técnicos y, con ellos, la física teórica está acabada. Tenemos un modelo que engloba todo lo que desamos saber acerca de nuestro mundo físico. ¿Qué más podemos desear? Los pobres ilusos no caen en la cuenta de que el tal Modelo, al que no podemos negarle su valía como una herramienta muy valiosa para la física, no deja de estar incompleto y, además, ha sido construido con algunos parámetros aleatorios (unos veinte) que no tienen justificación. Uno de ellos era el Bosón de Higgs y, según nos han contado los del LHC, ha sido hallado. Sin embargo, esperamos que nos den muchas explicaciones que no han estado

de que el tal Modelo, al que no podemos negarle su valía como una herramienta muy valiosa para la física, no deja de estar incompleto y, además, ha sido construido con algunos parámetros aleatorios (unos veinte) que no tienen justificación. Uno de ellos era el Bosón de Higgs y, según nos han contado los del LHC, ha sido hallado. Sin embargo, esperamos que nos den muchas explicaciones que no han estado presente en todas las algaradas y fanfarrias que dicho “hallazgo” ha producido (por aquel entonces), incluidos el Príncipe de Asturias y el Nobel. ¡Veremos en que queda todo esto al final!

presente en todas las algaradas y fanfarrias que dicho “hallazgo” ha producido (por aquel entonces), incluidos el Príncipe de Asturias y el Nobel. ¡Veremos en que queda todo esto al final!

Bueno, lo que hasta el momento hemos logrado no está mal del todo pero, no llega, ni con mucho, a la perfección que la Naturaleza refleja y que, nosotros perseguimos sin llegar a poder agarrar sus múltiples entresijos y parámetros que conforman ese todo en el que, sin ninguna clase de excusas, todo debe encajar y, de momento, no es así. Muchos son los flecos sueltos, muchas las incognitas, múltiples los matices que no sabemos perfilar.

el momento hemos logrado no está mal del todo pero, no llega, ni con mucho, a la perfección que la Naturaleza refleja y que, nosotros perseguimos sin llegar a poder agarrar sus múltiples entresijos y parámetros que conforman ese todo en el que, sin ninguna clase de excusas, todo debe encajar y, de momento, no es así. Muchos son los flecos sueltos, muchas las incognitas, múltiples los matices que no sabemos perfilar.

Es cierto que, el Modelo estándar, en algunos momento, nos produce y nos da la sensación de que puede ser perfecto. Sin embargo, esa ilusoria perfección, no es permanente y en algunas casos efímera. En primer lugar, podríamos empezar a quejarnos de las casi veinte constantes que no se pueden calcular. Pero si esta fuese la única queja, habría poco que hacer. Desde luego, se han sugerido numerosas ideas para explicar el origen de estos números y se han propuesto varias teorías para “predecir” sus valores. El problema con todas estas teorías es que los argumentos que dan nunca llegan a ser convincentes.

luego, se han sugerido numerosas ideas para explicar el origen de estos números y se han propuesto varias teorías para “predecir” sus valores. El problema con todas estas teorías es que los argumentos que dan nunca llegan a ser convincentes.

Algunos tienen la esperanza de que se verá la Supersimetría en el LHC para saber, qué hay más allá del Modelo Estándar. ¿Serán las cuerdas vibrantes de la Teoría M?

“El Modelo Estándar agrupa, pero no unifica, las dos primeras teorías –el modelo electrodébil y la cromodinámica cuántica– lo que proporciona una teoría internamente consistente que describe las interacciones entre todas las partículas observadas experimentalmente.”

“Aceleración recíproca de dos líneas de universo geodésicas. Como vemos, conforme se avanza en la coordenada temporal, el tensor de Riemann curva las geodésicas y provoca el acercamiento recíproco de las dos partículas.

En relatividad general, la aceleración de marea viene originada por el tensor de Riemann. Hay una correspondencia casi natural entre las ecuaciones newtonianas y las relativistas. En efecto, la ecuación newtoniana utilizada para computar las fuerzas de marea es la siguiente:

donde a es la aceleración de marea,

el potencial gravitatorio y

la distancia entre las dos partículas. Las fuerzas de marea vienen determinadas por las derivadas de segundo orden del potencial gravitatorio.”

Si deseamos medir la contracción de volumen producida por la masa-energía presente en una determinada región, hemos de aplicar las ecuaciones de universo de Einstein:

Computemos ahora los valores de

:

Tras ello obtenemos:

Como vemos, la atracción gravitatoria viene determinada nosolo por la masa-energía sino también por la presión, aunque la contribución de ésta es

inferior a la de la primera. Por eso, en las regiones del espacio-tiempo sometidas a bajas presiones y temperaturas, como las nebulosas o nuestro Sistema Solar, la masa es prácticamente la única fuente de atracción gravitatoria y por ello las ecuaciones de la gravitación universal newtonianas constituyen una muy buena aproximación de la realidad física. En cambio, en fluidos sometidos a altas presiones, como las estrellas que se colapsan, la materia que se precipita en los agujeros negros o los chorros que son expelidos de los centros de las galaxias; en todos ellos la presión puede tener cierta importancia a la hora de computar la atracción gravitatoria y la curvatura del espacio-tiempo.”

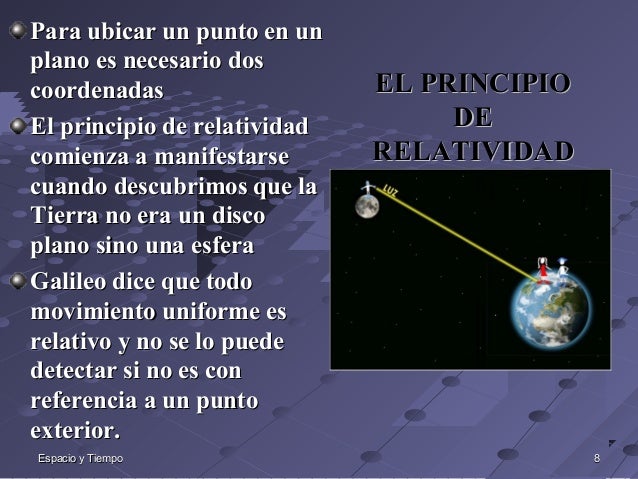

“Un principio de relatividad es un principio general sobre la forma que debe tomar una teoría física. Frecuentemente los principios de relatividad establecen equivalencias entre observadores, de acuerdo con principios de simetría o invariancia entre situaciones físicamente equivalentes. De acuerdo con estos principios una determinada descripción de un fenómeno podría ser incorrecta si no respeta el principio de relatividad básico que define la teoría (así la teoría de la gravitación de Newton era incompatible con el principio de relatividad que definía la teoría de la relatividad especial, razón que llevó a Einstein a formular una nueva teoría de la gravitación como parte de la relatividad general).”

¿Por qué se iba a preocupar la Naturaleza de una fórmula mágica si en ausencia de tal fórmula no hubiera contradicciones? Lo que realmente necesitamos es algún principio fundamental nuevo , tal como el principio de la relatividad, pero nos resistimos a abandonar todos los demás principios que ya conocemos; ¡esos, después de todo, han sido enormemente útiles en el descubrimiento del Modelo estándar! una herramienta que ha posibilitado a todos los físicos del mundo para

, tal como el principio de la relatividad, pero nos resistimos a abandonar todos los demás principios que ya conocemos; ¡esos, después de todo, han sido enormemente útiles en el descubrimiento del Modelo estándar! una herramienta que ha posibilitado a todos los físicos del mundo para poder construir sus trabajos en ese fascinante mundo de la mecánica cuántica, donde partículas infinitesimales interactúan con las fuerzas y podemos ver, como se comporta la materia en determinadas circunstancias. El mejor lugar para buscar nuevos principios es precisamente donde se encuentran los puntos débiles de la presente teoría.

poder construir sus trabajos en ese fascinante mundo de la mecánica cuántica, donde partículas infinitesimales interactúan con las fuerzas y podemos ver, como se comporta la materia en determinadas circunstancias. El mejor lugar para buscar nuevos principios es precisamente donde se encuentran los puntos débiles de la presente teoría.

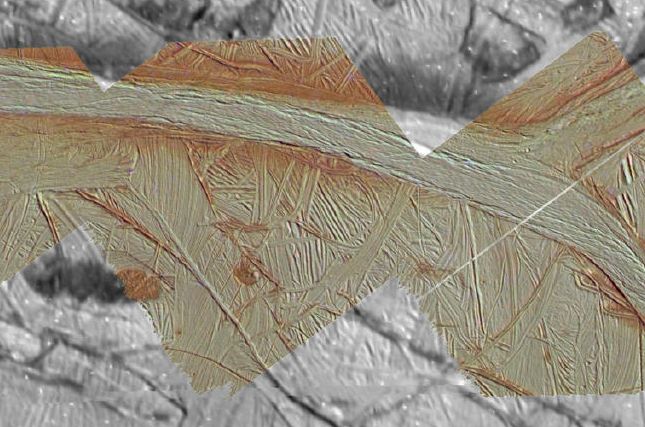

imagen nos decían:

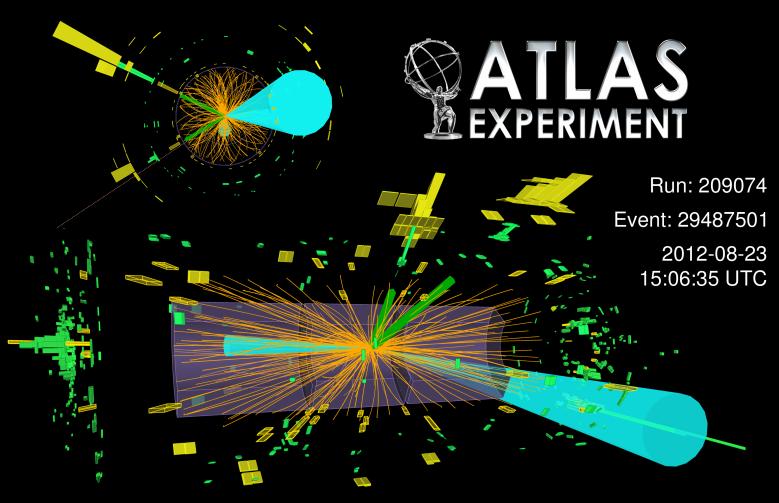

imagen nos decían:“Colisión del Bosón de Higgs desintegrándose en fermiones”. Primeras evidencias de un nuevomodo de desintegración del bosón de Higgs. Las primeras evidencias de la desintegración del recién descubierto bosón de Higgs en dos partículas denominadas tau, pertenecientes a la familia de partículas que compone la materia que vemos en el Universo. Hasta ahora

los experimentos del LHC habían detectado la partícula de Higgs mediante su desintegración en otro tipo

de partículas denominadas bosones, portadoras de las fuerzas que actúan en la Naturaleza, mientras las evidencias de desintegraciones en fermiones no eran concluyentes. Esta es la primera evidencia clara de este nuevo modo de desintegración del bosón de Higgs.”

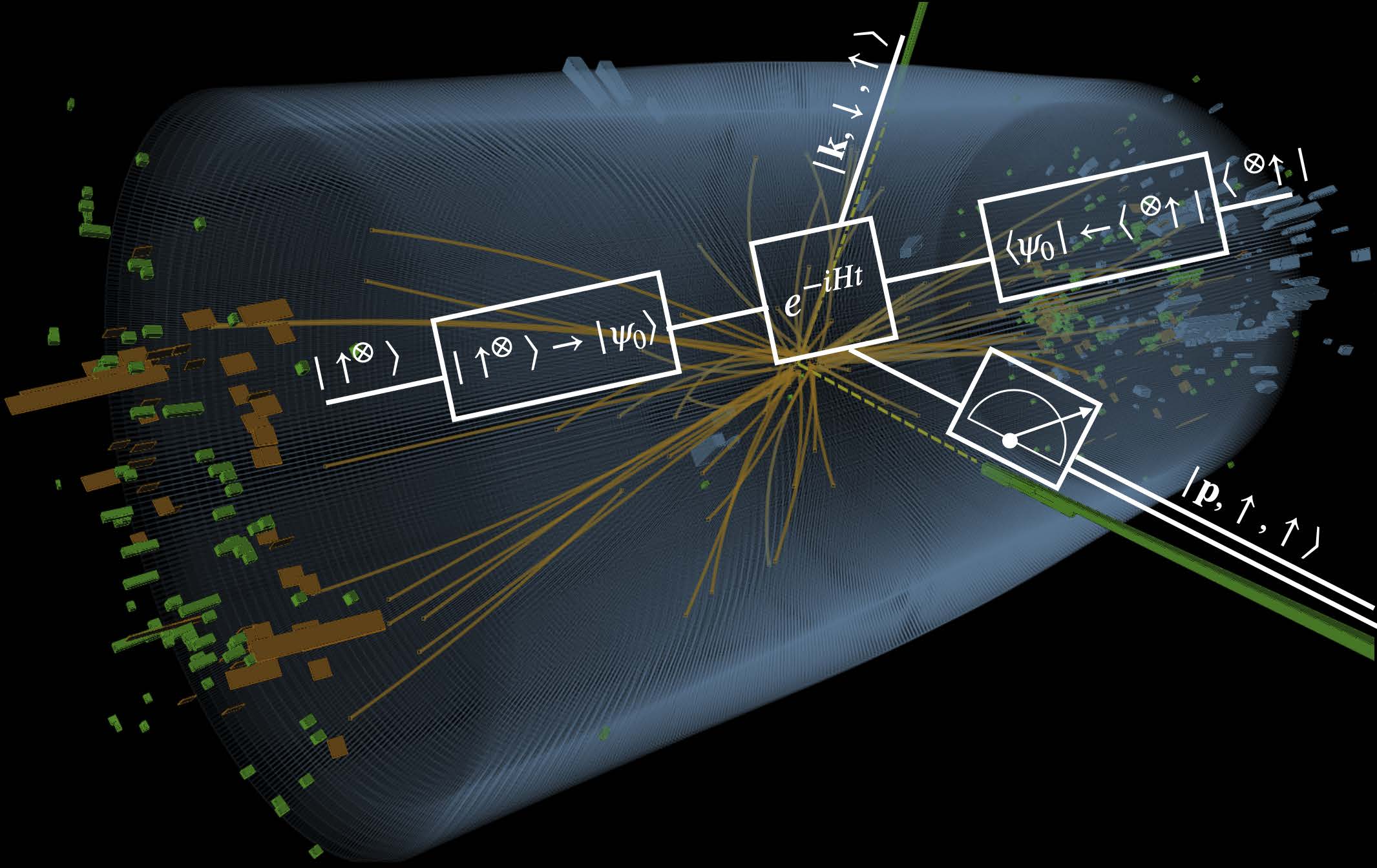

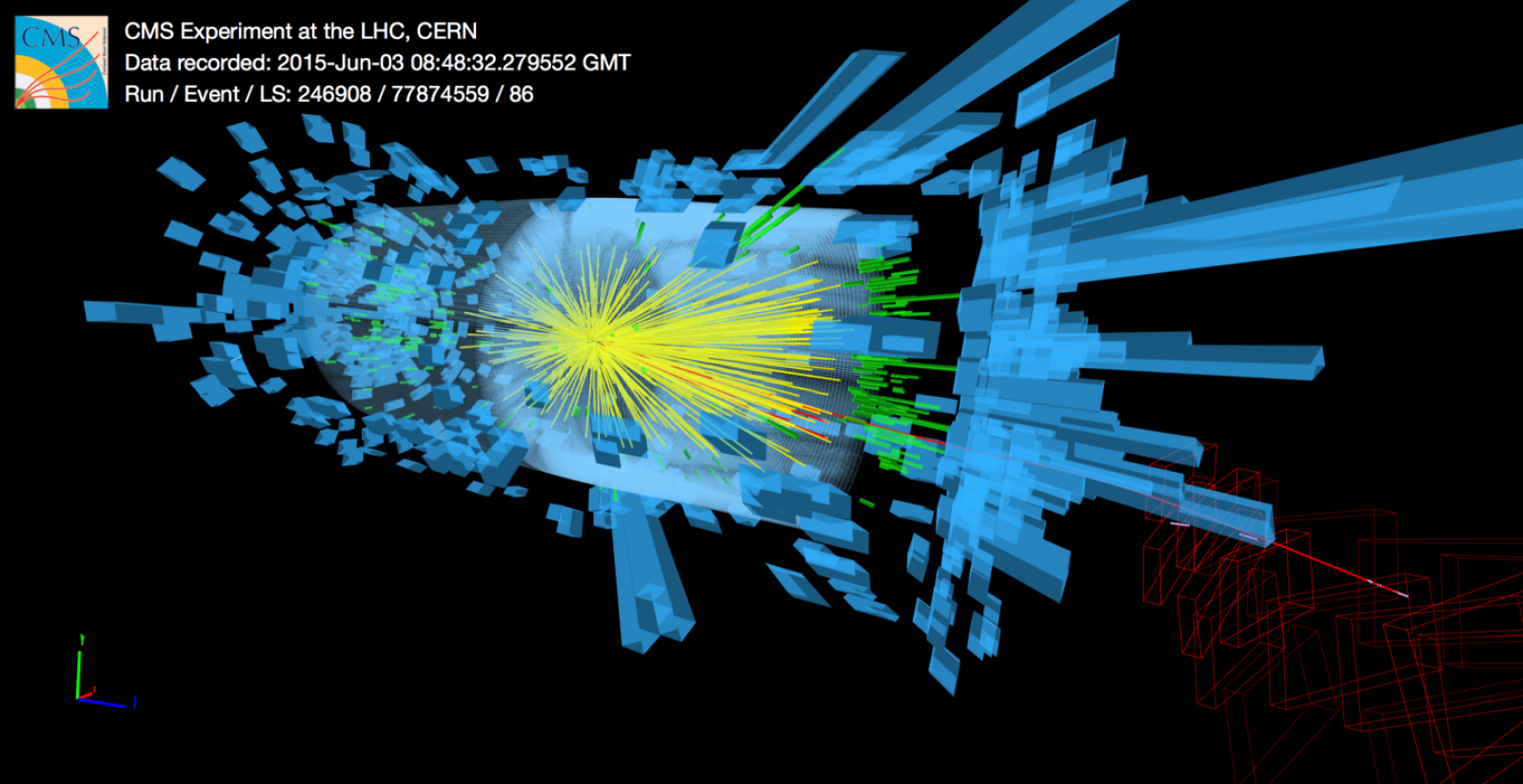

La regla universal en la física de partículas es que cuando las partículas chocan con energías cada vez mayores, los efectos de las colisiones están determinados por estructuras cada vez menores, más pequeñas en el espacio y en el tiempo. Supongamos por un momento que tenemos a nuestra disposición un Acelerador de Partículas 10.000 veces más potente que el LHC, donde las partículas pueden adquirir esas tantas veces más energías de las alcanzadas actualmente. Las colisiones que tendrían lugar nos dirían algo acerca de los detalles estructurales de esas partículas que ahora no conocemos, que serían mucho más pequeñas que las que ahora podemos contemplar. En este punto se me ocurre la pregunta: ¿Seguiría siendo correcto el Modelo estándar? 0, por el contrario, a medida que nos alejemos en las profundidades de lo muy pequeño, también sus normas podrían variar al mismo tiempo que varían las dimensiones de los productos hallados. Recordad que, el mundo no funciona de la misma manera en nuestro ámbito macroscópico que ante ese otro “universo” cuántico de lo infinitesimal.

¿Podéis imaginar conseguir colisiones a 70.000 TeV? ¿Qué podríamos ver? Y, entonces, seguramente, podríamos oír en los medios la algarada de las protestas de algunos grupos: “Ese monstruo creado por el hombre puede abrir en el espacio tiempo agujeros de gusano que se tragará el mundo y nos llevará hacia

abrir en el espacio tiempo agujeros de gusano que se tragará el mundo y nos llevará hacia otros universos” Comentarios así estarían a la orden del día. Los hay que siempre están dispuestos a protestar por todo y, desde

otros universos” Comentarios así estarían a la orden del día. Los hay que siempre están dispuestos a protestar por todo y, desde luego, no siempre llevan razón, toda vez que, la mayoría de las veces, ignoran de qué están hablando y juzgan si el conocimiento de causa necesario para ello. De todas las maneras, sí que debemos tener sumo cuidado con el manejo de fuerzas que… ¡no siempre entendemos! Cuando el LHC se vuelva a poner en marcha, se utilizarán energías que llegan hasta los 14 TeV, y, esas son palabras mayores.

luego, no siempre llevan razón, toda vez que, la mayoría de las veces, ignoran de qué están hablando y juzgan si el conocimiento de causa necesario para ello. De todas las maneras, sí que debemos tener sumo cuidado con el manejo de fuerzas que… ¡no siempre entendemos! Cuando el LHC se vuelva a poner en marcha, se utilizarán energías que llegan hasta los 14 TeV, y, esas son palabras mayores.

Hay que reconocer que imaginación se le ponemos a simples conjeturas

¿Justifica el querer detectar las partículas que conforman la “materia oscura”, o, verificar si al menos , podemos vislumbrar la sombra de las “cuerdas” vibrantes de esa Teoria del Todo, el que se gasten ingentes cantidades de dinero en esos artilugios descomunales? Bueno, a pesar de todos los pesares, la respuesta es que SÍ, el rendimiento y el beneficio que hemos podido recibir de los aceleradores de partículas, justifica de manera amplia todo el esfuerzo realizado, toda vez que, no solo

, podemos vislumbrar la sombra de las “cuerdas” vibrantes de esa Teoria del Todo, el que se gasten ingentes cantidades de dinero en esos artilugios descomunales? Bueno, a pesar de todos los pesares, la respuesta es que SÍ, el rendimiento y el beneficio que hemos podido recibir de los aceleradores de partículas, justifica de manera amplia todo el esfuerzo realizado, toda vez que, no solo nos ha llevado a conocer muchos secretos que la Naturaleza celosamente guardaba, sino que, de sus actividades hemos tenido beneficios muy directos en ámbitos como la medicina, las comunicaciones y otros que la gente corriente desconocen.

nos ha llevado a conocer muchos secretos que la Naturaleza celosamente guardaba, sino que, de sus actividades hemos tenido beneficios muy directos en ámbitos como la medicina, las comunicaciones y otros que la gente corriente desconocen.

Hoy, el Modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero tenemos algunas razones para sospechar que tales predicciones resultan estar muy alejadas de la realidad, o, incluso, ser completamente falsas. Cuando tenemos la posibilidad de llegar más lejos, con sorpresa podemos descubrir que aquello en lo que habíamos creído durante años, era totalmente diferente. El “mundo” cambia a medida que nos alejamos más y más de lo grande y nos sumergimos en ese otro “mundo” de lo muy pequeño, allí donde habitan los minúsculos objetos que conforman la materia desde los cimientos mismos de la creación.

que aquello en lo que habíamos creído durante años, era totalmente diferente. El “mundo” cambia a medida que nos alejamos más y más de lo grande y nos sumergimos en ese otro “mundo” de lo muy pequeño, allí donde habitan los minúsculos objetos que conforman la materia desde los cimientos mismos de la creación.

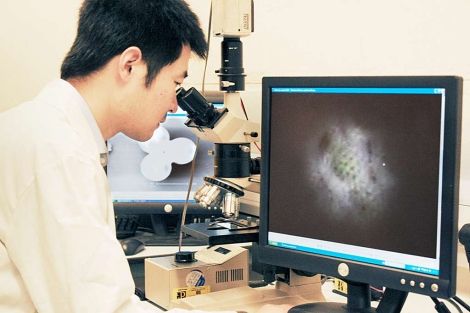

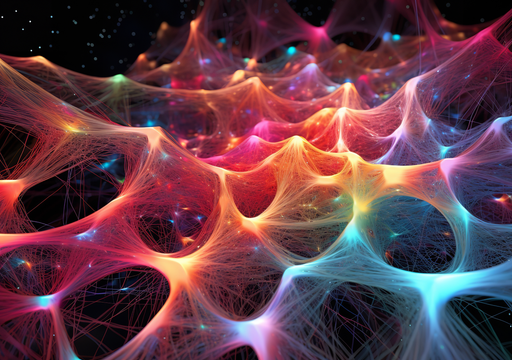

Encendamos nuestro super-microscopio imaginario y enfoquémoslo directamente en el centro de un protón o de cualquier otra partícula. Veremos hordas de partículas fundamentales desnudas pululando. Vistas a través del super-microscopio, el modelo estándar que contiene veinte constantes naturales, describen las fuerzas que rigen la forma en que se mueven. Sin embargo, ahora esas fuerzas no sólo son bastante fuertes sino que también se cancelan entre ellas de una forma muy especial; están ajustadas para conspirar de tal manera que las partículas se comportan como partículas ordinarias cuando se vuelven a colocar el microscopio en la escala de ampliación ordinaria.

esas fuerzas no sólo son bastante fuertes sino que también se cancelan entre ellas de una forma muy especial; están ajustadas para conspirar de tal manera que las partículas se comportan como partículas ordinarias cuando se vuelven a colocar el microscopio en la escala de ampliación ordinaria.

Si en nuestras ecuaciones matemáticas cualquiera de estas constantes fueran reemplazadas por un número ligeramente diferente, la mayoría de las partículas obtendrían inmediatamente masas comparables a las gigantescas energías que son relevantes en el dominio de las muy altas energías. El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural.

de las muy altas energías. El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural.

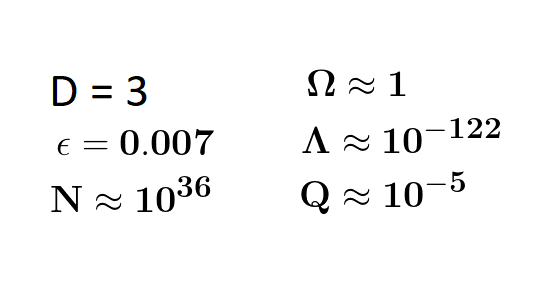

Ajuste fino paras el Universo, para la Vida y, para que esta sea posible en nuestro Universo, han tenido que confluir una serie de complejos ajustes, sin los cuales, no podríamos estar aquí.

¿Implica el ajuste fino un diseño con propósito? ¿Hay tantos parámetros que deben tener un ajuste fino y el grado de ajuste fino es tan alto, que no parece posible ninguna otra conclusión?

Antes decía: “El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural”. Es lo que se llama el “problema del ajuste fino”. Vistas a través del microscopio

decía: “El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural”. Es lo que se llama el “problema del ajuste fino”. Vistas a través del microscopio , las constantes de la Naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son.

, las constantes de la Naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son.

Hay algo muy erróneo aquí. Desde un punto de vista matemático, no hay nada que objetar, pero la credibilidad del Modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas o, lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas.

¿Y por qué debería ser el modelo válido hasta ahí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables, ellas podrían modificar completamente el mundo que Gulliver planeaba visitar. Si deseamos evitar la necesidad de un delicado ajuste fino de las constantes de la Naturaleza, creamos un nuevo problema:

problema:

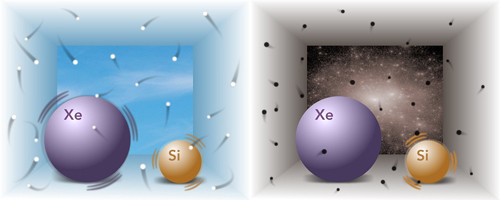

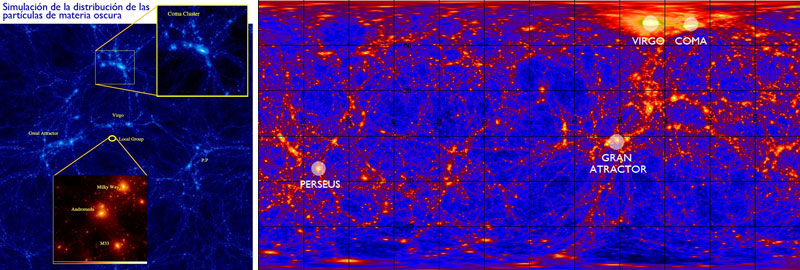

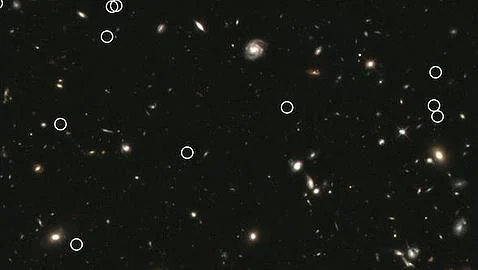

Aquí dicen: “La materia oscura podría estar hecha de extrañas partículas inmortales”

Es cierto que nuestra imaginación es grande pero … No pocas veces ¡la realidad la supera!

… No pocas veces ¡la realidad la supera!

¿Cómo podemos modificar el modelo estándar de tal manera que el ajuste-fino no sea necesario? Está claro que las moficiaciones son necesarias , lo que implica que muy probablemente hay un límite más allá del cual el modelo deja de ser válido. El Modelo estándar no será más que una aproximación matemática que hemos sido capaces de crear, tal que todos los fenómenos observados hasta el presente están de acuerdo con él, pero cada vez que ponemos en marcha un aparato más poderoso, debemos esperar que sean necesarias nuevas modificaciones para ir ajustando el modelo, a la realidad que descubrimos.

el presente están de acuerdo con él, pero cada vez que ponemos en marcha un aparato más poderoso, debemos esperar que sean necesarias nuevas modificaciones para ir ajustando el modelo, a la realidad que descubrimos.

Tendremos que convenir que… ¡Imaginación no nos falta!

¿Cómo hemos podido pensar de otra manera? ¿Cómo hemos tenido la “arrogancia” de pensar que podemos tener la teoría “definitiva”? Mirando las cosas de esta manera, nuestro problema ahora puede muy bien ser el opuesto al que plantea la pregunta de dónde acaba el modelo estándar: ¿cómo puede ser que el modelo estándar funcione tan extraordinariamente bien? y ¿por qué aún no hemos sido capaces de percibir nada parecido a otra generación de partículas y fuerzas que no encajen en el modelo estándar? La respuesta puede estar en el hecho cierto de que no disponemos de la energía necesaria para poder llegar más lejos de lo que hasta el momento hemos podido viajar con ayuda de los aceleradores de partículas.

puede muy bien ser el opuesto al que plantea la pregunta de dónde acaba el modelo estándar: ¿cómo puede ser que el modelo estándar funcione tan extraordinariamente bien? y ¿por qué aún no hemos sido capaces de percibir nada parecido a otra generación de partículas y fuerzas que no encajen en el modelo estándar? La respuesta puede estar en el hecho cierto de que no disponemos de la energía necesaria para poder llegar más lejos de lo que hasta el momento hemos podido viajar con ayuda de los aceleradores de partículas.

:quality(85)//s3.amazonaws.com/arc-wordpress-client-uploads/infobae-wp/wp-content/uploads/2017/04/20092708/particula-cern-1024x575.jpg)

Los asistentes escuchan la presentación de los resultados del experimento ATLAS, durante el seminario del Centro Europeo de Física de Partículas (CERN) para presentar los resultados de los dos experimentos paralelos que buscan la prueba de la existencia de la “partícula de Higgs, base del modelo estándar de física.

presentar los resultados de los dos experimentos paralelos que buscan la prueba de la existencia de la “partícula de Higgs, base del modelo estándar de física.

La pregunta “¿Qué hay más allá del Modelo estándar”? ha estado facinando a los físicos durante años. Y, desde luego, todos sueñan con llegar a saber, qué es lo que realmente es lo que conforma el “mundo” de la materia, qué partículas, cuerdas o briznas vibrantes. En realidad, lo cierto es que, la Física que conocemos no tiene que ser, necesariamente, la verdadera física que conforma el mundo y, sí, la física que conforma “nuestro mundo”, es decir, el mundo al que hemos podido tener acceso hasta el momento y que no necesariamente tiene que coincidir con el mundo real que no hemos podido alcanzar.

luego, todos sueñan con llegar a saber, qué es lo que realmente es lo que conforma el “mundo” de la materia, qué partículas, cuerdas o briznas vibrantes. En realidad, lo cierto es que, la Física que conocemos no tiene que ser, necesariamente, la verdadera física que conforma el mundo y, sí, la física que conforma “nuestro mundo”, es decir, el mundo al que hemos podido tener acceso hasta el momento y que no necesariamente tiene que coincidir con el mundo real que no hemos podido alcanzar.

O, como decía aquél:

decía aquél:

¡Que mundo más hermoso, parece de verdad!

Nuestros sentidos imperfectos no nos deja ver… Lo que la Naturaleza esconde

No todo lo que vemos es, necesariamente, un reflejo de la realidad de la Naturaleza que puede tener escondidos más allá de nuestras percepciones, otros escenarios y otros objetos, a los que, por ahora , no hemos podido acceder, toda vez que, físicamente tenemos carencias, intelectualmente también, y, nuestros conocimientos avanzar despacio para conseguir, nuevas máquinas y tecnologías nuevas que nos posibiliten “ver” lo que ahora nos está “prohibido” y, para ello, como ocurre siempre, necesitamos energías de las que no disponemos.

, no hemos podido acceder, toda vez que, físicamente tenemos carencias, intelectualmente también, y, nuestros conocimientos avanzar despacio para conseguir, nuevas máquinas y tecnologías nuevas que nos posibiliten “ver” lo que ahora nos está “prohibido” y, para ello, como ocurre siempre, necesitamos energías de las que no disponemos.

Hay dos direcciones a lo largo de las cuales se podría extender el Modelo estándar, tal lo conocemos actualmente, que básicamente se caracterizan así:

– Nuevas partículas raras y nuevas fuerzas extremadamente débiles, y

– nuevas partículas pesadas y nuevas estructuras a muy altas energías.

Podrían existir partículas muy difíciles de producir y de detectar y que, por esa razón, hayan pasado desapaercibidas hasta el momento presente. La primera partícula adicional en la que podríamos pensares un neutrino rotando a derecha. Recordaremos que si se toma el eje de rotación paralelo a la dirección del movimiento los neutrinos sólo rotan a izquierdas , esa sería otra historia.

En alguna parte pude leer:

“Los interferómetros atómicos tienen ahora

la sensibilidad para observar nuevas fuerzas más allá del modelo estándar de la física de partículas. “Las nuevas fuerzas a corta distancia son una predicción frecuente de las teorías más allá del Modelo Estándar y la búsqueda de estas nuevas fuerzas es un canal prometedor para una nueva física”, dice Jay Wackerdel Laboratorio del Acelerador Nacional SLAC en California. La pregunta es cómo encontrarlas”

Los neutrinos siempre me han fascinado. Siempre se han manifestado como si tuvieran masa estrictamente nula. Parece como si se movieran exactamente con la velocidad de la luz. Pero hay un límite para la precisión de nuestras medidas. Si los neutrinos fueran muy ligeros, por ejemplo, una cienmillonésima de la masa del electrón, seríamos incapaces de detectar en el laboratorio la diferencia éstos y los neutrinos de masa estrictamente nula. Pero, para ello, el neutrino tendría que tener una componente de derechas.

la precisión de nuestras medidas. Si los neutrinos fueran muy ligeros, por ejemplo, una cienmillonésima de la masa del electrón, seríamos incapaces de detectar en el laboratorio la diferencia éstos y los neutrinos de masa estrictamente nula. Pero, para ello, el neutrino tendría que tener una componente de derechas.

En este punto, los astrónomos se unen a la discusión. No es la primera vez, ni será la última, que la astronomía nos proporciona información esencial en relación a las partículas elementales. Por ejemplo, debido a las interacciones de corriente neutra (las interacciones débiles originadas por un intercambio Zº), los neutrinos son un facto crucial en la explosión supernova de una estrella. sabemos que debido a las interacciones por corriente neutra, pueden colisionar con las capas exteriores de la estrella y volarlas con una fuerza tremenda.

punto, los astrónomos se unen a la discusión. No es la primera vez, ni será la última, que la astronomía nos proporciona información esencial en relación a las partículas elementales. Por ejemplo, debido a las interacciones de corriente neutra (las interacciones débiles originadas por un intercambio Zº), los neutrinos son un facto crucial en la explosión supernova de una estrella. sabemos que debido a las interacciones por corriente neutra, pueden colisionar con las capas exteriores de la estrella y volarlas con una fuerza tremenda.

En realidad, los neutrinos nos tienen mucho que decir, todavía y, no lo sabemos todo acerca de ellos, sino que, al contrario, son muchos los y fenómenos que están y subyacen en ellos de los que no tenemos ni la menor idea que existan o se puedan producir. Nuestra ignorancia es grande, y, sin embargo, no nos arredra hablar y hablar de cuestiones que, la mayoría de las veces…ni comprendemos.

Aquí lo dejar´ñe por hoy, el tema es largo y de una fascinación que te puede llevar a lugares en los que no habías pensado al comenzar a escribir, lugares maravillosos donde reinan objetos exóticos y de fascinante porte que, por su pequeñez, pueden vivir en “mundos” muy diferentes al nuestro en los que, ocurren cosas que, nos llevan el asombro y también

que, por su pequeñez, pueden vivir en “mundos” muy diferentes al nuestro en los que, ocurren cosas que, nos llevan el asombro y también , a ese mundo mágico de lo fascinante y maravilloso.

, a ese mundo mágico de lo fascinante y maravilloso.

Emilio Silvera V.

Sep

17

LA VIDA

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

¿Qué es la vida? Difícil es, sin duda, dar una respuesta exacta a pregunta tan común y tan simple, que originó el nacimiento de la filosofía para explicarla.

Surgió la filosofía de una necesidad de explicación, y el interrogante incógnito que sirviera de estandarte a sus principios, sigue constituyendo un norte misterioso e inexplicable.

Complicadísimos procesos ontogénicos elaboran sabios, y tropezaron siempre con barreras insalvables.

Crearon ciencias y más ciencias, positivistas y metafísicas; investigaron incansables los abismos profundos de los fenómenos naturales; estudiaron la materia constitutiva de los seres y las cosas que nos rodean; abasamentaron conclusiones evidentes, aunque relativas.

Mucho hicieron por descifrar la incógnita, pero el velo de una materialidad absoluta e imperialista, cegaba todos sus caminos.

Y sobre las ruinas de todas esas aspiraciones muertas, surgían religiones idealistas. Ellas sí lo explicaban, aunque a decir verdad, sin comprenderlo.

Filósofo 1, científico 0

La Ciencia exige demostración

:format(jpg)/f.elconfidencial.com%2Foriginal%2Fec1%2F0d3%2Fbe8%2Fec10d3be8b0bb248b6d22d80dff9b651.jpg)

La Religión ha sido siempre cosa de Fe

La ciencia quiere comprender consciente. La religión admite sentires inconscientes.

La voluntad ayuda al sabio. La fe al creyente.

La inteligencia guía los pasos de la ciencia. El sentimiento los de la religión.

En el camino rudo de la ciencia, se abren abismos que orillar se deben.

En el camino de las religiones siempre existe una tabla promisora: la explicación en Dios.

La ciencia es incompleta para explicar la vida. La religión también.

Una, por su materialismo absoluto. La otra por su absoluto sobrenatural.

¿Inmortalidad? La Ciencia huye de lo que no ve

La ciencia huye de lo que no ve. La religión camina a oscuras. Es necesario entonces completar los vacíos de la una con los rellenos de la otra, y las dudas que presenta ésta, con las certezas que le brinda aquélla.

Formar la ciencia religiosa, o la religión científica.

Llegaríamos, entonces, a lo ideal; es decir, a modelar un algo que lo explique todo.

Que tenga la voluntad del sabio, y de la fe del creyente.

Que se interne en lo que no se ve, pero sin caminar a oscuras.

Fundir lo material con lo divino. Explicar lo uno como medio evidente de lo otro impalpable.

Hacer obrar a los sentidos, pero también al alma.

Saltar las barreras materiales con las alas de lo espiritual.

¿Existe hoy en día ese algo, que llamaremos doctrina, que participe a la vez de las certezas de la ciencia y de las explicaciones de la religión?

Si existe. Y en su seno van cobijándose ya, poco a poco, los necesitados del saber.

En sus filas van incorporándose los que comprenden que en su fuente fecunda e inagotable, encontrarán lo que la materialidad de sus conceptismos restringidos no pueden brindarles.

Esa doctrina ideal, que admite todo cuanto la ciencia estudia y rellena sus huecos con explicaciones racionales, es el Espiritualismo.

Estudiándolo, estudiaremos la Naturaleza. Todo lo que vibra en el infinito está comprendido entre sus límites. Todo, por lo tanto, es natural.

La vida no es más que manifestaciones naturales. La vida es natural. Si el Espiritualismo explica la Naturaleza, explicará la vida.

Su filosofía tiene la materialidad de lo científico, y lo astral de lo religioso. Es una religión consciente que demuestra. Es una ciencia que descorre el velo de lo no evidente.

Es el crisol hermoso donde funden los descubrimientos elaborados en siglos de investigación, y los ideales que gestaron millones de sentires.

El sentimiento en aras de una realidad. Y lo concreto en aras de una idealidad.

Su fuente es inagotable y pródiga: la Natura. Su medio es categórico y sublime: la voluntad y el amor. Su fin es una refinada y amplia concepción:

Ascender.

Es la vida misma, porque es el progreso, lo movible, lo eterno. El progreso es su norte, y la vida es un continuo evolucionismo hacia lo perfecto. La eternidad es la etapa de sus realizaciones, y la vida es inextinguible y duradera. El escudriñamiento de esa movilidad continua es su trabajo, y la vida es el todo que se mueve.

No preguntemos entonces a la ciencia lo qué es la vida. No le preguntemos a la religión. La una es el hierro, la otra es el calor. Busquemos el acero.

Busquemos a la doctrina, que es la ciencia templada al fuego de la religión. Ella, sí, nos dirá qué es la vida.

Nos llevará a la naturaleza para encontrarla, y nos dará la razón espiritual para explicarla. Encontraremos los arcanos llenos, tapados con un velo, pero estará allí el alma que lo corra.

Nos hará mirar la tierra para ver, y el cielo para comprender. Veremos maravillas en lo alto, pero para subir haremos la escalera con lo terreno. Lo divino será nuestro futuro, lo terrenal nuestro presente.

Para explicar la vida, entonces, vayamos a estudiar esa doctrina que completa, esa experimentación que siente, ese sentir que explica. Estudiemos el Espiritualismo como ideología y como ciencia.

Vayamos a estudiarlo, no en busca de lo perfecto, sino en lo que va en camino de la perfección. No como supersticionismo vago y terrorífico, sino como realidad cierta y bondadosa. No para encontrar sobrenaturales, sino para aprender a saber que todo es natural.

En su ceno la vida se hace dulce y buena, y se brinda sumisa para que la comprendamos.

¿Qué significan el Agua y la Luz en el Universo? ¡La Vida!

En ese faro intelectual del sentimiento, encontraremos luz, y sus rayos imperativos y seguros ahuyentarán las tinieblas de nuestra ignorancia, que atrofia y retrocede.

El calor de su amor sublime y bello alentará al alma, que luchará con bríos en la ruda batalla de la vida.

Nos hará acatar sumisos los dolores, como consejos mudos. Los golpes y reveces de esta existencia efímera, como promesas de un bienestar mayor.

¿Lo mejor de la Humanidad? ¡La Familia!

Aprendamos a amar la vida que enseña y que corrige, y arrastrados por su evolucionismo constante y progresista, recorreremos playas que brindan sus bondades, y encontraremos metas que alientan y estimulan.

En esta escuela inmensa que es la Tierra, sentados en el pupitre andante de nuestros Ideales, y teniendo al Espiritualismo a nuestro frente como maestro, llegaremos a conocer la esencia de las cosas: llegaremos a conocer

la vida, que es eterna, con sus etapas sucesivas infinitas.

Ovidio Pracilio

De su libro “Vida, Amor, Muerte” Envío: dantepracilio@gmail.com

Sep

17

Siempre hemos preguntado ¿Qué es la Vida? Pero… ¿Alguien supo...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Si tenemos la paciencia de visualizar el Video, al menos tendremos una idea más cercana de lo que la Vida es..

A mí, que me gustaría tener un Intelecto superior, para salir del paso he contestado:

La vida, amigos míos, es la materia evolucionada hasta las ideas, los pensamientos y los sentimientos.

Sep

17

¡Conocer la Naturaleza! Hoy sólo un sueño ¿Realidad mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (6)

Comments (6)

“A partir de sus principios en Sumeria alrededor del 3500 a. C., en Mesopotamia, los pueblos del norte comenzaron a intentar registrar la observación del mundo con datos cuantitativos y numéricos sumamente cuidados. Pero sus observaciones y medidas aparentemente fueron tomadas con otros propósitos más que la ley científica. Un caso concreto es el del teorema de Pitágoras, que fue registrado, aparentemente en el siglo XVIII a. C.: la tabla Mesopotámica Plimpton 322 registra un número de trillizos pitagóricos (3,4,5) (5,12,13)…., datado en el 1900 a. C., posiblemente milenios antes de Pitágoras,1 pero no era una formulación abstracta del teorema de Pitágoras.

cuantitativos y numéricos sumamente cuidados. Pero sus observaciones y medidas aparentemente fueron tomadas con otros propósitos más que la ley científica. Un caso concreto es el del teorema de Pitágoras, que fue registrado, aparentemente en el siglo XVIII a. C.: la tabla Mesopotámica Plimpton 322 registra un número de trillizos pitagóricos (3,4,5) (5,12,13)…., datado en el 1900 a. C., posiblemente milenios antes de Pitágoras,1 pero no era una formulación abstracta del teorema de Pitágoras.

Los avances significativos en el Antiguo Egipto son referentes a la astronomía, a las matemáticas y a la medicina.2 Su geometría era una consecuencia necesaria de la topografía, con el fin de intentar conservar la disposición y la propiedad de las tierras de labranza, que fueron inundadas cada año por el Nilo. La regla del triángulo rectángulo y otras reglas básicas sirvieron para representar estructuras rectilíneas, el pilar principal de la arquitectura dintelada egipcia. Egipto era también

año por el Nilo. La regla del triángulo rectángulo y otras reglas básicas sirvieron para representar estructuras rectilíneas, el pilar principal de la arquitectura dintelada egipcia. Egipto era también el centro de la química y la investigación para la mayor parte

el centro de la química y la investigación para la mayor parte del Mediterráneo.”

del Mediterráneo.”

Torres del Río, villa jacobea

sabel Pérez Arellano y Róbinson Torres Villa, publicaron un artículo en 2009, sobre la física moderna y sus paradigmas y, comenzaban diciendo:

“Desde

siempre el hombre ha intentado dar respuesta a los interrogantes más profundos que lo inquietan; preguntas que van desde ¿Quién soy?, ¿de dónde vengo? ¿y hacia dónde voy?, hasta

los intentos por explicar el origen y final universo en qué vive. Muchas son las prepuestas que se han dado a esos interrogantes, dependiendo de la corriente de pensamiento seguida por quien aborda esas preguntas; es así como se ven aproximaciones místicas, esotéricas, religiosas y científicas entre otras; pero todas con el objetivo de dilucidar alguna respuesta a esas preguntas fundamentales.

Desde el punto de vista científico y concretamente de la física moderna, se han planteado algunas explicaciones del universo en el que vivimos que algunas veces rozan con lo fantástico, dado el nivel de abstracción o especulación que llevan implícito, todo obviamente avalado por sofisticados modelos matemáticos que al parecer soportan las hipótesis planteadas.”

Si repasamos la historia de la ciencia, seguramente encontraremos muchos motivos para el optimismo. Por mencionar a un científico de nuestro tiempo, escojamos a E. Witten que está convencido de que la ciencia será algún día capaz de sondear hasta las energías de Planck. Como ya he contado en otras ocasiones, él dijo:

las energías de Planck. Como ya he contado en otras ocasiones, él dijo:

¿Podremos verificar algún día la Teoría de cuerdas

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles. En el siglo XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible. Si usted hubiera dicho a un físico del siglo XIX que hacia el siglo XX sería capaz de calcularlo, le habría parecido un cuento de hadas… La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante

25 años.”

Dicen que para la verificación de la Teoría de cuerdas, se nec4esitaría disponer de la energía de Planck. es decir, 1019 GeV, una energía que sólo estaba presente en el momento de la creación.

En su opinión, las buenas ideas siempre se verifican. Los ejemplos son innumerables: la gravedad de Newton, el campo eléctrico de Faraday y el electromagnetismo de Maxwell, la teoría de la relatividad de Einstein en sus dos versiones y su demostración del efecto fotoeléctrico, la teoría del electrón de Paul Dirac, el principio de incertidumbre de Heisenberg, la función de ondas de Schrödinger, y tantos otros. Algunos de los físicos teóricos más famosos, sin embargo, protestaban de tanto empeño en la experimentación.

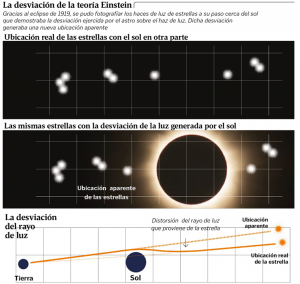

Para probar la teoría, sería necesario fotografiar estrellas cerca del Sol y luego tomarlas en el mismo lugar por la noche. Después, medir su posición en el cielo en cada momento. El escenario ideal para eso es un eclipse total, el momento en que la sombra de la Luna alcanza la Tierra y esconde el Sol

Negativo y positivo del eclipse de Sol de 1919, obtenido por Sir Arthur Eddington en la expedición para verificar si la luz procedente de las estrellas próximas a la corona solar era ligeramente desviada por el campo gravitatorio del Sol, de acuerdo con la Teoría de la Relatividad.

El astrónomo arthur Eddington se cuestionaba incluso si los científicos no estaban forzando las cosas cuando insistían en que todo debería ser verificado. El premio Nobel Paul dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años

insistían en que todo debería ser verificado. El premio Nobel Paul dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años , «Es sólo el optimista el que consigue algo en este mundo».“

, «Es sólo el optimista el que consigue algo en este mundo».“

Yo, como todos ustedes, un hombre normal y corriente de la calle, escucho a unos y a otros, después pienso en lo que dicen y en los argumentos y motivaciones que les han llevado a sus respectivos convencimientos, y finalmente, también decido según mis propios criterios y emito mi opinión de cómo es el mundo que, no obligatoriamente, coincidirá con alguna de esas opiniones, y que en algún caso, hasta difieren radicalmente.

decido según mis propios criterios y emito mi opinión de cómo es el mundo que, no obligatoriamente, coincidirá con alguna de esas opiniones, y que en algún caso, hasta difieren radicalmente.

Suponiendo que algún físico brillante nos resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro universo, con un poco de suerte, podría ocurrir en este mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando

mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando su “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas tiene

su “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas tiene su explicación allí, en aquel lugar y tiempo donde se produjeron las mayores energías conocidas en nuestro Universo y que, nosotros, no podemos alcanzar -de momento-.

su explicación allí, en aquel lugar y tiempo donde se produjeron las mayores energías conocidas en nuestro Universo y que, nosotros, no podemos alcanzar -de momento-.

Fuimos capaces de predecir que el Big Bang produjo un “eco” cósmico reverberando en el universo y que podría ser mesurable por los instrumentos adecuados. De hecho, Arno Penzias y Robert Wilson de los Bell Telephone Laboratories ganaron el premio Nobel en 1.978 por detectar este eco del Big Bang, una radiación de microondas que impregna el universo conocido.

eco del Big Bang, una radiación de microondas que impregna el universo conocido.

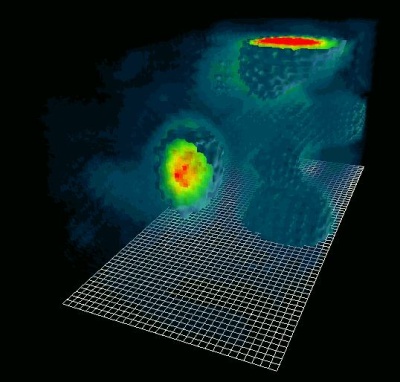

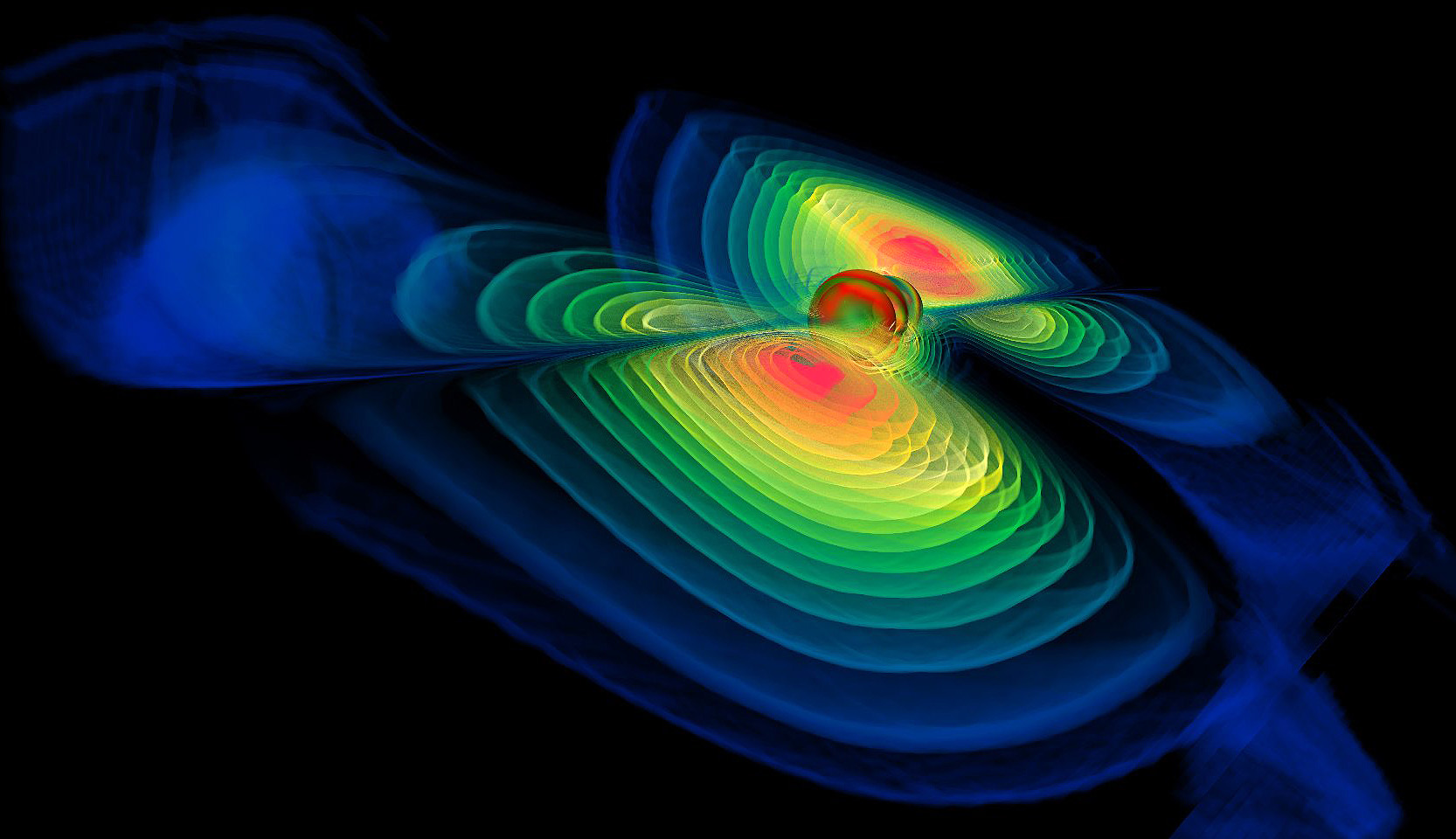

Como

una onda, podemos detectar el eco del Big Bang. Las ondas gravitacionales comprimen y expanden el tiempo y el espacio a medida que se desplazan a la velocidad de la luz, y así distorsionan el fondo de radiación cósmica, también llamado el eco del Big Bang.

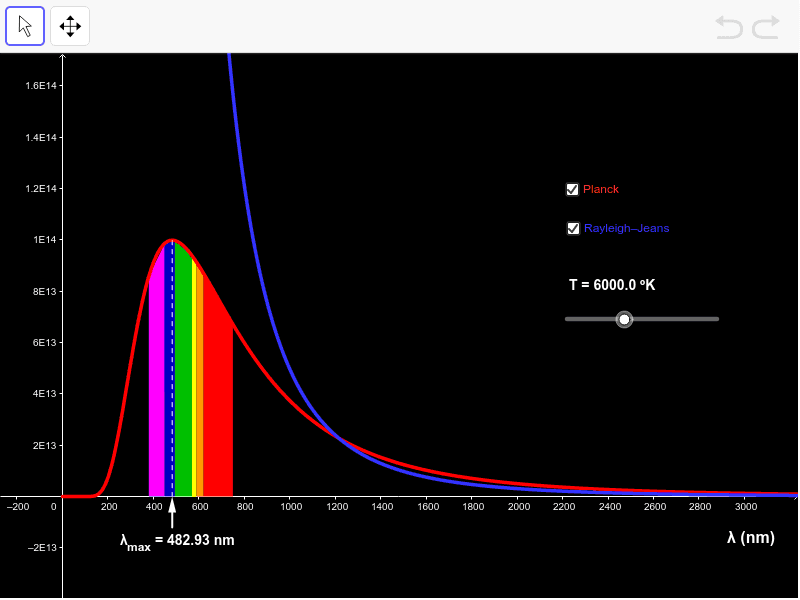

El que el eco del Big Bang debería estar circulando por el universo miles de millones de años después del suceso fue predicho por primera vez por George Gamow y sus discípulos Ralpher y Robert Herman, pero nadie les tomó en serio. La propia idea de medir el eco de la creación parecía extravagante cuando la propusieron por primera vez poco después de la segunda guerra mundial. Su lógica, sin embargo, era aplastante. Cualquier objeto, cuando se calienta, emite radiación de forma gradual. Ésta es la razón de que el hierro se ponga al rojo vivo cuando se calienta en un horno , y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

, y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

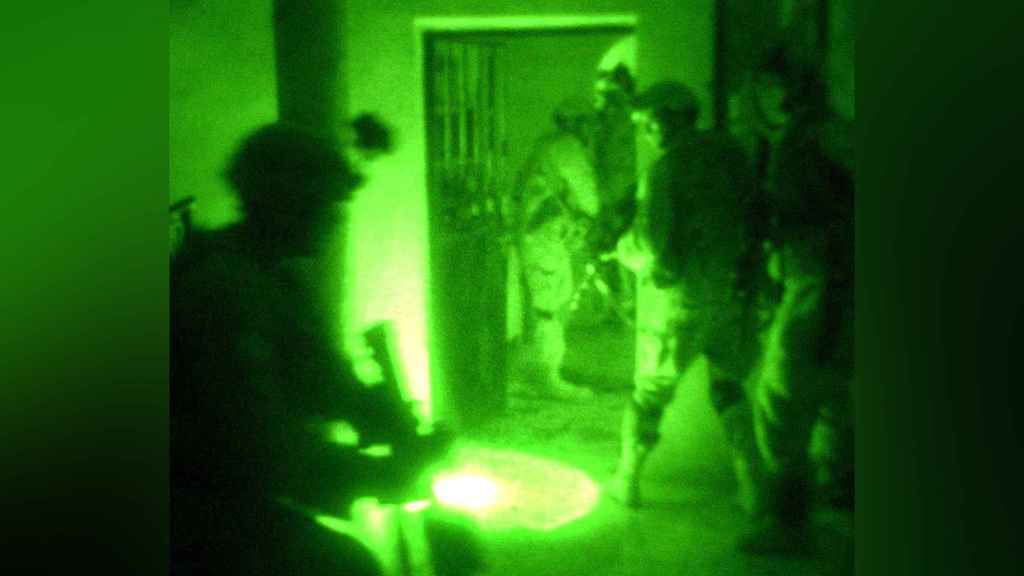

Podemos ver en plena oscuridad

Esta radiación, ¡cómo no!, ha sido aprovechada por los ejércitos, que mediante visores nocturnos pueden operar en la oscuridad. De noche, los objetos relativamente calientes, tales como soldados enemigos o los carros de combate, pueden estar ocultos en la oscuridad, pero continúan emitiendo radiación de cuerpo negro invisible en forma de radiación infrarroja, que puede ser captada por gafas especiales de infrarrojo. Ésta es también la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura y, cuando regresamos para proseguir el camino… ¿Quién es el guapo que entra?

la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura y, cuando regresamos para proseguir el camino… ¿Quién es el guapo que entra?

Análogamente, la radiación de cuerpo negro produce el efecto invernadero. Al igual que el vidrio, los altos niveles de dióxido de carbono en la atmósfera, causados por la combustión sin control de combustibles fósiles, pueden atrapar la radiación de cuerpo negro infrarroja en la Tierra, y de este modo calentar gradualmente el planeta.

Gamow razonó que el Big Bang era inicialmente muy caliente, y que por lo tanto sería un cuerpo negro ideal emisor de radiación. Aunque la tecnología de los años cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

La lógica que había detrás de su razonamiento era la siguiente: alrededor de 300.000 años después del Big Bang, el universo se enfrió hasta el punto en el que los átomos pudieron empezar a componerse; los electrones, entonces, pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento

el punto en el que los átomos pudieron empezar a componerse; los electrones, entonces, pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento , el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

, el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

Pasados 300.000 años, la radiación no era tan potente; se había enfriado y por lo tanto la luz podía atravesar grades distancias sin ser dispersada. En otras palabras, el universo se hizo repentinamente negro y transparente.

Terminaré esta parte comentando que un auténtico cuerpo negro es un concepto imaginario; un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica. La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

es la mejor aproximación que se puede tener de él en la práctica. La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

Hablar, sin más especificaciones, de radiación, es estar refiriéndonos a una energía que viaja en forma de ondas electromagnéticas o fotones por el universo. También

de ondas electromagnéticas o fotones por el universo. También nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

Radiación y magnetismo presentes en todas partes

La radiación actínida es la electromagnética que es capaz de iniciar una reacción química. El término es usado especialmente para la radiación ultravioleta que emiten las estrellas jóvenes y azuladas en las bellas nebulosas.

la radiación ultravioleta que emiten las estrellas jóvenes y azuladas en las bellas nebulosas.

Muchos son los tipos conpocidos: Radiación blanda, radiación cósmica, radiación de calor, radiación de fondo, de fondo de microondas, radiación dura, electromagnética, radiación gamma, infrarroja, ionizante, monocromática, policromática, de sincrotón, ultravioleta, de la teoría cuántica, de radiactividad… y, como se puede ver, la radiación en sus diversas formas es un universo en sí misma.

se puede ver, la radiación en sus diversas formas es un universo en sí misma.

El físico alemán Max Planck (1.858 – 1.947), responsable entre otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

Einstein se inspiró en este trabajo para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre

para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre : Em = hf – Φ.

: Em = hf – Φ.

En 1905 Einstein publicó cinco trabajos que le llevaron a la cúspide de la Física (fue su sño Mirabilis)

- Efecto fotoeléctrico. …

- Determinación de las dimensiones moleculares. …

- Movimiento browniano. …

- Electrodinámica de los cuerpos en movimiento o “relatividad especial” …

- Equivalencia de la masa y energía.

Planck publicó en 1.900 un artículo sobre la radiación de cuerpo negro que sentó las bases para la teoría de la mecánica cuántica que más tarde desarrollaron otros, como el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

1. Esta escala de longitud ( 10-35 m ) veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m, es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta

escala de longitud ( 10-35 m ) veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m, es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

2. Es la masa de una partícula cuya longitud de onda Compton es igual a la longitud de Planck. En la ecuación, ħ es la constante de Planck racionalizada, c es la velocidad de la luz y G es la constante gravitacional.

La descripción de una partícula elemental de esta masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como

masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 14 TeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas.

la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 14 TeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas.

Únicamente en un laboratorio aparecieron partículas que tenían energías del orden de la masa de Planck: en el universo primitivo, de acuerdo con la teoría del Big Bang, motivo éste por el que es necesaria una teoría cuántica de la gravedad para estudiar aquellas condiciones . Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para

. Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

Siempre, desde que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos.

que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos.

Emilio silvera V.

Sep

17

Sí, somos parte del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo misterioso ~

Clasificado en El Universo misterioso ~

Comments (0)

Comments (0)

Una parte de la ciencia estudia la estructura y la evolución del Universo: La cosmología.

La cosmología observacional se ocupa de las propiedades físicas del Universo, como su composición física referida a la química, la velocidad de expansión y su densidad, además de la distribución de Galaxias y cúmulos de galaxias. La cosmología física intenta comprender estas propiedades aplicando las leyes conocidas de la física y de la astrofísica. La cosmología teórica construye modelos que dan una descripción matemática de las propiedades observadas del Universo basadas en esta comprensión física.

La cosmología también tiene aspectos filosóficos, o incluso teológicos, en el sentido de que trata de comprender por qué el Universo tiene las propiedades observadas.

La cosmología teórica se basa en la teoría de la relatividad general, la teoría de Einstein de la gravitación. De todas las fuerzas de la naturaleza, la gravedad es la que tiene efectos más intensos a grandes escalas y domina el comportamiento del Universo en su conjunto.

El espacio-tiempo, la materia contenida en el Universo con la fuerza gravitatoria que genera y, nuestras mentes que tienen conocimientos de que todo esto sucede.

De manera que, nuestro consciente (sentimos, pensamos, queremos obrar con conocimiento de lo que hacemos), es el elemento racional de nuestra personalidad humana que controla y reprime los impulsos del inconsciente, para desarrollar la capacidad de adaptación al mundo exterior.

Al ser conscientes, entendemos y aplicamos nuestra razón natural para clasificar los conocimientos que adquirimos mediante la experiencia y el estudio que aplicamos a la realidad del mundo que nos rodea.

Claro que, no todos podemos percibir la realidad de la misma manera, las posibilidades existentes de que el conocimiento de esa realidad responda exactamente a lo que ésta es en sí, no parece fácil.

Descartes, Leibniz, Locke, Berkeley, Hume (que influyó decisivamente en Kant), entre otros, construyeron una base que tomó fuerza en Kant, para quien el conocimiento arranca o nace de nuestras experiencias sensoriales, es decir, de los datos que nos suministra nuestros cinco sentidos, pero no todo en él procede de esos datos. Hay en nosotros dos fuentes o potencias distintas que nos capacitan para conocer, y son la sensibilidad (los sentidos) y el entendimiento (inteligencia). Esta no puede elaborar ninguna idea sin los sentidos, pero éstos son inútiles sin el entendimiento.

A todo esto, para mí, el conocimiento está inducido por el interés. La falta y ausencia de interés aleja el conocimiento. El interés puede ser de distinta índole: científico, social, artístico, filosófico, etc. (La gama es tan amplia que existen conocimientos de todas las posibles vertientes o direcciones, hasta tal punto es así que, nunca nadie lo podrá saber todo sobre todo). Cada uno de nosotros puede elegir sobre los conocimientos que prefiere adquirir y la elección está adecuada a la conformación individual de la sensibilidad e inteligencia de cada cual. Álli, en alguna parte, está el germen del interés-curiosidad de cada cual.

También se da el caso de personas que prácticamente, por cuestiones genéticas o de otra índole, carecen de cualquier interés por el conocimiento del mundo que les rodea, sus atributos sensoriales y de inteligencia funcionan a tan bajo rendimiento que, sus comportamientos son casi-animales (en el sentido de la falta de racionalidad), son guiados por la costumbre y las necesidades primarias: comer, dormir…

Formamos parte del misterio que tratamos de descubrir

El polo opuesto lo encontramos en múltiples ejemplos de la historia de la ciencia, donde personajes como Newton, Einstein, Riemann, Ramanujan y tantos otros (cada uno en su ámbito del conocimiento), dejaron la muestra al mundo de su genio superior.

Pero toda la realidad está encerrada en una enorme burbuja a la que llamamos Universo y que encierra todos los misterios y secretos que nosotros, seres racionales y conscientes, persiguen.

Todo el mundo sabe lo que es la conciencia; es lo que nos abandona cada noche cuando nos dormimos y reaparece a la mañana siguiente cuando nos despertamos. Esta engañosa simplicidad me recuerda lo que William James escribió a finales del siglo XIX sobre la atención: ”Todo el mundo sabe lo que es la atención; es la toma de posesión por la mente, de una forma clara e intensa, de un hilo de pensamiento de entre varios simultáneamente posibles”. Más de cien años más tarde somos muchos los que creemos que seguimos sin tener una comprensión de fondo ni de la atención, ni de la conciencia que, desde luego, no creo que se marche cuando dormimos, ella no nos deja nunca.

La falta de comprensión ciertamente no se debe a una falta de atención en los círculos filosóficos o científicos. Desde que René Descartes se ocupara del problema, pocos han sido los temas que hayan preocupado a los filósofos tan persistentemente como el enigma de la conciencia.

Para Descartes, como para James más de dos siglos después, ser consciente era sinónimo de “pensar”: el hilo de pensamiento de James no era otra cosa que una corriente de pensamiento. El cogito ergo sum, “pienso, luego existo”, que formuló Descartes como fundamento de su filosofía en Meditaciones de prima philosophía, era un reconocimiento explícito del papel central que representaba la conciencia con respecto a la ontología (qué es) y la epistemología (qué conocemos y cómo le conocemos).

No siempre somos conscientes de Ser, y, saber el lugar que ocupamos… ¡Es conveniente! En caso contrario, nos podríamos creer más de lo que somos.

Claro que tomado a pie juntillas, “soy consciente, luego existo”, nos conduce a la creencia de que nada existe más allá o fuera de la propia conciencia y, por mi parte, no estoy de acuerdo. Existen muchísimas cosas y hechos que no están al alcance de mi conciencia. Unas veces por imposibilidad física y otras por imposibilidad intelectual, lo cierto es que son muchas las cuestiones y las cosas que están ahí y, sin embargo, se escapan a mi limitada conciencia.

Todo el entramado existente alrededor de la conciencia es de una complejidad enorme, de hecho, conocemos mejor el funcionamiento del Universo que el de nuestros propios cerebros.

¿Cómo surge la conciencia como resultado de procesos neuronales particulares y de las interacciones entre el cerebro, el cuerpo y el mundo?

¿Cómo pueden explicar estos procesos neuronales las propiedades esenciales de la experiencia consciente?

Cada uno de los estados conscientes es unitario e indivisible, pero al mismo tiempo cada persona puede elegir entre un número ingente de estados conscientes distintos.

Beltrand Russell decía: “El problema del mundo es que los estúpidos están seguros de todo y los inteligentes están llenos de dudas”.

Muchos han sido los que han querido explicar lo que es la conciencia. En 1.940, el gran neurofisiólogo charles Sherrington lo intento y puso un ejemplo de lo que él pensaba sobre el problema de la conciencia. Unos pocos años más tarde también lo intentaron otros y, antes, el mismo Bertrand Russell hizo lo propio, y, en todos los casos, con más o menos acierto, el resultado no fue satisfactorio, por una sencilla razón: nadie sabe a ciencia cierta lo que en verdad es la conciencia y cuales son sus verdaderos mecanismos; de hecho, Russell expresó su escepticismo sobre la capacidad de los filósofos para alcanzar una respuesta:

“Suponemos que un proceso físico da comienzo en un objeto visible, viaja hasta el ojo, donde se convierte en otro proceso físico en el nervio óptico y, finalmente, produce algún efecto en el cerebro al mismo tiempo que vemos el objeto donde se inició el proceso; pero este proceso de ver es algo “mental”, de naturaleza totalmente distinta a la de los procesos físicos que lo preceden y acompañan. Esta concepción es tan extraña que los metafísicos han inventado toda suerte de teorías con el fin de sustituirla con algo menos increíble”.

Está claro que en lo más profundo de ésta consciencia que no conocemos, se encuentran todas las respuestas planteadas o requeridas mediante preguntas que nadie ha contestado.

Sin la fuerza de Gravedad, nuestras mentes serían diferentes (o no serían), estamos estrechamente conectados a las fuerzas que rigen el Cosmos y, precisamente, somos como somos, porque las fuerzas fundamentales de la Naturaleza, son como son y hacen posible la vida y la existencia de seres pensantes y evolucionados que son capaces de tener conciencia de SER, de hacer preguntas tales como: ¿de donde venimos? ¿Hacia donde vamos?

Al comienzo mencionaba el cosmos y la gravedad junto con la consciencia y, en realidad, con más o menos acierto, de lo que estaba tratando era de hacer ver que todo ello, es la misma cosa. Universo-Galaxia-Mente. Nada es independiente en un sentido global, sino que son partes de un todo y están estrechamente relacionados.

Una Galaxia es simplemente una parte pequeña del Universo, nuestro planeta es, una mínima fracción infinitesimal de esa Galaxia, y, nosotros mismos, podríamos ser comparados (en relación a la inmensidad del cosmos) con una colonia de bacterias pensantes e inteligentes. Sin embargo, toda forma parte de lo mismo y, aunque pueda dar la sensación engañosa de una cierta autonomía, en realidad todo está interconectado y el funcionamiento de una cosa incide directamente en las otras.

Pocas dudas pueden caber a estas alturas del hecho de que poder estar hablando de estas cuestiones, es un “milagro” en sí mismo.

Después de millones y millones de años de evolución, se formaron las conciencias primarias que surgieron en los animales con ciertas estructuras cerebrales de alta complejidad que, podían ser capaces de construir una escena mental, pero con capacidad semántica o simbólica muy limitada y careciendo de un verdadero lenguaje.

La conciencia de orden superior (que floreció en los humanos y presupone la coexistencia de una conciencia primaria) viene acompañada de un sentido de la propia identidad y de la capacidad explícita de construir en los estados de vigilia escenas pasadas y futuras. Como mínimo, requiere una capacidad semántica y, en su forma más desarrollada, una capacidad lingüística.

Los procesos neuronales que subyacen en nuestro cerebro son en realidad desconocidos y, aunque son muchos los estudios y experimentos que se están realizando, su complejidad es tal que, de momento, los avances son muy limitados. Estamos tratando de conocer la máquina más compleja y perfecta que existe en el Universo.

Cuántas veces me habré preguntado: ¿Existirá una Conciencia Cósmica? Si no fuese así, ¿Cómo podríamos explicar ciertas cosas?

Emilio Silvera V.

Totales: 75.191.510

Totales: 75.191.510 Conectados: 49

Conectados: 49