Ago

4

Los Misterios de la Tierra

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencias de la Tierra ~

Clasificado en Ciencias de la Tierra ~

Comments (1)

Comments (1)

Encuentros espaciales

La más destructiva intensificación temporal de los normalmente suaves flujos de energía geotectónica – erupciones volcánicas o terremotos extraordinariamente potentes – o de energía atmosférica – vientos o lluvias anormalmente intensas –, parecen irrelevantes cuando se comparan con las repetidas colisiones del planeta con cuerpos extraterrestres relativamente grandes.

Existen simulaciones de lo que puede ser el choque del meteorito en la Tierra y, desde luego, no quisiera estar aquí cuando suceda. La Tierra está siendo bombardeada continuamente por invisibles partículas microscópicas de polvo muy abundantes en todo el Sistema Solar, y cada treinta segundos se produce un choque con partículas de 1 mm de diámetro, que dejan un rastro luminoso al autodestruirse en la atmósfera. También son relativamente frecuentes los choques con meteoritos de 1 metro de diámetro, que se producen con una frecuencia de, al menos, uno al año.

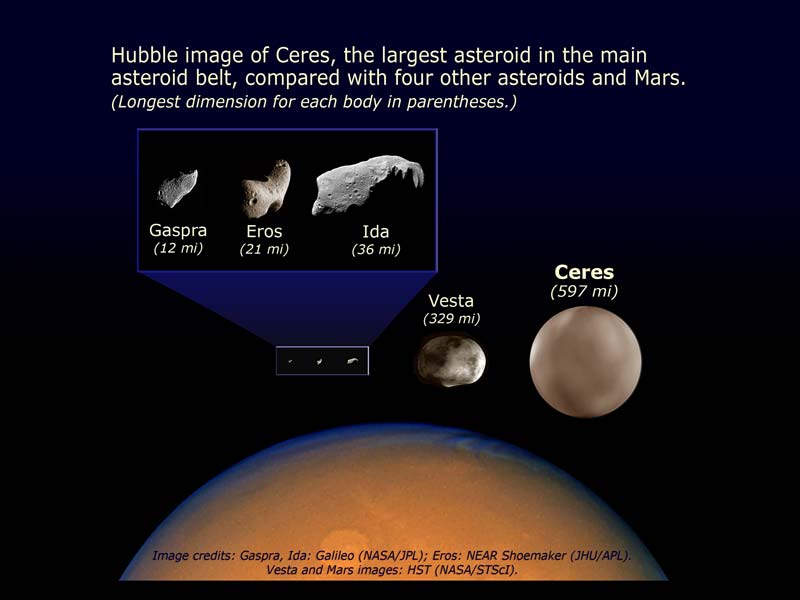

Pero los impactos, incluso con meteoritos mayores, producen solamente efectos locales. Esto es debido a que los meteoritos que deambulan por la región de asteroides localizada entre Marte y Júpiter están girando alrededor del Sol en el mismo sentido que la Tierra, de manera que la velocidad de impacto es inferior a 15 Km/s.

Entre Marte y Júpiter hay cientos de miles de cuerpos pequeños que orbitan alrededor del Sol llamados asteroides. También podemoas encontrarlos más allá de Plutón, llamado cinturón de Kuiper, y que en este caso reciben el nombre de objetos transneptunianos y que están hecho de hielo. Ceres es el asteroide más grande y tiene 913 km de diámetro.

El cráter de Arizona, casi perfectamente simétrico, se formó hace 25.000 años por el impacto de un meteorito que iba a una velocidad de 11 Km/s, lo que representa una potencia cercana a 700 PW. Estas gigantescas liberaciones de energías palidecen cuando se comparan con un choque frontal con un cometa típico. Su masa (al menos de 500 millones de toneladas) y su velocidad relativa (hasta 70 Km/s) elevan su energía cinética hasta 1022 J. Aunque se perdiera un diez por ciento de esta energía en la atmósfera, el impacto sería equivalente a una explosión de unas 2.500 bombas de hidrógeno de 100 megatones. Está claro que un fenómeno de estas características produciría impresionantes alteraciones climatológicas. Sin embargo, no es seguro y sí discutible que un impacto parecido fuese la causa de la extinción masiva del cretácico, siendo lo más probable, si tenemos en cuenta el periodo relativamente largo en que se produjo, que se podría explicar por la intensa actividad volcánica de aquel tiempo.

La frecuencia de impactos sobre la Tierra disminuye exponencialmente con el tamaño del objeto. Muchas toneladas son las que recibimos cada año de pequeños fragmentos de todo tipo pero, cuando estos van aumentando de tamaño, los sucesos de espacian de manera sustancial

Aproximadamente, cada cincuenta o sesenta millones de años se produce una colisión con un cometa, lo que significaría que la biosfera, que ha evolucionado durante cuatro mil millones de años, ha debido superar unos cuarenta impactos de este tipo. Está claro que ha salido airosa de estas colisiones, ya que aunque haya sido modificada, no ha sido aniquilada.

Igualmente, la evolución de la biosfera ha sobrevivido a las explosiones altamente energéticas de las supernovas más “cercanas”. Dado que en nuestra galaxia se produce por término medio la explosión de una supernova cada 50 años, el Sistema Solar se encuentra a una distancia de 100 parsecs de la explosión cada dos millones de años y a una distancia menor de 10 parsecs cada dos mil millones de años. En este último caso, la parte alta de la atmósfera se vería inundada por un flujo de rayos X y UV de muy corta longitud de onda, diez mil veces mayor que el flujo habitual de radiación solar, lo que implica que la Tierra recibiría, en unas pocas horas, una dosis de radiación ionizante igual a la que recibe anualmente. Exposiciones de 500 roentgens son setales para la mayoría de los vertebrados y, sin embargo, los diez episodios de esta magnitud que se han podido producir en los últimos 500 millones de años no han dejado ninguna consecuencia observable en la evolución de la biosfera.

Si suponemos que una civilización avanzada podría preparar refugios para la población durante el año que transcurre ente la llegada de la luz y la llegada de la radiación cósmica, se encontraría con la inevitable dosis de 500 roentgens cada mil millones de años, tiempo suficiente para permitir el desarrollo de una sociedad cuyo conocimiento le sirviera para defenderse de un flujo tan extraordinario y de consecuencias letales.

La fotosíntesis

Todo el Oxígeno de la Atmósfera terrestre procede del oxígeno que desprenden los organismos autótrofos durante la fotosíntesis.

La fotosíntesis es el principal proceso bioquímico que consigue pasar materiales desde el biotopo hasta la biocenosis de un ecosistema. Una vez incorporados como parte de los organismos autótrofos, los heterótrofos (por ejemplo, los animales) solo tienen que aprovecharse de aquellos; con la existencia de pequeñas cantidades de agua, todo está preparado para que el ecosistema entero comience a funcionar. Además, siempre habrá animales depredadores, carnívoros, que seguirán aprovechando los materiales de otros.

La conocida ecuación básica que describe la reacción endotérmica por la cual se sintetiza una molécula de glucosa a partir de sus seis moléculas de CO2 y H2O, y 2’8 MJ de radiación solar, es una simplificadisima caja negra. Una caja negra más realista sería la siguiente:

106 CO2 + 90 H2O + 16 NO3 + PO4 + nutrientes minerales + 5’4 MJ de radiación = 3’258 g de protoplasma (106 C, 180 H, 46 O, 16 N, 1 P y 815 g de cenizas minerales) + 154 O2 + 5’35 MJ de calor disipado.

Sin macronutrientes ni micronutrientes no se puede producir fito-masa, que está compuesta por los nutrientes básicos necesarios para todos los seres heterótrofos: azúcares complejos, ácidos grasos y proteínas.

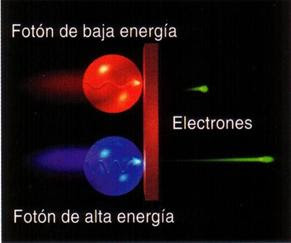

Para entender esta caja negra hay que comenzar por destacar la acción de unos pigmentos sensibles a la luz entre los cuales destacan las clorofilas. Éstas absorben la luz en dos bandas estrechas, una entre 420 y 450 nm, y la otra entre 630 y 690 nm. Así, la energía necesaria para la fotosíntesis sólo procede de la radiación azul y roja a la que corresponde menos de la mitad de la energía total de la insolación. Esta parte de la radiación fotosintéticamente activa (RFA) no se utiliza en reducir CO2, sino en la regeneración de compuestos consumidos durante la fijación del gas.

La síntesis de fitomasa en el ciclo reductor del fosfato pentosa (RPP) – un proceso con varios pasos de carboxilación por catálisis enzimática, reducción y regeneración – tiene que empezar con la formación de trifosfato de adenosina (ATP) y nicotinamida adenina dinucleótido fosfato (NADP), que son los dos compuestos que suministran energía a todas las reacciones biosintéticas. La síntesis de las tres moléculas de ATP y las dos de NADP que se necesitan para reducir cada molécula de CO2 requiere de diez cuantos de radiación solar con longitud de onda próxima al pico rojo de absorción de la clorofila (680 nm). El carbono procedente del CO2, combinado con el hidrógeno del agua y con los micronutrientes, dará lugar a nueva fitomasa que contiene 465 KJ/mol.

La cantidad de energía de un cuanto de luz roja es de 2’92×10-19 J (el producto de la constante de Planck, 6’62×10-34 por la frecuencia de la luz, que a su vez es el cociente entre la velocidad de la luz y la longitud de onda).

Un einstein (definido como un mol o número de Avogadro, 6’02×1023) de fotones rojos tiene una energía aproximadamente igual a 17 Kg. Suponiendo que la RFA es el 45% de la luz directa, la eficiencia global de la fotosíntesis es del 11%, que equivale a 456/(1.760/0’43). Esta eficiencia se reduce por lo menos en una décima parte más si tenemos en cuenta la reflexión de la luz en las hojas y la pérdida que supone atravesar la cubierta vegetal. Ninguna planta, sin embargo, se acerca siquiera a esta eficiencia teórica, porque parte de la luz absorbida por las clorofilas (generalmente, el 20 – 25 por ciento) vuelve a ser emitida en forma de calor, debido a que los pigmentos no pueden almacenar la luz y las reacciones enzimáticas no se producen con suficiente velocidad como para utilizar completamente el flujo de energía incidente. En la respiración se cede el carbono fijado en el metabolismo de la planta y en el mantenimiento de las estructuras que la soportan.

Mosaico de nuestro planeta Tierra que recibe una fracción de la energía solar

Para cada especie, la tasa con la que se pierde carbono está determinada principalmente por el tipo de fotosíntesis. Así, existen diferencias sustanciales entre las plantas C3 y C4. La respiración a escala de una comunidad o ecosistema depende del estado de crecimiento, y varía entre menos del 20 por ciento en plantas jóvenes en rápido crecimiento, hasta más del 90 por ciento en bosques maduros.

Con una pérdida del 25 por ciento para la reacción, y otro tanto para la respiración, la eficiencia fotosintética es ligeramente superior al 5 por ciento. En este punto, las estimaciones teóricas y los valores reales coinciden, ya que el valor medio de fotosíntesis neta en plantas muy productivas y en condiciones óptimas y durante cortos periodos de tiempo, oscila entre el 4 y el 5 por ciento. La mayoría de las plantas rinden en función de los nutrientes, especialmente nitrógeno y agua, o por las bajas temperaturas en las regiones de mayor altura y latitud. Los mejores rendimientos en sistemas naturales muy productivos, como los humedales y los cultivos, están entre el 2 y el 3 por ciento. En otros ecosistemas, como los pantanos tropicales templados y los bosques templados, el rendimiento de la transformación es del 1’5 por ciento, y en las praderas muy áridas sólo del 0’1 por ciento. Globalmente, la producción anual es, al menos, de 100.000 millones de toneladas de fitomasa, que se sintetizan con un rendimiento medio del 0’6 por ciento.

Mapa de clorofila en los océanos

La fotosíntesis en los océanos, muy afectada por la escasez de nutrientes, es incluso menos eficiente. La productividad medie es de poco más de 3 MJ/m2 y se realiza con un rendimiento fotosintético del 0’06 por ciento. La media ponderada total es 0’2 por ciento, es decir, que sólo uno de cada 500 cuantos de energía solar que llega a la superficie de la Tierra se transforma en energía de biomasa en forma de tejido vegetal.

La mayor parte de esta energía se almacena en forma de azúcares simples, que contienen más energía, y que sólo se encuentran en las semillas.

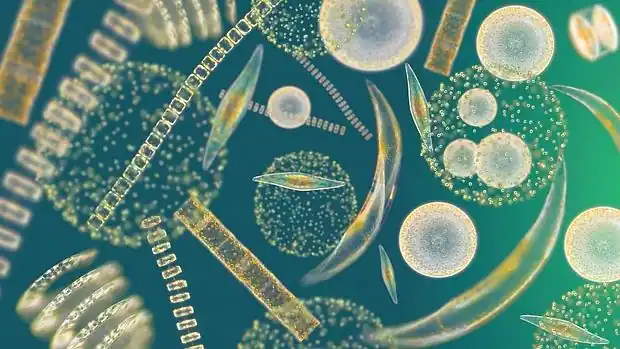

La mayor parte de la fitomasa está en los bosques. En los océanos, los principales productores son los organismos que componen el fitoplancton, que son muy pequeños y flotan libres. Su tamaño varía entre algo menos de 2 y 200 μm de diámetro y están formados por cantidades variables de bacterias y protoctistas eucarióticos. Las cianobacterias cocoides son tan abundantes en algunas aguas oligotrópicas que pueden ser las responsables de la mayor parte de la producción de fitoplancton.

Los protoctistas fotosintetizadores varían entre los más pequeños flagelados pigmentados (como las criptomonas y crisofitos), hasta las diatomeas y dinoflagelados, que son mayores (más de 10 mm) y generalmente dominantes. Las diatomeas están formadas por células sin flagelos, con paredes de silicio amorfo mezclados con otros compuestos orgánicos. Presentan una sorprendente y amplia variedad de diseño, desde las que tienen simetría central (las de forma radial son las dominantes en el océano), a las pennadas (simetría lateral), y otras forman largas cadenas.

La productividad de fitoplancton está controlada por la temperatura del agua y por la disponibilidad de radiación solar y nutrientes. La temperatura no es determinante, porque muchas especies son muy adaptables y consiguen una productividad similar en distintos ambientes. Aunque es frecuente la adaptación a diferentes condiciones lumínicas, tanto el volumen como en contenido en clorofila de las diatomeas aumenta con la intensidad de la luz. En el mar abierto, la mayor limitación es la cantidad de nutrientes disponibles.

Entre las carencias que más limitan la producción de fitoplancton está la de nitrógeno, el macro-nutriente más importante, la de fósforo, y la de algunos otros micronutrientes clave como el hierro y el silicio.

Los medios menos productivos de la Tierra están en la capa superficial y la capa inmediatamente inferior de los océanos. En el mar abierto, las concentraciones más altas de nutrientes se encuentran entre los 500 y los 1.000 metros, a bastante más profundidad que la zona eufórica, capa en la que penetra la luz solar y que se extiende a unos 100 metros en las aguas transparentes.

El pequeñísimo tamaño de los productores dominantes es una adaptación eficaz a la escasez de nutrientes, ya que cuanto mayor sea el cociente entre la superficie y el volumen, y más lento el hundimiento de las células de fitoplancton en la capa eufórica, mayor es la tasa de absorción de nutrientes.

Cuando las corrientes elevan a la superficie las aguas frías y cargadas de nutrientes, la producción de fitoplancton aumenta sustancialmente. Las aguas costeras de Perú, California, noroeste y sudoeste de África, y de la India occidental son ejemplos destacados de ascensión costera de aguas frías. También se dan casos de ascensión mar adentro en la mitad del Pacífico, cerca del ecuador y en las aguas que rodean la Antártida. Otras zonas altamente productivas se encuentran en las aguas poco profundas cercanas a la costa que están enriquecidas por el aporte continental de nutrientes. Este enriquecimiento, con una proporción N/P muy descompensada, es especialmente elevados en los estuarios adonde van a parar grandes cantidades de aguas residuales y fertilizantes.

Las diferentes medidas de la productividad en las aguas oligotróficas de los mares subtropicales y de las aguas eutróficas con corrientes ascensionales, varían entre menos de 50 gC/m2 y 1 gC/m2, más de un orden de magnitud. Las estimaciones de la producción global de fitoplancton están comprendidas entre 80.000 y 100.000 millones de toneladas, que representan entre dos tercios y cuatro quintos de la fitomasa total terrestre. Contrasta con el resultado anterior el hecho de que, dado el corto periodo de vida del fitoplancton (1 – 5 días), la fitomasa marina represente sólo una pequeña fracción de todo el almacenamiento terrestre.

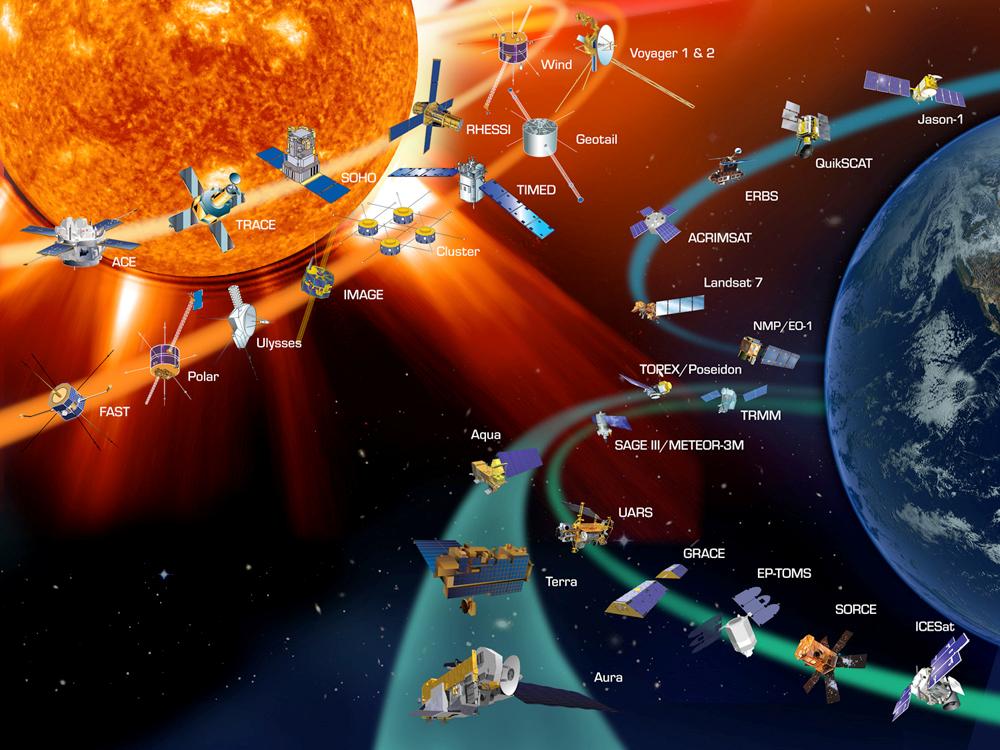

La distribución espacial del fitoplancton muestra zonas delimitadas que se extienden a escala local y global. La exploración desde los satélites es, con gran diferencia, la que permite detectar con mayor precisión las concentraciones de clorofila y la que ha posibilitado obtener las pautas de la distribución de fitoplancton. En las aguas que rodean la Antártida se observa claramente una distribución asimétrica en dos bandas casi concéntricas. La mejor distribución se explica por el hecho de que se deba a corrientes circumpolares y a la abundancia de ácido silicílico. Pero las zonas de mayor riqueza de fitoplancton se encuentran cerca de los continentes donde los ríos arrastran abundantes nutrientes disueltos.

La vida necesita un aporte continuo de energía que llega a la Tierra desde el Sol y pasa de unos organismos a otros a través de la cadena trófica.

El fitoplancton es la base energética de las intrincadas pirámides tróficas. Las cadenas alimenticias en el océano, generalmente, son redes complicadas. Una gran parte de la fito-masa disponible no la consumen directamente los herbívoros, sino que primero se almacena en depósitos de materia muerta que, transformada por bacterias, se convertirá en alimento para otros seres heterótrofos.

La gran producción de fitoplancton puede alimentar grandes cantidades de zoo-masa. El kril, pequeños crustáceos parecidos a las quisquillas que se alimentan de diatomeas, son los organismos más abundantes en la superficie del mar; sus densas acumulaciones pueden contener hasta mil millones de individuos y su producción anual de zoo-masa quizá llegue hasta los 1.300 millones de toneladas. Esta prodigiosa cantidad de zoo-masa sirve de alimento a focas, calamares y peces, así como a los mayores carnívoros de la biosfera, las especies de ballenas con barbas que se alimentan filtrando el agua.

emilio silvera

Dic

31

Fuerzas invisibles que inciden en nuestras vidas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencias de la Tierra ~

Clasificado en Ciencias de la Tierra ~

Comments (0)

Comments (0)

Entradas anteriores

Las corrientes de convección son movimientos que describen los fluidos. Cuando éstos se calientan, se dilatan y ascienden. Al llegar esos materiales a la corteza terrestre se enfrían debido a que esta capa tiene una baja temperatura. Al enfriarse los materiales, se contraen y descienden hasta alcanzar el núcleo de la Tierra, donde el proceso volverá a comenzar.

Toda esta energía térmica actúa sobre los materiales provocando el movimiento de estos, generando elevadas presiones que llevan a transformaciones en la estructura de los materiales. En ocasiones, estas presiones se liberan bruscamente. Todos hemos podido contemplar las consecuencias devastadoras de tales acontecimientos.

El placer de Descubrir: Aventurarse por nuevos caminos.

“Quien ha visto las cosas presentes ha visto todo, todo lo ocurrido desde la eternidad y todo lo que ocurrirá en el tiempo sin fin; pues todas las cosas son de la misma clase y la misma forma”.

Marco Aurelio

Claro que él, quería significar que todo, desde el comienzo del mundo, ha sido igual, sigue unos patrones que se repiten una y otra vez a lo largo del transcurso de los tiempos: el día y la noche, el hombre y la mujer, el frío y el calor, el río muerto por la sequía o aquel que, susurrante y rumoroso ve correr sus aguas cristalinas hasta que desembocan en el océano. La Bondad y la maldad…Así ha sido siempre y, así continuará siendo por toda la eternidad.

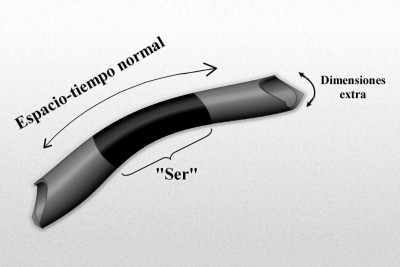

Sólo vamos a ser conscientes de dimensiones extra allí donde inciden directamente sobre las D-brana en la que “vivimos”. Más que una imagen de tipo “espacio cociente” que evoca la analogía de Kaluza-Klein original:

El gráfico representa un modelo de manguera de un espacio-tiempo de dimensiones más altas de tipo Kaluza-Klein, donde la longitud, o mejor, la dimensión a lo largo de la longitud de la manguera representa el 4-espacio-tiempo normal, y la dimensión alrededor de la manguera representa la dimensión extra “pequeñas” (quizá escala de Planck). Imaginemos un “ser” que habite en este mundo, que rebasa estas dimensiones extra “pequeñas”, y por ello no es realmente consciente de ellas.

Los campos magnéticos nos mantienen a salvo de la radiación peligrosa para la vida

Es ampliamente sabido que el planeta Tierra actúa como un gran imán cuyas líneas de campo geomagnético surgen de un polo (el polo sur magnético) y convergen en el otro polo (polo norte magnético). El eje longitudinal de este imán tiene una desviación de aproximadamente 11^o con respecto al eje de rotación. Por ello, los polos del campo magnético generado no coinciden exactamente con los polos geográficos.

Este campo geomagnético es producido por la combinación de varios campos generados por diversas fuentes, pero en un 90% es generado por la exterior del núcleo de la Tierra (llamado Campo Principal o “Main Field”).

Por otra , la interacción de la ionosfera con el viento solar y las corrientes que fluyen por la corteza terrestre componen la mayor del 10% restante. Sin embargo, durante las tormentas solares (eventos de actividad solar exacerbada) pueden introducirse importantes variaciones en el campo magnético terrestre.

Las grandes tormentas solares inciden sobre nosotros y nuestras obras

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

Muchas veces he comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisenberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el Espacio y en el Tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

Lo podríamos representar de cualquier manera, ya que, su cara nos es desconocida. El Gravitón es la única partícula mediadora de una fuerza (en este caso de la Gravedad), que no ha sido encontrada en ningún experimento. Sin embargo, todos los físicos creen que existe… ¡Dónde se esconde el puñetero!

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la Relatividad Especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

¿Quién alcanza a los fotones? y, ¿Cómo ver los electrones orbitando el núcleo atómico?

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio da a entender, no hay carga eléctrica; es neutro.

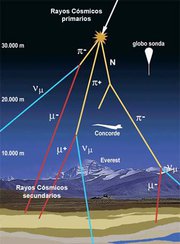

“Como esta unidad es muy pequeña para representar la energía que tienen las partículas que impactan la Tierra se usan múltiplos, como el Mega–electronvoltio (MeV). Un MeV es un millón de veces un electronvoltio y representa mejor la energía que tienen las partículas al impactar la Tierra.”

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10–15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

Son muchas y una de las fuentes productoras de rayos cósmicos es el Sol

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

emilio silvera

Jul

16

Nuestro Planeta: ¡Es tan complejo!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencias de la Tierra ~

Clasificado en Ciencias de la Tierra ~

Comments (1)

Comments (1)

Nuestro planeta, como nosotros mismos, está hecho de Agua y Luz

“La biósfera o biosfera1 es el sistema formado por el conjunto de los seres vivos del planeta Tierra y sus interrelaciones (influyen tanto los organismos en el medio, como el medio sobre los organismos).2 Este significado de «envoltura viva» de la Tierra, es el de uso más extendido, pero también se habla de biósfera, en ocasiones, para referirse al espacio dentro del cual se desarrolla la vida. Su origen se remonta, al menos, a 3500 millones de años atrás32

La biosfera es el ecosistema global. Al mismo concepto se refiere con otros términos, que pueden considerarse sinónimos, como ecosfera o biogeosfera. Tiene características que permiten hablar de ella como un gran ser vivo, con capacidad para controlar, dentro de unos límites, su propio estado y evolución.”

“En las ciencias de la Tierra, la hidrosfera o hidrósfera1 (del prefijo hidro-, este del prefijo griego ὑδρο- [hydro], ‘agua’, y del griego σφαῖρα [sfaira], ‘esfera’) es el sistema material constituido por el agua que se encuentra sobre la superficie de la tierra sólida, y también parte de la que se encuentra bajo la superficie, en la corteza terrestre.

La hidrosfera incluye océanos, mares, ríos, lagos, agua subterránea, el hielo y la nieve.

La Tierra es el único planeta del sistema solar en el que está presente de manera permanente el agua líquida, que cubre aproximadamente tres cuartas partes de la superficie terrestre,con una profundidad promedio de 3,5 km, lo que representa el 97 % del total de agua del planeta. El agua dulce representa 3 % del total y de esta cantidad aproximadamente 98,2 % está congelada, de ahí que solo se tenga acceso al 0,08 % de toda el agua del planeta.”

La Biosfera y la Hidrosfera están estrechamente relacionadas: el agua es el elemento esencial de todas las formas de vida, y la distribución del agua en el planeta (es decir, los límites de la hidrosfera) condiciona directamente la distribución de los organismos (los límites de la biosfera). El término biosfera, de reciente creación, indica el conjunto de zonas de la Tierra donde hay vida, y se circunscribe a una estrecha región de unos 20 Km de altura comprendida entre las cimas montañosas más elevadas y los fondos oceánicos más profundos. Sólo pueden hallarse formas de vida en la biosfera, donde las condiciones de temperatura, presión y humedad son adecuadas para las más diversas formas orgánicas de la Tierra.

Obviamente, las fronteras de dicha “esfera” son elásticas y su extensión coincide con la de la hidrosfera; se superpone a las capas más bajas de la atmósfera y a las superficiales de la litosfera, donde se sumerge, como máximo, unos 2 Km. Sin embargo, si por biosfera se entiende la zona en la que hay vida así como la parte inorgánica indispensable para la vida, deberíamos incluir en este concepto toda la atmósfera, sin cuyo “escudo” contra las radiaciones más fuertes no existiría ningún tipo de vida; o la corteza terrestre entera y las zonas superiores del manto, sin las cuales no existiría la actividad volcánica, que resulta necesaria para enriquecer el suelo con nuevas sustancias minerales.

Por tanto, la biosfera es un ecosistema tan grande como el planeta Tierra y en continua modificación por causas naturales y (desgraciadamente) artificiales.

Las modificaciones naturales se producen a escalas temporales muy variables: en tiempos larguísimos determinados por la evolución astronómica y geológica, que influyen decididamente en las características climáticas de los distintos ambientes (por ejemplo, durante las glaciaciones), o en tiempos más breves, relacionados con cambios climáticos desencadenados por sucesos geológicos-atmosféricos imprevistos (por ejemplo, la erupción de un volcán, que expulsa a la atmósfera grandes cantidades de cenizas capaces de modificar el clima de extensas áreas durante periodos considerables).

Feb

15

Es bueno hacerse preguntas y, tratar de contestarlas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencias de la Tierra ~

Clasificado en Ciencias de la Tierra ~

Comments (1)

Comments (1)

¿Qué le sucedería a todo el Oxígeno altamente reactivo de la atmósfera terrestre si no fuera renovado constantemente por la acción de los seres vivos que pueblan el planeta Tierra? Si elimináramos toda la vida que hay en el planeta, en muy poco tiempo la totalidad del Oxigeno quedaría bloqueado dentro de compuestos químicos estables, tales como los nitratos, el dióxido de Carbono, el agua, los óxidos de hierro y las rocas siliceas. Dicho de una forma más precisa, sin la intervención de la vida, todo el Oxígeno de la atmósfera quedaría bloqueado en menos de 10 millones de años. Esto indica lo sensible que es el entorno físico aparentemente estable de nuestro planeta a la presencia (0 ausencia) de la vida.

La Tierra se podría quedar sin Oxígeno si las temperaturas aumentan algunos grados más. El fitoplancton, los organismos vegetales que viven en suspensión dentro del agua y originan las dos terceras partes del oxígeno presente en la atmósfera, sería incapaz de gestionar tal incremento

El tema no resulta demasiado preocupante a una escala de Tiempo Humana -el mito popular según el cual, si mañana desapareciera la Selva Amazónica, nos asfixiaríamos todos, está lejos de ser verdad- pero diez millones de años representan sólo alrededor del 0,2 por ciento de la antigüedad de la Tierra hasta el momento presente.

Si un Astrónomo que está observando un planeta como la Tierra constata que dicho planeta posee una atmósfera rica en Oxígeno, esto significa que, o bien está siendo testigo de un suceso raro y transitorio qque por razones desconocidas tiene lugar en ese planeta, o que la atmósfera se mantiene en un estado que se encuentra lejos del equilibrio.

La Vida es parte de la Tierra y ésta, es como es, porque en ella está la Vida.

La idea de que la Vida puede formar parte de un sistema autoregulador que determina la naturaleza física de la superficie actual de la Tierra (al menos en la “zona de la vida” una fina capa que va desde el fondo del océano hasta la parte más alta de la troposfera, es decir, hasta unos 15 kilómetros por encima de nuestras cabezas) fue recibido inicialmente de manera hostíl por los biólogos, y aún hoy continúa teniendo algunos oponentes.

Bueno, como de todo tiene que haber, también existen algunos movimientos místicos, cercanos a una especie de religión, a favor de Gaia (que por cierto, irritaron a Lovelock como lo hizo la Tolkien Society para J.R.R. Tolkien), que se fundamenta en una mala interpretación de lo que Lovelock y sus colegas decían. La misma Enciclopedía Británica (una copia en CD) -que debería estar mejor documentada- me dice que: “La hipótesis e Gaia es muy discutible porque da a entender que cualesquiera especies (por ejemplo, las antiguas bacterias anaerobias) podrían sacrificarse así mismas en beneficio de todos los seres vivientes”

¡Desde luego eso no es así! Esta afirmación tiene la misma lógica que decir que la teoría de Darwin es muy discutible porque sugiere que los conejos se sacrifican así mismo en beneficio de los zorros. Quizá os tenga que explocar que Lovelock no dijop nunca que Gaia sea una especie de dios, ni que la Madre Tierra cuide de nosotros, ni que una especie haga sacrificio en el bien de todos.

La verdad de todo esto es que Lovelock encontró una manera simple de describir todos los procesos relativos a la Vida que tienen lugar en la Tierra, incluídos muchos que tradicionalmente se han considerado procesos físicos no relacionados con la vida, como parte de una compleja red de interacciones, un sistema autoregulador (o autoorganizador), que ha evolucionado hasta llegar a un estado interesante, pero crítico, en el cual se puede mantener el equilibrio durante períodos de tiempo que resultan muy largos con rspecto a los estándares humanos, pero en el que pueden ocurrir unas fluctuaciones repentinas que lo aparten del equilibrio (análogo al equilibrio discontinuo de la evolución biológica).

Lo que Lovelock nos dice es que, el comportamiento de la Vida en la Tierra altera el paisaje físico (en el término “físico” incluye cuestiones tales como la composición de la atmósfera) y también el paisaje biológico, y que ambos cambios afectan de manera global al paisaje adaptativo, siendo la retroalimentación un componente clave de las interacciones.

El conjunto Sol-Tierra-Vida forman el mejor triplete

No creo que sea necesario contar ahora toda la historia completa de cómo Gaia llegó a ser ciencia respetable, pero, si miramos retrospectivamente, podríamos tomar dos ejemplos del funcionamiento de esta teoría: Uno de ellos sería un modelo teórico y el otro sería tomado del mundo real, que muestran de qué modo se produce la autorregulación a partir de la interacción entre los componentes biológicos y físicos de un planeta vivo.

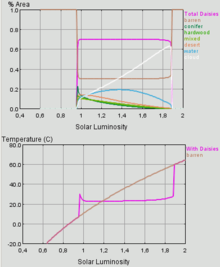

El primero, un modelo llamado “Daisywold” (“Un mundo de margaritas”), es especialmente apropiado ya que se construye directamente a partir de un enigma que Sagan planteó a Lovelock poco después de que éste tuviera su ráfaga de inspiración en el JPL, y además, el modelo resuelve este enigma; es también un claro ejemplo del surgimiento de la vida, considerando que el total es mayor que la suma de las partes. Y Lovelock dice que es “el invento del que me siento más orgulloso”.

El enigma que el mundo de margaritas resuelve se conoce entre los astrónomos como la “paradoja del joven Sol que palidece”, aunque en realidad sólo era un enigma, no una paradoja, y, gracias a Lovelock, ahora ya ni siquiera es un enigma. El enigma procede del hecho de que los astrónomos pueden decir que el Sol emitía mucho menos calor cuando era joven que en el momento actual.

Han llegado a saber esto combinando informaciones relativas a interacciones nucleares obtenidas en experimentos realizados en la Tïerra, simulando mediante ordenador las condiciones existentes en el interior de las estrellas, y comparando los resultados de sus cálculos con informaciones sobre emisión de energía y la composición de estrellas de diferentes tamaños y edades, obtenidas mediante espectroscopia. Este es uno de los grandes logros de la Físiica del siglo XX (en gran medida no conocido por el público, aunque en éstas páginas os he hablado con frecuencia de Franhoufer…). Bueno, para lo que nos interesa ahora, lo importante es que podemos decir con seguridad que, cuando el Sistema solar era joven, el Sol estaba entre un 25 y un 30 por ciento más frío que en la actualidad -o, por decdirlo de otra manera, desde que se asentó como una estrella estable, la emisión de energía procedente del Sol ha crecido entre un 33 y un 43 por ciento-.

El Sistema solar se estabilizó en lo que es más o menos su configuración actual hace aproximadamente unos 4.500 millones de años y sabemos, por las pruebas que aportan los fósiles hallados en las rocas más antiguas que se encuentran en la superficie terrestre, que el agua en estado líquido y la vida existían ambas en la superficie de nuestro planeta hace 4.000 millones de años.

El enigma es por qué el aumento de emisión de calor procedente del Sol, aproximadamente un 40 por ciento durante 4.000 millones de años, no hizo hervir el agua de la superficie terrestre, secándola y dejándola sin rastro de vida.

No hay problema alguna para explicar por qué la Tierra nmo era una bola de hielo cuando el Sol estaba más bien frío, Sabemos ahora que en la atmósfera de Venus, como en la de Marte, predonina el dióxido de Carbono, y este compuesto, junto con el vapor de agua, es una parte importante de los gases liberados por la actividad volcánica. No hay razón alguna para pensar que la atmósfera de la Tierra en los primeros tiempos fuera, de algún modo, diferente de las atmósferas de sus dos vecinos planetarios más próximos, y una atmósfera rica en dióxido de Carbono sería buena para captar el calor procedente del Sol en las proximidades de la superficie del planeta, manteniendola caliente por el llamado efecto invernadero.

Un astrónomo que se pudiera en la superficie de Marte, provisto de un buen telescopio y un espectrómetro de sensibilidades adecuadas, podría asegurar, midiendo la radiación infrarroja característica, que había un rastro de dióxido de Carbono en la atmósfera de la Tierra, de la misma manera que equipos aquí, en la Tierra, lo han detectado en la atmósfera de Marte. Pero la proporción del dióxido de Carbono en la Tierra es mucho menor que en la de Marte,

La potencia del efecto invernadero se puede ver contrastando la temperatura media que se da en la actualidad en la superficie terrestre con la de la Luna, que no tiene aire, aunque está prácticamente a la misma distancia del Sol que nosotros.

En realidad es bastante sencillo imaginar diversos modos en los que la temperatura del planeta ha podido mantenerse constante gracias a cambios en la composición de la atmósfera; científicos como Carl Sagan formuló varios razonamientos al respecto antes de que Lovelock presentara su concepto de Gaia, pero, ¿quer proceso natural podía conducir a la estabilidad? Nadie lo sabía. Entonces, ¿era sólo cuestión de suerte?. Sea lo que sea lo cierto es que, debemos procurar, a medida que la Tierra envejece, tratar de reducir de manera continuada, la emisión de gases que provoquen un efecto invernadero desmesurado y nosivo para la vida.

Las primeras formas de vida terrestre basadas en la fotosíntesis (aquellas antiguas bacterias anaerobias) habrían tomado dióxido de Carbono del aire y lo habrían utilizado para formar sus cuerpos, pero habrían emitido metano al aire, con lo que el dióxido quedaría sustituido por otro gas, también de efecto invernadero, pero con unas propiedades de absorción de infrarrojos distintas de las del dióxido de Carbono. Cuando estas bacterias son más activas, el equilibrio se descompensan a favor del metano; cuando son menos activas, el equilibrio se decanta a favor del dióxido de Carbono.

La clave para empezar a comprender como podía funcionar todo esto en la Naturaleza fue la introducción de una percepción retrospectiva en los cálculos. Con un sencillo modelo que tenía en cuenta la creciente producción de calor del Sol. Lovelock pudo demostrar que, si se permite que las bacterias aumenten a una velocidad máxima cuando la temperatura es de 25 ºC, pero con menos rapidez a temperaturas superiores o inferiores y, en ningún caso, cuando las temperaturas bajan de 0 ºC o superar los 50 ºC, se podría mantener la temperatura constante durante más o menos los primeros mil millones de años de la historia de la Tierra.

Entonces se pondrían en marcha otros procesos, principalmente el surgimiento de formas de vida que emitían oxígeno al aire, donde este elemento reaccionaria con el metano para eliminar de la red este componente, y también la disminución gradual de las concentraciones de dióxido de Carbono a través de los tiempos. Se puede hacer funcionar todo ello de una manera plausible, Sin embargo, el sistema (¿cómo no?) recibió algunas críticas. Y, aquí fue precisamente donde entró en escena Daisyworld.

Salidas de una simulación informática sencilla de un mundo de margaritas, en las que se aprecia la homeostasis que la biota es capaz de sostener en un cierto rango de temperatura.

Inicialmente Daisyworld fue un modelo desarrollado por Lovelock y sus colegas a principios de la década de los 80 y, desde entonces, ha cobrado vida por sí mismo (quizá adecuadamente), con variaciones sobre el tema que han sido desarrolladas por varios científicos, e incluso, en la década de 1990, se ha integrado en un juego de ordenador llamado Sim Eaurth.

Daisyworld comienza como un planeta igual que la Tierra, pero sin vida, que recorre una órbita alrededor del Sol, a la misma distancia que lo hace la Tierra. En las versiones más sencillas del modelo, la superficie del planeta es principalmente tierra firme, con el fin de ofrecer un lugar donde puedan crecer las margaritas, y la composición de la atmósfera se mantiene constante, por lo que hay un efecto invernadero constante. Las margaritas se presentan en dos colores, blancas o negras, y crecen cuando la temperatura es de 20 ºC. Les va proporcionalmente peor cuando la temperatura desciende por debajo de este valor óptimo, y no pueden crecer por debajo de 5 ºC; también les va peor en proporción cuando la temperatura asciende por encima del valor óptimo, y no consigue crecer por encima de 40 ºC.

El modelo se pone a funcionar cuando la temperatura del Sol virtual aumenta lentamente del mismo modo que lo hacía el Sol real en su juventud. Una vez que la temperatura en el ecuador de la Tierra del modelo alcanza los 5 ºC, se diseminan semillas de margarita de ambas variedades por la superficie y se deja que actúen por su cuenta -con la condición de que se reproduzcan de verdad, de tal modo que las margaritas blancas tengan siempre descendencia blanca y las margaritas negras produzcan siempre otas también negras.

Como ya sabe cualquiera que haya subido a un coche negro que ha estado aparcado al Sol en verano, los objetos de colores oscuros absorben el calor del Sol con mayor eficacia que los objetos de colores blancos. Por lo tanto, un macizo de margaritas negras absorberá calor y calentará la pequeña superficie en la que se encuentre, mientras que un macizo de margaritas blancas reflejará el calor y refrescará la tierra sobre la que está plantado.

Mientras Daisyworld está freco, las margaritas negras tienen una ventaja, ya que calientan su entorno, llevando la temperatura a un valor cercano al óptimo, y crecen. En las generaciones siguientes, las margaritas negras se propagan por la superficie del planeta a expensas de las blancas, de tal modo que todo el planeta se vuelve más eficaz para absorber el calor procedente del Sol, y su temperatura asciende aún más rápidamente que si lo hiciera sólo como resultado del aumento de la temperatura del Sol. Sin embargo, una vez la temperatura supera los 20 ºC en cualquier lugar de la superficie terrestre del modelo, son las margaritas blancas las que tienen ventaja, porque al refrescar la superficie hacen que la situación vuelva a tender a la temperatura óptima.

Aunque la temperatura del Sol continúe aumentando, dado que ahora las margaritas blancas se propagan a expensas de las negras, la temperatura del planeta ha quedado rondando los 20 ºC hasta que toda la superficie planetaria queda cubierta de margaritas blancas. Entonces, como la temperatura del Sol sigue aumentando, las margaritas lo tienen cada vez más difícil, hasta que la temperatura alcanza los 40 ºC y mueren todas. La gama total de producción de energía solar que cubre esta versión del modelo va desde el 60 por ciento hasta el 140 por ciento de la producción actual de energía de nuestro Sol.

El efecto global es que durante un largo período de tiempo, aunque la producción de calor del sol del modelo aumenta, la temperatura de la Tierra del modelo no sólo permanece constante, sino que se mantiene en la temperatura óptima para la vida -sin que las margaritas hagan ninguna planificación consciente, y sin indicios de que otra clase de margaritas “se esté sacrificando así misma” en beneficio de todos los seres vivos-. Ambas variedades actúan sólo en su propio interés. Pero, ¿puede un sistema muy sencillo, como éste, ser realmente representativo del modo en que la Naturaleza actúa en realidad?

Bueno, unas de las cosas que no me gustan de este modelo es que no permite que las margaritas evolucionen y que, por ejemplo, unas margaritas incoloras aparecieran por mutación y pudieran invadir todo el planeta en detrimento de las otras dos especies…Hay otras muchas posibilidades que el modelo deja fuera.

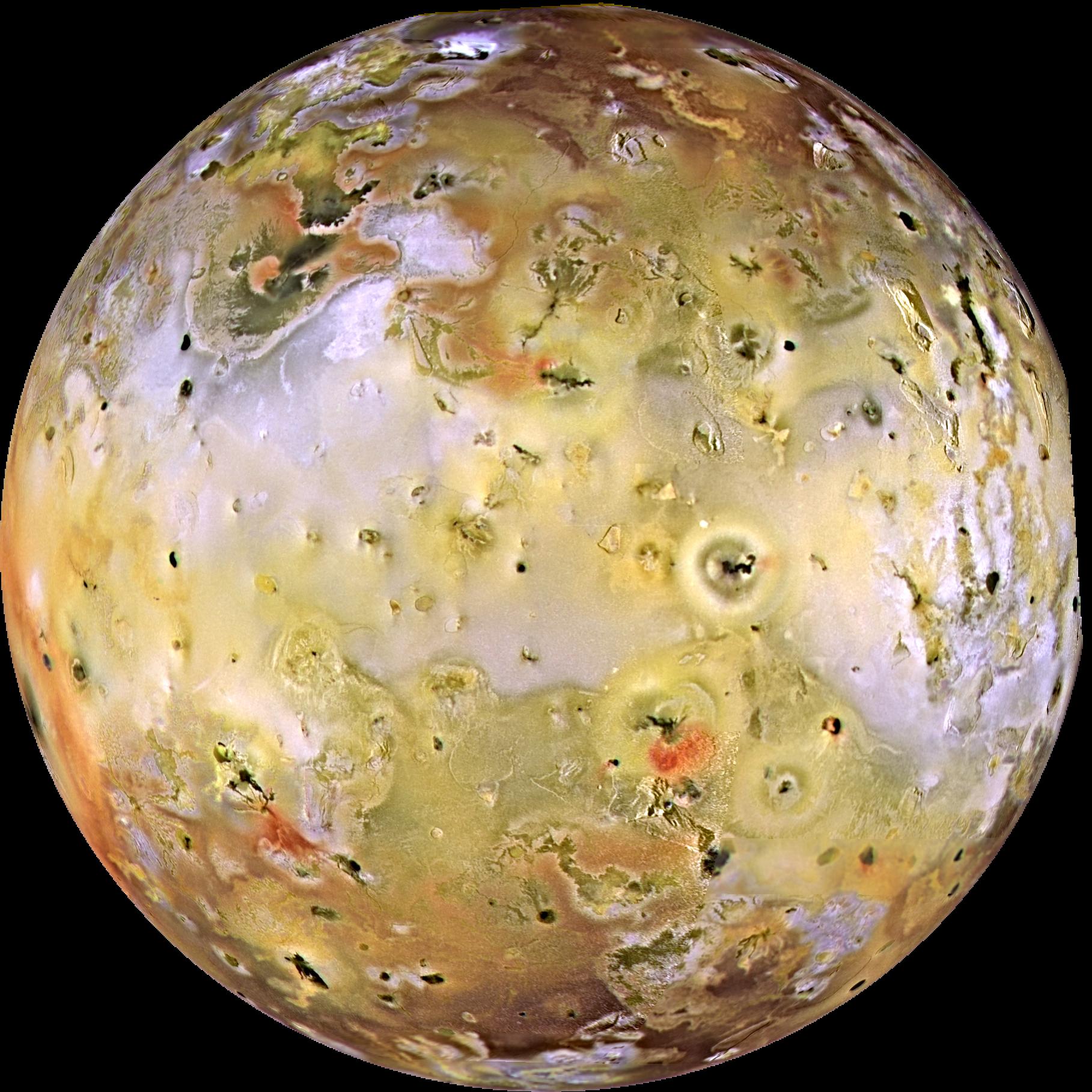

Esto es largo y, nos llevaría todo el día pero, lo que vengo a significar es que, el equilibrio Tierra-Vida es una fina línea que, en cualquier momento podemos romper y, si no andamos con cuidado podríamos ser los causantes de que, la simbiosis actual que existe entre la vida y el planeta se rompa y todo se vaya al traste…¿Qué pasó en Marte? La verdad es que nadie lo saber pero, si antes era como la Tierra y ahora, es como lo podemos ver…algo pasaría y, lo mejor es que no ocurra aquí lo mismo.

emilio silvera

Nov

25

Fuerzas invisibles que inciden en nuestras vidas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ciencias de la Tierra ~

Clasificado en Ciencias de la Tierra ~

Comments (0)

Comments (0)

Es ampliamente sabido que el planeta Tierra actúa como un gran imán cuyas líneas de campo geomagnéticosurgen de un polo (el polo sur magnético) y convergen en el otro polo (polo norte magnético). El eje longitudinal de este imán tiene una desviación de aproximadamente 11^o con respecto al eje de rotación. Por ello, los polos del campo magnético generado no coinciden exactamente con los polos geográficos.

Este campo geomagnético es producido por la combinación de varios campos generados por diversas fuentes, pero en un 90% es generado por la exterior del núcleo de la Tierra (llamado Campo Principal o “Main Field”).

Por otra , la interacción de la ionosfera con el viento solar y las corrientes que fluyen por la corteza terrestre componen la mayor del 10% restante. Sin embargo, durante las tormentas solares (eventos de actividad solar exacerbada) pueden introducirse importantes variaciones en el campo magnético terrestre.

Las grandes tormentas solares inciden sobre nosotros y nuestras obras

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

![[stephan_quinteto_2009_hubble.jpg]](http://3.bp.blogspot.com/_xBXZbW6ivIs/SqpvjP3SBJI/AAAAAAAAEqc/fh3ULAFurbs/s1600/stephan_quinteto_2009_hubble.jpg)

Muchas veces he comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

La gravedad está relacionada con la masa del cuepo, y, en una singularidad es inmensa, mientras que, en otros cuerpos (como la luna y la Tierra) es más moderada. Entre partículas es imperceptible.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10–15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

Una de las fuentes productoras de rayos cósmicos son las estrellas

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

emilio silvera

Totales: 75.497.183

Totales: 75.497.183 Conectados: 45

Conectados: 45