Feb

5

Cosas de la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡La Física! Esa maravilla que está presente en todo lo que podemos ver y en aquello donde la vista no llega. La infinitud de las partículas elementales que forman todo cuanto existe en la Naturaleza, no siempre se dejan ver ni hacen posible que podamos observar las maravillas que pueden llevar a cabo,

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos, y, si está conformada por distintos átomos, son compuestos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

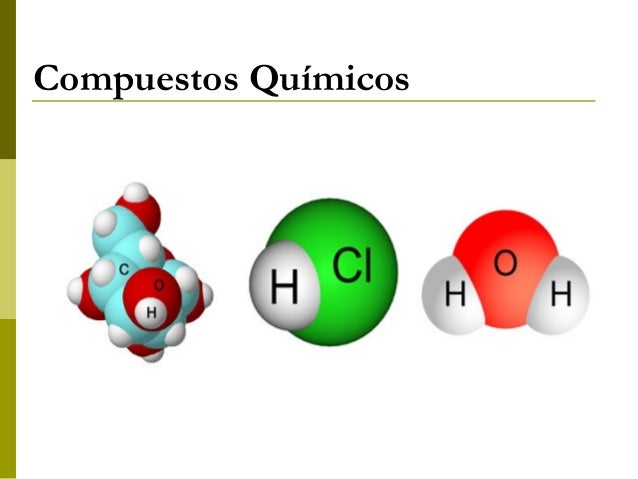

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su forma esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.8836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos hacia el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, para lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Claro que, no debemos olvidarnos de que, ¡Todo lo grande está hecho de cosas pequeñas! Una inmensa galaxia se conforma de un conjunto inmenso de átomos inifinitesimales que juntos, hace ese gran todo.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. Cuando uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

La perfecta sincronía Está en la Naturaleza

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

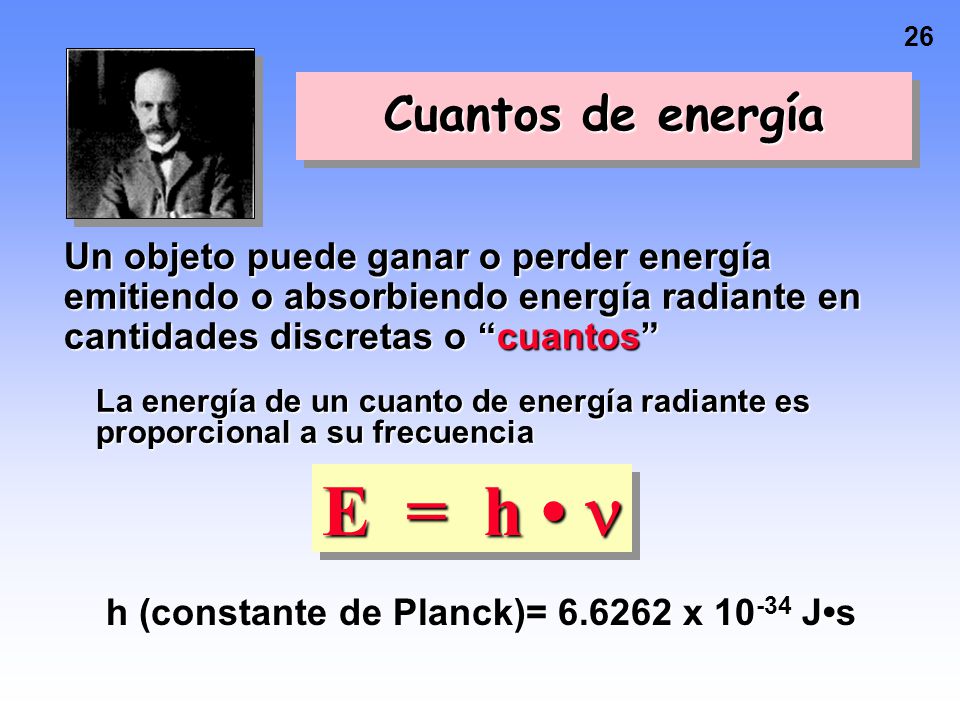

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

Donde E es la energía del paquete, v la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Los cuantos de energía están presentes en todos los objetos de materia que los emiten o absorben

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

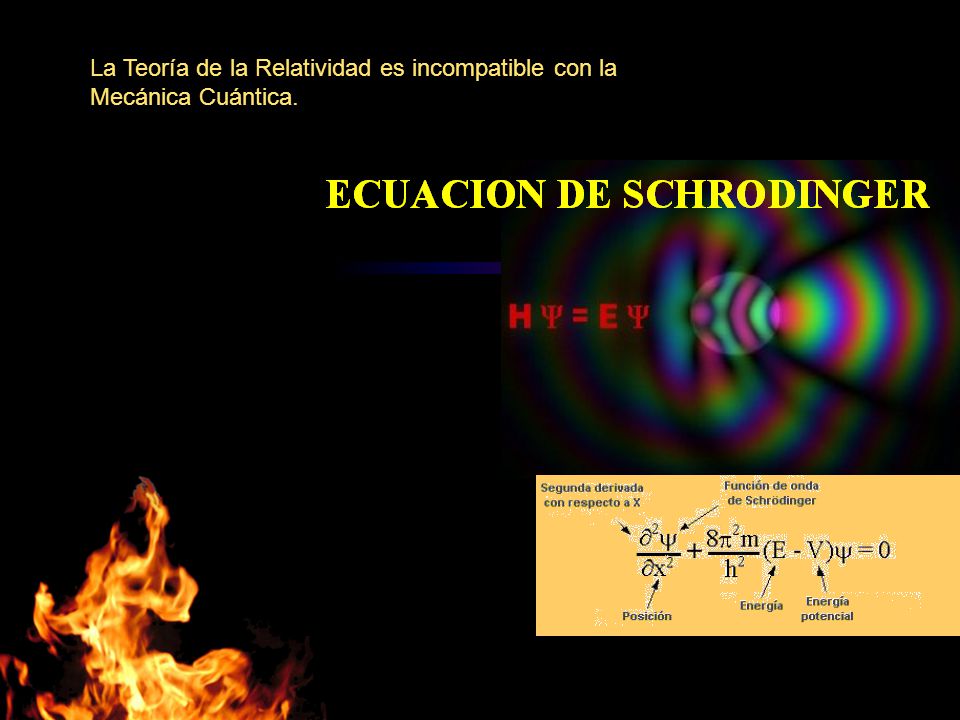

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió como escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial como general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no puede por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza.

emilio silvera

Feb

4

¿La Física? ¡Una maravilla! Nos dice cómo funciona la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

Ylia Prigogine ¡Qué personaje!

El Universo y la Vida… ¡Nuestra imaginación!

En su Libro Partículas, Gerard ´t Hofft, Premio Nobel de Física, nos cuenta:

“En el mundo de los seres vivos, la escala o tamaño crea importantes diferencias. En muchos aspectos, la anatomía de un ratón es una copia de la de un elefante, pero mientras que un ratón trepar por una pared prácticamente vertical sin mucha dificultad (y se puede caer desde una altura varias veces mayor que su propio tamaño sin hacerse daño), un elefante no sería capaz de realizar tal hazaña. Con bastante generalidad se puede afirmar que los efectos de la gravedad son menos importantes cuanto menores sean los objetos que consideremos (sean vivos o inanimados).”

Cuando llegamos a los seres unicelulares, se ve que ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de la gravedad a esa escala. Tranquilamente se pueden mover y desplazar por encima de una superficie acuática. Los pluricelulares no pueden hacer tal cosa.

Estas imágenes la hemos visto muchas veces en fuentes y charcos formados por la de la lluvia

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos de Van der Waals. fuerza tiene un alcance muy corto; para ser precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente 1/r7. Esto significa que si se reduce la distancia dos átomos a la mitad de la fuerza de Van der Waals con la que se atraen uno a otro se hace 2 × 2 × 2 × 2 × 2 × 2 × 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza. El conocimiento de esta fuerza se debe a Johannes Diderik Van der Waals (1837 – 1923) con su tesis sobre la continuidad del líquido y gaseoso que le haría famoso, ya que en esa época (1873), la existencia de las moléculas y los átomos no estaba completamente aceptado.

La tensión superficial del agua, es el efecto físico (energía de atracción entre las moléculas) que “endurece” la capa superficial del agua en reposo y permite a algunos insectos, como el mosquito y otros desplazarse por la superficie del agua sin hundirse.

El famoso físico inglés James Clerk Maxwell, que formuló la teoría del electromagnetismo de Faraday, quedó muy impresionado por este de Van der Waals.

Los tamaños de los seres unicelulares, animales y vegetales, se miden en micrómetros o “micras”, donde 1 micra es 1/1.000 de milímetro, aproximadamente el tamaño de los detalles más pequeños que se pueden observar con un microscopio ordinario. El mundo de los microbios es fascinante, pero no es el objeto de este trabajo, y continuaremos el viaje emprendido las partículas elementales que forman núcleos, átomos, células y materia, así como las fuerzas que intervienen en las interacciones fundamentales del universo y que afecta a todo lo que existe.

Hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Radiación de Cuerpo Negro

Un cuerpo negro es un objeto teórico o ideal que absorbe toda la luz y toda la energía radiante que incide sobre él. Nada de la radiación incidente se refleja o pasa a través del cuerpo negro. A pesar de su , el cuerpo negro emite luz y constituye un modelo ideal físico para el estudio de la emisión de radiación electromagnética. El nombre Cuerpo negro fue introducido por Gustav Kirchhoff en 1862.

La luz emitida por un cuerpo negro se denomina radiación de cuerpo negro. Todo cuerpo emite energía en de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada es la temperatura del emisor. La energía radiante emitida por un cuerpo a temperatura ambiente es escasa y corresponde a longitudes de onda superiores a las de la luz visible (es decir, de menor frecuencia). Al elevar la temperatura no sólo aumenta la energía emitida sino que lo hace a longitudes de onda más cortas; a esto se debe el cambio de color de un cuerpo cuando se calienta. Los cuerpos no emiten con igual intensidad a todas las frecuencias o longitudes de onda, sino que siguen la ley de Planck.

La onda electromagnética se puede entender como un grupo de “paquetes” ( cuantos) de muy poca energía que, juntos determinan la energía de la onda.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = h?, donde E es la energía del paquete, ? es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ? de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, esto lo veremos más adelante.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Si la mecánica cuántica tiene cosas extrañas y el espín es una de ellas. Y si uno piensa que la intuición le ayudará a comprender todo esto, pues no lo hará, o es poco probable que lo haga. Las partículas tienen un espín fundamental. Al igual que la carga eléctrica o la masa, el espín ayuda a definir que de partícula es cada una.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

La posición y el momento de una partícula nunca lo podremos saber con precisión ilimitada.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La mecánica cuántica es muy extraña a nuestro “sentido común”, sabemos que se desenvuelve en ese “universo” de lo muy pequeño, alejado de nuestra vida cotidiana en el macrocosmos tetradimensional que, no siempre coincide con lo que, en aquel otro infinitesimal acontece.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, existe otro universo dentro de nuestro del que, aún, nos queda mucho por aprender.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (?) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.”

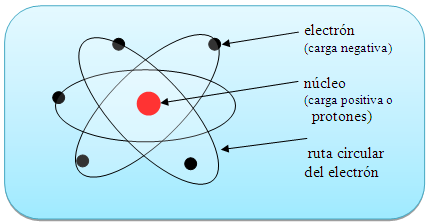

También Gerard ‘t Hooft es el autor de lo que han dado en llamar l principio holográfico es una conjetura especulativa acerca de las teorías de la Gravedad Cuántica propuesta en 1993 por este autor, y mejorada y promovida por Leonard Susskin en 1995. Postula que toda la información contenida en cierto volumen de un espacio concreto se puede conocer a partir de la información codificable sobre la frontera de dicha región. Una importante consecuencia es que la cantidad máxima de información que puede contener una determinada región de espacio rodeada por una superficie diferenciable está limitada por el área total de dicha superficie.

Por ejemplo, se pueden modelar todos los eventos que ocurran en un cuarto o una habitación creando una teoría en la que sólo tome en cuenta lo que suceda en sus paredes. En el principio holográfico también se afirma que por cada cuatro Unidades de Planck existe al menos un grado de libertad (o una unidad constante de Bolttzmann k de máxima entropía). Esto se conoce como frontera de Bekenstein:

donde S es la entropía y A es la unidad de mensura considerada. En unidades convencionales la fórmula anterior se escribe:

donde:

, es la constante de Boltzmann.

, es la constante de Boltzmann.

, es la vecolcidad de la luz.

, es la vecolcidad de la luz.

, es la constante gravitacional universal.

, es la constante gravitacional universal.

, es la constante de Planck racionalizada.

, es la constante de Planck racionalizada. , es la longitud de Planck.

, es la longitud de Planck.

Claro que esta… ¡Es otra Historia!

emilio silvera

Feb

4

Viajando al Corazón de la Materia

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

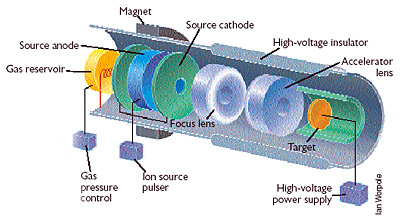

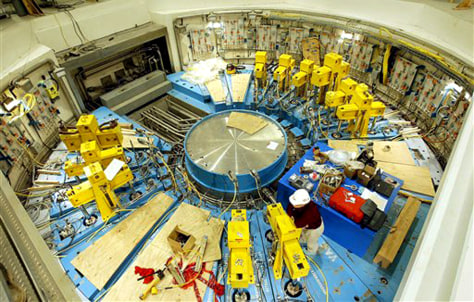

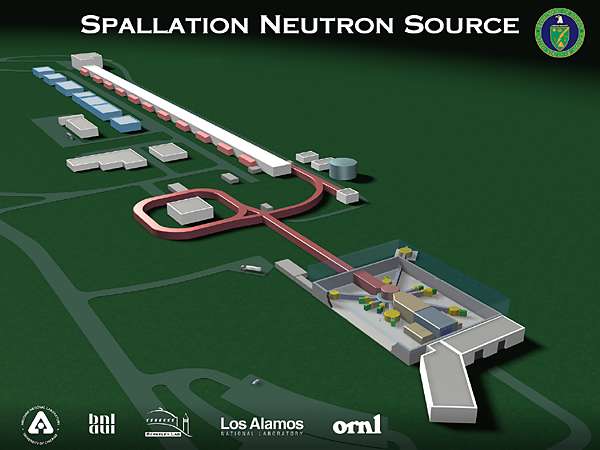

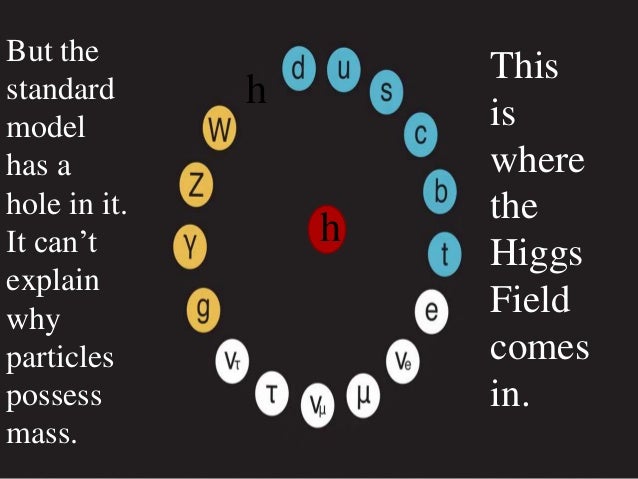

Después del Gran Colisionador de Hadrones (LHC) del CERN, situado en Suiza, otro gran experimento internacional promete sacudir la ciencia y nuestro conocimiento de la naturaleza. Hablamos de la Fuente Europea de Neutrones por Espalación (ESS, por sus siglas en inglés) un gran acelerador lineal de partículas que, como un poderoso microscopio, permitirá observar el interior de los materiales que componen nuestro mundo para así ser capaces de estudiar cómo se mueven e interactúan sus átomos por dentro y conocer los más variados fenómenos y propiedades donde nuestros ojos no llegan.

Tras un arduo período de selección del lugar de instalación del proyecto –en la que compitieron las ciudades de Bilbao y Debrecen (Hungría)–, la construcción comenzó en 2014. Las primeras pruebas están previstas para 2019 y, si todo sale como se espera, se empezará a trabajar a pleno rendimiento en 2025.

“Nuestra vida tecnológica cada vez depende más de la ciencia básica –señala a Sinc la bioquímica sueca Sindra Petersson Arsköld, que forma parte de los 400 investigadores del proyecto–. La ESS funcionará como un gran microscopio. Pero a diferencia de los microscopios convencionales no utilizará luz o lentes. Usaremos neutrones, partículas presentes en el núcleo del átomo, para ver a través de las cosas. Los neutrones atraviesan el metal como la luz atraviesa el cristal”.

Resultado de la imagen de la fuente europea de neutrones por Espalación (ESS)

Petersson comenta que “al poder estudiar como nunca las propiedades estructurales de la materia y sus dinámicos procesos internos, como los intercambios de energía, con este nuevo experimento podremos desarrollar baterías de litio más eficientes para los coches eléctricos. Además, se podrá mejorar el desarrollo de medicamentos y el funcionamiento de los trenes magnéticos. Y también podremos penetrar la piedra y ver dentro de huevos fosilizados de titanosaurios hallados en Mongolia sin necesidad de romperlos”, subraya.

Las instalaciones de la ESS ocuparán unas 10 hectáreas (equivalente a 14 canchas de fútbol). Actualmente, la construcción –cuyas obras ha tenido la oportunidad de visitar Sinc– está al 30%.

![[Img #45912]](http://noticiasdelaciencia.com/upload/img/periodico/img_45912.jpg)

Vista aérea del pasado mes de julio del estado de las obras de construcción de la Fuente Europea de Neutrones por Espalación en Lund (Suecia). (Foto: Perry Nordeng / ESS)

Caminar por su interior –con chaleco, casco, gafas y guantes protectores, después de haber suministrado datos personales y firmado una planilla por si sucede algún accidente– implica prestar atención a cada paso.

Por ejemplo, a lo largo del silencioso y por ahora vacío túnel subterráneo de 537 metros de largo por el que dentro de unos años circularán miles millones de protones generados por dos fuentes de iones. Acelerados por campos magnéticos al 96% de la velocidad de la luz, los pulsos de protones impactarán al final de su viaje por este túnel sobre un blanco, una rueda giratoria de tungsteno.

Será en estas colisiones en las que se producirá el proceso de espalación que le da el nombre a este proyecto: tras una reacción nuclear, por cada protón se generarán 30 neutrones, los verdaderos protagonistas de esta nueva ‘catedral’ de la ciencia moderna, que serán luego distribuidos en 16 instrumentos donde se analizarán las muestras.

“La tecnología necesaria para realizar estos experimentos es tan cara que varios países han tenido que unirse –detalla Petersson–. Suecia podría haberlo hecho sola pero hubiéramos tardado mucho más”.

A un coste de 1.843 millones de euros, no se trata de un proyecto de la UE sino de varios países europeos: 17 hasta el momento. Suecia y Dinamarca –los países anfitriones– pagan el 47,5 % de la construcción mientras que el resto de países que integran este consorcio –entre ellos Francia, Alemania, Italia, Reino Unido– se hace cargo del 52,5% restante. España fue el primer país socio de la ESS que firmó la carta oficial de intenciones en la que asumió un compromiso de aportar el 5% para su construcción.

La elección de Suecia como sede de la construcción de la ESS en mayo de 2009 significó una gran decepción para Bilbao, que desde 2006 anhelaba convertirse en un lugar de referencia en el mapa de la investigación y la ciencia.

Aun así, desempeña un rol importante: pese a una serie de recortes presupuestarios, en el centro estratégico de tecnologías neutrónicas ESS Bilbao (en Zamudio, Vizcaya), su plantilla de 60 trabajadores se encuentra diseñando y fabricando siete piezas clave de este proyecto: entre ellas una sección del acelerador (Medium Beam Energy Transport o MEBT), un gran espectrómetro llamado Miracles y en especial el ‘corazón’ de la ESS, el target o blanco de choque contra el que se dispararán los protones.

“El diseño desarrollado por ESS Bilbao consiste en unas 7.000 piezas de un material conocido como Wolframio colocados dentro de una rueda de 2,5 metros de diámetro, comenta a Sinc Sira Cordón, responsable de comunicación de este centro de investigación.

“La refrigeración del circuito será por gas helio. Los desarrollos de los trabajos evolucionan favorablemente –añade Cordón–. La comunidad científica española se verá beneficiada por las múltiples aplicaciones que la Fuente Europea de Neutrones por Espalación va a ofrecer para sus investigaciones con materiales en los más diversos sectores: desde el estudio de la eficacia de un detergente a la resistencia de materiales por ejemplo en transportes, la eficacia de las baterías, nuevas terapias contra el cáncer o dosificadores de medicamentos”.

Se espera además la visita de unos 2.000 científicos al año por lo que se está construyendo la Science Village Scandinavia, un pequeño pueblo de 17 hectáreas justo al lado de los límites de la instalación.

“Irónicamente, para visualizar los objetos más pequeños de la naturaleza necesitamos construir las instalaciones científicas más grandes del mundo, dice en un vídeo promocional el actor Patrick Stewart, el recordado capitán Picard de Star Trek y una de las caras famosas que buscan darle visibilidad al proyecto.

“ESS es el Hubble de la física de neutrones. Así como el telescopio espacial nos permite ver en las profundidades del espacio, con la ESS podremos explorar el espacio interior, abriendo una nueva frontera científica y tecnológica y conduciéndonos a descubrimientos que cambiarán la manera en que vemos nuestro mundo y que aún no somos capaces de imaginarnos”.

Aún sin haber comenzado a funcionar esta instalación ya ha deparado la primera gran sorpresa: el descubrimiento inesperado de un antiguo asentamiento de la Edad de Piedra, evidencia de que la gente ha estado viviendo en esta zona de Escandinavia más tiempo de lo que se creía anteriormente.

Durante el otoño de 2013, unos meses antes de la colocación de la primera piedra, 40 arqueólogos rastrillaron el amplio terreno deshabitado de unos 100.000 metros cuadrados, al noreste de Lund. Con paciencia, los investigadores del Museo de Historia Sueca inspeccionaron cada afloramiento que llamaba su atención.

El pasado no tardó en resurgir: como cuenta el director del proyecto, Magnus Andersson, encontraron restos de los primeros granjeros que habitaron el sur de Suecia entre los años 4000 y 3300 a.C. “Durante la excavación, pudimos discernir las huellas de dos casas de unos 13 metros de largo por seis de ancho –señala el arqueólogo–. Una sobre la otra, indicación de que no existieron al mismo tiempo”.

Los investigadores sospechan que varias generaciones habitaron en estas granjas. Cerca de estas cabañas redondas u ovaladas con una chimenea en el centro se encontraron también restos de unas 14 pequeñas chozas, miles de granos carbonizados –en especial cebada–, huesos de ganado, ovejas, cerdos y ciervos, un cementerio y fragmentos de cerámica con trazas de productos lácteos.

En este sitio, los arqueólogos hallaron también huellas de personas que vivieron en otro período posterior, durante la Edad de Hierro: restos de casas de madera, pozos y unos diez hornos. El asentamiento al parecer tuvo varios ocupantes porque hay indicaciones de que estuvo ocupado entre los años 500 a.C. hasta la era de los Vikingos, alrededor del 1050.

También encontraron unas 12 tumbas pero debido a las duras condiciones de conservación del suelo no se pudo recuperar mucho salvo dientes, anillos de oro y collares con cuentas de ámbar.

Los arqueólogos cuentan los días. Están ansiosos: desean que la construcción de la ESS termine lo antes posible para que todos estos tesoros recolectados y prolijamente catalogados, en especial los granos de hace casi 6.000 años, sean analizados por este súpermicroscopio nórdico, el futuro gigante de la ciencia europea. (Fuente: SINC)

Ene

23

¿La teoría cuántica y la Gravedad, dentro de las cuerdas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Sí, a veces la Física, parece un Carnaval. Imaginamos universos que… ¿serán posibles?

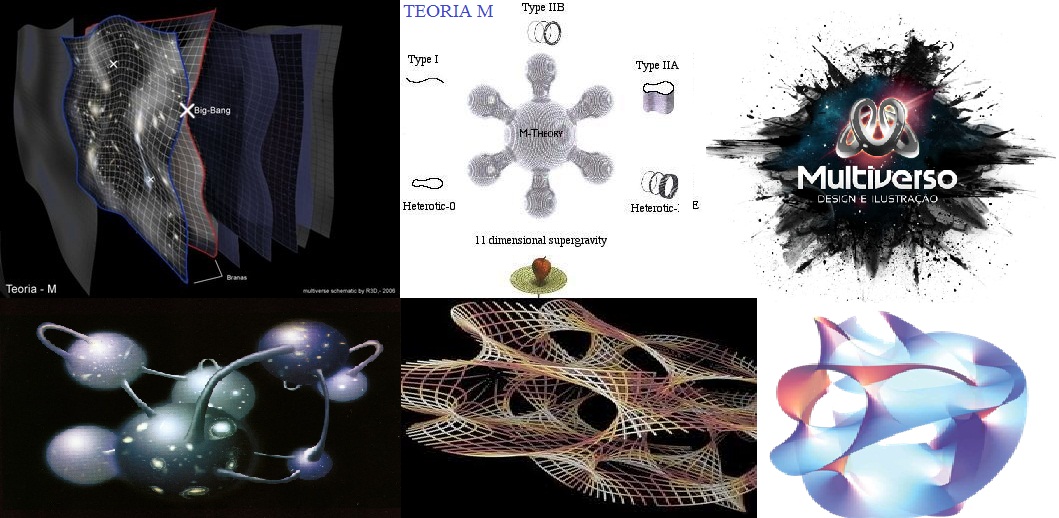

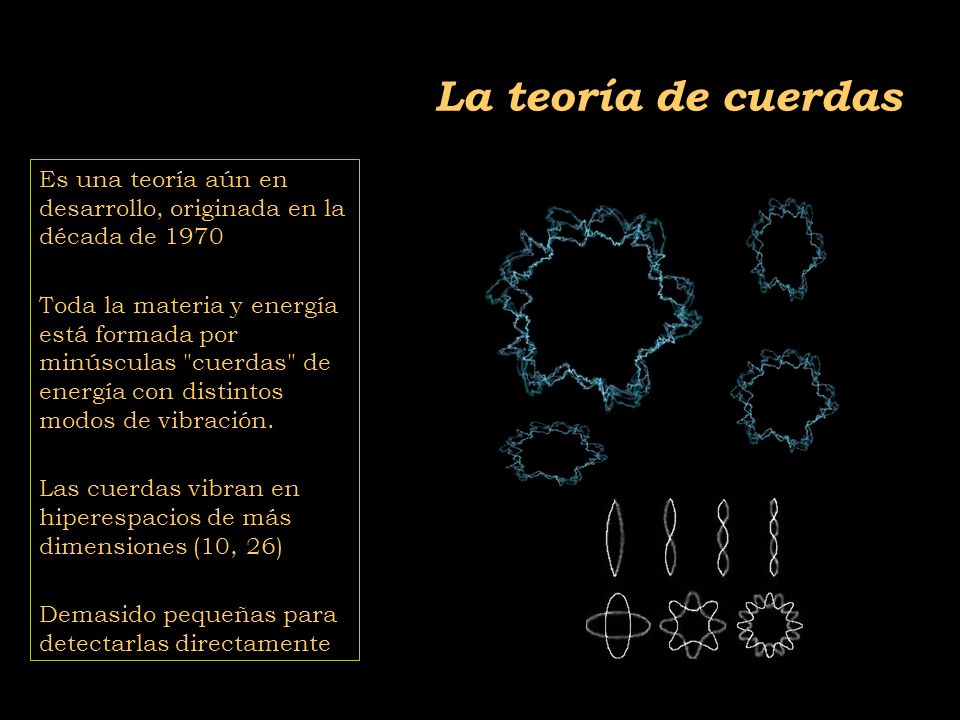

Las teorías de cuerdas [TC’s] no son una invención nueva, ni mucho menos. La primera TC se inventó a finales de los años sesenta del siglo XX en un intento para encontrar una teoría para describir la interacción fuerte. La idea medular consistía en que partículas como el protón y el neutrón podían ser consideradas como ondas de «notas de una cuerda de violín». La interacción fuerte entre las partículas correspondería a fragmentos de cuerda que se extenderían entre pequeños pedacitos de cuerda, como las telas que forman algunos simpáticos insectos. Para que esta teoría proporcionase el valor observado para la interacción fuerte entre partículas, las cuerdas tendrían que ser semejantes a las de un violín, pero con una tensión de alrededor de unas diez toneladas.

La primera expresión de las TC’s fue desarrollada por Jöel Scherk, de París, y John Schwuarz, del Instituto de Tecnología de California, quienes en el año 1974 publicaron un artículo en el que demostraban que la TC podía describir la fuerza gravitatoria, pero sólo si la tensión en la cuerda se tensiometrara alrededor de un trillón de toneladas métricas. Las predicciones de la teoría de cuerdas serían las mismas que las de la relatividad general a escala de longitudes normales, pero diferirían a distancias muy pequeñas, menores que una trillonésima de un cm. Claro está, que en esos años, no recibieron mucha atención por su trabajo.

Ahora se buscan indicios de la teoría de cuerdas en los grandes aceleradores de partículas donde parece que algunos indicios nos dicen que se va por el buen camino, sin embargo, nuestros aceleradores más potentes necesitarían multiplicar por un número muy elevado su potencia para poder, comprobar la existencia de las cuerda situadas a una distancia de 10-35 m, lugar al que nos será imposible llegar en muchas generaciones. Sin embargo, en las pruebas que podemos llevar a cabo en la actualidad, aparecen indicios de una partlicula de espín 2 que todos asocian con el esquivo Gravitón, y, tal indicio, nos lleva a pensar que, en la teoría de supercuerdad, está implícita una Teoría Cuántica de la Gravedad.

Los motivos que tuvo la comunidad científica, entonces, para no brindarle la suficiente atención al trabajo de Scherk y Schwuarz, es que, en esos años, se consideraba más viable para describir a la interacción fuerte a la teoría basada en los quarks y los gluones, que parecía ajustarse mucho mejor a las observaciones. Desafortunadamente, Scherk murió en circunstancias trágicas (padecía diabetes y sufrió un coma mientras se encontraba solo en su estudio). Así, Schwuarz se quedó solo, en la defensa de la teoría de cuerdas, pero ahora con un valor tensiométrico de las cuerdas mucho más elevado.

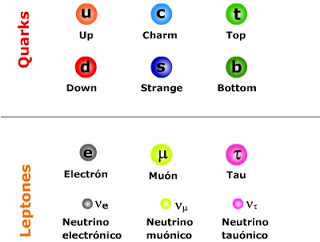

Pero con los quarks, gluones y también los leptones, en la consecución que se buscaba, los físicos entraron en un cuello de botella. Los quarks resultaron muy numerosos y los leptones mantuvieron su número e independencia existencial, con lo cual seguimos con un número sustancialmente alto de partículas elementales (60), lo que hace que la pregunta ¿son estos los objetos más básicos?

Si esos sesenta objetos fuesen los más básicos, entonces también aflora otra pregunta ¿por qué son como son y por qué son tantos? Los físicos quisieran poder decir «salen de esto», o «salen de esto y aquello», mencionar dos principios bien fundamentales y ojalá tan simples que puedan ser explicados a un niño. La respuesta «porque Dios lo quiso así» posiblemente a muchos les cause «lipotimia», ya que esa respuesta nos lleva a reconocer nuestra ignorancia y, además, la respuesta que esperamos no pertenece al ámbito de la religión. Por ahora, ¿cuál es la última que puede dar la ciencia?

La teoría de cuerdas rompe con esta idea. Presupone que las partes más pequeñas son filamentos de energía. Una especie de cuerdas que vibran.

El cuello de botella incentivó a que se encendiera una luz de esperanza. En 1984 el interés por las cuerdas resucitó de repente. Se desempolvaron las ideas de Kaluza y Klein, como las que estaban inconclusas de Scherk y Schwuarz. Hasta entonces, no se habían hecho progresos sustanciales para explicar los tipos de partículas elementales que observamos, ni tampoco se había logrado establecer que la supergravedad era finita.

El ser humano –en función de su naturaleza– cuando se imagina algo muy pequeño, piensa en un puntito de forma esférica. Los físicos también son seres de este planeta y, para ellos, las partículas elementales son como puntitos en el espacio, puntos matemáticos, sin extensión. Son sesenta misteriosos puntos y la teoría que los describe es una teoría de puntos matemáticos. La idea que sugieren las TC’s es remplazar esos puntos por objetos extensos, pero no como esferitas sino más bien como cuerdas. Mientras los puntos no tienen forma ni estructura, las cuerdas tienen longitud y forma, extremos libres como una coma “,” (cuerda abierta), o cerradas sobre sí misma como un circulito. Si el punto es como una esferita inerte de la punta de un elastiquito, la cuerda es el elástico estirado y con él se pueden hacer círculos y toda clase de figuras. Está lleno de posibilidades.

Muchas son las imágenes que se han elaborado para representar las cuerdas y, como nadie ha visto nunca ninguna, cualquiera de ellas vale para el objetivo de una simple explicación y, las cuerdas que se han imaginado han tomado las más pintorescas conformaciones para que, en cada caso, se adapten al modelo que se expone.

diferencia entre un punto y una coma. Según la teoría de cuerdas importa, y mucho. Por su extensión, a diferencia del punto, la cuerda puede vibrar. Y hacerlo de muchas maneras, cada modo de vibración representando una partícula diferente. Así, una misma cuerda puede dar origen al electrón, al fotón, al gravitón, al neutrino y a todas las demás partículas, según cómo vibre. Por ello, la hemos comparado con la cuerda de un violín, o de una guitarra, si se quiere.

Al dividir la cuerda en dos, tres, cuatro, cinco, o más partes iguales, se generan las notas de la escala musical que conocemos, o técnicamente, los armónicos de la cuerda. En general, el sonido de una cuerda de guitarra o de piano es una mezcla de armónicos. Según la mezcla, la calidad (timbre) del sonido. Si distinguimos el tono de estos instrumentos, es por la «receta» de la mezcla en cada caso, por las diferentes proporciones con que cada armónico entra en el sonido producido. Pero, también es posible hacer que una buena cuerda vibre en uno de esos armónicos en particular, para lo cual hay que tocarla con mucho cuidado. Los concertistas lo saben, y en algunas obras como los conciertos para violín y orquesta, usan este recurso de «armónicos». Así, la naturaleza, con su gran sabiduría y cuidado para hacer las cosas, produciría electrones, fotones, gravitones, haciendo vibrar su materia más elemental, esa única y versátil cuerda, en las diversas (infinitas) formas que la cuerda permite.

Una partícula ocupa un punto del espacio en todo momento. Así, su historia puede representarse mediante una línea en el espaciotiempo que se le conoce como «línea del mundo». Por su parte, una cuerda ocupa una línea en el espacio, en cada instante de tiempo. Por tanto, su historia en el espaciotiempo es una superficie bidimensional llamada la «hoja del mundo». Cualquier punto en una hoja del mundo puede ser descrito mediante dos números: uno especificando el tiempo y el otro la posición del punto sobre la cuerda. Por otra parte, la hoja del mundo es una cuerda abierta como una cinta; sus bordes representan los caminos a través del espaciotiempo (flecha roja) de los extremos o comas de la cuerda (figura 12.05.03.02). La hoja del mundo de una cuerda cerrada es un cilindro o tubo (figura 12.05.03.03); una rebanada transversal del tubo es un círculo, que representa la posición de la cuerda en un momento del tiempo.

No cabe duda que, de ser ciertas las TC’s, el cuello de botella queda bastante simplificado. Pasar de sesenta objetos elementales a una sola coma o circulito es un progreso notable. Entonces, ¿por qué seguir hablando de electrones, fotones, quarks, y las demás?

Que aparentemente las cosas se simplifican con las TC’s, no hay duda, pero desafortunadamente en física las cosas no siempre son como parecen. Para que una teoría sea adoptada como la mejor, debe pasar varias pruebas. No basta con que simplifique los esquemas y sea bella. La teoría de las cuerdas está –se puede decir– en pañales y ha venido mostrado distintas facetas permeables. Surgen problemas, y se la deja de lado; se solucionan los problemas y una avalancha de trabajos resucitan la esperanza. En sus menos de treinta años de vida, este vaivén ha ocurrido más de una vez.

Uno de los problemas que más afecta a la cuerda está ligado con su diminuto tamaño. Mientras más pequeño algo, más difícil de ver. Es una situación que se agudiza en la medida que se han ido corrigiendo sus permeabilidades. En sus versiones más recientes, que se llaman supercuerdas, son tan superpequeñas que las esperanzas de ubicarlas a través de un experimento son muy remotas. Sin experimentos no podemos comprobar sus predicciones ni saber si son correctas o no. Exagerando, es como una teoría que afirmara que los angelitos del cielo tienen alitas. ¿Quién la consideraría seriamente?

La propia base conceptual de la teoría comporta problemas. Uno de ellos, es el gran número de dimensiones que se usan para formularla. En algunos casos se habla de 26 o, en el mejor, de 10 dimensiones para una cuerdita: espacio (son 3), tiempo (1) y otras seis (o 22) más, que parecen estar enroscadas e invisibles para nosotros. Por qué aparecieron estas dimensiones adicionales a las cuatro que nos son familiares y por qué se atrofiaron en algún momento, no lo sabemos. También, la teoría tiene decenas de miles de alternativas aparentemente posibles que no sabemos si son reales, si corresponden a miles de posibles universos distintos, o si sólo hay una realmente posible. Algunas de estas versiones predicen la existencia de 496 fuerzones, partículas como el fotón, que transmiten la fuerza entre 16 diferentes tipos de carga como la carga eléctrica. Afirmaciones como éstas, no comprobables por la imposibilidad de hacer experimentos, plagan la teoría de cuerdas. Quienes alguna vez intentaron trabajar matemáticamente en las cuerdas, muchas veces deben haber pensado de que lo que estaban calculando más se asemejaba a juegos de ejercicios que la consecución de una base matemática teórica tras objetivo de dar un paso trascendental en el conocimiento de la naturaleza. Ahora, los que tienen puesta su fe en ella suelen afirmar que se trata de una teoría que se desfasó de la natural evolución de la física, que su hallazgo fue un accidente, y no existe aún el desarrollo matemático para formularla adecuadamente.

En las teorías de cuerdas, lo que anteriormente se consideraba partículas, se describe ahora como ondas viajando por las cuerdas, como las notas musicales que emiten las cuerdas vibrantes de un violín. La emisión o absorción de una partícula por otra corresponde a la división o reunión de cuerdas.

La Teoría de cuerdas trata de incorporar la Gravedad a las otras tres fuerzas y completar así el panorama actual de la Física de Partículas en el Modelo Estándar en el que sólo están incluídas estas tres interacciones de arriba, la Gravedad queda fuera por surgir infinitos no renormalizables que, desaparecen en la Teoría de supercuerdas de 26 dimensiones de espacio tiempo para los Bosones y de 10 y 11 dimensiones de espacio tiempo para los Fermiones.

El trabajo que aquí hemos leido lo he obtenido de fuentes diversas y, como tantos otros, nos dice más o menos lo que todos. La realidad de la Teoría de supercuerdas está en que no podemos llegar a ese límite necesario de los 10-35 m, donde supuestamente, está instalada la cuerda, y, como llegar a esa distancia nos exige una energía de 1019 GeV con la que no podemos ni soñar. Seguirán, por mucho tiempo, las especulaciones y cada cual, tendrá su idea, su propia teoría, toda vez que, ninguna de ellas podrá ser verificadas y mientras eso sea así (que lo es), todas las teorías tendrán la posibilidad de ser refrendadas…algún día.

- ¿Dónde estarán las respuestas?

Sin embargo, una cosa es cierta, es la única teoría, la de supercuerdas, que nos da cierta garantía de que vamos por el buen camino, en su desarrollo aparecen indicios confirmados por los experimentos, como por ejemplo, la aparici´çon de una partícula de espín 2, el Gravitón que nos lleva a pensar que, en la teoría de supercuerdas está integrada una teoría Cuántica de la Gravedad que nos, podrá llevar, hasta esos primeros momentos del Big Bang que ahora quedan tan oscuros a la vista de los observadores y, de la misma manera, nos dejará entrar en la Singularidad de un Agujero Negro para poder ver (al fin) lo que allí pueda haber, qué clase de partículas o de materia se ha podido formar en un material tan extremadamente denso como el de la singularidad.

Que parece reirse de nuestra ignorancia

Habrá que tener paciencia con la Teoría de cuerdas y con el hallazgo tan esperado del Gravitón que nos confirmará, al fín, que la Gravedad como las demás interacciones, también está cuantizada y tiene su Bosón transmisor. De lo que no acabo de estar seguro es…del hecho en sí, de que podamos univer la Gravedad con la cuántica…¡son tan dispares! y habitan en reinos tan diferentes.

emilio silvera

Ene

16

Teorías, masas, partículas, dimensiones…

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (3)

Comments (3)

Las Teorías:

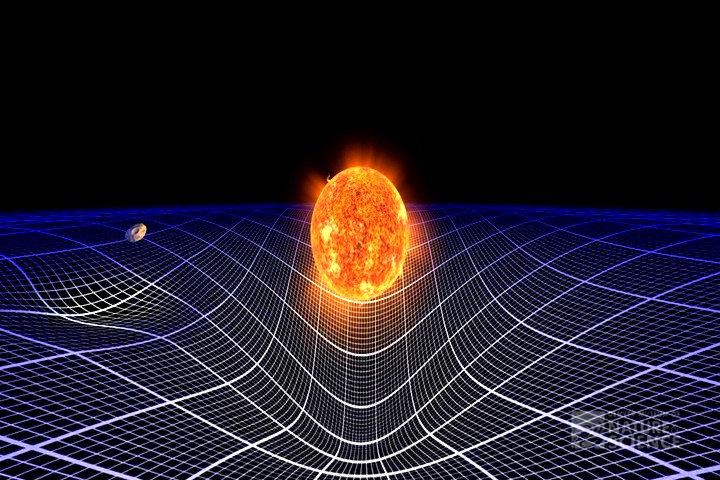

Una nos habla del Cosmos y de como el espacio se curva ante la presencia de masas, la otra, nos habla de funciones de ondas, entrelazamientos cuánticos, de diminutos objetos que conforman la materia y hacen posibles los átomos y la vida.

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

La longitud de Planck (ℓP) u hodón (término acuñado en 1926 por Robert Lévi) es la distancia o escala de longitud por debajo de la cual se espera que el espacio deje de tener una geometría clásica. Una medida inferior previsiblemente no puede ser tratada adecuadamente en los modelos de física actuales debido a la aparición de efectos de Gravedad Cuántica.

¿Quién puede ir a la longitud de Planck para verla? A distancias comparables con la longitud de Planck, se cree que están sucediendo cosas muy curiosas que rebasan ampliamente los límites de nuestra imaginación. A diferencia de la filosofía reduccionista que propone que lo más complejo está elaborado -axiomáticamente- a partir de lo más elemental, lo que está sucediendo en la escala de Planck no parece tener nada de elemental o sencillo. Se cree que a esta escala la continuidad del espacio-tiempo en vez de ir marchando sincronizadamente al parejo con lo que vemos en el macrocosmos de hecho stá variando a grado tal que a nivel ultra-microscópico el tiempo no sólo avanza o se detiene aleatoriamente sino inclusive marcha hacia atrás, una especie de verdadera máquina del tiempo. Las limitaciones de nuestros conocimientos sobre las rarezas que puedan estar ocurriendo en esta escala en el orden de los 10-35metros, la longitud de Planck, ha llevado a la proposición de modelos tan imaginativos y tan exóticos como la teoría de la espuma cuántica que supuestamente veríamos aún en la ausencia de materia-energía si fuésemos ampliando sucesivamente una porción del espacio-tiempo plano.

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que mencioné en páginas anteriores.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías.

¡Necesitamos algo más avanzado!

Cada partícula tiene encomendada una misión

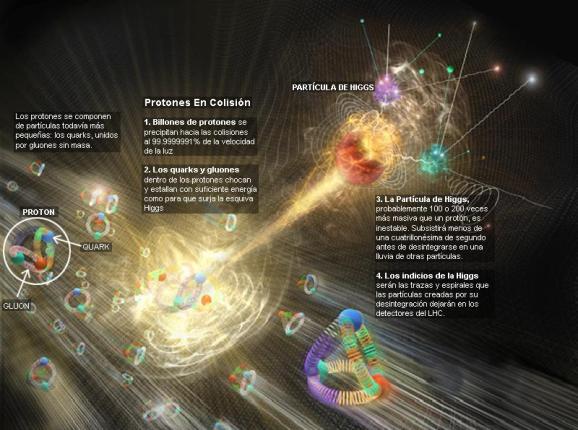

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las demás partículas. Cuando su autor lanzó la idea al mundo, resultó además de nueva muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Cuando los físicos hablan de la belleza de algunas ecuaciones, se refieren a las que, como ésta, dicen mucho con muy pocos caracteres. De hecho, puede que ésta sea la ecuación más famosa conocida en nuestro mundo.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Pero la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

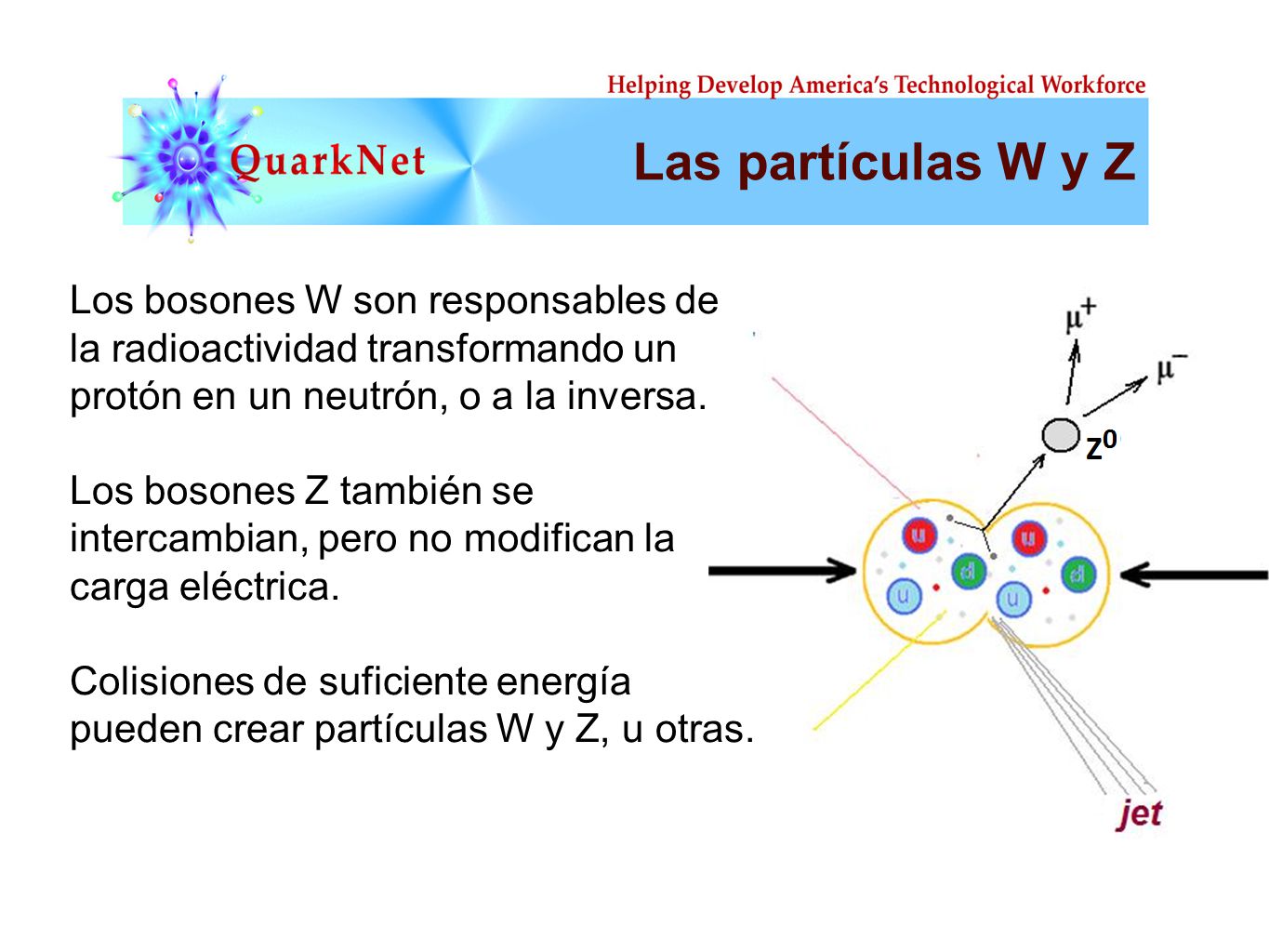

Hasta hace bien poco no teniamos ni idea de que reglas controlan los incrementos de masa generados por el Higgs (de ahí la expectación creada por el nuevo acelerador de partículas LHC cuando la buscaba). Pero el problema es irritante: ¿por qué sólo esas masas -Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa -los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébilse fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

Pero, encierra tantos misterios la materia que, a veces me hace pensar en que la podríamos denominar de cualuquier manera menos de inerte ¡Parece que la materia está viva!

Son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

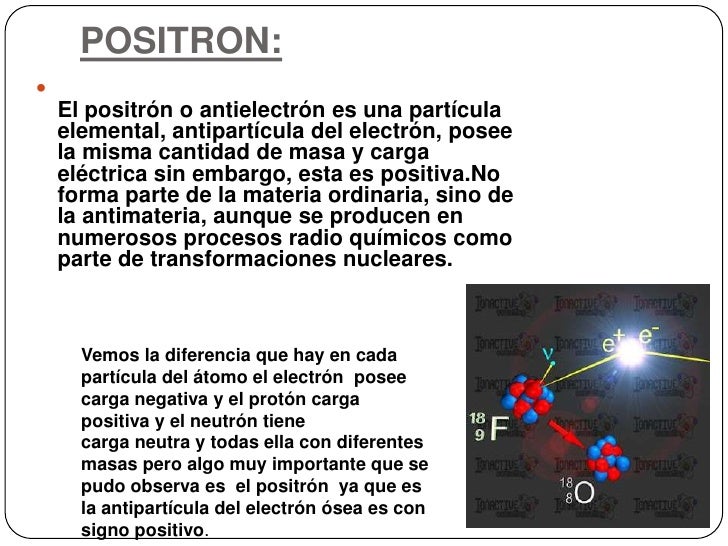

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lentos, que significa “delgado”).

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54) x 10-31 Kg la primera y, 1,602 177 33 (49) x 10-19 culombios, la segunda, y también su radio clásico: r0 = e2/mc2 = 2’82 x 10-13 m. No se ha descubierto aún ninguna partícula que sea menos cursiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que esta es la que se muestra en el electrón.

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería como lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí ahora.

¡No por pequeño, se es insignificante!

Recordémoslo, todo lo grande está hecho de cosas pequeñas.

En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones*.

Esta manifestación en forma de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”.

El fotón tiene una masa de 1, una carga eléctrica de o, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva para la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el nombre de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin descubrir) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm. De longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en forma de ondas), desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegare a captar la cienmillonésima parte de un centímetro.

Han llevado años captarlas, las ondas gravitatorias llevadas por el gravitón son débiles

Las débiles ondas de los gravitones, que producen del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de forma simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitatorias. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaran el hallazgo de Weber.

De todas formas, no creo que, a estas alturas, nadie pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es o, su carga es o, y su espín de 2. Como el fotón, no tiene antipartícula, ellos mismos hacen las dos versiones.

Tenemos que volver a los que posiblemente son los objetos más misteriosos de nuestro Universo: Los agujeros negros. Si estos objetos son lo que se dice (no parece que se pueda objetar nada en contrario), seguramente serán ellos los que, finalmente, nos faciliten las respuestas sobre las ondas gravitacionales y el esquivo gravitón.

La onda gravitacional emitida por el agujero negro produce una ondulación en la curvatura del espacio-temporal que viaja a la velocidad de la luz transportada por los gravitones.

Hay aspectos de la física que me dejan totalmente sin habla, me obligan a pensar y me transporta de este mundo material nuestro a otro fascinante donde residen las maravillas del Universo. Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro.

es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro.

Me llama poderosamente la atención lo que conocemos como las fluctuaciones de vacío, esas oscilaciones aleatorias, impredecibles e ineliminables de un campo (electromagnético o gravitatorio), que son debidas a un tira y afloja en el que pequeñas regiones del espacio toman prestada momentáneamente energía de regiones adyacentes y luego la devuelven.

Ordinariamente, definimos el vacío como el espacio en el que hay una baja presión de un gas, es decir, relativamente pocos átomos o moléculas. En ese sentido, un vacío perfecto no contendría ningún átomo o molécula, pero no se puede obtener, ya que todos los materiales que rodean ese espacio tienen una presión de vapor finita. En un bajo vacío, la presión se reduce hasta 10-2 pascales, mientras que un alto vacío tiene una presión de 10-2-10-7 pascales. Por debajo de 10-7 pascales se conoce como un vacío ultraalto.

No puedo dejar de referirme al vaciotheta (vació θ) que, es el estado de vacío de un campo gauge no abeliano (en ausencia de campos fermiónicos y campos de Higgs).

El vacío theta es el punto de partida para comprender el estado de vacío de las teoría gauge fuertemente interaccionantes, como la cromodinámica cuántica. En el vacío theta hay un número infinito de estados degenerados con efecto túnel entre estos estados. Esto significa que el vacío theta es análogo a una fundón de Bloch* en un cristal.

Se puede derivar tanto como un resultado general o bien usando técnicas de instantón. Cuando hay un fermión sin masa, el efecto túnel entre estados queda completamente suprimido.

Cuando hay campos fermiónicos con masa pequeña, el efecto túnel es mucho menor que para campos gauge puros, pero no está completamente suprimido.

Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Si, sabemos ponerles etiquetas como, por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránidos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobre pasando a la emisión de partículas alfa.

emilio silvera

Totales: 74.240.471

Totales: 74.240.471 Conectados: 84

Conectados: 84