Ene

20

Monopolos magneticos

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (10)

Comments (10)

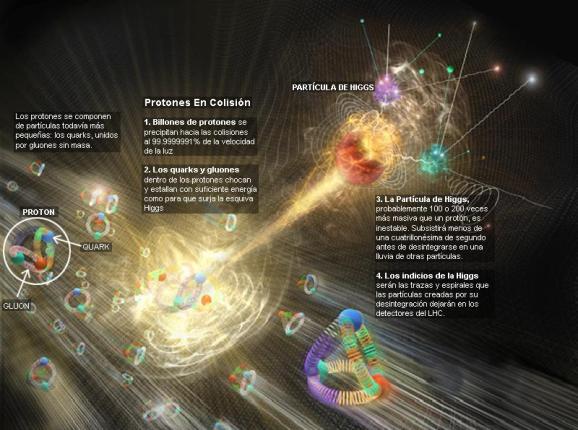

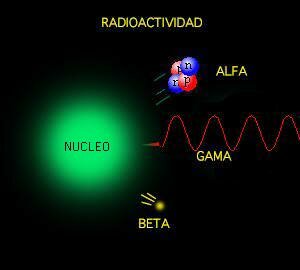

Cuando el LHC se ponía en marcha, algunos hablaron de que se podían crear monopolos magnéticos.

“Desde el punto de vista teórico, uno se siente inclinado a creer que los monopolos han de existir, debido a la belleza matemática de su concepción. Aunque se han hecho varias tentativas de hallarlos, ninguna ha tenido éxito. Debiera deducirse de ello que la belleza matemática en sí no es razón suficiente para que la naturaleza aplique una teoría. Nos queda aún mucho que aprender en la investigación de los principios básicos de la naturaleza.”

P. A. M. DIRAC, 1981

En los años treinta del pasado siglo Paul Dirac realizó unos cálculos teóricos que indicaban que si existieran los monopolos magnéticos, entonces se podría cuantizar fácilmente la carga del electrón. Bastaría que existiera un sólo monopolo magnético en el Universo para que los electrones tuvieran la carga que tienen y no otra.

La imagen de arriba vino acompañada de la noticia siguiente: “Afirman haber podido detectar por primera vez monopolos magnéticos como un estado de la materia que se daría a partir de una disposición especial de los momentos magnéticos dentro de un cristal a baja temperatura.”

En realidad, cohabitamos una naturaleza llena de fenómenos enigmáticos. Uno de estos fenómenos es la asimetría insólita que se observaba entre el magnetismo y la electricidad: no hay cargas magnéticas comparables a las cargas eléctricas. Nuestro mundo está lleno de partículas cargadas eléctricamente, como los electrones o los protones, pero nadie ha detectado jamás una carga magnética aislada. El objeto hipotético que la poseería se denomina monopolo magnético.

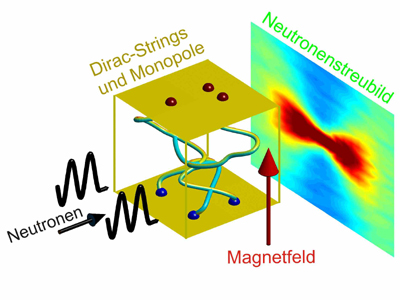

Montaje experimental. Foto: HZB, D.J.P. Morris y A. Tennant.

El grupo de investigadores dispuso un montaje experimental especial para poder detectar estas cuerdas de Dirac. Hicieron que un chorro de neutrones impactara sobre una muestra a la que aplicaban un campo magnético. En el interior de la muestra se formaban cuerdas de Dirac que dispersaban los neutrones con un patrón específico que delataba su presencia.

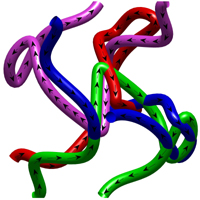

La muestra era un cristal de titanato de disprosio. La estructura cristalina de este compuesto tiene una geometría notable, de tal modo que los momentos magnéticos de su interior se organizan en lo que se llama un “espagueti de espines”. El nombre viene de la ordenación de los dipolos, que forman una red de tubos contorsionados (cuerdas) por los que se transporta flujo magnético.

Estos tubos pueden “hacerse visibles” cuando los neutrones interaccionan con ellos; pues los neutrones, aunque no tienen carga eléctrica, sí tienen momento magnético. El patrón de dispersión de los neutrones obtenido es una representación recíproca de las cuerdas de Dirac contenidas en la muestra. Con el campo magnético aplicado los investigadores podían controlar la simetría y orientación de las cuerdas. A temperaturas de entre 0,6 a 2 grados Kelvin los investigadores pudieron ver pruebas de la existencia de monopolos magnéticos (la temperatura suele ser la peor enemiga del magnetismo, pues tiene a desordenarlo todo) en forma de este tipo de cuerdas según se acaba de describir.

Además pudieron ver la firma que en la capacidad calorífica dejada el gas de monopolos, viendo que estas cuerdas interaccionan de manera similar a como lo hacen las cargas eléctricas, lo que era de prever para el caso de monopolos magnéticos. En este resultado los monopolos no son partículas, sino que emergen como un estado de la materia, en concreto a partir de un arreglo especial de los dipolos que forman parte del material.

Para hacernos una idea de cómo sería un monopolo magnético si existiera, imaginemos una barra imantada que, como sabemos, posee en cada extremos un «un polo magnético» por el cual se atraen o se repelen. Estos polos son de dos tipos, llamados «norte» y «sur», y se comportan como las cargas eléctricas, positiva y negativa. Esa configuración del campo es un ejemplo de «campo bipolar», y sus líneas de campo no paran: giran y giran interminablemente. Si partimos por la mitad la barra imantada, no tenemos dos polos, el norte y el sur, separados, sino dos imanes. Un polo norte o sur aislado (un objeto con líneas de campo magnético que sólo salgan o que sólo entren) sería un monopolo magnético. De hecho, es imposible aislar una de estas cargas magnéticas. Nunca se ha detectado monópolos magnéticos, es decir partículas que poseyeran una sola carga magnética aislada. Puede que ello se deba a razones no aclaradas, o bien la naturaleza no creó monopolos magnéticos o creó poquísimos.

Todos sabemos que hay cargas eléctricas de distinto signo, tanto positivas como negativas. De este modo podemos reunir unas cuantas cargas de un signo dado en un recinto espacial y ver cómo todas las líneas de campo entran o salen del mismo a través de su superficie. Esto viene dado por la ley de Gauss del campo electrostático, que es una de las leyes de Maxwell. En su forma diferencial se escribe de la siguiente forma:

|

Donde E es el campo eléctrico. Mientras que en su forma integral viene dada por:

|

O lo que es lo mismo: si sumamos las líneas de campo E que salen y entran en una superficie cerrada nos dará la distribución de carga total encerrada dentro de esa superficie. Para situaciones con geometría esférica este problema es trivial, pues el campo será equivalente al generado por una carga puntual, pero no lo es tanto si es de otro modo. También nos dice que el campo dentro de una esfera hueca cargada es nulo, puesto que cualquier superficie cerrada interior no contiene ninguna carga.

En cambio, los monopolos eléctricos (partículas que llevan carga eléctrica) son muy abundantes. Cada chispa de materia contiene un número increíble de electrones y protones que son auténticos monopolos eléctricos. Podríamos imaginar las líneas de fuerza del campo eléctrico surgiendo de una partícula cargada eléctricamente o convergiendo en ella y empezando o acabando allí. Además, la experiencia ha confirmado la ley de conservación de la carga eléctrica: la carga monopólica eléctrica total de un sistema cerrado no puede crearse ni puede destruirse. Pero en el mundo del magnetismo, no existe nada similar a los monopolos eléctricos, aunque un monopolo magnético sea fácilmente concebible.

Ene

18

Intrincada búsqueda: ¡La Gravedad cuántica!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

Nunca han importado muchos los peligros que tengamos que correr para buscar las respuestas de lo profundamente escondido en la Naturaleza, ni tampoco ha importado hasta donde ha tenido que viajar la imaginación para configurar modelos y teorías que, más tarde, queremos verificar.

También una teoría cuántica de la gravedad debería ampliar nuestro conocimiento de efectos cuánticos predichos por enfoques tentativos de otras teorías cuánticas, como la existencia de radiación de Hawking.”

¡Y mucho más sobre este mismo tema!

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “supergravedad”, “súpersimetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

“El concepto de una “teoría del todo” está arraigado en el principio de causalidad y su descubrimiento es la empresa de acercarnos a ver a través de los ojos del demonio de Laplace. Aunque dicha posibilidad puede considerarse como determinista, en una “simple fórmula” puede todavía sobrevivir la física fundamentalmente probabilista, como proponen algunas posturas actuales de la mecánica cuántica. Esto se debe a que aun si los mecanismos que gobiernan las partículas son intrínsecamente azarosos, podemos conocer las reglas que gobiernan dicho azar y calcular las probabilidades de ocurrencia para cada evento posible. Sin embargo, otras interpretaciones de la ecuación de Schrödinger conceden poca importancia al azar: este solo se tendría importancia dentro del átomo y se diluiría en el mundo macroscópico. Otras no obstante la niegan completamente y la consideran una interpretación equivocada de las leyes cuánticas. En consecuencia, la mayor dificultad de descubrir una teoría unificada ha sido armonizar correctamente leyes que gobiernan solo un reducido ámbito de la naturaleza y transformarlas en una única teoría que la explique en su totalidad, tanto en su mundo micro como macroscópico y explique la existencia de todas las interacciones fundamentales: las fuerzas gravitatoria, electromagnética, nuclear fuerte y nuclear débil.”

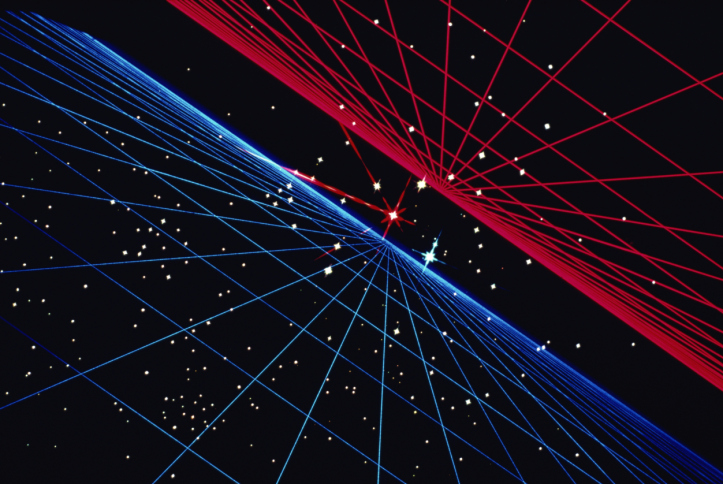

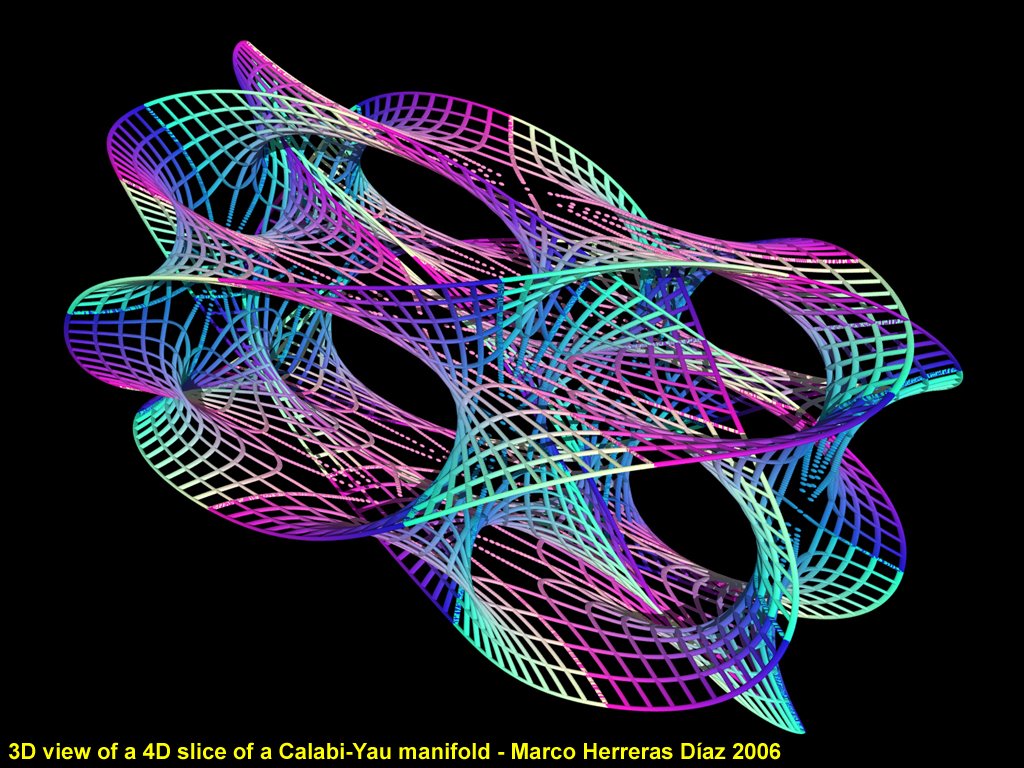

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para poder contemplar esas cuerdas vibrantes si es que están allí?

Ni vemos la longitud de Planck ni las dimensiones extra y, nos dicen que para poder profundizar hasta esa distancia, necesitamos disponer de la Energía de Planck, es decir 1019 GeV, una energía que ni en las próximas generaciones estará a nuestro alcance. Pero mientras tanto, hablamos de que, en 2.015, el LHC buscará las partículas de la “materia oscura”. ¡Qué gente!

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

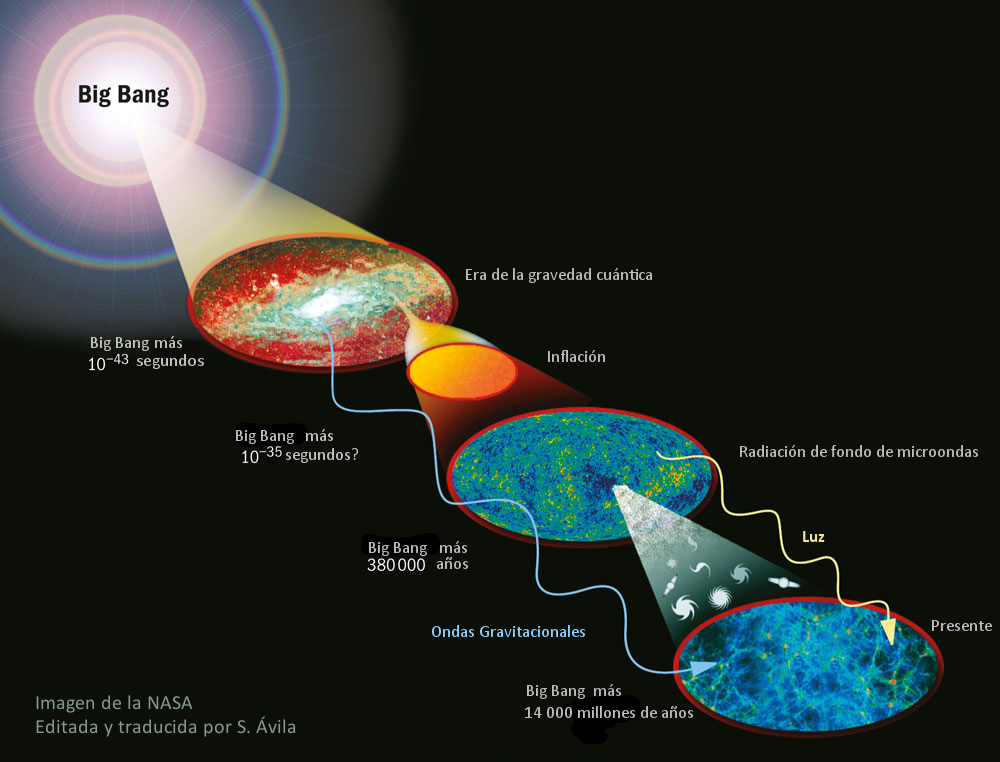

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro universo ¿es tridimensional y no podemos esas dimensiones extra de las que tanto hablan en las teorías más avanzadas pero, no verificadas?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que antes os hablaba.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. Ya sabéis lo que pasa cuando queremos juntar la relatividad con la cuántica: ¡Aparecen los infinitos que no son renormalizables!

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la física de partículas que incluye sólo tres de las interacicones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada y el hallazgo ha merecido el Nobel de Física. Sin embargo… nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

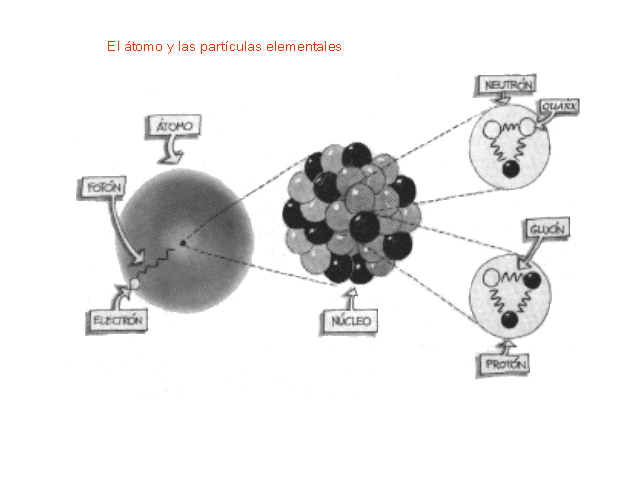

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

¿Es el efecto frenado que sufren las partículas que corren por el océano de Higgs, el que les da la masa?

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más

apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs(de ahí la expectación creada por el acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

No dejamos de experimentar para saber cómo es nuestro mundo, la Naturaleza, el Universo que nos acoge

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-Salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébilse fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Hay otra descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Desde Kaluza-Klein, la primera teoría de más dimensiones, estamos tratando de buscar como representar un espacio con dimensiones extra, y, a pesar de los muchos intentos, lo cierto es que, nuestro mundo sólo tiene tres de espacio y una de tiempo… ¿Dónde estarán esas otras hasta llegar a 11?

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

La topología es, el estudio de aquellas propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. La topología es probablemente la más joven de las ramas clásicas de las matemáticas. En contraste con el álgebra, la geometría y la teoría de los números, cuyas genealogías datan de tiempos antiguos, la topología aparece en el siglo diecisiete, con el nombre de analysis situs, ésto es, análisis de la posición.

De manera informal, la topología se ocupa de aquellas propiedades de las figuras que permanecen invariantes, cuando dichas figuras son plegadas, dilatadas, contraídas o deformadas, de modo que no aparezcan nuevos puntos, o se hagan coincidir puntos diferentes. La transformación permitida presupone, en otras palabras, que hay una correspondencia biunívoca entre los puntos de la figura original y los de la transformada, y que la deformación hace corresponder puntos próximos a puntos próximos. Esta última propiedad se llama continuidad, y lo que se requiere es que la transformación y su inversa sean ambas continuas: así, trabajarnos con homeomorfismos.

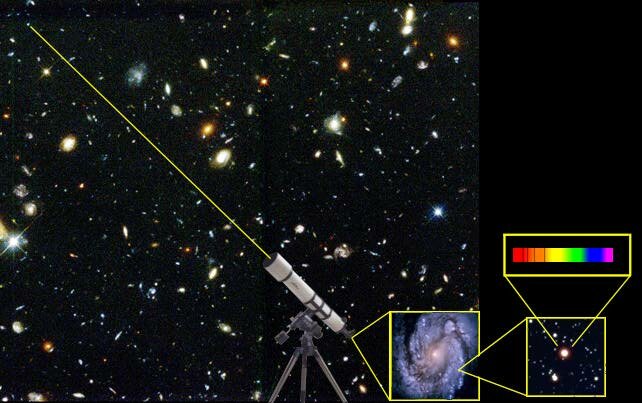

En cuanto a nuestra comprensión del universo a gran escala (galaxias, el Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado.

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situados los orígenes de esa “fuerza”, “materia”, o, “energía” que ahora no sabemos ver para explicar el anómalo movimiento de las galaxias o la expansión del espacio que corre sin freno hacia… ¿Otro universo que tira del nuestro, como ocurren con las galaxias que terminan por fusionarse?

emilio silvera

Ene

15

¿El núcleo del átomo? ¡Una maravilla de la Naturaleza!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

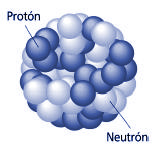

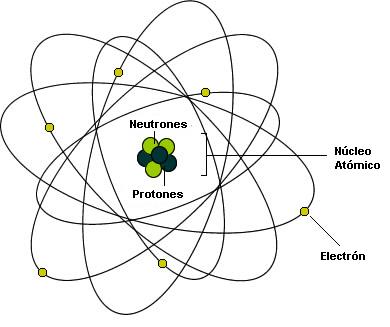

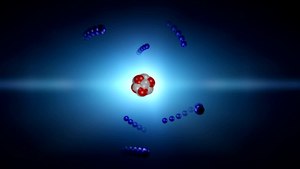

Las partículas del núcleo atómico. Protón y neutrón.

En 1920 (Rutherford) descdubrió las partículas positivas que forman los átomos, los protones.

Por lo tanto en los núcleos de los átomos hay unas partículas positivas que se llaman protones. En el hidrógeno solo hay una partícula ya que recordemos su masa era casi la misma.

Se comprobó que el número de protones es una característica especial de cada elemento químico, ya que todos los átomos del mismo elemento tienen el mismo número de protones. Se llama número atómico (Z) al número de protones que tienen los átomos de un elemento químico. A cada elemento químico le corresponde un número atómico desde 1 hasta 106.

Todavía tenemos que buscar otras partículas en el núcleo atómico. La masa de los protones de un núcleo es mucho menor que la masa del núcleo.

Cada elemento químico se caracteriza por el número de protones de su núcleo, que se denomina número atómico (Z). Así, el hidrógeno ( 1H) tiene un protón, el carbono ( 6C) tiene 6 protones y el oxígeno ( 8O) tiene 8 protones en el núcleo.

El número de neutrones del núcleo puede variar. Casi siempre hay tantos o más neutrones que protones. La masa atómica(A) se obtiene sumando el número de protones y de neutrones de un núcleo determinado.

Un mismo elemento químico puede estar constituído por átomos diferentes, es decir, sus números atómicos son iguales, pero el número de neutrones es distinto. Estos átomos se denominan isótopos del elemento en cuestión. Isótopos significa “mismo lugar“, es decir, que como todos los isótopos de un elemento tienen el mismo número atómico, ocupan el mismo lugar en la Tabla Periódica.

isótopos del Hidrógeno

Isótopos del Carbono

Desde 1918 estaba probado que existían los isótopos. Estos, eran átomos que tenían propiedades químicas iguales (parecían elementos iguales, por tanto), tenían el mismo número atómico, pero sus masas atómicas eran diferentes. En el núcleo debían existir partículas neutras que contribuyeran a la masa pero no tuvieran carga eléctrica.

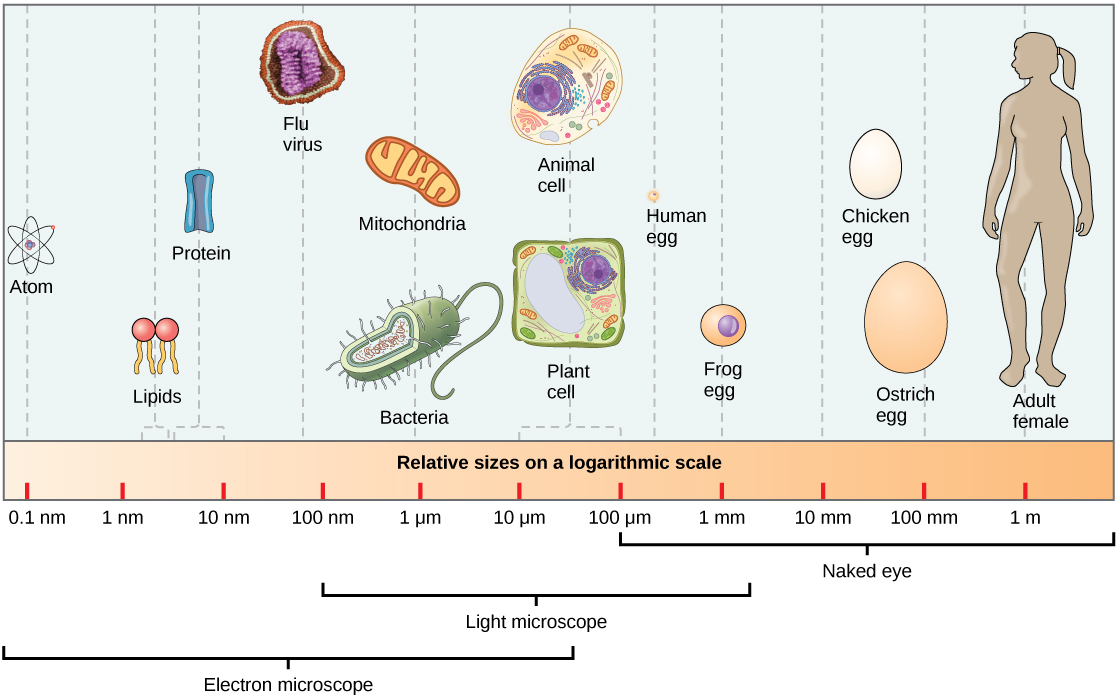

La curiosidad acerca del tamaño y masa del átomo atrajo a cientos de científicos durante un largo período en el que la falta de instrumentos y técnicas apropiadas impidió lograr respuestas satisfactorias. Con posterioridad se diseñaron numerosos experimentos ingeniosos para determinar el tamaño y peso de los diferentes átomos.

El átomo más ligero, el de hidrógeno, tiene un diámetro de aproximadamente 10-10 m (0,0000000001 m) y una masa alrededor de 1,7 x 10-27 kg (la fracción de un kilogramo representada por 17 precedido de 26 ceros y una coma decimal).

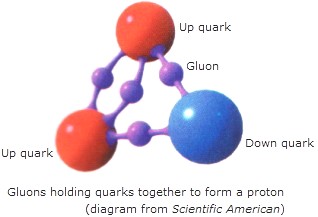

Como no es el objeto del trabao, no hablaremos hoy de los Quarks, y, simplemente diremos que en la naturaleza no se encuentran quarks aislados. Estos siempre se encuentran en grupos, llamados Hadrones. de dos o tres quarks, conocidos como mesones y bariones respectivamente. Esto es una consecuencia directa del confinamiento de color. En el año 2003 se encontró evidencia experimental de una nueva asociación de cinco quarks, los Pentaquarks, cuya evidencia, en principio controvertida , fue demostrada gracias al Colisionador de Partículas LHC en el pasado Julio de 2.015.

Pero sigamos con lo que nos ocupa y veámos que los Quarks están confinados dentro de los nucleones (protones y neutrones) donde la fuerza fuerte les retiene y nos los deja que se vayan alejando más de lo debido como se explica en el cuadro de arriba.

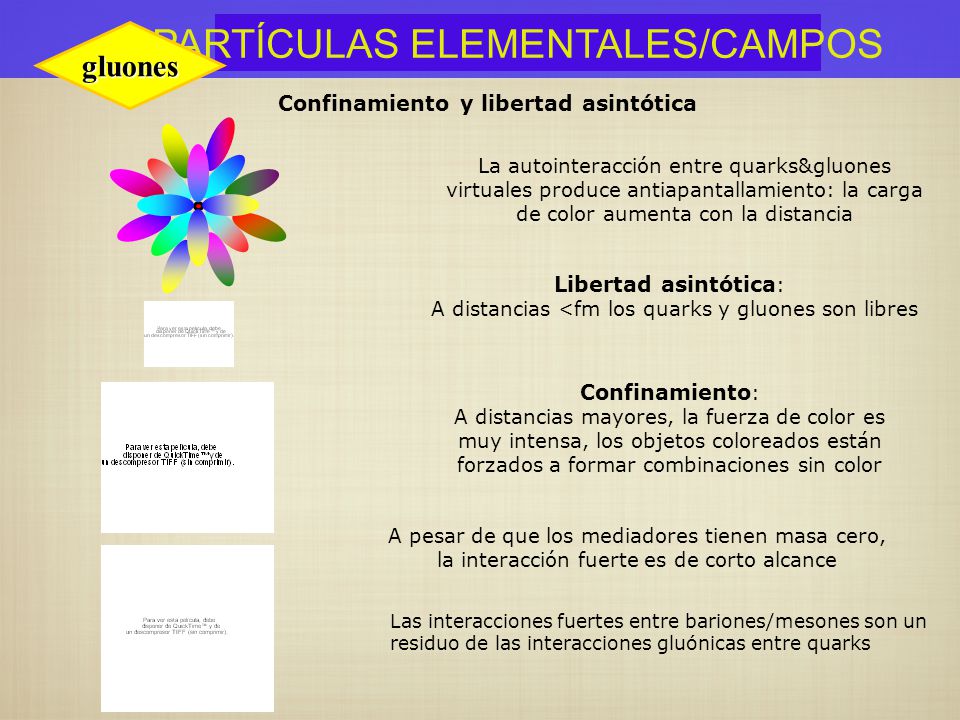

Dentro del nucleo se desatan las fuerzas de la Naturaleza, la que conocemos como fuerza nuclear fuerte, la más potente de las cuatro fuerzas fundamentales que, intermediada por otras partículas de la familia de los Bosones, los Gluones, no dejan que los Quarks se alejen y son retenidos allí, dentro de los nucleones donde tienen su función de conformar los hadrones másicos del núcleo que le aporta la materia al átomo.

Los Gluones, son las partículas intermediarias de la fuerza fuerte, y, de la misma manera, existen otros Bosones encargados de mediar en las otras fuerzas conocidas de la Naturaleza: El Fotón para los fenómenos electromagnéticos, el Gravitón (no encontrado aún) para la fuerza de Gravedad, y, los W+, W–y Zº para la fuerza nuclear débil.

Este acontecimiento se está dando continuamente en el interior de estrellas como el Sol, y es de esperar que se pueda reproducir algún día cercano para obtener energía barata y limpia mediante fusión nuclear.

El protón y el neutrón son Hadrones de la rama bariónica, y, el electrón, es un Leptón. Todos están presentes en el átomo, los primeros en el núcleo y el segundo formando la parte electrónica de espacios magnéticos que forman en su deambular a su alrededor.

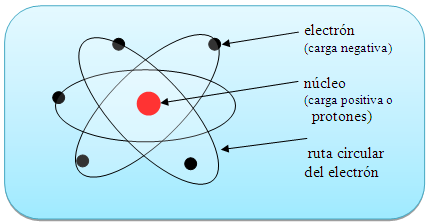

Lo cierto es que, el núcleo atómico está cargado positivamente y, tal carga, hace la llamada para que, un enjambre de electrones, con cargas negativas, vengan a rodear el núcleo atómico y, de esa manera, queda estabilidado el átomo, ese pequeño objeto que conforma todas las cosas hechas de materia.

Así, los electrones que rodea el núcleo, con su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). Y, sin embargo, la importancia del electrón es vital en el universo.

Repasando todo esto, no puedo dejar de recordar aquellas palabras que el físico Freeman Dyson escribió:

“Cuando miramos en el universo e identificamos los muchos accidentes de la física y la astronomía que han colaborado en nuestro beneficio, casi parece que el universo debe haber sabido, en cierto sentido, que nosotros íbamos a venir“.

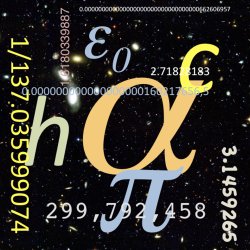

α es la constante de estructura fina, si variara con el paso del tiempo… … la vida no podría existir. Esas constantes hacen posible nuestra presencia aquí.

Fijaros en el hecho cierto de que, si la carga del electrón, o, la masa del protón, variaran aunque sólo fuese una diezmillonésima parte… ¡La vida no podría existir en el Universo! Estamos hechos de átomos y, con tal cambio, éstos nunca se habrían podido conformar.

emilio silvera.

Ene

13

¡Fluctuaciones de vacío! ¿Que son?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Un fuerte campo gravitatorio puede inducir un efecto desbocado en las fluctuaciones cuánticas que se producen en el espacio, aparentemente vacío, …

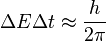

En física cuántica, la fluctuación cuántica es un cambio temporal en la cantidad de energía en un punto en el espacio como resultado del Principio de Incertidumbre que imaginó Werner Heisenberg. De acuerdo a una formulación de este principio energía y tiempo se relacionan de la siguiente forma:

Esto significa que la conservación de la energía puede parecer violada, pero sólo por breves lapsos. Esto permite la creación de pares partícula-antipartícula de partículas virtuales. El efecto de esas partículas es medible, por ejemplo, en la carga efectiva del electrón, diferente de su carga “desnuda”. En una formulación actual, la energía siempre se conserva, pero los estados propios del Hamiltoniano no son los mismos que los del operador del número de partículas, esto es, si está bien definida la energía del sistema no está bien definido el número de partículas del mismo, y viceversa, ya que estos dos operadores no conmutan.

Las fluctuaciones del vacío entre una esfera y una superficie plana

En un estudio realizado por un equipo de físicos con avanzados aparatos, han hallado un resultado del que nos dicen:

La materia se construye sobre fundamentos frágiles. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vació cuántico. Los investigadores simularon la frenética actividad que sucede en el interios de los protones y neutrones, que como sabéis son las partículas que aportan casi la totalidad de la masa a la materia común.

Cada protón (o neutrón) se compone de tres quarks – véase ilustración – pero las masas individuales de estos quarks apenas comprenden el 1% del total de la masa del protón¿Entonces de dónde sale el resto? La teoría sostiene que esta masa es creada por la fuerza que mantiene pegados a los quarks, y que se conoce como fuerza nuclear fuerte. En términos cuánticos, la fuerza fuerte es contenida por un campo de partículas virtuales llamadas gluones, las cuales irrumpen aleatoriamente en la existencia para desaparecer de nuevo. La energía de estas fluctuaciones del vacío debe sumarse a la masa total del neutróny del protón.

En nuestras mentes se acumulan signos y fórmulas que quieren ser los exponentes de la verdadera razón y origen de la materia pero… ¡Estaremos acertando!

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material desde las partículas elementales hasta las montañas y los océanos. Unas veces está en estado “inerte” y otras, se eleva hasta la vida que incluso, en ocasiones, alcanza la consciencia de SER. Sin embargo, no acabamos de dilucidar de dónde viene su verdadero origen, su esencia, lo que era antes de “ser” materia. ¿Existe acaso una especie de sustancia cósmica anterior a la materia? Y, si realmente existe esa sustancia… ¿Dónde está?

Claro que hemos llegado a saber que las llamadas fluctuaciones del vacío son oscilaciones aleatorias, impredecibles e ineliminables de un campo de fuerza (electromagnético o gravitatorio) que son debidas a un “tira y afloja” en el que pequeñas regiones del espacio toman prestada, momentáneamente, energía de regiones adyacentes y luego las devuelven. Pero…

– ¿Qué regiones adyacentes?

Acaso universos paralelos, acaso defomraciones del espacio-tiempo a escalas microscópicas, micros agujeros negros que pasan a ser agujeros blancos salidos de estas regiones o campos de fuerza que no podemos ver pero sí sentir, y, en última instancia, ¿por qué se forman esas partículas virtuales que de inmediato se aniquilan y desaparecen antes de que puedan ser capturadas? ¿Qué sentido tiene todo eso?

Las consecuencias de la existencia del cuanto mínimo de acción fueron revolucionarios para la comprensión del vacío. Mientras la continuidad de la acción clásica suponía un vacío plano, estable y “realmente” vacío, la discontinuidad que supone el cuanto nos dibuja un vacío inestable, en continuo cambio y muy lejos de poder ser considerado plano en las distancias atómicas y menores. El vacío cuántico es de todo menos vacío, en él la energía nunca puede quedar estabilizada en valor cero, está fluctuando sobre ese valor, continuamente se están creando y aniquilando todo tipo de partículas, llamadas por eso virtuales, en las que el producto de su energía por el tiempo de su existencia efímera es menor que el cuanto de acción. Se llaman fluctuaciones cuánticas del vacío y son las responsables de que exista un que lo inunda todo llamado campo de punto cero.

Pero volvamos de nuevo a las fluctuaciones de vacío, que al igual que las ondas “reales” de energía positiva, están sujetas a las leyes de la dualidad onda/partícula; es decir, tienen tanto aspectos de onda como aspectos de partícula.

Las ondas fluctúan de forma aleatoria e impredecible, con energía positiva momentáneamente aquí, energía negativa momentáneamente allí, y energía cero en promedio. El aspecto de partícula está incorporado en el concepto de partículas virtuales, es decir, partículas que pueden nacer en pares (dos partículas a un tiempo), viviendo temporalmente de la energía fluctuacional tomada prestada de regiones “vecinas” del , y que luego se aniquilan y desaparecen, devolviendo la energía a esas regiones “vecinas”. Si hablamos de fluctuaciones electromagnéticas del vacío, las partículas virtuales son fotones virtuales; en el caso de fluctuaciones de la gravedad en el vacío, son gravitones virtuales.

De las llamadas fluctuaciones de vacío pueden surgir, partículas virtuales y quién sabe que cosas más… Hasta un nuevo Universo.

Son muchas las preguntas que no tienen respuestas

Parece que las fluctiuaciones ocurren en cualquier lugar, pero que, son tan minúsculas que ningún observador o experimentador las ha detectado de una manera franca hasta la fecha y, se sabe que están ahí por experimentos que lo han confirmado. Estas fluctuaciones son más poderosas cuanto menos escala se considera en el espacio y, por debajo de la longitud de Planck-Wheeler las fluctuaciones de vacío son tan enormes que el espacio tal como lo conocemos “pareciera estar hirviendo” para convertirse en una especie de espuma cuántica que parece que en realidad, cubre todo el espacio “vacío cuántico” que sabemos que está ahí y es el campo del que surgen esas partículas virtuales que antes menccionaba.

¿Espuma cuántica? Si profundizamos mucho en la materia… Podríamos ver otro universo distinto al nuestro. Las cosas miles de millones de veces más pequeñas que en nuestro mundo cotidiano, no parecen las mismas cosas.

Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro. ¡Qué locura!

es la escala de longitud por debajo de la cual el tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro. ¡Qué locura!

En el complejo general, por ahí, en alguna parte, permanece oculta esa teoría cuántica de la gravedad que incansables (pero sin ningún éxito hasta el momento) buscamos. Cuando sepamos unir las dos teorías de lo pequeño y lo grande, lo tendremos todo.

Como tantas veces hemos comentado, los trabajos que se han realizado sobre poder construir una teoría cuántica de la gravedad nos llevan a un sorprendente de implicaciones. Por un lado, sólo se ha podido conceptuar a la gravedad cuántica, siempre y cuando, el universo tenga más de cuatro dimensiones. Además, se llega a considerar que en la era de Planck, tanto el universo como la gravedad pudieron ser una sola cosa compacta estructurada por objetos cuánticos infinitamente diminutos, como los que suponemos que conforman las supercuerdas. A esta escala, el mismísimo espaciotiempo estaría sometido a imprescindibles fluctuaciones muy semejantes a las que causan las partículas al nacer y desaparecer de la existencia en el espaciotiempo ordinario. Esta noción ha conducido a los teóricos a describir el universo de la era cuántica como una especie de extremadamente densa y agitada espuma que pudo haber contenido las vibrantes cuerdecillas que propugnan los cosmólogos cuerdistas.

Los físicos especulan que el cosmos ha crecido a desde una «nada» primigenia que al nacer comenzó el principio del tiempo y que, en ese parto, contenía toda la materia y toda la energía.

En física como en todas las demás disciplinas científicas, los conocimientos avanzan y las teorías que sostuvieron los cimientos de nuestros conocimientos se van haciendo viejas y van teniendo que ser reforzadas con las nuevas y más poderosas “vigas” de las nuevas ideas y los nuevos hallazgos científicos que hacen posible ir perfeccionando lo que ya teníamos.

Recientemente se han alzado algunas voces contra el Principio de Incertidumbre de Heisenberg. He podido leer en un artíoculo de la prestigiosa Revista Nature, un artículo del premio Nobel de Física Gerald ´t Hoofft, en el que propone que la naturaleza probabilistica de la mecánica cuántica, desaparecería a la escala de Planck, en la que el comportamiento de la materia sería determinista; a longitudes mayores, energías más pequeñas.

El mundo de lo muy pequeño (el micro espacio), a nivel atómico y subatómico, es el dominio de la física cuántica, así nunca podríamos saber, de acuerdo m con el principio de incertidumbre, y, en un momento determinado, la posición y el estado de una partícula. Este estado podría ser una función de la escala espacio-temporal. A esta escala tamaños todo sucede demasiado deprisa para nosotros.

El “universo cuántico” nada es lo que parece a primera vista, allí entramos en otro mundo que en nada, se parece al nuestro

Cuando hablamos de la mecánica cuántica, tenemos mirar un poco hacia atrás en el tiempo y podremos darnos del gran impacto que tuvo en el devenir del mundo desde que, en nuestras vidas, apareció el átomo y, más tarde, sus contenidos. Los nombres de Planck, Einstein, Bohr, Heisenberg, Schrödinger, Pauli, Bardeen, Roentgen, Dirac y muchos otros, se pudieron a la cabeza de la lista de las personas más famosas. Aquel primer premio Nobel de Física otorgado en 1900 a Roentgen por descubrir los rayos X, en el mismo año llegaría el ¡cuanto! De Planck que inspiró a Einstein para su trabajo sobre el Efecto fotoeléctrico que también, le valdría el Nobel, y, a partir de ese momento, se desencadenó una especie de alucinante por saber sobre el átomo, sus contenidos, y, de qué estaba hecha la materia.

La conocida como Paradoja EPR y los conceptos de Tiempo y , presente, pasado y futuro.

“Nadie ha resuelto la paradoja del gato de Schroedinger, ni la paradoja de Einstein-Podolsky-Rosen. El principio de incertidumbre no se ha explicado y se asume como un dogma, lo mismo pasa con el spin. El spin no es un giro pero es un giro. Aquí hay un desafío al pensamiento humano. ¡Aquí hay una aventura del pensamiento!”

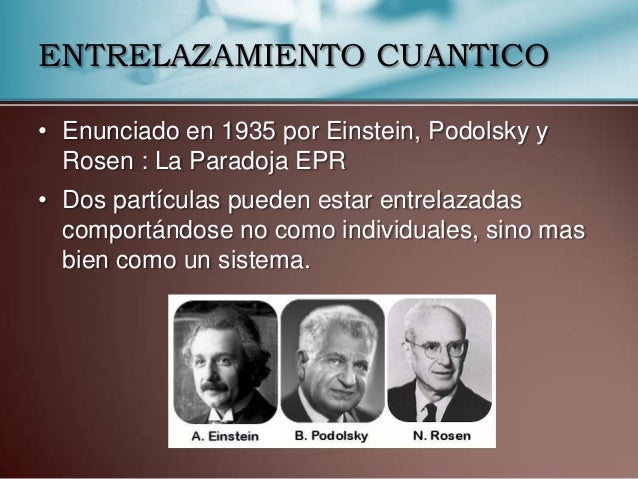

Fueron muchas las polémicas desatadas a cuenta de las aparentes incongruencias de la moderna Mecánica Cuántica. La paradoja de Einstein-Podolsky-Rosen, denominada “Paradoja EPR”, trata de un experimento mental propuesto por Albert Einstein, Boris Podolsky y Nathan Rosen en 1935. Es relevante, pues pone de manifiesto un problema aparente de la mecánica cuántica, y en las décadas siguientes se dedicaron múltiples esfuerzos a desarrollarla y resolverla.

A Einstein (y a muchos otros científicos), la idea del entrelazamiento cuántico le resultaba extremadamente perturbadora. Esta particular característica de la mecánica cuántica permite preparar estados de dos o más partículas en los cuales es imposible obtener útil sobre el estado total del sistema haciendo sólo mediciones sobre una de las partículas.

Por otro lado, en un entrelazado, manipulando una de las partículas, se puede modificar el estado total. Es decir, operando sobre una de las partículas se puede modificar el estado de la otra a distancia de manera instantánea. Esto habla de una correlación entre las dos partículas que no tiene paralaje en el mundo de nuestras experiencias cotidianas. Cabe enfatizar pues que cuando se mide el estado de una partícula, enseguida sabemos el estado de la otra, lo cual aparentemente es instantáneo, es decir, sin importar las distancias a las que se encuentren las partículas, una de la otra, ambas saben instantáneamente el estado de la otra.

El experimento planteado por EPR consiste en dos partículas que interactuaron en el pasado y que quedan en un estado entrelazado. Dos observadores reciben cada una de las partículas. Si un observador mide el momento de una de ellas, sabe cuál es el momento de la otra. Si mide la posición, gracias al entrelazamiento cuántico y al principio de incertidumbre, puede la posición de la otra partícula de forma instantánea, lo que contradice el sentido común.

Animación que muestra dos átomos de oxígeno fusionándose para formar una molécula de O2 en su estado cuántico fundamental. Las nubes de color representan los orbitales atómicos. Los orbitales 2s y 2p de cada átomo se combinan para formar los orbitales σ y π de la molécula, que la mantienen unida. Los orbitales 1s, más interiores, no se combinan y permiten distinguir a cada núcleo. Lo que ocurre a escalas tan pequeñas es fascienante.

Si nos pudiéramos convertir en electrones, por ejemplo, sabríamos dónde y cómo estamos en cada momento y podríamos ver asombrados, todo lo que estaba ocurriendo a nuestro alrededor que, entonces sí, veríamos transcurrir a un ritmo más lento del que podemos detectar en los electrones desde nuestro macroestado espacio temporal. El electrón, bajo nuestro punto de vista se mueve alrededor del núcleo atómico a una velocidad de 7 millones de km/h.

A medida que se asciende en la escala de tamaños, hasta el tiempo se va ajustando a esta escala, los objetos, a medida que se hacen mayores se mueven más despacio y, además, tienen más duración que los pequeños objetos infinitesimales del micro mundo cuántico. La vida media de un neutron es de unos 15 minutos, por ejemplo, mientras que la vida media de una estrellas se puede contar en miles de millones de años.

En nuestra macroescala, los acontecimientos y ,los objetos se mueven a velocidades que a nosotros nos parecen normales. Si se mueven con demasiada lentitud nos parece que no se mueven. Así hablamos de escala de tiempo geológico, para referirnos al tiempo y velocidad de la mayor parte de los acontecimientos geológicos que afectan a la Tierra, el tiempo transcurre aquí en millones de años y nosotros ni lo apreciamos; nos parece que todo está inmóvil. Nosotros, los humanos, funcionamos en la escala de años (tiempo biológico).

El Tiempo Cosmológico es aún mucho más dilatado y los objetos cósmicos (mundos, estrellas y galaxias), tienen una mayor duración aunque su movimiento puede ser muy rápido debido a la inmensidad del espacio universal en el que se mueven. La Tierra, por ejemplo, orbita alrededor del Sol a una velocidad media de 30 Km/s., y, el Sol, se desplaza por la Galaxia a una velocidad de 270 km/s. Y, además, se puede incrementar el tiempo y el espacio en su andadura al estar inmersos y ligados en una misma maya elñástica.

Así, el espacio dentro de un átomo, es muy pequeño; dentro de una célula, es algo mayor; dentro de un animal, mayor aún y así sucesivamente… hasta llegar a los enormes espaciosa que separan las estrellas y las galaxias en el Universo.

Distancias astronómicas separan a las estrellas entre sí, a las galaxias dentro del cúmulo, y a los cúmulos en los supercúmulos.

Las distancias que separan a los objetos del Cosmos se tienen que medir con unidades espaciales, tal es su inmensa magnitud que, nuestras mentes, aunque podamos hablar de ellas de manera cotidiana, en realidad, no han llegado a asimilarlas.Y, a todo ésto, los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Los físicos no están seguros si el problema es técnico o conceptual. No obstante, incluso prescindiendo de una teoría completa de gravedad cuántica, se puede deducir que los efectos de la teoría cuántica, habrían cruciales durante los primeros 10-43 segundos del inicio del universo, cuando éste tenía una densidad de 1093 gramos por centímetro cúbico y mayor. (El plomo sólido tiene una densidad de aproximadamente diez gramos por centímetro cúbico.) Este período, que es el que corresponde a la era de Planck, y a su estudio se le llama cosmología cuántica. Como el universo en su totalidad habría estado sujeto a grandes incertidumbres y fluctuaciones durante la era de Planck o era cuántica, con la materia y la energía apareciendo y desapareciendo de un vacío en grandes cantidades, el concepto de un principio del universo podría no tener un significado bien definido. En todo caso, la densidad del universo durante este período es de tal magnitud que escapa a nuestra comprensión. Para propósitos prácticos, la era cuántica podría considerarse el estado inicial, o principio, del universo. En consecuencia, los procesos cuánticos ocurridos durante este período, cualquiera sea su naturaleza, determinaron las iniciales del universo.

Una cosa nos ha podido quedar clara: Los científicos para lograr conocer la estructura del universo a su escala más grande, deben retroceder en el tiempo, centrando sus teorías en el momento en que todo comenzó. Para ello, como todos sabéis, se han formulado distintas teorías unificadoras de las cuatro fuerzas de la naturaleza, con las cuales se han modelado acontecimiento y en el universo primitivo casi a todo lo largo del camino hasta el principio. Pero cómo se supone que debió haber habido un «antes», aparece una barrera que impide ir más allá de una frontera que se halla fijada a los 10-43 [s] después del Big Bang, un instante conocido como «momento de Planck», en homenaje al físico alemán Max Planck.

Esta barrera existe debido a que antes del momento de Planck, durante el período llamado la «era de Planck o cuántica», se supone que las cuatro fuerza fundamentales conocidas de la naturaleza eran indistinguibles o se hallaban unificadas , que era una sola fuerza. Aunque los físicos han diseñado teorías cuánticas que unen tres de las fuerzas, una por una, a través de eras que se remontan al momento de Planck, hasta ahora les ha prácticamente imposible armonizar las leyes de la teoría cuántica con la gravedad de la relatividad de Einstein, en un sólo modelo teórico ampliamente convincente y con posibilidades claras de ser contrastado en experimentos de laboratorio y, mucho menos, con observaciones.

Y después de todo ésto, sólo una caso me queda clara: ¡Lo poco que sabemos! A pesar de la mucha imaginación que ponemos en las cosas que creemos conocer.

emilio silvera

Ene

10

Cosas de la Mecánica Cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

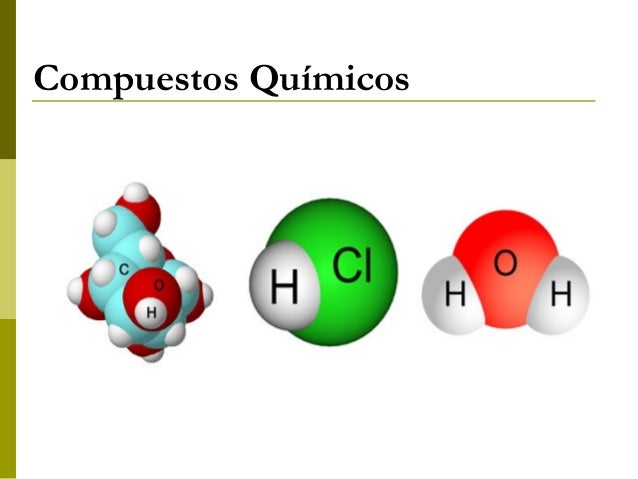

¡La Física! Esa maravilla que está presente en todo lo que podemos ver y en aquello donde la vista no llega. La infinitud de las partículas elementales que forman todo cuanto existe en la Naturaleza, no siempre se dejan ver ni hacen posible que podamos observar las maravillas que pueden llevar a cabo,

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos, y, si está conformada por distintos átomos, son compuestos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su forma esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.8836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos hacia el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, para lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Claro que, no debemos olvidarnos de que, ¡Todo lo grande está hecho de cosas pequeñas! Una inmensa galaxia se conforma de un conjunto inmenso de átomos inifinitesimales que juntos, hace ese gran todo.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. Cuando uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

La perfecta sincronía Está en la Naturaleza

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = h x v

Donde E es la energía del paquete, v la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Los cuantos de energía están presentes por todas partes y en todos los objetos

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió como escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial como general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no puede por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza.

emilio silvera

Totales: 74.385.854

Totales: 74.385.854 Conectados: 18

Conectados: 18