Jul

5

¿Cuál es el Camino? No hay ningún camino.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

El Camino lo tenemos que hacer nosotros al andar. Lo mismo que se forma la vereda en la Montaña cuando los seres vivos pasan por el mismo sitio una y otra vez, dando lugar a que se forme una línea en la tierra mil veces pisada que nos habla del paso por aquel lugar que los viandantes han creído el más idóneo para transitar hacia algún otro sitio. Lo tuvieron que elegir de manera racional al ser el más indicado y, por ese “camino” se creó el sendero por el que caminar. Antes allí, no había camino.

No pocas veces, el camino se crea a partir de una idea, una intuición, una ganas de saber lo que hay más allá de nuestros dominios, de explorar lo desconocido, de comprobar si la fascinación que presentimos por lo que pensamos que “allí” pueda existir, se debe a una certera intuición, o, por el contrario, es sólo un espejismo. No siempre el explorardor encontró aquella civilización perdida que gritaba insistente en su mente llamándolo sin cesar, ni el científico encuentra la anhelada explicación a un secreto de la Naturaleza que, tan claramente veía en sus sueños.

Está claro que el mismo acto de la exploración, modifica la perspectiva del explorador; Ni Ulises, Marco Polo o Colón podían ser los mismos cuando, después de sus respectivas aventuras regresaron a sus hogares. Lo mismo ha sucedido con la investigación científica en los extremos de las escalas, desde la grandiosa extensión del esapcio cosmológico…

… hasta el mundo minúsculo y enloquecido de las partículas subatómicas.

Estos viajes nos cambiaron y cambiaron muchos de los conceptos ancestrales que, en nuestras mentes, estaban apaciblemente aposentados y, desafiaron muchas de las concepciones científicas y también filosóficas que más valorábamos. Algunas, ante aquella realidad nueva, tuvieron que ser desechadas, como el bagaje que se deja atrás en una larga y pesada travesía un desierto. Otras tuvieron que ser modificadas y reconstituidas hasta quedar casi irreconocibles.

La exploración en el ámbito de las galaxias y cúmulos de galaxias esxtendió el alcanza de la visión humana en un factor de 1026 veces mayor que la propia escala humana, y produjo la revolución que identificamos con la relatividad, la cual reveló que la concepción newtoniana del mundo sólo era una perspectiva parroquiana dentro de un universo más vasto donde el espacio es curvo y el tiempo se hace flexible.

La exploración en el dominio subatómico nos llevó lejos en el ámbito de lo muy pequeño, a unos 10-15 de la escala humana, y también significó una revolución. Esta fue la física cuántica que transformó todo lo que abordó a partir de su nacimiento en 1900, cuando Max Planck, escribió aquel artículo de ocho páginas que fueron las semillas de las que más tarde, germiron “las flores” de la M.C.. Planck, comprendiò que sólo podía explicar lo que se llamaba la Curva del Cuerpo Negro -el espectro de energía que genera un objeto de radiación perfecta- si abandonaba el supuesto clásico de que la emisión de enertgía es continua, y lo reemplazó por la hipótesis sin presecentes de que la energía se emite en unidades discretas. Planck llamó cuantos a estas unidades y quedaron simbolizadas por la letra h.

Plan no era ningún revolucionario -a la edad de 42 años era un viejo, juzgado por los patrones de las ciencias matemáticas y, además, un pilar de la elevada cultura germana del siglo XIX-, pero se percató fácilmente de que el principio cuántico echaría abajo buena parte de la física clásica a la que habñía dedicado buena parte de su vida y de su carrera.

“Cuanto mayores sean sus dificultades -escribió-… tanto más importante será finalmente para la ampliación y profundización del conocimiento de la Física.” Aquellas palabras fueron proféticas: cambiando y desarrollándose constantemente, modificando su coloración de manera tan impredecible como una reflexión en una burbuja de jabón, la física cuántuica pronto se expandió prácticamente a todo el ámbito de la física, y el cuanto de acción de Planck, h, llegó a ser considerado una constante de la naturaleza tan fundamental como la velocidad de la luz, c, de Einstein.

En una batalla entre los principios estrellas de la historia cuántica, sólo puede haber un ganador. O no puede? . En el invierno de 1926-1927, Werner Heisenberg el brillante joven alemán estaba trabajando como jefe asistente de Niels Bohr , alojado en un desván en la parte superior del instituto del gran danés de Copenhague. Después de un día de trabajo, Bohr se acercaba al encuentro con Heisenberg para hablar de física cuántica. A menudo se sentaban hasta altas horas de la noche, en un intenso debate sobre el significado de la teoría cuántica revolucionaria, entonces en su infancia.

Un rompecabezas que se ponderó eran los rastros de las gotitas que dejan los electrones al pasar a través de las cámara de niebla un aparato utilizado para rastrear los movimientos de partículas cargadas. Cuando Heisenberg trató de cálcular estas aparentemente precisas trayectorias usando las ecuaciones de la mecánica cuántica, no lo consiguió.

Una noche de mediados de febrero, Bohr había dejado la ciudad en un viaje de esquí, y Heisenberg se había deslizado a tomar un poco de aire de la noche en las amplias avenidas de Fælled Parque, detrás del instituto. Mientras caminaba, se le ocurrió. El rastro de los electrones no era preciso en lo absoluto: si uno lo mira de cerca, consiste en una serie de puntos difusos. Eso reveló algo fundamental sobre la teoría cuántica. De vuelta en su ático, Heisenberg escribió con entusiasmo su idea en una carta a su colega el físico Wolfgang Pauli. Lo esencial de esto apareció en un documento unas pocas semanas más tarde: “Mientras más precisa la posición es determinada, menor precisión, en el momento se conoce en este instante, y viceversa.”

Fórmula y gráfico que escenifican el Principio de Incertidumbre o Indeterminación

Así el notorio principio de incertidumbre de Heisenberg había nacido. Una declaración de la incognoscibilidad fundamental del mundo cuántico, que se ha mantenido firme durante la mayor parte del siglo. Pero ¿por cuánto tiempo? Corren rumores de que un segundo principio cuántico – el entrelazamiento- puede sonar el tañido de muerte para la incertidumbre.

Sólo podemos obtener respuestas parciales, cuya narturaleza está determinada en cierta medida por las cuestiones que optamos por infagar. Cuando Hesinberg calculó la cantidad mínima ineludible de incertidumbre que limita nuestra comprensión de los sucesos de pequeña escala, halló que está definida que nada menos que por h, el cuanto de acción de Planck.

La indeterminación cuántica no depende del aparato experimental que podamos emplear para la investigación del mundo subatómico. Se trata, en la medida de nuestro conocimiento, de una limitación absoluta, que los más destacados sabios de una civilización extraterrestre avanzada conpartirían con los más humildes físicos de la Tierra. En la física atómioca clásica se suponía que se podía, en proncipio, medir las situaciones y trayectorias precisas de miles de millones de partículas -digamos, protones– y a partir de los datos resultantes hacer predicciones exactas de donde estarían los protones en determinado tiempo futuro.

Heisenberg demostró que tal supuesto era falso, que nunca podremos saberlo todo sobre la conducta de siquiera una sóla partícula, mucho menos de una gran cantidad de ellas, y, por lo tanto, nunca podremos hacer predicciones sobre el futuro que sean completamente exactas en todos los detalles. Esto marcó un cambio fundamental en la visión del mundo de la física. Revelaba que no sólo la materia y la energía sino también el conocimiento están cuántizados.

El principio de incertidumbre es aplicado a modelos del espacio 3D ordinario, donde el espacio tiempo es continuo. En los sistema cuantizados con retículos diminutos que conforman a los superejes, la información de las partículas pasa de un retículo a otro o a una zona cuántica distinta del mismo retículo. Dado que en el modelo de los eventos, los objetos no pertenecen a los eventos, simplemente evolucionan generando más información de nuevos eventos, la incertidumbre asociada a estos puede estar relacionada con radio del bucle de los retículos diminutos, y para el traslado de la información de un retículo a otro debe existir un nivel incertidumbre en cuanto a cual retículo pertenece el evento durante la transferencia de dicha información, o ¿a qué conjunto de valores cuánticos del mismo pertenece?

La mecánica cuántica (el salto cuantico del electrón) nos desvelará el secreto de cómo el electrón puede, al recibir un fotón, desaparecer del nivel nuclear que ocupa para de manera instantánea, y sin necesidad de recorrer la distancia que los separa, aparecer como por arte de magia en un nivel superior. Copiaremos el salto cuántico para viajar. Nos introduciremos en un cabina, marcaremos las coordenadas, pulsaremos un botón y desapareceremos en Madrid y de manera instantánea, apareceremos de la nada en otra cabina igual situada en Nueva York a 6.000 Km de distancia.

…cuando el núcleo de un átomo es excitado por una fuente de energía exterior, tiene lugar el salto quántico, que consiste en el paso de un electrón a otra órbita con una energía mayor. No se sabe por donde hizo el viaje sin tener que andar la distancia entre el lugar de origen y el de llegada… ¿Por dónde habría hecho el viaje?

No puede quitarme de la cabeza que, el Salto Cuántico, nos dará la idea para viajar de manera que podamos burlar, la velocidad de la luz. Sin embargo, ese “futuro” no podré verlo. Resulta que un electrón situado alrededor del núcleo de un átomo, es impacto por un fotón energético y, de inmediato, el electrón desaparece del lugar que ocupa en la órbita atómica y, de manera instantánea, aparece en otro lugar más cercano al núcleo. Lo asombroso del caso es que, no se sabe qué camino pudo coger para desplazarse de un lugar a otro. Simplemente desapareció de uno y apareció en el otro. Ese es, amigos míos, el Salto cuántico. Si somos capaces de copiarlo, viajaremos a las estrellas sin que nos importe cuántos años-luz nos puedan separar de ellas.

¿Quién sabe lo que podemos extraer del salto cuántico? El efecto túnel nos podría dar la fórmula para viajar a lugares lejanos. Creo que todos nuestros sueños se podrían realizar si, en el momento adecuado, observando la Naturaleza, sabemos elegirt el camino que tenemos que andar para llegar a ese destino soñado,o, imaginado.

Nuestras Mentes buscarán las formas de solucionar todos esos problemas complejos que ahora inquietan a la Humanidad.

La Física cuántica nos obliga a tomarnos en serio lo que antes eran puramentes consideraciones filosóficas: que no vemos las cosas en sí mismas, sino sólo aspectos de las cosas. Lo que vemos en la trayectoria de un electrón en la cámara de niebla no es un electrón, y lo que vemos en el cielo no son estrellas, como una grabación de la voz de Pavoroti no es Pavoroti. Al revelar que el observador desempeña un papel en la observación, la física cuántica hizo por la física lo que Darwin ha hecho por las ciencias de la vida: Echó abajo las paredes, reunificando la Mente con el Universo más vasto.

emilio silvera

Jul

4

Los secretos de la Naturaleza ¿Los podremos desvelar?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

El psicólogo Eric Ericsson llegó a proponer una teoría de estadios psicológicos del desarrollo. Un conflicto fundamental caracteriza cada fase. Si este conflicto no queda resuelto, puede enconarse e incluso provocar una regresión a un periodo anterior. Análogamente, el psiicólogo Jean Piaget demostró que el desarrollo mental de la primera infancia tampoco es un desarrollo continuo de aprendizaje, sino que está realmente caracterizado por estadios discontinuos en la capacidad de conceptualización de un niño. En un mes, un niño puede dejar de buscar una pelota una vez que ha rodado fuera de su campo de visión, sin comprender que la pelota existe aunque no la vea. Al mes siguiente, esto resultará obvio para el niño.

Los procesos siguen, las cosas cambian, el Tiempo inexorable transcurre, si hay vida vendrá la muerte, lo que es hoy mañana no será.

Esta es la esencia de la dialéctica. Según esta filosofía, todos los objetos (personas, gases, estrellas, el propio universo) pasan por una serie de estadios. Cada estadio está caracterizado por un conflicto entre dos fuerzas opuestas. La naturaleza de dicho conflicto determina, de hecho, la naturaleza del estadio. Cuando el conflicto se resuelve, el objeto pasa a un objetivo o estadio superior, llamado síntesis, donde empieza una nueva contradicción, y el proceso pasa de nuevo a un nivel superior.

Los filósofos llaman a esto transición de la “cantidad” a la “cualidad”. Pequeños cambios cuantitativos se acumulan hasta que, eventualmente, se produce una ruptura cualitativa con el pasado. Esta teoría se aplica también a las sociedades o culturas. Las tensiones en una sociedad pueden crecer espectacularmente, como la hicieron en Francia a finales del siglo XVIII. Los campesinos se enfrenaban al hambre, se produjeron motines espontáneos y la aristocracia se retiró a sus fortalezas. Cuando las tensiones alcanzaron su punto de ruptura, ocurrió una transición de fase de lo cuantitativo a lo cualitativo: los campesinos tomaron las armas, tomaron París y asaltaron la Bastilla. ¿No pasará aquí lo mismo con los políticos y los ciudadanos? Ellos tienen muchos privilegios a costa de quitarnos derechos a los demás.

Las transiciones de fases pueden ser también asuntos bastante explosivos. Por ejemplo, pensemos en un río que ha sido represado. Tras la presa se rápidamente un embalse con agua a enorme presión. Puesto que es inestable, el embalse está en el falso vacío. El agua preferiría estar en su verdadero vacío, significando esto que preferiría reventar la presa y correr aguas abajo, hacia un estado de menor energía. Así pues, una transición de fase implicaría un estallido de la presa, que tendría consecuencias desastrosas.

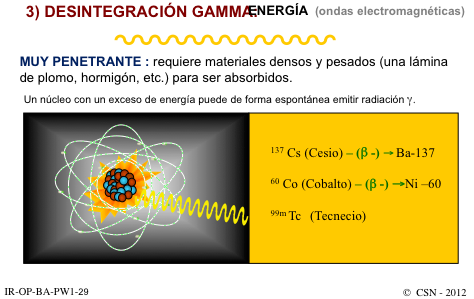

También podría poner aquí el ejemplo más explosivo de una bomba atómica, donde el falso vacío corresponde al núcleo inestable de uranio donde residen atrapadas enormes energías explosivas que son un millón de veces más poderosas, para masas iguales, que para un explosivo químico. De vez en cuando, el núcleo pasa por efecto túnel a un estado más bajo, lo que significa que el núcleo se rompe espontáneamente. Esto se denomina desintegración radiactiva. Sin embargo, disparando neutrones contra los núcleos de uranio, es posible liberar de golpe esta energía encerrada según la formula de Einstein E = mc2. Por supuesto, dicha liberación es una explosión atómica; ¡menuda transición de fase! De nefasto recuerdo por cierto.

Las transiciones de fase no son nada nuevo. Traslademosló a nuestras propias vidas. En un libro llamado Pasajes, el autor, Gail Sheehy, destaca que la vida no es un flujo continuo de experiencias, como parece, sino que realmente pasa por varios estadios, caracterizados por conflictos específicos que debemos resolver y por objetivos que debemos cumplir.

Los contornos recubiertos muestran la estructura de la galaxia al ser reconstruida desde las observaciones hechas bajo el fenómeno de lente gravitatorio con el radiotelescopio Submillimeter Array. La formación de nuevas estrellas en el Universo es imparable y, la materia más sencilla se constituye en una estructura que la transformará en más compleja, más activa, más dispuesta para que, la vida, también pueda surgir en mundos ignotos situados muy lejos del nuestro.

Sí, todo cambia y nada permanece: transiciones de fases hacia la complejidad

Las nuevas características descubiertas por los científicos en las transiciones de fases es que normalmente van acompañadas de una ruptura de simetría. Al premio Nobel Abdus Salam le gusta la ilustración siguiente: consideremos una mesa de banquete circular, donde todos los comensales están sentados con una copa de champán a cada lado. Aquí existe simetría. Mirando la mesa del banquete reflejada en un espejo, vemos lo mismo: cada comensal sentado en torno a la mesa, con copas de champán a cada lado. Asimismo, podemos girar la mesa de banquete circular y la disposición sigue siendo la misma.

Rompamos ahora la simetría. Supongamos ahora que el primer comensal toma la copa que hay a su derecha. Siguiendo la pauta, todos los demás comensales tomaran la copa de champán de su derecha. Nótese que la imagen de la mesa del banquete vista en el espejo produce la situación opuesta. Cada comensal ha tomado la copa izquierda. De este modo, la simetría izquierda-derecha se ha roto.

El niño del espejo le da a su “amiguito” reflejado la mano derecha y aquel, le saluda, con la izquierda. ¡La simetría especular…! Así pues, el estado de máxima simetría es con frecuencia también un estado inestable, y por lo tanto corresponde a un falso vacío.

Con respecto a la teoría de supercuerdas, los físicos suponen (aunque todavía no lo puedan demostrar) que el universo decadimensional original era inestable y pasó por efecto túnel a un universo de cuatro y otro de seis dimensiones. Así pues, el universo original estaba en un estado de falso vacío, el estado de máxima simetría, mientras que hoy estamos en el estado roto del verdadero vacío.

Al principio, cuando el universo era simétrico, sólo existía una sola fuerza que unificaba a todas las que ahora conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo. Más tarde, cuando el universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron las primeras quarks para unirse y formar protones y neutrones, los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos. Doscientos millones de años más tarde, se formaron las primeras estrellas y galaxias. Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes de que se formase el Sol. Podemos decir, sin temor a equivocarnos, que una supernova anónima explotó hace miles de millones de años y sembró la nube de gas que dio lugar a nuestro sistema solar, poniendo allí los materiales complejos y necesarios para que algunos miles de millones de años más tarde, tras la evolución, apareciéramos nosotros.

En las estrellas se tiene que producir el proceso triple alfa para que exista el Carbono

Las estrellas evolucionan desde que en su núcleo se comienza a fusionar hidrógeno en helio, de los elementos más ligeros a los más pesados. Avanza creando en el hornotermonuclear, cada vez, metales y elementos más pesados. Cuando llega al hierro y explosiona en la forma explosiva de una supernova. Luego, cuando este material estelar es otra vez recogido en una nueva estrella rica en hidrógeno, al ser de segunda generación (como nuestro Sol), comienza de nuevo el proceso de fusión llevando consigo materiales complejos de aquella supernova.

Puesto que el peso promedio de los protones en los productos de fisión, como el cesio y el kriptón, es menor que el peso promedio de los protones de uranio, el exceso de masa se ha transformado en energía mediante la conocida fórmula E = mc2. Esta es la fuente de energía que también subyace en la bomba atómica. Es decir, convertir materia en energía.

Así pues, la curva de energía de enlace no sólo explica el nacimiento y muerte de las estrellas y la creación de elementos complejos que también hicieron posible que nosotros estemos ahora aquí y, muy posiblemente, será también el factor determinante para que, lejos de aquí, en otros sistemas solares a muchos años luz de distancia, puedan florecer otras especies inteligentes que, al igual que la especie humana, se pregunten por su origen y estudien los fenómenos de las fuerzas fundamentales del universo, los componentes de la materia y, como nosotros, se interesen por el destino que nos espera en el futuro.

Cuando alguien oye por vez primera la historia de la vida de las estrellas, generalmente (lo sé por experiencia), no dice nada, pero su rostro refleja escepticismo. ¿Cómo puedo vivir una estrella 10.000 millones de años? Después de todo, nadie ha vivido tanto tiempo como para ser testigo de su evolución y poder contarlo.

Hay cosas que, cambiando… ¡Nunca cambian! La entropía se encarga de ello

Pero volviendo a las cosas de la Naturaleza y de la larga vida de las estrellas, sí, tenemos los medios técnicos y científicos para saber la edad que tiene, por ejemplo, el Sol. Nuestro Sol, la estrella alrededor de la que giran todos los planetas de nuestro Sistema Solar, la estrella más cercana a la Tierra (150 millones de Km = 1 UA), con un diámetro de 1.392.530 Km, tiene una edad de 4.500 millones de años, y, como todo en el Universo, su discurrir la va desgantando, evoluciona hacia su imparable destino como gigante roja primero y enana blanca después.

Una gigante roja engulle a un planeta cercano

Cuando ese momento llegue, ¿dónde estaremos? Pues nosotros, si es que estamos, contemplaremos el acontecimiento desde otros mundos. La Humanidad habrá dado el gran salto hacia las estrellas y, colonizando otros planetas se habrá extendido por regiones lejanas de la Galaxia.

El Universo siempre nos pareció inmenso, y, al principio, aquellos que empezaron a preguntarse cómo sería, lo imaginaron como una esfera cristalina que dentro contenía unos pocos mundos y algunas estrellas, hoy, hemos llegado a saber un poco más sobre él. Sin embargo, dentro de unos cuantos siglos, los que detrás de nosotros llegaran, hablarán de universos en plural, y, cuando pasen algunos eones, estaremos de visita de un universo a otro como vamos de una ciudad a otra.

¡Quién pudiera estar allí!

¡Es todo tan extraño! ¡Es todo tan complejo! y, sobre todo…¡sabemos tan poco!

Todo lo grande está hecho de cosas pequeñas

Según lo que podemos entender y hasta donde han podido llegar nuestros conocimientos actuales, ahora sabemos donde están las fronteras: donde las masas o las energías superan 1019 veces la masa del protón, y esto implica que estamos mirando a estructuras con un tamaño de 10-33 centímetros.

Esta ecuación nos habla de lo que se conoce como masa de Planck y a la distancia correspondiente la llamamos distancia de Planck. La masa de Planck expresada en gramos es de 22 microgramos, que es la masa de un grano muy pequeño de azúcar (que, por otra parte, es el único número de Planck que parece más o menos razonable, ¡los otros números son totalmente extravagantes!).

Esto significa que tratamos de localizar una partícula con la precisión de una Longitud de Planck, las fluctuaciones cuánticas darán tanta energía que su masa será tan grande como la masa de Planck, y los efectos de la fuerza gravitatoria entre partículas, así, sobrepasarán los de cualquier otra fuerza. Es decir, para estas partículas la gravedad es una interacción fuerte.

Lo cierto es que, esas unidades tan pequeñas, tan lejanas en las distancias más allá de los átomos, son las que marcan nuestros límites, los límites de nuestras teorías actuales que, mientras que no puedan llegar a esas distancias… No podrán avanzar en el conocimiento de la Naturaleza y, tampoco, como es natural, en la teoría de supercuerdas o en poder saber, lo que pasó en el primer momento del supuesto big bang, hasta esos lugares, nunca hemos podido llegar.

emilio silvera

Jun

21

La desintegración de un Neutrón

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

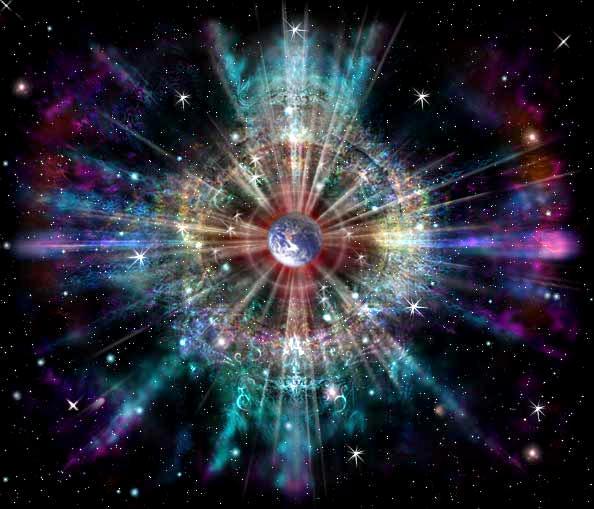

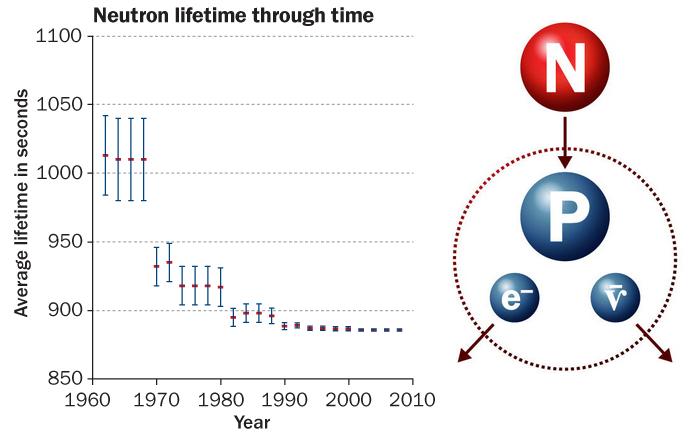

La desintegración Beta del neutrón está mediada por un Bosón W-,que transforma uno de sus quarks, y se desintegra en el par electrón-antineutrino. Ahora leamos el reportaje de la Revista “Investigación y Ciencia”, referido a la física de partículas y a unas mediciones efectuadas que no son coincidentes.

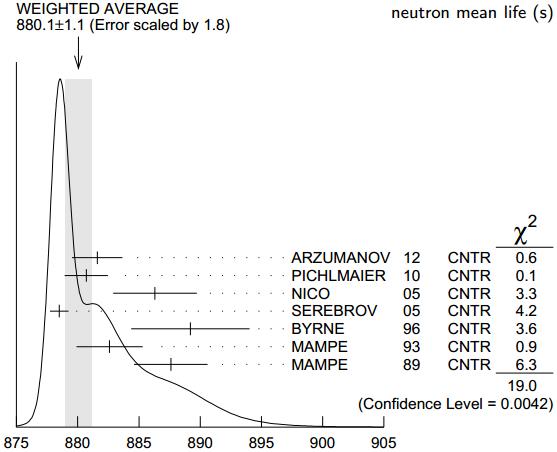

“Dos técnicas de precisión arrojan valores distintos para el tiempo que tardan los neutrones en desintegrarse. ¿Se trata de un error experimental, o hay un misterio más profundo?

En síntesis

Los neutrones libres no son estables: pasados unos 15 minutos, un neutrón se desintegra en un protón, un electrón y un antineutrino. Conocer con exactitud su vida media es clave para abordar varias cuestiones en física y cosmología.

Existen dos métodos para determinar con precisión la vida media de esta partícula. El primero cuenta los neutrones que quedan en un recipiente después de cierto tiempo; el segundo cuenta los protones generados en su desintegración.

Hace años que una y otra técnica arrojan valores considerablemente dispares. Se cree que la discrepancia obedece a errores sistemáticos en alguno de los experimentos; sin embargo, hasta ahora nadie ha logrado dar con ellos.

Un neutrón está formado por dos quarks dowm (abajo) y un quark up (arriba), tiene una vida media de 14,761 minutos, es una partícula de la familia de los hadrones en su vertiente bariónica, interacción: con la Gravedad, la nuclear débil y la nuclear fuerte, su símbolo es n, su antipartícula es el antineutrón, la teorízo Rutherford y la descubrio James Chadwick, su masa es de 1,674 927 29(28)×10−27 K., la carga eléctrica es cero, espín ½. Se conoce cuando forma parte del átomo por nucleón.

Por suerte para la vida en la Tierra, la mayor parte de la materia no es radiactiva. Aunque no solemos darle demasiada importancia, este hecho no deja de resultar sorprendente, ya que el neutrón (uno de los constituyentes, junto con el protón, de los núcleos atómicos) es propenso a desintegrarse. En el interior de un núcleo típico el neutrón puede vivir durante largo tiempo, pero, aislado, se desintegra en otras partículas en unos 15 minutos. Decimos «unos 15 minutos» para ocultar nuestra ignorancia al respecto, ya que, hasta ahora, no hemos sido capaces de medir con exactitud la vida media de esta partícula.

Diagrama de Segrè. El color indica el periodo de semidesintegración de los isótopos radiactivos conocidos, también llamado semivida. Observe que un ligero exceso de neutrones favorece la estabilidad en átomos pesados.

Resolver este «rompecabezas de la vida media del neutrón» no solo supone una cuestión de orgullo para nuestro gremio, el de los físicos experimentales, sino que resulta también vital para comprender mejor las leyes físicas. La desintegración del neutrón constituye uno de los procesos más sencillos en los que interviene la interacción débil, una de las cuatro fuerzas fundamentales de la naturaleza. Para entenderla por completo, hemos de saber cuánto tarda un neutrón aislado en desintegrarse. Por otro lado, la vida media del neutrón condicionó cómo se formaron los elementos químicos más ligeros después de la gran explosión que dio origen a nuestro universo. A los cosmólogos les gustaría poder calcular las abundancias esperadas de los distintos elementos y contrastarlas con los datos obtenidos por los astrofísicos. Un acuerdo apuntalaría nuestras teorías cosmológicas, mientras que una discrepancia indicaría la existencia de fenómenos físicos aún por descubrir. Pero, para poder llevar a cabo dicha comparación, hemos de conocer con exactitud cuánto vive un neutrón antes de desintegrarse.

Hace más de diez años, dos grupos experimentales, uno en Francia y otro en EE.UU., intentaron medir con precisión la vida media del neutrón. Uno de nosotros (Geltenbort) pertenecía al primer equipo, mientras que el otro (Greene) trabajaba en el segundo. Con sorpresa y cierta inquietud, comprobamos que nuestros resultados diferían de manera considerable. Algunos teóricos sugirieron que la discrepancia podría deberse a fenómenos físicos exóticos, como que parte de los neutrones se hubiesen desintegrado en partículas nunca antes observadas. Nosotros, sin embargo, achacamos la diferencia a una razón mucho más mundana: uno de los grupos —o ambos— tenía que haber cometido algún error o sobre-estimado la precisión de sus resultados.

Hace poco, el equipo estadounidense completó un largo y concienzudo proyecto para estudiar la principal fuente de error que afectaba a sus mediciones. Lejos de zanjar la cuestión, sus esfuerzos solo confirmaron los resultados previos. Al mismo tiempo, otros investigadores verificaron los resultados del grupo de Geltenbort. Esta discrepancia nos ha dejado más perplejos de lo que ya estábamos, pero no hemos abandonado. Por el momento, ambos equipos y otros físicos experimentales seguimos buscando una respuesta.

CRONOMETRAR NEUTRONES

El neutrón y el protón forman los núcleos de los átomos; el protón es estable (su vida media es superior a 10³² años, según PDG 2012), pero el neutrón es inestable (vía la interacción electrodébil se desintegra en un protón) y aislado su vida media es de solo 880,1 ± 1,1 segundos (14 minutos y 40,1 segundos)

En teoría, determinar la vida media del neutrón es sencillo. Entendemos bien la física del proceso y disponemos de las herramientas adecuadas para estudiarlo. Sabemos que, siempre que una partícula pueda desintegrarse en otras de menor masa, acabará haciéndolo si en el proceso se conservan ciertas propiedades, como la carga eléctrica o el espín. En la llamada desintegración beta, un neutrón se transforma en un protón, un electrón y un antineutrino. Las masas de estas tres partículas suman algo menos que la masa del neutrón, pero la carga y el espín totales permanecen idénticos. Entre las cantidades conservadas se incluye la suma de masa y energía, por lo que las tres partículas finales incorporan esa pequeña diferencia de masa en forma de energía cinética.”

Nota: El artículo me ha sido enviado por Don José Gómez, un contertulio y visitante de ésta página que, con buen criterio, apunta que en cuanto a esas diferencias, las pruebas deben ser repetidas en distintos lugares y, si es posible, por distintos científicos también, ya que, en física de partícula, los resultados de un experimento, debe coincidir sin fisuras.

Jun

5

Los secretos de la Naturaleza ¿Los podremos desvelar?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

El psicólogo Eric Ericsson llegó a proponer una teoría de estadios psicológicos del desarrollo. Un conflicto fundamental caracteriza cada fase. Si este conflicto no queda resuelto, puede enconarse e incluso provocar una regresión a un periodo anterior. Análogamente, el psiicólogo Jean Piaget demostró que el desarrollo mental de la primera infancia tampoco es un desarrollo continuo de aprendizaje, sino que está realmente caracterizado por estadios discontinuos en la capacidad de conceptualización de un niño. En un mes, un niño puede dejar de buscar una pelota una vez que ha rodado fuera de su campo de visión, sin comprender que la pelota existe aunque no la vea. Al mes siguiente, esto resultará obvio para el niño.

Los procesos siguen, las cosas cambian, el Tiempo inexorable transcurre, si hay vida vendrá la muerte, lo que es hoy mañana no será.

Esta es la esencia de la dialéctica. Según esta filosofía, todos los objetos (personas, gases, estrellas, el propio universo) pasan por una serie de estadios. Cada estadio está caracterizado por un conflicto entre dos fuerzas opuestas. La naturaleza de dicho conflicto determina, de hecho, la naturaleza del estadio. Cuando el conflicto se resuelve, el objeto pasa a un objetivo o estadio superior, llamado síntesis, donde empieza una nueva contradicción, y el proceso pasa de nuevo a un nivel superior.

Los filósofos llaman a esto transición de la “cantidad” a la “cualidad”. Pequeños cambios cuantitativos se acumulan hasta que, eventualmente, se produce una ruptura cualitativa con el pasado. Esta teoría se aplica también a las sociedades o culturas. Las tensiones en una sociedad pueden crecer espectacularmente, como la hicieron en Francia a finales del siglo XVIII. Los campesinos se enfrenaban al hambre, se produjeron motines espontáneos y la aristocracia se retiró a sus fortalezas. Cuando las tensiones alcanzaron su punto de ruptura, ocurrió una transición de fase de lo cuantitativo a lo cualitativo: los campesinos tomaron las armas, tomaron París y asaltaron la Bastilla.

Las transiciones de fases pueden ser también asuntos bastante explosivos. Por ejemplo, pensemos en un río que ha sido represado. Tras la presa se rápidamente un embalse con agua a enorme presión. Puesto que es inestable, el embalse está en el falso vacío. El agua preferiría estar en su verdadero vacío, significando esto que preferiría reventar la presa y correr aguas abajo, hacia un estado de menor energía. Así pues, una transición de fase implicaría un estallido de la presa, que tendría consecuencias desastrosas.

También podría poner aquí el ejemplo más explosivo de una bomba atómica, donde el falso vacío corresponde al núcleo inestable de uranio donde residen atrapadas enormes energías explosivas que son un millón de veces más poderosas, para masas iguales, que para un explosivo químico. De vez en cuando, el núcleo pasa por efecto túnel a un estado más bajo, lo que significa que el núcleo se rompe espontáneamente. Esto se denomina desintegración radiactiva. Sin embargo, disparando neutrones contra los núcleos de uranio, es posible liberar de golpe esta energía encerrada según la formula de Einstein E = mc2. Por supuesto, dicha liberación es una explosión atómica; ¡menuda transición de fase! De nefasto recuerdo por cierto.

Las transiciones de fase no son nada nuevo. Trasladémoslo a nuestras propias vidas. En un libro llamado Pasajes, el autor, Gail Sheehy, destaca que la vida no es un flujo continuo de experiencias, como parece, sino que realmente pasa por varios estadios, caracterizados por conflictos específicos que debemos resolver y por objetivos que debemos cumplir.

Los contornos recubiertos muestran la estructura de la galaxia al ser reconstruida desde las observaciones hechas bajo el fenómeno de lente gravitatorio con el radiotelescopio Submillimeter Array. La formación de nuevas estrellas en el Universo es imparable y, la materia más sencilla se constituye en una estructura que la transformará en más compleja, más activa, más dispuesta para que, la vida, también pueda surgir en mundos ignotos situados muy lejos del nuestro.

Sí, todo cambia y nada permanece: transiciones de fases hacia la complejidad

Las nuevas características descubiertas por los científicos en las transiciones de fases es que normalmente van acompañadas de una ruptura de simetría. Al premio Nobel Abdus Salam le gusta la ilustración siguiente: consideremos una mesa de banquete circular, donde todos los comensales están sentados con una copa de champán a cada lado. Aquí existe simetría. Mirando la mesa del banquete reflejada en un espejo, vemos lo mismo: cada comensal sentado en torno a la mesa, con copas de champán a cada lado. Asimismo, podemos girar la mesa de banquete circular y la disposición sigue siendo la misma.

Rompamos ahora la simetría. Supongamos ahora que el primer comensal toma la copa que hay a su derecha. Siguiendo la pauta, todos los demás comensales tomaran la copa de champán de su derecha. Nótese que la imagen de la mesa del banquete vista en el espejo produce la situación opuesta. Cada comensal ha tomado la copa izquierda. De este modo, la simetría izquierda-derecha se ha roto.

El niño del espejo le da a su amiguito reflejado la mano derecha y aquel, le saluda, con la izquierda. ¡La simetría especular…! Así pues, el estado de máxima simetría es con frecuencia también un estado inestable, y por lo tanto corresponde a un falso vacío.

Con respecto a la teoría de supercuerdas, los físicos suponen (aunque todavía no lo puedan demostrar) que el universo decadimensional original era inestable y pasó por efecto túnel a un universo de cuatro y otro de seis dimensiones. Así pues, el universo original estaba en un estado de falso vacío, el estado de máxima simetría, mientras que hoy estamos en el estado roto del verdadero vacío.

Al principio, cuando el universo era simétrico, sólo existía una sola fuerza que unificaba a todas las que ahora conocemos, la gravedad, las fuerzas electromagnéticas y las nucleares débil y fuerte, todas emergían de aquel plasma opaco de alta energía que lo inundaba todo. Más tarde, cuando el universo comenzó a enfriarse, se hizo transparente y apareció la luz, las fuerzas se separaron en las cuatro conocidas, emergieron las primeras quarks para unirse y formar protones y neutrones, los primeros núcleos aparecieron para atraer a los electrones que formaron aquellos primeros átomos. Doscientos millones de años más tarde, se formaron las primeras estrellas y galaxias. Con el paso del tiempo, las estrellas sintetizaron los elementos pesados de nuestros cuerpos, fabricados en supernovas que estallaron, incluso antes de que se formase el Sol. Podemos decir, sin temor a equivocarnos, que una supernova anónima explotó hace miles de millones de años y sembró la nube de gas que dio lugar a nuestro sistema solar, poniendo allí los materiales complejos y necesarios para que algunos miles de millones de años más tarde, tras la evolución, apareciéramos nosotros.

En las estrellas se tiene que producir el proceso triple alfa para que exista el Carbono

Las estrellas evolucionan desde que en su núcleo se comienza a fusionar hidrógeno en helio, de los elementos más ligeros a los más pesados. Avanza creando en el hornotermonuclear, cada vez, metales y elementos más pesados. Cuando llega al hierro y explosiona en la forma explosiva de una supernova. Luego, cuando este material estelar es otra vez recogido en una nueva estrella rica en hidrógeno, al ser de segunda generación (como nuestro Sol), comienza de nuevo el proceso de fusión llevando consigo materiales complejos de aquella supernova.

Puesto que el peso promedio de los protones en los productos de fisión, como el cesio y el kriptón, es menor que el peso promedio de los protones de uranio, el exceso de masa se ha transformado en energía mediante la conocida fórmula E = mc2. Esta es la fuente de energía que también subyace en la bomba atómica. Es decir, convertir materia en energía.

Así pues, la curva de energía de enlace no sólo explica el nacimiento y muerte de las estrellas y la creación de elementos complejos que también hicieron posible que nosotros estemos ahora aquí y, muy posiblemente, será también el factor determinante para que, lejos de aquí, en otros sistemas solares a muchos años luz de distancia, puedan florecer otras especies inteligentes que, al igual que la especie humana, se pregunten por su origen y estudien los fenómenos de las fuerzas fundamentales del universo, los componentes de la materia y, como nosotros, se interesen por el destino que nos espera en el futuro.

Cuando alguien oye por vez primera la historia de la vida de las estrellas, generalmente (lo sé por experiencia), no dice nada, pero su rostro refleja escepticismo. ¿Cómo puedo vivir una estrella 10.000 millones de años? Después de todo, nadie ha vivido tanto tiempo como para ser testigo de su evolución y poder contarlo.

Hay cosas que, cambiando… ¡Nunca cambian! La entropía se encarga de ello

Pero volviendo a las cosas de la Naturaleza y de la larga vida de las estrellas, sí, tenemos los medios técnicos y científicos para saber la edad que tiene, por ejemplo, el Sol. Nuestro Sol, la estrella alrededor de la que giran todos los planetas de nuestro Sistema Solar, la estrella más cercana a la Tierra (150 millones de Km = 1 UA), con un diámetro de 1.392.530 Km, tiene una edad de 4.500 millones de años, y, como todo en el Universo, su discurrir la va desgantando, evoluciona hacia su imparable destino como gigante roja primero y enana blanca después.

Una gigante roja engulle a un planeta cercano

Cuando ese momento llegue, ¿dónde estaremos? Pues nosotros, si es que estamos, contemplaremos el acontecimiento desde otros mundos. La Humanidad habrá dado el gran salto hacia las estrellas y, colonizando otros planetas se habrá extendido por regiones lejanas de la Galaxia.

El Universo siempre nos pareció inmenso, y, al principio, aquellos que empezaron a preguntarse cómo sería, lo imaginaron como una esfera cristalina que dentro contenía unos pocos mundos y algunas estrellas, hoy, hemos llegado a saber un poco más sobre él. Sin embargo, dentro de unos cuantos siglos, los que detrás de nosotros llegaran, hablarán de universos en plural, y, cuando pasen algunos eones, estaremos de visita de un universo a otro como vamos de una ciudad a otra.

¡Quién pudiera estar allí!

¡Es todo tan extraño! ¡Es todo tan complejo! y, sobre todo…¡sabemos tan poco!

Todo lo grande está hecho de cosas pequeñas

Según lo que podemos entender y hasta donde han podido llegar nuestros conocimientos actuales, ahora sabemos donde están las fronteras: donde las masas o las energías superan 1019 veces la masa del protón, y esto implica que estamos mirando a estructuras con un tamaño de 10-33 centímetros.

Esta ecuación nos habla de lo que se conoce como masa de Planck y a la distancia correspondiente la llamamos distancia de Planck. La masa de Planck expresada en gramos es de 22 microgramos, que es la masa de un grano muy pequeño de azúcar (que, por otra parte, es el único número de Planck que parece más o menos razonable, ¡los otros números son totalmente extravagantes!).

Esto significa que tratamos de localizar una partícula con la precisión de una Longitud de Planck, las fluctuaciones cuánticas darán tanta energía que su masa será tan grande como la masa de Planck, y los efectos de la fuerza gravitatoria entre partículas, así, sobrepasarán los de cualquier otra fuerza. Es decir, para estas partículas la gravedad es una interacción fuerte.

Lo cierto es que, esas unidades tan pequeñas, tan lejanas en las distancias más allá de los átomos, son las que marcan nuestros límites, los límites de nuestras teorías actuales que, mientras que no puedan llegar a esas distancias… No podrán avanzar en el conocimiento de la Naturaleza y, tampoco, como es natural, en la teoría de supercuerdas o en poder saber, lo que pasó en el primer momento del supuesto big bang, hasta esos lugares, nunca hemos podido llegar.

emilio silvera

Jun

4

¿La Física? ¡Una maravilla! Nos dice cómo funciona la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Ylia Prigogine ¡Qué personaje!

El Universo y la Vida… ¡Nuestra imaginación!

En su Libro Partículas, Gerard ´t Hofft, Premio Nobel de Física, nos cuenta:

“En el mundo de los seres vivos, la escala o tamaño crea importantes diferencias. En muchos aspectos, la anatomía de un ratón es una copia de la de un elefante, pero mientras que un ratón trepar por una pared prácticamente vertical sin mucha dificultad (y se puede caer desde una altura varias veces mayor que su propio tamaño sin hacerse daño), un elefante no sería capaz de realizar tal hazaña. Con bastante generalidad se puede afirmar que los efectos de la gravedad son menos importantes cuanto menores sean los objetos que consideremos (sean vivos o inanimados).”

Cuando llegamos a los seres unicelulares, se ve que ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de la gravedad a esa escala. Tranquilamente se pueden mover y desplazar por encima de una superficie acuática. Los pluricelulares no pueden hacer tal cosa.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos de Van der Waals. fuerza tiene un alcance muy corto; para ser precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente 1/r7. Esto significa que si se reduce la distancia dos átomos a la mitad de la fuerza de Van der Waals con la que se atraen uno a otro se hace 2 × 2 × 2 × 2 × 2 × 2 × 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza. El conocimiento de esta fuerza se debe a Johannes Diderik Van der Waals (1837 – 1923) con su tesis sobre la continuidad del líquido y gaseoso que le haría famoso, ya que en esa época (1873), la existencia de las moléculas y los átomos no estaba completamente aceptado.

La tensión superficial del agua, es el efecto físico (energía de atracción entre las moléculas) que “endurece” la capa superficial del agua en reposo y permite a algunos insectos, como el mosquito y otros desplazarse por la superficie del agua sin hundirse.

El famoso físico inglés James Clerk Maxwell, que formuló la teoría del electromagnetismo de Faraday, quedó muy impresionado por este de Van der Waals.

Los tamaños de los seres uniceculares, animales y vegetales, se miden en micrómetros o “micras”, donde 1 micra es 1/1.000 de milímetro, aproximadamente el tamaño de los detalles más pequeños que se pueden observar con un microscopio ordinario. El mundo de los microbios es fascinante, pero no es el objeto de este trabajo, y continuaremos el viaje emprendido las partículas elementales que forman núcleos, átomos, células y materia, así como las fuerzas que intervienen en las interacciones fundamentales del universo y que afecta a todo lo que existe.

Hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Radiación de Cuerpo Negro

Un cuerpo negro es un objeto teórico o ideal que absorbe toda la luz y toda la energía radiante que incide sobre él. Nada de la radiación incidente se refleja o pasa a través del cuerpo negro. A pesar de su , el cuerpo negro emite luz y constituye un modelo ideal físico para el estudio de la emisión de radiación electromagnética. El nombre Cuerpo negro fue introducido por Gustav Kirchhoff en 1862.

La luz emitida por un cuerpo negro se denomina radiación de cuerpo negro. Todo cuerpo emite energía en de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada es la temperatura del emisor. La energía radiante emitida por un cuerpo a temperatura ambiente es escasa y corresponde a longitudes de onda superiores a las de la luz visible (es decir, de menor frecuencia). Al elevar la temperatura no sólo aumenta la energía emitida sino que lo hace a longitudes de onda más cortas; a esto se debe el cambio de color de un cuerpo cuando se calienta. Los cuerpos no emiten con igual intensidad a todas las frecuencias o longitudes de onda, sino que siguen la ley de Planck.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = h?, donde E es la energía del paquete, ? es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ? de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, esto lo veremos más adelante.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Si la mecánica cuántica tiene cosas extrañas y el espín es una de ellas. Y si uno piensa que la intuición le ayudará a comprender todo esto, pues no lo hará, o es poco probable que lo haga. Las partículas tienen un espín fundamental. Al igual que la carga eléctrica o la masa, el espín ayuda a definir que de partícula es cada una.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

La posición y el momento de una partícula nunca lo podremos saber con precisión ilimitada.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La mecánica cuántica es muy extraña a nuestro “sentido común”, sabemos que se desenvuelve en ese “universo” de lo muy pequeño, alejado de nuestra vida cotidiana en el macrocosmos tetradimensional que, no siempre coincide con lo que, en aquel otro ininitesimal acontece.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, existe otro universo dentro de nuestro del que, aún, nos queda mucho por aprender.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (?) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.”

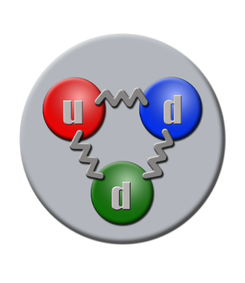

También Gerard ‘t Hooft es el autor de lo que han dado en llamar l principio holográfico es una conjetura especulativa acerca de las teorías de la Gravedad Cuántica propuesta en 1993 por este autor, y mejorada y promovida por Leonard Susskin en 1995. Postula que toda la información contenida en cierto volumen de un espacio concreto se puede conocer a partir de la información codificable sobre la frontera de dicha región. Una importante consecuencia es que la cantidad máxima de información que puede contener una determinada región de espacio rodeada por una superficie diferenciable está limitada por el área total de dicha superficie.

Por ejemplo, se pueden modelar todos los eventos que ocurran en un cuarto o una habitación creando una teoría en la que sólo tome en cuenta lo que suceda en sus paredes. En el principio holográfico también se afirma que por cada cuatro Unidades de Planck existe al menos un grado de libertad (o una unidad constante de Bolttzmann k de máxima entropía). Esto se conoce como frontera de Bekenstein:

donde S es la entropía y A es la unidad de mensura considerada. En unidades convencionales la fórmula anterior se escribe:

donde:

, es la constante de Boltzmann.

, es la constante de Boltzmann.

, es la vecolcidad de la luz.

, es la vecolcidad de la luz.

, es la constante gravitacional universal.

, es la constante gravitacional universal.

, es la constante de Planck racionalizada.

, es la constante de Planck racionalizada. , es la longitud de Planck.

, es la longitud de Planck.

Claro que esta… ¡Es otra Historia!

emilio silvera

Totales: 71.783.540

Totales: 71.783.540 Conectados: 40

Conectados: 40