Abr

25

¡Fluctuaciones de vacío! ¿Que son?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

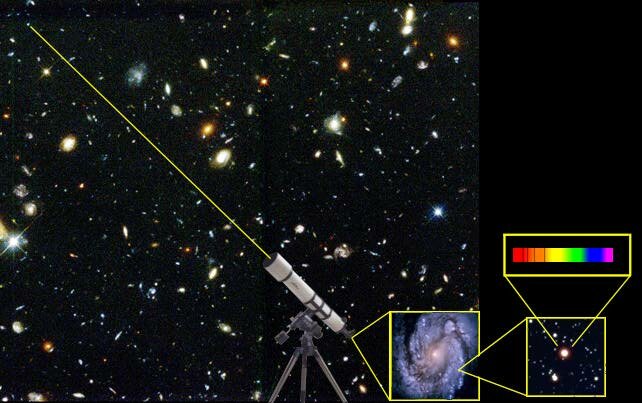

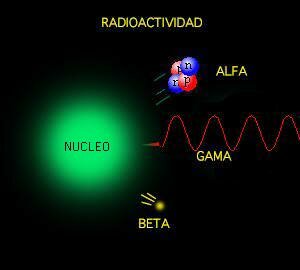

Un fuerte campo gravitatorio puede inducir un efecto desbocado en las fluctuaciones cuánticas que se producen en el espacio, aparentemente vacío, …

En física cuántica, la fluctuación cuántica es un cambio temporal en la cantidad de energía en un punto en el espacio como resultado del Principio de Incertidumbre que imaginó Werner Heisenberg. De acuerdo a una formulación de este principio energía y tiempo se relacionan de la siguiente forma:

Esto significa que la conservación de la energía puede parecer violada, pero sólo por breves lapsos. Esto permite la creación de pares partícula-antipartícula de partículas virtuales. El efecto de esas partículas es medible, por ejemplo, en la carga efectiva del electrón, diferente de su carga “desnuda”. En una formulación actual, la energía siempre se conserva, pero los estados propios del Hamiltoniano no son los mismos que los del operador del número de partículas, esto es, si está bien definida la energía del sistema no está bien definido el número de partículas del mismo, y viceversa, ya que estos dos operadores no conmutan.

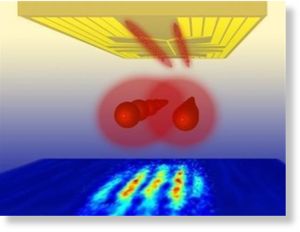

Las fluctuaciones del vacío entre una esfera y una superficie plana

En un estudio realizado por un equipo de físicos con avanzados aparatos, han hallado un resultado del que nos dicen:

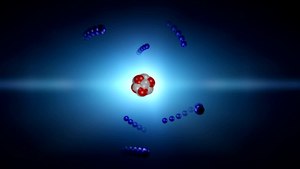

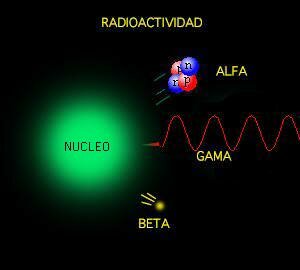

La materia se construye sobre fundamentos frágiles. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vació cuántico. Los investigadores simularon la frenética actividad que sucede en el interios de los protones y neutrones, que como sabéis son las partículas que aportan casi la totalidad de la masa a la materia común.

Cada protón (o neutrón) se compone de tres quarks – véase ilustración – pero las masas individuales de estos quarks apenas comprenden el 1% del total de la masa del protón ¿Entonces de dónde sale el resto? La teoría sostiene que esta masa es creada por la fuerza que mantiene pegados a los quarks, y que se conoce como fuerza nuclear fuerte. En términos cuánticos, la fuerza fuerte es contenida por un campo de partículas virtuales llamadas gluones, las cuales irrumpen aleatoriamente en la existencia para desaparecer de nuevo. La energía de estas fluctuaciones del vacío debe sumarse a la masa total del neutrón y del protón.

En nuestras mentes se acumulan signos y fórmulas que quieren ser los exponentes de la verdadera razón y origen de la materia pero… ¡Estaremos acertando!

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material desde las partículas elementales hasta las montañas y los océanos. Unas veces está en estado “inerte” y otras, se eleva hasta la vida que incluso, en ocasiones, alcanza la consciencia de SER. Sin embargo, no acabamos de dilucidar de dónde viene su verdadero origen, su esencia, lo que era antes de “ser” materia. ¿Existe acaso una especie de sustancia cósmica anterior a la materia? Y, si realmente existe esa sustancia… ¿Dónde está?

Claro que hemos llegado a saber que las llamadas fluctuaciones del vacío son oscilaciones aleatorias, impredecibles e ineliminables de un campo de fuerza (electromagnético o gravitatorio) que son debidas a un “tira y afloja” en el que pequeñas regiones del espacio toman prestada, momentáneamente, energía de regiones adyacentes y luego las devuelven. Pero…

– ¿Qué regiones adyacentes?

Acaso universos paralelos, acaso defomraciones del espacio-tiempo a escalas microscópicas, micros agujeros negros que pasan a ser agujeros blancos salidos de estas regiones o campos de fuerza que no podemos ver pero sí sentir, y, en última instancia, ¿por qué se forman esas partículas virtuales que de inmediato se aniquilan y desaparecen antes de que puedan ser capturadas? ¿Qué sentido tiene todo eso?

Las consecuencias de la existencia del cuanto mínimo de acción fueron revolucionarios para la comprensión del vacío. Mientras la continuidad de la acción clásica suponía un vacío plano, estable y “realmente” vacío, la discontinuidad que supone el cuanto nos dibuja un vacío inestable, en continuo cambio y muy lejos de poder ser considerado plano en las distancias atómicas y menores. El vacío cuántico es de todo menos vacío, en él la energía nunca puede quedar estabilizada en valor cero, está fluctuando sobre ese valor, continuamente se están creando y aniquilando todo tipo de partículas, llamadas por eso virtuales, en las que el producto de su energía por el tiempo de su existencia efímera es menor que el cuanto de acción. Se llaman fluctuaciones cuánticas del vacío y son las responsables de que exista un que lo inunda todo llamado campo de punto cero.

Pero volvamos de nuevo a las fluctuaciones de vacío, que al igual que las ondas “reales” de energía positiva, están sujetas a las leyes de la dualidad onda/partícula; es decir, tienen tanto aspectos de onda como aspectos de partícula.

Las ondas fluctúan de forma aleatoria e impredecible, con energía positiva momentáneamente aquí, energía negativa momentáneamente allí, y energía cero en promedio. El aspecto de partícula está incorporado en el concepto de partículas virtuales, es decir, partículas que pueden nacer en pares (dos partículas a un tiempo), viviendo temporalmente de la energía fluctuacional tomada prestada de regiones “vecinas” del , y que luego se aniquilan y desaparecen, devolviendo la energía a esas regiones “vecinas”. Si hablamos de fluctuaciones electromagnéticas del vacío, las partículas virtuales son fotones virtuales; en el caso de fluctuaciones de la gravedad en el vacío, son gravitones virtuales.

De las llamadas fluctuaciones de vacío pueden surgir, partículas virtuales y quién sabe que cosas más… Hasta un nuevo Universo.

Son muchas las preguntas que no tienen respuestas

Parece que las fluctiuaciones ocurren en cualquier lugar, pero que, son tan minúsculas que ningún observador o experimentador las ha detectado de una manera franca hasta la fecha y, se sabe que están ahí por experimentos que lo han confirmado. Estas fluctuaciones son más poderosas cuanto menos escala se considera en el espacio y, por debajo de la longitud de Planck-Wheeler las fluctuaciones de vacío son tan enormes que el espacio tal como lo conocemos “pareciera estar hirviendo” para convertirse en una especie de espuma cuántica que parece que en realidad, cubre todo el espacio “vacío cuántico” que sabemos que está ahí y es el campo del que surgen esas partículas virtuales que antes menccionaba.

¿Espuma cuántica? Si profundizamos mucho en la materia… Podríamos ver otro universo distinto al nuestro. Las cosas miles de millones de veces más pequeñas que en nuestro mundo cotidiano, no parecen las mismas cosas.

Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro. ¡Qué locura!

es la escala de longitud por debajo de la cual el tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro. ¡Qué locura!

En el complejo general, por ahí, en alguna parte, permanece oculta esa teoría cuántica de la gravedad que incansables (pero sin ningún éxito hasta el momento) buscamos. Cuando sepamos unir las dos teorías de lo pequeño y lo grande, lo tendremos todo.

Como tantas veces hemos comentado, los trabajos que se han realizado sobre poder construir una teoría cuántica de la gravedad nos llevan a un sorprendente de implicaciones. Por un lado, sólo se ha podido conceptuar a la gravedad cuántica, siempre y cuando, el universo tenga más de cuatro dimensiones. Además, se llega a considerar que en la era de Planck, tanto el universo como la gravedad pudieron ser una sola cosa compacta estructurada por objetos cuánticos infinitamente diminutos, como los que suponemos que conforman las supercuerdas. A esta escala, el mismísimo espaciotiempo estaría sometido a imprescindibles fluctuaciones muy semejantes a las que causan las partículas al nacer y desaparecer de la existencia en el espaciotiempo ordinario. Esta noción ha conducido a los teóricos a describir el universo de la era cuántica como una especie de extremadamente densa y agitada espuma que pudo haber contenido las vibrantes cuerdecillas que propugnan los cosmólogos cuerdistas.

Los físicos especulan que el cosmos ha crecido a desde una «nada» primigenia que al nacer comenzó el principio del tiempo y que, en ese parto, contenía toda la materia y toda la energía.

En física como en todas las demás disciplinas científicas, los conocimientos avanzan y las teorías que sostuvieron los cimientos de nuestros conocimientos se van haciendo viejas y van teniendo que ser reforzadas con las nuevas y más poderosas “vigas” de las nuevas ideas y los nuevos hallazgos científicos que hacen posible ir perfeccionando lo que ya teníamos.

Recientemente se han alzado algunas voces contra el Principio de Incertidumbre de Heisenberg. He podido leer en un artíoculo de la prestigiosa Revista Nature, un artículo del premio Nobel de Física Gerald ´t Hoofft, en el que propone que la naturaleza probabilistica de la mecánica cuántica, desaparecería a la escala de Planck, en la que el comportamiento de la materia sería determinista; a longitudes mayores, energías más pequeñas.

El mundo de lo muy pequeño (el micro espacio), a nivel atómico y subatómico, es el dominio de la física cuántica, así nunca podríamos saber, de acuerdo m con el principio de incertidumbre, y, en un momento determinado, la posición y el estado de una partícula. Este estado podría ser una función de la escala espacio-temporal. A esta escala tamaños todo sucede demasiado deprisa para nosotros.

El “universo cuántico” nada es lo que parece a primera vista, allí entramos en otro mundo que en nada, se parece al nuestro

Cuando hablamos de la mecánica cuántica, tenemos mirar un poco hacia atrás en el tiempo y podremos darnos del gran impacto que tuvo en el devenir del mundo desde que, en nuestras vidas, apareció el átomo y, más tarde, sus contenidos. Los nombres de Planck, Einstein, Bohr, Heisenberg, Schrödinger, Pauli, Bardeen, Roentgen, Dirac y muchos otros, se pudieron a la cabeza de la lista de las personas más famosas. Aquel primer premio Nobel de Física otorgado en 1900 a Roentgen por descubrir los rayos X, en el mismo año llegaría el ¡cuanto! De Planck que inspiró a Einstein para su trabajo sobre el Efecto fotoeléctrico que también, le valdría el Nobel, y, a partir de ese momento, se desencadenó una especie de alucinante por saber sobre el átomo, sus contenidos, y, de qué estaba hecha la materia.

La conocida como Paradoja EPR y los conceptos de Tiempo y , presente, pasado y futuro.

“Nadie ha resuelto la paradoja del gato de Schroedinger, ni la paradoja de Einstein-Podolsky-Rosen. El principio de incertidumbre no se ha explicado y se asume como un dogma, lo mismo pasa con el spin. El spin no es un giro pero es un giro. Aquí hay un desafío al pensamiento humano. ¡Aquí hay una aventura del pensamiento!”

Fueron muchas las polémicas desatadas a cuenta de las aparentes incongruencias de la moderna Mecánica Cuántica. La paradoja de Einstein-Podolsky-Rosen, denominada “Paradoja EPR”, trata de un experimento mental propuesto por Albert Einstein, Boris Podolsky y Nathan Rosen en 1935. Es relevante, pues pone de manifiesto un problema aparente de la mecánica cuántica, y en las décadas siguientes se dedicaron múltiples esfuerzos a desarrollarla y resolverla.

A Einstein (y a muchos otros científicos), la idea del entrelazamiento cuántico le resultaba extremadamente perturbadora. Esta particular característica de la mecánica cuántica permite preparar estados de dos o más partículas en los cuales es imposible obtener útil sobre el estado total del sistema haciendo sólo mediciones sobre una de las partículas.

Por otro lado, en un entrelazado, manipulando una de las partículas, se puede modificar el estado total. Es decir, operando sobre una de las partículas se puede modificar el estado de la otra a distancia de manera instantánea. Esto habla de una correlación entre las dos partículas que no tiene paralaje en el mundo de nuestras experiencias cotidianas. Cabe enfatizar pues que cuando se mide el estado de una partícula, enseguida sabemos el estado de la otra, lo cual aparentemente es instantáneo, es decir, sin importar las distancias a las que se encuentren las partículas, una de la otra, ambas saben instantáneamente el estado de la otra.

El experimento planteado por EPR consiste en dos partículas que interactuaron en el pasado y que quedan en un estado entrelazado. Dos observadores reciben cada una de las partículas. Si un observador mide el momento de una de ellas, sabe cuál es el momento de la otra. Si mide la posición, gracias al entrelazamiento cuántico y al principio de incertidumbre, puede la posición de la otra partícula de forma instantánea, lo que contradice el sentido común.

Animación que muestra dos átomos de oxígeno fusionándose para formar una molécula de O2 en su estado cuántico fundamental. Las nubes de color representan los orbitales atómicos. Los orbitales 2s y 2p de cada átomo se combinan para formar los orbitales σ y π de la molécula, que la mantienen unida. Los orbitales 1s, más interiores, no se combinan y permiten distinguir a cada núcleo. Lo que ocurre a escalas tan pequeñas es fascienante.

Si nos pudiéramos convertir en electrones, por ejemplo, sabríamos dónde y cómo estamos en cada momento y podríamos ver asombrados, todo lo que estaba ocurriendo a nuestro alrededor que, entonces sí, veríamos transcurrir a un ritmo más lento del que podemos detectar en los electrones desde nuestro macroestado espacio temporal. El electrón, bajo nuestro punto de vista se mueve alrededor del núcleo atómico a una velocidad de 7 millones de km/h.

A medida que se asciende en la escala de tamaños, hasta el tiempo se va ajustando a esta escala, los objetos, a medida que se hacen mayores se mueven más despacio y, además, tienen más duración que los pequeños objetos infinitesimales del micro mundo cuántico. La vida media de un neutron es de unos 15 minutos, por ejemplo, mientras que la vida media de una estrellas se puede contar en miles de millones de años.

En nuestra macroescala, los acontecimientos y ,los objetos se mueven a velocidades que a nosotros nos parecen normales. Si se mueven con demasiada lentitud nos parece que no se mueven. Así hablamos de escala de tiempo geológico, para referirnos al tiempo y velocidad de la mayor parte de los acontecimientos geológicos que afectan a la Tierra, el tiempo transcurre aquí en millones de años y nosotros ni lo apreciamos; nos parece que todo está inmóvil. Nosotros, los humanos, funcionamos en la escala de años (tiempo biológico).

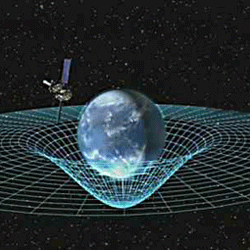

El Tiempo Cosmológico es aún mucho más dilatado y los objetos cósmicos (mundos, estrellas y galaxias), tienen una mayor duración aunque su movimiento puede ser muy rápido debido a la inmensidad del espacio universal en el que se mueven. La Tierra, por ejemplo, orbita alrededor del Sol a una velocidad media de 30 Km/s., y, el Sol, se desplaza por la Galaxia a una velocidad de 270 km/s. Y, además, se puede incrementar el tiempo y el espacio en su andadura al estar inmersos y ligados en una misma maya elñástica.

Así, el espacio dentro de un átomo, es muy pequeño; dentro de una célula, es algo mayor; dentro de un animal, mayor aún y así sucesivamente… hasta llegar a los enormes espaciosa que separan las estrellas y las galaxias en el Universo.

Distancias astronómicas separan a las estrellas entre sí, a las galaxias dentro del cúmulo, y a los cúmulos en los supercúmulos.

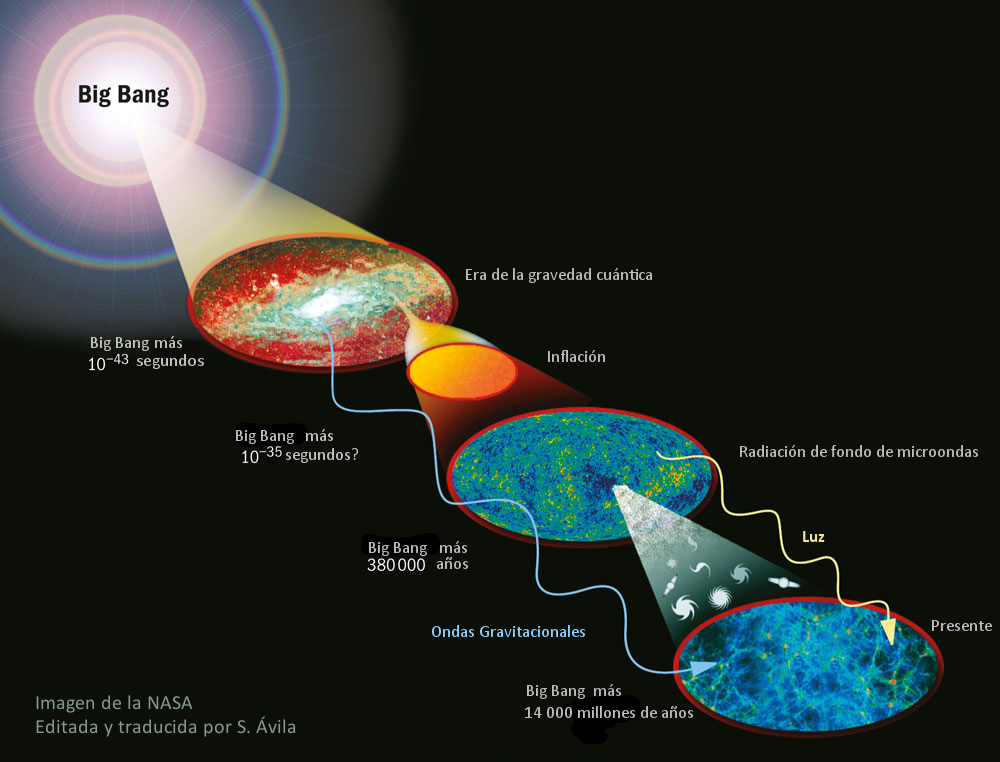

Las distancias que separan a los objetos del Cosmos se tienen que medir con unidades espaciales, tal es su inmensa magnitud que, nuestras mentes, aunque podamos hablar de ellas de manera cotidiana, en realidad, no han llegado a asimilarlas.Y, a todo ésto, los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Los físicos no están seguros si el problema es técnico o conceptual. No obstante, incluso prescindiendo de una teoría completa de gravedad cuántica, se puede deducir que los efectos de la teoría cuántica, habrían cruciales durante los primeros 10-43 segundos del inicio del universo, cuando éste tenía una densidad de 1093 gramos por centímetro cúbico y mayor. (El plomo sólido tiene una densidad de aproximadamente diez gramos por centímetro cúbico.) Este período, que es el que corresponde a la era de Planck, y a su estudio se le llama cosmología cuántica. Como el universo en su totalidad habría estado sujeto a grandes incertidumbres y fluctuaciones durante la era de Planck o era cuántica, con la materia y la energía apareciendo y desapareciendo de un vacío en grandes cantidades, el concepto de un principio del universo podría no tener un significado bien definido. En todo caso, la densidad del universo durante este período es de tal magnitud que escapa a nuestra comprensión. Para propósitos prácticos, la era cuántica podría considerarse el estado inicial, o principio, del universo. En consecuencia, los procesos cuánticos ocurridos durante este período, cualquiera sea su naturaleza, determinaron las iniciales del universo.

Una cosa nos ha podido quedar clara: Los científicos para lograr conocer la estructura del universo a su escala más grande, deben retroceder en el tiempo, centrando sus teorías en el momento en que todo comenzó. Para ello, como todos sabeis, se han formulado distintas teorías unificadoras de las cuatro fuerzas de la naturaleza, con las cuales se han modelado acontecimiento y en el universo primitivo casi a todo lo largo del camino hasta el principio. Pero cómo se supone que debió haber habido un «antes», aparece una barrera que impide ir más allá de una frontera que se halla fijada a los 10-43 [s] después del Big Bang, un instante conocido como «momento de Planck», en homenaje al físico alemán Max Planck.

Esta barrera existe debido a que antes del momento de Planck, durante el período llamado la «era de Planck o cuántica», se supone que las cuatro fuerza fundamentales conocidas de la naturaleza eran indistinguibles o se hallaban unificadas , que era una sola fuerza. Aunque los físicos han diseñado teorías cuánticas que unen tres de las fuerzas, una por una, a través de eras que se remontan al momento de Planck, hasta ahora les ha prácticamente imposible armonizar las leyes de la teoría cuántica con la gravedad de la relatividad de Einstein, en un sólo modelo teórico ampliamente convincente y con posibilidades claras de ser contrastado en experimentos de laboratorio y, mucho menos, con observaciones.

Y después de todo ésto, sólo una caso me queda clara: ¡Lo poco que sabemos! A pesar de la mucha imaginación que ponemos en las cosas que creemos conocer.

emilio silvera

Abr

18

La Vida de las partículas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

La Mente: Ese misterio

La mente humana es tan compleja que no todos ante la misma cosa vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugiere. De entre diez personas, sólo coinciden tres, los otros siete divergen en la apreciación de lo que el dibujo o la figura les sugiere. Un paisaje puede ser descrito de muy distintas maneras según quién lo pueda contar.

Solo el 1% de las formas de vida que han vivido en la Tierra están ahora presentes, el 99%, por una u otra razón se han extinguido. Sin embargo, ese pequeño tanto por ciento de la vida actual, supone unos cinco millones de especies según algunas estimaciones. La Tierra acoge a todas esas especies u palpita de vida que prolifera por doquier. Hay seres vivos por todas partes y por todos los rincones del inmenso mosaico de ambientes que constituye nuestro planeta encontramos formas de vida, cuyos diseños parecen hechos a propósito para adaptarse a su hábitat, desde las profundidades abisales de los océanos hasta las más altas cumbres, desde las espesas selvas tropicales a las planicies de hielo de los casquetes polares. Se ha estimado la edad de 3.800 millones de años desde que aparecieron los primeros “seres vivos” sobre el planeta (dato de los primeros microfósiles). Desde entonces no han dejado de aparecer más y más especies, de las que la mayoría se han ido extinguiendo. Desde el siglo XVIII en que Carlos Linneo propuso su Systema Naturae no han cesado los intentos por conocer la Biodiversidad…, de la que por cierto nuestra especie, bautizada como Homo sapiens por el propio Linneo, es una recién llegada de apenas 200.000 años.

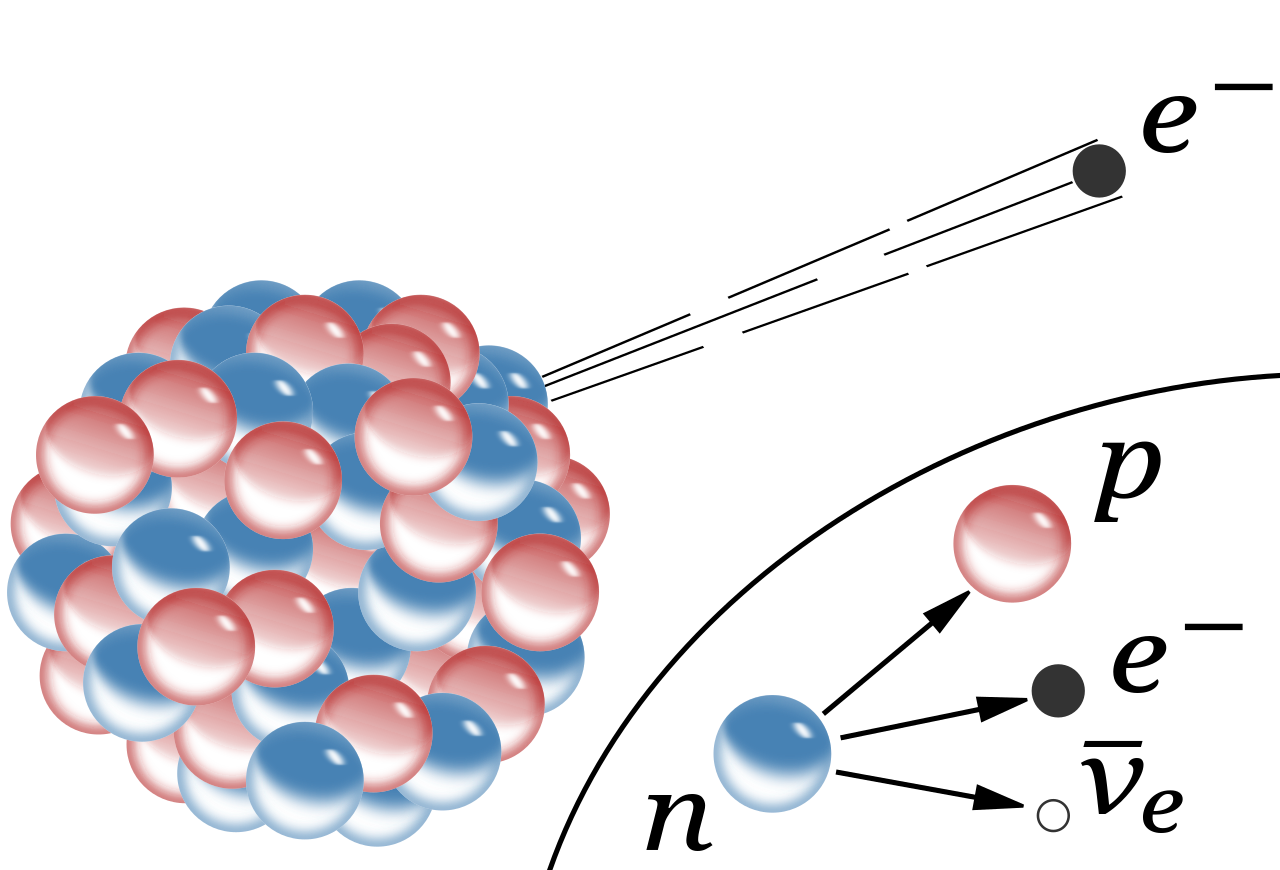

Ahora, hablaremos de la vida media de las partículas elementales (algunas no tanto). Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida media, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, psi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales maneras de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

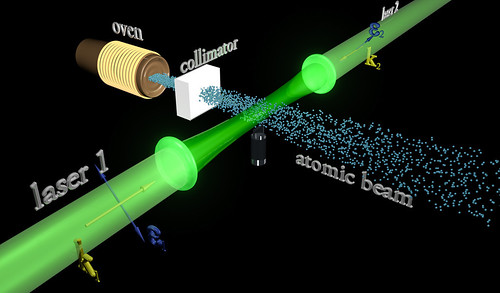

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

Una colisión entre un prtón y un antiprotón registrada mediante una cámara de chispas del experimento UA5 del CERN.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Se habla de ondas cuánticas y también, de ondas gravitacionales. Las primeras han sido localizadas y las segundas están siendo perseguidas.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Bariones Delta. Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (aunque nos parezca lo contrario), son aún bastante limitados, nos queda mucho por descubrir antes de que podamos decir que dominamos la materia y sabemos de todos sus componentes. Antes de que eso llegue, tendremos que conocer, en profundidad, el verdadero origen de la Luz que esconde muchos secretos que tendremos que desvelar.

Esperemos que con los futuros experimentos del LHC y de los grandes Aceleradores de partículas del futuro, se nos aclaren algo las cosas y podamos avanzar en el perfeccionamiento del Modelo Estándar de la Física de Partículas que, como todos sabemos es un Modelo incompleto que no contiene a todas las fuerzas de la Naturaleza y, cerca de una veintena de sus parámetros son aleatorios y no han sido explicados. Uno de ellos, el Bosón de Higgs, dicen que ha sido encontrado. Sin embargo, a mí particularmente me quedan muchas dudas al respecto.

emilio silvera

Abr

17

¡Fisica! Siempre la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡El Universo! ¿Sería eso lo que pasó?

Como nunca dejaremos a aprender cosas nuevas, de desvelar secretos de la Naturaleza, de seguir investigando en busca de “otras verdades”, de elaborar nuevos modelos y nuevas Teorías que nos acerquen, cada vez más a la realidad del mundo (ese es, de momento, nuestro cometido), estamos abocados a tratar de saber lo que no sabemos y que, no pocas veces, creemos que sabemos. Ya lo dijo Popper:

“Cuanto más profundizo en el saber de las cosas, más consciente soy de lo poco que sé. Mis conocimientos son finitos , mi ignorancia, es infinita“.

Lo que nos lleva a la versión antigua del dicho: “Sólo se que no se nada” de Sócrates.

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

“La revolución de la mecánica cuántica empieza a materializarse, y el qubit es el principal protagonista. Siendo la unidad mínima de información de extraño mundo, permitirá procesar toda la información existente en segundos.” El futuro que nos aguarda es inimaginable y cada día que pasa aparecen nuevos logros tecnológicos que nos sitúan en otro mundo, otra sociedad, otras nuevas formas de vivir y de comprender.

Sí, son los electrones los que dan al átomo su forma esférica

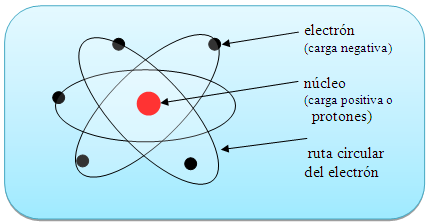

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Un experimento realizado por científicos del Centro de Viena para la Ciencia y Tecnología Cuánticas ha demostrado que, en el mundo cuántico, la transición hacia el equilibrio térmico es más interesante y más complicada de lo que se pensaba.

Según destaca el , publicado en ‘Science’, entre un ordenado inicial y un estado final estadísticamente mixto, puede emerger un “cuasi-estacionario estado intermedio”. Este estado intermedio ya exhibe algunas propiedades como el equilibrio, pero parte de las características del estado inicial permanecen visibles durante un período de tiempo muy largo.

El fenómeno se denomina “pre-termalización” y desempeña un papel importante en diversos procesos de no equilibrio en la física cuántica. Podría, por ejemplo, ayudarnos a comprender el estado del universo temprano.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

Sincronización perfecta, ¡es una sinfonía!

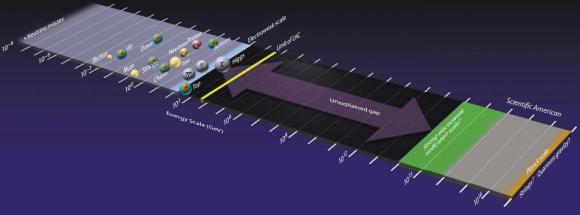

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

El espectro electromagnético se extiende la radiación de menor longitud de onda, como los rayos gamma y los rayos X, pasando por la luz ultravioleta, la luz visible y los rayos infrarrojos, hasta las ondas electromagnéticas de mayor longitud de onda, como son las ondas de radio. Se cree que el límite la longitud de onda más pequeña posible es la longitud de Planck mientras que el límite máximo sería el tamaño del Universo.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

donde h es la constante de Planck (cuyo valor es 6,626 × 10−34 J·s). Sólo los fotones con una frecuencia alta (por encima de un valor umbral específico) podían provocar la corriente de electrones. Por ejemplo, la luz azul emitía unos fotones con una energía suficiente para arrancar los electrones del metal, mientras que la luz roja no. Una luz más intensa por encima del umbral mínimo puede arrancar más electrones, pero ninguna cantidad de luz por debajo del mismo podrá arrancar uno solo, por muy intenso que sea su brillo.

El esquema del Efecto fotoeléctrico nos muestra como la luz arranca electrones de la placa.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza, al mismo tiempo que nos aleja de nuestra propia realidad.

Sí, están ahí pero, en realidad, no sabemos, a ciencia cierta, ni cómo se formaron las galaxias

¿Qué encontraremos cuando sea posible verificar la Teoría de cuerdas? ¿Qué hay más allá de los Quarks? ¿Sabremos alguna vez lo que es una singularidad? ¿Será verdad la existencia de esa materia oscura de la que tanto se habla? ¿Podremos al fín, encontrar esa fuente de energía que tanto necesita la Humanidad para dar ese segundo paso el futuro? ¿Tendremos, acaso, algún destino que no sea el de la irremisible extinción?

¡Preguntas! Preguntas y más preguntas que no podemos contestar. Es desesperante estar inmersos en inmenso océano de ignorancia. ¿Cuándo sabremos? El el epitafio que Hilbert ordenó esculpir en su Tumba, nos lo prometía: “Tenemos que saber, sabremos”. Si, ¿pero cuándo?

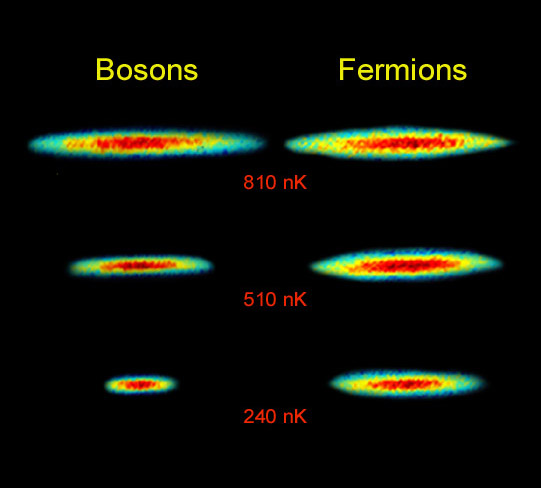

Lo cierto es que, las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas que rigen el universo.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Debido al principio de exclusión de Pauli no es imposible que dos fermiones ocupen el mismo espacio cuántico (al contrario de lo que ocurre con los bosones). Y, precisamente por eso, se degeneran electrones y neutrones dando lugar a la formación de estrellas enanas blancas y de neutrones que, encuentran la estabilidad frenando la fuerza de gravedad.

La condensación de Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7k) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Este efecto (condensación Bose-Einstein), ya habréis podido suponer, es llamado así en honor al físico Satyendra Naht Bose (1.894-1.974) y de Albert Einstein.

Más reciente es la obtención del Condensado de Bose-Einstein (BEC); en este caso las bases teóricas se postularon en la década de los 20 en manos de Satyendra Nath Bose y Albert Einstein. El primero describe ciertas reglas para determinar si dos fotones deberían considerarse idénticos o diferentes (Estadísticas de Bose) y Einstein aplica dichas reglas a los átomos intentando averiguar como se comportarían. Así, halla los efectos de que a muy bajas temperaturas los átomos están al mismo nivel cuántico produciendo fenómenos como la superfluidez o la superconductividad.

Distribución de momentos que confirma la existencia de un estado de agregación de la materia, el condensado de Bose-Einstein. obtenidos en un gas de átomos de rubidio, la coloración indica la cantidad de átomos a cada velocidad, con el rojo indicando la menor y el blanco indicando la mayor. Las áreas blancas y celestes indican las menores velocidades. A la izquierda se observa el diagrama inmediato anterior al condensado de Bose-Einstein y al centro el inmediato posterior. A la derecha se observa el diagrama luego de cierta evaporación, con la sustancia cercana a un condensado de Bose-Einstein puro. El pico no es infinitamente angosto debido al Principio de indeterminación de Heisenberg: dado que los átomos están confinados en una región del espacio, su distribución de velocidades posee necesariamente un cierto ancho mínimo. La distribución de la izquierda es para T > Tc (sobre 400 nanokelvins (nK)), la central para T < Tc (sobre 200 nK) y la de la derecha para T << Tc (sobre 50 nK).

… del sistema binario descubierto a 7,000 años luz de la Tierra, que está formado por una estrella de neutrones (el círculo más grande) y enana blanca (el …

Las estrellas enanas blancas, de neutrones y los púlsares existen, precisamente, por el principio de exclusión de Pauli que, degenera electrones y neutrones cuando las estrellas masivas, al final de su existencia, explotan como Supernovas y´su masa se contraen sobre sí misma más y más. Si la estrella es demasiado masiva, entonces ni ese principio de exclusión puede frenar a la Gravedad y se convierte en un Agujero negro.

Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones. Si nos fijamos en todo lo que estamos hablando aquí, nos daremos de que la mecánica cu´çantica es extraña y siendo fácil comprender como forma un campo magnético la partícula cargada que gira, no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado.

Lo cierto es que ocurre así. La prueba directa más evidente de ello es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalentes a cero, aunque por alguna razón desconocida, lograr crear un campo magnético cuando gira la partícula.

emilio silvera

Abr

14

Cosas de la Mecánica Cuántica

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡La Física! Esa maravilla que está presente en todo lo que podemos ver y en aquello donde la vista no llega. La infinitud de las partículas elementales que forman todo cuanto existe en la Naturaleza, no siempre se dejan ver ni hacen posible que podamos observar las maravillas que pueden llevar a cabo,

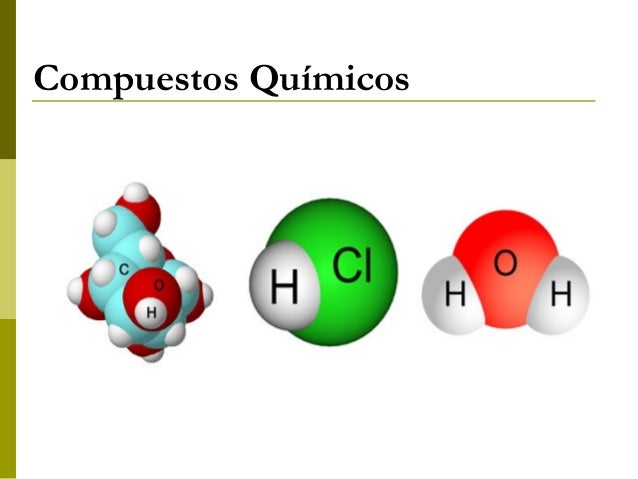

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos, y, si está conformada por distintos átomos, son compuestos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su forma esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.8836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos hacia el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, para lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Claro que, no debemos olvidarnos de que, ¡Todo lo grande está hecho de cosas pequeñas! Una inmensa galaxia se conforma de un conjunto inmenso de átomos inifinitesimales que juntos, hace ese gran todo.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. Cuando uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

La perfecta sincronía Está en la Naturaleza

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = h x v

Donde E es la energía del paquete, v la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Los cuantos de energía etán presentes por todas partes y en todos los objetos

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió como escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial como general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no puede por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza.

emilio silvera

Abr

5

¿Teoría de Cuerdas? ¡Qué extraña resulta!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Todos los que nos asomamos por la ventana de la Física, sabemos, más o menos que, después de más de treinta años de historia con la Teoría de dimensiones extra, no es aún, nada fácil encontrar una respuesta sencilla a una sencilla pregunta: ¿Qué es, la Teoría de Cuerdas? Y, lógicamente, muchos científicos del ámbito de la física, están verdaderamente escandalizados con todo este movimiento del que ellos, hablan como de un montaje circense, una comedia en la que, expertos malabaristas de las matemáticas topológicas, hacen trucos de magia para que parezca lo que no es.

Sin embargo, la cosa no parece que sea tan fácil de despachar, cientos y miles de artículos avalan esa Teoría que, en muchos aspectos, parece ser la esperanza futura de la Física y la única que nos puede abrir caminos ahora cerrados que, nos llevarán más lejos, a lugares que ahora, con la física actual, no podemos visitar.

Claro que no todo son críticas, en un artículo que leí en alguna parte nos dicen: “La teoría ha sido elogiada por algunos físicos debido a su potencial para forjar el largamente buscado vínculo entre la gravedad y las fuerzas que dominan en el núcleo atómico. Pero la teoría –que propone que todas las partículas subatómicas son en realidad diminutas “cuerdas” que vibran de diferentes formas– también ha arrastrado críticas por ser incomprobable en el laboratorio, y tal vez imposible de conectar con los fenómenos del mundo real.

Algunos ven la Teoría de cuerdas como un sueño imposible

Sin embargo, los investigadores de Princeton han descubierto una nueva prueba matemática de que alguna de las predicciones de la Teoría de Cuerdas se entrelazan estrechamente con un cuerpo de la física muy respetable llamado “Teoría Gauge”, el cual se ha demostrado que subyace en las interacciones entre quarks y gluones, los menudos objetos que se combinan para formar protones, neutrones y otras partículas subatómicas más exóticas. El descubrimiento, dicen los físicos, podría dar lugar a una gran cantidad de usos de la Teoría de Cuerdas atacando problemas de la física práctica.”

Es cierto que la Física está dominada por los paradigmas impuestos desde hace cien años por la mecánica cuántica y la relatividad que son dos teorías fundamentales que parten de principios rectores a partir de los cuales las teorías se construyen de una manera casi sistemática. En estos ejemplos es fácil de identificar ese principio rector:

En la Relatividad el principio es la constancia de la velocidad de la luz o, lo que es equivalente, que la velocidad de la luz determina una cota máxima sobre la velocidad de transmisión de información. Una vez aceptado este principio, el resto se da casi por añadidura. La constancia de la velocidad de la luz implica un espacio tiempo con una determinada geometría, la equivalencia entre masa y energía, así como el resto de los resultados de la Dinámica y la Cinemática Relativistas.

Este es el tiempo que tarda la luz en llegar desde la Tierra a la Luna situada a 380.000 Km de nosotros

No podemos perder de vista el hecho cierto de que, la razón por la que la Relatividad se convierte en una auténtica Teoría autónoma es precisamente porque eleva la constancia de la velocidad de la luz a principio rector, a postulado. No se trata de explicar o modelar dinámicamente por qué la velocidad de la luz es la velocidad máxima sino que, muy por el contrario, se trata de derivar toda una cinemática, de hecho la propia naturaleza geométrica del espacio y el tiempo, a partir de dicho postulado.

El Universo de la Mecánica Cuántica nos es fantasmagórico e irreal, es un mundo aparte en el que, podemos ver cosas inusuales y sorprendentes, allí no rigen las mismas leyes que podemos constatar a nuestro alrededor en el mundo macroscópico, o, si están presentes, funcionan de otra manera que, alejada de nuestro propio mundo, no hemos llegado a comprender…del todo.

Nos decía el filósofo Karl Popper:

“La ciencia será siempre una búsqueda, jamás un descubrimiento real. Es un viaje, nunca una llegada.”

El hombre llevaba toda la razón toda vez que, emprendemos la aventura de la Ciencia y tratamos de buscar “cosas” y “comportamientos” que nos digan por qué, la Naturaleza, funciona de esta o de aquella otra manera. Vamos desvelendo escenarios y obteniendo algunas respuestas pero, el viaje no acaba nunca, a cada puerta abierta, nos encontramos con otro nuevo espacio en el que también, existen muchas puertas cerradas cuyas llavez tendremos que encontrar y, siempre será, de esa manera: ¡Un viaje intermivnable! Siempre hay alguna cosa nueva si vamos un poco más allá.

Cada uno de estos cuatro espacios de Hilbert tiene un análisis de Fourier asociado con el.

L2([a,b]) → Series de Fourier

ℓ2([0,n−1]) → Transformada Discreta de Fourier

L2(R) → Transformada de Fourier

ℓ2(Z) → Transformada Discreta de Fourier en Tiempo

Pero los cuatros están basados en el mismo principio (Espacio de Hilbert).

Nota Importante: no todos los espacios normalizados son espacios de Hilbert

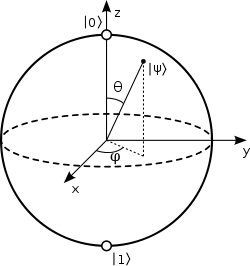

Y por tanto el espacio de Hilbert de esos estados puros se asociará con un punto en esa esfera y un sistema multiqubit será algo como lo expresado en la figura.

De forma más formal, el Espacio de Hilbert se define como un espacio de producto interior que es completo con respecto a la norma vectorial definida por el producto interior. Los espacios de Hilbert sirven para clarificar y para generalizar el concepto de series de Fourier, ciertas transformaciones lineales tales como la transformación de Fourie, y son de importancia crucial en la formulación matemática de la mecánica cuántica.

El espacio de Hilbert es una pura construcción matemática pero responde a la perfección a lo que hacía falta para elaborar la teoría cuántica. De no haberse descubierto habría habido que inventarlo para las necesidades de la teoría. El espacio de Hilbert es un espacio vectorial infinitamente grande. En su momento, esto fue una idea revolucionaria, en virtud de que todos los espacios vectoriales, inclusive los espacios matemáticos abstractos, eran finitos. Pero afortunadamente en su trabajo sobre ecuaciones integrales llevado a cabo en 1912 David Hilbert tuvo la visión suficiente para captar la necesidad de tener que postular un espacio vectorial infinitamente grande para poder proyectar todo el aparato matemático de la Mecánica Cuántica sobre una base rigurosamente formal. Y quince años después correspondió a otro matemático igualmente brillante, el matemático húngaro John Neumann, el darle en 1927 una definición axiomática al espacio vectorial de Hilbert en su ya famosa obra Mathematische Grundlagen der Quantenmechanik. Pero Hilbert no solo propuso un espacio vectorial infinitamente grande. Propuso también que los componentes de los “vectores” pudiesen ser números imaginarios o números complejos sin estar limitados a ser números reales, redefiniendo a la vez el concepto del producto interno de dos vectores para que dicho producto pudiese seguir siendo un número real con significado físico.

En el caso de la Mecánica Cuántica el principio rector es el Principio de Incertidumbre de Heisenberg. De nuevo este principio se postula como principio básico y a partir de allí se deduce como tiene que ser el espacio de estados físicos, que se convierte en un espacio de naturaleza completamente nueva como lo es un espacio de Hilbert.

Esto da lugar a fenómenos tan sorprendentes como el entrelazamiento cuántico o la estabilidad atómica.

Sí, el camino ha sido largo. En la serie de artículos Fundamentos de una teoría general de las ecuaciones integrales, Hilbert analizó las técnicas introducidas para estudiar estas ecuaciones por Poincaré y Fredholm a finales del XIX, mejorando sus resultados. En el cuarto artículo de esta serie, publicado en 1906, Hilbert prueba que las ecuaciones integrales pueden resolverse como un sistema de infinitas ecuaciones lineales con infinitas incógnitas.

Todos los objetos situados en el mismo campo gravitatorio caen con la misma aceleración si y sólo si la proporción entre masa gravitacional e inercial es igual a una constante. Por eso precisamente decimos que, en Relatividad General, el principio rector es el principio de equivalencia entre masa inercial y masa gravitatoria.

En la Teoría de Cuerdas la situación es completamente distinta. Se desconoce cual pueda ser el principio rector, si en realidad existe algún principio rector en esta teoría, y es, precisamente este desconocimiento el qure genera en nosotros perplejidad cuando se nos pide una respuesta sencilla a: ¿Qué es la Teoría de Cuerdas?

Recordemos que el nacimiento de la teoría fue, esencialmente modesto. Aquel momento en el que proliferaban los experimentos de resonancias en interacciones fuertes con espines altos resultaba desconcertante, se observó que una manera de hacer consistente la mediación de la interacción con partícuals de espín alto consistía en imponer a las amplitudes de colisión una simetría particular que se denominó dualidad. Desde entonces las cosas han cambiado de manera exponencial y se habla de otra manera y de otras cosas. Veámos que nos dice, por ejemplo, uno de los padres de la teoría de cuerdas:

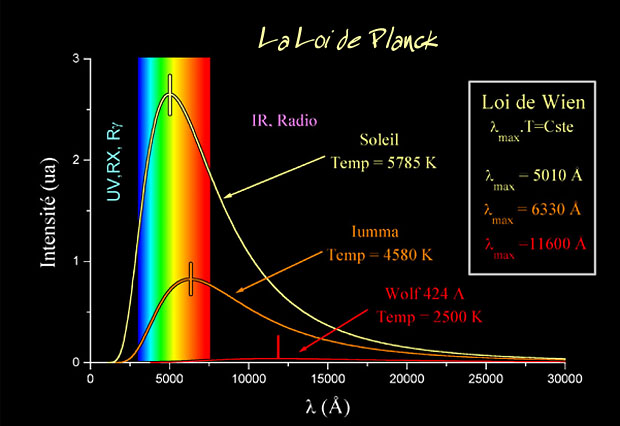

“Me gusta esta figura porque muestra muy claramente lo que conocemos en física de partículas, lo que esperamos explorar en las próximas décadas, y lo que creemos conocer, aunque nunca llegaremos a explorar de forma directa. La partícula con más masa conocida tiene menos de 200 GeV y todavía se sigue explorando entre 10 a 200 GeV en busca de nuevas partículas. Basta recordar que se acaba de descubrir una partícula con 125 GeV de masa, el bosón de Higgs, y que muchos físicos creen que la partícula responsable de la materia oscura tiene una masa en este rango. El LHC y sus sucesores en las próximas décadas explorarán las energías entre 100 y 5000 GeV (difícilmente podrán llegar más lejos). Sin embargo, hay un desierto hasta energías de 10 000 000 000 GeV (la escala de Planck) que no hemos explorado, que no podremos explorar en el siglo XXI y del que no conocemos absolutamente nada, aunque imaginamos muchas cosas.”

Si sabemos, por ejemplpo que.. la constante de Planck, h = 6,626075…x 10 exp. -34 julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, …

Como facilmente podemos deducir de lo que arriba se dice, estamos muy lejos aún de llegar a un autoconsistente final en la teoría de cuerdas que, posiblemente necesite disponer de la energía de Planck (1019 GeV), para verificarla de manera que no dejara ningún lugar a dudas. Hemos podido verificar la Teoría Cuántica y tambien, las dos versiones de la Teoría de la Relatividad. Sin embargo… Las cuerdas están lejos de ser una teoría que podamos aceptar y, sólo esperanzas podemos volcar en ella, con la idea de que, en un futuro más o menos lejano, nos pudiera dar aquellas respuestas que, de momento, no encontramos.

No podemos negar que algunos resultados en esta teoría han sido sobresalientes: Las resonancias, que habían actuado como motivación, se acomodaban como modos de vibración de las cuerdas y la democracia nuclear adquiría un status más sólido al reflejar una manera de unificar partículas, con espines arbitrariamente altos, como distintos modos de vibración de un mismo objeto fundamental. Aunque estos avances fueron destacados, la teoría empezó pronto a hacer aguas. En primer lugar, las cuerdas eran tan solo una manera de modelar la física subyacente a las amplitudes duales, pero por otra parte esta estructura de objetos extendidos fundamentales producía una serie de consecuencia que no iban a encajar con los futuros resultados experimentales en interacciones fuertes.

Las amplitudes duales, aunque implementaban la idea de democracia nuclear, daban ineludiblemente lugar a un comportamiento de las amplitudes a altas energías mucho más suave del que se observaba en la realidad. Por otro lado los avances formales habían mostrado que la consistencia de la teoría exigía un espacio tiempo de dimensión 26 y que el espectro contenía al menos un taquión (una partícula con masa imaginaria). Estos defectos fueron pronto, parcialmente subsanados, dando lugar a conceptos que han ocupado un papel crucial en la Física de los últimos lustros; estoy hablando de la supersimetría y al renacimiento de las ideas de Kaluza y Klein sobre espacio-tiempo con más de cuatro dimensiones.

Seguiremos hablando de la Teoría de Cuerdas y llegaremos hasta la actual posición que ocupa ésta compleja idea que algunos físicos han venido desarrollando en los últimos cuarenta años y que, nadie sabe en qué pueda desembocar. Muchas han sido las teorías que han sido desarrolladas y, siempre, nos dieron respuestas a cuestiones que, en un principio, ni podíamos imaginar.

¿Os acordáis de la Teoría del Caos?

El efecto mariposa, un atractor extraño

El orden lleva asociado un grado importante de predicción, al caos le sucede lo contrario. Los sistemas lineales, representan el orden, son predecibles y cómodos de manejar, de ahí nuestra tendencia a generalizarlos. Ante un sinfín de situaciones generalizamos, proyectamos los datos del presente para tratar de averiguar un comportamiento futuro y casi siempre nos va bien. Pero existen sistemas que se resisten: pequeñas variaciones, incertidumbres, en los datos iniciales desembocan en situaciones finales totalmente descontroladas e impredecibles. Son los llamados sistemas caóticos.

Pues, de la misma manera, estamos tratando de desarrollar una teoría que, de alguna manera, nos pueda responder a cuestiones que son presentidas e intuidas pero que, hasta el momento, nadie ha podido explicar y, es precisamente con la Teoría de Cuerdas con lo que se quiere buscar esas respuestas profundamente escondidas en las entrañas de la naturaleza: ¡La Teoría de Cuerdas! Que podría ser una quimera o una gran solución.

emilio silvera

Totales: 71.800.852

Totales: 71.800.852 Conectados: 60

Conectados: 60