Oct

20

¡Fisica! Siempre la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡El Universo! ¿Sería eso lo que pasó?

Como nunca dejaremos a aprender cosas nuevas, de desvelar secretos de la Naturaleza, de seguir investigando en busca de “otras verdades”, de elaborar nuevos modelos y nuevas Teorías que nos acerquen, cada vez más a la realidad del mundo (ese es, de momento, nuestro cometido), estamos abocados a tratar de saber lo que no sabemos y que, no pocas veces, creemos que sabemos. Ya lo dijo Popper:

“Cuanto más profundizo en el saber de las cosas, más consciente soy de lo poco que sé. Mis conocimientos son finitos , mi ignorancia, es infinita“.

Lo que nos lleva a la versión antigua del dicho: “Sólo se que no se nada” de Sócrates.

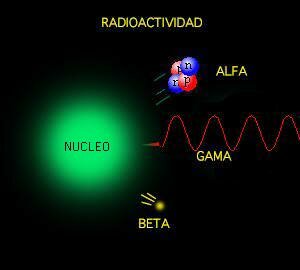

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

“La revolución de la mecánica cuántica empieza a materializarse, y el qubit es el principal protagonista. Siendo la unidad mínima de información de extraño mundo, permitirá procesar toda la información existente en segundos.” El futuro que nos aguarda es inimaginable y cada día que pasa aparecen nuevos logros tecnológicos que nos sitúan en otro mundo, otra sociedad, otras nuevas formas de vivir y de comprender.

Sí, son los electrones los que dan al átomo su forma esférica

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Un experimento realizado por científicos del Centro de Viena para la Ciencia y Tecnología Cuánticas ha demostrado que, en el mundo cuántico, la transición hacia el equilibrio térmico es más interesante y más complicada de lo que se pensaba.

Según destaca el , publicado en ‘Science’, entre un ordenado inicial y un estado final estadísticamente mixto, puede emerger un “cuasi-estacionario estado intermedio”. Este estado intermedio ya exhibe algunas propiedades como el equilibrio, pero parte de las características del estado inicial permanecen visibles durante un período de tiempo muy largo.

El fenómeno se denomina “pre-termalización” y desempeña un papel importante en diversos procesos de no equilibrio en la física cuántica. Podría, por ejemplo, ayudarnos a comprender el estado del universo temprano.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

Sincronización perfecta, ¡es una sinfonía!

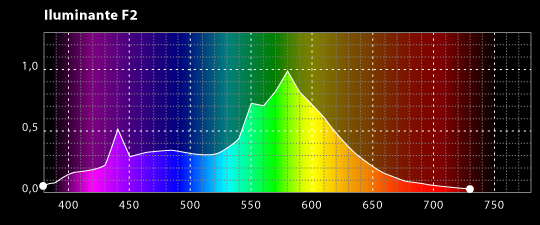

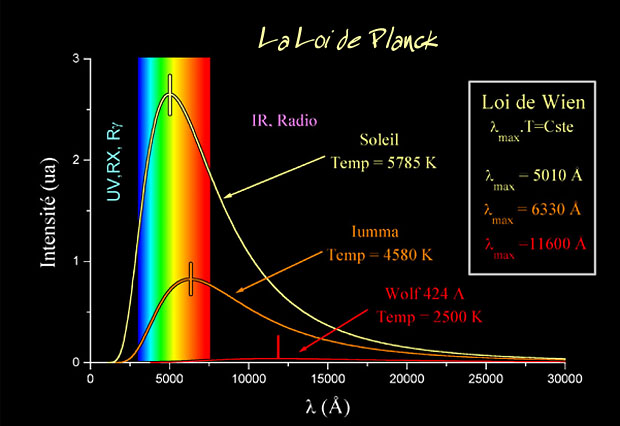

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

El espectro electromagnético se extiende la radiación de menor longitud de onda, como los rayos gamma y los rayos X, pasando por la luz ultravioleta, la luz visible y los rayos infrarrojos, hasta las ondas electromagnéticas de mayor longitud de onda, como son las ondas de radio. Se cree que el límite la longitud de onda más pequeña posible es la longitud de Planck mientras que el límite máximo sería el tamaño del Universo.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

donde h es la constante de Planck (cuyo valor es 6,626 × 10−34 J·s). Sólo los fotones con una frecuencia alta (por encima de un valor umbral específico) podían provocar la corriente de electrones. Por ejemplo, la luz azul emitía unos fotones con una energía suficiente para arrancar los electrones del metal, mientras que la luz roja no. Una luz más intensa por encima del umbral mínimo puede arrancar más electrones, pero ninguna cantidad de luz por debajo del mismo podrá arrancar uno solo, por muy intenso que sea su brillo.

El esquema del Efecto fotoeléctrico nos muestra como la luz arranca electrones de la placa.

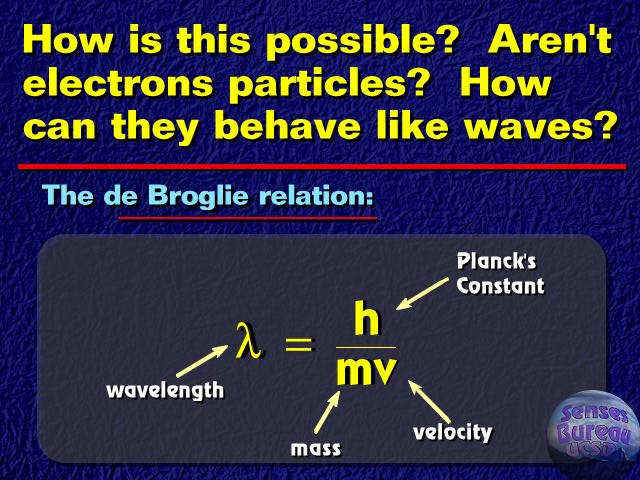

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

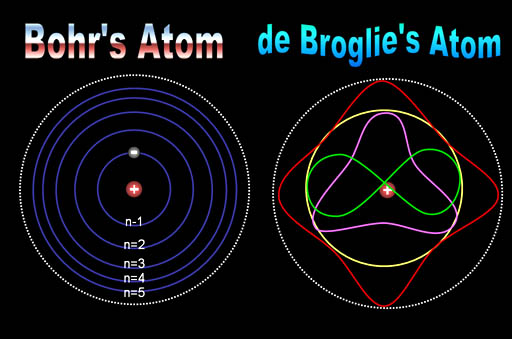

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza, al mismo tiempo que nos aleja de nuestra propia realidad.

Sí, están ahí pero, en realidad, no sabemos, a ciencia cierta, ni cómo se formaron las galaxias

¿Qué encontraremos cuando sea posible verificar la Teoría de cuerdas? ¿Qué hay más allá de los Quarks? ¿Sabremos alguna vez lo que es una singularidad? ¿Será verdad la existencia de esa materia oscura de la que tanto se habla? ¿Podremos al fín, encontrar esa fuente de energía que tanto necesita la Humanidad para dar ese segundo paso el futuro? ¿Tendremos, acaso, algún destino que no sea el de la irremisible extinción?

¡Preguntas! Preguntas y más preguntas que no podemos contestar. Es desesperante estar inmersos en inmenso océano de ignorancia. ¿Cuándo sabremos? El el epitafio que Hilbert ordenó esculpir en su Tumba, nos lo prometía: “Tenemos que saber, sabremos”. Si, ¿pero cuándo?

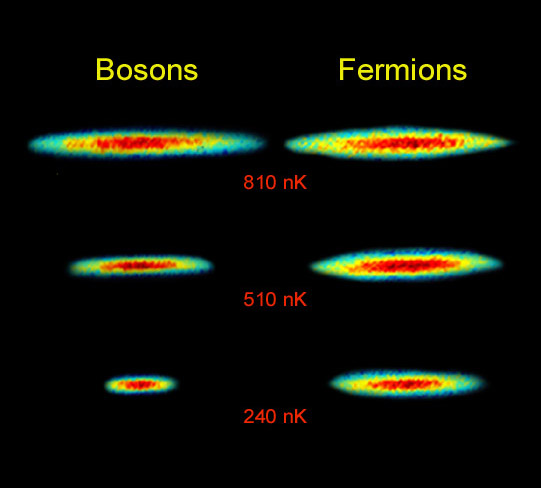

Lo cierto es que, las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas que rigen el universo.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Debido al principio de exclusión de Pauli no es imposible que dos fermiones ocupen el mismo espacio cuántico (al contrario de lo que ocurre con los bosones). Y, precisamente por eso, se degeneran electrones y neutrones dando lugar a la formación de estrellas enanas blancas y de neutrones que, encuentran la estabilidad frenando la fuerza de gravedad.

La condensación de Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7k) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Este efecto (condensación Bose-Einstein), ya habréis podido suponer, es llamado así en honor al físico Satyendra Naht Bose (1.894-1.974) y de Albert Einstein.

Más reciente es la obtención del Condensado de Bose-Einstein (BEC); en este caso las bases teóricas se postularon en la década de los 20 en manos de Satyendra Nath Bose y Albert Einstein. El primero describe ciertas reglas para determinar si dos fotones deberían considerarse idénticos o diferentes (Estadísticas de Bose) y Einstein aplica dichas reglas a los átomos intentando averiguar como se comportarían. Así, halla los efectos de que a muy bajas temperaturas los átomos están al mismo nivel cuántico produciendo fenómenos como la superfluidez o la superconductividad.

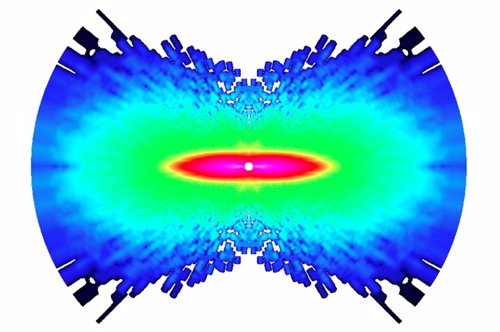

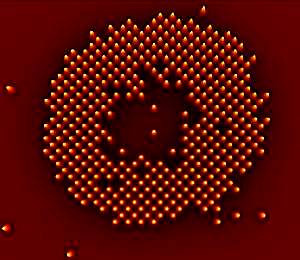

Distribución de momentos que confirma la existencia de un estado de agregación de la materia, el condensado de Bose-Einstein. obtenidos en un gas de átomos de rubidio, la coloración indica la cantidad de átomos a cada velocidad, con el rojo indicando la menor y el blanco indicando la mayor. Las áreas blancas y celestes indican las menores velocidades. A la izquierda se observa el diagrama inmediato anterior al condensado de Bose-Einstein y al centro el inmediato posterior. A la derecha se observa el diagrama luego de cierta evaporación, con la sustancia cercana a un condensado de Bose-Einstein puro. El pico no es infinitamente angosto debido al Principio de indeterminación de Heisenberg: dado que los átomos están confinados en una región del espacio, su distribución de velocidades posee necesariamente un cierto ancho mínimo. La distribución de la izquierda es para T > Tc (sobre 400 nanokelvins (nK)), la central para T < Tc (sobre 200 nK) y la de la derecha para T << Tc (sobre 50 nK).

… del sistema binario descubierto a 7,000 años luz de la Tierra, que está formado por una estrella de neutrones (el círculo más grande) y enana blanca (el …

Las estrellas enanas blancas, de neutrones y los púlsares existen, precisamente, por el principio de exclusión de Pauli que, degenera electrones y neutrones cuando las estrellas masivas, al final de su existencia, explotan como Supernovas y´su masa se contraen sobre sí misma más y más. Si la estrella es demasiado masiva, entonces ni ese principio de exclusión puede frenar a la Gravedad y se convierte en un Agujero negro.

Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones. Si nos fijamos en todo lo que estamos hablando aquí, nos daremos de que la mecánica cu´çantica es extraña y siendo fácil comprender como forma un campo magnético la partícula cargada que gira, no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado.

Lo cierto es que ocurre así. La prueba directa más evidente de ello es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalentes a cero, aunque por alguna razón desconocida, lograr crear un campo magnético cuando gira la partícula.

emilio silvera

Oct

16

La maravilla de… ¡los cuantos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos. Planck escribió un artículo de ocho páginas y el resultado fue que cambió el mundo de la física y aquella páginas fueron la semilla de la futura ¡mecánica cuántica! que, algunos años más tardes, desarrollarían físicos como Einstein (Efecto fotoeléctrico), Heisenberg (Principio de Incertidumbre), Feynman, Bhor, Schrödinger, Dirac…

La expresión radiación se refiere a la emisión continua de energía de la superficie de todos los cuerpos. Los portadores de esta energía son las ondas electromagnéticas producidas por las vibraciones de las partículas cargadas que forman parte de los átomos y moléculas de la materia. La radiación electromagnética que se produce a causa del movimiento térmico de los átomos y moléculas de la sustancia se denomina radiación térmica o de temperatura.

Ley de Planck para cuerpos a diferentes temperaturas.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía.

Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico o una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Acero al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = hv

Donde E es la energía del paquete, v es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck.

El príncipe francés Louis Victor de Broglie, dándole otra vuelta a la teoría, que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta dirección del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

Es curioso el comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Edwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar los cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de onda cuántica”.

No hay duda de que la Mecánica Cuántica funciona maravillosamente bien. Sin embargo, surge una pregunta muy formal: ¿qué significan realmente esas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá por el año 1687, formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo lo que significaban sus ecuaciones: que los planetas están siempre en una posición bien definida en el espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades con el tiempo.

Pero para los electrones todo esto es muy diferente. Su comportamiento parece estar envuelto en la bruma. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la “interpretación de Copenhague” de la Mecánica Cuántica. En vez de decir que el electrón se encuentra en el punto x o en el punto y, nosotros hablamos del estado del electrón. Ahora no tenemos el estado “x” o el estado “y”, sino estados “parcialmente x” o “parcialmente y. Un único electrón puede encontrarse, por lo tanto, en varios lugares simultáneamente. Precisamente lo que nos dice la Mecánica Cuántica es como cambia el estado del electrón según transcurre el tiempo.

Un “detector” es un aparato con el cual se puede determinar si una partícula está o no presente en algún lugar pero, si una partícula se encuentra con el detector su estado se verá perturbado, de manera que sólo podemos utilizarlo si no queremos estudiar la evolución posterior del estado de la partícula. Si conocemos cuál es el estado, podemos calcular la probabilidad de que el detector registre la partícula en el punto x.

Las leyes de la Mecánica Cuántica se han formulado con mucha precisión. Sabemos exactamente como calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas simultáneamente. Por ejemplo, podemos determinar la velocidad de una partícula con mucha exactitud, pero entonces no sabremos exactamente dónde se encuentra; o, a la inversa. Si una partícula tiene “espín” (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar con sencillez de dónde viene esta incertidumbre, pero hay ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar.

¿Onda o partícula? ¡Ambas a la vez! ¿Cómo es eso?

Para que las reglas de la Mecánica Cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuanto más grande y más pesado es un objeto más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica.

Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por “holismo”, y que se podría definir como “el todo es más que la suma de las partes”.

Bien, si la Física nos ha enseñado algo, es justamente lo contrario: un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (las partículas): basta que uno sepa sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que yo entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes.

Por ejemplo, la constante de Planck, h = 6,626075…x 10 exp. -34 julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros tales como Edwin Schrödinger, siempre presentaron serias objeciones a esta interpretación.

Quizá funcione bien, pero ¿dónde está exactamente el electrón, en el punto x o en el punto y? Em pocas palabras, ¿dónde está en realidad?, ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Hasta hoy, muchos investigadores coinciden con la actitud pragmática de Bohr. Los libros de historia dicen que Bohr demostró que Einstein estaba equivocado. Pero no son pocos, incluyéndome a mí, los que sospechamos que a largo plazo el punto de vista de Einstein volverá: que falta algo en la interpretación de Copenhague. Las objeciones originales de Einstein pueden superarse, pero aún surgen problemas cuando uno trata de formular la mecánica cuántica para todo el Universo (donde las medidas no se pueden repetir) y cuando se trata de reconciliar las leyes de la mecánica cuántica con las de la Gravitación… ¡Infinitos!

La mecánica cuántica y sus secretos han dado lugar a grandes controversias, y la cantidad de disparates que ha sugerido es tan grande que los físicos serios ni siquiera sabrían por donde empezar a refutarlos. Algunos dicen que “la vida sobre la Tierra comenzó con un salto cuántico”, que el “libre albedrío” y la “conciencia” se deben a la mecánica cuántica: incluso fenómenos paranormales han sido descritos como efectos mecanocuánticos.

Yo sospecho que todo esto es un intento de atribuir fenómenos “ininteligibles” a causas también “ininteligibles” (como la mecánica cuántica) dónde el resultado de cualquier cálculo es siempre una probabilidad, nunca una certeza.

Claro que, ahí están esas teorías más avanzadas y modernas que vienen abriendo los nuevos caminos de la Física y que, a mi no me cabe la menor duda, más tarde o más temprano, podrá explicar con claridad esas zonas de oscuridad que ahora tienen algunas teorías y que Einstein señalaba con acierto.

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? ¿Por qué están ahí? ¿Quiere eso decir que la Teoría de Einstein y la Mecánica Cuántica podrán al fin unirse en pacifico matrimonio sin que aparezcan los dichosos infinitos?

Bueno, eso será el origen de otro trabajo que también, cualquier día de estos, dejaré aquí para todos ustedes.

emilio silvera

Oct

13

De como llegamos hasta los Quarks

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

Ahora todos hablamos del LHC. Sin embargo, la historia de los aceleradores no comenzó con éste moderno y complejo conglomerado de sofisticadas estructuras que hacen posible que visitemos lugares muy lejanos en el corazón de la materia. Tendríamos que recordar al acelerador lineal también llamado LINAC (linear accelerator) es un tipo de acelerador que le proporciona a la partícula subatómica cargada pequeños incrementos de energía cuando pasa a través de una secuencia de campos eléctricos alternos.

Generador de Van de Graaff. El rodillo y peine superior.

Mientras que el generador de Van de Graaff proporciona energía a la partícula en una sola etapa, el acelerador lineal y el ciclotrón proporcionan energía a la partícula en pequeñas cantidades que se van sumando. El acelerador lineal, fue propuesto en 1924 por el físico sueco Gustaf Ising. El ingeniero noruego Rolf Wideröe construyó la primera máquina de esta clase, que aceleraba iones de potasio hasta una energía de 50.000 eV.

Durante la Segunda Guerra Mundial se construyeron potentes osciladores de radio frecuencia, necesarios para los radares de la época. Después se usaron para crear aceleradores lineales para protones que trabajaban a una frecuencia de 200 MHz, mientras que los aceleradores de electrones trabajan a una frecuencia de 3000 MHz.

El acelerador lineal de protones diseñado por el físico Luis Alvarez en 1946, tenía 875 m de largo y aceleraba protones hasta alcanzar una energía de 800 MeV (800 millones). El acelerador lineal de la universidad de Stanford es el más largo entre los aceleradores de electrones, mide 3.2 km de longitud y proporciona una energía de 50 GeV. En la industria y en la medicina se usan pequeños aceleradores lineales, bien sea de protones o de electrones.

El SLAC, ubicado al sur de San Francisco, acelera electrones y positrones a lo largo de algo más de tres kilómetros hacia varios blancos, anillos y detectores ubicados en su finalización. Este acelerador hace colisionar electrones y positrones, estudiando las partículas resultantes de estas colisiones. Construido originalmente en 1962, se ha ido ampliando y mejorando para seguir siendo uno de los centros de investigación de física de partículas mas avanzados del mundo. El centro ha ganado el premio nobel en tres ocasiones. Y, una vez recordada de manera breve la historia, pasaremos directamente al tema que en realidad nos ha tríado aquí: ¡El descubrimiento de los Quarks!

Ahora los medios con los que cuentan los físicos del LHC son inmensamente más eficaces y están más adelantados que aquellos viejos aceleradores que, sin embargo, fueron los pioneros y los que hicieron posible adquirir conocimientos que nos han traído hasta el moderno LHC.

En 1967 se emprendió una serie de experimentos de dispersión mediante los nuevos haces de electrones del SLAC. El objetivo era estudiar más incisivamente la estructura del protón. Entra el electrón de gran energía, golpea un protón en un blanco de hidrógeno y sale un electrón de energía mucho menor, pero en una dirección que forma un ángulo grande con respecto a su camino original. La estructura puntual dentro del protón actúa, en cierto sentido, como el núcleo con las partículas alfa de Rutherford. Pero el problema era aquí más sutíl.

Richard Edward Taylor

Richard Edward Taylor fue uno de los veintidós científicos que trabajó intensamente en el acelerador lineal de Stanford (SLAC), en una serie de pruebas experimentales que vinieron a demostrar que los protones y los neutrones son poseedores de una estructura interna, lo que a su vez confirma las predicciones teóricas del neoyorquino Murray Gell-Mann (1929- ), acerca de la existencia de los denominados quarks.

Junto con sus colegas de Stanford junto con Jerome I. Friedman y Henry W. Kendall -con los que luego habría de compartir el Nobel-, Taylor investigó sobre la estructura interna de la materia, en su mínima expresión, para lo que partió del modelo teórico de los quarks, postulado por Gell-Mann y -de forma independiente- G. Zweig. Tras sus descubrimientos experimentales en el acelerado lineal de Stanford, Taylor perfeccionó dicho modelo añadiéndole la existencia de unas subpartículas desconocidas hasta entonces, que luego fueron denominadas leptones; además, introdujo en el modelo teórico de Gell-Mann otras partículas no estructurales, sino de intercambio de fuerza, a las que en Stanford comenzaron a llamar bosones.

James Bjorken.

Richard Feynman

Los dos últimos párrafos los he tomado prestados de www.mcnbiografias.com., que es lo que se explica de este tema en casi todas partes. Sin embargo, pocos cuentan que, el equipo de Stanford, dirigido por el físico del SLAC por Richard Taylor y los otros dos físicos del MIT, Jerome Friedman y Henry Kendall, tuvieron la gran suerte de que, Richard Feynman y James Bjorken, metieran sus narices en el proyecto llevados por la curiosidad y como habían prestado su energía y su imaginación a las interacciones fuertes y se preguntaban: ¿que habrá dentro del protón?

Amnos, Feynman y Bjorken visitaban con frecuencia Stanford desde su base en el Cal Tech, en Pasadena. Bjorken, teórico de Stanford, estaba muy interesado en el proyecto experimental y en las reglas que regían unos datos aparentemente incompletos. Estas reglas, razonaba Bjorken, serían indicadoras de las leyes básicas (dentro de la “caja negra”) que controlaba la estructura de los hadrones.

No estaría mal echar una mirada hacia atrás en el tiempo y recordar, en este momento, a Demócrito que, con sus postulados, de alguna manera venía a echar un poco de luz sobre el asunto, dado que él decía que para determinar si algo era un á-tomo habría que ver si era indivisible. En el modelo de los quarks, el protón, en realidad, un conglomerado pegajoso de tres quarks que se mueven rápidamente. Pero como esos quarks están siempre ineludiblemente encadenados los unos a los otros, experimentalmente el protón aparece indivisible.

Acordémonos aquí de que Boscovich decía que, una partícula elemental, o un “á-tomo”, tiene que ser puntual. Y, desde luego, esa prueba, no la pasaba el protón. El equipo del MIT y el SLAC, con la asesoría de Feynman y Bjorken, cayó en la cuenta de que en este caso el criterio operativo era el de los “puntos” y no el de la indivisibilidad. La traducción de sus datos a un modelo de constituyentes puntuales requería una sutileza mucho mayor que el experimento de Rutherford.

Precisamente por eso era tan conveniente fue tan conveniente para Richard Edward Taylor y su equipo, tener a dos de los mejores teóricos del mundo en el equipo aportando su ingenio, agudeza e intuición en todas las fases del proceso experimental. El resultado fue que los datos indicaron, efectivamente, la presencia de objetos puntuales en movimiento dentro del protón.

En 1990 Taylor, Friedman y Kendall recogieron su premio Nobel por haber establecido la realidad de los quarks. Sin embargo, a mí lo que siempre me ha llamado más la atención es el hecho cierto de que, este descubrimiento como otros muchos (el caso del positrón de Dirac, por ejemplo), han sido posible gracias al ingenio de los teóricos que han sabido vislumbrar cómo era en realidad la Naturaleza.

A todo esto, una buena pregunta sería: ¿cómo pudieron ver este tipo de partículas de tamaño infinitesimal, si los quarks no están libres y están confinados -en este caso- dentro del protón? Hoy, la respuesta tiene poco misterio sabiendo lo que sabemos y hasta donde hemos llegado con el LHC que, con sus inmensas energías “desmenuza” un protón hasta dejar desnudos sus más íntimos secretos.

Este es, el resultado ahora de la colisión de protones en el LHC

Lo cierto es que, en su momento, la teoría de los Quarks hizo muchos conversos, especialmente a medida que los teóricos que escrutaban los datos fueron imbuyendo a los quarks una realidad creciente, conociendo mejor sus propiedades y convirtiendo la incapacidad de ver quarks libres en una virtud. La palabra de moda en aquellos momentos era “confinamiento”. Los Quarks están confinados permanentemente porque la energía requerida para separarlos aumenta a medida que la distancia entre ellos crece. Esa es, la fuerza nuclear fuerte que está presente dentro del átomo y que se encarga de transmitir los ocho Gluones que mantienen confinados a los Quarks.

Así, cuando el intento de separar a los Quarks es demasiado intenso, la energía se vuelve lo bastante grande para crear un par de quark-anti-quark, y ya tenemos cuatro quarks, o dos mesones. Es como intentar conseguir un cabo de cuerda. Se corta y… ¡ya tenemos dos!

¿Cuerdas? Me parece que estoy confundiendo el principal objetivo de este trabajo y, me quiero situar en el tiempo futuro que va, desde los quarks de Gell-Mann hasta las cuerdas de Veneziano y John Schwarz y más tarde Witten. Esto de la Física, a veces te juega malas pasadas y sus complejos caminos te llevan a confundir conceptos y momentos que, en realidad, y de manera individualizada, todos han tenido su propio tiempo y lugar.

¿Cuántas veces no habré pensado, en la posibilidad de tomar el elixir de la sabiduría para poder comprenderlo todo? Sin embargo, esa pósima mágica no existe y, si queremos saber, el único camino que tenemos a nuestro alcance es la observación, el estudio, el experimento… ¡La Ciencia!, que en definitiva, es la única que nos dirá como es, y como se comporta la Naturaleza y, si de camino podemos llegar a saber, por qué lo hace así…¡mucho mejor!

emilio silvera

Oct

11

¿Que es el principio de exclusión de Pauli?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (2)

Comments (2)

El principio de exclusión de Pauli es un principio cuántico enunciado por Wolfgang Ernst Pauli en 1925. Establece que no puede haber dos fermiones con todos sus números cuánticos idénticos (esto es, en el mismo estado cuántico de partícula individual) en el mismo sistema cuántico ligado.1 Formulado inicialmente como principio, posteriormente se comprobó que era derivable de supuestos más generales: de hecho, es una consecuencia del teorema de la estadística del spin.

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental para explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7 K) se puede formar un condensado de Bose-Einstein, en el que varios miles de átomos dorman una única entidad (un superátomo). Este efecto ha sido observado con átomos de rubidio y litio.

Condensado de Bose-Einstein

Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un momento angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría para explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y unos ajustes ad-hoc, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas.

El campo magnético de las estrellas de neutrones

Si nos fijamos en todo lo que estamos hablando aquí, es fácil comprender cómo un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma que lo haría si el hierro no estuviese magnetizado. El magnetismo delneutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón tiene masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos.

Es indudable que las antipartículas pueden combinarse formar la antimateria, de la misma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

La verdad es que, el momento, el éxito ha sido nulo y la antimateria, si existió alguna vez, quedó destruída en esos primeros momentos del Big Bang y, desapareció debido a que, la materia bariónica era algo mayor que la antimateria, es decir, había más protones que antiprotones.

Los físicos hablan de antipartícula y se están refiriendo a una partícula subatómica que tiene la misma masa que otra partícula y valores iguales pero opuestos de otra propiedad o propiedades. Por ejemplo, la antipartícula del electrón es el positrón, que tiene una carga positiva igual en módulo a la carga negativa del electrón. El antiprotón tiene una carga negativa igual al módulo de la carga positiva del protón. El neutrón y el antineutrón tienen momentos magnéticos con signos opuestos en relación con sus espines. La existencia de antipartículas es predicha por la mecánica cuántica relativista.

Cuando una partícula y su antipartícula colisionan ocurre la aniquilación. La antimateria consiste en materia hecha de antipartículas. Por ejemplo, el antihidrógeno consiste en un antiprotón con un positrón orbitando. El antihidrógeno ha sido creado artificialmente en laboratorio. El espectro del antihidrógeno debería ser idéntico al del hidrógeno y, precisamente por eso, es tan difícil para los astrónomos localizar antimateria (si es que la hay).

Parece que el Universo está formado mayoritariamente de materia (ordinaria) y la explicación de la ausencia de grandes cantidades de antimateria debe ser incorporada en modelos cosmológicos que requieren el uso de teorías de gran unificación de las partículas elementales.

Y, a todo esto, no debemos olvidarnos de la otra materia, esa que llamamos oscura y que, en realidad, deja al descubierto nuestra inmensa ignorancia, ya que, todo el Universo está empapado de ella, y, sin embargo, aún no hemos sido capaces de discernir lo que dicha materia oscura pueda ser, como se formó, o de qué está hecha y cómo se generó en el Universo, en verdad es un gran misterio qur todos los Astrónomos del mundo persiguen incansables.

Ahora se habla de otras dimensiones, y, nuestro cerebro está conformado en tres espaciales y una temporal ( la relatividad especial) y, desde luego, nos cuesta “ver” dimensiones más altas y no podemops crear en nuestras mentes imágenes que nos lleven a 5, 10, 11 o cualquier de dimensiones que están fuera de nuestro alcance mental pero, las matemáticas nos dicen que podrían muy bien existir y, para ello, han ideado una hermosa Teoría del Todo que llaman de supercuerdas o Teoría M.

Por mucho que esforzamos nuestra imaginación, visualizar esas dimensiones extra… ¡No será nada fácil! Nuestro muntro es tridimensional más el Tiempo que, desde Einstein, es la cuarta dimensión, Sin embargo, aunque con la numerología se trabaja con más dimensiones, y, los físicos de cuerdas logran que la Cuántica y la Relatividad (lo pequeño y lño grande) se junten sin alborotos, en la realidad cotidiana, donde las matemáticas quedan fuera, esas dimensiones más altas… ¡No se ven por ninguna parte!

Según los físicos, si es verdad que dichas dimensiones están ahí, ¿no podría esa materia y energía oscura estar alojada en alguna de ellas? Tengo un registrado en la Sociedad de Autores científicos que, precisamente se refiere a eso, a que la materia oscura pueda estar fuera de nuestra visión y que no la podamos detectar precisamente por no tenerla a la vista, y, mediante fluctuaciones del vacío, esa cantidad ingente de materia oscura deja pasar a los gravitones, los bosones intermediarios de la fuerza de Gravedad, que llegan a nuestro propio espacio, a nuestras dimensiones, y, se deja sentir haciendo que las galaxias se alejen las unas de las otras a mayor velociodad de lo que lo harían si la única materia presente fuese la Bariónica.

En fin, amigos, es tanto lo que no sabemos que, mejor será la búsqueda de éste y de otros misterios que, como el de la masa de las partículas, aún se nos escapa y tenemos que construir maravillas como el LHC para tratar de que responda a nuestras preguntas.

Una máquina gigantesca que quiere viajar hasta las cuerdas vibrantes

Pero, una cosa es cierta, nuestra osadía que nos lleva a comentar sobre cosas que no llegamos a comprender y, como por ejemplo, los taquiones, son simplemente objetos creados en nuestra inagotable imaginación. Los taquiones, si lo recordais, son partículas hipotéticas que viajan a mayor velocidad que la de la luz y, según la teoría electromagnética, una partícula cargada que viaja a través de un medio con velocidad mayor que la de la luz en ese medio emite radiación Cerenkov y, un taquión cargado emitirá radiación Cerenkov incluso en el vacío.

Claro que, por el momento no se han detectado partículas con esas caracterísiticas y, si llegan a hacer acto de presencia, ¿qué hacemos con la relatividad especial de Einstein que nos dice que nada en nuestro Universo podrá ir a más velocidad que la luz?

¡Es un serio problema! Mejor que el dichoso Taquión no aparezca.

Por otra parte, nunca podremos dejar de sorprendernos cuando nos sumergimos en el “universo” de la mecánica cuántica y en el mundo subatómico de las partículas. El 18 abril 2012, investigadores del Instituto Kavli de TU Delft y de la Fundación FOM han logrado una primera detección de partículas Majorana. Etore Majorana fue un brillante físico italiano que llevó a cabo sus investigaciones en los años treinta del siglo pasado, ahondando en la teoría cuántica y como una partícula especial que podría existir, una partícula que sería en sí misma su propia antipartícula: el fermion de Majorana. Eso sitúa a partícula en la frontera entre materia y antimateria.

¿Será cierto aquello de que, todo lo que podamos imaginar se puede convertir en realidad… ¡con el paso del tiempo!

emilio silvera

Oct

11

¡La Física! Siempre nos sorprende

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Diagrama de un microscopio de fuerza atómica

Diagrama de un microscopio de fuerza atómica

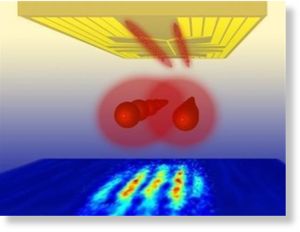

Las veloces computadoras cuánticas hechas con átomos atrapados por haces de luz pueden estar un poco más cerca, gracias a las primeras imágenes de átomos individuales obtenidas en una de estas grillas.

La velocidad de las computadoras cuánticas tiene que ver con el hecho de que sus componentes pueden ocupar una serie de estados en lugar de sólo dos como ocurre en una computadora binaria. Ciertos algoritmos especiales podrían explotar estos estados cuánticos para resolver problemas que derrotarían a una computadora convencional.

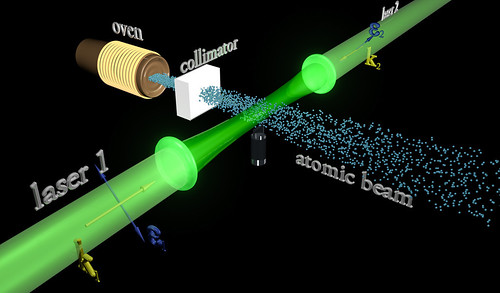

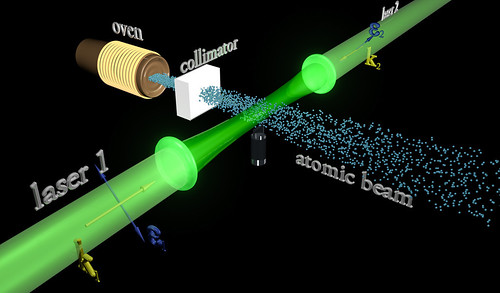

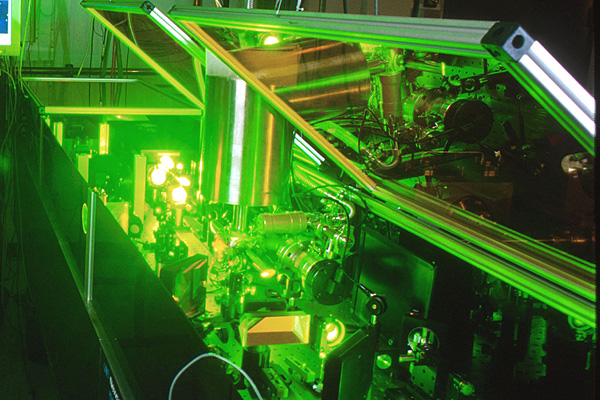

Una candidata a computadora de este tipo es la llamada “rejilla óptica”, en la que haces de rayos láser estratégicamente ubicados hacen que los átomos ultrafríos se coloquen en forma de grilla, como si fueran huevos en su envase de cartón. Pero antes de que uno pudiera leer o escribir sobre estos átomos, algo indispensable si la rejilla fuera a actuar como una computadora cuántica, haría falta determinar las posiciones exactas de los mismos.

Ahora dos equipos de investigadores, uno conducido por Stefan Kuhr del Instituto Max Planck de Óptica Cuántica de Garching, Alemania, y el otro por Markus Greiner de la Universidad de Harvard, han dado el primer paso al obtener imágenes de átomos individuales de rubidio en una rejilla óptica. Este es un reto no sólo porque los átomos son pequeños, sino también porque los fotones de los átomos cercanos pueden interferir unos con otros, enturbiando cualquier patrón.

Para superar esto, los equipos estudiaron el patrón de luz de un solo átomo. Luego crearon un algoritmo capaz de generar una combinación de este patrón a partir de diferentes disposiciones de una grilla de átomos. Cotejando estas simulaciones con el modelo real observado, el algoritmo podía determinar cuál era la distribución de los átomos.

Cada átomo en la grilla actúa como un bit cuántico. Kuhr dice que la rejilla óptica tiene muchos más de estos “qubits” que otros sistemas enfocados en la computación cuántica, por lo que puede ofrecer mayor velocidad.

Los láseres pueden volver reales las partículas virtuales. Los láseres de última generación tienen el poder de crear materia por medio de la captura de partículas fantasmales que, de acuerdo a la mecánica cuántica, permean el espacio aparentemente vacío

El principio de incertidumbre de la mecánica cuántica implica que el espacio nunca puede estar realmente vacío. En cambio, las fluctuaciones aleatorias causan el nacimiento de un caldero hirviente de partículas, como electrones y sus homólogos de antimateria, los positrones.

Las llamadas “partículas virtuales” normalmente se aniquilan entre sí demasiado rápido para que las veamos. Pero los físicos predijeron en los años 30 que un campo eléctrico muy fuerte transformaría las partículas virtuales en reales, y entonces las podríamos observar. El campo las impulsa en direcciones opuestas, porque tienen cargas eléctricas que se oponen, y las separándolos de modo que no puede destruirse mutuamente.

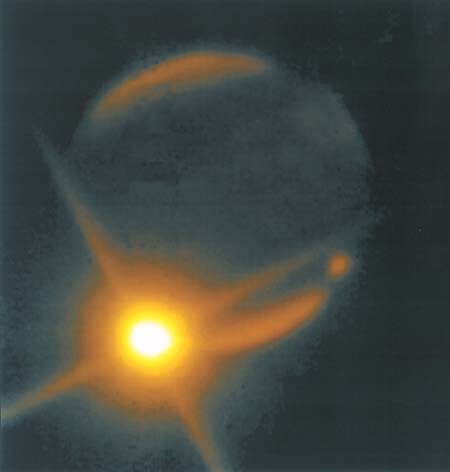

Los láseres son ideales para esta tarea, porque su luz posee campos eléctricos fuertes. En 1997, los físicos del Stanford Linear Accelerator Center (SLAC), en Menlo Park, California, utilizaron luz láser para crear unas pocas parejas de electrón-positrón. Ahora, nuevos cálculos indican que los láser de nueva generación serán capaces de crear pares por millones.

Reacción en cadena

En el experimento de SLAC, sólo se creó un par electrón-positrón a la vez. Pero con los láseres más potentes, es probable que se produzca una reacción en cadena.

El primer par es acelerado a gran velocidad por el láser, haciendo que emita luz. Esta luz, junto con la del láser, genera aún más pares, dice Alexander Fedotov de la Dirección Nacional de Investigaciones Nucleares de la Universidad de Moscú y sus colegas en un estudio que aparecerá en Physical Review Letters.

“Surgirá una gran cantidad de partículas del vacío”, dice John Kirk del Instituto Max Planck de Física Nuclear en Heidelberg, Alemania, que no participó en el estudio.

En los láseres que pueden concentrar cerca de 1026 vatios en un centímetro cuadrado, esta reacción desatada debería convertir de manera eficiente la luz del láser en millones de pares de electrones positrones, calcula el equipo.

Fábrica de antimateria

Ese nivel de intensidad lo podría alcanzar un láser que será construido por el proyecto Extreme Light Infrastructure en Europa. La primera versión del láser se podría construir en 2015, pero podría llevar un año más completar las actualizaciones necesarias para llegar a 1026 vatios por centímetro cuadrado, dice el coautor del estudio Georg Korn del Instituto Max Planck de Óptica Cuántica en Garching , Alemania.

La capacidad de generar una gran cantidad de positrones podría ser útil para los colisionadores de partículas, como el propuesto del Colisionador Lineal Internacional, que impactará electrones y positrones, dice Kirk McDonald de la Universidad de Princeton en Nueva Jersey.

Pero Pisin Chen, de la Universidad Nacional de Taiwan en Taipei, dice que el costo de los poderosos láseres puede hacer que este método sea más caro que el alternativo. En la actualidad, la manera estándar de crear una gran cantidad de positrones es disparar un haz de electrones de alta energía a una pieza de metal, para producir pares electrón-positrón. Vean la publicación siguiente:

La materia supera a la antimateria en un experimento que imita a la creación

El desequilibrio en el acelerador de partículas de Illinois podría presagiar grandes avances en Física

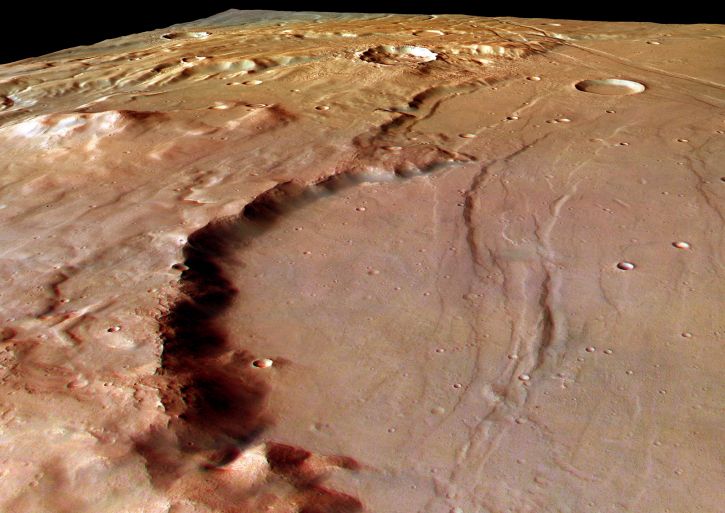

A menos de una billonésima de segundo después del Big Bang ocurrió otro evento tumultuoso. Aunque el Cosmos nació con partes iguales de materia y antimateria, que se destruyeron una a la otra al entrar en contacto, de alguna forma la materia comenzó a predominar. Los físicos han descubierto una nueva pista sobre la causa de este desequilibrio fortuito, que condujo a la existencia de galaxias, planetas y personas.

Circunferencia de 4 kilómetros de diámetro del Acelerador de Partículas del Laboratorio Fermi de Chicago

El nuevo hallazgo se basa en ocho años de estudio de la desintegración de partículas de vida corta, llamadas mesones B, que se produce durante las colisiones de alta energía en el acelerador de partículas Tevatrón del Laboratorio Fermi (Fermilab), ubicado en Batavia, Illinois. Los científicos del experimento DZero del Tevatrón han descubierto que los mesones B, cuando se desintegran, producen cerca del 1 % más de pares de muones (una versión pesada del electrón) que de pares de sus antipartículas, los antimuones. Los físicos se refieren a este fenómeno como una violación CP.

El desequilibrio, reportado el 14 de mayo en un seminario del Fermilab y publicado en Internet el 18 de mayo, podría servir para entender cómo fue que la materia superó a la antimateria en el Universo. También aumenta las posibilidades de que el Gran Colisionador de Hadrones, el acelerador de Suiza que sustituyó al Tevatrón como el colisionador de partículas más poderoso del mundo, encuentre nuevas partículas elementales o una nueva física. Hablamos del LHC que, de hecho, las ha encontrado.

El acelerador de partículas Tevatróndel Laboratorio Fermi (Fermilab),ubicado en Batavia, Illinois. Fue el primero en producir antimateria

“Aunque pequeño, este excedente del 1% es 50 veces más grande que la asimetría entre materia y antimateria prevista para la desintegración de mesones B por el modelo estándar de la Física de Partículas”, señala el portavoz del DZero, Stefan Söldner-Rembold, de la Universidad de Manchester en Inglaterra.

“Se nos puso la piel de gallina”, cuenta Söldner-Rembold acerca del momento en el que él y los 500 colaboradores del DZero comprendieron lo que habían descubierto. “Estábamos muy contentos porque significa que hay una nueva Física más allá del modelo estándar que tiene que estar a nuestro alcance para que la asimetría sea tan grande”.

“Aunque hay una probabilidad de menos del 0,1 % de que los resultados del DZero sean una casualidad, de acuerdo con las normas de la Física de Partículas hay que considerarlos como indicios aún por confirmar”, advierte el teórico Yuval Grossman de la Universidad de Cornell. Söldner-Rembold señala que los hallazgos del DZero son similares a una asimetría en la producción de materia-antimateria descubierta hace un año por otro experimento llevado a cabo en el Tevatrón, el CDF, pero los nuevos resultados tienen una precisión mayor.”

“Las teorías que podrían explicar las observaciones del DZero incluyen la supersimetría, que supone que cada partícula elemental en el modelo estándar de la Física de Partículas tiene una superpareja más pesada todavía por descubrir”, explica la teórica del Fermilab Marcela Carena, que no pertenece al equipo descubridor. “Otras teorías posibles incluyen un modelo en el que la gravedad y otras fuerzas operan en otras dimensiones ocultas, y la noción de que hay una cuarta familia de quarks más allá de las tres generaciones (arriba y abajo, encanto y extraño, y cima y fondo) que sirven como bloques de construcción de los núcleos atómicos y otras partículas.

“En los modelos que consideran una cuarta familia de quarks, la presencia de quarks nuevos y pesados y su interacción con las tres familias conocidas podrían dar lugar a un desequilibrio mayor entre materia y antimateria que el que se encuentra en el modelo estándar”, señala Carena. Y agrega: “En la teoría de la supersimetría, las superparejas pesadas jugarían un rol similar al de los quarks pesados, creando interacciones que podrían favorecer la producción de materia sobre la antimateria”.

No siempre la física lo puede explicar todo. Sin embargo… ¡Lo va consiguiendo!

En la teoría de las dimensiones extra, nuevas partículas mensajeras (portadoras de fuerzas previamente desconocidas) se moverían en dimensiones ocultas. Estas partículas transportadoras podrían alterar la carga y otra propiedad, llamada “sabor”, de las partículas elementales, causando el desequilibrio adicional entre materia y antimateria.

Carena añade: “Sin embargo, es difícil encontrar una teoría que pueda explicar esta asimetría sin contradecir otros resultados experimentales”.

La materia superó a la antimateria en el comienzo

Ulrich Nierste, de la Universidad de Karlsruhe en Alemania, advierte: “La conexión del resultado del DZero con el excedente de materia que existe en el Universo es vaga. Si bien el hallazgo insinúa una nueva fuente de asimetría en las propiedades del mesón B y de su antipartícula, el proceso que creó más partículas que antipartículas en el Universo primitivo podría involucrar un mecanismo físico muy diferente”.

“Sin embargo”, dice Carena, “hace falta alguna nueva fuente de asimetría para explicar el desequilibrio que hay entre la materia y la antimateria en el Universo, y, por lo tanto, nuestra existencia”. En cualquiera de los modelos propuestos “el Gran Colisionador de Hadrones debería ser la ventana directa para observar nuevas partículas”.

Uno de los experimentos más pequeños del Colisionador, diseñado para estudiar los mesones B, podría confirmar los hallazgos del DZero dentro de uno o dos años”, dice Yuval Grossman. Y agrega: “Los experimentos más grandes podrían entonces buscar nuevas partículas que serían el origen del desequilibrio cósmico entre materia y antimateria y determinar sus masas”.

El experimento Beauty (Belleza) es la matriz de investigación para la creación de antimateria. El choque de dos protones contra otro a la velocidad de la luz, ha tenido como resultado una partícula con 5 veces más masa que sus protones originales. A esa exótica partícula se le ha llamado B+ y está compuesta por un quark b-anti y un quark u. La partícula B+ se desintegra a una altísima velocidad pero le da tiempo a recorrer ¡¡2 mm!! antes de desintegrarse en dos partículas, el mesón J / ? y el Kaon K+. Esta distancia, comparada con los minúsculos tamaños que estamos tratando, es una auténtica pasada. Hemos tenido antimateria pura moviéndose a lo largo de dos extensos milímetros de “nuestro” espacio. Impresionante.

Lo revolucionario sin embargo es que de esta forma, los investigadores habrían demostrado la teoría de Albert Einstein. “Sí, podemos crear masa a partir de energía usando la famosa fórmula de Einstein, E=mc2, dicen los responsables del CERN. Aunque también hay que destacar que la confirmación de que existe la antimateria plantea muchas preguntas de difícil resolución puesto que esa sustancia no existe en nuestro universo. “Ya que la desaparición de antimateria primordial no puede ser explicada por el modelo tradicional, tendremos que comenzar a pensar en algo nuevo”, afirman los investigadores. “Los científicos están evaluando diferentes posibilidades pero, dado que sólo podemos observar un 4% de la energía y materia total del universo, podemos inferir que la respuesta al misterio de la antimateria se encuentra en la parte desconocida del mismo”, concluyen.

Como podéis ver, las preguntas son muchas y, las respuestas, son más escasas. Sin embargo, no dejamos de insistir y buscar con todos medios a nuestro alcance para saber sobre la Naturaleza no ya de la materia y la antimateria, sino sobre los muchos enigmas que tenemos planteados y a los que no sabemos dar una adecuada explicación. Parece que a lo lejos vemos una luz cegadora que nos inyecta la esperanza necesaria para seguir la búsqueda y tratar de llegar al corazón de todos esos secretos que el Universo esconde.

Hay cosas que… más que sorprendentes son… ¡Inclreibles! He leído por ahí que…

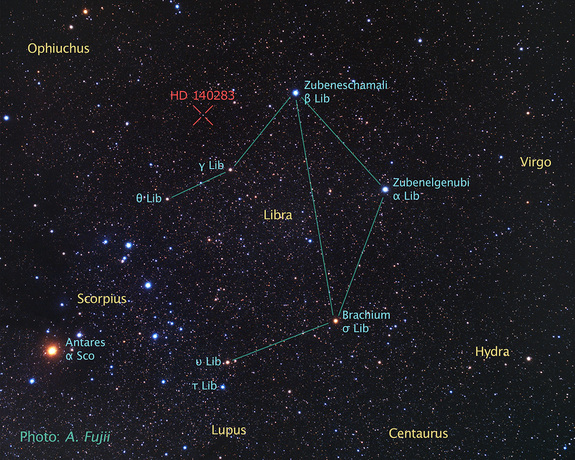

“Un grupo de astrónomos, usando datos del telescopio espacial Hubble, ha determinado la edad de la que es la estrella más vieja cuya edad puede medirse con precisión. El resultado ha sido que la edad de la estrella es de 14.500 ± 800 millones de años, mayor que la estimación de la edad del universo, unos 13.800 millones de años. La estrella en cuestión (HD 140283), también llamada “estrella Matusalén,” una gigante roja que se encuentra a una distancia de 190,1 años luz en la constelación de Libra (distancia medida con precisión mediante la técnica de paralaje). En el año 2000 se dató su edad en 16.000 millones de años. Sin embargo, existen algunas cuestiones que podrían aclarar la extrema edad de esta estrella. Nuevos modelos sobre la difusión de helio en el núcleo indican que la penetración del mismo podría ser mayor de la que se piensa, lo que provocaría un menor ritmo de combustión. También la relación oxígeno-hierro en esta estrella es anómala, demasiado grande, por lo que se cree que futuras observaciones que puedan determinar con mayor grado de precisión la abundancia de oxígeno podrían reducir nuevamente la estimación de la edad de la estrella.”

Totales: 71.812.694

Totales: 71.812.694 Conectados: 49

Conectados: 49