Ago

10

¡La Física! Esa gran disciplina

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica, Física Relativista ~

Clasificado en Física Cuántica, Física Relativista ~

Comments (0)

Comments (0)

Los extremos de las eslacalas del Universo

El mundo de la Física tiene planteado un gran problema y los físicos son muy conscientes de ello, conocen su existencia desde hace décadas. El problema es el siguiente:

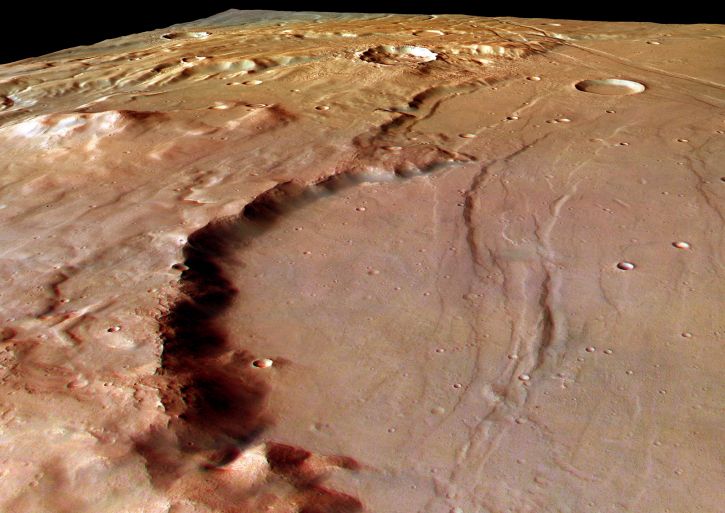

Existen dos pilares fundamentales en los cuales se apoya toda la física moderna. Uno es la relatividad general de Albert Einstein, que nos proporciona el marco teórico para la comprensión del universo a una escala máxima: estrellas, galaxias, cúmulos (o clusters) de galaxias, y aún más allá, hasta la inmensa expansión del propio universo.

El otro pilar es la mecánica cuántica, que en un primer momento vislumbro Max Planck y posteriormente fue desarrollada por W. Heisemberg, Schrödinger, el mismo Einstein, Dirac, Niels Bohr y otros, que nos ofrece un marco teórico para comprender el universo en su escala mínima: moléculas, átomos, y así hasta las partículas subatómicas, como los electrones y quarks.

Durante años de investigación, los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la practica totalidad de las predicciones que hacen las dos teorías. Sin embargo, estos mismos instrumentos teóricos nos llevan a una conclusión inquietante: tal como se formulan actualmente, la relatividad general y la mecánica cuántica no pueden ser ambas ciertas a la vez.

Nos encontramos con que las dos teorías en las que se basan los enormes avances realizados por la física durante el último siglo (avances que han explicado la expansión de los cielos y la estructura fundamental de la materia) son mutuamente incompatibles. Cuando se juntan ambas teorías, aunque la formulación propuesta parezca lógica, aquello explota; la respuesta es un sinsentido que nos arroja un sin fin de infinitos a la cara.

Así que si tú, lector, no has oído nunca previamente hablar de este feroz antagonismo, te puedes preguntar a que será debido. No es tan difícil encontrar la respuesta. Salvo en algunos casos muy especiales, los físicos estudian cosas que son o bien pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y pesadas (como estrellas de neutrones y agujeros negros), pero no ambas al mismo tiempo. Esto significa que sólo necesitan utilizar la mecánica cuántica, o la relatividad general, y pueden minimizar el problema que se crea cuando las acercan demasiado; las dos teorías no pueden estar juntas. Durante más de medio siglo, este planteamiento no ha sido tan feliz como la ignorancia, pero ha estado muy cerca de serlo.

No obstante, el universo puede ser un caso extremo. En las profundidades centrales de un agujero negro se aplasta una descomunal masa hasta reducirse a un tamaño minúsculo. En el momento del Bing Bang, la totalidad del universo salió de la explosión de una bolita microscópica cuyo tamaño hace que un grano de arena parezca gigantesco. Estos contextos son diminutos y, sin embargo, tienen una masa increíblemente grande, por lo que necesitan basarse tanto en la mecánica cuántica como en la relatividad general.

Por ciertas razones, las fórmulas de la relatividad general y las de la mecánica cuántica, cuando se combinan, empiezan a agitarse, a traquetear y a tener escapes de vapor como el motor de un viejo automóvil. O dicho de manera menos figurativa, hay en la física preguntas muy bien planteadas que ocasionan esas respuestas sin sentido, a que me referí antes, a partir de la desafortunada amalgama de las ecuaciones de las dos teorías.

Aunque se desee mantener el profundo interior de un agujero negro y el surgimiento inicial del universo envueltos en el misterio, no se puede evitar sentir que la hostilidad entre la mecánica cuántica y la relatividad general está clamando por un nivel más profundo de comprensión.

¿Puede ser creíble que para conocer el universo en su conjunto tengamos que dividirlo en dos y conocer cada parte por separado? Las cosas grandes una ley, las cosas pequeñas otra.

El tic tac de nuestras mentes debe continuar para llegar a comprender

No creo que eso pueda ser así. Mi opinión es que aún no hemos encontrado la llave que abre la puerta de una teoría cuántica de la gravedad, es decir, una teoría que unifique de una vez por todas las dos teorías más importantes de la física: mecánica cuántica + relatividad general.

La teoría de supercuerdas ha venido a darme la razón. Los intensos trabajos de investigación llevada a cabo durante los últimos 20 años demuestran que puede ser posible la unificación de las dos teorías cuántica y relativista a través de nuevas y profundas matemáticas topológicas que han tomado la dirección de nuevos planteamientos más avanzados y modernos, que pueden explicar la materia en su nivel básico para resolver la tensión existente entre las dos teorías.

En esta nueva teoría de supercuerdas se trabaja en 10, 11 ó en 26 dimensiones, se amplía el espacio ahora muy reducido y se consigue con ello, no sólo el hecho de que la mecánica cuántica y la relatividad general no se rechacen, sino que por el contrario, se necesitan la una a la otra para que esta nueva teoría tenga sentido. Según la teoría de supercuerdas, el matrimonio de las leyes de lo muy grande y las leyes de lo muy pequeño no sólo es feliz, sino inevitable.

Esto es sólo una parte de las buenas noticias, porque además, la teoría de las supercuerdas (abreviando teoría de cuerdas) hace que esta unión avance dando un paso de gigante. Durante 30 años, Einstein se dedicó por entero a buscar esta teoría de unificación de las dos teorías, no lo consiguió y murió en el empeño; la explicación de su fracaso reside en que en aquel tiempo, las matemáticas de la teoría de supercuerdas eran aún desconocidas. Sin embargo, hay una curiosa coincidencia en todo esto, me explico:

Cuando los físicos trabajan con las matemáticas de la nueva teoría de supercuerdas, Einstein, sin que nadie le llame, allí aparece y se hace presente por medio de las ecuaciones de campo de la relatividad general que, como por arte de magia, surgen de la nada y se hacen presentes en la nueva teoría que todo lo unifica y también todo lo explica; posee el poder demostrar que todos los sorprendentes sucesos que se producen en nuestro universo (desde la frenética danza de una partícula subatómica que se llama quark hasta el majestuoso baile de las galaxias o de las estrellas binarias bailando un valls, la bola de fuego del Big Bang y los agujeros negros) todo está comprendido dentro de un gran principio físico en una ecuación magistral.

Esta nueva teoría requiere conceptos nuevos y matemáticas muy avanzados y nos exige cambiar nuestra manera actual de entender el espacio, el tiempo y la materia. Llevará cierto tiempo adaptarse a ella hasta instalarnos en un nivel en el que resulte cómodo su manejo y su entendimiento. No obstante, vista en su propio contexto, la teoría de cuerdas emerge como un producto impresionante pero natural, a partir de los descubrimientos revolucionarios que se han realizado en la física del último siglo. De hecho, gracias a esta nueva y magnifica teoría, veremos que el conflicto a que antes me refería existente entre la mecánica cuántica y la relatividad general no es realmente el primero, sino el tercero de una serie de conflictos decisivos con los que se tuvieron que enfrentar los científicos durante el siglo pasado, y que fueron resueltos como consecuencia de una revisión radical de nuestra manera de entender el universo.

El primero de estos conceptos conflictivos, que ya se había detectado nada menos que a finales del siglo XIX, está referido a las desconcertantes propiedades del movimiento de la luz.

Isaac Newton y sus leyes del movimiento nos decía que si alguien pudiera correr a una velocidad suficientemente rápida podría emparejarse con un rayo de luz que se esté emitiendo, y las leyes del electromagnetismo de Maxwell decían que esto era totalmente imposible. Einstein, en 1.905, vino a solucionar el problema con su teoría de la relatividad especial y a partir de ahí le dio un vuelco completo a nuestro modo de entender el espacio y el tiempo que, según esta teoría, no se pueden considerar separadamente y como conceptos fijos e inamovibles para todos, sino que por el contrario, el espacio-tiempo era una estructura maleable cuya forma y modo de presentarse dependían del estado de movimiento del observador que lo esté midiendo.

El escenario creado por el desarrollo de la relatividad especial construyó inmediatamente el escenario para el segundo conflicto. Una de las conclusiones de Einstein es que ningún objeto (de hecho, ninguna influencia o perturbación de ninguna clase) puede viajar a una velocidad superior a la de la luz. Einstein amplió su teoría en 1915 – relatividad general – y perfeccionó la teoría de la gravitación de Newton, ofreciendo un nuevo concepto de la gravedad que estaba producida por la presencia de grandes masas, tales como planetas o estrellas, que curvaban el espacio y distorsionaban el tiempo.

Tales distorsiones en la estructura del espacio y el tiempo transmiten la fuerza de la gravedad de un lugar a otro. La luna no se escapa y se mantiene ahí, a 400.000 Km de distancia de la Tierra, porque está influenciada por la fuerza de gravedad que ambos objetos crean y los mantiene unidos por esa cuerda invisible que tira de la una hacia la otra y viceversa. Igualmente ocurre con el Sol y la Tierra que, separados por 150 millones de kilómetros, están influidos por esa fuerza gravitatoria que hace girar a la Tierra (y a los demás planetas del Sistema Solar) alrededor del Sol.

El espacio-tiempo es una estructura suave, al menos así lo sugiere un nuevo estudio, anotando una posible nueva victoria para Einstein sobre los teóricos que opinaban de otra manera y trataban de rebatir su teoría del espacio-tiempo relativista con argumentos que, nunca fueron demostrados.

Así las cosas, no podemos ya pensar que el espacio y el tiempo sean un telón de fondo inerte en el que se desarrollan los sucesos del universo, al contrario; según la relatividad especial y la relatividad general, son actores que desempeñan un papel íntimamente ligado al desarrollo de los sucesos.

El descubrimiento de la relatividad general, aunque resuelve un conflicto, nos lleva a otro. Durante tres décadas desde 1.900, en que Max Planck publicó su trabajo sobre la absorción o emisión de energía de manera discontinua y mediante paquetes discretos a los que él llamo cuantos, los físicos desarrollaron la mecánica cuántica en respuesta a varios problemas evidentes que se pusieron de manifiesto cuando los conceptos de la física del siglo XIX se aplicaron al mundo microscópico. Así que el tercer conflicto estaba servido, la incompatibilidad manifiesta entre relatividad general y mecánica cuántica.

La forma geométrica ligeramente curvada del espacio que aparece a partir de la relatividad general, es incompatible con el comportamiento microscópico irritante y frenético del universo que se deduce de la mecánica cuántica, lo cual era sin duda alguna el problema central de la física moderna.

Las dos grandes teorías de la física, la relatividad general y la mecánica cuántica, infalibles y perfectas por separado, no funcionaban cuando tratábamos de unirlas resulta algo incomprensible, y, de todo ello podemos deducir que, el problema radica en que debemos saber como desarrolar nuevas teorías que modernicen a las ya existentes que, siendo buenas herramientas, también nos resultan incompletas para lo que, en realidad, necesitamos.

emilio silvera

Ago

7

El “universo” de las partículas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Solo el 1% de las formas de vida que han vivido en la Tierra están ahora presentes, el 99%, por una u otra razón se han extinguido. Sin embargo, ese pequeño tanto por ciento de la vida actual, supone unos cinco millones de especies según algunas estimaciones. La Tierra acoge a todas esas especies u palpita de vida que prolifera por doquier. Hay seres vivos por todas partes y por todos los rincones del inmenso mosaico de ambientes que constituye nuestro planeta encontramos formas de vida, cuyos diseños parecen hechos a propósito para adaptarse a su hábitat, desde las profundidades abisales de los océanos hasta las más altas cumbres, desde las espesas selvas tropicales a las planicies de hielo de los casquetes polares. Se ha estimado la edad de 3.800 millones de años desde que aparecieron los primeros “seres vivos” sobre el planeta (dato de los primeros microfósiles). Desde entonces no han dejado de aparecer más y más especies, de las que la mayoría se han ido extinguiendo. Desde el siglo XVIII en que Carlos Linneo propuso su Systema Naturae no han cesado los intentos por conocer la Biodiversidad…, de la que por cierto nuestra especie, bautizada como Homo sapiens por el propio Linneo, es una recién llegada de apenas 200.000 años.

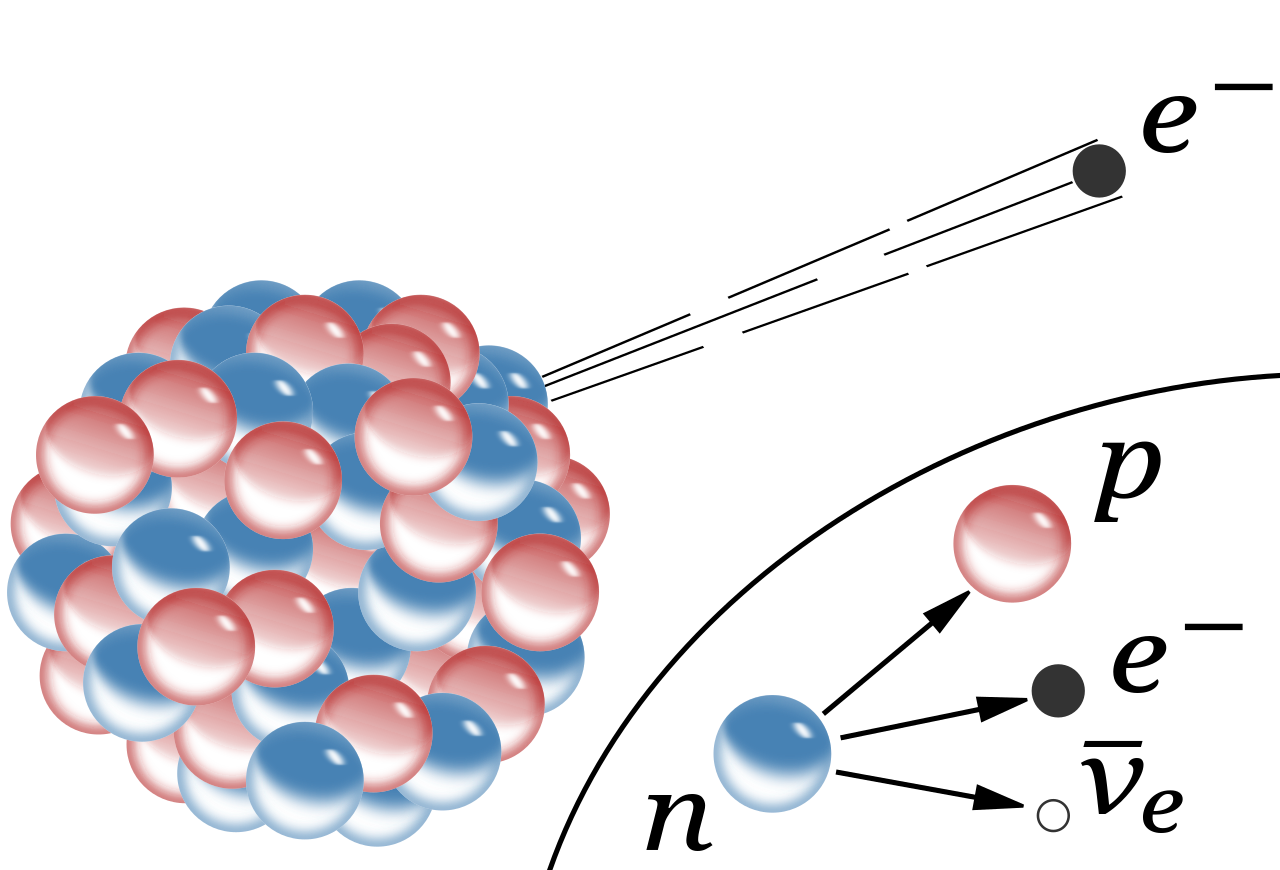

Ahora, hablaremos de la vida media de las partículas elementales (algunas no tanto). Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida media, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

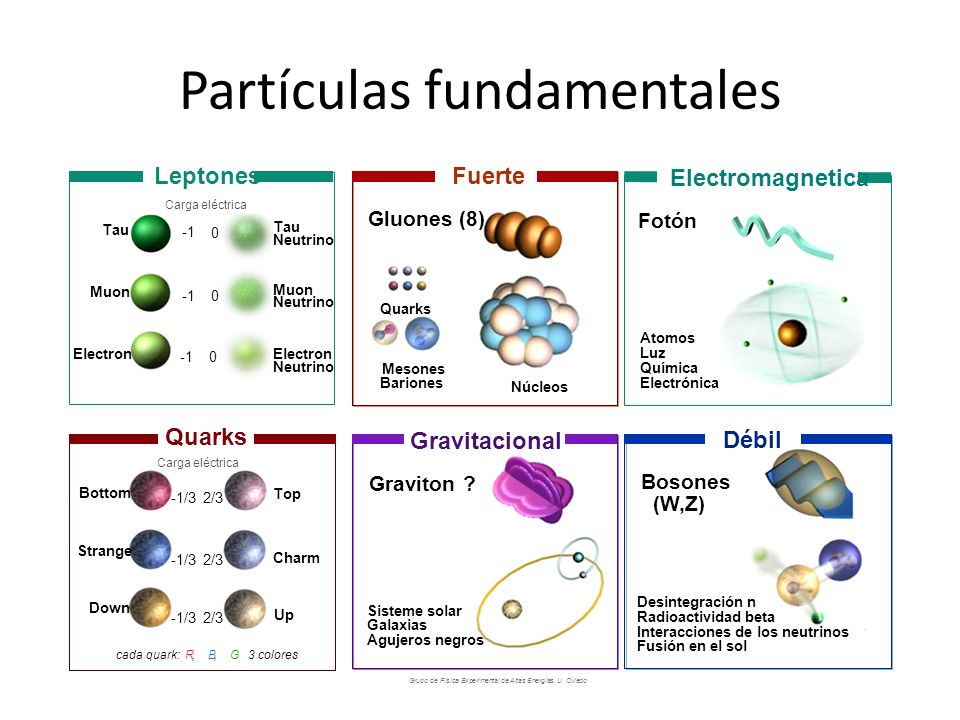

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, psi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales maneras de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

Una colisión entre un prtón y un antiprotón registrada mediante una cámara de chispas del experimento UA5 del CERN.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Se habla de ondas cuánticas y también, de ondas gravitacionales. Las primeras han sido localizadas y las segundas están siendo perseguidas.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Bariones Delta. Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (aunque nos parezca lo contrario), son aún bastante limitados, nos queda mucho por descubrir antes de que podamos decir que dominamos la materia y sabemos de todos sus componentes. Antes de que eso llegue, tendremos que conocer, en profundidad, el verdadero origen de la Luz que esconde muchos secretos que tendremos que desvelar.

Esperemos que con los futuros experimentos del LHC y de los grandes Aceleradores de partículas del futuro, se nos aclaren algo las cosas y podamos avanzar en el perfeccionamiento del Modelo Estándar de la Física de Partículas que, como todos sabemos es un Modelo incompleto que no contiene a todas las fuerzas de la Naturaleza y, cerca de una veintena de sus parámetros son aleatorios y no han sido explicados. Uno de ellos, el Bosón de Higgs, dicen que ha sido encontrado. Sin embargo, a mí particularmente me quedan muchas dudas al respecto.

emilio silvera

Jul

31

Recomendación

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

« Colaboraciones »

La cuántica y sus razones

La cuántica y sus razones

Fandila Soria Martínez

Si os gusta la Fisica, os recomiendo la lectura de esta colaboración del Contertulio y amigo Fandila. Es de lectura amena y sencilla y nos transporta a lugares mágicos, donde podemos contemplar maravillas de la Naturaleza relacionadas con esos pequeños objetos que llamamos partículas elementales (algunas más elementales que otras), él nos explica con gran maestría lo que en ese infinitesimal “universo” ocurre y, desde luego, te aseguro que, cuando finalices la lectura, serás un poquito más sabio... ¡A mí me ha pasado! y, podrás entrar en ese mágico universo de la física cuántica.

Pincha encima de “La cuántica y sus razones”, arriba, encima del nombre del autor, y, te verás transportado a ese lugar.

Jul

24

¿La Física? ¡Una maravilla! Nos dice cómo funciona la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

Ylia Prigogine haciendo lo que sólo unos privilegiados pueden hacer: desvelando los principios del mundo. Enn la pizarra, la entropía. La irreversibilidad del tiempo trae el orden al caos, decía. De alguna manera pretendía explicar que nada permanece y todo cambia bajo los efectos del inexorable paso del Tiempo.

“En el mundo de los seres vivos, la escala o tamaño crea importantes diferencias. En muchos aspectos, la anatomía de un ratón es una copia de la de un elefante, pero mientras que un ratón trepar por una pared prácticamente vertical sin mucha dificultad (y se puede caer desde una altura varias veces mayor que su propio tamaño sin hacerse daño), un elefante no sería capaz de realizar tal hazaña. Con bastante generalidad se puede afirmar que los efectos de la gravedad son menos importantes cuanto menores sean los objetos que consideremos (sean vivos o inanimados).

Cuando llegamos a los seres unicelulares, se ve que ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de la gravedad a esa escala. Tranquilamente se pueden mover y desplazar por encima de una superficie acuática. Los pluricelulares no pueden hacer tal cosa.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos de Van der Waals. fuerza tiene un alcance muy corto; para ser precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente 1/r7. Esto significa que si se reduce la distancia dos átomos a la mitad de la fuerza de Van der Waals con la que se atraen uno a otro se hace 2 × 2 × 2 × 2 × 2 × 2 × 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza. El conocimiento de esta fuerza se debe a Johannes Diderik Van der Waals (1837 – 1923) con su tesis sobre la continuidad del líquido y gaseoso que le haría famoso, ya que en esa época (1873), la existencia de las moléculas y los átomos no estaba completamente aceptado.

La tensión superficial del agua, es el efecto físico (energía de atracción entre las moléculas) que “endurece” la capa superficial del agua en reposo y permite a algunos insectos, como el mosquito y otros desplazarse por la superficie del agua sin hundirse.

El famoso físico inglés James Clerk Maxwell, que formuló la teoría del electromagnetismo de Faraday, quedó muy impresionado por este de Van der Waals.

Los tamaños de los seres uniceculares, animales y vegetales, se miden en micrómetros o “micras”, donde 1 micra es 1/1.000 de milímetro, aproximadamente el tamaño de los detalles más pequeños que se pueden observar con un microscopio ordinario. El mundo de los microbios es fascinante, pero no es el objeto de este trabajo, y continuaremos el viaje emprendido las partículas elementales que forman núcleos, átomos, células y materia, así como las fuerzas que intervienen en las interacciones fundamentales del universo y que afecta a todo lo que existe.

Hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Radiación de Cuerpo Negro

Un cuerpo negro es un objeto teórico o ideal que absorbe toda la luz y toda la energía radiante que incide sobre él. Nada de la radiación incidente se refleja o pasa a través del cuerpo negro. A pesar de su , el cuerpo negro emite luz y constituye un modelo ideal físico para el estudio de la emisión de radiación electromagnética. El nombre Cuerpo negro fue introducido por Gustav Kirchhoff en 1862.

La luz emitida por un cuerpo negro se denomina radiación de cuerpo negro. Todo cuerpo emite energía en de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada es la temperatura del emisor. La energía radiante emitida por un cuerpo a temperatura ambiente es escasa y corresponde a longitudes de onda superiores a las de la luz visible (es decir, de menor frecuencia). Al elevar la temperatura no sólo aumenta la energía emitida sino que lo hace a longitudes de onda más cortas; a esto se debe el cambio de color de un cuerpo cuando se calienta. Los cuerpos no emiten con igual intensidad a todas las frecuencias o longitudes de onda, sino que siguen la ley de Planck.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, esto lo veremos más adelante.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Si la mecánica cuántica tiene cosas extrañas y el espín es una de ellas. Y si uno piensa que la intuición le ayudará a comprender todo esto, pues no lo hará, o es poco probable que lo haga. Las partículas tienen un espín fundamental. Al igual que la carga eléctrica o la masa, el espín ayuda a definir que de partícula es cada una.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

La posición y el momento de una partícula nunca lo podremos saber con precisión ilimitada.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La mecánica cuántica es muy extraña a nuestro “sentido común”, sabemos que se desenvuelve en ese “universo” de lo muy pequeño, alejado de nuestra vida cotidiana en el macrocosmos tetradimensional que, no siempre coincide con lo que, en aquel otro ininitesimal acontece.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, existe otro universo dentro de nuestro del que, aún, nos queda mucho por aprender.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.”

También Gerard ‘t Hooft es el autor de lo que han dado en llamar l principio holográfico es una conjetura especulativa acerca de las teorías de la Gravedad Cuántica propuesta en 1993 por este autor, y mejorada y promovida por Leonard Susskin en 1995. Postula que toda la información contenida en cierto volumen de un espacio concreto se puede conocer a partir de la información codificable sobre la frontera de dicha región. Una importante consecuencia es que la cantidad máxima de información que puede contener una determinada región de espacio rodeada por una superficie diferenciable está limitada por el área total de dicha superficie.

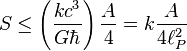

Por ejemplo, se pueden modelar todos los eventos que ocurran en un cuarto o una habitación creando una teoría en la que sólo tome en cuenta lo que suceda en sus paredes. En el principio holográfico también se afirma que por cada cuatro Unidades de Planck existe al menos un grado de libertad (o una unidad constante de Bolttzmann k de máxima entropía). Esto se conoce como frontera de Bekenstein:

donde S es la entropía y A es la unidad de mensura considerada. En unidades convencionales la fórmula anterior se escribe:

donde:

, es la constante de Boltzmann.

, es la constante de Boltzmann.

, es la vecolcidad de la luz.

, es la vecolcidad de la luz.

, es la constante gravitacional universal.

, es la constante gravitacional universal.

, es la constante de Planck racionalizada.

, es la constante de Planck racionalizada. , es la longitud de Planck.

, es la longitud de Planck.

Claro que esta… ¡Es otra Historia!

emilio silvera

Jul

15

El LHC descubre el pentaquark

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

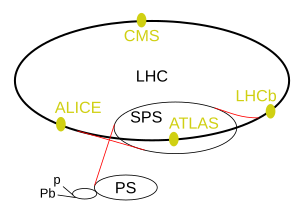

“El LHCb (que procede de las siglas “Large Hadron Collider beauty experiment”, donde “beauty” se refiere al quark bottom) es uno de los seis detectores de partículas, actualmente en construcción, instalados en el LHC (Large Hadron Collider) del CERN. LHCb es un experimento especializado en física del quark b, algunos de cuyos objetivos son la medida de parámetros de violación de simetría CP en las desintegraciones de hadrones que contengan dicho quark o la medida de precisión de las fracciones de desintegración (“branching ratios”) de algunos procesos extremadamente infrecuentes.”

La noticia del descubrimiento del Pentaquark, nos la cuentan así:

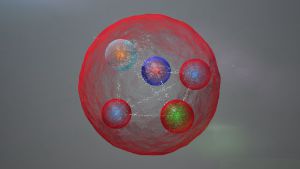

Científicos en el mayor acelerador de partículas del mundo anuncian el hallazgo de una exótica partícula compuesta de cinco quarks cuya existencia fue predicha hace medio siglo

Los científicos del mayor acelerador de partículas del mundo, el LHC de Ginebra, han descubierto una nueva partícula: el pentaquark.

El hallazgo, anunciado hoy por el laboratorio europeo de física de partículas CERN, lo ha hecho el equipo del experimento LHCb y confirma la existencia de una nueva forma de organizar la materia a nivel subatómico. El pentaquark recibe su nombre porque está compuesto de cinco partículas fundamentales.

Toda la materia que conocemos se organiza a nivel subatómico de diferentes maneras. Los protones y los neutrones, por ejemplo, están formados por tres quarks. Otro tipo de ensamblaje lo componen los mesones, formados por pares de quarks hechos de materia y antimateria. Más allá de estas dos categorías, se sabía que la materia podía componer otras variantes más exóticas que, sin embargo, nunca habían sido observadas.

El experimento LHCb ha permitido ahora encontrar una nueva variante formada de cuatro quarks de materia convencional y un antiquark, hecho de antimateria.

“Vimos un pico en las gráficas muy parecido al que se veía cuando el bosón de Higgs fue descubierto”, explica a Materia Guy Wilkinson, portavoz del experimento, uno de los cuatro grandes del CERN.

Curiosamente los datos aparecieron en la primera ronda de experimentos en el CERN, que terminó hace dos años. No fue hasta hace tres o cuatro meses que los científicos se toparon con esos datos. Hasta hace muy poco se estuvo comprobando que lo que veían no podía deberse a otra cosa sino a la existencia de una nueva partícula, explica Wilkinson. Ahora, el nivel de confianza está alrededor de nueve sigma, muy por encima de los cinco que se necesitan en física para reclamar un descubrimiento, resalta. Los detalles del hallazgo, anunciado hoy, están disponibles en arxiv.org y se han enviado a la revista Physical Review Letters.

Dentro del estándar

Vimos un pico en las gráficas muy parecido al que se veía cuando el bosón de Higgs fue descubierto

El primero en proponer la existencia de mesones y bariones hacia más de medio siglo fue Murray Gell-Mann en 1964, lo que le valió el Nobel de Física en 1969. Su modelo también predecía la existencia de partículas compuestas más exóticas como la recién descubierta. Esta nueva partícula “nos puede permitir entender de qué está compuesta la materia ordinaria, los protones y neutrones de los que estamos hechos”, dice Wilkinson.Probablemente, añade, no haya solo un tipo de pentaquark sino varios, y ahora toca buscarlos durante la presente ronda de experimentos en el LHC.

El objetivo más preciado del LHC, que ha empezado a funcionar al doble de potencia, es encontrar física más allá del llamado modelo estándar, que describe las leyes físicas que gobiernan la materia conocida. El nuevo hallazgo no llega a tanto, aunque es de gran importancia. “El modelo de quarks, propuesto hace más de 50 años no excluye la posibilidad de que existan partículas formadas por más de tres quarks, pero estos llamados hadrones exóticos solo empezaron a dar muestras de su existencia hace pocos años”, ha explicado Juan Saborido, responsable del grupo de la Universidad de Santiago de Compostela participante en LHCb, en una nota de prensa del CPAN. Para el investigador español, el descubrimiento de estas nuevas partículas formadas por cinco quarks, “no implica física más allá del Modelo Estándar, pero es un hallazgo muy importante para el entendimiento de la estructura de los hadrones”.

El pentaquark ha sido descubierto observando los productos de colisiones entre bariones y estudiando las partículas resultantes. Así han desvelado la existencia de dos estados intermedios de la materia cantidad de datos acumulada por el LHV indican la existencia de la nueva partícula.

“Hemos aprovechado la gran cantidad de datos acumulada por el LHC y la excelente precisión de nuestro detector para comprobar a qué se deben esas señales”, ha explicado Tomasz Skwarnicki , científico del LHCb, en una nota de prensa del CERN. “Nuestra conclusión es que solo pueden explicarse por la existencia de pentaquarks”, añade.

Ahora el gran misterio es cómo se sostienen los pentaquarks. Una posibilidad es que sus cinco componentes estén bien unidos. La otra es que sean el producto de la unión entre una barión y un mesón.

Fuente: El País

Totales: 71.815.805

Totales: 71.815.805 Conectados: 35

Conectados: 35