Abr

1

Sí, a pesar de todo, algunas cosas no cambian

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (33)

Comments (33)

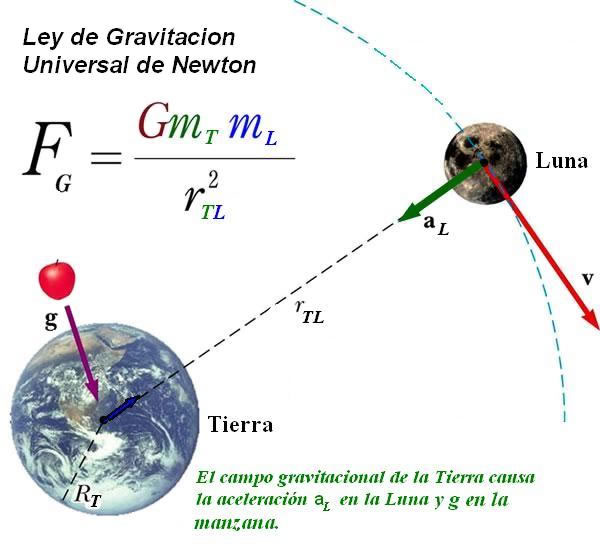

Esos números que representan a las Constantes de la Naturaleza que apareen considerando elementos y codifican secretos profundamente escondidos de la Naturaleza, y, entre esos parámetros naturales, se encuentran la Constante de la Gravitación universal (G), la de la velocidad de la luz en el vacío (c), la Constante de Planck (h), y, también, la Constante de Estructura Fina (α), entre otras.

La Física de los Primeros Principios a la que aludía Aristóteles (La Metafísica)

La Física de Aristóteles: Naturaleza, principios y causas.

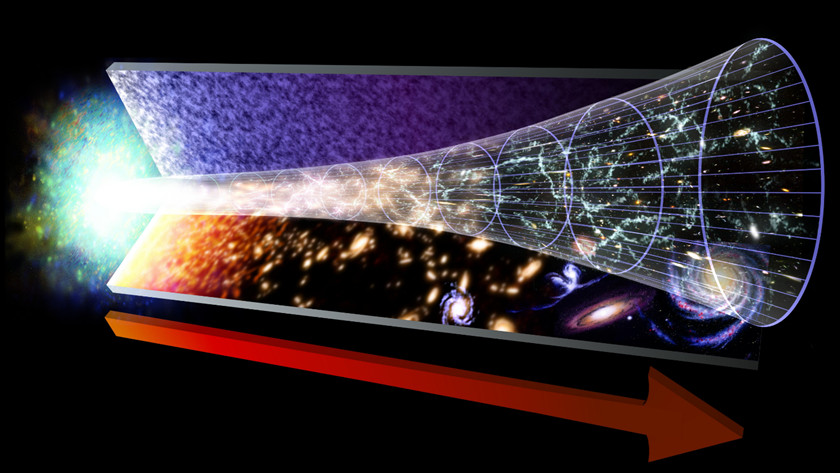

Lo que sucede primero, no es necesariamente el principio. Antes de ese “Principio”, suceden algunas cosas que nosotros no hemos podido o sabido percibir. Sin embargo, hay cosas que no cambian nunca.

¿Qué decir de las fluctuaciones cuántics?

Hace tiempo, los sucesos que constituían historias eran las irregularidades de la experiencia. Sabemos que lo que no cambia son las Constantes de la Naturaleza pero, tampoco cambia el Amor de una madre por un hijo, la salida y la puesta del Sol, nuestra curiosidad, y otras muchas cosas que conviven con nosotros en lo cotidiano.

Poco a poco, los científicos llegaron a apreciar el misterio de la regularidad y lo predecible del mundo. Pese a la concatenación de movimientos caóticos e impredecibles de átomos y moléculas, nuestra experiencia cotidiana es la de un mundo que posee una profunda consistencia y continuidad. Nuestra búsqueda de la fuente de dicha consistencia atendía primero a las leyes de la Naturaleza que son las que gobiernan como cambian las cosas. Sin embargo, y al mismo tiempo, hemos llegado a identificar una colección de números misteriosos arraigados en la regularidad de la apariencia. Son las Constantes de la Naturaleza que, como la carga y la masa del electrón o la velocidad de la luz, le dan al Universo un carácter distintivo y lo singulariza de otros que podríamos imaginar. Todo esto, unifica de una vez nuestro máximo conocimiento y también, nuestra infinita ignorancia.

Mar

26

¿Pueden llegarnos mensajes del futuro?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Investigadores proponen una solución a algunos problemas de la Física Cuántica, y se refieren a los viajes en el tiempo o la paradoja del abuelo.

Las curvas temporales abiertas podrían resolver muchos problemas de la Física – NPJ QUANTUM INFORMATION

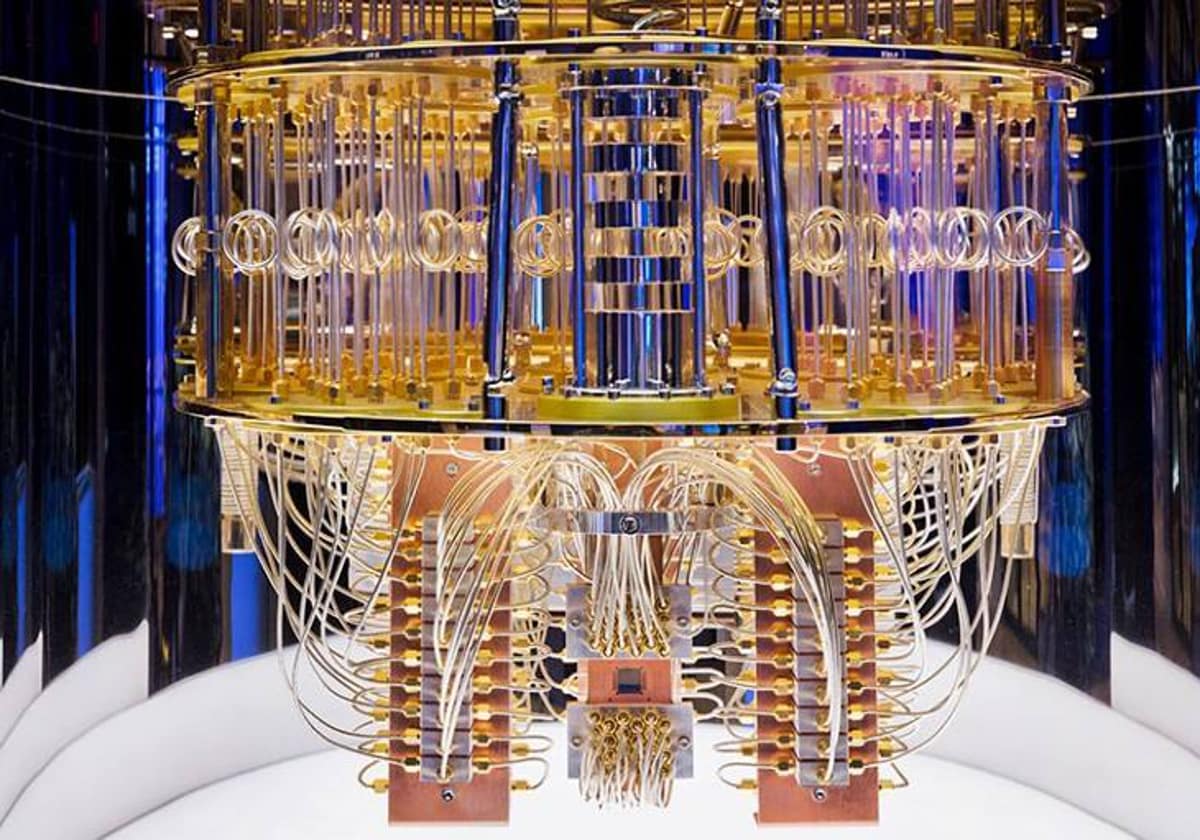

Un grupo internacional de investigadores, liderados por la Universidad de Singapur, acaba de demostrar que numerosos problemas de la Física Cuántica, hoy por hoy irresolubles, podrían solucionarse fácilmente con un ordenador cuántico que viajara a través de “curvas temporales abiertas”. El trabajo, que ha levantado gran expectación en la comunidad científica, se publica en la revista Nature Quantum Information.

IBM prepara el primer ordenador cuántico. La máquina podría resolver problemas que las computadoras actuales ni se pueden plantear. Cuando esté completada su configuración podrá dar millones de respuestas a un problema planteado en fracciones de segundo.

Hace ya una década que el físico Dave Bacon, que en la actualidad trabaja para Google, demostró que la mejor forma de resolver rápidamente todo un grupo de problemas de la Física (llamados NP-completo) y que traían de cabeza a los matemáticos, era utilizando un ordenador cuántico que se desplazara a través del tiempo. ¿La razón? El hipotético ordenador de Bacon podría moverse con libertad a través de una serie de “curvas cerradas de tiempo”, atajos en el tejido espaciotemporal que se curvan sobre sí mismos. La relatividad general en efecto, permite que dichos caminos puedan existir a través de las contorsiones en el espacio-tiempo que conocemos como agujeros de gusano.

Imaginamos cosas que….

¿Pero para qué enviar un mensaje en el tiempo y bloquearlo después para que nadie pueda leer su contenido? Sencillamente porque el procedimiento podría ser la clave que se necesitaba para resolver problemas que, actualmente, no tienen solución alguna. Y es que incluso un mensaje “sin abrir” puede resultar tremendamente útil, especialmente si los científicos “entrelazan” el mensaje con algún otro sistema antes de enviarlo.

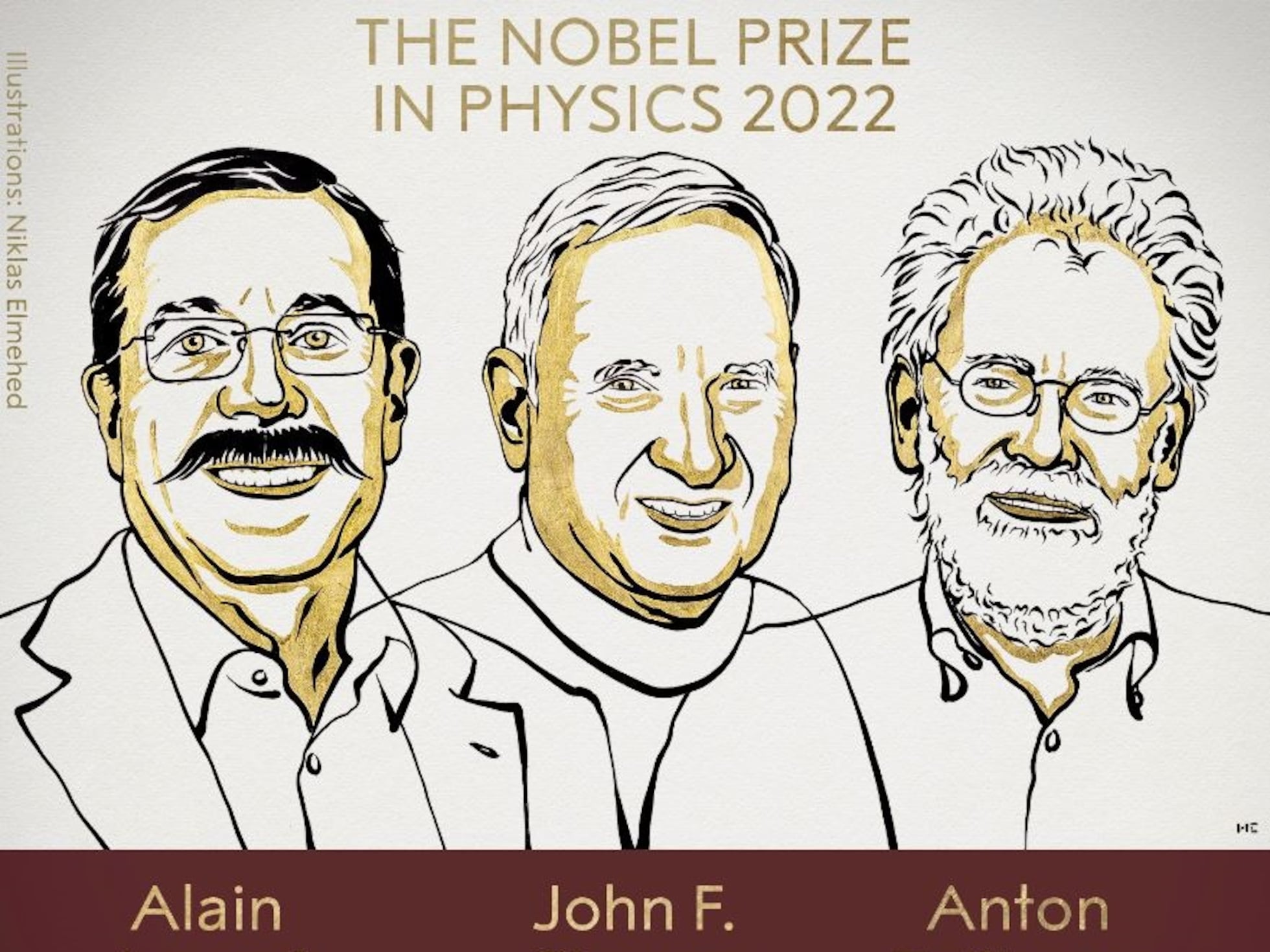

Confirman el entrelazamiento cuántico gracias a la luz de una estrella

“Ahora, una nueva investigación internacional dirigida por David Kaiser, del Instituto Tecnológico de Massachusetts (MIT) en Cambridge, Estados Unidos, en la que han participado físicos de la Universidad de Viena en Austria, y de otras entidades, han resuelto un fallo en uno de los test de la desigualdad de Bell, conocido como libertad de elección (Freedom-of-Choice Loophole). Al resolver este fallo, han conseguido una sólida demostración del entrelazamiento cuántico, según se informa en un comunicado. Los resultados se han publicado en la revista Physical Review Letters.”

Como se sabe, el entrelazamiento cuántico es un efecto extraño que es posible solo en el mundo de la Física subatómica, y consiste en una suerte de “comunicación instantánea” entre partículas que, como si fueran hermanos gemelos diminutos, “saben” al instante lo que le ha sucedido a las demás partículas entrelazadas y reaccionan al instante, sin importar la distancia que las separe. Y lo que proponen los investigadores es precisamente eso, crear un entrelazamiento entre el mensaje enviado a través del tiempo y el sistema del laboratorio. Una correlación que podría alimentar y potenciar la computación cuántica.

Sin embargo, las curvas temporales cerradas conllevan no pocos problemas. En general, los físicos creen que, aunque son teóricamente posibles, algo debe de estar evitando que ese tipo de desplazamientos temporales se produzcan en la Naturaleza. De otra forma, argumentan, podrían darse todo tipo de paradojas, entre ellas la clásica de que alguien podría viajar al pasado y matar a su abuelo, impidiendo así su propia existencia.

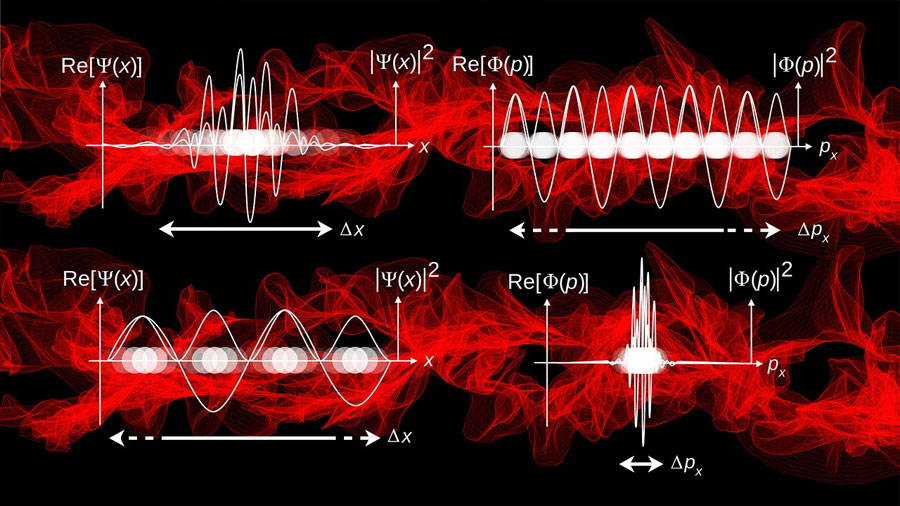

Y no solo es la familia la que estaría amenazada por unos viajes así. En efecto, romper el flujo temporal, dejando a un lado el principio de causalidad (un acontecimiento causa otro, que causa otro, y otro…) también puede tener consecuencias para la propia Física cuántica. A lo largo de las dos décadas pasadas los investigadores han mostrado hasta la saciedad que los principios mismos sobre los que se basa la Física Cuántica se quiebran en pedazos ante la presencia de curvas temporales cerradas. Por ejemplo, se puede quebrar el principio de incertidumbre, que establece la imposibilidad de conocer al mismo tiempo determinados pares de magnitudes físicas de una partícula (como la velocidad y el momento). O incluso dejar a un lado el Teorema de no Clonación, que dice que los estados cuánticos no se pueden copiar y que constituye uno de los pilares más sólidos de la Mecánica Cuántica.

Evitar las paradojas

De Historias referidas a Viajes en el Tiempo hemos podido ver muchas en películas fantásticas

Sin embargo, el nuevo trabajo muestra que un ordenador cuántico sería capaz de resolver problemas hasta ahora irresolubles si en vez de por curvas cerradas, se desplazara a través de “curvas temporales abiertas”, que no crean los problemas de causalidad anteriormente descritos. Esto se debe a que dichas curvas no permiten la interacción directa con cualquier cosa en el propio pasado del objeto: las partículas viajeras del tiempo (o, para ser más exactos, los datos que contienen) nunca interaccionarían con sí mismas.

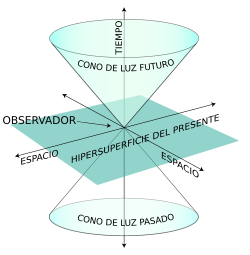

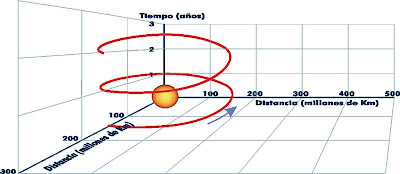

En la Teoría de la Relatividad se admite un espacio tetradimensional, con tres coordenadas espaciales y una temporal. Como no es posible representar en nuestra realidad semejante espacio de cuatro dimensiones, realizaremos una aproximación representando por un plano el espacio tridimensional, más una coordenada temporal. Las soluciones temporales abiertas para expresar la evolución de un punto sería una gráfica del tipo:

Para Mila Gu, de la Universidad de Singapur y director de la investigación, de esta forma “evitamos las paradojas clásicas, como la de los abuelos, aunque seguimos consiguiendo todos esos resultados extraños”.

“Cada vez que presentamos la idea -afirma por su parte Jayne Thompson, coautor de la investigación- todo el mundo dice que no hay forma de que esto pueda tener un efecto”. Pero sí que la hay. Las partículas enviadas de esta forma a través de un bucle temporal pueden, de hecho, ganar un enorme poder de “super computación”, incluso si jamás interactúan con nada del pasado. “La razón se debe a que algunos datos se almacenan en las correlaciones de entrelazado: y esto es precisamente lo que estamos aprovechando”, asegura Thompson.

Por imaginar…. ¡Que no quede!

Sin embargo, no todos los físicos piensan que estas líneas de tiempo abiertas tengan más posibilidades de manifestarse en el Universo físico que las líneas cerradas. Y pueden que tengan razón. Uno de los principales argumentos en contra de la existencia de curvas temporales cerradas es que nadie, que sepamos, nos ha visitado nunca desde el futuro. Un argumento que, por lo menos, no es válido con las curvas temporales abiertas, ya que en ellas cualquier mensaje procedente del futuro resultaría bloqueado.

Emilio Silvera Vázquez

Mar

24

La Vida de las partículas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

:format(jpg)/f.elconfidencial.com%2Foriginal%2Fd1c%2Fb60%2F633%2Fd1cb60633b738916a9a7eab75c82cf6a.jpg)

La Mente: Ese misterio

Una vez que fuimos conscientes de SER, pudimos discernir del por qué de las cosas, asombrados miramos los fenómenos naturales, el día y la noche, la lluvia y la tormenta, los relámpagos. el Sol abrasador, el frío y la nieve, el desborde de los ríos, el Mar y los océanos, las plantas y las flores, los frutos silvestre, la madera de los árboles, la tierra y el agua…

:format(jpg):quality(99):watermark(f.elconfidencial.com/file/bae/eea/fde/baeeeafde1b3229287b0c008f7602058.png,0,275,1)/f.elconfidencial.com/original/c2c/bba/036/c2cbba0360bd68d82954bfe903c67083.jpg)

La mente humana es tan compleja que no todos ante la misma cosa vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugiere. De entre diez personas, sólo coinciden tres, los otros siete divergen en la apreciación de lo que el dibujo o la figura les sugiere. Un paisaje puede ser descrito de muy distintas maneras según quién lo pueda contar.

Solo el 1% de las formas de vida que han vivido en la Tierra están ahora presentes, el 99%, por una u otra razón se han extinguido. Sin embargo, ese pequeño tanto por ciento de la vida actual, supone unos cinco millones de especies según algunas estimaciones. La Tierra acoge a todas esas especies u palpita de vida que prolifera por doquier. Hay seres vivos por todas partes y por todos los rincones del inmenso mosaico de ambientes que constituye nuestro planeta encontramos formas de vida, cuyos diseños parecen hechos a propósito para adaptarse a su hábitat, desde las profundidades abisales de los océanos hasta las más altas cumbres, desde las espesas selvas tropicales a las planicies de hielo de los casquetes polares. Se ha estimado la edad de 3.800 millones de años desde que aparecieron los primeros “seres vivos” sobre el planeta (dato de los primeros microfósiles). Desde entonces no han dejado de aparecer más y más especies, de las que la mayoría se han ido extinguiendo. Desde el siglo XVIII en que Carlos Linneo propuso su Systema Naturae no han cesado los intentos por conocer la Biodiversidad…, de la que por cierto nuestra especie, bautizada como Homo sapiens por el propio Linneo, es una recién llegada de apenas 200.000 años.

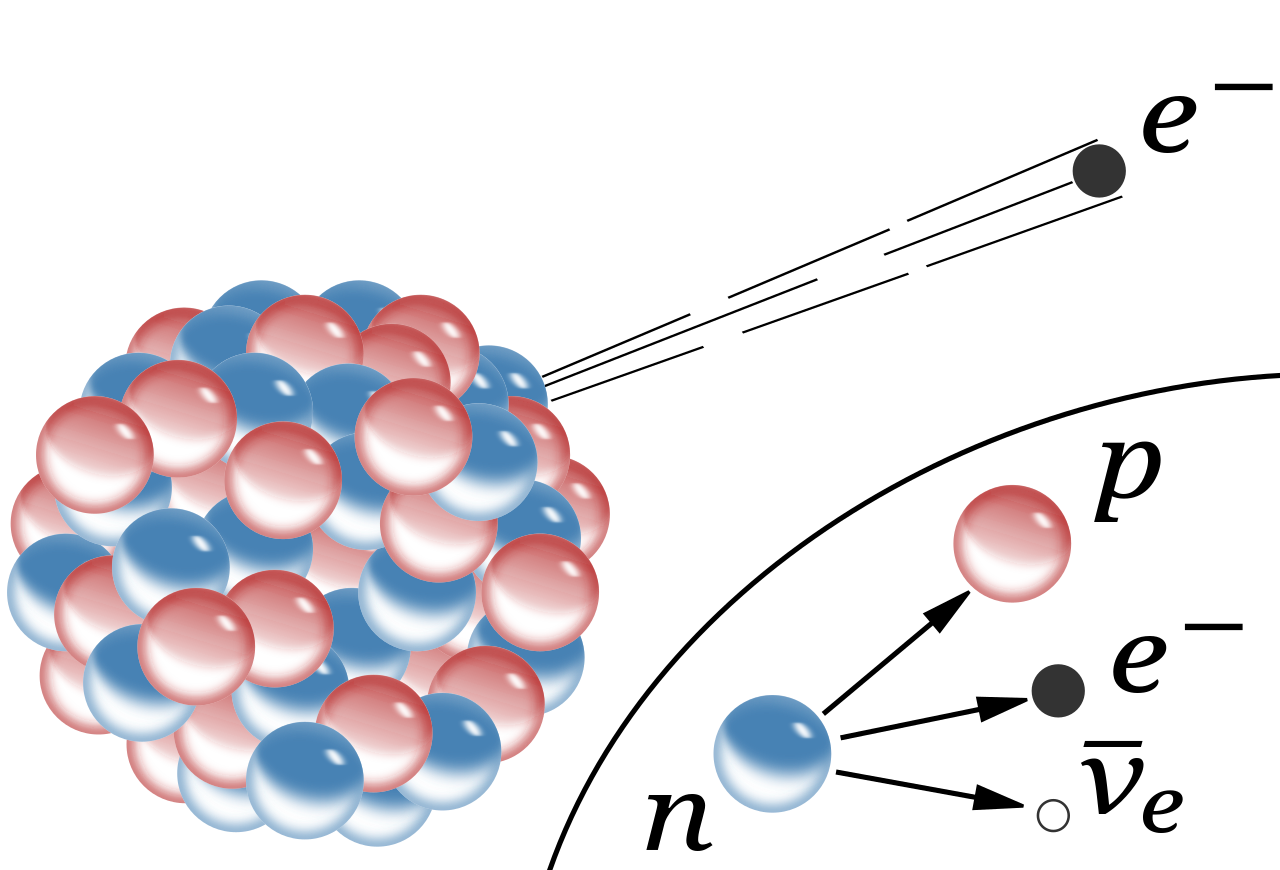

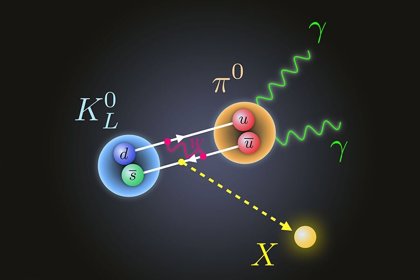

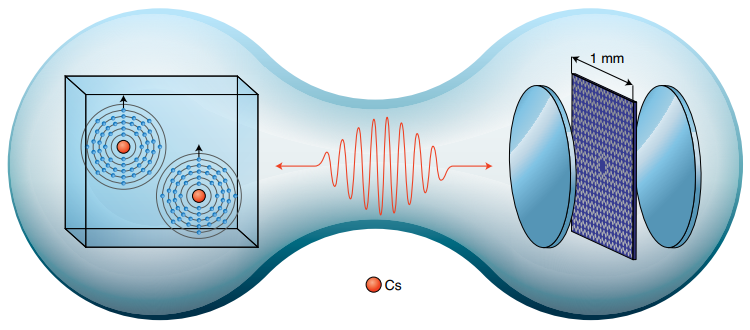

Ahora, hablaremos de la vida media de las partículas elementales (algunas no tanto). Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida media, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, psi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales maneras de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

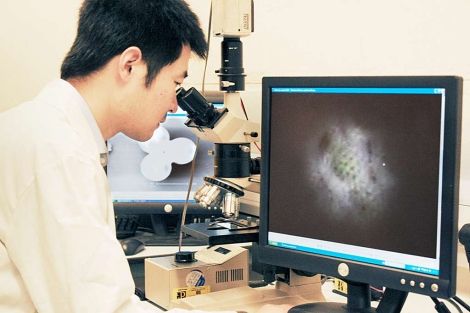

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

Una colisión entre un prtón y un antiprotón registrada mediante una cámara de chispas del experimento UA5 del CERN.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Se habla de ondas cuánticas y también, de ondas gravitacionales. Las primeras han sido localizadas y las segundas están siendo perseguidas.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10-23 segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Bariones Delta. Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (aunque nos parezca lo contrario), son aún bastante limitados, nos queda mucho por descubrir antes de que podamos decir que dominamos la materia y sabemos de todos sus componentes. Antes de que eso llegue, tendremos que conocer, en profundidad, el verdadero origen de la Luz que esconde muchos secretos que tendremos que desvelar.

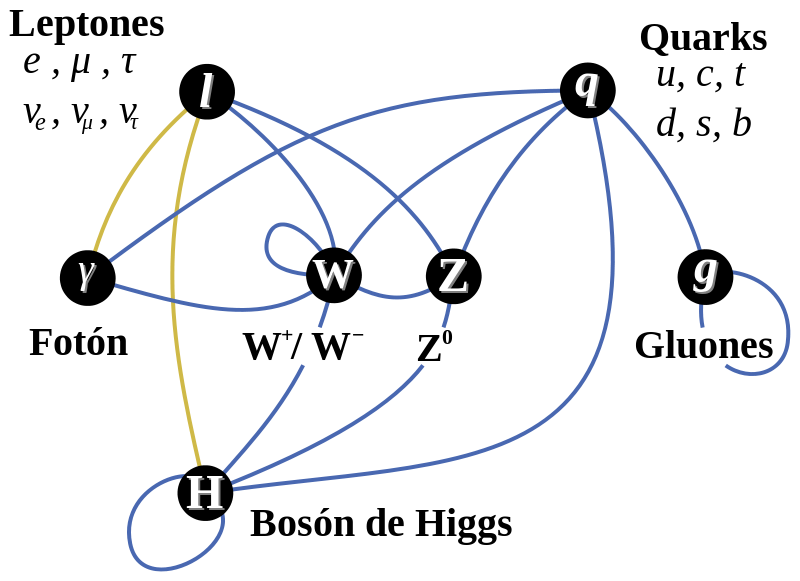

Esperemos que con los futuros experimentos del LHC y de los grandes Aceleradores de partículas del futuro, se nos aclaren algo las cosas y podamos avanzar en el perfeccionamiento del Modelo Estándar de la Física de Partículas que, como todos sabemos es un Modelo incompleto que no contiene a todas las fuerzas de la Naturaleza y, cerca de una veintena de sus parámetros son aleatorios y no han sido explicados. Uno de ellos, el Bosón de Higgs, dicen que ha sido encontrado. Sin embargo, a mí particularmente me quedan muchas dudas al respecto.

Emilio Silvera Vázquez

Mar

19

En recuerdo a un amigo. Ton Wood un Físico Teórico de Nueva York

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

El contertulio Tom Wood, es un físico al que le apasionan los tránsitos que se observan en la Naturaleza y sus mecanismos. Él es consciente de la dificultad que entraña unir esos dos mundos -en medio de los que nos encontramos-, el de la mecánica cuántica y el de la relatividad general, lo muy grande y lo muy pequeño están situados en “universos diferentes” y, nosotros, situados entre los dos, tratamos de desvelar esos secretos que, tan celosamente, la Naturaleza esconde. Así, la pasión de Tom por los fenómenos físicos, le transporta a “mundos” en los que suceden cosas que otros no podemos ver. Se hace preguntas que el mismo suele contestar:

“1- Pregunta:

–Según nuestras experiencias experimentales actuales:¿Por qué no detectamos energías de campos (Luz, campo gravitatorio,…) con velocidad cero?

–O a la forma oficial:

¿Por qué las partículas sin masa; los campos, las radiaciones, los fotones, les aparecen en la teoría, que no pueden tener masa en reposo?

Respuesta-1

–Porque cuando una energía-campo “alcanza” la velocidad cero, se confina como energía-masa. (Se convierte en partícula).

2-Pregunta:

–Según nuestras experiencias experimentales actuales:

¿Por que no detectamos energías-masas viajando con velocidades mayores o iguales que la de luz?

O a la forma oficial:

¿Por que las partículas con masa no alcanzan nunca la velocidad de la luz y mucho menos la superan?

Respuesta-2

-Porque cuando una energía-masa “alcanza” la velocidad de la luz, rompe esa topología de confinación y se convierte, regresa ha ser de nuevo una energía-campo libre.”

En un trabajo que nos decía que no siempre la física puede contestar todas las preguntas Tom nos decía

Tom Wood

el 31 de mayo del 2012 a las 18:11

¡Una joya su exposición!

“Mi modelo de la interacción Luz-Luz es algo primitivo, muy clásicos, no vivo de espalda ha esa realidad. Aunque para mí, en medio de tanta confusión física, represente cada día, la idea física más feliz de mi vida. Hacer modelos clásicos del complejo micromundo, ya modelado por teorías bien consistentes, es el pandemonio, la vergüenza de un físico moderno; al menos esa es la moral científica que se enseñanza en las universidad moderna. *Pero es una gran ignorancia física, subestimar la importancia, de la acción a distancia que le permitió a Newton redondear la imprescindible Mecánica Clásica, el calórico para la Termodinámica, el éter para la creación la Electrodinámica, el principio de equivalencia que se invento Einstein (la idea mas feliz de su vida, palabras de el) para crear la Teoría General de la Relatividad o el punto de inflexión que represento para la MC el modelo planetario del átomo de Bohr. Se que ninguna de esas ideas hoy es necesarias para sostener a los mejores modelo teórico que describn la naturaleza física de las cosas naturales. Pero también seria bueno que meditáramos, si de no habérsele ocurrido esas “grotescas ideas” a esos iluminados, no estaríamos discutiendo todavía, sobre cuantos elefantes sostienen la tierra. Yo sigo diciendo, sigo viendo, nada me convence de lo contrario por física, que la 6ta física que relacione, que generalice, que sintetice toda la numerología experimental que tenemos acumulada y que no logramos verle su relación, y que además no mutile lo bueno de las cinco físicas anteriores; esa 6ta física, surgirá de la misma forma que las cinco veces anteriores. ¿Por qué esta vez debería ser diferente el proceso? Hacia falta que las universidades les mostraran a los jóvenes estudiantes de físicas, que también les es posible seguir ese derrotero. Pero creo que será más lento el proceso, si solo lográramos verlo así, después de que hayamos recorrido todo el callejón sin salida en el que al parecer nos hemos metidos. Además, si se vislumbrara un camino bien claro con modelos más establishment, sentiría más pudor de escribir mis “groserías científicas”; pero ese no es el caso. Y es que ese tosco modelo me esta brindando tantas satisfacciones, que no creo que sean puros trucos de mi mente para auto complacerme, o para enajenarme por la desesperación del momento.”

Continuaba sus elucubraciones diciendo: Veo líneas generales que se repitieron para la creación de las cinco físicas, claro si las analizamos dialécticamente, aunque sea con ideas esquematizadas.

Ideas salidas de nuestras mentes

1-Muchas toscas ideas como las que explique arriba (*) y que ya solo tienen importancia histórica.

2-Siempre hay implicado un experimento tipo, o ideas sencillas. Primera física: Como fue el cliché de la manzana,… Segunda física: La razón de que variables macroscópicas como la temperatura o la presión surgen de los movimientos cinéticos, he interacciones de las microscópicas “bolita materiales”; en principio, Mecánica Clásica. Tercera física: Que la atracción que ejerce el ámbar cargado,… es producto de un campo también, como el gravitatorio (extrapolan la idea de la Mecánica Clásica) o que la luz es una onda como las mecánicas; en principio, Mecánica Clásica. Cuarta física: La brillante interpretación hecha por Planck a la curva experimental de radiación del cuerpo negro. Quinta física: La interpretación de Einstein del paradójico experimento de MM,… ¿Estará ya entre nosotros el experimento tipo que pueda aportar, aclarar esas sencillas ideas que posteriormente desatan el frenesí, para crear el resto de las complejidades físicas-matemáticas? Como no dispongo de mucho tiempo, por aquí creo que abordo el problema que no se esta entendiendo, a mi modesta forma de ver las cosas:

En sus comentarios, a Tom le gusta dejar referencias y ejemplos

http://cuentos-cuanticos.com/2012/05/08/los-paradigmas-de-kuhn/#comment-2951

http://cuentos-cuanticos.com/2012/05/31/hoy-me-dio-por-ser-honesto/#comment-3153

1-Buscando alternativa que emanen de las bases experimentales que tenemos explicadas.

2-De las que están explicadas; pero de una forma que no nos complace mucho; pero donde si partimos de algo experimental. Es decir, no de lógica formal…

Detectores con entrelazamiento cuántico

Fotones entrelazados

http://www.youtube.com/watch?v=fUZZgDOrY30

http://es.wikipedia.org/wiki/Entrelazamiento_cu%C3%A1ntico

http://es.wikipedia.org/wiki/Efecto_Aharonov-Bohm …

3-Y de las que no les hemos encontrado explicaciones; como esta curva (algo parecido al problema del cuerpo negro).

http://thebigblogtheoryesp.wordpress.com/category/comunicado/

O la numerología del SM, ¡cuantos números sin una relación, una síntesis, o unos símbolos (físicos-matemáticos) que los sinteticen con vergueta física! Que los humanos no le hayamos encontrado relación, no significa que en la naturaleza no tengan una, bien estrecha y definida.

http://es.wikipedia.org/wiki/Modelo_est%C3%A1ndar_de_f%C3%ADsica_de_part%C3%ADculas

El amigo Tom busca respuestas a preguntas que no han sido contestadas y, lo mismo que se descubrió el decaimiento Beta, él quiere llevarnos a una nueva física en la que aparezcan los efectos descritos por su modelo de la interacción Luz-Luz débil y fuerte.

Tom Wood

el 31 de mayo del 2012 a las 21:26, nos decía:

“He creados mi modelos sobre las partículas, tratando de partir de cosas reales, de hacerlos que se correspondan al menos con la mayoría de esas propiedades. No una propiedad por aquí y otra por allá. No me gusta, que la masa venga de un lado (Higgs), que el espín por el otro (LQG), que la carga no sea fundamental; porque solo es una excitación del campo. Que el campo magnético, no se le meta con fortaleza dentro del electrón o cualquier otra partícula y que a la vez el se corresponda de alguna forma con lo eléctrico,…; por decir algo, pero esta también ahí, al menos es lo que se mide en el laboratorio. Peor aun; me molesta mucho que los físicos se desentiendan, digan que son preguntas ilegales,… explicarnos con claridad porque los tiempos de vida de cada partícula son eso y no otros. Esto para mi es algo muy, pero muy importante y nadie le esta tirando con fuerza. Yo solo no puedo con problemas tan complejos, al menos desde mi línea de hoja de ruta. Voy muy lento, yo solo,… es frustrante ver cosas y que todos sigan empecinado en lo mismo. Eso en mi tosco modelo esta incluido, tiene que estar incluido; con todo lo demás. Eso en la naturaleza esta todo en un solo ente. Se que si separan las cosas es por lo compleja que son y por el desespero. ¿Pero no es que la física es una ciencia natural? ¿No están así esas cosas en la naturaleza? Entonces, que están explicando, naturaleza o truquitos lógicos. No podemos taparnos la cara y escapar de esa realidad por mas frustrante que se nos presente. De ser así, estaremos aquí por los siglos de los siglos, sobre los mismos modelos super-lógicos, super-abstractos; pero sin explicarnos las cosas, tal y como son. Modelos de muy bajos logros o rendimientos sintéticos/explicativos y que incrementan las paradojas. Bueno yo sigo avanzando, lento, por solo; pero con tantas satisfacciones que me da a diario mi modelo de la interacción Luz-Luz débil y fuerte; a través de considerar las energías-campos y las energías-masas (estas ultimas partículas o energías-campos confinadas) que me llenan de regocijos.”

Seguía: “Lo sorprendente es que aunque trato de que no aparezcan los fantasmas de los modelos super-abstractos, si aparecen.

Por ejemplos los fermiones surgen, son al final de todo producto de la geometría que adopta el electromagnético al confinarse, al circular para formar ese tipo de partículas. Confinación que no asume que este esta en reposo al confinarse; algo que retomo para explicar muchos fenómenos como (2 y 3). Más bien de la circulación geométrica, de alta simetría espaciotemporal que adopta ese electromagnético. Pero no digo fotones, porque no hay jerga para explicarlo… Tal vez ese electromagnético confinado, los futuros científicos tengan que cambiarle el nombre; es más estoy seguro que lo cambiaran todo, complejizaran tanto el modelo, que lo que yo tengo ahora servirá para risas y comentarios burlescos. Pero mas para nosotros ahora, para nuestra contemporaneidad y confusión, eso no es gracioso. Pero yo tengo que usar esas ideas clásicas anteriores, para mantenerme en la línea más simple posible. No te aburro mas, podríamos hablar horas de esto y el tiempo es oro.

Por ejemplo, nunca me gusto la idea de que emanara física de la geometría, odio eso. Pero no puedo ir contra las cosas que me grita el modelo, porque a mi no me agraden. Aunque no deja de ser extraño que un fermión, como el electrón, todas sus propiedades (masa, carga, campos, espin,…tiempo de vida estable) se puedan extraer de la geometría y la alta simetría que describe la circulación del electromagnético al confinarse. (Compleja topología, pero estudiada ya por otros modelos súper abstracto, yo medio que la veo en ellos, algo que también aborrezco). Es decir, no están partiendo de la física y por eso no logran relacionar las cosas físicas/naturales, con las físicas-matemáticas que crean. Ese es el punto, o la conclusión gnoseológica del modelo.

En el trabajo “No siempre la Física se puede explicar con palabras”, el amigo Tom Vood nos deja el siguiente comentario que, al parecerme de interés aquí os lo inserto para que todos, podáis pensar en lo que aquí expone: Creo que sí, deben ser divulgadas.

Tom Wood

el 31 de mayo del 2012 a las 21:48

Te dejo una entre muchas “revelaciones” reciente, calentitas solo para ti; que no quisiera que se divulgaran. Pero le dejo a su responsabilidad, si borrarlas, si usted cree que debo seguir como guerrillero de la ciencia o debe ser conocidas estas ideas por toda la comunidad científica. Disculpa, pero no logro discernir eso. Pero como admiras tanto a Einstein y yo soy tan tonto, te la insinúo por arribita: (Según el modelo de la interacción Luz-Luz).

¿Sabes por que las energíasmasas (partículas, o electromagnéticos confinados) no pueden superar la velocidad de la luz?

Nunca olvides el porque que dio el modelo de la interacción Luz-Luz; parece novedoso.

Bueno Einstein se moriría por explicárselo; a pesar de que para los modernos físicos esas preguntas ilegales no se le hacen a la física; recuerda el famoso: ¡no preguntes y calcula! Como diciendo, no eres físico, sino físico-matemático. O lo que no se, o no me puedo explicar, no lo puedes preguntar, es de mal gusto hacerlo, o de ignorantes. ¡Que daño Dios!

Bueno, pues una partícula según mi modelo es energía-campo confinada o electromagnético confinado en forma de energía-masa y por lo tanto cuando alcanza la velocidad de la luz, ocurre la ruptura de simetría que lo regresa a ser de nuevo energía-campo.

Más riguroso: Si una energía-masa alcanza la velocidad de la luz, se convierte en energía-campo.

De aquí se extraen miles de corolarios:

“-Las energías-masas (partículas) si alcanzan la velocidad de la luz, solo que una vez que la alcanzan, se rompe su topología de confinación, de energías-masas y se liberan de nuevo como energías-campos. Algo que nunca dejaron de ser. Es que eso nunca las cinco física anteriores lo prohibían; por algo era. Mi modelo no mutila, incorpora,… Son los físicos, los que al no tener un buen modelo, medio que lo veían implícito así en la teoría; que eso no podía suceder. Pero si sucede, solo que nunca pueden sostenerse así.

-Nunca una energía-masa (partícula con masa) podrá superar la velocidad de la luz. La conclusión Eisteniana que nadie se ha podido explicar. Vez que fácil es todo, una vez que se va ha la física.-La velocidad de la luz no es una barrera, la barrera es la ley que confina la energía-campo, en forma de energía-masa. Esa topología, geometría; o relaciona geometrías/energía.

-Toda aniquilación, desintegración y explosión tipo Big Bang (odio, o no creo lo del Big Bang) de los cuerpos del macrocosmo, es por la misma causa.

-De esto se extrae (del modelo también) la ley universal permitibilidad máxima de energía por unidad de espaciotiempo.

…”

El VICEVERSA; porque si no todo fuera energías-campos y la naturaleza no ocurre así:

Toda energía-campo (luz,…) se confina como energía-masa, cuando su velocidad se hace cero.

-O lo que es lo mismo, ninguna partícula sin masa puede llegar a alcanzar el estado de reposo. Otra cosa que ningún modelo ha explicado, aunque es evidente que es un principio natural. Como todo lo que les explico. ¡Total, si eso es ilegal para el establishment!

De aquí se infieren muchas preguntas, conclusiones, paradojas, o explicaciones más racionales, a muchas cosas que decimos explicadas o que no hemos explicado todavía.

La energías-campos (ustedes siempre piensen en la luz como yo al principio, para que no se pierdan) nunca puede estar en reposo (que la energía no puede estar en reposo es conocido, por eso es energía), pero como si existen circunstancias físicas muy especiales, donde esta puede ir disminuyendo su velocidad hasta que sea cero; la naturaleza resuelve esta paradoja, confinando las energías-campos, en diferentes topologías que donde se conserva como energías-campos (mas fácil verlo si piensan en luz); pero exteriormente se manifiesta como un ente, que puede estar en reposo o moverse como un todo; como lo que llamamos partículas con masa ( para mi energías-masas).

Otra idea que puede ayudarlos a digerir esto: la energía-campo oscila, están acotadas entre la velocidad cero y la velocidad “c”.

Esa oscilación, tipo superficie de agua hirviente, es lo que ocurre en la superficie de un agujero negro. Otra revelación de la riqueza física que despliega el modelo.

Te explico mejor:

“Cuando una energía-campo (luz) cae en un campo tan intenso como el de un agujero negro, su velocidad comienza a disminuir, llegado al “horizonte” (concepto que hay que ampliar) donde su velocidad seria cero; según mi modelo se confina como una energía-masa y trataría de moverse como un todo. Y aquí pueden ocurrir varias cosas que no te he explicado. Según la geometría que adopte la confinación, podrá ser un fermión izquierdo o derecho (una partícula o una antipartícula); así que puede ocurrir aniquilación,… También podría ocurrir que esa partícula (o energía-masa) alcance la velocidad de la luz; es decir regrese ha ser energía-campo, ya te explique por que. Ahora, la gravitación es energía-campo también, y aquí ocurre que ella penetra a la partícula (el mismo proceso de la aniquilación, todo es lo mismo, hay una regularidad natural entre el micro-mundo y el macro-mundo, que nadie ve), satura la estabilidad de su topología, y esta se desintegra (aquí tienes la explicación de todos los procesos de desintegración y con el, los tiempos de vida). Pero desintegración en mi razonamientos, en el modelo; es decaer en otra topología de menor energía y cuando esas topologías estables, quedan agotadas por las leyes naturales, que los físicos llamamos de conservación (carga, spin, Isoespín, CP, CPT,…); no le queda otro remedio a la energía-masa; que volver ha ser una energía-campo.”

Bueno espero haberte complacido en algo, “tuvisteis la exclusividad”, lo dejo ahí porque para que lo digieran y porque tengo muchos problemas que resolver. Tampoco tengo tiempo de leer lo que escribí (como ya es costumbre); pero ustedes son inteligentes como para no crucificarme, así que corrígeme ha tus Dones. Pueden divulgar a su antojo, como siempre les digo, “mi física de café con leche”. Tómense su tiempo para digerirlo, para acostumbrarse a estas nuevas concepciones físicas, esto párese merecerlo, parece novedoso.

Nuestro amigo Tom nos quiere llevar hasta una nueva física, hacia nuevos paradigmas que nos haga comprender muchos de los secretos que la Naturaleza esconde, secretos, a los que no resulta nada fácil llegar. Si lo consigue, nos hará ver el universo de lo grande y de lo muy pequeño, de otra distinta manera, una manera que va más lejos, donde reside un más profundo entendimiento de la Física que en nuestro Universo está presente.

Tom Wood

el 1 de junio del 2012 a las 0:49, me decía:El universo según el modelo de la interacción Luz-Luz; no es más:

“Que un hervidero de energías-campos alcanzando el “reposo” para convertirse (confinarse) en energíasmasas y estas a su vez “alcanzando” la velocidad de la luz, para convertirse en energías-campos.”

Pura energía que nunca esta en reposo y que se inventa las manifestaciones exteriores de las energías-campos confinadas (partículas mas elementales) que medimos en los laboratorios, a través de las topologías de las partículas. Así es que ella se divierte, nos esconde la realidad y nos confunde. Eso es lo que ocurre en los super-densos cuerpos estelares, en los intensos campos de los núcleos atómicos,… Como vez todo es lo mismo.

No creo que ahora no se vea que eso es lo único natural, sencillo y más general que hay en la naturaleza. Casi todo lo demás son modelos de bajo rendimientos sintéticos/explicativos; por alejados de la naturaleza física de las cosas o fantasmas oscuros, que traen mas problemas a la confusión general que las cosas sencillas ocultan.

Si decidí explicar al menos estas ideas, es para que se forme la excitación de los teóricos; cuando se forme la deserción que al parecer se avecina. Algún día tal vez tenga la oportunidad de exponer públicamente el experimento que sostiene la interacción Luz-Luz. Es tan increiblmete sencillo, que a ningún iluminado se le va ha ocurrir, es hasta infantil o escolar. Así que ese si esta a salvo, es mi carta de de triunfo final. Además fue por donde comenzó todo esto, hace unos 26 anos, si mal no calculo.

Nuestro principal defecto es lo inocentemente críticos que somos con el CMB; que de responder a esa interpretación (¡y mira que la han ajustado!) ya paso por aquí hace tanto tiempo, que me asusta mirar el numero. Solo es una idea peregrina, porque las cosas no están encajando bien y al darse cuenta, están poniendo la teja antes que llueva. Es la desbandada que debe concluir después de la generación de físicos que viene; por el 2050; calculo yo. Estas cosa no son nuevas, así somos los físico; recuerden la catástrofe ultravioleta y su termodinámica,…

Ni en los grandes aceleradores alcanzaremos nunca la velocidad de la luz

Tom Wood

el 1 de junio del 2012 a las 20:56

Clarificando las preguntas y respuestas 1 y 2: Pongo la palabra “alcanza” entre comillas, porque es lógico que nunca una energía-campo alcanza la velocidad de la luz; porque “antes” se convierte en una energía-campo. Y una energía-campo nunca “alcanza” el reposo porque antes se convierte en energía-campo. O “antes” de alcanzar el reposo una energíacampo se confina. Es que en ese instante, en ese punto de discontinuidad evitable, discontinuidad de solución de frontera, es que se producen los verdaderos cambios de fase, la verdadera ruptura de la anterior simetría, o cambios de topologías, como lo llamo yo, porque todo emana de la geometría. (Es que como nunca antes existieron estas ideas, no hay antecedentes, no encuentro fuentes; es lógico que no encuentre las jergas científicas adecuadas. Pero creo que me he esforzado tanto en explicármelo y explicárselos, que hasta un niño puede entender la idea central.)

Como tampoco es cualquier cosa, las correcciones quánticas y relativistas que introduce la nueva topología geométrica que le asigno a las energías-campos confinadas. Esa es mi segunda cartita, la otra que guardo debajo de la manga. Ayer les dije la primera: el experimento que revela la interacción Luz-Luz débil. Bueno tengo que dejar algo para yo entretenerme y que me permita ir, aunque sea un flash mas adelante. No me creo egoísta por eso ¿o si? De todas formas yo me lo estoy masticando más crudo. Y hay muchas rutas reveladas, que no les dejan perderse. De todos modos, el que le guste el modelo, le llevara tiempo digerirlo, aunque parece atractivo, por simple, lo simple da éxitos rápidos y lo atractivo entusiasma.

Podemos ver algunas cosas con claridad, sin embargo, existen enigmas en la Naturaleza que, como la espesa niebla de la noche, no nos deja “ver” , ni “saber”, lo que ocurre en muchas transiciones de fase en las que están presentes la luz, la energía en fin que, de alguna manera, no hemos llegado a conocer y, es, precisamente ese secreto el que trata de desvelar el amigo Tom con su nueva teoría.

¡Que lo consiga!

Emilio Silnera Vázquez

PD.

Con los comentarios de nuestro amigo Ton Wood, se podrían llenar muchas páginas y, como comprenderéis, eso requeriría un trabajo más profundo para presentar sus ideas de manera más extensa y pormenorizada, dado que lo expuesto más arriba, simplemente refleja una literalidad de una serie de ideas que bullen en tropel imparable en una mente preocupada por saber y descubrir, cuestiones que nadie nunca ha podido explicar.

Mar

1

La perfección imperfecta

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (5)

Comments (5)

Me refiero al Modelo estándar y, algunos han llegado a creer que sólo faltan algunos detalles técnicos y, con ellos, la física teórica está acabada. Tenemos un modelo que engloba todo lo que desamos saber acerca de nuestro mundo físico. ¿Qué más podemos desear?

Bueno, lo que hasta el momento hemos logrado no está mal del todo pero, no llega, ni con mucho, a la perfección que la Naturaleza refleja y que, nosotros perseguimos sin llegar a poder agarrar sus múltiples entresijos y parámetros que conforman ese todo en el que, sin ninguna clase de excusas, todo debe encajar y, de momento, no es así.

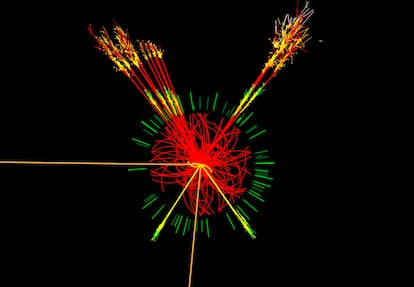

Fuente: Prog. Part. Nucl. Phys. 106: 68-119 (2019).

Para la mayoría de los físicos el modelo estándar es una teoría efectiva: el límite a baja energía de una teoría más fundamental desconocida. El lagrangiano ℒ del modelo estándar es un operador de dimensión cuatro (ya que la acción es S = ∫ℒ d⁴x). La física más allá del modelo estándar modificará dicho lagrangiano añadiendo términos de mayor dimensión; por ejemplo, ℒ + ∑ Cᵢ ?ᵢ /Λ², donde el sumatorio recorre los 2499 operadores ?ᵢ de dimensión seis y Λ es una nueva escala de energía (que será mucho mayor que la masa del quark top). El físico John Ellis (CERN) nos recuerda que ajustar estos 2500 parámetros (los ?ᵢ y Λ) usando las colisiones del LHC y otros colisionadores es imposible. La única solución es asumir simetrías que reduzcan dicho número parámetros. En su último artículo nos propone usar las simetrías SU(3)⁵ y SU(2)²×SU(3)³. Por supuesto, hay muchas otras alternativas.

La física de partículas se suele separar en física experimental (observacional), física teórica (fundamental) y física fenomenológica; las teorías efectivas son parte de esta última, siendo su objetivo desvelar los primeros indicios (lo que inglés se llama evidences) de física más allá del modelo estándar. Hoy en día disponemos de un conocimiento en teoría cuántica de campos suficiente para desarrollar de forma sistemática todas las teorías efectivas posibles; un elemento clave a tener en cuenta son las redefiniciones de campos, una redundancia cuya eliminación nos permite obtener lo que se llama una base de operadores. Una vez obtenida podemos ajustar sus parámetros con los datos de colisiones que se recaban en los grandes colisionadores de partículas (como el LHC en el CERN).

Por desgracia, el número de parámetros de estas teorías efectivas más allá del modelo estándar es enorme. John von Neumann decía que «con cuatro parámetros puedo ajustar un elefante, y con cinco puedo lograr que mueva su trompa» [LCMF, 27 may 2010]. Ajustar muchos parámetros, incluso cuando se dispone de una vasta cantidad de observaciones, requiere lidiar con el problema estadístico de las comparaciones múltiples (que en física de partículas se suele llamar look-elsewhere effect): pueden aparecer indicios espurios (señales con más de tres sigmas de significación estadística) que solo son falsos positivos. En un espacio de 2500 parámetros es muy fácil caer en este problema; incluso cuando se usa un espacio paramétrico mucho más pequeño (por ejemplo, la extensión supersimétrica mínima del modelo estándar, el modelo MSSM, tiene 124 parámetros libres).

Nadie dijo nunca que la búsqueda de física más allá del modelo estándar fuera sencilla. Y tampoco que fuera fácil de automatizar. La intuición física (que a veces se llama «búsqueda de la belleza») juega y jugará un papel fundamental en la labor de los físicos fenomenológicos (al menos hasta que no se les pueda sustituir por futuras inteligencias artificiales). El nuevo artículo es John Ellis, «SMEFT Constraints on New Physics Beyond the Standard Model,» arXiv:2105.14942 [hep-ph] (31 May 2021), que resume los resultados de John Ellis, Maeve Madigan, …, Tevong You, «Top, Higgs, Diboson and Electroweak Fit to the Standard Model Effective Field Theory,» Journal of High Energy Physics 2021: 279 (29 Apr 2021), doi: https://doi.org/10.1007/JHEP04(2021)279, arXiv:2012.02779 [hep-ph] (04 Dec 2020). También muestro resultados del artículo de Jens Erler, Matthias Schott, «Electroweak Precision Tests of the Standard Model after the Discovery of the Higgs Boson,» Progress in Particle and Nuclear Physics 106: 68-119 (2019), doi: https://doi.org/10.1016/j.ppnp.2019.02.007, arXiv:1902.05142 [hep-ph] (13 Feb 2019).

“El número de parámetros del modelo estándar, que está basado en interacciones gauge con simetrías SU(3)×SU(2)×U(1), depende de la física de los neutrinos (ignoramos si son fermiones de Dirac o de Majorana). Si los neutrinos no tuvieran masa serían 18 parámetros (llamados electrodébiles); en esta figura se añaden dos parámetros adicionales al final que están relacionados con la cromodinámica cuántica en régimen no perturbativo. Como los neutrinos tienen masa hay que añadir sus 3 masas y los parámetros de la mezcla de sus sabores en la matriz PMNS, que serían 4 para neutrinos de Dirac y 6 para Majorana. Además, habría que añadir un parámetro relacionado con la violación de la simetría CP en la interacción fuerte (que estaría relacionado con la masa de los axiones, si estos existieran). Así el número de parámetros del modelo estándar estaría entre 25 y 28.

Es cierto que, el Modelo estándar es casi (en algunos momentos), pero no permanentemente, perfecto. En primer lugar, podríamos empezar a quejarnos de las casi veinte constantes que no se pueden calcular. Pero si esta fuese la única queja, habría poco que hacer. Desde luego, se han sugerido numerosas ideas para explicar el origen de estos números y se han propuesto varias teorías para “predecir” sus valores. El problema con todas estas teorías es que los argumentos que dan nunca llegan a ser convincentes.”

Fuente: Ciencia de la Mula Francis.

¿Por qué se iba a preocupar la Naturaleza de una fórmula mágica si en ausencia de tal fórmula no hubiera contradicciones? Lo que realmente necesitamos es algún principio fundamental nuevo, tal como el principio de la relatividad, pero nos resistimos a abandonar todos los demás principios que ya conocemos; ¡esos, después de todo, han sido enormemente útiles en el descubrimiento del Modelo estándar! una herramienta que posibilitado a todos los físicos del mundo, construir sus trabajos en ese fascinante mundo de la mecánica cuántica, donde partículas infinitesimales interactúan con las fuerzas y podemos ver, como se comporta la materia en determinadas circunstancias. El mejor lugar para buscar nuevos principios es precisamente donde se encuentran los puntos débiles de la presente teoría.

Es cierto que la materia le habla al Espacio y el espacio le habla a la materia

La regla universal en la física de partículas es que cuando las partículas chocan con energías cada vez mayores, los efectos de las colisiones están determinados por estructuras cada vez menores, más pequeñas en el espacio y en el tiempo. Supongamos por un momento que tenemos a nuestra disposición un Acelerador de Partículas 10.000 veces más potente que el LHC, donde las partículas pueden adquirir esas tantas veces más energías de las alcanzadas actualmente. Las colisiones que tendrían lugar nos dirían algo acerca de los detalles estructurales de esas partículas que ahora no conocemos, que serían mucho más pequeños que los que ahora podemos contemplar. En este punto se me ocurre la pregunta: ¿Seguiría siendo correcto el Modelo estándar? 0, por el contrario, a medida que nos alejemos en las profundidades de lo muy pequeño, también sus normas podrían variar al mismo tiempo que varían las dimensiones de los productos hallados. Recordad que, el mundo no funciona de la misma manera ante lo grande que ante lo infinitesimal.

El LHC consiguió en menos de un mes el Bosón W

¿Podéis imaginar conseguir colisiones a 70.000 TeV? ¿Qué podrías ver? Y, entonces, seguramente, las protestas de algunas de que “ese monstruo” podría abrir un agujero de gusano en el espacio tiempo…¡tendría algún fundamento! No sabemos lo que puede pasar si andamos con fuerzas que no podemos dominar.

Hoy, el Modelo estándar es una construcción matemática que predice sin ambigüedad cómo debe ser el mundo de las estructuras aún más pequeñas. Pero tenemos algunas razones para sospechar que tales predicciones resultan estar muy alejadas de la realidad, o, incluso, ser completamente falsas.

Encendamos nuestro super-microscopio imaginario y enfoquémoslo directamente en el centro de un protón o de cualquier otra partícula. Veremos hordas de partículas fundamentales desnudas pululando. Vistas a través del super-microscopio, el Modelo Estándar que contiene veinte constantes naturales (o algunas más), describen las fuerzas que rigen la forma en que se mueven. Sin embargo, ahora esas fuerzas no sólo son bastante fuertes sino que también se cancelan entre ellas de una forma muy especial; están ajustadas para conspirar de tal manera que las partículas se comportan como partículas ordinarias cuando se vuelven a colocar el microscopio en la escala de ampliación ordinaria. Si en nuestras ecuaciones matemáticas cualquiera de estas constantes fueran reemplazadas por un número ligeramente diferente, la mayoría de las partículas obtendrían inmediatamente masas comparables a las gigantescas energías que son relevantes en el dominio de las muy altas energías. El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural.

Los ajustes finos del universo

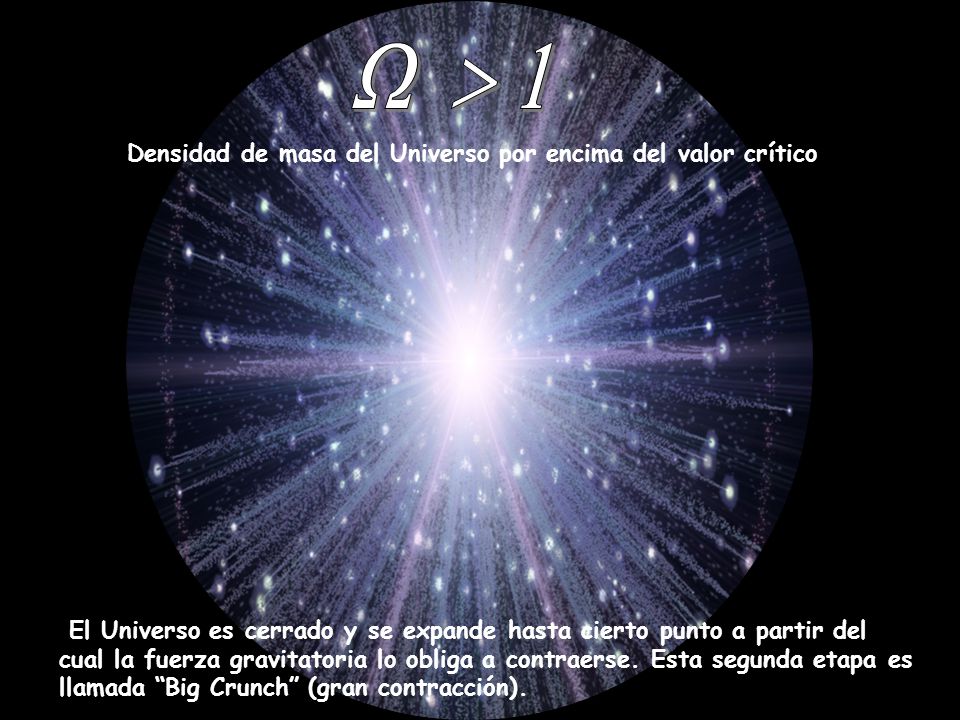

“Si uno se pone a examinarlo con detalle, resulta que el universo está maravillosamente ajustado para poder permitir la vida. A esto se le llama el problema del fine tuning o ajuste fino del universo. Normalmente, por ajuste fino se suele entender el hecho de que los valores de ciertas constantes, de ser ligeramente modificados, incluso muy ligeramente modificados, tendrían como resultado que la vida compleja como nosotros sería imposible.

Hugh Ross

Quizá el ejemplo más claro sea el de los valores de las fuerzas fundamentales (gravitatoria, nuclear débil, nuclear fuerte y electromagnética). Según Hugh Ross, una fuerza gravitatoria un poco más débil impediría estrellas como nuestro Sol; todas las estrellas que podrían formarse serían bastante más masivas y consumirían su combustible muchísimo antes de que la vida compleja pudiera emerger. Por otro lado, una fuerza de la gravedad más intensa no permitiría estrellas como el Sol, todas las estrellas serían muy ligeras e incapaces de sintetizar los elementos más pesados que la vida necesita. La fuerza nuclear fuerte también está increíblemente bien ajustada: un poco más fuerte y todo el hidrógeno se habría consumido al principio del universo, impidiendo la formación de estrellas con una vida larga; un poco más débil y muchos de los elementos químicos actuales serían radiactivos, con evidentes consecuencias negativas para la vida. Pueden encontrarse más ejemplos en la página de Wikipedia sobre el problema del ajuste fino (donde he sacado mucha información). El astrofísico Martin Rees, en su libro Solo seis números, determinó que en esencia eran 6 los parámetros (constantes universales o combinación de ellas) que si hubiesen variado siquiera un mínimo habrían impedido la vida:

–

, la relación entre la fuerza electromagnética y la gravitatoria. Además de los problemas asociados con la evolución estelar ya mencionados, si N fuera más pequeña, el universo se hubiera expandido y re-contraído muy rápidamente, sin permitir la formación de entidades complejas.

–

, mide la eficiencia del hidrógeno para convertirse en helio en las reacciones nucleares en las estrellas. Cuatro átomos de hidrógeno se convierten en uno de helio y se libera un 0.7 % de energía. Si

fuera 0.006 (una variación de una parte en diez mil) solo existiría el hidrógeno, con lo que toda química mínimamente compleja sería imposible. Por encima de un valor de 0.008 no existiría hidrógeno ya que la reacción sería «demasiado eficiente» y se habría fusionado todo poco después del Big Bang (con respecto a este valor de 0.008 hay que decir que hay autores que consideran que la horquilla es un poco más amplia).

no es una constante fundamental del universo, viene determinada por el valor de la fuerza nuclear fuerte (la que mantiene ligados a los protones y neutrones, es decir, a los quarks en el interior de los átomos).

–

. La letra griega omega indica la densidad del universo. Es el cociente entre la fuerza de contracción (la gravedad) y la energía de expansión. Con una

el universo se habría contraído rápidamente sobre sí mismo, volviendo a un estado similar al del Big Bang; con una

la gravedad es tan débil que no se forman estrellas. El valor medido está increíblemente próximo a 1, es decir, a la planitud.

–

.

mide el valor de la constante cosmológica (la energía que hay en el vacío) dividida por la densidad crítica del universo (la

de antes, que en su valor crítico es 1). En unidades naturales (las llamadas unidades de Planck) la constante cosmológica tiene un valor increíblemente pequeño, de modo tal que la expansión del universo es irrelevante para las escalas habituales en las que vivimos (no vemos que en nuestro mundo los objetos estén cada día más lejos de donde los dejamos la noche anterior). Con un valor no tan pequeño, las estrellas no podrían formarse. Curioso: si seguimos la teoría cuántica de campos, obtenemos para la energía del vacío un valor 120 órdenes de magnitud (

) más alto que lo que medimos para la constante cosmológica; si esto fuera así no habría estrellas y el universo se estaría expandiendo a una velocidad alucinante (de hecho, no estaríamos aquí para observarlo); a esto se le llama el problema de los 120 órdenes de magnitud y se ha dicho que es la peor predicción de la historia de la Física.

–

, Rees introdujo este poco conocido parámetro para estimar cuánta energía habría que usar para disociar por completo una galaxia utilizando su masa como energía (

). Más pequeño indicaría que no se podrían formar estrellas, más grande y el universo sería demasiado violento como para poder sobrevivir en él.

–

. El número de dimensiones espaciales es, como todos sabemos, de 3. Con más o menos dimensiones la vida no podría existir; entre otros argumentos, las órbitas de los planetas, por ejemplo, solo son estables en 3 dimensiones, de lo contrario los planetas acabarían colapsando sobre las estrellas. (Esto no excluye las dimensiones microscópicas que postulan algunas teorías como la teoría de cuerdas).

Este maravilloso ajuste del universo es un problema bastante complejo de resolver. Por un lado, uno puede apelar a la presencia de un Ser Superior que ha favorecido la vida. Desde una perspectiva más secular, algunos apelan al multiverso, esto es, una infinidad de universos de entre los cuales la vida solo es capaz de prosperar en unos pocos. En esta línea va el pensamiento que se conoce como Principio Antrópico, que viene a decir algo así como que el universo es como es porque si fuera de otra manera no tendría observadores para preguntarse por qué es como es. Este razonamiento circular, tautológico, no gusta a casi nadie, y con razón. Algunos científicos, como David Deutsch, creen que existe una explicación, aunque nosotros no podemos ni imaginarla ahora mismo. Otros son algo más escépticos.”

La doble hélice, es una especie de cuerda de dos hilos enredados uno alrededor del otro, ambos constituidos por 4 moléculas llamadas: adenina (A), timina (T), guanina (G) y citosina (C). Sin el ajuste fino no podría ser posible.

¿Implica el ajuste fino un diseño con propósito? Hay tantos parámetros que deben tener un ajuste fino y el grado de ajuste fino es tan alto, que no parece posible ninguna otra conclusión.

Bueno, quizá en la imagen y el comentario que lleva abajo, me he podido pasar un poco. Lo que antes decía: “El hecho de que todas las partículas tengan masa que corresponden a energías mucho menores repentinamente llega a ser bastante poco natural”, es lo que se llama el “problema del ajuste fino”. Vistas a través del microscopio, las constantes de la Naturaleza parecen estar cuidadosamente ajustadas sin ninguna otra razón aparente que hacer que las partículas parezcan lo que son. Hay algo muy erróneo aquí. Desde un punto de vista matemático, no hay nada que objetar, pero la credibilidad del Modelo estándar se desploma cuando se mira a escalas de tiempo y longitud extremadamente pequeñas o, lo que es lo mismo, si calculamos lo que pasaría cuando las partículas colisionan con energías extremadamente altas.

¿Y por qué debería ser el modelo válido hasta ahí? Podrían existir muchas clases de partículas súper pesadas que no han nacido porque se necesitan energías aún inalcanzables, e ellas podrían modificar completamente el mundo que Gulliver planeaba visitar. Si deseamos evitar la necesidad de un delicado ajuste fino de las constantes de la Naturaleza, creamos un nuevo problema:

Tres tipo de Ajuste Fino para la vida

La evidencia para el ajuste fino del universo es de tres tipos:

- El ajuste fino de las leyes de la naturaleza.

- El ajuste fino de las constantes físicas.

- El ajuste fino de la distribución inicial de la masa-energía del universo en el momento del Big Bang.

El Ajuste Fino de las Leyes de la Naturaleza

Cuando hablamos sobre el ajuste fino de las leyes de la naturaleza queremos decir que el universo debe tener precisamente el conjunto adecuado de leyes con el fin de que exista vida altamente compleja.

Ejemplos:

- Existencia de la Gravedad.

- Existencia de la Fuerza Electromagnética.

- Existencia de la Fuerza Nuclear Fuerte.

- Existencia del Principio de Cuantificación.

- Existencia del Principio de Exclusión de Pauli.

El Ajuste Fino de las constantes físicas

Por las constantes físicas, nos referimos a los números fundamentales que se producen en las leyes de la física, los cuales muchos de éstos deben estar ajustados con precisión en un grado extraordinario para que la vida se produzca.

Por ejemplo, tomemos la Constante Gravitacional —designado por G— la cual determina la fuerza de la gravedad a través de la Ley de la Gravedad de Newton:

Donde F es la fuerza entre dos masas, m1 y m2, que están a una distancia r de diferencia. Si aumentas o disminuyes G entonces la fuerza de la gravedad correspondientemente aumentará o disminuirá. (El valor real de G es 6,67 x 10-11 Nm2 / kg2.)

Ahora, para darnos una idea de qué tan finamente ajustada es la fuerza de la gravedad indicada por G debemos primero mirar el rango de las fuerzas fundamentales en la naturaleza:

Observa que la Fuerza Nuclear Fuerte es de 10 000 sextillones[1] de veces la Fuerza de la Gravedad. ¿Demasiado complicado? Bien, hagamos esto más digerible. Imagina que tienes una regla lo suficientemente grande para extenderla a través de todo el universo, ahora colocaremos los puntos en donde se localizarían la Fuerza de Gravedad y la Fuerza Nuclear Fuerte. Tendríamos algo así:

Retomemos el hilo que veo pasar una mosca y la sigo, la sigo, la sigo hasta no saber donde estoy.

¿Cómo podemos modificar el Modelo Estándar de tal manera que el ajuste-fino no sea necesario? Está claro que las modificaciones son necesarias , lo que implica que muy probablemente hay un límite más allá del cual el modelo deja de ser válido. El Modelo Estándar no será más que una aproximación matemática que hemos sido capaces de crear, tal que todos los fenómenos observados hasta el presente están de acuerdo con él, pero cada vez que ponemos en marcha un aparato más poderoso, debemos esperar que sean necesarias nuevas modificaciones para ir ajustando el modelo, a la realidad que descubrimos.

El hallazgo de una partícula que crearía nueva Física

¿Cómo hemos podido pensar de otra manera? ¿Cómo hemos tenido la “arrogancia” de pensar que podemos tener la teoría “definitiva”? Mirando las cosas de esta manera, nuestro problema ahora puede muy bien ser el opuesto al que plantea la pregunta de dónde acaba el modelo estándar: ¿Cómo puede ser que el modelo estándar funcione tan extraordinariamente bien? y ¿por qué aún no hemos sido capaces de percibir nada parecido a otra generación de partículas y fuerzas que no encajen en el modelo estándar?

Asistentes escuchan la presentación de los resultados del experimento ATLAS, durante el seminario del Centro Europeo de Física de Partículas (CERN) para presentar los resultados de los dos experimentos paralelos que buscan la prueba de la existencia de la “partícula de Higgs”, base del modelo estándar de física, hoy miércoles 4 de julio en Meyrin, Suiza.

La pregunta “¿Qué hay más allá del Modelo estándar”? ha estado fascinando a los físicos durante años. Y, desde luego, todos sueñan con llegar a saber, qué es lo que realmente es lo que conforma el “mundo” de la materia, qué partículas, cuerdas o briznas vibrantes. En realidad, lo cierto es que, la Física que conocemos no tiene que ser, necesariamente, la verdadera física que conforma el mundo y, sí, la física que conforma “nuestro mundo”, es decir, el mundo al que hemos podido tener acceso hasta el momento y que, no necesariamente tiene que tratarse del mundo real.

O, como decía aquél: ¡Que mundo más hermoso, parece de verdad!

No todo lo que vemos es, necesariamente, un reflejo de la realidad de la Naturaleza que, puede tener escondidos más allá de nuestras percepciones, otros escenarios y otros objetos, a los que, por ahora, no hemos podido acceder, toda vez que, físicamente tenemos carencias, intelectualmente también, y, nuestros conocimientos avanzar despacio para conseguir, nuevas máquinas y tecnologías nuevas que nos posibiliten “ver” lo que ahora nos está “prohibido” y, para ello, como ocurre siempre, necesitamos energías de las que no disponemos.

Hay dos direcciones a lo largo de las cuales se podría extender el Modelo estándar, tal como lo conocemos actualmente, que básicamente se caracterizan así:

– Nuevas partículas raras y nuevas fuerzas extremadamente débiles, y

– nuevas partículas pesadas y nuevas estructuras a muy altas energías.

Podrían existir partículas muy difíciles de producir y de detectar y que, por esa razón, hayan pasado desapercibidas hasta ahora. La primera partícula adicional en la que podríamos pensares un neutrino rotando a derecha. Recordaremos que si se toma el eje de rotación paralelo a la dirección del movimiento los neutrinos sólo rotan a izquierdas pero, esa sería otra historia.

En un artículo editado en Ciencia Kanija, pude leer:

“Los interferómetros atómicos tienen ahora la sensibilidad para observar nuevas fuerzas más allá del modelo estándar de la física de partículas. “Las nuevas fuerzas a corta distancia son una predicción frecuente de las teorías más allá del Modelo Estándar y la búsqueda de estas nuevas fuerzas es un canal prometedor para descubrir una nueva física”, dice Jay Wackerdel Laboratorio del Acelerador Nacional SLAC en California. La pregunta es cómo encontrarlas”

Los neutrinos siempre me han fascinado. Siempre se han manifestado como si tuvieran masa estrictamente nula. Parece como si se movieran exactamente con la velocidad de la luz. Pero hay un límite para la precisión de nuestras medidas. Si los neutrinos fueran muy ligeros, por ejemplo, una cienmillonésima parte de la masa del electrón, seríamos incapaces de detectar en el laboratorio la diferencia entre éstos y los neutrinos de masa estrictamente nula. Pero, para ello, el neutrino tendría que tener una componente de derechas.

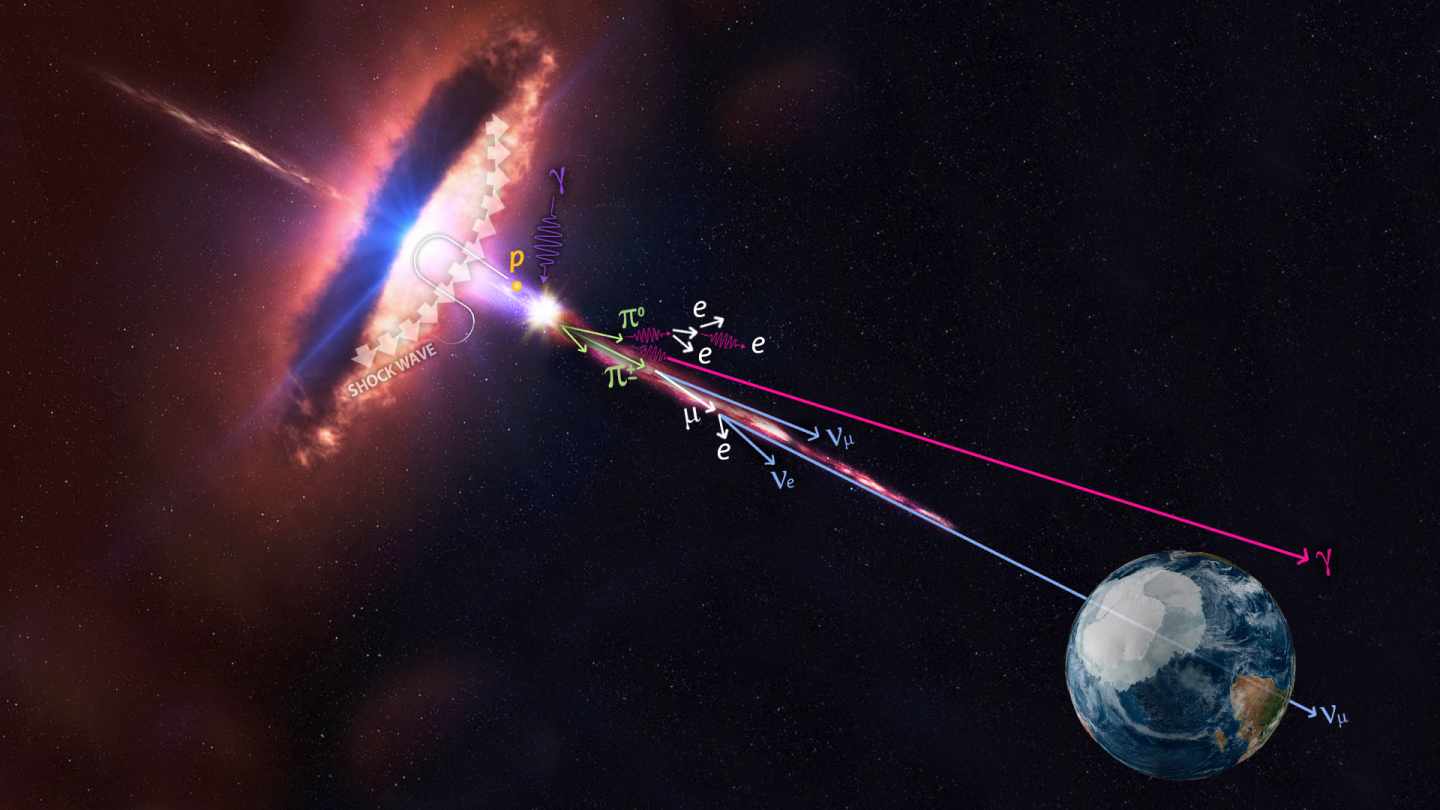

En este punto, los astrónomos se unen a la discusión. No es la primera vez, ni será la última, que la astronomía nos proporciona información esencial en relación a las partículas elementales. Por ejemplo, debido a las interacciones de corriente neutra (las interacciones débiles originadas por un intercambio Zº), los neutrinos son un facto crucial en la explosión supernova de una estrella. Ahora sabemos que debido a las interacciones por corriente neutra, pueden colisionar con las capas exteriores de la estrella y volarlas con una fuerza tremenda.

En realidad, los neutrinos nos tienen mucho que decir, todavía y, no lo sabemos todo acerca de ellos, sino que, al contrario, son muchos los datos y fenómenos que están y subyacen en ellos de los que no tenemos ni la menor idea que existan o se puedan producir. Nuestra ignorancia es grande, y, sin embargo, no nos arredra hablar y hablar de cuestiones que, la mayoría de las veces…ni comprendemos.

Aquí lo dejaré por hoy, el tema es largo y de una fascinación que te puede llevar a lugares en los que no habías pensado al comenzar a escribir, lugares maravillosos donde reinan objetos exóticos y de fascinante porte que, por su pequeñez, pueden vivir en “mundos” muy diferentes al nuestro en los que, ocurren cosas que, nos llevan hacia el asombro y también, a ese mundo mágico de lo fascinante y maravilloso.

¡Cuanta complejidad para que nuestra limitada capacidad intelectual la pueda desmenuzar! Pero, se hace lo que se puede.

Emilio Silvera Vázquez

Totales: 75.249.136

Totales: 75.249.136 Conectados: 53

Conectados: 53

![La METAFÍSICA de Aristóteles - [RESUMEN fácil + VÍDEOS y EJERCICIO]](https://cdn0.unprofesor.com/es/posts/7/1/5/la_metafisica_de_aristoteles_517_orig.jpg)