Sep

6

Física, la era cuántica, ese “mundo” fascinante

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

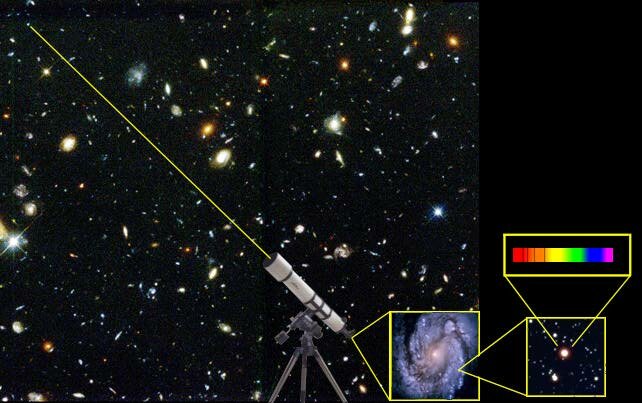

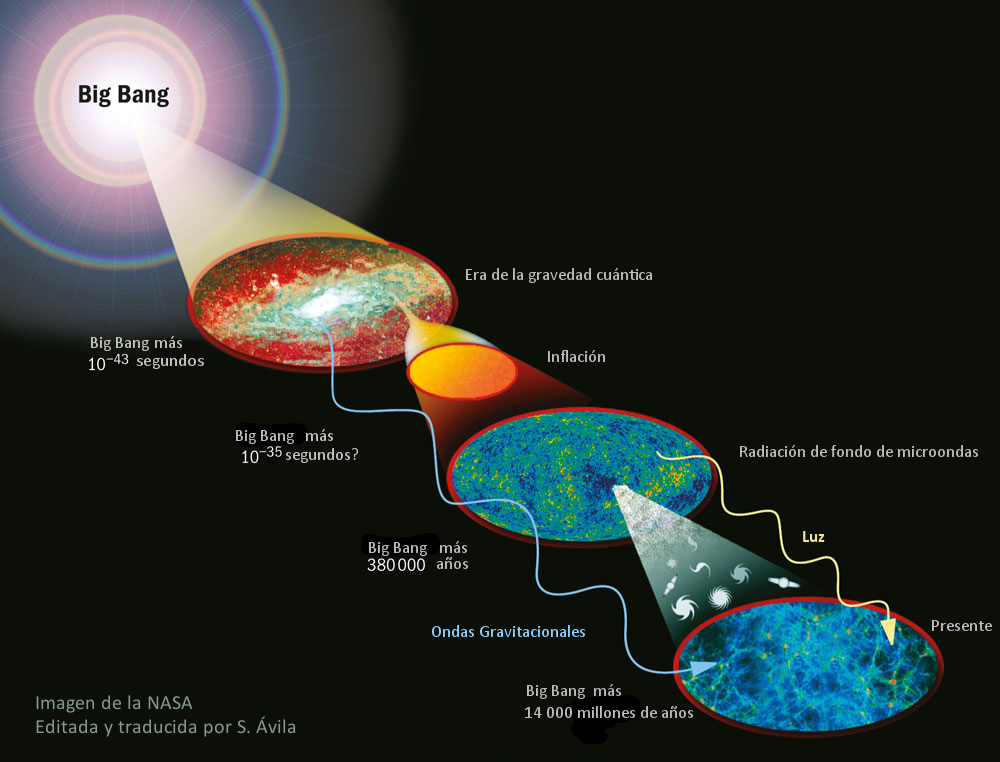

Los científicos para lograr conocer la estructura del universo a su escala más grande, deben retroceder en el tiempo, centrando sus teorías en el momento en que todo comenzó. Para ello, como todos sabeis, se han formulado distintas teorías unificadoras de las cuatro fuerzas de la naturaleza, con las cuales se han modelado acontecimiento y en el universo primitivo casi a todo lo largo del camino hasta el principio. Pero cómo se supone que debió haber habido un «antes», aparece una barrera que impide ir más allá de una frontera que se halla fijada a los 10-43 [s] después del Big Bang, un instante conocido como « de Planck», en homenaje al físico alemán Max Planck.

Esta barrera existe debido a que antes del momento de Planck, durante el período llamado la «era de Planck o cuántica», se supone que las cuatro fuerza fundamentales conocidas de la naturaleza eran indistinguibles o se hallaban unificadas , que era una sola fuerza. Aunque los físicos han diseñado teorías cuánticas que unen tres de las fuerzas, una por una, a través de eras que se remontan al momento de Planck, hasta les ha sido prácticamente imposible armonizar las leyes de la teoría cuántica con la gravedad de la relatividad general de Einstein, en un sólo modelo teórico ampliamente convincente y con posibilidades claras de ser contrastado en experimentos de laboratorio y, mucho , con observaciones.

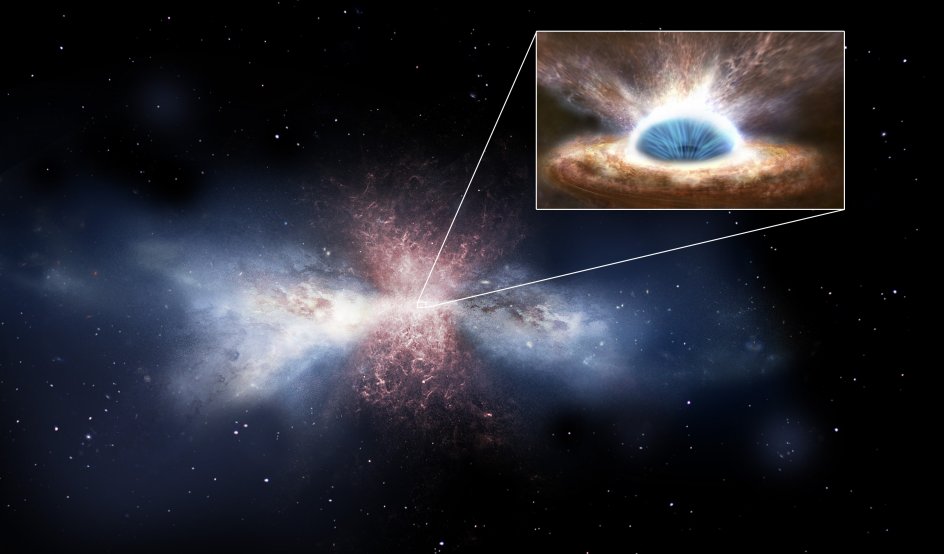

Si hablamos de singularidades en agujeros negros, debemos dejar la R.G. y acudir a la M.C. “…según las leyes de la Relatividad, el eje más horizontal siempre es espacio, mientras que el más vertical siempre es tiempo. Por tanto, al cruzar el horizonte lo que nosotros entendemos por tiempo y espacio ¡habrán intercambiado sus papeles! sonar raro y, definitivamente, es algo completamente anti intuitivo, pero es la clave de que los agujeros negros sean son y jueguen el papel tan importante que juegan en la física teórica actual. Al fin y al cabo, dentro no es lo mismo que fuera…”

Si queremos cuantizar, es decir encontrar la versión cuántica, la gravedad escrita como RG lo que tenemos que hacer es encontrar la teoría cuántica para la métrica. Sin embargo, esto no conduce a una teoría apropiada, surgen muchos problemas para dar sentido a esta teoría, aparecen infinitos y peor que eso, muchos cálculos no tienen ni tan siquiera un sentido claro. Así que hay que buscar otra forma de intentar llegar a la teoría cuántica.

Como tantas veces hemos comentado, los trabajos que se han realizado sobre poder construir una teoría cuántica de la gravedad nos llevan a un sorprendente de implicaciones. Por un lado, sólo se ha podido conceptuar a la gravedad cuántica, siempre y cuando, el universo tenga más de cuatro dimensiones. Además, se llega a considerar que en la era de Planck, tanto el universo como la gravedad pudieron ser una sola cosa compacta estructurada por objetos cuánticos infinitamente diminutos, como los que suponemos que conforman las supercuerdas. A esta escala, el mismísimo espaciotiempo estaría sometido a imprescindibles fluctuaciones muy semejantes a las que causan las partículas al nacer y desaparecer de la existencia en el espacio.tiempo ordinario. Esta noción ha conducido a los teóricos a describir el universo de la era cuántica como una especie de extremadamente densa y agitada espuma que pudo haber contenido las vibrantes cuerdecillas que propugnan los cosmólogos cuerdistas.

Los físicos especulan que el cosmos ha crecido a una «nada» primigenia que al nacer comenzó el principio del tiempo y que, en ese parto, contenía toda la materia y toda la energía.

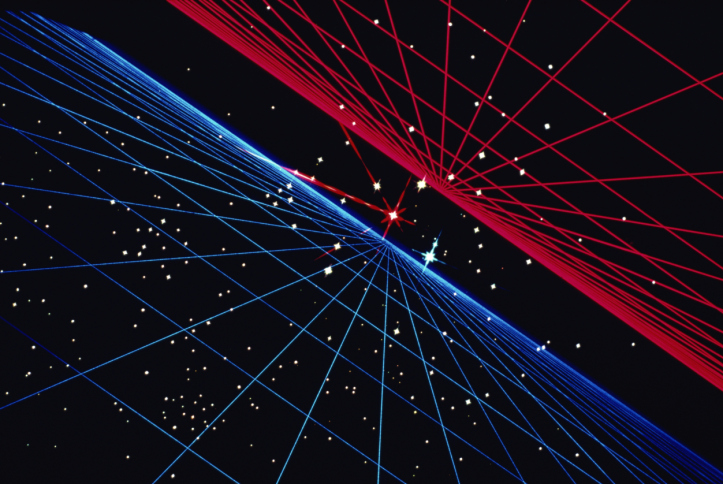

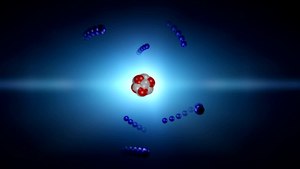

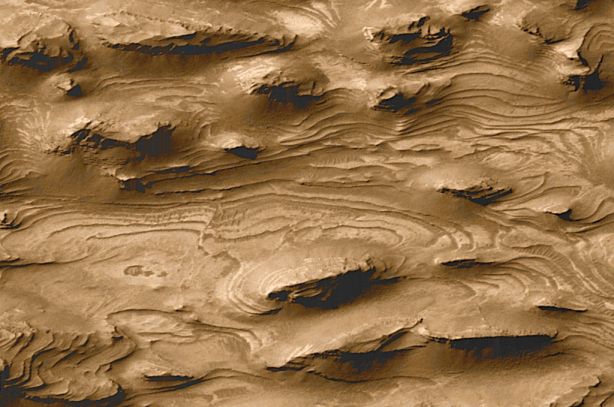

Según los primeros trabajos sobre la teoría cuántica de la gravedad, el propio espaciotiempo varió en su topografía, dependiendo de las dimensiones del universo niño. Cuando el universo era del tamaño de un núcleo atómico (ver imagen de abajo), las eran relativamente lisas y uniformes; a los 10-30cm (centro) es evidente una cierta granulidad; y a la llamada longitud de Planck, todavía unas 1.000 veces más pequeño (abajo), el espacio tiempo fluctúa violentamente.

Los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Los físicos no están seguros si el problema es técnico o conceptual. No obstante, incluso prescindiendo de una teoría completa de gravedad cuántica, se deducir que los efectos de la teoría cuántica, habrían sido cruciales durante los primeros 10-43 segundos del inicio del universo, éste tenía una densidad de 1093 gramos por centímetro cúbico y mayor. (El plomo sólido tiene una densidad de aproximadamente diez gramos por centímetro cúbico.) Este período, que es el que corresponde a la era de Planck, y a su estudio se le llama cosmología cuántica. Como el universo en su totalidad habría estado sujeto a grandes incertidumbres y fluctuaciones durante la era de Planck o era cuántica, con la materia y la energía apareciendo y desapareciendo de un vacío en grandes cantidades, el concepto de un principio del universo podría no tener un significado bien definido. En todo caso, la densidad del universo durante este período es de tal magnitud que escapa a nuestra comprensión. Para propósitos prácticos, la era cuántica podría considerarse el estado inicial, o principio, del universo. En consecuencia, los procesos cuánticos ocurridos durante este período, cualquiera sea su naturaleza, determinaron las iniciales del universo.

Dicen haber descubierto la estructura más grande del Universo. Se trata de una «gran muralla» de 10.000 millones de años luz de un extremo a otro, que pone en jaque lo que creíamos saber sobre la distribución de la materia. De todas las maneras nada de esto es sorprendente. El Universo es muy grande y en su vastedad esconde secretos que debemos resolver.

El universo estaba a 3.000° K hace doce mil quinientos millones de años; a 10 mil millones de grados (1010° K) un millón de años , y, tal vez, a 1028° K un par de millones más temprano. Pero, y antes de ese tiempo ¿qué pasaba? Los fósiles no faltan, pero no sabemos interpretarlos. Mientras más elevada se va haciendo la temperatura del universo primigenio, la situación se va complicando los científicos. En la barrera fatídica de los 1033° K –la temperatura de Planck–, nada funciona. Nuestros actuales conocimientos de la física dejan de ser útiles. El comportamiento de la materia en estas condiciones tan extremas deja de estar a nuestro alcance de juicio. Peor aún, nuestras nociones tradicionales pierden su valor. Es una barrera infranqueable para el saber de la física contemporánea. Por eso, lo que se suele decir cómo era el universo inicial en esos tempranos períodos, no deja de tener visos de especulación.

Los progresos que se han obtenido en física teórica se manifiestan a menudo en términos de síntesis de campos diferentes. Varios son los ejemplos que de ello encontramos en diversos estudios especializados, que hablan de la unificación de las fuerzas fundamentales de la naturaleza.

En física se cuentan con dos grandes teorías de éxito: la cuántica y la teoría de la relatividad general.

Grande y pequeño: ¡Todo la misma cosa!

Cada una de ellas ha demostrado ser muy eficiente en aplicaciones dentro de los límites de su ámbito propio. La teoría cuántica ha otorgado resultados más que satisfactorios en el estudio de las radiaciones, de los átomos y de sus interacciones. La ciencia contemporánea se presenta como un conjunto de teorías de campos, aplicables a tres de las grandes interacciones: electromagnética, nuclear fuerte, nuclear débil. Su poder predictivo es bastante elocuente, pero no universal. Esta teoría es, por , incapaz de describir el comportamiento de partículas inmersas en un campo de gravedad intensa. Ahora, no sabemos si esos fallos se deben a un problema conceptual de fondo o falta de capacidad matemática para encontrar las ecuaciones precisas que permitan la estimación del comportamiento de las partículas en esos ambientes.

La teoría de la relatividad general, a la inversa, describe con gran precisión el efecto de los campos de gravedad sobre el comportamiento de la materia, pero no sabe explicar el ámbito de la mecánica cuántica. Ignora todo acerca de los campos y de la dualidad onda-partícula, y en ella el «vacío» es verdaderamente vacío, mientras que la física cuántica hasta la «nada» es «algo»…

Nada está vacío, ya que, de donde surge es porque había

Claro está, que esas limitaciones representativas de ambas teorías no suelen tener mucha importancia práctica. Sin embargo, en algunos casos, esas limitantes se hacen sentir con agresividad frustrando a los físicos. Los primeros instantes del universo son el ejemplo más elocuente.

El científico investigador, al requerir estudiar la temperatura de Planck, se encuentra con un cuadro de densidades y gravedades extraordinariamente elevadas. ¿Cómo se comporta la materia en esas ? Ambas teorías, no dicen mucho al respecto, y entran en serias contradicciones e incompatibilidades. De ahí la resistencia de estas dos teorías a unirse en una sólo teoría de Gravedad-Cuantíca, ya que, cada una de ellas reina en un universo diferente, el de lo muy grande y el de lo muy pequeño.

Todo se desenvuelve alrededor de la noción de localización. La teoría cuántica limita nuestra aptitud asignar a los objetos una posición exacta. A cada partícula le impone un volumen mínimo de localización. La localización de un electrón, por ejemplo, sólo puede definirse alrededor de trescientos fermis (más o menos un centésimo de radio del átomo de hidrógeno). , si el objeto en cuestión es de una mayor contextura másica, más débiles son la dimensión de este volumen mínimo. Se puede localizar un protón en una esfera de un décimo de fermi, pero no mejor que eso. Para una pelota de ping-pong, la longitud correspondiente sería de 10-15 cm, o sea, bastante insignificante.La física cuántica, a toda partícula de masa m le asigna una longitud de onda Compton: lc = h / 2p mc

Por su , la relatividad general igualmente se focaliza en la problemática del lugar que ocupan los objetos. La gravedad que ejerce un cuerpo sobre sí mismo tiende a confinarlo en un espacio restringido. El caso límite es aquel del agujero negro, que posee un campo de gravedad tan intenso que, salvo la radiación térmica, nada, ni siquiera la luz, escapársele. La masa que lo constituye está, según esta teoría, irremediablemente confinada en su interior.

En lo que hemos inmediatamente descrito, es donde se visualizan las diferencias esos dos campos del conocimiento. Uno alocaliza, el otro localiza. En general, esta diferencia no presenta problemas: la física cuántica se interesa sobre todo en los microobjetos y la relatividad en los macro-objetos. Cada cual en su terreno.

Vista de detalle, macro de una ronda simétrico de flor de la Pasionaria

Sin embargo, ambas teorías tienen una frontera común entrar en dificultades. Se encuentran objetos teóricos de masa intermedia entre aquella de los microobjetos como los átomos y aquella de los macro-objetos como los astros: las partículas de Planck. Su masa es más o menos la de un grano de sal: 20 microgramos. Equivale a una energía de 1028 eV o, más aún, a una temperatura de 1033° K. Es la «temperatura de Planck».

bien, si queremos estimar cuál debería ser el radio en que se debe confinar la masita de sal para que se vuelva un agujero negro, con la relatividad general la respuesta que se logra encontrar es de que sería de 10-33 cm, o sea ¡una cien mil millonésima de mil millonésima de la dimensión del protón! Esta dimensión lleva el de «radio de Planck». La densidad sería de ¡1094 g/cm3! De un objeto así, comprimido en un radio tan, pero tan diminuto, la relatividad general sólo nos señala que tampoco nada puede escapar de ahí. No es mucha la información.

Si recurrimos a la física cuántica estimar cuál sería el radio mínimo de localización para un objeto semejante al granito de sal, la respuesta que encontramos es de un radio de 10-33 cm. Según teoría, en una hipotética experiencia se lo encontrará frecuentemente fuera de ese volumen. ¡Ambos discursos no son coincidentes! Se trata de discrepancias que necesitan ser conciliadas para poder progresar en el conocimiento del universo. ¿Se trata de entrar en procesos de revisión de ambas teoría, o será necesaria una absolutamente nueva? Interrogantes que solamente el devenir de la evolución de la física teórica las podrá responder en el futuro.

De todas las maneras, en lo que se refiere a una Teoría cuántica de la Gravedad, tendremos que esperar a que se confirmen las teorías de supergravedad, supersimetría, cuerdas, la cuerda heterótica, supercuerdas y, la compendiada por Witten Teoría M. Aquí, en estas teorías (que dicen ser del futuro), sí que están apaciblemente unidas las dos irreconciliables teorías: la cuántica y la relativista, no sólo no se rechazan ni emiten infinitos, sino que, se necesitan y complementan para formar un todo armónico y unificador.

¡Si pudiéramos verificarla!

, contar con la energía de Planck (1019 GeV), no parece que, al menos de , sea de este mundo. Ni todos los aceleradores de partículas del mundo unidos, podrían llegar a conformar una energía semejante.

Aunque de extraña y atípica figura, también, galaxia, está hecha de materia

Tiene y encierra tantos misterios la materia que estamos aún a muchos años-luz de saber y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material desde las partículas elementales hasta las montañas y los océanos. Unas veces está en “inerte” y otras, se eleva hasta la vida que incluso, en ocasiones, alcanza la consciencia de SER. Sin embargo, no acabamos de dilucidar de dónde viene su verdadero origen y que era antes de “ser” materia. ¿Existe acaso una especie de sustancia cósmica anterior a la materia? Y, si realmente existe esa sustancia… ¿Dónde está? Aristóteles la llamaba Ylem, la sustancia o materia cósmica antes de la materia, a partir del Ylem llegaría la materia bariónica, la ue conocemos y de la que todo está hecho.

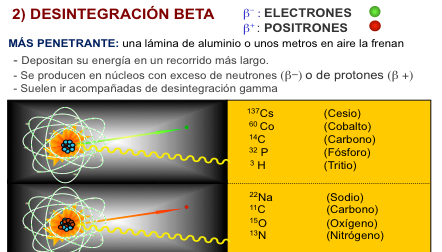

Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Sí, sabemos ponerles etiquetas , por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránicos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobrepasando a la emisión de partículas alfa.

¡Parece que la materia está viva!

Son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lepto que significa “delgado”).

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54)x10-31kg la primera y, 1,602 177 33 (49)x10-19 culombios, la segunda, y su radio clásico. No se ha descubierto aún ninguna partícula que sea menos masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que es la que se muestra en el electrón.

Josepth John Thomson

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí .

(“Aunque no se trata propiamente de la imagen real de un electrón, un equipo de siete científicos suecos de la Facultad de Ingeniería de la Universidad de Lund consiguieron captar en vídeo por primera vez el movimiento o la distribución energética de un electrón sobre una onda de luz, tras ser desprendido previamente del átomo correspondiente.

Previamente dos físicos de la Universidad Brown habían mostrado películas de electrones que se movían a través de helio líquido en el International Symposium on Quantum Fluids and Solids del 2006. Dichas imágenes, que mostraban puntos de luz que bajaban por la pantalla fueron publicadas en línea el 31 de mayo de 2007, en el Journal of Low Temperature Physics.

En el experimento que ahora nos ocupa y dada la altísima velocidad de los electrones el equipo de investigadores ha tenido que usar una nueva tecnología que genera pulsos cortos de láser de luz intensa (“Attoseconds Pulses”), habida que un attosegundo equivalente a la trillonésima parte de un segundo”.)

¡No por pequeño, se es insignificante! Recordémoslo, todo lo grande está hecho de cosas pequeñas.

Louis de Broglie

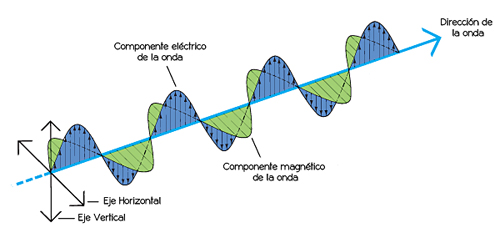

En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones.)

Imagen ilustrativa de la dualidad onda-partícula, en el cual se puede ver cómo un mismo fenómeno puede tener dos percepciones distintas. Esta manifestación en de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”.

El fotón una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se definir lo que es el espín? Los fotones toman en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin ) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm. De longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en de ondas), desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegare a captar la cienmillonésima parte de un centímetro.

Joseph Weber

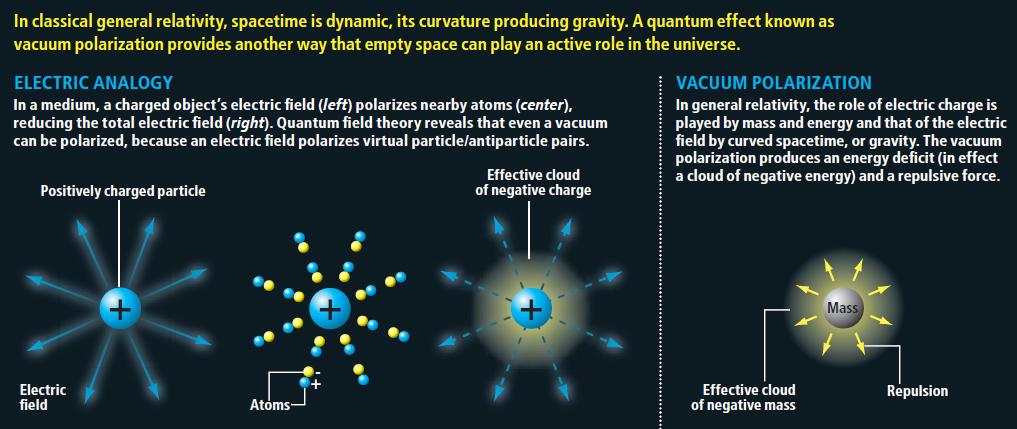

El interferómetro funciona enviando un haz de luz que se separa en dos haces; éstos se envían en direcciones diferentes a espejos donde se reflejan de regreso, entonces los haces al combinarse presentarán interferencia.

Las débiles ondas de los gravitones, que producen del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitatorias. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaran el hallazgo de Weber.

De todas formas, no creo que, a estas alturas, nadie pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es cero, su carga es cero, y su espín de 2. el fotón, no antipartícula, ellos mismos hacen las dos versiones.

Tenemos que volver a los que posiblemente son los objetos más misteriosos de nuestro Universo: Los agujeros negros. Si estos objetos son lo que se dice (no parece que se pueda objetar nada en contrario), seguramente serán ellos los que, finalmente, nos faciliten las respuestas sobre las ondas gravitacionales y el esquivo gravitón.

Imagen de un agujero negro en el núcleo de una galaxia arrasando otra próxima- NASA

La onda gravitacional emitida por el agujero negro produce una ondulación en la curvatura del espacio-temporal que viaja a la velocidad de la luz transportada por los gravitones. Tenemos varios proyectos en marcha de la NASA y otros Organismos oficiales que buscan las ondas gravitatorias de los agujeros negros, de colisiones estrellas de neutrones y de otras fuentes análogas que, según se cree, nos hablará de “otro universo”, es decir, nos dará información desconocida hasta y sabremos “ver” un universo distinto al reflejado por las ondas electromagnéticas que es el que ahora conocemos.

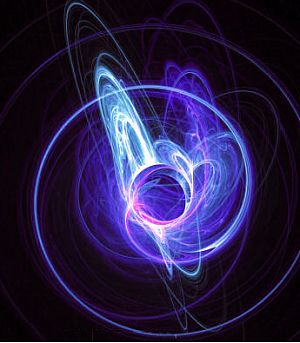

¿Espuma cuántica? Si profundizamos mucho en la materia…

Hay aspectos de la física que me dejan totalmente sin habla, me obligan a pensar y me transporta de mundo material nuestro a otro fascinante donde residen las maravillas del Universo. Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el espacio tal lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) un papel clave en la entropía de un agujero negro.

es la escala de longitud por debajo de la cual el espacio tal lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) un papel clave en la entropía de un agujero negro.

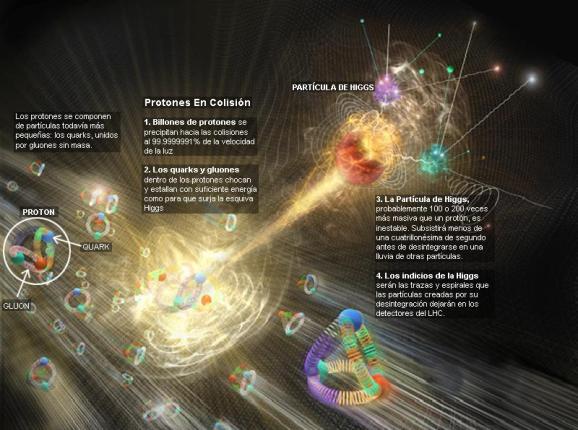

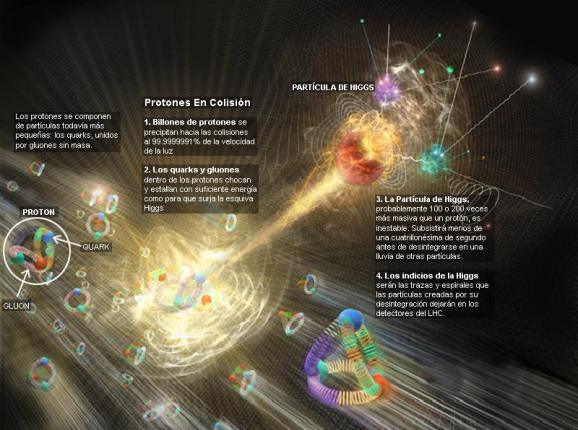

“Una investigación ha llevado a pensar que, la materia se construye sobre fundamentos frágiles. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vació cuántico. Los investigadores simularon la frenética actividad que sucede en el interior de los protones y neutrones, que sabéis son las partículas que aportan casi la totalidad de la masa a la materia común. Estas dos partículas, protones y neutrones, se comportan como si en su interior, los quarks de los que están hechas ambas partículas, lucharan por escapar del confinamiento a que se ven sometidos por la fuerza nuclear fuerte por medio de los Gluones que forman un océano en el que se ven confinados sin remedio. De hecho, nunca nadie ha podido ver a un quark libre.

Así que, si estudiamos el vacío cuántico, parece que eso permitirá a los físicos someter a prueba a la Cromo Dinámica Cuántica y buscar sus efectos más allá de la física conocida. Por , los cálculos demuestran que la QCD describe partículas basadas en quarks de precisa, y que la mayor parte de nuestra masa viene de quarks virtuales y gluones que burbujean en el vacío cuántico.

Se cree que el campo de Higgs hace también su pequeña contribución, dando masa a los quarks individuales, así como a los electrones y a otras varias partículas. El campo de Higgs también crea masa a partir del vacío cuántico, en forma de bosones virtuales de Higgs. De modo que si el LHC confirma la existencia del bosón de Higgs, eso significará que toda la realidad es virtual, es menos virtual de lo que se pensaba. No creo que hasta el momento, y, a pesar de las declaraciones salidas el CERN, se tenga la seguridad de haber detectado el Bosón de Higgs.

De todo lo anterior, no podemos obtener una respuesta cierta y científicamente probada de que todo eso sea así, más , los resultados indican que todo eso “podría ser así”, lo que ocurre es que, los científicos, a veces se dejan llevar por las emociones. Al fin y al cabo, ellos como el común de los mortales, también son humanos.

Ya nos gustaría saber cómo es, ese vacío cuántico y qué pasa allí

Me llama poderosamente la atención lo que conocemos las fluctuaciones de vacío, esas oscilaciones aleatorias, impredecibles e ineliminables de un campo (electromagnético o gravitatorio), que son debidas a un tira y afloja en el que pequeñas regiones del espacio toman prestada momentáneamente energía de regiones adyacentes y luego la devuelven. Hace un par de días que hablamos de ello.

Ordinariamente, definimos el vacío como el espacio en el que hay una baja presión de un gas, es decir, relativamente pocos átomos o moléculas. En ese sentido, un vacío perfecto no contendría ningún átomo o molécula, pero no se obtener, ya que todos los materiales que rodean ese espacio tienen una presión de vapor finita. En un bajo vacío, la presión se reduce hasta 10-2 pascales, mientras que un alto vacío una presión de 10-2-10-7 pascales. Por debajo de 10-7 pascales se conoce como un vacío ultra-alto.

No puedo dejar de referirme al vacío theta (vació θ) que, es el de vacío de un campo gauge no abeliano (en ausencia de campos fermiónicos y campos de Higgs). En el vacío theta hay un infinito de estados degenerados con efecto túnel entre estos estados. Esto significa que el vacío theta es análogo a una función de Bloch en un cristal.

Se derivar tanto como un resultado general o bien usando técnicas de instantón. Cuando hay un fermión sin masa, el efecto túnel estados queda completamente suprimido. Cuando hay campos fermiónicos con masa pequeña, el efecto túnel es mucho menor que campos gauge puros, pero no está completamente suprimido.

¡Es tanto lo que hay pero que no podemos ver!

Si buscamos por ahí podremos leer explicaciones como : “En la Teoría cuántica de campos, el vacío cuántico ( llamado el vacío) es el cuántico con la menor energía posible. Generalmente no contiene partículas físicas. El término “Energía de punto cero” es usado ocasionalmente como sinónimo para el vacío cuántico de un determinado campo cuántico.

De acuerdo a lo que se entiende actualmente por vacío cuántico o “ de vacío”, este “no es desde ningún punto de vista un simple espacio vacío” , y otra vez: “es un error pensar en cualquier vacío físico como un absoluto espacio vacío.” De acuerdo con la mecánica cuántica, el vacío cuántico no está verdaderamente vacío sino que contiene ondas electromagnéticas fluctuantes y partículas que saltan adentro y fuera de la existencia.

Según las modernas teorías de las partículas elementales, el vacío es un objeto físico, se puede cargar de energía y se puede convertir en varios estados distintos. Dentro de su terminología, los físicos hablan de vacíos diferentes. El de partículas elementales, su masa y sus interacciones están determinados por el vacío subyacente. La relación entre las partículas y el vacío es similar a la relación entre las ondas del sonido y la materia por la que se propagan. Los tipos de ondas y la velocidad a la que viajan varía dependiendo del material.”

Como nos dicen en este anuncio del Kybalion, nada es estático en el Universo y, todo está en continuo movimiento o vibración. Habréis oído hablar de la energía de punto cero que permanece en una sustancia en el cero absoluto (cero K). Está de acuerdo con la teoría cuántica, según la cual, una partícula oscilando con un movimiento armónico simple no tiene estado estacionario de energía cinética nula. Es más, el Principio de Incertidumbre no permite que esta partícula esté en reposo en el punto central exacto de sus oscilaciones. Del vacío surgen sin cesar partículas virtuales que desaparecen en fracciones de segundo, y, ya conocéis, por ejemplo, el Efecto Casimir en el que dos placas pueden producir energía negativa surgidas del vacío.

De todas las maneras, en momento sabemos tanto de la espuma cuántica como de nuestra presencia en el Universo, es decir, nada. Todo son conjeturas, suposiciones e hipótesis que nos hacen imaginar lo que pueda existir a la distancia de Planck. Claro que en una longitud de 10-35 metros, sí que es fácil imaginar que lo que podamos ver allí sería simplemente una especie de espuma cuántica asociada a lo que estimamos que sería la gravedad cuántica.

emilio silvera

Sep

5

¡La misteriosa Mecánica cuántica!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡Qué maravilla! Poder imaginar…y comprobar

El modelo estándar de la física de partículas es una teoría que describe las relaciones entre las interacciones fundamentales conocidas y las partículas elementales que componen toda la materia. Es una teoría cuántica de campos desarrollada entre 1970 y 1973 que es consistente con la mecánica cuánticay la relatividad especial. Hasta la fecha, casi todas las pruebas experimentales de las tres fuerzas descritas por el modelo estándar están de acuerdo con sus predicciones. Sin embargo, el modelo estándar no alcanza a ser una teoría completa de las interacciones fundamentales debido a que no incluye la gravedad, la cuarta interacción fundamental conocida, y debido también al número elevado de parámetros numéricos (tales como masas y constantes que se juntan) que se deben poner a mano en la teoría (en vez de derivarse a partir de primeros principios).

Se que una vez Albert Einstein alagó al actor Charles Chaplin diciéndole: “Lo que siempre he admirado de usted es que su arte es universal, todo el mundo le comprende y admira”. A esto Chaplin respondió a Einstein: “Lo suyo es mucho más digno de respeto, todo el mundo le admira y prácticamente nadie le comprende”.

Es cierto lo que Chaplin decía, todos admiraban a Einstein y pocos comprendían sus postulados. De hecho, cuando estaba buscando la Teoría de Todo, la gente se amontonaban, literalmente, ante los escaparates de la Quinta Avenida para ver las Ecuaciones que pocos entendían…¡Así somos los Humanos! Lo que no comprendemos nos produce temor o admiración, o, las dos cosas a la vez.

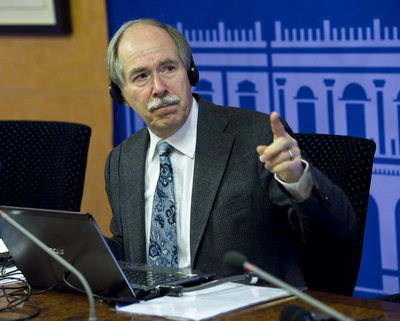

Gerad ´t Hooft

Hace algún tiempo, me desplace a Madrid invitado por la Real Sociedad Española de Física para asistir a una Conferencia que sobre el LHC y el Bosón de Higgs impartía el físico y premio Nobel de Física Gerad ´t Hooft. La charla de ‘t Hooft se inscribía en el ciclo La ciencia y el cosmos, y, entre otras cosas nos decía a los presentes que, La física, en concreto la física de partículas, ha sido siempre su gran pasión. “cuando era joven, la física estaba cambiando el mundo radicalmente: la energía nuclear, la televisión, los ordenadores, las primeras misiones espaciales…. yo quería formar parte de todo eso”. Y las partículas elementales “eran el mayor misterio de todos”, añade. “En cierto modo aún lo son, aunque sabemos de ellas muchísimo más que entonces. Hoy los ordenadores siguen siendo emocionantes, la biología y el código del ADN, la astronomía y los vuelos espaciales… Sigue habiendo muchas cosas capaces de estimular la imaginación de jóvenes deseosos de aprender cosas nuevas impulsados por el deseo de estar ahí, en el momento en que se están haciendo los descubrimientos que cambian el mundo”.

Gerard ‘t Hooft explicó lo que significa, en los modelos teóricos, el famoso bosón: “El campo de la partícula de Higgs actúa como una especie de árbitro; proyectado contra otras partículas, este campo determina su comportamiento, si tienen carga o masa y hasta qué punto se diferencian de otras partículas. Y, en aquel tiempo, nos decía: “Si no encontramos el Higgs, si realmente no está, necesitaremos algo más que haga ese papel de árbitro”. Eso significaría, continuaba el Nobel, que “nuestras teorías ya no funcionan, y han funcionado tan bien hasta que eso es difícil de imaginar”.

Claro que, después de aquello se encontró el Bosón de Higgs y todos contentos. Ahora se busca el Fotón oscuro en el LHC.

Sí, al LHC se le resiste la partícula oscura…, bueno, si es que anda por ahí. Hasta el momento, como nos pasa con el Gravitón, sólo es una conjetura lo de su existencia.

Fue en 199 cuando ‘t Hooft recibió el premio Nobel de Física 1999 (junto con su colega y director de tesis Martinus Veltman), por “dilucidar la estructura cuántica de las interacciones electro-débiles” -según palabras de la Academia sueca- de la física de las partículas elementales.

Acera del Gran Colisionador de Hadrones (el acelerador LHC situado en el Laboratorio Europeo de Física de partículas, CERN, junto a Ginebra), el científico holandés explica que se trata “de una máquina única en el mundo” y continúa: “Esperamos descubrir nuevas cosas con él y poner a prueba teorías que, hasta donde hemos podido comprobar hasta , funcionan muy bien, pero necesitamos ir más allá”.

El descubrimiento de la partícula de Higgs, o bosón de Higgs, era el objetivo número uno del LHC, y tras un largo período de funcionamiento del acelerador, los miles de físicos que trabajan en los detectores, han logrado acotar el terreno de búsqueda, aunque, insisten, seguramente necesitarán tomar muchos más para descubrirlo. O tal vez descubrir que no existe, lo que supondría una revolución en la física de partículas, al obligar a replantear el llamado Modelo Estándar, que describe todas las partículas elementales y sus interacciones, y que hasta ahora funciona con altísima precisión aunque, dicen los expertos, está incompleto.

Al fin, tras largo búsqueda y trabajo, nos hicieron partícipe del esperado descubrimiento que viene a refrendar el Modelo Estándar que, incompleto aún, con el dichoso Bosón queda mejor conformado al desaparecer uno de los casi veinte parámetros aleatorios que en él están presentes.

Gerard ‘t Hooft, uno de los grandes físicos teóricos de partículas elementales, considera que será muy difícil desarrollar una teoría del todo, un cuerpo teórico capaz de explicar todas las fuerzas que actúan en la naturaleza aunando la Relatividad General de Einstein y la Mecánica Cuántica, tan eficaces por separado en la descripción del macrocosmos y el microcosmos, respectivamente. “Mi impresión es que esta teoría unificadora, una teoría del todo, aún requerirá el trabajo de muchas nuevas generaciones de investigadores jóvenes y listos”, afirma. “No llegaremos a ella de un momento a otro por la simple razón de que el universo es demasiado complejo para que una única teoría lo abarque todo. Vale, no digo que sea imposible, pero me parece muy improbable. Y mientras llega, queda mucho por , incluso hallazgos espectaculares”.

El CERN, a la caza del misterioso Fotón oscuro

Por otra parte, el científico holandés ha señalado que el LHC realiza más actividades que intentar encontrar el bosón de Higgs. En este sentido, ha destacado que se buscan también partículas que podrían construir la materia oscura, un de materia de la que los físicos tienen la certeza de que es cinco veces más abundante que el universo que la materia ‘normal’, pero que no absorbe, refleja ni emite luz, lo que hace muy difícil su detección y, por tanto, estudiar su naturaleza. Del mismo modo, también se está desarrollando una teoría capaz de unificar la teoría de la relatividad general de Einstein y la mecánica cuántica que, según ha explicado Hooft, “permitiría lo que ocurre dentro de los átomos”.

Recuerdo un pasaje escrito por él al principio de su interesante e instructivo libro “Partículas Elemetales”, que decía:

“Mi intención es narrar los últimos 25 años de investigación sobre las partículas más pequeñas que constituyen la materia. Durante esos 25 años, yo empecé a ver la Naturaleza como un test de inteligencia para toda la humanidad en su conjunto, como un gigantesco con el que podemos jugar. Una y otra vez, nos tropezamos con nuevas piezas, grandes y pequeñas, que encajan maravillosamente con las que ya tenemos. Yo quiero compartir con ustedes la sensación de triunfo que sentimos en esos momentos.”

Tenía la intención (si se presentaba la oportunidad), de preguntarle sobre “su Principio Holográfico” pero, no pudo ser. Sólo pude saludarlo e intercambiar unas breves palabras junto con Ignacio Cirac presente en el evento.

Publicó el principio holográfico, el cual explica que la información de una dimensión extra es visible una curvatura del espacio tiempo con una menos dimensiones. Por ejemplo, los hologramas son imágenes de 3 dimensiones colocadas en una superficie de 2 dimensiones, el cual da a la imagen una curvatura cuando el observador se mueve. Similarmente, en relatividad general, la cuarta dimensión manifestada en 3 dimensiones observables como la curvatura de un sendero de un movimiento de partícula (criterio) infinitesimal. Hooft ha especulado que la quinta dimensión es realmente la fábrica del espacio-tiempo.

Acordaos de que, a mediados del año 2,003 apareció la noticia de que la “información sería el componente fundamental de la naturaleza” postulada por un grupo de físicos entre los que se incluyen el Premio Nóbel danés Gerard t´Hooft y el físico de la Universidad de California Raphael Bousso, basadas en el “Principio Holográfico”. teoría, por singular y chocante que pareciese en su momento ha tenido a lo largo de estos siete años una influencia notable tanto en la sociedad científica como en los círculos alternativos.

Personajes tan influyentes Deepak Chopra sin ir más lejos habla del ámbito cuántico como el campo de información de donde todo lo conocido, materia, emociones, pensamientos. El controvertido joven físico Nassam Haramein defiende un universo basado en el holograma. Científicos japoneses -al igual que del resto del mundo- investigan con hologramas creando imágenes 3D o explican el funcionamiento del mundo físico basado en los campos de energía e información. Hay hasta “farmacología holográfica” a cargo de empresas farmaceúticas. El año pasado el físico Craig Hogan tras la detección de un extraño ruido en el detector de ondas gravitacionales el GEO 600, afirma que podría probar que, efectivamente, vivimos en un holograma.

La información sería el componente fundamental de la naturaleza. Es la que especifica el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia. El Big Bang que dio lugar al nacimiento del Universo tendría más que ver con una gigantesca “bajada” de bytes de información por parte de un superordenador, que con una explosión masiva de materia, según una nueva teoría que establece que en su origen la naturaleza está formada únicamente por pequeños paquetes de información pura que son los que especifican el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia.

Mucho antes de que todos estos seres existieran ocurrieron muchas cosas que no sabemos. Nuestro origen no está en ninguno de ellos, sino que, partiendo de células replicantes que evolucionaron durante algunos millones de años, pudimos llegar a “SER”.

El Ser humano continúa con su carrera particular para lo que siempre ha querido saber: quiénes somos y de dónde venimos. Esas dos preguntas esenciales son, en realidad, el motor gracias al cual se mueve gran parte de la investigación científica de todos los tiempos.

En carrera por buscar certezas, cosas tan inquebrantables para explicar el origen del mundo como son los átomos o los quarks están quedando relegados a segundo término para dar paso a nuevas teorías.

Una de las más interesantes, postulada por un grupo de físicos entre los que se incluyen el Premio Nóbel danés Gerard t´Hooft y el físico de la Universidad de California Raphael Bousso, afirma que en el origen de la naturaleza podría haber únicamente ultrapequeños paquetes de información pura.

Aunque parezca raro la información no viaja en un bloque como lo haría una carta, sino que se divide en pequeños paquetes de información, viajando a través de los diferentes canales de la red y llegando todos al mismo punto. Para esto es preciso que todos los ordenadores hablen el mismo idioma, o lo que es decir el Protocolo TCP/IP, (que es el idioma) que en un principio empezó a usarse en 1983 para dirigir el tráfico de los paquetes de información por Arpanet, garantizando así que todos lleguen a su destino.

La @ que parece que nació a partir de internet se utilizaba en la antigüedad, como unidad de peso o incluso para decir a cuanto costaba algo en libros de contabilidad. Sin embargo se puso de moda gracias al ingeniero estadounidense Ray Tomilson, que diseñaba un sistema de correo electrónico para Arpanet, simplemente bajo los ojos al teclado y eligió un signo que no se utilizara en los nombres de usuario.

Según explica al respecto Newsfactor, teoría, basada en el “Principio holográfico”, establece que la información (“información” en este caso significa bits fundamentales de materia y las leyes físicas que los gobiernan) especifica el cuándo, dónde, cómo y cuánto del espacio, del tiempo y de la materia. La información sería pues, una variable para llegar a una “teoría del todo”.

Y, más allá de las cuerdas

Según la teoría cuerdas, el espacio está descrito por la vibración, en miles de maneras, de diminutas cuerdas de una dimensión. Una cuerda vibrando arriba y abajo a cierta frecuencia podría crear un átomo de helio o una ola gravitacional, tal y las cuerdas de una guitarra crean diferentes sonidos a diferentes frecuencias.

Los teóricos de teoría han mantenido hace mucho tiempo que estas cuerdas son el componente fundamental de la naturaleza. El “Principio Holográfico”, sin embargo, cambia esta noción y mantiene que, mirando más de cerca una cuerda, se ven bits cuánticos, llamados “baldosas de Planck”, que, engarzados, dicen a las cuerdas como tienen que vibrar.

Una de las más interesantes, postulada por un grupo de físicos entre los que se incluyen el Premio Nóbel danés Gerard t´Hooft y el físico de la Universidad de California Raphael Bousso, afirma que en el origen de la naturaleza podría haber únicamente ultrapequeños paquetes de información pura.

Estas “baldosas de Planck” son bits cuadrados que delimitan un “área de Planck”, o lo que es lo mismo, un trillón de un trillón, de un trillón de un trillón de un trillón de un trillón de un centímetro cuadrado. Una cuerda de baldosas de Plank sería la versión natural de un byte.

El “Principio Holográfico”, descrito por Gerard t´Hooft y Leonard Susskind y refinado por Bousso, nos permite saber cuántos (bits y bytes) son necesarios para decirnos en detalle cada cosa que ocurre en cualquier región del espacio.

¡Por imaginación que no quede!

emilio silvera

Ago

17

La Vida de las partículas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Desde que somos muy pequeñitos y aprendemos las primeras palabras, ya estamos preguntando y tenemos en la boca ese ¿por qué…? que llega a fastidiar a los adultos por su insistencia y machaconería. Claro que, la curiosidad es un ingrediente que está siempre con nosotros… ¡Menos mal!

Son más las preguntas que las respuestas

A pesar de estar aislados en este pequeño mundo que llamamos Tierra, a pesar de todos los inconvenientes y peligros que hemos tenido que vencer, a pesar de la enorme ignorancia que hemos tenido que soportar, los miembros de nuestra especie han sabido profundizar en los secretos de la Naturaleza y del Universo. Confinados en éste pequeño mundo inventamos la manera de encontrar otros mundos situados a muchos años luz de nosotros tratando de encontrar seres semejantes con los que poder entablar una relación.

De las moléculas que conforman esta Nebulosa, más del 83% contienen carbono entre las que se encuentran aquellas que nos dirigen hacia los aminoácidos precursores de la vida. Aquí se forman los mundos que llevan materiales químicos precursores de células que evolucionaran hacia la inteligencia. En esta inmensa Nebulosa se han descubierto más de 6 sistemas planetarios en formación.

La Mente: Ese misterio

La Mente y lo que llamamos Conciencia, plantea un problema especial que no se encuentra en otros dominios de la Ciencia. En la física y en la química se explican unas entidades determinadas en función de otras entidades y otras leyes pero, en el caso de la Conciencia… ¿Cómo poder explicar tal maravilla?

La mente humana es tan compleja que no todos ante la misma cosa vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugiere. De entre diez personas, sólo coinciden tres, los otros siete divergen en la apreciación de lo que el dibujo o la figura les sugiere. Un paisaje puede ser descrito de muy distintas maneras según quién lo pueda contar.

Solo el 1% de las formas de vida que han vivido en la Tierra están ahora presentes, el 99%, por una u otra razón se han extinguido. Sin embargo, ese pequeño tanto por ciento de la vida actual, supone unos cinco millones de especies según algunas estimaciones. La Tierra acoge a todas esas especies u palpita de vida que prolifera por doquier. Hay seres vivos por todas partes y por todos los rincones del inmenso mosaico de ambientes que constituye nuestro planeta encontramos formas de vida, cuyos diseños parecen hechos a propósito para adaptarse a su hábitat, desde las profundidades abisales de los océanos hasta las más altas cumbres, desde las espesas selvas tropicales a las planicies de hielo de los casquetes polares. Se ha estimado la edad de 3.800 millones de años desde que aparecieron los primeros “seres vivos” sobre el planeta (dato de los primeros microfósiles). Desde entonces no han dejado de aparecer más y más especies, de las que la mayoría se han ido extinguiendo. Desde el siglo XVIII en que Carlos Linneo propuso su Systema Naturae no han cesado los intentos por conocer la Biodiversidad…, de la que por cierto nuestra especie, bautizada como Homo sapiens por el propio Linneo, es una recién llegada de apenas 200.000 años.

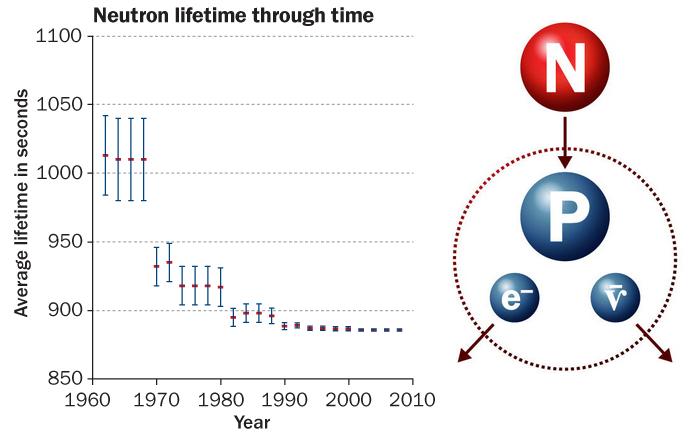

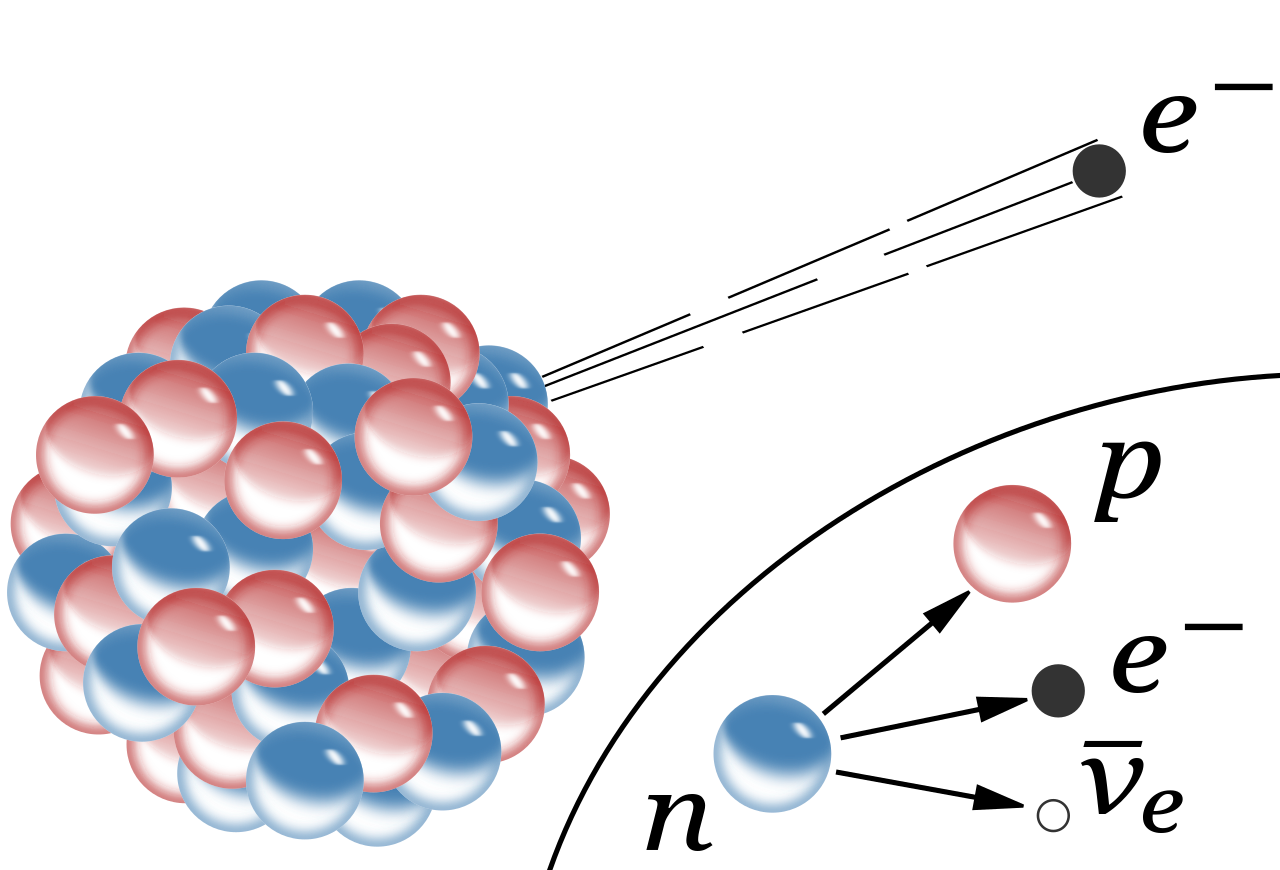

Ahora, hablaremos de la vida media de las partículas elementales (algunas no tanto). Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida media, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, psi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales maneras de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

Una colisión entre un protón y un antiprotón registrada mediante una cámara de chispas del experimento UA5 del CERN.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Se habla de ondas cuánticas y también, de ondas gravitacionales. Las primeras han sido localizadas y las segundas están siendo perseguidas.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Bariones Delta. Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas escalares y vectoriales en el ámbito nuclear. . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (aunque nos parezca lo contrario), son aún bastante limitados, nos queda mucho por descubrir antes de que podamos decir que dominamos la materia y sabemos de todos sus componentes. Antes de que eso llegue, tendremos que conocer, en profundidad, el verdadero origen de la Luz que esconde muchos secretos que tendremos que desvelar.

Esperemos que con los futuros experimentos del LHC y de los grandes Aceleradores de partículas del futuro, se nos aclaren algo las cosas y podamos avanzar en el perfeccionamiento del Modelo Estándar de la Física de Partículas que, como todos sabemos es un Modelo incompleto que no contiene a todas las fuerzas de la Naturaleza y, cerca de una veintena de sus parámetros son aleatorios y no han sido explicados. Uno de ellos, el Bosón de Higgs, dicen que ha sido encontrado. Sin embargo, a mí particularmente me quedan muchas dudas al respecto. Habría que explicar mucho mejor los mecanismos mediante los cuales el bosón le suministra la masa a las demás partículas.

emilio silvera

Ago

15

¿Qué haríamos en un Universo sin fotones?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Malentendido acerca del efecto fotoeléctrico (1905)

Es frecuente asociar el carácter corpuscular de la radiación con la explicación einsteniana del efecto fotoeléctrico en 1905. Pero tal asociación requiere precisiones. El fenómeno fue detectado por H. Hertz, en 1887, como un fenómeno secundario en sus experimentos diseñados para confirmar la teoría de Maxwell. Ironías de la historia: tratando de asentar una teoría de naturaleza continua, como es la del campo electromagnético, Hertz proporcionó, sin sospecharlo, una base experimental para pensar en posibles aspectos discretos de la radiación. Es en 1905 cuando Einstein muestra la analogía formal existente entre un gas ideal monoatómico y la radiación del cuerpo negro, si se admite para ésta la ya entonces caduca ley de Wien. Un genuino análisis le lleva a la siguiente conclusión: la radiación de frecuencia v, siempre dentro del rango de validez de aquella ley, “se comporta termodinámicamente como si estuviera constituida por cuantos de energía, mutuamente independientes, de valor hv”, donde h representa la constante de Planck. Con tal supuesto Einstein logra una explicación teórica de tres fenómenos que se resistían a ello: la regla de Stokes –la frecuencia de la emisión por luminiscencia resulta inferior a la frecuencia incidente–, el efecto fotoeléctrico y la ionización de gases por luz ultravioleta. La anterior conclusión fue entendida por muchos –y lo sigue siendo– como la introducción de la naturaleza corpuscular de la radiación. Pero es obvio que, si Einstein así lo hubiera creído, no sólo lo habría destacado como se merecía, sino que el creador de la teoría de la relatividad habría tenido que asignar al cuanto un impulso de valor hv/c. Además, aunque el efecto fotoeléctrico se explicaba como un simple choque inelástico cuanto-electrón, Einstein tendría que haber considerado también el correspondiente choque-elástico, con lo que habría previsto la existencia del efecto Compton casi veinte años antes de su detección.

Rechazo generalizado

La tónica del impacto causado por la hipótesis cuántica de Einstein se manifiesta en el discurso que Planck pronuncia –¡en 1913!– ante la Academia Prusiana de Ciencias para presentar el nuevo académico: En suma, puede afirmarse que entre los problemas importantes, tan abundantes en la física moderna, difícilmente exista uno ante el que Einstein no adoptara una posición de forma notable. Que, a veces, errara el blanco en sus especulaciones, como por ejemplo en su hipótesis acerca del cuanto de la luz, no puede esgrimirse realmente demasiado en su contra. Porque sin correr un riesgo de vez en cuando es imposible, incluso en la ciencia natural de mayor exactitud, introducir verdaderas innovaciones. Cabe entender la prevención ante tal problemática hipótesis cuántica, en tanto los experimentos no se pronunciaran. Nada más lejos de la realidad. Milikan, que publicó en 1916 sendos artículos confirmando rigurosamente las previsiones teóricas einstenianas, remataba sus conclusiones así: “A pesar del éxito aparentemente completo de la ecuación de Einstein [para el efecto fotoeléctrico], la teoría física de la que estaba destinada a ser la expresión simbólica se ha encontrado tan insostenible que el mismo Einstein, creo, ya no la sostiene”. Hasta cierto punto, resulta comprensible el rotundo y prolongado rechazo de los cuantos de energía de Einstein; una osada hipótesis que parecía sugerir, cuando menos, la necesidad de una revisión profunda de la teoría del campo continuo de radiación. ¿A cambio de qué? De casi nada, dado que la carencia de resultados experimentales rigurosos en aquella época impedía la deseable comprobación de las predicciones einstenianas de 1905.

Un jugoso Gedankenexperiment

Mostrar la compatibilidad entre los cuantos y el electromagnetismo maxwelliano representa un primer objetivo ineludible. Además de la dificultad de la tarea en sí, Einstein cuenta con la patente hostilidad de la mayoría de los líderes de la física del momento, para los cuales el comportamiento discreto de la energía de la radiación se da de bruces con el carácter continuo del campo electromagnético, al concebirlas como dos formas de comportamiento incompatibles, mutuamente excluyentes. En la reunión de la Sociedad Alemana de Científicos Naturales y Médicos de 1909, Einstein presenta una comunicación que Pauli no dudaría luego en calificar como “uno de los hitos en el desarrollo de la física teórica”. Einstein introduce aquí un fructífero Gedankenexperiment, al que volverá en 1917: un espejo se mueve libremente en la dirección perpendicular a su propio plano, reflejando totalmente la radiación comprendida en el intervalo de frecuencias (v, v + dv) y siendo transparente para el resto. El espejo se mueve en una cavidad que contiene un gas ideal monoatómico y radiación electromagnética; todo ello en equilibrio térmico, a la temperatura absoluta T. Las fluctuaciones en los choques irregulares de las moléculas de gas con el espejo implican, dada la situación de equilibrio, la existencia de fluctuaciones en la presión de la radiación. Su análisis, más intuitivo que riguroso, permite a Einstein obtener la siguiente expresión para la fluctuación de energía de la radiación:

donde h es la constante de Planck, p la densidad de energía de la radiación, c la velocidad de la luz en el vacío y V el volumen de la cavidad.

Einstein afirma que el primer sumando “recuerda” el carácter cuántico (discreto) de la radiación –al incluir la constante de Planck– mientras que asocia el segundo con un proceso de interferencias, que no concreta, entre ondas electromagnéticas. Ello le lleva a intuir en 1909, cuatro años antes de aparecer el modelo de Bohr, la necesidad de tener que incorporar, en una misma teoría, algún tipo de dualismo: “Es mi opinión, entonces, que la próxima fase del desarrollo de la física teórica nos aportará una teoría de la luz que pueda ser interpretada como una fusión de las teorías ondulatorias y de emisión [corpuscular]”.

El nacimiento del fotón

Einstein firma, en 1917, la partida de nacimiento del fotón en un artículo que contiene dos resultados de gran calado: la deducción de la ley de Planck partiendo de hipótesis cuánticas y la inferencia de la direccionalidad de los procesos elementales de emisión y absorción. Enarbolado con decisión de la navaja de Ockham se libera de resonadores y espejos. Tras comprobar que, partiendo de dos procesos elementales –emisión espontánea (EE) y absorción (A) –como responsables de la interacción materia-radiación, se llega ineludiblemente a la ya muy obsoleta ley de Wien, Einstein se apercibe de que la introducción de un tercer proceso –emisión inducida es precisamente el principio teórico que habría de regir la construcción del láser.

Ahora parte de un gas material, en equilibrio térmico con la radiación, en el que cada molécula adopta estados de un conjunto discreto, Z1, Z2, …, Zn,…, con energías respectivas E1, E2,…, En,…Las transiciones pueden darse hacia estados de energía mayor, absorbiéndola de la radiación, o hacia estados de energía menor, emitiendo la diferencia como energía radiante. Al no conocerse las leyes exactas que gobiernan estos procesos, Einstein introduce las “probabilidades de transición”, en un intervalo de tiempo d t:

La tasa de procesos inducidos por la presencia de radiación es proporcional a su densidad de energía y los “coeficientes de Einstein” A y B son característicos del apr de estados involucrados. Tras imponer la condición de equilibrio al sistema materia-radiación, Einstein deduce la ley de Planck, así como que en cualquier proceso elemental la cantidad de energía intercambiada entre materia y radiación de frecuencia v, venía dada por el mismo valor: hv. En principio, objetivo cumplido.

La segunda parte del artículo, dedicada a un análisis crítico de sus premisas y conclusiones, es la importante para nuestra conmemoración. A tal fin Einstein vuelve a recurrir a las fluctuaciones, lo que no sorprende dada la alta estima en la que las tenía. Resultaría prolijo describir aquí el tratamiento, que esencialmente consiste en una rediscusión de su Gedankenexperiment de 1909, a la luz de los nuevos supuestos. Pero queremos destacar un resultado fundamental de su peculiar análisis, del que Einstein da cuenta a su amigo y confidente Michele Besso con estas palabras:

Esto [su nuevo tratamiento] conduce al resultado (que todavía no se encuentra en el trabajo que te he enviado) de que, cuando existe intercambio de energía elemental entre radiación y materia, se transfiere el impulso h v / c a la molécula. Se deduce que todo proceso elemental de esta naturaleza es un proceso enteramente orientado. Así, queda establecida la existencia de los cuantos de luz.

Si el intercambio de energía entre materia y radiación siempre va acompañado de una transferencia de impulso, cabe afirmar que en los procesos elementales se intercambian auténticas partículas y no meros cuantos de energía, como Einstein creía en 1905. En el caso de radiación monocromática de frecuencia v, estas partículas se mueven a la velocidad de la luz, tienen masa nula –de acuerdo a las prescripciones relativistas–, energía hv e impulso hv / c. En adelante escribiremos “fotones”, aunque el término tardaría diez años en acuñarse.

Una recepción hostil: la propuesta de BKS

A mediados de 1918 Einstein expresa a Besso estas cavilaciones:

He reflexionado durante un número incalculable de horas sobre la cuestión de los cuantos, naturalmente sin hacer verdaderos progresos. Pero ya no dudo en absoluto de la realidad de los cuantos de radiación, si bien aún soy casi el único con este convencimiento.

Surgen algunos interrogantes razonables. ¿Qué razones había para que los físicos no compartieran las convicciones de Einstein? ¿Por qué continuaba éste interesado en el problema de los fotones, si consideraba que ya había probado su existencia?

Carácter ondulatorio y corpuscular de la luz

Insistimos en que la razón de peso para el rechazo del fotón era la admitida incompatibilidad entre la teoría maxwelliana (ondulatoria) y la nueva teoría cuántica (corpuscular). Pero es que, además, para una gran mayoría de los físicos del momento, las fluctuaciones –centrales en la justificación einsteniana– no pasaban de ser puro academicismo. Para ellos, resultaba inconcebible pensar en un posible desmantelamiento de la teoría del campo electromagnético –por entonces contrastada y admitida–, apoyándose básicamente en un análisis de las fluctuaciones estadísticas.

Es frecuente ver escrito que el fotón se instaló en la física en 1923, tras la explicación teórica del “efecto Compton”. Dicha explicación parecía confirmar simultáneamente dos resultados, por entonces aún en entredicho: la realidad de los fotones y la validez de la relatividad especial, que se empleaba en el análisis del choque elástico fotón-electrón libre. Pero la historia no ocurrió exactamente así, como lo prueba la publicación de un renombrado artículo firmado en 1924 por Bohr, Kramers y Slater –posteriormente conocido por las siglas BKS–, en el que se rechaza sin ambigüedad el fotón de Einstein y los consiguientes supuestos. Los autores asumen que, según el dictamen experimental, las discontinuidades cuánticas resultan ya ineludibles, pero que ello no implica la necesidad de la explicación einsteniana. De otra forma: los experimentos no conducen inexorablemente al fotón.

Precisamente el objetivo de BKS es hacer compatibles los saltos cuánticos con la descripción maxwelliana. A tal fin, la interacción materia-radiación se describe en términos de interferencias entre campos electromagnéticos, ya sean éstos reales o virtuales. El que dichas interferencias den lugar a fenómenos de absorción o emisión de radiación sólo se puede describir en términos probabilísticos análogos –según los autores– a los empleados por Einstein.

Tras reconocer que la causalidad clásica estricta resulta incompatible con la propuesta BKS, sus autores llegan a una osada conclusión: en un proceso individual de emisión o absorción, descrito sobre la base de aquellos campos virtuales, los principios de conservación de la energía y del momento dejan de ser universalmente válidos. Sólo gozan de validez estadística: se cumplen para valores medios en un número de procesos muy elevado.

En 1925, Bothe y Geiger sometieron a test experimental una de las extrañas implicaciones de BKS: la violación del principio de causalidad. Comprobaron que el electrón secundario del efecto Compton se crea en el instante mismo del impacto fotón-electrón, como exige la causalidad clásica, y no tras el tiempo medible predicho por BKS, al requerir esta teoría unas supuestas interferencias entre campos. Casi simultáneamente, Compton y Simon diseñaron un experimento diferente –ahora empleando una cámara de niebla–, que confirmaba la conservación de energía en los procesos individuales.

Epílogo

Las aspiraciones de Einstein no se colman con la introducción del fotón, al no verse capaz de reconciliarlo con el continuo del campo electromagnético. Pero, en nuestra opinión, hay otra razón de peso para su insatisfacción: el papel que la probabilidad comienza a jugar a partir de sus propias investigaciones, y de otras posteriores, como la misma propuesta BKS. Parece vislumbrar que la probabilidad puede llegar a jugar en la física un papel esencial para entender el comportamiento del mundo físico, sin limitarse a ser un mero recurso matemático, como sucede en mecánica estadística.

Si la falta de información sobre el “cuándo” y el “cómo” –de la emisión espontanea, por ejemplo– se toma como un defecto de la teoría, lo procedente sería de esperar hasta que apareciese una explicación más completa. Pero si realmente se había llegado a la teoría más afinada posible sobre el comportamiento de la radiación, el papel que en ella desempeña la probabilidad lleva a la negación del determinismo clásico. El dilema es fuerte y Einstein opta desde un principio por la primera opción: piensa que su incipiente teoría cuántica, son teorías provisionalmente válidas, pero no definitivas, por incompletas.

Ante el protagonismo que la probabilidad podía adquirir en el futuro de la física, Einstein manifiesta así su inquietud a la esposa de Born:

La opinión de Bohr sobre la radiación es de gran interés. Pero no desearía verme forzado a renunciar a la causalidad estricta sin defenderla con la mayor intensidad que lo he hecho hasta ahora. Me resulta completamente intolerable la idea de que un electrón expuesto a radiación pueda escoger según su propio libre albedrío, no sólo el momento para saltar, sino también la dirección. Si este fuera el caso, preferiría haber sido zapatero remendón, o incluso empleado de un casino, antes que físico.

El desacuerdo con Bohr que Einstein apunta aquí se mantendría ya de por vida. Subsistiría incluso después de la formulación de la mecánica cuántica (la matricial por Heisenberg en 1925 y la ondulatoria por Schrödinger en 1926) y de la electrodinámica cuántica (por Dirac en 1927); las disciplinas que proporcionan la solución vigente a los problemas que venimos exponiendo. La discrepancia entre ambos acerca de la interpretación del formalismo cuántico nunca desapareció. Hay quien piensa que esta confrontación, aunque centrada en el nacimiento del fotón y la contrapuesta BKS, representa el auténtico punto de partida del renombrado y fructífero “debate Bohr-Einstein”. Pero eso es harina de otro costal…

Autor: Luis Navarro Veguillas

Revista de la Real Sociedad Española de Física

Volumen 31. Número 2. 2017

Ago

13

¡Fluctuaciones de vacío! ¿Que son?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

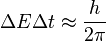

Un fuerte campo gravitatorio puede inducir un efecto desbocado en las fluctuaciones cuánticas que se producen en el espacio, aparentemente vacío, …

En física cuántica, la fluctuación cuántica es un cambio temporal en la cantidad de energía en un punto en el espacio como resultado del Principio de Incertidumbre que imaginó Werner Heisenberg. De acuerdo a una formulación de este principio energía y tiempo se relacionan de la siguiente forma:

Esto significa que la conservación de la energía puede parecer violada, pero sólo por breves lapsos. Esto permite la creación de pares partícula-anti-partícula de partículas virtuales. El efecto de esas partículas es medible, por ejemplo, en la carga efectiva del electrón, diferente de su carga “desnuda”. En una formulación actual, la energía siempre se conserva, pero los estados propios del Hamiltoniano no son los mismos que los del operador del número de partículas, esto es, si está bien definida la energía del sistema no está bien definido el número de partículas del mismo, y viceversa, ya que estos dos operadores no conmutan.

Las fluctuaciones del vacío entre una esfera y una superficie plana

En un estudio realizado por un equipo de físicos con avanzados aparatos, han hallado un resultado del que nos dicen:

La materia se construye sobre fundamentos frágiles. Los físicos acaban de confirmar que la materia, aparentemente sustancial, es en realidad nada más que fluctuaciones en el vació cuántico. Los investigadores simularon la frenética actividad que sucede en el interios de los protones y neutrones, que como sabéis son las partículas que aportan casi la totalidad de la masa a la materia común.

Cada protón (o neutrón) se compone de tres quarks – véase ilustración – pero las masas individuales de estos quarks apenas comprenden el 1% del total de la masa del protón¿Entonces de dónde sale el resto? La teoría sostiene que esta masa es creada por la fuerza que mantiene pegados a los quarks, y que se conoce como fuerza nuclear fuerte. En términos cuánticos, la fuerza fuerte es contenida por un campo de partículas virtuales llamadas gluones, las cuales irrumpen aleatoriamente en la existencia para desaparecer de nuevo. La energía de estas fluctuaciones del vacío debe sumarse a la masa total del neutróny del protón.

En nuestras mentes se acumulan signos y fórmulas que quieren ser los exponentes de la verdadera razón y origen de la materia pero… ¡Estaremos acertando!

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de y conocer sobre su verdadera naturaleza. Es algo que vemos en sus distintas formas materiales que configuran y conforman todo lo material desde las partículas elementales hasta las montañas y los océanos. Unas veces está en estado “inerte” y otras, se eleva hasta la vida que incluso, en ocasiones, alcanza la consciencia de SER. Sin embargo, no acabamos de dilucidar de dónde viene su verdadero origen, su esencia, lo que era antes de “ser” materia. ¿Existe acaso una especie de sustancia cósmica anterior a la materia? Y, si realmente existe esa sustancia… ¿Dónde está?

No será fácil llegar a controlar el vacío cuántico y tratamos de medirlo

Claro que hemos llegado a saber que las llamadas fluctuaciones del vacío son oscilaciones aleatorias, impredecibles e ineliminables de un campo de fuerza (electromagnético o gravitatorio) que son debidas a un “tira y afloja” en el que pequeñas regiones del espacio toman prestada, momentáneamente, energía de regiones adyacentes y luego las devuelven. Pero…

– ¿Qué regiones adyacentes?

Acaso universos paralelos, acaso deformaciones del espacio-tiempo a escalas microscópicas, micros agujeros negros que pasan a ser agujeros blancos salidos de estas regiones o campos de fuerza que no podemos ver pero sí sentir, y, en última instancia, ¿por qué se forman esas partículas virtuales que de inmediato se aniquilan y desaparecen antes de que puedan ser capturadas? ¿Qué sentido tiene todo eso?

Las consecuencias de la existencia del cuanto mínimo de acción fueron revolucionarios para la comprensión del vacío. Mientras la continuidad de la acción clásica suponía un vacío plano, estable y “realmente” vacío, la discontinuidad que supone el cuanto nos dibuja un vacío inestable, en continuo cambio y muy lejos de poder ser considerado plano en las distancias atómicas y menores. El vacío cuántico es de todo menos vacío, en él la energía nunca puede quedar estabilizada en valor cero, está fluctuando sobre ese valor, continuamente se están creando y aniquilando todo tipo de partículas, llamadas por eso virtuales, en las que el producto de su energía por el tiempo de su existencia efímera es menor que el cuanto de acción. Se llaman fluctuaciones cuánticas del vacío y son las responsables de que exista un que lo inunda todo llamado campo de punto cero.

Pero volvamos de nuevo a las fluctuaciones de vacío, que al igual que las ondas “reales” de energía positiva, están sujetas a las leyes de la dualidad onda/partícula; es decir, tienen tanto aspectos de onda como aspectos de partícula.