Feb

1

Intrincada búsqueda: ¡La Gravedad cuántica!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Nunca han importado muchos los peligros que tengamos que correr para buscar las respuestas de lo profundamente escondido en la Naturaleza, ni tampoco ha importado hasta donde ha tenido que viajar la imaginación para configurar modelos y teorías que, más tarde, queremos verificar.

También una teoría cuántica de la gravedad debería ampliar nuestro conocimiento de efectos cuánticos predichos por enfoques tentativos de otras teorías cuánticas, como la existencia de radiación de Hawking.

¡Y mucho más sobre este mismo tema!

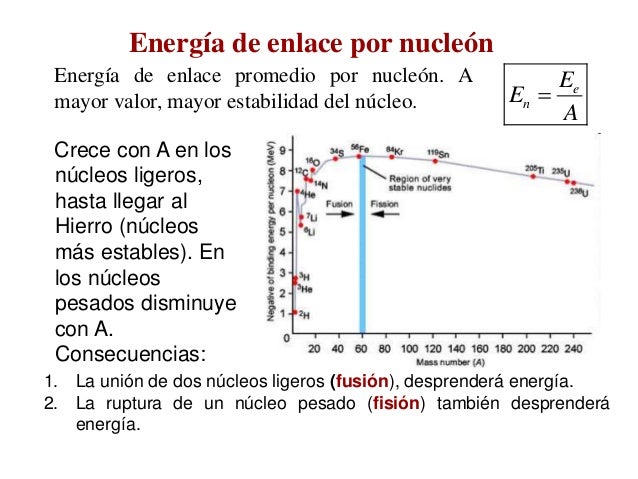

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “super-gravedad”, “súper-simetría”, “supercuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada.

“El concepto de una “teoría del todo” está arraigado en el principio de causalidad y su descubrimiento es la empresa de acercarnos a ver a través de los ojos del demonio de Laplace. Aunque dicha posibilidad puede considerarse como determinista, en una “simple fórmula” puede todavía sobrevivir la física fundamentalmente probabilista, como proponen algunas posturas actuales de la mecánica cuántica. Esto se debe a que aun si los mecanismos que gobiernan las partículas son intrínsecamente azarosos, podemos conocer las reglas que gobiernan dicho azar y calcular las probabilidades de ocurrencia para cada evento posible. Sin embargo, otras interpretaciones de la ecuación de Schrödinger conceden poca importancia al azar: este solo se tendría importancia dentro del átomo y se diluiría en el mundo macroscópico. Otras no obstante la niegan completamente y la consideran una interpretación equivocada de las leyes cuánticas. En consecuencia, la mayor dificultad de descubrir una teoría unificada ha sido armonizar correctamente leyes que gobiernan solo un reducido ámbito de la naturaleza y transformarlas en una única teoría que la explique en su totalidad, tanto en su mundo micro como macroscópico y explique la existencia de todas las interacciones fundamentales: las fuerzas gravitatoria, electromagnética, nuclear fuerte y nuclear débil.”

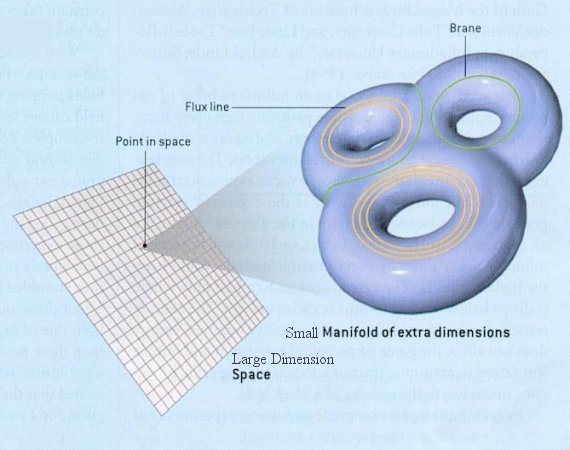

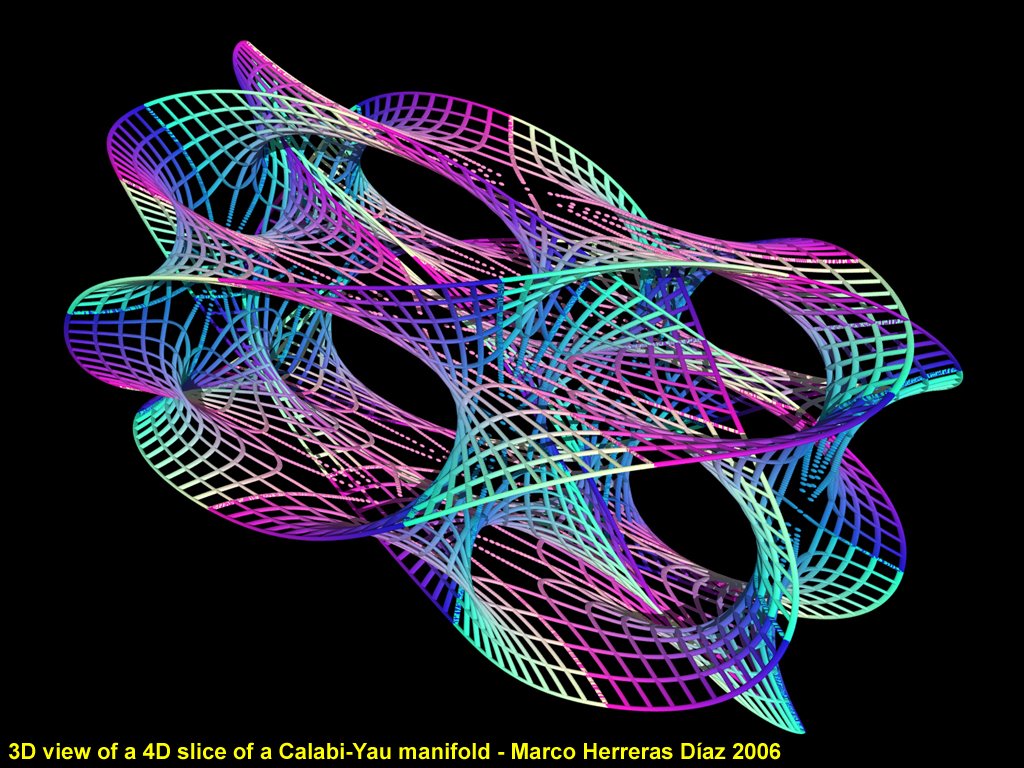

Ahí tenemos unas matemáticas exóticas que ponen de punta hasta los pelos de las cejas de algunos de los mejores matemáticos del mundo (¿y Perelman? ¿Por qué nos se ha implicado?). Hablan de 10, 11 y 26 dimensiones, siempre, todas ellas espaciales menos una que es la temporal. Vivimos en cuatro: tres de espacio (este-oeste, norte-sur y arriba-abajo) y una temporal. No podemos, ni sabemos o no es posible instruir, en nuestro cerebro (también tridimensional), ver más dimensiones. Pero llegaron Kaluza y Klein y compactaron, en la longitud de Planck las dimensiones que no podíamos ver. ¡Problema solucionado!

¿Quién puede ir a la longitud de Planck para poder contemplar esas cuerdas vibrantes si es que están allí?

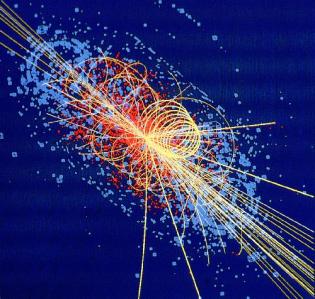

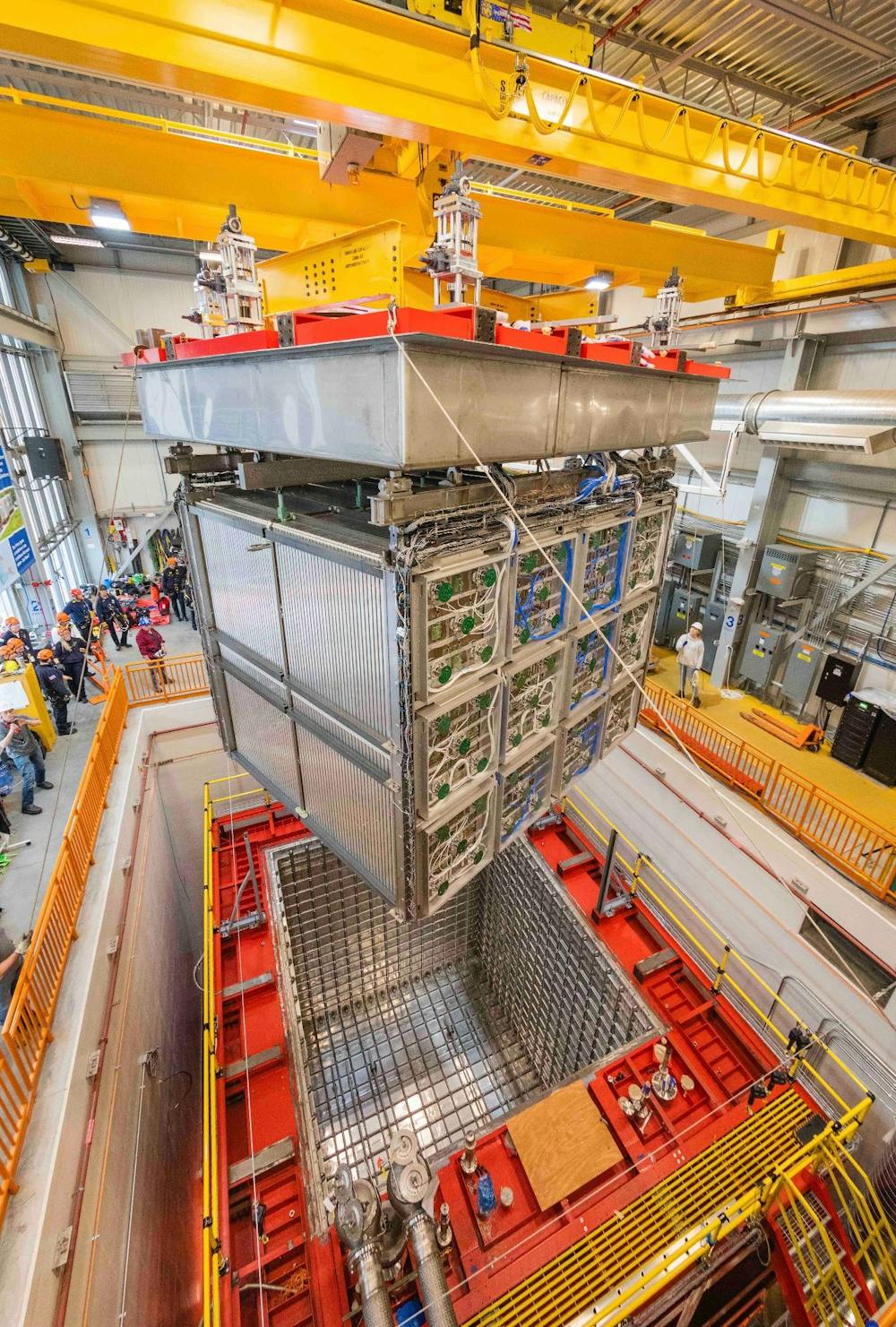

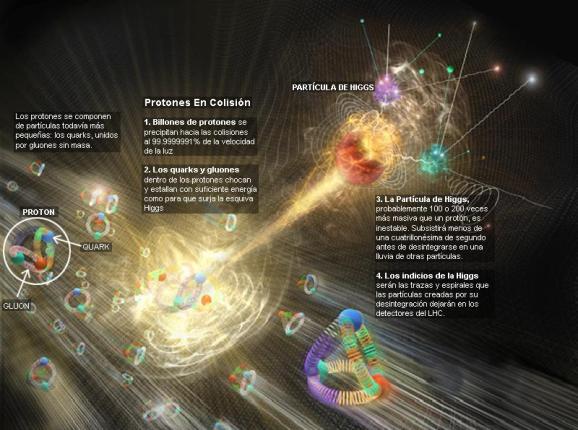

Ni vemos la longitud de Planck ni las dimensiones extra y, nos dicen que para poder profundizar hasta esa distancia, necesitamos disponer de la Energía de Planck, es decir 1019 GeV, una energía que ni en las próximas generaciones estará a nuestro alcance. Pero mientras tanto, hablamos de que, en 2.015, el LHC buscará las partículas de la “materia oscura”. ¡Qué gente!

La puerta de las dimensiones más altas quedó abierta y, a los teóricos, se les regaló una herramienta maravillosa. En el Hiperespacio, todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí si es posible encontrar esa soñada teoría de la Gravedad cuántica.

Así que, los teóricos, se han embarcado a la búsqueda de un objetivo audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos, una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

¿Dónde radica el problema?

Nuestro universo ¿es tridimensional y no podemos esas dimensiones extra de las que tanto hablan en las teorías más avanzadas pero, no verificadas?

El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC que con sus 14 TeV no llegaría ni siquiera a vislumbrar esas cuerdas vibrantes de las que antes os hablaba.

La verdad es que, la teoría que ahora tenemos, el Modelo Estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. Ya sabéis lo que pasa cuando queremos juntar la relatividad con la cuántica: ¡Aparecen los infinitos que no son re-normalizables!

Con sus 20 parámetros aleatorios (parece que uno de ellos ha sido hallado -el bosón de Higgs-), el Modelo estándar de la física de partículas que incluye sólo tres de las interacciones fundamentales -las fuerzas nucleares débil y fuerte y el electromagnetismo-, ha dado un buen resultado y a permitido a los físicos trabajar ampliamente en el conocimiento del mundo, de la Naturaleza, del Universo. Sin embargo, deja muchas preguntas sin contestar y, lo cierto es que, se necesitan nuevas maneras, nuevas formas, nuevas teorías que nos lleven más allá.

¡Necesitamos algo más avanzado!

Se ha dicho que la función de la partícula de Higgs es la de dar masa a las partículas que conocemos y están incluidas en el Modelo estándar, se nos ha dicho que ha sido encontrada y el hallazgo ha merecido el Nobel de Física. Sin embargo… nada se ha dicho de cómo ésta partícula transmite la masa a las demás. Faltan algunas explicaciones.

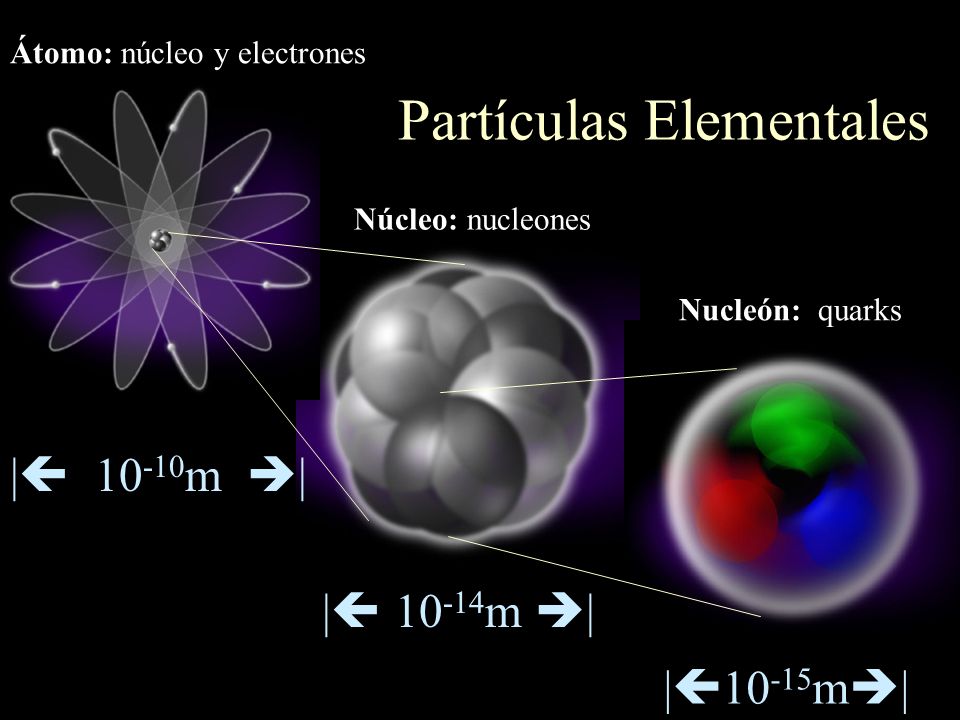

El secreto de todo radica en conseguir la simplicidad: el átomo resulto ser complejo lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, resultó que tenía un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún, los quarks que estaban instalados en nubes de otras partículas llamadas gluones y, ahora, queremos continuar profundizando, sospechamos, que después de los quarks puede haber algo más.

¿Es el efecto frenado que sufren las partículas que corren por el océano de Higgs, el que les da la masa?

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes. Es decir, que si miramos a las estrellas en una noche clara estamos mirando el campo de Higgs. Las partículas influidas por este campo, toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado, del campo gravitatorio o del electromagnético. Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquiriría energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra.

Como E=mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del Sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein. La masa, m, tiene en realidad dos partes. Una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Peor la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más

apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas.

Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan éstas al campo de Higgs.

La influencia de Higgs en las masas de los quarks y de los leptones, nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de que reglas controlan los incrementos de masa generados por el Higgs(de ahí la expectación creada por el acelerador de partículas LHC). Pero el problema es irritante: ¿por qué sólo esas masas –Las masas de los W+, W–, y Zº, y el up, el down, el encanto, el extraño, el top y el bottom, así como los leptones – que no forman ningún patrón obvio?

https://youtu.be/LAjDp6XSJcg

No dejamos de experimentar para saber cómo es nuestro mundo, la Naturaleza, el Universo que nos acoge.

Las masas van de la del electrón 0’0005 GeV, a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-Salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnéticas y débiles. En la unidad hay cuatro partículas mensajeras sin masa –los W+, W–, Zº y fotón que llevan la fuerza electrodébil. Además está el campo de Higgs, y, rápidamente, los W y Z chupan la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos) y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen los teóricos. Hay otra descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

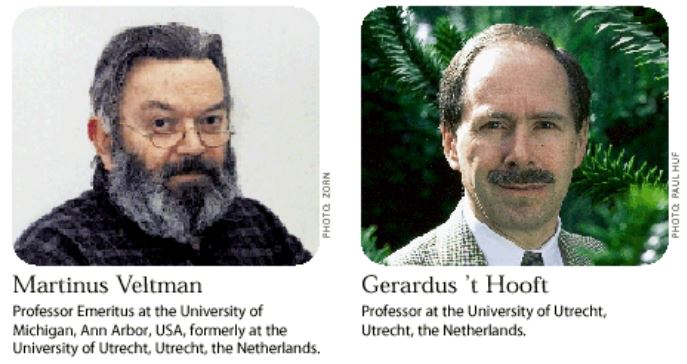

Las masas de los W y el Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil. Y las relajadas sonrisas de los físicos teóricos nos recuerdan que Gerard ^t Hooft y Veltman dejaron sentado que la teoría entera esta libre de infinitos.

https://youtu.be/RA4NOv165dw

La teoría de supercuerdas tiene tantas sorpresas fantásticas que cualquiera que investigue en el tema reconoce que está llena de magia. Es algo que funciona con tanta belleza… Cuando cosas que no encajan juntas e incluso se repelen, si se acerca la una a la otra alguien es capaz de formular un camino mediante el cual, no sólo no se rechazan, sino que encajan a la perfección dentro de ese sistema, como ocurre ahora con la teoría M que acoge con naturalidad la teoría de la relatividad general y la teoría mecánico-cuántica; ahí, cuando eso se produce, está presente la belleza.

Lo que hace que la teoría de supercuerdas sea tan interesante es que el marco estándar mediante el cual conocemos la mayor parte de la física es la teoría cuántica y resulta que ella hace imposible la gravedad. La relatividad general de Einstein, que es el modelo de la gravedad, no funciona con la teoría cuántica. Sin embargo, las supercuerdas modifican la teoría cuántica estándar de tal manera que la gravedad no sólo se convierte en posible, sino que forma parte natural del sistema; es inevitable para que éste sea completo.

¿Por qué es tan importante encajar la gravedad y la teoría cuántica? Porque no podemos admitir una teoría que explique las fuerzas de la naturaleza y deje fuera a una de esas fuerzas. Así ocurre con el Modelo Estándar que deja aparte y no incluye a la fuerza gravitatoria que está ahí, en la Naturaleza.

La teoría de supercuerdas se perfila como la teoría que tiene implicaciones si tratamos con las cosas muy pequeñas, en el microcosmos; toda la teoría de partículas elementales cambia con las supercuerdas que penetra mucho más; llega mucho más allá de lo que ahora es posible.

La topología es, el estudio de aquellas propiedades de los cuerpos geométricos que permanecen inalteradas por transformaciones continuas. La topología es probablemente la más joven de las ramas clásicas de las matemáticas. En contraste con el álgebra, la geometría y la teoría de los números, cuyas genealogías datan de tiempos antiguos, la topología aparece en el siglo diecisiete, con el nombre de análisis situs, ésto es, análisis de la posición.

De manera informal, la topología se ocupa de aquellas propiedades de las figuras que permanecen invariantes, cuando dichas figuras son plegadas, dilatadas, contraídas o deformadas, de modo que no aparezcan nuevos puntos, o se hagan coincidir puntos diferentes. La transformación permitida presupone, en otras palabras, que hay una correspondencia biunívoca entre los puntos de la figura original y los de la transformada, y que la deformación hace corresponder puntos próximos a puntos próximos. Esta última propiedad se llama continuidad, y lo que se requiere es que la transformación y su inversa sean ambas continuas: así, trabajarnos con homeomorfismos.

Steam Community: Steam Artwork

“En cada instante de la historia del universo existe una distancia que determina un límite u horizonte para el universo observable en esa época, el cual está fijado por la distancia que ha viajado la luz desde la singularidad inicial del Big Bang (ver horizontes en cosmología). Este horizonte tiene el efecto de ser el límite de distancia para la cual dos regiones del Universo pueden estar causalmente conectadas, es decir, que una señal luminosa haya podido llegar desde una de las regiones hasta la otra.”

Nosotros sí vemos el Horizonte en nuestras cortas distancia por la redondez de la Tierra ¿Cómo ver el Horizonte del Universo?

El horizonte del universo es una frontera conceptual que representa el límite más lejano desde el cual la luz o cualquier otra forma de información podría alcanzarnos. Esto se debe a la expansión del universo, que hace que las distancias entre galaxias y objetos cósmicos se incrementen con el tiempo.

En cuanto a nuestra comprensión del universo a gran escala (galaxias, el Big Bang…), creo que afectará a nuestra idea presente, al esquema que hoy rige y, como la nueva teoría, el horizonte se ampliará enormemente; el cosmos se presentará ante nosotros como un todo, con un comienzo muy bien definido y un final muy bien determinado.

Para cuando eso llegue, sabremos lo que es, como se genera y dónde están situados los orígenes de esa “fuerza”, “materia”, o, “energía” que ahora no sabemos ver para explicar el anómalo movimiento de las galaxias o la expansión del espacio que corre sin freno hacia… ¿Otro universo que tira del nuestro, como ocurren con las galaxias que terminan por fusionarse?

Emilio Silvera Vázquez

Dic

19

El fascinante “universo” cuántico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

Las leyes que gobiernan el mundo físico tienen dos características importantes: muchas leyes de la naturaleza permanecen inalterables, no se alteran cuando cambia la escala, pero hay otros fenómenos, tales como una vela encendida o las gotas de agua, que no cambian del mismo modo. La implicación final es que el mundo de los objetos muy pequeños será completamente diferente del mundo ordinario.

El producto de la incertidumbre en la posición de una partícula y la incertidumbre en su momento nunca puede ser inferior a la mitad de la constante de Planck reducida: Δ x Δ p ≥ ℏ / 2 . Δ x Δ p ≥ ℏ / 2 . Esta relación expresa el principio de incertidumbre de Heisenberg.

En 1928 Dirac se propuso encontrar la ecuación del electrón libre relativista, porque la ecuación de Schrödinger no cumplía con los requisitos de la teoría de Einstein¹, es decir, no trataba por igual espacio y tiempo, y no incorporaba la energía en reposo (el famoso E=mc²). Además de eso no explicaba el espín, una propiedad fundamental de las partículas sin equivalencia clásica, pero que separa la naturaleza en dos familias totalmente distintas: bosones (como el fotón, de espín entero) y fermiones (como el electrón, de espín semientero). Para los que no sois físicos el espín os resultará una tontería pero debéis saber que es tan importante que las fuerzas de la naturaleza se transmiten sólo por bosones, mientras que las partículas más elementales están formadas sólo por fermiones.

La Ecuación

siendo m la masa en reposo del electrón, c la velocidad de la luz p el operador de momento, ℏ la constante reducida de Planck, x y t las coordenadas del Espacio y el Tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vector que cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac. Hay más de una forma de escoger un conjunto de matrices de Dirac; un criterio práctico es:

La ecuación de Dirac es una ecuación de ondas relativista de la mecánica cuántica formulada por Paul Dirac en 1928. Da una descripción de las partículas elementales con masa de espín 1/2 como el electrón, y es consistente con los principios de la mecánica cuántica y de la teoría de la relatividad especial, explicando de forma natural la existencia del espín y de las antipartículas. Sin embargo, es sólo una aproximación a la electro dinámica cuántica que describe la interacción de partículas cargadas mediante interacciones eléctricas.

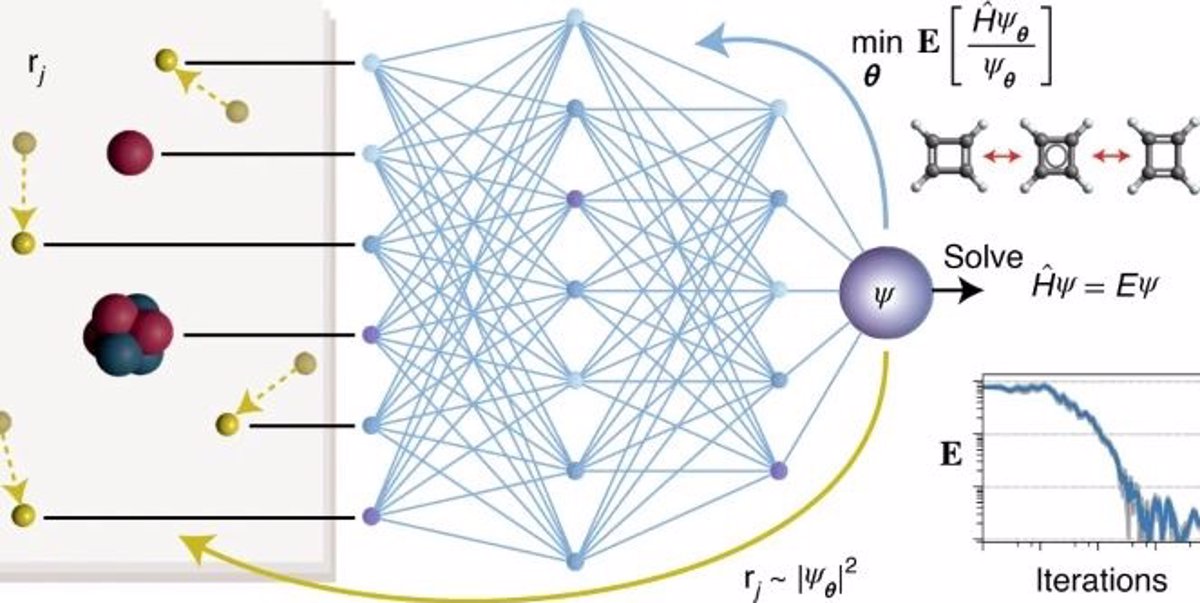

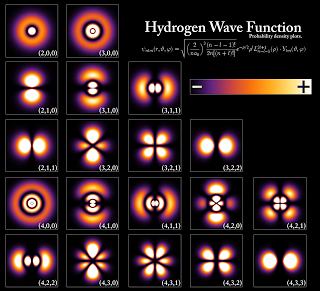

La ecuación de Schrödinger independiente del tiempo predice que las funciones de onda pueden tener la forma de ondas estacionarias, denominados estados estacionarios (también llamados “orbitales”, como en los orbitales atómicos o los orbitales moleculares).

La función de onda de Schrödinger es un constructo matemático, que no representa una realidad física, asociada a una partícula libre, de energía y momento , que se mueve con velocidad , el cual, multiplicada con su conjugada, nos da la función de probabilidad de encontrar una partícula en determinado punto del espacio tiempo.

Schrödinger sugirió que el movimiento de los electrones en el átomo correspondía a la dualidad onda-partícula y, en consecuencia, los electrones podían moverse alrededor del núcleo como ondas estacionarias.

La función de onda en la mecánica cuántica se puede considerar como una representación del estado de movimiento discontinuo aleatorio de las partículas, y en un nivel más profundo, puede representar la propiedad disposicional de las partículas que determina su movimiento discontinuo aleatorio.

Ahora tendríamos que hablar algo de la mecánica cuántica y, en ese ámbito, las reglas de la mecánica cuántica funcionan tan bien que resultaría realmente difícil refutarlas. Acordaos de los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac, o, Schrödinger que vinieron a mejorar y completar las reglas generales. Sin embargo, algunos de aquellos pioneros (Einstein y el mismo Schrödinger), sin embargo, presentaron serias objeciones a dicha interpretación de la naturaleza de lo muy pequeño.

Resuelta la ecuación, con ayuda de Weyl, Schrödinger obtuvo el espectro del átomo de hidrógeno, partes discreta y continua, para lo que añadió la condición

a largas distancias.

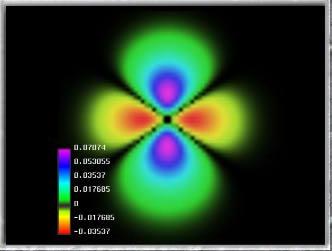

Esta cosita tan pequeñita, el electrón, es inversamente proporcional en importancia para que el mundo, la Naturaleza, y, nuestro Universo sea como es. Se ha conseguido fotografiar a un electrón. Poder filmar y fotografiar un electrón no es fácil por dos razones: primero, gira alrededor del núcleo atómico cada 0,000000000000000140 segundos , y, porque para fotografiar un electrón es necesario bombardearlo con partículas de luz (y cualquier que haya intentado sacarle una foto a un electrón sabe que hay que hacerlo sin flash). La imagen de la izquierda es el resultado.

El electrón fue descubierto en 1.897 por el físico británico Joseph John Thomson (1.856 – 1940). El problema de la estructura (si la hay) del electrón no está resuelto. Si el electrón se considera como una carga puntual, su autoenergía es infinita y surgen dificultades en la ecuación conocida como de Lorentz–Dirac.

Muchas veces hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; tiene una masa de solamente 1/1.836 de la del núcleo más ligero, el del hidrógeno que está formado por un solo protón. La importancia del electrón es vital en el universo.

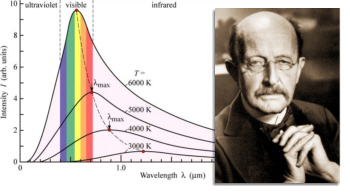

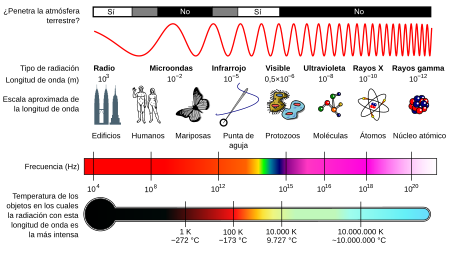

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

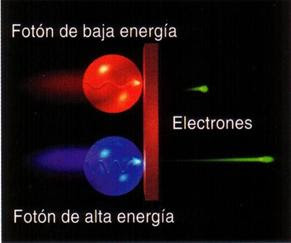

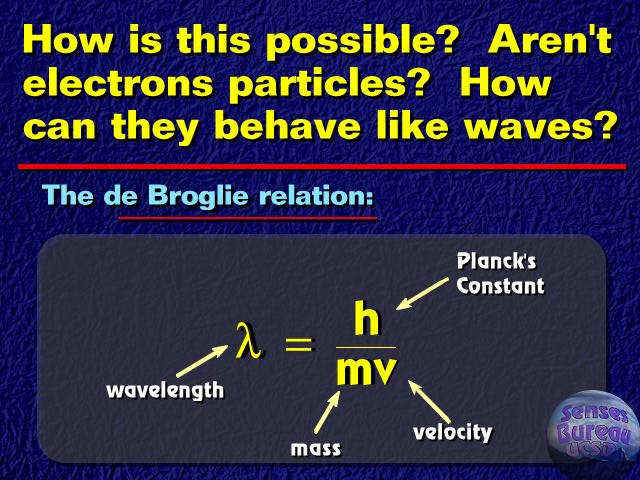

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza, pero esto lo veremos más adelante.

El Electrón como Onda y partícula

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Cuando Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero para los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras.

¿Qué puede significar todo esto?

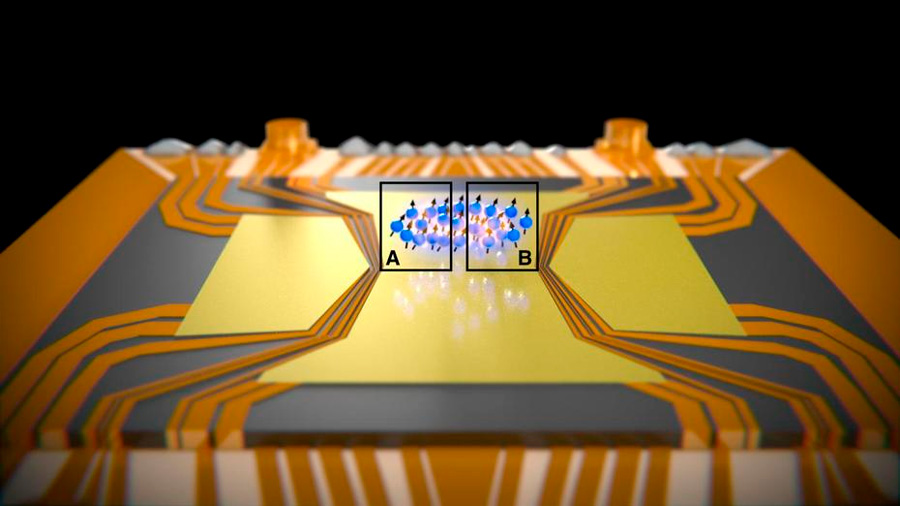

Superposición cuántica

La notable capacidad de un electrón de existir en dos lugares al mismo tiempo ha sido controlada en el material electrónico más comun el – silicio – por primera vez, siendo este un gran avance para la electrónica moderna y tiene un potencial enorme para el futuro y para la creación de la computadora cuántica.

Imagen: El movimiento de los electrones en el silicio. El electrón gira alrededor de una átomo de fósforo embebido en la estructura cristalina del silicio, que se muestra en plata. La distribución de densidad electrónica no perturbado, a partir de la ecuaciones de la mecánica cuántica del movimiento se muestra en amarillo. Un pulso de láser de electrones puede modificar el estado de manera que tiene la distribución de la densidad se muestra en verde. Nuestro pulso láser en primer lugar, que llegan desde la izquierda, pone el electrón en una superposición de ambos estados, que podemos controlar con un segundo impulso, también desde la izquierda, para dar un pulso que se detecte que, saliendo a la derecha. Las características de este “eco” del pulso nos hablan de la superposición que hemos hecho.

Cuando podamos dominar el “universo” de lo muy pequeño… ¡Nuestro Universo será otro para nosotros!

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento musical se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Sí, la música influye en el cerebro

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Aunque la semilla la puso Planck en 1900, fue a partir de 1930 cuando la mecánica cuántica se aplicó con mucho éxito a problemas relacionados con núcleos atómicos, moléculas y materia en estado sólido. La mecánica cuántica hizo posible comprender un extenso conjunto de datos, de otra manera enigmáticos. Sus predicciones han sido de una exactitud notable. Ejemplo de esto último es la increíble precisión de diecisiete cifras significativas del momento magnético del electrón calculadas por la EDC (Electrodinámica Cuántica) comparadas con el experimento.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

Sí, las reglas de la mecánica cuántica son extrañas y misteriosas, pero… ¿Las vamos entendiendo?

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisemberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a esta interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Hablar de Mecánica Cuántica es como hacerlo de la Quinta (la Cuarta es el Tiempo) Dimensión

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos ahora se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de forma estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un momento dado.

¿Ganaré algún día esa lotería que me quite de trabajar por necesidad?

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.

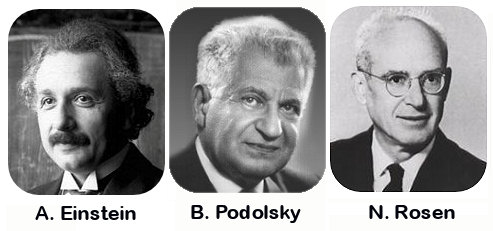

Por primera vez, se observa la paradoja de Einstein-Podolsky-Rosen en un sistema de muchas partículas

Albert Einstein, Nathan Rosen y Boris Podolski idearon un “Gedankenexperiment”, un experimento hipotético, realizado sobre el papel, para el cual la mecánica cuántica predecía como resultado algo que es imposible de reproducir en ninguna teoría razonable de variables ocultas. Más tarde, el físico irlandés John Stewar Bell consiguió convertir este resultado en un teorema matemático; el teorema de imposibilidad.

Bueno, a todo esto, una cosa sí que nos queda clara, como la posibilidad asombrosa de nuestras Mentes a germinar ideas que salen bulliciosas al mundo. No todas llegan a su destino. Sin embargo, las que lo hacen, marcan un hito y nos señalan el camino a seguir en ese largo viaje (en realidad interminable -nunca podremos saberlo todo sobre todas las cosas-), a la búsqueda del saber del Mundo y del Universo en fin.

Emilio Silvera Vázquez

Dic

13

La maravilla de… ¡Los cuantos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

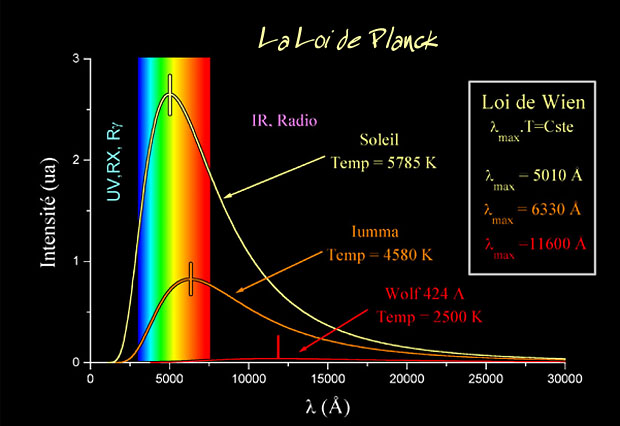

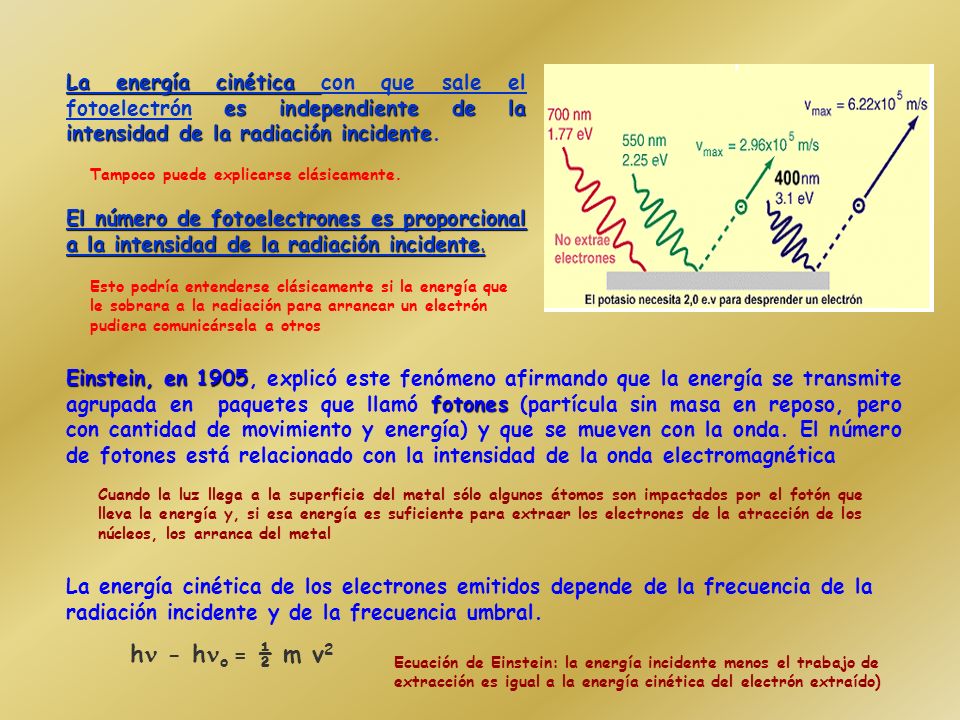

La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había estado intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos. Planck escribió un artículo de ocho páginas y el resultado fue que cambió el mundo de la física y aquella páginas fueron la semilla de la futura ¡mecánica cuántica! que, algunos años más tardes, desarrollarían físicos como Einstein (Efecto fotoeléctrico), Heisenberg (Principio de Incertidumbre), Feynman, Bhor, Schrödinger, Dirac…

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado: E = hv

Donde E es la energía del paquete, v es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

La expresión radiación se refiere a la emisión continua de energía de la superficie de todos los cuerpos. Los portadores de esta energía son las ondas electromagnéticas producidas por las vibraciones de las partículas cargadas que forman parte de los átomos y moléculas de la materia. La radiación electromagnética que se produce a causa del movimiento térmico de los átomos y moléculas de la sustancia se denomina radiación térmica o de temperatura.

Ley de Planck para cuerpos a diferentes temperaturas.

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía.

Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, desde luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico o una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de la luz visible.

Acero al “rojo vivo”, el objeto está radiando en la zona de la luz visible

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

E = hv

Donde E es la energía del paquete, v es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo esta nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck.

El príncipe francés Louis Victor de Broglie, dándole otra vuelta a la teoría, que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta dirección del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

Es curioso el comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Edwin Schrödinger descubrió como escribir la teoría ondulatoria de De Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar los cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de onda cuántica”.

No hay duda de que la Mecánica Cuántica funciona maravillosamente bien. Sin embargo, surge una pregunta muy formal: ¿Qué significan realmente esas ecuaciones?, ¿Qué es lo que están describiendo? Cuando Isaac Newton, allá por el año 1687, formuló cómo debían moverse los planetas alrededor del Sol, estaba claro para todo el mundo lo que significaban sus ecuaciones: que los planetas están siempre en una posición bien definida en el espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades con el tiempo.

Pero para los electrones todo esto es muy diferente. Su comportamiento parece estar envuelto en la bruma. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de forma tal que con su explicación se pudo seguir trabajando y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la “interpretación de Copenhague” de la Mecánica Cuántica. En vez de decir que el electrón se encuentra en el punto x o en el punto y, nosotros hablamos del estado del electrón. Ahora no tenemos el estado “x” o el estado “y”, sino estados “parcialmente x” o “parcialmente y. Un único electrónpuede encontrarse, por lo tanto, en varios lugares simultáneamente. Precisamente lo que nos dice la Mecánica Cuántica es como cambia el estado del electrón según transcurre el tiempo.

Un “detector” es un aparato con el cual se puede determinar si una partícula está o no presente en algún lugar pero, si una partícula se encuentra con el detector su estado se verá perturbado, de manera que sólo podemos utilizarlo si no queremos estudiar la evolución posterior del estado de la partícula. Si conocemos cuál es el estado, podemos calcular la probabilidad de que el detector registre la partícula en el punto x.

Las leyes de la Mecánica Cuántica se han formulado con mucha precisión. Sabemos exactamente como calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas simultáneamente. Por ejemplo, podemos determinar la velocidad de una partícula con mucha exactitud, pero entonces no sabremos exactamente dónde se encuentra; o, a la inversa. Si una partícula tiene “espín” (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

No es fácil explicar con sencillez de dónde viene esta incertidumbre, pero hay ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar.

¿Onda o partícula? ¡Ambas a la vez! ¿Cómo es eso?

Para que las reglas de la Mecánica Cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuanto más grande y más pesado es un objeto más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica.

Me gustaría referirme a esta exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por “holismo”, y que se podría definir como “el todo es más que la suma de las partes”.

Bien, si la Física nos ha enseñado algo, es justamente lo contrario: un objeto compuesto de un gran número de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (las partículas): basta que uno sepa sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que yo entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes.

Por ejemplo, la constante de Planck, h = 6,626075…x 10 exp. -34 julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros tales como Edwin Schrödinger, siempre presentaron serias objeciones a esta interpretación.

Quizá funcione bien, pero ¿Dónde está exactamente el electrón, en el punto x o en el punto y? Em pocas palabras, ¿dónde está en realidad?, ¿Cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Hasta hoy, muchos investigadores coinciden con la actitud pragmática de Bohr. Los libros de historia dicen que Bohr demostró que Einstein estaba equivocado. Pero no son pocos, incluyéndome a mí, los que sospechamos que a largo plazo el punto de vista de Einstein volverá: que falta algo en la interpretación de Copenhague. Las objeciones originales de Einstein pueden superarse, pero aún surgen problemas cuando uno trata de formular la mecánica cuántica para todo el Universo (donde las medidas no se pueden repetir) y cuando se trata de reconciliar las leyes de la mecánica cuántica con las de la Gravitación… ¡Infinitos!

La mecánica cuántica y sus secretos han dado lugar a grandes controversias, y la cantidad de disparates que ha sugerido es tan grande que los físicos serios ni siquiera sabrían por donde empezar a refutarlos. Algunos dicen que “la vida sobre la Tierra comenzó con un salto cuántico”, que el “libre albedrío” y la “conciencia” se deben a la mecánica cuántica: incluso fenómenos paranormales han sido descritos como efectos mecano-cuánticos.

Yo sospecho que todo esto es un intento de atribuir fenómenos “ininteligibles” a causas también “ininteligibles” (como la mecánica cuántica) dónde el resultado de cualquier cálculo es siempre una probabilidad, nunca una certeza.

Claro que, ahí están esas teorías más avanzadas y modernas que vienen abriendo los nuevos caminos de la Física y que, a mi no me cabe la menor duda, más tarde o más temprano, podrá explicar con claridad esas zonas de oscuridad que ahora tienen algunas teorías y que Einstein señalaba con acierto.

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? ¿Por qué están ahí? ¿Quiere eso decir que la Teoría de Einstein y la Mecánica Cuántica podrán al fin unirse en pacifico matrimonio sin que aparezcan los dichosos infinitos?

Bueno, eso será el origen de otro comentario que también, cualquier día de estos, dejaré aquí para todos ustedes.

Emilio Silvera Vázquez

Dic

11

Los Quarks invisibles

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

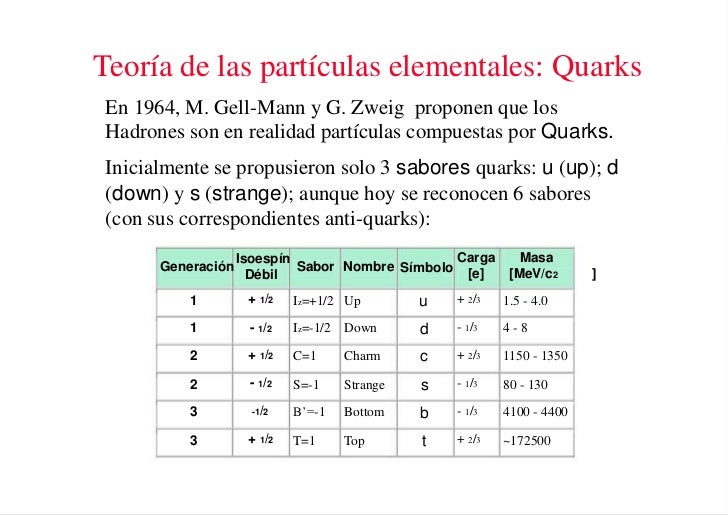

Una vez que se ha puesto orden entre las numerosas especies de partículas, se puede reconocer una pauta. Igual que Dimitri Ivanovich Mendeleev descubrió el sistema periódico de los elementos químicos en 1869, así también se hizo visible un sistema similar para las partículas. Esta pauta la encontraron independientemente el americano Murray Gell-Mann y el israelí Yuval Ne’eman. Ocho especies de mesones, todos con el mismo espín, u ocho especies de bariones, con el mismo espín, se podían reagrupar perfectamente en grupos que llamaremos multipletes. El esquema matemático correspondiente se llama SU(3). Grupletes de ocho elementos forman un octete “fundamental”. Por esta razón Gell-Mann llamó a esta teoría el “óctuplo camino”. Lo tomó prestado del budismo de acuerdo con el cual el camino hacia el nirvana es el camino óctuplo.

Rueda del dharma

El dharma chakra (o “rueda del darma”, “rueda de la ley”) es un símbolo que representa al dharma (‘ley’ o ‘religión’), en el hinduismo, el budismo y el jainismo. Ocasionalmente se traduce como ‘rueda de doctrina’. El dharmachakra o rueda del dharma.

El Noble Camino Óctuple es considerado, según el budismo, como la vía que lleva al cese del sufrimiento. Este cese del sufrimiento se conoce como nirvana. Puede ser que eso fuese lo que sintiera Gell-Mann al finalizar sus trabajos, y, de ahí la adopción del nombre y todo lo que lleva consigo de simbología.

El noble camino es una de las enseñanzas budistas fundamentales; la cuarta parte de las Cutro Nobles Verdades. En la simbología budista, el noble camino es usualmente representado con la rueda del dharma, donde cada rayo representa un elemento del sendero. Este símbolo también se utiliza para el budismo en general.

Los elementos del noble camino óctuple se subdividen en tres categorías básicas: sabiduría, conducta ética y entrenamiento de la mente (o meditación); para rehabilitar y desacondicionar la mente. En todos los elementos del noble camino, la palabra «correcta» es una traducción de la palabra “sammā” (en pali), que significa ‘plenitud’, ‘coherencia’, ‘perfección’ o ‘ideal’. El noble camino es: Sabiduría.

Pero sigamos con el trabajo.

Las matemáticas SU(3) también admiten multipletes de diez miembros. Cuando se propuso este esquema se conocían nueve bariones con espín 3/2. Los esquemas SU(3) se obtienen al representar dos propiedades fundamentales de las partículas, la extrañeza S frente al iso-espín I₃ , en una gráfica.

Primera observación de un neutrino en una cámara de burbujas, noviembre de 1970. El neutrino incidente golpea un protón (a la derecha en la foto). El neutrino se transforma en un leptón mu (la larga traza en medio de la foto). La traza corta es el protón. La tercera traza es de un mesón pi.

Arriba dos imágenes de trazas en la cámara de burbujas del primer evento observado incluyendo bariones Ω, en el Laboratorio Nacional Brookhaven. Dependiendo de su masa y tamaño las partículas producen distintos remolinos en la cámara de burbujas.

De esta manera, Gell-Mann predijo un décimo barión, el omega-menos (Ω¯), y pudo estimar con bastante precisión su masa porque las masas de los otros nueve bariones variaban de una forma sistemática en el gráfico (también consiguió entender que las variaciones de la masa eran una consecuencia de una interacción simple). Sin embargo, estaba claro que la Ω¯, con una extrañeza S = -3, no tenía ninguna partícula en la que desintegrarse que no estuviera prohibida por las leyes de conservación de la interacción fuerte. De modo que, la Ω¯ sólo podía ser de tan sólo 10¯²³ segundos como los demás miembros del multiplete, sino que tenía que ser del orden de 10¯¹⁰ segundos. Consecuentemente, esta partícula debería viajar varios centímetros antes de desintegrarse y esto la haría fácilmente detectable. La Ω¯ fue encontrada en 1964 con exactamente las mismas propiedades que había predicho Gell-Mann.

Se identificaron estructuras multipletes para la mayoría de los demás bariones y mesones y Gell-Mann también consiguió explicarlas. Sugirió que los mesones, igual que los bariones, debían estar formados por elementos constitutivos “más fundamentales aún”. Gell-Mann trabajaba en el Instituto de Tecnología de California en Pasadena (CalTech), donde conversaba a menudo con Richard Feynman. Eran ambos físicos famosos pero con personalidades muy diferentes. Gell-Mann, por ejemplo, es conocido como un entusiasta observador de Pájaros, familiarizado con las artes y la literatura y orgulloso de su conocimiento de lenguas extranjeras.

A comienzos de los años sesenta, un profesor del Instituto de Tecnología de California (Caltech) imparte un curso completo de física ante una cada día más numerosa. Su nombre: Richard Feynman

Feynman fue un hombre hecho a sí mismo, un analista riguroso que se reía de cualquier cosa que le recordara la autoridad establecida. Hay una anécdota que parece no ser cierta de hecho, pero que me parece tan buena que no puedo evitar el contarla; podía haber sucedido de esta forma. Gell-Mann le dijo a Feynman que tenía un problema, que estaba sugiriendo un nuevo tipo de ladrillos constitutivos de la materia y que no sabía qué nombre darles. Indudablemente debía haber de haber pensado en utilizar terminología latina o griega, como ha sido costumbre siempre en la nomenclatura científica. “Absurdo”, le dijo Feynman; “tú estás hablando de cosas en las que nunc ase había pensado antes. Todas esas preciosas pero anticuadas palabras están fuera de lugar. ¿Por qué no los llamas simplemente “shrumpfs”, “quacks” o algo así?”.

Los pequeños componentes de la materia ordinaria

Cuando algún tiempo después le pregunté a Gell-Mann, éste negó que tal conversación hubiera tenido lugar. Pero la palabra elegida fue quark, y la explicación de Gell-Mann fue que la palabra venía de una frase de Fynnegan’s Wake de James Joyce; “¡Tres quarks para Muster Mark!”. Y, efectivamente así es. A esas partículas les gusta estar las tres juntas. Todos los bariones están formados por tres quarks, mientras que los mesones están formados por un quark y un anti-quark.

Los propios quarks forman un grupo SU(3) aún más sencillo. Los llamaremos “arriba (u)”, “abajo” (d), y “extraño” (s). Las partículas “ordinarias” contienen solamente quarks u y d. Los hadrones “extraños” contienen uno o más quarks s (o antiquarks ŝ).

La composición de quarks de espín 3/2 se puede ver en cualquier tabla de física.. La razón por la que los bariones de espín ½ sólo forman un octete es más difícil de explicar. Está relacionada con el hecho de que en estos estados, al menos dos de los quarks tienen que ser diferentes unos de otros.

Junto con los descubrimientos de los Hadrones y de sus componentes, los Quarks, durante la primera mitad del sigo XX, se descubrieron otras partículas. Los Hadrones forman dos ramas, los mesones formados por dos quarks y los bariones por tres.

.

.

:format(jpg)/f.elconfidencial.com%2Foriginal%2Fdd9%2F7af%2F724%2Fdd97af724d3beb0d79794af2f42d5d52.jpg)

La Mecánica cuántica es muy extraña

Realmente, la idea de que los hadrones estuvieran formados por ladrillos fundamentales sencillos había sido también sugerida por otros. George Zweig, también en el Cal Tech, en Pasadena, había tenido la misma idea. Él había llamado a los bloques constitutivos “ases!, pero es la palabra “quark” la que ha prevalecido. La razón por la que algunos nombres científicos tienen más éxito que otros es a veces difícil de comprender.

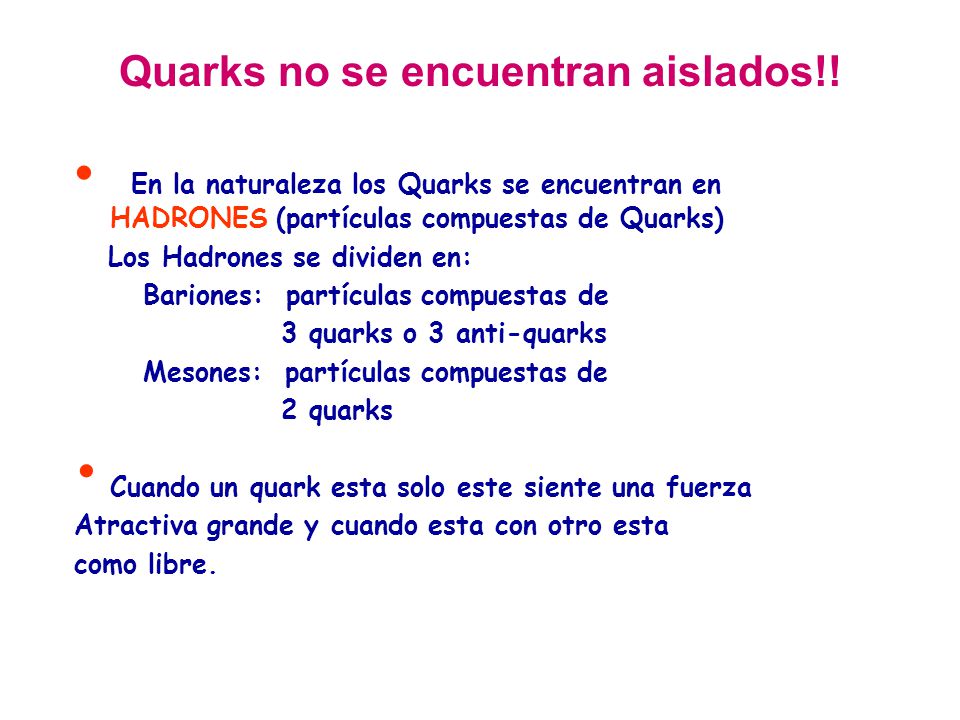

Pero en esta teoría había algunos aspectos raros. Aparentemente, los quarks (o ases) siempre existen en parejas o tríos y nunca se han visto solos. Los experimentadores habían intentado numerosas veces detectar un quark aislado en aparatos especialmente diseñados para ello, pero ninguno había tenido éxito.

Loa quarks –si se pudieran aislar- tendrían propiedades incluso más extrañas. Por ejemplo, ¿Cuáles serían sus cargas eléctricas? Es razonable suponer que tanto los quarks u como los quarks s y d deban tener siempre la misma carga. La comparación de la tabla 5 con la tabla 2 sugiere claramente que los quarks d y s tienen carga eléctrica -1/3 y el quark u tiene carga +2/3. Pero nunca se han observado partículas que no tengan carga múltiplo de la del electrón o de la del protón. Si tales partículas existieran, sería posible detectarlas experimentalmente. Que esto haya sido imposible debe significar que las fuerzas que las mantienen unidas dentro del hadrón son necesariamente increíblemente eficientes.

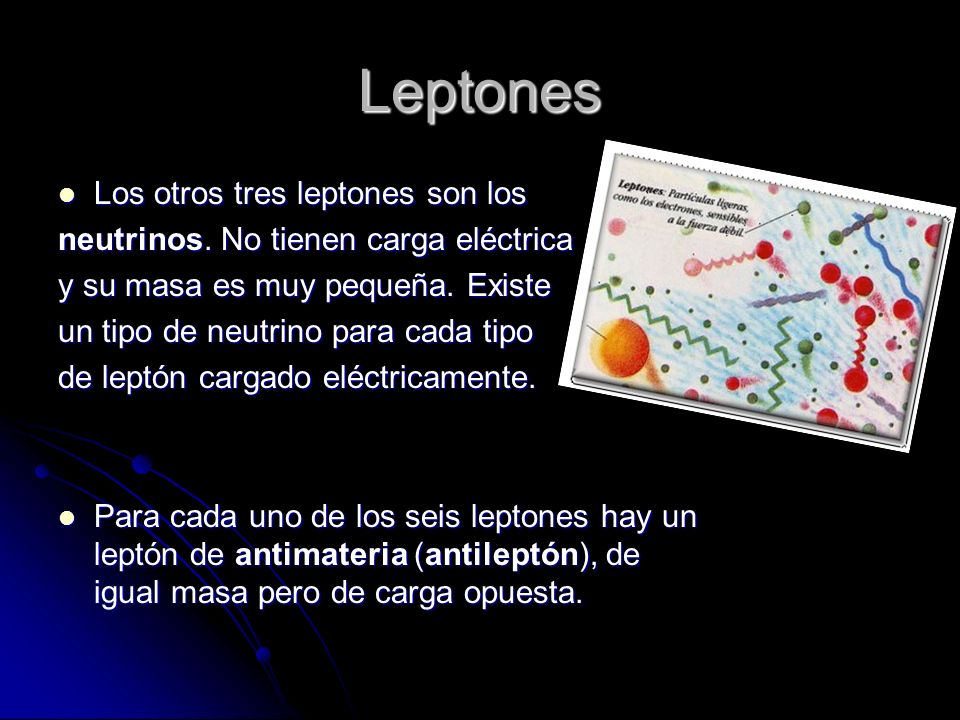

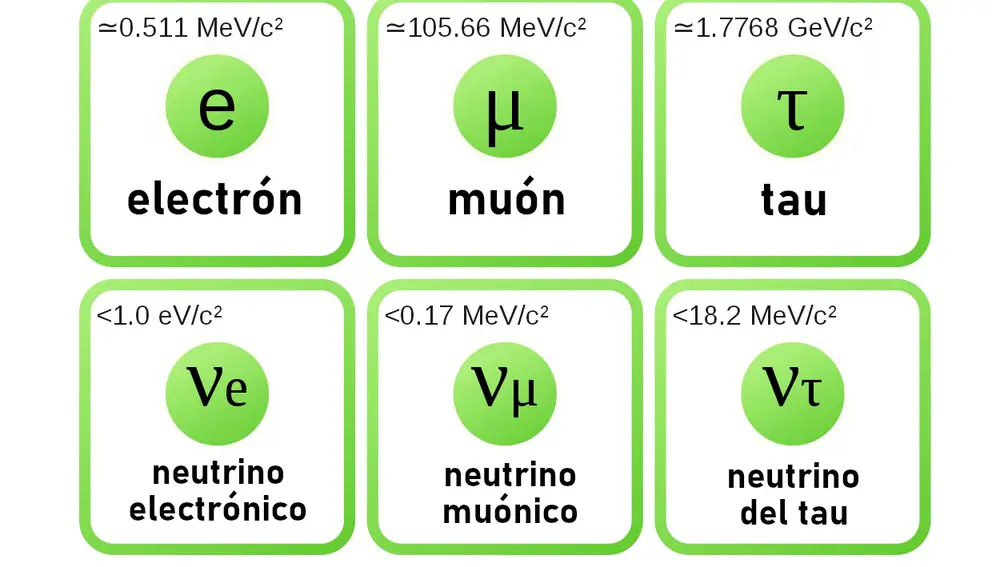

Todos sabemos que los Leptones son: El electrón, el muón y la partícula Tau y, cada una de ellas tiene su tipo de neutrino: el electrónico, el muónico y el tauónico.

Aunque con la llegada de los quarks se ha clarificado algo más la flora y la fauna de las partículas subatómicas, todavía forman un conjunto muy raro, aún cuando solamente unas pocas aparezcan en grandes cantidades en el universo (protones, neutrones, electrones y fotones). Como dijo una vez Sybren S. de Groot cuando estudiaba neutrinos, uno realmente se enamora de ellos. Mis estudiantes y yo amábamos esas partículas cuyo comportamiento era un gran misterio. Los leptones, por ser casi puntuales, son los más sencillos, y por tener espín se ven afectados por la interacción que actúa sobre ellos de forma muy complicada, pero la interacción débil estaba bastante bien documentada por entonces.

Los hadrones son mucho más misteriosos. Los procesos de choque entre ellos eran demasiado complicados para una teoría respetable. Si uno se los imagina como pequeñas esferas hachas de alguna clase de material, aún quedaba el problema de entender los quarks y encontrar la razón por la que se siguen resistiendo a los intentos de los experimentadores para aislarlos.

Emilio Silvera Vázquez

Si queréis saber más sobre el tema, os recomiendo leer el libro Partículas de Gerard ´t Hooft

Dic

6

Observando el movimiento combinado de núcleos y electrones

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

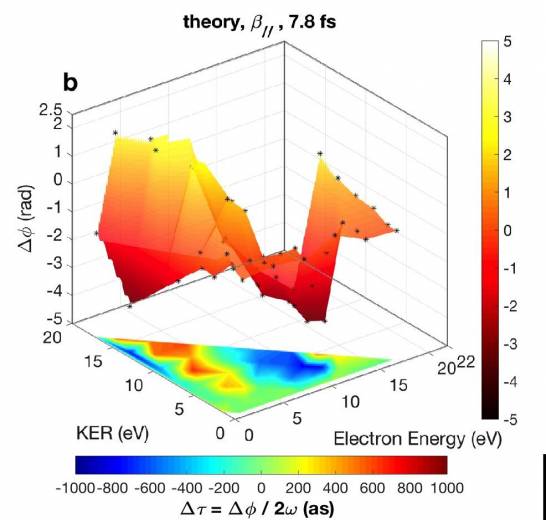

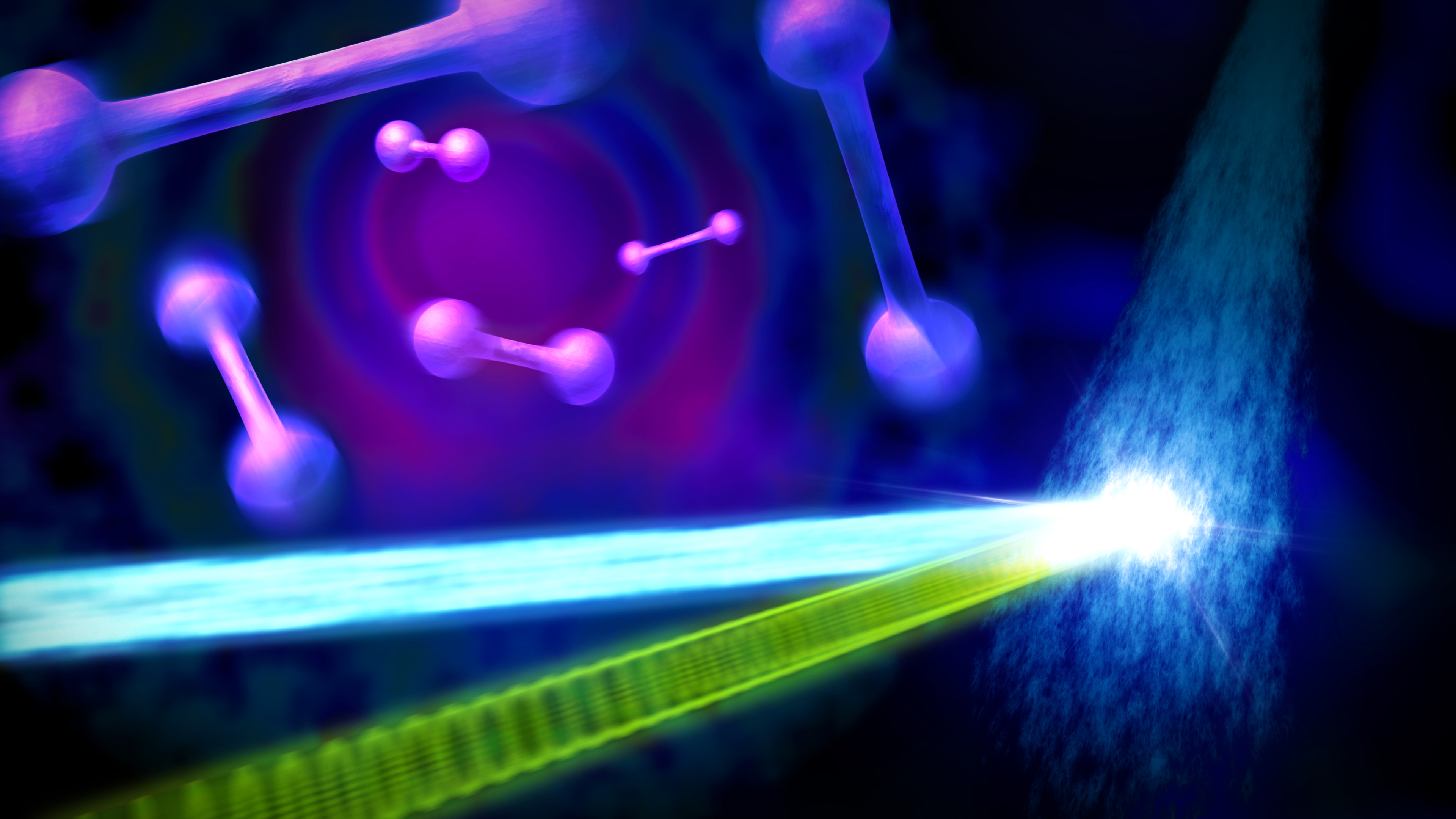

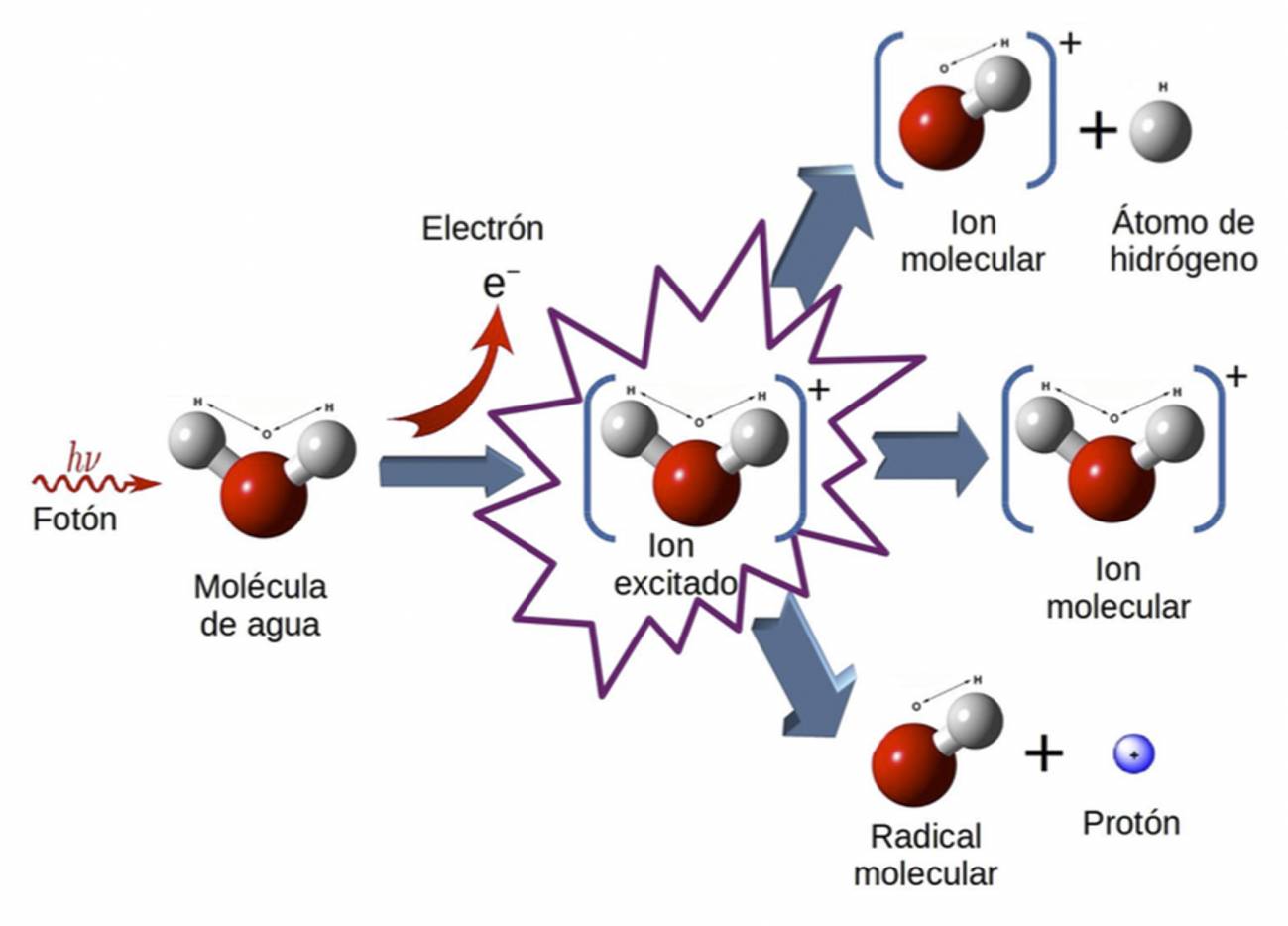

… IMDEA Nanociencia y el Instituto Politécnico de Zurich han logrado observar por primera vez el movimiento correlacionado de electrones y núcleos …

Gracias a los espectaculares avances que la tecnología láser ha experimentado en la última década, hoy es posible visualizar el movimiento de los electrones en el interior de átomos y moléculas. Para esto se utilizan pulsos de luz ultravioleta o de rayos X con una duración de tan sólo unos pocos cientos de atto-segundos (10 -18 segundos), que es la escala de tiempo en la que se mueven los electrones de forma natural.

Para esto se utilizan pulsos de luz ultravioleta o de rayos X con una duración de tan sólo unos pocos cientos de attosegundos, que es la escala de tiempo en la que se mueven los electrones de forma natural. En una molécula, además de los electrones, también se mueven los núcleos atómicos que la componen.

En una molécula, además de los electrones, también se mueven los núcleos atómicos que la componen. En un reciente trabajo publicado en la revista Nature Physics, investigadores de la Universidad Autónoma de Madrid (UAM) (España), IMDEA Nanociencia e Instituto Politécnico de Zurich observaron por primera vez el movimiento combinado de electrones y núcleos en la molécula de hidrógeno (H2), demostrando explícitamente que existe una enorme interdependencia entre ellos.

Como electrones y núcleos son los responsables de la formación de enlaces químicos en las moléculas (desde el H2 al ADN), estos resultados abren la puerta a manipular las propiedades de estos enlaces actuando indistintamente sobre electrones o núcleos en intervalos de tiempos del orden de los atto-segundos.

Observando el movimiento combinado de núcleos y electrones

Las reacciones químicas son consecuencia de la rotura y formación de enlaces entre núcleos atómicos en una molécula, lo que conduce a la formación de otras moléculas distintas. El que los enlaces se formen o se rompan se debe principalmente al movimiento de los electrones, que con su carga eléctrica negativa apantallan la repulsión entre los núcleos de carga eléctrica positiva.

Sin embargo, estos últimos también se mueven, con lo que la reactividad química es en realidad un proceso dinámico que resulta del movimiento combinado de electrones y núcleos. En general, el movimiento de los núcleos es mucho más lento que el de los electrones, porque los primeros son mucho más pesados que los segundos.

![OC] Nubes de electrones de hidrógeno en 2D : r/dataisbeautiful](https://preview.redd.it/p41rvqbfyka51.jpg?auto=webp&s=23a4bf4ae359b5c2bc5b38a78937799da1cc60e0)

La figura muestra que el tiempo que tarda el electrón en abandonar la molécula de hidrógeno depende fuertemente de la energía del protón y viceversa, demostrando el alto grado de correlación que existe entre ambos tipos de movimiento. (Foto: UAM)

Por ejemplo, el núcleo más ligero que existe, el del átomo de hidrógeno (protón, p+), es aproximadamente 1.800 veces más pesado que un electrón (e-). Sin embargo, cuando una molécula absorbe energía de una fuente externa, por ejemplo la luz, los núcleos pueden llegar a moverse casi tan rápido como los electrones (dependiendo de cómo se repartan la energía entre ellos).

La mecánica cuántica nos mostró un “mundo” asombroso

En estos casos, cabe esperar que el movimiento de núcleos y electrones esté correlacionado, es decir, que el movimiento de unos condicione el movimiento de los otros. Como muchas de las reacciones químicas se inician irradiando las moléculas con luz externa, visualizar este movimiento correlacionado en tiempo real es de enorme importancia para entender cómo se producen tales reacciones.

“En nuestro grupo ya habíamos demostrado anteriormente que la combinación de pulsos de luz de attosegundos y femtosegundos con el denominado esquema bombeo-sonda, donde uno de los pulsos induce una cierta dinámica en un átomo o molécula y el otro toma ‘fotografías’ de la misma en distintos instantes, permitiendo visualizar el movimiento de uno o varios electrones, incluso cuando estos últimos se mueven de forma concertada”, afirma Fernando Martín, investigador de la UAM y director del trabajo.

Observación en tiempo real del movimiento correlacionado de núcleos y electrones

Por su parte, la coautora Alicia Palacios, también investigadora de la UAM, añade: “En este trabajo hemos demostrado que, utilizando un esquema bombeo-sonda en combinación con técnicas de detección de multi-coincidencia en las que se mide simultáneamente la energía y el momento de electrones y núcleos, es posible visualizar a la vez el movimiento de ambos tipos de partículas. Además, este movimiento está en efecto correlacionado”.

Para llegar a esta conclusión, los científicos realizaron un experimento en el que la molécula de hidrógeno se bombardeó con un tren de pulsos ultravioletas de atto-segundos, sincronizado con un pulso infrarrojo de femtosegundos, y variaron el retardo entre ambos tipos de pulsos con una precisión de tan solo unas decenas de atto-segundos.

Esta secuencia de pulsos produce inevitablemente la ionización y la disociación de la molécula, dando lugar a la emisión de un electrón, un protón y un átomo de hidrógeno. La detección del electrón (e-) y del protón (p+) en coincidencia para todos los retrasos temporales, en combinación con elaborados cálculos mecano-cuánticos, permitió visualizar el movimiento concertado de estas dos partículas en la molécula.

Las gráficas muestran que el tiempo que tarda el electrón en abandonar la molécula de hidrógeno depende fuertemente de la energía del protón y viceversa, demostrando el alto grado de correlación que existe entre ambos tipos de movimiento. (Fuente: UAM)

Totales: 75.451.213

Totales: 75.451.213 Conectados: 62

Conectados: 62

![Vista del atardecer en un planeta oceánico en alguna parte del Universo [1920 × 1080] : r/wallpaper](https://preview.redd.it/8ctgq94mwh041.jpg?width=640&crop=smart&auto=webp&s=89d7e0d0e369d94fd142b8d221ac1c307a5cde24)