Nov

24

Fuerzas invisibles que inciden en nuestras vidas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

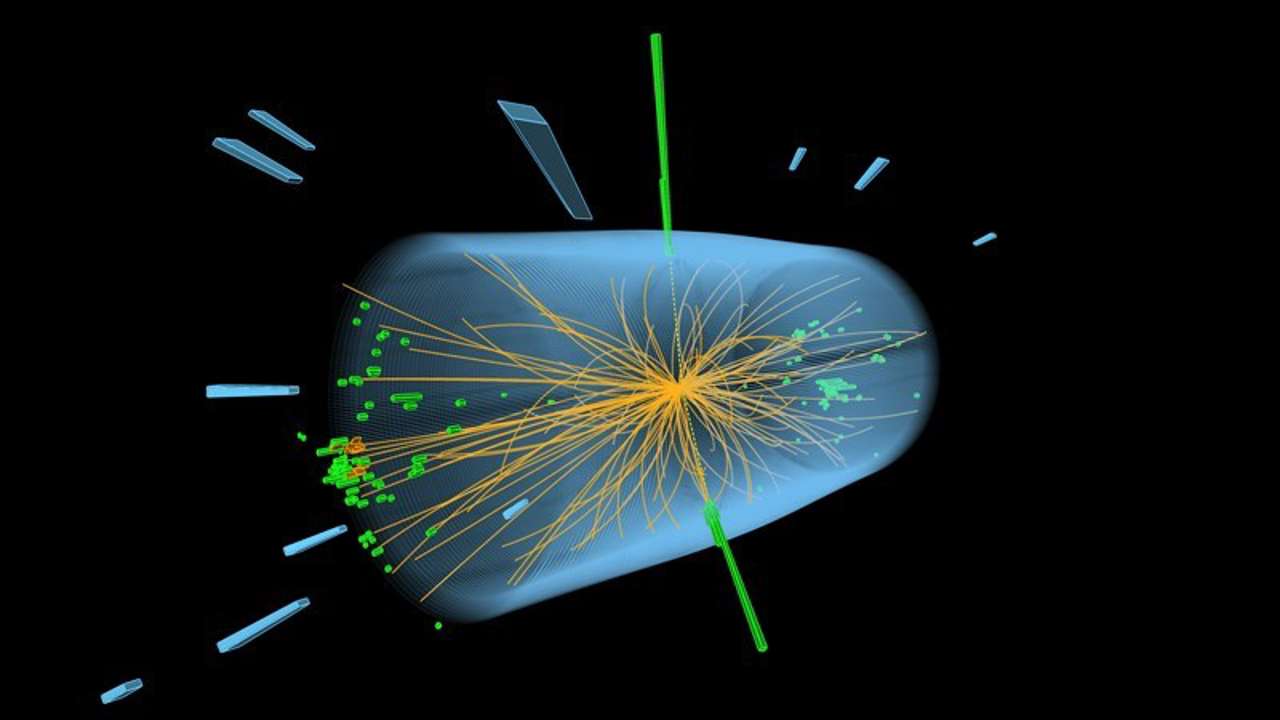

El LHC nos lleva a las entrañas de la Materia

¡La Naturaleza! Que tenemos que descubrir

Tratamos de buscar el origen de la vida y sabemos que comenzó con base química y debido a una serie de parámetros que conforman parte de las llamadas constantes de la Naturaleza, el surgir de aquella primera célula replicante que inició la fascinante aventura de la vida, el evolucionar de la materia “inerte”… ¡Hasta los pensamientos! ¿La Consciencia de Ser?

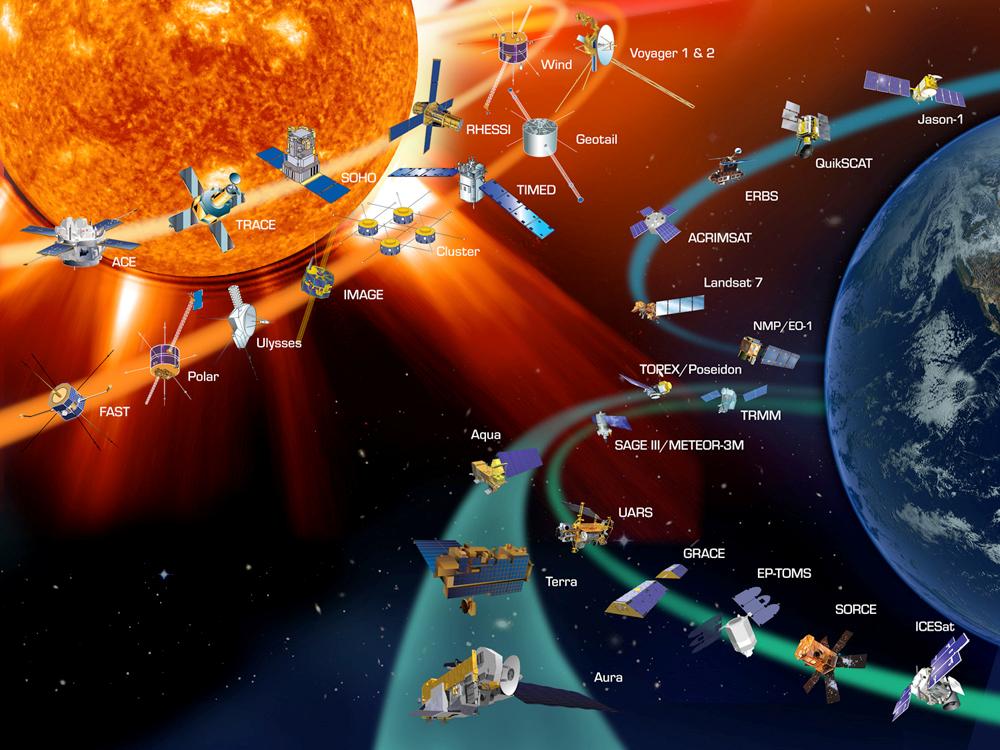

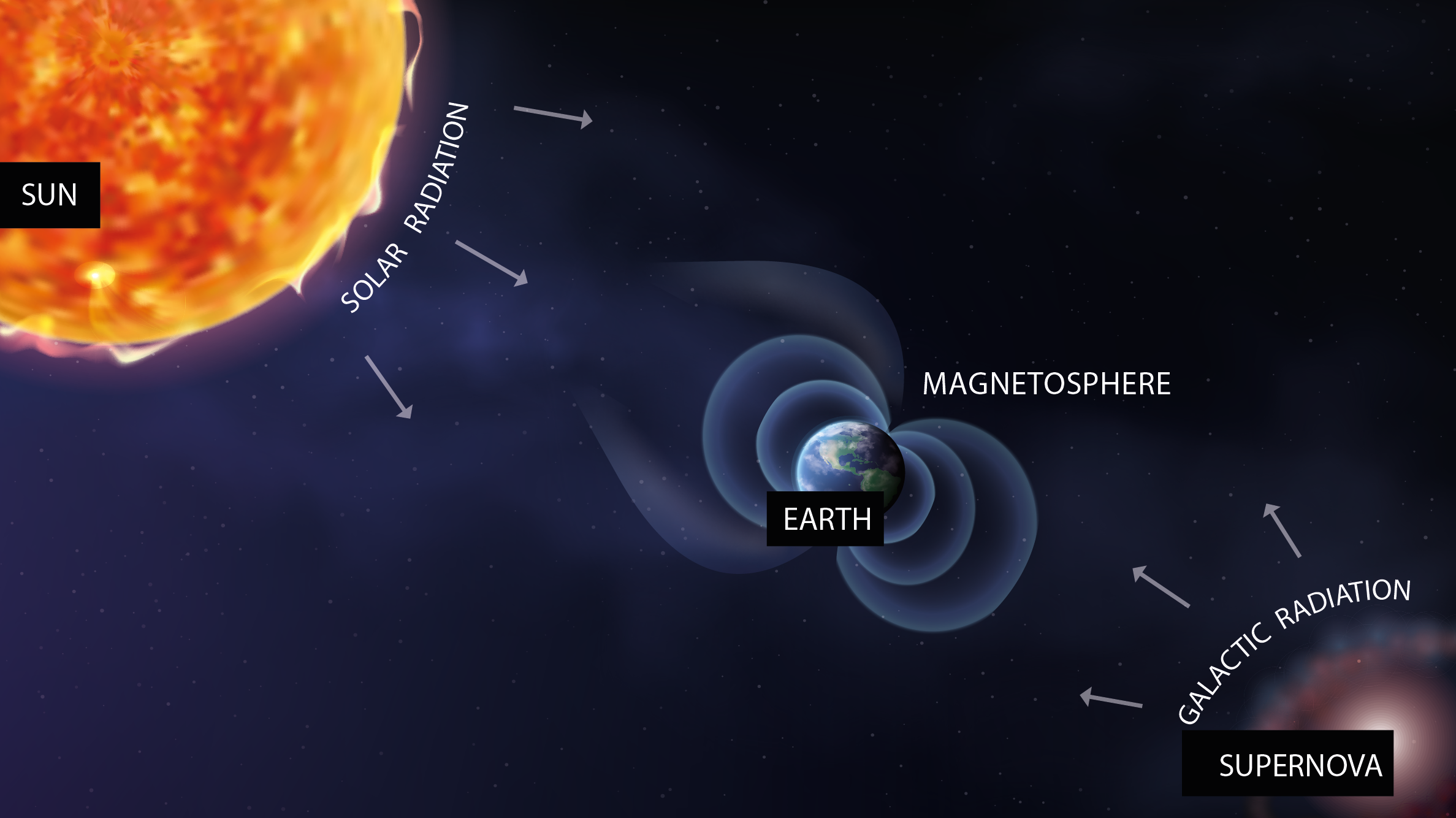

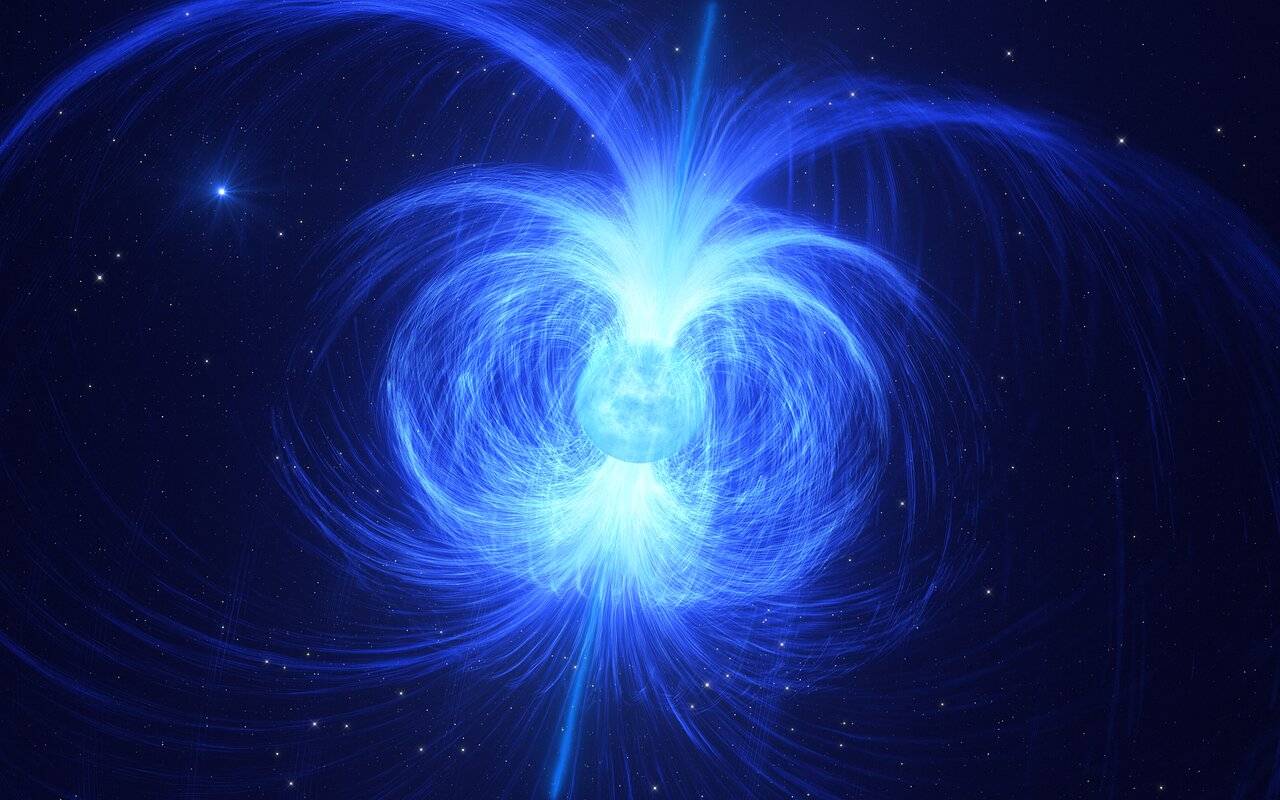

Es ampliamente sabido que el planeta Tierra actúa como un gran imán cuyas líneas de campo geomagnético surgen de un polo (el polo sur magnético) y convergen en el otro polo (polo norte magnético). El eje longitudinal de este imán tiene una desviación de aproximadamente 11^o con respecto al eje de rotación. Por ello, los polos del campo magnético generado no coinciden exactamente con los polos geográficos.

Este campo geomagnético es producido por la combinación de varios campos generados por diversas fuentes, pero en un 90% es generado por la exterior del núcleo de la Tierra (llamado Campo Principal o “Main Field”).

Por otra , la interacción de la ionosfera con el viento solar y las corrientes que fluyen por la corteza terrestre componen la mayor del 10% restante. Sin embargo, durante las tormentas solares (eventos de actividad solar exacerbada) pueden introducirse importantes variaciones en el campo magnético terrestre.

Las grandes tormentas solares inciden sobre nosotros y nuestras obras

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

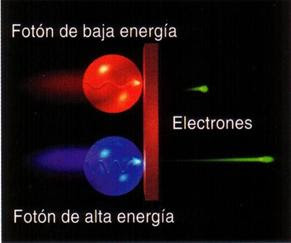

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

![[stephan_quinteto_2009_hubble.jpg]](http://3.bp.blogspot.com/_xBXZbW6ivIs/SqpvjP3SBJI/AAAAAAAAEqc/fh3ULAFurbs/s1600/stephan_quinteto_2009_hubble.jpg)

Muchas veces he comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10–15 metros, o lo que es lo mismo, 0’000000000000001 metros.

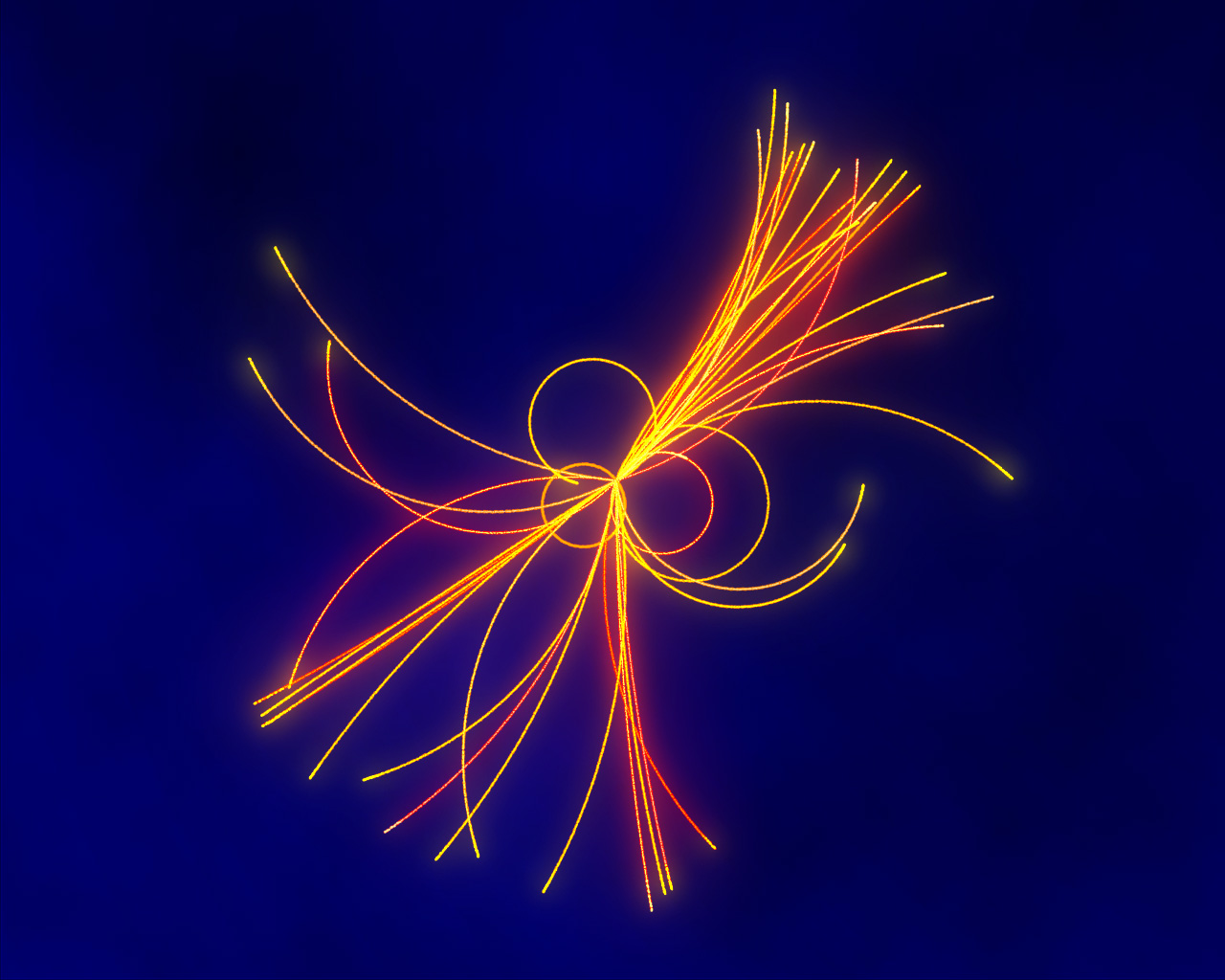

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo indica (glueen inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

Una de las fuentes productoras de rayos cósmicos es el Sol. Abundante e imperceptible, como una tormenta muda, a todas horas caen sobre nosotros millones de partículas elementales. No hay paraguas que frene el torrente de neutrinos solares que atraviesa cada centímetro cuadrado de nuestro planeta y nuestro cuerpo, como imágenes espectrales de sí mismos. Desde arriba, de día, y desde abajo, de noche. La energía que la mayoría de ellos transporta apenas alcanza la milésima parte de la masa de un protón.

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

Emilio Silvera Vázquez

Nov

20

El enigma del Neutrón

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

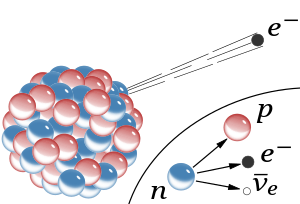

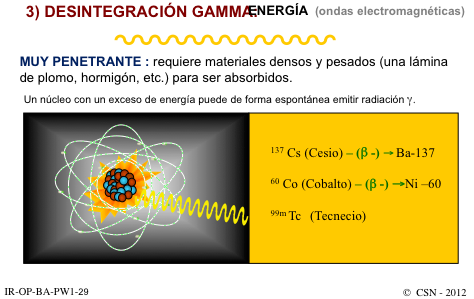

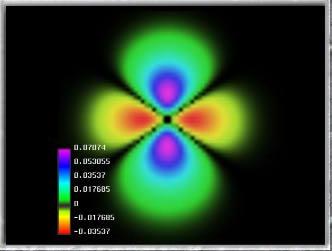

Decaimiento β– de un núcleo. Se ilustra cómo uno de los neutrones se convierte en un protón a la vez que emite un electrón (β-) y un antineutrino electrónico.

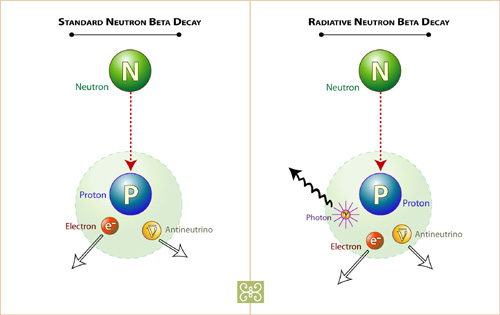

La desintegración Beta del neutrón está mediada por un Bosón W–,que transforma uno de sus quarks, y se desintegra en el par electrón-antineutrino. Ahora leamos el reportaje de la Revista “Investigación y Ciencia”, referido a la física de partículas y a unas mediciones efectuadas que no son coincidentes.

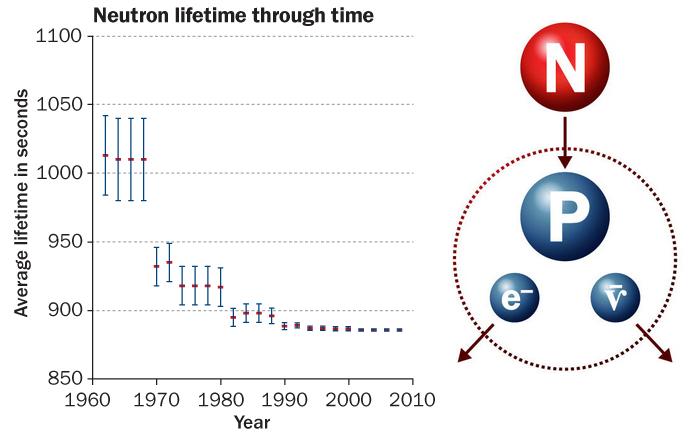

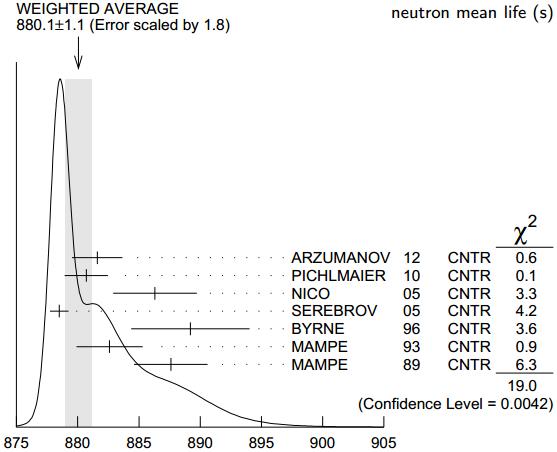

“Dos técnicas de precisión arrojan valores distintos para el tiempo que tardan los neutrones en desintegrarse. ¿Se trata de un error experimental, o hay un misterio más profundo?

En síntesis

Un neutrón libre es un neutrón que existe fuera de un núcleo atómico. Mientras que los neutrones pueden ser estables cuando están unidos dentro de los núcleos, los neutrones libres son inestables y se desintegran con una vida media de 886 segundos, unos quince minutos.

Los neutrones libres no son estables: pasados unos 15 minutos, un neutrón se desintegra en un protón, un electrón y un antineutrino. Conocer con exactitud su vida media es clave para abordar varias cuestiones en física y cosmología.

Existen dos métodos para determinar con precisión la vida media de esta partícula. El primero cuenta los neutrones que quedan en un recipiente después de cierto tiempo; el segundo cuenta los protones generados en su desintegración.

Hace años que una y otra técnica arrojan valores considerablemente dispares. Se cree que la discrepancia obedece a errores sistemáticos en alguno de los experimentos; sin embargo, hasta ahora nadie ha logrado dar con ellos.

Así hemos podido desvelar el secreto de que como se dice antes y se ve en la imagen, el neutrón al desintegrarse sigue este camino:

14 6C → 14 7N + e–

Este proceso ocurre espontáneamente en neutrones libres, en el transcurso de 885.7(8) s de vida media.

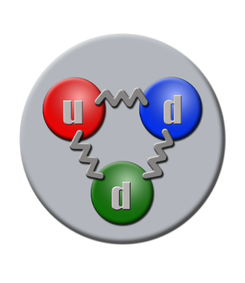

Un neutrón está formado por dos quarks dowm (abajo) y un quark up (arriba), tiene una vida media de 14,761 minutos, es una partícula de la familia de los hadrones en su vertiente bariónica, interacción: con la Gravedad, la nuclear débil y la nuclear fuerte, su símbolo es n, su antipartícula es el antineutrón, la teorizo Rutherford y la descubrió James Chadwick, su masa es de 1,674 927 29(28)×10−27 K., la carga eléctrica es cero, espín ½. Se conoce cuando forma parte del átomo por nucleón.

Por suerte para la vida en la Tierra, la mayor parte de la materia no es radiactiva. Aunque no solemos darle demasiada importancia, este hecho no deja de resultar sorprendente, ya que el neutrón (uno de los constituyentes, junto con el protón, de los núcleos atómicos) es propenso a desintegrarse. En el interior de un núcleo típico el neutrón puede vivir durante largo tiempo, pero, aislado, se desintegra en otras partículas en unos 15 minutos. Decimos «unos 15 minutos» para ocultar nuestra ignorancia al respecto, ya que, hasta ahora, no hemos sido capaces de medir con exactitud la vida media de esta partícula.

El neutrón y el protón forman los núcleos de los átomos; el protón es estable (su vida media es superior a 10³² años, según PDG 2012), pero el neutrón es inestable (vía la interacción electrodébil se desintegra en un protón) y aislado su vida media es de solo 880,1 ± 1,1 segundos (14 minutos y 40,1 segundos).

Profundizar hasta el núcleo del átomo… ¡Es llegar a la maravilla! ¿Cómo en una parte de cien mil (que es lo que ocupa el núcleo en el átomo), puede estar el 99 por ciento de la masa del átomo, los nucleones (que son los hadrones de la rama bariónica), que están conformados por tripletes de Quarks, y, conocidos como protones y neutrones. Los Quarks están allí confinados y retenidos por la fuerza nuclear fuerte que es transmitida por partículas de la familia de los Bosones, los gluones. Si Los Quarks tratan de separarse son retenidos por la fuerza nuclear, ya que esta fuerza actúa al revés de las otras tres fuerza de la naturaleza, es decir, aumenta con la distancia. Lo dicho, una maravilla.

Hace años que una y otra técnica arrojan valores considerablemente dispares. Se cree que la discrepancia obedece a errores sistemáticos en alguno de los experimentos; sin embargo, hasta ahora nadie ha logrado dar con ellos.

Resolver este «rompecabezas de la vida media del neutrón» no solo supone una cuestión de orgullo para nuestro gremio, el de los físicos experimentales, sino que resulta también vital para comprender mejor las leyes físicas. La desintegración del neutrón constituye uno de los procesos más sencillos en los que interviene la interacción débil, una de las cuatro fuerzas fundamentales de la naturaleza. Para entenderla por completo, hemos de saber cuánto tarda un neutrón aislado en desintegrarse. Por otro lado, la vida media del neutrón condicionó cómo se formaron los elementos químicos más ligeros después de la gran explosión que dio origen a nuestro universo. A los cosmólogos les gustaría poder calcular las abundancias esperadas de los distintos elementos y contrastarlas con los datos obtenidos por los astrofísicos. Un acuerdo apuntalaría nuestras teorías cosmológicas, mientras que una discrepancia indicaría la existencia de fenómenos físicos aún por descubrir. Pero, para poder llevar a cabo dicha comparación, hemos de conocer con exactitud cuánto vive un neutrón antes de desintegrarse.

Hace más de diez años, dos grupos experimentales, uno en Francia y otro en EE.UU., intentaron medir con precisión la vida media del neutrón. Uno de nosotros (Geltenbort) pertenecía al primer equipo, mientras que el otro (Greene) trabajaba en el segundo. Con sorpresa y cierta inquietud, comprobamos que nuestros resultados diferían de manera considerable. Algunos teóricos sugirieron que la discrepancia podría deberse a fenómenos físicos exóticos, como que parte de los neutrones se hubiesen desintegrado en partículas nunca antes observadas. Nosotros, sin embargo, achacamos la diferencia a una razón mucho más mundana: uno de los grupos —o ambos— tenía que haber cometido algún error o sobreestimado la precisión de sus resultados.

Hace poco, el equipo estadounidense completó un largo y concienzudo proyecto para estudiar la principal fuente de error que afectaba a sus mediciones. Lejos de zanjar la cuestión, sus esfuerzos solo confirmaron los resultados previos. Al mismo tiempo, otros investigadores verificaron los resultados del grupo de Geltenbort. Esta discrepancia nos ha dejado más perplejos de lo que ya estábamos, pero no hemos abandonado. Por el momento, ambos equipos y otros físicos experimentales seguimos buscando una respuesta.

CRONOMETRAR NEUTRONES

El neutrón y el protón forman los núcleos de los átomos; el protón es estable (su vida media es superior a 10³² años, según PDG 2012), pero el neutrón es inestable (vía la interacción electrodébil se desintegra en un protón) y aislado su vida media es de solo 880,1 ± 1,1 segundos (14 minutos y 40,1 segundos)

En teoría, determinar la vida media del neutrón es sencillo. Entendemos bien la física del proceso y disponemos de las herramientas adecuadas para estudiarlo. Sabemos que, siempre que una partícula pueda desintegrarse en otras de menor masa, acabará haciéndolo si en el proceso se conservan ciertas propiedades, como la carga eléctrica o el espín. En la llamada desintegración beta, un neutrón se transforma en un protón, un electrón y un antineutrino. Las masas de estas tres partículas suman algo menos que la masa del neutrón, pero la carga y el espín totales permanecen idénticos. Entre las cantidades conservadas se incluye la suma de masa y energía, por lo que las tres partículas finales incorporan esa pequeña diferencia de masa en forma de energía cinética.”

Nota: El artículo me ha sido enviado por Don José Gómez, un contertulio y visitante de ésta página que, con buen criterio, apunta que en cuanto a esas diferencias, las pruebas deben ser repetidas en distintos lugares y, si es posible, por distintos científicos también, ya que, en física de partícula, los resultados de un experimento, debe coincidir sin fisuras.

Nov

20

Estructuras fundamentales del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

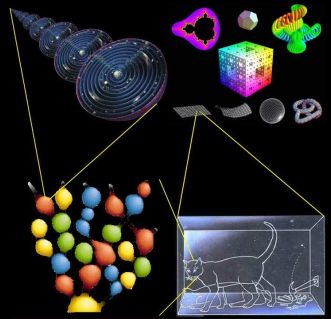

Estructuras Fundamentales de la Naturaleza

Hemos llegado a poder discernir la relación directa que vincula el tamaño, la energía de unión y la edad de las estructuras fundamentales de la Naturaleza. Una molécula es mayor y más fácil de desmembrar que un átomo; lo mismo podemos decir de un átomo respecto al núcleo atómico, y de un núcleo con respecto a los quarks que contiene.

La cosmología sugiere que esta relación resulta del curso de la historia cósmica, que los quarks se unieron primero, en la energía extrema del big bang original, y que a medida que el Universo se expandió, los protones y neutrones compuestos de quarks se unieron para formar núcleos de átomos, los cuales, cargados positivamente, atrajeron a los electrones cargados con electricidad negativa estableciéndose así como átomos completos, que al unirse formaron moléculas y estas, a su vez, juntas en una inmensa proporción, forman los cuerpos que podemos ver a lo largo y lo ancho de todo el universo. Grandes estructuras y cúmulos y supercúmulos de galaxias que están hechos de la materia conocida como bariónica, es decir, de Quarks y Leptones (todo lo que existe está formado por estas dos partículas).

Si es así, cuanto más íntimamente examinemos la Naturaleza, tanto más lejos hacia atrás vamos en el tiempo. Alguna vez he puesto el ejemplo de mirar algo que nos es familiar, el dorso de la mano, por ejemplo, e imaginemos que podemos observarlo con cualquier aumento deseado.

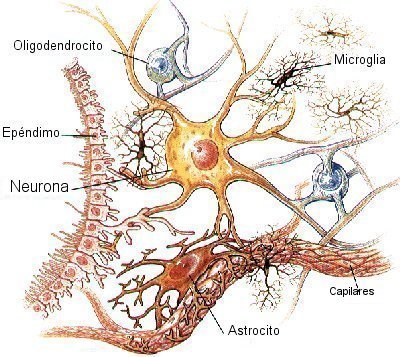

Con un aumento relativamente pequeño, podemos ver las células de la piel, cada una con un aspecto tan grande y complejo como una ciudad, y con sus límites delineados por la pared celular. Si elevamos el aumento, veremos dentro de la célula una maraña de ribosomas serpenteando y mitocondrias ondulantes, lisosomas esféricos y centríolos, cuyos alrededores están llenos de complejos órganos dedicados a las funciones respiratorias, sanitarias y de producción de energía que mantienen a la célula.

Ya ahí tenemos pruebas de historia. Aunque esta célula particular solo tiene unos pocos años de antigüedad, su arquitectura se remonta a más de mil millones de años, a la época en que aparecieron en la Tierra las células eucariota o eucarióticas como la que hemos examinado.

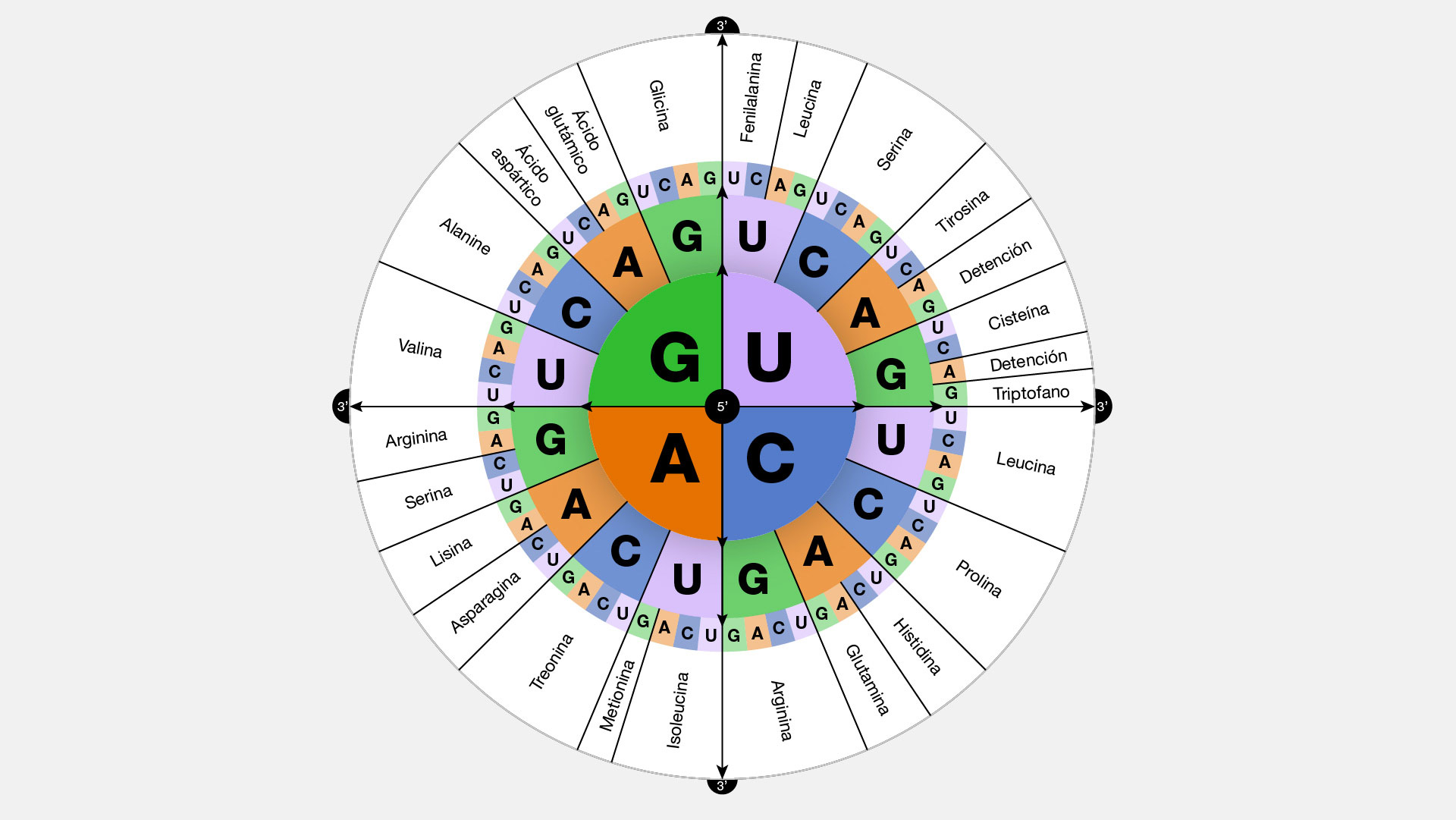

Para determinar dónde obtuvo la célula el esquema que le indicó como formarse, pasemos al núcleo y contemplemos los delgados contornos de las macromoléculas de ADN segregadas dentro de sus genes. Cada una contiene una rica información genética acumulada en el curso de unos cuatro mil millones de años de evolución.

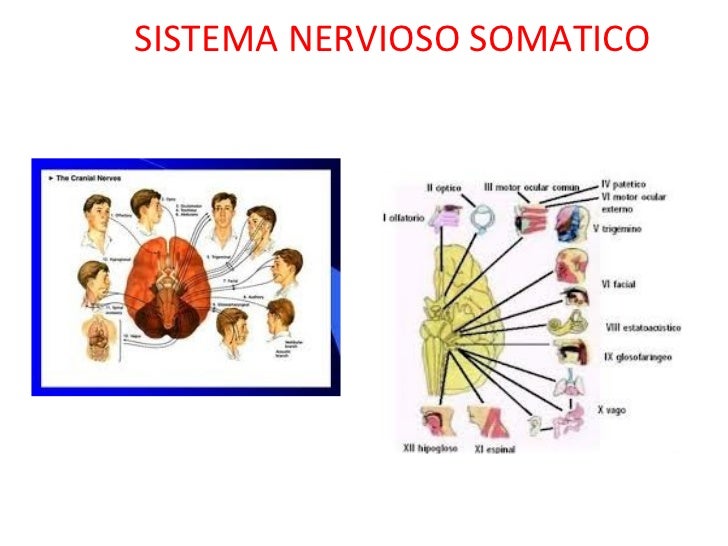

Sistema nervioso somático

Incluye grupos de neuronas que llevan información desde los órganos sensoriales (incluyendo toda la piel) hasta el sistema nervioso central (principalmente hasta el cordón espinal). A estos grupos de neuronas se les llama neuronas sensoriales o aferentes.

a. Las neuronas que recogen información directamente de los órganos sensoriales son neuronas especializadas con formas y sensibilidad particular. Por lo regular, estas neuronas tienen abundantes dendritas y axones cortos.

b. Por su parte, las neuronas que llevan información desde los órganos sensoriales hasta el sistema nervioso central suelen tener menos dendritas y axones largos. Grupos de estos axones forman lo que generalmente conocemos como nervios. Estos muestran un color blanco debido a la abundancia de capas de mielina, característico de los axones. A estos grupos de axones se les conoce como nervios sensoriales o aferentes.

Almacenado en un alfabeto de nucleótidos de cuatro “letras”- hecho de moléculas de azúcar y fosfatos, y llenos de signos de puntuación, reiteraciones para precaver contra el error, y cosas superfluas acumuladas en los callejones sin salida de la historia evolutiva-, su mensaje dice exactamente cómo hacer un ser humano, desde la piel y los huesos hasta las células cerebrales.

Si elevamos más el aumento veremos que la molécula de ADN está compuesta de muchos átomos, con sus capas electrónicas externas entrelazadas y festoneadas en una milagrosa variedad de formas, desde relojes de arena hasta espirales ascendentes como largos muelles y elipses grandes como escudos y fibras delgadas como puros. Algunos de esos electrones son recién llegados, recientemente arrancados átomos vecinos; otros se incorporaron junto a sus núcleos atómicos hace más de cinco mil millones de años, en la nebulosa de la cual se formó la Tierra.

Si elevamos el aumento cien mil veces, el núcleo de un átomo de carbono se hinchará hasta llenar el campo de visión. Tales núcleos átomos se formaron dentro de una estrella que estalló mucho antes de que naciera el Sol. Si podemos aumentar aún más, veremos los tríos de quarks que constituyen protones y neutrones.

Los quarks han estado unidos desde que el Universo sólo tenía unos pocos segundos de edad

Al llegar a escalas cada vez menores, también hemos entrado en ámbitos de energías de unión cada vez mayores. Un átomo puede ser desposeído de su electrón aplicando sólo unos miles de electrón-voltios de energía. Sin embargo, para dispersar los nucleones que forman el núcleo atómico se requieren varios millones de electrón-voltios, y para liberar los quarks que constituyen cada nucleón se necesitaría cientos de veces más energía aún.

Introduciendo el eje de la historia, esta relación da testimonio del pasado de las partículas: las estructuras más pequeñas, más fundamentales están ligadas por niveles de energía mayores porque las estructuras mismas fueron forjadas en el calor del Big Bang.

Nos cuesta asimilar que la evolución de la materia se pudiera elevar (bajo un sin fin de parámetros y transmutaciones muy complejos), hasta alcanzar la consciencia y llegar a generar pensamientos. Parece como si el Universo hubiera sabido que nosotros (también otros seres similares e inteligentes en otros mundos del inmenso Cosmos), teníamos que venir y, para ello, creó sistemas idóneos para la vida como el planeta Tierra y muchos otros de su clase que ofrecen tal cobijo a criaturas vivas.

Los aceleradores de partículas, como los telescopios, funcionen como máquinas del tiempo. Un telescopio penetra en el pasado en virtud del tiempo que tarda la luz en desplazarse entre las estrellas; un acelerador recrea, aunque sea fugazmente, las condiciones que prevalecían en el Universo primitivo. En la imagen de arriba podemos ver como el Telescopio Espacial Hubble, poco a poco, ha podido ir avanzando hacia atrtás en el tiempo para enseñarnos las imágenes captadas cuando el Universo era muy joven. ¿Podremos algún día fabricar telescopios tan potentes que puedan captar imágenes del universo vecino?

Hemos llegado a dominar técnicas asombrosas que nos facilitan ver aquello que, prohibido para nuestro físico, sólo lo podemos alcanzar mediante sofisticados aparatos que bien nos introduce en el universo microscópico de los átomos, o, por el contrario nos llevan al Universo profundo y nos enseña galaxias situadas a cientos y miles de millones de años-luz de la Tierra.

Cuando vemos esos objetos cosmológicos lejanos, cuando estudiamos una galaxia situada a 100.000 mil años-luz de nosotros, sabemos que nuestros telescopios la pueden captar gracias a que, la luz de esa galaxia, viajando a 300.000 Km/s llegó a nosotros después de ese tiempo, y, muchas veces, no es extraño que el objeto que estamos viendo ya no exista o si existe, que su conformación sea diferente habiéndose transformado en diferentes transiciones de fase que la evolución en el tiempo ha producido.

Siempre hemos querido saber lo que hay más allá de lo que el ojo ve

En el ámbito de lo muy pequeño, vemos lo que está ahí en ese momento pero, como se explica más arriba, en realidad, también nos lleva al pasado, a los inicios de cómo todo aquello se formó y con qué componentes que, en definitiva, son los mismos de los que están formadas las galaxias, las estrellas y los planetas, una montaña y un árbol y, cualquiera de nosotros que, algo más evolucionado que todo lo demás, podemos contarlo aquí.

Estas y otras muchas maravillas son las que nos permitirán, en un futuro relativamente cercano, que podamos hacer realidad muchos sueños largamente dormidos en nuestras mentes.

Emilio Silvera Vázquez

Nov

15

¿Una familia de partículas inmortales?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

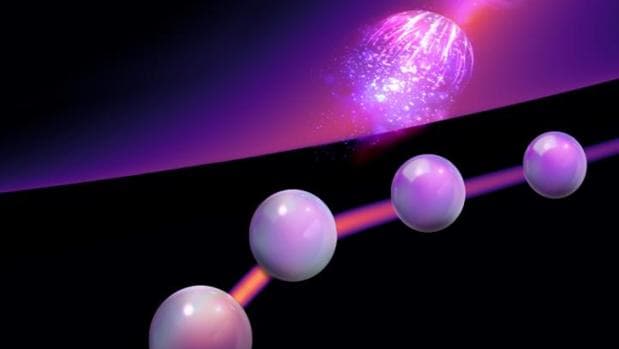

Las interacciones cuánticas convierten a las cuasipartículas en inmortales – K. Verresen / TUM

Por primera vez, un equipo de físicos comprueba que las cuasipartículas renacen de sus cenizas después de desintegrarse

Si hay algo en lo que todos estamos de acuerdo es que nada dura para siempre. Lo dicen las leyes de la Física, en concreto la segunda ley de la termodinámica, que es la que rige el destino del Universo: toda actividad o proceso incrementa la entropía de un sistema. O lo que es lo mismo, el desorden. Por eso envejecemos, por eso las estrellas se apagan, los átomos se descomponen y por eso, también, los cristales de un vaso que se ha roto jamás volverán a recomponerse.

Pero un equipo de investigadores de la Universidad Técnica de Munich, en el Instituto Max Planck para la Física de Sistemas Complejos, parece haber hallado una excepción a esta norma universal. De hecho, han descubierto que lo que parece inconcebible en nuestra experiencia cotidiana puede estar sucediendo en el misterioso mundo cuántico. Y que allí, unos extraños entes llamados “cuasipartículas” tienen la propiedad de desintegrarse y volver a renacer después de sus propias cenizas, en una serie de ciclos que no tienen fin y que las convierte, de hecho, en inmortales. El extraordinario hallazgo se acaba de publicar en Nature Physics.

Las cuasipartículas pueden describirse como un extraño fenómeno de “excitación colectiva” que sucede en el interior de los cuerpos sólidos. Cuando, por ejemplo, un electrón se mueve en el interior de un sólido, su movimiento se ve perturbado por las interacciones con otros muchos electrones, o núcleos atómicos, que también se están moviendo. Y eso hace que, a pesar de seguir comportándose como un electón libre, tenga una masa diferente, que recibe el nombre de “cuasipartícula de electrones”. Otras cuasipartículas incluyen a los fonones, que son partículas derivadas de las vibraciones de los átomos dentro de un sólido, a los plasmones, que son partículas derivadas de las oscilaciones de un plasma, y a muchas otras, como los famosos fermiones de Majorana, que son a la vez materia y antimateria, los fluxones, los plasmones o los solitones.

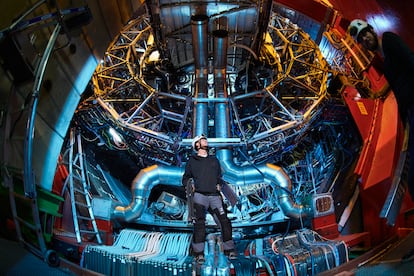

En los grandes aceleradores de partículas podemos observar sus comportamientos y desvelar sus secretos

A pesar de que una cuasipartícula implica a todas las partículas que, con sus movimientos, se afectan unas a otras, pueden ser consideradas como partículas individuales que se mueven en el interior de un sistema, rodeadas por una nube de otras partículas que se apartan de su camino o que son arrastradas por su movimiento. El concepto de cuasipartículas fue acuñado por el físico y ganador del premio Nobel Lev Davidovich Landau. Lo usó para describir estados colectivos de muchas partículas o más bien sus interacciones debido a fuerzas eléctricas o magnéticas. A causa de estas interacciones, varias partículas actúan como una sola.

“Hasta ahora -explica Frank Pollmann, uno de los autores del artículo- se suponía que las cuasipartículas en sistemas cuánticos interactivos decaen después de un cierto tiempo. Pero ahora sabemos que no es así: las interacciones fuertes pueden, incluso, detener la descomposición por completo”.

“Hasta el momento -prosigue el investigador- no se sabía con detalle qué procesos influyen en el destino de esas cuasipartículas en sistemas que interactúan. Pero ahora contamos con métodos numéricos con los que podemos calcular interacciones complejas, y computadoras con un rendimiento lo suficientemente alto como para resolver estas ecuaciones”.

Con estas armas a su disposición, los investigadores llevaron a cabo complejas simulaciones para “espiar” a las cuasipartículas. “Es cierto que se desintegran -explica por su parte Ruben Verresen, autor principal del estudio- pero nuevas entidades de partículas idénticas emergen de los escombros. Si el decaimiento se produce muy rápidamente, después de un cierto tiempo se produce una reacción inversa y los escombros vuelven a converger. Este proceso puede repetirse sin fin, como una oscilación sostenida en el tiempo entre decaimiento y renacimiento”.

Muerte y resurrección

La mecánica cuántica tiene muchas implicaciones que no llegamos a comprender

Desde el punto de vista de la Física, esa oscilación entre “muerte y resurrección” puede considerarse como una onda que se transforma en materia, en virtud de la dualidad onda-partícula que predice la mecánica cuántica. Por lo tanto, las cuasipartículas inmortales no violan la segunda ley de la termodinámica. Su entropía permanece constante, la decadencia se detiene.

Cada día damos un paso más en el conocimiento de lo muy pequeño

El descubrimiento, además, consigue también explicar una serie de fenómenos que hasta ahora habían desconcertado a los científicos. Los físicos experimentales, por ejemplo, han medido que el compuesto magnético Ba3CoSB2O9 es sorprendentemente estable, cuando no debería serlo. Ahora se sabe que los magnones, un tipo de cuasipartículas magnéticas, son las responsables de ello. Del mismo modo, otras cuasipartículas, los fotones hacen posible que el helio, que en la superficie de la Tierra es un gas, se convierta en un líquido a -273 grados centígrados (el cero absoluto, donde la actividad atómica se detiene) y pueda seguir fluyendo sin restricciones.

“Nuestro trabajo es pura investigación básica -enfatiza Pollmann-. Sin embargo, es perfectamente posible que algún día nuestros resultados permitan incluso aplicaciones, por ejemplo, la construcción de memorias de datos duraderas para futuras computadoras cuánticas”.

Noticias

Nov

15

Siempre buscaremos nuevas teorías de la Física y del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

Una reacción nuclear “desafiante”

Una nueva clase de reacción de fisión nuclear observada en el CERN ha mostrado importantes puntos débiles en nuestro entendimiento actual del núcleo atómico. La fisión del mercurio-180 se suponía una reacción “simétrica” que daría lugar a dos fragmentos iguales, pero en lugar de ello ha producido dos núcleos con masas bastante diferentes, una reacción “asimétrica” que plantea un serio desafío a los teóricos.

La Ciencia no duerme. En todo el mundo (ahora también fuera de él -en el espacio), son muchos los Científicos que trabajan de manera tenaz para buscar nuevas formas de alcanzar lo ahora inalcanzable y, para ello, se emplean las más sofisticadas estructuras técnicas de avanzados sistemas tecnológicos que hacen posible llegar allí donde nunca nadie había llegado.

Entre los teóricos, el casamiento de la relatividad general y la teoría cuántica es el problema central de la física moderna. A los esfuerzos teóricos que se realizan con ese propósito se les llama “super-gravedad”, “súper-simetría”, “super-cuerdas” “teoría M” o, en último caso, “teoría de todo o gran teoría unificada”.

Esta es una vista hemisférica de Venus, los colores representan las elevaciones. Cortesía de NASA/JPL.

El segundo planeta a partir del Sol. Tiene la órbita más circular de todos los planetas. Su albedo geométrico medio, 0,65, es el mayor de todos los planetas, como resultado de su cubierta de nubes blancas sin fracturas. En su máximo alcanza magnitud -4,7, mucho más brillante que cualquier otro planeta. Su eje de rotación está inclinado casi 180º con respecto a la vertical, de manera que su rotación es retrógrada. Rota alrededor de su eje cada 243 días, y, por tanto, muestra siempre la misma cara hacia la Tierra cuando los dos planetas se encuentran en su máxima aproximación.

La atmósfera de Venus es en un 96,5% de dióxido de carbono y un 3,5 de nitrógeno, con trazas de dióxido de azufre, vapor de agua, argón, hidrógeno y monóxido de carbono. La presión en la superficie es de 92 bares (es decir, 92 veces la presión a nivel del mar en la Tierra). La temperatura superficial promedio es de 460 ºC debido al “efecto invernadero” en la atmósfera del planeta. Los rayos son muy frecuentes. Existe una densa capa de nubes a una altitud de unos 45/65 Km. compuesta de ácido sulfúrico y gotitas de agua.

VENUS: El Planeta Imposible

Mundos inimaginables que tendrán, como en el nuestro, formas de vida de una rica diversidad que ni podemos imaginar. Simplemete en una galaxia, por ejemplo la nuestra, existen cientos de miles de millones de planetas de los más diversos pelajes, y, no pocos, serán muy parecidos a nuestra Tierra y estarán situados en la zona adecuada para que, la vida, pudiera surgir en ellos como lo hizo aquí, toda vez que, tanto aquellos planetas como el nuestro, están sometidos a las mismas fuerzas, a las mismas constantes, y, en consecuencia, a situaciones iguales, ¡iguales resultados!

Nuestros sueños de visitar mundos remotos, y, en ellos, encontrar otras clases de vida, otras inteligencias, es un sueño largamente acariaciado por nuestras mentes que, se resisten a estar sólas en un vasto Universo que, poseyendo cientos de miles de millones de mundos, también debe estar abarrotados de una diversidad Biológica inimaginable. No creo que estémos sólos en tan vasto universo.

Hace algún tiempo que los medios publicaron la noticias:

“Físicos británicos creen que el bosón de Higgs y su relación con la gravedad puede ser la clave para crear una ecuación única que explique el Universo entero.”

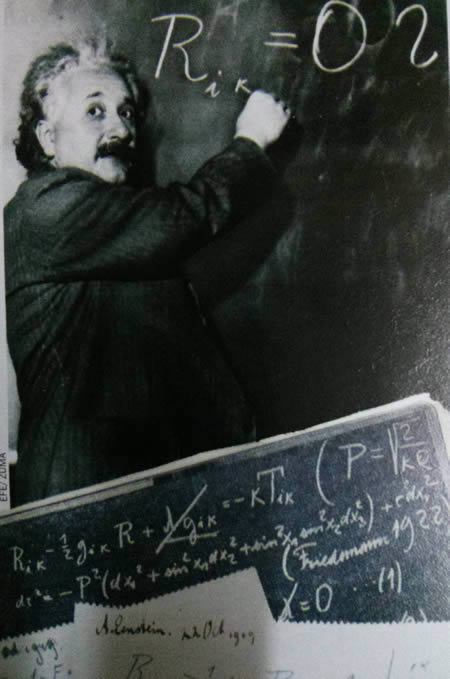

Imagen de Archivo donde Einstein escribe una ecuación sobre la densidad de la Vía Láctea en el Instituto Carnegie en Pasadena (California)

“La teoría del todo, también conocida como teoría unificada, fue el sueño que Einstein nunca pudo cumplir. Consiste en una teoría definitiva, una ecuación única que explique todos los fenómenos físicos conocidos y dé respuesta a las preguntas fundamentales del Universo. Esa teoría unificaría la mecánica cuántica y la relatividad general, dos conocimientos aceptados pero que describen el Cosmos de forma muy diferente. Albert Einstein no consiguió formularla. Tampoco nadie después de él, pero sigue siendo la ambición de muchos científicos. En este empeño, físicos de la británica Universidad de Sussex han dado un nuevo paso para probar que solo hay una fuerza fundamental en la naturaleza. Creen haber observado como el campo de Higgs interactúa con la Gravedad.”

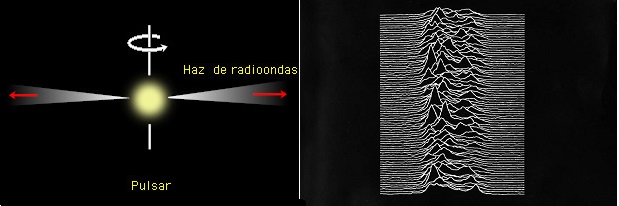

Si hablamos de nuestra Galaxia, la Vía Láctea, lo hacemos de algo que tiene 100.000 millones de años-luz de diámetro y más de ciento cincuenta mil millones de estrellas, no digamos de mundos y otra infinidad de objetos de exótica estructura e increíbles conformaciones que, como los púlsares, los agujeros negros o los magnétares, no dejan de asombrarnos.

Somos, una especie viviente que ha llegado a poder generar pensamientos y crear teorías encaminadas a descubrir la verdad de la Naturaleza, y, nuestra aparente “insignificante presencia”, podría ser un signo de que, el universo “ha permitido” observadores para que lo expliquen y se pueda comprender.

Tenemos el Universo dentro de nuestras mentes. Bueno, lo cierto es que… ¡Somos parte de él!

El universo es un lugar tan maravilloso, rico y complejo que el descubrimiento de una teoría final, en el sentido en el que está planteada la teoría de supercuerdas, no supondría de modo alguno el fin de la ciencia ni podríamos decir que ya lo sabemos todo y para todo tendremos respuestas. Más bien será, cuando llegue, todo lo contrario: el hallazgo de esa teoría de Todo (la explicación completa del universo en su nivel más microscópico, una teoría que no estaría basada en ninguna explicación más profunda) nos aportaría un fundamento mucho más firme sobre el que podríamos construir nuestra comprensión del mundo y, a través de estos nuevos conocimientos, estaríamos preparados para comenzar nuevas empresas de metas que, en este momento, nuestra ignorancia no nos dejan ni vislumbrar. La nueva teoría de Todo nos proporcionaría un pilar inmutable y coherente que nos daría la llave para seguir explorando un universo más comprensible y por lo tanto, más seguro, ya que el peligro siempre llega de lo imprevisto, de lo desconocido que surge sin aviso previo; cuando conocemos bien lo que puede ocurrir nos preparamos para evitar daños.

Una Teoría que abarcará a todas las demás

Algunos dicen que para cuando tengamos una Teoría de Todo, el mundo habrá cambiado, habrá pasado tanto tiempo que, para entonces, la teoría habrá quedado vieja y se necesitará otra nueva teoría más avanzada. Eso significa, si es así, que nunca tendremos una explicación de todo y siempre quedarán cuestiones enigmáticas que tendremos que tesolver. ¡Menos mal!

La búsqueda de esa teoría final que nos diga cómo es el Universo, el Tiempo y el Espacio, la Materiay los elementos que la conforman, las Fuerzas fundamentales que interaccionan con ella, las constantes universales y en definitiva, una formulación matemática o conjunto de ecuaciones de las que podamos obtener todas las respuestas, es una empresa nada fácil y sumamente complicada; la teoría de cuerdas es una estructura teórica tan profunda y complicada que incluso con los considerables progresos que se han realizado durante las últimas décadas, aún nos queda un largo camino antes de que podamos afirmar que hemos logrado dominarla completamente. Se podría dar el caso de que el matemático que encuentre las matemáticas necesarias para llegar al final del camino, aún no sepa ni multiplicar y esté en primaria en cualquier escuela del mundo civilizado. Por otra parte, siempre andamos inventando ecuaciones para todo, que expliquen este o aquel enigma que deseamos conocer.

Lo cierto es que, no conocemos el futuro que le espera a la Humanidad pero, tal desconocimiento no incide en el hecho cierto de que siempre estemos tratando de saber el por qué de las cosas y, seguramente, si Einstein hubiera conocido la existencia de las cuatro fuerzas fundamentales, habría podido avanzar algo más, en su intento de lograr esa ecuación maravillosa que “todo” lo pudiera explicar. Se pasó sus últimos 30 años buscando la Teoría del Todo, y, en un escaparate de la 5ª Avda. en Nueva York, exponían sus ecuaciones, la gente, se amontonaban para verlas y, lo cierto es que no entendían nada… ¡La curiosidad humana!

Muchos de los grandes científicos del mundo (Einstein entre ellos), aportaron su trabajo y conocimientos en la búsqueda de esta teoría, no consiguieron su objetivo pero sí dejaron sus ideas para que otros continuaran la carrera hasta la meta final. Por lo tanto, hay que considerar que la teoría de cuerdas es un trabajo iniciado a partir de las ecuaciones de campo de la relatividad general de Einstein, de la mecánica cuántica de Planck, de las teorías gauge de campos, de la teoría de Kaluza-Klein, de las teorías de… hasta llegar al punto en el que ahora estamos.

Comprender de manera armoniosa cómo se juntan las dos mejores teorías de la física que tenemos actualmente, la cuántica y la relatividad general… ¡Sin que surjan infinitos!

La armoniosa combinación de la relatividad general y la mecánica cuántica será un éxito muy importante. Además, a diferencia de lo que sucedía con teorías anteriores, la teoría de cuerdas tiene la capacidad de responder a cuestiones primordiales que tienen relación con las fuerzas y los componentes fundamentales de la naturaleza. Allí, en sus ecuaciones, aparece el esquivo gravitón implicándo con ello que la teoría contiene implícitamente una teoría cuántica de la Gravedad.

Ahora, en la nueva etapa del LHC, tratarán de buscar partículas Super-simétricas y las partículas componentes de la materia oscura, objetos que expliquen algunos enigmas sin resolver. Para ello emplearán nuevos métodos y nuevas energías, se quiere llegar hasta los 100 TeV, para el Bosón de Higss sólo hicieron falta 14 TeV, veremos que pasa.

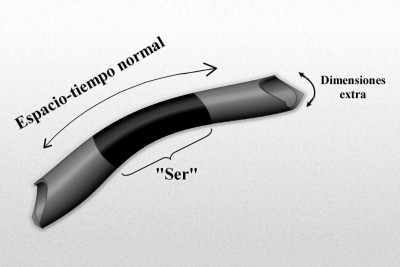

Igualmente importante, aunque algo más difícil de expresar, es la notable elegancia tanto de las respuestas que propone la teoría de cuerdas, como del marco en que se generan dichas respuestas. Por ejemplo, en la teoría de cuerdas muchos aspectos de la Naturaleza que podrían parecer detalles técnicos arbitrarios (como el número de partículas fundamentales distintas y sus propiedades respectivas) surgen a partir de aspectos esenciales y tangibles de la geometría del universo. Si la teoría de cuerdas es correcta, la estructura microscópica de nuestro universo es un laberinto multidimensional ricamente entrelazado, dentro del cual las cuerdas del universo se retuercen y vibran en un movimiento infinito, marcando el ritmo de las leyes del cosmos.

¿Serán las cuerdas las que hacen de nuestro Universo el que es?

Lejos de ser unos detalles accidentales, las propiedades de los bloques básicos que construyen la naturaleza están profundamente entrelazadas con la estructura del espacio-tiempo. En nuestro Universo, aunque no pueda dar esa sensación a primera vista, cuando se profundiza, podemos observar que, de alguna manera, todo está conectado, de la misma manera, nuestras mentes son parte del universo y, en ellas, están todas las respuestas.

Claro que, siendo todos los indicios muy buenos, para ser serios, no podemos decir aún que las predicciones sean definitivas y comprobables para estar seguros de que la teoría de cuerdas ha levantado realmente el velo de misterio que nos impide ver las verdades más profundas del universo, sino que con propiedad se podría afirmar que se ha levantado uno de los picos de ese velo y nos permite vislumbrar algo de lo que nos podríamos encontrar, a través de esa fisura parece que se escapa la luz de la comprensión que, en su momento, se podría alcanzar.

Muchos sueñan con encontrar esa Teoría del Todo

Mientras que la soñada teoría llega, nosotros estaremos tratando de construir ingenios que como el GEO600, el más sensible detector de ondas gravitacionales que existe ( capaz de detectar ínfimas ondulaciones en la estructura del espacio-tiempo ), nos pueda hablar de otra clase de universo. Hasta el momento el universo conocido es el que nos muestran las ondas electromagnéticas de la luz pero, no sabemos que podríamos contemplar si pudiéramos ver ese otro universo que nos hablan de la colisión de agujeros negros…por ejemplo.

“El detector de ondas gravitacionales GEO 600, de Hannover, en Alemania, registró un extraño ruido de fondo que ha traído de cabeza a los investigadores que en él trabajan. El actual director del Fermilab de Estados Unidos, el físico Carl Hogan, ha propuesto una sorprendente explicación para dicho ruido: proviene de los confines del universo, del rincón en que éste pasa de ser un suave continuo espacio-temporal, a ser un borde granulado. De ser cierta esta teoría, dicho ruido sería la primera prueba empírica de que vivimos en un universo holográfico, asegura Hogan. Nuevas pruebas han de ser aún realizadas con el GEO 600 para confirmar que el misterioso ruido no procede de fuentes más obvias. “

La teoría de cuerdas, aunque en proceso de elaboración, ya ha contribuido con algunos logros importantes y ha resuelto algún que otro problema primordial como por ejemplo, uno relativo a los agujeros negros, asociado con la llamada entropía de Bekenstein-Hawking, que se había resistido pertinazmente durante más de veinticinco años a ser solucionada con medios más convencionales. Este éxito ha convencido a muchos de que la teoría de cuerdas está en el camino correcto para proporcionarnos la comprensión más profunda posible sobre la forma de funcionamiento del universo, que nos abriría las puertas para penetrar en espacios de increíble “belleza” y de logros y avances tecnológicos que ahora ni podemos imaginar.

Como he podido comentar en otras oportunidades, Edward Witten, uno de los pioneros y más destacados experto en la teoría de cuerdas, autor de la versión más avanzada y certera, conocida como teoría M, resume la situación diciendo que: “la teoría de cuerdas es una parte de la física que surgió casualmente en el siglo XX, pero que en realidad era la física del siglo XXI“.

Witten, un físico-matemático de mucho talento, máximo exponente y punta de lanza de la teoría de cuerdas, reconoce que el camino que está por recorrer es difícil y complicado. Habrá que desvelar conceptos que aún no sabemos que existen.

Ellos nos legaron parte de las teorías que hoy manejamos en el mundo para tratar de conocer el Universo pero, sigue siendo insuficientes… ¡Necesitamos Nuevas Teorías! que nos lleven al conocimientos más profundos de la realidad en que se mueve la Naturaleza, sólo de esa manera, podremos seguir avanzando.

El hecho de que nuestro actual nivel de conocimiento nos haya permitido obtener nuevas perspectivas impactantes en relación con el funcionamiento del universo es ya en sí mismo muy revelador y nos indica que podemos estar en el buen camino al comprobar que las ecuaciones topológicas complejas de la nueva teoría nos habla de la rica naturaleza de la teoría de cuerdas y de su largo alcance. Lo que la teoría nos promete obtener es un premio demasiado grande como para no insistir en la búsqueda de su conformación final.

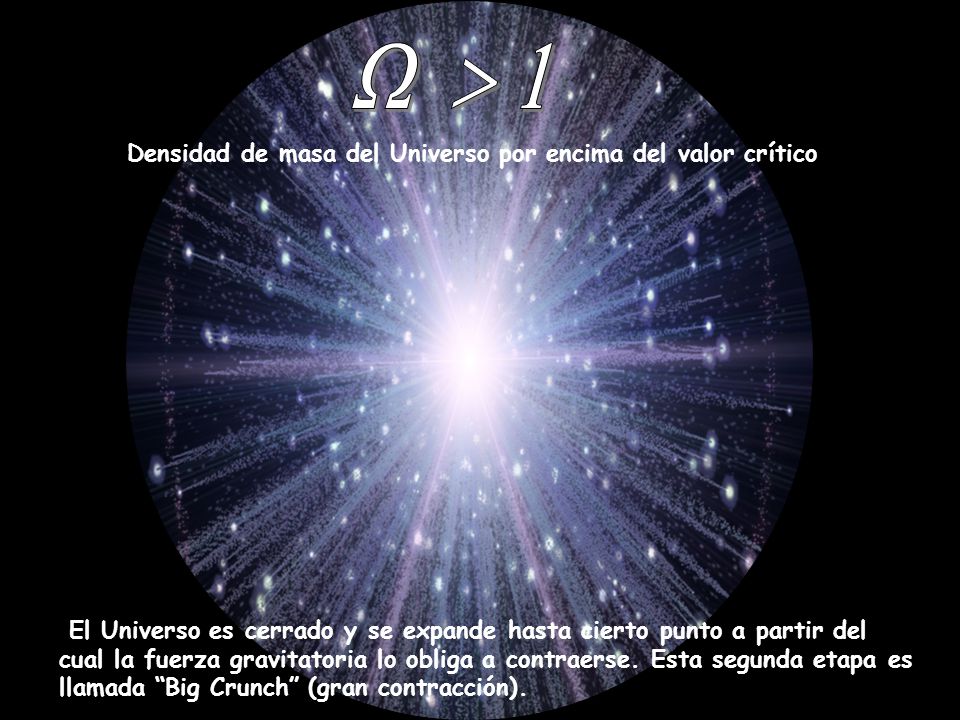

Ω el signo omega es el que representa la densidad que tiene nuestro Universo, es decir, lo que llaman Densidad Crítica ” El Omega Negro”, y, dependiendo de esa densidad, tendremos un universo plano, abierto o cerrado con distintos finales.

La expansión del universo se ha estudiado de varias maneras diferentes, pero la misión WMAP completada en 2003, representa un paso importante en la precisión y los resultados presentados hasta el momento con mayor precisión para saber, en qué clase de Universo estamos, cómo pudo comenzar y, cuál podría ser su posible final. Todo ello, es un apartado más de ese todo que tratamos de buscar para saber, en qué Universo estamos, cómo funcionan las cosas y por qué lo hacen de esa determinada manera y no de otra diferente.

La relatividad general nos dijo cómo es la geometría del Universo

El universo, la cosmología moderna que hoy tenemos, es debida a la teoría de Einstein de la relatividadgeneral y las consecuencias obtenidas posteriormente por Alexandre Friedmann. El Big Bang, la expansión del universo, el universo plano y abierto o curvo y cerrado, la densidad crítica y el posible Big Crunch.

Un comienzo y un final que abarcará miles y miles de millones de años de sucesos universales a escalas cosmológicas que, claro está, nos afectará a nosotros, insignificantes mortales habitantes de un insignificante planeta, en un insignificante sistema solar creado por una insignificante y común estrella.

Pero… ¿somos en verdad tan insignificantes?

Los logros alcanzados hasta el momento parecen desmentir tal afirmación, el camino recorrido por la humanidad no ha sido nada fácil, los inconvenientes y dificultades vencidas, las luchas, la supervivencia, el aprendizaje por la experiencia primero y por el estudio después, el proceso de humanización (aún no finalizado), todo eso y más nos dice que a lo mejor, es posible, pudiera ser que finalmente, esta especie nuestra pudiera tener un papel importante en el conjunto del universo. De momento y por lo pronto ya es un gran triunfo el que estemos buscando respuestas escondidas en lo más profundo de las entrañas del cosmos.

Tengo la sensación muy particular, una vez dentro de mi cabeza, un mensaje que no sé de dónde pero que llega a mi mente que me dice de manera persistente y clara que no conseguiremos descubrir plenamente esa ansiada teoría del todo, hasta tanto no consigamos dominar la energía de Planck que hoy por hoy, es inalcanzable y sólo un sueño.

Sus buenas aportaciones a la Física fueron bien recompensadas de muchas maneras.

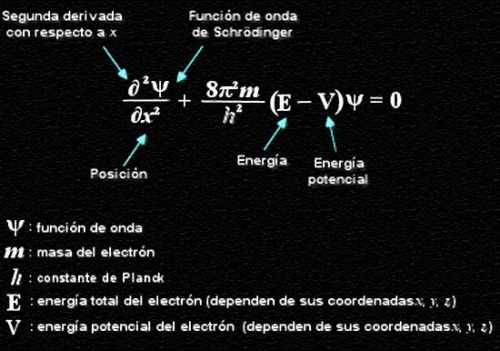

En mecánica cuántica es corriente trabajar con la constante de Planck racionalizada, (ħ = h/2p = 1’054589×10-34 Julios/segundo), con su ley de radiación (Iv = 2hc-2v3/[exp(hv/KT)-1]), con la longitud de Planck , con la masa de Planck, y otras muchas ecuaciones fundamentales para llegar a lugares recónditos que, de otra manera, nunca podríamos alcanzar.

Todo lo anterior son herramientas de la mecánica cuántica que en su conjunto son conocidas como unidades de Planck, que como su mismo nombre indica son un conjunto de unidades, usadas principalmente en teorías cuánticas de la gravedad, en que longitud, masa y tiempo son expresadas en múltiplos de la longitud, masa y tiempo de Planck, respectivamente. Esto es equivalente a fijar la constante gravitacional (G), como la velocidad de la luz (c), y la constante de Planck racionalizada (ħ) iguales todas a la unidad. Todas las cantidades que tienen dimensiones de longitud, masa y tiempo se vuelven adimensionales en unidades de Planck. Debido a que en el contexto donde las unidades de Planck son usadas es normal emplear unidades gaussianas o unidades de Heaviside-Lorentz para las cantidades electromagnéticas, éstas también se vuelven adimensionales, lo que por otra parte ocurre con todas las unidades naturales. Un ejemplo de esta curiosidad de adimiensionalidad, está presente en la constante de estructura fina (2πe2/hc) de valor 137 (número adimensional) y cuyo símbolo es la letra griega α (alfa).

Estas unidades de Planck nos llevan a la cosmología del nacimiento del universo y nos proporciona un marco elegante, coherente y manejable mediante cálculos para conocer el universo remontándonos a los primeros momentos más breves posteriores a la explosión o Big Bang. El tiempo de Planck por ejemplo, expresado por , tiene un valor del orden de 10-43 segundos, o lo que es lo mismo, el tiempo que pasó desde la explosión hasta el tiempo de Planck fue de:

0,000.000.000.000.000.000.000.000.000.000.000.000.000.001 de 1 segundo. En la fórmula, G es la constante universal de Newton, ħ es la constante de Planck racionalizada y c es la velocidad de la luz.

Es una unidad de tiempo infinitesimal, como lo es el límite de Planck que se refiere al espacio recorrido por un fotón (que viaja a la velocidad de la luz) durante una fracción de tiempo de ínfima duración y que es de 0,000.000.000.000.000.000.000.000.000.000.001 de cm.

Hasta tal punto llegan los físicos en sus cálculos para tratar de adecuar los conocimientos a la realidad por medio del experimento. Buscamos incansables…¡las respuestas! Hasta que no podamos tocar con nuestras propias manos esa partícula final…

Sin embargo, cuando hablamos de estas unidades tan pequeñas, no debemos engañarnos. Precisamente, para tratar de llegar hasta esos límites tan profundos se necesitan máquinas que desarrollan inmensas energías: los aceleradores de partículas, que como el Fermilab o el LHC en el CERN, han facilitado a los físicos experimentadores entrar en las entrañas de la materia y descubrir muchos de los secretos antes tan bien guardados. Ahora, disponiendo de 14 TeV, tratan de buscar partículas supersimétricas y el origen de la “materia oscura”.

Haber fabricado acelerados tan potentes como para poder detectar la partícula de Higgs, esa partícula responsable de proporcionar masa a todas las demás partículas, en tiempos pasados era un sueño que pudimos hacer realidad y, de la misma manera, soñamos ahora con tener un Acelerador tan Potente como para poder encontrar las cuerdas o las partículas simétricas de las que se cree están conformadas. Y, por supuesto, más lejos queda la posibilidad de que podamos construir un acelerador que pudiera alcanzar la energía de Planck, del orden de 1019 eV (1 eV = 10-19 julios) = 1’60210×10-19. Hoy por hoy, ni nuestra tecnología ni todos los recursos que tenemos disponibles si empleáramos todo el presupuesto bruto de todos los países del globo unidos, ni así digo, podríamos alcanzar esta energía necesaria para comprobar experimentalmente la existencia de “cuerdas” vibrantes que confirmen la teoría de Todo.

Claro que, pudiera ser que, todo se pudiera alcanzar de manera mucho más simple y que, teniéndolo a la vista, no hemos sabido ver. Habrá que agudizar el ingenio para resolver estas y otras cuestiones que, como la de la Velocidad de la Luz, nos tienen atados y bien atados a este granito de arena inmerso en un vasto universo y que, nosotros, llamamos mundo.

Emilio Silvera Vázquez

Totales: 75.644.345

Totales: 75.644.345 Conectados: 3

Conectados: 3