Sep

10

El enigma del Neutrón

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

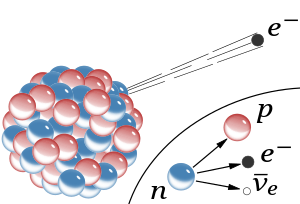

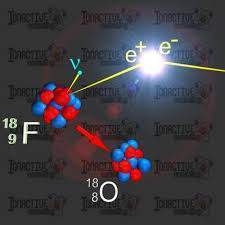

Decaimiento β– de un núcleo. Se ilustra cómo uno de los neutrones se convierte en un protón a la vez que emite un electrón (β-) y un antineutrino electrónico.

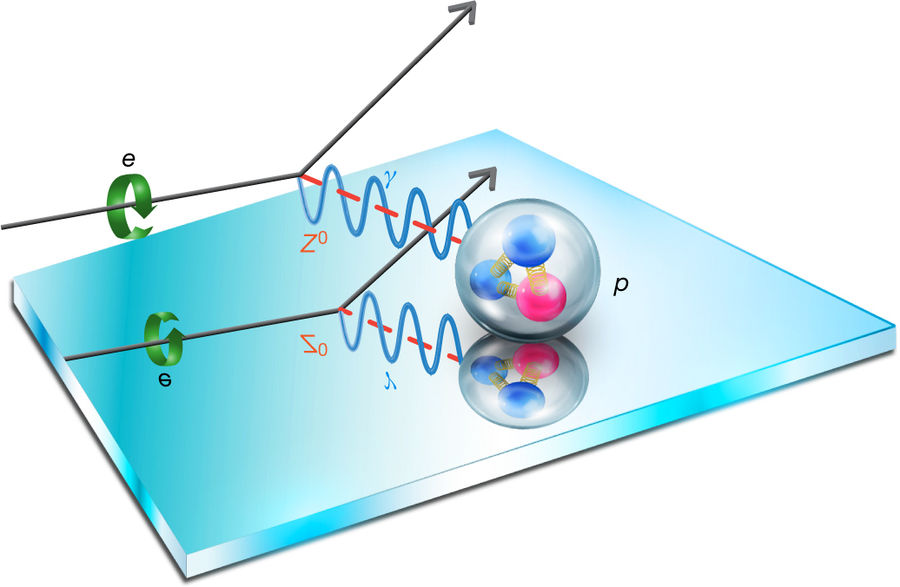

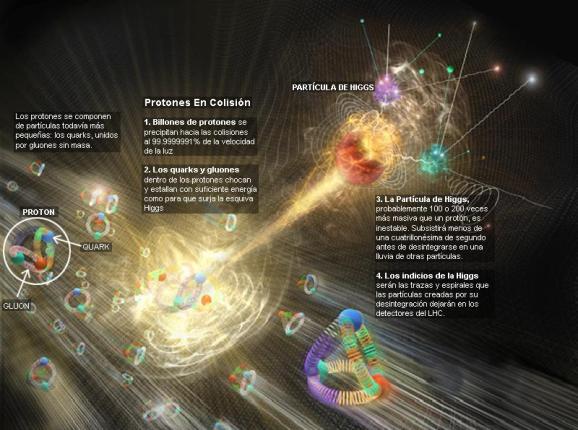

La desintegración Beta del neutrón está mediada por un Bosón W–,que transforma uno de sus quarks, y se desintegra en el par electrón-antineutrino. Ahora leamos el reportaje de la Revista “Investigación y Ciencia”, referido a la física de partículas y a unas mediciones efectuadas que no son coincidentes.

“Dos técnicas de precisión arrojan valores distintos para el tiempo que tardan los neutrones en desintegrarse. ¿Se trata de un error experimental, o hay un misterio más profundo?

BILL MAYER

En síntesis

Neutrones Libres, ¿pueden “vivir” eternamente?

Los neutrones pueden “permanecer” indefinidamente de manera estable en los núcleos pertenecientes a ciertos isótopos, con mayor probabilidad en aquellos de número atómico menor al del hierro (Z=26), aunque también pueden permanecer establemente en núcleos más pesados.

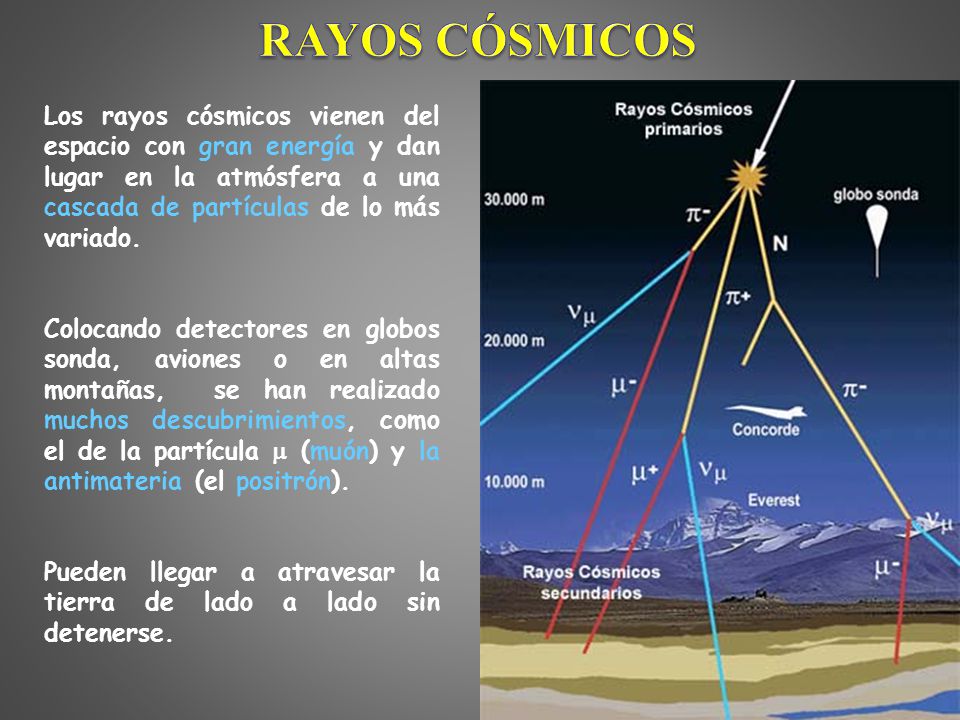

Sin embargo, cuando los neutrones son liberados a consecuencia ya sea de una reacción de fusión (como aquellas ocurridas en el sol, por ejemplo: H + H à He + n) o una de fisión en la Tierra, o de su separación desde un núcleo inducida por un muon (originado en un rayo cósmico golpeando la atmósfera), pueden suceder varias situaciones con él: i) una es que sea capturado por el núcleo de un isótopo y pase a formar parte del núcleo de otro isótopo estable del mismo elemento o compuesto químico (agua liviana a agua pesada, H20 a D20). ii) Otra es que la fisión libere neutrones, en cuyo caso puede repetirse cualquiera de las reacciones i), ii). Y la última iv) es que al menos un neutrón liberado no sea “capturado” en ninguno de los procesos descritos, de modo que pase a ser un “neutrón libre”.

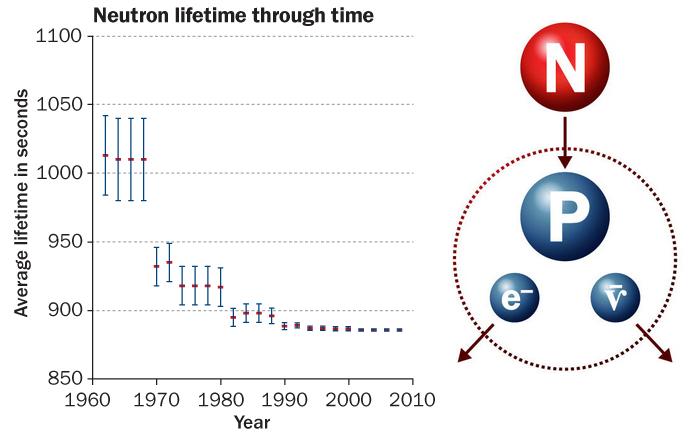

Un neutrón libre es un neutrón que existe fuera de un núcleo atómico. Mientras que los neutrones pueden ser estables cuando están unidos dentro de los núcleos, los neutrones libres son inestables y se desintegran con una vida media de 886 segundos, unos quince minutos.

Los neutrones libres no son estables: pasados unos 15 minutos, un neutrón se desintegra en un protón, un electrón y un antineutrino. Conocer con exactitud su vida media es clave para abordar varias cuestiones en física y cosmología.

Existen dos métodos para determinar con precisión la vida media de esta partícula. El primero cuenta los neutrones que quedan en un recipiente después de cierto tiempo; el segundo cuenta los protones generados en su desintegración.

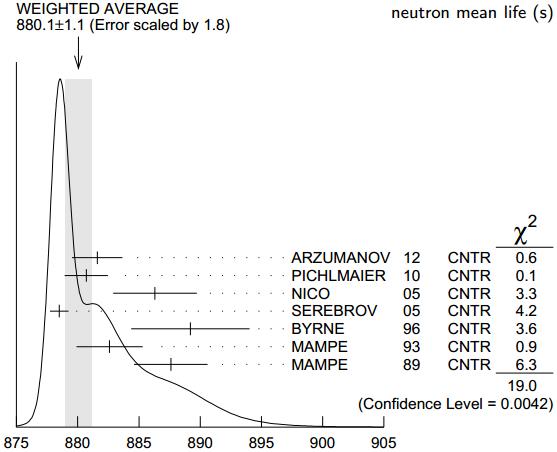

Hace años que una y otra técnica arrojan valores considerablemente dispares. Se cree que la discrepancia obedece a errores sistemáticos en alguno de los experimentos; sin embargo, hasta ahora nadie ha logrado dar con ellos.

Así hemos podido desvelar el secreto de que como se dice antes y se ve en la imagen, el neutrón al desintegrarse sigue este camino:

14 6C → 14 7N + e–

Este proceso ocurre espontáneamente en neutrones libres, en el transcurso de 885.7(8) s de vida media.

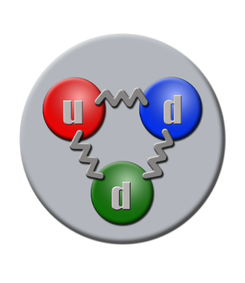

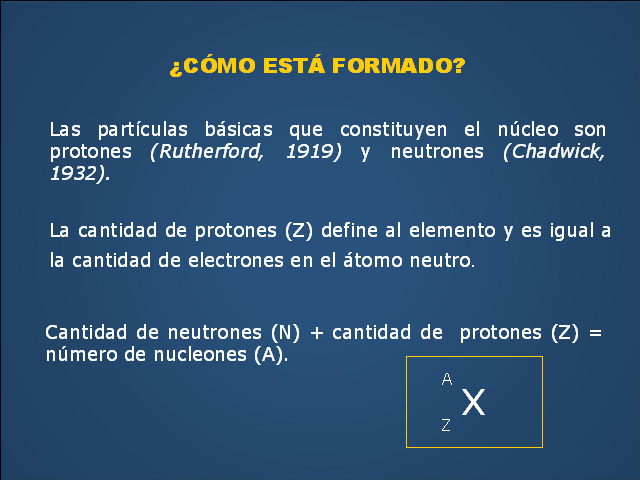

Un neutrón está formado por dos quarks dowm (abajo) y un quark up (arriba), tiene una vida media de 14,761 minutos, es una partícula de la familia de los hadrones en su vertiente bariónica, interacción: con la Gravedad, la nuclear débil y la nuclear fuerte, su símbolo es n, su antipartícula es el antineutrón, la teorizó Rutherford y la descubrió James Chadwick, su masa es de 1,674 927 29(28)×10−27 K., la carga eléctrica es cero, espín ½. Se conoce cuando forma parte del átomo por nucleón.

Por suerte para la vida en la Tierra, la mayor parte de la materia no es radiactiva. Aunque no solemos darle demasiada importancia, este hecho no deja de resultar sorprendente, ya que el neutrón (uno de los constituyentes, junto con el protón, de los núcleos atómicos) es propenso a desintegrarse. En el interior de un núcleo típico el neutrón puede vivir durante largo tiempo, pero, aislado, se desintegra en otras partículas en unos 15 minutos. Decimos «unos 15 minutos» para ocultar nuestra ignorancia al respecto, ya que, hasta ahora, no hemos sido capaces de medir con exactitud la vida media de esta partícula.

Estructura de cuarks de un neutrón. Fuera del núcleo atómico, los neutrones son inestables, teniendo una vida media de 14.7 minutos (879,4 ± 0,6 s); cada neutrón libre se descompone en un electrón, un antineutrino electrónico y un protón. Su masa es muy similar a la del protón, aunque ligeramente mayor.

Resolver este «rompecabezas de la vida media del neutrón» no solo supone una cuestión de orgullo para nuestro gremio, el de los físicos experimentales, sino que resulta también vital para comprender mejor las leyes físicas. La desintegración del neutrón constituye uno de los procesos más sencillos en los que interviene la interacción débil, una de las cuatro fuerzas fundamentales de la naturaleza. Para entenderla por completo, hemos de saber cuánto tarda un neutrón aislado en desintegrarse. Por otro lado, la vida media del neutrón condicionó cómo se formaron los elementos químicos más ligeros después de la gran explosión que dio origen a nuestro universo. A los cosmólogos les gustaría poder calcular las abundancias esperadas de los distintos elementos y contrastarlas con los datos obtenidos por los astrofísicos. Un acuerdo apuntalaría nuestras teorías cosmológicas, mientras que una discrepancia indicaría la existencia de fenómenos físicos aún por descubrir. Pero, para poder llevar a cabo dicha comparación, hemos de conocer con exactitud cuánto vive un neutrón antes de desintegrarse.

Hace más de diez años, dos grupos experimentales, uno en Francia y otro en EE.UU., intentaron medir con precisión la vida media del neutrón. Uno de nosotros (Geltenbort) pertenecía al primer equipo, mientras que el otro (Greene) trabajaba en el segundo. Con sorpresa y cierta inquietud, comprobamos que nuestros resultados diferían de manera considerable. Algunos teóricos sugirieron que la discrepancia podría deberse a fenómenos físicos exóticos, como que parte de los neutrones se hubiesen desintegrado en partículas nunca antes observadas. Nosotros, sin embargo, achacamos la diferencia a una razón mucho más mundana: uno de los grupos —o ambos— tenía que haber cometido algún error o sobreestimado la precisión de sus resultados.

Hace poco, el equipo estadounidense completó un largo y concienzudo proyecto para estudiar la principal fuente de error que afectaba a sus mediciones. Lejos de zanjar la cuestión, sus esfuerzos solo confirmaron los resultados previos. Al mismo tiempo, otros investigadores verificaron los resultados del grupo de Geltenbort. Esta discrepancia nos ha dejado más perplejos de lo que ya estábamos, pero no hemos abandonado. Por el momento, ambos equipos y otros físicos experimentales seguimos buscando una respuesta.

CRONOMETRAR NEUTRONES

El neutrón y el protón forman los núcleos de los átomos; el protón es estable (su vida media es superior a 10³² años, según PDG 2012), pero el neutrón es inestable (vía la interacción electrodébil se desintegra en un protón) y aislado su vida media es de solo 880,1 ± 1,1 segundos (14 minutos y 40,1 segundos)

En teoría, determinar la vida media del neutrón es sencillo. Entendemos bien la física del proceso y disponemos de las herramientas adecuadas para estudiarlo. Sabemos que, siempre que una partícula pueda desintegrarse en otras de menor masa, acabará haciéndolo si en el proceso se conservan ciertas propiedades, como la carga eléctrica o el espín. En la llamada desintegración beta, un neutrón se transforma en un protón, un electrón y un antineutrino. Las masas de estas tres partículas suman algo menos que la masa del neutrón, pero la carga y el espín totales permanecen idénticos. Entre las cantidades conservadas se incluye la suma de masa y energía, por lo que las tres partículas finales incorporan esa pequeña diferencia de masa en forma de energía cinética.”

Nota: El artículo me ha sido enviado por Don José Gómez, un contertulio y visitante de ésta página que, con buen criterio, apunta que en cuanto a esas diferencias, las pruebas deben ser repetidas en distintos lugares y, si es posible, por distintos científicos también, ya que, en física de partícula, los resultados de un experimento, debe coincidir sin fisuras.

Sep

5

¿Qué será la materia?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (1)

Comments (1)

« ¿Qué habrá en los Océanos de Higgs? ¡Si existen!

En primaria, nos decían que estaba en tres estados. Se profundizaba poco más y, el desconocimiento de la materia era grande: Sólido, Líquido y Gaseoso, esa era toda la explicación que sobre la materia nos daban.

En este estado la materia, muy poco densa, no tiene ni forma ni volumen fijo. Plasma: Es un estado parecido al gas, pero compuesto por átomos ionizados, donde los electrones circulan libremente. Calentando un gas se puede obtener plasma.

En física, condensado de Bose-Einstein es el estado de la materia que se da en ciertos materiales a temperaturas cercanas a 0 K (cero absoluto). La propiedad que lo caracteriza es que una cantidad macroscópica de las partículas del material pasan al nivel de mínima energía, denominado estado fundamental.

La Física nos habla de otros estados de la materia:

- lido. Los objetos en estado sólido se presentan de forma definida, es decir, normalmente su forma no cambia, no es posible alterarla sin aplicar una gran fuerza o cambiar el estado del objeto en cuestión. …

- Líquido. …

- Gas. …

- Plasma. …

- Condensado de Bose-Einstein. …

- Condensado de Fermi. …

- Super-sólido. …

- Super-cristal.

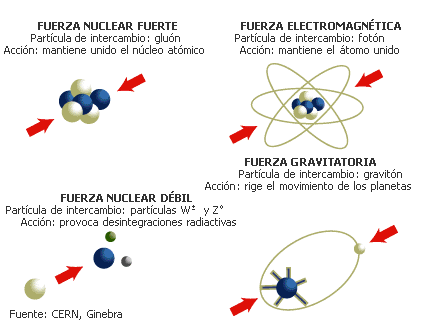

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de saber y conocer sobre su verdadera naturaleza. Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Si, sabemos ponerles etiquetas como, por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránicos.

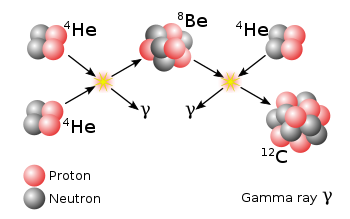

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobrepasando a la emisión de partículas alfa.

Maravillas como el proceso triple Alfa nos hace pensar que la materia está viva. La radiación ha sido muy bien estudiada y hoy se conocen sus secretos. Sin embargo, son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

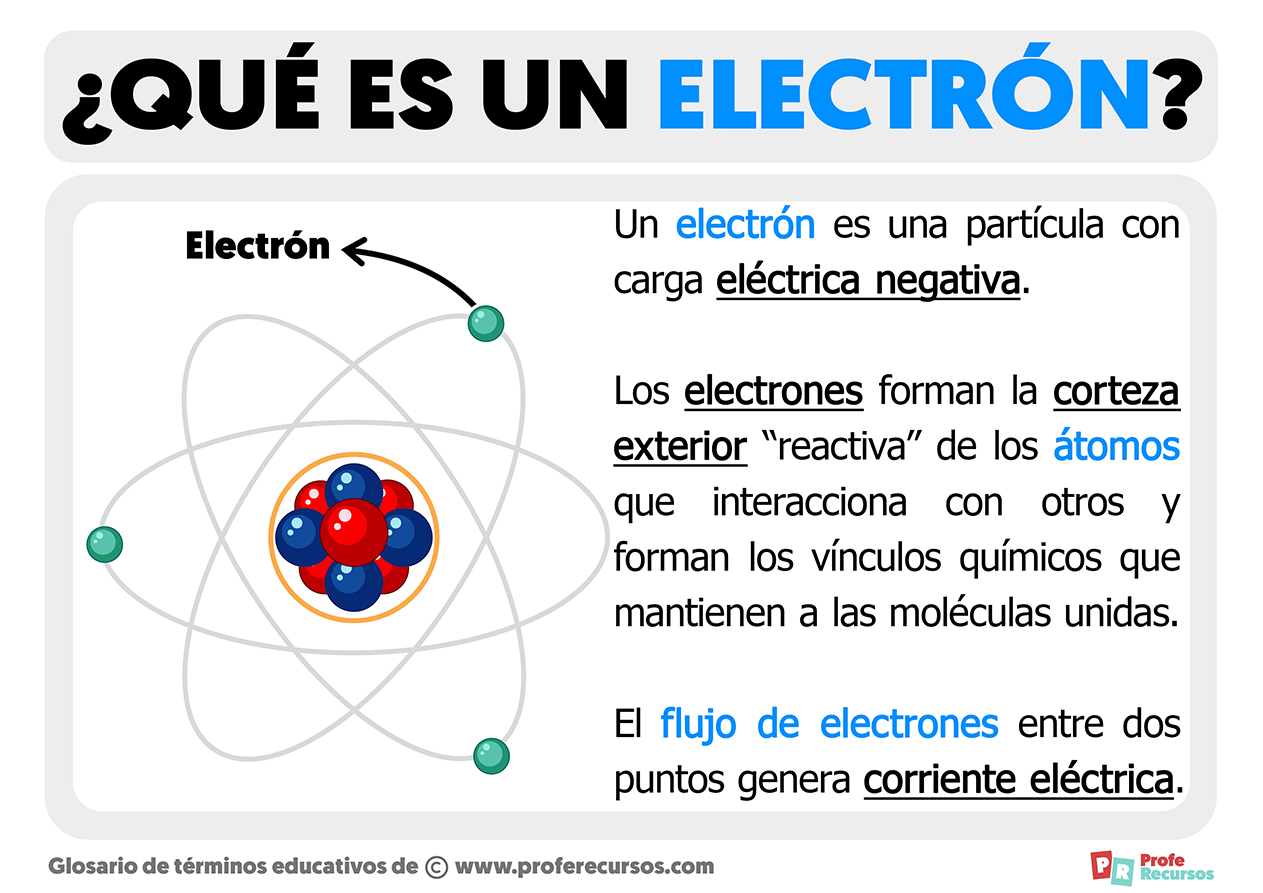

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lepto que significa “delgado”).

El electrón es onda y partícula

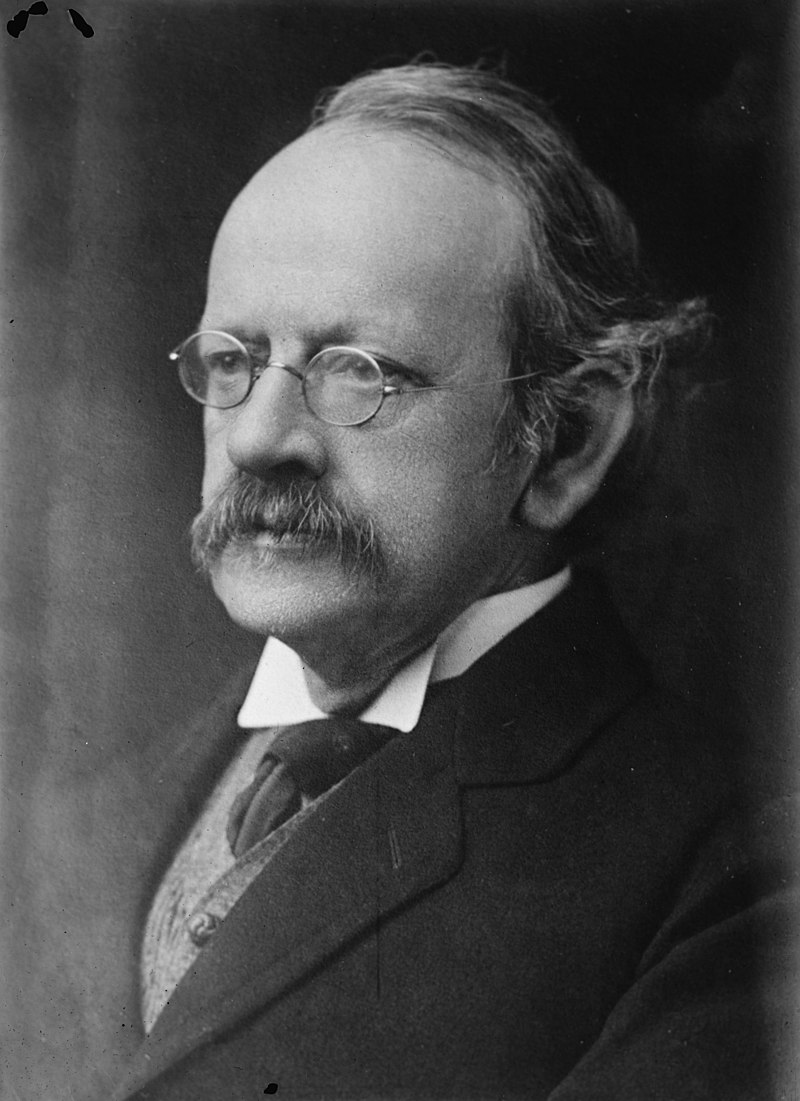

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54)x10-31kg la primera y, 1,602 177 33 (49)x10-19 culombios, la segunda, y también su radio clásico. No se ha descubierto aún ninguna partícula que sea menos masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que esta es la que se muestra en el electrón.

Joseph John Thomson

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería como lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí ahora.

Son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lepto que significa “delgado”).

Primeras imágenes de átomos en movimiento en una molécula

Investigadores de la Universidad Estatal de Ohio (Estados Unidos), han registrado, utilizando una nueva cámara ultrarrápida, la primera imagen en tiempo real de dos átomos vibrando en una molécula. La clave del experimento, que ha sido publicado en la revista ‘Nature’, fue la utilización de la energía del propio electrón de una molécula.

CAPTAN COMO UN ELECTRON SALTA DE UN ATOMO A OTRO

Un equipo de siete científicos suecos de la Facultad de Ingeniería de la Universidad de Lund consiguieron captar en vídeo por primera vez el movimiento o la distribución energética de un electrón sobre una onda de luz, tras ser desprendido previamente del átomo correspondiente.

Previamente dos físicos de la Universidad Brown habían mostrado películas de electrones que se movían a través de helio líquido en el International Symposium on Quantum Fluids and Solids del 2006. Dichas imágenes, que mostraban puntos de luz que bajaban por la pantalla fueron publicadas en línea el 31 de mayo de 2007, en el Journal of Low Temperature Physics.

En el experimento que ahora nos ocupa y dada la altísima velocidad de los electrones el equipo de investigadores ha tenido que usar una nueva tecnología que genera pulsos cortos de láser de luz intensa (“Attoseconds Pulses”), habida cuenta que un attosegundo equivalente a la trillonésima parte de un segundo”.)

¿Cuánto te puede hacer sentir? ¿No es lo más grande de tu vida?

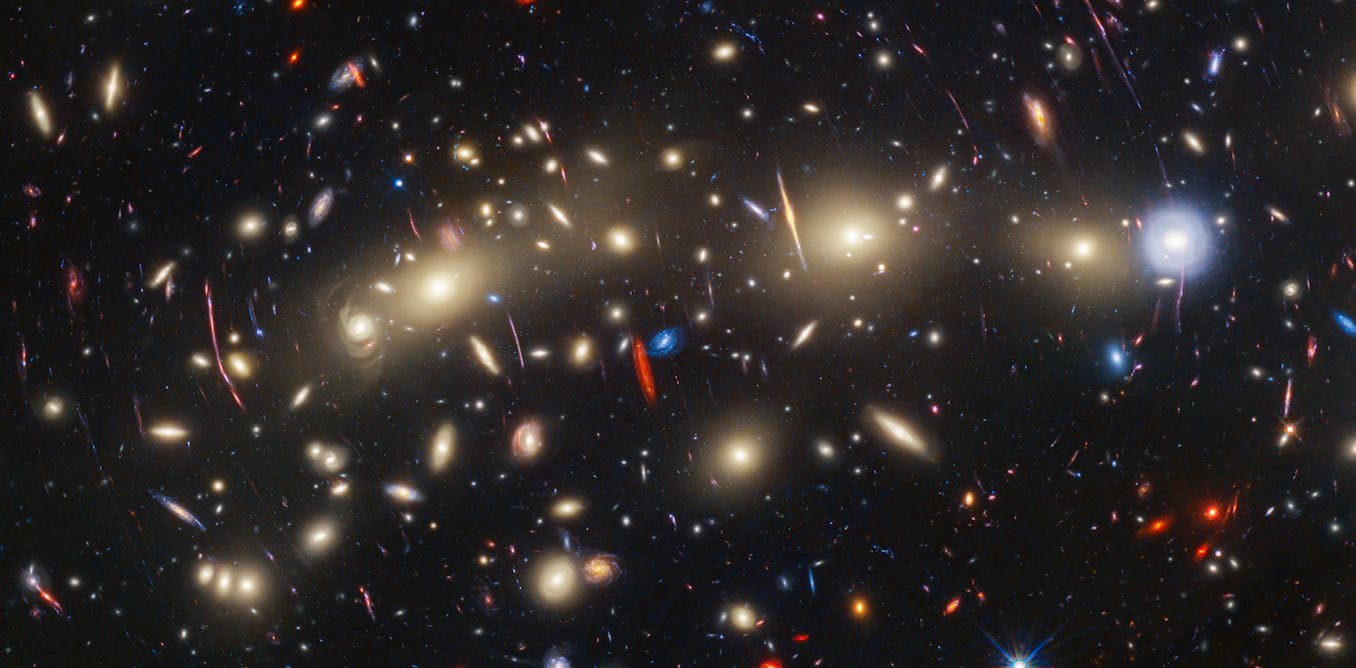

¡No por pequeño, se es insignificante! Recordémoslo, todo lo grande está hecho de cosas pequeñas. Las inmensas galaxias son el conjunto de muchos pequeños átomos unidos para formar moléculas que a su vez se juntan y forman cuerpos. Los océanos de la Tierra, las montañas de Marte, los lagos de metano de Titán, los hielos de Europa… ¡Todo está hecho de materia bariónica! Es decir, son pequeños Quarks y Leptones que conforman los átomos de lo que todo está hecho en nuestro Universo. Bueno, al menos todo lo que podemos ver.

La familia Quarks: Tan pequeños y tan importantes

Uno de los enigmas más grandes de la física de partículas a día de hoy es por qué existen tres generaciones de partículas, tres copias idénticas pero de masa muy superior de las partículas que conforman toda la materia que observamos en el universo.

Un “simple” átomo está conformado de una manera muy compleja. Por ejemplo, un protón está hecho de tres quarks: 2 up y 1 down. Mientras tanto, un neutrón está constituido de 2 quarks down y 1 quark up. Los protones y neutrones son hadrones de la rama barión, es decir, que emiten radiación. También son fermiones y, debido a su función en el átomo, se les suele llamar nucleones. Dichos quarks existen confinados dentro de los protones y neutrones inmersos en una especie de pegamento gelatinoso formado por unas partículas de la familia de los Bosones que se llaman Gluones y son los transmisores de la Fuerza nuclear fuerte. Es decir, si los quarks se quieren separar son atrapados por esa fuerza que los retiene allí confinados.

Louis de Broglie

Estudiar el “universo” de las partículas subatómicas es fascinante y se pueden llegar a entender las maravillas que nos muestra la mecánica cuántica, ese extraño mundo que nada tiene que ver con el nuestro cotidiano situado en el macromundo. En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones.)

Imagen ilustrativa de la dualidad onda-partícula, en el cual se puede ver cómo un mismo fenómeno puede tener dos percepciones distintas. Esta manifestación en forma de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”. Recientemente he podido leer que unos científicos han logrado (de alguna manera) “congelelar” la luz y hacerla sólida. Cuando recabe más información os lo contaré con todo detalle. El fotón, el cuanto de luz, es en sí mismo una maravilla.

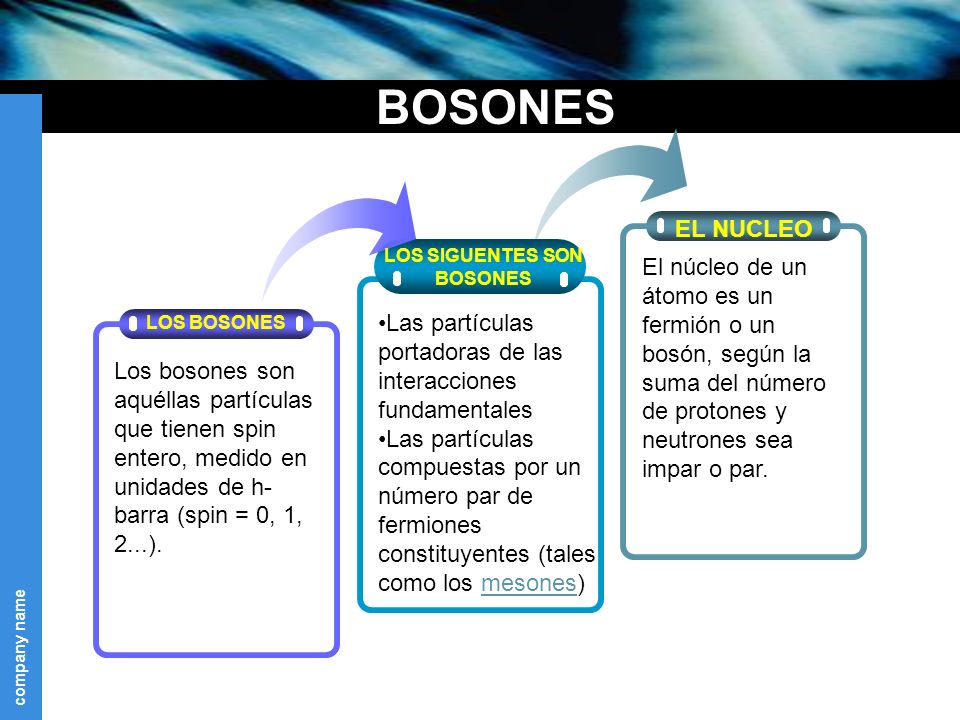

El fotón tiene una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva para la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el nombre de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin descubrir) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

El Gravitón se ríe de nosotros que no sabemos encontrarlo. ¿Qué Bosón tan guasón!

El gravitón parece estar riéndose de todos y no se deja ver. El gravitón es la partícula elemental responsable de la fuerza de la gravedad. Todavía no ha sido descubierto experimentalmente. Teóricamente debería tener masa en reposo nula. ¿Qué límites para la masa del gravitón ofrece el fondo cósmico de microondas? El gravitón es la partícula elemental responsable de la “versión” cuántica de gravedad. No ha sido descubierto aún, aunque pocos dudan de su existencia. ¿Qué propiedades tiene? Debe ser un bosón de espín 2 y como la gravedad parece ser una fuerza de largo alcance, debe tener masa en reposo muy pequeña (billones de veces más pequeña que la del electrón), posiblemente es exactamente cero (igual que parecer ser la del fotón).

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm., de longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en forma de ondas), desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegare a captar la cienmillonésima parte de un centímetro.

Finalmente lo consiguieron

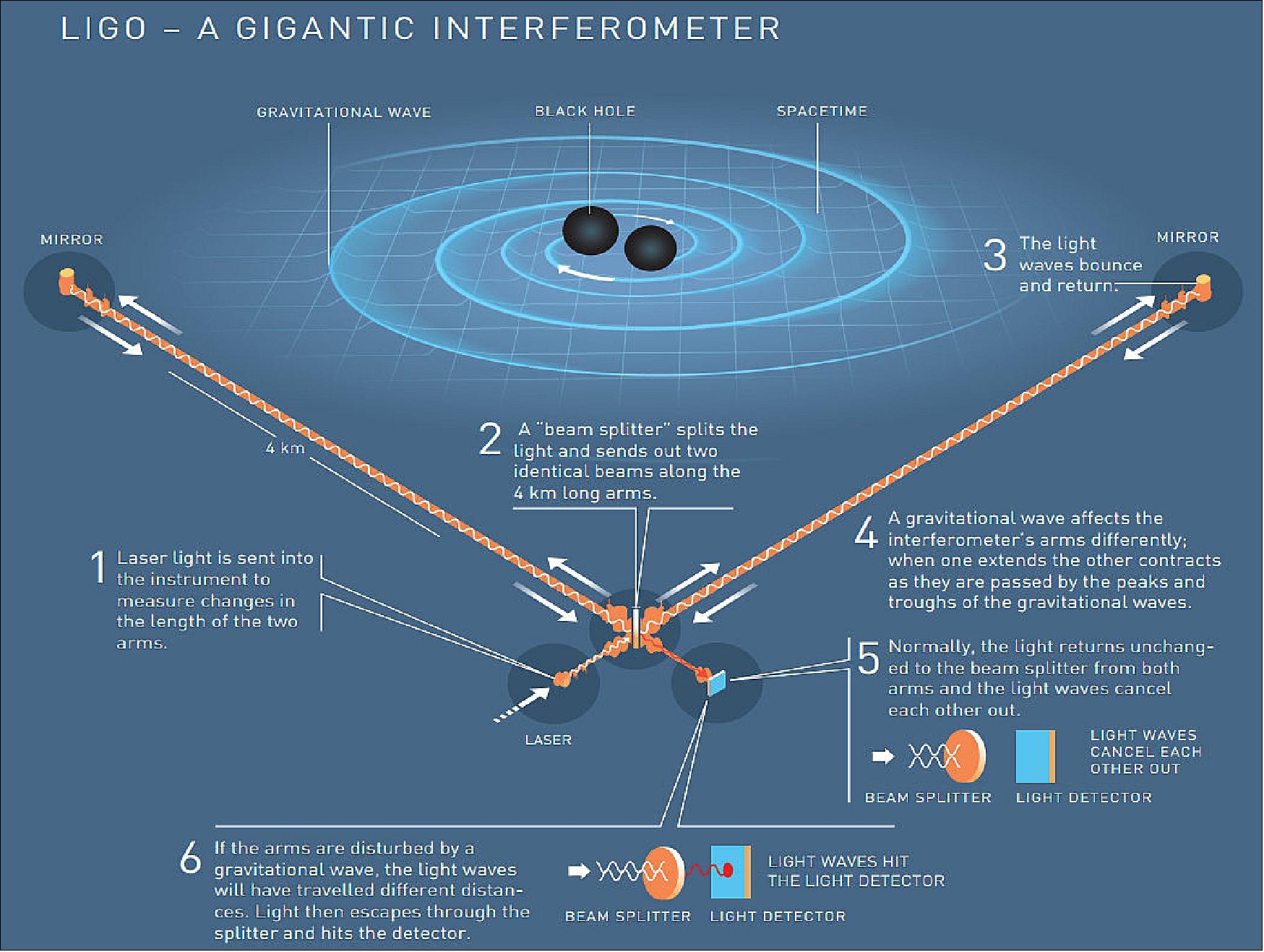

Para detectar ondas gravitacionales necesitamos instrumentos extremadamente precisos que puedan medir distancias en escalas diminutas. Una onda gravitacional afecta longitudes en escalas de una millonésima de billonésima de metro, así que ¡necesitamos un instrumento que sea lo suficientemente sensible para “ver” a esas escalas! Parece que al fín, LIGO y otros lo han conseguido.

El interferómetro funciona enviando un haz de luz que se separa en dos haces; éstos se envían en direcciones diferentes a unos espejos donde se reflejan de regreso, entonces los haces al combinarse presentarán interferencia.

Las débiles ondas de los gravitones, que producen del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de forma simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitatorias. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaran el hallazgo de Weber.

De todas formas, no creo que, a estas alturas, nadie pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es 0, su carga es 0, y su espín de 2. Como el fotón, no tiene antipartícula, ellos mismos hacen las dos versiones.

Tenemos que volver a los que posiblemente son los objetos más misteriosos de nuestro Universo: Los agujeros negros. Si estos objetos son lo que se dice (no parece que se pueda objetar nada en contrario), seguramente serán ellos los que, finalmente, nos faciliten las respuestas sobre las ondas gravitacionales y el esquivo gravitón.

Imagen de un agujero negro en el núcleo de una galaxia arrasando otra próxima- NASA

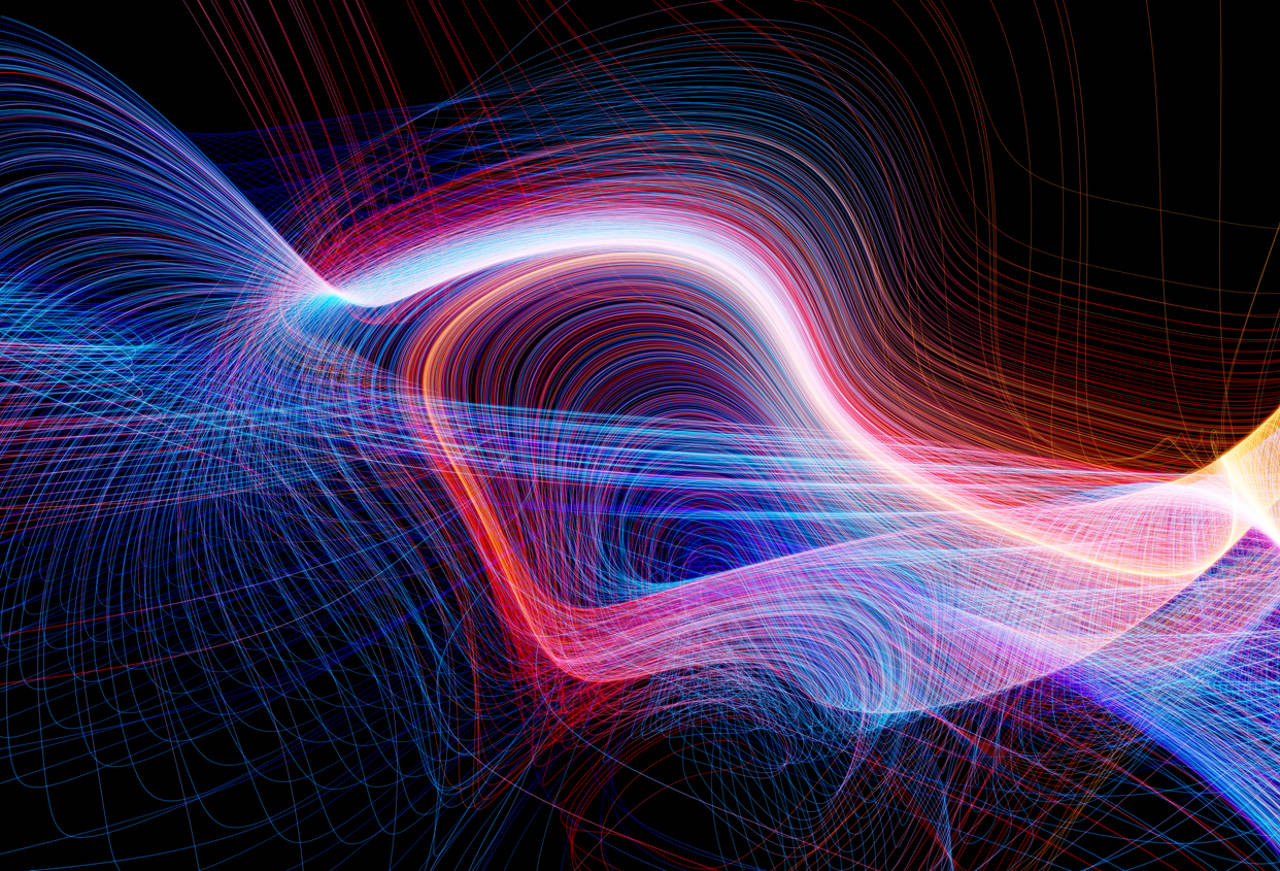

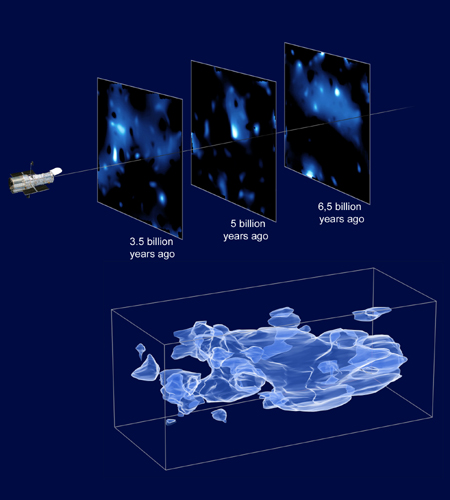

La onda gravitacional emitida por el agujero negro produce una ondulación en la curvatura del espacio-temporal que viaja a la velocidad de la luz transportada por los gravitones. Algunos proyectos como LIGO, están a la caza de esas ondas gravitatotias y, los expertos dicen que, cuando podamos leer sus mensajes, se presentará ante nosotros todo un nuevo universo que aíun no conocemos. Ahora, todo lo que captamos, las galaxias y estrellas lejanas, son gracias a la luz que viaja desde miles de millones de años luz hasta nosotros, los telescopios la captan y nos muestran esas imágenes de objetos lejanos pero, ¿qué veremos cuando sepamos captar esas ondas gravitatorias que viajan por el Espacio a la velocidad de la luz como los fotones y, son el resultado del choque de galaxias, de agujeros negros y de estrellas de neutrones?

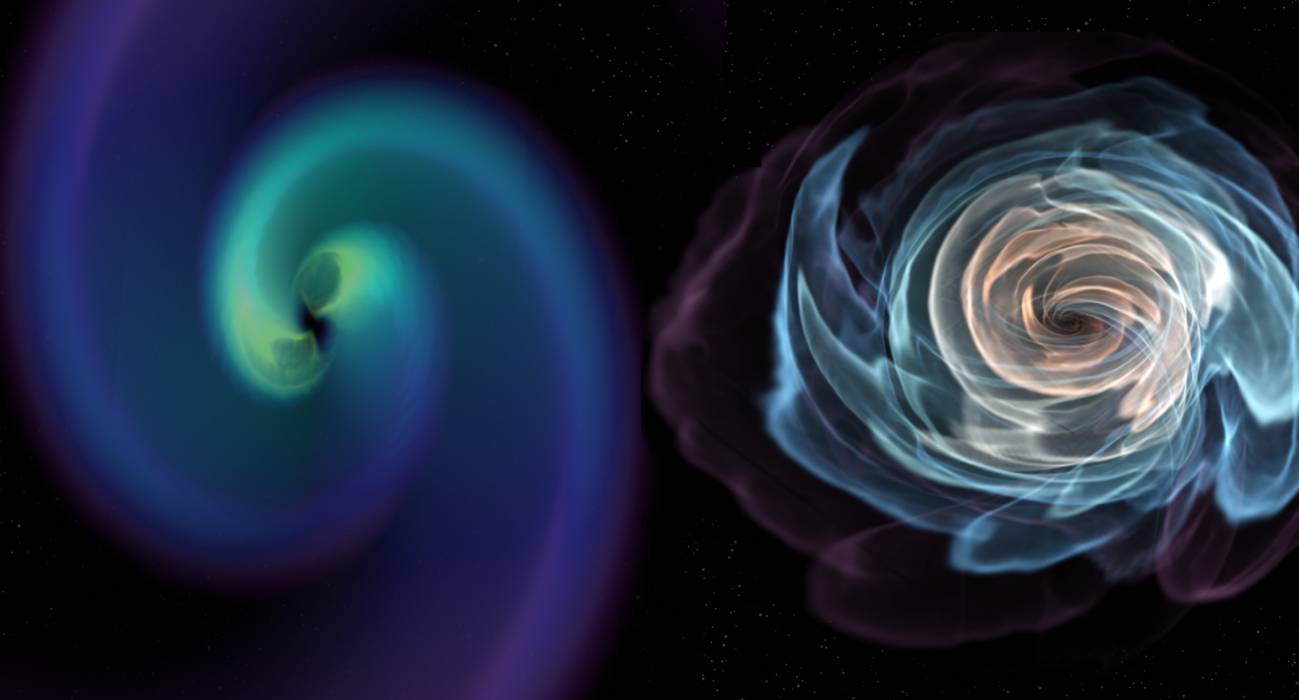

El choque de dos estrellas de neutrones producen ondas gravitatorias

Hay aspectos de la física que me dejan totalmente sin habla, me obligan a pensar y me transporta de este mundo material nuestro a otro fascinante donde residen las maravillas del Universo. Hay magnitudes asociadas con las leyes de la gravedad cuántica. La longitud de Planck-Wheeler, ![]() es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro.

es la escala de longitud por debajo de la cual el espacio tal como lo conocemos deja de existir y se convierte en espuma cuántica. El tiempo de Planck-Wheeler (1/c veces la longitud de Planck-Wheeler o aproximadamente 10-43 segundos), es el intervalo de tiempo más corto que puede existir; si dos sucesos están separados por menos que esto, no se puede decir cuál sucede antes y cuál después. El área de Planck-Wheeler (el cuadrado de la longitud de Planck-Wheeler, es decir, 2,61×10-66cm2) juega un papel clave en la entropía de un agujero negro.

Me llama poderosamente la atención lo que conocemos como las fluctuaciones de vacío, esas oscilaciones aleatorias, impredecibles e in-eliminables de un campo (electromagnético o gravitatorio), que son debidas a un tira y afloja en el que pequeñas regiones del espacio toman prestada momentáneamente energía de regiones adyacentes y luego la devuelven. Hace un par de días que hablamos de ello.

Ordinariamente, definimos el vacío como el espacio en el que hay una baja presión de un gas, es decir, relativamente pocos átomos o moléculas. En ese sentido, un vacío perfecto no contendría ningún átomo o molécula, pero no se puede obtener, ya que todos los materiales que rodean ese espacio tienen una presión de vapor finita. En un bajo vacío, la presión se reduce hasta 10-2 pascales, mientras que un alto vacío tiene una presión de 10-2-10-7 pascales. Por debajo de 10-7 pascales se conoce como un vacío ultra-alto.

El primer gran vacío en ser detectado fue el de Boötes en 1.981; tiene un radio de unos 180 millones de años luz y su centro se encuentra a aproximadamente 500 millones de años luz de la Vía Láctea. La existencia de grandes vacíos no sorprende a la comunidad de astrónomos y cosmólogos, dada la existencia de cúmulos de galaxias y supercúmulos a escalas muy grandes. Claro que, según creo yo personalmente, ese vacío, finalmente, resultará que está demasiado lleno, hasta el punto de que su contenido nos manda mensajes que, aunque lo hemos captado, no lo sabemos descifrar.

No puedo dejar de referirme al vaciotheta (vació θ) que, es el estado de vacío de un campo gauge no abeliano (en ausencia de campos fermiónicos y campos de Higgs). En el vacío theta hay un número infinito de estados degenerados con efecto túnel entre estos estados. Esto significa que el vacío theta es análogo a una fundón de Bloch en un cristal.

Se puede derivar tanto como un resultado general o bien usando técnicas de instantón. Cuando hay un fermión sin masa, el efecto túnel entre estados queda completamente suprimido. Cuando hay campos fermiónicos con masa pequeña, el efecto túnel es mucho menor que para campos gauge puros, pero no está completamente suprimido.

Emilio Silvera V.

Ago

31

¿Dónde están las respuestas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

¡Son posibles tantas cosas!

Algunos quieren encontrar las respuestas en la religión (que si ha sido escogida voluntariamente… ¡bien está!). Pero, como todos sabemos, es cosa de fe. Creer en aquello que no podemos ver ni comprobar no es precisamente el camino de la ciencia que empieza por imaginar, después conjeturar, más tarde teorizar, se comprueba una y mil veces la teoría aceptada a medias y sólo cuando todo está amarrado y bien atado, todas esas fases pasan a la categoría de una ley o norma que se utiliza para continuar investigando en la buena dirección. Einstein solía decir: “La religión sin Ciencia es ciega.”

Otros han sido partidarios de la teoría del caos y argumentan que a medida que el nivel de complejidad de un sistema aumenta, entran en juego nuevos tipos de leyes. Entender el comportamiento de un electrón o un quark es una cosa; utilizar este conocimiento para comprender el comportamiento de un tornado es otra muy distinta. La mayoría está de acuerdo con este aspecto. Sin embargo, las opiniones divergen con respecto a si los fenómenos diversos y a veces inesperados que pueden darse en sistemas más complejos que las partículas individuales son realmente representativos del funcionamiento de los nuevos principios de la física, o si los principios implicados son algo derivado y están basados, aunque sea de un modo terriblemente complicado, en los principios físicos que gobiernan el ingente número de componentes elementales del universo.

“La teoría del todo o teoría unificada fue el sueño incumplido de Einstein. A este empeñó dedicó con pasíón los últimos 30 años de su vida. No lo logró, y hoy continúa sin descubrirse. Consiste en una teoría definitiva, una ecuación única que dé respuesta a todas las preguntas fundamentales del Universo. Claro que, Einstein no sabía que las matemáticas para plasmar esa Teoría mágica… ¡No se habían inventado en su tiempo ni tampoco en el nuestro!

La teoría del todo debe explicar todas la fuerzas de la Naturaleza, y todas las características de la energía y la materia. Debe resolver la cuestión cosmológica, es decir, dar una explicación convincente al origen del Universo. Debe unificar relatividad y cuántica, algo hasta ahora no conseguido. Y además, debe integrar otros universos en caso de que los haya. No parece tarea fácil. Ni siquiera se sabe si existe una teoría del todo en la Naturaleza. Y, en caso de que exista, si es accesible a nuestro entendimiento y a nuestras limitaciones tecnológicas para descubrirla.”

Hace ya muchos años, estando en Nueva York, paseaba por la 5ª Avenida y, me llamó la atención un escaparate en el que la gente, se arremolinaba. ¿Qué trataban de ver? Curioso me acerqué, y, asombrado ví que miraban las últimas ecuaciones de Einstein de la Teoría del Todo. Nadie entendía nada pero, se pegaban por verlas.

Einstein se pasó los últimos treinta años de su vida en la búsqueda de esa teoría que nunca pudo encontrar. En los escaparates de la 5ª Avenida de Nueva York, exponían sus ecuaciones y la gente, sin entender lo que veían, se arremolinaban ante el cristal para verlas.

:format(jpg)/f.elconfidencial.com%2Foriginal%2F68c%2Fe14%2Fc51%2F68ce14c519946fca88d27a853ea6ce98.jpg)

Casi todo el mundo está de acuerdo en que el hallazgo de la Gran Teoría Unificada (teoría del Todo), no significaría de modo alguno que la psicología, la biología, la geología, la química, y también la física, hubieran resuelto todos sus problemas.

El universo es un lugar tan maravilloso, rico y complejo que el descubrimiento de una teoría final, en el sentido en el que esta planteada la teoría de supercuerdas, no supondría de modo alguno el fin de la ciencia ni podríamos decir que ya lo sabemos todo y para todo tendremos respuestas. Más bien será, cuando llegue, todo lo contrario: el hallazgo de esa teoría de Todo (la explicación completa del universo en su nivel más microscópico, una teoría que no estaría basada en ninguna explicación más profunda) nos aportaría un fundamento mucho más firme sobre el que podríamos construir nuestra comprensión del mundo y, a través de estos nuevos conocimientos, estaríamos preparados para comenzar nuevas empresas de metas que, en este momento, nuestra ignorancia no nos dejan ni vislumbrar. La nueva teoría de Todo nos proporcionaría un pilar inmutable y coherente que nos daría la llave para seguir explorando un universo más comprensible y por lo tanto, más seguro, ya que el peligro siempre llega de lo imprevisto, de lo desconocido que surge sin aviso previo; cuando conocemos bien lo que puede ocurrir nos preparamos para evitar daños.

La búsqueda de esa teoría final que nos diga cómo es el universo, el tiempo y el espacio, la materia y los elementos que la conforman, las fuerzas fundamentales que interaccionan, las constantes universales y en definitiva, una formulación matemática o conjunto de ecuaciones de las que podamos obtener todas las respuestas, es una empresa nada fácil y sumamente complicada; la teoría de cuerdas es una estructura teórica tan profunda y complicada que incluso con los considerables progresos que ha realizado durante los últimos décadas, aún nos queda un largo camino antes de que podamos afirmar que hemos logrado dominarla completamente. Se podría dar el caso de que el matemático que encuentre las matemáticas necesarias para llegar al final del camino, aún no sepa ni multiplicar y esté en primaria en cualquier escuela del mundo civilizado.

Muchos de los grandes científicos del mundo (Einstein entre ellos), aportaron su trabajo y conocimientos en la búsqueda de esta teoría, no consiguieron su objetivo pero sí dejaron sus ideas para que otros continuaran la carrera hasta la meta final. Por lo tanto, hay que considerar que la teoría de cuerdas es un trabajo iniciado a partir de las ecuaciones de campo de la relatividad general de Einstein, de la mecánica cuántica de Planck, de las teorías gauge de campos, de la teoría de Kaluza-Klein, de las teorías de… hasta llegar al punto en el que ahora estamos.

El Universo de lo muy grande y el de lo muy pequeño… ¡Es el mismo universo! Simplemente se trata de mirar en distintos ámbitos del saber, y, la importancia de las medidas… ¡también es relatividad! Porque, ¿podríamos valorar la importancia de los electrones. La existencia de los fotones, o, simplemente la masa del protón? Si alguno de esos objetos fuese distinto, el Universo también lo sería.

La armoniosa combinación de la relatividad general y la mecánica cuántica es un éxito muy importante. Además, a diferencia de lo que sucedía con teorías anteriores, la teoría de cuerdas tiene la capacidad de responder a cuestiones primordiales que tienen relación con las fuerzas y los componentes fundamentales de la naturaleza.

Igualmente importante, aunque algo más difícil de expresar, es la notable elegancia tanto de las respuestas que propone la teoría de cuerdas, como del marco en que se generan dichas respuestas. Por ejemplo, en la teoría de cuerdas muchos aspectos de la naturaleza que podrían parecer detalles técnicos arbitrarios (como el número de partículas fundamentales distintas y sus propiedades respectivas) surgen a partir de aspectos esenciales y tangibles de la geometría del universo. Si la teoría de cuerdas es correcta, la estructura microscópica de nuestro universo es un laberinto multidimensional ricamente entrelazado, dentro del cual las cuerdas del universo se retuercen y vibran en un movimiento infinito, marcando el ritmo de las leyes del cosmos.

Lejos de ser unos detalles accidentales, las propiedades de los bloques básicos que construyen la naturaleza están profundamente entrelazadas con la estructura del espacio-tiempo.

Accede al artículo original espacioprofundo.es/2013/01/11/einstein-tenia-razon-el-espacio-tiempo-es-una-estructura-suave/ © Espacio Profundo

¿Dónde estarán las cuerdas vibrantes? Dicen que se necesita una energía de 1019 GeV para poder verificarlas, y, esa energía corresponde al momento de la creación no disponemos de ella.

Claro que, siendo todos los indicios muy buenos, para ser serios, no podemos decir aún que las predicciones sean definitivas y comprobables para estar seguros de que la teoría de cuerdas ha levantado realmente el velo de misterio que nos impedía ver las verdades más profundas del universo, sino que con propiedad se podría afirmar que se ha levantado uno de los picos de ese velo y nos permite vislumbrar algo de lo que nos podríamos encontrar.

La teoría de cuerdas, aunque en proceso de elaboración, ya ha contribuido con algunos logros importantes y ha resuelto algún que otro problema primordial como por ejemplo, uno relativo a los agujeros negros, asociado con la llamada entropía de Bekenstein-Hawking, que se había resistido pertinazmente durante más de veinticinco años a ser solucionada con medios más convencionales. Este éxito ha convencido a muchos de que la teoría de cuerdas está en el camino correcto para proporcionarnos la comprensión más profunda posible sobre la forma de funcionamiento del universo, que nos abriría las puertas para penetrar en espacios de increíble belleza y de logros y avances tecnológicos que ahora ni podemos imaginar.

Como he podido comentar en otras oportunidades, Edward Witten, uno de los pioneros y más destacados experto en la teoría de cuerdas, autor de la versión más avanzada y certera, conocida como teoría M, resume la situación diciendo que: “la teoría de cuerdas es una parte de la física que surgió casualmente en el siglo XX, pero que en realidad era la física del siglo XXI“.

Witten, un físico-matemático de mucho talento, máximo exponente y punta de lanza de la teoría de cuerdas, reconoce que el camino que está por recorrer es difícil y complicado. Habrá que desvelar conceptos que aún no sabemos que existen.

El hecho de que nuestro actual nivel de conocimiento nos haya permitido obtener nuevas perspectivas impactantes en relación con el funcionamiento del universo es ya en sí mismo muy revelador y nos indica que podemos estar en el buen camino revelador de la rica naturaleza de la teoría de cuerdas y de su largo alcance. Lo que la teoría nos promete obtener es un premio demasiado grande como para no insistir en la búsqueda de su conformación final.

El universo, la cosmología moderna que hoy tenemos, es debida a la teoría de Einstein de la relatividad general y las consecuencias obtenidas posteriormente por Alexandre Friedmann. El Big Bang, la expansión del universo, el universo plano y abierto o curvo y cerrado, la densidad crítica y el posible Big Crunch que, según parece, nunca será un hecho y, el universo, tendrá una “muerte” térmica, es decir, cuando el alejamiento de las galaxias lo haga más grande, más oscuro y más frío. En el cero absoluto de los -273 ºC, ni los átomos se moverán.

Un comienzo y un final que abarcará miles y miles de millones de años de sucesos universales a escalas cosmológicas que, claro está, nos afectará a nosotros, insignificantes mortales habitantes de un insignificante planeta, en un insignificante sistema solar creado por una insignificante y común estrella.

Pero… ¿somos en verdad tan insignificantes.

Claro que, tampoco debemos tomar a pie juntillas todo lo que digamos.

Emilio Silvera V.

Ago

31

Velocidades inimaginables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

https://youtu.be/6z5AIQ7AmK8

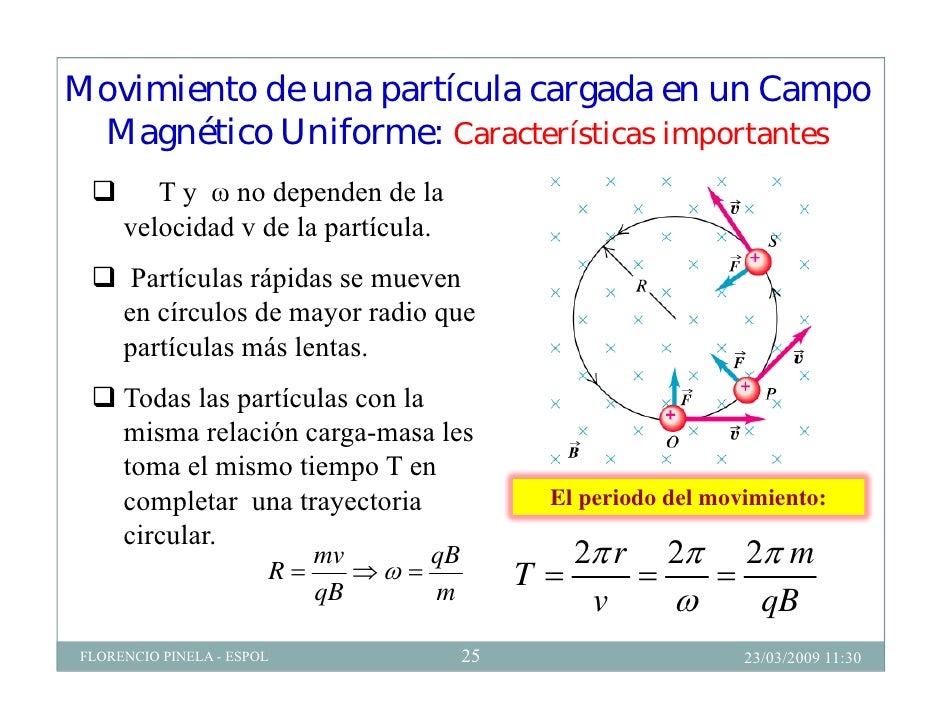

En el centro del átomo se encuentra un pequeño grano compacto aproximadamente 100.000 veces más pequeño que el propio átomo: el núcleo atómico. Su masa, e incluso más aún su carga eléctrica, determinan las propiedades del átomo del cual forma parte. Debido a la solidez del núcleo parece que los átomos, que dan forma a nuestro mundo cotidiano, son intercambiables entre sí, e incluso cuando interaccionan entre ellos para formar sustancias químicas (los elementos). Pero el núcleo, a pesar de ser tan sólido, puede partirse. Si dos átomos chocan uno contra el otro con gran velocidad podría suceder que los núcleos llegaran a chocar entre sí y entonces, o bien se rompen en trozos, o se funden liberando en el proceso partículas sub-nucleares. La nueva física de la primera mitad del siglo XX estuvo dominada por los nuevos acertijos que estas partículas planteaban.

Pero tenemos la mecánica cuántica; ¿es que no es aplicable siempre?, ¿Cuál es la dificultad? Desde luego, la mecánica cuántica es válida para las partículas subatómicas, pero hay más que eso. Las fuerzas con que estas partículas interaccionan y que mantienen el núcleo atómico unido son tan fuertes que las velocidades a las que tienen que moverse dentro y fuera del núcleo están cerca de la velocidad de la luz, c, que es de 299.792’458 Km/s. Cuando tratamos con velocidades tan altas se necesita una segunda modificación a las leyes de la física del siglo XIX; tenemos que contar con la teoría de la relatividad especial de Einstein.

Esta teoría también fue el resultado de una publicación de Einstein de 1905. en esta teoría quedaron sentadas las bases de que el movimiento y el reposo son conceptos relativos, no son absolutos, como tampoco habrá un sistema de referencia absoluto con respecto al cual uno pueda medir la velocidad de la luz.

Pero había más cosas que tenían que ser relativas. En este teoría, la masa y la energía también dependen de la velocidad, como lo hacen la intensidad del campo eléctrico y del magnético. Einstein descubrió que la masa de una partícula es siempre proporcional a la energía que contienen, supuesto que se haya tenido en cuenta una gran cantidad de energía en reposo de una partícula cualquiera, como se denota a continuación:

E = mc2

Como la velocidad de la luz es muy grande, esta ecuación sugiere que cada partícula debe almacenar una cantidad enorme de energía, y en parte esta predicción fue la que hizo que la teoría de la relatividad tuviese tanta importancia para la física (¡y para todo el mundo!). Para que la teoría de la relatividad también sea auto-consistente tiene que ser holista, esto es, que todas las cosas y todo el mundo obedezcan a las leyes de la relatividad. No son sólo los relojes los que se atrasan a grandes velocidades, sino que todos los procesos animados se comportan de la forma tan inusual que describe esta teoría cuando nos acercamos a la velocidad de la luz. El corazón humano es simplemente un reloj biológico y latirá a una velocidad menor cuando viaje en un vehículo espacial a velocidades cercanas a la de la luz. Este extraño fenómeno conduce a lo que se conoce como la “paradoja de los gemelos”, sugerida por Einstein, en la que dos gemelos idénticos tienen diferente edad cuando se reencuentran después de que uno haya permanecido en la Tierra mientras que el otro ha viajado a velocidades relativistas.

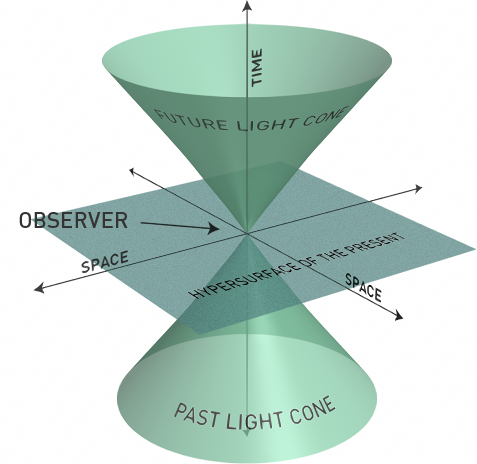

Einstein comprendió rápidamente que las leyes de la gravedad también tendrían que ser modificadas para que cumplieran el principio relativista.

Para poder aplicar el principio de la relatividad a la fuerza gravitatoria, el principio tuvo que ser extendido de la siguiente manera: no sólo debe ser imposible determinar la velocidad absoluta del laboratorio, sino que también es imposible distinguir los cambios de velocidad de los efectos de una fuerza gravitatoria.

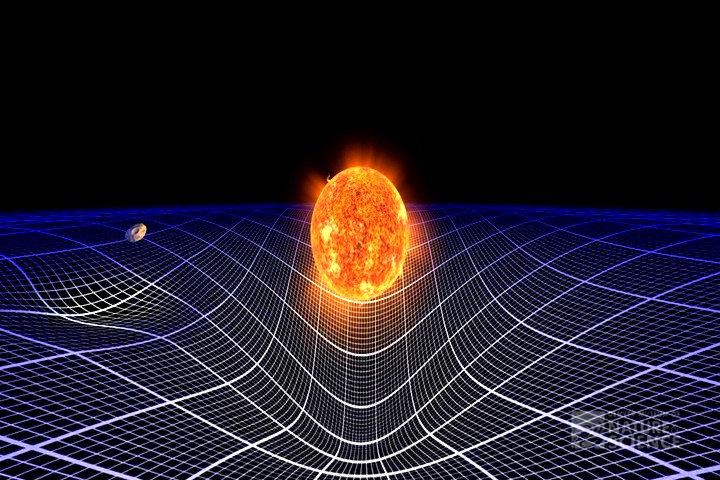

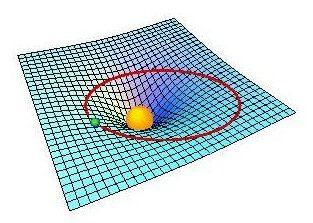

Einstein comprendió que la consecuencia de esto era que la gravedad hace al espacio-tiempo lo que la humedad a una hoja de papel: deformar la superficie con desigualdades que no se pueden eliminar. Hoy en día se conocen muy bien las matemáticas de los espacios curvos, pero en el época de Einstein el uso de estas nociones matemáticas tan abstractas para formular leyes físicas era algo completamente nuevo, y le llevó varios años encontrar la herramienta matemática adecuada para formular su teoría general de la relatividad que describe cómo se curva el espacio en presencia de grandes masas como planetas y estrellas.

Einstein tenía la idea en su mente desde 1907 (la relatividad especial la formuló en 1905), y se pasó 8 años buscando las matemáticas adecuadas para su formulación.

En geometría de Riemann, el tensor métrico es un tensor de rango 2 que se utiliza para definir conceptos métricos como distancia, ángulo y volumen en un espacio localmente euclídeo. Paraboloide de Flamm (solución exterior de Schwarzschild)

Leyendo el material enviado por un amigo al que pidió ayuda, Einstein quedó paralizado. Ante él, en la primera página de una conferencia dada ante el Sindicato de Carpinteros, 60 años antes por un tal Riemann, tenía la solución a sus desvelos: el tensor métrico de Riemann, que le permitiría utilizar una geometría espacial de los espacios curvos que explicaba su relatividad general.

No está mal que en este punto recordemos la fuerza magnética y gravitatoria que nos puede ayudar a comprender mejor el comportamiento de las partículas subatómicas.

El electromagnetismo, decíamos al principio, es la fuerza con la cual dos partículas cargadas eléctricamente se repelen (si sus cargas son iguales) o se atraen (si tienen cargas de signo opuesto).

La interacción magnética es la fuerza que experimenta una partícula eléctricamente cargada que se mueve a través de un campo magnético. Las partículas cargadas en movimiento generan un campo magnético como, por ejemplo, los electrones que fluyen a través de las espiras de una bobina.

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

¿Qué dicen?

La electricidad y el magnetismo no pueden desvanecerse sin más. Una región de un campo eléctrico girando crea un campo magnético perpendicular al giro. Una región de un campo magnético girando crea un campo eléctrico perpendicular al giro, pero en el sentido opuesto.

¿Por qué es importante?

Fue la primera unificación importante de fuerzas físicas, mostrando que la electricidad y el magnetismo están íntimamente interrelacionados, o, son dos aspectos diferentes de la misma cosa.

¿Qué provocó?

La predicción de que las ondas electromagnéticas existen, desplazándose a la velocidad de la luz, de modo que la propia luz es una de dichas ondas. Esto motivó la invención de la radio, el radar, la televisión, las conexiones inalámbricas para los ordenadores y la mayoría de las comunicaciones modernas.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos Alfa (α) y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

También antes hemos comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el nombre de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria entre dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

El gravitón hace tiempo que se ríe de nosotros…y se oculta donde no lo podamos ver

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza entre cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles entre sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo entre hadrones para mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10-15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo nombre indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante entre los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida entre la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el nombre de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

Antes de seguir veamos las partículas elementales de vida superior a 10-20 segundos que eran conocidas en el año 1970.

| Nombre | Símbolo | Masa (MeV) | Carga | Espín | Vida media (s) |

| Fotón | γ | 0 | 0 | 1 | ∞ |

| Leptones (L = 1, B = 0) | |||||

| Electrón | e– | 0’5109990 | – | ½ | ∞ |

| Muón | μ– | 105’6584 | – | ½ | 2’1970 × 10-6 |

| Tau | τ | ||||

| Neutrino electrónico | νe | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino muónico | νμ | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino tauónico | ντ | ~ 0 | 0 | ½ | ~ ∞ |

| Mesones (L = 0, B = 0) | |||||

| Pión + | π+ | 139’570 | 2’603 × 10-8 | ||

| Pión – | π– | 139’570 | 2’603 × 10-8 | ||

| Pión 0 | π0 | 134’976 | 0’84 × 10-16 | ||

| Kaón + | k+ | 493’68 | 1’237 × 10-8 | ||

| Kaón – | k– | 493’68 | 1’237 × 10-8 | ||

| Kaón largo | kL | 497’7 | 5’17 × 10-8 | ||

| Kaón corto | kS | 497’7 | 0’893 × 10-10 | ||

| Eta | η | 547’5 | 0 | 0 | 5’5 × 10-19 |

| Bariones (L = 0, B = 1) | |||||

| Protón | p | 938’2723 | + | ½ | ∞ |

| Neutrón | n | 939’5656 | 0 | ½ | 887 |

| Lambda | Λ | 1.115’68 | 0 | ½ | 2’63 × 10-10 |

| Sigma + | Σ+ | 1.189’4 | + | ½ | 0’80 × 10-10 |

| Sigma – | Σ– | 1.1974 | – | ½ | 7’4× 10-20 |

| Sigma 0 | Σ0 | 0 | ½ | 1’48 × 10-10 | |

| Ksi 0 | Ξ0 | 1.314’9 | 0 | ½ | 2’9 × 10-10 |

| Ksi – | Ξ– | 1.321’3 | – | ½ | 1’64 × 10-10 |

| Omega – | Ω– | 1.672’4 | – | 1½ | 0’82 × 10-10 |

Para cada leptón y cada barión existe la correspondiente antipartícula, con exactamente las mismas propiedades a excepción de la carga que es la contraria. Por ejemplo, el antiprotón se simboliza con y el electrón con e+. Los mesones neutros son su propia antipartícula, y el π+ es la antipartícula del π–, al igual que ocurre con k+ y k–. El símbolo de la partícula es el mismo que el de su antipartícula con una barra encima. Las masas y las vidas medias aquí reflejadas pueden estar corregidas en este momento, pero de todas formas son muy aproximadas.

Los símbolos que se pueden ver algunas veces, como s (extrañeza) e i (isoespín) están referidos a datos cuánticos que afectan a las partículas elementales en sus comportamientos.

Debo admitir que todo esto tiene que sonar algo misterioso. Es difícil explicar estos temas por medio de la simple palabra escrita sin emplear la claridad que transmiten las matemáticas, lo que, por otra parte, es un mundo secreto para el común de los mortales, y ese lenguaje es sólo conocido por algunos privilegiados que, mediante un sistema de ecuaciones pueden ver y entender de forma clara, sencilla y limpia, todas estas complejas cuestiones.

Si hablamos del espín (o, con más precisión, el momento angular, que es aproximadamente la masa por el radio por la velocidad de rotación) se puede medir como un múltiplo de la constante de Planck, h, dividido por 2π. Medido en esta unidad y de acuerdo con la mecánica cuántica, el espín de cualquier objeto tiene que ser o un entero o un entero más un medio. El espín total de cada tipo de partícula – aunque no la dirección del mismo – es fijo.

El electrón, por ejemplo, tiene espín ½. Esto lo descubrieron dos estudiantes holandeses, Samuel Gondsmit (1902 – 1978) y George Uhlenbeck (1900 – 1988), que escribieron sus tesis conjuntamente sobre este problema en 1972. Fue una idea audaz que partículas tan pequeñas como los electrones pudieran tener espín, y de hecho, bastante grande. Al principio, la idea fue recibida con escepticismo porque la “superficie del electrón” se tendría que mover con una velocidad 137 veces mayor que la de la luz, lo cual va en contra de la teoría de la relatividad general en la que está sentado que nada en el universo va más rápido que la luz, y por otra parte, contradice E=mc2, y el electrón pasada la velocidad de la luz tendría una masa infinita.

Hoy día, sencillamente, tal observación es ignorada, toda vez que el electrón carece de superficie.

Las partículas con espín entero se llaman bosones, y las que tienen espín entero más un medio se llaman fermiones. Consultado los valores del espín en la tabla anterior podemos ver que los leptones y los bariones son fermiones, y que los mesones y los fotones son bosones. En muchos aspectos, los fermiones se comportan de manera diferente de los bosones. Los fermiones tienen la propiedad de que cada uno de ellos requiere su propio espacio: dos fermiones del mismo tipo no pueden ocupar o estar en el mismo punto, y su movimiento está regido por ecuaciones tales que se evitan unos a otros. Curiosamente, no se necesita ninguna fuerza para conseguir esto. De hecho, las fuerzas entre los fermiones pueden ser atractivas o repulsivas, según las cargas. El fenómeno por el cual cada fermión tiene que estar en un estado diferente se conoce como el principio de exclusión de Pauli. Cada átomo está rodeado de una nube de electrones, que son fermiones (espín ½). Si dos átomos se aproximan entre sí, los electrones se mueven de tal manera que las dos nubes se evitan una a otra, dando como resultado una fuerza repulsiva. Cuando aplaudimos, nuestras manos no se atraviesan pasando la uno a través de la otra. Esto es debido al principio de exclusión de Pauli para los electrones de nuestras manos que, de hecho, los de la izquierda rechazan a los de la derecha.

En contraste con el característico individualismo de los fermiones, los bosones se comportan colectivamente y les gusta colocarse todos en el mismo lugar. Un láser, por ejemplo, produce un haz de luz en el cual muchísimos fotones llevan la misma longitud de onda y dirección de movimiento. Esto es posible porque los fotones son bosones.

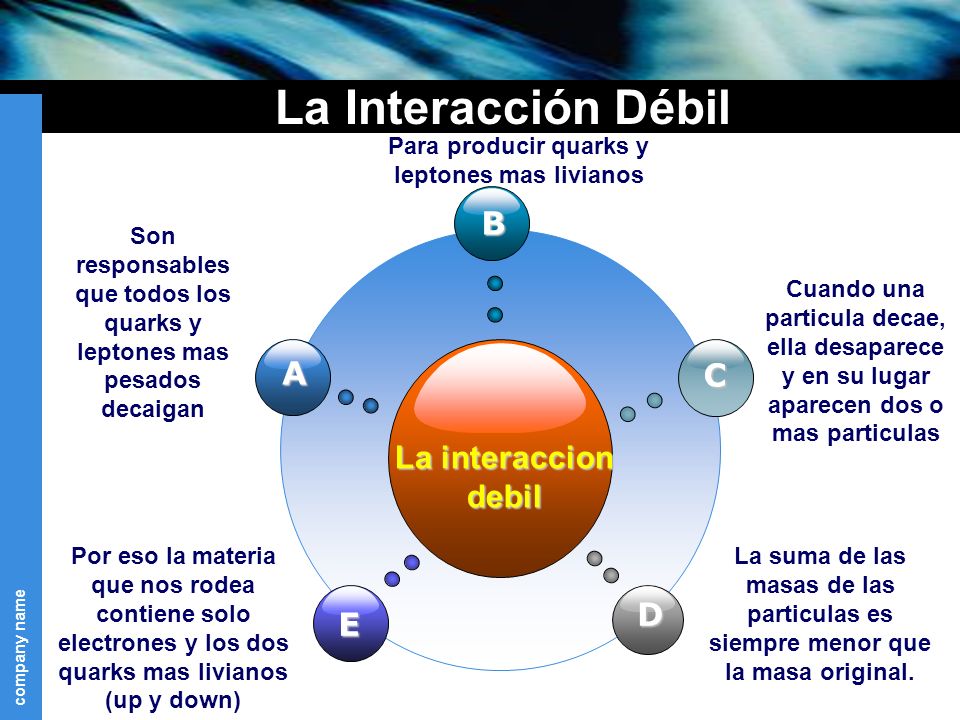

Cuando hemos hablado de las fuerzas fundamentales que, de una u otra forma, interaccionan con la materia, también hemos explicado que la interacción débil es la responsable de que muchas partículas y también muchos núcleos atómicos exóticos sean inestables. La interacción débil puede provocar que una partícula se transforme en otra relacionada, por emisión de un electrón y un neutrino. Enrico Fermi, en 1934, estableció una fórmula general de la interacción débil, que fue mejorada posteriormente por George Sudarshan, Robert Marschak, Murray Gell-Mann, Richard Feynman y otros. La fórmula mejorada funciona muy bien, pero se hizo evidente que no era adecuada en todas las circunstancias.

¿Cuál es la diferencia entre el protón y el neutrón?

Basta con cambiar un quark tipo U a uno tipo D.

Pues justamente esto es lo que ocurre en la naturaleza cuando entra en acción la fuerza nuclear débil. Un quark tipo U cambia a uno tipo D por medio de la interacción débil así

Las otras dos partículas que salen son un anti-electrón y un neutrino.

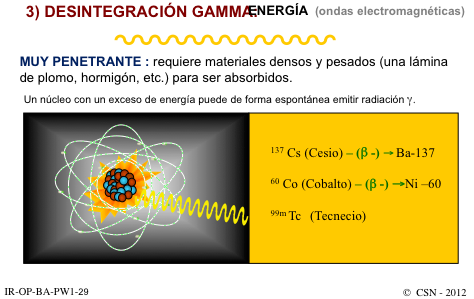

Este mismo proceso es el responsable del decaimiento radiactivo de algunos núcleos atómicos. Cuando un neutrón se convierte en un protón en el decaimiento radiactivo de un núcleo, aparece un electrón y un neutrino. Este es el origen de la radiación beta (electrónes).

En 1970, de las siguientes características de la interacción débil sólo se conocían las tres primeras:

- La interacción actúa de forma universal sobre muchos tipos diferentes de partículas y su intensidad es aproximadamente igual para todas (aunque sus efectos pueden ser muy diferentes en cada caso). A los neutrinos les afecta exclusivamente la interacción débil.

- Comparada con las demás interacciones, ésta tiene un alcance muy corto.

- La interacción es muy débil. Consecuentemente, los choques de partículas en los cuales hay neutrinos involucrados son tan poco frecuentes que se necesitan chorros muy intensos de neutrinos para poder estudiar tales sucesos.

- Los mediadores de la interacción débil, llamados W+, W– y Z0, no se detectaron hasta la década de 1980. al igual que el fotón, tienen espín 1, pero están eléctricamente cargados y son muy pesados (esta es la causa por la que el alcance de la interacción es tan corto). El tercer mediador, Z0, que es responsable de un tercer tipo de interacción débil que no tiene nada que ver con la desintegración de las partículas llamada “corriente neutra”, permite que los neutrinos puedan colisionar con otras partículas sin cambiar su identidad.

A partir de 1970, quedó clara la relación de la interacción débil y la electromagnética (electrodébil de Weinberg-Salam).

La interacción fuerte (como hemos dicho antes) sólo actúa entre las partículas que clasificamos en la familia llamada de los hadrones, a los que proporciona una estructura interna complicada. Hasta 1972 sólo se conocían las reglas de simetría de la interacción fuerte y no fuimos capaces de formular las leyes de la interacción con precisión.

Como apuntamos, el alcance de esta interacción no va más allá del radio de un núcleo atómico ligero (10-13 cm aproximadamente).

En 1963, cuando se supo que protones y neutrones (los llamados nucleones) están formados por Quarks, se pensó que la fuerza fuerte actúa realmente entre los Quarks.

En la teoría cuántica de campos, a cada tipo de interacción le corresponde una familia de partículas portadoras de la interacción.Las partículas que transportan la fuerza fuerte nuclear que interactúa entre los quarks se denominan gluones.

La fuerza nuclear fuerte se deduce del requisito de que las ecuaciones que describen a los quarks deben ser las mismas, independientemente de cómo se elija la definición de los colores de los quarks.

La interacción es fuerte. En realidad, la más fuerte de todas.

Lo dejaré aquí, en verdad, eso que el Modelo Estándar de la Física, es feo, complejo e incompleto y, aunque hasta el momento es una buena herramienta con la que trabajar, la verdad es que, se necesita un nuevo modelo más avanzado y que incluya la Gravedad.

Veremos que nos trae la nueva etapa del LHC.

Emilio Silvera V.

Ago

30

Nuestra Imaginación es mucho más rçapida que la luz

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Una de las verdades perdidas en la noche de los Tiempos… ¡Es la ATLANTIDA!

¿Cuántas veces habré “visitado” Marte con la Imaginación?

Pero bajemos hasta la realidad y pongamos los pies en el suelo, veamos que cosas pasan por aquí, en nuestro mundo real que, a veces, también resultan tan fantásticas como viajar a Marte con el pensamiento.

Satélite Gravity Probe B. Dedicado a medir la curvatura del campo gravitatorio terrestre debido a la teoría de la relatividad de Einstein. La gravedad ha sido medida y comprobada de muchas maneras pero… ¡Gravedad cuántica! ¿qué es eso? La imaginación anda más rápida que los conocimientos. Sin embargo, así hemos ido avanzando en el transcurrir del Tiempo. Hace algunos miles de años algunos imaginaron la existencia del átomo y de los elementos y, ya sabéis lo que de esas cuestiones sabemos hoy.

La llamada gravedad cuántica trata de fundir en una sola las dos teorías físicas más soberbias con las que contamos, la relatividad general y la mecánica cuántica, que en el estado actual de nuestro conocimiento parecen incompatibles. Su estudio, ahora mismo, es en algunos aspectos análogo a la física de hace cien años, cuando se creía en los átomos, pero se ignaraban los detalles de su estructura.

Desde aquel día en que Kaluza, le escribió a Einstein una carta con su teoría de las cinco dimensiones, en la que unía la Gravedad con el Electromagnetismo, la puerta de las dimensiones más altas quedó abierta y a los teóricos se les regaló una herramienta maravillosa: el hiperespacio; todo es posible. Hasta el matrimonio de la relatividad general y la mecánica cuántica, allí sí es posible encontrar esa soñada teoría de la gravedad cuántica.

Así que las teorías se han embarcado a la búsqueda de un objeto audaz: buscan una teoría que describa la simplicidad primigenia que reinaba en el intenso calor del universo en sus primeros tiempos; una teoría carente de parámetros, donde estén presentes todas las respuestas. Todo debe ser contestado a partir de una ecuación básica.

Claro que saber, lo que el universo es, leyendo una ecuación, por muy ingeniosa que ésta sea y por mucho que la misma pueda abarcar… Parece poco probable. ¿Dónde radica el problema? El problema está en que la única teoría candidata no tiene conexión directa con el mundo de la observación, o no lo tiene todavía si queremos expresarnos con propiedad. La energía necesaria para ello, no la tiene ni el nuevo acelerador de partículas LHC, la máquina más potente del mundo hasta el momento.

La verdad es que la teoría que ahora tenemos, el modelo estándar, concuerda de manera exacta con todos los datos a bajas energías y contesta cosas sin sentido a altas energías. ¡Necesitamos algo más avanzado!

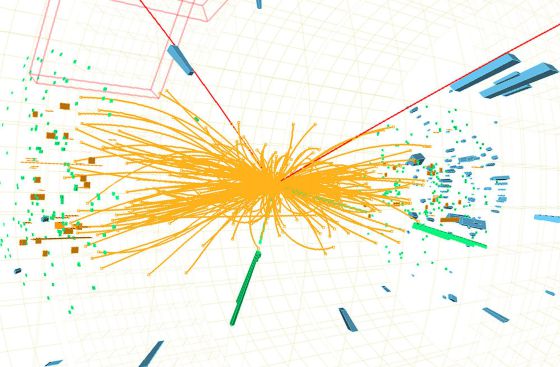

A pesar de su grandeza, se queda corto para que nos pueda decir, lo que necesitamos saber: Si nos habló del Bosón de Higgs, por el momento no está nada mal, y, ahora, en su nueva etapa, seguramente nos dará alguna sorpresa y nos puede desvelar algún que otro secreto de la materia, del universo que presentimos y no podemos ver.

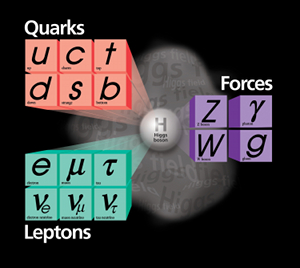

Se dijo que la función de la partícula de Higgs era la de dar masa a las partículas que carecen de ella, disfrazando así la verdadera simetría del mundo. Cuando su autor lanzó la idea a la comunidad científica, resultó además de nueva, muy extraña. El secreto de todo radica en conseguir la simplicidad: el átomo resultó ser complejo, lleno de esas infinitesimales partículas electromagnéticas que bautizamos con el nombre de electrones, y, el núcleo, una parte entre cien mil del total del átomo, resultó ser de una complejidad asombrosa. Allí los nucleones (protones y neutrones) resultaron estar hechos por tripletes de Quarks que, confinados por la fuerza nuclear fuerte, eran rtenidos por los Gluones, los Bosones transmisores de esa fuerza de la naturaleza. Así que un núcleo que contenía, a pesar de ser tan pequeño, casi toda la masa del átomo, cuando fue descubierto en todo su contenido, fue motivo de un gran asombro entre la comunidad científica. El núcleo, tan pequeño, estaba compuesto de otros objetos más pequeños aún; los quarks que estaban instalados en nubes de otras partículas llamadas gluones, y ahora queremos continuar profundizando, sospechando que después de los quarks puede haber algo más.

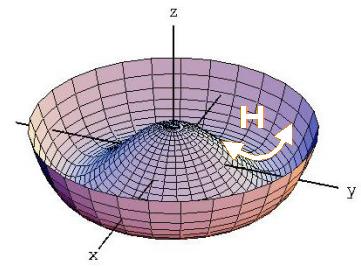

Nos dicen que existen lugares que llaman los Océanos de Higgs, y, por ellos, circula libremente el dichoso Bosón que, también según nos dicen, proporciona la masa al resto de las partículas. Todo el Universo está permeado por esa especie de sustancia -como el viejo éter- que los griegos llamaban Ilem cósmico y que, a medida que el tiempo avanza, le vamos cambiando el nombre. Pues bien, ahí, en ese “océano” dicen que está el Bosón dador de masas que según parece, descubrieron hace un par de años.

Bueno, la idea nueva que surgió es que el espacio entero contiene un campo, el campo de Higgs, que impregna el vacío y es el mismo en todas partes, es decir, que si miramos a las estrellas en una noche clara, estamos mirando el campo de Higgs. Las partículas influidas por este campo toman masa. Esto no es por sí mismo destacable, pues las partículas pueden tomar energía de los campos (gauge) de los que hemos comentado otras veces, tales como: del campo gravitatorio o del electromagnético.

Si llevamos un bloque de plomo a lo alto de la Torre Eiffel, el bloque adquirirá energía potencial a causa de la alteración de su posición en el campo gravitatorio de la Tierra. Como E = mc2, ese aumento de la energía potencial equivale a un aumento de la masa, en este caso la masa del sistema Tierra-bloque de plomo. Aquí hemos de añadirle amablemente un poco de complejidad a la venerable ecuación de Einstein: la masa, m, tiene en realidad dos partes; una es la masa en reposo, m0, la que se mide en el laboratorio cuando la partícula está en reposo. La partícula adquiere la otra parte de la masa en virtud de su movimiento (como los protones en el acelerador de partículas, o los muones, que aumentan varias veces su masa cuando son lanzados a velocidades cercanas a c) en los aceleradores, o en virtud de su energía potencial de campo. Vemos una dinámica similar en los núcleos atómicos. Por ejemplo, si separamos el protón y el neutrón que componen un núcleo de deuterio, la suma de las masas aumenta.

Pero la energía potencial tomada del campo de Higgs difiere en varios aspectos de la acción de los campos familiares. La masa tomada de Higgs es en realidad masa en reposo. De hecho, en la que quizá sea la versión más apasionante de la teoría del campo de Higgs, éste genera toda la masa en reposo. Otra diferencia es que la cantidad de masa que se traga del campo es distinta para las distintas partículas. Los teóricos dicen que las masas de las partículas de nuestro modelo estándar miden con qué intensidad se acoplan estas al campo de Higgs cuando interaccionan con él.

La influencia de Higgs en las masas de los quarks y de los leptones nos recuerda el descubrimiento por Pieter Zeeman, en 1.896, de la división de los niveles de energía de un electrón cuando se aplica un campo magnético al átomo. El campo (que representa metafóricamente el papel de Higgs) rompe la simetría del espacio de la que el electrón disfrutaba.

Hasta ahora no tenemos ni idea de qué reglas controlan los incrementos de masa generados por Higgs (de ahí la expectación creada -en su momento- por el nuevo acelerador de partículas LHC), pero el problema es irritante: ¿por qué sólo esas masas - las masas de los W+, W–, Z0, y el up, down, encanto, extraño, top y bottom, así como los leptones – que no forman ningún patrón obvio?

Las masas van desde la del electrón (0’0005 GeV) a la del top, que tiene que ser mayor que 91 GeV. Deberíamos recordar que esta extraña idea (el Higgs) se empleó con mucho éxito para formular la teoría electrodébil (Weinberg-Salam). Allí se propuso el campo de Higgs como una forma de ocultar la unidad de las fuerzas electromagnética y débil. En la unidad hay cuatro partículas mensajeras sin masa – los W+, W–, Z0 y el fotón – que llevan la fuerza electrodébil. Además está el campo de Higgs, y rápidamente, los W y Z absorben la esencia de Higgs y se hacen pesados; el fotón permanece intacto. La fuerza electrodébil se fragmenta en la débil (débil porque los mensajeros son muy gordos), y la electromagnética, cuyas propiedades determina el fotón, carente de masa. La simetría se rompe espontáneamente, dicen las teorías. Prefiero la descripción según la cual el Higgs oculta la simetría con su poder dador de masa.

“En la actualidad, prácticamente todos los fenómenos subatómicos conocidos son explicados mediante el modelo estándar, una teoría ampliamente aceptada sobre las partículas elementales y las fuerzas entre ellas. Sin embargo, en la década de 1960, cuando dicho modelo aún se estaba desarrollando, se observaba una contradicción aparente entre dos fenómenos. Por un lado, la fuerza nuclear débil entre partículas subatómicas podía explicarse mediante leyes similares a las del electromagnetismo (en su versión cuántica). Dichas leyes implican que las partículas que actúen como intermediarias de la interacción, como el fotón en el caso del electromagnetismo y las partículas W y Z en el caso de la fuerza débil, deben ser no masivas. Sin embargo, sobre la base de los datos experimentales, los bosones W y Z, que entonces sólo eran una hipótesis, debían ser masivos.

En 1964, tres grupos de físicos publicaron de manera independiente una solución a este problema, que reconciliaba dichas leyes con la presencia de la masa. Esta solución, denominada posteriormente mecanismo de Higgs, explica la masa como el resultado de la interacción de las partículas con un campo que permea el vacío, denominado campo de Higgs. El modelo estándar quedó finalmente constituido haciendo uso de este mecanismo.”

Tampoco el Higgs es una partícula especial porque sea una excitación del del campo de Higgs que nos permita explorar sus propiedades, porque en las teorías sin Higgs o con Higgs compuesto también hay excitaciones del vacío que nos permiten explorar el campo.” Eso nos dicen en el magnifico Blog de Francis (th)E mule Science’s News.

| Partícula | Símbolo | Masa (en GeV/c2) | Carga eléctrica | Espín | Interacción |

|---|---|---|---|---|---|

| Fotón |  |

0 | 0 | 1 | electromagnética |

| Bosón W | W± | 80,4 | ± 1 | 1 | débil |

| Bosón Z | Z0 | 91,187 | 0 | 1 | débil |

| Gluón | g | 0 | 0 | 1 | fuerte |

Las masas de los W y Z se predijeron con éxito a partir de los parámetros de la teoría electrodébil, y las relajadas sonrisas de los físicos teóricos nos recuerdan que Hooft y Veltman dejaron sentado que la teoría entera está libre de infinitos.

Todos los intentos y los esfuerzos por hallar una pista de cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿por qué pesa el muón?”. Ahora, por lo menos, tenemos una respuesta parcial, en absoluto completa. Una voz potente y segura nos dice “¡Higgs!”. Durante más de sesenta años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo de Higgs presenta el problema en un contexto nuevo; no se trata sólo del muón. Proporciona, por lo menos, una fuente común para todas las masas. La nueva pregunta feynmaniana podría ser: ¿cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas de la materia?

La variación de la masa con el estado de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente, y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen en entredicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “renormalizándolo”, ese truco matemático que empleam cuando no saben hacerlo bien.

¿Sabremos alguna vez cómo adquieren masa las partículas?

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. Hace que la historia de Higgs se tenga en pie: la masa no es una propiedad intrínseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrínseca como la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en la que los espines estarían asociados para siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

Una cosa más; hemos hablado de los bosones gauge y de su espín de una unidad. Hemos comentado también las partículas fermiónicas de la materia (espín de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espín cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs da masa a los objetos donde quiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” (sin dirección) por esa razón.

La interacción débil, recordaréis, fue inventada por E. Fermi para describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme número de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar nuevas partículas que puedan despejar algunos interrogantes.

Recuerdo cuando andaban a la caza del Bosón de Higgs y decían “Pero todavía hay que responder montones de preguntas: ¿cuáles son las propiedades de las partículas de Higgs? y, lo que es más importante, ¿cuál es su masa? (Bueno, parece que, en el último experimento apareció se localizó un bosón con ~125 GeV que, según parece, podría ser el esquivo Hihhs)¿Cómo reconoceremos una si nos la encontramos en una colisión del LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas o sólo las hace incrementarse? ¿Cómo podemos saber más al respecto? Cómo es su partícula, nos cabe esperar que la veremos ahora después de gastar más de 50.000 millones de euros en los elementos necesarios para ello.”

También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del universo, añadiendo pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal como se lo concibe ahora, se puede destruir con una energía grande, o temperaturas altas. Éstas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuado que las partículas y la cosmología pintan juntas de un universo primitivo puro y de resplandeciente simetría es demasiado caliente para Higgs. Pero cuando la temperatura cae bajo los 10-5 grados Kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así, por ejemplo, antes del Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

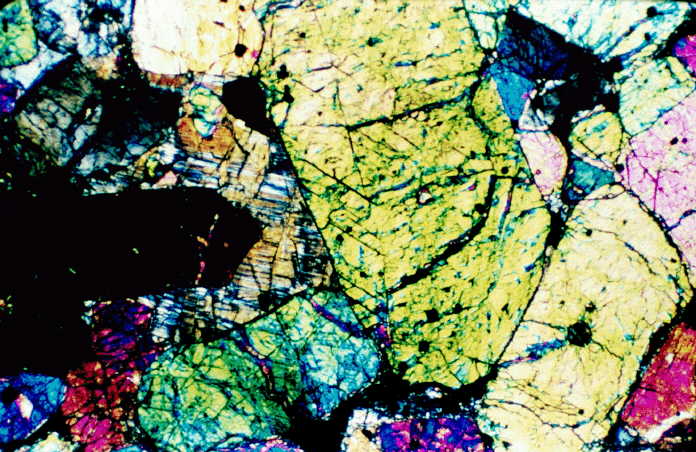

No, esto no es el Higgs, es, simplemente, una burbuja multicolor

El universo se expande y se enfría, y entonces viene el Higgs (que “engorda” los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe. Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra parte una interacción electromagnética, llevada por los fotones. Es como si para algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que les hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es como el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

De todas formas, es tanta la ignorancia que tenemos sobre el origen de la masa que nos agarramos como a un clavo ardiendo, en este caso, a la partícula de Higgs, que algunos han llegado a llamar “la partícula divina”. Lo mismo nos pasa con la dichosa “materia oscura” para ocultar lo que no sabemos sobre la expansión del Universo.

¡Ya veremos en qué termina todo esto!

Arriba tenemos nada más y nada menos que: a John Mather, Carlo Rubbia, Martinus Veltman, Gerardus ‘t Hooft at the Lindau Nobel Meetings 2010. Si científicos como ellos no vienen a nuestro rescate, y nos sacan del atolladero en el que estamos inmerso y hasta el cuelo de ignorancia…¡Mal hirán las cosas!