May

20

¡Cuántas maravillas! Y, nuestra Mente, entre ellas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (6)

Comments (6)

Parafraseando a Hilbert: ¡Tenemos que saber, y sabremos!

En la tumba de David Hilbert (1862-1943), en el cementerio de Gotinga (Alemania), dice:

“Debemos saber. Sabremos”.

Hilbert nos hacía su planteamiento que era obtener la respuesta a tres importantes preguntas:

- ¿Son las matemáticas completas, es decir cualquier proposición puede ser probada o rechazada?

- ¿Son las matemáticas consistentes, es decir no es posible demostrar algo falso?

- ¿Son las matemáticas decidibles, es decir cualquier proposición se puede demostrar como cierta o falsa tras una secuencia finita de pasos?”

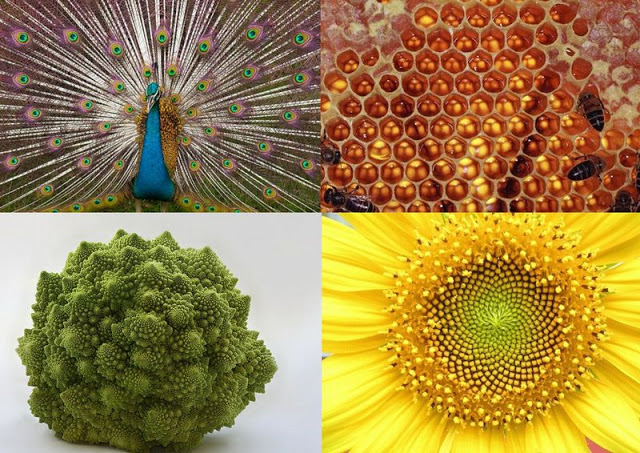

La importancia de la Simetría en la Naturaleza. La simetría en la naturaleza es un fenómeno ampliamente observado en diferentes aspectos de nuestro entorno natural. Se refiere a la existencia de formas, patrones y estructuras que exhiben una organización equilibrada y armoniosa en relación con un eje, plano o punto de referencia.

No sería descabellado decir que las simetrías que vemos a nuestro alrededor, desde un arco iris a las flores y a los cristales, pueden considerarse en última instancia como manifestaciones de fragmentos de la teoría decadimensional original. Riemann y Einstein habían confiado en llegar a una comprensión geométrica de por qué las fuerzas pueden determinar el movimiento y la naturaleza de la materia. Por ejemplo, la fuerza de Gravedad generada por la presencia de la materia, determina la geometría del espacio-tiempo.

Dado el enorme poder de sus simetrías, no es sorprendente que la teoría de supercuerdas sea radicalmente diferente de cualquier otro de física. De hecho, fue descubierta casi por casualidad. Muchos físicos han comentado que si este accidente fortuito no hubiese ocurrido, entonces la teoría no se hubiese descubierto hasta bien entrado el siglo XXI. Esto es así porque supone una neta desviación de todas las ideas ensayadas en este siglo. No es una extensión natural de tendencias y teorías populares en este siglo que ha pasado; permanece aparte.

Por el contrario, la teoría de la relatividad general de Einstein tuvo una evolución normal y lógica. En primer lugar, su autor, postula el principio de equivalencia. Luego reformuló principio físico en las matemáticas de una teoría de campos de la gravitación basada en los campos de Faraday y en el tensor métrico de Riemann. Más tarde llegaron las “soluciones clásicas”, tales el agujero negro y el Big Bang. Finalmente, la última etapa es el intento actual de formular una teoría cuántica de la gravedad. Por lo tanto, la relatividad general siguió una progresión lógica, un principio físico a una teoría cuántica.

Geometría → teoría de campos → teoría clásica → teoría cuántica.

Contrariamente, la teoría de supercuerdas ha estado evolucionando hacia atrás su descubrimiento accidental en 1.968. Esta es la razón de que nos parezca extraña y poco familiar, estamos aún buscando un principio físico subyacente, la contrapartida del principio de equivalencia de Einstein.

La teoría nació casi por casualidad en 1.968 cuando dos jóvenes físicos teóricos, Gabriel Veneziano y Mahiko Suzuki, estaban hojeando independientemente libros de matemáticas. Figúrense ustedes que estaban buscando funciones matemáticas que describieran las interacciones de partículas fuertemente interactivas. Mientras estudiaban en el CERN, el Centro Europeo de Física Teórica en Ginebra, Suiza, tropezaron independientemente con la función beta de Euler, una función matemática desarrollada en el S. XIX por el matemático Leonhard Euler. Se quedaron sorprendidos al que la función beta de Euler ajustaba casi todas las propiedades requeridas para describir interacciones fuertes de partículas elementales.

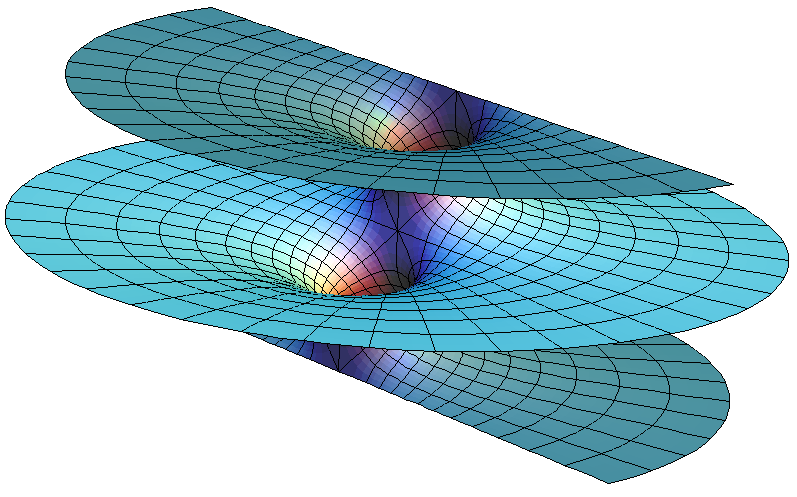

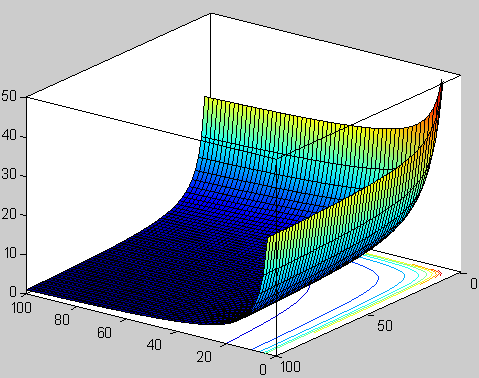

Función beta. Representación de la función valores reales positivos de x e y.

Según he leído, durante un almuerzo en el Lawrence Berkeley Laboratory en California, con una espectacular vista del Sol brillando sobre el puerto de San Francisco, Suzuki le explicó a Michio Kaku mientras almorzaban la excitación de , prácticamente por casualidad, un resultado parcialmente importante. No se suponía que la física se pudiera hacer de ese modo casual.

Tras el descubrimiento, Suzuki, muy excitado, mostró el hallazgo a un físico veterano del CERN. Tras oír a Suzuki, el físico veterano no se impresionó. De hecho le dijo a Suzuki que otro físico joven (Veneziano) había descubierto la misma función unas semanas antes. Disuadió a Suzuki de publicar su resultado. Hoy, esta función beta se conoce con el de modelo Veneziano, que ha inspirado miles de artículos de investigación iniciando una importante escuela de física y actualmente pretende unificar todas las leyes de la física.

Gabriele Veneziano y Mahiko Suzuki

En 1.970, el Modelo de Veneziano-Suzuki (que contenía un misterio), fue parcialmente explicado cuando Yoichiro Nambu, de la Universidad de Chicago, y Tetsuo Goto, de la Nihon University, descubrieron que una cuerda vibrante yace detrás de sus maravillosas propiedades. Así que, como la teoría de cuerdas fue descubierta atrás y por casualidad, los físicos aún no conocen el principio físico que subyace en la teoría de cuerdas vibrantes y sus maravillosas propiedades. El último paso en la evolución de la teoría de cuerdas (y el primer paso en la evolución de la relatividad general) aún está pendiente de que alguien sea capaz de darlo.

Así, Witten dice:

“Los seres humanos en el planeta tierra nunca dispusieron del marco conceptual que les llevara a concebir la teoría de supercuerdas de manera intencionada, surgió por razones del azar, por un feliz accidente. Por sus propios méritos, los físicos c del siglo XX no deberían haber tenido el privilegio de estudiar esta teoría muy avanzada a su tiempo y a su conocimiento. No tenían (ni tenemos mismo) los conocimientos y los prerrequisitos necesarios para desarrollar dicha teoría, no tenemos los conceptos correctos y necesarios.”

Actualmente, como ha quedado dicho en este mismo trabajo, Edwar Witten es el físico teórico que, al frente de un equipo de físicos de Princeton, lleva la bandera de la teoría de supercuerdas con aportaciones muy importantes en el desarrollo de la misma. De todas las maneras, aunque los resultados y avances son prometedores, el camino por andar es largo y la teoría de supercuerdas en su conjunto es un edificio con muchas puertas cerradas de las que no tenemos las llaves acceder a su interior y mirar lo que allí nos aguarda.

Ni con colección de llaves podremos abrir la puerta que nos lleve a la Teoría cuántica de la gravedad que, según dicen, subyace en la Teoría M, la más moderna versión de la cuerdas expuesta por E. Witten y que, según contaron los que estuvieron presentes en su presentación, Witten les introdujo en un “universo” fascinante de inmensa belleza que, sin embargo, no puede ser verificado por el experimento.

El problema está en que nadie es lo suficientemente inteligente para resolver la teoría de campos de cuerdas o cualquier otro enfoque no perturbativo de teoría. Se requieren técnicas que están actualmente más allá de nuestras capacidades. Para encontrar la solución deben ser empleadas técnicas no perturbativas, que son terriblemente difíciles. Puesto que el 99 por ciento de lo que conocemos sobre física de altas energías se basa en la teoría de perturbaciones, esto significa que estamos totalmente perdidos a la hora de encontrar la verdadera solución de la teoría.

¿Por qué diez dimensiones?

Uno de los secretos más profundos de la teoría de cuerdas, que aún no es bien comprendido, es por qué está definida sólo en diez, once y veintiséis dimensiones. Si calculamos cómo se rompen y se vuelven a juntar las cuerdas en el espacio N-dimensional, constantemente descubrimos que pululan términos absurdos que destruyen las maravillosas propiedades de la teoría. Afortunadamente, estos términos indeseados aparecen multiplicados por (N-10). Por consiguiente, para hacer que desaparezcan estas anomalías, no tenemos otra elección cuántica que fijar N = 10. La teoría de cuerdas, de hecho, es la única teoría cuántica conocida que exige completamente que la dimensión del espacio-tiempo esté fijada en un único, el diez.

Por desgracia, los teóricos de cuerdas están, por el momento, completamente perdidos explicar por qué se discriminan las diez dimensiones. La respuesta está en las profundidades de las matemáticas, en un área denominada funciones modulares.

Al manipular los diagramas de lazos1 de Kikkawa, Sakita y Virasoro creados por cuerdas en interacción, allí están esas extrañas funciones modulares en las que el 10 aparecen en los lugares más extraños. Estas funciones modulares son tan misteriosas como el hombre que las investigó, el místico del este. Quizá si entendiéramos mejor el trabajo de este genio indio, comprenderíamos por qué vivimos en nuestro universo actual.

Cuando nos asomamos a la Teoría de cuerdas, entramos en un “mundo” lleno de sombras en los que podemos ver brillar, a lo lejos, un resplandor cegador. Todos los físicos coinciden en el hecho de que es una teoría muy prometedora y de la que parece se podrán obtener buenos rendimientos en el futuro pero, de , es imposible verificarla.

El misterio de las funciones modulares podría ser explicado por quien ya no existe, Srinivasa Ramanujan, el hombre más extraño del mundo de los matemáticos. Igual que Riemann, murió antes de cumplir cuarenta años, y Riemann antes que él, trabajó en total aislamiento en su universo particular de números y fue capaz de reinventar por sí mismo lo más valioso de cien años de matemáticas occidentales que, al estar aislado del mundo en las corrientes principales de los matemáticos, le eran totalmente desconocidos, así que los buscó sin conocerlos. Perdió muchos años de su vida en redescubrir matemáticas conocidas.

Dispersas oscuras ecuaciones en sus cuadernos están estas funciones modulares, que figuran entre las más extrañas jamás encontradas en matemáticas. Ellas reaparecen en las ramas más distantes e inconexas de las matemáticas. Una función que aparece una y otra vez en la teoría de las funciones modulares se denomina (como ya he dicho otras veces) hoy día “función de Ramanujan” en su honor. extraña función contiene un término elevado a la potencia veinticuatro.

La magia esconde una realidad

El 24 aparece repetidamente en la obra de Ramanujan. Este es un ejemplo de lo que las matemáticas llaman números mágicos, que aparecen continuamente donde menos se esperan por razones que nadie entiende. Milagrosamente, la función de Ramanujan aparece también en la teoría de cuerdas. El número 24 que aparece en la función de Ramanujan es también el origen de las cancelaciones milagrosas que se dan en la teoría de cuerdas. En la teoría de cuerdas, cada uno de los veinticuatro modos de la función de Ramanujan corresponde a una vibración física de la cuerda. Cuando quiera que la cuerda ejecuta sus movimientos complejos en el espacio-tiempo dividiéndose y recombinándose, deben satisfacerse un gran número de identidades matemáticas altamente perfeccionadas. Estas son precisamente las entidades matemáticas descubiertas por Ramanujan. Puesto que los físicos añaden dos dimensiones más cuando cuentan el número total de vibraciones que aparecen en una teoría relativista, ello significa que el espacio-tiempo debe tener 24 + 2 = 26 dimensiones espacio-temporales.

comprender este misterioso factor de dos (que añaden los físicos), consideramos un rayo de luz que tiene dos modos físicos de vibración. La luz polarizada puede vibrar, por ejemplo, o bien horizontal o bien verticalmente. Sin embargo, un campo de Maxwell relativista Aµ cuatro componentes, donde µ = 1, 2, 3, 4. Se nos permite sustraer dos de estas cuatro componentes utilizando la simetría gauge de las ecuaciones de Maxwell. Puesto que 4 – 2 = 2, los cuatro campos de Maxwell originales se han reducido a dos. Análogamente, una cuerda relativista vibra en 26 dimensiones. Sin embargo, dos de estos modos vibracionales pueden ser eliminados rompemos la simetría de la cuerda, quedándonos con 24 modos vibracionales que son las que aparecen en la función de Ramanujan.

“En matemática, la función theta de Ramanujan generaliza la forma de las funciones theta de Jacobi, a la vez que conserva sus propiedades generales. En particular, el producto triple de Jacobi se puede escribir elegantemente en términos de la función theta de Ramanujan. La función toma nombre de Srinivasa Ramanujan, y fue su última gran contribución a las matemáticas.”

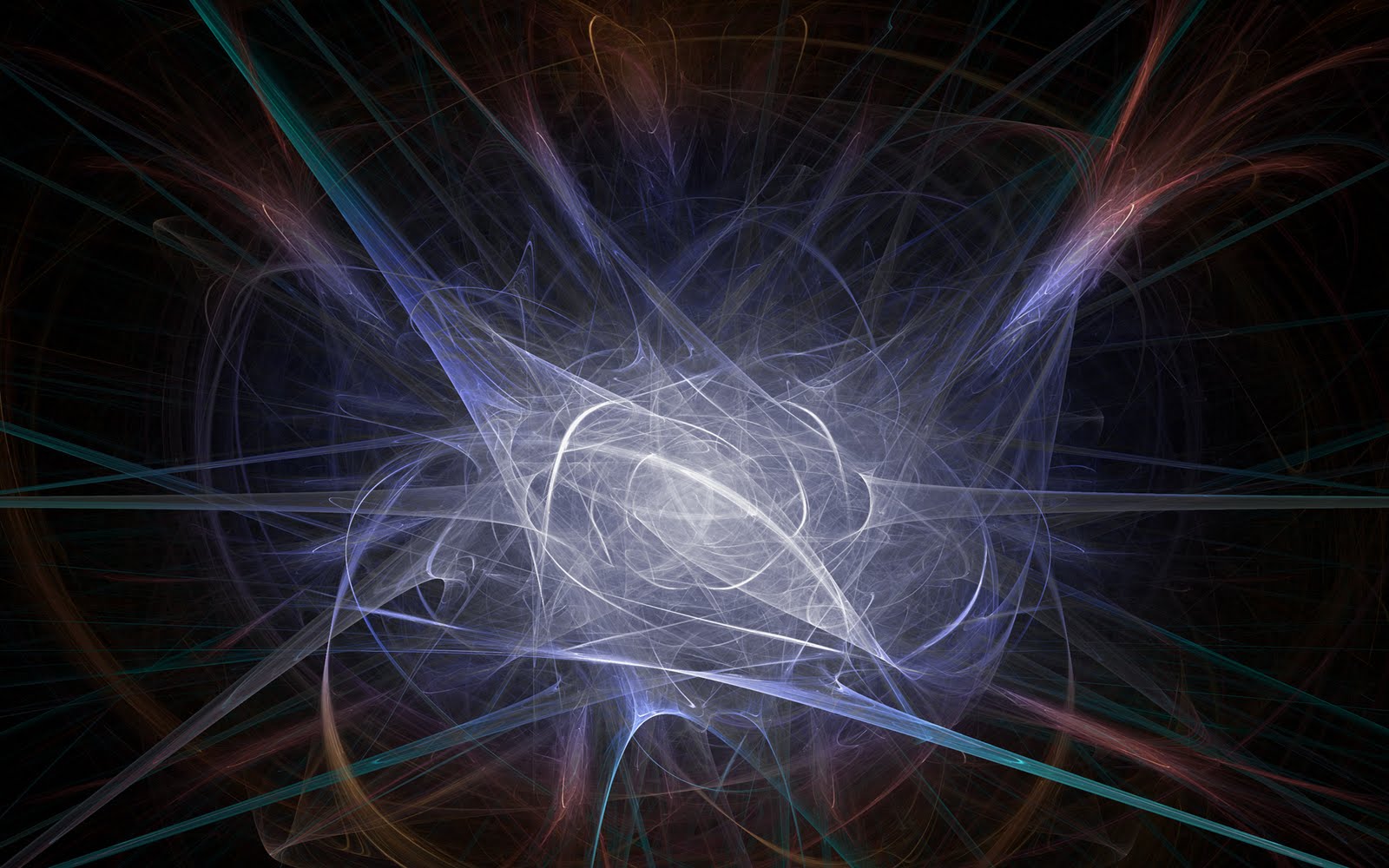

Como un revoltijo de hilos entrecruzados que son difíciles de seguir, así son las matemáticas de la teoría de cuerdas

Cuando se generaliza la función de Ramanujan, el 24 queda reemplazado por el 8. Por lo tanto, el número crítico para la supercuerda es 8+2=10. Este es el origen de la décima dimensión que exige la teoría. La cuerda vibra en diez dimensiones porque requiere estas funciones de Ramanujan generalizadas para permanecer auto consistente. Dicho de otra manera, los físicos no tienen la menor idea de por qué 10 y 26 dimensiones se seleccionan como dimensión de la cuerda. Es como si hubiera algún tipo de numerología profunda que se manifestara en estas funciones que nadie comprende. Son precisamente estos números mágicos que aparecen en las funciones modulares elípticas los que determinan que la dimensión del espacio-tiempo sea diez.

En el análisis final, el origen de la teoría deca-dimensional es tan misterioso como el propio Ramanujan. Si alguien preguntara a cualquier físico del mundo por qué la naturaleza debería existir en diez dimensiones, estaría obligado a responder “no lo sé”. Se sabe en términos difusos, por qué debe seleccionarse alguna dimensión del espacio tiempo (de lo contrario la cuerda no puede vibrar de una cuánticamente autoconsistente), pero no sabemos por qué se seleccionan estos números concretos.

Godfrey Harold Hardy

G. H. Hardy, el mentor de Ramanujan, trató de estimar la capacidad matemática que poseía Ramanujan. Concedió a David Hilbert, universalmente conocido y reconocido uno de los mayores matemáticos occidentales del siglo XIX, una puntuación de 80. A Ramanujan le asignó una puntuación de 100. Así mismo, Hardy se concedió un 25.

Por desgracia, ni Hardy ni Ramanujan parecían interesados en la psicología a los procesos de pensamiento mediante los cuales Ramanujan descubría estos increíbles teoremas, especialmente cuando diluvio material brotaba de sus sueños con semejante frecuencia. Hardy señaló:

“Parecía ridículo importunarle sobre como había descubierto o ese teorema conocido, cuando él me estaba mostrando media docena cada día, de nuevos teoremas”.

Ramanujan

Hardy recordaba vivamente:

-”Recuerdo una vez que fui a visitarle cuando estaba enfermo en Putney. Yo había tomado el taxi 1.729, y comenté que el numero me parecía bastante feo, y que esperaba que no fuese mal presagio.”

– No. -Replicó Ramanujan postrado en su cama-. Es un número muy interesante; es el número más pequeño expresable una suma de dos cubos en dos formas diferentes.

(Es la suma de 1 x 1 x 1 y 12 x 12 x 12, y la suma de 9 x 9 x 9 y 10 x 10 x 10).

Era capaz de recitar en el acto teoremas complejos de aritmética cuya demostración requeriría un ordenador moderno.

En 1.919 volvió a casa, en la India, donde un año más tarde murió enfermo.

El legado de Ramanujan es su obra, que consta de 4.000 fórmulas en cuatrocientas páginas que llenan tres volúmenes de notas, todas densamente llenas de teoremas de increíble fuerza pero sin ningún comentario o, lo que es más frustrante, sin ninguna demostración. En 1.976, sin embargo, se hizo un nuevo descubrimiento. Ciento treinta páginas de borradores, que contenían los resultados del último año de su vida, fueron descubiertas por casualidad en una caja en el Trinity Collage. Esto se conoce ahora con el de “Cuaderno Perdido” de Ramanujan.

Comentando cuaderno perdido, el matemático Richard Askey dice:

“El de este año, mientras se estaba muriendo, era el equivalente a una vida entera de un matemático muy grande”. Lo que él consiguió era increíble. Los matemáticos Jonathan Borwien y Meter Borwein, en relación a la dificultad y la ardua tarea de descifrar los cuadernos perdidos, dijeron: “Que nosotros sepamos nunca se ha intentado una redacción matemática de este alcance o dificultad”.

Por mi parte creo que, Ramanujan, fue un genio matemático muy adelantado a su tiempo y que pasaran algunos años que podamos descifrar al cien por ciento sus trabajos, especialmente, sus funciones modulares que guardan el secreto de la teoría más avanzada de la física moderna, la única capaz de unir la mecánica quántica y la Gravedad.

Fórmula de Ramanujan determinar los decimales de pi

Las matemáticas de Ramanujan son como una sinfonía, la progresión de sus ecuaciones era algo nunca vísto, él trabajaba otro nivel, los números se combinaban y fluían de su cabeza a velocidad de vértigo y con precisión nunca antes conseguida por nadie. Tenía tal intuición de las cosas que éstas simplemente fluían de su cerebro. Quizá no los veía de una manera que sea traducible y el único lenguaje eran los números.

Como saben los físicos, los “accidentes” no aparecen sin ninguna razón. Cuando están realizando un cálculo largo y difícil, y entonces resulta de repente que miles de términos indeseados suman milagrosamente cero, los físicos saben que esto no sucede sin una razón más profunda subyacente. Hoy, los físicos conocen que estos “accidentes” son una indicación de que hay una simetría en juego. Para las cuerdas, la simetría se denomina simetría conforme, la simetría de estirar y deformar la hoja del Universo de la cuerda.

Nuestro mundo asimétrico hermosas simetrías

Aquí es precisamente donde entra el trabajo de Ramanujan. Para proteger la simetría conforme original contra su destrucción por la teoría cuántica, deben ser milagrosamente satisfechas cierto de identidades matemáticas que, son precisamente las identidades de la función modular de Ramanujan. ¡Increíble! Pero, cierto.

Aunque el perfeccionamiento matemático introducido por la teoría de cuerdas ha alcanzado alturas de vértigo y ha sorprendido a los matemáticos, los críticos de la teoría aún la señalan su punto más débil. Cualquier teoría, afirman, debe ser verificable. Puesto que ninguna teoría definida a la energía de Planck de 1019 miles de millones de eV es verificable, ¡La teoría de cuerdas no es realmente una teoría!

El principal problema, es teórico más que experimental. Si fuéramos suficientemente inteligentes, podríamos resolver exactamente la teoría y encontrar la verdadera solución no perturbativa de la teoría. Sin embargo, esto no nos excusa de encontrar algún medio por el que verificar experimentalmente la teoría, debemos esperar señales de la décima dimensión.

Volviendo a Ramanujan…

Es innegable lo sorprendente de su historia, un muchacho pobre con escasa preparación y arraigado como pocos a sus creencias y tradiciones, es considerado como una de los mayores genios de las matemáticas del siglo XX. Su legado a la teoría de números, a la teoría de las funciones theta y a las series hipergeométricas, además de ser invaluable aún sigue estudiándose por muchos prominentes matemáticos de todo el mundo. Una de sus fórmulas más famosas es la que aparece más arriba en el lugar número 21 de las imágenes expuestas y utilizada para realizar aproximaciones del Pi con más de dos millones de cifras decimales. Otra de las sorprendentes fórmulas descubiertas por Ramanujan es un igualdad en que era “casi” un número entero (la diferencia era de milmillonésimas). De hecho, durante un tiempo se llegó a sospechar que el número era efectivamente entero. No lo es, pero este hallazgo sirvió de base la teoría de los “Cuasi enteros”. A veces nos tenemos que sorprender al comprobar hasta donde puede llegar la mente humana que, prácticamente de “la nada”, es capaz de sondear los misterios de la Naturaleza para dejarlos al descubierto ante nuestros asombros ojos que, se abren como platos ante tales maravillas.

Publica: emilio silvera

”Algunas personas buscan un significado a la vida a través del beneficio, a través de las relaciones personales, o a través de experiencias propias. Sin embargo, creo que el estar bendecido con el intelecto para adivinar los últimos secretos de la naturaleza da significado suficiente a la vida”.

May

14

¿La Física? ¡Una maravilla! Nos dice cómo funciona la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (1)

Comments (1)

Ylia Prigogine haciendo lo que sólo unos privilegiados pueden hacer: desvelando los principios del mundo. Enn la pizarra, la entropía. La irreversibilidad del tiempo trae el orden al caos, decía. De alguna manera pretendía explicar que nada permanece y todo cambia bajo los efectos del inexorable paso del Tiempo.

Ylia Prigogine ¡Qué personaje!

Ese misterio que llamamos “Mente”, ese algo material de una complejidad inimaginable que llamamos cerebro, ese “ingrediente” que está en nosotros y que llamamos “conciencia”. Todo eso nos lleva a la duda que siempre tenemos: ¿No llegamos a comprender los secretos del Universo, porque en última instancia, nos tendríamos que comprender nosotros? Sobre ese tema podemos decir que tenemos algunas nociones de cómo podemos Ser, sin embargo, conocernos, lo que se dice conocernos a nosotros mismos… ¡No nos conocemos!

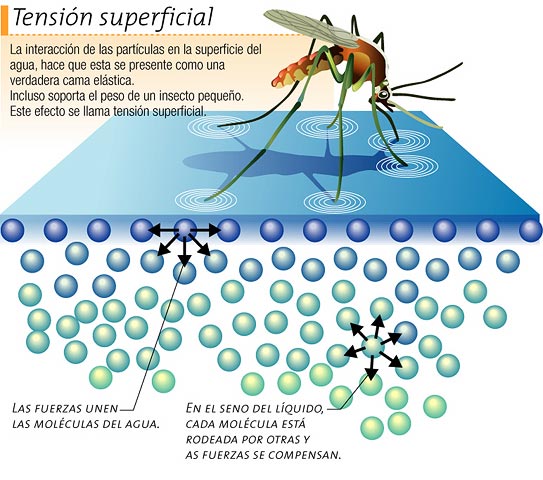

“En el mundo de los seres vivos, la escala o tamaño crea importantes diferencias. En muchos aspectos, la anatomía de un ratón es una copia de la de un elefante, pero mientras que un ratón trepar por una pared prácticamente vertical sin mucha dificultad (y se puede caer desde una altura varias veces mayor que su propio tamaño sin hacerse daño), un elefante no sería capaz de realizar tal hazaña. Con bastante generalidad se puede afirmar que los efectos de la gravedad son menos importantes cuanto menores sean los objetos que consideremos (sean vivos o inanimados).

Cuando llegamos a los seres unicelulares, se ve que ellos no hay distinción entre arriba y abajo. Para ellos, la tensión superficial del agua es mucho más importante que la fuerza de la gravedad a esa escala. Tranquilamente se pueden mover y desplazar por encima de una superficie acuática. Los pluricelulares no pueden hacer tal cosa.

La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos de Van der Waals. fuerza tiene un alcance muy corto; para ser precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente 1/r7. Esto significa que si se reduce la distancia dos átomos a la mitad de la fuerza de Van der Waals con la que se atraen uno a otro se hace 2 × 2 × 2 × 2 × 2 × 2 × 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza. El conocimiento de esta fuerza se debe a Johannes Diderik Van der Waals (1837 – 1923) con su tesis sobre la continuidad del líquido y gaseoso que le haría famoso, ya que en esa época (1873), la existencia de las moléculas y los átomos no estaba completamente aceptado.

La tensión superficial del agua, es el efecto físico (energía de atracción entre las moléculas) que “endurece” la capa superficial del agua en reposo y permite a algunos insectos, como el mosquito y otros desplazarse por la superficie del agua sin hundirse.

El famoso físico inglés James Clerk Maxwell, que formuló la teoría del electromagnetismo de Faraday, quedó muy impresionado por este de Van der Waals.

Los tamaños de los seres unicelulares, animales y vegetales, se miden en micrómetros o “micras”, donde 1 micra es 1/1.000 de milímetro, aproximadamente el tamaño de los detalles más pequeños que se pueden observar con un microscopio ordinario. El mundo de los microbios es fascinante, pero no es el objeto de este trabajo, y continuaremos el viaje emprendido las partículas elementales que forman núcleos, átomos, células y materia, así como las fuerzas que intervienen en las interacciones fundamentales del universo y que afecta a todo lo que existe.

Hemos hablado del electrón que rodea el núcleo, de su carga eléctrica negativa que complementa la positiva de los protones y hace estable al átomo; una masa de solamente 1/1.836 de la del núcleo más ligero (el del hidrógeno). La importancia del electrón es vital en el universo.

Pero busquemos los “cuantos”. La física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menor intensidad, por los objetos más fríos (radiación de cuerpo negro).

Estaba bien aceptado entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si utilizamos las leyes de la termodinámica para calcular la intensidad de una radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para longitudes mayores como para menores. Esta longitud de onda característica es inversamente proporcional a la temperatura absoluta de objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273º bajo cero). Cuando a 1.000º C un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

Radiación de Cuerpo Negro

Un cuerpo negro es un objeto teórico o ideal que absorbe toda la luz y toda la energía radiante que incide sobre él. Nada de la radiación incidente se refleja o pasa a través del cuerpo negro. A pesar de su , el cuerpo negro emite luz y constituye un modelo ideal físico para el estudio de la emisión de radiación electromagnética. El nombre Cuerpo negro fue introducido por Gustav Kirchhoff en 1862.

La luz emitida por un cuerpo negro se denomina radiación de cuerpo negro. Todo cuerpo emite energía en de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada es la temperatura del emisor. La energía radiante emitida por un cuerpo a temperatura ambiente es escasa y corresponde a longitudes de onda superiores a las de la luz visible (es decir, de menor frecuencia). Al elevar la temperatura no sólo aumenta la energía emitida sino que lo hace a longitudes de onda más cortas; a esto se debe el cambio de color de un cuerpo cuando se calienta. Los cuerpos no emiten con igual intensidad a todas las frecuencias o longitudes de onda, sino que siguen la ley de Planck.

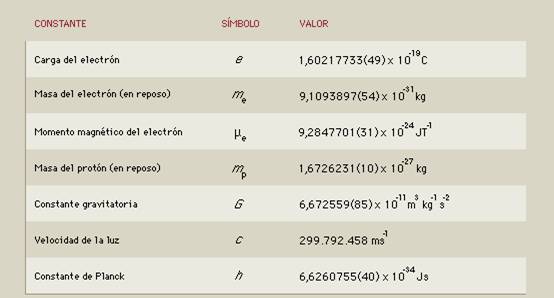

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en paquetes de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de onda, y por tanto, proporcional a la frecuencia de radiación emitida. La fórmula es E = hν, donde E es la energía del paquete, ν es la frecuencia y h es una nueva constante fundamental de la naturaleza, la constante de Planck. Cuando Planck calculó la intensidad de la radiación térmica imponiendo nueva condición, el resultado coincidió perfectamente con las observaciones.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una manera mucho más tajante: él sugirió que los objetos calientes no son los únicos que emiten radiación en paquetes de energía, sino que toda la radiación consiste en múltiplos del paquete de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene energía, sino que cualquier cosa con energía se debe comportar una “onda” que se extiende en una cierta región del espacio, y que la frecuencia ν de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilantes de campos de fuerza.

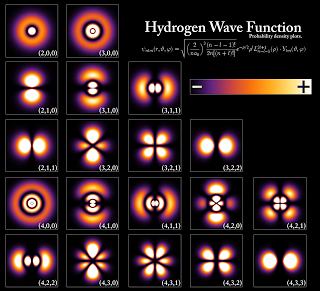

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de de Broglie. Poco después, en 1926, Edwin Schrödinger descubrió cómo escribir la teoría ondulatoria de de Broglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños quedaba exactamente determinado por las recién descubiertas “ecuaciones de ondas cuánticas”.

Está bien comprobado que la mecánica cuántica funciona de maravilla…, pero, sin embargo, surge una pregunta muy formal: ¿qué significan realmente estas ecuaciones?, ¿qué es lo que están describiendo? Isaac Newton, allá en 1867 formuló cómo debían moverse los planetas alrededor del Sol, estaba claro todo el mundo qué significaban sus ecuaciones: que los planetas estaban siempre en una posición bien definida des espacio y que sus posiciones y sus velocidades en un momento concreto determinan inequívocamente cómo evolucionarán las posiciones y las velocidades en el tiempo.

Pero los electrones todo es diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudieran “existir” en diferentes lugares simultáneamente, como si fueran una nube o una onda, y esto no es un efecto pequeño. Si se realizan experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió responder a esta pregunta de tal que con su explicación se pudo seguir trabajando, y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la interpretación de Copenhague de la mecánica cuántica.

Si la mecánica cuántica tiene cosas extrañas y el espín es una de ellas. Y si uno piensa que la intuición le ayudará a comprender todo esto, pues no lo hará, o es poco probable que lo haga. Las partículas tienen un espín fundamental. Al igual que la carga eléctrica o la masa, el espín ayuda a definir que de partícula es cada una.

Las leyes de la mecánica cuántica han sido establecidas con mucha precisión; permite cómo calcular cualquier cosa que queramos saber. Pero si queremos “interpretar” el resultado, nos encontramos con una curiosa incertidumbre fundamental: que varias propiedades de las partículas pequeñas no pueden estar bien definidas de manera simultánea. Por ejemplo, podemos determinar la velocidad de una partícula con mucha precisión, pero entonces no sabremos exactamente dónde se encuentra; o a la inversa, podemos determinar la posición con precisión, pero entonces su velocidad queda mal definida. Si una partícula tiene espín (rotación alrededor de su eje), la dirección alrededor de la cual está rotando (la orientación del eje) no puede ser definida con gran precisión.

La posición y el momento de una partícula nunca lo podremos saber con precisión ilimitada.

No es fácil explicar de forma sencilla de dónde viene esta incertidumbre, pero existen ejemplos en la vida cotidiana que tienen algo parecido. La altura de un tono y la duración en el tiempo durante el cual oímos el tono tienen una incertidumbre mutua similar. Para afinar un instrumento se debe escuchar una nota durante un cierto intervalo de tiempo y compararla, por ejemplo, con un diapasón que debe vibrar también durante un tiempo. Notas muy breves no tienen bien definido el tono.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuando más grande y más pesado es un objeto, más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica. Me gustaría referirme a exigencia tan importante y tan peculiar de la teoría con la palabra “holismo”. Esto no es exactamente lo mismo que entienden algunos filósofos por holismo, y que podría definir como “el todo es más que la suma de sus partes”. Si la física nos ha enseñado algo es justo lo contrario. Un objeto compuesto de un gran de partículas puede ser entendido exactamente si se conocen las propiedades de sus partes (partículas); basta que sepamos sumar correctamente (¡y esto no es nada fácil en mecánica cuántica!). Lo que entiendo por holismo es que, efectivamente, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck, h, que es igual a 6’626075… × 10-34 Julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

La mecánica cuántica es muy extraña a nuestro “sentido común”, sabemos que se desenvuelve en ese “universo” de lo muy pequeño, alejado de nuestra vida cotidiana en el macrocosmos tetradimensional que, no siempre coincide con lo que, en aquel otro infinitesimal acontece.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros como Erwin Schrödinger siempre presentaron serias objeciones a interpretación. Quizá funcione bien, pero ¿dónde está exactamente el electrón?, ¿en el punto x o en el punto y? En pocas palabras, ¿dónde está en realidad?, y ¿cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

Es cierto que, existe otro universo dentro de nuestro del que, aún, nos queda mucho por aprender.

La mecánica cuántica puede ser definida o resumida así: en principio, con las leyes de la naturaleza que conocemos se puede predecir el resultado de cualquier experimento, en el sentido que la predicción consiste en dos factores: el primer factor es un cálculo definido con exactitud del efecto de las fuerzas y estructuras, tan riguroso como las leyes de Isaac Newton para el movimiento de los planetas en el Sistema Solar; el segundo factor es una arbitrariedad estadística e incontrolable definida matemáticamente de estricta. Las partículas seguirán una distribución de probabilidades dadas, primero de una forma y luego de otra. Las probabilidades se pueden calcular utilizando la ecuación de Schrödinger de función de onda (Ψ) que, con muchas probabilidades nos indicará el lugar probable donde se encuentra una partícula en un dado.

Muchos estiman que esta teoría de las probabilidades desaparecerá cuando se consiga la teoría que explique, de forma completa, todas las fuerzas; la buscada teoría del todo, lo que implica que nuestra descripción actual incluye variables y fuerzas que (aún) no conocemos o no entendemos. Esta interpretación se conoce como hipótesis de las variables ocultas.”

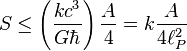

También Gerard ‘t Hooft es el autor de lo que han dado en llamar l principio holográfico es una conjetura especulativa acerca de las teorías de la Gravedad Cuántica propuesta en 1993 por este autor, y mejorada y promovida por Leonard Susskin en 1995. Postula que toda la información contenida en cierto volumen de un espacio concreto se puede conocer a partir de la información codificable sobre la frontera de dicha región. Una importante consecuencia es que la cantidad máxima de información que puede contener una determinada región de espacio rodeada por una superficie diferenciable está limitada por el área total de dicha superficie.

Por ejemplo, se pueden modelar todos los eventos que ocurran en un cuarto o una habitación creando una teoría en la que sólo tome en cuenta lo que suceda en sus paredes. En el principio holográfico también se afirma que por cada cuatro Unidades de Planck existe al menos un grado de libertad (o una unidad constante de Bolttzmann k de máxima entropía). Esto se conoce como frontera de Bekenstein:

donde S es la entropía y A es la unidad de mensura considerada. En unidades convencionales la fórmula anterior se escribe:

donde:

, es la constante de Boltzmann.

, es la constante de Boltzmann.

, es la velocidad de la luz.

, es la velocidad de la luz.

, es la constante gravitacional universal.

, es la constante gravitacional universal.

, es la constante de Planck racionalizada.

, es la constante de Planck racionalizada. , es la longitud de Planck.

, es la longitud de Planck.

Claro que esta… ¡Es otra Historia!

Emilio Silvera V-.

May

1

Todo tiene un límite. Las “Teorías” también

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

:format(jpg)/f.elconfidencial.com%2Foriginal%2Fdd9%2F7af%2F724%2Fdd97af724d3beb0d79794af2f42d5d52.jpg)

Llevamos más de cien años y, la Física, sigue dominada por dos Teorías: La Cuántica y la Relatividad

Poco a poco vamos pudiendo explicar las cosas que hoy no sabemos y, los adelantos continuados, en todas las disciplinas, del saber humano, hace posible que las teorías de hoy, no sean las del mañana, toda vez que, cuando se descubren nuevos datos y nuevos sucesos, nos hacen tomar también, caminos nuevos que nos llevan a la búsqueda de nuevas teorías. Lo cierto es que siempre andamos a vueltas con las teorías, y, tenemos que ser conscientes que las teorías tienen unos límites que están bien determinados.

Veamos:

Unas nos hablan del “universo” de lo muy pequeño y otras, del “universo” de lo muy grande, pero… ¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 centímetros, más joven que el tiempo de Planck 10ˉ⁴³ segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

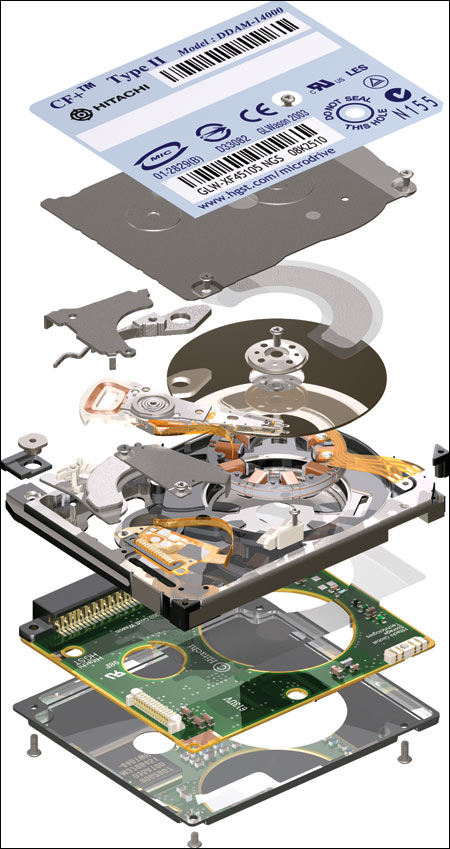

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes. Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

Los procesamiento de información vienen impuestos por las constantes de la naturaleza. Día a día la computación cuántica se va acercando a la realidad.

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos. Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora

máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora . Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

Planck

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias. Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón.

el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias. Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón.

“Tras medir alfa en unas 300 galaxias lejanas, vimos un patrón constante: este número , que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros estudios nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

, que nos dice la fuerza del electromagnetismo, no es igual en otras partes que en la Tierra, y parecer variar de forma continua a lo largo de un eje”. Algunos se empeñan en variar la constante de estructura fina y, si eso llegara a producirse… las consecuencias serían funestas para nosotros. Otros estudios nos dicen que esa constante, no ha variado a lo largo de los miles de millones de años del Universo y, así debe ser, o, si varió, lo hizo en una escala ínfima.

| α = 2πe2 / hc ≈ 1/137 |

| αG = (Gmp2)2 / hc ≈ 10-38 |

Si varían algunas de las dos en sólo una diezmillonésima, muchas de las cosas que conforman el Universo serían imposible y, la consecuencia sería, la ausencia de vida. La identificación de constantes adimensionales de la naturaleza como α (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro. Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

Cuando surgen comentarios de números puros y adimensionales, de manera automática aparece en mi mente el número 137. Ese número encierra más de lo que estamos preparados para comprender; me hace pensar y mi imaginación se desboca en múltiples ideas y teorías. Einstein era un campeón en esta clase de ejercicios mentales que él llamaba “libre invención de la mente”. El gran físico creía que no podríamos llegar a las verdades de la naturaleza sólo por la observación y la experimentación. Necesitamos crear conceptos, teorías y postulados de nuestra propia imaginación que posteriormente deben ser explorados para averiguar si existe algo de verdad en ellos.

137. Ese número encierra más de lo que estamos preparados para comprender; me hace pensar y mi imaginación se desboca en múltiples ideas y teorías. Einstein era un campeón en esta clase de ejercicios mentales que él llamaba “libre invención de la mente”. El gran físico creía que no podríamos llegar a las verdades de la naturaleza sólo por la observación y la experimentación. Necesitamos crear conceptos, teorías y postulados de nuestra propia imaginación que posteriormente deben ser explorados para averiguar si existe algo de verdad en ellos.

Para poner un ejemplo de nuestra ignorancia poco tendríamos que buscar, tenemos a mano miles de millones.

El gran físico León Lederman nos decía:

“Todos los físicos del mundo, deberían tener un letrero en el lugar más visible de sus casas, para que al mirarlo, les recordara lo que no saben. En el cartel sólo pondría esto: 137. Ciento treinta y siete es el inverso de algo que lleva el nombre

de constante de estructura fina”.

Este número guarda relación con la posibilidad de que un electrón emita un fotón o lo absorba. La constante de estructura fina responde también al nombre de “alfa” y sale de dividir el cuadrado de la carga del electrón, por el producto de la velocidad de la luz y la constante de Planck. Tanta palabrería y numerología no significan otra cosa sino que ese solo numero, 137, encierra los misterios del electromagnetismo (el electrón, e–), la relatividad (la velocidad de la luz, c), y la teoría cuántica (la constante de Planck, h).

Sus dimensiones y masa le permiten ¡lo imposible! para nosotros. La tensión superficial es una consecuencia de que todas las moléculas y los átomos se atraen unos a otros con una fuerza que nosotros llamamos fuerza de Van der Vaalls. esta fuerza tiene un alcance muy corto. para ser más precisos, diremos que la intensidad de esta fuerza a una distancia r es aproximadamente proporcional a 1/r7. Esto significa que si se reduce la distancia entre dos átomos a la mitad, la fuerza de Van der Vaalls con la que se atraen uno a otro se hace 2 x 2 x 2 x 2 x 2 x 2 x 2 = 128 veces más intensa. Cuando los átomos y las moléculas se acercan mucho unos a otros quedan unidos muy fuertemente a través de esta fuerza.

La mecánica cuántica domina en el micro-mundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Se parece más a una ola de histeria que se expande: es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

Por el contrario, la relatividad general era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros.

describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros.

Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

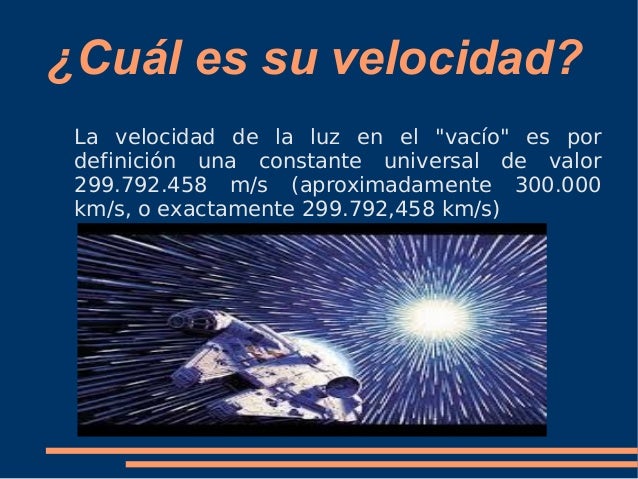

La velocidad de la luz en el vacío es por definición una constante universal de valor 299.792.458 m/s(suele aproximarse a 3·108 m/s), o lo que es lo mismo 9,46·1015 m/año; la segunda cifra es la usada para definir al intervalo llamado año luz. La información se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales. Lo cierto es que algún día nos daremos cuenta y descubriremos que la luz tiene más importancia de la que ahora le podemos dar, toda vez que no conocemos, la realidad de su naturaleza y todo lo que significa en nuestro Universo. Nosotros mismos, en última instancia… ¡Somos luz!

definir al intervalo llamado año luz. La información se transmitirá a esa velocidad como máximo, nuestro Universo, no permite mayor rapidéz, al menos, por los métodos convencionales. Lo cierto es que algún día nos daremos cuenta y descubriremos que la luz tiene más importancia de la que ahora le podemos dar, toda vez que no conocemos, la realidad de su naturaleza y todo lo que significa en nuestro Universo. Nosotros mismos, en última instancia… ¡Somos luz!

Estamos hechos de átomos y de luz

De átomos que se juntan para formar moléculas y sustancias que tienen sus origen en las estrellas, y, que por unas inexplicables transformaciones, ese conjunto evolucionada y puede llegar, a convertirse en pensamientos.

El año 2.015 fue el Año Internacional de la Luz, ese fenómeno natural del que tenemos muchos secretos que desvelar. Creo que, el día que sepamos, lo es realmente la luz,la inmensa ignorancia que llevamos acuesta, será más llevadera.

¡Sabemos aun tan poco!

emilio silvera

Abr

30

La masa y la energía ¿De donde vienen?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

No es ningún secreto que la obra más famosa de la denominada literatura árabe, Alf Laylah wa-Laylah (Las mil y una noches), era en realidad una antigua obra persa. Hazar Afsana ( un millar de cuentos), que contenía distintos relatos, muchos de los cuales eran de origen Indio. Con el paso del tiempo, se hicieron adiciones a obra, no sólo a partir de fuentes árabes, sino también griegas, hebreas, turcas y egipcias. La obra que hemos leído (casi) todos, en realidad, es un compendio de historias y cuentos de distintas nacionalidades, aunque la ambientación que conocemos, es totalmente árabe.

Los físicos que abordan el multiverso coinciden en que sería imposible visitar los universos vecinos, pero pueden estar ahí. / The Washington Post (Washington Post)

Nuestro universo, con lo inmenso que es, con centenares de miles de millones de galaxias visibles y tantos millones de estrellas en cada una de ellas, puede que no sea el único que exista. Tal vez hay otros universos, distintos del que conocemos, y alguno parecido… ¿Sería posible visitarlos? ¿Echarles un vistazo? ¿Comprobar siquiera si efectivamente están por ahí como burbujas aisladas… a no ser que entren algunas en colisión? Medio centenar de expertos estadounidenses, europeos y españoles se han reunido esta semana en un encuentro científico de alto nivel celebrado en la Universidad Autónoma de Madrid (UAM) para discutir precisamente los multiversos y las teorías en las que emerge su existencia.

En realidad, cuando observamos el Universo y vemos los fenómenos que ahí ocurren, las transiciones de fase que se producen en la materia, las energías desatadas que por todas partes son proyectadas en explosiones de supernovas y colisiones de estrellas de neutrones o agujeros negros, cuando dos inmensas galaxias se funden en una y se fusionan mediante un Vals de Gravedad que dura algunos millones de años… Cuando todo eso ocurre, podríamos pensar que, la Vida, no está preparada para ese entorno. Sin embargo, ¡aquí estamos!

Como nos dice la filosofía, nada es como se ve a primera vista, todo depende del punto de vista desde el que miremos las cosas, de la perspectiva que nos permita nuestra posición física y, la intelectual también. No todos podemos ver las cosas de la misma manera. La imagen de abajo que es una Nebulosa como otras tantas, ¿qué te dice a tí? ¿qués es lo que ahí puedes ver? ¿qué deduces de los componentes de la nebulosa? ¿qué puede surgir de ahí y de otros lugares como este de abajo? ¿Cómo llegó a formarse tal conglomerado de gas y polvo?

Richard Feynman

“Siempre me ha intrigado que, cuando se trata de aplicar las leyes tal como las entendemos actualmente, una computadora necesite hacer un número infinito de operaciones lógicas para efectuar cálculos relativos a lo que sucede en cualquier zona insignificante del tiempo. ¿Cómo puede suceder todo eso en un espacio diminuto? ¿Por qué se necesita una cantidad infinita de operaciones lógicas para averiguar lo que va a pasar en un fragmento diminuto de espacio-tiempo? A menudo he formulado la hipótesis de que en última instancia la física no necesitará una expresión matemática, ya que al fin se descubrirá la maquinaria y las leyes llegarán a ser sencillas, como un juego de ajedrez con todas sus aparentes complejidades.”

Patrón de un kilogramo

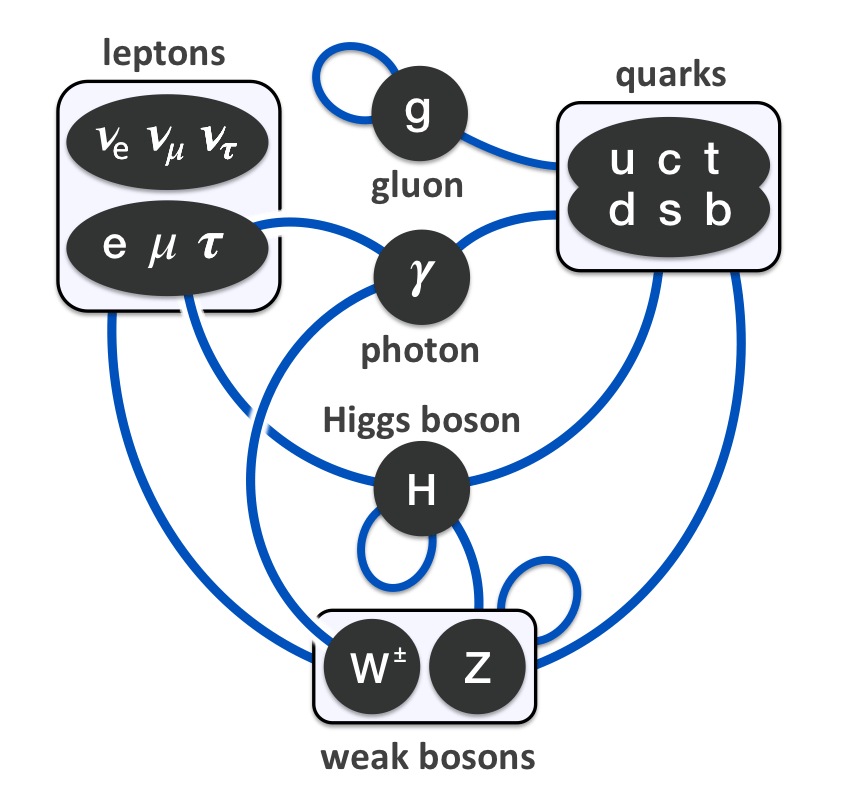

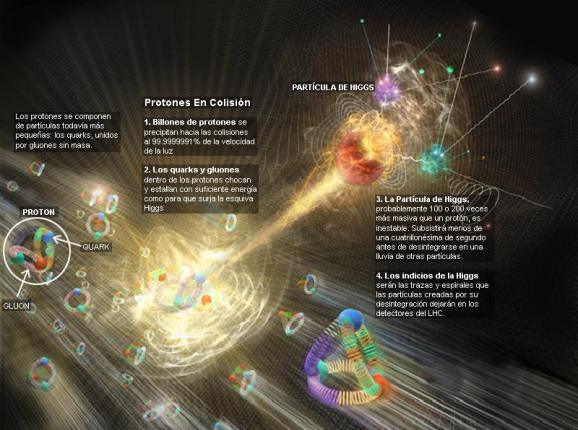

Todos los intentos y los esfuerzos por hallar una pista del cuál era el origen de la masa fallaron. Feynman escribió su famosa pregunta: “¿Por qué pesa el muón?”. , por lo menos, tenemos una respuesta parcial, en absoluto completa. Una voz potente y ¿segura? nos dice: “!Higgs¡” Durante más de 60 años los físicos experimentadores se rompieron la cabeza con el origen de la masa, y ahora el campo Higgs presenta el problema en un contexto ; no se trata sólo del muón. Proporciona, por lo menos, una fuente común todas las masas. La nueva pregunta feynmaniana podría ser: ¿Cómo determina el campo de Higgs la secuencia de masas, aparentemente sin patrón, que da a las partículas la materia?

La variación de la masa con el de movimiento, el cambio de masa con la configuración del sistema y el que algunas partículas (el fotón seguramente y los neutrinos posiblemente) tengan masa en reposo nula son tres hechos que ponen dicho que el concepto de masa sea un atributo fundamental de la materia. Habrá que recordar aquel cálculo de la masa que daba infinito y nunca pudimos resolver; los físicos sólo se deshicieron de él “renormalizándolo”, ese truco matemático que emplean cuando no saben encontrar la respuesta al problema planteado.

Ese es el problema de trasfondo con el que tenemos que encarar el problema de los quarks, los leptones y los vehículos de las fuerzas, que se diferencian por sus masas. que la historia de Higgs se tenga en pie: la masa no es una propiedad intrinseca de las partículas, sino una propiedad adquirida por la interacción de las partículas y su entorno.

La idea de que la masa no es intrinseca la carga o el espín resulta aún más plausible por la idílica idea de que todos los quarks y fotones tendrían masa cero. En ese caso, obedecerían a una simetría satisfactoria, la quiral, en laque los espines estarían asociados siempre con su dirección de movimiento. Pero ese idilio queda oculto por el fenómeno de Higgs.

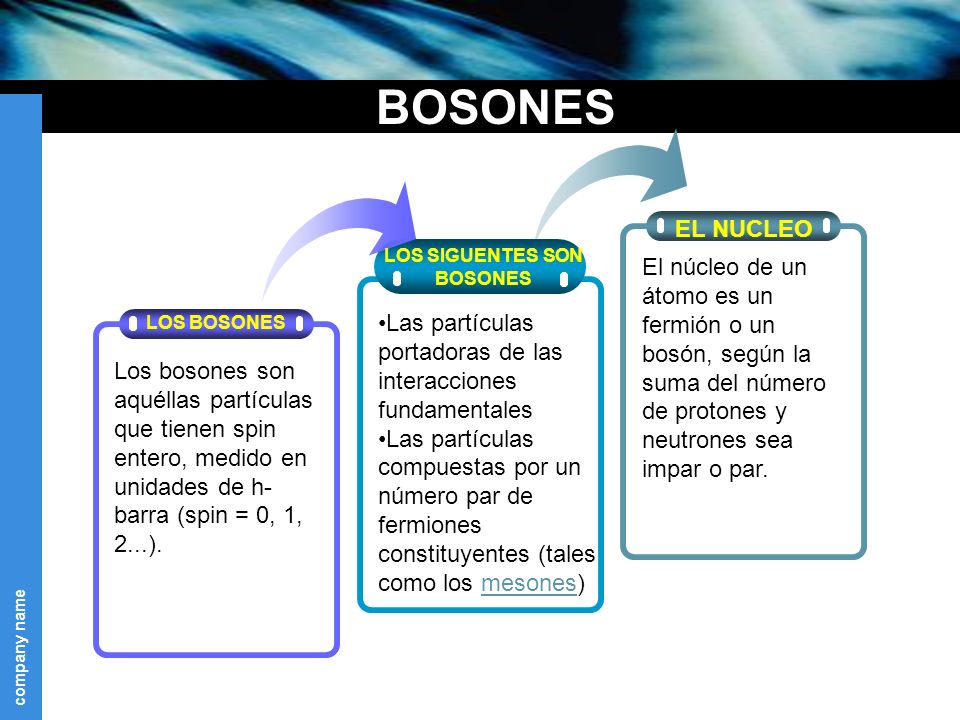

¡Ah, una cosa más! Hemos hablado de los bosones gauge y de su espín de una unidad; hemos comentado también las partículas fermiónicas de la materia (espin de media unidad). ¿Cuál es el pelaje de Higgs? Es un bosón de espin cero. El espín supone una direccionalidad en el espacio, pero el campo de Higgs da masa a los objetos dondequiera que estén y sin direccionalidad. Al Higgs se le llama a veces “bosón escalar” [sin dirección] por esa razón.

La interacción débil, recordareis, fue inventada por E. Fermi describir la desintegración radiactiva de los núcleos, que era básicamente un fenómeno de poca energía, y a medida que la teoría de Fermi se desarrolló, llegó a ser muy precisa a la hora de predecir un enorme de procesos en el dominio de energía de los 100 MeV. Así que ahora, con las nuevas tecnologías y energías del LHC, las esperanzas son enormes para, por fin, encontrar el bosón Higgs origen de la masa… y algunas cosas más.

Fabiola Gianotti, portavoz del experimento ATLAS, ofreció algunos avances:

“En nuestros observamos claros signos de una nueva partícula compatible con la teoría de Higgs, con un nivel aproximado de 5 sigma [99,977% de eficiencia], en la región de masa alrededor de los 126 GeV. El increíble rendimiento del LHC y el ATLAS y los enormes esfuerzos de mucha gente nos han traído a excitante punto, pero hace falta un poco más de tiempo para preparar estos resultados cara a su publicación.”

El Modelo Estándar describe las partículas de todo cuanto nos rodea, incluso de nosotros mismos. Toda la materia que podemos observar, sin embargo, no parece significar más que el 4% del total. Higgs podría ser el puente para comprender el 96% del universo que permanece oculto.

El 4 de julio de 2012 se anunció el descubrimiento de un bosón. Punto. En diciembre de 2012 se empezó a hablar de “un” Higgs (en lugar de “el” Higgs), pero oficialmente seguía siendo un nuevo bosón. ¿Importa el Higgs de que se trate? El Premio Nobel de Física para el bosón de Higgs sólo será concedido cuando el CERN afirme con claridad y rotundidad que se ha descubierto “el” Higgs, si el CERN es conservador, la Academia Sueca lo es aún más. Sin embargo, el rumor es que quizás baste con que el CERN diga que se ha descubierto “un” Higgs. Al final se concedió.

¿Por qué, a pesar de todas las noticias surgidas el CERN, creo que no ha llegado el momento de celebrarlo? ¿Es acaso el Higgs lo encontrado? Al menos a mí me faltan expliaciones sobre el verdadero mecanismo mediante el cual las partículas adquieren masa.

Hay que responder montones de preguntas. ¿Cuáles son las propiedades de las partículas de Higgs y, lo que es más importante, cuál es su masa? ¿Cómo reconoceremos una si nos la encontramos en una colisión de LHC? ¿Cuántos tipos hay? ¿Genera el Higgs todas las masas, o las hace incrementarse? ¿Y, cómo podemos saber más al respecto? También a los cosmólogos les fascina la idea de Higgs, pues casi se dieron de bruces con la necesidad de tener campos escalares que participasen en el complejo proceso de la expansión del Universo, añadiendo, pues, un peso más a la carga que ha de soportar el Higgs.

El campo de Higgs, tal y como se lo concibe , se puede destruir con una energía grande, o temperaturas altas. Estas generan fluctuaciones cuánticas que neutralizan el campo de Higgs. Por lo tanto, el cuadro que las partículas y la cosmología pintan juntas de un universo primitivo puso y de resplandeciente simetría es demasiado caliente Higgs. Pero cuando la temperatura cae bajo los 10’5 grados kelvin o 100 GeV, el Higgs empieza a actuar y hace su generación de masas. Así por ejemplo, de Higgs teníamos unos W, Z y fotones sin masa y la fuerza electrodébil unificada.

El Universo se expande y se enfría, y entonces viene el Higgs (que engorda los W y Z, y por alguna razón ignora el fotón) y de ello resulta que la simetría electrodébil se rompe. Tenemos entonces una interacción débil, transportada por los vehículos de la fuerza W+, W–, Z0, y por otra una interacción electromagnética, llevada por los fotones. Es como si algunas partículas del campo de Higgs fuera una especie de aceite pesado a través del que se moviera con dificultad y que las hiciera parecer que tienen mucha masa. Para otras partículas, el Higgs es el agua, y para otras, los fotones y quizá los neutrinos, es invisible.

Cada suceso, la línea del haz es el eje común de los cilindros de malla de alambre ECAL y HCAL. ¿Cuál es el mejor candidato W? el mejor candidato Z? En cada evento, ¿Dónde ocurrió la colisión y el decaimiento de las partículas producidas? Lo cierto es que, en LHC se hacen toda clase de pruebas para saber del mundo de las partículas, de dónde vienen y hacia dónde se dirigen y, el Bosón de Higgs, es una asignatura pendiente a pesar de las noticias y de los premios

De todas las maneras, es tanta la ignorancia que tenemos sobre el origen de la masa que, nos agarramos como a un clavo ardiendo el que se ahoga, en caso, a la partícula de Higgs que viene a ser una de las soluciones que le falta al Modelo Estándar para que todo encaje con la teoría.

¡Ya veremos en que termina todo esto! Y, aunque el que suena siempre es Higgs, lo cierto es que los autores de la teoría del “Bosón de Higgs”, son tres a los que se ha concedido, junto al CERN, el Premio Principe de Asturias. Peter Ware Higgs —el primero en predecir la existencia del bosón— junto a los físicos François Englert, y el belga Robert Brout—fallecido en el año 2011—.

Peter Higgs, de la Universidad de Edimburgo, introdujo la idea en la física de partículas. La utilizaron los teóricos Steven Weinberg y V. Salam, que trabajaban por separado, comprender como se convertía la unificada y simétrica fuerza electrodébil, transmitida por una feliz familia de cuatro partículas mensajeras de masa nula, en dos fuerzas muy diferentes: la QED con un fotón carente de masa y la interacción débil con sus W+, W– y Z0 de masa grande. Weinberg y Salam se apoyaron en los trabajos previos de Sheldon Glasgow, quien tras los pasos de Julian Schwinger, sabía sólo que había una teoría electrodébil unificada, coherente, pero no unió todos los detalles. Y estaban Jeffrey Goldstone y Martines Veltman y Gerard’t Hooft. También hay otras a los que había que mencionar, pero lo que siempre pasa, quedan en el olvido de manera muy injusta. Además, ¿Cuántos teóricos hacen falta para encender una bombilla?

La verdad es que, casi siempre, han hecho falta muchos. Recordemos el largo recorrido de los múltiples detalle sueltos y físicos que prepararon el terreno para que, llegara Einstein y pudiera, uniéndolo todo, exponer su teoría relativista.

Sobre la idea de Peter Higgs, Veltman, uno de sus arquitectos, dice que es una alfombra bajo la que barremos nuestra ignorancia. Glasgow es menos amable y lo llamó retrete donde echamos las incoherencias de nuestras teorías actuales. La objeción principal: que no teníamos la menor prueba experimental que parece que va asomando la cabeza en el LHC.

![]()

Esperemos que la partícula encontrada, el bosón hallado, sea en realidad el Higgs dador de masa a las demás partículas pero… ¡Cabe la posibilidad de que sólo sea el hermano menor! de la familia. El modelo estándar es lo bastante fuerte decirnos que la partícula de Higgs de menor masa (podría haber muchas) debe “pesar” de 1 TeV. ¿Por qué? Si tiene más de 1 TeV, el modelo estándar se vuelve incoherente y tenemos la crisis de la unitariedad.

Después de todo esto, tal como lo están planteando los del CERN, se llegar a la conclusión de que, el campo de Higgs, el modelo estándar y nuestra idea de cómo se hizo el Universo dependen de que se encuentre el Bosón de Higgs. Y , por fin, el mayor Acelerador del mundo, el LHC, nos dice que el Bosón ha sido encontrado y las pruebas tienen una fiabilidad enorme.

¡La confianza en nosotros mismos, no tiene límites! Pero el camino no ha sido recorrido por completo y quedan algunos tramos que tendremos que andar para poder, al fín, dar una explicación más completa, menos oscura y neblinosa que lo que hasta el momento tenemos, toda vez que, del Bosón de Higgs y de su presencia veráz, dependen algunos detalles de cierta importancia para que sean confirmados nuestros conceptos de lo que es la masa y, de paso, la materia.

¿Pasará igual con las cuerdas?

Pero volviendo al principal tema aquí tratado, ya todo eso quedó sobrepasado y el Bosón de Higgs (según nos dijeron los del CERN), ha sido descubierto para que le concedieran el Nobel de Física a Peter Ware Higgs —el primero en predecir la existencia del bosón— junto al físico François Englert. Desgraciadamente, el belga Robert Brout -también merecedor al premio- no pudo estar presente, se marchó antes de tiempo para hacerlo posible.

emilio silvera

Fuente principal: León Lederman

Abr

27

Velocidades inimaginables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (9)

Comments (9)

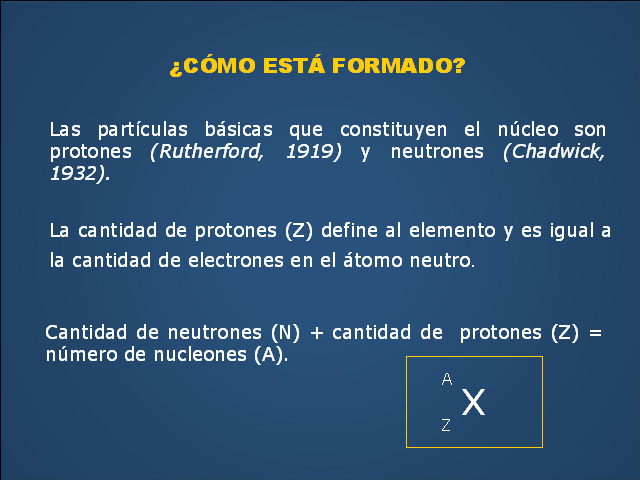

El núcleo tiene dimensiones muy reducidas. Ocupa la parte central del átomo; en él reside toda la carga positiva y casi la totalidad de la masa atómica. Está formado fundamentalmente por protones y neutrones. Los protones tienen una carga positiva cuantitativamente igual a la del electrón (1,602 x 10-19 culombios).

En el centro del átomo se encuentra un pequeño grano compacto aproximadamente 100.000 veces más pequeño que el propio átomo: el núcleo atómico. Su masa, e incluso más aún su carga eléctrica, determinan las propiedades del átomo del cual forma parte. Debido a la solidez del núcleo parece que los átomos, que dan forma a nuestro mundo cotidiano, son intercambiables entre sí, e incluso cuando interaccionan entre ellos para formar sustancias químicas (los elementos). Pero el núcleo, a pesar de ser tan sólido, puede partirse. Si dos átomos chocan uno contra el otro con gran velocidad podría suceder que los núcleos llegaran a chocar entre sí y entonces, o bien se rompen en trozos, o se funden liberando en el proceso partículas subnucleares. La nueva física de la primera mitad del siglo XX estuvo dominada por los nuevos acertijos que estas partículas planteaban.

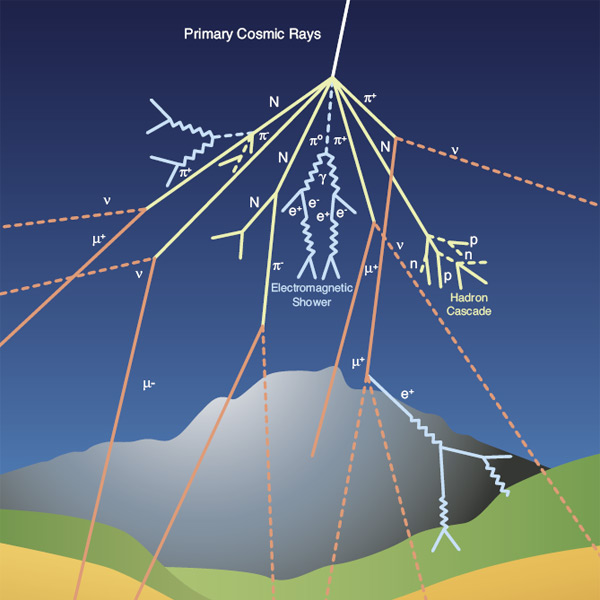

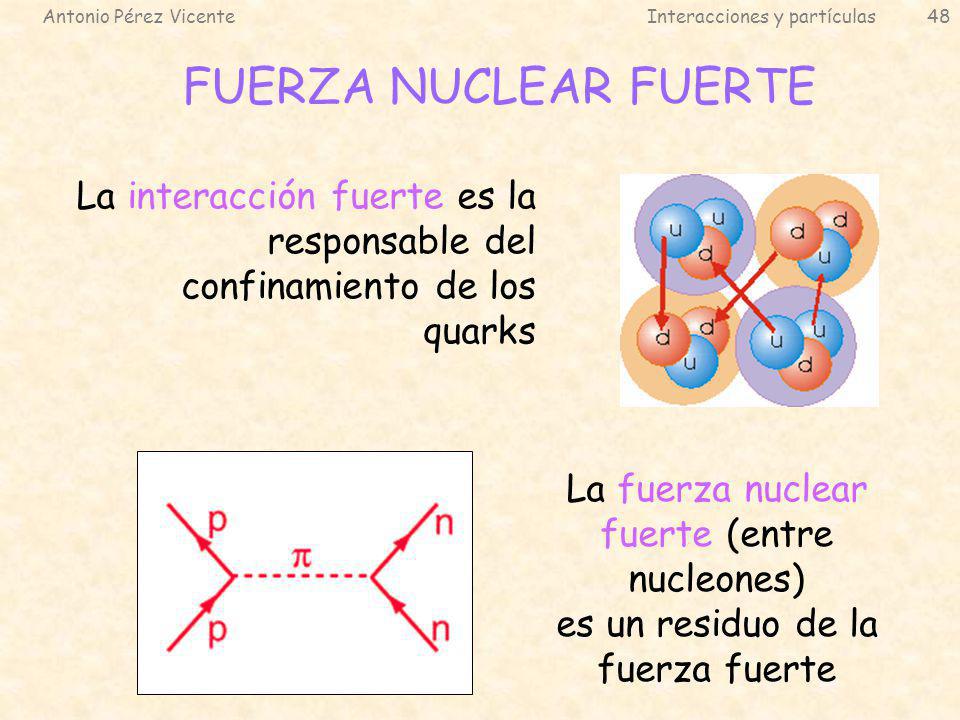

Pero tenemos la mecánica cuántica; ¿es que no es aplicable siempre?, ¿Cuál es la dificultad? Desde luego, la mecánica cuántica es válida para las partículas subatómicas, pero hay más que eso. Las fuerzas con que estas partículas interaccionan y que mantienen el núcleo atómico unido son tan fuertes que las velocidades a las que tienen que moverse dentro y fuera del núcleo están cerca de la velocidad de la luz, c, que es de 299.792’458 Km/s. Cuando tratamos con velocidades tan altas se necesita una segunda modificación a las leyes de la física del siglo XIX; tenemos que contar con la teoría de la relatividad especial de Einstein.

Esta teoría también fue el resultado de una publicación de Einstein de 1905. en esta teoría quedaron sentadas las bases de que el movimiento y el reposo son conceptos relativos, no son absolutos, como tampoco habrá un sistema de referencia absoluto con respecto al cual uno pueda medir la velocidad de la luz.

Pero había más cosas que tenían que ser relativas. En este teoría, la masa y la energía también dependen de la velocidad, como lo hacen la intensidad del campo eléctrico y del magnético. Einstein descubrió que la masa de una partícula es siempre proporcional a la energía que contienen, supuesto que se haya tenido en cuenta una gran cantidad de energía en reposo de una partícula cualquiera, como se denota a continuación:

E =mc2 La ecuación nos dice que masa y energía son la misma cosa.

Como la velocidad de la luz es muy grande, esta ecuación sugiere que cada partícula debe almacenar una cantidad enorme de energía, y en parte esta predicción fue la que hizo que la teoría de la relatividad tuviese tanta importancia para la física (¡y para todo el mundo!). Para que la teoría de la relatividad también sea autoconsistente tiene que ser holista, esto es, que todas las cosas y todo el mundo obedezcan a las leyes de la relatividad. No son sólo los relojes los que se atrasan a grandes velocidades, sino que todos los procesos animados se comportan de la forma tan inusual que describe esta teoría cuando nos acercamos a la velocidad de la luz. El corazón humano es simplemente un reloj biológico y latirá a una velocidad menor cuando viaje en un vehículo espacial a velocidades cercanas a la de la luz. Este extraño fenómeno conduce a lo que se conoce como la “paradoja de los gemelos”, sugerida por Einstein, en la que dos gemelos idénticos tienen diferente edad cuando se reencuentran después de que uno haya permanecido en la Tierra mientras que el otro ha viajado a velocidades relativistas.

Einstein comprendió rápidamente que las leyes de la gravedad también tendrían que ser modificadas para que cumplieran el principio relativista.

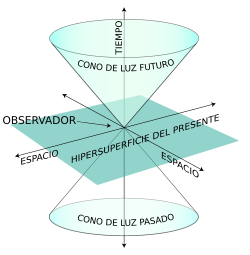

La formulación de newton es bien conocida, en la segunda imagen que se representan en este esquema dos partículas que se acercan entre sí siguiendo un movimiento acelerado. La interpretación newtoniana supone que el espacio-tiempo es llano y que lo que provoca la curvatura de las líneas de universo es la fuerza de interacción gravitatoria entre ambas partículas. Por el contrario, la interpretación einsteiniana supone que las líneas de universo de estas partículas son geodésicas (“rectas”), y que es la propia curvatura del espacio tiempo lo que provoca su aproximación progresiva.

Para poder aplicar el principio de la relatividad a la fuerza gravitatoria, el principio tuvo que ser extendido de la siguiente manera: no sólo debe ser imposible determinar la velocidad absoluta del laboratorio, sino que también es imposible distinguir los cambios de velocidad de los efectos de una fuerza gravitatoria.

Einstein comprendió que la consecuencia de esto era que la gravedad hace al espacio-tiempo lo que la humedad a una hoja de papel: deformar la superficie con desigualdades que no se pueden eliminar. Hoy en día se conocen muy bien las matemáticas de los espacios curvos, pero en el época de Einstein el uso de estas nociones matemáticas tan abstractas para formular leyes físicas era algo completamente nuevo, y le llevó varios años encontrar la herramienta matemática adecuada para formular su teoría general de la relatividad que describe cómo se curva el espacio en presencia de grandes masas como planetas y estrellas.

Einstein tenía la idea en su mente desde 1907 (la relatividad especial la formuló en 1905), y se pasó 8 años buscando las matemáticas adecuadas para su formulación.

Leyendo el material enviado por un amigo al que pidió ayuda, Einstein quedó paralizado. Ante él, en la primera página de una conferencia dada ante el Sindicato de Carpinteros, 60 años antes por un tal Riemann, tenía la solución a sus desvelos: el tensor métrico de Riemann, que le permitiría utilizar una geometría espacial de los espacios curvos que explicaba su relatividad general.

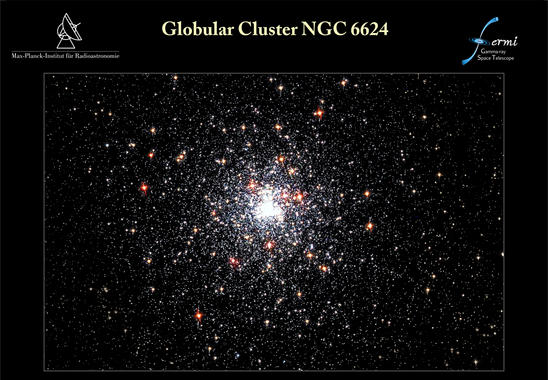

Desde que se puso en órbita el telescopio espacial de rayos gamma Fermi, el 11 de junio de 2008, ha detectado poblaciones enteras de objetos nunca antes vistos. El último hallazgo de Fermi afecta al púlsar J1823-3021A, avistado en 1994 con el radiotelescopio Lovell, en Inglaterra. Un equipo internacional de expertos se ha dado cuenta de que esta estrella pulsante emite rayos gamma y gracias a Fermi ha podido caracterizar sus inusuales propiedades. Los resultados de su investigación se publican en el último número de Science. Lo cierto es que han descubierto el púlsar de milisegundos más joven y con la fuerza magnética más potente

No está mal que en este punto recordemos la fuerza magnética y gravitatoria que nos puede ayudar a comprender mejor el comportamiento de las partículas subatómicas.

El electromagnetismo, decíamos al principio, es la fuerza con la cual dos partículas cargadas eléctricamente se repelen (si sus cargas son iguales) o se atraen (si tienen cargas de signo opuesto).

La interacción magnética es la fuerza que experimenta una partícula eléctricamente cargada que se mueve a través de un campo magnético. Las partículas cargadas en movimiento generan un campo magnético como, por ejemplo, los electrones que fluyen a través de las espiras de una bobina.

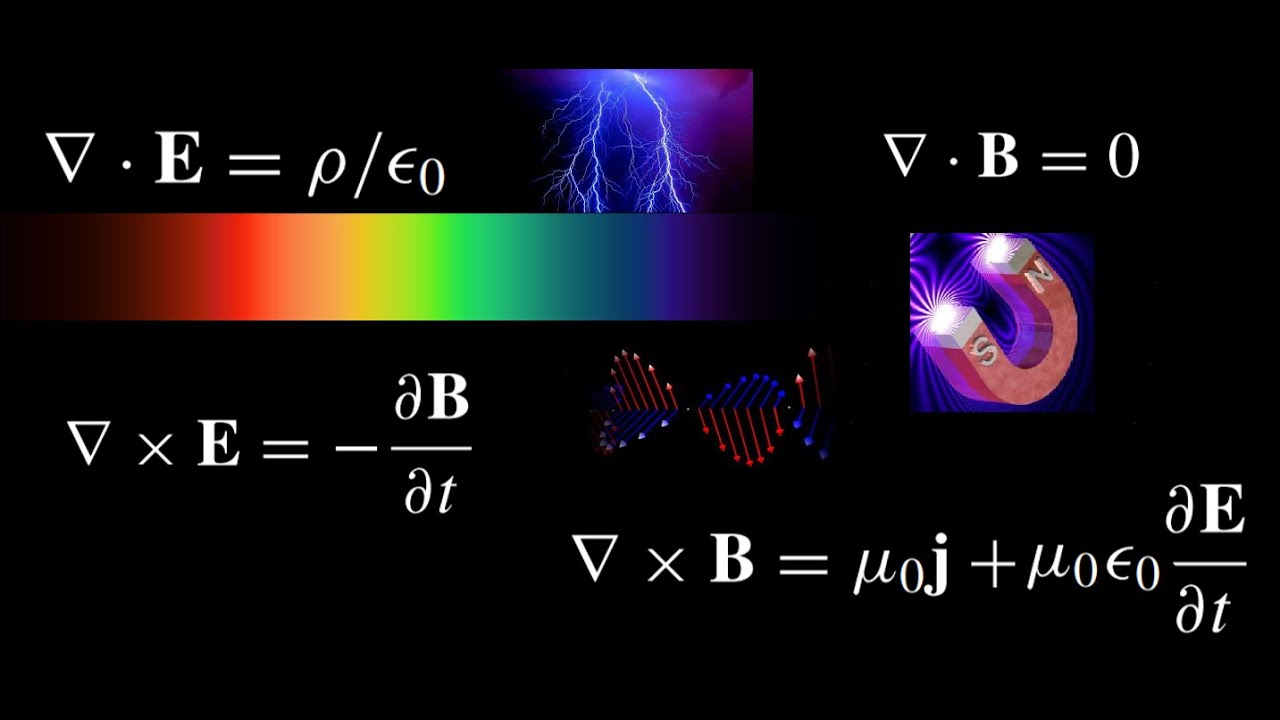

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

También antes hemos comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el nombre de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.