Feb

2

Hoy un sueño ¿Realidad mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

Playa dorada al atardecer

Selva tropical

El inmenso desierto y sus dunas

legará un día en el que, podremos entrar en un inmenso espacio, una enorme habitación, en la que, previa elección de la programación adecuada, todo se transformará en un “mundo ficticio”, un holograma que, lo mismo podrá ser una playa luminosa con arena dorada por el Sol que, una Selva tropical o un desierto, dependiendo de los gustos del usuario.

Si repasamos la historia de la ciencia, seguramente encontraremos muchos motivos para el optimismo. Witten (el Físico de la Teoría M), está convencido de que la ciencia será algún día capaz de sondear hasta las energías de Planck. Como ya he referido en otras ocasiones, él dijo:

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles. En el siglo XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible. Si usted hubiera dicho a un físico del siglo XIX que hacia el siglo XX sería capaz de calcularlo, le habría parecido un cuento de hadas… La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante 25 años.”

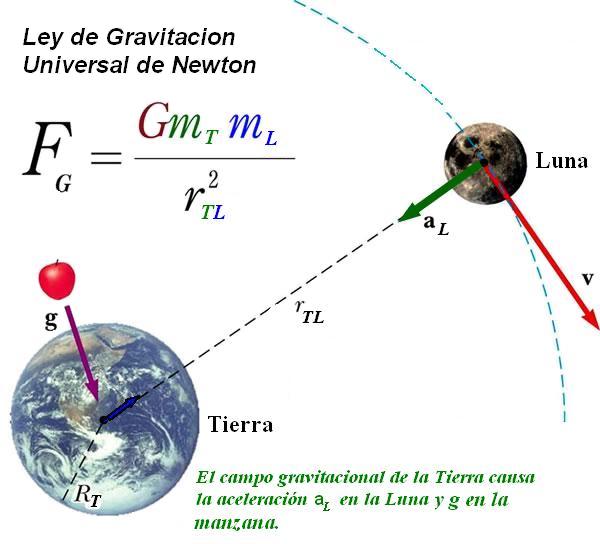

En su opinión, las buenas ideas siempre se verifican. Los ejemplos son innumerables: la gravedad de Newton, el campo eléctrico de Faraday y el electromagnetismo de Maxwell, la teoría de la relatividad de Einstein en sus dos versiones y su demostración del efecto fotoeléctrico, la teoría del electrón de Paul Dirac, el principio de incertidumbre de Heisenberg, la función de ondas de Schrödinger, y tantos otros. Algunos de los físicos teóricos más famosos, sin embargo, protestaban de tanto empeño en la experimentación. El astrónomo arthur Eddington se cuestionaba incluso si los científicos no estaban forzando las cosas cuando insistían en que todo debería ser verificado. ¡Cómo cambia todo con el Tiempo! Hasta la manera de pensar.

Sin embargo, muchos son los ejemplos de un ingenio superior que nos llevaron a desvelar secretos de la Naturaleza que estaban profundamente escondidos, y, el trabajo de Dirac en relación al electrón, es una buena muestra de ese ingenio humano que, de vez en cuando vemos florecer.

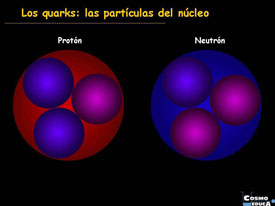

Ya que la ecuación de Dirac fue originalmente formulada para describir el electrón, las referencias se harán respecto a “electrones”, aunque actualmente la ecuación se aplica a otros tipos de partículas elementales de espín ½, como los quarks. Una ecuación modificada de Dirac puede emplearse para describir de forma aproximada los protones y los neutrones, formados ambos por partículas más pequeñas llamadas quarks (por este hecho, a protones y neutrones no se les da la consideración de partículas elementales).

La ecuación de Dirac presenta la siguiente forma:

Siendo m la masa en reposo del electrón, c la velocidad de la luz, p el operador de momento,  la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vectorque cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

la constante reducida de Planck, x y t las coordenadas del espacio y el tiempo, respectivamente; y ψ (x, t) una función de onda de cuatro componentes. La función de onda ha de ser formulada como un espinor (objeto matemático similar a un vectorque cambia de signo con una rotación de 2π descubierto por Pauli y Dirac) de cuatro componentes, y no como un simple escalar, debido a los requerimientos de la relatividad especial. Los α son operadores lineales que gobiernan la función de onda, escritos como una matriz y son matrices de 4×4 conocidas como matrices de Dirac.

:quality(75)/cloudfront-us-east-1.images.arcpublishing.com/elcomercio/NWWCZA763FBS3N7H45WIQBANVQ.jpg)

El premio Nobel Paul Dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años, «Es sólo el optimista el que consigue algo en este mundo».“

Yo, como todos ustedes, un hombre normal y corriente de la calle, escucho a unos y a otros, después pienso en lo que dicen y en los argumentos y motivaciones que les han llevado a sus respectivos convencimientos, y finalmente, también decido según mis propios criterios mi opinión, que no obligatoriamente coincidirá con alguna de esas opiniones, y que en algún caso, hasta me permito emitirla.

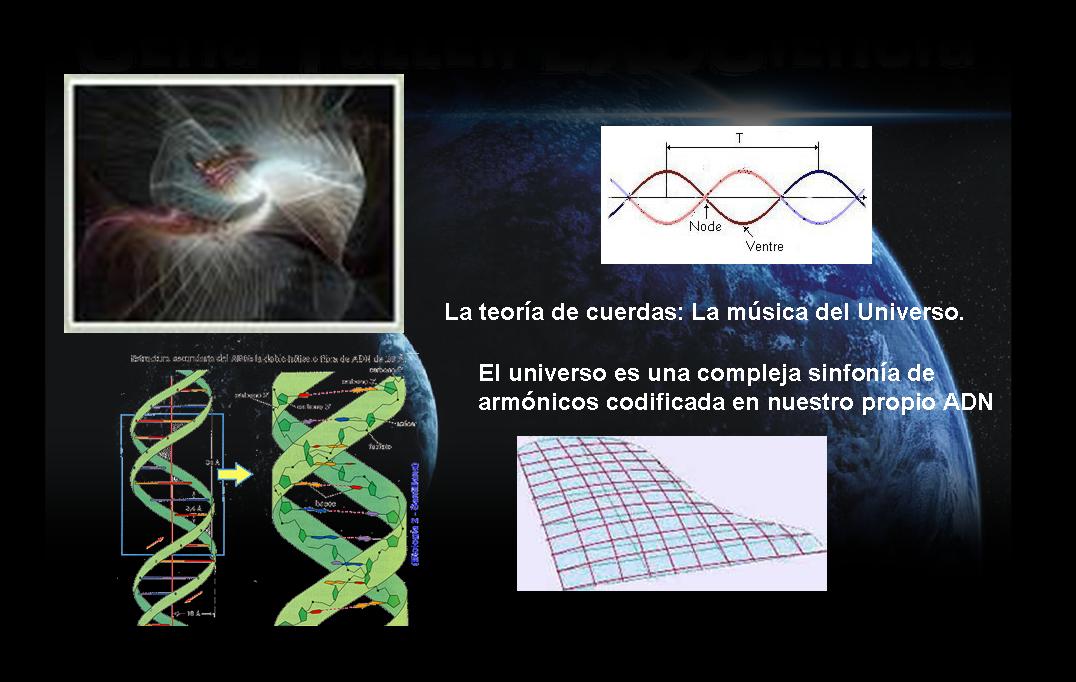

¿No es curioso que, cuando se formula la moderna Teoría M, surjan, como por encanto, las ecuaciones de Einstein de la Relatividad General? Nadie las llama y, sin embargo, allí aparecen para decirnos que, la Teoría de cuerdas es un buen camino a seguir, ya que, si en ella subyacen las ecuaciones de Einstein de la relatividad General… ¡No debe ser por casualidad!

Suponiendo que algún físico brillante nos resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro universo, con un poco de suerte, podría ocurrir en este mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas es naturalmente una teoría de la creación.

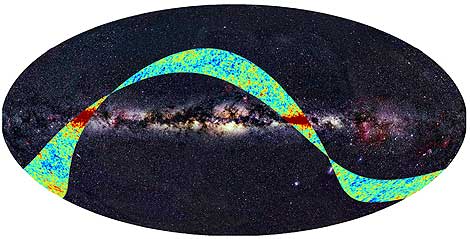

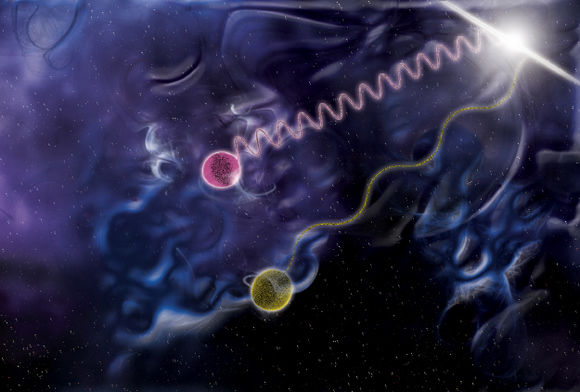

Las primeras observaciones realizadas por Planck | ESA y Axel Mellinger

La sonda WMAP | NASA

La sonda WMAP | NASA

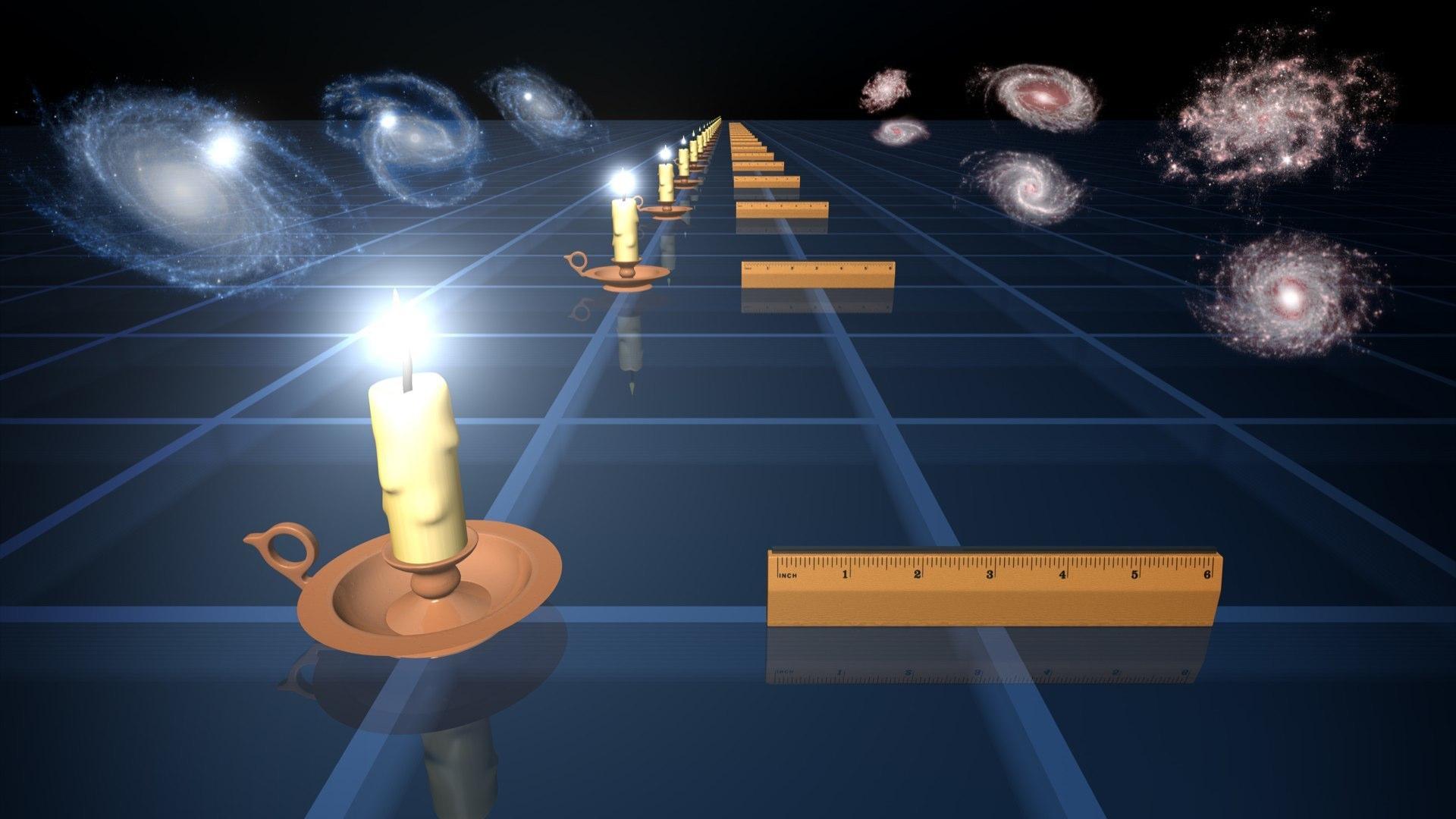

Al COBE le sucedió un telescopio de mayor precisión, el WMAP, que fue lanzado por la NASA desde Cabo Cañaveral en 2001. Los nuevos datos han ido refinando cada más las características del modelo estándar de nuestro universo. WMAP no sólo cartografió las irregularidades del fondo cósmico con un detalle muy fino, sino que estimó la edad del universo en 13,7 miles de millones de años, con una precisión del orden del 1 %.

Fuimos capaces de predecir que el Big Bang produjo un “eco” cósmico reverberando en el universo y que podría ser mesurable por los instrumentos adecuados. De hecho, Arno Penzias y Robert Wilson de los Bell Telephone Laboratories ganaron el premio Nobel en 1.978 por detectar este eco del Big Bang, una radiación de microondas que impregna el universo conocido. El que el eco del Big Bang debería estar circulando por el universo miles de millones de años después del suceso fue predicho por primera vez por George Gamow y sus discípulos Ralpher y Robert Herman, pero nadie les tomó en serio. La propia idea de medir el eco de la creación parecía extravagante cuando la propusieron por primera vez poco después de la segunda guerra mundial. Su lógica, sin embargo, era aplastante.

La estufa básica es la resistencia por hilo enrollado. Ésta se llega a poner al rojo vivo, por lo que emite también algo de calor por radiación.

Cualquier objeto, cuando se calienta, emite radiación de forma gradual. Ésta es la razón de que el hierro se ponga al rojo vivo cuando se calienta en un horno, y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

Esta radiación, cómo no, ha sido aprovechada por los ejércitos, que mediante visores nocturnos pueden operar en la oscuridad. De noche, los objetos relativamente calientes, tales como soldados enemigos o los carros de combate, pueden estar ocultos en la oscuridad, pero continúan emitiendo radiación de cuerpo negro invisible en forma de radiación infrarroja, que puede ser captada por gafas especiales de infrarrojo. Ésta es también la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura.

Análogamente, la radiación de cuerpo negro produce el efecto invernadero. Al igual que el vidrio, los altos niveles de dióxido de carbono en la atmósfera, causados por la combustión sin control de combustibles fósiles, pueden atrapar la radiación de cuerpo negro infrarroja en la Tierra, y de este modo calentar gradualmente el planeta.

Gamow razonó que el Big Bang era inicialmente muy caliente, y que por lo tanto sería un cuerpo negro ideal emisor de radiación. Aunque la tecnología de los años cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

Ya la lista de ingenios es larga. Todos quieren medir la radiación del fondo de microondas generadas por el Big Bang. Incluso hemos preparado telescopios especiales para que nos puedan captar las ondas gravitatorias surgidas en aquellos primeros momento de la inflación.

La lógica que había detrás de su razonamiento era la siguiente: alrededor de 300.000 años después del Big Bang, el universo se enfrió hasta el punto en el que los átomos pudieron empezar a componerse; los electrones pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento, el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

Pasados 300.000 años, la radiación no era tan potente; se había enfriado y por lo tanto la luz podía atravesar grades distancias sin ser dispersada. En otras palabras, el universo se hizo repentinamente negro y transparente.

Terminaré esta parte comentando que un auténtico cuerpo negro es un concepto imaginario; un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica.

La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

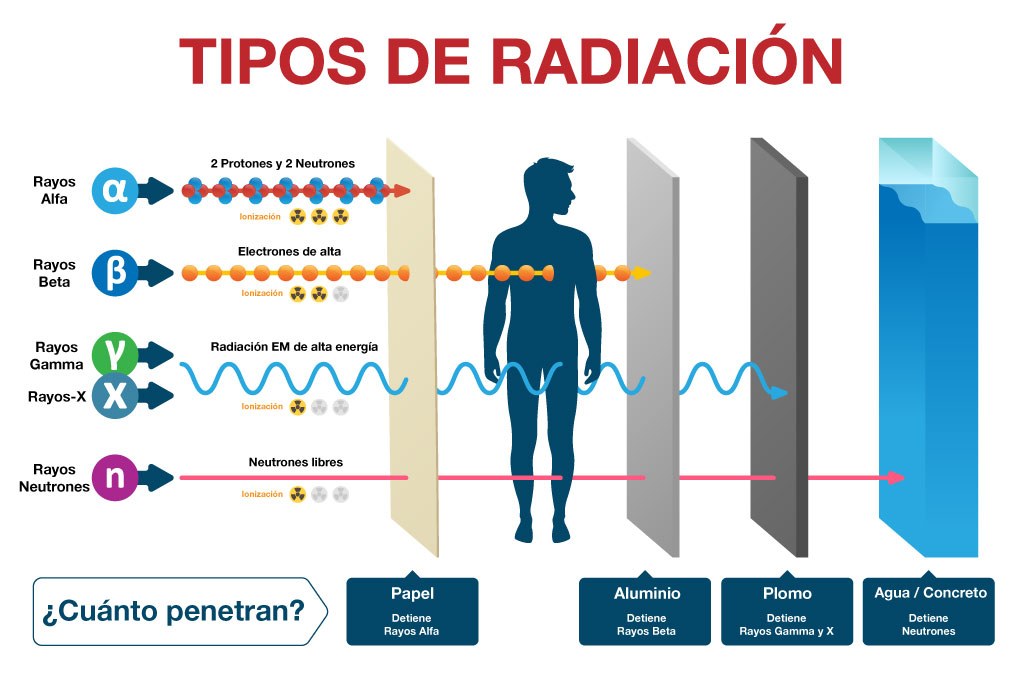

Hablar, sin más especificaciones, de radiación, es estar refiriéndonos a una energía que viaja en forma de ondas electromagnéticas o fotones por el universo. También nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

La radiación actínida es la electromagnética que es capaz de iniciar una reacción química. El término es usado especialmente para la radiación ultravioleta y también para denotar radiación que podría afectar a las emulsiones fotográficas.

La radiación gamma es un tipo de radiación electromagnética producida generalmente por elementos radioactivos o procesos subatómicos como la aniquilación de un par positrón-electrón. Este tipo de radiación de tal magnitud también es producida en fenómenos astrofísicos de gran violencia.

Debido a las altas energías que poseen, los rayos gamma constituyen un tipo de radiación ionizante capaz de penetrar en la materia más profundamente que la radiación alfa o beta. Dada su alta energía pueden causar grave daño al núcleo de las células, por lo que son usados para esterilizar equipos médicos y alimentos.

La Radiación expone un amplio abanico dependiendo de la fuente: blanda, radiación cósmica, radiación de calor, radiación de fondo, de fondo de microondas, radiación dura, electromagnética, radiación gamma, infrarroja, ionizante, monocromática, policromática, de sincrotrón, ultravioleta, de la teoría cuántica, de radiactividad… y, como se puede ver, la radiación en sus diversas formas es un universo en sí misma.

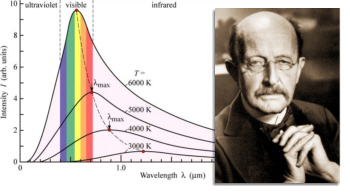

La ley de Planck describe la radiación electromagnética emitida por un cuerpo negro en equilibrio térmico en una temperatura definida. Se trata de un resultado pionero de la física moderna y la teoría cuántica. Ley de Planck para cuerpos a diferentes temperaturas.

Siempre me llamó la atención y se ganó mi admiración el físico alemán Max Planck (1.858 – 1.947), responsable entre otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

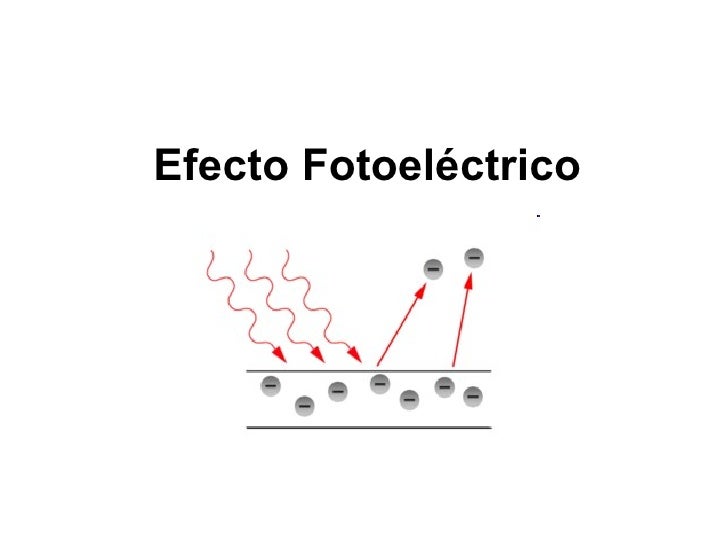

Einstein se inspiró en este trabajo para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre: Em = hf – Φ.

Cada metal requiere, para que se produzca la extracción, una radiación con una frecuencia mínima (no). Cualquier otra radiación de menor frecuencia, no será capaz de arrancar electrones. Por debajo de la frecuencia mínima la intensidad de corriente -”i” (amperios)- será cero. No hay efecto fotoeléctrico.

Planck publicó en 1.900 un artículo sobre la radiación de cuerpo negro que sentó las bases para la teoría de la mecánica cuántica que más tarde desarrollaron otros, como el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feynmann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

1. vale 10-35 metros. Esta escala de longitud (veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m) es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

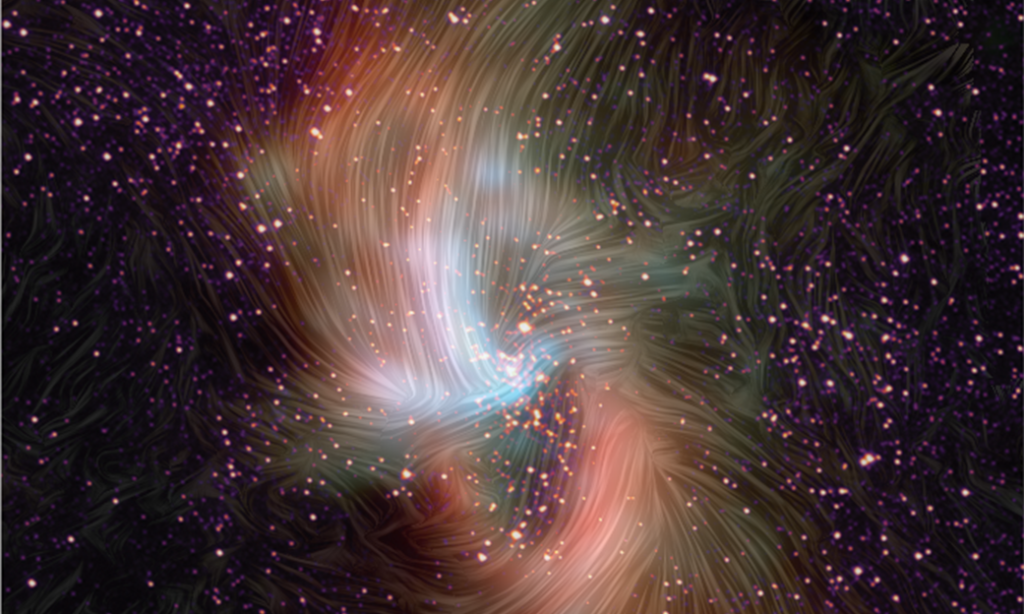

2. . Es la masa de una partícula cuya longitud de onda Compton es igual a la longitud de Planck. En la ecuación, ħ es la constante de Planck racionalizada, c es la velocidad de la luz y G es la constante gravitacional. Así, Se denomina masa de Planck a la cantidad de masa (21,7644 microgramos) que, incluida en una esfera cuyo radio fuera igual a la longitud de Planck, generaría una densidad del orden de 1093 g/cm³. Según la física actual, esta habría sido la densidad del Universo cuando tenía unos  segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planc se denota:

segundos, el llamado Tiempo de Planck. Su ecuación, es decir la masa de Planc se denota:

El valor de la masa de Planck  se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

se expresa por una fórmula que combina tres constantes fundamentales, la constante de Planck, (h), la velocidad de la luz (c), y la constante de gravitación universal (G). La masa de Planck es una estimación de la masa del agujero negro primordial menos masivo, y resulta de calcular el límite donde entran en conflicto la descripción clásica y la descripción cuántica de la gravedad.

“Aunque todas estas descripciones reflejan más una abundante imaginación que un hecho existencial apoyado teóricamente con alguna hipótesis que pueda ser comprobada en el laboratorio sobre hechos que están más allá de poder ser medidos jamás en algún laboratorio construido por humanos. La única forma de confrontar la factibilidad o la posibilidad del modelo de la espuma cuántica nos lleva necesariamente a confrontar la carencia de un modelo que logre unificar exitosamente al macrocosmos con el microcosmos, a la Relatividad General con la Mecánica Cuántica, la Gravedad Cuántica. Si la energía y la materia (o mejor dicho la masa-energía) están discretizadas, se supone que también deben de estarlo el espacio y el tiempo (o mejor dicho, el espacio-tiempo), y la “partícula fundamental” del espacio-tiempo debe de serlo el gravitón, aunque de momento todo esto son especulaciones que seguirán siéndolo mientras no tengamos a la mano algo que pueda confirmar la existencia de tan exótica partícula, quizá la más exótica de cuantas hayan sido concebidas por la imaginación del hombre.”

La descripción de una partícula elemental de esta masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 103 GeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas. Únicamente en un laboratorio aparecieron partículas que tenían energías del orden de la masa de Planck: en el universo primitivo, de acuerdo con la teoría del Big Bang, motivo éste por el que es necesaria una teoría cuántica de la gravedad para estudiar aquellas condiciones. Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

Siempre, desde que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos. Muchos han sido los velos que hemos podido descorrer para que, la luz cegadora del saber pudiera entrar en nuestras mentes para hacerlas comprender cómo actuaba la Naturaleza en ciertas ocasiones y el por qué de tales comportamientos, y, sin embargo, a pesar del largo camino recorrido, es mucho más el que nos queda por andar.

emilio silvera

Ene

20

¡Conocer la Naturaleza! Hoy sólo un sueño ¿Realidad mañana?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

“A partir de sus principios en Sumeria alrededor del 3500 a. C., en Mesopotamia, los pueblos del norte comenzaron a intentar registrar la observación del mundo con datos cuantitativos y numéricos sumamente cuidados. Pero sus observaciones y medidas aparentemente fueron tomadas con otros propósitos más que la ley científica. Un caso concreto es el del teorema de Pitágoras, que fue registrado, aparentemente en el siglo XVIII a. C.: la tabla mesopotámica Plimpton 322 registra un número de trillizos pitagóricos (3,4,5) (5,12,13)…., datado en el 1900 a. C., posiblemente milenios antes de Pitágoras,1 pero no era una formulación abstracta del teorema de Pitágoras.

cuantitativos y numéricos sumamente cuidados. Pero sus observaciones y medidas aparentemente fueron tomadas con otros propósitos más que la ley científica. Un caso concreto es el del teorema de Pitágoras, que fue registrado, aparentemente en el siglo XVIII a. C.: la tabla mesopotámica Plimpton 322 registra un número de trillizos pitagóricos (3,4,5) (5,12,13)…., datado en el 1900 a. C., posiblemente milenios antes de Pitágoras,1 pero no era una formulación abstracta del teorema de Pitágoras.

Los avances significativos en el Antiguo Egipto son referentes a la astronomía, a las matemáticas y a la medicina.2 Su geometría era una consecuencia necesaria de la topografía, con el fin de intentar conservar la disposición y la propiedad de las tierras de labranza, que fueron inundadas cada año por el Nilo. La regla del triángulo rectángulo y otras reglas básicas sirvieron para representar estructuras rectilíneas, el pilar principal de la arquitectura dintelada egipcia. Egipto era también

año por el Nilo. La regla del triángulo rectángulo y otras reglas básicas sirvieron para representar estructuras rectilíneas, el pilar principal de la arquitectura dintelada egipcia. Egipto era también el centro de la química y la investigación para la mayor parte

el centro de la química y la investigación para la mayor parte del Mediterráneo.”

del Mediterráneo.”

Isabel Pérez Arellano y Róbinson Torres Villa, publicaron un artículo en 2009, sobre la física moderna y sus paradigmas y, comenzaban diciendo:

“Desde

siempre el hombre ha intentado dar respuesta a los interrogantes más profundos que lo inquietan; preguntas que van desde ¿Quién soy?, ¿de dónde vengo? ¿y hacia dónde voy?, hasta

los intentos por explicar el origen y final universo en qué vive. Muchas son las prepuestas que se han dado a esos interrogantes, dependiendo de la corriente de pensamiento seguida por quien aborda esas preguntas; es así como se ven aproximaciones místicas, esotéricas, religiosas y científicas entre otras; pero todas con el objetivo de dilucidar alguna respuesta a esas preguntas fundamentales.

Desde el punto de vista científico y concretamente de la física moderna, se han planteado algunas explicaciones del universo en el que vivimos que algunas veces rozan con lo fantástico, dado el nivel de abstracción o especulación que llevan implícito, todo obviamente avalado por sofisticados modelos matemáticos que al parecer soportan las hipótesis planteadas.”

Si repasamos la historia de la ciencia, seguramente encontraremos muchos motivos para el optimismo. Por mencionar a un científico de nuestro tiempo, escojamos a E. Witten que está convencido de que la ciencia será algún día capaz de sondear hasta las energías de Planck. Como ya he contado en otras ocasiones, él dijo:

las energías de Planck. Como ya he contado en otras ocasiones, él dijo:

“No siempre es tan fácil decir cuáles son las preguntas fáciles y cuáles las difíciles. En el siglo XIX, la pregunta de por qué el agua hierve a 100 grados era desesperadamente inaccesible. Si usted hubiera dicho a un físico del siglo XIX que hacia el siglo XX sería capaz de calcularlo, le habría parecido un cuento de hadas… La teoría cuántica de campos es tan difícil que nadie la creyó completamente durante

25 años.”

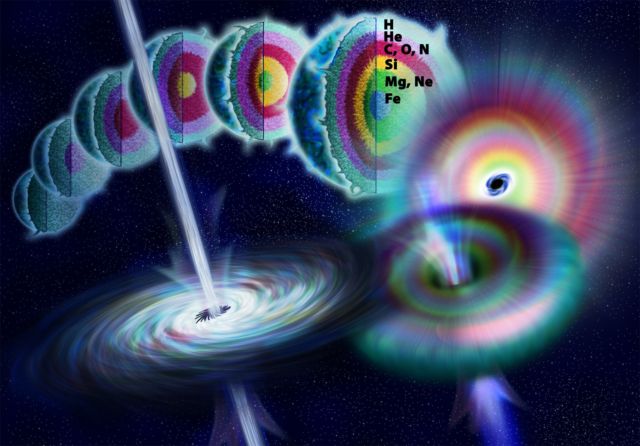

Dos maravillas de la Mente Humana

En su opinión, las buenas ideas siempre se verifican. Los ejemplos son innumerables: la gravedad de Newton, el campo eléctrico de Faraday y el electromagnetismo de Maxwell, la teoría de la relatividad de Einstein en sus dos versiones y su demostración del efecto fotoeléctrico, la teoría del electrón de Paul Dirac, el principio de incertidumbre de Heisenberg, la función de ondas de Schrödinger, y tantos otros. Algunos de los físicos teóricos más famosos, sin embargo, protestaban de tanto empeño en la experimentación.

Arthur Eddington es famoso por su trabajo relacionado con la Teoría de la Relatividad. Eddington escribió un artículo en 1919- Report on the relativity theory of gravitation (Informe sobre la teoría relativista de la gravitación), que transmitió la Teoría de la Relatividad de Einstein al mundo anglosajón. Debido a la Primera Guerra Mundial, los avances científicos alemanes no eran muy conocidos en Gran Bretaña.

Demostró que la energía en el interior de las estrellas era transportada por radiación y convección. Estos trabajos quedaron plasmados en el libro The Internal Constitution of the Stars (1926). Era un gran científico y se hizo amigo de Einstein desde que comprobó que éste llevaba razón en sus predicciones cuando comprobó que la luz se curva en presencia de grandes masas, como consecuencia de un eclipose solar.

Arthur Eddington se cuestionaba incluso si los científicos no estaban forzando las cosas cuando insistían en que todo debería ser verificado. El premio Nobel Paul dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años

insistían en que todo debería ser verificado. El premio Nobel Paul dirac incluso llegó a decir de forma más categórica: “Es más importante tener belleza en las ecuaciones que tener experimentos que se ajusten a ellas“, o en palabras del físico John Ellis del CERN, “Como decía en una envoltura de caramelos que abrí hace algunos años , «Es sólo el optimista el que consigue algo en este mundo».“

, «Es sólo el optimista el que consigue algo en este mundo».“

Yo, como todos ustedes, un hombre normal y corriente de la calle, escucho a unos y a otros, después pienso en lo que dicen y en los argumentos y motivaciones que les han llevado a sus respectivos convencimientos, y finalmente, también decido según mis propios criterios y emito mi opinión de cómo es el mundo que, no obligatoriamente, coincidirá con alguna de esas opiniones, y que en algún caso, hasta difieren radicalmente.

decido según mis propios criterios y emito mi opinión de cómo es el mundo que, no obligatoriamente, coincidirá con alguna de esas opiniones, y que en algún caso, hasta difieren radicalmente.

Suponiendo que algún físico brillante nos resuelva la teoría de campos de cuerdas y derive las propiedades conocidas de nuestro universo, con un poco de suerte, podría ocurrir en este mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando

mismo siglo, lo que no estaría nada mal considerando las dificultades de la empresa. El problema fundamental es que estamos obligando a la teoría de supercuerdas a responder preguntas sobre energías cotidianas, cuando su “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas tiene

su “ámbito natural” está en la energía de Planck. Esta fabulosa energía fue liberada sólo en el propio instante de la creación, lo que quiere decir que la teoría de supercuerdas tiene su explicación allí, en aquel lugar y tiempo donde se produjeron las mayores energías conocidas en nuestro Universo y que, nosotros, no podemos alcanzar -de momento-.

su explicación allí, en aquel lugar y tiempo donde se produjeron las mayores energías conocidas en nuestro Universo y que, nosotros, no podemos alcanzar -de momento-.

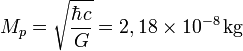

Fuimos capaces de predecir que el Big Bang produjo un “eco” cósmico reverberando en el universo y que podría ser mesurable por los instrumentos adecuados. De hecho, Arno Penzias y Robert Wilson de los Bell Telephone Laboratories ganaron el premio Nobel en 1.978 por detectar este eco del Big Bang, una radiación de microondas que impregna el universo conocido.

eco del Big Bang, una radiación de microondas que impregna el universo conocido.

Como una onda, podemos detectar el eco del big bang

una onda, podemos detectar el eco del big bang

El que el eco del Big Bang debería estar circulando por el universo miles de millones de años después del suceso fue predicho por primera vez por George Gamow y sus discípulos Ralpher y Robert Herman, pero nadie les tomó en serio. La propia idea de medir el eco de la creación parecía extravagante cuando la propusieron por primera vez poco después de la segunda guerra mundial. Su lógica, sin embargo, era aplastante. Cualquier objeto, cuando se calienta, emite radiación de forma gradual. Ésta es la razón de que el hierro se ponga al rojo vivo cuando se calienta en un horno , y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

, y cuanto más se calienta, mayor es la frecuencia de radiación que emite. Una fórmula matemática exacta, la ley de Stefan-Boltzmann, relaciona la frecuencia de la luz (o el color en este caso) con la temperatura. De hecho, así es como los científicos determinan la temperatura de la superficie de una estrella lejana; examinando su color. Esta radiación se denomina radiación de cuerpo negro.

Podemos ver en plena oscuridad

Esta radiación, ¡cómo no!, ha sido aprovechada por los ejércitos, que mediante visores nocturnos pueden operar en la oscuridad. De noche, los objetos relativamente calientes, tales como soldados enemigos o los carros de combate, pueden estar ocultos en la oscuridad, pero continúan emitiendo radiación de cuerpo negro invisible en forma de radiación infrarroja, que puede ser captada por gafas especiales de infrarrojo. Ésta es también la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura y, cuando regresamos para proseguir el camino… ¿quién es el guapo que entra?

la razón de que nuestros automóviles cerrados se calientes en verano, ya que la luz del Sol atraviesa los cristales del coche y calienta el interior. A medida que se calienta, empieza a emitir radiación de cuerpo negro en forma de radiación infrarroja. Sin embargo, esta clase de radiación no atraviesa muy bien el vidrio, y por lo tanto queda atrapada en el interior del automóvil, incrementando espectacularmente la temperatura y, cuando regresamos para proseguir el camino… ¿quién es el guapo que entra?

Todo cuerpo emite energía en forma de ondas electromagnéticas, siendo esta radiación, que se emite incluso en el vacío, tanto más intensa cuando más elevada …

Análogamente, la radiación de cuerpo negro produce el efecto invernadero. Al igual que el vidrio, los altos niveles de dióxido de carbono en la atmósfera, causados por la combustión sin control de combustibles fósiles, pueden atrapar la radiación de cuerpo negro infrarroja en la Tierra, y de este modo calentar gradualmente el planeta.

Gamow razonó que el Big Bang era inicialmente muy caliente, y que por lo tanto sería un cuerpo negro ideal emisor de radiación. Aunque la tecnología de los años cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

cuarenta era demasiado primitiva para captar esta débil señal de la creación, Gamow pudo calcular la temperatura de dicha radiación y predecir con fiabilidad que un día nuestros instrumentos serían lo suficientemente sensibles como para detectar esta radiación “fósil”.

La lógica que había detrás de su razonamiento era la siguiente: alrededor de 300.000 años después del Big Bang, el universo se enfrió hasta el punto en el que los átomos pudieron empezar a componerse; los electrones, entonces, pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento

el punto en el que los átomos pudieron empezar a componerse; los electrones, entonces, pudieron empezar a rodear a los protones y neutrones formando átomos estables, que ya no serían destruidos por la intensa radiación que estaba impregnando todo el universo. Antes de este momento , el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

, el universo estaba tan caliente que los átomos eran inmediatamente descompuestos por esa radiación tan potente en el mismo acto de su formación. Esto significa que el universo era opaco, como una niebla espesa absorbente e impenetrable.

Pasados 300.000 años, la radiación no era tan potente; se había enfriado y por lo tanto la luz podía atravesar grades distancias sin ser dispersada. En otras palabras, el universo se hizo repentinamente negro y transparente.

Terminaré esta parte comentando que un auténtico cuerpo negro es un concepto imaginario; un pequeño agujero en la pared de un recinto a temperatura uniforme es la mejor aproximación que se puede tener de él en la práctica. La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

es la mejor aproximación que se puede tener de él en la práctica. La radiación de cuerpo negro es la radiación electromagnética emitida por un cuerpo negro. Se extiende sobre todo el rango de longitudes de onda y la disminución de energías sobre este rango tiene una forma característica con un máximo en una cierta longitud de onda, desplazándose a longitudes de onda más cortas al aumentar las temperaturas*.

Hablar, sin más especificaciones, de radiación, es estar refiriéndonos a una energía que viaja en forma de ondas electromagnéticas o fotones por el universo. También

de ondas electromagnéticas o fotones por el universo. También nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

nos podríamos estar refiriendo a un chorro de partículas, especialmente partículas alfa o beta de una fuente radiactiva o neutrones de un reactor nuclear.

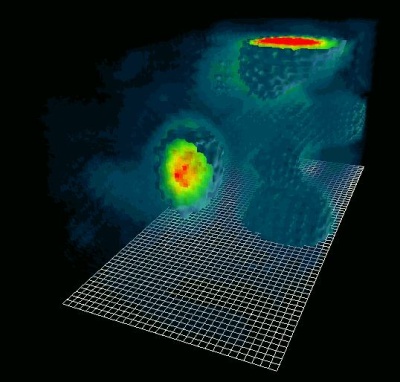

Radiación y magnetismo presentes en todas partes, No se ve pero… ¡Ahí está!

La radiación actínida es la electromagnética que es capaz de iniciar una reacción química. El término es usado especialmente para la radiación ultravioleta que emiten las estrellas jóvenes y azuladas en las bellas nebulosas.

la radiación ultravioleta que emiten las estrellas jóvenes y azuladas en las bellas nebulosas.

Muchos son los tipos conpocidos: Radiación blanda, radiación cósmica, radiación de calor, radiación de fondo, de fondo de microondas, radiación dura, electromagnética, radiación gamma, infrarroja, ionizante, monocromática, policromática, de sincrotón, ultravioleta, de la teoría cuántica, de radiactividad… y, como se puede ver, la radiación en sus diversas formas es un universo en sí misma.

se puede ver, la radiación en sus diversas formas es un universo en sí misma.

El físico alemán Max Planck (1.858 – 1.947), responsable entre otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

otros muchos logros de la ley de radiación de Planck, que da la distribución de energía radiada por un cuerpo negro. Introdujo en física el concepto novedoso de que la energía es una cantidad que es radiada por un cuerpo en pequeños paquetes discretos, en vez de una emisión continua. Estos pequeños paquetes se conocieron como cuantos y la ley formulada es la base de la teoría cuántica.

Einstein se inspiró en este trabajo para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre

para a su vez presentar el suyo propio sobre el efecto fotoeléctrico, donde la energía máxima cinética del fotoelectrón, Em, está dada por la ecuación que lleva su nombre : Em = hf – Φ.

: Em = hf – Φ.

Planck publicó en 1.900 un artículo sobre la radiación de cuerpo negro que sentó las bases para la teoría de la mecánica cuántica que más tarde desarrollaron otros, como el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

el mismo Einstein, Heisenberg, Schrödinger, Dirac, Feymann, etc. Todos los físicos son conocedores de la enorme contribución que Max Planck hizo en física: la constante de Planck, radiación de Planck, longitud de Planck, unidades de Planck, etc. Es posible que sea el físico de la historia que más veces ha dado su nombre a conceptos de física. Pongamos un par te ejemplos de su ingenio:

1. Esta escala de longitud ( 10-35 m ) veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m, es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta

escala de longitud ( 10-35 m ) veinte órdenes de magnitud menor que el tamaño del protón, de 10-15 m, es a la que la descripción clásica de gravedad cesa de ser válida y debe ser tenida en cuenta la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

la mecánica cuántica. En la fórmula que la describe, G es la constante gravitacional, ħ es la constante de Planck racionalizada y c en la velocidad de la luz.

2. Es la masa de una partícula cuya longitud de onda Compton es igual a la longitud de Planck. En la ecuación, ħ es la constante de Planck racionalizada, c es la velocidad de la luz y G es la constante gravitacional.

La descripción de una partícula elemental de esta masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como

masa, o partículas que interaccionan con energías por partículas equivalentes a ellas (a través de E = mc2), requiere de una teoría cuántica de la gravedad. Como la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 14 TeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas.

la masa de Planck es del orden de 10-8 Kg (equivalente a una energía de 1019 GeV) y, por ejemplo, la masa del protón es del orden de 10-27 Kg y las mayores energías alcanzables en los aceleradores de partículas actuales son del orden de 14 TeV, los efectos de gravitación cuántica no aparecen en los laboratorios de física de partículas.

Únicamente en un laboratorio aparecieron partículas que tenían energías del orden de la masa de Planck: en el universo primitivo, de acuerdo con la teoría del Big Bang, motivo éste por el que es necesaria una teoría cuántica de la gravedad para estudiar aquellas condiciones . Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para

. Esta energía de la que estamos hablando, del orden de 1019 GeV (inalcanzable para nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

nosotros), es la que necesitamos para verificar la teoría de supercuerdas.

Siempre, desde que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos.

que puedo recordar, me llamó la atención los misterios y secretos encerrados en la naturaleza, y la innegable batalla mantenida a lo largo de la historia por los científicos para descubrirlos.

emilio silvera

Ene

18

Buscando los secretos de la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

Hay que reconocer que algunas imágenes captadas por los telescopios son asombrosas

Las fuerzas fundamentales

|

Tipo de Fuerza |

Alcance en m |

Fuerza relativa |

Función |

|

Nuclear fuerte |

<3×10-15 |

1041 |

Une Protones y Neutrones en el núcleo atómico por medio de Gluones. |

|

Nuclear débil |

< 10-15 |

1028 |

Es responsable de la energía radiactivaproducida de manera natural.Portadoras W y Z– |

|

Electromagnetismo |

Infinito |

1039 |

Une los átomos para formar moléculas; propaga la luz y las ondas de radio y otras formas de energías eléctricas y magnéticas por medio de los fotones. |

|

Gravitación |

Infinito |

1 |

Mantiene unidos los planetas del Sistema Solar, las estrellas en las galaxias y, nuestros pies pegados a la superficie de la Tierra. La transporta el gravitón. |

Ene

14

¡El Universo! Esa Historia Interminable

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

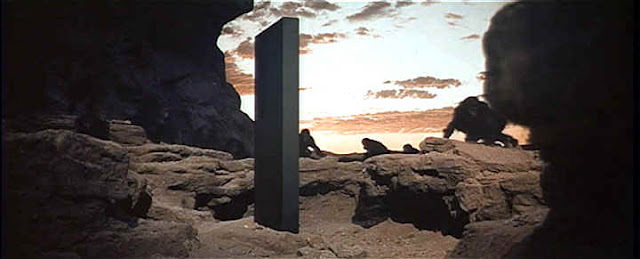

Algunas escenas de 2001 Una Odisea del Espacio, son inolvidables

Quizás lo más recordado de esta película sea su banda sonora, donde aparece esa magnífica composición titulada Así habló Zaratustra de Richard Strauss. Los acordes rotundos se van escuchando mientras un supuesto precursor del homo sapiens aprende a manejar un hueso, golpeándolo violentamente contra otros huesos esparcidos por el suelo. Entre tanto, la escena está siendo contemplada por un misterioso monolito que ha venido de no se sabe dónde y que se convierte después en el núcleo de la película.

El monolito negro y enigmático aparece en ese momento en que comienza el despertar de la raza humana. Resulta ser una especie de guía, un instructor, un objeto cuya presencia es el punto de partida del desarrollo del hombre. No se sabe quién lo colocó allí, pero evidentemente se trata de una inteligencia superior que quiere que el ser humano evolucione, y que en esas épocas de fragilidad para la especie humana viene a ayudar en el desarrollo de destrezas inteligentes que permitirán a los homínidos tomar ventaja frente al ecosistema y las demás especies competidoras.

Desde entonces, desde que esta posible escena fue el presente de la Tierra, los movimientos de los cuerpos celestes se han registrado, anotado y comentados en una variedad infinita de maneras, pero la serie continua de observaciones astronómicas ha sido consecuente a través de las distintas culturas que, siempre buscaban el por qué de las cosas y, debido a ello, un día se preguntaron quiénes eran y qué hacían aquí.

Pero, por su curiosidad, volvamos al monolito que aquellos monos miraban asombrados sin llegar a comprender su significado:

Una curiosa, y quizás poco importante, característica del bloque, había provocado discusiones interminables. El monolito tenía 11 pies de alto, y 1¼ por 5 pies en su sección transversal. Cuando sus dimensiones se midieron con gran cuidado, se descubrió que estaban en la proporción exacta 1 – 4 – 9, los cuadrados de los tres primeros números enteros. Nadie podía sugerir ninguna explicación convincente para esto, pero difícilmente podía ser una coincidencia, porque las proporciones se mantenían hasta los límites de la precisión de las medidas. Era humillante pensar que toda la tecnología terrestre no era capaz de dar forma a un bloque, aunque fuera inerte, de ningún material, con tan fantástico grado de precisión. A su forma, esta pasiva pero casi arrogante muestra de perfección geométrica era tan impresionante como cualquiera de los demás atributos del monolito.

Así, pues, cada uno de los bloques es un ortoedro perfecto con unas dimensiones exactas. Si consideramos el ancho como 1 unidad, el largo serían 4 unidades y el alto 9 unidades, es decir, sus dimensiones son proporcionales a los números 1, 4 y 9.

Ene

11

Las simetrías biológicas del Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

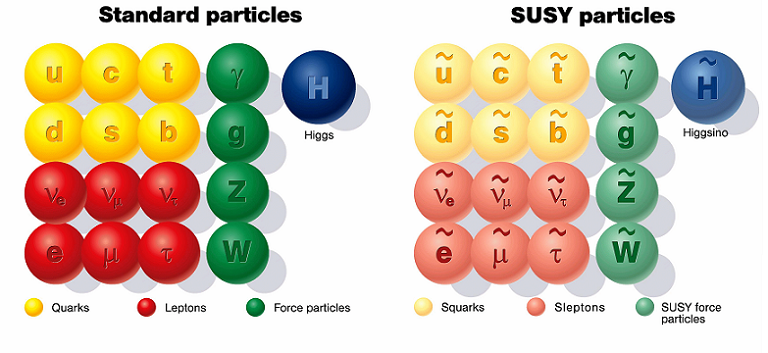

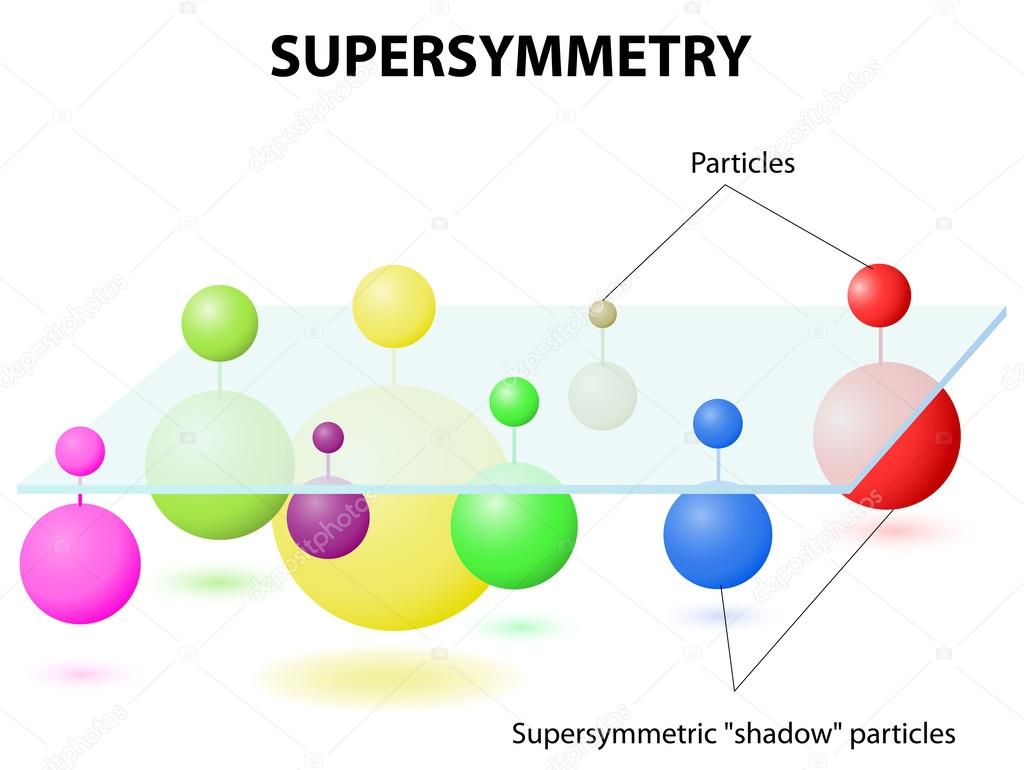

En cualquier sitio que miremos nos dirán que la supersimetría en la física de partículas es: Una simetría hipotética propuesta que relacionaría las propiedades de los Bosones y los Fermiones. Aunque todavía no se ha verificado experimentalmente que la supersimetría sea una simetría de la naturaleza, es parte fundamental de muchos modelos teóricos, incluyendo la teoría de supercuerdas. La super-simetría La también es conocida por el acrónimo inglés SUSY.

La Supersimetría tiene unas matemáticas muy bellas y por esa razón los artículos sobre el tema están llenos de ellas. Como ha sucedido antes, por ejemplo, cuando se propuso la teoría de Yang – Mills, tenemos un esquema matemático brillante que aún no sabemos como encajar en el conjunto de las leyes naturales. No tiene ningún sentido, todavía, pero esperamos que lo tenga en un tiempo futuro.

Hay otro escenario mucho más atractivo para nuestra imaginación. Hemos podido ver que los átomos están formados por pequeños constituyentes, los fotones, neutrones y electrones. Luego descubrimos que esos constituyentes, a su vez, tienen una subestructura: están formados de quarks y gluones. ¿Por qué, como probablemente hayas pensado tú antes, el proceso no continúa así? Quizñá esos Quarks y Gluones, e igualmente los electrones y todas las demás partículas aún llamadas “elementales” en el Modelo Estándar, estén también construidas de unos granos de materia aún menores y, finalmente, toda esa materia, si seguimos profundizando, nos daría la sorpresa de que toda ella es pura luz, es decir, la esencia de la materia.

Yo he tenido esa idea muy frecuentemente, nadie me quita de la cabeza que la materia, en lo más profundo de su “ser”, es la luz congelada en trozos de materia que, cuando llegan los sucesos, las transiciones de fase, se deja ver y sale a la “luz” del mundo para que la podamos contemplar.

Simetría es nuestra presencia aquí como observadores, la concha de un caracol, una galaxia, una flor y también las estrellas y los mundos, todo forma un conjunto armónico que hace ese todo en el que nosotros, inmersos en tanta grandeza, no acabamos de asimilar lo mucho que la Naturaleza nos quiere transmitir y, al formar parte de ella, nos cuesta más mirarla desde “fuera” para entenderla, sin ser conscientes que, en realidad, la debemos mirar desde dentro, ahí es donde estamos. ¡Dentro de ella! Siempre hay algo más allá:

The Scale of the Universe 2 – HTwins.net

¿Quieres darte una vueltecita por el universo, en un tiempo razonable y entre las escalas de lo más inimaginablemente grande y lo infinitesimalmente pequeño? Prueba The Scale of the Universe 2, segunda parte de un interactivo similar que hace tiempo estuvo circulando por la Red, y a disfrutar. Basta mover la barra de desplazamiento o usar la rueda del ratón, y también se puede hacer clic sobre los objetos para aprender algo sobre ellos.

Todas ellas, sin excepción, están formadas por las mismas cosas, los mismos elementos, las mismas fuerzas y las mismas constantes dinámicas que actúan según unos patrones encaminados a cambiarlo todo para que todo sea renovado.

Lo invadieron las pulgas

Todos sabemos de las grandes estructuras (inertes o vivas) que, en su inmensidad, transportan dentro de ellas o en la misma superficie, otras estructuras más pequeñas que, no por ello, dejan de ser también complejas. Grandes pulgas transportan pequeñas pulgas en su piel y, al igual que nosotros, llevan en ellas mismas a otros animáculos más pequeños, o, infinitesimales que, también, como nosotros, animales más grandes, tienen una misión encomendada sin la cual, seguramente nosotros, ni podríamos ser. Así que, tenemos que prestar mucha atención a lo que creemos “ínfimo” y que, en la mayoría de las veces, resulta ser más importante de lo que podemos llegar a imaginar.

Si miramos a los Quarks de un protón, por ejemplo, la mecánica cuántica (esa teoría maravillosa que controla todo el micromundo con increíble precisión), exige que el producto de la masa por la velocidad, el llamado “momento”, debe ser inversamente proporcional al tamaño de la “caja” en la cual ponemos nuestro sistema. El protón puede ser considerado como una de tales cajas y es tan pequeño que los quarks en su interior tendrían que moverse con una velocidad cercana a la de la luz. Debido a esto, la masa efectiva de los quarks más pequeños, u y d, es aproximadamente de 300 MeV, que es mucho mayor que el valor que vemos en las Tablas de Partículas; eso también explica porque la masa del Protón es de 900 MeV, mucho mayor que la suma de las masas en reposo de los quarks /y Gluones).

Sí, dentro de los protones y neutrones, seguramente pueda haber mucho más de lo que ahora podemos vislumbrar. Nuestros aceleradores de partículas han podido llegar hasta ciertos límites que nos hablan de Quarks y ahora se buscan partículas supersimétricas o bosones traficantes de masa (como diría Ton Wood), y, nosotros, no sabemos si esos objetos existen o si podremos llegar a encontrarlos pero, por intentarlo… No dudamos en gastar ingentes cantidades y en utilizar cuantos recursos humanos sean precisos. El conocimiento de la Naturaleza es esencial para que, el futuro de la Física, sea la salvación de la Humanidad o, en su caso, de la raza que vendrá detrás de nosotros.

Algunas Teorías, como todos conocemos, han intentado unificar teorías de color con las de supersimetría. Quizá los nuevos Aceleradores de Hadrones (LHC) y otros similares que estarán acabamos poco después de estas primeras décadas del siglo XXI, nos puedan dar alguna pista y desvelar algunos de los nuevos fenómenos asociados a los nuevos esquemas que se dibujan en las nuevas teorías.

El fotón es la partícula más veloz del Universo, es también la transmisora de la fuerza electromagnética entre partículas cargadas como los electrones. Los fotones no tienen masa, marcan el límite de la velocidad en nuestro Universo y están presentes en todos los tipos de radiación que se producen.

Los astrofísicos están muy interesados en estas ideas que predicen una gran cantidad de nuevas partículas superpesadas y, también varios tipos de partículas que interaccionan ultra-débilmente. Estas podrían ser las “famosas” WIMPs que pueblan los huecos entre galaxias para cumplir los sueños de los que, al no saber explicar algunas cuestiones, acudieron a la “materia oscura” que, como sabeis, les proporcionó el marco perfecto para ocultar su inmensa ignorancia. “¡La masa perdida!” ¿Qué masa es esa? Y, sin embargo, los Astrofísicos, incansables, se aferran a ella y la siguen buscando…¡Ilusos!

¡El Universo! ¡Son tantas cosas!

Desde nosotros los observadores, hasta la más ínfima partícula de materia

Yo, en mi inmensa ignorancia, no puedo explicar lo que ahí pueda existir. Sin embargo, sospecho que, deberíamos ahondar algo más en esa fuerza que llamamos Gravedad y que, me da la sensación de que nos esconde secretos que aún no hemos sabido desvelar. Y, por otra parte, tengo la sospecha de que la Luz, es más de lo que podemos suponer.

Ella dijo: “Dime algo bonito”, y él le dijo: “(∂ + m) ψ = 0”.

“Ésa es la ecuación de Dirac. Gracias a esto, se describe el fenómeno de entrelazamiento cuántico, que en la práctica dice que: ‘Si dos sistemas interactúan uno con el otro durante un cierto período de tiempo y luego se separan, lo podemos describir como dos sistemas separados, pero de alguna manera sutil están convertidos en un solo sistema. Uno de ellos sigue influyendo en el otro, a pesar de kilómetros de distancia o años luz’. Esto es el entrelazamiento cuántico o conexión cuántica. Dos partículas que, en algún momento estuvieron unidas, siguen estando de algún modo relacionadas. No importa la distancia entre ambas, aunque se hallen en extremos opuestos del universo. La conexión entre ellas es instantánea.”

emilio silvera

Totales: 75.420.851

Totales: 75.420.851 Conectados: 118

Conectados: 118