Mar

2

¡Los cuantos! II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Pero para los electrones todo es muy diferente. Su comportamiento parece estar envuelto en misterio. Es como si pudiera “existir” en diferentes lugares simultáneamente, como si fuera una nube o una onda, y esto no es un efecto sin importancia. Si realizamos experimentos con suficiente precisión, se puede determinar que el electrón parece capaz de moverse simultáneamente a lo largo de trayectorias muy separadas unas de otras. ¿Qué puede significar todo esto?

Niels Bohr consiguió contestar a esa pregunta de forma tal que con su explicación se pudo seguir trabajando y muchos físicos siguen considerando su respuesta satisfactoria. Se conoce como la “interpretación de Copenague” de la mecánica cuántica. En vez de decir que un electrón se encuentra en un punto X o un punto Y, nosotros hablamos acerca del estado de un electrón. Ahora no sólo tenemos el estado “X” o el estado “Y”, sino estados “parcialmente X y también parcialmente Y”. Un único electrón puede encontrarse, por tanto, en varios lugares simultáneamente. Precisamente lo que nos dice la mecánica cuántica es cómo cambia el estado del electrón según transcurre el tiempo.

Para que las reglas de la mecánica cuántica funcionen, es necesario que todos los fenómenos naturales en el mundo de las cosas pequeñas estén regidos por las mismas reglas. Esto incluye a los virus, bacterias e incluso a las personas. Sin embargo, cuanto más grande y más pesado es un objeto más difícil es observar las desviaciones de las leyes del movimiento “clásicas” debidas a la mecánica cuántica.

Está claro que, el todo es la suma de las partes, pero sólo se puede hacer la suma si todas las partes obedecen a las mismas leyes. Por ejemplo, la constante de Planck , h = 6,626075… x 10ˉ³⁴ julios segundo, debe ser exactamente la misma para cualquier objeto en cualquier sitio, es decir, debe ser una constante universal.

Las reglas de la mecánica cuántica funcionan tan bien que refutarlas resulta realmente difícil. Los trucos ingeniosos descubiertos por Werner Heisenberg, Paul Dirac, Feynmann y muchos otros mejoraron y completaron las reglas generales. Pero Einstein y otros pioneros tales como Erwin Schrödinger, siempre presentaron serias objeciones a esta interpretación. Quizá funcione bien, pero ¿Dónde está exactamente el electrón, en el punto X o en el punto Y? En definitiva, ¿Dónde está en realidad?, cuál es la realidad que hay detrás de nuestras fórmulas? Si tenemos que creer a Bohr, no tiene sentido buscar tal realidad. Las reglas de la mecánica cuántica, por sí mismas, y las observaciones realizadas con detectores son las únicas realidades de las que podemos hablar.

A la derecha; MOSCÚ, el monumento a Einstein y Bohr

Todos sabemos de las controversias entre Einstein y Bohr en relación a todo esto, y, veremos, si finalmente, no vuelve el punto de vista de Einstein, ya que, según todos los indicios, en el punto de vista de la “interpretación de Copenhague” parece faltar algo, ya que, al tratar de formular la mecánica cuántica para todo el Universo (donde las medidas no se pueden repetir) y cuando se trata de reconciliar las leyes de la mecánica cuántica con las de la gravitación, surgen serios problemas.

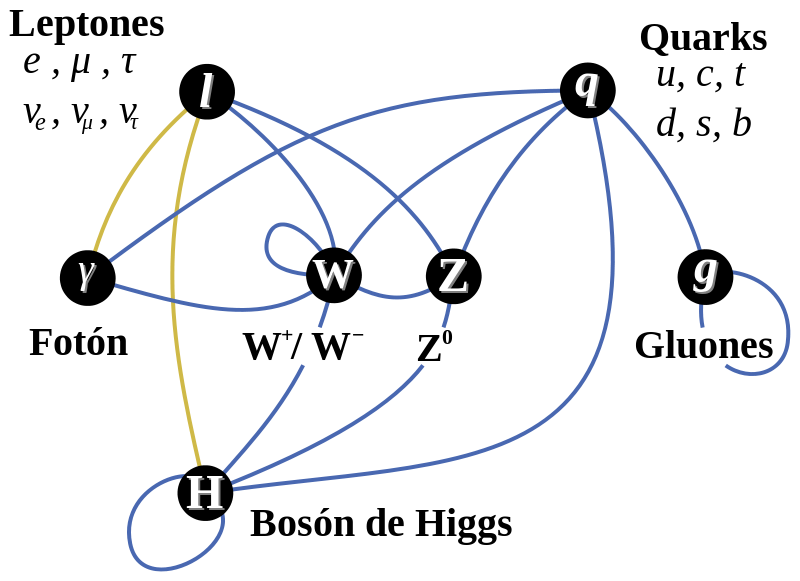

¿Son antagónicas? ¿Por qué no se quieren juntar? La Gravedad no está en el Modelo Estandar

Podemos finalizar este comentario diciendo que, la realidad lo que se impone es buscar una teoría cuántica de la gravedad que nos pueda explicar, todas las cuestiones que, de momento, ignoramos, y, tal ignorancia, desemboca en especulaciones y conjeturas de las que, algún día, surgirán las respuestas.

¡La Física! ¿Cuántos misterios nos guarda?

Emilio Silvera V.

Mar

2

La “Vida” y la “Muerte” de las Partículas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (2)

Comments (2)

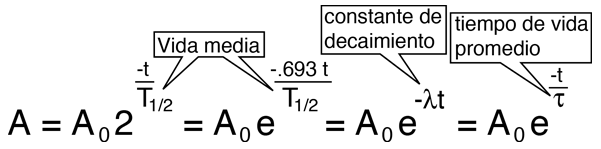

“La vida media es el promedio de vida de un núcleo o de una partícula subatómica libre antes de desintegrarse. Se representa con la letra griega (Tau). La desintegración de partículas es un proceso probabilístico (en concreto sigue la ley de Poisson) por lo que esto no significa que un determinado núcleo vaya a tardar exactamente ese tiempo en desintegrarse. La vida media no debe confundirse con el periodo de semidesintegración, semiperiodo, vida mitad o semivida: son conceptos relacionados, pero diferentes. En particular el periodo de semidesintegración se aplica solamente a sustancias radiactivas y no a partículas libres como se dice.”

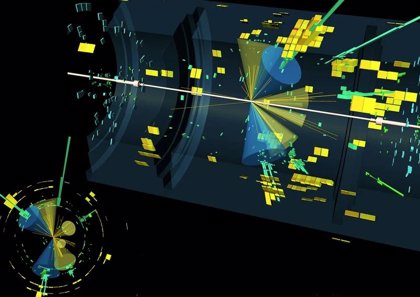

Haces de partículas lanzadas a velocidades relativistas chocan con el haz contrario y surgen partículas nuevas.

la velocidad de la luz (c)

Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida medio, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, ksi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales manera de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

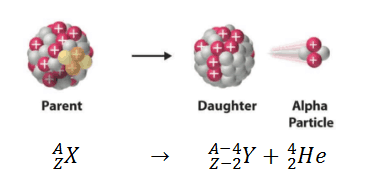

Desintegración Alfa

Desintegración Beta

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

Aunque el tiempo sea distinto, como le pasa a las partículas le pasa a todo lo demás. Toda nace y muere

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su corta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas,

Un descanso el en trabajo.

Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

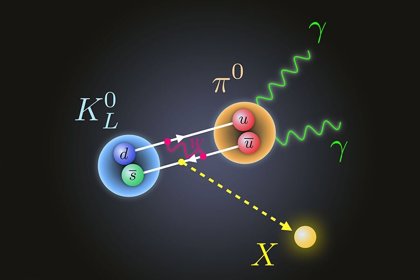

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

No confundir con resonancia magnética

Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

“La resonancia ϒ(1S), observada por la colaboración E288, dirigida por Leon Lederman, en Fermilab en 1977. La resonancia se sitúa a 9.5 GeV, lo que se corresponde con la masa del mesón ϒ(1S).”

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (materia), es aún limitado.

Emilio Silvera V.

Mar

1

Visualizar el Pasado desde el Presente

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Mar

1

¿A qué velocidad mueve el Tiempo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

¿A qué velocidad viaja el Tiempo?

“Si nada lo distorsiona (sin efectos relativistas de alta velocidad o gravedad intensa), el tiempo fluye a través de todo observador en reposo a la velocidad de la luz (299.792.458 m/s.) Se mueve a una tasa de 1 segundo por segundo para el propio observador, marcando su propio tiempo.

En resumen, en ausencia de distorsiones, el tiempo avanza a un ritmo constante y absoluto para el sujeto, el cual equivale a la velocidad de la luz (c) en el espacio-tiempo.”

Yo no estaría tan seguro de esto, presiento que algo se nos escapa.

¿Es la Gravedad presente la que determina su velocidad?

No hay quien me quite de mi cabeza que, no es el Tiempo el que se ralentiza (que sigue a su ritmo normal por mucho que corramos), creo que somos nosotros los que, al ir más rápido, adelantamos al Tiempo y lo dejamos atrás.

Porque, en efecto, si el tiempo pasa a diferentes ritmos dependiendo de cual sea la intensidad gravitatoria local, cabe la posibilidad de que, desde la perspectiva de un cuerpo de gran masa, viéramos a un rayo de luz lejano viajar a una velocidad mayor que c.

¿Por qué?

Es que si la velocidad de la luz es de 300 000 km por segundo, cabe la pregunta: ¿de qué segundos?

Lo lógico es pensar que esa velocidad se refiere a los segundos que pasan según el ritmo temporal de la región por la que el rayo atraviesa.

https://www.youtube.com/shorts/Yyeb8VuVe8A?feature=share

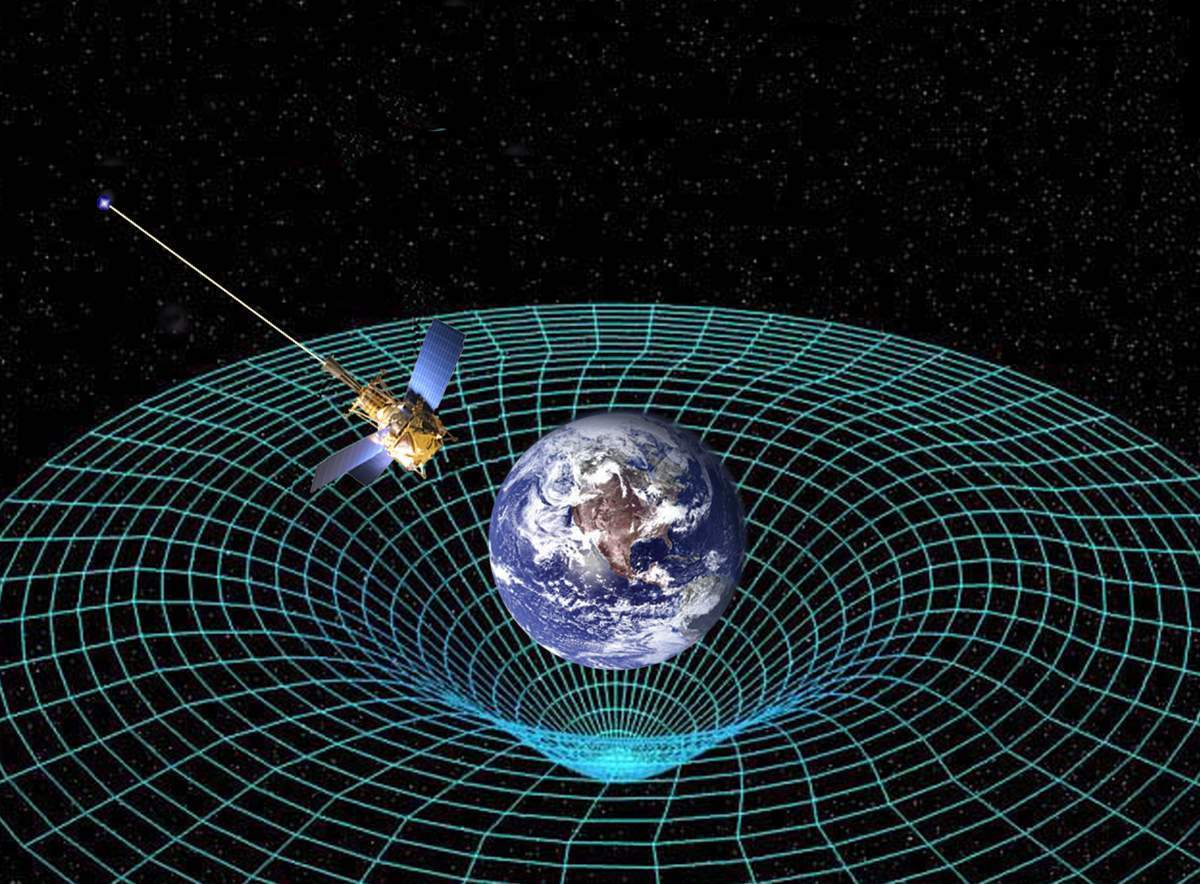

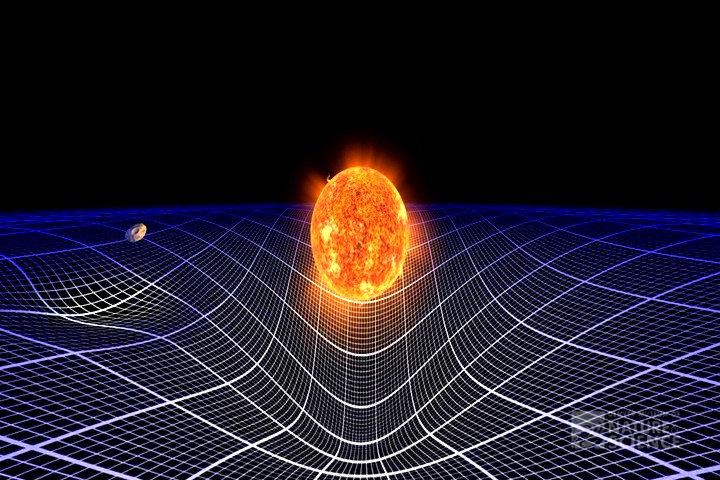

“La curvatura del espacio–tiempo es una de las principales consecuencias de la teoría de la relatividad general de acuerdo con la cual la gravedad es efecto o consecuencia de la geometría curva del espacio–tiempo.”

Hay que entender que el espacio-tiempo es la única descripción en cuatro dimensiones del Universo en la que la posición de un objeto se especifica por tres coordenadas en el espacio y una en el tiempo.

De acuerdo con la relatividad especial, no existe un tiempo absoluto que pueda ser medido con independencia del observador, de manera que eventos simultáneos para un observador ocurren en instantes diferentes vistos desde otro lugar.Curvatura del Espacio.

El tiempo puede ser medido, por tanto, de manera relativa, como los son las posiciones en el espacio (Euclides) tridimensional, y esto puede conseguirse mediante el concepto de espacio-tiempo. La trayectoria de un objeto en el espacio-tiempo se denomina por el nombre de línea de Universo. La relatividad general, nos explica lo que es un espacio-tiempo curvo con las posiciones y movimientos de las partículas de materia.

La curvatura del espacio tiempo es la propiedad del espacio-tiempo en la que las leyes familiares de la geometría no son aplicables en regiones donde los campos gravitatorios son intensos.

La curvatura del espacio tiempo es la propiedad del espacio-tiempo en la que las leyes familiares de la geometría no son aplicables en regiones donde los campos gravitatorios son intensos.

En una singularidad , la densidad de materia es tanta que la fuerza de gravedad que allí se emite, paraliza el Tiempo y curva el espacio sobre sí mismo

La relatividad general de Einstein, nos explica y demuestra que el espacio-tiempo está íntimamente relacionado con la distribución de materia en el Universo y, nos dice que, el espacio se curva en presencia de masas considerables como planetas, estrellas o Galaxias (entre otros).

En un espacio de sólo dos dimensiones, como una lámina de goma plana, la geometría de Euclides se aplica de manera que la suma de los ángulos internos de un triángulo en la lámina es de 180º. Si colocamos un objeto masivo sobre la lámina de goma, la lámina se distorsionará y los caminos de los objetos que se muevan sobre ella se curvaran. Esto es en esencia, lo que ocurre en relatividad general.

Si pudiéramos viajar a la velocidad de la luz se producirían fenómenos extraños en relación a los que no viajaran a esa velocidad.

Los efectos de c (la velocidad de la luz en el espacio vacío). Recordad la paradoja de los gemelos: el primero hace un viaje a la velocidad de la luz hasta Alfa de Centauri y regresa, cuando baja de la nave espacial, tiene 8,6 años más que cuando partió de la Tierra. Sin embargo, el segundo gemelo que esperó en el planeta Tierra, el regreso de su hermano, era ya un viejo jubilado. El tiempo transcurrido había pasado más lento para el gemelo viajero. La velocidad relantiza el transcurrir del tiempo.

Otra curiosidad de la relatividad especial es la que expresó Einstein mediante su famosa fórmula de E= mc2 que, nos viene a decir que masa y energía son dos aspectos de una misma cosa. Podríamos considerar que la masa (materia), es energía congelada. La bomba atómica demuestra la certeza de esta ecuación.

“Esquema sobre la contracción de Lorentz. (X′,cT′) representan las coordenadas de un observador en reposo a una barra, mientras que (X,cT) son las coordenadas de otro observador en movimiento con respecto a dicha barra. Por la naturaleza pseudoeuclídea del espacio-tiempo aun cuando el primer observador mide una longitud l, el segundo mide una longitud menor l/γ < l.”

Diagrama de Minkowski del experimento mental de Einstein sobre la contracción de la longitud (1911). Dos barras con longitud en reposo A ′ B ′ = A ″ B ″ = L …

Hay otras implicaciones dentro de esta maravillosa teoría de la relatividad especial, ahí está presente también la contracción de Lorentz. Un objeto que se mueve a velocidad de cercana a c, se achata o contrae en el sentido de la marcha, y, además, a medida que se acerca a la velocidad de la luz (299.752,458 Km/s), su masa va aumentando y su velocidad disminuyendo.

Así se ha demostrado con muones en los aceleradores de partículas que, lanzados a velocidades relativista, han alcanzado una masa en 10 veces superior a la suya.

Esto quiere decir que la fuerza de inercia que se le está transmitiendo a la nave (por ejemplo), cuando se acerca a la velocidad de la luz, se convierte en masa.

Así queda demostrado que, masa y energía son dos aspectos de la misma cosa E=mc2.

Seguiremos con otras cuestiones de interés.

Hay que entender que el espacio-tiempo es la única descripción en cuatro dimensiones del Universo en la que la posición de un objeto se especifica por tres coordenadas en el espacio y una en el tiempo.

De acuerdo con la relatividad especial, no existe un tiempo absoluto que pueda ser medido con independencia del observador, de manera que eventos simultáneos para un observador ocurren en instantes diferentes vistos desde otro lugar.

El tiempo puede ser medido, por tanto, de manera relativa, como los son las posiciones en el espacio (Euclides) tridimensional, y esto puede conseguirse mediante el concepto de espacio-tiempo. La trayectoria de un objeto en el espacio-tiempo se denomina por el nombre de línea de Universo. La relatividad general, nos explica lo que es un espacio-tiempo curvo con las posiciones y movimientos de las partículas de materia.

En presencia de grandes masas (estrellas, mundos, galaxias…) El Espacio-tiempo se transforma, la geometría del Universo la determina la fuerza de Gravedad.

La curvatura del espacio tiempo es la propiedad del espacio-tiempo en la que las leyes familiares de la geometría no son aplicables en regiones donde los campos gravitatorios son intensos.

La curvatura del espacio tiempo es la propiedad del espacio-tiempo en la que las leyes familiares de la geometría no son aplicables en regiones donde los campos gravitatorios son intensos.

La relatividad general de Einstein, nos explica y demuestra que el espacio-tiempo está íntimamente relacionado con la distribución de materia en el Universo y, nos dice que, el espacio se curva en presencia de masas considerables como planetas, estrellas o Galaxias (entre otros).

En un espacio de sólo dos dimensiones, como una lámina de goma plana, la geometría de Euclides se aplica de manera que la suma de los ángulos internos de un triángulo en la lámina es de 180º. Si colocamos un objeto masivo sobre la lámina de goma, la lámina se distorsionará y los caminos de los objetos que se muevan sobre ella se curvaran. Esto es en esencia, lo que ocurre en relatividad general.

Otra curiosidad de la relatividad especial es la que expresó Einstein mediante su famosa fórmula de E= mc2 que, nos viene a decir que masa y energía son dos aspectos de una misma cosa. Podríamos considerar que la masa (materia), es energía congelada. La bomba atómica demuestra la certeza de esta ecuación.

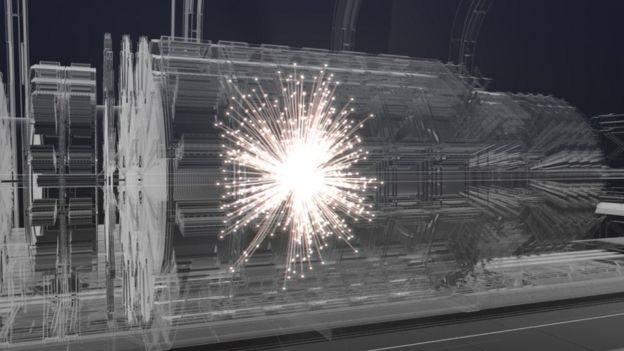

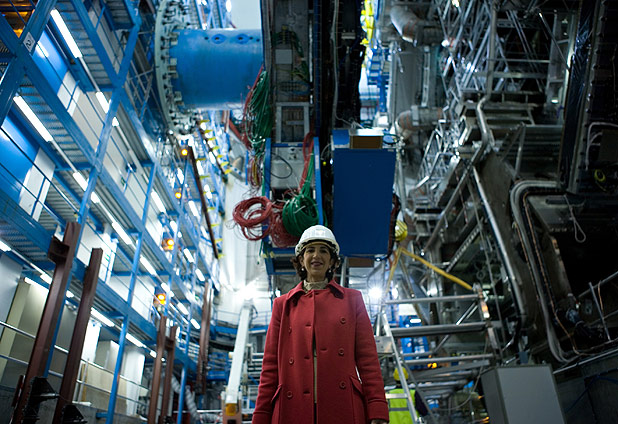

En el LHC haces de muones lanzados a velocidades relativistas, aumentaron su masa 10 veces

Así se ha demostrado con muones en los aceleradores de partículas que, lanzados a velocidades relativista, han alcanzado una masa en 10 veces superior a la suya.

Esto quiere decir que la fuerza de inercia que se le está transmitiendo a la nave (por ejemplo), cuando se acerca a la velocidad de la luz, se convierte en masa.

Así queda demostrado que, masa y energía son dos aspectos de la misma cosa E=mc2.

Seguiremos con otras cuestiones de interés.

Emilio Silvera V.

Mar

1

Estamos tratando de recrear la creación

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (1)

Comments (1)

Como es habitual, repasando boletines y revistas de la Real Sociedad Española de Física. Entre otras muchas noticias, me ha llamado la atención una que dice:

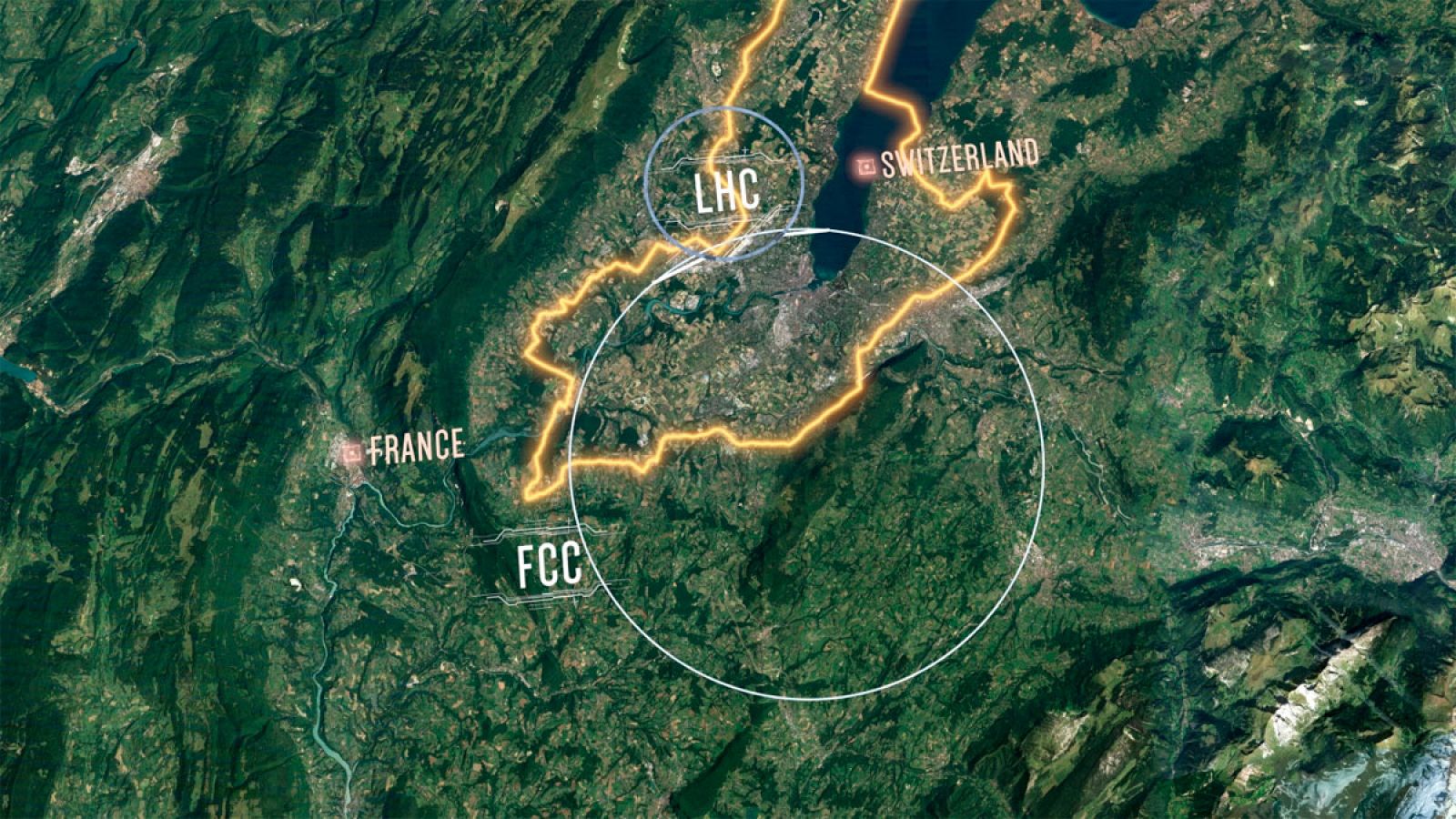

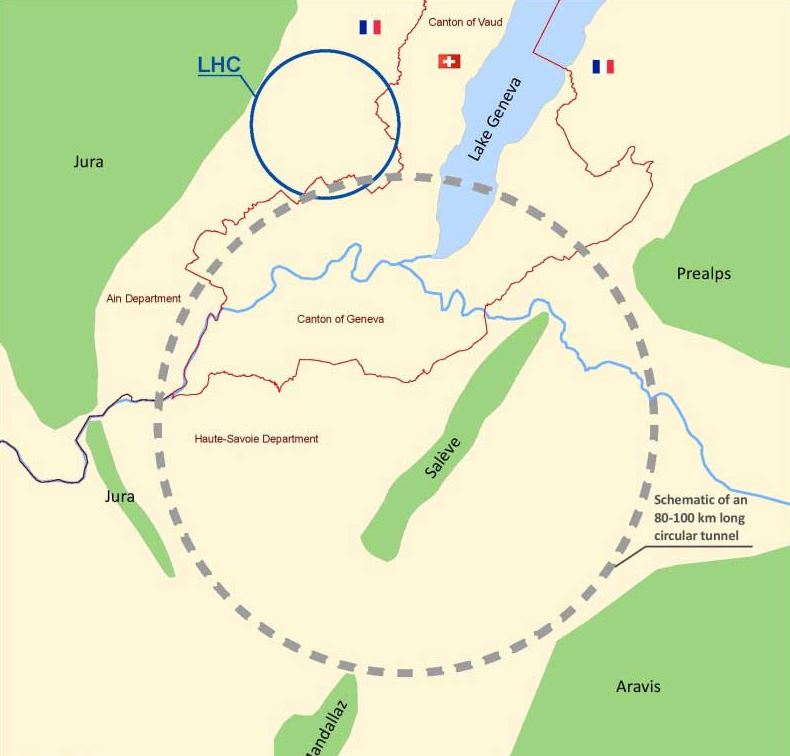

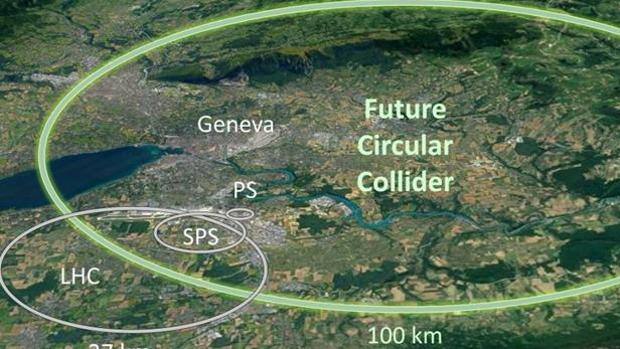

“Europa construirá un acelerador tres veces mayor que el LHC. Aunque el LHC seguirá funcionando por lo menos durante dos décadas más, Europa ya empieza a pensar en su sucesor: un enorme colisionador con una circunferencia de 100 km (frente a los 27 del LHC) y capaz de alcanzar una energía de 100 TeV, siete veces superior a los 14 TeV a los que puede llegar, como máximo, el LHC. Tras alcanzar el hito de detectar el bosón de Higgs.

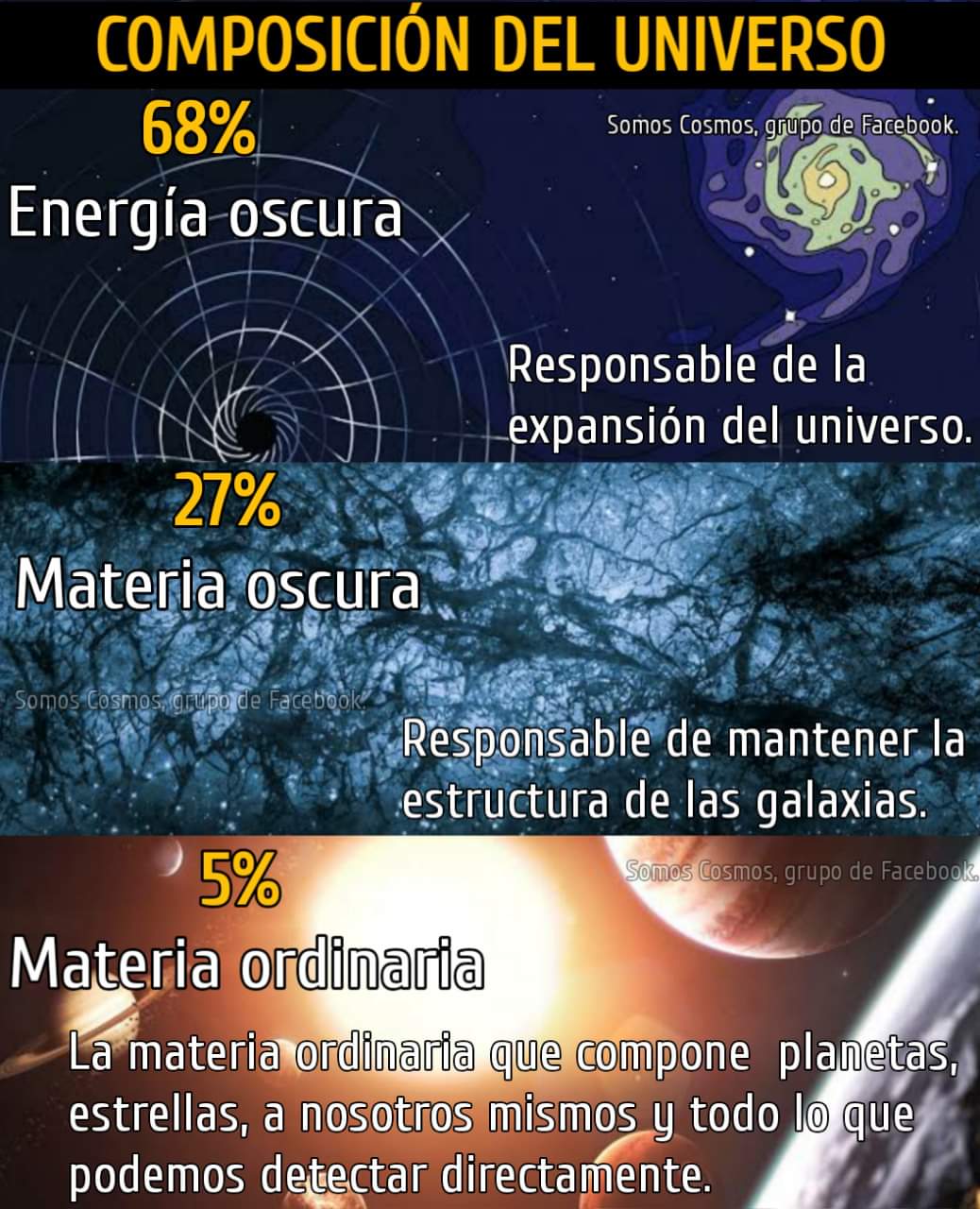

Cuando salió esta noticia, el LHC estaba apagado para llevar a cabo tareas de mantenimiento y no volvería a funcionar hasta meses más tarde. El Modelo Estándar incluye a todos los componentes fundamentales de la materia ordinaria pero no dice nada de la “materia oscura” ni de la “energía oscura”.

Pero… ¿Existen en realidad la Materia y la Energía oscura? Hablan de ellas como si realmente estuvieran ahí, en el inmenso universo. A veces me da la sensación que son inventos que cubren la ignorancia de los cosmólogos que tratan de normalizarlas diciento cosas como estas:

No se debe confundir la energía oscura con la materia oscura, ya que, aunque ambas forman la mayor parte de la masa del universo, la materia oscura es una forma de materia, mientras que la energía oscura se asocia a un campo que ocupa todo el espacio.

“Tenemos muchas esperanzas de que cuando el LHC funcione de nuevo a su máximo nivel de energía podamos tener un primer atisbo de lo que es la “materia oscura”. Y a partir de ahí determinar los objetivos del próximo gran colisionador”, decía el Director del CERN.”

Diseñaron un nuevo experimento para localizar la “materia oscura”

“El CERN aprobó un nuevo experimento diseñado para buscar partículas ligeras y de interacción débil, asociadas con la elusiva “materia oscura”, en el Gran Colisionador de Hadrones (LHC)”

Digamos que hasta el momento, todos los esfuerzos han sido vanos, no han hallado el menor indicio de la hipotética “materia oscura”, si es que finalmente se comprueba que realmente existe.

Nuestra imaginación no descansa y construimos escenarios en nuestras mentes que podrían ser, y, la única manera de comprobar esas ideas es la de intentar confirmarlas con experimentos y observación.

Está bien que no dejemos de avanzar y sigamos buscando aquello que desconocemos. La Naturaleza esconde muchos secretos que tratamos de desvelar y, la hipotética “materia oscura” es uno de ellos. Hablamos y hablamos sobre algo que no sabemos si será. Tampoco sabemos de que pueda estar conformada, de dónde surgió y por qué, si emite o genera fuerza gravitatoria no emite radiación. En fin, un misterio que sería bueno resolver.

¡100 TeV! ¡100 Km de diámetro!

Si cuando se acercaba la hora de la puesta en marcha del LHC salieron múltiples organizaciones planteando protestas de todo tipo, incluso alguna se atrevió a decir que el Acelerador tenía tanta energía que crearía un agujero negro que se tragaría a la Tierra. ¿Qué dirán ahora del futuro Acelerador? Seguramente, habrá mucha más algarabía, protestas y un sin fin de manifestaciones de todo tipo. Sin embargo, el futuro… ¡Es imparable!

Si nos retrotraemos en el Tiempo… ¡El asombro por lo logrado será grande!

A estas alturas pocas dudas podemos tener de que nuestra especie viaja desde el Pasado hacia el Futuro pasando por un inquieto Presente que trata de preparar el camino a los que vendrán de la misma manera que Demócrito y Empédocles balbucearon sobre el átomo y los elementos, ahora nosotros lo hacemos sobre cuerdas, materia oscura, universos paralelos y otros posibles escenarios que podrían ser confirmados.

Algunas veces el entusiasmo por alcanzar logros científicos nos puede poner en difíciles situaciones, la Ciencia debe tener un exquisito cuidado con lo que hace, no puede aventurarse a correr riesgos que, incluso, podrían destruir a la propia especie.

El futuro colisonador será cuatro veces más grande y diez veces más potente que el actual LHC, parece oportuno volver a preguntarse por la seguridad de esas gigantescas máquinas, las mayores jamás construidas por el hombre, capaces de triturar los componentes de la materia y de reproducir condiciones que no se conocían en el Universo desde el mismísimo Big Bang.

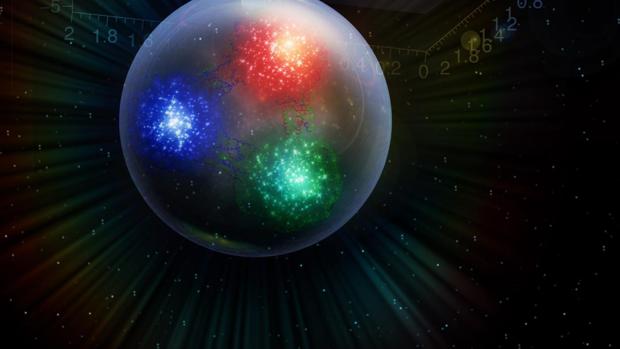

“Científicos han logrado la primera medición de una propiedad mecánica en partículas subatómicas: han medido la distribución de presión en el interior de un protón.”

“El modelo estándar de la física, el marco teórico usado por los científicos para explicar el comportamiento de la materia, dice que existen cuatro fuerzas o interacciones fundamentales: la nuclear fuerte, la electromagnética, la nuclear débil y la gravitatoria. La fuerza nuclear fuerte es, como su nombre indica, la más potente. Es capaz de mantener unidos a protones y neutrones, que se encuentran en el núcleo de los átomos, incluso a pesar de que los primeros tienen carga positiva y se repelen entre sí. Se puede decir que la fuerza nuclear fuerte es el pegamento que mantiene unidos los núcleos de los átomos, pero esta fuerza tiene una peculiaridad: su rango de acción es muy pequeño y a mayores escalas es superada por las otras interacciones.” ABC – Ciencia)

“Las estrellas de neutrones tienen densidades totales de 3,7×1017 a 5,9×1017 kg/m3 (de 2,6×1014 a 4,1×1014 veces la densidad del Sol), comparable con la densidad aproximada de un núcleo atómico de 3×1017 kg/m3. La densidad de una estrella de neutrones varía desde menos de 1×109 kg/m3 en la corteza, aumentando con la profundidad a más de 6×1017 u 8×1017 kg/m3 aún más adentro (más denso que un núcleo atómico). Esta densidad equivale aproximadamente a la masa de un Boeing 747 comprimido en el tamaño de un pequeño grano de arena.”

Volviendo al futuro colisionador, no son pocos los que creen que su puesta en marcha a esas energías de 100 TeV, se podrían producir agujeros negros que comenzarían a tragarse todo lo que tenga a su alrededor, iría creciendo más y más y, finalmente, se tragaría la Tierra entera.

Aunque parece conveniente no dejar de avanzar, así lo aconseja el futuro que nos espera con la “muerte” del Sol, también es cierto que falta mucho para que ese suceso comience su proceso (al menos 1.000 millones de años para que el Sol comience su proceso hacia estrella Gigante roja). Así que, en ese Tiempo, debemos trabajar en la buena dirección y tener en cuenta los riegos a los que nunca nos debemos exponer para provocar que seamos nosotros mismos los que iniciemos la propia destrucción.

Los peligros que nos asechan no son todos artificiales, algunos los provocan la Naturaleza misma

Otros podrían estar provocados por nuestra propia ambición sin límites de crear lo imposible, seres artificiales que tenga conciencia de Ser. Serían más fuertes e inteligentes que nosotros, no necesitaran comer ni dormir, no les afecta la radiación del espacio, nos superan en fuerza, no tienen enfermedades….

¿Para que nos necesitarían?

¿Ciencia? SÍ, siempre que se pongan algunos límites que nos preserven de consecuencias irreversibles,

Emilio Silvera V.

Totales: 86.126.911

Totales: 86.126.911 Conectados: 64

Conectados: 64