Feb

28

Tener presente el Pasadol

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

La cultura de El Argar se considera una de las civilizaciones más importantes y fundacionales de la antigua Andalucía y del sureste de la Península Ibérica, marcando el inicio de la Edad de Bronce en la región entre el 2200 y el 1550 a.C.

- Ubicación y Alcance: El yacimiento principal se encuentra en Antas, Almería, pero esta cultura se extendió por gran parte de Andalucía Oriental (Almería, Granada, Jaén) y Murcia.

- Innovación Social: Fue la primera sociedad con una verdadera estructura de clases, estado y una organización política compleja en la zona. A diferencia de la cultura anterior (Los Millares, Edad del Cobre), los argáricos crearon asentamientos elevados, fortificados y con una marcada estratificación social (nobles, artesanos, campesinos).

- Urbanismo: Se les considera la primera sociedad urbana del Mediterráneo occidental. Construían sus viviendas con piedra, tapial o adobe, aprovechando las laderas aterrazadas, y gestionaban el agua mediante cisternas.

- Economía y Tecnología: Desarrollaron una metalurgia avanzada del bronce (usada para armas y herramientas) y un control de la producción agrícola, especialmente de la cebada.

- Costumbres Funerarias: Una característica distintiva era el enterramiento de sus muertos dentro de los propios poblados, a menudo bajo el suelo de las viviendas o en urnas cerámicas (cistas).

Feb

28

La física que hace IMPOSIBLE el viaje interestelar | Leonard Susskind

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Ya es hora de que aceptemos la imposibilidad de viajar a las estrellas. El descubrimiento de otros mundos habitables, por un lado, y el conocer que un día lejano en futuro, el Sol morirá, nos han llevado a especular con la posibilidad de viajar a las estrellas.

Son muchos los inconvenientes físicos y técnicos que hacen imposible que podamos viajar a otros mundos.

Ya expusimos aquí las explicaciones de este mismo científico (el 21/02/2026), que nos explicaba la imposibilidad de viajar a Marte. Los datos son muy parecidos a los que nos ofrece aquí, que solo vienen a reforzar aquellos.

Lo esencial de esta entrada: Derribar el mito de los viajes espaciales que, solo son posibles en las películas y novelas de Ciencia Ficción. La cruda realidad… ¿Es muy dist9inta!

Emilio Silvera v.

Feb

26

¿Qué es el Amor?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

El irrefrenable deseo de fusión con el Ser amado

El inexplicable sentimiento que tiene más fuerza que un huracán. Cuando llega no sabe de clases, ni de fronteras. Recuerdo aquella metáfora que plasmaba en uno de mis escritos que, para significar que cuando llega el Amor verdadero, nada impide que se produzca el acercamiento, y, contaba que una mitocondria se había enamorado de una célula eucariota.

¿Empezaría allí todo?

Si unos seres inteligentes de otro mundo nos estuviera observando… ¿Qué diría de nuestro comportamiento? En el Amor y en otros ámbitos de la Vida que, a veces, pueden resultar totalmente irracionales.

¡Cómo somos! La Humanidad… ¿Quién la entiende? Somos más de 7.000 millones y las diferencias de pensamiento a la vista están.

Me gustaría saber en qué desembocará todo esto… ¿Nos destruiremos a nosotros mismos?

Yo creo que, el Amor, es lo que nos hace mejores, y pienso que, ¡sufrir por algo que vale la pena es una alegría!

¿Qué no harías por el Ser amado, por un hijo, por la familia?

Emilio Silvera V.

Feb

26

Creemos algunas cosas… ¿Qué serán ciertas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (3)

Comments (3)

Algunas de las cosas que aquí nos cuentan… ¡Son de dudosa veracidad!

Está bien divulgar lo que se cree que sabemos, al menos mientras no se descubran nuevos parámetros que nos obliguen a cambiar los criterios de esa “verdad” que, a lo largo de la Historia… ¡Hemos tenido que ir cambiando!

Viajar muy rápido nos hace “estar” viviendo en un Tiempo más lento.

Estamos hechos de polvo de estrellas (lo que parece que es cierto).

Todo lo grande está hecho de “cosas” pequeñas.

Nada puede surgir de la Nada, si surgió es porque había.

Tener imaginación es totalmente imprescindible para los Físicos teóricos.

No estar completamente satisfecho de las teorías, tratar de buscar los fallos.

Aplicar la lógica y apartar divinidades y otros extraños parámetros alejados de la Ciencia.

Conjeturar, teorizar, experimentar…. Comprobar una y mil veces la misma cosa, en distintos lugares, por distintas personas, y, si todas esas pruebas dan el mismo resultado… ¡Se darán por buenas!

Y, como decía aquel escritor de Mente algo retorcida: “Que no está muerto lo que duerme eternamente, y, con el paso de los Eones, hasta la misma muerte morirá.”

En fin amigos, a todo esto, no podemos olvidar que sabemos menos de lo que creemos saber, por lo que yo como tantos otros, se apuntarían al deseo de aquel gran filósofo:

“Cambiaría todo lo que se, por la mitad de lo que ignoro.” Lo que es una manera menos humilde de lo que decía Sócrates: “Solo sé, que no se nada.”

Comentario de Emilio Silvera

Feb

26

¿Qué es el agua? Sin ella, la Vida, no podría existir

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

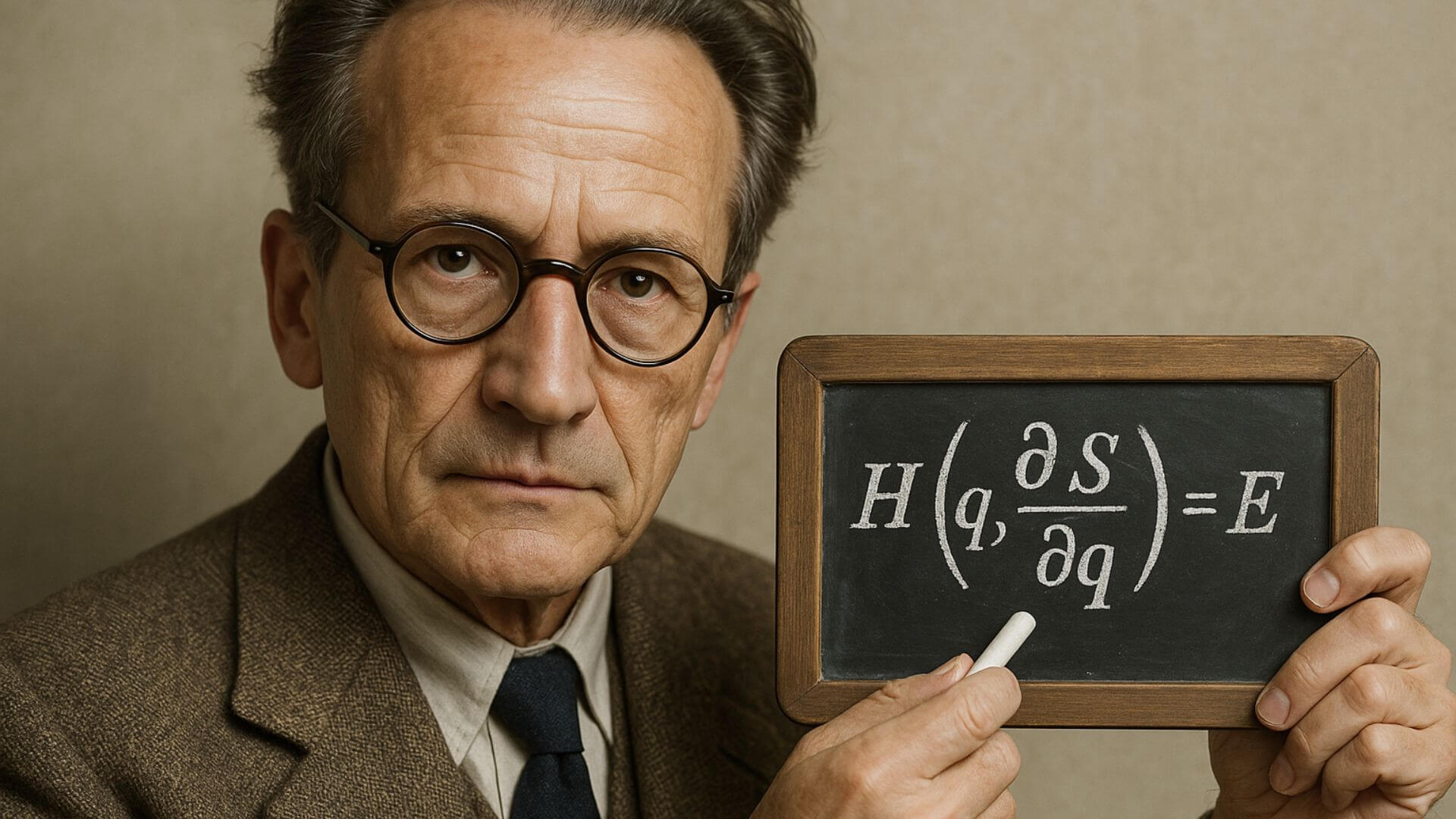

La Mecánica Cuántica desentraña los misterios del Agua

Un Modelo informático basado en la ecuación de Schrödinger descubre la interacción de sus moléculas. También supimos que la luz estaba compuesta por fotones y, sin ella, tampoco estaríamos cómodos en este pequeño mundo.

La ecuación de Schrödinger, uno de los fundamentos de la teoría de la mecánica cuántica, ha desvelado el funcionamiento de las moléculas del agua gracias al uso de un conjunto de ordenadores super-potentes. Formada por dos átomos de hidrógeno y por uno de oxígeno, se cree que el secreto de las propiedades de este líquido tan común como misterioso radica en la capacidad de sus moléculas para formar determinados enlaces entre los átomos de hidrógeno. El desarrollo de este nuevo modelo informático podría tener múltiples aplicaciones, y quizá resuelva determinadas cuestiones como la razón por la que el agua, en estado sólido (hielo), no se hunde dentro de sí misma.

Esencial para todas las formas de vida, y objetivo eterno de estudio, el agua es una sustancia con algunos misterios que aún no han podido ser revelados, al menos desde la física clásica.

La presencia de agua en el planeta res esencial para la vida

El acercamiento a este extraño elemento constitutivo, sin embargo, desde la perspectiva de la física cuántica (desde la ecuación de Schrödinger para ser más exactos), y gracias al uso de un conjunto de ordenadores super-potentes, ha revelado la estructura subyacente del conjunto de moléculas aparentemente sencillas del agua, que están formadas “tan sólo” por dos átomos de hidrógeno y uno de oxígeno.

El logro lo ha alcanzado un equipo de científicos de la universidad norteamericana de Delaware y de la Radboud University de Holanda, que han desarrollado un nuevo método para desvelar las propiedades ocultas del agua, y sin necesidad de concienzudos experimentos de laboratorio: simplemente, informática.

Principios fundamentales

Funciones de onda del electrón en un átomo de hidrógeno en diferentes niveles de energía. La mecánica cuántica no puede predecir la ubicación exacta de una partícula en el espacio, solo la probabilidad de encontrarla en diferentes lugares. Las áreas más brillantes representan una mayor probabilidad de encontrar el electrón.

-

La idea teórica:

La ecuación de Schrödinger es una ley fundamental de la mecánica cuántica que describe el estado de un sistema físico, como un átomo o una molécula, en términos de su función de onda.

-

La escala macroscópica:

En principio, si pudiéramos aplicar la ecuación a todos los átomos individuales de una sustancia macroscópica, su comportamiento colectivo (química y física) quedaría completamente determinado.

-

La complejidad:

La aplicación práctica de esta idea es inviable porque la ecuación de Schrödinger se vuelve computacionalmente intratable cuando el número de partículas (átomos) es extremadamente grande, como los 1023 átomos que hay en una unidad de materia.

-

El uso práctico:Por esta razón, la ecuación de Schrödinger se utiliza con éxito para describir sistemas más pequeños, como los átomos individuales y las moléculas, mientras que la física macroscópica se basa en aproximaciones estadísticas y leyes como las de Newton.

Utilizar esta ecuación y aplicarla de manera eficaz es actualmente posible gracias al uso de ordenadores con una capacidad de cálculo super-potente, que permitirían comprender algunas de las enigmáticas propiedades del agua. Este tipo de herramienta informática de análisis ya se ha aplicado en otros campos, como la meteorología y la mecánica celeste.

Propiedades extrañas

Todo el mundo sabe que una molécula de agua es H2O, pero, aunque su composición parezca simple, el agua líquida en realidad es mucho más compleja que eso. Por ejemplo, señala Szalewicz, contrariamente a otros líquidos, el agua aumenta de volumen cuando se congela, lo que explica que el hielo flote en el agua. Por otro lado, el agua puede absorber grandes cantidades de calor antes de empezar a calentarse y lo libera lentamente mientras se enfría.

Las características únicas del agua parecen relacionarse con su estructura molecular y con la capacidad de sus moléculas para formar enlaces de hidrógeno con otras moléculas de agua. El hidrógeno de la molécula del agua tiene una carga ligeramente positiva, mientras que la carga del otro extremo de la molécula es ligeramente negativa.

Tradicionalmente se pensó que en el agua en estado líquido cada molécula se coordinaba con una media de otras cuatro moléculas gracias a estos enlaces de hidrógeno. Sin embargo, posteriormente se descubrió que esta coordinación tiene lugar sólo con dos moléculas.

Ambigüedades

Todas estas ambigüedades del agua han sido estudiadas desde la mecánica cuántica por Szalewicz y sus colegas, aplicando leyes de la física a un nivel microscópico, allí aparece la vida oculta del agua y todo lo que en ella se esconde.

El resultado: los investigadores han conseguido generar un nuevo marco teórico para describir la estructura y el comportamiento de la molécula del agua átomo a átomo, gracias a los ordenadores de última generación, multiprocesadores, capaces de aportar soluciones bastante ajustadas de las ecuaciones de la mecánica cuántica para la descripción de las fuerzas que ejercen unas moléculas del agua sobre otras. Esto debería permitir desvelar el porqué de las extrañas propiedades de este líquido.

Una gota de agua bajo el microscopio

Con un conjunto de ordenadores Linux funcionando en paralelo, y que realizaron cálculos a gran escala, el estudio tardó varios meses en completarse. El nuevo modelo puede predecir con bastante exactitud, tanto las propiedades de un par de moléculas de agua, como las del agua en estado líquido.

Las aplicaciones de este novedoso modelo, señalan los investigadores, van desde la posibilidad de comprender mejor el agua en diversos estados y en condiciones extremas, hasta el estudio de otros líquidos y sistemas moleculares, el ADN en biología o el llamado plegamiento de proteínas (proceso por el que una proteína alcanza su estructura tridimensional), entre otras.

Todos estos conocimientos que han sido conquistados por nuestra especie, son objetos de publicaciones múltiples en los medios, se dan conferencias, entrevistas, publicaciones de todo tipo encaminadas a divulgar conocimientos esenciales para conocer el mundo en el que vivimos.

Bueno, eso es el agua y mucho más pero, ¿Qué decir de la luz? La Física nos dice:

“La luz es una forma de energía y radiación electromagnética que viaja en ondas a casi 300.000 Km/s., capaz de ser percibida por el ojo humano (luz visible). Presenta una naturaleza dual, comportándose tanto como onda (campos eléctricos/magnéticos) como partícula (fotones sin masa). Es esencial para la visión y proviene de fuentes naturales (Sol) o artificiales.

Claro que, por otra parte sabemos que el Universo era opaco hasta que se des-confinaron (1) los fotones y se hizo transparente, asi tenemos que agradecer a la luz que podamos ver el universo.

Emilio Silvera V.

(1) El término “desconfinamiento de fotones” se refiere principalmente al proceso en el cual los fotones (partículas de luz) son liberados o pueden propagarse libremente a través de un medio que antes era opaco o denso, como el plasma, o cuando se estudian condiciones extremas de la materia, como la transición al plasma de quarks-gluones.

Totales: 86.128.120

Totales: 86.128.120 Conectados: 87

Conectados: 87