Nov

2

¿Hacia dónde vamos? ¿Camino del futuro o de la festrucción?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (30)

Comments (30)

Cuando se lee un buen libro, se saborean sus pasajes más interesantes y, al final, sientes un poco de pena porque aquello se termine tan pronto. Sientes que quieres más, te quedas algo insatisfecho de no haber podido llegar más lejos, de profundicar más en aquello que tánto llamó tu atención y despertó tu curiosidad. Saber sobre aquello que te preocupa es tan vital para la mente que, cuando no puedes desarrollar ciertos pemnsamientos por falta de conocimientos, te sientes frustado y, de alguna manera, sufres por no saber.

Habiendo finalizado la lectura de Las sombras de la Mente, de Roger Penrose, en la que nos habla de la posibilidad de comprender de forma científica lo que la conciencia es y, extrapola dicha conciencia, hasta ese otro mundo de la I.A., en el que, si nada lo remedia, estamos inmersos hasta tal punto que, en el futuro más o menos lejano, será lo que predomine tanto aquí en la la Tierra, como en los mundos y lunas que nos acompañan en el Sistema solar, e, incluso, mucho más allá. Ellos serán, los Robots, los que surquen los cielos y el espacio interestelar en busca de las estrellas.

Es posible que podamos llegar a los límites de la realidad pero… ¿No crearemos una nueva raza para que, sin nosotros saberlo nos suplante en el futuro?

La computación y el Pensamiento consciente

En los últimos tiempos, mucho es lo que se habla de la I.A., y, algunos, nos preguntamos: ¿Será posible que en un futuro más o menos lejano, eso que llamamos Inteligencia Artificial, nos pueda superar?

Hay corrientes en ese sentido que nos llevan a pensar y, ¿por qué no? A preocuparnos profundamente. Si hacemos caso de esas afirmaciones (quizá algo extremas pero, con visos de verdad) de los que defienden a capa y espada el futuro de la I.A., diciendo que, con el tiempo, los ordenadores y los robots superarán a los humanos en inteligencia al llegar a tener todas y cada una de las capacidades humanas y otras que, los humanos nunca podrán tener. Entonces, estos ingenios serían capaces de hacer muchísimo más que ayudar simplemente a nuestras tareas inteligentes.

De hecho, tendrían sus propias y enormes inteligencias. Podríamos entonces dirigirnos a estas inteligencias superiores en busca de consejo y autoridad en todas las cuestiones complejas y de interés que, por nosotros mismos, no pudiéramos solucionar; ¡y finalmente podrían resolver los problemas del mundo que fueron generados por la Humanidad!

Alan Turing estaba convencido de que algún día, las máquinas serían tan inteligentes como los humanos. Y para demostrarlo, inventó el Test de Turing, en 1950. El Test de Turing se basa en la idea de que si no puedes distinguir las respuestas de un programa frente a las de un humano, entonces es porque la inteligencia artificial es tan inteligente como nosotros.

Así se empieza pero… ¿Cómo acaba?

La Nasa ha fabricado un robot que pesa 150 kilogramos, tiene aspecto humanoide y se llama Robonaut-2 (R-2 para los amigos). Este androide será lanzando al espacio y pronto será el nuevo compañero de los tripulantes de la Estación Espacial Internacional. Por algo se comienza y, nunca se sabe como todo terminará.

El Robot que construyó la NASA

Pero, si todo eso fuera así (que podría llegar a serlo), podríamos extraer otras consecuencias lógicas de estos desarrollos potenciales de la I.A. que muy bien podría generar una cierta alarma muy justificada ante una situación tan atípica, en la que, unos “organismos” artificiales creados por nosotros mismos, nos superen y puedan llegar más lejos de lo que nosotros, podríamos ser capaces de llegar nunca. ¿No harían estos ordenadores y Robots, a la larga, que los Humanos fueran superfluos para ellos?

Si los Robots guiados por ordenadores insertados en sus cerebros positrónicos o espintrónicos, o, guiados por un enorme y potente Ordenador Central, resultaran ser muy superiores a nosotros en todos los aspectos, entonces, ¿no descubrirían que pueden dirigir el mundo sin necesidad alguna de nosotros? La propia Humanidad se habría quedado obsoleta. Quizá, si tenemos suerte, ellos podrían conservarnos como animales de compañía (como alguien dijo en cierta ocasión); o, si somos inteligentes, podríamos ser capaces de transferir las “estructuras de información” que somos “nosotros mismos” a una forma de robot (como han pensado algunos otros), o quizá no tengamos esa suerte y no lleguemos a ser tan inteligentes…

Algunos podrían ser muy, muy peligrosos

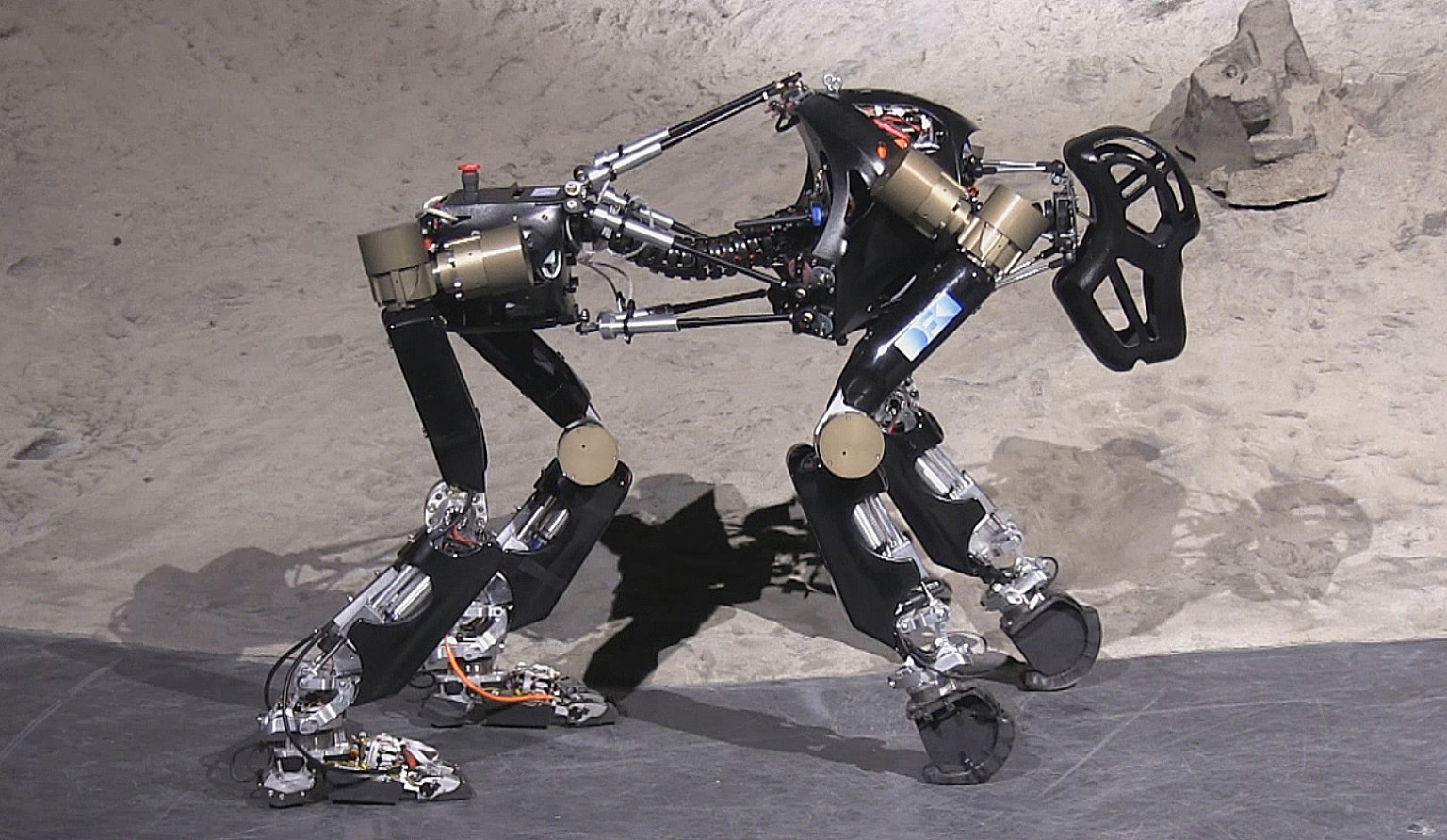

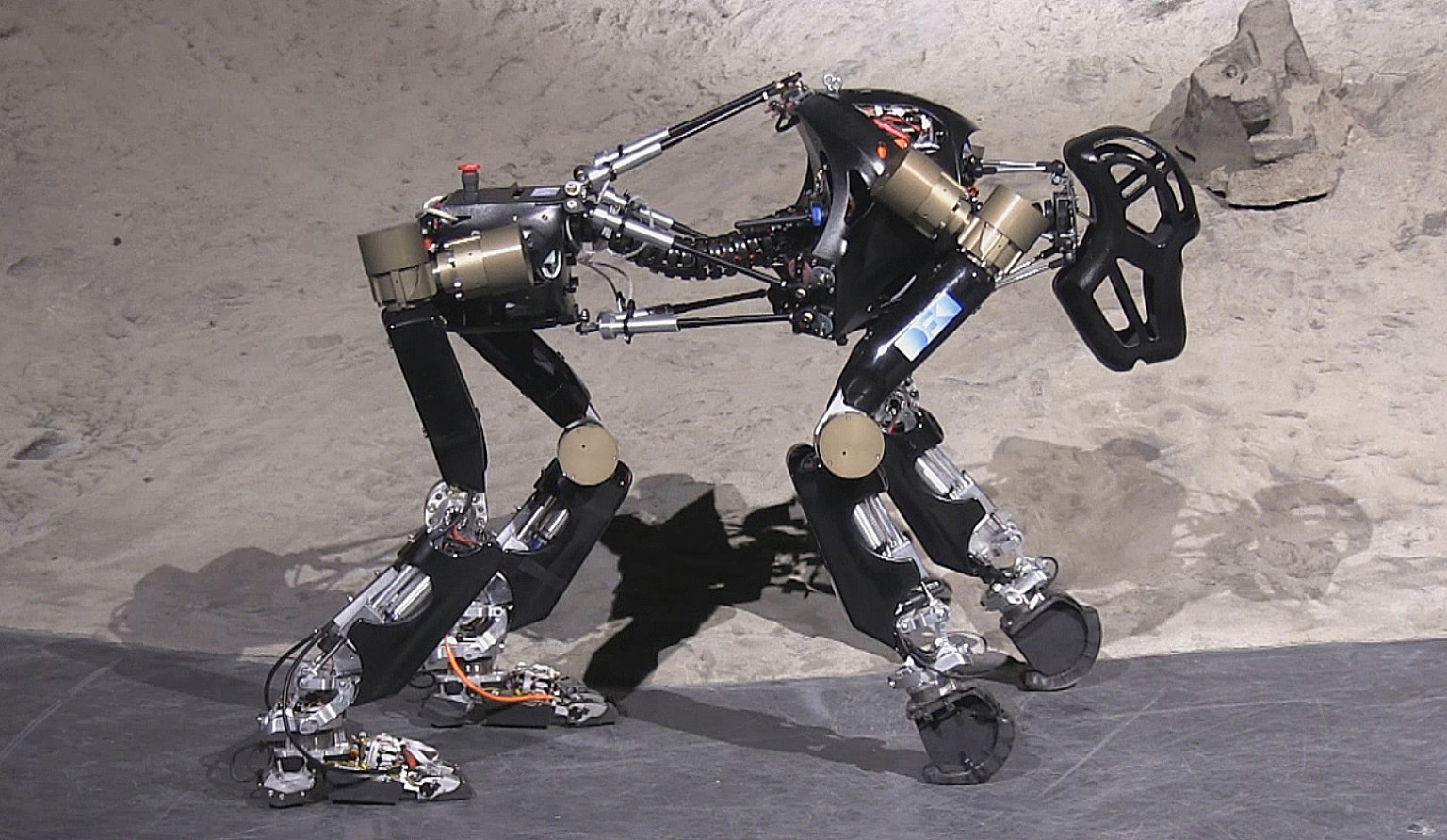

Investigadores de la Universidad de Bremen en Alemania dio a conocer el simio robot – un aparatito de cuatro extremidades que se tambalea a lo largo de su frente “nudillos” y patas traseras. El robot de 40 libras, que tuvo más de tres años en desarrollarse, puede moverse hacia adelante, hacia atrás y hacia los lados – todo ello sin un cable de control. Cuenta con sensores de presión en sus patas traseras, y puede incluso dar vuelta en torno a sí mismo.

Colonizar el espacio con robots es un antiguo argumento de obras de ciencia-ficción, algo que podrían hacer realidad en Japón en no demasiado tiempo. La imagen de arriba, a no tardar mucho, podría ser una realidad. De momento hemos enviado sondas y naves espaciales de todo tipo y rovers-laboratorios andarines pero, en el futuro cercano, la cosa irá en aumento de cantidad y calidad.

Por otra parte, quiero pensar que, lo que hace y es capaz de realizar nuestro cerebro creador de pensamientos, nunca será del dominio de la I.A. que, nunca podrán describir o realizar funciones que de manera natural realizan nuestras mentes. ¿Llegarán a tener mentes de verdad los Robots del futuro? ¿Será posible que lleguen a tener sentimientos, a sentir miedo, a poder llorar? ¿Tiene algún sentido que hablemos de semejantes cosas en términos científicos? También podríamos pensar que, la Ciencia, no está capacitada para abordar ciertas cuestiones relacionadas con la complejidad de la Conciencia Humana.

Claro que, por otra parte, no podemos dejar de pensar en el hecho cierto de que, la propia materia parece tener una existencia meramente transitoria puesto que puede transformarse de una forma en otra, de una cosa en otra, e, incluso, puede llegar esa transformación ser tan compleja como para cambiar desde la materia “inerte” hasta el ser consciente.

Incluso la masa de un cuerpo material, que proporciona una medida física precisa de la cantidad de materia que contiene el cuerpo, puede transformarse en circunstancias apropiadas en pura energía (E = mc2) de modo que, incluso la sustancia material parece ser capaz de transformarse en algo con una actualidad meramente matemática y teórica. Dejemos en este caso, la cuántica y otras teorías a un lado para centrarnos en el tema que tratamos de la I.A. y sus posibles consecuencias.

¿Permite la Física actual la posibilidad de una acción que, en principio, sea imposible de simular en un ordenador? Hoy esa respuesta no está disponible y, cuando eso vaya a ser posible, tendríamos que estar en posesión de una nueva Física mucho más avanzada que la actual.

No debemos apartarnos de un hecho cierto: Nuestra Mente, aunque está apoyada por un ente físico que llamamos cerebro y recibe la información del exterior a través de los sentidos, también es verdad que, de alguna manera, sale de nosotros, está fuera de nuestros cuerpos y, viaja en el tiempo y en el espacio, aprende y conoce nuevos lugares, nuevas gente, nuevos conocimientos de su entorno y de entornos lejanos y, a todos ellos, sin excepción, se puede trasladar de manera incorpórea con un simple pensamiento que, de manera instantánea, nos sitúa en este o aquel lugar, sin importar las distancias que nos puedan separar.

Así La parte física y la parte mental, aunque juntas, están separadas de una manera muy real y, desde luego, existe una clara divisoria entre lo físico y lo mental que ocupan distintos dominios de alcance también distintos y, hasta donde pueda llegar el dominio mental ¡No se conoce!

Circuitos y conexiones de infinita potencia. Ahí están encerrados otros mundos de inimaginable belleza, agujeros negros gigantes, púlsares y quásares, estrellas de neutrones y fantásticas nebulosas de increíbles figuras de las que surgen sin cesar nuevas estrellas y nuevos mundos. También ahí residen pensamientos y recuerdos y, hasta es posible rememorizar imágenes nunca vistas de universos paralelos… ¿Cómo son posible todas esas maravillas? Y, ante esa poderosa “herramienta”, me pregunto, podrá alguna vez, la Inteligencia Artificial hacer algo parecido.

El futuro es incierto

Quisiera pensar que, el humano, siempre prevalecerá sobre el “ser Artificial”, sin embargo, tal optimismo, si pensamos en hacerlo real, nunca podrá estar a nuestro alcance. La evolución de la Ciencia, las necesidades de nuestra especie, las exigencias de una Sociedad creciente que llena el planeta hasta límites insoportables…Todo eso, nos llevará a seguir procurando ayuda de ese “universo artificial” que, al fin y a la postre, es la única salida que tenemos para poder llegar a otros mundos en los que poder alojarnos para que, el planeta Tierra, no se vea literalmente asfixiado por la superpoblación. Así que, siendo las cosas así (que lo son), estamos irremisiblemente abocados a ese futuro dominado por la I.A. que, si tenemos suerte, nos dejará convivir con ella y, si no la tenemos… Muy cruda.

Así que, el día que los Robots sean equiparables a los Humanos, ese día, habrá comenzado el principio del fin de la especie que, tan tonta fue, que creó a su propio destructor.

Hay pensamientos que producen miedo

Claro que, para que todo esto llegue a pasar, podrían transcurrir siglos. No parece que sea muy factible que una simulación realizada por un Robot avanzado pueda ser semejante a lo que un Humano puede hacer hoy. Sin embargo, cuando los ordenadores y Robots hayan alcanzando la inteligencia de pensamiento y discurrir del cerebro Humano, ese día, amigos míos, no creo que sea un día para celebrar.

Claro que, la idea de poner unir nuestras mentes a esos “Seres”, podría ser una salida, una solución híbrida para paliar nuestras carencias de salir al espacio exterior por nosotros mismos y dentro de la frágil coraza humana que contiene a nuestras Mentes pensantes que, dentro de tan ligera y débil estructura, no tienen la seguridad suficiente para realizar ciertas tareas.

…Si llegan a controlar el átomo y la luz…

No quiero ser pesimista ni llevar a vuestro ánimo ideas intranquilizadoras. Sin embargo, si la cosa sigue adelante por el camino emprendido, el futuro que nos espera será ese: Convivir con los Robots, emitir leyes para su control, tratar de que hagan sólo aquellos trabajos y tareas encomendadas pero, ¿cómo podremos evitar que, algún día, más evolucionados al exigirle cada vez más complejidad en las ayudas que nos tendrán que prestar, comiencen a pensar por sí mismos?

Así que, como estamos dando a esos Robots el “Conocimiento”, la “Comprensión”, la “Consciencia” y, la “Inteligencia”, lo estamos haciendo partícipes y están tomando posesión, de los bienes más valiosos que podemos poseer y, tal dislate…¡Podríamos pagarlo muy caro!

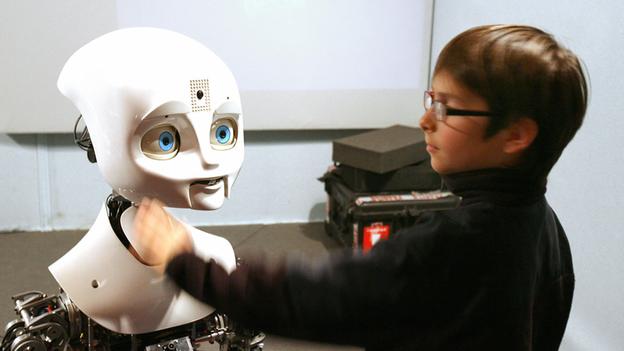

La escena no me gusta nada y, sin embargo, podría ser un escenario cotidiano del futuro

- “Un Robot no puede hacer daño a un ser humano o, mediante la inacción que un ser humano sufra daños”

- “Un Robot debe de obedecer las ordenes dadas por los seres humanos, salvo que esto provoque un conflicto con la primera ley”

- “Un Robot debe proteger su propia existencia, a no ser que provoque un conflicto con las dos primeras”

Estas leyes fueros enunciadas por Isaac Asimos con el objetivo de intentar que la finalidad inicial para la que se originó la robótica no fuera modificada y eso ocasionara problemas a la humanidad. Sin embargo…

Nuestros sueños e conquistar el Espacio exterior y de poblar otros mundos, hace más de 50 años que se puso en marcha. Desde entonces, hemos enviado aparatos más o menos sofisticados lejos de la Tierra y, nos han enviado información de Mercurio, de Venus y Marte, de Saturno y Júpiter, de las Lunas que, como Io, Titán, Encelado, Ganímedes Europa y otras pueden tener algún interés científico para el futuro de la Humanidad. Estos “artilugios” guiados desde nuestro planeta, nos envían imágenes de lugares que nunca pudimos imaginar.

Así, las máquinas pueden hacer lo que nosotros no podemos y “ellas” no duermen ni comen y, cuando no puedan obtener energía del propio Sol, lo harán de pilas atómicas que durarán cientos de años. La radiación del espacio no les afecta y la falta de gravedad tampoco. Ellos tendrán todos los atributos que nos faltan para conquistar el espscio, y… ¿De nosotros que será?

La pregunta queda en el aire, toda vez que, en este momento, nadie la sabe contestar.

emilio silvera

Oct

12

¿Hacia donde vamos?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (1)

Comments (1)

Cuando se lee un buen libro, se saborean sus pasajes más interesantes y, al final, sientes un poco de pena porque aquello se termine tan pronto. Sientes que quieres más, te quedas algo insatisfecho de no haber podido llegar más lejos, de profundicar más en aquello que tánto llamó tu atención y despertó tu curiosidad. Saber sobre aquello que te preocupa es tan vital para la mente que, cuando no puedes desarrollar ciertos pemnsamientos por falta de conocimientos, te sientes frustado y, de alguna manera, sufres por no saber.

Habiendo finalizado la lectura de Las sombras de la Mente, de Roger Penrose, en la que nos habla de la posibilidad de comprender de forma científica lo que la conciencia es y, extrapola dicha conciencia, hasta ese otro mundo de la I.A., en el que, si nada lo remedia, estamos inmersos hasta tal punto que, en el futuro más o menos lejano, será lo que predomine tanto aquí en la la Tierra, como en los mundos y lunas que nos acompañan en el Sistema solar, e, incluso, mucho más allá. Ellos serán, los Robots, los que surquen los cielos y el espacio interestelar en busca de las estrellas.

Es posible que podamos llegar a los límites de la realidad pero… ¿No crearemos una nueva raza para que, sin nosotros saberlo nos suplante en el futuro?

La computación y el Pensamiento consciente

En los últimos tiempos, mucho es lo que se habla de la I.A., y, algunos, nos preguntamos: ¿Será posible que en un futuro más o menos lejano, eso que llamamos Inteligencia Artificial, nos pueda superar?

Hay corrientes en ese sentido que nos llevan a pensar y, ¿por qué no? A preocuparnos profundamente. Si hacemos caso de esas afirmaciones (quizá algo extremas pero, con visos de verdad) de los que defienden a capa y espada el futuro de la I.A., diciendo que, con el tiempo, los ordenadores y los robots superarán a los humanos en inteligencia al llegar a tener todas y cada una de las capacidades humanas y otras que, los humanos nunca podrán tener. Entonces, estos ingenios serían capaces de hacer muchísimo más que ayudar simplemente a nuestras tareas inteligentes.

De hecho, tendrían sus propias y enormes inteligencias. Podríamos entonces dirigirnos a estas inteligencias superiores en busca de consejo y autoridad en todas las cuestiones complejas y de interés que, por nosotros mismos, no pudiéramos solucionar; ¡y finalmente podrían resolver los problemas del mundo que fueron generados por la Humanidad!

Alan Turing estaba convencido de que algún día, las máquinas serían tan inteligentes como los humanos. Y para demostrarlo, inventó el Test de Turing, en 1950. El Test de Turing se basa en la idea de que si no puedes distinguir las respuestas de un programa frente a las de un humano, entonces es porque la inteligencia artificial es tan inteligente como nosotros.

Así se empieza pero… ¿Cómo acaba?

La Nasa ha fabricado un robot que pesa 150 kilogramos, tiene aspecto humanoide y se llama Robonaut-2 (R-2 para los amigos). Este androide será lanzando al espacio y pronto será el nuevo compañero de los tripulantes de la Estación Espacial Internacional. Por algo se comienza y, nunca se sabe como todo terminará.

Pero, si todo eso fuera así (que podría llegar a serlo), podríamos extraer otras consecuencias lógicas de estos desarrollos potenciales de la I.A. que muy bien podría generar una cierta alarma muy justificada ante una situación tan atípica, en la que, unos “organismos” artificiales creados por nosotros mismos, nos superen y puedan llegar más lejos de lo que nosotros, podríamos ser capaces de llegar nunca. ¿No harían estos ordenadores y Robots, a la larga, que los Humanos fueran superfluos para ellos?

Si los Robots guiados por ordenadores insertados en sus cerebros positrónicos o espintrónicos, o, guiados por un enorme y potente Ordenador Central, resultaran ser muy superiores a nosotros en todos los aspectos, entonces, ¿no descubrirían que pueden dirigir el mundo sin necesidad alguna de nosotros? La propia Humanidad se habría quedado obsoleta. Quizá, si tenemos suerte, ellos podrían conservarnos como animales de compañía (como alguien dijo en cierta ocasión); o, si somos inteligentes, podríamos ser capaces de transferir las “estructuras de información” que somos “nosotros mismos” a una forma de robot (como han pensado algunos otros), o quizá no tengamos esa suerte y no lleguemos a ser tan inteligentes…

Investigadores de la Universidad de Bremen en Alemania dio a conocer el simio robot – un aparatito de cuatro extremidades que se tambalea a lo largo de su frente “nudillos” y patas traseras. El robot de 40 libras, que tuvo más de tres años en desarrollarse, puede moverse hacia adelante, hacia atrás y hacia los lados – todo ello sin un cable de control. Cuenta con sensores de presión en sus patas traseras, y puede incluso dar vuelta en torno a sí mismo.

Colonizar el espacio con robots es un antiguo argumento de obras de ciencia-ficción, algo que podrían hacer realidad en Japón en no demasiado tiempo. La imagen de arriba, a no tardar mucho, podría ser una realidad. De momento hemos enviado sondas y naves espaciales de todo tipo y rovers-laboratorios andarines pero, en el futuro cercano, la cosa irá en aumento de cantidad y calidad.

Por otra parte, quiero pensar que, lo que hace y es capaz de realizar nuestro cerebro creador de pensamientos, nunca será del dominio de la I.A. que, nunca podrán describir o realizar funciones que de manera natural realizan nuestras mentes. ¿Llegarán a tener mentes de verdad los Robots del futuro? ¿Será posible que lleguen a tener sentimientos, a sentir miedo, a poder llorar? ¿Tiene algún sentido que hablemos de semejantes cosas en términos científicos? También podríamos pensar que, la Ciencia, no está capacitada para abordar ciertas cuestiones relacionadas con la complejidad de la Conciencia Humana.

Claro que, por otra parte, no podemos dejar de pensar en el hecho cierto de que, la propia materia parece tener una existencia meramente transitoria puesto que puede transformarse de una forma en otra, de una cosa en otra, e, incluso, puede llegar esa transformación ser tan compleja como para cambiar desde la materia “inerte” hasta el ser consciente.

Incluso la masa de un cuerpo material, que proporciona una medida física precisa de la cantidad de materia que contiene el cuerpo, puede transformarse en circunstancias apropiadas en pura energía (E = mc2) de modo que, incluso la sustancia material parece ser capaz de transformarse en algo con una actualidad meramente matemática y teórica. Dejemos en este caso, la cuántica y otras teorías a un lado para centrarnos en el tema que tratamos de la I.A. y sus posibles consecuencias.

¿Permite la Física actual la posibilidad de una acción que, en principio, sea imposible de simular en un ordenador? Hoy esa respuesta no está disponible y, cuando eso vaya a ser posible, tendríamos que estar en posesión de una nueva Física mucho más avanzada que la actual.

No debemos apartarnos de un hecho cierto: Nuestra Mente, aunque está apoyada por un ente físico que llamamos cerebro y recibe la información del exterior a través de los sentidos, también es verdad que, de alguna manera, sale de nosotros, está fuera de nuestros cuerpos y, viaja en el tiempo y en el espacio, aprende y conoce nuevos lugares, nuevas gente, nuevos conocimientos de su entorno y de entornos lejanos y, a todos ellos, sin excepción, se puede trasladar de manera incorpórea con un simple pensamiento que, de manera instantánea, nos sitúa en este o aquel lugar, sin importar las distancias que nos puedan separar.

Así La parte física y la parte mental, aunque juntas, están separadas de una manera muy real y, desde luego, existe una clara divisoria entre lo físico y lo mental que ocupan distintos dominios de alcance también distintos y, hasta donde pueda llegar el dominio mental ¡No se conoce!

Circuitos y conexiones de infinita potencia. Ahí están encerrados otros mundos de inimaginable belleza, agujeros negros gigantes, púlsares y quásares, estrellas de neutrones y fantásticas nebulosas de increíbles figuras de las que surgen sin cesar nuevas estrellas y nuevos mundos. También ahí residen pensamientos y recuerdos y, hasta es posible rememorizar imágenes nunca vistas de universos paralelos… ¿Cómo son posible todas esas maravillas? Y, ante esa poderosa “herramienta”, me pregunto, podrá alguna vez, la Inteligencia Artificial hacer algo parecido.

El futuro es incierto

Quisiera pensar que, el humano, siempre prevalecerá sobre el “ser Artificial”, sin embargo, tal optimismo, si pensamos en hacerlo real, nunca podrá estar a nuestro alcance. La evolución de la Ciencia, las necesidades de nuestra especie, las exigencias de una Sociedad creciente que llena el planeta hasta límites insoportables…Todo eso, nos llevará a seguir procurando ayuda de ese “universo artificial” que, al fin y a la postre, es la única salida que tenemos para poder llegar a otros mundos en los que poder alojarnos para que, el planeta Tierra, no se vea literalmente asfixiado por la superpoblación. Así que, siendo las cosas así (que lo son), estamos irremisiblemente abocados a ese futuro dominado por la I.A. que, si tenemos suerte, nos dejará convivir con ella y, si no la tenemos… Muy cruda.

Así que, el día que los Robots sean equiparables a los Humanos, ese día, habrá comenzado el principio del fin de la especie que, tan tonta fue, que creó a su propio destructor.

Hay pensamientos que producen miedo

Claro que, para que todo esto llegue a pasar, podrían transcurrir siglos. No parece que sea muy factible que una simulación realizada por un Robot avanzado pueda ser semejante a lo que un Humano puede hacer hoy. Sin embargo, cuando los ordenadores y Robots hayan alcanzando la inteligencia de pensamiento y discurrir del cerebro Humano, ese día, amigos míos, no creo que sea un día para celebrar.

Claro que, la idea de poner unir nuestras mentes a esos “Seres”, podría ser una salida, una solución híbrida para paliar nuestras carencias de salir al espacio exterior por nosotros mismos y dentro de la frágil coraza humana que contiene a nuestras Mentes pensantes que, dentro de tan ligera y débil estructura, no tienen la seguridad suficiente para realizar ciertas tareas.

No quiero ser pesimista ni llevar a vuestro ánimo ideas intranquilizadoras. Sin embargo, si la cosa sigue adelante por el camino emprendido, el futuro que nos espera será ese: Convivir con los Robots, emitir leyes para su control, tratar de que hagan sólo aquellos trabajos y tareas encomendadas pero, ¿cómo podremos evitar que, algún día, más evolucionados al exigirle cada vez más complejidad en las ayudas que nos tendrán que prestar, comiencen a pensar por sí mismos?

Así que, como estamos dando a esos Robots el “Conocimiento”, la “Comprensión”, la “Consciencia” y, la “Inteligencia”, lo estamos haciendo partícipes y están tomando posesión, de los bienes más valiosos que podemos poseer y, tal dislate…¡Podríamos pagarlo muy caro!

- “Un Robot no puede hacer daño a un ser humano o, mediante la inacción que un ser humano sufra daños”

- “Un Robot debe de obedecer las ordenes dadas por los seres humanos, salvo que esto provoque un conflicto con la primera ley”

- “Un Robot debe proteger su propia existencia, a no ser que provoque un conflicto con las dos primeras”

Estas leyes fueros enunciadas por Isaac Asimos con el objetivo de intentar que la finalidad inicial para la que se originó la robótica no fuera modificada y eso ocasionara problemas a la humanidad. Sin embargo…

Nuestros sueños e conquistar el Espacio exterior y de poblar otros mundos, hace más de 50 años que se puso en marcha. Desde entonces, hemos enviado aparatos más o menos sofisticados lejos de la Tierra y, nos han enviado información de Mercurio, de Venus y Marte, de Saturno y Júpiter, de las Lunas que, como Io, Titán, Encelado, Ganímedes Europa y otras pueden tener algún interés científico para el futuro de la Humanidad. Estos “artilugios” guiados desde nuestro planeta, nos envían imágenes de lugares que nunca pudimos imaginar.

Así, las máquinas pueden hacer lo que nosotros no podemos y “ellas” no duermen ni comen y, cuando no puedan obtener energía del propio Sol, lo harán de pilas atómicas que durarán cientos de años. La radiación del espacio no les afecta y la falta de gravedad tampoco. Ellos tendrán todos los atributos que nos faltan para conquistar el espscio, y… ¿De nosotros que será?

La pregunta queda en el aire, toda vez que, en este momento, nadie la sabe contestar.

emilio silvera

Mar

29

Nanofotónica: luz + nanopartículas = Futuro tecnológico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (1)

Comments (1)

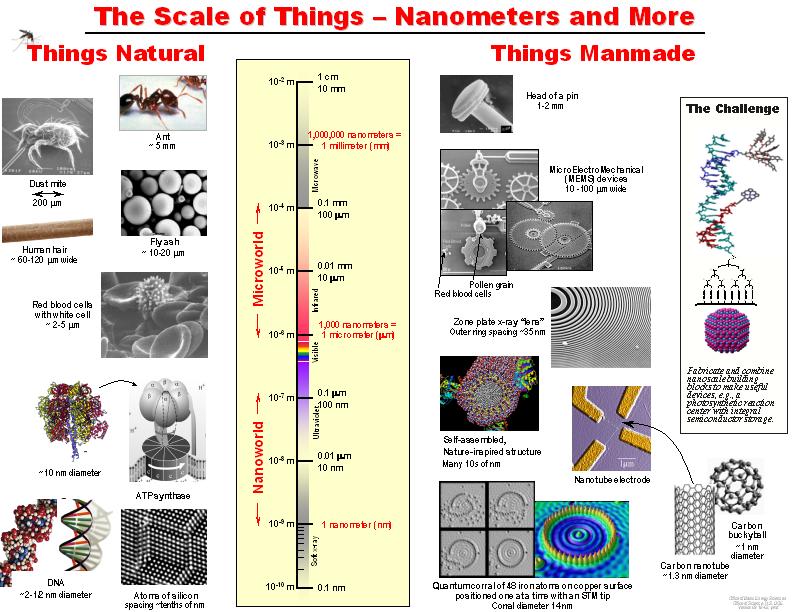

Han pasado ya cincuenta años desde que Richard Feynman dictara su famosa charla: There is plenty of room at the bottom: An invitation to enter a new field of physics (Hay suficiente espacio en el fondo: Una invitación a entrar en un campo en la Física). En ella estableció que las leyes de la Física no impiden manipular las cosas átomo a átomo; –es algo que se pero no se ha hecho debido a que somos demasiado grandes hacerlo-.

Desde entonces se ha estado buscando la manera de poder diseñar los materiales átomo a átomo. De hecho, los materiales nanoestructurados ya han sido utilizados en aplicaciones prácticas, siendo importantes en nuestra vida diaria. El color rojo de los vitrales en las catedrales góticas de Europa se obtenía utilizando nanopartículas de oro; la película fotográfica utiliza nanopartículas de plata; los bloqueadores solares utilizan nanopartículas de dióxido de titanio y de zinc como parte activa. El primer caso es una aplicación del efecto nano del oro y es quizás la primera aplicación de la nanotecnología. Quizás el mayor desarrollo de las nanoestructuras se dio con el descubrimiento de la microscopia de fuerza atómica ya que con esta se podía manipular a los átomos o partículas muy pequeñas. Hoy día, la investigación en el campo de los materiales nanoestructurados se ha multiplicado y sus aplicaciones abarcan todas las disciplinas convirtiendo a la nanotecnología en un campo interdisciplinario. Muchos países han implementado programas especiales para la investigación en este campo invirtiendo grandes cantidades de dinero. La apuesta puede ser de alto riesgo, pero el premio promete ser enorme.

Richard Feynman

Hoy día se estima el mercado de la nanotecnología en cientos de miles de millones de dólares. Nuestro país también ha apoyado la iniciativa aunque en menor proporción. De hecho la nanotecnología no es una prioridad dentro de nuestro sistema de investigación, no hay programas especiales de apoyo económico en este tópico y se compite por igual con todas las áreas. Con pocos recursos económicos se tiene poca infraestructura y en general grupos pequeños lo que dificulta la capacidad para competir. Aún con estas limitaciones, se han obtenido excelentes resultados y hay grupos en nuestro país que cuentan con reconocimiento internacional.

Materiales nanoestructurados y nanotecnología

Los materiales nanoestructurados (NEMs, por siglas en inglés) han despertado rápidamente un gran interés debido a la diversidad de sus aplicaciones. De acuerdo a la definición más aceptada, los materiales nanoestructurados son aquellos en los que por lo una de sus dimensiones se encuentra en el rango de 1-100 nm. Es decir, los NEMs son tres órdenes de magnitud más pequeños que los MEMS (sistemas microelectromecánicos, por sus siglas en inglés), e incluyen nanopartículas, nanocristales, nanoalambres, nanobarras, nanotubos, nanofibras, nanoespumas, etc. Los NEMs pueden ser semiconductores, dieléctricos, metales, orgánicos, inorgánicos, aleaciones, biomateriales, biomoléculas, oligómeros, polímeros, etc.

Nos sorprendería saber en qué lugares están presentes los cristales fotónicos con las nuevas técnicas alcanzadas en la nanotecnología

Aunque existen sistemas nanoestructurados de dimensiones mayores son los cristales fotónicos. En el rango de nanómetros, los materiales presentan propiedades ópticas, eléctricas, magnéticas y mecánicas únicas y totalmente diferentes de los materiales en el rango de los micrómetros o milímetros llamados también materiales en bulto.

tener una idea de que tan pequeño es un nanómetro podemos mencionar que un milímetro tiene un millón de nanómetros; el diámetro del cabello humano mide 10,000 y 50,000 nanómetros; los glóbulos rojos y blancos miden entre 2 y 5 nanómetros mientras que el ADN mide 2.5 nanómetros.

Los superátomos de silicio pueden formar, por ejemplo, nanotubos. Además, se les agregar un metal de transición con el objetivo de cambiar sus propiedades eléctricas, lo que se denomina dopaje. Cuando el superátomo es de anión (tiene carga eléctrica negativa, le sobran electrones), “se le dopa con un metal alcalino, como el potasio”, que tiene un electrón en su nivel energético más externo. Del mismo modo, cuando son cationes (con carga negativa, al perder electrones) se les dopa con un metal halógeno, que necesita un electrón más completar su último nivel energético.

Las propiedades de los NEMs son dominadas por los efectos de superficie mientras que las de los materiales en bulto son debidas a un efecto de volumen. La tecnología su producción y uso se ha convirtiendo en una industria muy poderosa: la nanotecnología. La nanotecnología es la ciencia e ingeniería de producir materiales o estructuras funcionales de unos cuantos nanómetros. Es la tecnología del futuro con la cual se desarrollarán los nuevos materiales y dispositivos. Las aplicaciones son sorprendentes así como variadas, por ejemplo, la industria optoelectrónica y fotónica, biomedicina, sensores, celdas solares y de combustible, catálisis, memorias ópticas, procesadores de computadoras, fotodetectores, herramientas de corte, industria aeronáutica, moduladores e interruptores, cosméticos, etc. Aunque todas las aplicaciones son de gran interés, sin duda alguna las aplicaciones en sistemas biológicos son las más sobresalientes. Especialmente las aplicaciones de las propiedades ópticas de los sistemas nanoestructurados.

La Tecnología fundamental del siglo XXI: Nano Tecnología

Uno de sus apartados es la Nanofotónica

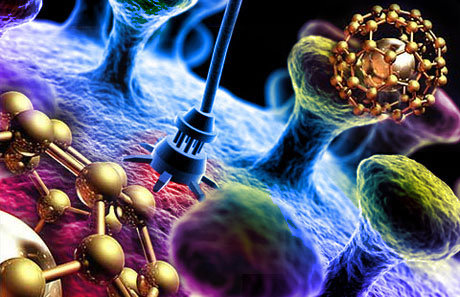

Esas nuevas formas, la nanotecnología, entrará en el “universo” de la mecánica cuántica, en el mundo infinitesimal, y, se lograrán cosas que , serían impensables. Posiblemente, la primera visita que hagamos a un mundo habitado por otros seres, estará tripulada por seres nanotecnológicos que, al igual que la misma nave, tengan medidas tan pequeñas que serán imposibles de observar y, sin embargo, estarán dotadas de adelantos tales que, podrán medir, evaluar, estudiar, captar imágenes, enviar por medios desconocidos, y, en fin, serán las avanzadillas de lo que irá después, la visita de humanos a otros mundos.

La nanofotónica es la fusión de la nanotecnología y la fotónica. Es un campo multidisciplinario que estudia las propiedades ópticas de los sistemas nanoestructurados y la interacción luzmateria a nivel nanoscópico. Ya mencionamos que las propiedades ópticas de las nanopartículas son dominadas por los efectos de superficie. Así, controlando el tamaño de las nanopartículas o nanoestructuras podemos controlar o amplificar ciertas propiedades de los sistemas bajo estudio. En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas.

La Nanotecnología marcará nuestro futuro. De ella partirán las nuevas ideas e instrumentos, los nuevos modos de construir lo que queda por venir, nuevas maneras de sondear el espacio “infinito”, de curar enfermedades, de sustituir órganos vitales, de construir robots.

Curiosamente, existe una creencia bastante arraigada en amplios sectores de la comunidad científica de que la fotónica (conjunto de tecnologías relacionadas con la luz) es un campo que cae fuera del universo de la nanotecnología. La creencia se apoya en el clásico criterio de Rayleigh de que la resolución espacial de un sistema óptico está limitada por la longitud de onda de la luz (≈ 500 nm), y por ello es próxima al micrómetro, muy lejos de los requisitos de la nanotecnología.

Yo, por mi , estimo que división es sin duda errónea, y hoy en día la fotónica está íntimamente implicada con la nanotecnología, e incluso se hablar propiamente de nanofotónica, de igual manera que se hablar de nanoelectrónica o de nanomagnetismo.

sepamos conectar de manera conveniente todas las disciplinas del sabe Humano… ¡Las cosas cambiaran!

Decía que: “En general, las nanoestructuras pueden ser de tres tipos, semiconductoras, dieléctricas y metálicas”. una de ellas produce fenómenos de especial interés interactúan con una señal óptica, pudiendo así ser aplicadas en diferentes campos. Un campo de especial interés es la biología.

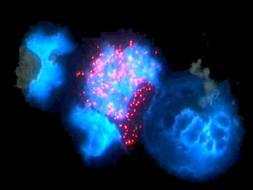

El estudio de las propiedades luminiscentes de sistemas nanoestructurados en sistemas biológicos es el campo de estudio de la bionanofotónica. Especialmente trata sobre el estudio de sistemas nanoestructurados en aplicaciones biomédicas. Diferentes nanopartículas han sido propuestas para ser utilizadas en la detección de bajas concentraciones de diferentes elementos como células cancerigenas, virus, ADN, ARN, proteínas, etc. También han sido utilizadas para la entrega de medicamentos en dirigida y controlada así como para la destrucción de tumores cancerigenos. En la última década, los avances han sido sorprendentes pero aún hay mucho por hacer. En el CIO, durante los últimos 6 años hemos trabajando en la síntesis de nanopartículas y estudiado sus propiedades ópticas a fin de poder ser utilizadas en distintas aplicaciones.

Las propiedades luminescentes de nuestras nanopartículas son muy interesantes y prometen grandes oportunidades de aplicación en diferentes áreas.

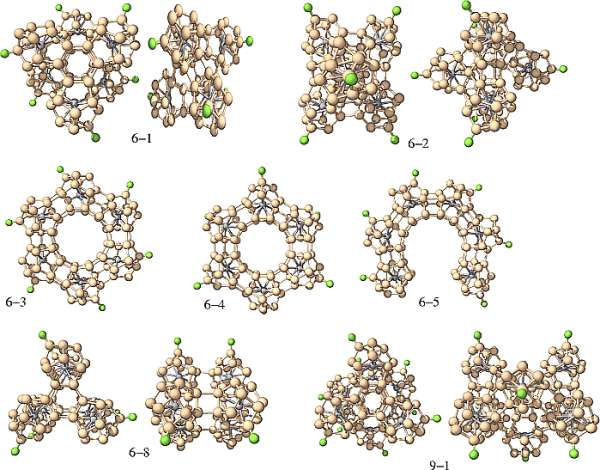

Nanopartículas semiconductoras o puntos cuánticos

Los nanocristales semiconductores también llamados puntos cuánticos son nanoestructuras a base de materiales semiconductores inorgánicos y representan el grupo donde el efecto del tamaño es más evidente. El tamaño nano da lugar a lo que se conoce confinamiento cuántico, que no es más que la localización de los electrones en un espacio bien definido, es poner un electrón en una caja. Mientras que tamaños mayores los electrones están no localizados. El confinamiento produce un ensanchamiento de la banda de energía prohibida del semiconductor así la aparición de sub-bandas discretas en la banda de valencia y de conducción. Las dimensiones típicas oscilan uno y diez nanómetros.

Con frecuencia se les describe como átomos artificiales debido a que los electrones están dimensionalmente confinados como en un átomo y sólo se tiene niveles de energía discretos. las nanoestructuras más estudiadas se encuentran las de CdSe/ZnS, CdSe/CdS, InP/ZnSe, CdTe/CdSe, entre otras. El resultado más vistoso de estas nanoestructuras es la capacidad poder sintonizar la longitud de onda o color de la emisión.

Así, con un solo material y variando el tamaño de la nanopartícula es posible obtener múltiples colores o longitudes de onda de la señal emitida. Las aplicaciones son impresionantes y apuntan en todas las direcciones. Por ejemplo, podrían ser utilizados como colorantes inorgánicos sin problemas de degradación a diferencia de los colorantes orgánicos. También podrían ser utilizados en el diseño de los nuevos amplificadores ópticos de amplio ancho de banda tan importantes en los sistemas de comunicación óptica; en este caso nanopartícula con un diámetro determinado funcionaría como un amplificador, así el ancho de banda se determina con la selección adecuada de los diámetros de las partículas. O bien la producción de fuentes de luz blanca mediante excitación con un LED u OLED o por electroluminiscencia.

Quizás una de las aplicaciones que mayor atención ha recibido es en su uso como etiquetas fluorescentes con emisión en la región visible del espectro, para la detección de una gran variedad de compuestos entre ellas células cancerigenas. Las técnicas actuales no detectan bajas concentraciones de células cancerigenas o compuestos de interés, por lo que la técnica de detección de fluorescencia de nanopartículas es una gran promesa para la detección temprana de este mal, para así incrementar el éxito en el tratamiento. Dado el tamaño tan pequeño de los puntos cuánticos actualmente se intenta desarrollar nanoestructuras más complejas formadas por puntos cuánticos o nanocristales acomplejados con diferentes componentes que desempeñan distintas funciones, detección, entrega de medicamento dirigido, efecto de la terapia, etc. Es decir, se busca una nanoestructura inteligente con múltiples funciones. El problema que presentan los puntos cuánticos es que son poco estables ya que tienden a aglomerarse, además de que se excitan con una fuente de luz UV donde la mayoría de los compuestos que se pueden encontrar en interior del cuerpo humano emiten luz lo que significa pérdida de contraste en la imagen de la célula deseada.

Nanopartículas dieléctricas o nanocristales

Los nanocristales dieléctricos son óxidos que presentan una banda de energía prohibida muy ancha y como consecuencia requieren altas energías de bombeo o luz en el UV obtener emisión que en general es débil, aunque cuando se combina en adecuadacon diversos componentes son excelentes emisores de luz debido a su eficiencia y alta estabilidad. Son excelentes matrices soportar iones de tierras raras que son muy buenos emisores de luz. En este caso no se observan efectos de confinamiento debido a que los electrones se encuentran localizados en orbitales atómicos del ion activo. Sin embargo, la dinámica de los iones emisores de luz se ve afectada por la interacción a nivel nanoscópico lo que producir una mejora en la eficiencia de emisión.

los nanocristales mas estudiados se encuentran algunos silicatos como Y2SiO5, la combinación nY2O3 + mAl2O3 que comprende puramente el óxido de itria, puramente el óxido de aluminio, cuando se combinan con n=3 y m=5 da lugar a la estructura cristalina mas utilizada en óptica producir láseres conocida como YAG, o YAP la combinación n=m=1 que corresponde a uno de los cristales mas sensibles a laradiación ionizante y que es utilizado para la detección de rayos X o rayos gama. El óxido de titanio (TiO2) y el óxido de zinc (ZnO) que se utilizan en los bloqueadores solares además de ser excelentes para los procesos de fotocatálisis, útiles en la reducción de contaminantes, para celdas solares y como bactericida.

Recientemente, hemos demostrado que el óxido de zirconio (ZrO2) combinado con otros elementos bloquea el rango completo de la luz ultravioleta, especialmente aquella región que produce el . Este mismo nanocristal presenta excelente respuesta en la detección de radiación ionizante, UV, rayos X, gama, beta y alfa, tanto en tiempo real como en acumulada lo que sugiere buenas oportunidades para su uso en el diseño de dosímetros para la cuantificación de dosis recibidas.

Además, es excelente soporte para iones de tierras raras, con las cuales hemos obtenido luz visible (azul, verde y rojo) excitando con una fuente en el cercano infrarrojo. Ya que con fuente solo se excitan los nanocristales no hay emisión de fondo lo que mejora el contraste de las imágenes obtenidas. Estas características convierten a estos nanocristales en excelentes candidatos en aplicaciones biomédicas para la detección de diversos elementos a concentraciones bajas. La fabricación de estos nanocristales implica un tratamiento térmico para el proceso de oxidación lo que induce un tamaño de partícula grande. Se han reportado tamaños de partícula 10 a 90 nm.

Lo curioso es que en todo, siempre está la Luz presente

Muchas veces se obtienen cristales muy pequeños pero con poca eficiencia de emisión, el reto es obtener mayor eficiencia de emisión sin incrementar demasiado el diámetro de las nanopartículas. Tamaños promedios con los que se han obtenido excelente eficiencia de emisión son 40 y 60 nm.

Nano partículas metálicas, plasmones.

Las nanopartículas metálicas tienen la habilidad de esparcir y absorber la luz incidente. En caso, los efectos en las propiedades ópticas respecto a su contraparte en bulto se derivan de los efectos electrodinámicos y de la modificación del ambiente dieléctrico. A escala nanométrica la frontera metaldieléctrico produce cambios considerables en las propiedades ópticas.

resultado de la interacción la nanopartícula metálica y la señal óptica se obtiene la oscilación colectiva de electrones de superficie lo que genera bandas de resonancia conocidas como plasmones localizados o plasmones de superficie localizados. La longitud de onda o color a la que se obtiene dicha resonancia se le conoce como banda de absorción del plasmón que depende tanto del tamaño como de la de la nanopartícula y es lo que da lugar a la diferente coloración observada. Las nanoestructuras metálicas más conocidas son partículas esféricas, barras y películas con núcleo dieléctrico. Aunque más recientemente se han reportado otras estructuras como cubos, triángulos, estrellas y ovoides. En todos los casos, la banda de resonancia se recorre hacia el cercano infrarrojo en comparación con las nanopartículas esféricas cuya banda centrada en la región verde del espectro.

Los plasmones producen en la interfase un campo eléctrico intensificado que a su vez intensifica varios procesos ópticos lineales y no lineales. El campo eléctrico producido es utilizado como una interfase sensible a las interacciones ópticas y se convierte en una poderosa herramienta el monitoreo óptico y para la formación de imágenes ópticas

localizadas. Una de las aplicaciones establecidas es de superficie mejorada (SERS por sus siglas en inglés). En este caso el espectro Raman de un componente cercano a la superficie metálica se ve fuertemente amplificado. Se ha demostrado que es posible amplificar el campo 11 000 veces más cuando las partículas presentan cierta aglomeración. Otros fenómenos que presentan amplificación son la espectroscopia infrarroja de superficie mejorada, espectroscopia de fluorescencia

y la espectroscopia de resonancia de plasmones de superficie. Todas estas técnicas son complementarias y son utilizadas en la detección de componentes químicos y bioquímicos a nivel de trazas.

Células modificadas y célula cancerigena que la nanofotónica podrá modificar e incluso regenerar en el fiuturo.

Quizás un proyecto más ambicioso es el de poder detectar células cancerigenas a temprana edad de lo cual ya se han reportado importantes avances. En el CIO trabajamos con nanopartículas de oro y plata a fin de desarrollar sensores ópticos la detección de diferentes compuestos a nivel de trazas y estamos aplicado exitosamente nanopartículas deoro en la detección de células cancerigenas.

En resumen, las nanoestructuras presentan propiedades ópticas únicas que no presentan su contraparte en bulto o de escala mayor. Éstas están siendo utilizadas para el desarrollo de la nueva generación de dispositivos optoelectrónicos y/o fotónicos. Las aplicaciones son muy variadas y abarcan muchos campos haciendo de la nanociencia y nanotecnología una área

multidisciplinaria. Especial atención recibe el uso de dichas propiedades en aplicaciones biomédicas para la detección a nivel de trazas de diversos agentes patógenos. El estudio de las propiedades ópticas de las nanoestructuras ha definido una nueva área conocida como nanofotónica.

¡El futuro está aquí!

emilio silvera

Mar

13

Desde el pasado, pasando por el presente y… ¡Hacia el futuro!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (0)

Comments (0)

![[IMG]](http://static.hsw.com.br/gif/synchrotron-1.jpg)

Imagem cedida por Diamond Light Source

Acelerador de partículas construido en las instalaciones del Diamond Ligth Source en Oxfordshire (Inglaterra). Llamado la Fuente luminosa de diamante, el Diamond synchrotron comenzó a funcionar en enero de 2007. La luz que generar este artefacto es 100 mil millones de veces más brillante que un rayo X estándar médico.

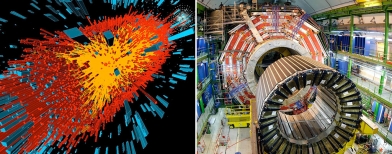

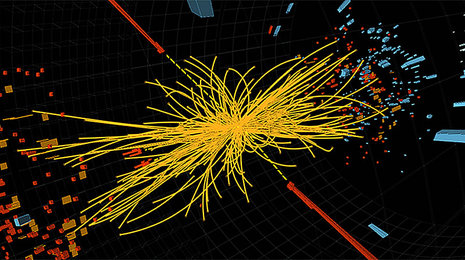

Un acelerador de partículas (como todos sabemos) es, a grandes rasgos, una máquina que mediante campos electromagnéticos acelera partículas hasta que alcanzan velocidades inimaginables. Luego, por ejemplo, hacen chocar estas partículas y así se consigue saber de qué está formada la materia en sus partes más diminutas (mucho más diminutas que un átomo). Eso es lo que hace el LHC.

Sin embargo, en el caso de este acelerador, los científicos esperaban usar la luz del Diamond synchrotron “leer” los textos antiguos que han sufrido el daño significativo. Porque los potentes rayos X permitirán hacerlo sin ni siquiera abrir el libro. El synchrotron emite un rayo X tan poderoso que, al incidir en una voluta, permite producir una imagen de 3-D del texto.

La técnica ya había sido aplicada satisfactoriamente en textos escritos con la tinta de hierro, que los escribanos comenzaron a usar en el siglo XII. Algunas de las tintas hechas con extractos vegetales y sales de hierro utilizadas en el Siglo XII deterioran el de pergamino utilizado, imposibilitando la lectura de documentos valiosos. Simplemente he querido incluir esta introducción para que os hagais una idea de hasta donde puede llegar nuestro ingenio.

(ilustración de un nano robot)

Si hablamos de nuevos inventos en los campos más diversos, nos podríamos sorprender de lo que se ha conseguido en los últimos años que, una “mano robótica” capaz de realizar toda clase de movimientos, “El sexto sentido”, una interfaz gestual portable que permite la interacción los gestos y los movimientos naturales del cuerpo humano con una computadora, o, un Implantes de retina, que devuelve la visión a pacientes con degeneración macular y ceguera mediante implantes microelectrónicos. Entre los últimos inventos dedestaca una variedad de plástico hecha con orina de cerdo y lentes de biónicos. Se inventa un proceso capaz de cultivar parte de un corazón humano a partir de células madre, una máquina que puede imprimir una novela completa de 300 páginas en tan solo 3 minutos y por un costo ínfimo, una batería que funciona con cualquier solución azucarada y enzimas de digestión de glucosa capaz de extraer electrones que crean electricidad…

Las nuevas tecnologías y los inventos que se están produciendo en el diglo XXI, harían abrir la boca por el asombro a los filósofos naturalistas del pasado que trataban de profundizar en el conocimiento de la Naturaleza. Ellos fueron los que pusieron las primeras piedras del Edificio que hoy, llamamos Ciencia.

Corazones e Hígados artificiales, el guante de braille ciegos, o, yendo más allá…

Un “Diente telefónico”. Se trata de un minúsculo implante que se coloca en el diente molar y que mediante un complejo sistema de señales y vibraciones permite recibir llamadas telefónicas. Tejido artificial nanotecnológico, Parche hormonal anticonceptivo, o, esa invención que hace posible que con una pequeña gota nos permite si en una bebida se ha vertido alguna de las llamadas “drogas del depredador” como las GHB o la Ketamina. Estas drogas suelen utilizarse por violadores y secuestradores pues facilitan dicho crimen al desinhibir a la víctima. El “Motor a nanoescala”, lo suficientemente pequeño como para viajar en la espalda de un virus. Un dispositivo que administra medicamentos a través de ondas sonoras que sustituyen las inyecciones, siendo igual de efectivas. Plástico inteligente capaz de modificar su estructura ante la exposición de determinadas longitudes de onda. Un dispositivo móvil creado por Aqua Sciences que permite beber agua del aire. ¿Os imaginais lo que supondrá eso en la travesía de un desierto? INSCENTINEL inventa un sistema de entrenamiento que abejas sean capaces de detectar bombas y explosivos.

Las cosas no llegaron por arte de magia… ¡muchas ideas hicieron falta!

miramos a nuestro alrededor y todo lo que vemos que ocurre nos parece lo normal, que las cosas son así. Sin embargo, habría que pensar -por ejemplo, en el ámbito de la física de partículas- que, el diluvio de estructuras subnucleares que desencadenó “el acelerador” de partículas, fue tan sorprende los objetos celestes que descubrió el telescopio de Galileo. Lo mismo que pasó con la revolución galileana, con la venida de los aceleradores de partículas, la Humanidad adquirió unos conocimientos nuevos e insospechados acerca de cómo era el mundo, la naturaleza de la materia.

Que en caso de los aceleradores se refería al “espacio interior” en lugar de al “espacio exterior” no los hacía menos profundos ni menos importantes. El descubrimiento de los microbios y del universo biológico invisible por Pasteur fue un descubrimiento similar y, ya puestos, haremos notar que pocos se acuerdan ya de Demócrito, aquel filósofo sontiente que, tomó prestado de los antiguos hindúes, la idea del á-tomo, la expresión “más pequeña de la materia” que era “indivisible”.

sabemos que Demócrito estaba equivocado y que el átomo, sí se puede dividir. Sin embargo, él señaló un camino y, junto a Empédocles, el que hablaba de “elementos” como agua, aire, fuego y tierra, para significar que eran los componentes, en la debida proporción de todo lo que existía…, junto a otros muchos, nos han traído hasta aquí. Así que, los inventos que antes se mencionaban, no han llegado porque sí, ha sido un largo camino, mucha curiosidad y mucho y, no lo olvidemos: ¡Observar, Imaginar y Experimentar!

Nos dimos y estaba claro que la búsqueda de la menor de las partículas requería que se expandiese la capacidad del ojo humano: primero lupas, después microscopios y, finalmente… ¡Aceleradores! que, utilizando energías inimaginables ( 14 TeV), nos llevaría hasta las entrañas de la materia que tratamos de conocer.

Todos estos experimentos en los aceleradores han posibilitado muchos de los avances que hoy día conocemos en los distintos campos del saber humano. Generalmente, cuando se habla de aceleradores de partículas, todos piensan en el Bosón de Higgs y cosas por el estilo. Sin embargo, las realidades prácticas de dichos ingenios van mucho más allá.

“La “gran ciencia” (big science) genera tecnología, tecnología punta, genera industria, mucha industria, genera riqueza. Los grandes aceleradores de partículas, como el LHC del CERN, son ejemplos perfectos de ello. La tecnología de aceleradores de partículas ha permitido desarrollar dispositivos de implantación iónica que se utilizan para la fabricación de mejores semiconductores, para la fabricación prótesis de rodilla más duraderas, para la fabricación de menos contaminantes, para el desarrollo de nuevas terapias contra el cáncer. Esto último gracias a que lo último de lo último en superimanes superconductores está en los grandes aceleradores. Esta tecnología ha permitido desarrollar y permitirá mejorar los potentes imanes necesarios en el diagnóstico clínico (como en resonancia magnética nuclear) y para terapias contra el cáncer basadas en haces de protones. Nos lo Elizabeth Clements, en “Particle physics benefits: Adding it up,” Symmetry, dec. 2008″ (Francis (th)E mule Science’s News).

Beneficios de la investigación básica en Física de Partículas: La tecnología desarrollada en los aceleradores de partículas tiene beneficios indirectos para la Medicina, la Informática, la industria o el . Los imanes superconductores que se usan para acelerar las partículas han sido fundamentales para desarrollar técnicas de diagnóstico por imagen como la resonancia magnética. Los detectores usados para identificar las partículas son la base de los PET, la tomografía por emisión de positrones (antipartícula del electrón). Y muchos hospitales utilizan haces de partículas terapia contra el cáncer.

Con velocidades 10.000 mayor que una conexión típica, “The Grid” podrá enviar un catálogo completo de información Gran Bretaña a Japón en menos de 2 segundos. Esta red, creada en el centro de física de partículas CERN, puede proveer el poder necesario para transmitir imágenes holográficas; permitir juegos en línea con cientos de miles de personas, y ofrecer una telefonía de alta definición en video al precio de una llamada local

Así, la World Wide Web (WWW), el ‘lenguaje’ en el que se basa Internet, fue creado en el CERN para compartir información entre científicos ubicados alrededor del mundo, y las grandes cantidades de que se producen motivan el desarrollo de una red de computación global distribuida llamada GRID. Los haces de partículas producidos en aceleradores tipo sincrotrón o las fuentes de espalación de neutrones, instrumentos creados para comprobar la naturaleza de la materia, tienen aplicaciones industriales en la determinación de las propiedades de nuevos materiales, así como para caracterizar estructuras biológicas o nuevos fármacos. Otras aplicaciones de la Física de Partículas son la fabricación de , esterilización de recipientes para alimentos o reutilización de residuos nucleares, entre otros muchos campos.

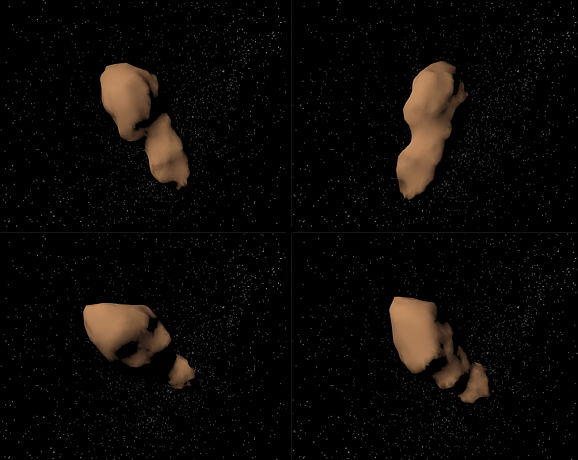

Tambien en el campo de la Astronomía, el LHC, nos ayudar a comprender cosas que ignoramos. Nos henmos preguntado sobre la existencia de estrellas de Quarks-Gluones, y, sobre el tema, algo nos ha dicho ya el Acelerador Europeo de Partículas que trata de llegar hasta “la materia oscura” y algunos otros enigmas que nos traen de cabeza.

No es extraño encontrarnos una mañana al echar una mirada a la prensa del día, con noticias como éstas:

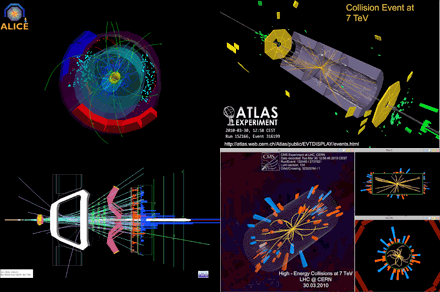

Colisión de iones pesados registrada por el experimento ALICE. (Imagen: CERN.)

El acelerador europeo ha obtenido plasma de quarks–gluones, el primer estado de la materia tras el Big Bang.

“No todo son bosones de Higgs en las instalaciones del CERN. Aún hay muchas preguntas sobre el universo y sus partículas que se pueden responder a de colisiones de alta energía. Y en eso, elLHC es el mejor. Un grupo de investigadores del consorcio europeo ha realizado nuevas mediciones de la que creen que es el primer tipo de materia que hubo durante los instantes iniciales del universo. El plasma de quarks–gluones.

Los quarks y los gluones son, respectivamente, los ladrillos y el cemento de la materia ordinaria. Durante los primeros momentos tras el Big Bang, sin embargo, no estaban unidos constituyendo partículas —como protones o neutrones— sino que se movían libremente en estado de plasma. A base de colisionar iones de plomo —que es un átomo muy pesado— a velocidades cercanas a las de la luz, el LHC pudo recrear durante pequeños lapsos de tiempo las que se creen fueron las de los primeros momentos del universo.

El plasma de quarks–gluones es extremo y efímero. Por eso los investigadores han tenido que analizar los de más de mil millones de colisiones para obtener resultados significativos.”

Evento de colisión de 7 TeV visto por el detector LHCb. El experimento del LHCb en el LHC estará bien ubicado para explorar el misterio de la antimateria. Crédito: LHC, CERN. Ya sabéis que, durante muchos años, la ausencia de antimateria en el Universo ha atormentado a los físicos de partículas y a los cosmólogos: mientras que el Big Bang debería haber cantidades iguales de materia y antimateria, no observamos ninguna antimateria primordial hoy en día. ¿Dónde ha ido? Los experimentos del LHC tienen el potencial de dar a conocer los procesos naturales que podrían ser la clave para resolver esta paradoja.

Cada vez que la materia es creada a partir de energía pura, se genera la misma cantidad de partículas y antipartículas. Por el contrario, cuando la materia y la antimateria se encuentran, se aniquilan mutuamente y producen luz. La antimateria se produce habitualmente cuando los rayos cósmicos chocan contra la atmósfera de la Tierra, y la aniquilación de materia y antimateria se observa durante los experimentos de física en los aceleradores de partículas.

Equipos de físicos en todo el mundo siguen analizando . Aquellas primeras colisiones de protones a la alta energía prevista de 7 Teraelectronvoltios (TeV), una potencia jamás alcanzada en ningún acelerador antes, nos puede traer noticias largamente esperadas y desvelar misterios, contestar a preguntas planteadas y, en definitiva, decirnos cómo es la Naturaleza allí, donde el ojo humano no puede llegar pero, si la inteligencia.

Lo cierto es que, todos tenemos que convenir en el hecho cierto de que, el LHC es el mayor experimento físico de la historia de la Ciencia y que, de seguro, nos dará la de comprender muchas cuestiones que antes se nos aparecían oscuras e indistinguibles entre la bruma de esa lejanía infinitesimal de la cuántica. Ahora, tenemos una herramienta capaz de llevarnos hasta aquellos primeros momentos en los que se construyó la historia del universo y, si podemos, de esta manera “estar allí”, veremos, con nuestros propios ojos lo que pasó y por qué pasó de esa manera.

Toda esta larga exposición de temas, de alguna manerta conectados, viene al caso para dejar claro que, aquellos detractores del LHC, no llevaban la razón y, sus protestas no tenían un científico. El Acelerador de Partículas que llamamos abreviadamente LHC, nos ha dado y nos seguirá dando, muchos beneficios para toda la Humanidad.

emilio silvera

Oct

3

Sí, nuevas Teorías nos hablarán de cómo es la Naturaleza

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Hacia el futuro ~

Clasificado en Hacia el futuro ~

Comments (1)

Comments (1)

En nuestro Universo existen cosas extrañas que, seguramente, cuando sepamos más, sabremos su explicación: ¿Por qué no hay anti-bariones primordiales en el Universo mientras que hay un barión por cada mil millones de fotones?, dicho de otra manera, el origen de la materia. Claro que, para explicar este hecho necesitamos comprender como se comportaba nuestro Universo a temperaturas tan altas como un billón de grados.

Las interacciones entre partículas elementales (interacciones electromagnéticas, débiles y fuertes) están clasificadas por su entidad (constantes de acoplamiento) y por las partículas “transportadoras” de las mismas (partículas de spín=1 0 bosones de gauge) . Todas ellas están bellamente descritas por lo que se conoce habitualmente como Modelo Estándar de las interacciones electrodébiles y fuerte. Estamos deliberadamente dejando al margen las interacciones gravitatorias que, al menos a nivel clásico, están perfectamente descritas por la Teoría de la Gravitación o Relatividad General formulada por A. Einstein en 1915 y 1916.

El Modelo Estándar nos dice que las partículas elementales, cuya interacción se detecta en particular en los grandes aceleradores como el Large Hadrón Collider (LHC) que está funcionando el el CERN (Ginebra-Suiza), no son los átomos, ni los núcleos atómicos, ni siquiera los protones y neutrones de los que están constituidos, sino los Quarks, de los que están compuestos neutrones y protones, los leptones cargados eléctricamente (partículas ligeras como los electrones que están en la corteza de los átomos o muones que aparecen en ciertas desintegraciones), los leptones neutros o neutrinos (partículas enigmáticas con una masa pequeñísima comparada con el resto del espectro) y partículas transportadoras de las interacciones como fotones (cuanto de luz) transportadores de las interacciones electromagnéticas, los bosones W+, W- y Z0 que transportan las interacciones electrodébiles y los Gluones que transportan la interacción fuerte.

Partiendo de los Quarks, se conforma el núcleo hecho de protones y neutrones. Los Quarks, confinados dentro de estos nucleones, quedan sujetos por la fuerza fuerte a través de las partícuals mediadoras, los Gluones. Para formar el átomo, se necesitan electrones que, rodean el núcleo en número igual al de protones que contiene, y, como el protón está cargado eléctricamente con fuerza positiva, ésta se equilibra mediante la negativa de la misma potencia que aportan los electrones. De esta manera, el átomo queda debidamente estabilizado para poder unirse a otros para formar células que, a su vez se unen para formar moléculas que, a su vez, se juntan para formar materia.

Todas estas partículas de las que podemos hablar ya han sido descubiertas, mientras que la única incógnita del Modelo Estándar reside en el mecanismo por el que los fermiones elementales y ciertas partículas transportadoras de las interacciones como la W y Z adquieren masa. La Teoría de la “ruptura expontánea de simetría electrodébil” implica que tiene que existir una partícula aún no descubierta, el Bosón de Higgs, que es responsable de que las anteriores partículas, incluida ella misma, sean masivas.

¿Cómo será ese Bosón de Higgs y, de qué mecanismo se vale para dar masa a las demás partículas?

Todos hemos oido hablar hasta la saciedad de que el Bosón de Higgs debe ser descubierto por el Colisionador LHC y tal descubrimiento añadiría una buena ráfaga de luz sobre algunos enigmas, propiedades no bien conocidas de las interacciones débiles. Ahora que dicen haberlo encontrado, al menos de momento, no parece que se tengan noticias de ninguna nueva revolusión de la física. ¡Habrá que esperar!

El Modelo Estándar es pues la estructura matemática que describe las interacciones entre las partículas elementales conocidas. El Modelo Estándar, como cualquier otra teoría física, tiene que ser capaz de describir de froma correcta los datos experimentales que son los que realmente establece el veredicto último de una teoría.

En particular el Modelo Estándar ya ha sido (y está siendo) ampliamente contrastado con los datos experimentales de las colisiones de altas energías, como el Large Electrón Positrón (LEP) que estuvo funcionando en el CERN hasta el año 2000 y el Tevatrón que está en funcionamiento en el Laboratorio Fermilab (En Chicago, Illinois, USA), así como en aceleradores de baja energía.

El Tevatron, que ha sido el acelerador de partículas más potente del mundo hasta que entró en funcionamiento el LHC europeo, cerró el pasado 30 de de septiembre de 2011, de forma definitiva, tras 26 años de operación.

El resultado obtenido es que el acuerdo entre la teoría y los resultados experimentales es concluyente, llevándose el acuerdo hasta niveles de 0,1%. Sin embargo, a pesar de que los resultados experimentales no indiquen apenas fisuras en el Modelo Estándar existen motivaciones acuciantes para ir más allá de éste. Está claro que, el principal objetivo del Modelo está en descubrir los orígenes de la Materia, entendiendo por tal los protones y neutrones de los que estamos hechos nosotros mismos, es decir, la materia bariónica.

En este lugar, el Fermilab, se llevan a cabo proyectos de enorme importancia para conocer lo que la materia es. Y, de la misma manera que en el CERN, se realizan colisiones de haces de partículas que reproducen aquellos momentos de la creación, el big bang en miniatura para, a partir del estudio de lo que ahí pasa, poder llegar a comprender aquellos primeros momentos que aún, mantiene, algunas regiones oscuras que no dejan ver lo que allí pasó.

Los dos problemas “experimentales” más acuciantes que presenta en estos momentos el Modelo Estándar está relacionado con los dos tipos de Materia que constituyen el Universo observable. El 17% de la Materia de nuestro Universo es materia “luminosa”, es decir, materia constituida, como nosotros mismos por protones y neutrones. Por otro lado, el 83% de nuestro universo Universo está constituido por Materia Oscura (yo prefiero decir: parece que está constituido por materia invisible que llamamos oscura), es decir, materia que ha sido detectada por el momento sólo indirectamente a través de sus interacciones gravitacionales.

De nuevo el Modelo Estándar requiere de una extensión para poder incluir candidatos a Materia Oscura.

Muchas son las noticias que saltan a los medios y que son emitidas por equipos que quieren llevarse el galardón del hallazgo de la M. O. Veamos por ejemplo uno de ellos:

24 OCTUBRE 2010. Un teórico del Fermilab y sus colegas de la Universidad de Nueva York podrían haber encontrado pistas sobre algunos de los más jugosos secretos del universo en el centro de la Vía Láctea. La materia oscura. En su análisis de los datos públicos de los rayos gamma del Telescopio Espacial Fermi, Dan Hooper, científico del Fermilab, y Lisa Goodenough, un estudiante graduado en la Universidad de Nueva York, informan que los rayos gamma de muy alta energía procedentes del centro de la Vía Láctea vienen de las colisiones de materia oscura.

“Salimos de nuestra manera de considerar todas las causas de los fondos que imitan la señal, y no se encontraron otras fuentes plausibles en astrofísica o la mecánica que se puede producir una señal como ésta”, dijo Hooper.

Un reciente trabajo, publicado en el servidor repositorio científico arXiv-pre, describe sus hallazgos. Los astrofísicos desde hace mucho tiempo postulan una amplia gama de partículas de materia oscura, incluyendo los axiones, las partículas súper pesadas y partículas que se encuentran entre: débilmente partículas masivas de interacción, o WIMPs.

Ahora nos dicen que el LHC se prepara para poder buscar la materia oscura y, que yo sepa, el Bosón de Higgs (aunque digan lo contrario) no se ha encontrado. Al parecer han localizado una partícula que tiene todos los atributos para poder ser el Higgs pero… ¿Será él?

Claro que, la realidad es tozuda, y, nadie puede decirnos qué es la dichosa y teórica “materia oscura” de qué está hecha, cómo se formó, de qué mecanismos se vale para pasar inadvertida sin emitir radiaciones que podamos detectar, y, un sin fin de cuestiones que la hace extraña y muy exótica, hasta el punto de que podamos pensar que está y no está en este mundo. ¿No estará escondida en eso que llamamos vacío y, las partículas portadoras de la Fuerza Gravitatoria, el Gravitón, nos trae a nuestra parte del “mundo” la Gravedad que genera y que es, la que detectan los cosmólogos cuando ven que las galaxias se alejan las unas de las otras a más velocidad de la que tendrían que hacerlo si sólo existiera la materia bariónica que podemos observar?

Hablámos de los posibles candidatos a materia oscura, aquí la situación es incluso más complicada puesto que candidatos a materia oscura no han sido detectados por experimentos de física de partículas con lo que (como antes decía) su misma naturaleza nos es desconocida. Para competar el relato cabe decir que experimentos astrofísicos, en particular detección de supernovas, indican que el total de la materia anteriormente descrita (o sea luminosa y oscura) constituyen tan sólo el 28% de la densidad de energía del universo observable mientras que el resto es una energía no detectable mediante experimentos de Física de Partículas y que se conoce con el nombre de energía Oscura, que puede ser simplemente una Constante Cosmológica.

Einstein se burla de nosotros como si supiera (el muy ladino) que él llevaba razón, y, la Constante Cosmológica está ahí, presente en el Universo. La verdad es que, nos trae de cabeza, el no saber detectar dónde está la verdad para saber el camino a tomar en el futuro.

Así que, finalmente podemos concluir que el 4,6% es la materia bariónica (Supercúmulos de Galaxias, Nebulosas, Mundos, y demás cuerpos observables .-también nosotros-) y, el 17% de la densidad de materia del universo podría ser la llamada “materia oscura” . Aún cuando la proporción sea minoritaria para la Bariónica, para nosotros es prioritaria, de ella estamos hecho nosotros mismos y que, por supuesto, es la única materia que podemos detectar de forma directa, conocemos (las partículas que la conforman) sus secretos, sus parámetrtos físicos, sus masas y cargas, sus funciones dentro del contexto general y, en definitiva es la materia que está tan cerca de nosotros que, nosotros mismos somos ella.

También los pilares básicos de nuestro propio ser, son Quark y Leptones, es decir, materia bariónica. Así que, si los observadores del Universo (nosotros) somos de materia radiante y luminosa, no creo que esa “materia oscura” tenga más importancia que aquella de la que nosotros estamos formados. Más bien creo que, existe alguna fuerza (llámese constante cosmológica o de cualquier otra forma) desconocida que, se confunde con esa clase de materia. Materia, lo que se dice materia, por mí, sólo existe la que podemos ver y detectar.

Dos son los problemas esenciales que deben ser entendidos en relación con el número bariónico del Universo:

– El primero es que no hay prácticamente evidencia de antimateria en el Universo. De hecho no hay antimateria en nuestro Sistema solar y solamente aparecen antiprotones en los rayos cósmicos. Sin embargo, los antiprotones se pueden producir como producto secundarios en colisiones del tipo pp → 3p + p (en esta última p debería aparecer una rayita horizontal encima (antiprotón) pero, en mi cuadro de caracteres especiales no lo tengo) que proporcionan una abundancia de antiprotones semejante a la observada.

Así por ejemplo, resulta que se detecta un antiprotón aproximadamente por cada 3000 protones mientras que se encuentra un átomo de antihelio por cada 10000 átomos de Helio. Todos estos datos experimentales están de acuerdo con la existencia de antimateria primordial en el Universo. De hecho, la no existencia de antimateria resulta esencial para la estabilidad del mismo puesto que la materia y la materia se aniquilan entre sí produciendo radiación.

Satélite WMAP

– Una vez explicado el hecho de que practicamente no hay antimateria en el Universo, el segundo problema sería entender el origen de la densidad de materia luminosa. De hecho, utilizando los datos de la abundancia primordial de elementos ligeros, de acuerdo con la teoría de la nucleosíntesis, junto con los datos del Satélite WMAP, se deduce que hay en torno a 1 protón por cada mil millones de fotones en el Universo. Siendo nB y n γ las densidades de bariones y fotones respectivamente, se tiene que η=nB/nγ ≈ 0.61 x 10-9.

Para ser un poco más preciso podríamos decir que en 5 metros cúbicos hay un sólo barión y mil millones de fotones en promedio.

Para entender mejor cuál puede ser el mecanismo que explique la generación de materia en nuestro Universo, es decir, el parámetro η que acabamos de describir, debemos retrotraernos a la época en que el universo estaba muy caliente, poco después del Big Bang. Es decir, la llamada era denominada de la Radiación. Las partículas cuya masa es (muy) inferior a la temperatura del universo se aniquilan con sus antipartículas por las reacciones inversas a las anteriores. En este momento las partículas se comportan practicamente como si fueran de masa cero y se dice que la partícula en cuestión está en equilibrio térmico con la radiación. El Modelo Estándar Cosmológico predice una relación entre la edad del Universo (en segundos) y la temperatura del mismo (en K) que viene dada por:

en donde kB es la constante de Boltzmann. La ecuación anterior nos dice que para una temperatura próxima al GeV (equivalente a la masa del protón, que es de unos diez billones de grados, ¡el tiempo transcurrido en el universo después del Big Bang era de unas dos diez millonésimas de segundo!

Para temperasturas inferiores a la masa de la partícula, las partículas y antipartículas siguen aniquilándose en fotones, aunque el proceso inverso no puede tener ya lugar y la densidad de equilibrio térmico de partículas y antipartículas decrece exponencialmente como exp (-m/T) en donde m es la masa de la partícula en cuestión. Este proceso se termina cuando el ritmo de aniquilación de partículas y antipartículas no puede competir con el ritmo de expansión del universo (constante de Hubble H) , momento en el que las partículas y antipartículas se salen del equilibrio térmico y su densidad queda “congelada” a los valores de equilibrio correspondientes a la temperatura de”congelación” (temperatura de freezeout). Si aplicamos este proceso a los nucleones protones y neutrones) y antinucleones de masa ~ 1 GeV se puede ver como la densidad de los mismos empieza a disminuir exponencialmente para temperaturas inferiores al GeV, mientras que se salen de equilibrio térmico para temperaturas del orden de 20 MeV, para la cual la densidad de equilibrio resulta ser: nB/nγ=nB/nγ ≈ 10-18.

Esto nos demuestra que partiendo de un Universo simétrico, como hemos supuesto hasta el momento, hoy en día el Universo seguiría siendo simétrico respecto al número bariónico y, además, ¡el número de bariones sería mil millones más bajo que el que observamos! La solución de este problema sólo puede tener una respuesta: debemos abandonar la hipótesis de que el Universo era inicialmente simétrico respecto al número bariónico. La explicación podría seguir y es larga y algo compleja pero, por mi cuenta, resumo diciendo que, esa simetría no es posible, si tenemos en cuenta que, las partículas creadas después del Big Bang, al ser diferentes, también tenían diferentes masas y, tal hecho cierto, hace imposible que la expansión del Universo fuera isotrópica, así que, al expandirse anisotrópicamente, la asimetría queda servida.

Sí, podríamos decir que, la asimetría del Universo es la responsable de su diversidad. No todo es igual en el Universo. Lo son todos los protones y electrones que existen, y, también, todos los neutrones, es decir, son idénticos y simétricos los objetos de la misma familia a niveles microscópicos pero, cuando nos vamos al mundo macroscópico de las galaxias, las estrellas, los mundos o, nosotros mismos, no encontramos dos iguales.

El Universo, amigos, es una maravilla.

Agradeceré aquí la mayor aportación de D. Mariano Quirós de cuyo artículo en el Volumen 25, número 4 de la Revista de Física, encontré el Origen de la materia: bariogenesis, del que pude obtener la mayor parte del texto que aquí han podido leer.

Este trabajo fue publicado en este lugar el pasado 24 de marzo

Totales: 75.298.687

Totales: 75.298.687 Conectados: 39

Conectados: 39