May

15

El micro mundo de los átomos y la información

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Tecnología futura ~

Clasificado en Tecnología futura ~

Comments (0)

Comments (0)

La fusión nuclear es la energía del Futuro ¿La materia prima? El Agua de los océanos

Cuando por primera vez se puso este trabajo, dio lugar a comentarios que nos llevan hasta la realidad de hasta donde, resulta para nosotros, incomprensible ese micro mundo de la cuántica, ese “universo” infinitesimal donde ocurren cosas que, no llegamos a comprender.

Sí, existe otro mundo que no vemos pero, ¡está en éste! La cuántica reside en todas partes, en nuestros cerebros también. 88.000 millones de neuronas lo atestiguan

La mecánica cuántica domina en el micro-mundo de los átomos y de las partículas “elementales”. Nos enseña que en la naturaleza cualquier masa, por sólida o puntual que pueda parecer, tiene un aspecto ondulatorio. Esta onda no es como una onda de agua. Es una onda de información. Nos indica la probabilidad de detectar una partícula. La longitud de onda de una partícula, la longitud cuántica, se hace menor cuanto mayor es la masa de esa partícula.

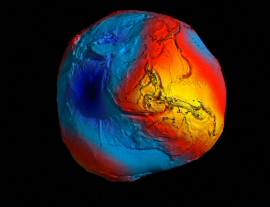

Por el contrario, la Relatividad General era siempre necesaria cuando se trataba con situaciones donde algo viaja a la velocidad de la luz, o está muy cerca o donde la gravedad es muy intensa. Se utiliza para describir la expansión del universo o el comportamiento en situaciones extremas, como la formación de agujeros negros. Sin embargo, la gravedad es muy débil comparada con las fuerzas que unen átomos y moléculas y demasiado débil para tener cualquier efecto sobre la estructura del átomo o de partículas subatómicas, se trata con masas tan insignificantes que la incidencia gravitatoria es despreciable. Todo lo contrario que ocurre en presencia de masas considerables como planetas, estrellas y galaxias, donde la presencia de la gravitación curva el espacio y distorsiona el tiempo.

La Gravedad hace que la Tierra se vea como un mapa. Es una vista altamente exagerada, pero ilustra a las claras cómo la atracción gravitatoria que se manifiesta desde la masa de roca bajo nuestros pies no es la misma en todo lugar. La gravedad es más fuerte en áreas amarillas y más débil en las azules. (Imagen tomada por el satélite Goce)

La gravedad cuántica estaría escondida en los agujeros negros, y, como nadie ha podido entrar ahí… ¡Seguimos sin encontrarla!

Como resultado de estas propiedades antagónicas, la teoría cuántica y la teoría relativista gobiernan reinos diferentes, muy dispares, en el universo de lo muy pequeño o en el universo de lo muy grande. Nadie ha encontrado la manera de unir, sin fisuras, estas dos teorías en una sola y nueva de Gravedad-Cuántica.

¿Cuáles son los límites de la teoría cuántica y de la teoría de la relatividad general de Einstein? Afortunadamente, hay una respuesta simple y las unidades de Planck nos dicen cuales son.

Supongamos que tomamos toda la masa del universo visible y determinamos su longitud de onda cuántica. Podemos preguntarnos en qué momento esta longitud de onda cuántica del universo visible superará su tamaño. La respuesta es: cuando el universo sea más pequeño en tamaño que la longitud de Planck, es decir, 10-33 centímetros, más joven que el Tiempo de Planck, 10-43 segundos y supere la temperatura de Planck de 1032 grados. Las unidades de Planck marcan la frontera de aplicación de nuestras teorías actuales. Para comprender en que se parece el mundo a una escala menor que la longitud de Planck tenemos que comprender plenamente cómo se entrelaza la incertidumbre cuántica con la gravedad. Para entender lo que podría haber sucedido cerca del suceso que estamos tentados a llamar el principio del universo, o el comienzo del tiempo, tenemos que penetrar la barrera de Planck. Las constantes de la naturaleza marcan las fronteras de nuestro conocimiento existente y nos dejan al descubierto los límites de nuestras teorías.

Las unidades de Planck o unidades naturales son un sistema de unidades propuesto por primera vez en 1899 por Max Planck. El sistema mide varias de las magnitudes fundamentales del universo: tiempo, longitud, masa, carga eléctrica y temperatura.

En los intentos más recientes de crear una teoría nueva para describir la naturaleza cuántica de la gravedad ha emergido un nuevo significado para las unidades naturales de Planck. Parece que el concepto al que llamamos “información” tiene un profundo significado en el universo. Estamos habituados a vivir en lo que llamamos “la edad de la información”. La información puede ser empaquetada en formas electrónicas, enviadas rápidamente y recibidas con más facilidad que nunca antes.

Los tiempos cambian y la manera de informar también, lejos nos queda ya aquellos toscos aparatos impresores del pasado, ahora, en espacios muy reducidos, tenemos guardada más información que antes había en una colección de libros.

Nuestra evolución en el proceso rápido y barato de la información se suele mostrar en una forma que nos permite comprobar la predicción de Gordon Moore, el fundador de Intel, llamada ley de Moore, en la que, en 1.965, advirtió que el área de un transistor se dividía por dos aproximadamente cada 12 meses. En 1.975 revisó su tiempo de reducción a la mitad hasta situarlo en 24 meses. Esta es “la ley de Moore” cada 24 meses se obtiene una circuiteria de ordenador aproximadamente el doble, que corre a velocidad doble, por el mismo precio, ya que, el coste integrado del circuito viene a ser el mismo, constante.

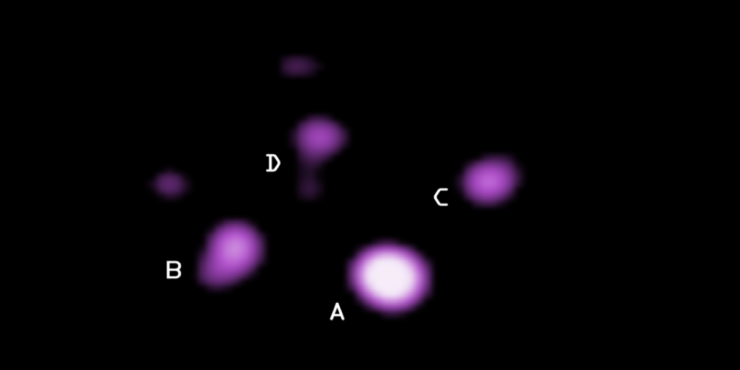

Jacob David Bekenstein (Ciudad de México, 1 de mayo de 1947-Helsinki, 16 de agosto de 2015) fue un físico teórico y astrónomo estadounidense e israelí nacido en México, quien investigó la relación entre los agujeros negros, su entropía y su relación con la teoría de la información

Los límites últimos que podemos esperar para el almacenamiento y los ritmos de procesamiento de la información están impuestos por las constantes de la naturaleza. En 1.981, el físico israelí, Jacob Bekenstein, hizo una predicción inusual que estaba inspirada en su estudio de los agujeros negros. Calculó que hay una cantidad máxima de información que puede almacenarse dentro de cualquier volumen. Esto no debería sorprendernos. Lo que debería hacerlo es que el valor máximo está precisamente determinado por el área de la superficie que rodea al volumen, y no por el propio volumen. El número máximo de bits de información que puede almacenarse en un volumen viene dado precisamente por el cómputo de su área superficial en unidades de Planck. Supongamos que la región es esférica. Entonces su área superficial es precisamente proporcional al cuadrado de su radio, mientras que el área de Planck es proporcional a la longitud de Planck al cuadrado, 10-66 cm2. Esto es muchísimo mayor que cualquier capacidad de almacenamiento de información producida hasta ahora. Asimismo, hay un límite último sobre el ritmo de procesamiento de información que viene impuesto por las constantes de la naturaleza.

La información llega a todos los rincones del Mundo, lo que hace poco más de 100 años era impensable, ahora, en pocos minutos, las noticias pasan de un rincón del mundo al otro opuesto. Internet y los asombrosos adelantos que vienen de camino lo aseguran.

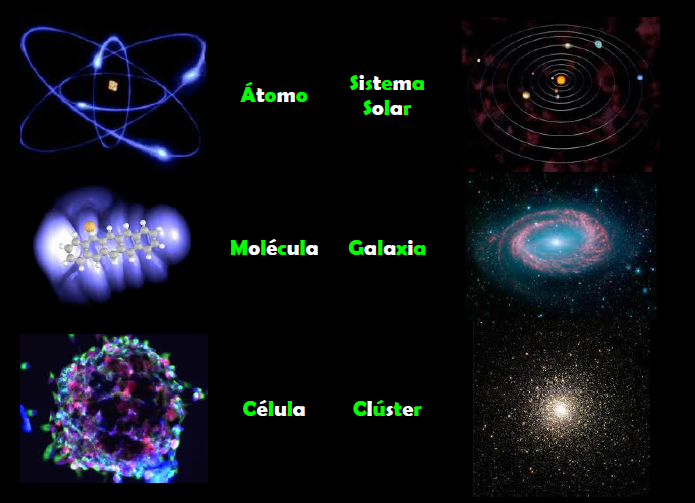

No debemos descartar la posibilidad de que seamos capaces de utilizar las unidades de Planck-Stoney para clasificar todo el abanico de estructuras que vemos en el universo, desde el mundo de las partículas elementales hasta las más grandes estructuras astronómicas. Este fenómeno se puede representar en un gráfico que recree la escala logarítmica de tamaño desde el átomo a las galaxias.

Todas las estructuras del universo existen porque son el equilibrio de fuerzas dispares y competidoras que se detienen o compensan las unas a las otras; la atracción y la repulsión. Ese es el equilibrio de las estrellas donde la repulsión termonuclear tiende a expandirla y la atracción (contracción) de su propia masa tiende a comprimirla; así, el resultado es la estabilidad de la estrella. En el caso del planeta Tierra, hay un equilibrio entre la fuerza atractiva de la gravedad y la repulsión atómica que aparece cuando los átomos se comprimen demasiado juntos. Todos estos equilibrios pueden expresarse aproximadamente en términos de dos números puros creados a partir de las constantes e, h, c, G y mprotón.

α = 2πe2 / hc ≈ 1/137

αG = (Gmp2)2 / hc ≈ 10-38

La identificación de constantes adimensionales de la naturaleza como a (alfa) y aG, junto con los números que desempeñan el mismo papel definitorio para las fuerzas débil y fuerte de la naturaleza, nos anima a pensar por un momento en mundos diferentes del nuestro.

Estos otros mundos pueden estar definidos por leyes de la naturaleza iguales a las que gobiernan el universo tal como lo conocemos, pero estarán caracterizados por diferentes valores de constantes adimensionales. Estos cambios numéricos alterarán toda la fábrica de los mundos imaginarios. Los átomos pueden tener propiedades diferentes. La gravedad puede tener un papel en el mundo a pequeña escala. La naturaleza cuántica de la realidad puede intervenir en lugares insospechados.

Lo único que cuenta en la definición del mundo son los valores de las constantes adimensionales de la naturaleza (así lo creían Einstein y Planck). Si se duplica el valor de todas las masas no se puede llegar a saber, porque todos los números puros definidos por las razones de cualquier par de masas son invariables.

La constante de estructura fina de Sommerfeld (símbolo α) es la constante física fundamental que caracteriza la fuerza de la interacción electromagnética. Es una cantidad sin dimensiones, por lo que su valor numérico es independiente del sistema de unidades usado.

Cuando surgen comentarios de números puros y adimensionales, de manera automática aparece en mi mente el número 137. Ese número encierra más de lo que estamos preparados para comprender; me hace pensar y mi imaginación se desboca en múltiples ideas y teorías. Einstein era un campeón en esta clase de ejercicios mentales que él llamaba “libre invención de la mente”. El gran físico creía que no podríamos llegar a las verdades de la naturaleza sólo por la observación y la experimentación. Necesitamos crear conceptos, teorías y postulados de nuestra propia imaginación que posteriormente deben ser explorados para averiguar si existe algo de verdad en ellos. Con los adelantos actuales, estudiando la luz lejana de cuásares muy antiguos, se estudia si la constante de estructura fina (α) ha variado con el paso del tiempo.

Ninguna imagen podrá nunca reflejar la realidad del Universo, ni su grandeza, siempre tendremos escenarios muy parciales de su asombrosa realidad. Y, de la misma manera (al menos por el momento), nunca podremos ver la imagen de nuestra Galaxia, la Vía Láctea, captada por un telescopio, ya que, tendría que salir de la galaxia para captar la imagen. Así, vemos galaxias situadas a miles de millones de años luz del Sistema solar pero… ¡Nunca veremos la nuestra!

El auto-engaño es un arma poderosa. Debajo de la imagen se puede leer:

“Planck, el telescopio de la Agencia Espacial Europea, ha captado la primera imagen total del cosmos. La instantánea es de importancia no solo por aportar un nuevo vistazo al universo, con estrellas y galaxias, sino también por aportar información sobre cómo se creó después del Big Bang.”

El Universo es muy grande, inmensamente grande y, probablemente, todo lo que nuestras mentes puedan imaginar podrá existir en alguna parte de esas regiones perdidas en las profundidades cósmicas, en los confines del Espacio- Tiempo, en lugares ignotos de extraña belleza en los que otros mundos y otras criaturas tendrán, su propio hábitat que, siendo diferente al nuestro, también, sus criaturas, estarán buscando el significado de las leyes del Universo.

emilio silvera

Abr

29

El “universo” de lo muy pequeño: NANO

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Tecnología futura ~

Clasificado en Tecnología futura ~

Comments (4)

Comments (4)

Richard Feynman

Alguna vez hemos hablado aquí de Nanotecnología pero, pocos saben que sus comienzos se remontan a 1959 cuando el físico y premio Nobel Richard Feynman pronunció en el Instituto de Tecnología de California su famoso discurso (en el ámbito de la Física). Feynman trató en su conferencia del problema de la manipulación individual de objetos tan pequeños como átomos y moléculas y de las múltiples oportunidades tecnológicas que ofrecería dicha manipulación.

A él le hubiera gustado conocer la realidad actual sobre todo lo que vaticinó en aquella conferencia, ya que, al haberse cumplido todos sus pronósticos, estaría satisfecho al ver que llevaba razón y sus ideas estaban bien encaminadas. La Nanociencia y la Nanotecnología son hoy un conjunto de conocimientos teóricos y prácticos que permiten determinar como se comporta el denominado nanamundo (el ámbito en el que el tamño de los objetos tienen 1 y 100 nm). A partir de estos conocimientos se están haciendo continuamente interesantes y arriesgadas apuestas sobre nuevos procedimientos.

Pero los seres humanos no somos los primeros nanotecnólogos. Ese honor le corresponde a cualquier célula, sea una bacteria, un protozoo o un fibroblasto. Las células están continuamente realizando procesos nanotecnológicos para mantenerse vivas. Como siempre, los seres humanos estamos aprendiendo a copiar procesos que se llevan a cabo en la Naturaleza con la esperanza de mejorarlos y beneficiarnos de ellos.

La elaboración de materiales nanoestructurados tridimensionales – aquellos que tienen formas distintivas y estructuras a escalas de unas pocas millonésimas de un metro – se ha convertido en un área fértil de investigación, produciendo materiales útiles dispositivos biomédicos, fotónica y electrónica.

Sin embargo, los métodos de elaboración de materiales han estado limitados en la complejidad 3D que pueden producir. Ahora, un equipo del MIT ha encontrado una manera para producir estructuras más complicadas utilizando una mezcla de enfoques Top-down y Bottom-up.

En aquel discurso de Feynman, no se pronunció, sin embargo, la palabra Nanotecnología. Dicho término no fue acuñado 1974 por el profesor N. Taniguchi de la Universidad de las Ciencias de Tokio en un artículo titulado “On the Basic Concept of ´Nanotecnolgy´”. Se presentó en una conferencia de la Sociedad Japonesa de Ingenieria de Precisión. En este contexto, la Nanotecnología se presenta como la tecnología que nos permite separar, consolidar y deformar materiales átomo a átomo o molécula a molécula.

En la Nanotecnología suelen intervenir Ingenieros, Físicos, Químicos, Bioquímicos, Biólogos, Médicos y perfiles de todos aquellos campos dónde la nanotecnología tiene aplicación. La nanotecnología es un sector transversal. Un campo de las ciencias aplicadas a tecnologías que pueden ayudar a optimizar la cadena de valor de cualquier proceso de producción, permitiendo implementar el ratio de competitividad de las empresa. Es tecnología punta y, va estando presente en infinidad de máquinas y sofisticados aparatos que, tanto en la Tierra con el en Espacio, llevan a cabo cometidos de todo con una garantía y seguridad que antes era imposible obtener.

Aquellas semillas sembradas por Feynman y regadas por Taniguchi, empezaron a germinar cuando E. Drexter publicó su libro titulado “Engines of Creation” en el que describe como será viable construir ordenadores hasta maquinaria pesada, ensamblando molécula a molécula, ladrillo a ladrillo, mediante nanorobots ensambladores, que funcionarán de un modo parecido a como lo hacen los ribosomas y otros agregados moleculares en las células de nuestro cuerpo (siempre copiando a la Naturaleza). Este conjunto de ideas -1960-1990-, han sido el punto de arranque de lo que hoy en día conocemos por Nanotecnología, el bagaje creciente de conocimientos teórico-prácticos que nos permitirán dominar la materia en la región de dimensiones comprendidas entre 1 y 100 nm, y que denominamos nanoescala que es el ámito de la Nanotecnología y la Nanociencia.

Si vamos ya a ejemplos concretos de interrelaciones entre estas tecnologías en desarrollo encontraremos una importante cantidad de dirigido al área de la salud, por ejemplo en el campo de los biosensores y técnicas de diagnóstico, en donde se unen principalmente herramientas nano y bio, siempre apoyadas por la tecnología de la información. Así mismo, aparecen los proyectos dirigidos a desarrollar tratamientos médicos localizados o al transporte y suministro local de fármacos. También en el campo de la salud, una imprescindible sinergia está ya establecida entre la bio y la info en lo que se llama la bioinformática, que permite por ejemplo diseñar fármacos computacionalmente, desarrollar terapias génicas o la ingeniería genética en los cultivos. Sobre las ciencias cognitivas, sus aplicaciones e interacciones con las otras tecnologías, también encontramos importantísimas áreas de trabajo ya en marcha, como es el caso del desarrollo de órganos artificiales o prótesis inteligentes, combinando los conocimientos de neurociencia, principalmente con tecnologías de la información y bio, y en muchos casos, con el área de nuevos materiales desarrollados gracias a la nanotecnología. De manera general, para entender mejor el funcionamiento del cerebro (ciencias cognitivas), tendremos que apoyarnos fuertemente en las herramientas que nos brinda la biotecnología y la tecnología de la información, que, a su vez aprovechará las conclusiones que se vayan obteniendo para proponer nuevas aplicaciones.

Si vamos ya a ejemplos concretos de interrelaciones entre estas tecnologías en desarrollo encontraremos una importante cantidad de dirigido al área de la salud, por ejemplo en el campo de los biosensores y técnicas de diagnóstico, en donde se unen principalmente herramientas nano y bio, siempre apoyadas por la tecnología de la información. Así mismo, aparecen los proyectos dirigidos a desarrollar tratamientos médicos localizados o al transporte y suministro local de fármacos. También en el campo de la salud, una imprescindible sinergia está ya establecida entre la bio y la info en lo que se llama la bioinformática, que permite por ejemplo diseñar fármacos computacionalmente, desarrollar terapias génicas o la ingeniería genética en los cultivos. Sobre las ciencias cognitivas, sus aplicaciones e interacciones con las otras tecnologías, también encontramos importantísimas áreas de trabajo ya en marcha, como es el caso del desarrollo de órganos artificiales o prótesis inteligentes, combinando los conocimientos de neurociencia, principalmente con tecnologías de la información y bio, y en muchos casos, con el área de nuevos materiales desarrollados gracias a la nanotecnología. De manera general, para entender mejor el funcionamiento del cerebro (ciencias cognitivas), tendremos que apoyarnos fuertemente en las herramientas que nos brinda la biotecnología y la tecnología de la información, que, a su vez aprovechará las conclusiones que se vayan obteniendo para proponer nuevas aplicaciones.

Claro que, trabajar con objetos tan pequeños entraña una gran dificultad, y de hecho fue prácticamente imposible que se desarrollaron los microscopios de campo cercano (SPMs) a partir del miscroscopio de Efecto Túnel (STM que fue inventado por H. Rohrer y G. Binning a principio de la década de los 80, contribución por la que recibieron el premio Nobel en 1986. Las herramientas SPM permiten no sólo la visualización, sino también la manipulación de objetos de dimensiones nanométricas y de muy distinta naturaleza.

Aventurarse a predecir futuras aplicaciones del conocimiento científico siempre resulta una tarea arriesgada, y con más razón se trata de un conocimiento tan joven como la Nanociencia. No obstante, a la luz del camino ya recorrido es posible adivinar algunas de las implicaciones futuras de este conocimiento. Los campos científicos y tecnológicos que podrían beneficiarse a medio o largo plazo son muchos y variados.

Sin ánimo de ser exhaustivos, podemos destacar algunas de las ramas del saber y de la técnica que pueden aplicar la Nanotecnología en un futuro no demasiado lejano.

Nanomateriales

A medio plazo podemos destacar las siguientes mejoras:

– Televisores y pantallas presentar información. Se pretende aumentar el área útil de estos dispositivos, mejorando el brillo de los actuales TFT. Nanocristales de seleniuro de cinc o de sulfuro de cadmio con candidatos muy prometedores que, además, permitirían reducir el consumo energético.

– Aditivos en aditivos: Se ha comprobado que las nanopartículas de óxido de cerio permiten reducir el gasto de diesel.

– Baterias diesel:clara la necesidad de aumentar la capacidad de almacenamiento de energía de las baterías que se utilizan en dispositivos móviles (ordenadores portátiles, teléfonos). Se ha comprobado que los nanocristales sintetizados por técnicas sol-gel mejorar dicha capacidad debida a su estructura aerogel.

– Catálisis: La eficacia de proceso depende fundamentalmente del área, y la razón área/volumen es mayor en partículas de pequeño tamaño.

Nanomateriales aplicados a dispositivos electrónicos y los tres tipos de geometrías de nanotubos de carbono

Las aplicaciones a largo plazo podrían ser:

- Composites de nanotubos de carbón, que deberían presentar unas excepcionales propiedades mecánicas (alta resistencia y poco peso).

- Lubruicantes: Se pretenden utilizar nanoesferas de materiales inorgánicos que actúen pequeños rodamientos, reduciendo el desgaste de superficies sometidas a grandes tensiones mecánicas.

- Materiales mangnéticos: Los nanocristales de ytrio-samario-cobalto presentan grandes campos cohercitivos. Su uso mejoraría las prestaciones de ciertos instrumentos como aquellos utilizados en Resonancia Magnética Nuclear. Asimismo, podrían mejorar la capacidad de almacenamiento de información de los discos duros empleados por los ordenadores.

Electrónica

- Miniaturización de circuitos integrados: objetivo sigue siendo esencial para el desarrollo de la electrónica tal y como la conocemos hoy día. Se cree que la tecnología de 22 nm estará disponible en unos 10 años.

- Cristales fotónicos, con mejores rendimientos para focalizar haces de luz, mejorando la eficiencia de las guías de luz. Por ejemplo, un típico cristal fotónico podría estar basado en redes de agujeros realizados en un dieléctrico, uno fabricado con una precisión inferior a los 10 nm. Las imperfecciones deben ser necesariamente pequeñas porque en caso contrario se degradan las bandas prohibidas de estos dispositivos.

- Computación Cuántica y criptografía cuántica: Los puntos cuánticos basados en semiconductores son candidatos ideales fabricar dispositivos que permitan aplicar todas las teorías que ya existen sobre computación y criptografía cuánticas.

- Sensores: El sensor ideal es aquel de pequeño tamaño que resulte mínimamente invasivo. Para fabricar un dispositivo de 1 mm2 que contenga una fuente de alimentación, el sensor y el transmisor de la señal es indudable que se requiere una alta miniaturización.

Diferentes geometrías de cristales fotónicos

Biotecnología

- Nanofarmacología: El transporte de los fármacos a los lugares específicos del cuerpo donde son necesarios reduce la necesidad de ingesta alta dosis de los mismos y mejora su eficacia. Así, se especula que los nanocristales de plata podrían liberar iones de plata un largo intervalo de tiempo, actuando sobre un espectro de unos 150 agentes patógenos.

- Nanosensores: Al disminuir su tamaño resultan invasivos y por tanto más beneficiosos para el diagnóstico médico.

- ADN: Sus propiedades de carácter semiconductor cuando se ha eliminado el agua son muy prometedoras para su uso como nanohilos. Además, tiene unas cualidades muy atractivas para su aplicación en nanoelectrónica por su capacidad para auto-ensamblarse y duplicarse. Se alcanzaría así el objetivo de conseguir circuitos electrónicos con capacidad para auto-repararse.

Molécula de ADN

Todos estos conocimientos generados han desembocado en la puesta a punto de diferentes iniciativas (programas de investigación, nuevos centros y equipamientos, proyectos futuristas, ingenios espaciales, óptica, medicina, ingeniería, fotónica, computación, robótica, etc. Y, pocas dudas nos pueden caber a estas alturas de que, todo este “universo” de lo NANO, desembocará en un nuevo mundo de tecnología muy tangible y real en nuestro futuro próximo. La gran belleza de estos experimentos y nuevas técnicas, junto a las enormes e ilimitadas espectivas que de ellos se generan han conducido a la proliferación del prefijo “nano” (no pocas veces un tanto abusiva y con el simple objetivo de revalorizar el producto o la linea de investigación). Así podemos oir hablar de disciplinas como nanoquímica, nanoelectrónica, nanofotónica, nanomedicina o nanobiotecnología; o de objetos tales como nanopartículas, nanotubos, nanoimánes o nanomotores. Es decir, el colocar el prefijo “nano” delante de una palabra determinada nos indica que ese campo se va estudiar enfatizando aquellos aspectos del mismos relacionados con la nanoescala.

Los más fiables y sofisticados aparatos son empleados hoy para desarrollar estas tecnologías que, si buscamos un símil sencillo, el fundamento en que se baza gran parte de la tecnología actual se asemeja al trabajo realizado por un escultor, que cincela, pule y modela un bloque de material para obtener un objeto más pequeño con la forma deseada. Puesto que cada vez son más necesarias tecnologías de fabricación más precisas, es importante disponer de tamños de “cincel” cada vez más pequeños y, también, más precisos. Este planteamiento es conocido como tecnología de fabricación descendente o “top-down” (arriba y abajo, el de los quarks que conforman a los protones y neutrones).

Se están consiguendo maravillas en el campo de la electrónica molecular. El potencial de las moléculas como componentes electrónicos manométricos. Variando la estructura de moléculas especialmente diseñadas que contienen átomos de metales de transición, como el cobalto en un caso y un par de átomos de vanadio en el otro ,se consigue obtener las características similares a de un transistor y establecer un flujo de corriente a través de un cuantico. El siguiente dibujo es una representación de un complejo cobalto-terpiridinil (cobalt-terpyridinyl) (a la izquierda) y de una molécula di vanadio(a la derecha) unidas ambas a electrodos de oro.

El “universo” de lo muy pequeño, nos tiene deparada grandes sorpresas

Investigadores de la universidad de Cornell y de la universidad de Harvard informaron sobre el desarrollo de este sistema de un solo átomo del cobalto en un caso y dos átomos del vanadio en el otro. Todo una hazaña increíblemente difícil de realizar, construir estos circuitos requirió la fabricación de “moléculas diseñadas” integradas por varios átomos dispuestos a modo de andamio en donde los átomos de cobalto o de vanadio se ubican en central.

Una pequeña molécula de 1 a 2 nm(nanómetro) de longitud se une a dos electrodos de oro, los cuales se depositan en una superficie de oxido de silicio.Infinidad de experimentos y funciones son objetos de los más variados proyectos

La Electrónica se molecular y la molécula Memoria

Por ejejmplo, una punta de cobalto sobre un colorante azul finamente fijada en una isla de cobalto emplatada en una base de cobre. Parece una receta de cocina de vanguardia, no, es molectrónica, electrónica molecular nanométrica. Un equipo de instituto tecnológico de Karlsruhe ha conseguido un detector magnético de un nanómetro de diámetro, basado en una molécula orgánica común (el azul de los bolis) y un fenómeno mecanocuántico la magnetorresistencia gigante. Rico, rico, veamos el sencillo fundamento.

Magnetorresistencia gigante mediante una única molécula de H2 ftalocianina. Electrónica molécular de espín. Representación del dispositivo compuesto por una isla base de cobalto sobre la que se deposita una sola molécula de ftalocianina, la punta a escala atómica de cobalto. La escala del dispositivo es realmente sorprendente, el diámetro de la molécula orgánica es de 0.6 nm de diámetro y la fila de diez átomos de cobalto (Co) es de 1.5 nm. De longitud.

La magnetoresistencia es la variación de la resistencia que ofrece un material se aplica sobre él un campo magnético. La magnetorresistencia gigante es un fenómeno cuántico, a escalas pequeñas, se da en estructuras de finísimas capas ferromagnéticas separadas por un espaciador no magnético, un sandwidch don el pan conduce y la mortadela no. Cuando se aplica un campo magnético externo disminuye muchísimo la resistencia eléctrica al alinearse los espines de los electrones de todas las capas.

La idea que subyace es utilizar la simple química de moléculas orgánicas comunes, como la utilizada en la tinta azul de los bolis y unirla a su peculiar física cuando se depositan como una capa monoatómica dos sustratos ferromagnéticos. Se aúna electrónica molecular, con la electrónica de espín ‘espintrónica’. Son las moléculas de hidrógeno ftalocianina las que actuarán transistores, resistencias y unidades del circuito electrónico.

Científicos en Suiza han logrado visualizar una semanas los atomos que forman la molécula del pentaceno, representando un hito en el ámbito de la nanotecnología y la electrónica molecular. La molécula es el pentaceno (C22H14), consistente en cinco anillos de benceno enlazados formando una cadena aromática, que es candidato a ser utilizada en nuevos semiconductores orgánicos.

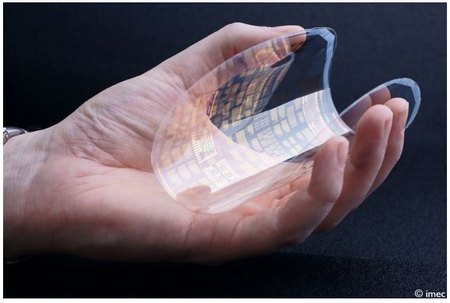

Investigadores europeos informaron en el Internacional Solid-State Circuits de San Francisco, California, el desarrollo del primer microprocesador flexible orgánico. Los investigadores, especialistas en polímeros y electrónica molecular, son del Imec, un centro de investigación de nanotecnología de Belgica.

El mayor escollo para desarrollar esta tecnología, según el leader del equipo de investigadores, Jan Genoe, fue encontrar la de controlar los transistores orgánicos, pues cuando se habla de estructura, el silicio es mejor que las alternativas orgánicas pues su estructura monocristalina permite una reacción más consistente.

El costo de estos tipos de procesadores es mucho más baratos que los de silicio. Más o menos costaría producirlos el 10 % de lo que cuesta producir uno de silicio.

Según la fuente, este descubrimiento puede ser el inicio de un montón de aplicaciones que van desde poder registrar la presión del agua, cuando se lo coloca alrededor de una caño, hasta empaquetar alimentos y drogas de farmacia, ya que podría indicar el de la comida y avisar cuando nos olvidamos de tomar una medicina.

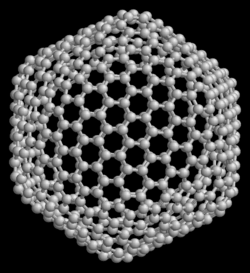

Fullereno C540.

Ampliamente hemos hablado aquí de los fullerenos y Nanotubos de carbono, Grafeno, Nanohilos y Nanopartículas y seguiremos hablando en el futuro, todos estos bocablos y palabras nuevas son las que están desceribiendo las tecnologías que nos llevarán adelante y, si queremos estar al día, si deseamos no quedarnos atras, debemos estar pendientes de todo lo que se mueva en ese “nuievo” campo de la Ciencia que, de seguro, nos dará muchas alegrías.

¿Hasta dónde podremos llegar?

¿Qué límite nos impondrá la Naturaleza?

O, al ser también nosotros de ella, nos dejará acercarnos tanto que, podremos, finalmente, confundirnos con ella al llegar a entenderla tan profundamente que, nada se interpone para que, nos podamos fusionar en un abrazo final cuando, llegado el momento y, convertidos en pura luz de energía infinita, podamos vagar por las estrellas del Universo siendo parte, una importante parte, de todo ese complejo conglomerado que llamamos Universo.

emilio silvera

Totales: 75.392.117

Totales: 75.392.117 Conectados: 89

Conectados: 89