Dic

27

¡El Origen del Universo! ¿Cómo puedo saberlo yo?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

“¿Dónde estabas tú cuando yo puse los cimientos de la Tierra? Dilo si tienes entendimiento?”

Claro que a esta pregunta, lo único que podríamos contestar sería:

¿Quién sabe realmente?

La especulación sobre el origen del universo es una vieja actividad humana que está sin resolver, ya que, pretendemos saber algo que no sabemos si llegó a ocurrir, toda vez que incluso, podría ser, que el universo esté aquí desde siempre. Y, si llegó como algo nuevo, tampoco sabemos, a ciencia cierta, cómo y de dónde lo hizo. Pero, nosotros, los humanos, no dejamos de especular con esta cuestión de compleja resolución y dejamos volar nuestra imaginación en forma de conjeturas y teorías que, no siempre son el fiel reflejo de lo que pudo pasar que, de momento, permanece en el más profundo anonimato.

Claro que la Humanidad y el Universo están tan juntos (nosotros también somos universo), tan conectados que, sería imposible que no hablaran de él, y, sobre todo, que no trataran de saber su comienzo (si es que lo hubo) y, hurgar en su dinámica para poder entender nuestra presencia aquí junto con las estrellas de las que procedemos y de las galaxias que son las “villas” del Universo que alojan a cientos de millones de mundos ¿habitados? que, como la Tierra, tienen otras criaturas que también, ellas se preguntan por el principio y el final para poder conocer sus destinos.

Si surgió es porque había, nada puede aparecer a partir de la “Nada” que, en realidad, no existe

Algunos nos dicen que el Universo surgió de la “Nada” y, está claro que la Nada no puede existir y, si surgió es porque había, con lo cual, la Nada queda invalidada. Pero, si hubo un suceso de creación, ¿Qué duda nos puede caber de que tuvo que haber una causa? Lo cierto es que, en las distintas teorías de la “creación” del universo, existen muchas reservas. No puedo quitarme del pensamiento ¡Una Fluctuación de Vacío!

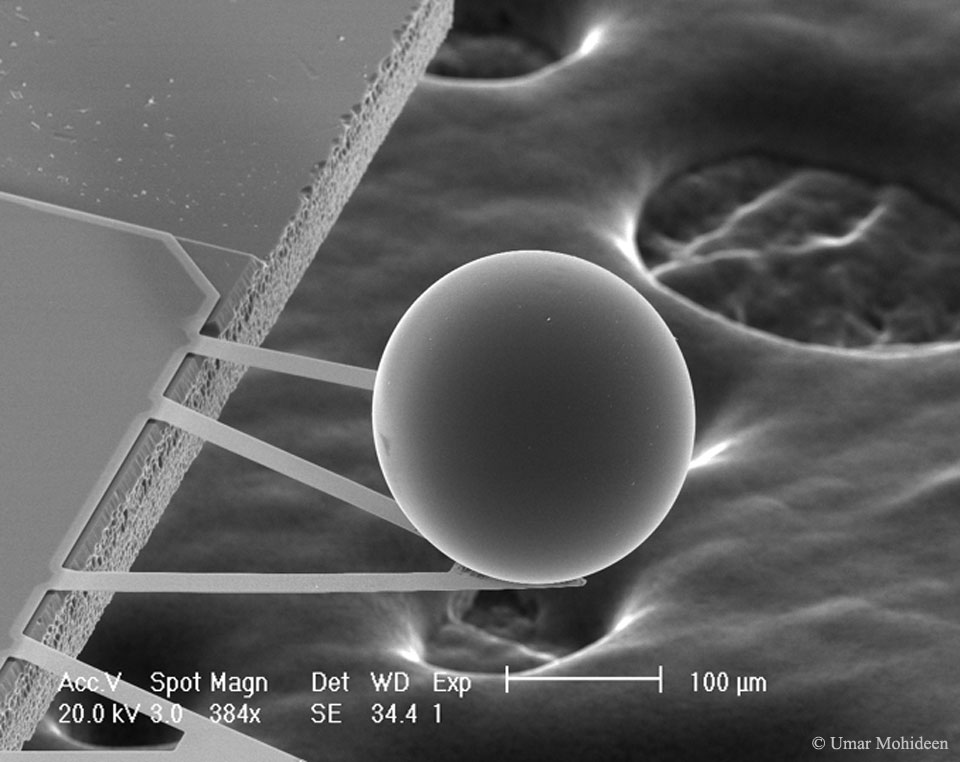

En experimentos científicos se han medido las Fluctuaciones del Vacío

No obstante tales reservas, unos pocos científicos trataron de investigar la cuestión de cómo pudo haberse originado el universo, aunque admitiendo que sus esfuerzos quizás eran “prematuros”, como dijo Weinberg con suavidad. En el mejor de los casos, contemplado con una mirada alentadora, el trabajo realizado hasta el momento, parece haber encendido una lámpara en la antesala de la génesis. Lo que allí quedó iluminado era muy extraño, pero era, en todo caso, estimulante. No cabía descubrir algo familiar en las mismas fuentes de la creación.

Hemos podido contemplar como en la Nebulosa del Águila nacen nuevas estrellas masivas. Sin embargo, no hemos llegado a poder saber, con certeza como surgió el Universo entero y de dónde y porqué lo hizo para conformar un vasto espacio-tiempo lleno de materia que evolucionaría hasta poder conformar las estrellas y los mundos en enormes galaxias, y, en esos mundos, pudieron surgir criaturas que, conscientes de SER, llegaron desde un nivel animal rudimentario, hasta los más sofisticados pensamientos que les hicieron preguntarse: ¿Quiénes somos, de dónde venimos, hacia dónde vamos? Y, esas preguntas, realizadas 14.000 millones de años después del comienzo del tiempo, y junto a la pregunta del origen del Universo, todavía, no han podido ser contestadas. Nuestro intelecto evoluciona pero, sus límites son patentes.

Una estrella que se forma en la Nebulosa comienza siendo proto-estrellas y, cuando entra en la secuencia principal, brilla durante miles de millones de años durante los cuales crea nuevos elementos a partir del más sencillo, el Hidrógeno. Los cambios de fase que se producen por fusión en el horno nuclear de las estrellas, son los que han permitido que existieran los materiales necesarios para la química de la vida que, al menos hasta donde sabemos, no apareció en nuestro planeta Tierra, hasta hace unos 4.o0o millones de años, y, desde entonces, ha estado evolucionando para que ahora, nosotros, podamos preguntas, por el origen del universo.

Los científicos han imaginado y han puesto sobre la mesa para su estudio, dos hipótesis, la llamada génesis del vacío, y la otra, génesis cuántica y ambas, parecían indicar mejor lo que el futuro cercano podía deparar al conocimiento humano sobre el origen del Universo.

La Génesis de vacío: El problema central de la cosmología es explicar como algo surge de la nada. Por “algo” entendemos la totalidad de la materia y la energía, el espacio y el tiempo: el universo que habitamos. Pero la cuestión de lo que significa NADA es más sutil. En la ciencia clásica, “nada” era un vacío, el espacio vacío que hay entre dos partículas de materia. Pero esta concesión siempre planteaba problemas, como lo atestigua la prolongada indagación sobre si el espacio estaba lleno de éter, y en todo caso no sobrevivió al advenimiento de la física cuántica.

El vacío cuántico nunca es realmente vacío, sino que resoba de partículas “virtuales”. Las partículas virtuales pueden ser concebidas como la posibilidad esbozada por el principio de indeterminación de Heisenberg de que una partícula “real” llegue en un tiempo determinado a un lugar determinado. Como las siluetas que salen de pronto en un campo de tiro policial, representan no sólo lo que es sino también lo que podría ser. Desde el punto de vista de la física cuántica, toda partícula “real” está rodeada por una corona de partículas y antipartículas virtuales que borbotean del vacío, interaccionan unas con otras y luego desaparecen.

Las ondas fluctúan de forma aleatoria e impredecible, con energía positiva momentáneamente aquí, energía negativa momentáneamente allí, y energía cero en promedio. El aspecto de partícula está incorporado en el concepto de partículas virtuales, es decir, partículas que pueden nacer en pares (dos partículas a un tiempo), viviendo temporalmente de la energía que se producen en las fluctuaciones tomada prestada de regiones “vecinas” del espacio, y que luego se aniquilan y desaparecen, devolviendo la energía a esas regiones “vecinas”. Si hablamos de fluctuaciones electromagnéticas del vacío, las partículas virtuales son fotones virtuales; en el caso de fluctuaciones de la gravedad en el vacío, son gravitones virtuales.

Fluctuaciones en el Vacío Cuántico

Claro que, en realidad, sabemos poco de esas regiones vecinas de las que tales fluctuaciones toman la energía. ¿Qué es lo que hay allí? ¿Está en esa región la tan buscada partícula de Higgs? Sabemos que las fluctuaciones de vacío son, para las ondas electromagnéticas y gravitatorias, lo que los movimientos de degeneración claustrofóbicos son para los electrones. Si confinamos un electrón a una pequeña región del espacio, entonces, por mucho que uno trate de frenarlo y detenerlo, el electrón está obligado por las leyes de la mecánica cuántica a continuar moviéndose aleatoriamente, de forma impredecible. Este movimiento de degeneración claustrofóbico que produce la presión mediante la que una estrella enana blanca se mantiene contra su propia compresión gravitatoria o, en el mismo caso, la degeneración de neutrones mantiene estable a la estrella de neutrones, que obligada por la fuerza que se genera de la degeneración de los neutrones, es posible frenar la enorme fuerza de gravedad que está comprimiendo la estrella.

Una cosa sí sabemos, las reglas que gobiernan la existencia de las partículas virtuales se hallan establecidas por el principio de incertidumbre y la ley de conservación de la materia y de la energía.

En un nuevo estudio, un grupo de físicos ha propuesto que la gravedad podría disparar un efecto desbocado en las fluctuaciones cuánticas, provocando que crezcan tanto que la densidad de energía del vacío del campo cuántico podría predominar sobre la densidad de energía clásica. Este efecto de predominancia del vacío, el cual surge bajo ciertas condiciones específicas pero razonables, contrasta con la ampliamente sostenida creencia de que la influencia de la gravedad sobre los fenómenos cuánticos debería ser pequeña y subdominante.

Claro que, hablar aquí del vacío en relación al surgir del universo, está directamente asentado en la creencia de algunos postulados que dicen ser posible que, el universo, surgiera de una Fluctuación de vacío producida en otro universo paralelo y, desde entonces, funciona de manera autónoma como un nuevo universo de los muchos que son en el más complejo Meta-verso.

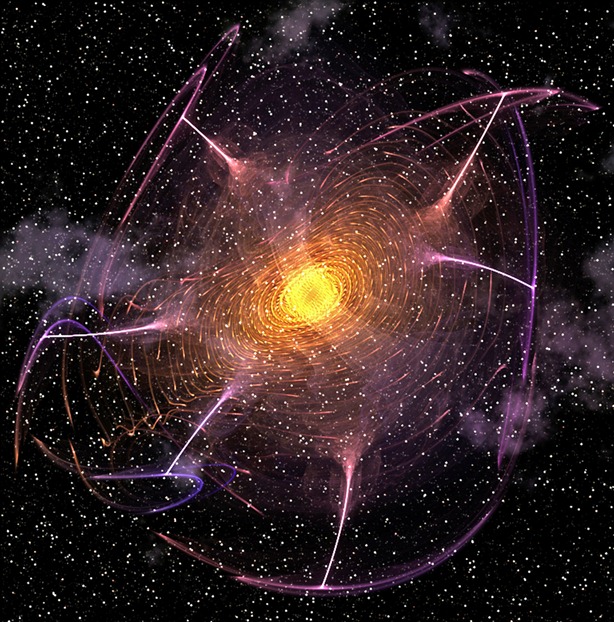

Inmediatamente después de que la llamada espuma cuántica del espacio-tiempo permitiera la creación de nuestro Universo, apareció una inmensa fuerza de repulsión gravitatoria que fue la responsable de la explosiva expansión del Universo primigenio (inflación(*)).Las fluctuaciones cuánticas del vacío, que normalmente se manifiestan sólo a escalas microscópicas, en el Universo inflacionario en expansión exponencial aumentaron rápidamente su longitud y amplitud para convertirse en fluctuaciones significativas a nivel cosmológico.

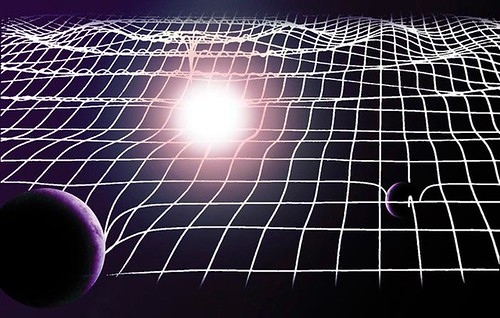

En el Modelo corriente del Big Bang que actualmente prevalece y que, de momento, todos hemos aceptado al ser el que más se acerca a las observaciones realizadas, el universo surgió a partir de una singularidad, es decir, un punto de infinita densidad y de inmensa energía que, explosionó y se expansionó para crear la materia, el espacio y el tiempo que, estarían gobernados por las cuatro leyes fundamentales de la naturaleza:

Fuerzas nucleares débil y fuerte, el electromagnetismo y la Gravedad. Todas ellas, estarían apoyadas por una serie de números que llamamos las constantes universales y que hacen posible que nuestro universo, sea tal como lo podemos contemplar. Sin embargo, existen algunas dudas de que, realmente, fuera esa la causa del nacimiento del Universo y, algunos postulan otras causas como transiciones de fase en un universo anterior y otras, que siendo más peregrinas, no podemos descartar.

Nosotros, estamos confinados en el planeta Tierra que es un mundo suficientemente preparado para acoger nuestras necesidades físicas, pero, de ninguna manera podrá nunca satisfacer nuestras otras necesidades de la Mente y del intelecto que produce imaginación y pensamientos y que, sin que nada la pueda frenar, cual rayo de luz eyectado desde una estrella masiva refulgente, nuestros pensamientos vuelan también, hacia el espacio infinito y con ellos, damos rienda suelta a nuestra más firme creencia de que, nuestros orígenes están en las estrellas y hacia las estrellas queremos ir, allí, amigos míos, está nuestro destino.

Nuestro destino y nuestro origen están en las estrellas

El Universo es grande, inmenso, casi infinito pero, ¿y nosotros? Bueno, al ser una parte de él, al ser una creación de la Naturaleza, estamos formando parte de esta inmensidad y, precisamente, nos ha tocado desempeñar el papel de una “parte” parte que piensa, ¿tendrá eso algún significado?

Yo, no lo sé… Pero… ¿¡Quién sabe realmente!?

Emilio Silvera V.

Dic

27

No todo lo podemos explicar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Las grandes construcciones existentes por casi todo el mundo, de cuyas enormes estructuras no podemos dar una explicación, han quedado en el Historia de la Humanidad como un gran misterio.

Cuando contemplamos las obras y grandes estructuras que dejaron nuestros antepasados de las distintas civilizaciones, lo único que podemos hacer es preguntarnos: ¿Cómo pudieron? ¿De qué medios se valieron? No tenemos señales de tecnologías avanzadas y, sin embargo… ¡Ahí están!

Hablamos de grandes Civilizaciones perdidas, y de otras que, muy avanzadas, emigraron de la Tierra después de dejarnos los conocimientos suficientes para salir adelante. Nos dicen que algún día lejano en el Futuro, volverán.

La imaginación siempre ha formado parte (7una parte bastante importante), de nuestros deseos y nuestros sueños. Y, siendo cierto que existen estructuras del pasado que no sabemos explicar en el sentido de que, el tiempo en el fueron construidas, no existían los medios que lo hiciera posible.

Un misterio de los muchos que no hemos podido desvelar.

Emilio Silvera V.

Dic

27

El fino equilibrio que permite la presencia de la Vida

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

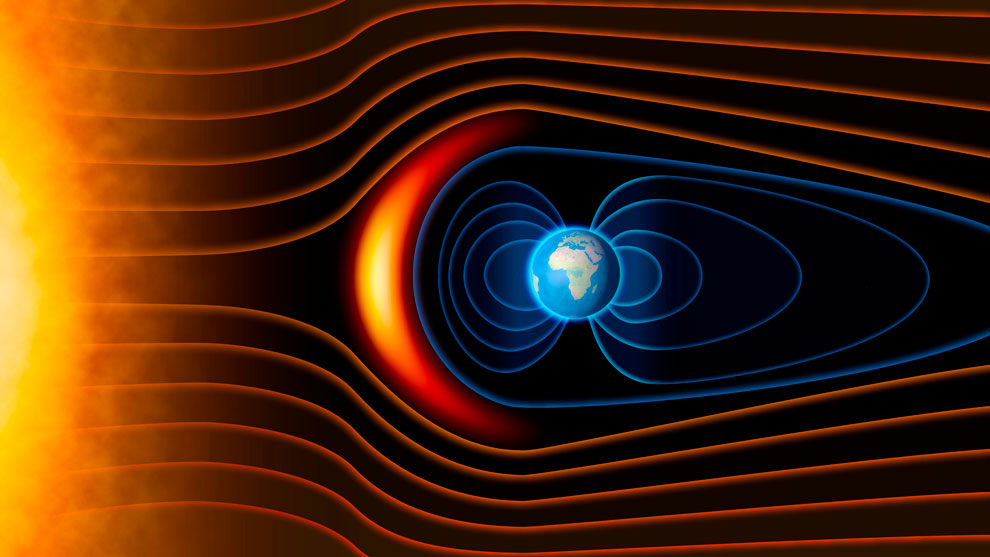

Las estrellas típicas como el Sol, emiten desde su superficie un viento de partículas cargadas eléctricamente que barre los atmósferas de los planetas en órbitas a su alrededor y a menos que el viento pueda ser desviado por un campo magnético, los posibles habitantes de ese planeta lo podrían tener complicado soportando tal lluvia de radiactividad. En nuestro sistema solar el campo magnético de la Tierra ha protegido su atmósfera del viento solar, pero Marte, que no está protegido por ningún campo magnético, perdió su atmósfera hace tiempo.

Hasta el momento sólo sabemos de la vida en la Tierra

Probablemente no es fácil mantener una larga vida en un planeta del Sistema solar. Poco a poco hemos llegado a apreciar cuán precaria es. Dejando a un lado los intentos que siguen realizando los seres vivos de extinguirse a sí mismos, agotar los recursos naturales, propagan infecciones letales y venenos mortales y emponzoñar la atmósfera, también existen serias amenazas exteriores.

Los movimientos de cometas y asteroides, a pesar de tener la defensa de Júpiter, son una seria y cierta amenaza para el desarrollo y persistencia de vida inteligente en las primeras etapas. Los impactos no han sido infrecuentes en el pasado lejano de la Tierra habiendo tenido efectos catastróficos. Somos afortunados al tener la protección de la luna y de la enorme masa de Júpiter que atrae hacia sí los cuerpos que llegan desde el exterior desviándolos de su probable trayectoria hacia nuestro planeta.

La caída en el Planeta de uno de estos enormes pedruscos podría producir extinciones globales y retrasar en millones de años la evolución.

Cuando comento éste tema no puedo evitar el recuerdo del meteorito caído en la Tierra que impactó en la península de Yucatán hace 65 millones de años, al final de la Era Mesozoica, cuando según todos los indicios, los dinosaurios se extinguieron. Sin embargo, a aquel suceso catastrófico para los grandes lagartos, en realidad supuso que la Tierra fue rescatada de un callejón sin salida evolutivo. Parece que los dinosaurios evolucionaron por una vía que desarrollaba el tamaño físico antes que el tamaño cerebral.

La desaparición de los dinosaurios junto con otras formas de vida sobre la Tierra en aquella época, hizo un hueco para la aparición de los mamíferos. Se desarrollo la diversidad una vez desaparecidos los grandes depredadores. Así que, al menos en este caso concreto, el impacto nos hizo un gran favor, ya que, hizo posible que 65 millones de años más tarde pudiéramos llegar nosotros. Los dinosaurios dominaron el planeta durante 150 millones de años; nosotros, en comparación, llevamos tres días y, desde luego, ¡la que hemos formado!

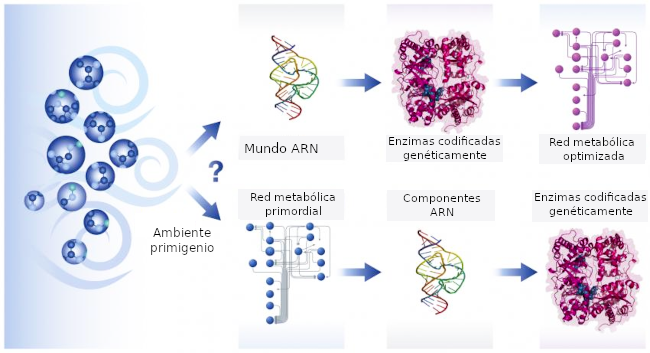

En nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. Hay algo inusual en esto. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas cristalicen los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono, etc.

Parece que la similitud en los “tiempos” no es una simple coincidencia. El argumento, en su forma más simple, lo introdujo Brandon Carter y lo desarrolló John D. Barrow por un lado y por Frank Tipler por otro. Al menos, en el primer sistema Solar habitado observado ¡el nuestro!, parece que sí hay alguna relación entre t(bio) y t(estrella) que son aproximadamente iguales el t(bio) –tiempo biológico para la aparición de la vida- algo más extenso.

La evolución de una atmósfera planetaria que sustente la vida requiere una fase inicial durante la cual el oxígeno es liberado por la fotodisociación de vapor de agua. En la Tierra esto necesitó 2.400 millones de años y llevó el oxígeno atmosférico a aproximadamente una milésima de su valor actual. Cabría esperar que la longitud de esta fase fuera inversamente proporcional a la intensidad de la radiación en el intervalo de longitudes de onda del orden de 1000-2000 ángstroms, donde están los niveles moleculares clave para la absorción de agua.

Este simple modelo indica la ruta que vincula las escalas del tiempo bioquímico de evolución de la vida y la del tiempo astrofísico que determina el tiempo requerido para crear un ambiente sustentado por una estrella estable que consume hidrógeno en la secuencia principal y envía luz y calor a los planetas del Sistema Solar que ella misma forma como objeto principal.

A muchos les cuesta trabajo admitir la presencia de vida en el Universo como algo natural y corriente, ellos abogan por la inevitabilidad de un Universo grande y frío en el que, es difícil la aparición de la vida, y, en el supuesto de que ésta aparezca, será muy parecida a la nuestra.

Creo que la clave está en los compuestos del carbono, toda la vida terrestre actualmente conocida exige también el Agua como disolvente. Y como para el carbono, se supone a veces que el agua es el único producto químico conveniente para cumplir este papel. El amoníaco (el nitruro de hidrógeno) es la alternativa ciertamente al agua, la más generalmente posible propuesta como disolvente bioquímico. Numerosas reacciones químicas son posibles en disolución en el amoníaco, y el amoníaco líquido tiene algunas semejanzas químicas con el agua. El amoníaco puede disolver la mayoría de las moléculas orgánicas al menos así como el agua, y por otro lado es capaz de disolver muchos metales elementales. A partir de este conjunto de propiedades químicas, se teorizó que las formas de vida basada en el amoníaco podrían ser posibles. También se dijo del Silicio. Sin embargo, ninguno de esos elementos son tan propicios para la vida como el Carbono y tienen, como ya sabemos, parámetros negativos que no permiten la vida tal como la conocemos.

Hasta el momento, todas las formas de vida descubiertas en la Tierra, están basadas en el Carbono.

Los biólogos, sin embargo, parecen admitir sin problemas la posibilidad de otras formas de vida, pero no están tan seguros de que sea probable que se desarrollen espontáneamente, sin un empujón de formas de vida basadas en el carbono. La mayoría de los estimaciones de la probabilidad de que haya inteligencias extraterrestres en el Universo se centran en formas de vida similares a nosotras que habiten en planetas parecidos a la Tierra y necesiten agua y oxígeno o similar con una atmósfera gaseosa y las demás condiciones de la distancia entre el planeta y su estrella, la radiación recibida, etc. En este punto, parece lógico recordar que antes de 1957 se descubrió la coincidencia entre los valores de las constantes de la Naturaleza que tienen importantes consecuencias para la posible existencia de carbono y oxígeno, y con ello para la vida en el Universo.

Hay una coincidencia o curiosidad adicional que existe entre el tiempo de evolución biológico y la astronomía. Puesto que no es sorprendente que las edades de las estrellas típicas sean similares a la edad actual del Universo, hay también una aparente coincidencia entre la edad del Universo y el tiempo que ha necesitado para desarrollar formas de vida como nosotros.

Si miramos retrospectivamente cuánto tiempo han estado en escena nuestros ancestros inteligentes (Homo sapiens) vemos que han sido sólo unos doscientos mil años, mucho menos que la edad del Universo, trece mil millones de años, o sea, menos de dos centésimos de la Historia del Universo. Pero si nuestros descendientes se prolongan en el futuro indefinidamente, la situación dará la vuelta y cuando se precise el tiempo que llevamos en el Universo, se hablará de miles de millones de años.

- C: Carbono

- H: Hidrógeno

- O: Oxígeno

- N: Nitrógeno

- P: Fósforo

- Fe: Hierro

- S: Azufre

- Ca: Calcio

- I: Yodo

- Na: Sodio

- K: Potasio

- Cl: Cloro

- Mg: Magnesio

- F: Flúor

- Cu: Cobre

- Zn: Zinc

- Glúcidos o Hidratos de Carbono

- Lípidos

- Proteínas

- Ácidos Nucleicos

Todos tienen encomendadas sus funciones.

A veces, nuestra imaginación dibuja mundos de ilusión y fantasía pero, en realidad… ¿serán sólo sueños?, o, por el contrario, pudieran estar en alguna parte del Universo todas esas cosas que imaginamos aquí y que pudieran estar presentes en otros mundos lejanos que, como el nuestro…posibilito la llegada de la vida.

Sí, imaginamos demasiado pero… ¿Qué hay más poderoso que la imaginación?

Brandon Carter y Richard Gott han argumentado que esto parece hacernos bastante especiales comparados con observadores en el futuro muy lejano.

¿Cuántos secretos están en esos números escondidos? La mecánica cuántica (h), la relatividad (c), el electromagnetismo (e–), Gravedad G. Todo eso está ahí escondido. El número 137 es un número puro y adimensional, nos habla de la constante de estructura fina alfa (α), y, el día que sepamos desentrañar todos sus mensajes… ¡Ese día sabremos!

Extraños mundos que pudieran ser

Podríamos imaginar fácilmente números diferentes para las constantes de la Naturaleza de forma tal que los mundos también serían distintos al planeta Tierra y, la vida no sería posible en ellos. Aumentemos la constante de estructura fina más grande y no podrá haber átomos, hagamos la intensidad de la gravedad mayor y las estrellas agotarán su combustible muy rápidamente, reduzcamos la intensidad de las fuerzas nucleares y no podrá haber bioquímica, y así sucesivamente.

Hay cambios infinitesimales que seguramente podrían ser soportados sin notar cambios perceptibles, como por ejemplo en la vigésima cifra decimal de la constante de estructura fina. Si el cambio se produjera en la segunda cifra decimal, los cambios serían muy importantes. Las propiedades de los átomos se alteran y procesos complicados como el plegamiento de las proteínas o la replicación del ADN pueden verse afectados de manera adversa. Sin embargo, para la complejidad química pueden abrirse nuevas posibilidades. Es difícil evaluar las consecuencias de estos cambios, pero está claro que, si los cambios consiguen cierta importancia, los núcleos dejarían de existir, no se formarían células y la vida se ausentaría del planeta, siendo imposible alguna forma de vida.

“Es difícil formular cualquier teoría firme sobre las etapas primitivas del universo porque no sabemos si hc/e2 es constante o varía proporcionalmente a log(t). Si hc/e2 fuera un entero tendría que ser una constante, pero los experimentadores dicen que no es un entero, de modo que bien podría estar variando. Si realmente varía, la química de las etapas primitivas sería completamente diferente, y la radiactividad también estaría afectada. Cuando empecé a trabajar sobre la gravedad esperaba encontrar alguna conexión ella y los neutrinos, pero esto ha fracasado.” – Dirac

Las constantes de la naturaleza ¡son intocables!

Ahora sabemos que el Universo tiene que tener miles de millones de años para que haya transcurrido el tiempo necesario par que los ladrillos de la vida sean fabricados en las estrellas y, la gravitación nos dice que la edad del Universo esta directamente ligada con otros propiedades como la densidad, temperatura, y el brillo del cielo.

Ahora, cuando miramos el Universo, comprendemos, en parte, lo que ahí está presente.

Puesto que el Universo debe expandirse durante miles de millones de años, debe llegar a tener una extensión visible de miles de millones de años luz. Puesto que su temperatura y densidad disminuyen a medida que se expande, necesariamente se hace frío y disperso. Como hemos visto, la densidad del Universo es hoy de poco más que 1 átomo por M3 de espacio. Traducida en una medida de las distancias medias entre estrellas o galaxias, esta densidad tan baja muestra por qué no es sorprendente que otros sistemas estelares estén tan alejados y sea difícil el contacto con extraterrestres. Si existe en el Universo otras formas de vía avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada, entonces, como nosotros, habrán evolucionado sin ser perturbadas por otros seres de otros mundos hasta alcanzar una fase tecnológica avanzada.

La expansión del Universo es precisamente la que ha hecho posible que el alejamiento entre estrellas con sus enormes fuentes de radiación, no incidieran en las células orgánicas que más tarde evolucionarían hasta llegar a nosotras, diez mil millones de años de alejamiento continuado y el enfriamiento que acompaña a dicha expansión, permitieron que, con la temperatura ideal y una radiación baja los seres vivos continuaran su andadura en este planeta minúsculo, situado en la periferia de la galaxia que comparado al conjunto de esta, es solo una cuota de polvo donde unos insignificantes seres laboriosos, curiosos y osados, son conscientes de estar allí y están pretendiendo determinar las leyes, no ya de su mundo o de su galaxia, sino que su osadía ilimitada les lleva a pretender conocer el destino de todo el Universo.

Cuando a solas pienso en todo esto, la verdad es que no me siento nada insignificante y nada humilde ante la inmensidad de los cielos. Las estrellas pueden ser enormes y juntas, formar inmensas galaxias… pero no pueden pensar ni amar; no tienen curiosidad ni en ellas está el poder de ahondar en el porqué de las cosas, nosotros si podemos hacer todo eso y más.

La estructura de los átomos y las moléculas está controlada casi por completo por dos números: la razón entre las masas del electrón y el protón b, que es aproximadamente igual a 1/1.836, y la constante de estructura fina a, que es aproximadamente 1/137. Supongamos que permitimos que estas dos constantes cambien su valor de forma independiente y supongamos también (para hacerlo sencillo) que ninguna otra constante de la Naturaleza cambie. ¿Qué le sucede al mundo si las leyes de la naturaleza siguen siendo las mismas?

Si deducimos las consecuencias pronto encontramos que no hay muchos espacios para maniobrar. Incrementemos b demasiado y no puede haber estructuras moleculares ordenadas porque es el pequeño valor de Beta (aF) el que asegura que los electrones ocupen posiciones bien definidas alrededor de un núcleo atómico y las cargas negativas de los electrones igualan las cargas positivas de los protones haciendo estable el núcleo y el átomo.

Si en lugar de a versión b, jugamos a cambiar la intensidad de la fuerza nuclear fuerte aF, junto con la de a, entonces, a menos que aF > 0,3 a½, los elementos como el carbono no existirían.

No podrían existir químicos orgánicos, no podrían mantenerse unidos. Si aumentamos aF en solo un 4 por 100, aparece un desastre potencial porque ahora puede existir un nuevo núcleo de helio, el helio-2, hecho de 2 protones y ningún neutrón, que permite reacciones nucleares directas y más rápidas que de protón + protón → helio-2.

Las estrellas agotarían rápidamente su combustible y se hundirían en estados degenerados o en agujeros negros. Por el contrario, si aF decreciera en un 10 por 100, el núcleo de deuterio dejaría de estar ligado y se bloquearía el camino a los caminos astrofísicos nucleares hacia los elementos bioquímicos necesarios para la vida.

Hasta donde sabemos, en nuestro sistema solar la vida se desarrolló por primera vez sorprendentemente pronto tras la formación de un entorno terrestre hospitalario. El secreto reside en el tiempo biológico necesario para desarrollar la vida y el tiempo necesario para desarrollar estrellas de segunda generación y siguientes que en novas y supernovas que llegaran a poder cristalizar los materiales complejos necesarios para la vida, tales como el hidrógeno, nitrógeno, oxígeno, carbono… Si miramos por ahí, encontraremos múltiples noticias como estas:

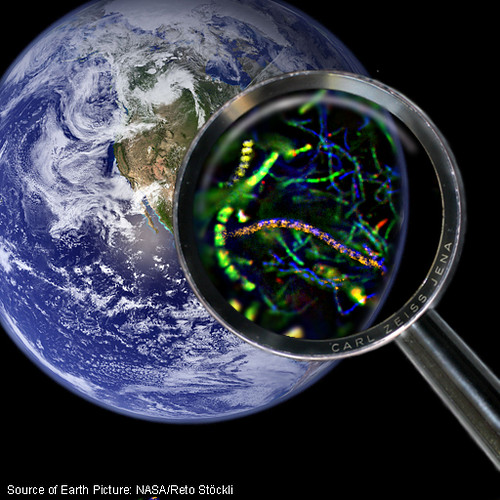

Telescopio Spitzer de la NASA ha detectado los pilares de la vida en el universo distante, aunque en un entorno violento. Ha posado su poderoso ojo infrarrojo en un débil objeto situado a una distancia de 3.200 millones de años luz (recuadro), Spitzer ha observado la presencia de agua y moléculas orgánicas en la galaxia IRAS F00183-7111.

Como podemos ver, amigos míos, la vida, como tantas veces vengo diciendo aquí, pulula por todo el Universo en la inmensa familia galáctica compuesta por más de ciento veinticinco mil millones y, de ese número descomunal, nos podríamos preguntar: ¿Cuántos mundos situados en las zonas habitables de sus estrellas habrá y, de entre todos esos innumerables mundos, cuántos albergaran la vida?

A muchos les cuesta trabajo admitir la presencia de vida en el universo como algo natural, ellos abogan por la inevitabilidad de un universo grande y frío en el que es difícil la aparición de la vida. Yo (como muchos otros), estoy convencido de que la vida es, de lo más natural en el universo y estará presente en miles de millones de planetas que, como la Tierra, tienen las condiciones para ello. Una cosa no se aparta de mi mente, muchas de esas formas de vida, serán como las nuestras aquí en la Tierra y estarán también, basadas en el Carbono. Sin embargo, no niego que puedan existir otras formas de vida diferentes a las terrestres.

Emilio Silvera Vázquez

Dic

27

Persiguiendo lo imposible

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Tendemos a retar parámetros de la naturaleza que parecen invencibles. Lo que habría que ver es si el coste del proyecto compensa a lo que nos dará. Podemos subir 32.000 Km hacia arriba pero…

Una vez arriba ¿Qué hacemos?

Si alguno de ustedes lo sabe… ¡Que nos lo diga!

Dic

27

¿Con qué ilusión esperamos el Nuevo Año?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (0)

Comments (0)

Fios los cría y ellos se juntan

Existen diversas dictaduras en el mundo, con ejemplos notables siendo Corea del Norte (dinastía Kim), China (Partido Comunista), Siria (régimen de Assad) e Irán (teocracia islámica), junto a otras naciones como Eritrea, Guinea Ecuatorial, Bielorrusia y Turkmenistán, caracterizadas por líderes autoritarios, falta de democracia, represión de la oposición y control estatal absoluto, aunque la clasificación puede variar entre regímenes autoritarios, totalitarios o híbridos.

Personajes como este ¿Dónde deberían estar? ¿Cómo hemos podido consentir que puedan surgir para causar tanto daño?

En México

En México, no hay una única entidad que “mande”, sino una lucha constante entre poderosos cárteles, destacando el Cártel de Sinaloa (CDS) y el Cártel de Jalisco Nueva Generación (CJNG) como los principales, que se disputan el control territorial, las rutas de tráfico y el poder, generando una fragmentación y guerra interna donde “Los Chapitos” (hijos del Chapo) y “La Mayiza” (facción de Ismael “El Mayo” Zambada) del CDS están en conflicto, mientras el CJNG expande su influencia, con estos grupos manejando gran parte del tráfico de drogas a EE. UU..

Más de mil millones de criaturas sometidas por la inhumana dictadura de personajes sin conciencia

Si los queremos poner a todos, nos faltaría espacio.

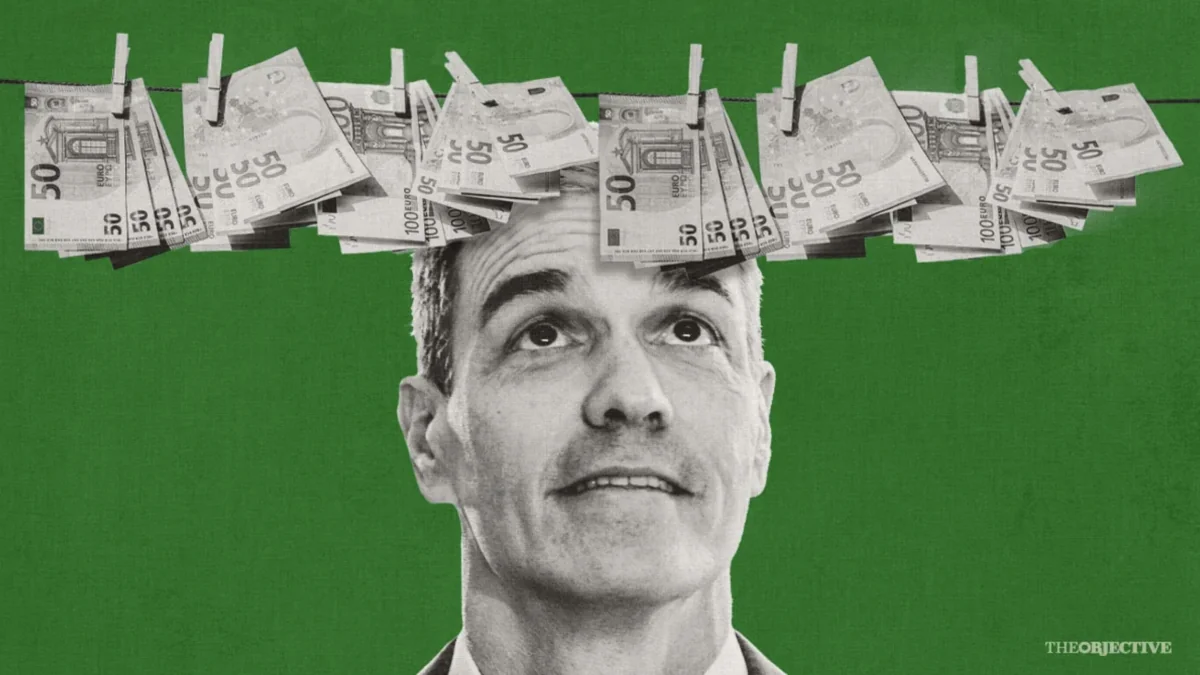

Veamos en España

El Fiscal General del Estado Condenado

Altos cargos del Gobierno detenido y encarcelado

El Ministro y su Asesor en la Cárcel

Denuncia de Acoso a mujeres de altos cargos del partido Socialista en el Gobierno

El Madrid lujoso de la trama corrupta: mesa en Ramses, prostíbulo en el Viso, hotel en Sol y visitas al Congreso.

La trama se movía por un radio reducido durante la pandemia mientras recurría a los servicios de prostitutas de lujo.

El conocido como Caso Mediador tiene su propia ruta de la corrupción. Un recorrido que va desde el centro del poder político hasta el lumpen de alto standing con cocaína, prostitutas, y viagra mediante. Un camino que, además, era cíclico: «Era toda la noche de juerga, y al Congreso al día siguiente con gafas de sol», contó Antonio Navarro, alias el Mediador, en una entrevista a EL MUNDO.

Dudoso “rescate” con dinero público de ignorado destino final

Anticorrupción investiga si Plus Ultra derivó dinero del … La Fiscalía Anticorrupción investiga si la compañía aérea Plus Ultra desvió el dinero del rescate de 53 millones de euros que el Gobierno le …

El rescate de Air Europa se resolvió en solo dos meses frente a los 12 del resto de casos.

La UCO cree probado que José Luis Ábalos, Víctor de Aldama y Koldo García intermediaron para agilizar la operación.

¿Quiénes han cobrado comisiones por este dudoso rescate en el que intervino de manera muy directa la mujer del Presidente?

El hermano del Presidente Sánchez imputado por tráfico de influencias, al serle adjudicado un puesto en el Conservatorio de Música de Extremadura , al que no fue nunca, y cobraba pero no pagaba los impuestos alegando que vivía en Portugal, lo que no impide, aplicando la Ley, que tuviera que cotizar en España al cobrar de un Organismo Público del Estado. Lo más vergonzoso (si admitimos que pueda ser posible), es que Hacienda, avaló en un informe, que no tenía que contribuir.

La Ley de Amnistía a separatistas catalanes, impulsada por Pedro Sánchez, es extremadamente polémica y divisiva, descrita por sus críticos como una “vergüenza” y un “intercambio de poder” a cambio de apoyo para su investidura, violando la Constitución según juristas, mientras que el gobierno la defiende como una vía para la normalización política y social en Cataluña tras el procés, aunque su aplicación y constitucionalidad sigue siendo objeto de debate y recursos judiciales.

Sánchez invade el Constitucional, el Consejo de Estado, la Fiscalía, el Poder Judicial…

Reparte dinero a los medios como si fuera suyo, los quiere tener bien calladitos y apoyando sus ?felonías?

Lo que no podré nunca llegar a comprender, es como un personaje de este pelaje ha podido llegar a ocupar el puesto que ocupa, y, tampoco comprendo como el pueblo lo consiente. ¿No sería más que justificado que el país entero se paralizara hasta que se fuese este sujeto?

Bueno, y así el panorama en el mundo y sobre todo aquí, en España, ¿Qué ilusión podemos tener en la entrada del nuevo años?

Tampoco comprendo como no se han unido los autónomos para negarse a que les roben de esa manera, trabajan medio año para Hacienda, la Agencia Tributaria vulnera el artículo 31 de la Constitución que nos dice que todos debemos contribuir a los gastos generales del Estado de manera proporcional a los ingresos y no consiente la confiscación que es lo que se está haciendo por parte de Hacienda.

Bueno, la esperanza es lo último que se pierde, esperemos que todo cambie para mejor en todos los lugares del mundo. Lo que está pasando, lo que ha pasado, y, lo que se vislumbra que puede pasar en el futuro, nos viene a confirmar que, nuestra especie, aún no alcanzó el nivel de humanización que sería deseable, es decir, que lleguemos a sentir el dolor ajeno como el propio dolor.

¿Qué soy un iluso? No lo niego, y reconozco que el cambio que pido es una utopía, la parte animal que nos conforma y está en nuestros genes, tiene mucha fuerza, sale a la superficie con el egoísmo, la envidia que son parte de nuestra naturaleza. Sí, tenemos otras cualidades que nos mejoran pero… ¡Están circunscritas al ámbito familiar! El único lugar en el que somos mejores.

¿Feliz año nuevo? Bueno, que sea lo que la Conciencia Cósmica nos tenga destinados.

Emilio Silvera V.

Totales: 86.169.316

Totales: 86.169.316 Conectados: 83

Conectados: 83