Ago

31

La Física no duerme

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

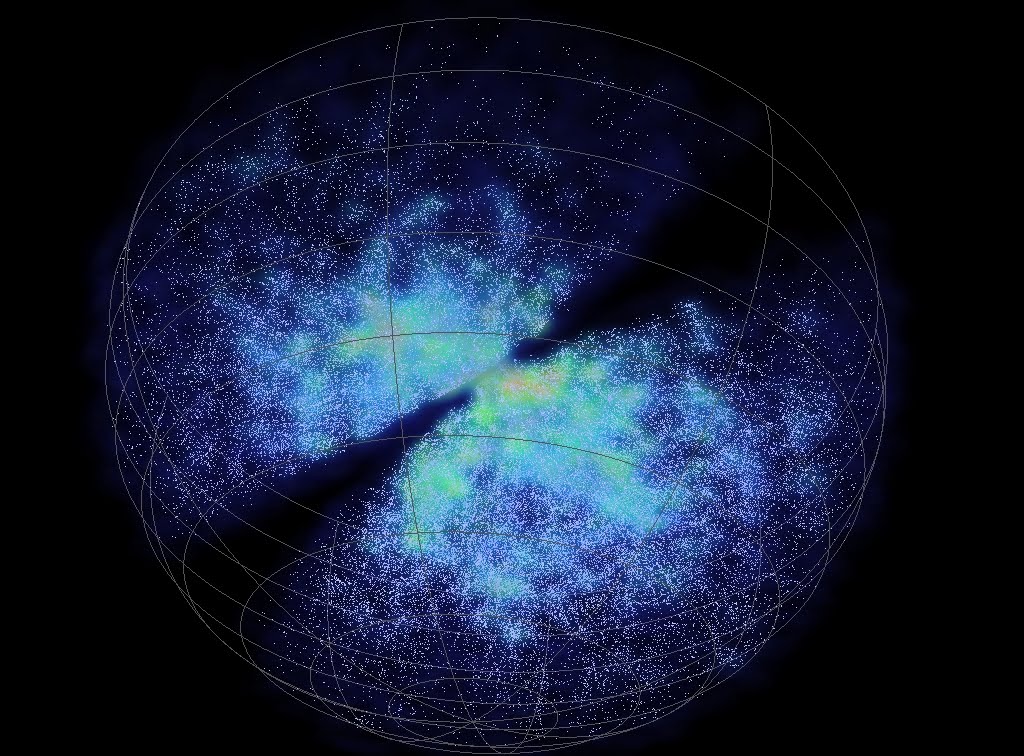

Se quiere publicar los resultados completos obtenidos en BaBar detector Y Belle

” Durante la última década BaBar y Belle han estudiado la física de la parte inferior y el encanto mesones, leptones tau, estados quarkonium pesados, etc, que se produjeron en el PEP-II y anillos KEKB e + e-almacenamiento. Las dos colaboraciones desarrolladas contiuously cada vez más sofisticadas técnicas para extraer la máxima cantidad de información de los datos.

A menudo, estas técnicas se han utilizado en muchos análisis. Sin embargo, como la mayoría de BaBar de y más de 600 publicaciones de Belle son en la revista Physical Review Letters, Physical Review D Rapid Communications, y Physics Letters, donde el límite de páginas impuestas por las revistas no permiten una descripción completa de los análisis, muchos detalles de esta obra nunca se han publicado. La física de los B-Fábricas abordarán este problema proporcionando descripciones de todas las técnicas desarrolladas por los experimentos, y una visión global de las mediciones. Esto proporcionará una referencia esencial para los físicos que trabajan en la próxima generación de Fábricas Súper sabor”

Future Analysis

“Más de ocho años de datos de física de partículas cristalinas se mantienen disponibles para su análisis o re-análisis por lo menos hasta 2018, ahora ese proyecto a largo plazo de acceso a datos de BaBar es completa. El proyecto conserva un conjunto completo de datos de BaBar – todos femtobarns 530-plus inversas de ella – por, en cierto sentido, el tiempo de parada para ello, integrándola en un seguro de las actualizaciones, correcciones de errores y parches capullo computacional. Cualquier cosa que pueda interrumpir el ambiente de computación en donde se guarda cuidadosamente los datos se aloja por una disposición inteligente de los servidores, software y máquinas virtuales en red.

El proyecto BaBar LTDA es parte de un creciente movimiento para preservar los datos conseguidos con tanto esfuerzo para las generaciones futuras, en lugar de permitir que se desvanezca en el olvido, atrapado en medios de almacenamiento que han quedado obsoletas. BaBar tomó datos de las colisiones electrón-positrón en PEP II colisionador de SLAC 1999-2008, mientras que en busca de indicios de por qué la materia y la antimateria no llena el universo en su lugar.

Photos: Reidar Hahn, Fermilab

Cuando el experimento BaBar en el SLAC National Accelerator Laboratory cerró en abril de 2008, que puso fin a casi nueve años de la toma de datos en las desintegraciones de partículas subatómicas llamadas mesones B. Pero eso era apenas el final de la historia de los 500 científicos que trabajan en el experimento. En noviembre se celebraba la publicación de su artículo 400, y que esperan que los próximos años van a producir al menos 100 más.

No sólo son investigadores BaBar ocupados explorar las sutilezas de sus preguntas originales, pero también están utilizando datos BaBar para arrojar luz sobre otros misterios que pueden y de hecho surgir. Ahora los datos están listos.

“Somos el primer esfuerzo de conservación de datos para llegar a un estado tan madura”, a pesar de los numerosos criterios del proyecto LTDA debía cumplir, dijo Tina Cartaro, coordinador de informática de Babar. Los datos tuvieron que ser fácil de administrar y fácil de mantener con un mínimo de esfuerzo, agregó la coordinadora Tina Cartaro.”

Entre 1999 y 2008, en el acelerador de partículas del SLAC, se produjeron más de 500 millones de mesones B, y sus contrapartidas de antimateria llamados B-bar. Así, los científicos observaron cómo estas partículas incumplían la simetría CP. El problema para observar la ruptura de la simetría T residía en que los mesones B se desintegran irreversiblemente en pocas billonésimas de segundo, impidiendo invertir su situación inicial y final. La solución se ha encontrado mediante la correlación cuántica entre los dos B, que permite que la información de la partícula que se desintegra primero se utilice en ese momento para determinar el estado de su partícula compañera que aún vive. Los investigadores han descubierto que el estado de este último mesón B se transforma en otro unas seis veces más a menudo en un sentido que en el inverso.

Observan la ruptura de simetría temporal en un líquido de spín quiral gracias al efecto Hall anómalo

En física no se deja de experimentar para saber como funciona la Naturaleza y si sus leyes son estables. Por ejemplo, el magnetismo de un imán es debido a los momentos magnéticos libres (espines) de los átomos que lo constituyen. En un material paramagnético, al aplicar un campo magnético, estos espines se alinean paralelamente al campo, en otro caso están orientados al azar. Un imán permanente es un material ferromagnético en el que el acoplamiento entre los espines es suficientemente fuerte para mantener su alineamiento. Muchos materiales paramagnéticos dejan de serlo a muy baja temperatura debido a una ruptura espontánea de la isotropía (simetría continua de rotación) en su estado fundamental. Un paramagneto cuántico es un material que mantiene su paramagnetismo a temperaturas muy bajas.

“Ruptura de simetría en el tiempo en las leyes de la Física Una investigación liderada por el Instituto de Física Corpuscular, centro mixto del CSIC y la Universidad de Valencia, ha obtenido evidencias de la ruptura de la simetría en el tiempo en las leyes de la Física. El hallazgo, que se publica en la revista Physical Review Letters, ha contado con el apoyo de la colaboración internacional BaBar del laboratorio SLAC (Stanford Linear Accelerator Center) del Departamento de Energía de Estados Unidos en la Universidad de Stanford (California).

En experimentos previos con partículas conocidas como mesones K y B, se observó que no se cumplía la simetría CP. El teorema CPT indica que, para cualquier sistema de partículas, las simetrías deben mantenerse equilibradas, es decir, si la simetría CP no se cumple, la simetría T tampoco. El investigador Fernando Martínez Vidal añade que “la clave para medir directamente la ruptura de la simetría T nos la dio el experimento BaBar del SLAC, que fue diseñado para el estudio en profundidad de la asimetría entre materia y antimateria”.

“Cualquier indicio de ruptura de la simetría CPT requeriría un serio replanteamiento de nuestro entendimiento de la Naturaleza”

Eso es lo que han dicho reputados físicos reconocidos mundialmente, y, si eso es así (que lo es), parece que estamos entrando en una nueva era del conocimiento. El tiempo discurre inexorablemente. En la historia del universo y en los sistemas complejos, la evolución temporal está asociada al aumento de entropía. Dicho de otro modo, con el paso del tiempo, el desorden siempre crece a partir de una situación inicial más ordenada.

El Universo como sistema cerrado está aumentando constantemente su entropía. Acodáos de la sencilla y maravillosa ecuación S = k log W que figura en la cabecera de la lápida de Boltzmann como reconocimiento a su ingenio. La sencilla ecuación (como todas las que en Física han tenido una enorme importancia, es la mayor aportaciópn de Boltzmann y una de las ecuaciones más importantes de la Física. El significado de las tres letras que aparecen (aparte la notación para el logaritmo es el siguiente: S es la entropía de un Sistema; W el número de microestados posibles de sus partículas elementales y k una constante de proporcionalidad que hoy día recibe el nombre de constante de Boltzmann y cuyo valor es k = 1,3805 x 10-23 J(K (si el logaritmo se toma en base natural). En esta breve ecuación se encierra la conexión entre el micromundo y el macromundo, y por ella se reconoce a Boltzmann como el padre de la rama de la Física comocida como Mecánica Estadistica.

El tiempo discurre inexorablemente. En la historia del universo y en los sistemas complejos, la evolución temporal está asociada al aumento de entropía. Dicho de otro modo, con el paso del tiempo, el desorden siempre crece a partir de una situación inicial más ordenada.

Para explicarlo, podemos imaginar que vemos hacia atrás una película en la que un jarrón cae al suelo y se rompe en pedazos. Veremos como retroceden las imágenes y las piezas rotas del jarrón se vuelven a juntar para mostrarse de nuevo perecto. Nos percataríamos muy rápido de que lo que observamos es imposible desde el punto de vista de las leyes físicas, porque sabemos que no es posible que los pedazos vuelen del suelo y se ordenen formando un jarrón. Y eso es porque desde nuestro punto de vista, “

Lo que se rompe roto queda en el pasado y todo corre hacia el futuro

Ahora bien, para una partícula aislada, el paso del tiempo parece el mismo hacia delante y hacia atrás, es decir, su movimiento es reversible o temporalmente simétrico. Imaginemos que ahora vemos una película en la que aparece una bola de billar que choca contra una banda. Si no nos lo dicen, no seríamos capaces de saber si la proyección de la película va hacia delante o hacia atrás. Esto se debe a que, en ambos sentidos temporales, el movimiento de la bola de billar cumple las mismas leyes físicas. Este concepto se conoce como simetría bajo inversión temporal y nos dice que, en el mundo de las partículas, las teorías físicas son válidas tanto para un sentido de su movimiento como para su inverso, lo que equivale a decir que funcionan igual hacia delante como hacia atrás en el tiempo.

El tiempo tiene una dirección preferente

El investigador José Bernabéu explica: “La ruptura de la simetría temporal o simetría T en física de partículas está relacionada con la asimetría CP existente entre materia y antimateria, necesaria para generar el universo actual de materia en algún momento de su historia. La simetría C afirma que, sabiendo que a cada partícula de la naturaleza le corresponde una antipartícula con carga opuesta, las leyes de la física serían las mismas al intercambiar las partículas con carga positiva con las de carga negativa”.

En el Universo que observamos si existe la antimateria, no la hemos podido localizar de manera innegable y, es posible que ande por ahí y que, incluso, algunos de los fenómenos energéticos de grandes explosiones Gamma que se han detectado pudieran ser el resultado del encuentra de objetos de materia con otros de antimateria pero… ¡No lo sabemos! Si el telescopio Hubble, por ejemplo, captara la imagen de una hermosa galaxias de antimatería, no lo sabríamos, ya que sería exacta a la imagen de la misma galaxia de materia.

Dos representaciones dimensionales de paridad son dadas por un par de estados cuánticos que van entre ellos sobre la paridad. Sin embargo, esta representación puede reducirse siempre a combinaciones lineales de estados; cada uno de ellos es par o impar bajo la paridad. Se dice que todas las representaciones irreductibles de la paridad son de dimensión 1.

La paridad es la simetría de Alicia en el país de las maravillas a través del espejo. La simetría P de una ley física indica que dicha ley es invariante si reflejamos el universo en un espejo. La teoría electrodébil de la fuerza nuclear débil en desintegraciones de partículas que involucran neutrinos viola la simetría P lo que fue toda una revolución en su momento (Premio Nobel de Física en 1957, justo un año después del descubrimiento). La cromodinámica cuántica, la teoría de la fuerza fuerte, no viola la paridad (en el mismo sentido que la teoría electrodébil). Sin embargo, como se teorizó hace más de 10 años (Dmitri Karzeev et al., PRL 1998) y se ha descubierto experimentalmente…

Pero hablábamos de simetría y la simetría P, que señala que las leyes de la física permanecerían inalteradas bajo inversiones especulares, es decir, el universo se comportaría igual que su imagen en un espejo. Estas dos simetrías combinadas dan lugar a la simetría carga-paridad o simetría CP. En experimentos previos con partículas conocidas como mesones K y B, se observó que no se cumplía la simetría CP. El teorema CPT indica que, para cualquier sistema de partículas, las simetrías deben mantenerse equilibradas, es decir, si la simetría CP no se cumple, la simetría T tampoco.

La simetría CPT es un principio fundamental de invariancia o simetría de las leyes físicas que establece que bajo transformaciones simultáneas que involucren la inversión de la carga eléctrica, la paridad y el sentido del tiempo las ecuaciones de evolución temporal de un proceso físico y las de un proceso análogo en que:

- Conjugación de carga (C).Todas las partículas se sustituyen por sus correspondientes antipartículas.

- Inversión de paridad (P). Se invierte la paridad espacial de proceso (esto tiene que ver con el intercambio de derecha e izquierda, y con el cambio en el espin de las partículas).

- Inversión temporal (T). Se invierte el sentido del tiempo.

son invariantes y vienen descritos por las mismas ecuaciones y arrojan los mismos resultados. Pero la Física es amplia y podríamos también, hablar aquí de sus teorías como, por ejmplo…

Partículas y campos, clásicos y cuánticos. Las nociones clásicas de partícula y campo comparadas con su contrapartid cuántica. Una partícula cuántica está deslocalizada: su posición se reparte en una distribución de probabilidad. Un campo cuántico es equivalente a un colectivo de partículas cuánticas.

La teoría cuántica de campos es una disciplina de la físicaque aplica los principios de la mecñanica cuántica a los sistemas clásicos de campos contiinuos, por ejemplo, el campo electromanético. Una consecuencia inmediata de esta teoría es que el comportamiento cuántico de un campo continuo es equivalente al de un sistema de partículasn 1 cuyo número no es constante, es decir, que pueden crearse o destruirse. También se la denomina teoría de campos cuánticos, TCC o QFT, sigla en inglés de quantum field theory.

Su principal aplicación es la fñisica de altas energías, donde se combina con los postulados de la relatividad especial. En este régimen se usa para estudiar las partículas subatómicas y sus interacciones, y permite explicar fenómenos como la relación entre espín y estadística, la la simetría CPT, la existencia de la antiomateria, etc.

Dispersión de neutrones. La dispersión inelásctivca de neutrones en un cristal es el resultado de la interacción de un neutrón lanzado contra los átomosá en vibración de la red cristalina. En teoría cuántica de campos, el proceso se modeliza de manera más sencilla al introducir los cuantos de las ondas sonoras del cristal, los fonones, entendiéndolo como la absorción o emisión de un fonón por el neutrón.

Pero sigamos con el Teorema CPT, en vitud del cual la operación combinada de cambiar la conjunción de carga C, la paridad P y la inversión temporal T, denotada CPT, es una simetría fundamental de las teorías cuánticas de campo relativistas. A pesar de todo lo que se diga, no se conoce ninguna experiencia de la violación del Teorema CPT. Cuando C, P y T (o dos cualquiera de ellas) son violadas, los principios de la Teoría cuántica de campos relativista no se ven afectados. Sin embargo, la violación de la invariancia CPT cambiaría drásticamente los fundamentos de la teoría cuántica de campos relativista. No se conoce si las supercuerdas o las supersimetrías obedecen versiones del Teorema CPT.

La simetría CPT es una simetría fundamental de las leyes físicas bajo transformaciones que implican la inversión simultánea de la carga, la paridad, y el tiempo. Una consecuencia de esta derivación es que la violación de la CPT indica automáticamente una violación de Lorentz. La implicación de la simetría CPT es que una “imagen en espejo” de nuestro universo – con todos los objetos que tienen sus posiciones reflejadas en un plano imaginario, toda momentos invierte y con toda la materia reemplazado por antimateria – evolucionaría exactamente bajo nuestras leyes físicas. La transformación CPT convierte nuestro universo su “imagen en espejo” y viceversa en. La simetría CPT es reconocida como una propiedad fundamental de las leyes físicas.

La teoría de las partículas elementales considera tres formas básicas de simetría: simetría especular, simetría de carga y simetría temporal (en el lenguaje de la física la simetría especular es denominada P, de paridad; la simetría de carga, C y la simetría temporal,T).

En la simetría especular todos los sucesos ocurren exactamente igual si son observados directamente o reflejados en un espejo. Ello implica que no existe ninguna diferencia entre izquierda y derecha y nadie sería capaz de distinguir su propio mundo de otro reflejado en un espejo. La simetría de carga predice que las partículas cargadas se comportarán exactamente igual que sus antipartículas, las cuales tiene exactamente las mismas propiedades pero carga opuesta. Y de acuerdo con la simetría temporal, las cosas sucederían exactamente igual con independencia de que el tiempo transcurra hacia delante o hacia atrás.

Publica emilio silvera

Fuentes diversas.

Ago

29

Si la Naturaleza bosteza… ¡Nosotros a Temblar!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Catástrofes Naturales ~

Clasificado en Catástrofes Naturales ~

Comments (1)

Comments (1)

Alerta Roja en Islandia pendiente de una peligrosa erupción volcánica.

Se ha producido una erupción en el volcáb Bárdarbunga, al norte del Glacial Dyngjujokull.

El Volcan llevaba en silencio más de cien años. Claro que, los ciclos de la Naturaleza son mayores que los de los humanos.

Imagen del 18 de abril de 2010 que muestra humo y cenizas saliendo del volcán Eyjafjallajokull S.OLAFS EFE

La Oficina Meteorológica de Islandia (IMO) detectó este viernes una erupción en una fisura en el norte del volcán Bárdarbunga y elevó a rojo el nivel de alerta para la aviación sobre la zona, aunque aún no ha detectado cenizas.

La erupción comenzó al norte del glaciar Dyngjujökull pasada la medianoche y cerca de dos horas y cuarenta minutos pareció que la actividad disminuía.

En Islancia ya tienen experiencia de estos sucesos

El temblor sísmico fue registrado por la cámara web situada en el área y también por todas las estaciones sísmicas.

El Bárdarbunga, uno de los volcanes de mayor tamaño de Islandia, está bajo un glaciar y no entra en erupción desde hace más de un siglo.

Fuente: El MUNDO.

Ago

27

El patinazo del ‘GPS’ europeo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Noticias ~

Clasificado en Noticias ~

Comments (0)

Comments (0)

Así titulan la noticia publicada en el MUNDO

-

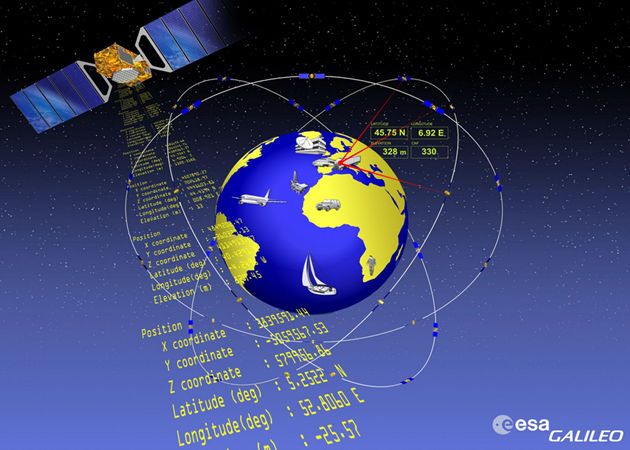

Los ingenieros de la ESA estudian cómo recuperar los dos satélites de la constelación ‘Galileo’ que, tras ser lanzados el pasado viernes, se situaron en una órbita incorrecta.

Recreación artística de los dos satélites FOC lanzados el viernes. ESA

Recreación artística de los dos satélites FOC lanzados el viernes. ESA

«Hemos tenido que hacer una parada en una estación imprevista, pero [el sistema de navegación por satélite] Galileo es un tren que sigue en marcha y el viaje continúa». Así resumía ayer a este diario desde París el portavoz de la Agencia Espacial Europea (ESA) la situación tras el fallido lanzamiento, el pasado viernes, de los dos primeros satélites con capacidad plena de operaciones de Galileo, el flamante sistema de navegación europeo que se espera que esté completamente operativo en 2020.

Estos dos primeros satélites FOC (Full Operational Capability o Capacidad Plena de Operaciones) despegaron el viernes a bordo de un cohete ruso Soyuz desde Kurú, en la Guayana Francesa. Al cabo de varias horas, los ingenieros de la ESA y de Arianespace, la empresa que se encarga del lanzamiento, detectaron que no habían sido colocados en la órbita prevista. En lugar de situarse en una órbita circular a 29.900 kilómetros, estaban en una órbita elíptica a 26.200 km.

MADRID, 24 Ago. (EUROPA PRESS) –

Una comisión de expertos investiga lo ocurrido y estudia qué pasos van a seguir para intentar recuperar los satélites para el programa Galileo o, al menos, darles otra finalidad. Según asegura la ESA, los aparatos funcionan perfectamente, están controlados en todo momento desde su centro de operaciones ESOC en Darmstadt (Alemania) y no suponen ninguna amenaza para la población.

El fallo técnico, al parecer, se produjo durante la última fase del cohete, llamada Fregat. Determinar la causa exacta que provocó que los satélites no entraran en la órbita deseada es particularmente importante y urgente, pues para el próximo diciembre está previsto el lanzamiento de otros dos satélites Galileo también a bordo de un cohete ruso Soyuz. El primer lanzamiento de 2015 se hará, sin embargo, con un cohete Ariane 5.

«Hay posibilidades de resolver el problema. No estamos en una situación desesperada. Esperamos que la comisión de investigación que comenzó a trabajar el lunes nos ofrezca una respuesta rápida que nos permita mantener el calendario de próximos lanzamientos», señala por teléfono el portavoz de ESA.

Una de las opciones que barajan, explica, es utilizar su propio combustible para conducirlos a la órbita deseada. Sin embargo, tendrán que decidir si compensa hacer algo así, pues las maniobras consumirían buena parte de los 70 kilos de carburante que lleva a cada uno. Es el que necesitan para completar sus 12 años de vida, que se reducirían significativamente tras la operación. Y en el peor de los escenarios, señala, los satélites serían utilizados en una misión tecnológica, para hacer pruebas y aprovechar su capacidad al máximo.

Los primeros cuatro satélites de la constelación Galileo, que estará integrada por un total de 30 aparatos, eran de prueba y fueron puestos en órbita con éxito en dos lanzamientos en 2011 y 2012. «Han demostrado ya que Galileo funciona», señala.

El coste del programa

Pese a que existen opciones para que este lanzamiento no sea un completo fracaso, el fallo supone un revés para Galileo, un programa conjunto de la ESA y la Comisión Europea cuya gestión y puesta en marcha ha recibido críticas tanto por la década de retraso que lleva respecto al calendario previsto en 2000, cuando se originó, como por la inversión que ha supuesto. Según la ESA, su coste total es de 5.000 millones de euros. La Comisión Europea, por su parte, ha exigido un plan de acción para corregir el fallo.

Por lo que respecta a los dos satélites lanzados el viernes, cada uno tiene un coste de 35 millones. Si no se logra recuperarlos para Galileo, tendrán que construir otros dos. Es la opción que considera más probable Antonio Juan Fernández, responsable de la Unidad de Negocio del área de Navegación por Satélite de Elecnor Deimos, una de las empresas que trabaja en el control de la misión Galileo desde los centros de tierra. Según explica, el principal problema no es la altura a la que están, sino el tipo de órbita, que es elíptica y no circular.

«Supongo que tratarán de llevarlos a una órbita que sea lo más útil posible reduciendo su excentricidad, es decir, que no sea tan elíptica y sea lo más circular posible. Intentarán maximizar la cobertura con los cuatro que ya tienen en órbita y podrán usarlos para hacer pruebas», añade el ingeniero, que considera que «no se trata de un fracaso total».

Basándose en los datos ofrecidos sobre su actual localización, el veterano ingeniero aeroespacial Víctor Rodrigo opina que «estando en buenas condiciones los satélites y al haber desplegado los paneles solares, lo más probable es que los dejen en la órbita que están, pues con una excentricidad pequeña de 0,23 el perigeo está a unos 20.000 km». Por ello, Rodrigo considera «que podrán funcionar razonablemente bien» y los demás satélites de la constelación compensarían el menor rendimiento de los otros dos. Aunque considera que «la situación es complicada», no cree que sea «un fallo catastrófico». «Lo peor es cuando falla el satélite, pero el problema aquí ha sido por el lanzador. Estoy convencido de que alguna solución encontrarán».

Hasta aquí la noticia que, como tantas otras veces, nos muestra que no somos infalibles y, como humanos que somos, nos equivocamos. Sobre todo ocurren cosas así cuando son muchos los que intervienen y no todos, están siempre bien coordinados. El fallo es una falta grave de control, toda vez que antes de “pulsar el botón”, hay que cerciorarse una y mil veces de que estará bien pulsado. ¡El coste es inmenso!

Ago

26

¡Aquellos primeros momentos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Descubrir y aprender ~

Clasificado en Descubrir y aprender ~

Comments (0)

Comments (0)

¡El Universo!

Antes de alrededor de un minuto y cuarenta segundos desde el comienzo del tiempo, no hay núcleos atómicos estables. El nivel de energía en el ambiente es mayor que la energía de unión nuclear. Por consiguiente, todos los núcleos que se forman, se destruyen de rápidamente.

Alrededor de un segundo desde el comienzo del tiempo, llegamos a la época de desacoplamiento de los neutrinos. Aunque en esa época el Universo es más denso que las orcas (y tan caliente como la explosión de una bomba de hidrógeno), ya ha empezado a parecer vacío a los neutrinos. Puesto que los neutrinos sólo reaccionan a la fuerza débil, que tiene un alcance extremadamente corto, pueden escapar de sus garras y volar indefinidamente sin experimentar ninguna otra interacción.

Aunque parezca mentira, al día de hoy no sabemos, a ciencia cierta, como se formaron las galaxias

Así, emancipados, en lo sucesivo son libres de vagar por el Universo a su manera indiferente, volando a través de la mayor de la materia como sino existiese. (Diez trillones de neutrinos atravesarán sin causar daños el cerebro y el cuerpo del lector en el tiempo que le lleve leer esta frase. Y en el tiempo en que usted haya leído esta frase estarán más lejos que la Luna).

En menos de un siglo, el neutrino pasó de una partícula fantasma – propuesta en 1930 por el físico austríaco Wolfgang Pauli (1900-1958) a explicar el balance de energía en una forma de radioactividad, el llamado decaimiento beta, en una sonda capaz de escrutar el interior de estrellas y de la propia Tierra.

De esa manera, oleadas de neutrinos liberados en un segundo después del big bang persiste aún después, formando una radiación cósmica de fondo de neutrinos semejante a la radiación de fondo de microondas producida por el desacoplamiento de los fotones.

Si estos neutrinos “cósmicos” (como se los llama para diferenciarlos de los neutrinos liberados más tarde por las supernovas) pudiesen ser observador por un telescopio de neutrinos de alguna clase, proporcionarían una visión directa del Universo cuando sólo tenía un segundo.

A medida que retrocedemos en el tiempo, el Universo se vuelve más denso y más caliente, y el nivel de estructura que puede existir se hace cada vez más rudimentario.

Por supuesto, en ese tiempo, no hay moléculas, ni átomos, ni núcleos atómicos, y, a 10-6 (0.000001) de segundo después del comienzo del tiempo, tampoco hay neutrones ni protones. El Universo es un océano de quarks libres y otras partículas elementales.

Si nos tomamos el de contarlos, hallaremos que por cada mil millones de antiquarks existen mil millones y un quark. asimetría es importante. Los pocos quarks en exceso destinados a sobrevivir a la aniquilación general quark-antiquark formaran todos los átomos de materia del Universo del último día. Se desconoce el origen de la desigualdad; presumiblemente obedezca a la ruptura de una simetría materia antimateria en alguna etapa anterior.

Nos aproximamos a un tiempo en que las estructuras básicas de las leyes naturales, y no sólo las de las partículas y campos cuya conducta dictaban, cambiaron a medida que evolucionó el Universo.

La primera transición semejante se produjo en los 10-11 de segundo después del comienzo del tiempo, cuando las funciones de las fuerzas débiles y electromagnéticas se regían por una sola fuerza, la electrodébil. hay bastante energía ambiente para permitir la creación y el mantenimiento de gran de bosones w y z.

Estas partículas – las mismas cuya aparición en el acelerador del CERN verificó la teoría electrodébil – son las mediadoras intercambiables en las interacciones de fuerzas electromagnéticas y débiles, lo que las hace indistinguibles. En ese tiempo, el Universo está gobernando sólo por tres fuerzas: la gravedad, la interacción nuclear fuerte y la electrodébil.

Más atrás de ese tiempo nos quedamos en el misterio y envueltos en una gran nebulosa de ignorancia. Cada uno se despacha a su gusto para lanzar conjeturas y teorizar sobre lo que pudo haber sido. Seguramente, en el futuro, será la teoría M (de supercuerdas) la que contestará esas preguntas sin respuestas ahora.

En los 10-35 de segundo desde el comienzo del tiempo, entramos en un ámbito en el que las cósmicas son aún menos conocidas. Si las grandes teorías unificadas son correctas, se produjo una ruptura de la simetría por la que la fuerza electronuclear unificada se escindió en las fuerzas electrodébil y las fuertes. Si es correcta la teoría de la supersimetría, la transición puede haberse producido antes, había involucrado a la gravitación.

En el universo temprano la primera materia (hidrógeno y Helio) era llevada por la fuerza de gravedad a conformarse en grandes conglomerados de gas y polvo que interacioban, producían calor y formaron las primeras estrellas.

Elaborar una teoría totalmente unificada es tratar de comprender lo que ocurrió en ese tiempo remoto que, según los últimos estudios está situado entre 15.000 y 18.000 millones de años, cunado la perfecta simetría que, se pensaba, caracterizó el Universo, se hizo añicos para dar lugar a los simetrías rotas que hallamos a nuestro alrededor y que, nos trajo las fuerzas y constantes Universales que, paradójicamente, hicieron posible nuestra aparición para que , sea posible que, alguien como yo esté contando lo que pasó.

Pero hasta que no tengamos tal teoría no podemos esperar comprender lo que realmente ocurrió en ese Universo bebé. Los límites de nuestras conjeturas actuales cuando la edad del Universo sólo es de 10-43 de segundo, nos da la única respuesta de encontrarnos ante una puerta cerrada.

Del otro lado de esa puerta está la época de Plank, un tiempo en que la atracción gravitatoria ejercida por cada partícula era comparable en intensidad a la fuerza nuclear fuerte.

La fuerza nuclear fuerte hizo posible la existencia de los núcleos que atraían electrones para formar átomos

Así que, llegados a este punto podemos decir que la clave teórica que podría abrir esa puerta sería una teoría unificada que incluyese la gravitación, es decir, una teoría cuántica-gravitatoria que uniese, de una vez por todas, a Planck y Einsteins que, aunque eran muy amigos, no parecen que sus teorías (la Mecánica Cuántica) y (la Relatividad General) se lleven de maravilla.

emilio silvera

Ago

25

MISIÓN MARTE 2020

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Marte ~

Clasificado en Marte ~

Comments (1)

Comments (1)

buscará convertir el CO2 en oxígeno

El próximo proyecto de la NASA en el planeta rojo, será la Misión Marte 2020, en la que destaca la intención de investigar la manera de transformar el CO2 en oxígeno.

Europa Press | Madrid | Actualizado el 03/08/2014 a las 23:05 horas

El próximo rover que la NASA enviará a Marte en 2020 llevará siete instrumentos cuidadosamente seleccionados para investigaciones sin precedente en el Planeta Rojo. El más llamativo persigue convertir en oxígeno dióxido de carbono de la atmósfera marciana.

La NASA ha escogido sobre 58 propuestas recibidas en enero de investigadores e ingenieros de todo el mundo. Las propuestas recibidas fueron el doble del número habitual en este tipo de convocatorias, un indicador de lo extraordinario interés por la comunidad científica en la exploración de Marte.

La Misión Marte 2020 se basa en el diseño del exitoso Curiosity, que aterrizó hace casi dos años, y actualmente está operando en Marte. El nuevo rover llevará hardware más sofisticado y nuevos instrumentos para realizar evaluaciones geológicas del sitio de aterrizaje, determinar la habitabilidad potencial del medio ambiente, y buscar directamente signos de la antigua vida marciana, según informa la NASA.

“La exploración de Marte será el legado de esta generación, y el rover Marte 2020 será otro paso crítico en el camino de los seres humanos al Planeta Rojo”, dijo el administrador de la NASA, Charles Bolden.

Los científicos utilizarán el vehículo para identificar y seleccionar una colección de muestras de roca y suelo que almacenará para su posible regreso a la Tierra de una futura misión.

El rover de Marte 2020 también ayudará a avanzar en nuestro conocimiento de cómo los futuros exploradores humanos podrían utilizar los recursos naturales disponibles en la superficie del planeta rojo. La capacidad de vivir de la tierra marciana transformaría la futura exploración del planeta. Los diseñadores de las futuras expediciones humanas pueden utilizar esta misión para entender los peligros planteados por el polvo marciano y demostrar la tecnología para procesar el dióxido de carbono de la atmósfera para producir oxígeno.

Las propuestas seleccionadas son:

– MastCam-Z: un sistema de cámara avanzada con capacidad estereoscópica de imágenes panorámicas y con capacidad de zoom. El instrumento también determinará la mineralogía de la superficie marciana y ayudará en las operaciones del rover. El investigador principal es James Bell, de la Universidad Estatal de Arizona en Tempe.

– SuperCam, un instrumento que puede proporcionar imágenes, análisis de la composición química, y la mineralogía. El instrumento también será capaz de detectar la presencia de compuestos orgánicos en rocas y regolito a distancia. El investigador principal es Roger Wiens, del Laboratorio Nacional de Los Alamos, Nuevo México.

– Instrumento Planetario para Litoquímica en Rayos X (PIXL), un espectrómetro de fluorescencia de rayos X, que también contendrá un reproductor de imágenes de alta resolución para determinar la composición elemental a escala fina de materiales de la superficie de Marte. PIXL proporcionará capacidades que permitan la detección y análisis más detallados de elementos químicos que nunca. La investigadora principal es Abigail Allwood, el Laboratorio de Propulsión a Chorro de la NASA en Pasadena, California.

– Escaneo de Entornos Habitables con Raman y Luminiscencia para Productos Orgánicos y Químicos (SHERLOC), un espectrómetro que proporcionará imágenes a escala fina y utiliza una luz ultravioleta de láser para determinar la mineralogía a escala fina y detectar compuestos orgánicos. El investigador principal es Luther Beegle, DEL JPL.

– Experimento ISRU de Oxígeno en Marte, una investigación de tecnología de exploración que va a producir oxígeno a partir del dióxido de carbono atmosférico marciano. El investigador principal es Michael Hecht, Institute of Technology, Cambridge, Massachusetts.

– Analizador de Dinámicas Ambientales en Marte, un conjunto de sensores que permitirá la medición de temperatura, velocidad y dirección del viento, presión, humedad relativa y el tamaño y la forma de polvo. El investigador principal es José Rodríguez-Manfredi, del Centro de Astrobiología, Instituto Nacional de Tecnica Aeroespacial, España.

– Radar de Imagen para la Exploración del Subsuelo de Marte, un radar de penetración de tierra que proporcionará resolución de centímetro en la estructura geológica del subsuelo. El investigador principal es Svein-Erik Hamran, del Forsvarets forskning Institute, Noruega.

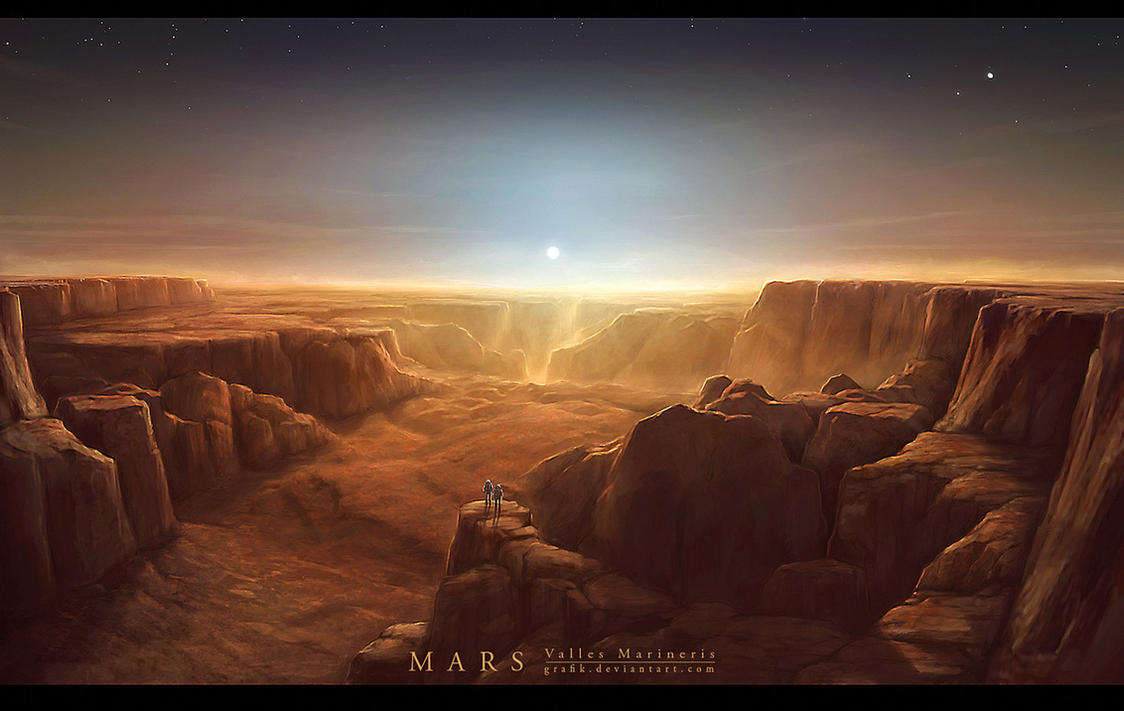

Arriba podemos contemplar Valles Marineris, un accidente geográfico de cuatro mil kilómetros de longitud, 200 de ancho y 10 de profundidad. Marte tiene rincones que debemos descubrir y, sobre todo, me intrigan esos huecos o grutas naturales que bajo la superficie fueron hechos por la pasada actividad volcánica del planeta en el pasado. Allí, a más profundidad y más alta temperatura, a salvo de la radiación nosiva del exterior… ¡Pudiera estar presente el agua líquida! Y, si eso es así… ¡La Vida andará muy cerca.

Como podéis ver por la noticia de la NASA, no dejamos de dar pequeños pasos hacia nuevos “pequeños” logros en aquel planeta que, algún día (lejano aún ene l futuro), podremos visitar.

emilio silvera

Totales: 72.334.228

Totales: 72.334.228 Conectados: 49

Conectados: 49