Oct

20

¡Fisica! Siempre la Física

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

¡El Universo! ¿Sería eso lo que pasó?

Como nunca dejaremos a aprender cosas nuevas, de desvelar secretos de la Naturaleza, de seguir investigando en busca de “otras verdades”, de elaborar nuevos modelos y nuevas Teorías que nos acerquen, cada vez más a la realidad del mundo (ese es, de momento, nuestro cometido), estamos abocados a tratar de saber lo que no sabemos y que, no pocas veces, creemos que sabemos. Ya lo dijo Popper:

“Cuanto más profundizo en el saber de las cosas, más consciente soy de lo poco que sé. Mis conocimientos son finitos , mi ignorancia, es infinita“.

Lo que nos lleva a la versión antigua del dicho: “Sólo se que no se nada” de Sócrates.

Las sustancias formadas por una sola clase de átomos se llaman elementos químicos. La palabra “átomo” procede del griego ατομος, que significa “indivisible” y el uso de la palabra “elemento” sugiere que se ha llegado a los ladrillos básicos con los que está formada la materia. De hecho, esta es la imagen que se tenía a mediados del siglo XIX cuando se acuñaron estos términos. Sin embargo, hoy sabemos que todo esto es falso, que los átomos se pueden dividir y que, de esta manera, los elementos han dejado de ser verdaderamente elementales. Los físicos continúan con esta nomenclatura aunque sea formalmente incorrecta, ya que, la costumbre, como dicen los juristas, no pocas veces rigen la jerga de las leyes.

“La revolución de la mecánica cuántica empieza a materializarse, y el qubit es el principal protagonista. Siendo la unidad mínima de información de extraño mundo, permitirá procesar toda la información existente en segundos.” El futuro que nos aguarda es inimaginable y cada día que pasa aparecen nuevos logros tecnológicos que nos sitúan en otro mundo, otra sociedad, otras nuevas formas de vivir y de comprender.

Sí, son los electrones los que dan al átomo su forma esférica

A todo esto y hablando de los átomos, por fuerza, nos tenemos que acordar del electrón que da al átomo su esférica. Son partículas cargadas eléctricamente que se mueven alegremente alrededor del núcleo. El electrón es muy ligero: su masa es solamente 1/1.836 de la del núcleo más ligero (el hidrógeno). La carga eléctrica del electrón es de signo opuesto a la del núcleo, de manera que los electrones están fuertemente atraídos el núcleo y se repelen mutuamente. Si la carga eléctrica total de los electrones en un átomo iguala a la del núcleo, lo que generalmente se necesitan varios electrones, se dice que el átomo está en equilibrio o que es eléctricamente neutro.

Un experimento realizado por científicos del Centro de Viena para la Ciencia y Tecnología Cuánticas ha demostrado que, en el mundo cuántico, la transición hacia el equilibrio térmico es más interesante y más complicada de lo que se pensaba.

Según destaca el , publicado en ‘Science’, entre un ordenado inicial y un estado final estadísticamente mixto, puede emerger un “cuasi-estacionario estado intermedio”. Este estado intermedio ya exhibe algunas propiedades como el equilibrio, pero parte de las características del estado inicial permanecen visibles durante un período de tiempo muy largo.

El fenómeno se denomina “pre-termalización” y desempeña un papel importante en diversos procesos de no equilibrio en la física cuántica. Podría, por ejemplo, ayudarnos a comprender el estado del universo temprano.

La fuerza a la que obedecen los electrones, la denominada fuerza electrostática o de Coulomb, es matemáticamente bastante sencilla y, sin embargo, los electrones son los responsables de las importantes propiedades de los “enlaces químicos”. Esto se debe a que las leyes de movimiento de los electrones están regidas completamente por la “mecánica cuántica”, teoría que se completó a principios del siglo XX. Es una teoría paradójica y difícil de entender y explicar, pero al mismo tiempo es muy interesante, fantástica y revolucionaria. uno se introduce en las maravillas de la mecánica cuántica es como si hiciera un viaje a un universo que está situado fuera de este mundo nuestro, ya que, las cosas que allí se ven, desdicen todo lo que dicta nuestro sentido común de cómo tiene que ser el mundo que nos rodea.

Sincronización perfecta, ¡es una sinfonía!

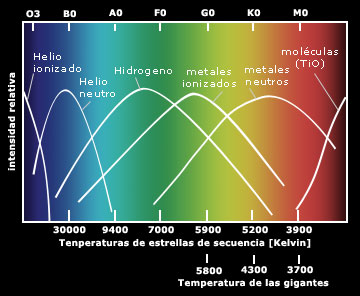

No solamente los electrones, sino también los núcleos atómicos y los átomos en su conjunto obedecen y se rigen por la mecánica cuántica. La Física del siglo XX empezó exactamente en el año 1900, cuando el físico alemán Max Planck, escribió un artículo de ocho páginas y allí propuso una posible solución a un problema que había intrigando a los físicos durante años. Es el problema de la luz que emiten los cuerpos calentados a una cierta temperatura, y también la radiación infrarroja emitida, con menos intensidad, por los objetos más fríos.

Estaban bien aceptados entonces que esta radiación tenía un origen electromagnético y que se conocían las leyes de la naturaleza que regían estas ondas electromagnéticas. También se conocían las leyes para el frío y el calor, la así llamada “termodinámica”, o al menos eso parecía. Pero si usamos las leyes de la termodinámica para calcular la intensidad de la radiación, el resultado no tiene ningún sentido. Los cálculos nos dicen que se emitiría una cantidad infinita de radiación en el ultravioleta más lejano, y, luego, esto no es lo que sucede. Lo que se observa es que la intensidad de la radiación muestra un pico a una cierta longitud de onda característica, y que la intensidad disminuye tanto para las longitudes mayores como para las longitudes menores. Esta longitud característica es inversamente proporcional a la temperatura absoluta del objeto radiante (la temperatura absoluta se define por una escala de temperatura que empieza a 273 ºC bajo cero). Cuando a 1.000 ºC un objeto se pone al “rojo vivo”, el objeto está radiando en la zona de luz visible.

El espectro electromagnético se extiende la radiación de menor longitud de onda, como los rayos gamma y los rayos X, pasando por la luz ultravioleta, la luz visible y los rayos infrarrojos, hasta las ondas electromagnéticas de mayor longitud de onda, como son las ondas de radio. Se cree que el límite la longitud de onda más pequeña posible es la longitud de Planck mientras que el límite máximo sería el tamaño del Universo.

Lo que Planck propuso fue simplemente que la radiación sólo podía ser emitida en de un tamaño dado. La cantidad de energía de uno de esos paquetes, o cuantos, es inversamente proporcional a la longitud de la onda y, por lo tanto, proporcional a la frecuencia de la radiación emitida. La sencilla fórmula es:

donde h es la constante de Planck (cuyo valor es 6,626 × 10−34 J·s). Sólo los fotones con una frecuencia alta (por encima de un valor umbral específico) podían provocar la corriente de electrones. Por ejemplo, la luz azul emitía unos fotones con una energía suficiente para arrancar los electrones del metal, mientras que la luz roja no. Una luz más intensa por encima del umbral mínimo puede arrancar más electrones, pero ninguna cantidad de luz por debajo del mismo podrá arrancar uno solo, por muy intenso que sea su brillo.

El esquema del Efecto fotoeléctrico nos muestra como la luz arranca electrones de la placa.

Poco tiempo después, en 1905, Einstein formuló esta teoría de una forma mucho más tajante: el sugirió que los objetos calientes no son los únicos que emiten radiación en de energía, sino que toda la radiación consiste en múltiplos de los paquetes de energía de Planck. El príncipe francés Louis-Victor de Broglie, dándole otra vuelta a la teoría, propuso que no sólo cualquier cosa que oscila tiene una energía, sino que cualquier cosa con energía se debe comportar como una “onda” que se extiende en una cierta región del espacio, y que la frecuencia, v, de la oscilación verifica la ecuación de Planck. Por lo tanto, los cuantos asociados con los rayos de luz deberían verse como una clase de partículas elementales: el fotón. Todas las demás clases de partículas llevan asociadas diferentes ondas oscilatorias de campos de fuerza.

El curioso comportamiento de los electrones en el interior del átomo, descubierto y explicado por el famoso físico danés Niels Bohr, se pudo atribuir a las ondas de De Broglie. Poco después, en 1926, Erwin Schrödinger descubrió escribir la teoría ondulatoria de Debroglie con ecuaciones matemáticas exactas. La precisión con la cual se podían realizar cálculos era asombrosa, y pronto quedó claro que el comportamiento de todos los objetos pequeños estaban exactamente determinados por la recién descubiertas “ecuaciones de onda cuánticas”.

Pocas dudas nos pueden caber a estas alturas de que la mecánica cuántica (de Planck) y, la Relatividad –tanto especial general- (de Einstein), además de ser las dos teorías más importantes de la Física de nuestro tiempo, funcionan de tal forma que uno, cuando profundiza en sus predicciones y las compara con lo que ocurre en el Universo, no por menos que, asombrarse, al comprobar como unas mentes humanas han sido capaces de llegar a estos profundos pensamientos que nos acerca a la realidad de la Naturaleza, al mismo tiempo que nos aleja de nuestra propia realidad.

Sí, están ahí pero, en realidad, no sabemos, a ciencia cierta, ni cómo se formaron las galaxias

¿Qué encontraremos cuando sea posible verificar la Teoría de cuerdas? ¿Qué hay más allá de los Quarks? ¿Sabremos alguna vez lo que es una singularidad? ¿Será verdad la existencia de esa materia oscura de la que tanto se habla? ¿Podremos al fín, encontrar esa fuente de energía que tanto necesita la Humanidad para dar ese segundo paso el futuro? ¿Tendremos, acaso, algún destino que no sea el de la irremisible extinción?

¡Preguntas! Preguntas y más preguntas que no podemos contestar. Es desesperante estar inmersos en inmenso océano de ignorancia. ¿Cuándo sabremos? El el epitafio que Hilbert ordenó esculpir en su Tumba, nos lo prometía: “Tenemos que saber, sabremos”. Si, ¿pero cuándo?

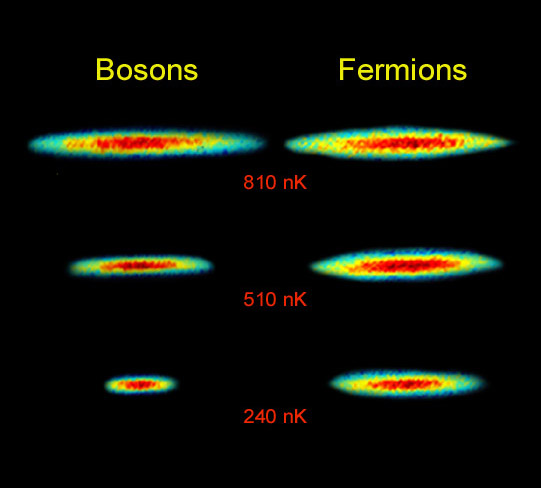

Lo cierto es que, las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de ésta teoría en vez de las de la mecánica clásica. En estadística cuantica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier de partículas puede ocupar un estado cuántico dado. Dichas partículas (como dije antes) son los bosones que, tienden a juntarse.

Los bosones tienen un angular n h / 2p, donde n es cero o un entero y h es la constante de Planck. bosones idénticos, la función de ondas es siempre simétrica. Si solo una partícula puede ocupar un cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n+½) h/2p y cualquier función de ondas de fermiones idénticos es siempre antisimétrica.

La mejor teoría explicar el mundo subatómico nació en 1928 cuando el teórico Paul Dirac combinó la mecánica cuántica con la relatividad especial para explicar el comportamiento del electrón. El resultado fue la mecánica cuántica relativista, que se transformó en un ingrediente primario en la teoría cuántica de campos. Con unas pocas suposiciones y ajustes, la teoría cuántica de campos ha probado ser suficientemente poderosa para formar la base del modelo estándar de las partículas y las fuerzas que rigen el universo.

La relación el espín y la estadística de las partículas está demostrada por el teorema espín-estadística. En un espacio de dos dimensiones es posible que existan partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el de aiones; para aniones idénticos la función de ondas no es simétrica (un cambio de fase de+1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

Debido al principio de exclusión de Pauli no es imposible que dos fermiones ocupen el mismo espacio cuántico (al contrario de lo que ocurre con los bosones). Y, precisamente por eso, se degeneran electrones y neutrones dando lugar a la formación de estrellas enanas blancas y de neutrones que, encuentran la estabilidad frenando la fuerza de gravedad.

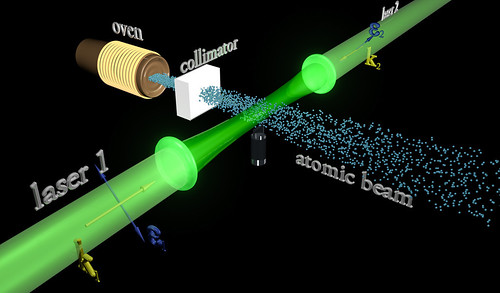

La condensación de Bose-Einstein es de importancia fundamental explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7k) se formar un condensado de Bose-Einstein, en el que varios miles de átomos forman una única entidad (un superátomo). efecto ha sido observado con átomos de rubidio y litio. Este efecto (condensación Bose-Einstein), ya habréis podido suponer, es llamado así en honor al físico Satyendra Naht Bose (1.894-1.974) y de Albert Einstein.

Más reciente es la obtención del Condensado de Bose-Einstein (BEC); en este caso las bases teóricas se postularon en la década de los 20 en manos de Satyendra Nath Bose y Albert Einstein. El primero describe ciertas reglas para determinar si dos fotones deberían considerarse idénticos o diferentes (Estadísticas de Bose) y Einstein aplica dichas reglas a los átomos intentando averiguar como se comportarían. Así, halla los efectos de que a muy bajas temperaturas los átomos están al mismo nivel cuántico produciendo fenómenos como la superfluidez o la superconductividad.

Distribución de momentos que confirma la existencia de un estado de agregación de la materia, el condensado de Bose-Einstein. obtenidos en un gas de átomos de rubidio, la coloración indica la cantidad de átomos a cada velocidad, con el rojo indicando la menor y el blanco indicando la mayor. Las áreas blancas y celestes indican las menores velocidades. A la izquierda se observa el diagrama inmediato anterior al condensado de Bose-Einstein y al centro el inmediato posterior. A la derecha se observa el diagrama luego de cierta evaporación, con la sustancia cercana a un condensado de Bose-Einstein puro. El pico no es infinitamente angosto debido al Principio de indeterminación de Heisenberg: dado que los átomos están confinados en una región del espacio, su distribución de velocidades posee necesariamente un cierto ancho mínimo. La distribución de la izquierda es para T > Tc (sobre 400 nanokelvins (nK)), la central para T < Tc (sobre 200 nK) y la de la derecha para T << Tc (sobre 50 nK).

… del sistema binario descubierto a 7,000 años luz de la Tierra, que está formado por una estrella de neutrones (el círculo más grande) y enana blanca (el …

Las estrellas enanas blancas, de neutrones y los púlsares existen, precisamente, por el principio de exclusión de Pauli que, degenera electrones y neutrones cuando las estrellas masivas, al final de su existencia, explotan como Supernovas y´su masa se contraen sobre sí misma más y más. Si la estrella es demasiado masiva, entonces ni ese principio de exclusión puede frenar a la Gravedad y se convierte en un Agujero negro.

Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones. Si nos fijamos en todo lo que estamos hablando aquí, nos daremos de que la mecánica cu´çantica es extraña y siendo fácil comprender como forma un campo magnético la partícula cargada que gira, no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado.

Lo cierto es que ocurre así. La prueba directa más evidente de ello es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalentes a cero, aunque por alguna razón desconocida, lograr crear un campo magnético cuando gira la partícula.

emilio silvera

Oct

20

Coreografía de un par de electrones

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

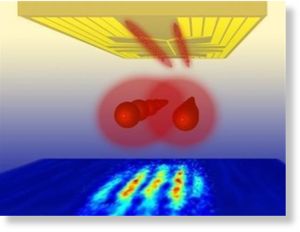

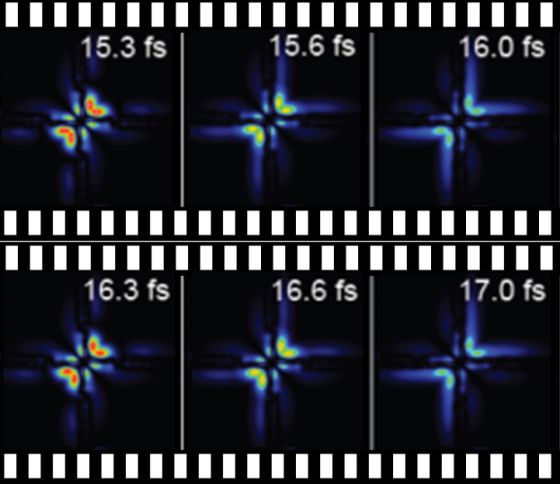

Físicos y químicos nos sorprenden cada día con el control que pueden ejercer sobre la materia. Por primera vez, investigadores españoles y alemanes hemos conseguido obtener la película del movimiento de los dos electrones que constituyen el átomo de helio e incluso controlar los pasos de esta singular pareja de baile. Para ello, hemos empleado una combinación de pulsos de luz visible y ultravioleta con una duración de tan solo unos pocos cientos de attosegundos (un attosegundo es una mil millonésima de una milmillonésima parte de un segundo). El control sobre el movimiento de pares de electrones podría revolucionar nuestra visión de la química, ya que los enlaces entre los distintos átomos que constituyen las moléculas, desde el agua al ADN, son el resultado del apareamiento de dos electrones. Por tanto, la perspectiva de utilizar láseres de attosegundos para controlar el destino de los electrones apareados en un enlace abre el camino a la producción de sustancias que no pueden ser sintetizadas utilizando procedimientos químicos convencionales.

Representación animada de un átomo de deuterio, uno de los isótopos del hidrógeno.

Para explicar algunas características extrañas en el espectro del átomo de hidrógeno, en 1913, el físico Niels Bohr introdujo un modelo planetario en el que el electrón cargado negativamente, unido al núcleo cargado positivamente por la fuerza electrostática de Coulomb, está restringido a moverse solamente a lo largo de órbitas muy concretas. Esta cuantificación del movimiento electrónico abrió un nuevo capítulo de la física y química modernas, sin el cual no se podría haber alcanzado el conocimiento de la materia del que se dispone hoy en día. En el modelo de Bohr, las cosas suceden rápidamente: el año sideral, es decir, el tiempo que el electrón necesita para completar la órbita más corta alrededor del núcleo, tiene la increíblemente corta duración de 0.000 000 000 000 000 152 segundos, o 152 attosegundos (as), un valor que se hace aún más pequeño cuando se consideran elementos más pesados en la tabla periódica de los elementos químicos.

… investigadores de la UAM consigue por primera vez utilizar pulsos láser con una duración de attosegundos para observar el movimiento de los electrones …

El attosegundo es, de hecho, la escala de tiempo natural en el que los electrones se mueven en la materia ordinaria. El movimiento ultrarrápido predicho por el modelo de Bohr no pudo ser confirmado directamente hasta que, a comienzos de este siglo, una serie de avances revolucionarios generó la tecnología láser capaz de producir destellos de luz suficientemente cortos (el récord mundial es de 67 as) para hacer fotografías del movimiento de un electrón y así generar la película de ese movimiento. En contraste con el mundo macroscópico, una película del movimiento del electrón no revela un desplazamiento a lo largo de una trayectoria bien definida. Como consecuencia del comportamiento ondulatorio de la materia a nivel atómico, el electrón aparece como una nube difusa (o paquete de ondas) en movimiento. La densidad de la nube indica la probabilidad de encontrar al electrón en distintas regiones del espacio.

Observar el comportamiento de los electornes es todo un espectáculo

En los sistemas más grandes que el hidrógeno, con varios electrones, la misma fuerza de Coulomb que une a un electrón con el núcleo también actúa repulsivamente entre los electrones. El efecto de tal repulsión es apantallar la carga nuclear, debilitando así el efecto atractivo del núcleo sobre cada uno de los electrones. Sin embargo, en gran medida, los electrones siguen actuando como partículas independientes y, por tanto, el movimiento del paquete de ondas que representa a todos los electrones no es mucho más complicado que el observado para un solo electrón en el átomo de hidrógeno. Hasta ahora, los experimentos llevados a cabo para seguir el movimiento de los paquetes de onda en átomos complejos fueron capaces de poner en marcha un solo electrón a la vez, confirmando esta imagen de que los electrones se mueven de forma casi independiente los unos de los otros.

La repulsión electrostática entre los electrones, sin embargo, tiene un efecto secundario, más sutil. De la misma manera que un pasajero de autobús evita sentarse al lado de otros pasajeros y toparse con ellos a medida que camina por el pasillo, los electrones tratan de evitarse el uno al otro cuando se mueven en el interior de un átomo o una molécula; el movimiento de los electrones se dice que está correlacionado. De este modo, los electrones minimizan su repulsión mutua y, como consecuencia, estabilizan el átomo o molécula a la que pertenecen. Dicha estabilización es responsable del balance energético de todos los procesos naturales, y es clave para nuestra comprensión y control del comportamiento de la materia, como la transferencia de energía en sistemas fotosintéticos, la protección de datos en los futuros ordenadores cuánticos, etcétera. A pesar de ello, el movimiento de dos electrones correlacionados ha eludido la observación experimental directa hasta el momento presente. Además, es muy difícil de reproducir teóricamente, ya que, incluso para el átomo de helio, que es el sistema más simple con dos electrones, las ecuaciones físico-cuánticas que describen este movimiento no pueden resolverse exactamente y, en su lugar, deben realizarse costosos cálculos numéricos en superordenadores.

Para poder tomar en cuenta la indistinguibilidad de los dos electrones del helio siguiendo las reglas de la Mecánica Cuántica, lo cual requiere que en una …

Esta semana, en la revista Nature, los investigadores teóricos de la Universidad Autónoma de Madrid, Luca Argenti y Fernando Martín, en colaboración con el grupo experimental de Thomas Pfeifer, del Instituto Max Planck de Heidelberg, explicamos cómo hemos reconstruido por primera vez el movimiento simultáneo de dos electrones excitados en el helio, a partir de datos experimentales y cálculos de física cuántica inéditos. Hemos utilizado una versión de alta resolución de una técnica conocida como espectroscopia de absorción transitoria de attosegundos, mediante la cual se midió la transparencia de una muestra de helio a destellos cortos de luz ultravioleta en función del tiempo transcurrido entre este destello y otro de luz roja generado por un láser de titanio-zafiro.

Al igual que un adulto empuja a un niño en un columpio, el pulso ultravioleta lleva el átomo a un estado excitado, donde ambos electrones oscilan. Actuando de manera adecuada, las piernas de los niños pueden amplificar o amortiguar las oscilaciones del columpio. Y midiendo la amplitud de dichas oscilaciones se puede deducir el punto en el que el niño movió las piernas, es decir, reconstruir el movimiento original del columpio. De una manera similar, en el experimento, el pulso de luz roja fortalece o debilita la absorción de la luz ultravioleta en función del tiempo transcurrido entre los dos pulsos. A partir de la modulación de la absorción ultravioleta, hemos logrado reconstruir la oscilación de los dos electrones, y de ahí deducir la evolución del correspondiente paquete de ondas. Más allá del seguimiento de este movimiento, también pudimos modificarlo y controlarlo aumentando la intensidad del pulso rojo. Volviendo a la analogía del columpio, es como si el niño estuviera, además, sujetando una cometa: un fuerte golpe de viento alteraría por completo la oscilación del columpio.

Con este trabajo, consideramos que hemos abierto el camino para la observación directa del movimiento electrónico correlacionado en átomos y moléculas, y quizá para controlar el movimiento de los electrones apareados en enlace químicos, lo que permitiría la producción de sustancias que no pueden ser obtenidas con procedimientos químicos convencionales.

Luca Argenti y Fernando Martín son investigadores teóricos del Departamento de Química de la Universidad Autónoma de Madrid

Oct

19

Nuevos materiales, nuevos procesos, nuevos dispositivos I

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física... ¡Y mucho más! ~

Clasificado en Física... ¡Y mucho más! ~

Comments (1)

Comments (1)

En los últimos años se han desarrollado materiales que, debido a su estructura nanométrica, presentan nuevas propiedades, y por tanto tienen aplicaciones en campos tan diversos como son la transmisión de información mediante luz, el almacenamiento de datos, la generación y el transporte de energía eléctrica, la síntesis de catalizadores, la elaboración de textiles más resistentes, o la implantación de nuevos implantes óseos.

El gran número de nuevos materiales y dispositivos demostradores que se han desarrollado en estos años ha sido fruto, por un lado del desarrollo de sofisticadas técnicas de síntesis, caracterización y manipulación que se han puesto a punto y, por otro, del gran avance en los métodos de computación en la nanoescala (técnicas ab-initio, dinámica molecular, etc.) que se han probado en las grandes instalaciones dedicadas al cálculo científico de altas prestaciones. Es precisamente la combinación de experimentos punteros con métodos teóricos precisos un elemento esencial para comprender un gran número de procesos y mecanismos que operan en la nanoescala. En concreto, una de las aportaciones teóricas más importantes al desarrollo de la Nanotecnología ha llegado de la mano de la Teoría de Funcionales de la Densidad (DFT, en sus siglas en inglés) por la que en 1998 Walter Kohn recibió el Premio Nobel en Química, compartido con John A. Pople, “padre” de la Química Cuántica. Con respecto al desarrollo experimental, cabe resaltar el alto grado de desarrollo de las técnicas SPM para ver y manipular la materia a escala nanométrica en multitud de ambientes diferentes (ultra alto vacío, humedad controlada, celdas catalíticas, temperaturas variables,…). Esta capacidad nos ha permitido diseñar nuevos experimentos con los que comprender el comportamiento de nuevos materiales y dispositivos. Dado la gran variedad de materiales y sus aplicaciones, es imposible en un artículo presentar una visión completa de la situación de la Nanotecnología, por lo que nos vamos a limitar a presentar algunos ejemplos que ilustran el estado actual de este campo.

Hacia la electrónica molecular: Electrónica molécular de espín. Representación del dispositivo compuesto por una isla base de cobalto sobre la que se deposita una sola molécula de …

Debido a su tamaño nanométrico, las estructuras moleculares pueden poner de manifiesto nuevas propiedades electrónicas. Sin embargo, la necesidad de poder producir estructuras nanométricas de forma masiva, tal y como requieren las aplicaciones industriales hace que la manipulación individual de nano-objetos como las moléculas pase a un segundo plano, requiriéndose alternativas más útiles para incorporar la Nanotecnología a los procesos de fabricación. Por esta razón, en los últimos años se están estudiando profusamente las condiciones de formación y las propiedades de capas autoensambladas de diferentes moléculas orgánicas sobre superficies.

ampliación del anterior, con el agregado de la molécula de piridina,a modo de explicación en el dibujo, toda la molécula (las 6 moléculas de piridina mas el átomo de cobalto)es una supramolecula.

En estos casos la superficie no sólo proporciona un soporte, sino que posee un papel activo en la formación de diferentes patrones moleculares en dos dimensiones. Así, la posibilidad de generar sistemas autoensamblados de moléculas con propiedades bien definidas y dirigidas hacia la realización de funciones concretas abre un camino para cambiar desde el imperante paradigma del silicio en la electrónica hacia otro basado en la electrónica molecular. Este nuevo paradigma será mucho más rico por la gran diversidad de componentes moleculares que pueden entrar en juego. Entre los componentes prometedores para la Nanotecnología, que están relacionados con las moléculas orgánicas, y que habrá que tener en cuenta en el futuro de la microelectrónica, estarán los fullerenos, los nanotubos de carbono y el grafeno, de los que hablamos a continuación.

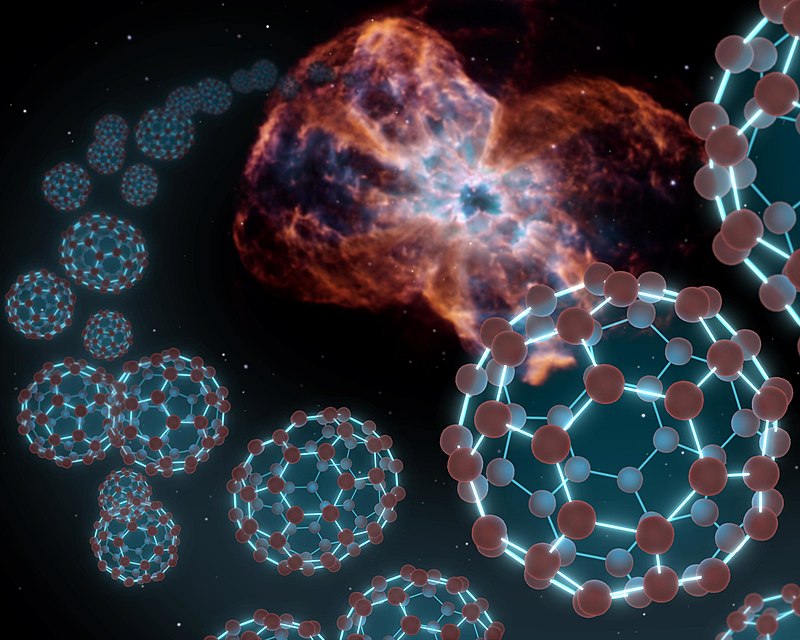

Los fullerenos o “bucky-balls”

Con este nombre se denomina al conjunto de distintas moléculas cerradas sobre sí mismas con formulación. El más conocido, por lo estable y abundante en naturaleza es el llamado Cn. El más conocido, por lo estable y abundante en la Naturaleza es el llamado C60, que está formado por 12 pentágonos y 20 exágonos, dispuestos como en un balón de futbol. Las aplicaciones Nanotecnológicas que se pueden derivar del uso de esta molécula están todavía en fase de estudio y son muy variadas. Sin embargo, aunque actualmente no existen aplicaciones concretas ya se han sintetizado más de mil nuevas moléculas basadas en fullereno y hay más de cien patentes internacionales registradas. El carácter rectificador de los fullerenos les hace atractivos para su uso en electrónica molecular.

La formación de este tipo de estructuras se produce más fácilmente de lo que podemos imaginar, pues son uno de los principales integrantes de la carbonilla y se generan abundantemente en cualquier combustión. Sin embargo, a día de hoy uno de los principales problemas para su utilización es el de conseguir una síntesis controlada de fullereno. Esto requiere complicadas técnicas, tales como la vaporización del grafito o la pirolisis láser, que normalmente producen exclusivamente los fullerenos más estables. Recientemente se ha propuesto un nuevo método para conseguirlo basado en principios “nano”.

La paridad es la simetría de Alicia en el país de las maravillas a través del espejo. La simetría P de una ley física indica que dicha ley es invariante si …

Se trata de partir de una molécula precursora sintetizada de forma tal que sea como un fullereno abierto, con los enlaces rotos saturados por hidrógeno. Esta molécula se puede plegar sobre sí misma mediante una transformación topológica de manera que de lugar a un fullereno. Se trata de partir de una estructura plana (un recortable) para posteriormente ensamblar un objeto en tres dimensiones. Este plegado se consigue mediante un proceso des-hidrogenación catalizada por una superficie. Una vez que la molécula plana ha perdido estos hidrógenos se cierran sobre sí misma de forma expontánea formando un fullereno.

Este proceso se ha podido seguir, entre otras técnicas, mediante imágenes de microscopía túnel in-situ. Los mecanismos existentes en el proceso se pueden entender gracias a los cálculos ab-initio que apoyan la investigación experimental. Esta combinación pone de manifiesto como una molécula plana de carbono sin hidrógeno se pliega expontáneamente. La belleza de este nuevo método de síntesis reside en que si se sintetizan moléculas precursoras planas con diferentes topologías se pueden conseguir moléculas cerradas de diferentes formas, tamaños e incluso que contengan átomos diferentes al Carbono. Así se ha sintetizado por primera vez la molécula C57 N3 sobre una superficie.

¡La Naturaleza! La NASA encontró fulerenos esféricos o buxkybolas en la nebulosa Tc1 a 6.000 años-luz. Posiblemente sean una de las moléculas más bellas que podamos encontrar, es una de las formas más estables del carbono, y sus 60 átomos se distribuyen formando 20 hexágonos y 12 pentágonos que ofrecen una forma idéntica al clásico balón de fútbol.

Nanotubos de Carbono

Si el descubrimiento del C60 fue un hito importante para la Nanotecnología, el de los llamados Nanotubos de Carbono lo ha superado con creces. Los Nanotubos de Carbono, unas diez mil veces más finos que un cabello, presentan excelentes propiedades físicas y su fabricación resulta relativamente económica. Un cable fabricado de Nanotubos de Carbono resultaría diez veces más ligero que uno de acero con el mismo diámetro pero sería ¡cien veces más resistente! A estas impresionantes propiedades mecánicas se le añaden unas interesantes propiedades eléctricas, puesto que pueden ser tanto conductores como aislantes, según la topología que presenten.

Un Nanotubo de Carbono se obtiene mediante el plegado sobre sí mismo de un plano atómico de grafito (enrollándolo). Según como se pliegue el plano grafítico se obtiene un Nanotubo que puede conducir la corriente eléctrica, ser semiconductor o ser aislante. En el primer caso, los Nanotubos de Carbono son muy buenos conductores a temperatura ambiente, pudiendo transportar elevadas densidades de corriente. En el segundo presentan propiedades rectificadoras. Por otra parte, si inducimos defectos en la estructura podemos generar moléculas semiconductoras y así formar diodos o transistores. Es decir, tenemos todos los elementos en nuestras manos para construir nanocircuitos basados en Carbono.

Grafeno

A un solo plano atómico de grafito se le llama grafeno, y éste, a diferencia del grafito, es difícil de obtener. Recientemente, mediante cálculos teóricos, se han realizado predicciones acerca de las importantes propiedades electrónicas que podría tener este material. Entre ellas una altísima movilidad electrónica y una baja resistividad, de manera que estos planos atómicos podrían ser los futuros sustitutos del silicio en los dispositivos electrónicos. Ahora bien, al día de hoy, estas propuestas provienen esencialmente de cálculos teóricos y, por tanto, antes de que el grafeno pase a sustituir al silicio en la electrónica del futuro, es necesario verificar las predicciones teóricas en el laboratorio. Actualmente, éste es un campo muy activo de investigación, y muchos grupos están trabajando en la obtención de capas de grafeno soportadas sobre diferentes materiales, como polímeros o aislantes, para poder determinar sus propiedades eléctricas y comprobar las predicciones teóricas.

El estudio de grafeno sobre metales de transición es un campo muy activo de investigación ya que las capas de grafeno crecen de manera fácil, muy controladas y con un bajo número de defectos sobre estas superficies. Además el grafeno sobre un substrato forma patrones conocidos como redes de Moiré, en las que la periodicidad atómica de las dos redes cristalinas (substrato y grafeno), coincide cada dos-tres nm, dando lugar a deformaciones de la capa de grafeno, que se reflejan como prominencias en la imagen STM.

Nanohilos

No sólo las moléculas, los Nanotubos o el grafeno son las apuestas para sustituir al silicio. Otros elementos como los Nanohilos fabricados a partir de materiales semiconductores o los Nanohilos metálicos tendrán también cierto protagonismo. En concreto, los Nanohilos semiconductores presentan un gran potencial como transistores pero también presentan aplicaciones en campos como octoelectrónica o en la fabricación de censores biológicos. Por otro lado los Nanohilos metálicos, cuya síntesis controlada es más difícil, poseen gran interés como interconectores. En el caso de los Nanohilos formados de materiales Ni, Co o Fe se puede aprovechar también su potencial comportamiento magnetorresisitivo para ser usados en dispositivos de almacenamiento magnético. Los Nanohilos metálicos son interesantes a su vez porque los efectos de tamaño inducen en ellos la aparición de transiciones de fase martensíticas y la aparición de configuraciones no cristalinas.

En el siguiente hablaremos de las Nanopartículas y la fuente de estos conocimientos aparece publicada en…

Editadas por la RSEF.

Publica: emilio silvera

Oct

19

Partículas “bellas” de materia y antimateria

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en General ~

Clasificado en General ~

Comments (12)

Comments (12)

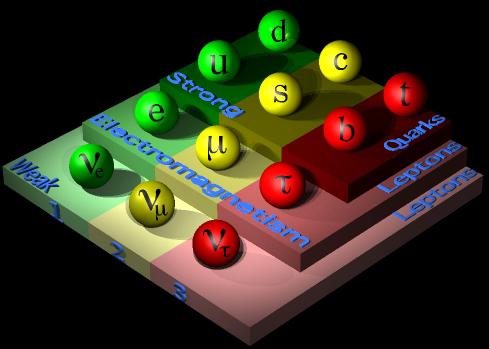

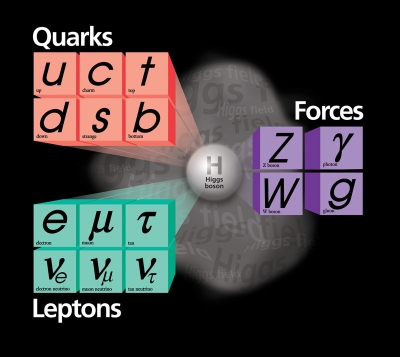

¿Cuántas generaciones de partículas existen? El modelo estándar no predice el número de generaciones de fermiones (quarks y leptones). Hoy conocemos tres generaciones, pero podrían existir más. Una cuarta generación dentro del modelo estándar estaría formada por dos quarks pesados y

y dos leptones pesados

y

. Cualquier otra opción implicaría física más allá del modelo estándar. En este caso SM4 sustituiría a SM3, como SM3 sustituyó a SM2 en los 1970. (Fuente Francis (th)E mule Science’s News).

Pero hablemos de partículas “bellas” de materia y antimateria. Así se titula un magnifico artículo de Don Alberto Ruiz Jimeno, miembro del Grupo de Altas Energías del Instituto de Física Moderna Universidad de Cantabria y Jefe del Grupo de Altas Energías. En él nos dice que:

El resultado procede del análisis de CDF de miles de millones de colisiones de protones y antiprotones producidos en el colisionador Tevatron del Fermilab. De acuerdo con la Teoría de la Relatividad de Einstein, energía es igual a masa, por lo que esas colisiones de alta energía pueden lanzar a la existencia a partículas subatómicas masivas no vistas en nuestro mundo cotidiano. Los físicos intentan entonces identificar esas partículas estudiando las combinaciones de partículas más familiares en las que decaen.

“Nuevos bariones constituidos por tres Quarks, como los protones, pero conteniendo el quarks b (“belleza”) han sido observado en el experimento CDF del Acelerador del Tevatrón de protones y antiprotones. Por otra parte (nos dice), se ha observado por primera vez la oscilación de los mesones B, entre materia y antimateria. Dado que el artículo puede tener un alto interés para ustedes, he creído positivo transcribirlo aquí para gozo del personal que, con estos nuevos conocimientos (como me pasó a mí), podrán aumentar los suyos.

La física de partículas elementales tiene por objeto el estudio de los constituyentes más elementales de la materia y de las fuerzas fundamentales que rigen su comportamiento. La dinámica de estos bloques fundamentales viene formulada por la mecánica cuántica relativista.

El denominado Modelo Estándar establece que los bloques elementales de la materia tienen un momento magnético intrínseco (spín) de valor ½, denominándose fermiones por verificar las leyes de la estadística cuántica que formularon Fermi y Dirac a comienzos del siglo XX. A su vez, las fuerzas fundamentales vienen determinadas por el intercambio de cuantos de energía, con spin 1 (salvo el hipotético gravitón que tendría spin 2), llamado bosones al verificar las leyes estadísticas cuántica establecidas por Bose y Einstein, en el mismo siglo XX.

Los Bosones de interacción son el fotón, causante de la interacción electromagnética; los bosones vectoriales W+, W– y Z0, causantes de la interacción nuclear débil; los ocho tipos de Gluones que confinan a los Quarks en hadrones (como el protón o el neutrón) a causa de la interacción fuerte nuclear, y el gravitón u onda gravitacional que explicaría la interacción gravitatoria. La fuerza gravitacional es despreciable a escala subatómica, pero es la dominante a grandes escalas. Su portador aún no ha sido observado; de hecho, su existencia requeriría una teoría cuántica de la gravitación, que aún no ha sido formulada.

Los fermiones de materia se denominan quarks o leptones, siendo los primeros los que están sometidos a los cuatro tipos de interacciones y los segundos los que no están sometidos a la interacción nuclear fuerte; en cualquiera de los casos, la interacción electromagnética solo afecta a las partículas que poseen carga eléctrica y la interacción gravitatoria a las que poseen masa.

Los quarks son de seis tipos o sabores, así como los leptones. Unos y otros se clasifican en familias o generaciones, siendo la más ligera la constituida por los quarks y los leptones electrón y neutrino electrónico. Los nucleones, protón y neutrón, tienen la estructura de quarks, respectivamente uud y udd. Los átomos tienen un núcleo interno constituido por nucleones y electrones orbitando en torno al mismo.

El resto de quarks y leptones constituyen materia exótica, siendo producidos en los aceleradores de partículas y en la radiación cósmica, pero formaban parte de la materia original del Universo primitivo. Los quarks pueden tener, además, tres tipos de carga fuerte o “color”.

Además existen otros doce sabores correspondientes a la antimateria, en forma de anti-quarks y anti-leptones, con las mismas masas que los quarks y leptones correspondientes, pero con sus cargas invertidas. No se ha observado antimateria en el Universo actual, pero el Universo primigenio tenía igual cantidad de materia que de antimateria. Toda la antimateria actual es producida en los choques de partículas aceleradas, como consecuencia de la transformación de energía en pares materia-antimateria.

La ecuación cuántica relativista que gobierna el comportamiento de los fermiones es la ecuación de Dirac, debida al famoso físico inglés. Las soluciones de dicha ecuación incluyen las denominadas partículas de antimateria, que poseen la misma masa que la partícula correspondiente, pero tienen todas sus “cargas” internas, como la carga eléctrica, con el signo opuesto. Así por cada quark tenemos un antiquark y por cada leptón un antileptón. Cuando un fermión y su correspondiente antifermión se encuentran se aniquilan mutuamente, convirtiéndose en energía y, a la viceversa, si tenemos energía superior a la suma de las masas de fermión y antifermión, puede convertirse en un par fermión-antifermión.

El 7 de agosto de 1912, el físico austriaco Victor Franz Hess descubrió esta potentísima fuente de energía llegada del espacio, lo que años después le supuso el premio Nobel ABC.ES / MADRID V.F. SOCIETY Víctor F. Hess, en un globo entre 1911 y 1912.

La historia de la Física de Partículas debe mucho al descubrimiento de los rayos cósmicos, realizada por el físico austríaco Francis Hess, en 1912, y apodados como tales por el físico americano Robert Millikan, en 1925. Los experimentos de Hess, utilizando globos aerostáticos, concluyeron que la cantidad de radiación crecía por encima de los 2000 metros de altura y la fuente de los mismos eran el Sol y otras fuentes procedentes del firmamento.

A partir de esa fecha y hasta mediados del siglo XX, gracias a los experimentos con rayos cósmicos, el número de tipos diferentes de partículas observadas, que previamente se reducían al protón y el electrón, se multiplicó, creándose un auténtico caos que obligó a pensar en esquemas de clasificación de las mismas.

Esquema de un sincrotrón

El sincrotrón es un tipo deacelerador de partículas. Se diferencia de otros aceleradores en que las partículas se mantienen en una órbita cerrada. Los primeros sincrotrones se derivaron del ciclotron. que usa un campo magnético constante para curvar la trayectoria de las partículas, aceleradas mediante un campo eléctrico también constante, mientras que en el sincrotrón ambos campos varían. La velocidad máxima a la que las partículas se pueden acelerar está dada por el punto en que la radiación sincrotrón emitida por las partículas al girar es igual a la energía suministrada. Los sincrotrones también se utilizan para mantener las partículas circulando a una energía fija; en este casos reciben el nombre de «anillos de almacenamiento».

En 1947, los físicos del Laboratorio Lawrence Berkeley, de California, construyeron el primer gran acelerador, un ciclotrón, comenzando la era de los grandes aceleradores de partículas, que continuaron descubriendo nuevos tipos de las mismas, de modo que, en 1960, había cientos de tipos de partículas observadas, sin que hubiera, aún, un esquema de clasificación adecuado. Este fue desarrollado durante la década de 1960, en la que el análisis de las colisiones de partículas, y las propiedades de los diferentes tipos de interacción observadas, establecieron la base para la construcción del Modelo Estándar.

Sí, las fuerzas fundamentales, o, interaciones… ¡Están presentes en todas partes por el Universo! Son las que marcan el ritmo.

Las leyes que rigen el comportamiento de las interacciones fundamentales y sus propiedades de simetría permitieron establecer un marco de clasificación de los hadrones (partículas compuestas por quarks, como es el caso del protón) que pueden ser de dos tipos: Bariones, si en su constitución tenemos tres quarks, o mesones, si si están constituidos de un quark y un antiquark.

En realidad, la dinámica de los hadrones está determinada, esencialmente, por la interacción nuclear fuerte, de modo que los quarks constituyentes son los quarks de “valencia”, en analogía con los electrones de valencia de los átomos (los que fijan sus propiedasdes químicas). En la dinámica de la interacción fuerte nuclear hay un continuo intercambio de Gluones entre los quarks y reacciones de producción y aniliquilación de quarks y antiquarks mediante Gluones.

Esta dinámica es debida a la existencia de una propiedad intrínseca de los quarks que denominamos “color”, que es intercambiada en las reacciones de Quarks y Gluones. Los hadrones son, globalmente, neutros de color (como los átomos son neutros de carga eléctrica) y es tan fuerte y característica la interacción que los quarks están confinados en unas dimensiones especiales inferiores al tamaño de los núcleos de los átomos, siendo paradójicamente casi libres en el interior de los hadrones (libertad asintótica de los quarks).

La fuerza nuclear fuerte es la más potente de la Naturaleza y mantiene el núcleo de los átomos unidos

El Modelo Estándar ha sido comprobado desde su desarrollo formal, a mediados de 1960, y sus parámetros han sido medidos con extraordinaria precisión, gracias al desarrollo de experimentos muy potentes, entre los que destacan los realizados en el acelerador LEP (“Large Electrón Positrón”) del CERN ( Centro Europeo de Física de Partículas, en Ginebra), durante la última década del siglo XX, y del Tevatrón del Laboratorio Fermilab (Chicago, USA), aún en funcionamiento.

A continuación viene una referencia al LHC que, a estas alturas está sobrepasada por conocer todos nosotros lo que ha pasó en su inauguración y sus primeras pruebas. Así que, no me parece oportuno plasmar aquí esa referencia que conoceremos de primera mano cuando sucedieron los hechos y toda la prensa los publicó.

emilio silvera

Oct

18

¡Son muchas las cosas que no sabemos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

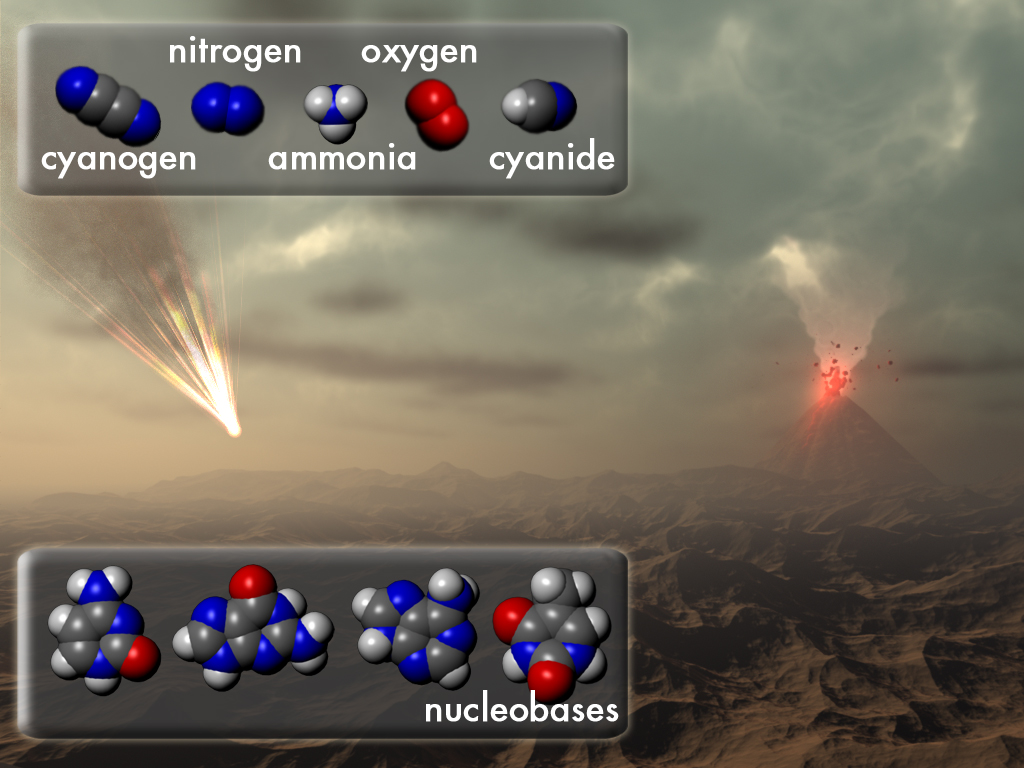

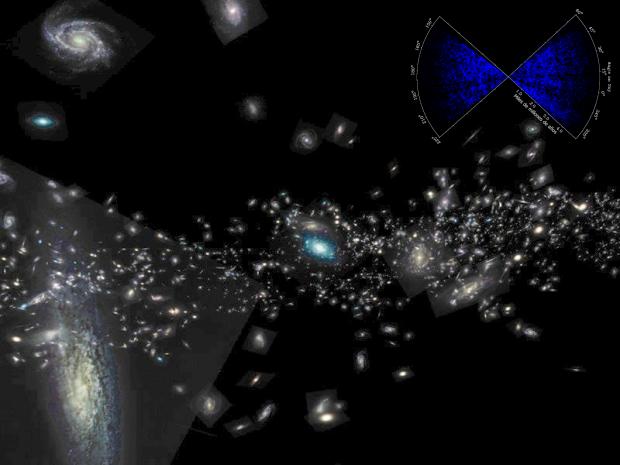

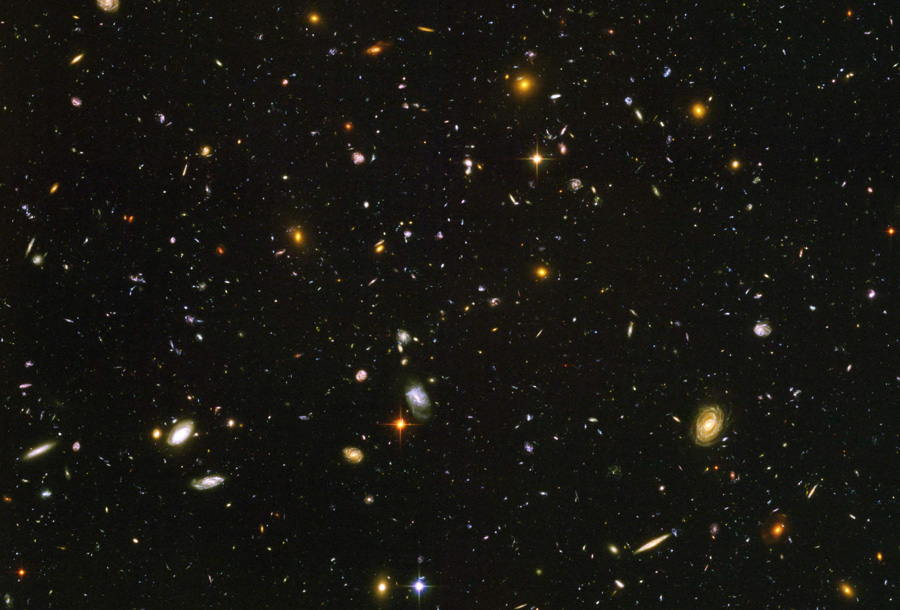

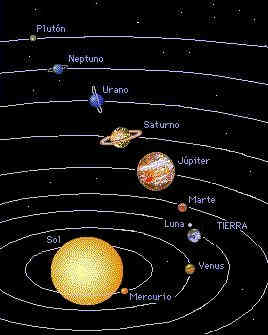

Hemos hablado aquí otras veces sobre el hecho cierto de que, el material del que estamos hechos, se fabricó en las estrllas, y, alguna supernova, hace ya miles de millones de años, sembró el espacio interestelar para que se formara nuestro Sistema Solar. Claro que los procesos de la alquimia estelar necesitan tiempo: miles de millones de años de tiempo. Y debido a que nuestro universo se está expandiendo, tiene que tener un tamaño de miles de millones de años-luz para que durante ese periodo de tiempo necesario pudiera haber fabricado los componentes y elementos complejos para la vida. Un universo que fuera sólo del tamaño de nuestra Vía Láctea, con sus cien mil millones de estrellas resultaría insuficiente, su tamaño sería sólo de un mes de crecimiento-expansión y no habría producido esos elementos básicos para la vida.

Planetas descubiertos por el telescopio Kepler que han sido confirmados como dentro de la zona de habitabilidad /Fuente: NASA

El universo tiene la curiosa propiedad de hacer que los seres vivos piensen que sus inusuales propiedades son poco propicias para la vida, para la existencia de vida, cuando de hecho, es todo lo contrario; las propiedades del universo son esenciales para la vida. Lo que ocurre es que en el fondo tenemos miedo; nos sentimos muy pequeños ante la enorme extensión y tamaño del universo que nos acoge. Sabemos aún muy poco sobre sus misterios, nuestras capacidades son limitadas y al nivel de nuestra tecnología actual estamos soportando el peso de una gran ignorancia sobre muchas cuestiones que necesitamos conocer.

Extraños objetos pueden ser observados en el Universo en los que, energías inimaginables están presentes

Con sus miles de millones de galaxias y sus cientos de miles de millones de estrellas, si niveláramos todo el material del universo para conseguir un mar uniforme de materia, nos daríamos cuenta de lo poco que existe de cualquier cosa. La media de materia del universo está en aproximadamente 1 átomo por cada metro cúbico de espacio. Ningún laboratorio de la Tierra podría producir un vacío artificial que fuera remotamente parecido al vacio del espacio estelar. El vacío más perfecto que hoy podemos alcanzar en un laboratorio terrestre contiene aproximadamente mil millones de átomos por m3.

Esta nueva manera de mirar el universo nos da nuevas ideas, no todo el espacio son agujeros negros, estrellas de neutrones, galaxias y desconocidos planetas; la verdad es que casi todo el universo está vacío y sólo en algunas regiones tiene agrupaciones de materia en forma de estrellas y otros objetos estelares y cosmológicos; muchas de sus propiedades y características más sorprendentes (su inmenso tamaño y su enorme edad, la soledad y oscuridad del espacio) son condiciones necesarias para que existan observadores inteligentes como nosotros.

Esta imagen circula mucho por los medios como posible observador inteligente fuera de la Tierra. Algunos comentan que somos nosotros en el futuro y hemos venido a contemplar cómo éramos. La imaginación del Ser humano no tiene límites y para pensar tal cosa… ¡Hay que tener mucha imaginación!

No debería sorprendernos la vida extraterrestre; si existe, pudiera ser tan rara y lejana para nosotros como en realidad nos ocurre aquí mismo en la Tierra, donde compartimos hábitat con otros seres vivos con los que hemos sido incapaces de comunicarnos, a pesar de que esas formas de vida, como la nuestra, están basadas también en el carbono. No se puede descartar formas de vida inteligente basadas en otros elementos, como por ejemplo, el silicio.

La baja densidad media de materia en el universo significa que si agregáramos material en estrellas o galaxias, deberíamos esperar que las distancias medias entre objetos fueran enormes.

| El universo visible contiene sólo: |

| 1 átomo por metro cúbico |

| 1 Tierra por (10 años luz)3 |

| 1 Estrella por (103 años luz)3 |

| 1 Galaxia por (107 años luz)3 |

| 1 “Universo” por (1010 años luz)3 |

El cuadro expresa la densidad de materia del universo de varias maneras diferentes que muestran el alejamiento que cabría esperar entre los planetas, estrellas y galaxias. No debería sorprendernos que encontrar vida extraterrestre sea tan raro. Si tenemos en cuenta las distancias que nos separan y el tiempo que llevamos aquí, aún no hemos podido alcanzar la rtecnología suficiente para realizar viajes a las estrellas. Claro que, una Civilización extraterrestre llegada al Universo en otro mundo de nuestra propia Galaxia, si llegó un millón de años antes que nosotros, ¿cómo estarían de adelantados?

Estaremos aislados en un cosmos “infinito”

“El hecho fundamental de nuestra existencia es que parecemos estar aislados en el cosmos. Somos los únicos seres racionales capaces de expresarse en el silencio del universo. En la historia del Sistema Solar se ha dado en la Tierra, durante un periodo de tiempo infinitesimalmente corto, una situación en la que los seres humanos evolucionan y adquieren conocimientos que incluye el ser conscientes de sí mismos y de existir… Dentro del Cosmos ilimitado, en un minúsculo planeta, durante un minúsculo periodo de tiempo de unos pocos milenios, algo ha tenido lugar como si este planeta fura lo que abarca todo, lo auténtico. Este es el lugar, una mota de polvo en la inmensidad del cosmos, en el que el ser ha despertado con el hombre”.

¡Son tántos los mundos! ¿Cómo no van a existir otros seres que, como en la Tierra, se pregunten las mismas cosas y tengan las mismas dudas?

Hay aquí algunas grandes hipótesis sobre el carácter único de la vida humana en el universo (creo que equivocada). En cualquier caso se plantea la pregunta, aunque no se responde, de por qué estamos aquí en el tiempo y lugar en que lo hacemos. Hemos visto que la cosmología moderna puede ofrecer algunas respuestas esclarecedoras a estas preguntas.

En mi anterior trabajo quedaron reflejadas todas las respuestas a estas preguntas. Nada sucede porque sí, todo es consecuencia directa de la causalidad. Cada suceso tiene su razón de ser en función de unos hechos anteriores, de unas circunstancias, de unos fenómenos concretos que de no haberse producido, tampoco el tal suceso se habría significado, simplemente no existiría. Con la vida en nuestro planeta, ocurrió igual.

Una atmósfera primitiva evolucionada, la composición primigenia de los mares y océanos con sus compuestos, expuestos al bombardeo continuo de radiación del espacio exterior que llegaba en ausencia de la capa de ozono, la temperatura ideal en relación a la distancia del Sol a la Tierra y otra serie de circunstancias muy concretas, como la edad del Sistema Solar y los componentes con elementos complejos del planeta Tierra, hecho del material estelar evolucionado a partir de supernovas, todos estos elementos y circunstancias especiales en el espacio y en el tiempo, hicieron posible el nacimiento de esa primera célula que fue capaz de reproducirse a sí misma y que, miles de años después, hizo posible que evolucionara hasta lo que hoy es el hombre que, a partir de materia inerte, se convirtió en un ser pensante que ahora es capaz de exponer aquí mismo estas cuestiones. ¡Es verdaderamente maravilloso!

El entorno cambiante en un universo en expansión como el nuestro, a medida que se enfría y envejece (la entropía) es posible que se formen átomos, moléculas, galaxias, estrellas, planetas y organismos vivos. En el futuro, las estrellas agotaran su combustible nuclear y morirán todas. En función de sus masas serán estrellas enanas blancas (como nuestro Sol), estrellas de neutrones (a partir de 1’5 masas sobre hasta 3 masas solares) y agujeros negros a partir de 3 masas solares. Hay un recorrido de historia cósmica en el que nuestro tipo de evolución biológica debe ocurrir bajo esas circunstancias especiales a las que antes me referí.

![[muertetermica12015585658%255B3%255D.jpg]](http://lh5.ggpht.com/-oB5bpCrDPsY/TsK_cRftqbI/AAAAAAAASbU/rhusDMrkoTA/s1600/muertetermica12015585658%25255B3%25255D.jpg)

Circula por ahí una Teoría que nos habla de la muerte Térmica del Universo

No podemos saber cuándo, pero sí tenemos una idea muy clara de cómo será dicho final. El universo es todo lo que existe, incluyendo el espacio, el tiempo y la materia. El estudio del universo es la cosmología, que distingue entre el Universo con “U” mayúscula, significando el cosmos y su contenido, y el universo con “u” minúscula, que es normalmente un modelo matemático deducido de alguna teoría. El universo real está constituido en su mayoría por espacios aparentemente vacios, existiendo materia concentrada en galaxias formadas por estrellas y gas. El universo se está expandiendo, de manera que el espacio entre las galaxias está aumentando gradualmente, provocando un desplazamiento al rojo cosmológico en la luz procedente de los objetos distantes.*

Dicen algunos que existe una evidencia creciente de que el espacio está o puede estar lleno de una materia invisible, “materia oscura”, que puede constituir muchas veces la masa total de las galaxias visibles (materia bariónica). Sabemos que el origen más probable del universo está en al teoría conocida como del Big Bang que, a partir de una singularidad de una densidad y energía infinita, hace ahora unos 15 mil millones de años, surgió una inmensa bola de fuego que desde entonces no ha dejado de expandirse y enfriarse.

Somos osados. Cuando hablamos de lo que no sabemos

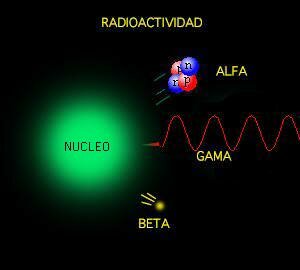

En el proceso, nació el tiempo y el espacio, surgieron las primeros quarks que pudieron unirse para formar protones y electrones que formaron los primeros núcleos y, cuando estos núcleos fueron rodeados por los electrones, nacieron los átomos que evolucionando y juntándose hicieron posible la materia; todo ello, interaccionado por cuatro fuerzas fundamentales que, desde entonces, por la rotura de la simetría original divididas en cuatro parcelas distintas, rigen el universo. La fuerza nuclear fuerte responsable de mantener unidos los nucleones, la fuerza nuclear débil, responsable de la radiactividad natural desintegrando elementos como el uranio, el electromagnetismo que es el responsable de todos los fenómenos eléctricos y magnéticos, y la fuerza de gravedad que mantiene unidos los planetas y las galaxias.

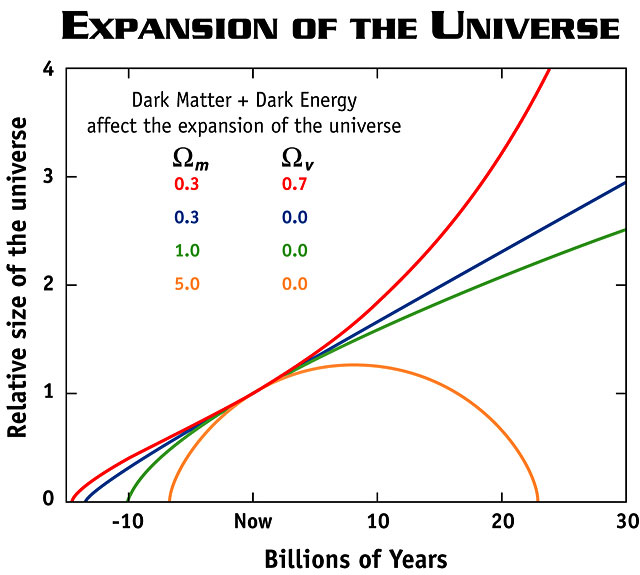

Pero hemos llegado a saber que el universo podrá ser abierto o cerrado. Un universo que siempre se expande y tiene una vida infinita es abierto. Esto es un universo de Friedmann que postuló que el nuestro tenía una densidad menor que la densidad crítica.

El universo cerrado es el que es finito en tamaño, tiene una vida finita y en el que el espacio está curvado positivamente. Un universo de Friedman con la densidad mayor que la densidad crítica.

El universo en expansión es el que el espacio entre los objetos está aumentando continuamente. En el universo real, los objetos vecinos como los pares de galaxias próximas entre sí no se separan debido a que su atracción gravitatoria mutua supera los efectos de la expansión cosmológica (el caso de la Vía Láctea y Andrómeda). No obstante, la distancia entre dos galaxias muy separadas, o entre dos cúmulos de galaxias, aumenta con el paso del tiempo y la expansión imparable del universo.

Aunque estémos acostumbrados a ver imágenes de bellos cúmulos de galaxias, lo cierto es que, en el Universo, predominan los espacios vacíos.

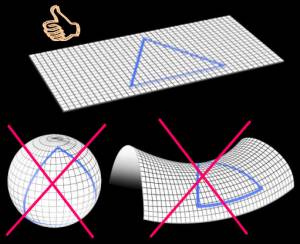

El universo real está en función de la densidad crítica que es la densidad media de materia requerida para que la gravedad detenga la expansión del universo. Un universo con una densidad muy baja se expandirá para siempre, mientras que uno con densidad muy alta colapsara finalmente. Un universo con exactamente la densidad crítica, alrededor de 10-29g/cm3, es descrito por el modelo de universo de Einstein-de Sitter, que se encuentra en la línea divisoria de estos dos extremos. Pero la densidad media de materia que puede ser observada directamente en nuestro universo no representa la cantidad necesaria para generar la fuerza de gravedad que se observa en la velocidad de alejamiento de las galaxias, que necesita mucha más materia que la observada para generar esta fuerza gravitatoria, lo que nos da una prueba irrefutable de que ahí fuera, en el espacio entre galaxias, está oculta esa otra materia invisible, la “materia oscura”, que nadie sabe lo que es, cómo se genera o de qué esta hecha. Así que, cuando seamos capaces de abrir esa puerta cerrada ante nuestras narices, podremos por fin saber la clase de universo en el que vivimos; si es plano, si es abierto e infinito, o si es un universo que, por su contenido enorme de materia es curvo y cerrado.

Según todos los indicios, estamos en un Universo Plano

Claro que saber la cantidad de materia que pueda contener nuestro universo, no resultará tan fácil como mirar a las estrellas. Aunque alguna idea tenemos…, con certeza nada sabemos en relación a infinut de cuestiones con el Universo relacionadas…, a otras sí hemos podido acercarnos algo más. Pero la respuesta a la pregunta, aún sin saber exactamente cuál es la densidad crítica del universo, sí podemos contestarla en dos vertientes, en la seguridad de que al menos una de las dos es la verdadera.

El destino final será:

a) Si el universo es abierto y se expande para siempre, cada vez se hará más frio, las galaxias se alejarán las unas de las otras, la entropía hará desaparecer la energía y el frio será tal que la temperatura alcanzará el cero absoluto, -273ºK. La vida no podrá estar presente.

b) Si el universo es cerrado por contener una mayor cantidad de materia, llegará un momento en que la fuerza de gravedad detendrá la expansión de las galaxias, que poco a poco se quedarán quietas y muy lentamente, comenzaran a moverse en el sentido inverso; correrán ahora las unas hacia las otras hasta que un día, a miles de millones de años en el futuro, todo la materia del universo se unirá en una enorme bola de fuego, el Big Crunch. Se formará una enorme concentración de materia de energía y densidad infinitas. Habrá dejado de existir el espacio y el tiempo. Nacerá una singularidad que, seguramente, dará lugar a otro Big Bang. Todo empezará de nuevo, otro universo, otro ciclo ¿pero aparecemos también nosotros en ese nuevo universo?

Esta pregunta sí que no sé contestarla.

Aquí sabemos de la infinitud de galaxias que conforma nuestro univeroso, de la entropía que acompaña al inexorable pasar del tiempo, el espacio que nos separa de los objetos del cosmos, de cómo está formada la materia conocida…y, sin embargo, no sabemos muchas de las cosas que nos rodean y, tampoco de nosotros mismos.

Contemplamos en la imagen de más abajo como muchas galaxias terminan por fusionarse. Así podría ser el futuro de la Vía Láctea y Andrómeda. ¿Y nosotros, dónde estaremos para cuando eso ocurra? Y, ¿Cuando el Sol se convierta en Gigante roja primero y Nebulosa planetaria después, si hemos podido sobrevivir, ¿dónde nos habremos instalados? ¿Qué nuevos mundos serán nuestros hogares?

Así las cosas, no parece que el futuro de la Humanidad sea muy alentador. Claro que los optimistas nos hablan de hiperespacio y universos paralelos a los que, para ese tiempo, ya habremos podido desplazarnos garantizando la continuidad de la especie Humana. Bien pensado, si no fuera así ¿para qué tantas dificultades vencidas y tantas calamidades pasadas? ¿Para terminar congelados o consumidos por un fuego abrasador?

¡Quién pudiera contestar a eso!

Cuando pensamos en la edad y el tamaño del universo lo hacemos generalmente utilizando medidas de tiempo y espacio como años, kilómetros o años-luz. Como ya hemos visto, estas medidas son extraordinariamente antropomórficas. ¿Por qué medir la edad del universo con un “reloj” que hace “tic” cada vez que nuestro planeta completa una órbita alrededor de su estrella madre, el Sol? ¿Por qué medir su densidad en términos de átomos por metro cúbico? Las respuestas a estas preguntas son por supuesto la misma: porque es conveniente y siempre lo hemos hecho así.

Si para entonces hemos aguantado, sabremos lo que tenemos que hacer para que nuestra especie perdure. Y, espero con fuerzas que, para cuando eso llegue a pasar, todos tengamos consciencia de que, el dolor del otro es nuestro dolor.

Ésta es una situación en donde resulta especialmente apropiado utilizar las unidades “naturales”; la masa, longitud y tiempo de Stoney y Planck, las que ellos introdujeron en la ciencia física para ayudarnos a escapar de la camisa de fuerza que suponía la perspectiva centrada e el ser humano.

Es fácil caer en la tentación de mirarnos el ombligo y no hacerlo al entorno que nos rodea. Muchas más cosas habríamos evitado y habríamos descubierto si por una sola vez hubiésemos dejado el ego a un lado y, en lugar de estar pendientes de nosotros mismos, lo hubiéramos hecho con respecto a la naturaleza que, en definitiva, es la que nos enseña el camino a seguir.

La edad actual del universo visible ≈ 1060 tiempos de Planck

Tamaño actual del Universo visible ≈ 1060 longitudes de Planck

La masa actual del Universo visible ≈ 1060 masas de Planck

Vemos así que la bajísima densidad de materia en el universo es un reflejo del hecho de que:

Densidad actual del universo visible ≈10-120 de la densidad de Planck

Y la temperatura del espacio, a 3 grados sobre el cero absoluto es, por tanto

Temperatura actual del Universo visible ≈ 10-30 de la Planck

Estos números extraordinariamente grandes y estas fracciones extraordinariamente pequeñas nos muestran inmediatamente que el universo está estructurado en una escala sobrehumana de proporciones asombrosas cuando la sopesamos en los balances de su propia construcción.

Con respecto a sus propios patrones, el universo es viejo. El tiempo de vida natural de un mundo gobernado por la gravedad, la relatividad y la mecánica cuántica es el fugaz breve tiempo de Planck. Parece que es mucho más viejo de lo que debería ser.

Pero, pese a la enorme edad del universo en “tics” de Tiempo de Planck, hemos aprendido que casi todo este tiempo es necesario para producir estrellas y los elementos químicos que traen la vida.

¿Por qué nuestro universo no es mucho más viejo de lo que parece ser? Es fácil entender por qué el universo no es mucho más joven. Las estrellas tardan mucho tiempo en formarse y producir elementos más pesados que son las que requiere la complejidad biológica. Pero los universos viejos también tienen sus problemas. Conforme para el tiempo en el universo el proceso de formación de estrellas se frena. Todo el gas y el polvo cósmico que constituyen las materias primas de las estrellas habrían sido procesados por las estrellas y lanzados al espacio intergaláctico donde no pueden enfriarse y fundirse en nuevas estrellas. Pocas estrellas hacen que, a su vez, también sean pocos los sistemas solares y los planetas. Los planetas que se forman son menos activos que los que se formaron antes, la entropía va debilitando la energía del sistema para realizar trabajo.

La producción de elementos radiactivos en las estrellas disminuirá, y los que se formen tendrán semividas más largas. Los nuevos planetas serán menos activos geológicamente y carecerán de muchos de los movimientos internos que impulsan el vulcanismo, la deriva continental y la elevación de las montañas en el planeta. Si esto también hace menos probable la presencia de un campo magnético en un planeta, entonces será muy poco probable que la vida evolucione hasta formas complejas.

emilio silvera

Totales: 72.364.151

Totales: 72.364.151 Conectados: 42

Conectados: 42