Jun

24

Nebulosas Planetarias y estrellas enanas blancas

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Nebulosas y estrellas ~

Clasificado en Nebulosas y estrellas ~

Comments (3)

Comments (3)

NGC 2392 es una nebulosa planetaria en la constelación de Gérminis

En la imagen de arriba contemplamos la Nebulosa del Esquimal o del Payaso, NGC 2392, que forma un conjunto vistoso. Por su curiosa apariencia, que recuerda a la cara de una persona rodeada por una capucha, recibe también los nombres de Nebulosa Esquimal. Se encuentra, según autores, a unos 3000 o/ 5000 años-luz de la Tierra.

La edad de NGC 2392 se estima en unos 10.000 años, y está compuesta por dos lóbulos elípticos de materia saliendo de la estrella moribunda. Desde nuestra perspectiva, unos de los lóbulos está delante del otro.

Se cree que la forma de la nebulosa se debe a un anillo de material denso alrededor del ecuador de la estrella expulsado durante la fase de gigante roja. Este material denso es arrastrado a una velocidad de 115.000 km/h., impidiendo que el viento estelar, que posee una velocidad mucho mayor, empuje la materia a lo largo del ecuador. Por el contrario, este viento de gran velocidad (1,5 millones de km/h) barre material por encima y debajo de la estrella, formando burbujas alargadas. Estas burbujas, de 1 año luz de longitud y la mitad de anchura, tienen filamentos de materia más densa. No obstante, las líneas que van de dentro a afuera en el anillo exterior (en la capucha) no tienen todavía explicación, si bien su origen puede deberse a la colisión entre gases de baja y alta velocidad.

La Nebulosa del Esquimal fue descubierta por William Herschel el 17 de enero de 1787.

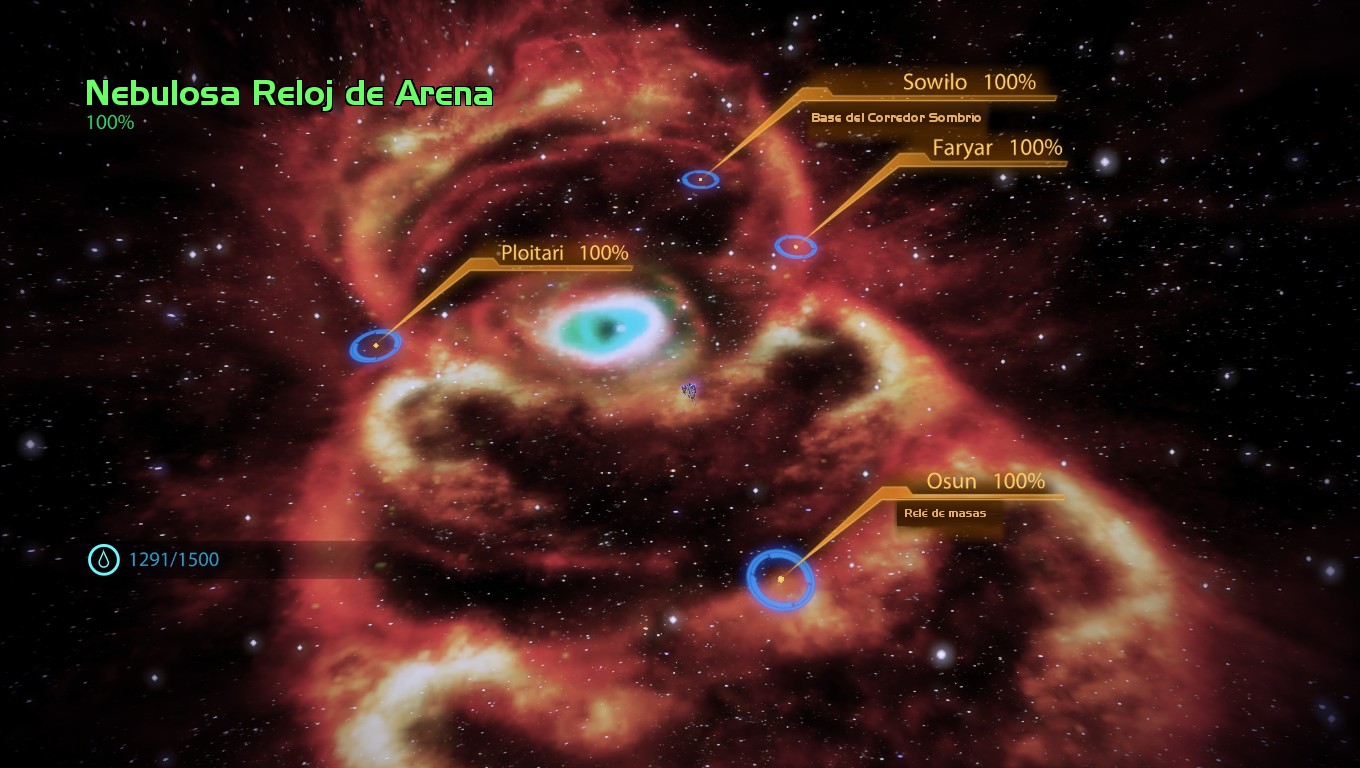

La Nebulosa Reloj de Arena

Una nebulosa planetaria es una nebulosa de emisión consistente en una envoltura brillante en expansión de plasma y gas ionizado, expulsada durante la fase de rama asintótica gigante que atraviesan las estrellas gigantes rojas en los últimos momentos de sus vidas.

Las nebulosas planetarias son objetos de gran importancia en astronpmía, debido a que desempeñan un papel crucial en la evolución química de las Galaxias, devolviendo al medio interestelar metales pesados y otros productos de la nucleosíntesis de las estrellas (como Carbono, Nitrógeno, xígeno, Calcio… y otros). En galaxias lejanas, las nebulosas planetarias son los únicos objetos de los que se puede obtener información útil acerca de su composición química.

La Nebulosa Ojo de Gato. Imagen en falso color (visible y rayos X) tomada por el tomada por el Hubble.

La gama y diseños de Nebulosas Planetarias es de muy amplio abanico y, en esa familia de Nubulosas podemos admirar y asombrarnos con algunas que, como la famosa Ojo de Gato (arriba), nos muestra una sinfonía de arquitectónica superpuesta que ni la mente del más avispado arquitecto habría podido soñar.

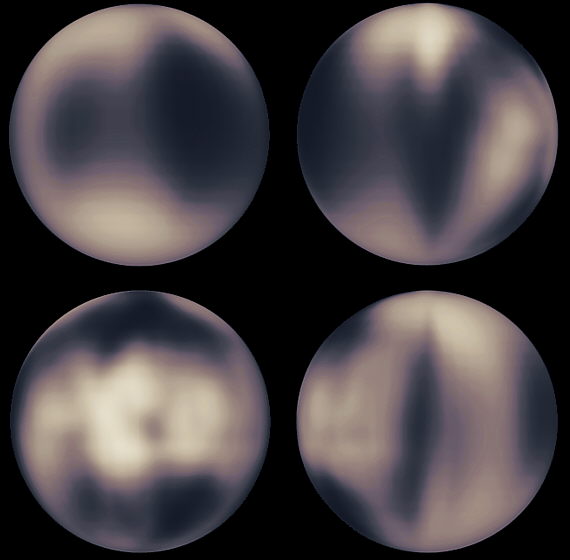

Una enana blanca es una pequeña y densa estrella que es el resultado final de la evolución de todas las estrellas (por el ejemplo el Sol), excepto las muy masivas. Según todos los estudios y observaciones, cálculos, modelos de simulación, etc., estas estrellas se forman cuando, al final de la vida de las estrellas medianas, agotan el combustible de fusión nuclear, se produce el colapso de sus núcleos estelares, y quedan expuestas, cuando las partes exteriores de la estrella son expulsadas al espacio interestelar formar una Nebulosa Planetaria. En el centro de la Nebulosa, queda desnudo un puntito blanco que es, la estrella enana blanca.

El Núcleo se contrae bajo su propia gravedad hasta que, habiendo alcanzado un tamaño similar al de la Tierra , se ha vuelto tan densa (5 x 10 ^8 Kg/m3) que sólo evita su propio colapso por la preseión de degeneración de los electrones (los electrones son fermiones que estando sometidos al Principio de exclusión de Pauli, no pueden ocupar niguno de ellos el mismo lugar de otro al tener el mismo número cuántico y, siendo así, cuando se juntan demasiado, se degeneran y comienzan una frenética carrera que, en su intensidad, incluso frenar la implosión de una estrella -como es el caso de las enanas blancas).

Las enanas blancas se forman con muy altas temperaturas superficiales (por encima de los 10 000 K) debido al calor atrapados en ellas, y liberado por combustiones nucleares previas y por la intensa atracción gravitacional que sólo se ve frenada por la degeneración de los electrones que, finalmente, la estabilizan como estrella enana blanca.

tipo de estrellas, con el paso del tiempo, se enfrían gradualmente, volviéndose más débiles y rojas. Las enanas blancas pueden constituir el 30 por ciento de las estrellas de la vecindad solar, aunque debido a sus bajas luminosidades de 10 ^-3 – 10 ^-4 veces la del Sol, pasan desapercibidas. La máxima máxima posible de una enana blanca es de 1,44 masas solares, el límite de Shandrasekhar. Un objeto de masa mayor se contraería aún más y se convertiría en una estrella de neutrones o, de tener mucha masa, en un agujero negro.

Las enanas blancas son estrellas calientes y pequeñas, generalmente del tamaño de la Tierra, por lo que su luminosidad es muy baja. Se cree que las enanas blancas son los residuos presentes en el centro de las nebulosas planetarias. Dicho de otra manera, las enanas blancas son el núcleo de las estrellas de baja masa que quedan después de que la envoltura se ha convertido en una nebulosa planetaria.

El núcleo de una enana blanca consiste de material de electrones degenerados. Sin la posibilidad de tener nuevas reacciones nucleares, y probablemente después de haber perdido sus capas externas debido al viento solar y la expulsión de una nebulosa planetaria, la enana blanca se contrae debido a la fuerza de gravedad. La contracción hace que la densidad en el núcleo aumente hasta que se den las condiciones necesarias para tener un material de electrones degenerados. Este material genera presión de degeneración, el cual contrarresta la contracción gravitacional.

Procyon B, una débil enana blanca.

Al ser estudiadas más a fondo las propiedades de las enanas blancas se encontró que al aumentar su masa, su radio disminuye. A partir de esto es que se encuentra que hay un límite superior la masa de una enana blanca, el cual se encuentra alrededor de 1.4 masas solares (MS). Si la masa es superior a 1.4 MS la presión de degeneración del núcleo no es suficiente detener la contracción gravitacional. Este se llama el límite de Chandrasekhar.

Debido a la existencia de este límite es que las estrellas de entre 1.4 MS y 11 MS deben perder masa para poder convertirse en enanas blancas. Ya explicamos que dos medios de pérdida de masa son los vientos estelares y la expulsión de nebulosas planetarias. Sin embargo, existen otras posiblidades que se puedan dar en este tipo de estrellas que son muy densas. Por ejemplo, si cerca de alguna de ellas reside otra estrella que esté lo bastante cerca, la enana blanca, poco a poco, puede ir robándole masa a la estrela compañera hasta que, llegado a un punto, ella misma se recicla y se convierte en una estrella de Neutrones.

Después de que una estrella se ha convertido en enana blanca, lo más probable es que su destino sea enfriarse y perder brillo. Debido a que las enanas blancas tienen una baja luminosidad, pierden energía lentamente, por lo que pueden permanecer en etapa en el orden de años. Una vez que se enfrían, se vuelven rocas que se quedan vagando por el Universo. Este es el triste destino de nuestro Sol.

La detección de enanas blancas es difícil, ya que son objetos con un brillo muy débil. Por otro lado, hay ciertas diferencias en las enanas blancas según su masa. Las enanas blancas menos masivas sólo alcanzan a quemar hidrógeno en helio. Es decir, el núcleo de la estrella nunca se comprime lo suficiente como alcanzar la temperatura necesaria para quemar helio en carbono. Las enanas blancas más masivas sí llevan a cabo reacciones nucleares de elementos más pesados, es decir, en su núcleo podemos encontrar carbono y oxígeno.

Allá por el año 1908, siendo Chandrasekhar un avanzado estudiante de física, vivía en Madrás, en la Bahía de Bengala (En cuyo Puerto trabajó Ramanujan), y, estando en aquella ciudad el célebre científico Arnold Sommerfeld, le pidió audiciencia y se pudo entrevistar con él que, le vino a decir que la física que estudiaba estaba pasada, que se estaban estudiando nuevos caminos de la física y, sobre todo, uno a cuya teoría se la llamaba mecánica cuántica que podía explicar el comportamiento de lo muy pequeño.

Cuando se despidieron Sommerfeld dio a Chandrasekhar la prueba de imprenta de un artículo técnico que acaba de escribir. Contenía una derivación de las leyes mecanocuánticas que gobiernan grandes conjuntos de electrones comprimidos en volúmenes pequeños, por ejemplo ( este caso) en una estrella enana blanca.

A partir de aquel artículo, Chandrasekhar buscó más información y estudió estos fenómenos estelares que desembocaban en enanas blancas. Este tipo de estrella habían descuibiertas por las astrónomos a través de sus telescopios. Lo misterioso de las enanas blancas era su densidad extraordinariamente alta de la materia en su interior, una densidad muchísimo mayor que la de cualquier otra cosa que los seres humanos hubieran encontrado antes. Chandrasekhar no tenía forma de saberlo cuando abrió un libro de Eddintong que versaba sobre la materia, pero la lucha por desvelar el misterio de alta densidad le obligaría fibnalmente a él y a Eddintong a afrontar la posibilidad de que las estrellas masivas, cuando mueren, pudieran contraerse para formar agujeros negros.

De las enanas blancas más conocidas y cercanas, tenemos a Sirio B. Sirio A y Sirio B son la sexta y la séptima estrellas en orden de proximidad a la Tierra, a 8,6 años-luz de distancia, y Sirio es la estrella más brillante en nuestro cielo. Sirio B orbita en torno a Sirio de la misma manera que lo hace la Tierra alrededor del Sol, pero Sirio B tarde 50 años en completar una órbita a Sirio y la Tierra 1 año al Sol.

Eddintong describía como habían estimado los astrónomos, a partir de observaciones con telescopios, la masa y la circunferencia de Sirio B. La masa era de 0,85 veces la masa del Sol; la circunferencia media 118.000 km. Esto significaba que la densidad media de Sirio B era de 61.000 gramos por centímetro cúbico, es decir 61.000 veces mayor que la densidad del agua. “Este argumento se conoce ya hace algunos años -nos decía Eddintong-” Sin embargo, la mayoría de los astrónomos de aquel tiempo, no se tomaban en serio tal densidad, Sin embargo, si hubieran conocido la verdad que conocemos: (Una masa de 1,05 soles, una circunferencia de 31.000 km y una densidad de 4 millones de gramos por cm3), la habrían considerado aún más absurda.

Arriba la famosa Nebulosa planetaria ojo de Gato que, en su centro luce una estrella enana blanca de energéticas radiaciones en el ultravioleta y que, a medida que se vaya enfriando, serán de rayos C y radio que, dentro de unos 100 millones de años vieja y fria, será más rojiza y se habrá convertido en un cadáver estelar.

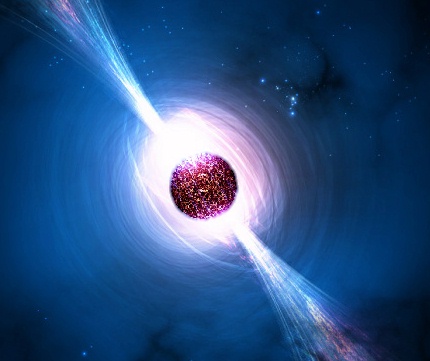

Aquellos trabajos de Chandraskar y Eddintong desembocaron en un profundo conocimiento de las estrellas de neutrones y, se llego a saber el por qué conseguian el equilibrio que las estabilizaba a través de la salvación que, finalmente encontraban, en la mecánica cuántica, cuando los electrones degenerados por causa del Principio de esclusión de Pauli, no dejaban que la fuerza gravitatoria continuara el proceso de contracción de la estrella y así, quedaba estabilizada como estrella de neutrones.

De la misma manera, se repetía el proceso estrellas más masivas que, no pudiendo ser frenadas en su implosión gravitatoria por la degeneración de los electrones, sí que podia frenarse la Gravedad, mediante la degeneración de los Neutrones. Cuando esa estrella más masiva se contraía más y más, el Principio de exclusión de pauli que impide que los fermiones estén juntos, comenzaba su trabajo e impedía que los neutrones (que son fermiones), se juntaran más, entonces, como antes los electrones, se degeneraban y comenzaban a moverse con velocidades relativistas y, tan hecho, impedía, por sí mismo que la Gravedad consiguiera comprimir más la masa de la estrella que, de manera, quedaba convertida, finalmente, en una Estrella de Neutrones.

Al formarse la estrella de neutrones la estrella se colapsa hasta formar una esfera perfecta con un radio de tan solo unos 10 kilómetros. En este punto la presión neutrónica de Fermi resultante compensa la fuerza gravitatoria y estabiliza la estrella de neutrones. Apenas una cucharilla del material que conforma una estrella de neutrones tendría una masa superior a 5 x 10 ^12 kilogramos.

Los modelos de estrellas de neutrones que se han logrado construir utilizando las leyes físicas presentan varias capas. Las estrella de neutrones presentarían una corteza de hierro muy liso de, aproximadamente, un metro de espesor. Debajo de corteza, prácticamente todo el material está compuesto por núcleos y partículas atómicas fuertemente comprimidos formando un “cristal” sólido de materia nucleica.

Son objetos extremadamente pequeños u densos que surgen cuando estrellas masivas sufren una explosión supernova del II, el núculeo se colapsa bajo su propia gravedad y puede llegar hasta una densidad de 10 ^17 Kg/m3. Los electrones y los protones que están muy juntos se fusionan y forman neutrones. El resultado final consiste solo en neutrones, cuyo material, conforma la estrella del mismo . Con una masa poco mayor que la del Sol, tendría un diámetro de sólo 30 Km, y una densidad mucho mayor que la que habría en un terrón de azúcar con una masa igual a la de toda la humkanidad. Cuanto mayor es la masa de una estrella de neutrones, menor será su diámetro. Está compuesta por un interior de neutrones superfluidos (es decir, neutrones que se comportan como un fluido de viscosidad cero), rodeado por más o menos una corteza sólida de 1 km de grosor compuesta de elementos como el hierro. Los púlsares son estrellas de neutrones magnetizadas en rotación. Las binarias de rayos X masivas también se piensan que contienen estrellas de neutrones.

Todos aquellos argumentos sobre el comportamiento de las enanas blancas vinieron a desembocar en la paradoja de Edddintong que, en realidad, fue resuelta por el Joven Chandrasekhar en el año 1925 al leer un artículo de R.H. Fowler “Sobre la materia densa”. La solución residía en el fallo de las leyes de la física que utilizaba Eddintong. Dichas leyes debían ser reemplazadas por la nueva mecánica cuántica, que describía la presión en el interior de Sirio B y otras enanas blancas como debida no al calor sino a un fenómeno mecanocuántico : los movimientos degenerados de los electrones, también llamado degeneración electrónica.

La degeneración electrónica es algo muy parecido a la claustrofia humana. Cuando la materia es comprimida hasta una densidad 10.000 veces mayor que la de una roca, la nube de electrones en torno a cada uno de sus núcleos atómicos se hace 10.000 veces más condensada, Así, cada electrón queda confinado en una “celda” con un volumen 10.000 veces menor que el volumen en el que previamente podía moverse. Con tan poco espacio disponible, el electrón, como nos pasaría a cualquiera de nosotros, se siente incómodo, siente claustrofobia y comienza a agitarse de manera incontrolada, golpeando con enorme fuerza las paredes de las celdas adyacentes. Nada puede deternerlo, el electrón está obligado a ello por las leyes de la mecánica cuántica. Esto está producido por el Principio de esclusión de Pauli que impide que dos fermiones estén juntos, así que, fuerza es, la que finalmente posibilita que la estrella que se comprime más y más, quede finalmente, constituida estable como una enana blanca.

emilio silvera

Jun

23

Nueva manera de mirar el Universo

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Ondas gravitacionales ~

Clasificado en Ondas gravitacionales ~

Comments (4)

Comments (4)

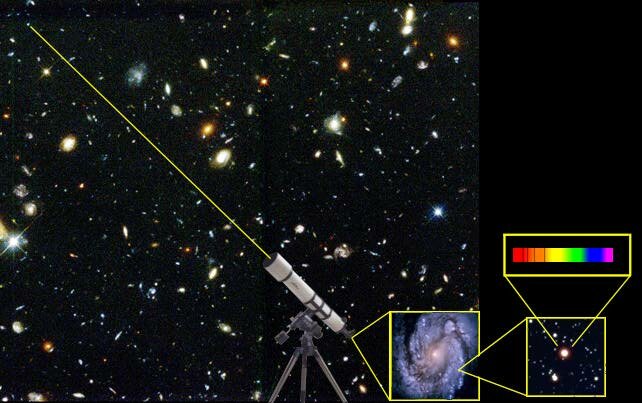

Telescopios como el de la imagen (en Chile) ayudan a entender el origen del Universo. Fermilab

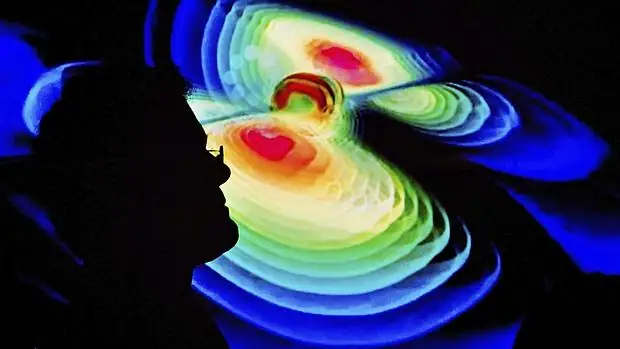

La historia de la primera onda gravitacional detectada por un experimento humano es casi tan antigua como el Universo. Así lo indica un estudio publicado hoy que reconstruye hasta su origen más remoto la señal captada en septiembre de 2015 por el Observatorio de Interferometría Láser de Ondas Gravitacionales (LIGO), uno de los descubrimientos más importantes de esta década.

Hace un siglo, Albert Einstein predijo que, de acuerdo con la teoría de la relatividad, los fenómenos más violentos del cosmos deberían producir intensos estallidos de energía que viajaría a la velocidad de la luz en forma de ondas gravitatorias. Estas ondulaciones curvan el espacio y el tiempo a su paso y se expanden en todas direcciones durante miles de millones de años. Pero detectarlas en la Tierra era imposible. El origen de estos fenómenos está tan lejos y sus señales atraviesan tanto espacio que al llegar al Sistema Solar son imperceptibles incluso con la tecnología más avanzada, pensó el genio alemán.

Ahora sabemos que se equivocó en el detalle y acertó, como siempre, en lo importante. La primera señal de ondas gravitatorias se captó en septiembre de 2015 y fue anunciada en febrero. La produjo la fusión de dos agujeros negros, cada uno unas 30 veces con más masa que el Sol, y sucedió hace unos 1.300 millones de años, cuando todos los terrícolas eran microbios incapaces de entender qué estaba pasando.

El nuevo estudio, publicado hoy en Nature, aclara cómo se formaron esos dos agujeros negros. El trabajo lo firman cuatro científicos expertos en cosmología y relatividad computacional de la Universidad de Chicago y el Instituto de Tecnología de Rochester, ambos en EE UU, y la Universidad de Varsovia, en Polonia. Han creado un modelo informático que reconstruye la historia del universo y permite estimar qué tipo de cuerpos celestes podrían producir una señal como la detectada por LIGO. Para esto han necesitado usar Atlas, el mayor superordenador dedicado al estudio de ondas gravitacionales del mundo, y además algo de tiempo de computación de miles de PCs de ciudadanos interesados por la ciencia a través del proyecto Universe@home.

Ahora sabemos que Einstein se equivocó en el detalle y acertó, como siempre, en lo importante

Los resultados muestran que, para viajar hasta la semilla de la primera onda gravitacional, hay que remontarse a unos 2.000 millones de años después del Big Bang. En aquel universo adolescente se formaron dos estrellas que tenían cada una al menos 40 veces más masa que el Sol y que estaban peligrosamente juntas. Es lo que los astrónomos llaman un sistema binario, dos astros que orbitan el uno en torno al otro y que, con cada vuelta, recortan un poco la distancia que los separa.

Las dos estrellas estaban entre las más brillantes y grandes de todo el Universo, según J. J. Eldridge, físico de la Universidad de Auckland (Nueva Zelanda). El científico razona que, si los cálculos del estudio son correctos, estos dos astros contribuyeron a que el Universo saliese de la llamada Edad oscura, un paso fundamental en la línea de eventos que lleva hasta nosotros pues, de no haberse superado esta etapa no habría estrellas, galaxias ni vida.

Cuatro millones de años después de su nacimiento, un instante en términos cosmológicos, a una de las dos estrellas se le agotó el combustible. Su enorme núcleo se derrumbó sobre sí mismo creando un punto matemático de volumen cero y densidad infinita. Nada, ni siquiera la luz de su estrella compañera ni cualquier otra en todo el Universo era capaz de escapar a su atracción si se acercaba demasiado. Era un agujero negro de unas 30 masas solares. Pasado otro millón de años, su estrella compañera sufrió idéntica metamorfosis.

Ambos monstruos estaban separados por unos 34 millones de kilómetros, bastante menos distancia que un viaje espacial de la Tierra a Marte. Según los cálculos del estudio, la atracción gravitatoria entre ambos fue royendo centímetros a esa separación hasta que, 10.000 millones de años después, acabaron fundiéndose en un violento abrazo. La unión formó un gran agujero negro y liberó en fracciones de segundo toda la energía que cabría en tres estrellas como el Sol. Si alguien hubiese estado cerca, hubiera vivido una letal tormenta donde el espacio se estiró y se contrajo como un chicle y el tiempo osciló de forma caótica entre el pasado y el futuro.

Las ondas gravitacionales producidas por esta fusión siguieron avanzando hasta que, ya reducidas a una vibración menor que la milésima parte del diámetro de un protón, pasados 1.300 millones de años, fueron captadas por los haces de luz láser del experimento LIGO, instalados en Luisiana y Washington, con un pequeñísimo retardo que permitió determinar la región del universo desde la que llegaban. La noticia causó una enorme expectación que alcanzó las portadas de los mejores periódicos del mundo. Einstein era reivindicado una vez más, justo 100 años después de su predicción, y se abría una nueva era para la exploración y comprensión del cosmos. Si no es la mejor historia jamás contada, por lo menos es una de las más largas: 11.700 millones de años de principio a fin.

Mil fusiones al año

Una de las principales utilidades de los observatorios de ondas gravitacionales como LIGO o el europeo Virgo es reconstruir la evolución del universo. Permiten saber cómo y dónde nacen los agujeros negros, cómo se transforman y estimar cuántos hay en el universo observable. De hecho hasta ahora las observaciones de estos monstruos del cosmos, que influyen de forma fundamental en la evolución de todas las galaxias, incluida la nuestra, eran indirectas.

El objetivo ahora es ir sumando detecciones de ondas que aclaren todos estos asuntos. Según el estudio publicado hoy, se detectarán unas 1.000 fusiones de agujeros negros similares a las captadas hasta ahora cada año una vez que LIGO y el resto de observatorios alcancen su máxima sensibilidad.

Jun

23

La Limpia y Pulcra Vecina Galáctica de la Vía Láctea

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en El Universo asombroso ~

Clasificado en El Universo asombroso ~

Comments (0)

Comments (0)

Muchas galaxias están cargadas de polvo, mientras que otras, a veces, tienen rastros oscuros de opaco hollín cósmico arremolinándose entre el gas y las estrellas. Sin embargo, el objeto de esta nueva imagen, captada con la cámara OmegaCAM (instalada en el Telescopio de rastreo del VLT de ESO, en Chile) es poco común: la pequeña galaxia IC 1613, ¡es una maniática de la limpieza! IC 1613 contiene muy poco polvo cósmico, permitiendo a los astrónomos explorar su contenido con gran facilidad. Esto no es sólo una cuestión de apariencias: la limpieza de la galaxia es vital para comprender el universo que nos rodea.

IC 1613 es una galaxia enana irregular en la constelación de la Ballena, situada cerca de la estrella 26 Ceti. Situada a 2,38 millones de años luz de la Tierra, se aproxima a nosotros a 234 km/s. Su magnitud aparente es 9,9. Fue descubierta en 1906 por Max Wolf.

IC 1613 es una galaxia enana de la constelación de Cetus (el monstruo marino). Esta imagen del VST muestra, con gran detalle, la poco convencional belleza de esta galaxia, con todas sus estrellas y el gas rosa brillante esparcidos.

El astrónomo alemán Max Wolf descubrió el débil resplandor de IC 1613 en 1906. En 1928, su compatriota, Walter Baade, utilizó un telescopio más potente, el Telescopio de 2,5 metros del Observatorio del Monte Wilson (California), para distinguir con éxito sus estrellas individuales. De estas observaciones, los astrónomos dedujeron que la galaxia debía estar muy cerca de la Vía Láctea, ya que sólo es posible resolver estrellas individuales en galaxias muy cercanas a nosotros.

Desde entonces, los astrónomos han confirmado que IC 1613 es, de hecho, un miembro del Grupo Local, una colección de más de 50 galaxias que incluye a nuestra galaxia, la Vía Láctea. La propia IC 1613 se encuentra a poco más de 2,3 millones de años luz de nosotros. Ha sido bastante estudiada debido a su proximidad y los astrónomos la han clasificado como una galaxia enana irregular que no cuenta con muchas de las características de otras galaxias enanas, como, por ejemplo, un disco estrellado.

Sin embargo, lo que le falta en forma, IC 1613 lo compensa en orden. Conocemos la distancia a IC 1613 con una gran precisión, en parte debido a los niveles inusualmente bajos de polvo que encontramos tanto dentro de la galaxia como a lo largo de la línea de visión desde la Vía Láctea – algo que permite hacer observaciones mucho más claras.

La galaxia enana IC 1613. Image Credit: NASA/JPL-Caltech

La segunda razón por la que conocemos la distancia a IC 1613 con tanta precisión es que la galaxia tiene una notable cantidad de dos tipos de estrellas: estrellas variables Cefeidas y estrellas variables RR Lyrae. Ambos tipos de estrellas pulsan rítmicamente, creciendo de forma característica y aumentando su brillo a intervalos fijos.

Como sabemos por nuestra experiencia cotidiana en la Tierra, los objetos brillantes, como las bombillas o la llama de una vela, se ven más débiles cuanto más lejos están de nosotros. Los astrónomos pueden utilizar esta simple lógica para averiguar exactamente a qué distancia están las cosas en el universo -siempre y cuando sepan cuál es su brillo real, lo cual se denomina brillo intrínseco.

Las variables Cefeidas y RR Lyrae tienen la propiedad especial de que su período de brillo y oscurecimiento está relacionado directamente con su brillo intrínseco. Por lo tanto, midiendo la rapidez con la que fluctúan, los astrónomos pueden deducir su brillo intrínseco. Luego, pueden comparar estos valores con el brillo aparente medido y extrapolar a qué distancia deben estar para verse tan tenues.

Las estrellas con brillo intrínseco conocido pueden actuar como candelas estándar, como dicen los astrónomos, igual que una vela con un brillo específico actuaría como un buen indicador de intervalos de distancia basándonos en el brillo observado del parpadeo de la llama.

Usando candelas estándar (como las estrellas variables de IC 1613 y las explosiones de supernova de Tipo Ia, menos comunes, pero que pueden verse a mayores distancias cósmicas) los astrónomos han reconstruido una escala de distancias cósmicas, alcanzando zonas cada vez más profundas del espacio.

Hace décadas, IC 1613 ayudó a los astrónomos a deducir cómo utilizar estrellas variables para trazar la gran expansión del universo. No está mal para una galaxia pequeña y sin forma.

Fuente: Noticias de Prensa

Jun

22

¿La teoría cuántica y la Gravedad, dentro de las cuerdas?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (2)

Comments (2)

Sí, a veces la Física, parece un Carnaval. Imaginamos universos que… ¿serán posibles?

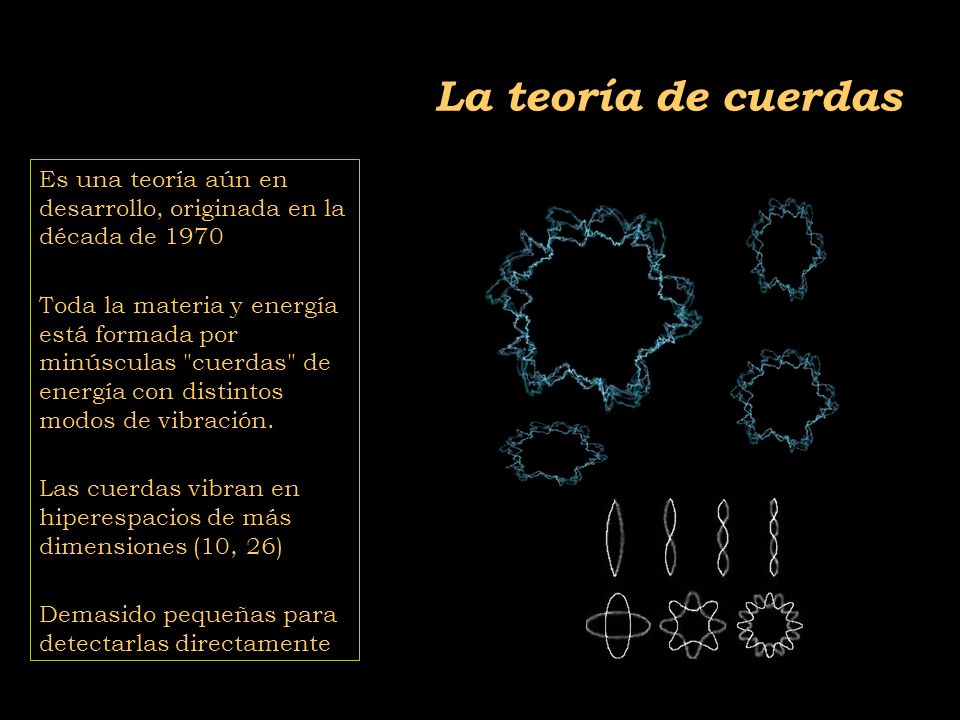

Las teorías de cuerdas [TC’s] no son una invención nueva, ni mucho menos. La primera TC se inventó a finales de los años sesenta del siglo XX en un intento para encontrar una teoría para describir la interacción fuerte. La idea medular consistía en que partículas como el protón y el neutrón podían ser consideradas como ondas de «notas de una cuerda de violín». La interacción fuerte entre las partículas correspondería a fragmentos de cuerda que se extenderían entre pequeños pedacitos de cuerda, como las telas que forman algunos simpáticos insectos. Para que esta teoría proporcionase el valor observado para la interacción fuerte entre partículas, las cuerdas tendrían que ser semejantes a las de un violín, pero con una tensión de alrededor de unas diez toneladas.

La primera expresión de las TC’s fue desarrollada por Jöel Scherk, de París, y John Schwuarz, del Instituto de Tecnología de California, quienes en el año 1974 publicaron un artículo en el que demostraban que la TC podía describir la fuerza gravitatoria, pero sólo si la tensión en la cuerda se tensiometrara alrededor de un trillón de toneladas métricas. Las predicciones de la teoría de cuerdas serían las mismas que las de la relatividad general a escala de longitudes normales, pero diferirían a distancias muy pequeñas, menores que una trillonésima de un cm. Claro está, que en esos años, no recibieron mucha atención por su trabajo.

Ahora se buscan indicios de la teoría de cuerdas en los grandes aceleradores de partículas donde parece que algunos indicios nos dicen que se va por el buen camino, sin embargo, nuestros aceleradores más potentes necesitarían multiplicar por un número muy elevado su potencia para poder, comprobar la existencia de las cuerda situadas a una distancia de 10-35 m, lugar al que nos será imposible llegar en muchas generaciones. Sin embargo, en las pruebas que podemos llevar a cabo en la actualidad, aparecen indicios de una partlicula de espín 2 que todos asocian con el esquivo Gravitón, y, tal indicio, nos lleva a pensar que, en la teoría de supercuerdad, está implícita una Teoría Cuántica de la Gravedad.

Los motivos que tuvo la comunidad científica, entonces, para no brindarle la suficiente atención al trabajo de Scherk y Schwuarz, es que, en esos años, se consideraba más viable para describir a la interacción fuerte a la teoría basada en los quarks y los gluones, que parecía ajustarse mucho mejor a las observaciones. Desafortunadamente, Scherk murió en circunstancias trágicas (padecía diabetes y sufrió un coma mientras se encontraba solo en su estudio). Así, Schwuarz se quedó solo, en la defensa de la teoría de cuerdas, pero ahora con un valor tensiométrico de las cuerdas mucho más elevado.

Pero con los quarks, gluones y también los leptones, en la consecución que se buscaba, los físicos entraron en un cuello de botella. Los quarks resultaron muy numerosos y los leptones mantuvieron su número e independencia existencial, con lo cual seguimos con un número sustancialmente alto de partículas elementales (60), lo que hace que la pregunta ¿son estos los objetos más básicos?

Si esos sesenta objetos fuesen los más básicos, entonces también aflora otra pregunta ¿por qué son como son y por qué son tantos? Los físicos quisieran poder decir «salen de esto», o «salen de esto y aquello», mencionar dos principios bien fundamentales y ojalá sea tan simples que puedan ser explicados a un niño. La respuesta «porque Dios lo quiso así» posiblemente a muchos les cause «lipotimia», ya que esa respuesta nos lleva a reconocer nuestra ignorancia y, además, la respuesta que esperamos no pertenece al ámbito de la religión. Por ahora, ¿cuál es la última respuesta que puede dar la ciencia?

El cuello de botella incentivó a que se encendiera una luz de esperanza. En 1984 el interés por las cuerdas resucitó de repente. Se desempolvaron las ideas de Kaluza y Klein, como las que estaban inconclusas de Scherk y Schwuarz. Hasta entonces, no se habían hecho progresos sustanciales para explicar los tipos de partículas elementales que observamos, ni tampoco se había logrado establecer que la supergravedad era finita.

La Teoría de cuerdas que no ha podido ser verificada, ha tenido muchos detractores. Claro que no todo son críticas, en alguna parte pude leer: “La teoría ha sido elogiada por algunos físicos debido a su potencial para forjar el largamente buscado vínculo entre la gravedad y las fuerzas que dominan en el núcleo atómico. Pero la teoría – que propone que todas las partículas subatómicas son en realidad diminutas “cuerdas” que vibran de diferentes formas – también ha arrastrado críticas por ser incomprobable en el laboratorio, y tal vez imposible de conectar con los fenómenos del mundo real.

El ser humano –en función de su naturaleza– cuando se imagina algo muy pequeño, piensa en un puntito de forma esférica. Los físicos también son seres de este planeta y, para ellos, las partículas elementales son como puntitos en el espacio, puntos matemáticos, sin extensión. Son sesenta misteriosos puntos y la teoría que los describe es una teoría de puntos matemáticos. La idea que sugieren las TC’s es remplazar esos puntos por objetos extensos, pero no como esferitas sino más bien como cuerdas. Mientras los puntos no tienen forma ni estructura, las cuerdas tienen longitud y forma, extremos libres como una coma “,” (cuerda abierta), o cerradas sobre sí misma como un circulito. Si el punto es como una esferita inerte de la punta de un elastiquito, la cuerda es el elástico estirado y con él se pueden hacer círculos y toda clase de figuras. Está lleno de posibilidades.

Muchas son las imágenes que se han elaborado para representar las cuerdas y, como nadie ha visto nunca ninguna, cualquiera de ellas vale para el objetivo de una simple explicación y, las cuerdas que se han imaginado han tomado las más pintorescas conformaciones para que, en cada caso, se adapten al modelo que se expone.

diferencia entre un punto y una coma. Según la teoría de cuerdas importa, y mucho. Por su extensión, a diferencia del punto, la cuerda puede vibrar. Y hacerlo de muchas maneras, cada modo de vibración representando una partícula diferente. Así, una misma cuerda puede dar origen al electrón, al fotón, al gravitón, al neutrino y a todas las demás partículas, según cómo vibre. Por ello, la hemos comparado con la cuerda de un violín, o de una guitarra, si se quiere.

Al dividir la cuerda en dos, tres, cuatro, cinco, o más partes iguales, se generan las notas de la escala musical que conocemos, o técnicamente, los armónicos de la cuerda. En general, el sonido de una cuerda de guitarra o de piano es una mezcla de armónicos. Según la mezcla, la calidad (timbre) del sonido. Si distinguimos el tono de estos instrumentos, es por la «receta» de la mezcla en cada caso, por las diferentes proporciones con que cada armónico entra en el sonido producido. Pero, también es posible hacer que una buena cuerda vibre en uno de esos armónicos en particular, para lo cual hay que tocarla con mucho cuidado. Los concertistas lo saben, y en algunas obras como los conciertos para violín y orquesta, usan este recurso de «armónicos». Así, la naturaleza, con su gran sabiduría y cuidado para hacer las cosas, produciría electrones, fotones, gravitones, haciendo vibrar su materia más elemental, esa única y versátil cuerda, en las diversas (infinitas) formas que la cuerda permite.

Una partícula ocupa un punto del espacio en todo momento. Así, su historia puede representarse mediante una línea en el espaciotiempo que se le conoce como «línea del mundo». Por su parte, una cuerda ocupa una línea en el espacio, en cada instante de tiempo. Por tanto, su historia en el espaciotiempo es una superficie bidimensional llamada la «hoja del mundo». Cualquier punto en una hoja del mundo puede ser descrito mediante dos números: uno especificando el tiempo y el otro la posición del punto sobre la cuerda. Por otra parte, la hoja del mundo es una cuerda abierta como una cinta; sus bordes representan los caminos a través del espaciotiempo (flecha roja) de los extremos o comas de la cuerda (figura 12.05.03.02). La hoja del mundo de una cuerda cerrada es un cilindro o tubo (figura 12.05.03.03); una rebanada transversal del tubo es un círculo, que representa la posición de la cuerda en un momento del tiempo.

No cabe duda que, de ser ciertas las TC’s, el cuello de botella queda bastante simplificado. Pasar de sesenta objetos elementales a una sola coma o circulito es un progreso notable. Entonces, ¿por qué seguir hablando de electrones, fotones, quarks, y las demás?

Que aparentemente las cosas se simplifican con las TC’s, no hay duda, pero desafortunadamente en física las cosas no siempre son como parecen. Para que una teoría sea adoptada como la mejor, debe pasar varias pruebas. No basta con que simplifique los esquemas y sea bella. La teoría de las cuerdas está –se puede decir– en pañales y ha venido mostrado distintas facetas permeables. Surgen problemas, y se la deja de lado; se solucionan los problemas y una avalancha de trabajos resucitan la esperanza. En sus menos de treinta años de vida, este vaivén ha ocurrido más de una vez.

Uno de los problemas que más afecta a la cuerda está ligado con su diminuto tamaño. Mientras más pequeño algo, más difícil de ver. Es una situación que se agudiza en la medida que se han ido corrigiendo sus permeabilidades. En sus versiones más recientes, que se llaman supercuerdas, son tan superpequeñas que las esperanzas de ubicarlas a través de un experimento son muy remotas. Sin experimentos no podemos comprobar sus predicciones ni saber si son correctas o no. Exagerando, es como una teoría que afirmara que los angelitos del cielo tienen alitas. ¿Quién la consideraría seriamente?

Lo cierto es que hablamos de esas dimensiones extra que son necesarias para desarrollar la Teoría de Cuerdas pero, en nuestro mundo cotidiano, sólo podemos detectar las tres dimensiones espaciales y la temporal que nos indicó Einstein en su Teoría de la Relatividad Especial.

La propia base conceptual de la teoría comporta problemas. Uno de ellos, es el gran número de dimensiones que se usan para formularla. En algunos casos se habla de 26 o, en el mejor, de 10 dimensiones para una cuerdita: espacio (son 3), tiempo (1) y otras seis (o 22) más, que parecen estar enroscadas e invisibles para nosotros. Por qué aparecieron estas dimensiones adicionales a las cuatro que nos son familiares y por qué se atrofiaron en algún momento, no lo sabemos. También, la teoría tiene decenas de miles de alternativas aparentemente posibles que no sabemos si son reales, si corresponden a miles de posibles universos distintos, o si sólo hay una realmente posible.

Con respecto a la teoría de supercuerdas, los físicos suponen (aunque todavía no lo puedan demostrar) que el universo decadimensional original era inestable y pasó por efecto túnel a un universo de cuatro y otro de seis dimensiones. Así pues, el universo original estaba en un estado de falso vacío, el estado de máxima simetría, mientras que hoy estamos en el estado roto del verdadero vacío.

Hablamos de Branas, de universos paralelos y … de ¡cuerdas!

Algunas de estas versiones predicen la existencia de 496 fuerzones, partículas como el fotón, que transmiten la fuerza entre 16 diferentes tipos de carga como la carga eléctrica. Afirmaciones como éstas, no comprobables por la imposibilidad de hacer experimentos, plagan la teoría de cuerdas. Quienes alguna vez intentaron trabajar matemáticamente en las cuerdas, muchas veces deben haber pensado de que lo que estaban calculando más se asemejaba a juegos de ejercicios que la consecución de una base matemática teórica tras objetivo de dar un paso trascendental en el conocimiento de la naturaleza. Ahora, los que tienen puesta su fe en ella suelen afirmar que se trata de una teoría que se desfasó de la natural evolución de la física, que su hallazgo fue un accidente, y no existe aún el desarrollo matemático para formularla adecuadamente.

En las teorías de cuerdas, lo que anteriormente se consideraba partículas, se describe ahora como ondas viajando por las cuerdas, como las notas musicales que emiten las cuerdas vibrantes de un violín. La emisión o absorción de una partícula por otra corresponde a la división o reunión de cuerdas.

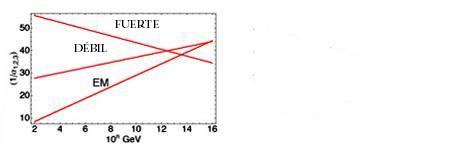

“Al principio se vio como un gran éxito, pero pronto esta “reunificación”, no tan exacta, empezó a dar fallos entre los físicos que trabajaban en las “grandes teorías unificadas”. Como puede verse en la gráfica que representa las intensidades de las fuerzas básicas respecto a la energía expresada en GeV (en la figura se representa en el eje horizontal los exponentes de las potencias de diez), las gráficas no llegan a coincidir en un punto como era de esperar aunque la “tendencia” si se apreciaba unificadora.”

La Teoría de cuerdas trata de incorparar la Gravedad a las otras tres fuerzas y completar asíel panorama actual de la Física de Partículas en el Modelo Estándar en el que sólo están incluídas estas tres interacciones de arriba, la Gravedad queda fuera por surgir infinitos no renormalizables que, desaparecen en la Teoría de supercuerdas de 26 dimensdiones de espacio tiempo para los Bosones y de 10 y 11 dimensiones de espacio tiempo para los Ferniones.

El trabajo que aquí hemos leido lo he obtenido de fuentes diversas y, como tantos otros, nos dice más o menos lo que todos. La realidad de la Teoría de supercuerdas está en que no podemos llegar a ese límite necesario de los 10-35 m, donde supuestamente, está instalada la cuerda, y, como llegar a esa distancia nos exige una energía de 1019 GeV con la que no podemos ni soñar. Seguirán, por mucho tiempo, las especulaciones y cada cual, tendrá su idea, su propia teoría, toda vez que, ninguna de ellas podrá ser verificadas y mientras eso sea así (que lo es), todas las teorías tendrán la posibilidad de ser refrendadas…algún día.

- ¿Dónde estarán las respuestas?

Sin embargo, una cosa es cierta, es la única teoría, la de supercuerdas, que nos da cierta garantía de que vamos por el buen camino, en su desarrollo aparecen indicios confirmados por los experimentos, como por ejemplo, la aparici´çon de una partícula de espín 2, el Gravitón que nos lleva a pensar que, en la teoría de supercuerdas está integrada una teoría Cuántica de la Gravedad que nos, podrá llevar, hasta esos primeros momentos del Big Bang que ahora quedan tan oscuros a la vista de los observadores y, de la misma manera, nos dejará entrar en la Singularidad de un Agujero Negro para poder ver (al fin) lo que allí pueda haber, qué clase de partículas o de materia se ha podido formar en un material tan extremadamente denso como el de la singularidad.

Habrá que tener paciencia con la Teoría de cuerdas y con el hallazgo tan esperado del Gravitón que nos confirmará, al fín, que la Gravedad como las demás interacciones, también está cuantizada y tiene su Bosón transmisor. De lo que no acabo de estar seguro es…del hecho en sí, de que podamos univer la Gravedad con la cuántica…¡son tan dispares! y habitan en reinos tan diferentes.

emilio silvera

Jun

20

Objetos, moléculas, agregados, sustancias…Materia… Y,...

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¡Tenemos que saber! ~

Clasificado en ¡Tenemos que saber! ~

Comments (0)

Comments (0)

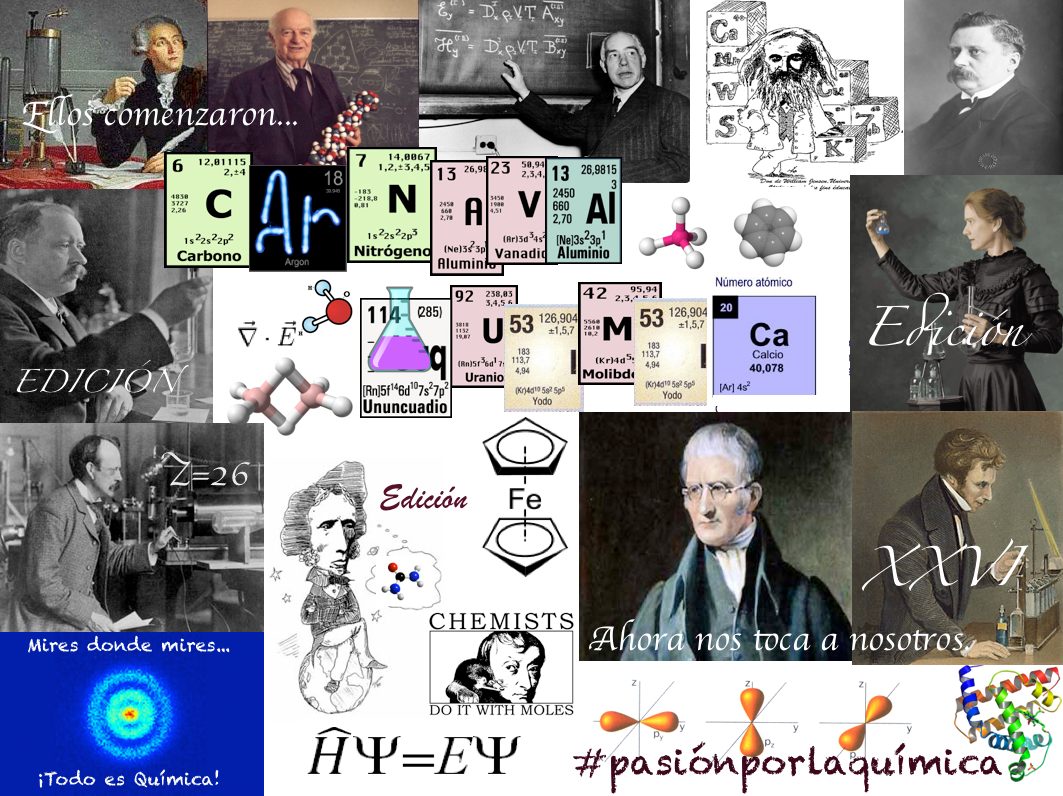

En los organismos se encuentran cuatro tipos diferentes de moléculas orgánicas en gran cantidad: carbohidratos, lípidos, proteínas y nucleótidos. Todas estas moléculas contienen carbono, hidrógeno y oxígeno. Además, las proteínas contienen nitrógeno y azufre, y los nucleótidos, así como algunos lípidos, contienen nitrógeno y fósforo. Se ha dicho que es suficiente reconocer cerca de 30 moléculas para tener un conocimiento que permita trabajar con la bioquímica de las células. Dos de esas moléculas son los azúcares glucosa y ribosa; otra, un lípido; otras veinte, los aminoácidos biológicamente importantes; y cinco las bases nitrogenadas, moléculas que contienen nitrógeno y son constituyentes claves de los nucleótidos. En esencia, la química de los organismos vivos es la química de los compuestos que contienen carbono o sea, los compuestos orgánicos.

Modelos de esferas y varillas y fórmulas estructurales del metano, etano y butano.

Las propiedades químicas específicas de una molécula orgánica derivan principalmente de los grupos de átomos conocidos como grupos funcionales. Estos grupos están unidos al esqueleto de carbono, reemplazando a uno o más de los hidrógenos que estarían presentes en un hidrocarburo.

La enorme variedad de formas, colores, comportamientos, etc que acompaña a los objetos, incluidos los vivientes, sería una consecuencia de la riqueza en la información que soportan las moléculas (y sus agregados) que forman parte de dichos objetos. Ello explicaría que las moléculas de la vida sean en general de grandes dimensiones (macromoléculas). La inmensa mayoría de ellas contiene carbono. Debido a su tetravalencia y a la gran capacidad que posee dicho átomo para unirse consigo mismo, dichas moléculas pueden considerarse como un esqueleto formado por cadenas de esos átomos.

Podemos encontrar numerosos tipos de silicio, ácido silícico, ortosilícico, dióxido de silicio, silicio coloidal, silanol, etc.

El carbono no es el único átomo con capacidad para formar los citados esqueletos. Próximos al carbono en la tabla periódica, el silicio, fósforo y boro comparten con dicho átomo esa característica, si bien en un grado mucho menor. Refiriéndonos al silicio, que para nosotros es el más importante, señalaremos que las “moléculas” que dicho átomo forma con el oxígeno y otros átomos, generalmente metálicos poseyendo gran nivel de información, difieren en varios aspectos de las moléculas orgánicas, es decir, de las que poseen un esqueleto de átomos de carbono.

El mundo de los silicatos es de una gran diversidad, existiendo centenares de especies minerológicas. Esas diferencias se refieren fundamentalmente a que el enlace químico en el caso de las moléculas orgánicas es covalente, y cuando se forma la sustancia correspondiente (cuatrillones de moléculas) o es un líquido, como es el caso de los aceites, o bien un sólido que funde fácilmente. Entre las moléculas que lo forman se ejercen unas fuerzas, llamadas de Van der Waals, que pueden considerarse como residuales de las fuerzas electromagnéticas, algo más débiles que éstas. En cambio, en los silicatos sólidos (como en el caso del topacio) el enlace covalente o iónico no se limita a una molécula, sino que se extiende en el espacio ocupado por el sólido, resultando un entramado particularmente fuerte.

Al igual que para los cristales de hielo, en la mayoría de los silicatos la información que soportan es pequeña, aunque conviene matizar este punto. Para un cristal ideal así sería en efecto, pero ocurre que en la realidad el cristal ideal es una abstracción, ya que en el cristal real existen aquí y allá los llamados defectos puntuales que trastocan la periodicidad espacial propia de las redes ideales. Precisamente esos defectos puntuales podían proporcionar una mayor información.

Si prescindimos de las orgánicas, el resto de las moléculas que resultan de la combinación entre los diferentes átomos no llega a 100.000, frente a los varios millones de las primeras. Resulta ranozable suponer que toda la enorme variedad de moléculas existentes, principalmente en los planetas rocosos, se haya formado por evolución de los átomos, como corresponde a un proceso evolutivo. La molécula poseería mayor orden que los átomos de donde procede, esto es, menor entropía. En su formación, el ambiente se habría desordenado al ganar entropía en una cierta cantidad tal, que arrojarse un balance total positivo.

No puedo dejar pasar la oportunidad, aunque sea de pasada, de mencionar las sustancias.

Las sustancias pueden ser simples y compuestas, según que la molécula correspondiente tenga átomos iguales o diferentes. El de las primeras es enormemente inferior al de las segundas.

Las así llamadas, son cuerpos formados por moléculas idénticas, entre las cuales pueden o no existir enlaces químicos. Veremos varios ejemplos. Las sustancias como el oxígeno, cloro, metano, amoníaco, etc, se presentan en estado gaseoso en condiciones ordinarias de presión y temperatura. Para su confinamiento se embotellan, aunque existen casos en que se encuentran mezcladas en el aire (os podéis dar una vueltecita por el polo químico de Huelva).

En cualquier caso, un gas como los citados consiste en un enjambre de las moléculas correspondientes. Entre ellas no se ejercen fuerzas, salvo cuando colisionan, lo que hacen con una frecuencia que depende de la concentración, es decir, del número de ellas que están concentradas en la unidad de volumen; número que podemos calcular conociendo la presión y temperatura de la masa de gas confinada en un volumen conocido.

¿Y la teoría cinética molecular?

Decía que no existen fuerzas entre las moléculas de un gas. En realidad es más exacto que el valor de esas fuerzas es insignificante porque las fuerzas residuales de las electromagnéticas, a las que antes me referí, disminuyen más rápidamente con la distancia que las fuerzas de Coulomb; y esta distancia es ordinariamente de varios diámetros moleculares.

Podemos conseguir que la intensidad de esas fuerzas aumente tratando de disminuir la distancia media entre las moléculas. Esto se puede lograr haciendo descender la temperatura, aumentando la presión o ambas cosas. Alcanzada una determinada temperatura, las moléculas comienzan a sentir las fuerzas de Van der Waals y aparece el estado líquido; si se sigue enfriando aparece el sólido. El orden crece desde el gas al líquido, siendo el sólido el más ordenado. Se trata de una red tridimensional en la que los nudos o vértices del entramado están ocupados por moléculas.

Todas las sustancias conocidas pueden presentarse en cualquiera de los tres estados de la materia (estados ordinarios y cotidianos en nuestras vidas del día a día).

Si las temperaturas reinantes, como decíamos en páginas anteriores, es de miles de millones de grados, el estado de la materia es el plasma, el material más común del universo, el de las estrellas (aparte de la materia oscura, que no sabemos ni lo que es, ni donde está, ni que “estado” es el suyo).

En condiciones ordinarias de presión, la temperatura por debajo de la cual existe el líquido y/o sólido depende del tipo de sustancia. Se denomina temperatura de ebullición o fusión la que corresponde a los sucesivos equilibrios (a presión dada) de fases: vapor ↔ líquido ↔ sólido. Estas temperaturas son muy variadas, por ejemplo, para los gases nobles son muy bajas; también para el oxígeno (O2) e hidrógeno (H2). En cambio, la mayoría de las sustancias son sólidos en condiciones ordinarias (grasas, ceras, etc).

Las sustancias pueden ser simples y compuestas, según que la molécula correspondiente tenga átomos iguales o diferentes. El número de las primeras es enormemente inferior al de las segundas.

El concepto de molécula, como individuo físico y químico, pierde su significado en ciertas sustancias que no hemos considerado aún. Entre ellas figuran las llamadas sales, el paradigma de las cuales es la sal de cocina. Se trata de cloruro de sodio, por lo que cualquier estudiante de E.G.B. escribiría sin titubear su fórmula: Cl Na. Sin embargo, le podríamos poner en un aprieto si le preguntásemos dónde se puede encontrar aisladamente individuos moleculares que respondan a esa composición. Le podemos orientar diciéndole que en el gas Cl H o en el vapor de agua existen moléculas como individualidades. En realidad y salvo casos especiales, por ejemplo, a temperaturas elevadas, no existen moléculas aisladas de sal, sino una especie de molécula gigante que se extiende por todo el cristal. Este edificio de cristal de sal consiste en una red o entramado, como un tablero de ajedrez de tres dimensiones, en cuyos nudos o vértices se encuentran, alternativamente, las constituyentes, que no son los átomos de Cl y Na sino los iones Cl– y Na+. El primero es un átomo de Cl que ha ganado un electrón, completándose todos los orbitales de valencia; el segundo, un átomo de Na que ha perdido el electrón del orbital s.

Cuando los átomos de Cl y Na interaccionan por aproximarse suficientemente sus nubes electrónicas, existe un reajuste de cargas, porque el núcleo de Cl atrae con más fuerza los electrones que el de Na, así uno pierde un electrón que gana el otro. El resultado es que la colectividad de átomos se transforma en colectividad de iones, positivos los de Na y negativos los de Cl. Las fuerzas electromagnéticas entre esos iones determinan su ordenación en un cristal, el Cl Na. Por consiguiente, en los nudos de la red existen, de manera alternativa, iones de Na e iones de Cl, resultando una red mucho más fuerte que en el caso de que las fuerzas actuantes fueran de Van der Waals. Por ello, las sales poseen puntos de fusión elevados en relación con los de las redes moleculares.

Hablando de átomos y moléculas estamos hablando de ese “universo” de lo muy pequeño”, ese lugar que estando en nuestro “mundo” parece que está en otro, toda vez que, su infinitesimales medidas, no hacen posible que el ojo lo pueda contemplar a simple vista y, para saber que están ahí, nos valemos de experimentos de altas energías en aceleradores de partículas.

El mundo de lo muy pequeño (el micro espacio), a nivel atómico y subatómico, es el dominio de la física cuántica, así nunca podríamos saber, de acuerdo m con el principio de incertidumbre, y, en un momento determinado, la posición y el estado de una partícula. Este estado podría ser una función de la escala espacio-temporal. A esta escala tamaños todo sucede demasiado deprisa para nosotros.

El “universo cuántico” nada es lo que parece a primera vista, allí entramos en otro mundo que en nada, se parece al nuestro

Cuando hablamos de la mecánica cuántica, tenemos mirar un poco hacia atrás en el tiempo y podremos darnos del gran impacto que tuvo en el devenir del mundo desde que, en nuestras vidas, apareció el átomo y, más tarde, sus contenidos. Los nombres de Planck, Einstein, Bohr, Heisenberg, Schrödinger, Pauli, Bardeen, Roentgen, Dirac y muchos otros, se pudieron a la cabeza de la lista de las personas más famosas. Aquel primer premio Nobel de Física otorgado en 1900 a Roentgen por descubrir los rayos X, en el mismo año llegaría el ¡cuanto! De Planck que inspiró a Einstein para su trabajo sobre el Efecto fotoeléctrico que también, le valdría el Nobel, y, a partir de ese momento, se desencadenó una especie de alucinante por saber sobre el átomo, sus contenidos, y, de qué estaba hecha la materia.

La conocida como Paradoja EPR y los conceptos de Tiempo y , presente, pasado y futuro

Fueron muchas las polémicas desatadas a cuenta de las aparentes incongruencias de la moderna Mecánica Cuántica. La paradoja de Einstein-Podolsky-Rosen, denominada “Paradoja EPR”, trata de un experimento mental propuesto por Albert Einstein, Boris Podolsky y Nathan Rosen en 1935. Es relevante, pues pone de manifiesto un problema aparente de la mecánica cuántica, y en las décadas siguientes se dedicaron múltiples esfuerzos a desarrollarla y resolverla.

A Einstein (y a muchos otros científicos), la idea del entrelazamiento cuántico le resultaba extremadamente perturbadora. Esta particular característica de la mecánica cuántica permite preparar estados de dos o más partículas en los cuales es imposible obtener útil sobre el estado total del sistema haciendo sólo mediciones sobre una de las partículas.

Por otro lado, en un entrelazado, manipulando una de las partículas, se puede modificar el estado total. Es decir, operando sobre una de las partículas se puede modificar el estado de la otra a distancia de manera instantánea. Esto habla de una correlación entre las dos partículas que no tiene paralaje en el mundo de nuestras experiencias cotidianas. Cabe enfatizar pues que cuando se mide el estado de una partícula, enseguida sabemos el estado de la otra, lo cual aparentemente es instantáneo, es decir, sin importar las distancias a las que se encuentren las partículas, una de la otra, ambas saben instantáneamente el estado de la otra.

El experimento planteado por EPR consiste en dos partículas que interactuaron en el pasado y que quedan en un estado entrelazado. Dos observadores reciben cada una de las partículas. Si un observador mide el momento de una de ellas, sabe cuál es el momento de la otra. Si mide la posición, gracias al entrelazamiento cuántico y al principio de incertidumbre, puede la posición de la otra partícula de forma instantánea, lo que contradice el sentido común.

Animación que muestra dos átomos de oxígeno fusionándose para formar una molécula de O2 en su estado cuántico fundamental. Las nubes de color representan los orbitales atómicos. Los orbitales 2s y 2p de cada átomo se combinan para formar los orbitales σ y π de la molécula, que la mantienen unida. Los orbitales 1s, más interiores, no se combinan y permiten distinguir a cada núcleo. Lo que ocurre a escalas tan pequeñas es fascienante.

Si nos pudiéramos convertir en electrones, por ejemplo, sabríamos dónde y cómo estamos en cada momento y podríamos ver asombrados, todo lo que estaba ocurriendo a nuestro alrededor que, entonces sí, veríamos transcurrir a un ritmo más lento del que podemos detectar en los electrones desde nuestro macroestado espacio temporal. El electrón, bajo nuestro punto de vista se mueve alrededor del núcleo atómico a una velocidad de 7 millones de km/h.

A medida que se asciende en la escala de tamaños, hasta el tiempo se va ajustando a esta escala, los objetos, a medida que se hacen mayores se mueven más despacio y, además, tienen más duración que los pequeños objetos infinitesimales del micro mundo cuántico. La vida media de un neutron es de unos 15 minutos, por ejemplo, mientras que la vida media de una estrellas se puede contar en miles de millones de años.

En nuestra macroescala, los acontecimientos y ,los objetos se mueven a velocidades que a nosotros nos parecen normales. Si se mueven con demasiada lentitud nos parece que no se mueven. Así hablamos de escala de tiempo geológico, para referirnos al tiempo y velocidad de la mayor parte de los acontecimientos geológicos que afectan a la Tierra, el tiempo transcurre aquí en millones de años y nosotros ni lo apreciamos; nos parece que todo está inmóvil. Nosotros, los humanos, funcionamos en la escala de años (tiempo biológico).

El Tiempo Cosmológico es aún mucho más dilatado y los objetos cósmicos (mundos, estrellas y galaxias), tienen una mayor duración aunque su movimiento puede ser muy rápido debido a la inmensidad del espacio universal en el que se mueven. La Tierra, por ejemplo, orbita alrededor del Sol a una velocidad media de 30 Km/s., y, el Sol, se desplaza por la Galaxia a una velocidad de 270 km/s. Y, además, se puede incrementar el tiempo y el espacio en su andadura al estar inmersos y ligados en una misma maya elñástica.

Así, el espacio dentro de un átomo, es muy pequeño; dentro de una célula, es algo mayor; dentro de un animal, mayor aún y así sucesivamente… hasta llegar a los enormes espaciosa que separan las estrellas y las galaxias en el Universo.

Distancias astronómicas separan a las estrellas entre sí, a las galaxias dentro del cúmulo, y a los cúmulos en los supercúmulos. Ladistancia a una

Las distancias que separan a los objetos del Cosmos se tienen que medir con unidades espaciales, tal es su inmensa magnitud que, nuestras mentes, aunque podamos hablar de ellas de manera cotidiana, en realidad, no han llegado a asimilarlas.Y, a todo ésto, los físicos han intentado con denuedo elaborar una teoría completa de la gravedad que incluya la mecánica cuántica. Los cálculos de la mayoría de las teorías propuesta de la «gravedad cuántica» arrojan numerosos infinitos. Los físicos no están seguros si el problema es técnico o conceptual. No obstante, incluso prescindiendo de una teoría completa de gravedad cuántica, se puede deducir que los efectos de la teoría cuántica, habrían cruciales durante los primeros 10-43 segundos del inicio del universo, cuando éste tenía una densidad de 1093 gramos por centímetro cúbico y mayor.

(El plomo sólido tiene una densidad de aproximadamente diez gramos por centímetro cúbico.) Este período, que es el que corresponde a la era de Planck, y a su estudio se le llama cosmología cuántica. Como el universo en su totalidad habría estado sujeto a grandes incertidumbres y fluctuaciones durante la era de Planck o era cuántica, con la materia y la energía apareciendo y desapareciendo de un vacío en grandes cantidades, el concepto de un principio del universo podría no tener un significado bien definido. En todo caso, la densidad del universo durante este período es de tal magnitud que escapa a nuestra comprensión. Para propósitos prácticos, la era cuántica podría considerarse el estado inicial, o principio, del universo. En consecuencia, los procesos cuánticos ocurridos durante este período, cualquiera sea su naturaleza, determinaron las iniciales del universo.

Una cosa nos ha podido quedar clara: Los científicos para lograr conocer la estructura del universo a su escala más grande, deben retroceder en el tiempo, centrando sus teorías en el momento en que todo comenzó. Para ello, como todos sabeis, se han formulado distintas teorías unificadoras de las cuatro fuerzas de la naturaleza, con las cuales se han modelado acontecimiento y en el universo primitivo casi a todo lo largo del camino hasta el principio. Pero cómo se supone que debió haber habido un «antes», aparece una barrera que impide ir más allá de una frontera que se halla fijada a los 10-43 [s] después del Big Bang, un instante conocido como «momento de Planck», en homenaje al físico alemán Max Planck.

Esta barrera existe debido a que antes del momento de Planck, durante el período llamado la «era de Planck o cuántica», se supone que las cuatro fuerza fundamentales conocidas de la naturaleza eran indistinguibles o se hallaban unificadas , que era una sola fuerza. Aunque los físicos han diseñado teorías cuánticas que unen tres de las fuerzas, una por una, a través de eras que se remontan al momento de Planck, hasta ahora les ha prácticamente imposible armonizar las leyes de la teoría cuántica con la gravedad de la relatividad de Einstein, en un sólo modelo teórico ampliamente convincente y con posibilidades claras de ser contrastado en experimentos de laboratorio y, mucho menos, con observaciones.

Y después de todo ésto, sólo una caso me queda clara: ¡Lo poco que sabemos! A pesar de la mucha imaginación que ponemos en las cosas que creemos conocer.

emilio silvera

Totales: 72.351.624

Totales: 72.351.624 Conectados: 39

Conectados: 39