Feb

26

¿Qués es la luz? hace 340 años que supimos de su velocidad

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

En estos lugares se vivía a base de antorchas y velas para alumbrar los lóbregos pasillos

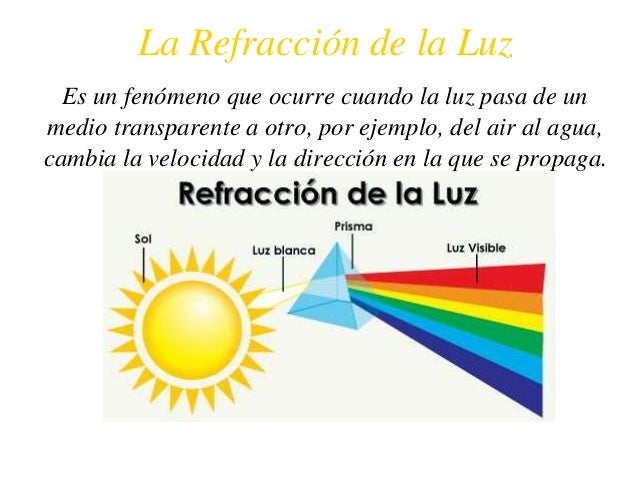

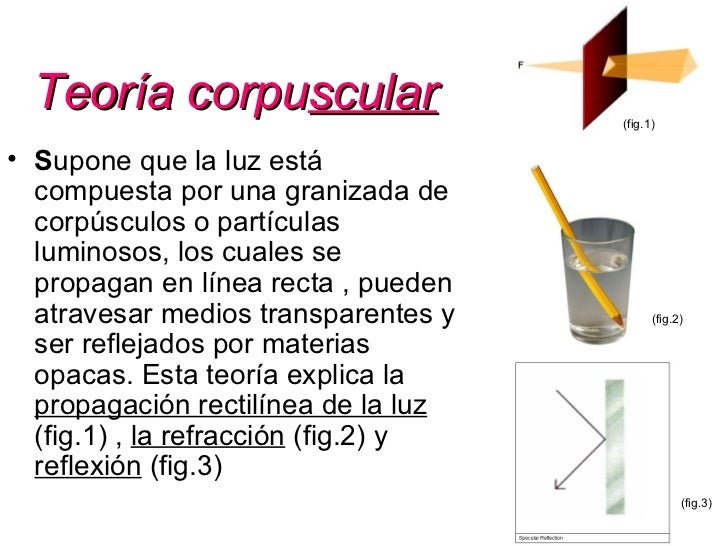

Está claro que, los estudiosos de la época antigua y medieval estaban por completo a oscuras acerca de la naturaleza de la luz. Especulaban sobre que consistía en partículas emitidas por objetos relucientes o tal vez por el mismo ojo. Establecieron el hecho de que la luz viajaba en línea recta, que se reflejaba en un espejo con un ángulo igual a aquel con el que el rayo choca con el espejo, y que un rayo de luz se inclina (se refracta) cuando pasa del aire al cristal, al agua o a cualquier otra sustancia transparente.

Cuando la luz entra en un cristal, o en alguna sustancia transparente, de una forma oblicua (es decir, en un ángulo respecto de la vertical), siempre se refracta en una dirección que forma un ángulo menor respecto de la vertical. La exacta relación entre el ángulo original y el ángulo reflejado fue elaborada por primera vez en 1.621 por el físico neerlandés Willerbrord Snell. No publicó sus hallazgos y el filósofo francés René Descartes descubrió la ley, independientemente, en 1.637.

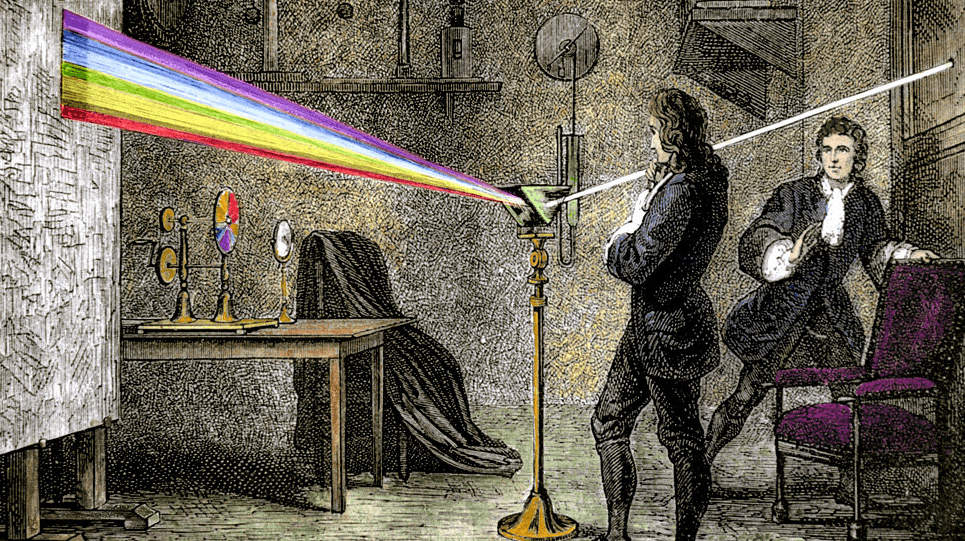

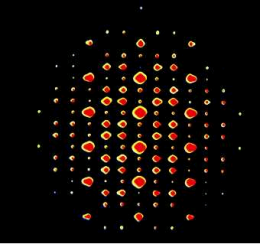

Los primeros experimentos importantes acerca de la naturaleza de la luz fueron llevados a cabo por Isaac Newton en 1.666, al permitir que un rayo de luz entrase en una habitación oscura a través de una grieta e las persianas, cayendo oblicuamente sobre una cara de un prisma de cristal triangular. El rayo se refracta cuando entra en el cristal y se refracta aún más en la misma dirección cuando sale por una segunda cara del prisma. (Las dos refracciones en la misma dirección se originan por que los dos lados del prisma de se encuentran en ángulo en vez de en forma paralela, como sería el caso en una lámina ordinaria de cristal.)

Newron y sus experimentos con la luz

Cuando Newton empezó su lucha por establecer un método inductivo correcto en física, estaba trabajando en el campo de la óptica, no en cinemática o en astronomía. En sus primeros años, mucho antes de que los Principia le dieran la fama, llevó a cabo un estudio de la luz y los colores, un estudio que ha sido descrito como “la más excelsa investigación experimental del siglo XVII

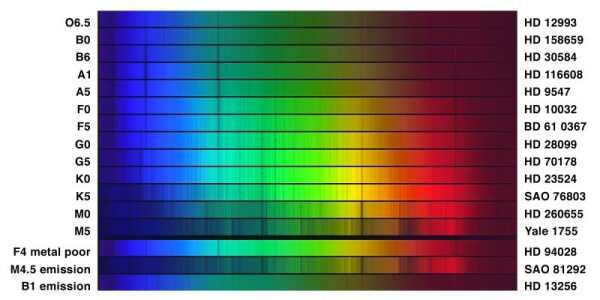

Newton atrapó el rayo emergente sobre una pantalla blanca para ver el efecto de la refracción reforzada. Descubrió que, en vez de formar una mancha de luz blanca, el rayo se extendía en una gama de colores: rojo, anaranjado, amarillo, verde, azul, y violeta, en este orden.

Newton dedujo de ello que la luz blanca corriente era una mezcla de varias luces que excitaban por separado nuestros ojos para producir las diversas sensaciones de colores. La amplia banda de sus componentes se denominó spectrum (palabra latina que significa “espectro”, “fantasma”).

Newton llegó a la conclusión de que la luz se componía de diminutas partículas (“corpúsculos”), que viajaban a enormes velocidades.

Le surgieron y se planteó algunas inquietudes cuestiones. ¿Por qué se refractaban las partículas de luz verde más que los de luz amarilla? ¿Cómo se explicaba que dos rayos de luz se cruzaran sin perturbase mutuamente, es decir, sin que se produjeran colisiones entre partículas?

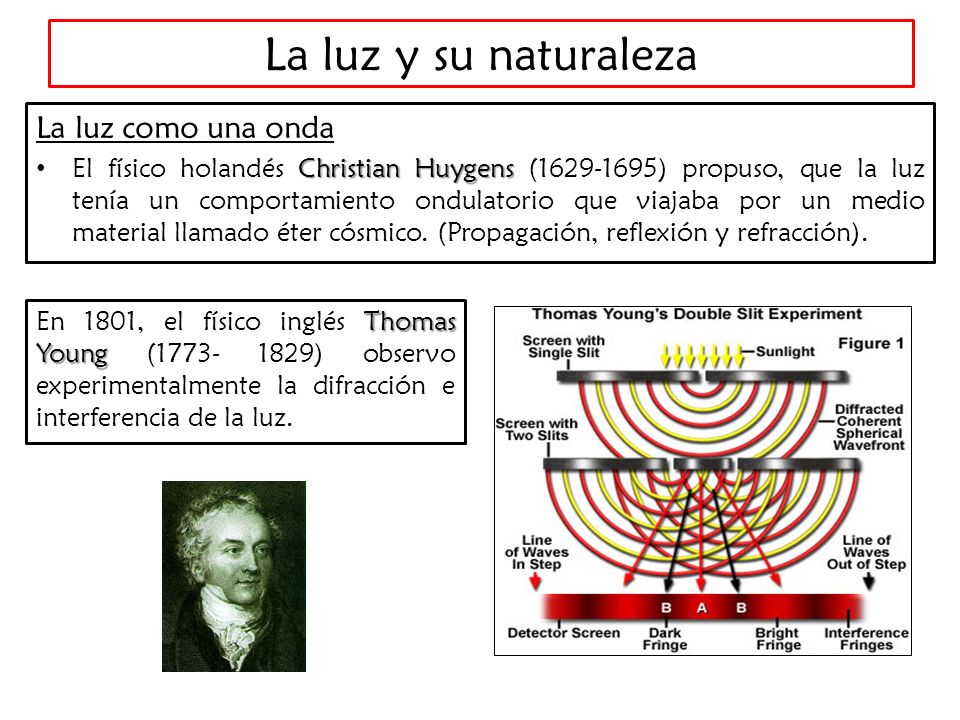

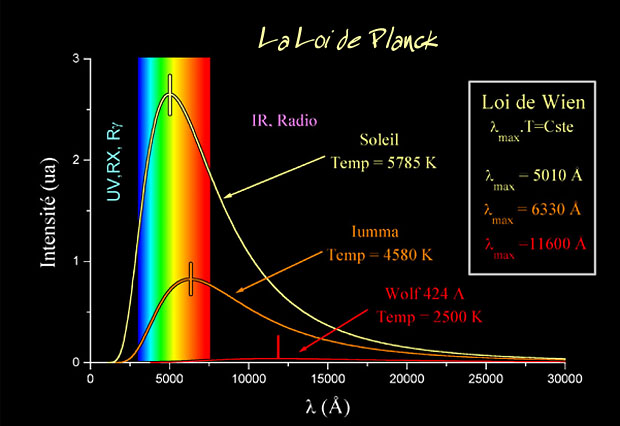

En 1.678, el físico neerlandés Christian Huyghens (un científico polifacético que había construido el primer reloj de péndulo y realizado importantes trabajos astronómicos) propuso una teoría opuesta: la de que la luz se componía de minúsculas ondas. Y si sus componentes fueran ondas, no sería difícil explicar los diversos difracciones de los diferentes tipos de luz a través de un medio refractante, siempre y cuando se aceptara que la luz se movía más despacio en ese medio refractante que en el aire. La cantidad de refracción variaría con la longitud de las ondas: cuanto más corta fuese tal longitud, tanto mayor sería la refracción. Ello significaba que la luz violeta (la más sensible a este fenómeno) debía de tener una longitud de onda mas corta que la luz azul, ésta, más corta que la verde, y así sucesivamente.

Lo que permitía al ojo distinguir los colores eran esas diferencias entre longitudes de onda. Y, como es natural, si la luz estaba integrada por ondas, dos rayos podrían cruzarse sin dificultad alguna. (Las ondas sonoras y las del agua se cruzan continuamente sin perder sus respectivas identidades.)

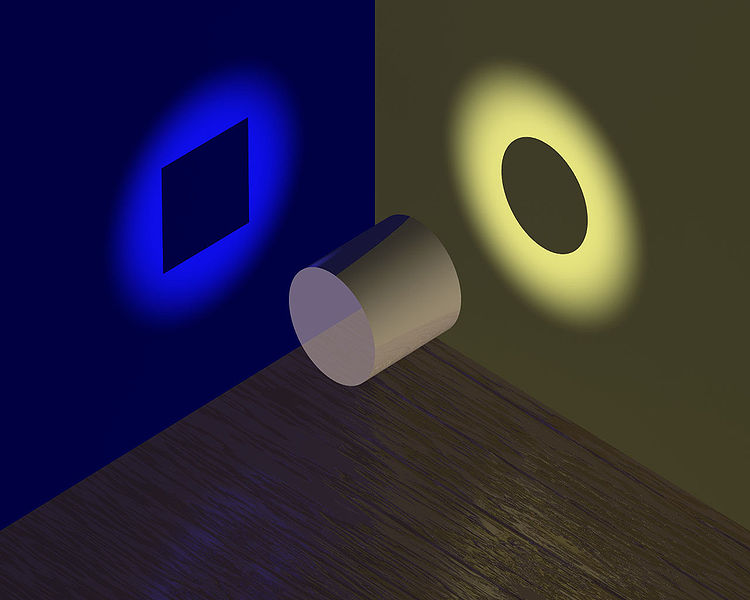

Pero la teoría de Huyqhens sobre las ondas tampoco fue muy satisfactoria. No explicaba por qué se movían en línea recta los rayos luminosos; ni por qué proyectaban sombras recortadas; ni aclaraba por qué las ondas luminosas no podían rodear los obstáculos, del mismo modo que pueden hacerlo las ondas sonoras y de agua. Por añadidura, se objetaba que si la luz consistía en ondas, ¿cómo podía viajar por el vacío, ya que cruzaba el espacio desde el Sol y las Estrellas? ¿cuál era esa mecánica ondulatoria?

Aproximadamente durante un siglo, contendieron entre sí estas teorías. La teoría corpuscular, de Newton, fue, con mucho, la más popular, en parte, porque la respaldó el famoso nombre de su autor. Pero hacia 1.801, un físico y médico ingles, de nombre Thomas Young, llevó a cabo un experimento que arrastró la opinión pública al campo opuesto. Proyectó un fino rayo luminoso sobre una pantalla, haciéndolo pasar antes por dos orificios casi juntos. Si la luz estuviera compuesta por partículas, cuando los dos rayos emergieran de ambos orificios, formarían presuntamente en la pantalla una región más luminosa donde se superpusieran, y regiones menos brillantes, donde no se diera tal superposición. Pero no fue esto lo que descubrió Young. La pantalla mostró una serie de bandas luminosas, separadas entre sí por bandas oscuras. Pareció incluso que, en esos intervalos de sombra, la luz de ambos rayos contribuía a intensificar la oscuridad.

Sería fácil explicarlo mediante la teoría ondulatoria. La banda luminosa representaba el refuerzo presado por las ondas de un rayo a las ondas del otro. Dicho de otra manera: Entraba “en fase” dos trenes de ondas, es decir, ambos nodos, al unirse, se fortalecían el uno al otro. Por otra parte, las bandas oscuras representaban puntos en que las ondas estaban “desfasadas” porque el vientre de una neutralizaba el nodo de la otra. En vez de aunar sus fuerzas, las ondas se interferían mutuamente, reduciendo la energía luminosa neta a las proximidades del punto cero.

Considerando la anchura de las bandas y la distancia entre los dos edificios por los que surgen ambos rayos, se pudo calcular la longitud de las ondas luminosas, por ejemplo, de la luz roja a la violeta o los colores intermedios. Las longitudes de onda resultaron ser muy pequeñas. Así, la de la luz roja era de unos 0’000075 cm. (Hoy se expresan las longitudes de las ondas luminosas mediante una unidad muy práctica ideada por Angströn. Esta unidad, denominada, en honor a su autor Ángstrom (Á), es la cienmillonésima parte de un centímetro. Así, pues, la longitud de onda de la luz roja equivale más o menos a 7.500 Á, y la de la luz violeta, a 3.900 Å, mientras que las de colores visibles en el espectro oscilan entre ambas cifras.)

La cortedad de estas ondas es muy importante. La razón de que las ondas luminosas se desplacen en línea recta y proyecten sombras recortadas se debe a que todas son incomparablemente más pequeñas que cualquier objeto; pueden contornear un obstáculo sólo si éste no es mucho mayor que la longitud de onda. Hasta las bacterias, por ejemplo, tienen un volumen muy superior de una onda luminosa y, por tanto, la luz puede definir claramente sus contornos bajo el microscopio. Sólo los objetos cuyas dimensiones se asemejan a la longitud de la onda luminosa (por ejemplo, los virus y otras partículas submicroscópicas) son lo suficientemente pequeños como para que puedan ser contorneados por las ondas luminosas.

Un físico francés, Augustin-Jean Fresnel, fue quien demostró por vez primera, en 1.818, que si un objeto es lo suficientemente pequeño, la onda luminosa lo contorneará sin dificultad. En tal caso, la luz determina el llamado fenómeno de “difracción”. Por ejemplo, las finísimas líneas paralelas de una “reja de disfracción” actúan como una serie de minúsculos obtáculos, que se refuerzan entre si. Puesto que la magnitud de la difracción va asociada a la longitud de onda, se produce el espectro. A la inversa, se puede calcular la longitud de onda midiendo la difracción de cualquier color o porción del espectro, así como la separación de las marcas sobre el cristal.

A través de los rayos espectrales se supo de qué estaban hechas las estrellas y los obbjetos celestes

Fraunhofer exploró dicha reja de difracción con objeto de averiguar sus finalidades prácticas, progreso que suele olvidarse, pues queda eclipsado por su descubrimiento más famoso: los rayos espectrales. El físico americano Henry Augustus Rowlane ideó la reja cóncava y desarrolló técnicas para regularlas de acuerdo con 20.000 líneas por pulgada. Ello hizo posible la sustitución del prisma por el espectroscopio.

Ante tales hallazgos experimentales, más el desarrollo metódico y matemático del movimiento ondulatorio, debido a Fresnel, pareció que la teoría ondulatoria de la luz había arraigado definitivamente, desplazando y relegando para siempre a la teoría corpuscular.

La luz tiene una naturaleza dual: se comporta como onda y partícula. Entre las propiedades de la onda luminosa se incluyen la refracción de la onda cuando …

No sólo se aceptó las existencias de ondas luminosas, sino que también se midió su longitud con una precisión cada vez mayor. Hacia 1.827, el físico francés Jacques Babinet sugirió que se empleara la longitud de onda luminosa (una cantidad física inalterable) como unidad para medir tales longitudes, en vez de las muy diversas unidades ideadas y empleadas por el hombre. Sin embargo, tal sugerencia no se llevó a la práctica hasta 1.880 cuando el físico germano-americano Albert Abraham Michelson inventó un instrumento, denominado “interferómetro”, que podía medir las longitudes de ondas luminosas con una exactitud sin precedentes. En 1.893, Michelson midió la onda de la raya roja en el espectro del cadmio y determinó que su longitud era de 1/1.553.164 m.

Pero la incertidumbre reapareció al descubrirse que los elementos estaban compuestos por isótopos diferentes, cada uno de los cuáles aportaba una raya cuya longitud de onda difería ligeramente de las restantes. En la década de 1.930 se midieron las rayas del criptón 86. Como quiera que este isótopo fuera gaseoso, se podía abordar con bajas temperaturas, para frenar el movimiento atómico y reducir el consecutivo engrosamiento de la raya.

En 1.960, el Comité Internacional de Pesos y Medidas adoptó la raya del criptón 86 como unidad fundamental de longitud. Entonces se restableció la longitud de metro como 1.650.763’73 veces la longitud de onda de dicha raya espectral. Ello aumento mil veces la precisión de las medidas de longitud. Hasta entonces se había medido el antiguo metro patrón con un margen de error equivalente a una millonésima, mientras que en lo sucesivo se pudo medir la longitud de onda con un margen de error equivalente a una milmillonésima.

Ahora, después de todo esto, sabemos algo más sobre la luz.

Pero ¿qué pasa con su velocidad?

¡Veámoslo!

Está claro que, la luz se desplaza a enormes velocidades. Si pulsamos el interruptor de apagado de la lámpara de nuestro salón, todo queda a oscuras de manera instantánea.

La velocidad del sonido es más lenta, por ejemplo, si vemos a un leñador que está cortando leña en un lugar alejado de nosotros, sólo oiremos los golpes momentos después de que caiga el hacha. Así, pues, el sonido tarda cierto tiempo en llegar a nuestros oídos. En realidad es fácil medir la velocidad de su desplazamiento: unos 1.206 km/h en el aire y a nivel del mar.

Galileo fue el primero en intentar medir la velocidad de la luz. Se colocó en lo alto de una colina, mientras que su ayudante, se situaba en otro lugar alto de la colina vecina; luego sacó una linterna encendida: tan pronto como su ayudante vió la luz, hizo una señal con otra linterna. Galileo repitió el experimento a distancias cada vez mayores, suponiendo que el tiempo requerido por su ayudante para responder mantendría una uniformidad constante, por lo cual, el intervalo entre la señal de su propia linterna y la de su ayudante representaría el tiempo empleado por la luz para recorrer cada distancia. Aunque la idea era lógica, la luz viajaba demasiado aprisa como para que Galileo pudiera percibir las sutiles diferencias con un método tan rudimentario.

Observaciones de Röemer

En 1.676, el astrónomo danés Olau Roemer logró cronometrar la velocidad de la luz a escala de distancias astronómicas. Estudiando los eclipses de Júpiter en sus cuatro grandes satélites, Roemer observó que el intervalo entre eclipses consecutivos era más largo cuando la Tierra se alejaba de Júpiter, y más corto cuado se movía en su órbita hacía dicho astro. Al parecer, la diferencia entre las duraciones del eclipse reflejaba la diferencia de distancias entre la Tierra y Júpiter. Y trataba, pues, de medir la distancia partiendo del tiempo empleado por la luz para trasladarse desde Júpiter hasta la Tierra. Calculando aproximadamente el tamaño de la órbita terrestre y observando la máxima discrepancia en las duraciones del eclipse que, según Roemer, representaba el tiempo que necesitaba la luz para atravesar el eje de al órbita terrestre, dicho astrónomo computó la velocidad de la luz. Su resultado, de 225.000 km/s., parece excelente si se considera que fue el primer intento, y resultó bastante asombroso como para provocar la incredulidad de sus coetáneos.

![[foto de la noticia] [foto de la noticia]](http://estaticos01.elmundo.es/elmundo/imagenes/2009/03/31/1238489169_extras_ladillos_3_2.jpg)

Sin embargo, medio siglo después se confirmaron los cálculos de Roemer en un campo totalmente distinto. Allá por 1.728, el astrónomo británico James Bradley descubrió que las estrellas parecían cambiar de posición con los movimientos terrestres; y no por el paralaje, sino porque la traslación terrestre alrededor del Sol era una fracción mensurable (aunque pequeña) de la velocidad de la luz. La analogía empleada usualmente es la de un hombre que camina con el paraguas abierto bajo un temporal. Aun cuando las gotas caigan verticalmente, el hombre debe inclinar hacia delante el paraguas, porque ha de abrirse paso entre las gotas.

Cuanto más acelere su paso, tanto más deberá inclinar el paraguas. De manera semejante la Tierra avanza entre los ligeros rayos que caen desde las estrellas, y el astrónomo debe inclinar un poco su telescopio y hacerlo en varias direcciones, de acuerdo con los cambios de la trayectoria terrestre (no olvidemos que nuestro planeta Tierra, es como una enorme nave espacial que nos lleva en un viaje eterno, alrededor del Sol, a la velocidad de 30 km/s. + -) Mediante ese desvío aparente de los astros (“aberración de la luz”), Bradley pudo evaluar la velocidad de la luz y calcularla con gran precisión.

Sus cálculos fueron de 285.000 km/s, bastante más exacto que los de Roemer, pero aún un 5’5% más bajos.

Poco a poco, con medios tecnológicos más sofisticados y más conocimientos matemáticos, los científicos fueron obteniendo medidas más exactas aún, conforme se fue perfeccionando la idea original de Galileo y sus sucesores.

En 1.849, el físico francés Armand-Hippolyte-Louis Fizeau ideó un artificio mediante el cual se proyectaba la luz sobre un espejo situado a 8 km de distancia, que devolvía el reflejo al observador. El tiempo empleado por la luz en su viaje de ida y vuelta no rebasó apenas la 1/20.000 de segundo, por Fizeau logró medirlo colocando una rueda dentada giratoria en la trayectoria del rayo luminoso. Cuando dicha rueda giraba a cierta velocidad, regulada, la luz pasaba entre los dientes y se proyectaba contra el siguiente, al ser devuelta por el espejo; así, Fizeau, colocado tras la rueda, no pudo verla. Entonces se dio más velocidad a la rueda, y el reflejo pasó por la siguiente muesca entre los dientes, sin intercepción alguna. De esa forma, regulando y midiendo la velocidad de la rueda giratoria, Fizeau pudo calcular el tiempo transcurrido y, por consiguiente, la velocidad a que se movía el rayo de luz.

Experimento de Focault

Cuando el espejo gira a una velocidad suficientemente elevada para que el tiempo de que tarda en dar una vuelta sea comparable al tiempo que tarda la luz en ir y volver en su recorrido, la señal luminosa se observa a una distancia fácilmente medible del orificio por el que sale el rayo luminoso.

En estas circunstancias es fácil determinar el ángulo que se ha desviado el rayo. Como se conoce la velocidad de rotación, se determina el tiempo que ha tardado el espejo en girar la mitad de ese ángulo. En este tiempo la luz ha recorrido y de esa cifra se obtiene el valor de la velocidad.

La velocidad del espejo fue de 400 revoluciones por segundo y la distancia entre el espejo giratorio y el espejo fijo era de 5 metros.

Un año más tarde, Jean Foucault (quien realizaría poco después su experimento con los péndulos) precisó más estas medidas empleando un espejo giratorio en ve de una rueda dentada. Entonces se midió el tiempo transcurrido desviando ligeramente el ángulo de reflexión mediante el veloz espejo giratorio. Foucault obtuvo un valor de la velocidad de la luz de 300.883 km/s. También, el físico francés utilizó su método para determinar la velocidad de la luz a través de varios líquidos. Averiguó que era notablemente inferior a la alcanzada en el aire. Esto concordaba también con la teoría ondulatoria de Huyghens.

Experimento Michelson-Morley Reposo con el éter luminífero Interferómetro de Michelson y Morley en reposo respecto al éter luminífero.

Michelson fue más preciso aún en sus medidas. Este autor, durante cuarenta años largos, a partir de 1.879, fue aplicando el sistema Fizeau-Foucault cada vez con mayor refinamiento, para medir la velocidad de la luz. Cuando se creyó lo suficientemente informado, proyectó la luz a través de vacío, en vez de hacerlo a través del aire, pues este frena ligeramente su velocidad, y, empleó para ello tuberías de acero cuya longitud era superior a 1’5 km. Según sus medidas, la velocidad de la luz en el vacío era de 299.730 km(seg. (sólo un 0’006% más bajo). Demostraría también que todas las longitudes de ondas luminosas viajan a la misma velocidad en el vacío.

En 1.972, un equipo de investigadores bajo la dirección de Kenneth M. Eveson efectuó unas mediciones aún más exactas y vio que la velocidad de la luz era de 299.727’74 km/seg. Una vez se conoció la velocidad de la luz con semejante precisión, se hizo posible usar la luz, o por lo menos formas de ella, para medir distancias.

Aunque para algunos resulte alto tedioso el tema anterior, no he podido resistirme a la tentación de exponerlo, así podrá saber algo más sobre la luz y, habrán conocido a personajes que hicieron posible el que ahora nosotros, la conozcamos mejor.

Las ondas de luz están presentes en el Espacio Interestelar

Podría continuar, hasta el final de este trabajo, hablando de la luz y sus distintas formas o aplicaciones: ondas de luz a través del espacio, de cómo se transmite la luz en el “vacío”, nos llega a través del espacio desde Galaxias situadas a miles de millones de años luz; las líneas de fuerzas electromagnéticas de Faraday y Maxwell de campos eléctricos y magnéticos cambiantes (todo ello explicado en un simple conjunto de cuatro ecuaciones, que describían casi todos los fenómenos referentes a esta materia electromagnética), o de los enigmas aún por descubrir (aunque predichos).

Ahora, en Física, se dice que la luz es una forma de radiación electromagnética a la que el ojo humano es sensible y sobre la cual depende nuestra consciencia visual del universo y sus contenidos.

Sí, el ojo humano puede ver todo objeto en el que incida la luz

Patrón de referencia

En el año 1983, el Bureau Internacional de Poids et Mesures resolvió modificar la definición del metro como unidad de longitud del Sistema Internacional, estableciendo su definición a partir de la velocidad de la luz

El metro como patrón en barras de platino e Iridio

En consecuencia, el mínimo reajuste arbitrario efectuado en la definición del metro, permite que la velocidad de la luz, lógicamente, tenga un valor exacto de 299 792 458 m/s cuando se expresa en metros/segundo. Esta modificación aprovecha de forma práctica una de las bases de la teoría de la relatividad de Einstein: la inmutabilidad de la velocidad de la luz en el vacío, sea cual sea el sistema de referencia utilizado para medirla, convirtiendo esta propiedad en uno de los patrones de los que se deducen otras unidades.

Aparte de todo lo que antes hemos explicado, no sería justo finalizar el trabajo sin exponer aquí que, en 1905, Albert Einstein, inspirado en el cuanto de Planck, realizó un importante avance en el conocimiento de lo que es la luz. Demostró que el Efecto fotoeléstrico sólo podía ser explicado con la hipótesis de que la luz consiste en un chorro de fotones de energía electromagnética discretos.

El conflicto entre la teoría ondulatoria y corpuscular de la luz fue resuelto con la evolución de la teoría cuántica y la mecánica ondulatoria que ha dejado claro que, los electrones y las otras partículas elementales tienen propiedades duales de partículas y onda.

sería mucho más largo, pero creo que está bien con lo dicho.

emilio silvera

Feb

24

¡El Universo! ¡Civilizaciones! ¡Los pensamientos!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Civilizaciones antiguas ~

Clasificado en Civilizaciones antiguas ~

Comments (0)

Comments (0)

Cuando decimos Universo, nos estamos refiriendo a ¡tántas cosas”. En realidad, la palabra contiene en sí misma, todo lo que existe, incluyendo el Espacio, el Tiempo y la materia en todas sus formas, bien sea “inerte” o “viva” orgánica o inorgánica y, conforme a lo que sabemos, ahí está también recogida la energía en todas las formas que pueda adoptar… Creo que, incluso los pensamientos.

Cada día aquí, comentamos sobre algún aspecto de la Física o de la Astronomía (también de la vida y de los que los seres humanos hicimos a nuestro paso por este mundo), que nos puedan llevar a comprender, algo mejor, todo lo que podemos ver que ocurre a nuestro alrededor y, en nuestro entorno espacial que, con los adelantos que hemos podido conseguir, abarca ya, inmensas regiones del Universo. Sin embargo, no debemos olvidar lo que pasó.

Las estrellas que forman las galaxias, los mundos que orbitan a las estrellas, las Nebulosas que son los semilleros de estrellas nuevas, los demás objetos que en el Universo son…, todos han necesitado tiempo para conformarse en lo que son y, con el paso del tiempo, todos se convirtieron en otros objetos distintos de lo que fueron. Nada permanece, todo se transofrma y, de alguna manera, todo muere y todo vuelve a nacer, vive y muere con el inexorable transcurrir del Tiempo.

¡EL TIEMPO!

Sí, es el tiempo el factor que juega a nuestro favor y, en nuestra contra, depende de la perspectiva con que lo miremos: A nuestro favor para conseguir nuestros logros más difíciles, para hacer posible nuestros sueños, para aprender y llegar a saber y llegar a poder responder preguntas de las que antes no teníamos ni la menor noción, para preguntar sobre alguna cosa hay que saber que ésta existe, o, puede existir. Nunca llegaremos a poder contestarlas todas y, siempre, nos quedarán preguntas que plantear y también por contestar.

Tenemos una ventaja que el Tiempo no puede eliminar, creamos Entropía negativa mediante la replicación de la especie, hacemos surgir al mundo otros seres humanos y los educamos desde pequeños para que sigan nuestros pasos y continúen con el trabajo que comenzó hace milenios. También las galaxias espirales producen Entropía negativa, en ella nacen estrellas nuevas-

Mirando por ahí, he tratado de buscar algunas cuestiones que resuman (aunque sea de manera muy escueta) algo de lo que el mundo es, de lo que hicimos y dejaron atrás aquellas civilizaciones y aquellos pensadores del pasado, y, encontré un lugar (Olcicilizacións´s Blog)desde el que os traigo lo que sigue:

Los olmecas, transmitieron sus conocimientos a los toltecas, considerados por los estudiosos como una rama de los chichimecas, y éstos más tarde a los mayas.

Civilizaciones perdidas que construyeron mundos de fantástica belleza

![]()

Seres superiores que nos dejaron sus ideas y un mundo que posibilitó la diversidad de pensamientos

detrás de cada imagen se esconden historias que nos gustaría conocer. Cuentan pasajes de hechos del pasado, o del presente y, algunas veces, también quieren significar lo que será el futuro. Desde siempre, además de por medio de la escritura, hemos querido representar los hechos, personajes y obras por medio de grandiosos templos, en pinturas más o menos sofisticadas y, sobre todo, en historias contadas por dramaturgos y poetas, y, sobre todo, por los historiadores que dejaron un reflejo de su tiempo en cada momento de nuestra Historia.

¿Quien no conoce “las historias” que se esconden detrás de éstas pinturas?

Cada Civilización quizo dejar su huella y contar su historia a… su manera

Según el Génesis: “Tenía entonces toda la tierra una sola lengua y unas mismas palabras.” En la actualidad hay unas seis mil quinientas lenguas en nuestro mundo. De ellas, solamente veinticinco pueden considerarse importantes por su extensión y por su producción escrita. La pregunta que ha preocupado siempre a pensadores y lingüistas es inmediata: ¿De dónde surgió tal diversidad? ¿Cuál fue el origen de todas las lenguas? Ya hemos hablado aquí extensamente de los orígenes de la lengua y de la escritura y, son historias apasionantes que nos llegan del pasado.

Siempre hemos tenido imaginación y, los mitos antiguos proliferan en todas aquellas civilizaciones. Entre los antiguos mitos budistas figura el de un misterioso paraíso perdido, conocido como Chang Shambhala, que se considera la fuente de la sabiduría eterna y donde vivirían seres inmortales en armonía perfecta con la naturaleza y el universo. En la India, oculto entre los Himalayas, se le llama Kalapa, mientras que la tradición china lo ubica en los montes Kunlun. Según las leyendas budistas, Kalāpa (‘atado, manojo’) es la mítica ciudad capital del reino de Shambhala(quizá algún lugar de Tíbet o de Cachemira). Allí el rey

Kulika reina sentado en un trono de leones. Se dice que Kalapa es una hermosa ciudad, con jardines de sándalo que contienen un gran mándala tridimensional de kala chakrá realizado por el rey Suchandra. Este rey vino desde el norte de Cachemira, y desarrolló la práctica del kalachakrá, que aprendió del propio Buda (siglo VI a. C.) en Dhania Kataka. La cordillera montañosa Kunlun es una de las más largas cadenas montañosas de Asia, extendiéndose a lo largo de más de 3.000 km. Corre a lo largo del borde occidental de China, hacia el Sur, al lado de la cordillera del Pamir, curvándose luego hacia el este para formar la frontera del Tíbet. Se extiende al sur de lo que se denomina actualmente la cuenca de Tarim, el famoso Takla Makan o desierto de las “casas enterradas en la arena“, y el desierto de Gobi. La cordillera tiene cerca de 200 picos de altura superior a los 6.000 metros. Los tres picos más altos son el Kongur Tagh (7.719 m), el Dingbei (7.625 m) y el famoso Mutzagata (7.546 m). Estos picos se encuentran en la cordillera Arkatag dentro del complejo de cordilleras. Hacia el sur, una rama de las montañas Kunlun da lugar a la zona de captación de las cuencas de los dos ríos más largos de China, el Yangtsé y el río Amarillo. La cordillera se formó en el lado norte de la placa India durante su colisión a finales del Triásico, con la placa Euroasiática, dando lugar al cierre del océano Paleo-Thetys. Las montañas son muy conocidas en la mitología china, y se considera que encierran el paraíso taoísta. El primero en visitar este paraíso fue, según la leyenda, el rey Mu (1001-947 a. C.) de la dinastía Zhou. Supuestamente descubrió el Palacio de Jade de Huangdi, el mítico Emperador Amarillo, y encontró a Xiwangmu, la Reina Madre del Oeste, que también tiene su mítico refugio en estas montañas.

Se cuentan algunas historias que… Hermes Trismegisto es el nombre griego de un personaje mítico que se asoció a un sincretismo del dios egipcio Dyehuty (Toth en griego) y el dios heleno Hermes, o bien al Abraham bíblico. Hermes Trismegisto significa en griego ‘Hermes, tres veces grande’. En latín es: Mercurius ter Maximus. Hermes Trismegisto es mencionado primordialmente en la literatura ocultista como el sabio egipcio, paralelo al dios Toth egipcio, que creó la alquimia y desarrolló un sistema de creencias metafísicas que hoy es conocida como hermética.

Para algunos pensadores medievales, Hermes Trismegisto fue un profeta pagano que anunció el advenimiento del cristianismo. Se le han atribuido estudios de alquimia como la Tabla de esmeralda —que fue traducida del latín al inglés por Isaac Newton— y de filosofía, como el Corpus hermeticum. No obstante, debido a la carencia de evidencias contundentes sobre su existencia, el personaje histórico se ha ido construyendo ficticiamente desde la Edad Media hasta la actualidad, sobre todo a partir del resurgimiento del esoterismo. Fueron los griegos quienes bautizaron como Hermes Trismegisto al dios Toth egipcio, el responsable del conocimiento; aquel que, según la tradición, explicó a los habitantes del Nilo que su país era una suerte de eco de las maravillas que contemplaban en su negra bóveda celeste. De hecho, una de las teorías más populares para explicar la orientación de las pirámides es que éstas imitaban, como las catedrales harían más tarde, la situación de ciertas estrellas del firmamento nocturno. Pero no la de unas estrellas cualesquiera, sino aquellas llamadas por sus milenarios textos religiosos El Duat. Bajo ese nombre se conoció en Egipto a los tres astros que integran el cinturón de Orión -nosotros las llamamos «las tres Marías»-. Los egipcios creían que eran la puerta simbólica por la que el faraón accedía a los reinos del más allá. Las pirámides, por tanto, fueron «modelos» en piedra de esa entrada; lugares de iniciación en los que el gobernante de Egipto se preparaba para el viaje más importante de su existencia: el de su muerte.

Y, hablandio de la muerta, los humanos siempre hemos tenido mucha imaginación para ese trance final de nuestras vidas y, se han dicho muchas cosas y se han contado muchas versiones.

¿Qué es la muerte? Quizá la analogía más común sea la comparación entre muerte y sueño. Morir, nos decimos, es como dormirse.

Esta figura del lenguaje es muy común en el pensamiento y lenguaje de cada día, así como en laliteratura de muchas culturas y épocas. Incluso era corriente en la Grecia clásica. En la Ilíada, por ejemplo, Homero llama al sueño «hermano de la muerte», y Platón, en su diálogo la Apología, pone las siguientes palabras en boca de Sócrates, su maestro, que acaba de ser sentenciado a muerte por un jurado ateniense: “Si la muerte es sólo dormirse sin sueños, debe ser un maravilloso premio. Imagino que si a alguien se le dijese que escogiera la noche en que durmió tan profundamente que ni siquiera soñó y la comparase con el resto de noches y días de su vida y que dijese entonces, tras la debida consideración, cuántos días y noches más felices había tenido, creo que… [cualquiera] se daría cuenta de que esas noches y días son fáciles de contar en comparación con el resto. Si la muerte es así, la considero ventajosa, pues todo el tiempo, si la miramos de esa forma, puede tomarse como una sola noche”.

En 1964, una revista de estudios orientales había publicado un artículo que trataba de una relación entre la Gran Pirámide y el Cinturón de Orión. Un egiptólogo llamado Alexander Badawy había pedido a la astrónoma norteamericana Virginia Trimble, que le ayudase a verificar su teoría de que el «pozo de ventilación» meridional de la Cámara del Rey señalaba directamente a Orión cuando se construyó la Gran Pirámide, hacia el 2550 a. de C. Virginia Trimble, basada en sus cálculo, pudo decir a Badawy que, en

efecto, el pozo de ventilación señalaba directamente al Cinturón de Orión hacia el 2550 a. de C. Una persona lo bastante delgada como para acostarse en el pozo de ventilación hubiera visto cómo el cinturón de Orión pasaba directamente por encima de ella todas las noches. Por supuesto, pasarían otras estrellas, cientos de ellas… pero ninguna de semejante magnitud. Si las pirámides de Gizeh representaban las tres estrellas del Cinturón de Orión -Zeta, Epsilón y Delta-, ¿no era posible que otras pirámides representasen a otras estrellas de Orión? De hecho, Robert Bauval se dio cuenta de que la pirámide de Nebka, en Abu Ruwash, correspondía a la estrella situada en el pie izquierdo del Cazador; y la pirámide de Zawyat al-Aryan a la estrella que estaba en su hombro derecho. Desde luego, si otras dos pirámides hubieran completado la forma de «reloj de arena», la prueba hubiese sido concluyente, pero, por desgracia, estas dos pirámides o bien nunca se habían construido o hacía ya mucho tiempo que habían desaparecido bajo la arena.

Con la originalidad de su cultura, el Antiguo Egipto ha generado una gran fascinación. Los poderes de los hierofantes o magos, las profecías, la ciencia de los sacerdotes y la aspiración a la vida eterna, junto con la conservación de las momias, las increíbles construcciones sagradas y la extraordinaria validez actual de algunos papiros milenarios, nos han maravillado a lo largo de la historia.

Jean-Franςois Champollion

Pero ¿qué es lo que le sucede al viajero cuando llega a Egipto? Sin dudas, un gran encandilamiento. El gusto por la aventura incrementa la imaginación de quien sabe abstraerse frente a lo majestuoso y lo secreto, conceptos estrechamente ligados a la cultura faraónica. En el período de la conquista árabe, las leyendas comenzaron a expandir teorías en un intento por correr el velo de misterio y significación inexplicable. Las descomunales pirámides, de proporciones matemáticas rigurosas, habrían sido concebidas con el fin de preservar esa sabiduría de los antiguos, manteniendo oculto el saber milenario. ¿Qué secretos esconden estos monumentos que dominan simbólicamente el Valle del Nilo desde hace 4500 años? Mucho más de lo imaginado. Pese al desconocimiento sobre el tema, los eruditos trataron de plasmar en manuales las formas de acceso al interior de las pirámides, regidos muchas veces por una marcada ambición de llegar a los lugares que creían repletos de riquezas y tesoros incalculables. Tal como dijo Napoleón: «¡Soldados! Desde lo alto de estas pirámides, cuarenta siglos os contemplan».

Los Tuareg, la legendaria reina attlante Tin Hionan, Tassili y la antigua civilización Uigur

Las leyendas parten de hechos reales sucedidos mucho tiempo atrás, mientras que los mitos hablan de realidades simbólicas. Es decir transmiten verdades con el lenguaje de los sueños. La historia de la Atlántida contiene leyenda y también es mítica. España es considerada dentro de la leyenda Atlante como parte directa del imperio desaparecido, con la antigua Tartessos, o bien como colonia comandada por atlantes de nombre íberos, que acabaron dando nombre a la península. Y el único país de Europa, junto con Portugal, que conservan parte del continente desaparecido: islas Canarias y Azores. En África, en 1926, el conde Byron Kûhn de Protok descubrió en sus excavaciones arqueológicas en el Sahara, lo que los tuareg llamaban la tumba de la última reina de los Atlantes Tin Hinan. En el Museo del El Bardo, en Argel, se exhibe un esqueleto de dos metros de altura. Se dice que fue una princesa huida de la Atlántida. Juan José Benítez, en algunas de cuyas obras me he basado para escribir este artículo, explica lo siguiente: “… en mi primera visita a Argel me apresuré a recorrer el museo del El Bardo, en su búsqueda. Allí estaba, casi olvidada en un rincón. La examiné con detenimiento y admiración recordando las leyendas que circulan sobre ella. Los informes de los forenses tenían razón. Aquella mujer pudo alcanzar los dos metros de altura. Era Tin-Hinan, princesa de los tuaregs y de la etnia bereber. La única mujer conocida que gobernó al levantisco pueblo del desierto. ¿O no se trataba de una mujer?”

Salomón es un personaje descrito en la Biblia como el tercer y último rey del Israel unificado (incluyendo el reino de Judá). Es célebre por su sabiduría, riqueza y poder, pues La Biblia’ ‘lo considera el hombre más sabio que existió en la Tierra. Logró reinar cuarenta años y su reinado quedaría situado entre los años 970 a.C. y el 930 a.C. aproximadamente. Construyó el Templo de Jerusalén, y se le atribuye la autoría del Libro de Eclesiastés, libro de los Proverbios y Cantar de los Cantares, todos estos libros recogidos en la Biblia. Es elprotagonista de muchas leyendas posteriores, como que fue uno de los maestros de la Cábala.

En el Tanaj (libro hebreo, a una versión del cual los cristianos llaman Antiguo Testamento) también se le llama Jedidías. En la Biblia se dice del rey Salomón que heredó un considerable imperio conquistado por su padre el rey David, que se extendía desde el Valle Torrencial, en la frontera con Egipto, hasta el río Éufrates, en Mesopotamia. Tenía una gran riqueza y sabiduría y administró su reino a través de un sistema de 12 distritos. Poseyó un gran harén, el cual incluía a «la hija del faraón». Honró a otros dioses en su vejez y consagró su reinado a grandes proyectos de construcción. La Biblia dice del rey Salomón que era «el más sabio de los hombres», que podía pronunciar un discurso sobre la biodiversidad de todas las plantas, «desde los cedros del Líbano hasta el hisopo que crece en los muros, y animales, y pájaros, y cosas que se arrastran, y peces». Entre los distintos autores que han tratado sobre Salomón y el Arca de la Alianza, se distingue Erich von Daniken, que lo relata, con su estilo atrevido, en su obra “Profeta del Pasado”, en la que me he basado para escribir este artículo.

Algunos lo explican en términos de las inundaciones anuales de la llanura Tigris-Eufrates. Conjeturan que una de tales inundaciones pudo ser especialmente severa. Campos y ciudades, hombres y animales fueron barridos por la crecida de las aguas, y los pueblos primitivos, viendo el acontecimiento como un castigo de los dioses, propagaron la leyenda del Diluvio. Sir Leonard Woolley (Londres, 1880 – 1960) fue un arqueólogo británico, conocido por sus excavacionesen la antigua ciudad sumeria de Ur (en el actual Irak) y por haber encontrado evidencia geológica del diluvio de Gilgamesh.

La historia del Diluvio es conocida por muchas culturas

Se le considera el primer arqueólogo moderno, y fue nombrado caballero en 1935 por sus contribuciones a la disciplina. Graduado de la Universidad de Oxford, tras trabajar tres años en el Museo Ashmolean de la misma ciudad, viajó al actual Sudán para participar en 1907 y 1911 en la expedición arqueológica británica en el yacimiento egipcio de Wadi Halfa. En 1912 dirigió junto a T.E. Lawrence (conocido como Lawrence de Arabia) las excavaciones de la ciudad hitita de Karkemish, en la Siria septentrional, donde permaneció dos años y cuyos hallazgos publicó entre 1921 y 1953. Posteriormente pasó a Egipto para dirigir la excavación de Tell el-Amarna, la ciudad sagrada del faraón Akhenatón.

Lo cierto amigos, es que nunca nos faltó la energía necesaria para poder llevar a cabo andaduras que, miradas en la perspectiva que el tiempo nos da, nos parecen increíbles, como increíbles nos parecen aquellos pensamientos surgidos de mentes de la antigüedad, cuando aún no se tenían verdaderos conocimeintos de ninguna de las formas científicas que ahora podemos cultivar. Sin embargo, las ideas fluían, la imaginación caminaba veloz y, las mentes intuitivas de muchos pensadores, pusieron los cimientos que hicieron un buen edificio en el que ahora, confortablemente vivímos todos.

Mirar al pasado y recordar…¡es bueno!

emilio silvera

Feb

24

Sí, el Mundo avanza… ¡Cometiendo errores!

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Anécdotas de personajes de la Ciencia ~

Clasificado en Anécdotas de personajes de la Ciencia ~

Comments (2)

Comments (2)

Lo cierto es que dentro del átomo están encerradas todas las energías de los infiernos. El 6 de agosto de 1945 el mundo se pudo enterar de ello cuando, desde Hiroshima llegaron las noticias de que el hombre había desembarcado en la parte oscura de ese minúsculo objeto que llamamos átomo. Los misterios que dentro de él se esconden obsesionaron durante todo el siglo XX a los mejores físicos del mundo. Sin embargo, el “átomo” había sido durante más de dos mil años una de las más cercanas preocupaciones de los llamados “filófosos naturales”. La misma palabra venía a significar la unidad mínima de la materia que, en aquellos tiempos se suponía indestructible. Ahora, para nosotros, átomo es un término uso corriente que, sin embargo, no ha dejado de ser una amenaza y una promesa sin precedente.

Demócrito

“El Universo se compone sólo de átomos y de vacío, todo lo demás, es opinión e ilusión”

El primer filósofo atómico fue un griego legendario, Leucipo, que se cree vivió en el siglo V a. C.

Demócrito de Abdera, su discípulo, que dio al atomismo su forma clásica como filosofía, le divertían tanto las locuras de los hombres que era conocido como el “filósofo risueño”. Sin embargo, fue uno de los primeros que se opuso a la idea de la decadencia de la Humanidad a partir de una Edad de Oro mítica, y predicó siempre con el progreso. Si todo el Universo estaba compuesto solamente de átomos y vacío, no sólo no era infinitamente complejo, sino que, de un modo u otro, era inteligible, y seguramente el poder del hombre evolucionado no tendría límite.

Lo cierto es que, nuestro futuro es un libro en blanco y, lo que se pueda leer en él, aún no está escrito pero… ¿depende de nosotros?

Lucrecio (c. 95 a, C. – c. 55 a. C.) perpetuó en De rerum natura, uno de los más importantes poemas latinos, al atomismo antiguo. Con la intención de liberar al pueblo del temor a los dioses, el poeta demostró que el mundo entero estaba constituido por vacío y átomos, los cuales se movían según sus leyes propias; que el alma moría con el cuerpo y que por consiguiente no había razón para temer a la muerte o a los poderes sobrenaturales.

Lucrecio decía que comprender la Naturaleza era el único modo de hallar la paz de espíritu, y, como era de esperar, los padres de la Iglesia que pregonaban la vida eterna, atacaron sin piedad a Lucrecio y este fue ignorado y olvidado durante toda la Edad Media que, como sabéis, fue la culpable de la paralización del saber de la Humanidad. Sin embargo, Lucrecio fue, una de las figuras más influyentes del Renacimiento.

Llamamos Renacimiento al gran movimiento literio, artístico y de pensamientos, iniciado en Italia en el siglo XIV de donde se pudo esparcir por toda Europa, cambiando la vida de los ideales de la Sociedad. Su principal característica fue la veneración a la cultura griega y bajo su impulso podemos decir que florecieron las artes en el mundo literario y artístico en general.

Entre las causas que facilitaron el Renacimiento cabrían destacar:

– La riqueza de algunas ciudades Italianas, originadas por el comercio y la industria.

– Las familias enriquecidas y los Papas protegieron las artes.

– La caída de Constantinopla que obligó a los sabios bizantinos a venirse a Europa.

– Los grandes descubrimientos geográficos de españoles y portugueses.

– La difusión de Inventos: la imprenta, el papel, la tinto, la pólvora, la brújula… ¡el telescopio!

Pero no perdamos la “brújula”. Así pues, en un principio el atomismo vino al mundo como sistema filosófico. Del mismo modo que la simetría pitagórica había proporcionado un marco a Copérnico, la geometría había seducido a Kepler y el círculo perfecto aristotélico hechizo a Harvey, así los “indestructibles” átomos de los filósofos atrajeron a los físicos y a los químicos. Francis Bacon observó que “la teoría de Demócrito referida a los átomos es, si no cierta, al menos aplicable con excelentes resultados al análisis de la Naturaleza”.

Descartes (1596 – 1650) inventó su propia noción de partículas infinitamente pequeñas que se movían en un medio que llamó éter. Otro filósofo francés, Pierre Gassendi (1592 – 1655), pareció confirmar la teoría de Demócrito y presentó otra versión más del atomismo, que Robert Boyle (1627 – 1691) adaptó a la química demostrando que los “elementos clásicos –tierra, aire, fuego y agua- no eran en absoluto elementales.

Las proféticas intuiciones de un matemático jesuita, R.G. Boscovich (1711 – 1787) trazaron los caminos para una nueva ciencia, la física atómica. Su atrevido concepto de “los puntos centrales” abandonaba la antigua idea de una variedad de átomos sólidos diferentes. Las partículas fundamentales de la materia, sugería Boscovich, eran todas idénticas, y las relaciones espaciales alrededor de esos puntos centrales constituían la materia… Boscovich que había llegado a estas conclusiones a partir de sus conocimientos de matemáticas y astronomía, anunció la íntima conexión entre la estructura del átomo y la del Universo, entre lo infinitesimal y lo infinito.

El átomo de Dalton

El camino experimental hacia el átomo fue trazado por John Dalton (1766 – 1844). Era este un científico aficionado cuáquero y autodidacta que recogió un sugestivo concepto de Lavoisier (1743 – 1794). Considerado una de los fundadores de la química moderna, Lavoisier, cuando definió un “elemento” como una sustancia que no puede ser descompuesta en otras sustancias por medio de ningún método conocido, hizo del átomo un útil concepto de laboratorio y trajo la teoría atómica a la realidad.

Dalton había nacido en el seno de una familia de tejedores de Cumberland, localidad inglesa situada en la región de los lagos, y estuvo marcada toda su vida por su origen humilde. A los doce años ya se encontraba a cargo de la escuela cuáquera de su pueblo. Después, comenzó a ejercer la enseñanza en la vecina Kendal, y en la biblioteca del colegio encontró ejemplares de los Principia de Newton, de las Obras de la Historia Natural de Buffón, así como un telescopio reflectante de unos setenta centímetros y un microscopio doble.

Dalton recibió allí la influencia de John Gough, un notable filósofo natural ciego que, de acuerdo a lo que Dalton escribió a un amigo, “entiende muy bien todas las diferentes ramas de las matemáticas…Conoce por el tacto, el sabor y el olor de casi todas las plantas que crecen a casi treinta kilómetros a la redonda”. También Wordsworth elogia a Gough en su Excursión. Dalton recibió del filósofo ciego una educación básica en latín, griego y francés, y fue introducido en las matemáticas, la astronomía y todas las ciencias “de la observación”. Siguiendo el ejemplo de Gough, Dalton comenzó a llevar un registro meteorológico diario, que continuó hasta el día de su muerte.

Jhon Dalton retrato de 1837

Cuando los “disidentes” fundaron su colegio propio en Manchester, Dalton fue designado profesor de matemáticas y de filosofía natural. Halló una audiencia muy receptiva para sus experimentos en la Sociedad Literaria y Filosófica de Manchester, y presentó allí sus Hechos extraordinarios concernientes a la visión de los colores, que probablemente fue el primer trabajo sistemático sobre la imposibilidad de percibir los colores, o daltonismo, enfermedad que padecían tanto John Dalton como su hermano Jonathan. “He errado tantas veces el camino por aceptar los resultados de otros que he decidido escribir lo menos posible y solamente lo que pueda afirmar por mi propia experiencia”.

Dalton observó la aurora boreal, sugirió el probable origen de los vientos alisios, las causas de la formación de nubes y de la lluvia y, sin habérselo propuesto, introdujo mejoras en los pluviómetros, los barómetros, los termómetros y los higrómetros. Su interés por la atmósfera le proporcionó una visión de la química que lo condujo al átomo.

Newton había confiado en que los cuerpos visibles más pequeños siguieran las leyes cuantitativas que gobernaban los cuerpos celestes de mayor tamaño. La química sería una recapitulación de la Astronomía. Pero, ¿Cómo podía el hombre observar y medir los movimientos y la atracción mutua de estas partículas invisibles? En los Principios Newton había conjeturado que los fenómenos de la Naturaleza no descritos en este libro podrían “depender todos de ciertas fuerzas por las cuales las partículas de los cuerpos, debido a causas hasta ahora desconocidas, se impulsan mutuamente unas hacia otras y se unen formando figuras regulares, o bien se repelen y se apartan unas de otras.”

Dalton se lanzó a la búsqueda de “estas partículas primitivas” tratando de encontrar algún medio experimental que le permitiera incluirlas en un sistema cuantitativo. Puesto que los gases eran la forma de materia más fluida, más móvil, Dalton centró su estudio en la atmósfera, la mezcla de gases que componen el aire, el cual constituyó el punto de partida de toda su reflexión sobre los átomos.

“¿Por qué el agua no admite un volumen similar de cada gas?, preguntó Dalton a sus colegas de la Sociedad Literaria y Filosófica de Manchester en 1803. “Estoy casi seguro de que la circunstancia depende del peso y el número de las partículas últimas de los diversos gases; aquellos cuyas partículas son más ligeras y simples se absorben con más dificultad, y los demás con mayor facilidad, según vayan aumentando en peso y en complejidad.”

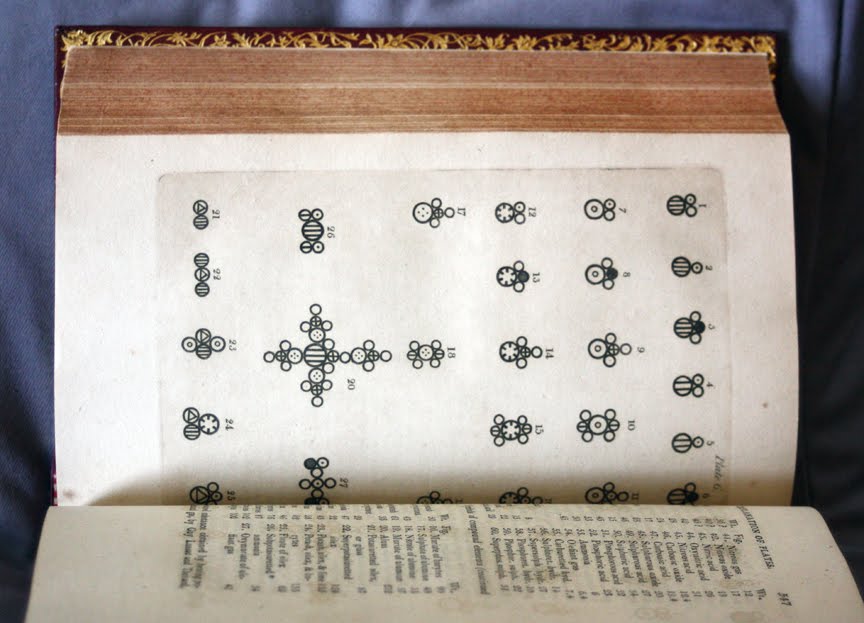

Dalton había descubierto que, contrariamente a la idea dominante, el aire no era un vasto disolvente químico único sino una mezcla de gases, cada uno de los cuales conservaban su identidad y actuaba de manera independiente. El producto de sus experimentos fue recogido en la trascendental TABLE: Of the Relative Weights of Ultimate Particles of Gaseous and Other Bodies (“Tabla de los pesos relativos de las partículas últimas de los cuerpos gaseosos y de otros cuerpos”).

Tomando al Hidrógeno como número uno, Dalton detalló en esta obra veintiuna sustancias. Describió las invisibles “partículas últimas” como diminutas bolitas sólidas, similares a balas pero mucho más pequeñas, y propuso que se les aplicaran las leyes newtonianas de las fuerzas de atracción de la materia. Dalton se proponía lograr “una nueva perspectiva de los primeros principios de los elementos de los cuerpos y sus combinaciones”, que “sin duda…con el tiempo, producirá importantísimos cambios en el sistema de la química y la reducirá a una ciencia de gran simplicidad, inteligible hasta para los intelectos menos dotados”. Cuando Dalton mostró una “partícula de aire que descansa sobre cuatro partículas de agua como una ordenada pila de metralla” donde cada pequeño globo está en contacto con sus vecinos, proporcionó el modelo de esferas y radio de la química del siglo siguiente.

Una ilustración de moléculas, según la teoría atómica de John Dalton. En el siglo XIX, Dalton sentó las bases de la actual teoría atómica, que luego se revelaría como substancialmente correcta. A lo largo de la Historia siempre ha sido igual, es muy raro encontrar que un descubrimiento o una teoría venga de una sola mente. La mente que finalmente la plasma en realidad, ha bebido antes del saber del mundo. Es decir, de todos quellos que antes que él pusieron sus ideas que fueron perfeccionando y haciendo posible ese finalñ feliz. Hasta Leucipo y Demócrito se aprovecharon de aventureros que, venidos de la India, les hablaron del átomo, una idea germinal de aquella zona de Asia.

Dalton inventó unas “señales arbitrarias como signos elegidos para representar los diversos elementos químicos o partículas últimas”, organizadas en una tabla de pesos atómicos que utilizaba en sus populares conferencias. Naturalmente, Dalton no fue el primero en emplear una escritura abreviada para representar las sustancias químicas, pues los alquimistas también tenían su código. Pero él fue probablemente el primero que utilizó este tipo de simbolismo en un sistema cuantitativo de “partículas últimas”. Dalton tomó como unidad el átomo de Hidrógeno, y a partir de él calculó el peso de las moléculas como la suma de los pesos de los átomos que la componían, creando así una sintaxis moderna para la química. Las abreviaturas actuales que utilizan la primera letra del nombre latino (por ejemplo H2O) fueron ideadas por el químico sueco Berzelius (1779 – 1848).

Sir Humpry Davy a los veintitrés años.

La teoría del átomo de Dalton no fue recibida en un principio con entusiasmo. El gran sir Humphry Davy desestimó inmediatamente sus ideas tachándolas de “más ingeniosas que importantes”. Pero las nociones de Dalton, desarrolladas en A New System of Chemical Philosophy (1808), eran tan convincentes que en 1826 le fue concedida la medalla real. Como Dalton no olvidó nunca su origen plebeyo, permaneció siempre apartado de la Royal Society de Londres, pero fue elegido miembro, sin su consentimiento, en 1822. Receloso del tono aristocrático y poco profesional de la Sociedad, él se encontraba más a gusto en Manchester, donde realizó la mayor parte de su obra, colaboró con Charles Babage y contribuyó a fundar la Asociación Británica para el Progreso de la Ciencia, cuyo objetivo era llevar la ciencia hasta el pueblo. Los newtonianos partidarios de la ortodoxia religiosa no creían que Dios hubiera hecho necesariamente sus invisibles “partículas últimas” invariables e indestructibles. Compartían con Isaac Newton la sospecha de que Dios había utilizado su poder “para variar las leyes de la Naturaleza y crear mundos diversos en distintos lugares del Universo”.

El átomo indestructible de Dalton se convirtió en el fundamento de una naciente ciencia de la química, proporcionando los principios elementales, las leyes de composición constante y de proporciones múltiples y la combinación de elementos químicos en razón de su peso atómico. “El análisis y la síntesis química no van más allá de la separación de unas partículas de otras y su reunión”, insistió Dalton. “La creación o la destrucción de la materia no está al alcance de ningún agente químico. Sería lo mismo tratar de introducir un planeta nuevo en el Sistema Solar o aniquilar uno de los ya existentes que crear o destruir una partícula de Hidrógeno.” Dalton continuó usando las leyes de los cuerpos celestes visibles como indicios del Universo infinitesimal. El profético sir Humphry Davy, sin embargo, no se convencía, “no hay razón para suponer que ha sido descubierto un principio real indestructible”, afirmó escéptico.

Dalton no era más que un Colón. Los Vespucios aún no habían llegado, y cuando lo hicieron trajeron consigo algunas sorpresas muy agradables y conmociones aterradoras. Entretanto, y durante medio siglo, el sólido e indestructible átomo de Dalton fue muy útil para los químicos, y dio lugar a prácticas elaboraciones. Un científico francés, Gay-Lussac, demostró que cuando los átomos se combinaban no lo hacían necesariamente de dos en dos, como había indicado Dalton, sino que podían agruparse en asociaciones distintas de unidades enteras. Un químico italiano, Avogadro (1776 – 1856), demostró que volúmenes iguales de gases a la misma temperatura y presión contenían el mismo número de moléculas. Un químico ruso, Mendeleiev, propuso una sugestiva “Ley periódica” de los elementos. Si los elementos estaban dispuestos en orden según su creciente peso atómico entonces grupos de elementos de características similares se repetirían periódicamente.

La disolución del indestructible átomo sólido provendría de dos fuentes, una conocida y la otra bastante nueva: el estudio de la luz y el descubrimiento de la electricidad. El propio Einstein describió este histórico movimiento como la decadencia de una perspectiva “mecánica” y el nacimiento de una perspectiva “de campo” del mundo físico, que le ayudó a encontrar su propio camino hacia la relatividad, hacia explicaciones y misterios nuevos.

Albert Einstein tenía en la pared de su estudio un retrato de Michael Faraday (1791 – 1867), y ningún otro hubiera podido ser más apropiado, pues Faraday fue el pionero y el profeta de la gran revisión que hizo posible la obra de Einstein. El mundo ya no sería un escenario newtoniano de “fuerzas a distancias”, objetos mutuamente atraídos por la fuerza de la Gravedad inversamente proporcional al cuadrado de la distancia que hay entre ellos. El mundo material se convertiría en una tentadora escena de sutiles y omnipresentes “campos de fuerzas”. Esta idea era tan radical como la revolución newtoniana, e incluso más difícil de comprender para los legos en la materia.

emilio silvera

Feb

23

Sí ¡Tenemos que Saber! Para avanzar

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

David Hilbert

El nombre de David Hilbert (1862–1942) ocupa un lugar muy especial en el imaginario colectivo de los matemáticos . Sin duda se trata del matemático más famoso del siglo XX, a lo que contribuyeron de manera muy especial su aportación a la configuración de los métodos axiomáticos actuales, sus profundos resultados en álgerbra, teoría de números, geometría y teoría de funciones [análisis complejo], los celebérrimos “problemas matemáticos” que dejó planteados en 1900, y las venturas y desventuras de sus intentos de resolver la cuestión de los fundamentos de la matemática.

Esas letras que se ven gravadas abajo, en la piedra, lo que dicen es su célebre: ” “wir müssen wissen, wir werden wissen” [debemos saber; llegaremos a saber].

Pero yo quería hablar de los físicos y del hecho cierto de que son conscientes de que, en el panorama de su disciplina, en el lejano horizonte, vislumbran oscuros nubarrones que empañan el paisaje, oscurecen el futuro y pertuban sus pensamientos al ver con diáfana claridad las dificultades que tendrán que solventar si quieren continuar en el camino del progreso desvelando los secretos de la naturaleza.

Ellos, los físicos, son muy conscientes de que toda la física moderna está apoyada sobre la base de dos imponentes columnas: La Relatividad General de Einstein, que proporciona un marco teórico para la comprensión del universo en la escala más alta: estrellas, galaxias, cúmulos de galaxias y más allá, hasta los confines del universo observable en su contínua expansión. La otra columna es la Mecánica Cuántica, que les ofrece el marco teórico para la comprensión del Universo en sus mínimas escalas: Átomos y moléculas comenzando por las partículas que todo lo conforman como los Quarks y los electrones.

El estudio de fenómenos a escala microscópica mediante las hipótesis de la cuantización de la energía y la dualidad onda-partícula fue desarrolado bajo el nombre de Mecánica cuántica por Erwin Schrödinger, Werner Heisenberg, Paul Dirac y el mismo Einstein entre otros muchos, a partir de la idea seminal de Max Planck con su cuanto de acción, h, allá por los alrededores de 1925-1926, Aunque el trabajo de Einstein, inspirado en el de Planck, sobre el Efecto fotoeléctrico fue antes (creo).

A partir de 1930 la mecánica cuántica se aplicó con mucho éxito a problemas relacionados con núcleos atómicos, moléculas y materia en estado sólido. La mecánica cuántica hizo posible comprender un extenso conjunto de datos, de otra manera enigmáticos. Sus predicciones han sido de una exactitud notable. Ejemplo de ésto último es la increíble precisión de diesciciete cifras significativas del momento magnético del electrón calculadas por la EDC (Electrodinámica Cuántica) comparadas con el experimento.

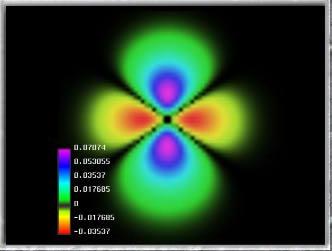

Imagen ilustrativa de la dualidad onda-partícula, en el que se aprecia cómo un mismo fenómeno puede ser percibido de dos modos distintos. La mecánica cuántica describe, en su visión más ortodoxa, cómo en cualquier sistema físico –y por tanto, en todo el universo- existe una diversa multiplicidad de estados, los cuales habiendo sido descritos mediante ecuaciones matemáticas por los físicos, son denominadoss estados cuánticos. De esta forma la mecánica cuántica puede explicar la existencia del átomo y desvelar los misterios de la estructura atómica, tal como hoy son entendidos; fenómenos que no puede explicar debidamente la física o más propiamente la mecánica clásica.

Pocas dudas nos pueden caber sobre el hecho cierto de que, la Mecánica cuántica ha sido uno de los más grandes avances de la Humanidad y, gracias a ella, hemos podido tener acceso a grandes logros e inventos que hoy hacen más cómoda nuestras vidas y también, en el campo de las nuevas tenologías este apartado de la física, ha tenido mucho que decir: Explica el comportamiento de lamateria y de la energía. Su aplicación ha hecho posible el descubrimiento y desarrollo de muchas tenologías, como por ejemplo, los transistores, componentes profusamente utilizados en casi todos los aparatos que tengan alguna parte funcional electrónica y muchos más cuya lista pormenorizada no cabría aquí en un simple comentario.

A lo largo de años de investigación, los físicos han confirmado experimentalmente, con una exactitud casi inimaginable, la práctica totalidad de las predicciones que hace cada una de estas dos teorías (la Relatividad General y la Mecánica Cuántica). Sin embargo, estos mismos instrumentos teóricos conducen a otra conclusión inquietante: tal como se formulan actualmente, la rrlatividad general y la mecánica cuántica no pueden ambas ser ciertas a la vez. Las dos teorías en las que se bazan los enormes avances realizados por la física durante los últimos cien años -unos avances que han explicado la expansión de los cielos y las estructuras fundamentales de la materia- son mutuamente incompatibles.

Las ideas de Einstein siempre estuvieron unidas al Universo

Creo que todos hemos podido hablar, en alguna ocasión, de la incompatibilidad de estas dos teorías que, siendo ciertas por separado hasta límites insospechados, cuando se juntan, aquello resulta un auténtico desastre. ¿Por qué será? Bueno, la respuesta podría estar en el hecho cierto de que, los físicos, estudian cosas muy pequeñas y ligeras (como los átomos y sus partes constituyentes), o cosas que son enormes y muy pesadas (como los mundos, las estrellas y las galaxias), pero no estudian ambas al mismo tiempo. Y, siendo así (que lo es), no necesitan utilizar las dos teorías al mismo tiempo, sino que, dependiendo del estudio a realizar de lo muy pequeño (la mecánica cuántica) y de lo muy grande (la relatividad general) y, de esta manera, ahogan el grito que mientras operan, les lanza la otra teoría, la que no están utilizando. Así, durante las últimas décadas, este planteamiento no ha sido tan feliz como la ignorancia, pero ha estado muy cerca de serlo. Lo único que ha enturbiado la paz, ha sido el hecho cierto de que, los físicos, han sido muy conscientes de que se necesita encontrar esa teoría de la Gravedad-Cuántica que, al parecer, sólo en el ámbito de la Teoría de Supercuerdas pueden encontrar.

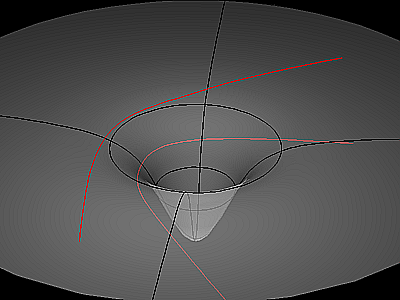

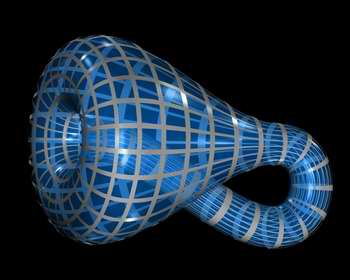

Cuerda cerrada en forma de botella de Klein

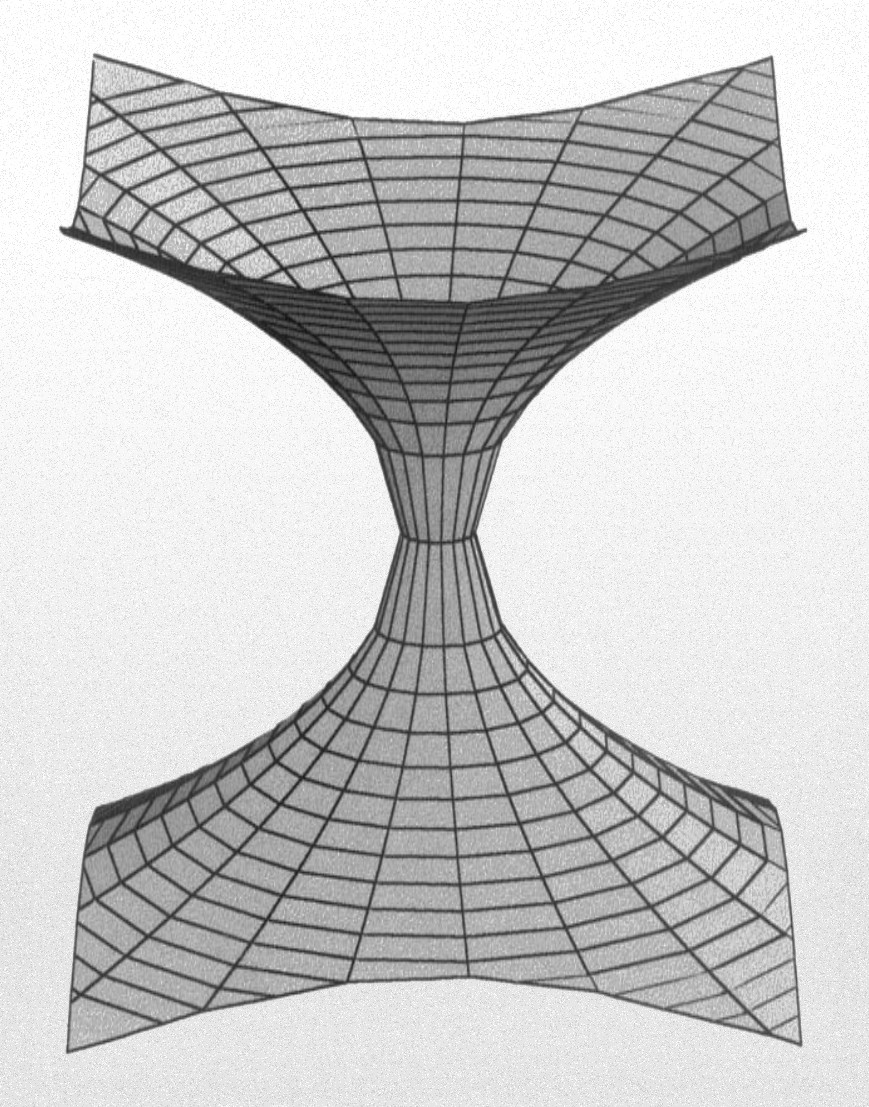

Algunos veces hemos podido llegar apensar que, el Universo, puede encontrar en casos extremos: Unas veces en las profundidades nucleares de un agujero negro donde se aplasta una inmensa cantidad de masa que se reduce hasta un minúsculo tamaño. Estos dos conceptos del tamaño diminuto y de la inmensa masa, nos requieren para poder explicarlos, a los dos teorías: La Mecánica cuántica y la Relatividad General y, sin embargo, cuando hemos tratado de unir las fórmulas de ambas teorías, los “tornillos” de sus estructuras saltan y aquello parece explotar, la incompatibilidad es manifiesta.

La Teoría de supercuerdas, una advenidiza que se mueve en las arenas movedizas de no poder ser verificada, en comparación con los dos venerables edificios de la M.C. y la R.G., que por el contrario no tienen nada que demostrar más allá de lo ya demostrado, y, sin embargo, la llegada de esta incipiente teoría (aunque lleve muchos años en el candelero), nos viene a decir lo que, las otras dos no han podido: Que en ella (en la Teoría de Cuerdas), no sólo se puede explicar la materia en su nivel más básico sino que, además, se resuelve la tensión existente entre las dos teorías incompatibles hasta el momento y, además, hace posible que la unión de ambas avance dando un paso de gigante. De hecho, la teoría de las supercuerdas muestra aún más: dentro de este nuevo marco, la relatividad general y la mecánica cuántica, se necesitan la una a la otra para que esta teoría tenga sentido y pueda explicar el universo en su conjunto. Según la teoría de supercuerdas, , el matrimonio entre las leyes de lo muy grande y lo muy pequeño no sólo es feliz, sino inevitable.

Por otra parte, la teoría bosónica no habla tampoco de los fermiones sino sólo a bosones como los fotones. Pero sabemos que los bosones son un caso particular de comportamiento, y que muchas otras partículas observan conductas muy distintas. ¿Qué haremos si no podemos explicar a los fermiones como los quarks, componentes fundamentales de la materia y la energía? Algunas nuevas teorías como la supersimetría intentan describir tanto a bosones como fermiones, y todas ellas juntas han llevado a los nuevos modelos que tenemos actualmente.

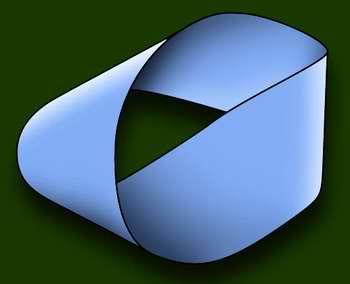

Una cinta de Moebius, posible en esta teoría

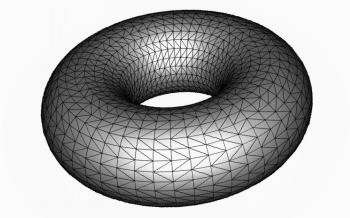

En nuestra mirada del siglo XXI, si las cuerdas determinan una realidad plana, es posible imaginar a las partículas y sus interacciones como “ondas” o “montículos” e incluso “ondas concéntricas” sobre ese plano. Las cuerdas pueden dividirse (como un hilo en forma de Y) o reunirse, entrecruzarse y fundirse, y todas estas conductas repercutirán en la topología del plano que determinan. Varias cuerdas de tipo cerrado pueden juntarse y converger en un solo tubo único, emitir ramales laterales e incluso cerrarse sobre sí mismas para configurar un mundo con la forma del cuerpo geométrico conocido como toro. O una cinta de Moebius. O una botella de Klein. O lo que se nos ocurra o nos guste imaginar. En este caso, podríamos imaginar a las partículas como ondulaciones que se desplazaran por los tubos. La adición de una partícula se vería como cuerdas que convergen, y la emisión como ramales divergentes.

Cuerdas toroidales

La gravedad, por su parte (protagonista fundamental de las interacciones del universo) puede representarse fácilmente como tres tubos unidos en forma de H. El Sol atrae a la Tierra: los tubos verticales son las partículas del Sol y de nuestro planeta, y el trazo horizontal es el gravitón del Sol que viaja desde él hacia nosotros. Las formas determinadas por las cuerdas tienen una cantidad de dimensiones que varían de acuerdo con la teoría que se considere. Si la supersimetría es correcta, el universo tiene 10 u 11 dimensiones. Si la teoría bosónica es la que tiene razón, la realidad consta de nada menos que 26 dimensiones. El problema, como es fácil comprender, es que todo ello entra en conflicto directo con nuestro universo espaciotemporal de 4 dimensiones, que cualquiera puede observar, medir y confirmar.

Algunos científicos postulan hoy que la teoría de las cuerdas no merece ni siquiera que se le aplique el método científico, porque no es capaz de describir el universo ni siquiera a un grado básico. Otros creen que algún día demostraremos que existen gigantescas cuerdas uniendo inclusive las galaxias a nivel universal. Esta cuerdas irradiarían grandes ondas gravitatorias en todas direcciones y podrían explicar algunos fenómenos de gran escala que hoy en día no podemos explicar. La realidad es que hay que darle tiempo. No hemos tenido, hasta hoy, ocasión de chequear todas la complejas implicaciones de la teoría (LAS teorías) de cuerdan en cuanto a explicaciones completas, coherentes e inatacables de la realidad que observamos. Tal vez algún día, en un futuro no tan lejano, podamos probarlas o descartarlas definitivamente.

- Materia.

- Estructura molecular.

- Átomos.

- Electrones.

- Quarks.

- Cuerdas?

Claro que, aparte de que no tenemos la energía de Planck para poder llegar hasta ellas (1019 GeV), además, nos topamos con el hecho cierto de que nos encontramos anclados a las viejas teorías (R.G. y M.C.) y, si queremos avanzar, las características encontradas en las teorías de cuerdas, nos ecigen que cambiémos drácticamente nuestra manera de entender el espacio, el tiempo y la materia, y, esa ttarea amigos míos, no será nada fácil. No estamos (yo diría que estamos lejos) en ese nivel en el que mnos resultaría cómodo manejar esas nuevas teorías.

¿Pero las cuerdas? Las cuerdas no parecen ser una estructura preferida por la naturaleza en el diseño de los cielos. No vemos cuerdas en el espacio exterior. De hecho no las vemos por ninguna parte. ¡A que va a resultar que, la verdadera semilla de la materia y el componente esencial del Universo, va a resultar ser, finalmente, algo tan pequeño que reside fuera de nuestro alcance?

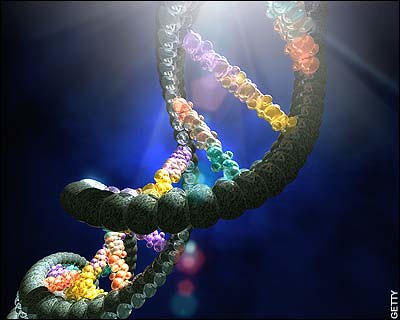

Un momento de reflexión, sin embargo, revelará que la naturaleza ha reservado un papel especial a las cuerdas, como un ladrillo básico para otras formas. Por ejemplo, la característica esencial de la vida en el planeta Tierra es la molécula de ADN similar a una cuerda, que contiene la información compleja y el código de la propia vida. Para construir la materia de la vida, tanto como la materia subatómica, las cuerdas parecen ser la respuesta perfecta. En ambos casos, queremos encerrar una gran cantidad de información en una estructura reproducible y relativamente simple. La característica distintiva de una cuerda es que es una de la forma más compacta de almacenar grandes cantidades de datos de un modo en que la información pueda ser replicada.

Para los seres vivos la naturaleza utiliza la doble cadena de la molécula de ADN, que se separa y forma copias duplicadas de cada una de ellas. Nuestros cuerpos también contienen millones de millones de cadenas de proteínas, formadas de ladrillos de aminoácidos. Nuestro cuerpo, en cierto sentido, puede ser considerado como una enorme colección de cuerdas: moléculas de proteínas que revisten nuestros huesos. Sin embargo, nadie puede dar una explicación de nuestro entendimiento, de la inteligencia que se crea y que llevamos con nosotros desde el mismo momento del nacimiento, está ahí presente, a la espera de que se la despierte, es la inteligencia dormida y evolucionada por el conocimiento de las cosas. La conciencia de SER a la que llamamos alma, y que de alguna manera es inmortal, ya que lo que sabemos lo cedemos y lo dejamos aquí para los que nos siguen en la tarea emprendida por la humanidad desde que, en el preciso momento en que surgió aquella primera célula original que fue capaz de dividirse para replicarse a sí misma, se dio el primer paso para el nacimiento de la vida en nuestro planeta. Pero esa es otra cuestión que será tratada en otro próximo trabajo, ahora volvamos al tema de la teoría de cuerdas de la física.

Se habla de cuerdas abiertas, cerradas o de lazos, de p branas donde p denota su dimensionalidad (así, 1 brana podría ser una cuerda y 2.Brana una membrana) o D-Branas (si son cuerdas abiertas) Y, se habla de objetos mayores y diversos que van incorporados en esa teoría de cuerdas de diversas familias o modelos que quieren sondear en las profundidades del Universo físico para saber, como es.

Claro que, a todo esto, no debemos perder de vista ni olvidar que, la teoría de cuerdas emerge como un producto impresionante, pero natural, a partir de los descubrimientos revolucionarios que ha realizado la física durante los últimos cien años. De hecho, veremos que el conflicto existente entre la reltiviad general y la mecánica cuántica no es precisamente el primero, sino el tercero de una serie de conflictos decisivos con los que se tuvieron que enfrentar los científicos durante el siglo pasado, y que han resuelto como consecuencia de una revisión radical de nuestro modo de comprender en universo.

Uno de aquellos conflictos eran las desconcertante propiedades del movimiento de la Luz. Dicho resumidamente, según las leyes del movimiento de Isaac Newton, si alguien corre a una velocidad suficientemente rápida podría emparejarse con un rayo de luz que se esté emitiendo, mientras que, según las leyes del electromagnetismo de james Clerl Maxwell, esto es imposible. Einstein resolvió el conflicto mediante su teoría de la relatividad especial y así dio un vuelco completo a nuestro modo de entender el espacio y el tiempo que ya no podían entenderse como conceptos universales grabados en piedra y percibidos por todos los individuos de forma idéntica.

El desarrollo de la relatividad especial creó inmediatamente el escenario para el segundo conflicto. Una de las conclusiones del trabajo de Eisntein es que ningún objeto -de hecho, ninguna influencia o perturbación de ninguna clase- puede viajar a una velocidad mayor que la de la luz. Sin embargo, como hemos podido leer muchas veces, la teoría universal de la gravedad de Newton, que experimentalmente funciona tan bien y es tan grata para la intuición, habla de influencias que se transmiten en el espacio a grandes distancias instantáneamente. De nuevo fue Eisntein el que intervino en el conflicto y lo resolvió ofreciendo un nuevo concepto de la Gravedad en su teoría general de la relatividad.

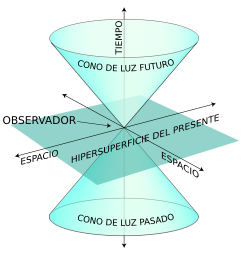

No es sólo que el Espacio y el Tiempo estén influidos por el esatado del movimiento del observador, sino que, además, pueden alabearse y curvarse en respuesta a la presencia de materia o energía. Tales distorsiones en la estructura del Espacio y el Tiempo, transmiten la fuerza de Gravedad de un lugar a otro que, más cercano o más lejano, recibe la influencia de esta fuerza fundamental. Así que, desde entonces, no se puede ya pensar que el Espacio y el Tiempo sean un telón de fondo inamovible e inerte en el que se desarrollan los sucesos del universo; al contrario, según la relatividad especial y la relatividad general, son actores de primera fila que desempeñan un papel óntimamente ligado al desarrollo de todos los hechos que en el universo ocurren.

Una vez más el modelo se repite: el descubrimiento de la relatividad general, aunque resuleve un cnflicto, nos lleva a otro. A lo largo de tres décadas a partir de 1900, los físicos desarrollaron la me´canica cuántica en respuesta a varios problemas evidentes que se pusieron de manifiesto cuando los conceptos de la física del siglo XIX se aplicaron al mundo microscópico. Como he mencionado anteriormente, el tercer conflicto, el más trascendental, surge de la incompatibilidad entrem la mecánica cuántica y la relatividad general. La forma geométrica ligeramente curvada del esapcio, que aparece a partir de la relatividad general, es incompatible con el comportamiento microscópico irritante y frenético del universo que se deduce de la mecánica cuántica.

Y, volvemos otra vez al principio: Tenemos que persistir en aquellos trabajos de los años ochenta, cuando se presentó la solución que ofrecía la teoría de cuerdas para este tercer conflicto o problema. En realidad, es el mayor conflicto que se nos presenta en la física moderna. Necesitamos ya, para poder explicar muchas cosas y seguir avanzando, una teoría cuántica de la gravedad -si eso fuera posible-. Estamos parados, no podemos avanzar como sería deseable y, desde luego muchas son las iniciativas que se intentan: Teoría de Cuerdas, Teoría Luz-luz, o, energía masa, y otras muchas que están, en la mente de los mejores físicos del mundo pero que, no acaban de germinar.

Esperémos que, a no tardar mucho, alguna de esas teorías venga a decirnos algo más, del mundo que nos acoge, de la Naturaleza, y, del Universo en fin que contiene todo lo que existe y que de manera inexorable, irá cambiando hacia el futuro y, ¡las teorías también! Todo cambiará, incluso nosotros.

emilio silvera

Feb

22

Unificar las fuerzas de la Naturaleza en una Teoría

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Unificar la Naturaleza ~

Clasificado en Unificar la Naturaleza ~

Comments (15)

Comments (15)

La geometría del Universo, del espaciotiempo, está determinada por la materia que contiene

La discusión de la unificación de las leyes de la Naturaleza fue más bien abstracta, y lo habría seguido siendo si Einstein no hubiese dado el siguiente paso decisivo. Él comprendió que si el espacio y el tiempo pueden unificarse en una sola entidad, llamada espaciotiempo, entonces quizá la materia y la energía pueden unirse también en una relación dialéctica. Si las reglas pueden contraerse y los relojes pueden frenarse, razonó, entonces cualquier cosa que midamos con regla y relojes también debe cambiar. (Es deseable dejar aquí una nota aclaratoria de que, todo lo que ahora se cuenta de Einstein, en parte, tiene su fuente en otros científicos que, aportaron la base de sus ideas en las que él se inspiró para llegar hasta la relatividad, y, su efecto fotoeléctrico -que le valió el Nobel de Física- le llegó desde la mente de Planck que, con su cuento de acción, h, le abrió el camino a aquel trabajo).

La velocidad de la luz recorre la distancia de la Tierra a la Luna en poco más de un segundo

Sin embargo, casi todo en el laboratorio de un físico se mide con regla y relojes. Esto significa que los físicos tendrán que recalibrar todas las magnitudes del laboratorio que una vez dieron por hecho que eran constantes.

En concreto, la energía es una cantidad que depende de cómo midamos las distancias y los intervalos de tiempo. Un automóvil de prueba que choca a gran velocidad contra una pared de ladrillos tiene obviamente energía. No obstante, si el veloz automóvil se aproxima a la velocidad de la luz, sus propiedades se distorsionan. Se contrae como un acordeón y los relojes en su interior se frenan.

Lo que es más importante, Einstein descubrió que la masa del automóvil también aumenta cuando reacelera. Pero ¿de dónde procede este exceso de masa? Y él concluyó que procedía de la energía. La masa relativista es la masa de un cuerpo medida por un observador con respecto al cual ese cuerpo se mueve. De acuerdo con la teoría de Einstein, esta masa está dada por:

donde m0 es su masa en reposo y c es la velocidad de la luz. La masa relativista sólo difiere de la masa en reposo si su velocidad es una fracción apreciable de la velocidad de la luz. Si V= c/2, por ejemplo, la masa relativista es un 15% mayor que la masa en reposo.

De hecho, cuando una partícula se acerca a la velocidad de c, su masa … ¡aumenta!