Agujeros Negros

Logran fotografiar por primera vez el agujero negro del centro de nuestra galaxia

IMPRESIÓN NO PERMITIDA - TEXTO SUJETO A DERECHOS DE AUTOR

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Astronomía y Astrofísica ~

Clasificado en Astronomía y Astrofísica ~

Comments (2)

Comments (2)

El Modelo del Big Bang, que justo es reconocerlo, coincide con las observaciones realizadas, algunos, sin embargo, no lo tienen tan claro y dudan de que, a partir de un punto de infinita densidad y energía saliera todo esto que llamamos universo.

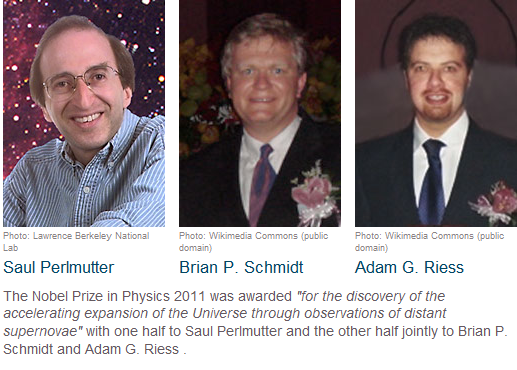

El Premio Nobelk de Física de 2011 se otorgó a los tres físicos que arriba podeis contemplar “por el descubrimiento de la expansión acelerada del universo gracias a observaciones de supernovas lejanas”. Es sin duda una de los hallazgos más extraordinarios que nos ha ofrecido la cosmología desde el descubrimiento del fondo cósmico de radiación de microondas. Gracias a estas observaciones, ahora sabemos que el universo no sólo se expande sino que lo hace de forma acelerada, en contra de lo esperado si estuviera compuesto de materia ordinaria.

(Es curioso que, después de que los premios fuesen concedidos a estos físicos, ha salido un español que, según dice y ha sido publicado, tenía registrado el trabajo, o uno similar, al que ha valido el novel de 2.011 a estos de arriba. La polémica está en marcha).

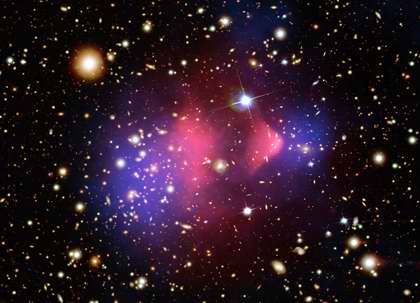

Esta imagen compuesta muestra conglomerado de galaxias 1E 0657-56. Este conglomerado se formó despues del choque de dos grandes grupos de galaxias, el suceso más energético que se conoce en el universo luego del Big Bang. Lo cierto es que, cuando ese punto (singularidad) del que surgió todo, es decir, el nacimiento del Universo, mediante el llamado Big Bang, la expansión del universo fue exponencial y ciertamente tuvo que ser máyor que c, lo cual nos lleva a pensar en cómo pudieron formarse las galaxias, si todo se estaba expandiendo a tal velocidad, la materia no tendría que haberse podido aglomerar (juntar) para formarlas. ¡Es todo tan extraño!

Los astrónomos dicen que han encontrado las mejores pruebas hasta la fecha sobre la Materia Oscura, la misteriosa sustancia invisible que se cree constituye la mayor parte de la masa del universo. En la imagen de arriba han querido significar, diferenciándola en colores, las dos clases de materia, la bariónica y la oscura que, en este caso, sería la azulada -según dicen-. Sin embargo, la imagen no refleja la proporción que dicen existe entre la una y la otra.

Para poder comprender este resultado tan extraordinario, podríamos poner un ejemplo sencillo: Por ejemplo, si lanzamos una pelota con fuerza hacia arriba, ésta sale despedida en la medida de la fuerza que la impulsó, y, llegado a un punto, la Gravedad que ejerce la Tierra sobre ella, la hará caer de nuevo. Sin embargo, si lanzamos la pelota con mucha más fuerza, ésta podría vencer la gravedad terrestre y salir al espacio exterior y escapar a velocidades cada vez menores. Sin embargo, lo que han observado los investigadores que han recibido el Nobel en 2011, es que el universo no se comporta de esta manera. En lugar de frenarse conforme se expande, el universo parece expandirse de forma acelerada. En la analogía de la pelota, es como si esta, una vez escapara de la Tierra, se alejara con una velocidad cada vez mayor. De esta realidad observada, se deduce de manera clara que, sobre el Universo, está actuando una fuerza desconocida que lo atrae y supera la atracción gravitacional de toda la materia que contiene conocida por nosotros.

Pero antes de describir las observaciones, recapitulemos sobre lo que sabemos del universo hasta ahora. La expansión del universo fue descubierta en los años 20 del pasado siglo por Vesto Slipher, Knut Lundmark, Georges Lemaítre y Edwin Hubble. El ritmo de exdpansión depende del contenido de energía, y un universo que contiene sólo materia termina frenándose gracias a la fuerza de gravedad.

Las galaxias se alejan las unas de las otras ganando velocidad

Las observaciones de la recesión de las galaxias, así como de las abundancias de elementos ligeros, pero sobre todo del fondo de radiación de microondas, nos han permitido construir una imagen del universo en expansión, a partir de un origen extremadamente caliente y denso, que se va enfriando conforme se expande. Hasta hace unas décadas se creía que esa expansión era cada vez más lenta y se especulaba sobre la posibilidad de que eventualmente el universo “recolapsara”. Sin embargo, las observaciones de la luz que nos llega de supernovas a distancias astronómicas, de hasta siete mil millones de años-luz -hechas por dos colaboraciones independientes: El Supernovae Cosmology Project, liderado por Saul Perlmutter, y el High Redshift Supernova Project, de Brian Schmidt y Adam Riess- mostraron que actualmente el ritmo de expansión está acelerándose, en lugar de decelerarse.

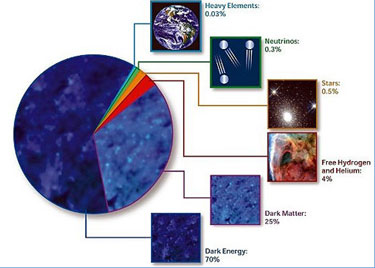

La hipótesis más común para dar cuenta de la expansión acelerada del universo es asumir la existencia de un tipo de energía exótica llamada energía oscura. De acuerdo con los cálculos cuantitativos alrededor del 70% del contenido energético del Universo consistiría en energía oscura, cuya presencia tendría un efecto similar a una constante cosmológica de tipo expansivo como el observado; sin embargo, la naturaleza exacta de este tipo de energía es desconocida.Pero, ¿qué pasa con las observaciones realizadas?

Estas observaciones han sido posible gracias a que las supernovas de tipo Ia son explosiones extraordinariamente violentas que se ven a enormes distancias y afortunadamente siguen un patrón de luminosidad característico, llegando a su máximo pocos días después de la explosión y a partir de ahí lentamnete decreciendo en luminosidad hasta que dejamos de verla. La relación entre la máxima luminosidad y el período de decrecimiento se puede calibrar con supernovas cercanas, de manera que midiendo estos períodos para muchas supernovas podemos deducir su distancvia a nosotros y de ahí el ritmo de expansión del universo desde el momento en que la supernova explotó hace miles de millones de años. Las medidas de las supernovas lejanas muestran no sólo que el universo se está expandiendo aceleradamente hoy día, sino también que en el pasado lo hacia de forma decelerada, lo que concuerda con nuestras predicciones basadas en la Teoría de Einstein.

En el contexto del Modelo estándar cosmológico, la aceleración se cree causada por la energía del vacío -a menudo llamada “energía oscura”- una componente que da cuenta de aproximadamente el 73% de toda la densidad de energía del universo. Del resto, cerca del 23%, sería debido a una forma desconocida de materia a la que llamamos “materia oscura”. Sólo alrededor del 4% de la densidad de la energía correspondería a la materia ordinaria, es decir, la que llamamos Bariónica, esa que emite radiación, la luminosa y de la que estamos nosotros constituidos, así como las estrellas, los mundos y las galaxias. Es, precisamente esa luz, la que nos permite adentrarnos en lo más profundo del universo desconocido, lejano y oscuro para poder saber, sobre estos misterios.

La energía del vacío es una clase de energía del punto cero existente en el espacio incluso en ausencia de todo tipo de materia. La energía del vacío tiene un origen puramente cuántico y es responsable de efectos físicos observables como el efecto Casimir y otros.

En nuestras vidas cotidianas, los efectos de la energía de vacío son ínfimos, diminutos, pero aún así detectables en pequeñas correcciones a los niveles de las energías de los átomos. En Teorías de campos relativistas, la energía de vacío está dada por una expresión matemáticamente idéntica y físicamente indistinguible de la famosa constante cosmológica, o por el contrario varia con el tiempo, algo que tendría consecuencias importantísimas para el destino del universo y que es un tema de investigación candente en cosmología, con varios experimentos propuestos para detectarlo.

Tipos de espacio según la densidad crítica del universo. Es decir, dependiendo del valor de Omega, tendremos un universo abierto, cerrado o plano. De momento, todos los indicios nos dicen que estamos en un universo plano que se expandirá para siempre.

En fin amigos, el tema es interesante y lo continuaremos en otro momento…

Le he robado un rato al trabajo para dejar esta página en el Blog por estimarla de interés para que todos, estén al día de los últimos descubrimientos en relación al universo en el que vivímos y de lo que los científicos nos cuentan de vez en cuando que, no siempre (creo), coincide con la realidad.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en a otros mundos ~

Clasificado en a otros mundos ~

Comments (0)

Comments (0)

Si los humanos pudiéramos escapar mañana a otro sistema solar, nuestra mejor opción sería ir a una enana roja. Estos astros mucho más pequeños y tenues que el Sol, invisibles a simple vista en el cielo nocturno, son los más abundantes en la Vía Láctea y albergan los planetas más cercanos y parecidos a la Tierra que se conocen. Ayer, el mejor destino hubiera sido el astro Trappist-1, que posiblemente alberga siete tierras, tres de ellas habitables, es decir, con posible agua líquida, a unos 40 años luz de nosotros. Los más arriesgados argumentarían que es mejor viajar a Próxima b, donde está el planeta terrestre más cercano al nuestro, a apenas cuatro años luz. Hoy, la cosas han cambiado, pues se ha descubierto el exoplaneta donde puede ser más probable encontrar indicios de vida, según sus descubridores.

Muchas son las enanas rojas que tienen en órbitas planetas como la Tierra

El nuevo planeta está a 40 años luz de la Tierra y orbita en torno a una enana roja llamada LHS 1140. En septiembre de 2014, el telescopio M-Earth, en Chile, captó una leve disminución de su luz que podía deberse al tránsito de un planeta. Este telescopio, junto a su gemelo en el hemisferio norte, tiene como objetivo observar todas las estrellas enanas que hay a menos de 100 años luz de la Tierra, a razón de 30 minutos por astro. Tras detectar la señal, el telescopio comenzó a seguir a la estrella en tiempo real mientras un sistema de inteligencia artificial seleccionaba los datos interesantes para confirmar la existencia del planeta.

Los resultados del estudio, publicados hoy en Nature y que incluyen el uso de otros telescopios, confirman que hay un planeta con un radio 1,4 veces el de la Tierra y una masa seis veces y media mayor. Estos dos datos implican que lo más probable es que este planeta tenga un núcleo de hierro denso recubierto de rocas, la misma composición que la Tierra.

Este nuevo mundo está unas 10 veces más cerca de su sol que la Tierra, pero el astro es tan tenue que la cantidad de radiación que le llega es la mitad de la que recibe nuestro planeta. Esto hace posible que el planeta tenga dos elementos indispensables para la vida: agua líquida y atmósfera.

Por ahora este es el candidato número uno a ser un planeta como la Tierra”

“Por ahora todos los datos que tenemos nos indican que este planeta debe tener un aspecto como el de la Tierra”, explica Jason Dittmann, astrónomo del Centro de Astrofísica Harvard-Smithsonian (EE UU) y coautor del estudio, quien desarrolló el sistema de inteligencia artificial que se ha empleado en el descubrimiento. “Por ahora este es el candidato número uno a ser un planeta como la Tierra”, asegura.

El planeta LHS 1140b se habría formado hace 5.000 millones de años posiblemente de una forma similar a la Tierra, aunque en un entorno mucho más hostil. Cuando las enanas rojas son jóvenes, emiten una alta radiación que puede destruir la atmósfera de los planetas rocosos en su entorno y hacerlos más parecidos a Venus que a nuestro planeta, explica Dittmann. El hecho de que este planeta sea ligeramente más grande que la Tierra podría favorecer que en el pasado albergase mares de lava que podrían haber permitido conservar una atmósfera con su aportación de vapores magmáticos.

Por ahora este puede ser el mejor candidato para observar la primera atmósfera de un mundo habitable fuera del Sistema Solar. Dittman señala que su equipo ya ha pedido tiempo de observación con el telescopio espacial Hubble para medir la dispersión de Rayleigh, el efecto que hace que la Tierra vista desde el espacio sea un punto azul pálido, y que podría confirmar la existencia de una atmósfera en el nuevo exoplaneta. Y en un año se podría usar el Telescopio Espacial James Webb para detectar oxígeno, metano y dióxido de carbono, compuestos que podrían indicar la presencia de vida, señala.

Trappist-1

El descubrimiento de este nuevo planeta es importante “comparado con Trappist-1 y Próxima b porque es el primer planeta terrestre con masa y tamaño bien determinados”, opina Guillem Anglada-Escudé, astrónomo español codescubridor del exoplaneta más cercano a la Tierra. “De momento han encontrado un solo planeta, pero es probable que haya más”, como “pasó con trappist-1, y esperamos que pase con Próxima”, explica. “Este puede ser unos de los sistemas solares importantes para la detección de atmósferas”, señala, aunque puede ser que pronto haya mejores candidatos aún. “Creo que se van a descubrir media docena más de estos planetas, alguno más cercano que Trappist-1 y este, porque hay unas 400 estrellas entre Trappist-1 y nosotros”, resalta.

“Este es el siguiente paso que estábamos esperando en la búsqueda de planetas como la Tierra”, señala José Caballero, investigador del Centro de Astrobiología. “Se descubren tantos planetas de golpe ahora porque hay muchos grupos de investigación en el mundo detrás de lo mismo”, explica. “Dentro de una década vendrán los planetas habitables alrededor de estrellas de tipo G, como el Sol”, añade.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

La mente humana es tan compleja que no todos ante la misma cosa vemos lo mismo. Nos enseñan figuras y dibujos y nos piden que digamos (sin pensarlo) la primera cosa que nos sugiere. De entre diez personas, sólo coinciden tres, los otros siete divergen en la apreciación de lo que el dibujo o la figura les sugiere. Un paisaje puede ser descrito de muy distintas maneras según quién lo pueda contar.

Solo el 1% de las formas de vida que han vivido en la Tierra están ahora presentes, el 99%, por una u otra razón se han extinguido. Sin embargo, ese pequeño tanto por ciento de la vida actual, supone unos cinco millones de especies según algunas estimaciones. La Tierra acoge a todas esas especies u palpita de vida que prolifera por doquier. Hay seres vivos por todas partes y por todos los rincones del inmenso mosaico de ambientes que constituye nuestro planeta encontramos formas de vida, cuyos diseños parecen hechos a propósito para adaptarse a su hábitat, desde las profundidades abisales de los océanos hasta las más altas cumbres, desde las espesas selvas tropicales a las planicies de hielo de los casquetes polares. Se ha estimado la edad de 3.800 millones de años desde que aparecieron los primeros “seres vivos” sobre el planeta (dato de los primeros microfósiles). Desde entonces no han dejado de aparecer más y más especies, de las que la mayoría se han ido extinguiendo. Desde el siglo XVIII en que Carlos Linneo propuso su Systema Naturae no han cesado los intentos por conocer la Biodiversidad…, de la que por cierto nuestra especie, bautizada como Homo sapiens por el propio Linneo, es una recién llegada de apenas 200.000 años.

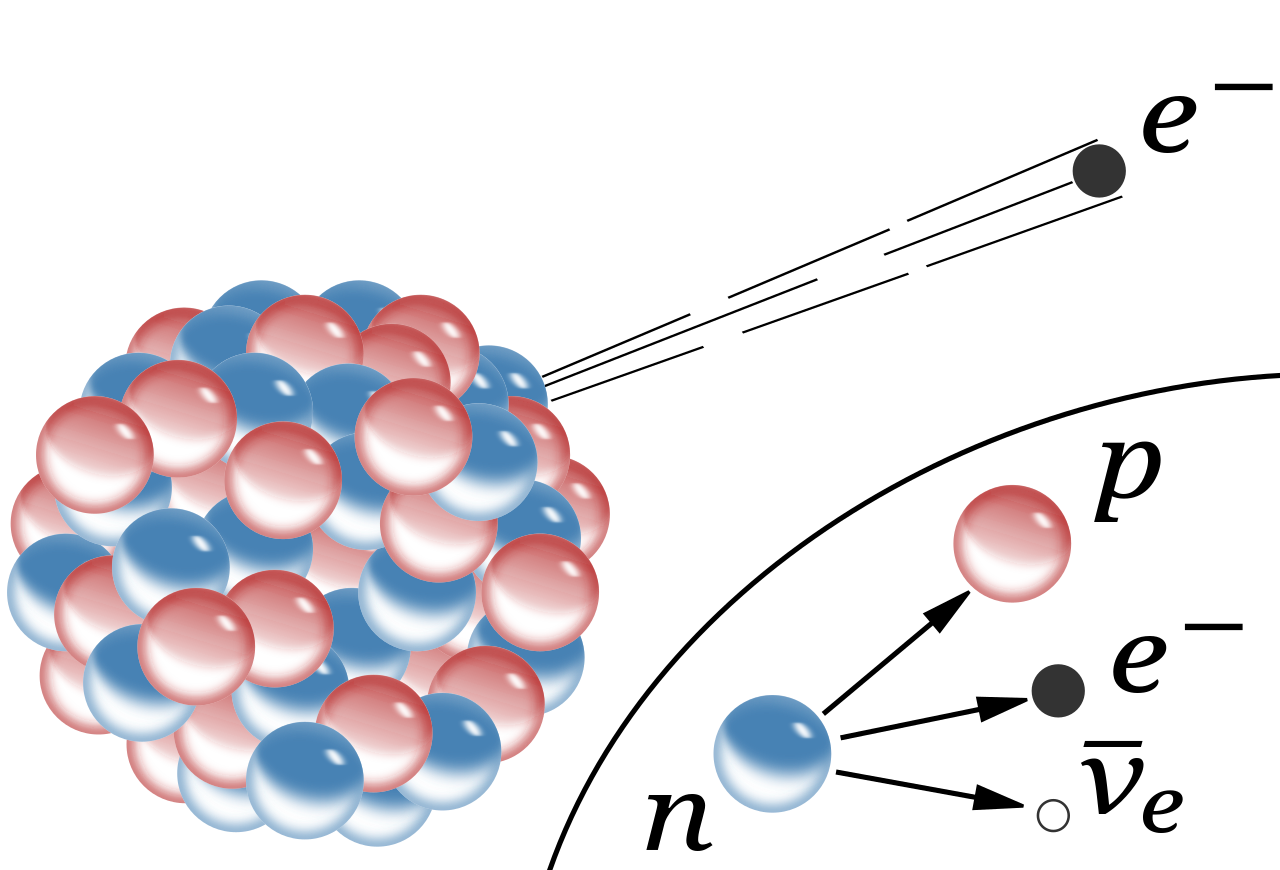

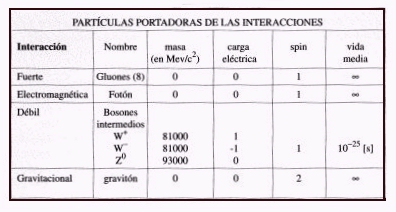

Ahora, hablaremos de la vida media de las partículas elementales (algunas no tanto). Cuando hablamos del tiempo de vida de una partícula nos estamos refiriendo al tiempo de vida media, una partícula que no sea absolutamente estable tiene, en cada momento de su vida, la misma probabilidad de desintegrarse. Algunas partículas viven más que otras, pero la vida media es una característica de cada familia de partículas.

También podríamos utilizar el concepto de “semivida”. Si tenemos un gran número de partículas idénticas, la semivida es el tiempo que tardan en desintegrarse la mitad de ese grupo de partículas. La semivida es 0,693 veces la vida media.

Si miramos una tabla de las partículas más conocidas y familiares (fotón, electrón muón tau, la serie de neutrinos, los mesones con sus piones, kaones, etc., y, los Hadrones bariones como el protón, neutrón, lambda, sigma, psi y omega, en la que nos expliquen sus propiedades de masa, carga, espín, vida media (en segundos) y sus principales maneras de desintegración, veríamos como difieren las unas de las otras.

Algunas partículas tienen una vida media mucho más larga que otras. De hecho, la vida media difiere enormemente. Un neutrón por ejemplo, vive 10¹³ veces más que una partícula Sigma⁺, y ésta tiene una vida 10⁹ veces más larga que la partícula sigma cero. Pero si uno se da cuenta de que la escala de tiempo “natural” para una partícula elemental (que es el tiempo que tarda su estado mecánico-cuántico, o función de ondas, en evolucionar u oscilar) es aproximadamente 10ˉ²⁴ segundos, se puede decir con seguridad que todas las partículas son bastantes estables. En la jerga profesional de los físicos dicen que son “partículas estables”.

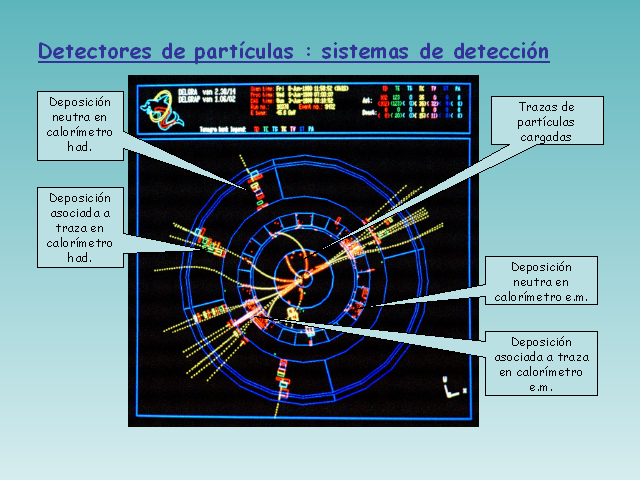

¿Cómo se determina la vida media de una partícula? Las partículas de vida larga, tales como el neutrón y el muón, tienen que ser capturadas, preferiblemente en grandes cantidades, y después se mide electrónicamente su desintegración. Las partículas comprendidas entre 10ˉ¹⁰ y 10ˉ⁸ segundos solían registrarse con una cámara de burbujas, pero actualmente se utiliza con más frecuencia la cámara de chispas. Una partícula que se mueve a través de una cámara de burbujas deja un rastro de pequeñas burbujas que puede ser fotografiado. La Cámara de chispas contiene varios grupos de de un gran número de alambres finos entrecruzados entre los que se aplica un alto voltaje. Una partícula cargada que pasa cerca de los cables produce una serie de descargas (chispas) que son registradas electrónicamente. La ventaja de esta técnica respecto a la cámara de burbujas es que la señal se puede enviar directamente a una computadora que la registra de manera muy exacta.

Una partícula eléctricamente neutra nunca deja una traza directamente, pero si sufre algún tipo de interacción que involucre partículas cargadas (bien porque colisionen con un átomo en el detector o porque se desintegren en otras partículas), entonces desde luego que pueden ser registradas. Además, realmente se coloca el aparato entre los polos de un fuerte imán. Esto hace que la trayectoria de las partículas se curve y de aquí se puede medir la velocidad de las partículas. Sin embargo, como la curva también depende de la masa de la partícula, es conveniente a veces medir también la velocidad de una forma diferente.

Una colisión entre un protón y un antiprotón registrada mediante una cámara de chispas del experimento UA5 del CERN.

En un experimento de altas energías, la mayoría de las partículas no se mueven mucho más despacio que la velocidad de la luz. Durante su carta vida pueden llegar a viajar algunos centímetros y a partir de la longitud media de sus trazas se puede calcular su vida. Aunque las vidas comprendidas entre 10ˉ¹³ y 10ˉ²⁰ segundos son muy difíciles de medir directamente, se pueden determinar indirectamente midiendo las fuerzas por las que las partículas se pueden transformar en otras. Estas fuerzas son las responsables de la desintegración y, por lo tanto, conociéndolas se puede calcular la vida de las partículas, Así, con una pericia ilimitada los experimentadores han desarrollado todo un arsenal de técnicas para deducir hasta donde sea posible todas las propiedades de las partículas. En algunos de estos procedimientos ha sido extremadamente difícil alcanzar una precisión alta. Y, los datos y números que actualmente tenemos de cada una de las partículas conocidas, son los resultados acumulados durante muchísimos años de medidas experimentales y de esa manera, se puede presentar una información que, si se valorara en horas de trabajo y coste de los proyectos, alcanzaría un precio descomunal pero, esa era, la única manera de ir conociendo las propiedades de los pequeños componentes de la materia.

Que la mayoría de las partículas tenga una vida media de 10ˉ⁸ segundos significa que son ¡extremadamente estables! La función de onda interna oscila más de 10²² veces/segundo. Este es el “latido natural de su corazón” con el cual se compara su vida. Estas ondas cuánticas pueden oscilar 10ˉ⁸ x 10²², que es 1¹⁴ o 100.000.000.000.000 veces antes de desintegrarse de una u otra manera. Podemos decir con toda la seguridad que la interacción responsable de tal desintegración es extremadamente débil.

Se habla de ondas cuánticas y también, de ondas gravitacionales. Las primeras han sido localizadas y las segundas están siendo perseguidas.

Aunque la vida de un neutrón sea mucho más larga (en promedio un cuarto de hora), su desintegración también se puede atribuir a la interacción débil. A propósito, algunos núcleos atómicos radiactivos también se desintegran por interacción débil, pero pueden necesitar millones e incluso miles de millones de años para ello. Esta amplia variación de vidas medias se puede explicar considerando la cantidad de energía que se libera en la desintegración. La energía se almacena en las masas de las partículas según la bien conocida fórmula de Einstein E = Mc². Una desintegración sólo puede tener lugar si la masa total de todos los productos resultantes es menor que la masa de la partícula original. La diferencia entre ambas masas se invierte en energía de movimiento. Si la diferencia es grande, el proceso puede producirse muy rápidamente, pero a menudo la diferencia es tan pequeña que la desintegración puede durar minutos o incluso millones de años. Así, lo que determina la velocidad con la que las partículas se desintegran no es sólo la intensidad de la fuerza, sino también la cantidad de energía disponible.

Si no existiera la interacción débil, la mayoría de las partículas serían perfectamente estables. Sin embargo, la interacción por la que se desintegran las partículas π°, η y Σ° es la electromagnética. Se observará que estas partículas tienen una vida media mucho más corta, aparentemente, la interacción electromagnética es mucho más fuerte que la interacción débil.

Durante la década de 1950 y 1960 aparecieron tal enjambre de partículas que dio lugar a esa famosa anécdota de Fermi cuando dijo: “Si llego a adivinar esto me hubiera dedicado a la botánica.”

Si la vida de una partícula es tan corta como 10ˉ²³ segundos, el proceso de desintegración tiene un efecto en la energía necesaria para producir las partículas ante de que se desintegre. Para explicar esto, comparemos la partícula con un diapasón que vibra en un determinado modo. Si la “fuerza de fricción” que tiende a eliminar este modo de vibración es fuerte, ésta puede afectar a la forma en la que el diapasón oscila, porque la altura, o la frecuencia de oscilación, está peor definida. Para una partícula elemental, esta frecuencia corresponde a su energía. El diapasón resonará con menor precisión; se ensancha su curva de resonancia. Dado que para esas partículas extremadamente inestable se miden curvas parecidas, a medida se las denomina resonancias. Sus vidas medias se pueden deducir directamente de la forma de sus curvas de resonancia.

Bariones Delta. Un ejemplo típico de una resonancia es la delta (∆), de la cual hay cuatro especies ∆ˉ, ∆⁰, ∆⁺ y ∆⁺⁺(esta última tiene doble carga eléctrica). Las masas de las deltas son casi iguales 1.230 MeV. Se desintegran por la interacción fuerte en un protón o un neutrón y un pión.

Existen tanto resonancias mesónicas como bariónicas . Las resonancias deltas son bariónicas. Las resonancias deltas son bariónicas. (También están las resonancias mesónicas rho, P).

Las resonancias parecen ser solamente una especie de versión excitada de los Hadrones estable. Son réplicas que rotan más rápidamente de lo normal o que vibran de diferente manera. Análogamente a lo que sucede cuando golpeamos un gong, que emite sonido mientras pierde energía hasta que finalmente cesa de vibrar, una resonancia termina su existencia emitiendo piones, según se transforma en una forma más estable de materia.

Por ejemplo, la desintegración de una resonancia ∆ (delta) que se desintegra por una interacción fuerte en un protón o neutrón y un pión, por ejemplo:

∆⁺⁺→р + π⁺; ∆⁰→р + πˉ; o п+π⁰

En la desintegración de un neutrón, el exceso de energía-masa es sólo 0,7 MeV, que se puede invertir en poner en movimiento un protón, un electrón y un neutrino. Un Núcleo radiactivo generalmente tiene mucha menos energía a su disposición.

El estudio de los componentes de la materia tiene una larga historia en su haber, y, muchos son los logros conseguidos y muchos más los que nos quedan por conseguir, ya que, nuestros conocimientos de la masa y de la energía (aunque nos parezca lo contrario), son aún bastante limitados, nos queda mucho por descubrir antes de que podamos decir que dominamos la materia y sabemos de todos sus componentes. Antes de que eso llegue, tendremos que conocer, en profundidad, el verdadero origen de la Luz que esconde muchos secretos que tendremos que desvelar.

Esperemos que con los futuros experimentos del LHC y de los grandes Aceleradores de partículas del futuro, se nos aclaren algo las cosas y podamos avanzar en el perfeccionamiento del Modelo Estándar de la Física de Partículas que, como todos sabemos es un Modelo incompleto que no contiene a todas las fuerzas de la Naturaleza y, cerca de una veintena de sus parámetros son aleatorios y no han sido explicados. Uno de ellos, el Bosón de Higgs, dicen que ha sido encontrado. Sin embargo, a mí particularmente me quedan muchas dudas al respecto.

emilio silvera

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Agujeros negros ~

Clasificado en Agujeros negros ~

Comments (0)

Comments (0)

Sin embargo, la imagen que acompaña a este impactante titular es una ilustración. ¿Por qué? Más detalles -incluyendo la participación española en esta gesta científica- en el interior de la noticia.

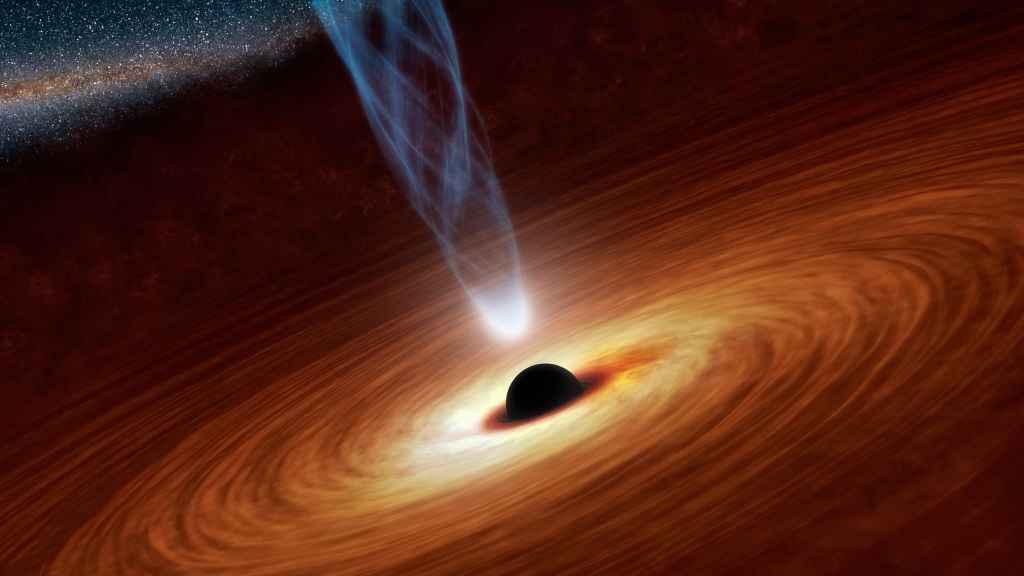

Ilustración de un agujero negro. NASA / JPL

Ilustración de un agujero negro. NASA / JPL

El titular de esta noticia anuncia que, por primera vez, se ha logrado fotografiar un agujero negro pero la imagen que lo acompaña es simplemente una ilustración. Pero eh, no se marchen todavía: esa foto existe, ha sido tomada por el Event Horizon Telescope (EHT) a lo largo de diez días y, aparentemente, representa a Sagitario A*, el agujero negro supermasivo ubicado en el centro de nuestra Vía Láctea.

La imagen, según sus responsables, está siendo sometida a investigación, pero se espera que para finales de 2017 la anhelada foto se haga pública. Por hacer un símil fotográfico, la imagen del agujero negro es como una Polaroid que tendremos que agitar durante unos meses para ver si representa con exactitud lo que queríamos fotografiar o si se ve borrosa.

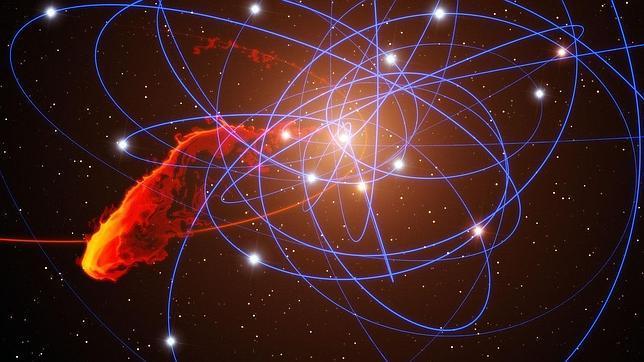

Pese a tener una masa equivalente a cuatro millones de soles, Sagitario A* fue un desconocido hasta mediados de los años setenta, cuando Bruce Balick y Robert Brown descubrieron que algo perturbaba la órbita de una estrella cercana, S2. Pese a las sospechas, no pudieron identificar inmediatamente que fuese un agujero negro.

Hubo que esperar hasta 2002, cuando el alemán Reinhard Genzel reveló que hablábamos de un agujero negro supermasivo en el centro de nuestra galaxia. “¿Pueden ser los agujeros negros y las galaxias dos sistemas que se alimentan el uno al otro con un intercambio de gas y radiación?”, declaró Genzel en entrevista con EL ESPAÑOL, “vamos teniendo evidencia ahora de que esto es así, es fascinante lo que estamos aprendiendo: parece ser una relación cercana, pero aún no sabemos si fue primero el huevo o la gallina”.

Hasta el momento, lo más cercano que tenemos para ver el citado agujero negro es esta imagen del Observatorio Europeo Austral, en el que el efecto gravitatorio de Sagitario A* lleva a una nube de polvo a moverse en dirección al agujero negro desde el punto azul (2006) al verde (2010) y finalmente al rojo (2013).

Una nube de gas desplazada del punto azul (2006) al rojo (2013) por Sagitario A*. ESO / S. Gillessen

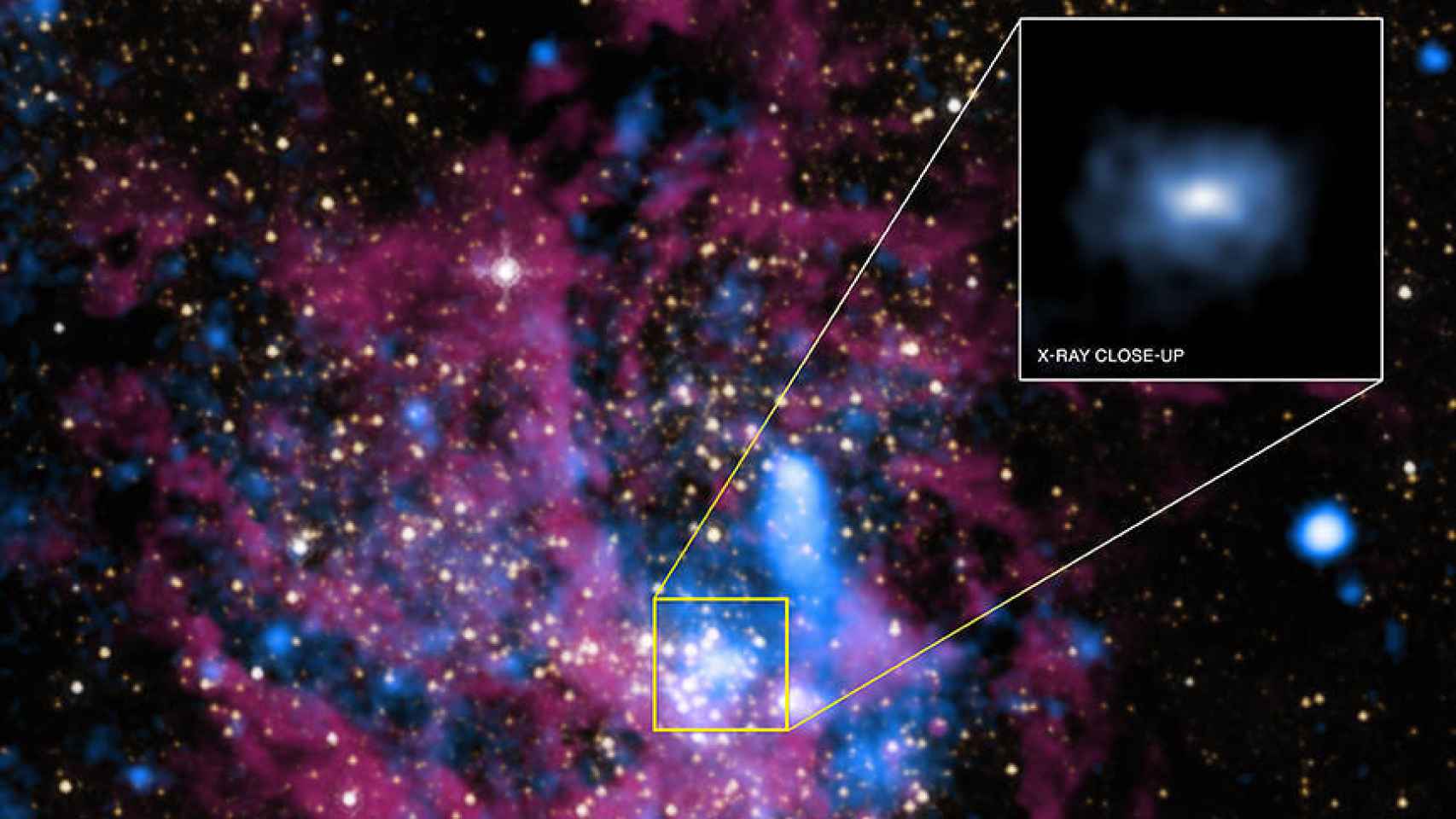

Otro reciente intento de enmarcar al esquivo agujero negro es éste, de la NASA, con telescopios de rayos X. Lo que brilla en este caso es un fogonazo de actividad que brota de las nubes de gas que rodean al agujero.

Arriba a la derecha, imagen destacada de Sagitario A*. NASA

La anhelada fotografía del agujero negro ocupa el trozo de espacio entre Sagitario A* y sus alrededores hasta la ‘cercana’ galaxia M87 y está almacenada en 4.024 discos duros. Se ha tomado desde ocho radio telescopios de alta frecuencia ubicados en altiplanos o montañas de distintas partes del mundo, entre ellos el Telescopio de 30 metros que tenemos situado en el Pico Veleta, en Sierra Nevada.

En primer lugar, porque son muy pequeños. Sagitario A* tiene una masa equivalente a cuatro millones de soles, pero su tamaño es tan sólo 17 veces mayor que nuestra estrella más cercana, y eso, a 25.000 años luz de distancia, no es nada.

A este problema hay que añadir otro, que un agujero negro es espacio vacío y que, con una concentración semejante de masa en tan poco espacio, su fuerza gravitatoria es tan grande que atrae toda la luz a su alrededor.

La combinación de varios telescopios recogiendo datos en distintos puntos del globo resolvió un problema, pero generó otro: ¿Cómo combinar tantos y tan variados conjuntos de datos sobre el espacio? Porque en realidad, si este año logramos ver finalmente la imagen de un agujero negro es gracias a un algoritmo, llamado CHIRP y generado en el Instituto Tecnológico de Massachussets (MIT) por Katie Bouman, una joven doctoranda en informática, y su equipo.

Cuando tomamos una fotografía panorámica con el móvil, lo que va haciendo la cámara es tomar distintas fotos y superponerlas como parches. CHIRP hace algo parecido, aunque con un nivel de complejidad supremo: millones de datos sobre el espacio mezclados, que se confunden con la composición de nuestra propia atmósfera y que además fueron recogidos en momentos diferentes.

Incluso si esta foto acaba siendo más cutre de lo esperado, para los astrofísicos tendrá un enorme valor porque podrá servir para comprobar si las teorías de Albert Einstein sobre la gravedad siguen siendo válidas en un espacio tan extremo como los alrededores de un agujero negro.

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (0)

Comments (0)

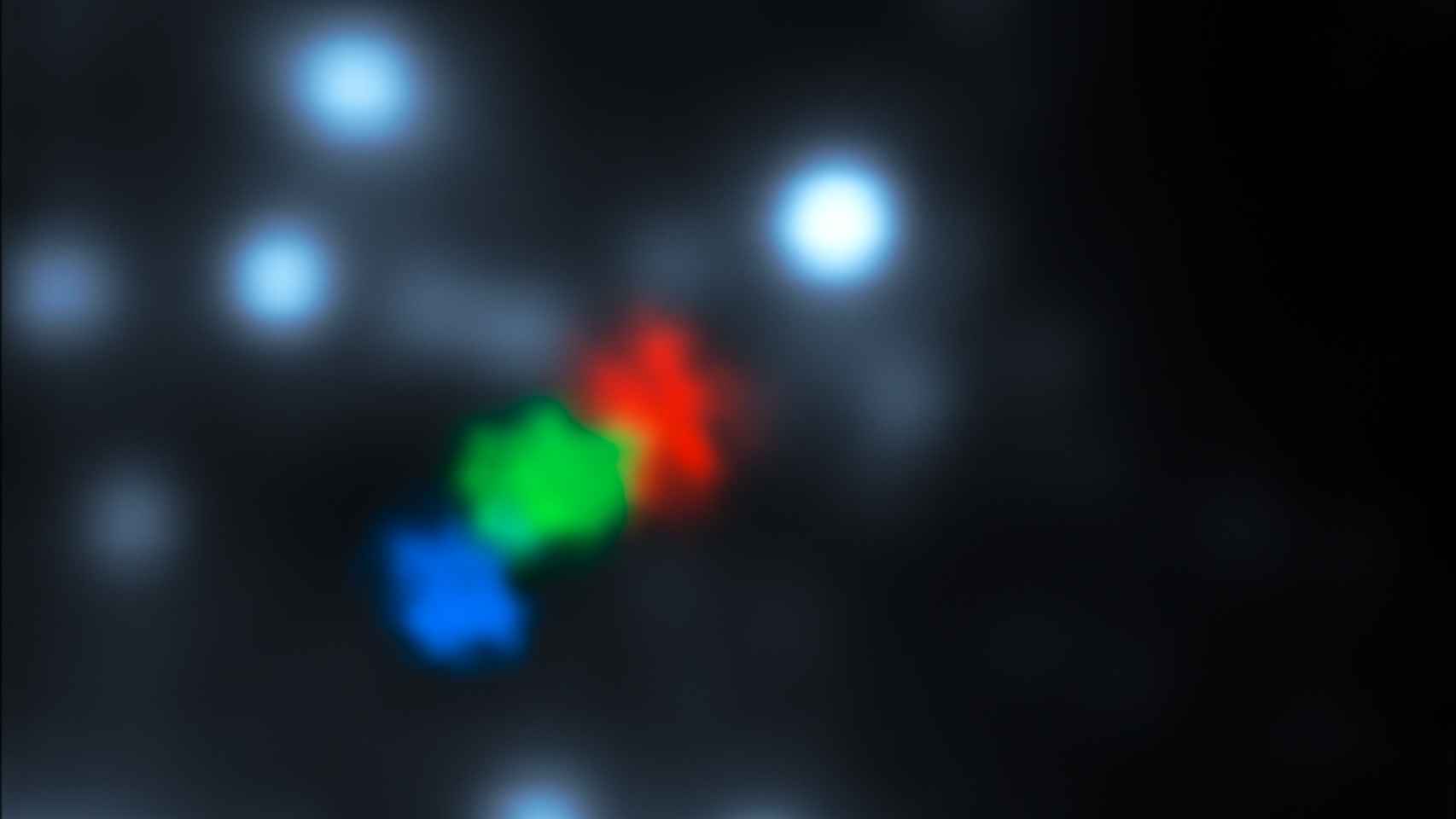

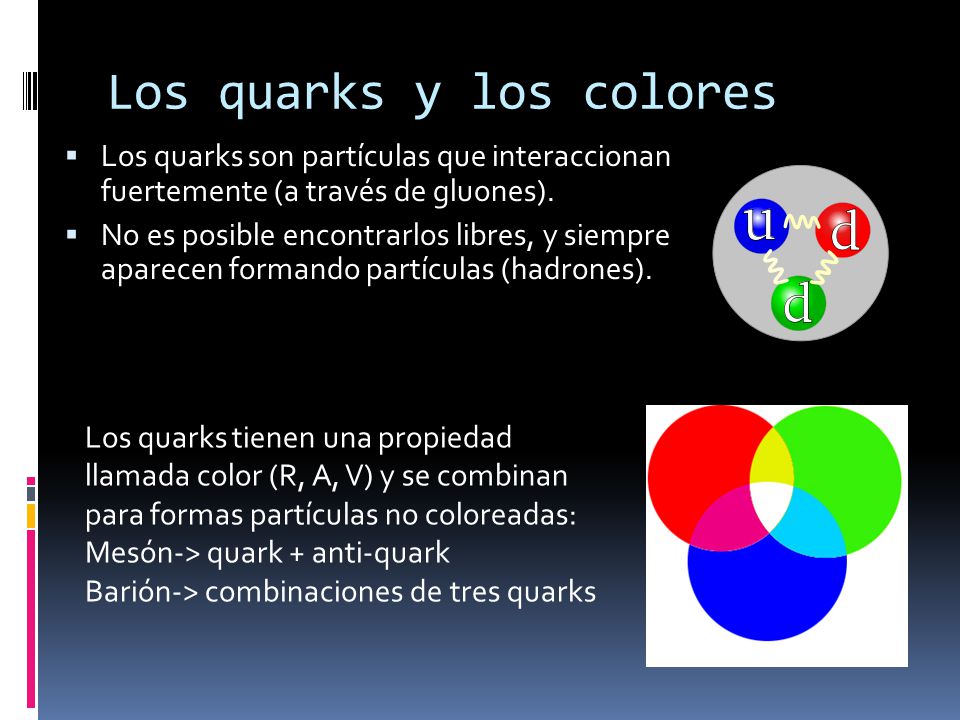

Bajo la “definición basada en quarks y leptones”, las partículas elementales y compuestas formadas de quarks (en púrpura) y leptones (en verde) serían la “materia”; mientras los bosones “izquierda” (en rojo) no serían materia. Sin embargo, la energía de interacción inherente a partículas compuestas (por ejemplo, gluones, que implica a los neutrones y los protones) contribuye a la masa de la materia ordinaria.

Esquema de una aniquilación electrón-positrón.

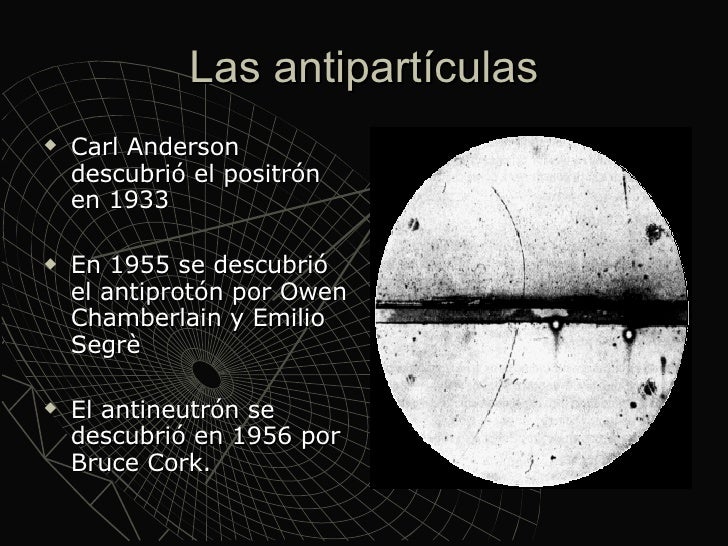

Ya hemos descrito en trabajos anteriores las dos familias de partículas elementales: Quarks y Leptones. Pero hasta ahí, no se limita la sociedad del “universo” infinitesimal. Existen además las antifamilias. A quarks y electrones se asocian, por ejemplo, antiquarks y antielectrones. A cada partícula, una antipartícula.

Uno de los primeros éxitos de la teoría relativista del campo cuántico fue la predicción de las antipartículas: nuevos cuantos que eran la imagen especular de las partículas ordinarias. Las antipartículas tienen la misma masa y el mismo spin que sus compañeras las partículas ordinarias, pero cargas inversas. La antipartícula del electrón es el positrón, y tiene, por tanto, carga eléctrica opuesta a la del electrón. Si electrones y positrones se colocan juntos, se aniquilan, liberando la energía inmensa de su masa según la equivalencia masa-energía einstrniana.

¿Cómo predijeron los físicos la existencia de antipartículas? Bueno, por la «interpretación estadística» implicaba que la intensidad de un campo determinaba la probabilidad de hallar sus partículas correspondientes. Así pues, podemos imaginar un campo en un punto del espacio describiendo la creación o aniquilación de sus partículas cuánticas con una probabilidad concreta. Si esta descripción matemática de la creación y aniquilación de partículas cuánticas se inserta en el marco de la teoría relativista del campo cuántico, no podemos contar con la posibilidad de crear una partícula cuántica sin tener también la de crear un nuevo género de partícula: su antipartícula. La existencia de antimateria es imprescindible para una descripción matemáticamente coherente del proceso de creación y aniquilación según la teoría de la relatividad y la teoría cuántica.

La misteriosa sustancia conocida como “materia oscura” puede ser en realidad una ilusión, creada por la interacción gravitacional entre partículas de corta vida de materia y antimateria. Un mar hirviente de partículas en el espacio puede crear la gravedad repulsiva.

Puede ser posible que las cargas gravitacionales en el vacío cuántico podrían proporcionar una alternativa a la “materia oscura”. La idea se basa en la hipótesis de que las partículas y antipartículas tienen cargas gravitacionales de signo opuesto. Como consecuencia, los pares de partícula-antipartícula virtuales en el vacío cuántico y sus dipolos de forma gravitacional (una carga gravitacional positivos y negativos) pueden interactuar con la materia bariónica para producir fenómenos que se suele atribuir a la materia oscura. Fue el físico del CERN, Dragan Slavkov Hajdukovic, quien propuso la idea, y demostró matemáticamente que estos dipolos gravitacionales podrían explicar las curvas de rotación de las galaxias observadas sin la materia oscura en su estudio inicial. Sin embargo, señaló que quedaba mucho por hacer.

Pero sigamos con la cuántica…

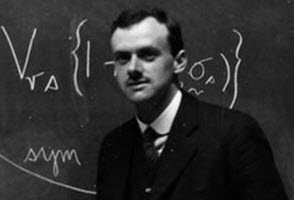

El pionero en comprender que era necesario que existiesen antipartículas fue el físico teórico Paul Dirac, que hizo varías aportaciones importantes a la nueva teoría cuántica. Fue él quien formuló la ecuación relativista que lleva hoy su nombre, y a la que obedece el campo electrónico; constituye un descubrimiento comparable al de las ecuaciones del campo electromagnético de Maxwell. Cuando resolvió su ecuación, Dirac se encontró con que además de describir el electrón tenía soluciones adicionales que describían otra partícula con una carga eléctrica opuesta a la del electrón. ¿Qué significaría aquello? En la época en que Dirac hizo esta observación, no se conocían más partículas con esta propiedad que el protón. Dirac, que no deseaba que las partículas conocidas proliferasen, decidió que las soluciones adicionales de su ecuación describían el protón.

Pero, tras un análisis más meticuloso, se hizo evidente que las partículas que describían las soluciones adicionales tenían que tener exactamente la misma masa que el electrón. Quedaba así descartado el protón, cuya masa es por lo menos, 1.800 veces mayor que la del electrón. Por tanto, las soluciones adicionales tenían que corresponder a una partícula completamente nueva de la misma masa que el electrón, pero de carga opuesta: ¡El antielectrón! Esto quedó confirmado a nivel experimental en 1932 cuando Carl Anderson, físico del Instituto de Tecnología de Calífornia, detectó realmente el antielectrón, que hoy se llama positrón.

Antes de empezar, debemos recordar que el Premio Nobel de Física de 1936 se repartió a partes iguales entre Victor Franz Hess y Carl David Anderson. Merece la pena leer la Nobel Lecture de Carl D. Anderson, “The production and properties of positrons,” December 12, 1936, quien nos explica que en esta imagen un “electrón” de 63 MeV atraviesa un placa de plomo de 6 mm y emerge con una energía de 23 MeV, pero lo hace con la curvatura “equivocada” como si fuera una partícula de carga positiva, como si fuera un protón pero con la masa de un electrón. La Nobel Lecture muestra muchas otras fotografías de positrones y electrones. Anderson afirma: “The present electron theory of Dirac provides a means of describing many of the phenomena governing the production and annihilation of positrons.”

Por otro lado, el Premio Nobel de Física de 1933 se repartió a partes iguales entre Erwin Schrödinger y Paul Adrien Maurice Dirac. También vale la pena leer la Nobel Lecture de Paul A. M. Dirac, “Theory of electrons and positrons,” December 12, 1933, aunque no cuente la historia de su descubrimiento, afirma que su ecuación predice el “antielectrón” de soslayo: ”There is one other feature of these equations which I should now like to discuss, a feature which led to the prediction of the positron.” (fuente: Francis (th)E mule Science’s News).

La aparición de las antipartículas cambió definitivamente el modo de pensar de los físicos respecto a la materia. Hasta entonces, se consideraba la materia permanente e inmutable. Podían alterarse las moléculas, podían desintegrarse los átomos en procesos radiactivos, pero los cuántos fundamentales se consideraban invariables. Sin embargo, tras el descubrimiento de la antimateria realizado por Paul Dirac hubo que abandonar tal criterio. Heisenberg lo expresaba así:

“Creo que el hecho de que Dirac haya descubierto partículas y antipartículas, ha cambiado toda nuestra visión de la física atómica… creo que, hasta entonces, todos los físicos habían concebido las partículas elementales siguiendo los criterios de la filosofía de Demócrito, es decir, considerando esas partículas elementales como unidades inalterables que se hallan en la naturaleza como algo dado y son siempre lo mismo, jamás cambian, jamás pueden transmutarse en otra cosa. No son sistemas dinámicos, simplemente existen en sí mismas. Tras el descubrimiento de Dirac, todo parecía distinto, porque uno podía preguntar: ¿por qué un protón no podría ser a veces un protón más un par electrón-positrón, etc.?… En consecuencia, el problema de la división de la materia había adquirido una dimensión distinta.”

Dado que la antimateria tiene la misma masa que la materia, es decir son de la misma magnitud y signo (la definición de masa es positiva siempre), el efecto gravitacional de la antimateria no debe ser distinto de la materia, es decir, siempre sera un efecto atractivo. Pero, ¿acaso no importa la equivalencia establecida de antipartícula viajando al futuro = partícula viajando al pasado?

Existe un “universo” que se nos escapa de la comprensión

La respuesta es sí. Dicha equivalencia proviene de algo llamado simetría CPT (Charge-Parity-Time), y nos dice que la equivalencia entre las partículas y antipartículas no solo corresponde a realizar una transformación sobre la carga, sino también sobre la paridad y el tiempo. La carga no afecta la gravedad, pero la paridad y el tiempo si la afectan. En otras palabras, al modificarse el tiempo (poner el tiempo al reves) y el espacio (la paridad es “girar” el espacio), estamos alterando el espacio-tiempo, y como la teoría general de la relatividad lo afirma, es la geometría de este el que determina la gravedad.

El carácter mutable de la materia se convirtió en piedra angular de la nueva física de partículas. El hecho de que partículas y antipartículas puedan crearse juntas a partir del vacío si se aporta energía suficiente, no sólo es importante para entender cómo se crean las partículas en aceleradores de alta energía, sino también para entender los procesos cuánticos que se produjeron en el Big Bang.

Como ya lo hemos expresado, el conocimiento que se obtuvo sobre la existencia de antifamilias de partículas o familias de antipartículas es una consecuencia de la aplicación de la teoría relativista del campo cuántico, para cada partícula existe una partícula que tiene la misma masa pero cuya carga eléctrica (y otras llamadas cargas internas) son de signo opuesto. Estas son las antipartículas. Así, al conocido electrón, con carga negativa, le corresponde un «electrón positivo» como antipartícula, llamado positrón, descubierto en 1932. El antiprotón, descubierto en 1956, tiene la misma masa que el protón, pero carga eléctrica negativa de igual valor. El fotón, que no tiene masa ni carga eléctrica, puede ser considerada su propia antipartícula.

Un agujero negro es un objeto que tiene tres propiedades: masa, espin y carga eléctrica. La forma del material en un agujero negro no se conoce, en parte porque está oculta para el universo externo, y en parte porque, en teoría, el material continuaría colapsando hasta tener radio cero, punto conocido como Singularidad, de densidad infinita.

Un agujero negro tiene tres propiedades: masa, espín y carga eléctrica. La forma del material de un agujero negro no se conoce, en parte porque está oculta para el universo externo, y en parte porque, en teoría, el material continuaría colapsando hasta tener radio cero, punto conocido como singularidad, de densidad infinita.

La luz (fotones), no son una onda distinta que un electrón o protón, etc.

1°- “No se dispersan”, no son más pequeñas, como las ondas del agua (olitas) cuando tiramos una piedrita, a medida que se alejan de su centro; sino que en el caso de la luz son menos partículas, pero son siempre el mismo tipo de onda (determinada frecuencia), igual tamaño.

2°- Las ondas con más energía son más grandes, los fotones al igual que las partículas son más pequeñas, contra toda lógica (contracción de Lorentz).

3°- No necesitan de un medio material para desplazarse. Viajan en el vacío. El medio que usan para viajar, es el mismísimo espacio.

4°- Su cualidad de onda no es diferente de las partículas. Lo podemos ver en la creación de pares y la cualidad de onda de las partículas, etc. En ningún momento la partícula, es una cosa compacta (ni una pelotita), siempre es una onda, que no se expande. En la comparación con la ola, sería como un “montón” o un “pozo” de agua, con una dirección, lo que conocemos como ecuación de Schrödinger. En ningún momento la partícula, es una pelotita; la ola sobre el agua, no es un cuerpo que se mueve sobre el agua, no es un montón de agua que viene (aunque parece), sino una deformación del agua. Así la partícula, no es un montón de algo, sino una deformación del espacio.

La curvatura está relacionadas con la probabilidad de presencia, no es una bolita que está en uno de esos puntos, sino que es una onda en esa posición. El fotón es una onda que no necesita de un medio material para propagarse, se propaga por el espacio vacío. Así como una onda de sonido es una contracción-expansión del medio en que se propaga, el fotón es una contracción-expansión del espacio (del mismísimo espacio), razón por la cual entendemos que el espacio se curva, se contrae y expande. La rigidez del medio, da la velocidad de la deformación (velocidad de la onda), en el caso de la rigidez del espacio da una velocidad “c”.Esta onda por causa de la contracción del tiempo (velocidad “c”), no se expande, sino que se mantiene como en su origen (para el observador ), como si fuese una “burbuja”, expandida o contraída, en cada parte, positiva-negativa

Cada partícula está caracterizada por un cierto número de parámetros que tienen valores bien definidos: su masa, carga eléctrica, spin o rotación interna y otros números, conocidos como cuánticos. Estos parámetros son tales que, en una reacción, su suma se mantiene y sirve para predecir el resultado. Se dice que hay conservación de los números cuánticos de las partículas. Así, son importantes el número bariónico, los diversos números leptónicos y ciertos números definidos para los quarks, como la extrañeza, color, etc. Estos últimos y sus antipartículas tienen cargas eléctricas (± 1/3 o ± 2/3) y números bariónicos (±1/3) fraccionarios. No todos los números asociados a cada partícula han sido medidos con suficiente precisión y no todas las partículas han sido detectadas en forma aislada, por lo menos de su ligamento, como el caso de

Los gluones son una especie de «partículas mensajeras» que mantienen unidos a los quarks. Su nombre proviene del término inglés “glue”, que significa pegamento, en español quizás podría ser gomón. Ahora, en cuanto a los quarks, ya hicimos referencia de ellos anteriormente. Pero recordemos aquí, que fueron

descubiertos en 1964 por Mu rray Gell-Mann, como los componentes más reducidos de la materia. Hasta entonces se pensaba que los átomos consistían simplemente en electrones rodeando un núcleo formado por protones y electrones.

rray Gell-Mann, como los componentes más reducidos de la materia. Hasta entonces se pensaba que los átomos consistían simplemente en electrones rodeando un núcleo formado por protones y electrones.

En estado natural, quarks y gluones no tienen libertad. Pero si se eleva la temperatura a niveles 100.000 veces superiores, como se ha hecho en aceleradores de partículas, a la del centro del Sol, se produce el fenómeno del desconfinamiento y por un brevísimo tiempo quedan libres. En ese preciso momento aparece lo que se suele llamar plasma, «una sopa de quarks y gluones» que equivale al estado en que se podría haber encontrado la naturaleza apenas una milésima de segundo luego del Big Bang.

Recientemente se ha descubierto un nuevo estado de la materia, esta vez a niveles muy altos de energía, que los científicos han denominado Plasma Gluón-Quark. La transición ocurre a temperaturas alrededor de cien mil millones de grados y consiste en que se rompen las fuertes ligaduras que mantienen unidos los quarks dentro de los núcleos atómicos. Los protones y neutrones están formados, cada uno, por 3 quarks que se mantienen unidos gracias a los gluones (El gluón es la partícula portadora de interacción nuclear fuerte, fuerza que mantiene unida los núcleos atómicos). A temperaturas superiores se vence la fuerza nuclear fuerte y los protones y neutrones se dividen, formando esta sopa denominada plasma Gluón-Quark.

Pero por ahora aquí, nos vamos a quedar con los quarks al natural. Normalmente, los quarks no se encuentra en un estado separados, sino que en grupos de dos o tres. Asimismo, la duración de las vidas medias de las partículas, antes de decaer en otras, es muy variable (ver tablas).

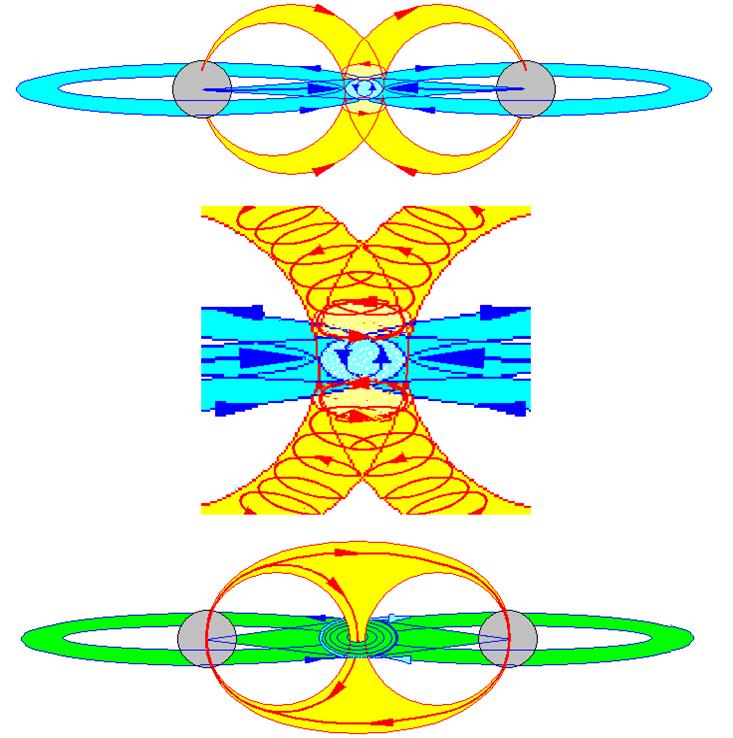

Por otra parte, las partículas presentan una o más de las siguientes interacciones o fuerzas fundamentales entre ellas. Por un lado se tiene la gravitación y el electromagnetismo, conocidas de la vida cotidiana. Hay otras dos fuerzas, menos familiares, que son de tipo nuclear y se conocen como interacciones fuertes y débiles.

La gravitación afecta a todas las partículas, es una interacción universal. Todo cuerpo que tiene masa o energía está sometido a esta fuerza. Aunque es la más débil de las interacciones, como las masas son siempre positivas y su alcance es infinito, su efecto es acumulativo. Por ello, la gravitación es la fuerza más importante en cosmología.

Los campos magnéticos están presentes por todo el Universo

La fuerza electromagnética se manifiesta entre partículas con cargas eléctricas. A diferencia de las demás, puede ser de atracción (entre cargas de signos opuestos) o de repulsión (cargas iguales). Esta fuerza es responsable de la cohesión del átomo y las moléculas. Mantiene los objetos cotidianos como entidades con forma propia. Un vaso, una piedra, un auto, el cuerpo humano. Es mucho más fuerte que la gravitación y aunque es de alcance infinito, las cargas de distinto signo se compensan y sus efectos no operan a grandes distancias. Dependiendo de las circunstancias en que actúen, estas interacciones pueden manifestarse como fuerzas eléctricas o magnéticas solamente, o como una mezcla de ambos tipos.

La Fuerza Nuclear Débil: otra fuerza nuclear, considerada mucho más débil que la Fuerza Nuclear Fuerte. El fenómeno de decaimiento aleatorio de la población de las partículas subatómicas (la radioactividad) era difícil de explicar hasta que el concepto de esta fuerza nuclear adicional fue introducido.

La interacción nuclear débil es causa de la radioactividad natural y la desintegración del neutrón. Tiene un rol capital en las reacciones de fusión del hidrógeno y otros elementos en el centro de las estrellas y del Sol. La intensidad es débil comparada con las fuerzas eléctricas y las interacciones fuertes. Su alcance es muy pequeño, sólo del orden de 10-15 cm.

La interacción fuerte es responsable de la cohesión de los núcleos atómicos. Tiene la intensidad más elevada de todas ellas, pero es también de corto alcance: del orden de 10-13 cm. Es posible caracterizar las intensidades de las interacciones por un número de acoplamiento a, sin dimensión, lo que permite compararlas directamente:

Fuerte as = 15

Electromagnéticas a = 7,3 x 10-3

Débil aw 3,1 x 10-12

Gravitacional aG = 5,9 x 10-39

Por otro lado, la mecánica cuántica considera que la interacción de dos partículas se realiza por el intercambio de otras llamadas «virtuales». Tienen ese nombre porque no son observables: existen por un tiempo brevísimo, tanto más corto cuanto mayor sea su masa, siempre que no se viole el principio de incertidumbre de Heisenberg de la teoría cuántica (que en este contexto dice que el producto de la incertidumbre de la energía por el tiempo de vida debe ser igual o mayor que una constante muy pequeña). Desaparecen antes de que haya tiempo para que su interacción con otras partículas delate su existencia.

El fotón virtual común se desplaza hacia la partícula menos energética.

Dos partículas interactúan al emitir una de ellas una partícula virtual que es absorbida por la otra. Su emisión y absorción cambia el estado de movimiento de las originales: están en interacción. Mientras menos masa tiene la partícula virtual, más lejos llega, mayor es el rango de la interacción. El alcance de la interacción es inversamente proporcional a la masa de la partícula portadora o intermedia. Por ejemplo, la partícula portadora de la fuerza electromagnética es el fotón, de masa nula y, por lo tanto, alcance infinito. La interacción gravitacional también tiene alcance infinito y debe corresponder a una partícula de masa nula: se le denomina gravitón. Naturalmente tiene que ser neutro. (Aún no ha sido vistos ni en pelea de perros).

Como ya hicimos mención de ello, a las fuerzas nucleares se les asocian también partículas portadoras. Para la interacción débil estas partículas se llaman bosones intermedios, expresados como W+, W- y Zº (neutro). El W- es antipartícula del W+. Los W tienen masas elevadas comparadas con las otras partículas elementales. Lo de bosones les viene porque tienen spin entero, como el fotón y el gravitón, que también los son, pero que tienen masas nulas. Las fuerzas fuertes son mediadas por unas partículas conocidas como gluones, de los cuales habría ocho. Sin embargo, ellos no tienen masa, pero tienen algunas de las propiedades de los quarks, que les permiten interactuar entre ellos mismos. Hasta ahora no se han observado gluones propiamente tal, ya que lo que mencionamos en párrafos anteriores corresponde a un estado de la materia a la que llamamos plasma. Claro está, que es posible que un tiempo más se puedan detectar gluones libres cuando se logre aumentar, aún más, la temperatura, como está previsto hacerlo en el acelerador bautizado como “Relativistic Heavy Ion Collider”, empotrado en Estados Unidos de Norteamérica.

TABLA DE LAS PRINCIPALES PROPIEDADES DE LAS PARTÍCULAS PORTADORAS DE LAS INTERACCIONES FUNDAMENTALES

Una partícula y su antipartícula no pueden coexistir si están suficientemente cerca como para interactuar. Si ello ocurre, ellas se destruyen mutuamente: hay aniquilación de las partículas. El resultado es radiación electromagnética de alta energía, formada por fotones gamma. Así, si un electrón está cercano a un positrón se aniquilan en rayos gamma. Igual con un par protón-antiprotón muy próximos.

La reacción inversa también se presenta. Se llama «materialización o creación de partículas» de un par partícula-antipartícula a partir de fotones, pero se requieren condiciones físicas rigurosas. Es necesario que se creen pares partícula-antipartícula y que los fotones tengan una energía mayor que las masas en reposo de la partículas creadas. Por esta razón, se requieren fotones de muy alta energía, de acuerdo a la relación de Einstein E=mc2 . Para dar nacimiento a electrones/positrones es necesario un campo de radiación de temperaturas mayores a 7×109 °K. Para hacer lo mismo con pares protón/antiprotón es necesario que ellas sean superiores a 2×1012 °K. Temperaturas de este tipo se producen en los primeros instantes del universo.

Se detectan grandes emisiones de rayos gamma en explosiones supernovas y otros objetos energéticos

Los rayos gamma están presentes en explosiones de supernovas, colisión de estrellas de neutrones… Todos los sucesos de altas energías los hace presente para que nuestros ingenios los detecten y podamos conocer lo que la materia esconde en lo más profundo de sus “entrañas”. Aún no hemos podido conocer en profundidad la materia ni sabemos, tampoco, lo que realmente es la luz.

emilio silvera