Hay veces en las que nos cuentan cosas y hechos de los que nunca hemos tenido noticias y, resultan del máximo interés. Nuestra curiosidad nos llama a desentrañar los misterios y secretos que, tanto a nuestro alrededor, como en las regiones más lejanas del Universo, puedan haber ocurrido, puedan estar sucediendo ahora, o, en el futuro pudieran tener lugar, ya que, de alguna manera, todas ellas tienen que ver con nosotros que, de alguna manera, somos parte de la Naturaleza, del Universo y, lo que sucedió, lo que sucede y lo que sucederá… ¡Nos importa!

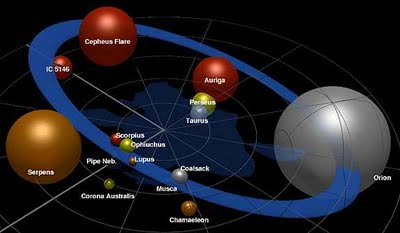

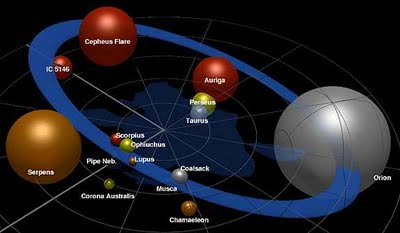

Cinturón de Gould. La linea indicada como 500 PC (500 Parsecs) equivales a una distancia al Sol (en el centro) de 1.630 años-luz que son 31.000 billones de kilómetros. Las distancias del Espacio no son Humanas, nosotros, aunque estamos y formamos parte del mundo, del Universo, en realidad, no hemos llegado a poder asimilar distancias como las que, en el Cosmos, podemos constatar.

El Cinturón de Gould es un sector del Brazo de Orión. El Brazo de Orión es la primera gran estructura a la que pertenecemos; grande en sentido galáctico. Es un larguísimo arco estelar de 10.000 años-luz de longitud y 3.500 de ancho. Mucho más del 99% de lo que ven nuestros ojos a simple vista, en una noche normal, está aquí. Muchas personas de ciudad vivirán y morirán sin ver en persona nada más allá del Brazo de Orión.

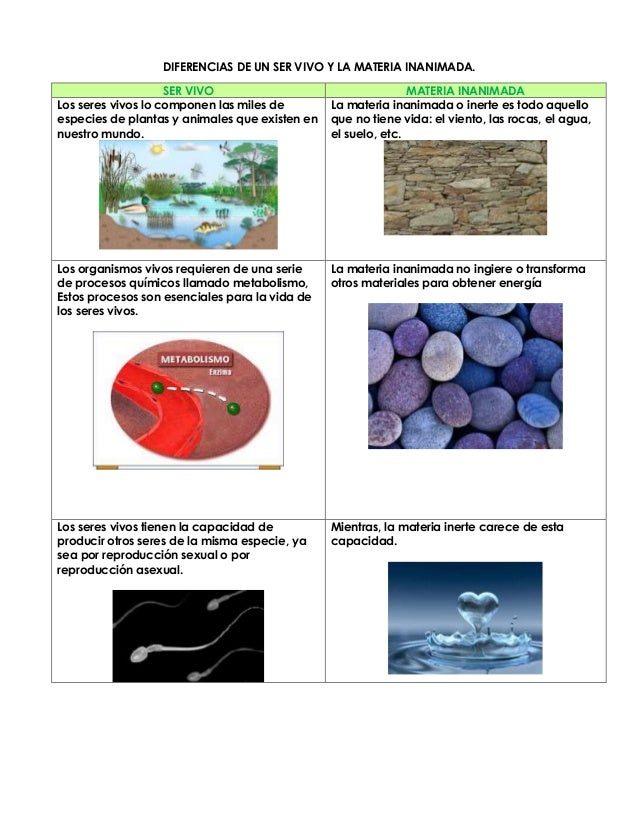

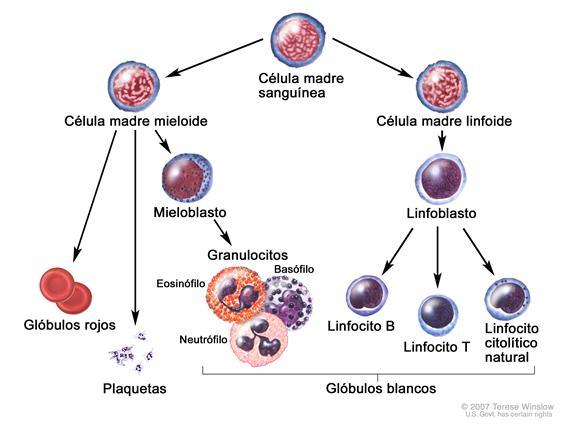

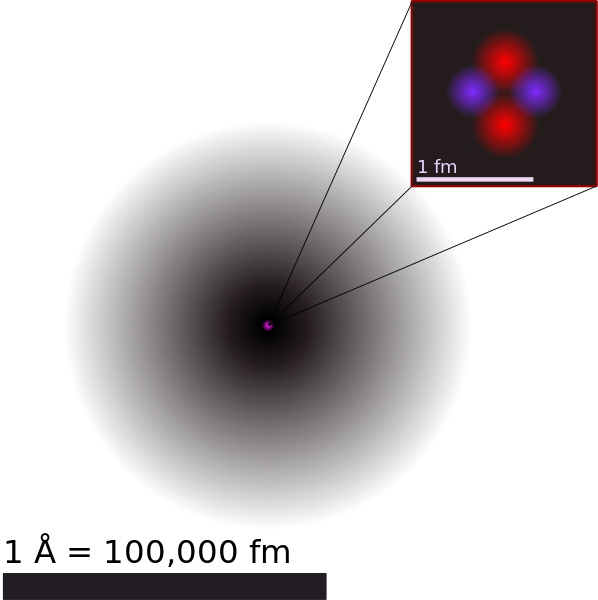

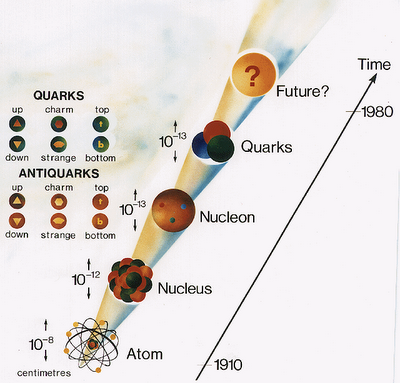

Se ha discutido, argumentado y teorizado sobre la vida durante siglos, quizás milenios. Lo que conocemos como vida es ni más ni menos que una estructura formada de átomos que se han organizado y que lograron crear mecanismos que les permiten mantener esa organización. Decir que los átomos “se han organizado” es una locura. En el mundo material no hay nada más básico que un átomo, y algo tan básico no es capaz de hacer algo tan complejo como “organizarse”.

¿O sí?

Una célula es un sistema muy complejo (célula animal)

La realidad es que sí. Los átomos, en cumplimiento de leyes físicas simples, se organizan en estructuras. La más sencilla es una molécula, que puede estar formada por algunos átomos, pero se llega a estructuras bastante complejas y ordenadas, como los cristales y fibras

naturales y maravillosas formas como las buckyballs.  Buckyballs es el nombre coloquial utilizado para describir un fullereno. Los avances logrados por la Humanidad, son tan grandes que, estando a nuestro alrededor, no somos conscientes de su verdadero alcance.

Buckyballs es el nombre coloquial utilizado para describir un fullereno. Los avances logrados por la Humanidad, son tan grandes que, estando a nuestro alrededor, no somos conscientes de su verdadero alcance.

Nanomateriales aplicados a dispositivos electrónicos y los tres tipos de geometrías de nanotubos de carbono

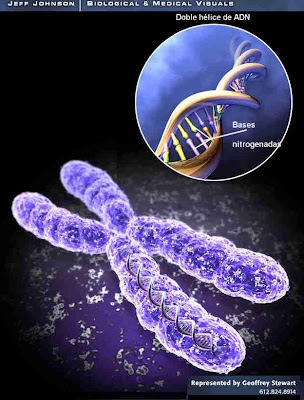

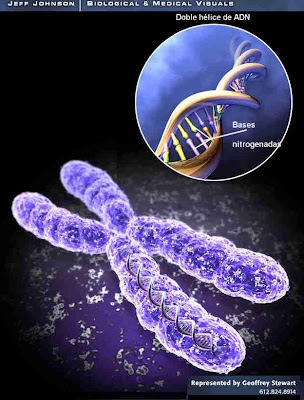

Los avances fueron de hecho tan espectaculares que hacia mediados del siglo XX ya se había dado respuesta a todas las cuestiones sencillas. Conceptos tales como la teoría general de la relatividad y la mecánica cuántica explicaron el funcionamiento global del universo a escalas muy grandes y muy pequeñas respectivamente, mientras el descubrimiento de la estructura del ADN y el modo en que éste se copia de una generación a otra hizo que la propia vida, así como la evolución, parecieran sencillas a nivel molecular. Sin embargo, persistió la complejidad del mundo a nivel humano –al nivel de la vida-. La cuestión más interesante de todas, la que planteaba cómo la vida pudo haber surgido a partir de la materia inerte, siguió sin respuesta.

Un descubrimiento así no podía dejar al mundo indiferente. En unos años el mundo científico se puso al día y la revolución genética cambió los paradigmas establecidos. Mucha gente aún no está preparada para aceptar el comienzo de una era poderosa en la que el ser humano tiene un control de sí mismo mayor al habitual. Había nacido la Ingeniería genética. No debe extrañarnos que sea precisamente a escala humana donde se den las características más complejas del universo.

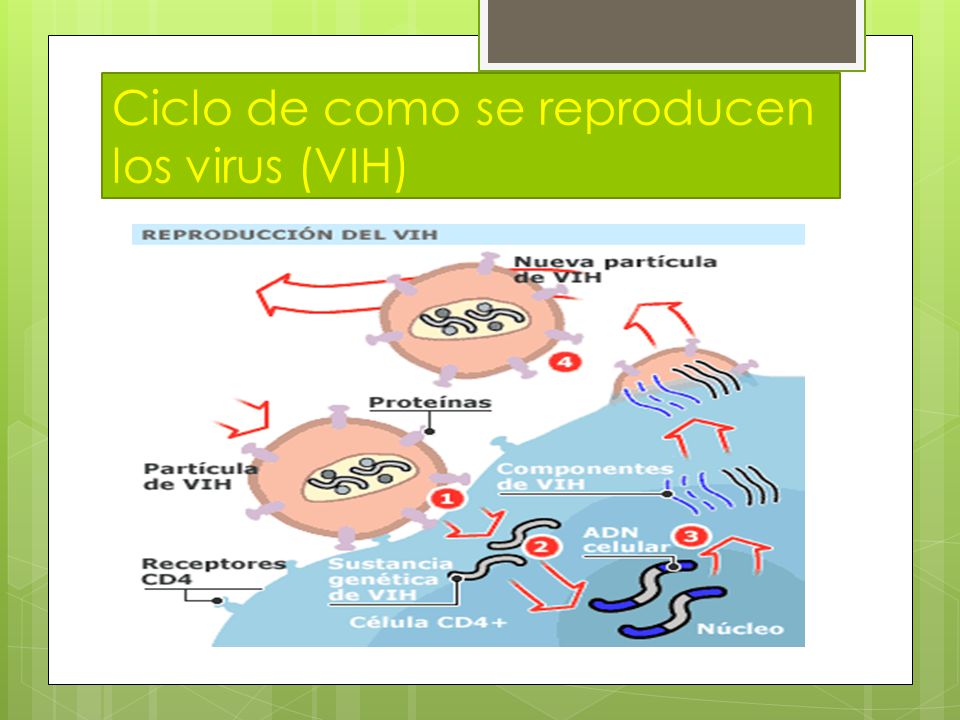

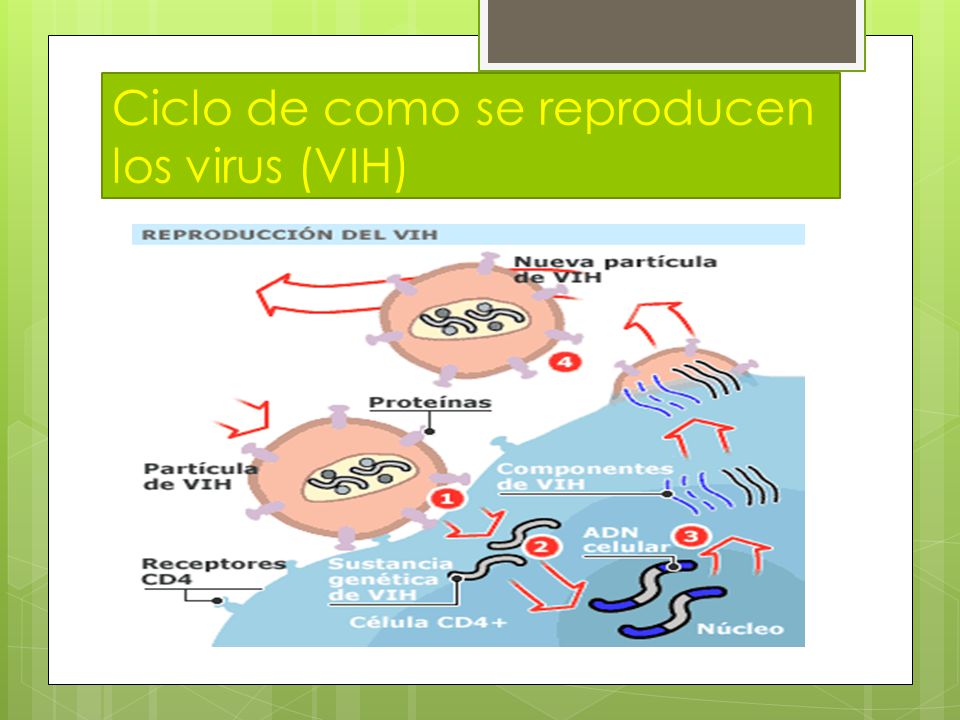

Los virus son parásitos de las células vivas y viven dentro o sobre los organismos como huésped

Claro que nada de esto se aproxima al nivel de organización que implica la vida. Recordemos ahora la parte de la frase sobre los átomos que dice “lograron crear mecanismos”, lo cual jamás puede ser cierto… al menos no en la forma directa que uno se imagina al primer momento. Un virus, por ejemplo, es una especie de “máquina” capaz de propagarse. No de reproducirse, al menos no en el sentido que se le da a la palabra en biología, pero sí de activar un mecanismo que permite obtener copias de sí mismo.

Los virus infectan tanto células como bacterias porque no pueden multiplicarse por sí mismos. Al hacerlo, usan las moléculas y enzimas de su desafortunado hospedero para replicar su genoma y construir sus cápsulas virales, las cuales son muy parecidas a unas sondas espaciales pero que, en este caso, sólo transportan ADN o ARN con el único fin de repetir el ciclo en otra víctima.

Antes de seguir quiero hacer una salvedad: todo lo que diga encontrará alguien para discutirlo. Los conceptos básicos que se aplican a la vida aún no están del todo definidos. Por ejemplo, sé que hay corrientes de pensamiento para las cuales los virus no son seres vivos. De acuerdo, sólo es cuestión de definiciones, y no es necesario —ni posible— discutirlas aquí. Yo prefiero incluir a los virus en este análisis porque son algo así como el primer nivel de estructura a discutir (sí, sé que existen estructuras menores, pero no con tanta entidad).

Siguiendo en la línea que venía, la cuestión es que parece haber una barrera entre el nivel de organización que pueden alcanzar los átomos por leyes simples de la física y la estructura que presenta la vida. ¿Es esto cierto? Da para discutir mucho, pero creo, en base a muchas líneas de investigación y descubrimientos que se vienen presentando, que no. La estructuración de la vida es gradual. De un evento físico no surge una célula ni, mucho menos, un ratón, pero la realidad es que cada uno de los pasos intermedios que llevan desde un amasijo de átomos a una de estas formas de vida son dados por fenómenos que tienen que ver con la física, la química y… la propia orientación de lo que es la vida. Digamos que la vida, una vez aparecida, crea un entorno de leyes propias que impulsan su desarrollo. ¿Cómo y por qué se crean estas leyes, en base a qué voluntad? Ninguna. (Y aquí surgirán de nuevo las discusiones.) Simplemente, no puede existir la vida sin esas leyes. El hecho de que estemos en un planeta que tenga vida por doquier, y muy desarrollada, es porque la vida, cuando existe, sigue estas reglas que le permiten desarrollarse, y si no las sigue desaparece. Es como decir que hay leyes físicas, leyes básicas del universo, que han sido puestas especialmente para la vida. De hecho, considerando la vida una forma de la materia, creo que es así. Es decir, la vida —cumpliendo los requisitos— sería algo inevitable en el Universo…

Kepler-16b, un mundo que orbita dos soles (NASA).

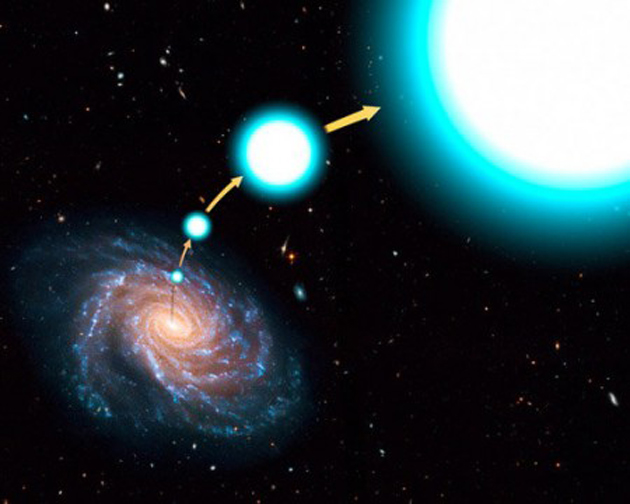

Kepler A y Kepler B son dos astros con el 69% y el 20% de la masa del Sol respectivamente, mientras que Kepler-16b es un exosaturno que tiene 0,33 veces la masa de Júpiter. Posee un periodo de 229 días y se halla situado a 105 millones de kilómetros del par binario, la misma distancia que separa a Venus del Sol en nuestro Sistema Solar. Pero debido a que Kepler-16 AB son dos estrellas relativamente frías, la temperatura “superficial” de este gigante gaseoso ronda unos gélidos 170-200 K dependiendo de la posición orbital. Es decir, nada que ver con el infierno de Venus. Otros mundos, más parecidos a nuestra Tierra, ¿por qué no tendrían formas de vida? Lo lógico es pensar que sí, que albergue la vida más o menos inteligente y conforme se haya producido su evolución.

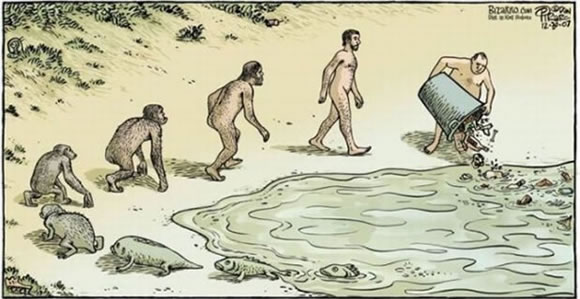

Me estoy extendiendo fuera del tema. No pretendo estudiarlo filosóficamente, sino usar un poco de lógica para llegar a una respuesta para una pregunta que se hacen los científicos, y que nos hacemos todos, excepto aquellos que quieren creer en entidades superiores que se ocuparon de ello (lo cual es, simplemente, pasar el problema a otro nivel, sin resolverlo): ¿Cómo es que la vida evolucionó desde átomos, moléculas, células, seres simples, a una especie como la nuestra, tan tremendamente compleja y capaz de, como lo estoy haciendo yo, reflexionar sobre sí misma, transmitirlo y, además, cambiar el mundo como lo estamos cambiando?

Lo estamos cambiando de muchas maneras. Estuve pensando que, si se prueba que es cierta, esta teoría de los georreactores planetarios se debe aplicar a todos los cuerpos planetarios del universo. Estoy seguro de que ustedes deben conocer la ecuación de Drake (1) que intenta estimar el número de inteligencias que podrían existir en el universo, algo que se tiene en gran consideración en el SETI. ¿Se debería agregar un nuevo valor a esta fórmula que represente el tiempo esperado de vida del georreactor en un planeta tipo Tierra? Quizá en el núcleo de los planetas que forman ese escudo magnético a su alrededor, esté el secreto del surgir de la vida en ellos.

(1) Hoy ha sido refinada y está más ajustada a lo que podría ser.

Con los datos que tenemos en las manos, sabiendo que existen miles de millones de estrellas como el Son, del tipo G2V que están orbitadas por planetas (algunos como el nuestro), negar la posibilidad de que en ellos exista la vida… ¡Es dejar de lado la lógica!

Yo creo en una cosa, y esto puede desatar miles de discusiones: llegar desde materiales básicos a la creación del ser humano se basó en juntar los materiales (átomos), tener las leyes físicas actuando y a la casualidad (o azar). ¿Qué quiero decir con “casualidad”? Que la existencia de la vida está ligada a un sorteo permanente. Que hay una enormidad de cosas que son necesarias para que pueda haber vida (es innegable que se han dado en este planeta) y para que pueda continuar una vez producida. Que fue necesario un transcurso determinado de hechos y situaciones para que los microorganismos aparecieran, se propagaran, compitieran y se fueran haciendo más y más complejos. Que se debieron dar infinidad de circunstancias para que estos organismos se convirtieran en estructuras multicelulares y para que estas estructuras se organizaran en órganos ubicados dentro de seres complejos. Y que se necesitaron enormidad de coincidencias y hechos casuales para que las condiciones llevaran a algunos de estos seres terrestres, vertebrados, pequeños mamíferos (por los cuales durante una enormidad de tiempo ningún juez cósmico hubiese apostado), a evolucionar para convertirse en los animales que más influimos en este mundo: nosotros.

En un Universo inmenso, encontrar planetas habitados… ¡No será nada fácil! Lo cual nos lleva a la frustración si tenemos en cuenta que, sólo en nuestra Galaxia, serán miles y cientos de miles pero… ¡Las distancias!

La cantidad de circunstancias, situaciones y condiciones en juego es enorme. En un libro muy interesante de Carl Sagan, anterior a Cosmos, llamado Vida inteligente en el Cosmos (junto a I. S. Shklovskii), se plantea muy bien este tema. Se puede encontrar allí una enumeración de las condiciones que requiere la vida y una especie como la nuestra para existir. Desde las características de nuestra galaxia, su edad, composición, situación, forma; a las de nuestro Sol, su sistema de planetas, la ubicación de la Tierra, su tamaño, su rotación, su inclinación, su composición, los vecinos que tiene… y mucho más.

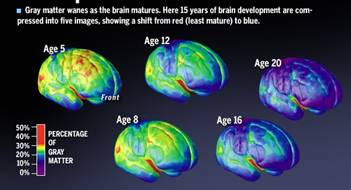

Llegar a esta red compleja que es nuestra mente, ha costado, más de diez mil millones de años, el tiempo que necesitaron las estrellas para fabricar esos elementos de los que estamos hechos. El suministro de datos que llega en forma de multitud de mensajes procede de los sentidos, que detectan el entorno interno y externo, y luego envía el resultado a los músculos para dirigir lo que hacemos y decimos. Así pues, el cerebro es como un enorme ordenador que realiza una serie de tareas basadas en la información que le llega de los sentidos. Pero, a diferencia de un ordenador, la cantidad de material que entra y sale parece poca cosa en comparación con la actividad interna. Seguimos pensando, sintiendo y procesando información incluso cuando cerramos los ojos y descansamos. Pero sigamos.

Yo voy a agregar algunas cosas que me parecen significativas, que han surgido de los últimos descubrimientos y observaciones. Enumero algunas, aunque ya verán que hay más. Extinciones y cambios físicos producidos por impactos de asteroides; influencia de estrellas cercanas, fijas y viajeras; el “clima” interestelar; el “clima” galáctico; las circunstancias que han sufrido los otros planetas; nuestras circunstancias, nada comunes…

Extinciones

Grandes rocas errantes pululan por el Sistema Solar. Los asteroides no son ni cosa del pasado ni riesgos de muy baja probabilidad. Hay pruebas muy concretas sobre diversos impactos de consideración sobre nuestro mundo y, no hace mucho, tuvimos un ejemplo de ello. Encima, hasta parecen tener una regularidad. No es sólo que tenemos la suerte de que en los últimos 10 millones de años no haya caído un gran asteroide en la Tierra, lo que nos hubiese hecho desaparecer incluso antes de que apareciéramos, sino que tenemos la suerte de que antes de eso sí cayeron de esos asteroides, y de que cambiaran las cosas a nuestro favor. ¿Estaríamos aquí si no hubiese impactado un cuerpo de unos 10 km de diámetro en el Caribe, más precisamente sobre el borde de la península de Yucatán, y hubiese producido una hecatombe para quienes reinaban en el mundo en esa época, los dinosaurios? ¿Quién puede saberlo? ¿Y si no hubiesen ocurrido las extinciones anteriores, fueran por las causas que fueran, estaríamos aquí? Quizás un día se sepa lo suficiente como para simular en computadoras una ecología planetaria entera y ver qué hubiera pasado. Será muy interesante.

Los asteroides cayeron, es un hecho. Y forman parte de las condiciones necesarias —algunos discutirán que no— para que estemos aquí… Veamos algunas nuevas informaciones:

Los Amonites fueron contemporáneos de los Dinosaurios. Los amonites eran una de las clases de moluscos cefalópodos que existieron en las eras del Devónico hasta el Cretácico. Hay de diferentes tipologías según la profundidad en la que estaban inmersos, dependiente las distintas zonas de todo el mundo. Al ser un fósil, poco se puede saber de las partes blandas de este organismo marino, suponiéndose que fueron similares a los actuales nautilos, cuyo cuerpo constaba de una corona de tentáculos en la cabeza que asoman por la abertura de la llamada concha. El fósil encontrado en las cercanías de El Chaltén pertenecería al cretácico inferior del estrato llamado Río MAYER, con una antigüedad de unos 500 millones de años.

Vivieron en la Tierra como duelo y selñores más de 150 millones de años.

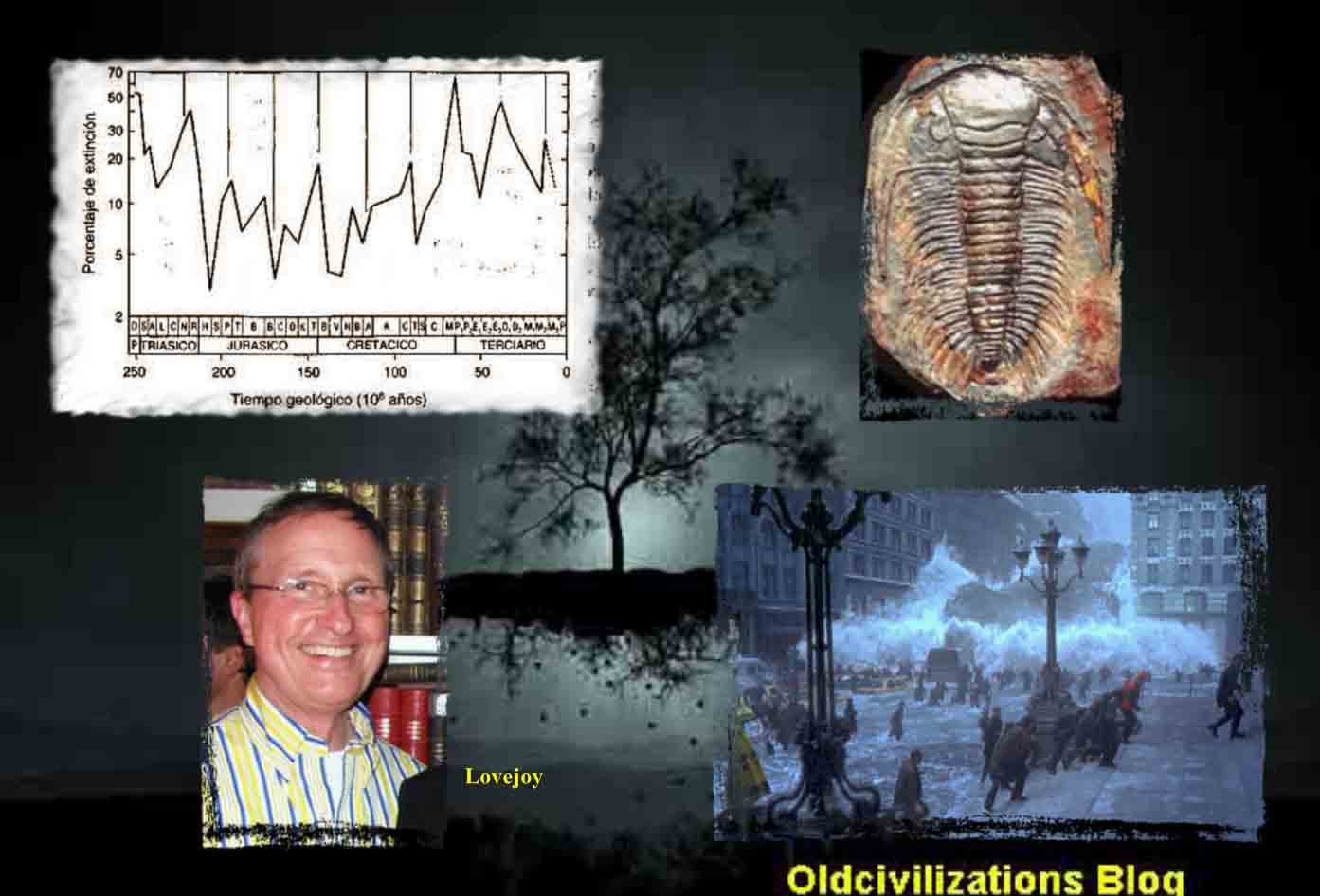

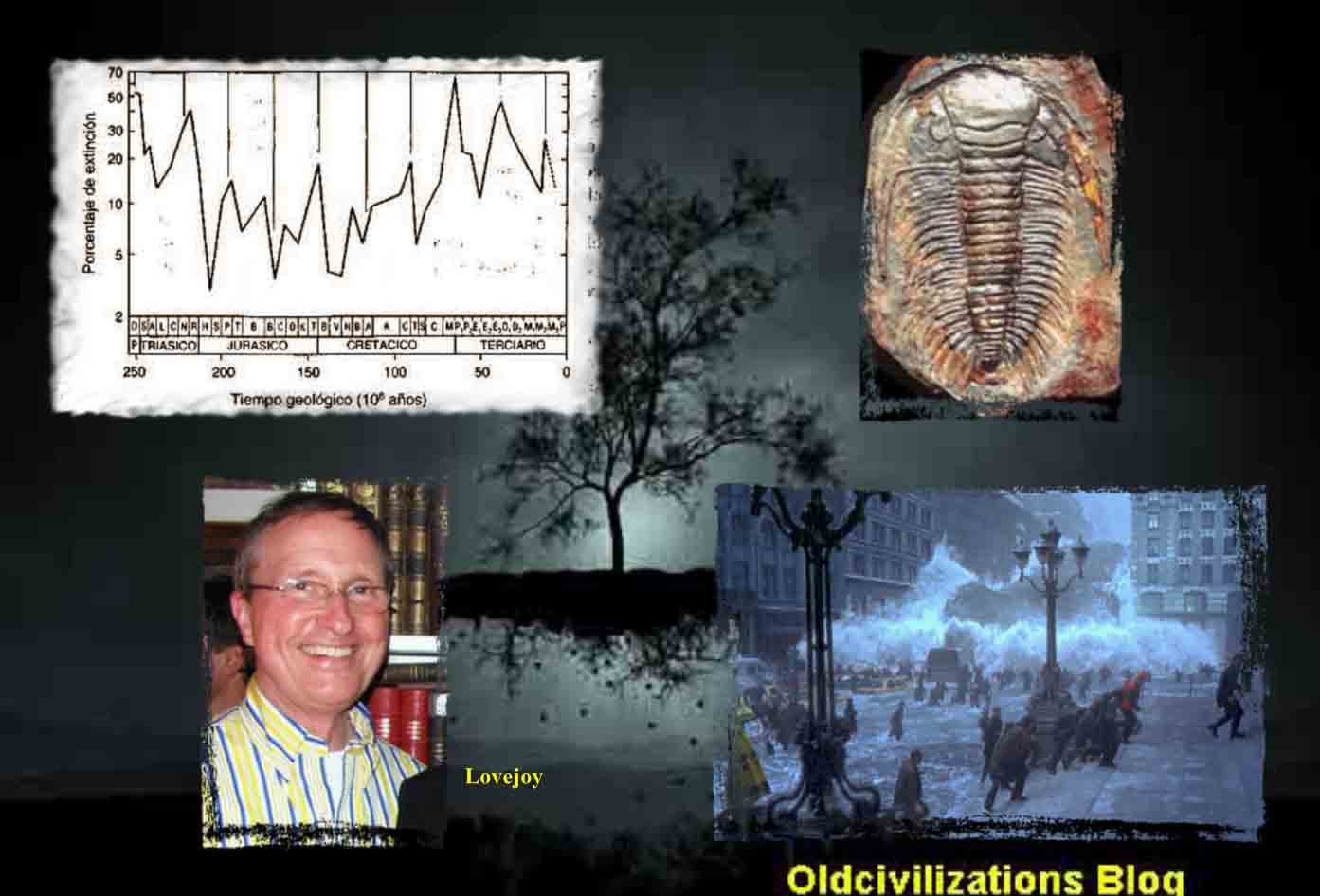

Hace 380 millones de años se produjo una importante extinción entre los animales que poblaban el mar, en especial de los amonites, unos moluscos emparentados con los pulpos y calamares pero cubiertos con una concha espiralada y de tamaños a veces gigantescos. Nunco se supo por qué fue. Ahora surgen pistas de que esta mortalidad estuvo relacionada —igual que hace 65 millones de años, en el momento en que los dinosaurios dominaban nuestro mundo— con el impacto de un cuerpo extraterrestre.

Algunos geólogos dicen que hace unos 380 millones de años, un asteroide llegado desde el espacio golpeó contra la Tierra. Creen que el impacto eliminó una importante fracción de los seres vivos. Esta idea puede fortalecer la discutida conexión entre las extinciones masivas y los impactos. Hasta ahora, el único candidato para hacer esta relación era el meteoro que habría causado el exterminio de los dinosaurios, caído en la península de Yucatán, en México.

Brooks Ellwood, de Louisiana State University en Baton Rouge, Estados Unidos, dice que los signos de una antigua catátrofe coinciden con la desaparición de muchas especies animales. “Esto no quiere decir que el impacto en sí mismo haya matado a los animales; la sugerencia es que tuvo algo que ver.” Y agregó que hoy, aunque no se puedan encontrar rastros del cráter de una roca del espacio, se puede saber dónde ha caído.

Otros investigadores coinciden en que hubo un impacto más o menos en esa época, pero creen que la evidencia de que produjo una extinción masiva es muy débil. Claro que, tal valoración no está avalada por hechos y, si tenemos en cuenta el tiempos transcurrido desde los hechos, buscar pruebas materiales…no es nada fácil

El equipo de Ellwood descubrió rocas en Marruecos que fueron enterradas alrededor de 380 millones de años atrás bajo una capa de sedimento que parece formada por restos de una explosión cataclísmica. El sedimento tiene propiedades magnéticas inusuales y contiene granos de cuarzo que parecen haber experimentado tensiones extremas.

Más o menos para esa época se produjo la desaparición del registro fósil de alrededor del 40% de los grupos de animales marinos.

El geólogo Paul Wignall, de la Leeds University, Reino Unido, dice que hay una fuerte evidencia del impacto. Si se lo pudiese relacionar con una extinción masiva sería un gran hallazgo. Si fuera cierto, el potencial letal de los impactos crecería enormemente.

Pero no está claro cuántas desapariciones se produjeron en la época del impacto. Wignall dice que la mortalidad puede haber sido mucho menor que lo que sugiere el equipo de Ellwood. Él piensa que los paleontólogos deberían buscar las pistas que les den una mejor imagen de lo que pasó en aquella época.

El paleontólogo Norman MacLeod, que estudia las extinciones masivas en el Natural History Museum de Londres, coincide en que aunque 40% es el valor correcto para aquel período de la historia de la Tierra, no es una extinción masiva, sino parte de una serie de sucesos mucha más extensa. MacLeod duda de que las extinciones masivas sean resultado de intervenciones extraterrestres. “Los impactos son un fenómeno bastante común”, dice. “Pero no coinciden significativamente con los picos de extinción.”

Las estrellas vecinas

Aunque nuestro entorno es inmenso, hemos llegado a conocer muy bien nuestra vecindad

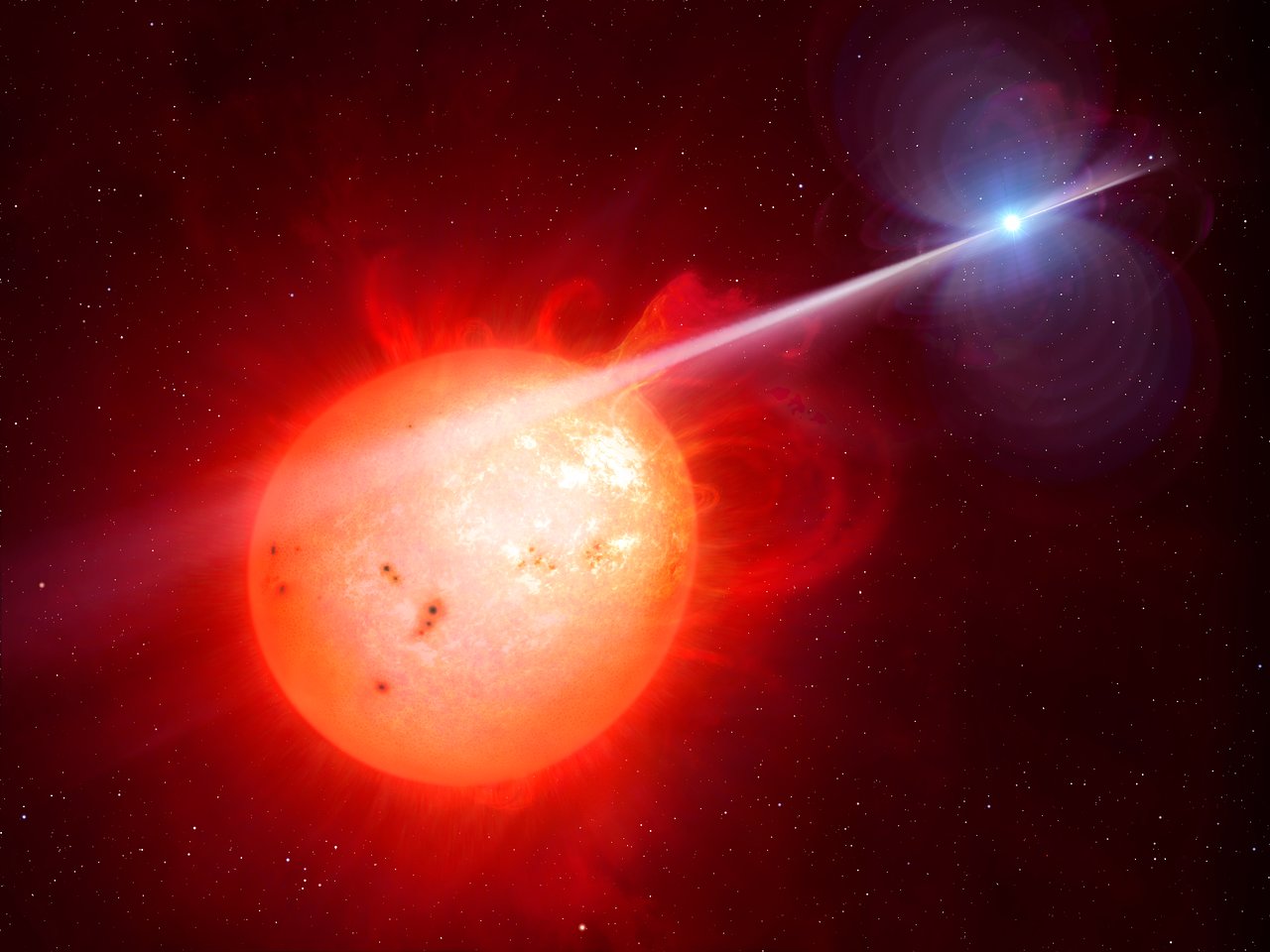

Nuestro vecindario galáctico es muy humilde. Nada de supergigantes o exóticas estrellas de neutrones. La mayoría de estrellas vecinas -unas 41- son simples enanas rojas (estrellas de tipo espectral M), las estrellas más comunes del Universo. Cinco son estrellas de tipo K, dos de tipo solar (tipo G, Alfa Centauri A y Tau Ceti), una de tipo F (Procyon) y una de tipo A (Sirio). Los tipos espectrales se ordenan según la secuencia OBAFGKM, siendo las estrellas más calientes (y grandes) las de tipo O y las más pequeñas y frías las de tipo M (siempre y cuando estén en la secuencia principal, claro). Además tenemos tres enanas blancas y tres candidatas a enanas marrones. Como vemos, no nos podemos quejar. Hay toda una multitud de posibles objetivos para nuestra primera misión interestelar. ¿Cuál elegir?

El llamado Grupo Local de galaxias al que pertenecemos es, afortunadamente, una agrupación muy poco poblada, sino podríamos ser, en cualquier momento (o haber sido aún antes de existir como especie) destruidos en catástrofes cósmicas como las que ocurren en los grupos con gran población de galaxias. Los astrónomos comprenden cada vez más el porqué de las formas de las galaxias, y parece que muchas (incluso la nuestra) han sufrido impactos contra otras para llegar a tener la figura que tienen. Gracias al telescopio espacial Hubble se están viendo en los últimos tiempos muy buenas imágenes de colisiones entre galaxias.

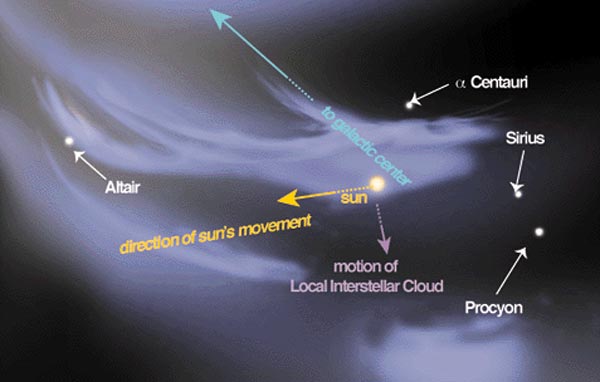

El “clima” interestelar

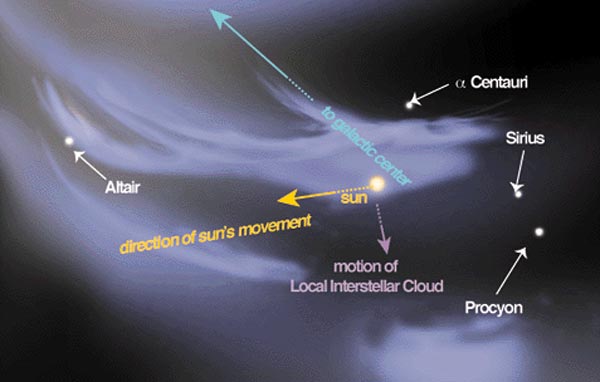

La Nube Interestelar Local se encuentra dentro de una estructura mayor: la Burbuja Local. La Burbuja Local es una acumulación de materia aún mayor, procedente de la explosión de una o varias supernovas que estallaron hace entre dos y cuatro millones de años. Pero aunque estemos atravesando ahora mismo la Nube Interestelar y la Burbuja locales, nuestra materia no procede de ellas. Sólo estamos pasando por ahí en este momento de la historia del universo. Entramos hace unos cinco millones de años, y saldremos dentro de otros tantos. Nuestro sistema solar –y la materia que contiene, incluyéndonos a ti y a mí– se formó mucho antes que eso, hace más de 4.500 millones de años.

“Banda de estrellas calientes y brillantes que forman un círculo alrededor del cielo. Representa una estructura local de estrellas jóvenes y material interestelar inclinada unos 16º con respecto al plano galáctico. Entre los componentes más prominentes del cinturón se encuentran las estrellas brillantes de Orión, Can mayor, constelación de la Popa, Carina, Centauro y Escorpio, incluyendo la asociación Sco-Cen. El cinturón tiene el diámetro de unos 3.000 años luz (alrededor de una décima parte del radio de la Galaxia), hallándose el Sol en él. Visto desde la Tierra, el Cinturón de Gould se proyecta por debajo del plano de nuestra Galaxia desde el borde inferior del Brazo de Orión, y por encima en la dirección opuesta. El cinturón se estima que tiene unos 50 millones de años de antigüedad, aunque su origen es desconocido. Su nombre proviene del astrónomo Benjamin Apthorp Gould, quien lo identificó durante la década de 1879.”

Al parecer, la Vía Láctea, nuestra galaxia, reside dentro de una “burbuja local” en una red de cavidades en el medio interestelar que probablemente fue esculpida por estrellas masivas que explotaron hace millones de años. Se le llama Medio Interestelar a la materia que existe en el espacio y que se encuentra situada entre los sistemas estelares. Esta materia está conformada por gas en forma de iones, átomos y moléculas, además de gas y rayos cósmicos.

Nuestra Burbuja Local forma a su vez parte del Cinturón de Gould que presentamos más arriba. El Cinturón de Gould es ya una estructura mucho más compleja y mayor. Es un anillo parcial de estrellas, de unos 3.000 años luz de extensión. ¿Recuerdas aquella nave espacial tan rápida que utilizamos antes? Pues con ella, tardaríamos 12.800.000 años en atravesarlo por completo. Vaya, esto empieza a ser mucho tiempo.

La Burbuja Local es una cavidad en el medio interestelar en el Brazo de Orión de la Vía Láctea. Tiene al menos un diámetro de 300 años luz. El gas caliente y difuso en la Burbuja Local emite rayos X.

Vivimos dentro de una burbuja. El planeta, el Sistema Solar, nuestro grupo local. El estallido de una supernova ha dejado un resto fósil en nuestro entorno: creó una enorme burbuja en el medio interestelar y nosotros nos encontramos dentro de ella. Los astrónomos la llaman “Burbuja local”. Tiene forma de maní, mide unos trescientos años luz de longitud y está prácticamente vacía. El gas dentro de la burbuja es muy tenue (0,001 átomos por centímetro cúbico) y muy caliente (un millón de grados), es decir, mil veces menos denso y entre cien y cien mil veces más caliente que el medio interestelar ordinario. Esta situación tiene influencia sobre nosotros, porque estamos inmersos dentro. ¿Qué pasaría si nos hubiese tocado estar dentro de una burbuja de gases ardientes resultantes de una explosión más reciente o de otro suceso catastrófico? ¿O si estuviésemos en una zona mucho más fría del espacio? No estaríamos aquí.

En algunos lugares de la Tierra, podemos ir viajando por caminos y carreteras y encontrarnos de frente con imágenes que, por su magnificencia, ¡asustan! Nuestra galaxia está en movimiento constante. No es una excepción en relación con el resto del universo. La Tierra se mueve alrededor del Sol, este último gira en torno a la Vía Láctea, y la gran mancha blanca a su vez forma parte de súper cúmulos que se mueven en relación a la radiación remanente de la gran explosión inicial. Pero hablemos del…

”Clima” galáctico

Dado que la Vía Láctea se está moviendo hacia la constelación de Hydra con una velocidad de 550 km / s, la velocidad del sol es de 370 km / s, …

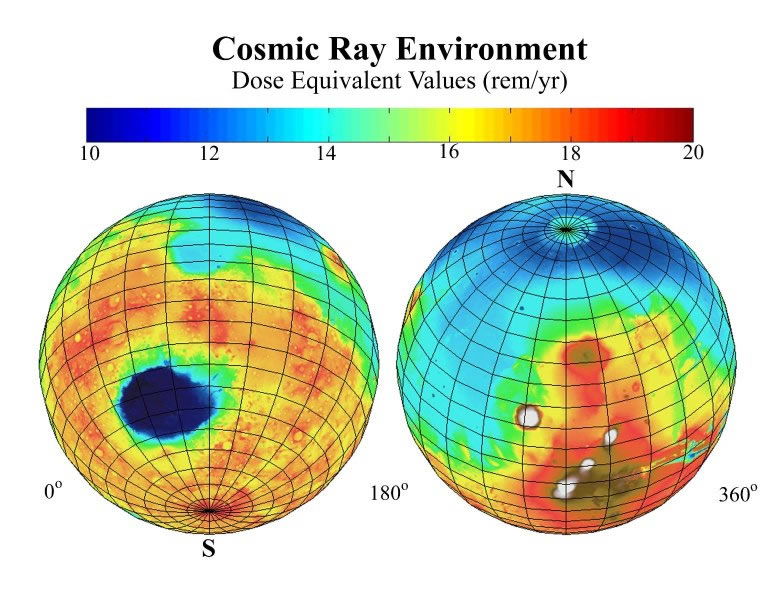

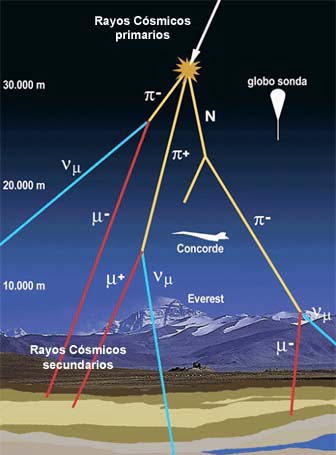

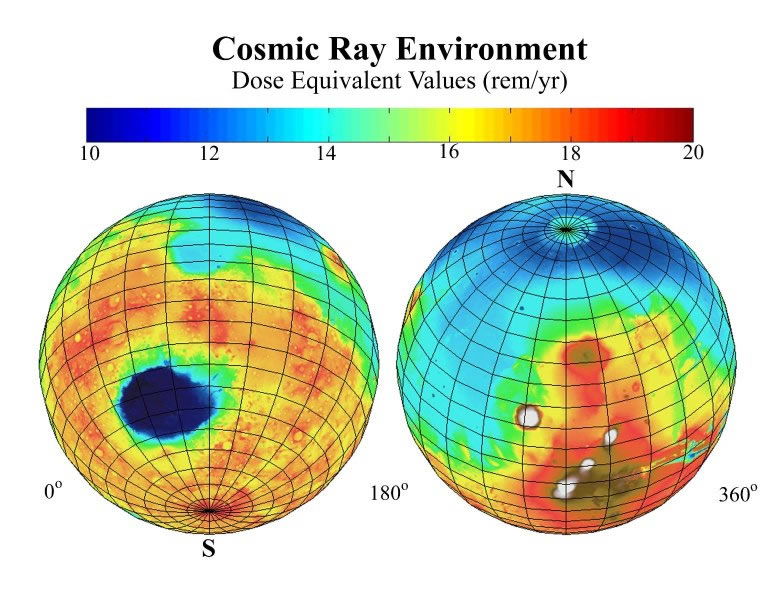

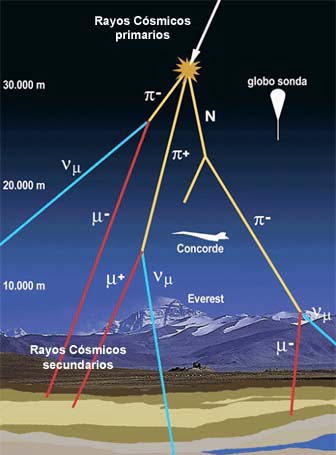

La galaxia en que vivimos podría tener una mayor influencia en nuestro clima que lo que se pensaba hasta ahora. Un reciente estudio, controvertido aún, asegura que el impacto de los rayos cósmicos sobre nuestro clima puede ser mayor que el del efecto invernadero que produce el dióxido de carbono.

Según uno de los autores de este estudio, el físico Nir Shaviv de la Universidad Hebrea de Jerusalén, en Israel, el dióxido de carbono no es tan “mal muchacho” como dice la gente. Shaviv y el climatólogo Ján Veizer de la Universidad Ruhr, de Alemania, estiman que el clima terrestre, que exhibe subas y bajas de temperatura global que al graficarse forman una figura de dientes de sierra, está relacionado con los brazos espirales de nuestra galaxia. Cada 150 millones de años, el planeta se enfría a causa del impacto de rayos cósmicos, cuando pasa por ciertas regiones de la galaxia con diferente cantidad de polvo interestelar.

Los rayos de todo tipo se nos vienen encima desde todos los rincones del Universo, y, algunos no llegan a la superficie de nuestro planeta gracias al escudo protector que salvaguarda nuestra integridad física.

Los rayos cósmicos provenientes de las estrellas moribundas que hay en los brazos de la Vía Láctea, ricos en polvo, incrementan la cantidad de partículas cargadas en nuestra atmósfera. Hay algunas evidencias de que esto ayuda a la formación de nubes bajas, que enfrían la Tierra.

Shaviv y Veizer crearon un modelo matemático del impacto de rayos cósmicos en nuestra atmósfera. Compararon sus predicciones con las estimaciones de otros investigadores sobre las temperaturas globales y los niveles de dióxido de carbono a lo largo de los últimos 500 millones de años, y llegaron a la conclusión de que los rayos cósmicos por sí solos pueden ser causa del 75% de los cambios del clima global durante ese período y que menos de la mitad del calentamiento global que se observa desde el comienzo del siglo veinte es debido al efecto invernadero.

La teoría, como es normal en la ciencia, no es del todo aceptada. Los expertos en clima mundial están a la espectativa, considerando que algunas de las conexiones que se han establecido son débiles. Se debe tener en cuenta, dicen los paleontólogos, que se trata de una correlación entre la temperatura, que es inferida de los registros sedimentarios, de la cantidad de dióxido de carbono, que se deduce del análisis de conchas marinas fosilizadas, y de la cantidad de rayos cósmicos, que se calculan a partir de los meteoritos. Las tres técnicas están abiertas a interpretaciones. Además, uno de los períodos fríos de la reconstrucción matemática es, en la realidad, una época que los geólogos consideran caliente. De todos modos, también hay muchos otros que están muy interesados e intrigados.

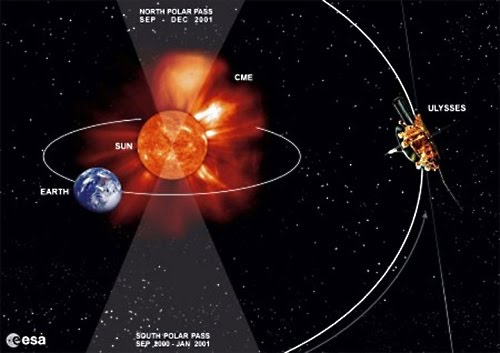

La variabilidad solar afecta la cantidad de rayos cósmicos que impactan a nuestro planeta. El Sol produce radiaciones similares a los rayos cósmicos, especialmente en el período más caliente, llamado máximo solar (maximum), de su ciclo de 11 años. Estudios anteriores no pudieron separar el impacto climático de esta radiación, de los rayos cósmicos que llegan desde la galaxia y de la mayor radiación calórica que llega desde el Sol.

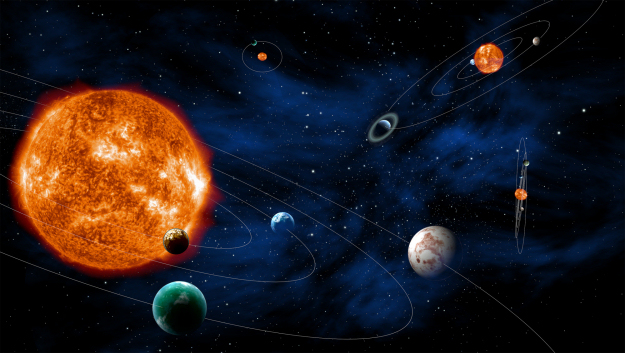

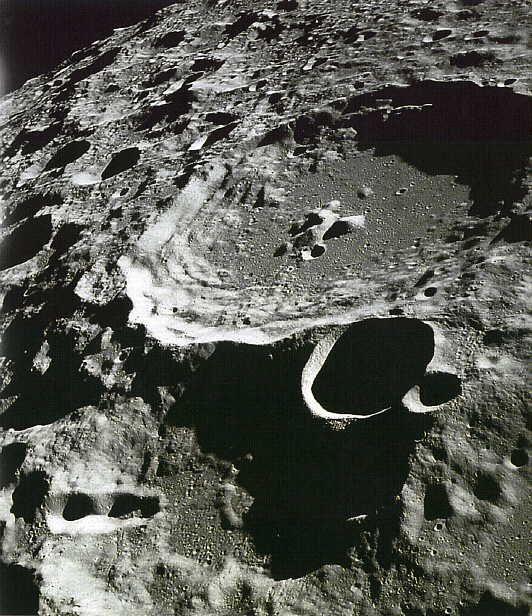

Los otros planetas y la Luna

Recientemente, se ha anunciado el hallazgo de un sistema planetario que podría ser similar al nuestro. En realidad no se ha logrado aún una observación tan directa que permita afirmarlo, sino que se deduce como posibilidad. Este sistema presenta un planeta gaseoso gigante similar a nuestro Júpiter, ubicado a una distancia orbital similar a la que tiene Júpiter en nuestro sistema. El sol es similar al nuestro, lo que deja lugar a que haya allí planetas ubicados en las órbitas interiores, dentro de la franja de habitabilidad en la que la radiación solar es suficiente para sostener la vida y no es excesiva como para impedirla.

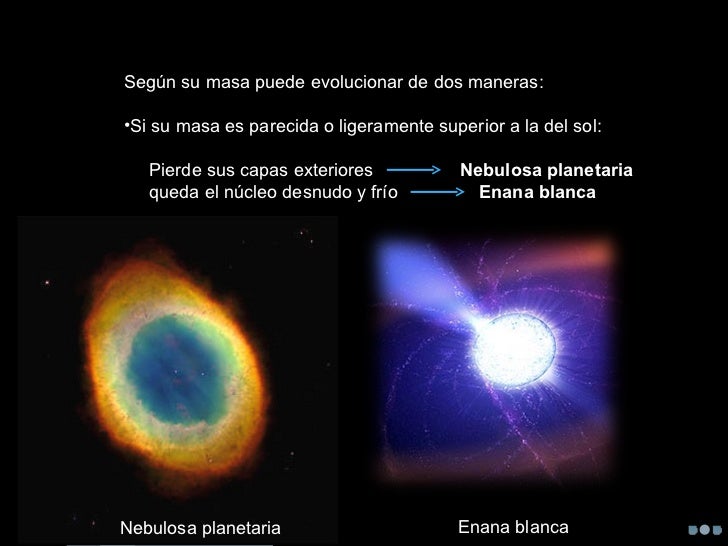

Cuando la Tierra comenzó a enfriarse, aparecieron las primeras células vivas, hace 3.800 M. de años

Si nuestro sistema no tuviese las características que posee, la vida en la Tierra tendría problemas. Por ejemplo, podría haber planetas, planetoides o grandes asteroides (de hecho algo hay) que giraran en planos diferentes y con órbitas excéntricas y deformes. Cuerpos así podrían producir variaciones cíclicas que hicieran imposible —o difícil— la vida. Venus parece haber sufrido un impacto que le cambió el sentido de rotación sobre sí mismo. Es posible que este impacto también haya desbaratado su atmósfera y su clima. Podría habernos pasado a nosotros, y de hecho parecería que nos ocurrió, sólo que fue durante el génesis del sistema planetario y además (otra gran casualidad y premio cósmico) nos dejó a la Luna, excelente compañera para facilitar la vida.

Según una teoría del geofísico J. Marvin Herndon, la Tierra es una gigantesca planta natural de generación nuclear. Nosotros vivimos en su delgada coraza, mientras a algo más de 6.000 kilómetros bajo nuestros pies se quema por la fisión nuclear una bola de uranio de unos ocho kilómetros de diámetro, produciendo un intenso calor que hace hervir el metal del núcleo, lo que produce el campo magnético terrestre y alimenta los volcanes y los movimientos de las placas continentales.

La cosa no acaba aquí: si el calor del reactor es el que produce la circulación de hierro fundido (por convección) que genera el campo magnético terrestre, entonces los planetas que no tienen su reactor natural no tendrían un campo magnético (magnetósfera) que los proteja de las radiaciones de su sol —como Marte y la Luna— lo que hace que difícilmente puedan sostener vida.

Pero ésta es sólo una teoría. Lo que está más en firme es que nuestro mundo y su luna forman un sistema muy particular, mucho más estable que si se tratara de un planeta solitario. Gracias a esto —a nuestra Luna— tenemos un clima más o menos estable, conservamos la atmósfera que tenemos y la velocidad y el ángulo de nuestro giro son los que son. Si no estuviese la Luna, el planeta se vería sujeto a cambios en su eje de rotación muy graves para los seres vivos, y, lo cierto es que…

La Tierra es única entre los planetas rocosos por tener una luna relativamente grande. La Luna ocupa el 5to lugar en diámetro entre todos los satélites del Sistema Solar. Tiene el 27% del diámetro de la Tierra y sólo tiene 1/81 de su masa.

Totales: 72.363.613

Totales: 72.363.613 Conectados: 52

Conectados: 52 por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en

Clasificado en

Buckyballs es el nombre coloquial utilizado para describir un fullereno. Los avances logrados por la Humanidad, son tan grandes que, estando a nuestro alrededor, no somos conscientes de su verdadero alcance.

Buckyballs es el nombre coloquial utilizado para describir un fullereno. Los avances logrados por la Humanidad, son tan grandes que, estando a nuestro alrededor, no somos conscientes de su verdadero alcance.